Kurs

Du hast also gerade von Databricks Unity Catalog gehört. Und du fragst dich jetzt, was es damit auf sich hat und welche Rolle es im modernen Datenmanagement spielt.

Dieser umfassende Leitfaden führt dich in Databricks Unity Catalog ein und hilft dir, seine Bedeutung für die Datenanalyse im modernen Data Stack zu verstehen.

Was ist der Databricks Unity Catalog?

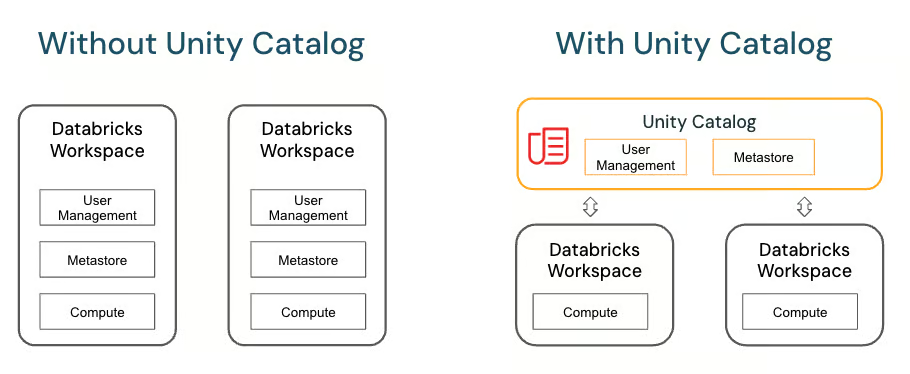

Databricks Unity Catalog ist ein einheitlicher Data-Governance-Service, der das Datenmanagement vereinfacht und optimiert. Datenmanagement für analytische Workloads vereinfacht und optimiert. Sie vereint alle verschiedenen Arten von Metadaten, die von verschiedenen Business Intelligence Tools, Datenbanken, Data Warehousesund Datenseen an einem zentralen Ort. Dies fördert die Interoperabilität zwischen den Systemen und erleichtert das Auffinden und den Zugriff auf strukturierte und unstrukturierte Daten.

Wenn Unternehmen ihren Datenbetrieb erweitern, wird die Verwaltung von Zugriff, Governance und Compliance über mehrere Datenplattformen hinweg komplex. Unity Catalog löst diese Herausforderung, indem es eine einheitliche Ebene für Metadaten, Zugriffskontrolle und Nachverfolgung bietet und so den betrieblichen Aufwand reduziert.

Dieser zentralisierte Data-Governance-Ansatz bringt einige Vorteile bei der gemeinsamen Nutzung von Datenprodukten mit sich, wie z. B:

- Modelle für maschinelles Lernen

- Notizbücher

- Dashboards

- Dateien

Zu den Kernkomponenten von Databricks Unity Catalog gehören:

- Metastore: Eine Speicherebene für Metadaten, die das Auffinden von Daten vereinfacht und die Datenabfolge verbessert.

- Katalog: Ein zentrales Repository zum Speichern, Verwalten und Auffinden von Datenbeständen.

- Schema: Ein Datenmodell, das zur Organisation und Verwaltung von Datenbeständen in Databricks Unity Catalog verwendet wird.

- Granularität: Der Detaillierungsgrad des Lernpfads für Metadaten. Es ermöglicht den Teams, den Zugriff auf verschiedenen Ebenen (Katalog, Schema, Tabelle oder sogar Spalte) zu verwalten und so eine fein abgestufte Kontrolle über die Datenbestände zu gewährleisten."

- Tabellen, Ansichten und Bände: Dies sind die grundlegenden Datenobjekte in Databricks Unity Catalog, die zur Darstellung strukturierter und unstrukturierter Daten verwendet werden.

- Abstammung der Daten: Eine visuelle Darstellung des Datenflusses von der Quelle bis zum Ziel, die hilft, Änderungen zu verfolgen und die Datenintegrität zu gewährleisten.

Diese Komponenten arbeiten zusammen, um eine umfassende Data-Governance-Lösung zu bieten, die die Datenverwaltung vereinfacht und die Zusammenarbeit zwischen den Teams fördert.

Vorteile des Unity-Katalogs

Die Verwendung von Databricks Unity Catalog bietet mehrere wichtige Vorteile, die wir im Folgenden erläutern:

1. Data Governance und Compliance

Databricks Unity Catalog bietet einen zentralen Ort für die Speicherung und Verwaltung von Metadaten und gewährleistet Datenverwaltung und Compliance über verschiedene Systeme hinweg.

Unity Catalog bietet zum Beispiel Warnungen für potenzielle PII-Erkennung in maschinellen Lernmodellen in der Produktion. Durch die Datenabfolge können diese Modelle leicht zurückgesetzt werden.

Das hilft Unternehmen, die Datenintegrität zu wahren, Vorschriften einzuhalten und Risiken zu verringern.

2. Zusammenarbeit und Self-Service-Analysen

Unity Catalog fördert die teamübergreifende Zusammenarbeit, indem er einen zentralen Ort für die Speicherung von Datenbeständen bietet. Dadurch werden Silos beseitigt und die funktionsübergreifende Kommunikation gefördert, was die Self-Service-Analysen.

Datenanalysten und Geschäftsanwender können relevante Datenbestände leicht finden und darauf zugreifen, wodurch sich der Zeitaufwand für die Datenaufbereitung verringert.

Wichtige Anwendungsfälle für den Unity-Katalog

Es gibt verschiedene Möglichkeiten, den Unity-Katalog umzusetzen:

1. Datenzugangskontrolle und Sicherheit

Databricks Unity Catalog ermöglicht es Unternehmen, eine fein abgestufte Zugriffskontrolle für Datenbestände zu implementieren und so sicherzustellen, dass nur autorisierte Benutzer auf die Daten zugreifen können. Es ermöglicht auch den sicheren Austausch von sensiblen Daten zwischen Teams.

2. Datenentdeckung und Abstammung

Unity Catalogs Metadaten-Management ermöglicht eine effiziente Datenerkennung und bietet eine visuelle Darstellung des Datenflusses von der Quelle bis zum Ziel. Auf diese Weise lassen sich Änderungen in Datensätzen nachverfolgen, was die Prüfung und Fehlerbehebung erleichtert.

3. Vereinfachung von Compliance und Audits

Mit einem zentralen Repository für alle Datenbestände und deren Herkunft vereinfacht Unity Catalog die Compliance-Berichterstattung und Audit-Prozesse. Das reduziert den Zeit- und Arbeitsaufwand für die Einhaltung von Vorschriften.

So aktivierst du den Unity-Katalog in Databricks

Probieren wir den Unity-Katalog mithilfe dieses einfachen Tutorials aus:

Voraussetzungen

Bevor du den Unity-Katalog aktivieren und nutzen kannst, musst du sicherstellen, dass du die folgenden Voraussetzungen erfüllst:

Databricks Premium oder Enterprise Plan

Unity Catalog wird nur auf den Databricks Premium oder Enterprise Tiers unterstützt. Stelle sicher, dass dein Databricks-Arbeitsbereich auf einem dieser Pläne ist.

Entsprechende Genehmigungen

- Account admin: Du musst die Rolle Account Admin in Databricks haben, um Unity Catalog auf Kontoebene einzurichten und zu verwalten.

- Arbeitsbereich admin: Du solltest ein Arbeitsbereich-Admin in dem Arbeitsbereich sein, in dem du den Unity-Katalog aktivieren möchtest.

Verfügbarkeit des Metastore

Unity Catalog erfordert einen Metastore auf der Kontoebene. Wenn du noch keinen erstellt hast, musst du das während der Einrichtung nachholen. Bei einem Databricks-Testkonto wird bereits ein Katalog mit Metastore für dich erstellt.

Unterstützte Cloud-Plattformen

Derzeit wird der Unity-Katalog unterstützt auf:

- AWS

- Azure

- GCP

Stelle sicher, dass du eine unterstützte Databricks-Umgebung in einer dieser Clouds verwendest.

Verwalteter Speicher oder externe Standorte

Entscheide, ob du verwaltete Tabellen (Managed Storage) nutzen oder externe Tabellen erstellen willst, die auf Daten an einem externen Speicherort verweisen (wie S3, ADLS oder GCS). Jeder Ansatz kann unterschiedliche Genehmigungsanforderungen haben.

Aktivieren des Unity-Katalogs: Schritt-für-Schritt-Anleitung

Navigieren in Databricks Einstellungen

- Melde dich in der Databricks-Konsole an

- Gehen Sie zur Databricks-Konto-Konsole (Die URL kann für AWS, Azure oder GCP leicht abweichen). Verwende einen Administrator, um dich anzumelden.

- Zugriff auf die Katalogseite

- Suchen Sie im linken Navigationsbereich (in der Kontenkonsole) nach Katalog abhängig von deiner Databricks-Version.

- In einer Databricks-Testversion sollten ein Serverless Starter Warehouse Metastore und ein Katalog erstellt worden sein.

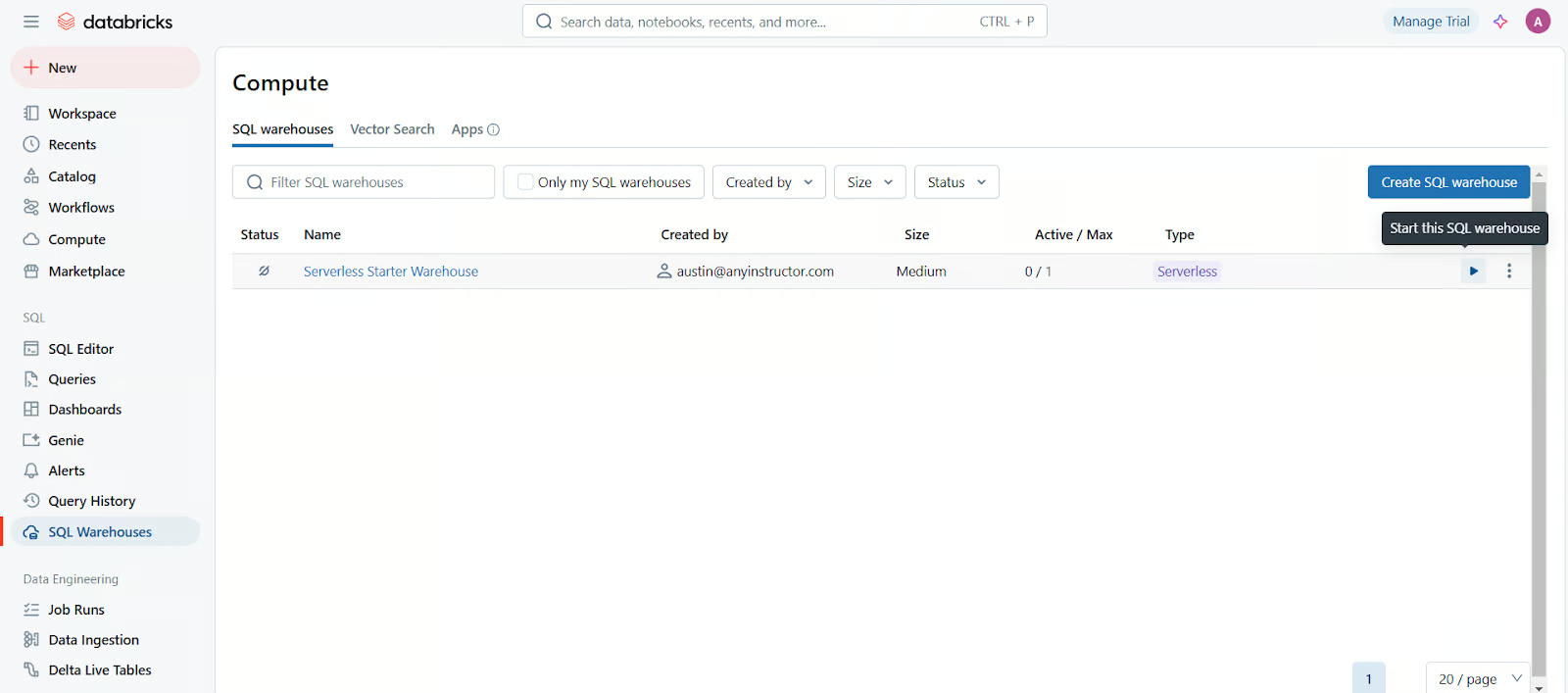

- SQL-Warehouse-Berechnung starten

- Wählen Sie im linken Navigationsbereich SQL-Warehousesund starte dann das Serverless Starter Warehouse, indem du auf die Schaltfläche Abspielen Symbol auf der rechten Seite klickst.

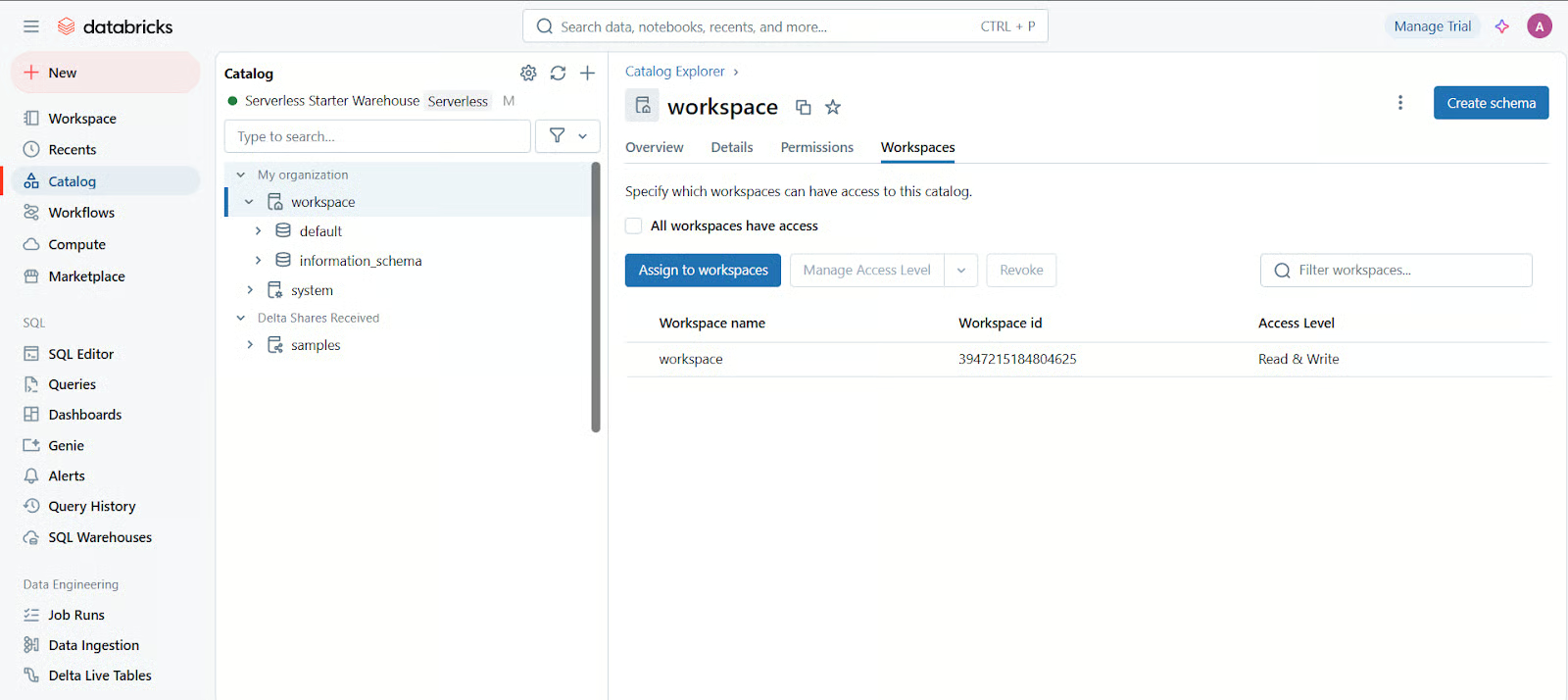

- Arbeitsbereichen zuweisen

- Unter Arbeitsbereiche in der Katalogkonfiguration die Arbeitsbereiche an, die diesen Katalog verwenden sollen.

Unity-Katalog konfigurieren

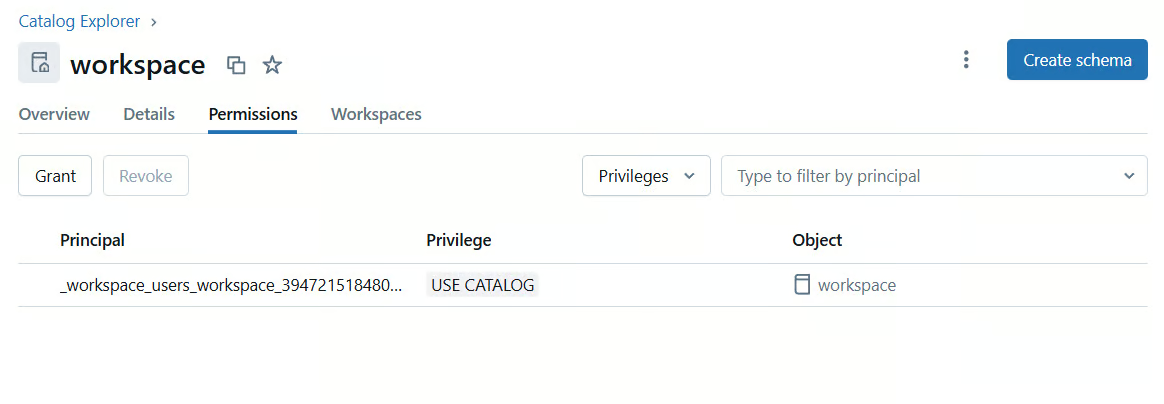

- Berechtigungen zuweisen

- Als Administrator navigierst du zu Katalog in der linken Seitenleiste deines Databricks-Arbeitsbereichs.

- Wähle den Arbeitsbereich aus, den du verwalten willst.

- Klicke auf die Registerkarte "Berechtigungen ", um Berechtigungen einzurichten (z. B. wer Kataloge, Schemas und Tabellen erstellen darf). Standardmäßig hat der Kontoverwalter oder der Arbeitsbereichsverwalter alle Rechte, aber du kannst die Rechte auch an andere Benutzer oder Gruppen delegieren.

- Kataloge und Schemata erstellen (falls erforderlich)

- Du kannst zusätzliche Kataloge und Schemata für verschiedene Teams, Projekte oder Datendomänen erstellen. Dies geschieht oft über SQL-Befehle (siehe unten).

-- Creates a new catalog named "demo_catalog"

CREATE CATALOG IF NOT EXISTS demo_catalog

COMMENT 'This catalog is created for Unity Catalog demo';- Externe Speicherorte konfigurieren (optional)Wenn du externe Tabellen benötigst, die an externen Orten gespeichert werden:

- Erstelle einen externen Speicherort im Unity Catalog, der auf deinen Cloud-Speicher (S3, ADLS oder GCS) verweist.

- Erteile Benutzern oder Gruppen über den Unity Catalog Lese- und Schreibzugriff auf diese Orte.

Beispielcode und Verwendung

Im Folgenden findest du einige Beispiele für Databricks Notebooks/SQL-Befehle, die du verwenden kannst, sobald Unity Catalog in deinem Arbeitsbereich konfiguriert ist.

Du kannst sie in einem Databricks-Notizbuch oder im SQL-Editor deines Arbeitsbereichs ausführen.

Privilegien für einen Katalog erteilen

Die Vergabe von Berechtigungen für einen Katalog stellt sicher, dass bestimmte Benutzergruppen auf die darin gespeicherten Daten zugreifen und mit ihnen interagieren können. Mit USAGE allein können die Nutzer jedoch keine Daten abfragen, sondern nur sehen, dass der Katalog existiert. Um eine vollständige Interaktion zu ermöglichen, musst du zusätzliche Berechtigungen auf Schema- oder Tabellenebene vergeben.

Zum Beispiel, um Dateningenieuren den Zugriff auf einen Katalog zu ermöglichen:

-- Grant USAGE to a specific group on the newly created catalog

GRANT USAGE ON CATALOG demo_catalog TO data_engineers_group;Wenn sie innerhalb dieses Katalogs auch Schemata erstellen müssen:

GRANT CREATE ON CATALOG demo_catalog TO data_engineers_group;Erstellen eines Schemas (Datenbank) innerhalb des Katalogs

Ein Schema in Unity Catalog organisiert die Tabellen und Ansichten innerhalb eines Katalogs, ähnlich wie eine Datenbank Tabellen in traditionellen RDBMS-Systemen enthält. Die Verwendung von IF NOT EXISTS verhindert Fehler, wenn das Schema bereits existiert.

So erstellen Sie ein Schema für Analysedaten in demo_catalog:

CREATE SCHEMA IF NOT EXISTS demo_catalog.analytics

COMMENT 'Schema for analytics data';Nach der Erstellung musst du eventuell bestimmten Nutzern Berechtigungen erteilen:

GRANT USAGE ON SCHEMA demo_catalog.analytics TO data_analysts_group;So kann die Gruppe data_analysts_group das Schema sehen, aber noch nicht die Tabellen abfragen.

Erstellen einer verwalteten Tabelle

Verwaltete Tabellen werden vollständig von Unity Catalog kontrolliert, d.h. Databricks kümmert sich um die Speicherung und den Lernpfad der Metadaten. Das vereinfacht die Verwaltung, bedeutet aber auch, dass die Daten gelöscht werden, wenn die Tabelle gelöscht wird.

So erstellst du eine verwaltete Tabelle für Verkaufsdaten:

USE CATALOG demo_catalog;

USE SCHEMA analytics;

CREATE TABLE IF NOT EXISTS sales_data (

transaction_id STRING,

product_id STRING,

quantity INT,

price DECIMAL(10,2),

transaction_date DATE

)

COMMENT 'Managed table for sales data';

Erteilen von Privilegien für eine Tabelle

Die Vergabe von Tabellenprivilegien stellt sicher, dass die Benutzer Daten abfragen oder ändern können. Das SELECT Privileg erlaubt es Benutzern, Daten zu lesen, aber nicht zu ändern.

Damit Data Scientists aus der Tabelle der Verkäufe lesen können:

GRANT SELECT ON TABLE demo_catalog.analytics.sales_data TO data_scientists_group;

Wenn sie neue Datensätze einfügen müssen, gewähren sie INSERT:

GRANT INSERT ON TABLE demo_catalog.analytics.sales_data TO data_scientists_group;

Für volle Kontrolle (Lesen, Schreiben, Ändern), verwende:

GRANT ALL PRIVILEGES ON TABLE demo_catalog.analytics.sales_data TO data_scientists_group;

Einrichtung eines externen Standorts

Wenn du einen externen Datenstandort hast (z.B. S3 auf AWS), kannst du ein externes Standortobjekt in Unity Catalog erstellen:

-- Create an external location named "demo_external_location"

CREATE EXTERNAL LOCATION demo_external_location

URL 's3://my-demo-bucket/my-path/'

WITH CREDENTIAL my_storage_credential

COMMENT 'External location for demo data';

-- Grant read and write privileges to a group

GRANT READ, WRITE ON EXTERNAL LOCATION demo_external_location

TO data_engineers_group;Databricks Unity Katalog Architektur

Databricks Unity Catalog basiert auf dem Open-Source-Projekt Apache Sparkauf, das eine verteilte Computing-Plattform für die Verarbeitung großer Datenmengen bietet. Sie verwendet den Hive Metastore um Metadaten über Datensätze und Tabellen zu speichern, was eine effiziente Verwaltung und Abfrageleistung ermöglicht.

Die Architektur des Unity-Katalogs umfasst drei Hauptkomponenten:

- Metadata Store: Diese Komponente speichert alle Metadaten zu Datensätzen, Tabellen, externen Standorten und anderen Objekten.

- Katalog: Diese Komponente fungiert als Schnittstelle zwischen dem Metadatenspeicher und der Berechnungsschicht. Sie bietet eine einheitliche Ansicht aller im Metadatenspeicher gespeicherten Metadaten, die es den Nutzern erleichtert, auf ihre Daten zuzugreifen und sie abzufragen.

- Arbeitsbereiche: Workspaces sind virtuelle Speicherorte, an denen Daten sicher gespeichert und verwaltet werden können. Sie ermöglichen eine einfache Zusammenarbeit zwischen Teams, indem sie einen zentralen Ort für den Datenzugriff und die Datenbearbeitung bieten.

Quelle: Databricks

Mit Databricks Unity Catalog können Nutzer ihre Daten einfach verwalten und abfragen, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen. Sie können auch mit anderen Teammitgliedern zusammenarbeiten, indem sie ihnen bestimmte Berechtigungen, wie z. B. Lese- und Schreibrechte, für verschiedene Datensätze oder Tabellen erteilen.

Um diese Berechtigungen zu erteilen, können Benutzer SQL-Befehle wie "GRANT" verwenden, um festzulegen, welche Benutzer oder Gruppen auf bestimmte Daten zugreifen dürfen. So wird sichergestellt, dass nur autorisierte Personen Zugang zu sensiblen Informationen haben.

Wie Unity Catalog mit bestehenden Datensystemen integriert wird

Unity Catalog lässt sich nahtlos in bestehende Datensysteme integrieren, wie z. B. Amazon S3 und Azure Blob Storageund macht es einfach, auf Daten aus verschiedenen Quellen zuzugreifen und sie zu verwalten. So können Nutzer/innen schnell große Datensätze analysieren, ohne die Daten manuell in Databricks verschieben oder kopieren zu müssen.

Unity Catalog unterstützt auch verschiedene Dateiformate wie CSV, JSON, Parquet und Avro, sodass du flexibel mit unterschiedlichen Datentypen arbeiten kannst.

Databricks Unity Catalog Best Practices

Bei der Arbeit mit dem Unity Catalog gibt es einige Best Practices, die ein effizientes und effektives Datenmanagement ermöglichen.

Dazu gehören:

- Verwende aussagekräftige Namenskonventionen für Tabellen und Spalten, um das Verständnis der Daten zu erleichtern.

- Aktualisiere regelmäßig die Metadaten im Unity-Katalog, damit du alle Änderungen an den zugrunde liegenden Daten verfolgen kannst.

- Nutze Zugangskontrollen, um den Zugang zu sensiblen Daten zu beschränken und folge dabei dem Prinzip des "geringsten Privilegs". Das bedeutet, dass du Nutzern oder Gruppen nur die notwendigen Berechtigungen auf der Grundlage ihrer Rollen und Verantwortlichkeiten erteilst.

- Verwende Tags und Labels, um Datensätze im Unity Catalog zu klassifizieren und zu organisieren, damit du leichter nach bestimmten Daten suchen kannst.

Diese Maßnahmen tragen dazu bei, eine effektive Datenverwaltung und optimale Leistung zu gewährleisten.

Häufige Herausforderungen und wie man sie angeht

Unity Catalog ist keine narrensichere Lösung und kann einige Herausforderungen bei der effektiven Datenverwaltung mit sich bringen.

Einige häufige Probleme sind:

- Datenvervielfältigung: Das passiert, wenn dieselben Daten mehrfach gespeichert werden, was zu Inkonsistenzen und Fehlern führt.

- Datenqualität: Schlecht gepflegte oder ungenaue Daten können Geschäftsentscheidungen und -prozesse beeinträchtigen.

- Komplexe Datenhierarchien: Große Datensätze mit komplexen Beziehungen können im Unity-Katalog schwer zu organisieren und zu verwalten sein.

Um diese Herausforderungen zu meistern, findest du hier einige Tipps:

- Überprüfe und bereinige die Daten regelmäßig, um Doppelarbeit zu vermeiden. Dazu gehört auch das Entfernen unnötiger oder veralteter Daten.

- Implementiere Datenqualitätsprüfungen und Validierungen um die Richtigkeit der Daten im Unity-Katalog zu gewährleisten.

Schlussgedanken

Unity Catalog ist ein leistungsfähiges Werkzeug zur Verwaltung von Daten in einer einzigen Ansicht durch die Verwendung von Metaspeichern, Katalogen und Arbeitsbereichen. Es bietet einen zentralen Ort für die Speicherung und Organisation von Daten und erleichtert so die Verwaltung und Nutzung in deinen Geschäftsprozessen.

Willst du mehr über Databricks erfahren? Du solltest dir unsere Einführung in Databricks Kurs besuchen, Databricks Tutorial Handbuch und Databricks-Webinar.

Databricks Unity Katalog FAQs

Was ist der Unterschied zwischen Unity Catalog und Hive Metastore Databricks?

Unity Catalog ist ein einheitlicher Metadatendienst, der eine effizientere und skalierbarere Alternative zum traditionellen Hive Metastore auf Databricks bietet. Es bietet eine zentrale Quelle für alle deine Metadaten und ermöglicht eine einfachere Verwaltung und einen leichteren Zugriff.

Kann ich den Unity Catalog mit Datenquellen verwenden, die nicht von Databricks stammen?

Ja, Unity Catalog unterstützt sowohl von Databricks verwaltete als auch externe Tabellen, so dass du Metadaten aus verschiedenen Quellen ganz einfach an einem Ort integrieren kannst. Allerdings kann es einige Einschränkungen geben.

Wie verbessert der Unity-Katalog die Leistung?

Durch die Bereitstellung eines zentralen Metadatenspeichers macht Unity Catalog häufige Abfragen bei externen Systemen überflüssig, was zu schnelleren Abfragezeiten führt.

Ich bin Austin, ein Blogger und Tech-Autor mit jahrelanger Erfahrung als Datenwissenschaftler und Datenanalyst im Gesundheitswesen. Ich habe meine Reise in die Welt der Technik mit einem Hintergrund in Biologie begonnen und helfe jetzt anderen mit meinem Technik-Blog, den gleichen Weg einzuschlagen. Meine Leidenschaft für Technologie hat dazu geführt, dass ich für Dutzende von SaaS-Unternehmen schreibe, um andere zu inspirieren und meine Erfahrungen zu teilen.