programa

Al utilizar la aplicación DeepSeek en nuestro teléfono u ordenador de sobremesa, puede que nos encontremos inseguros sobre cuándo elegir R1, también conocido como DeepThink, en comparación con el modelo predeterminado V3 para nuestras tareas cotidianas.

Para los desarrolladores, el reto es un poco diferente. Al integrar DeepSeek a través de su API, el reto consiste en averiguar qué modelo se ajusta mejor a los requisitos de nuestro proyecto y mejora la funcionalidad.

En este blog, trataré los aspectos clave de ambos modelos para ayudarte a tomar estas decisiones más fácilmente. Proporcionaré ejemplos para ilustrar cómo se comporta y funciona cada modelo en diferentes situaciones. También te daré una guía de decisión que puedes utilizar para elegir entre DeepSeek-R1 y DeepSeek-V3.

¿Qué son DeepSeek-V3 y DeepSeek-R1?

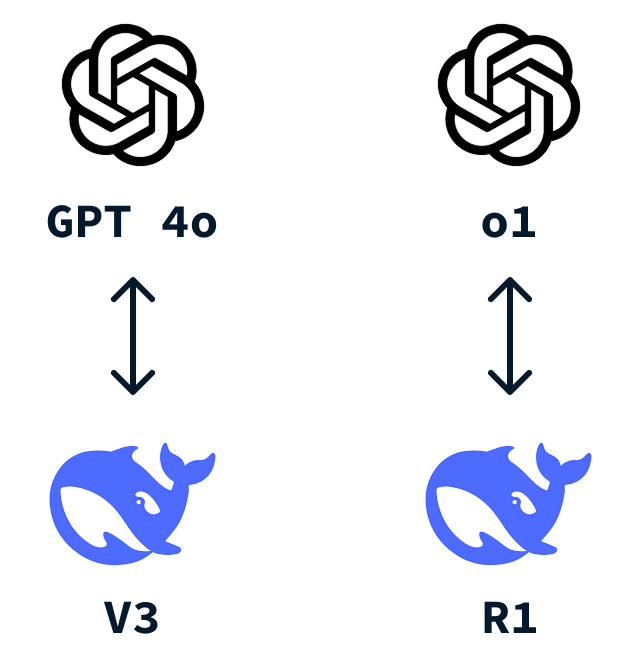

DeepSeek es una startup china de IA que ha acaparado la atención internacional tras desarrollar DeepSeek-R1 a un coste mucho menor que el o1 de OpenAI. Al igual que OpenAI tiene el ChatGPT que todos conocemos, DeepSeek también tiene un chatbot similar, y viene con dos modelos: DeepSeek-V3 y DeepSeek-R1.

¿Qué es DeepSeek-V3?

DeepSeek-V3 es el modelo por defecto que se utiliza cuando interactuamos con la aplicación DeepSeek. Es un versátil gran modelo de lenguaje (LLM) que destaca como herramienta de uso general capaz de realizar una amplia gama de tareas.

Este modelo compite con otros modelos lingüísticos bien conocidos, como el de OpenAI GPT-4o.

Una de las características clave de DeepSeek-V3 es el uso de un enfoque de Mezcla de Expertos (MDE). Este método permite al modelo elegir entre distintos "expertos" para realizar tareas específicas. Después de dar al modelo tu indicación, sólo se activa la parte más relevante del modelo para una tarea determinada, lo que ahorra recursos informáticos a la vez que ofrece resultados precisos. Para saber más, consulta esta entrada del blog sobre Mezcla de Expertos (ME).

En esencia, DeepSeek-V3 es una opción fiable para la mayoría de las tareas cotidianas que exigiríamos a un LLM. Sin embargo, como la mayoría de los LLM, funciona utilizando la predicción de la palabra siguiente, lo que limita su capacidad para resolver problemas que requieran razonamiento o para idear nuevas respuestas que no estén codificadas de algún modo en los datos de entrenamiento.

¿Qué es DeepSeek-R1?

DeepSeek-R1 es un potente modelo de razonamiento construido para resolver tareas que requieren razonamiento avanzado y resolución de problemas en profundidad. Funciona muy bien para los retos de codificación que van más allá de regurgitar el código que se ha escrito miles de veces y las preguntas con mucha lógica.

Piensa en ella como tu opción a la que recurrir cuando la tarea que quieras resolver exija operaciones cognitivas de alto nivel, similares al razonamiento profesional o de nivel experto.

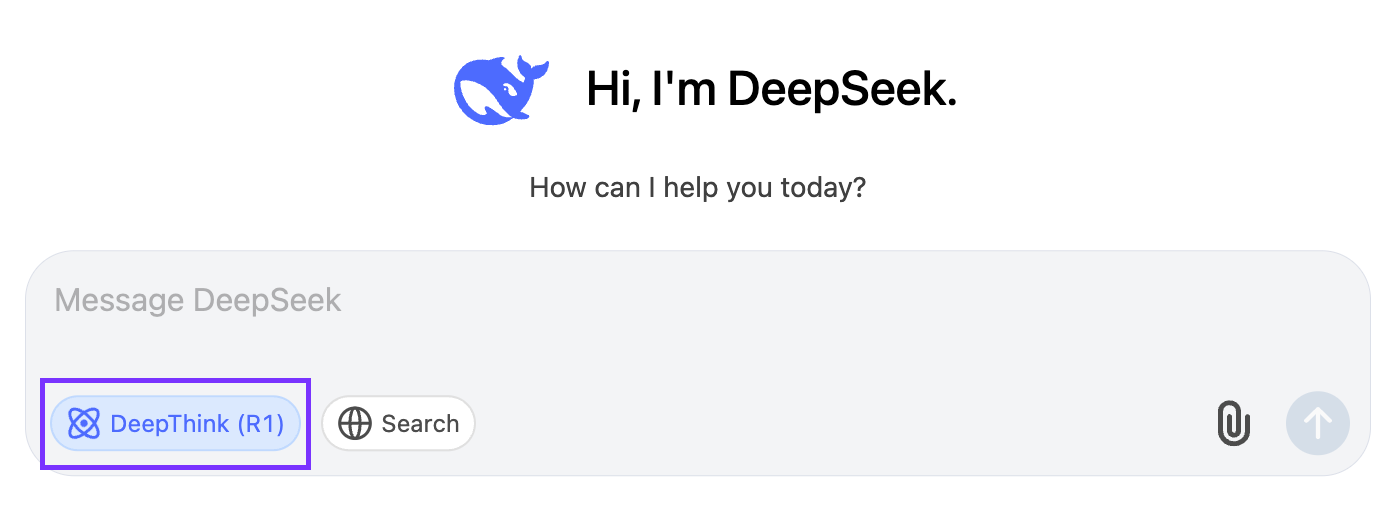

Lo activamos pulsando el botón "DeepThink (R1)":

Lo que diferencia a DeepSeek-R1 es su uso especial del aprendizaje por refuerzo. Para entrenar a R1, DeepSeek se basó en los cimientos establecidos por V3, utilizando sus amplias capacidades y su gran espacio de parámetros. Realizaron el aprendizaje por refuerzo permitiendo que el modelo generara varias soluciones para los escenarios de resolución de problemas. A continuación, se utilizó un sistema de recompensa basado en reglas para evaluar la corrección de las respuestas y los pasos de razonamiento. Este enfoque de aprendizaje por refuerzo animó al modelo a perfeccionar sus capacidades de razonamiento a lo largo del tiempo, aprendiendo efectivamente a explorar y desarrollar vías de razonamiento de forma autónoma.

DeepSeek-R1 es un competidor directo del o1 de OpenAI.

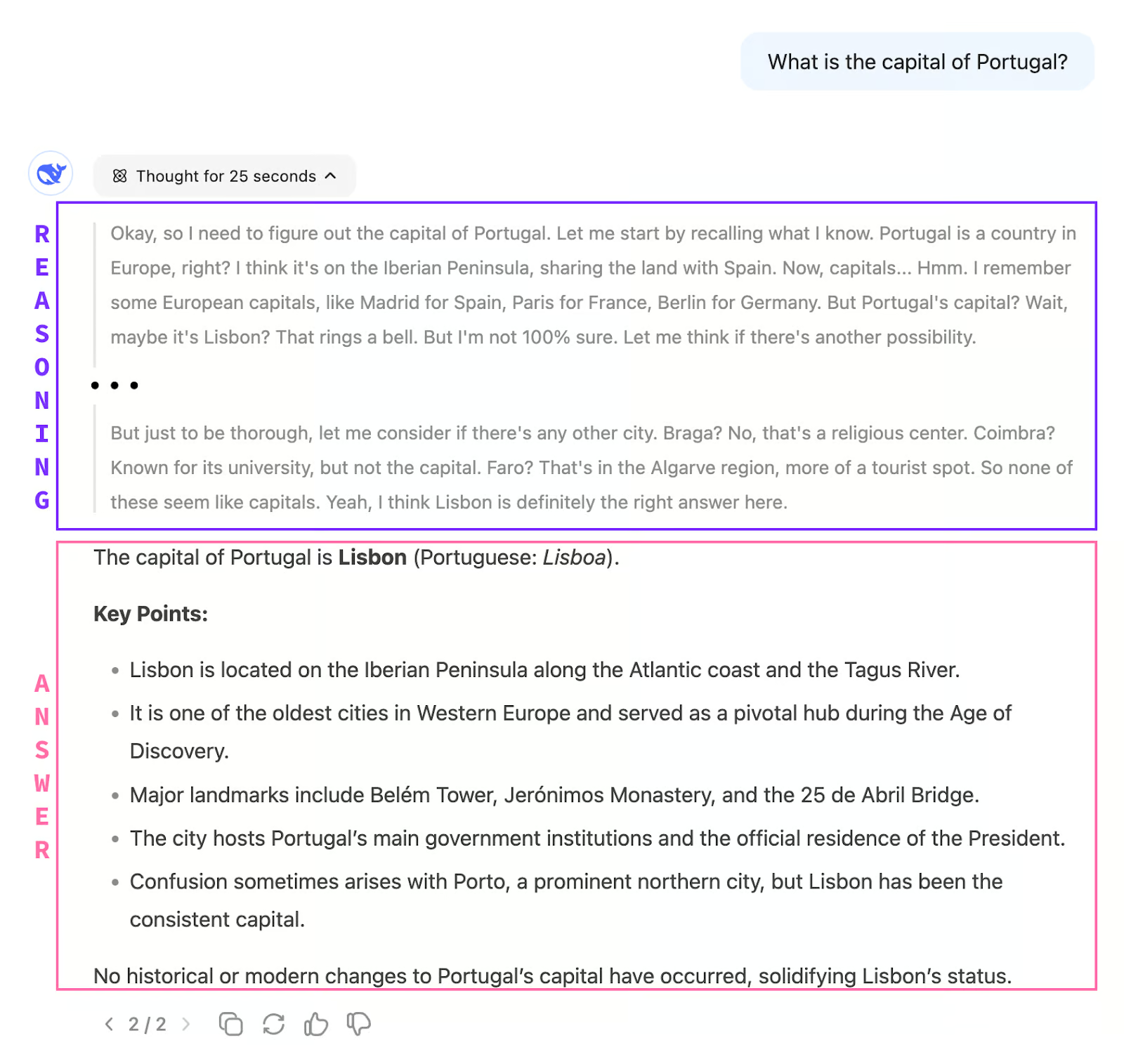

Una diferencia entre V3 y R1 es que cuando chateamos con R1, no obtenemos inmediatamente una respuesta. El modelo utiliza primero cadena de pensamiento para pensar en el problema. Sólo cuando termina de pensar empieza a emitir la respuesta.

Esto también significa que, en general, R1 es mucho más lento que V3 a la hora de responder, ya que el proceso de pensamiento puede tardar varios minutos en completarse, como veremos en ejemplos posteriores.

Diferencias entre V3 y R1

Repasemos las diferencias entre DeepSeek-R1 y DeepSeek-V3 en función de varios aspectos:

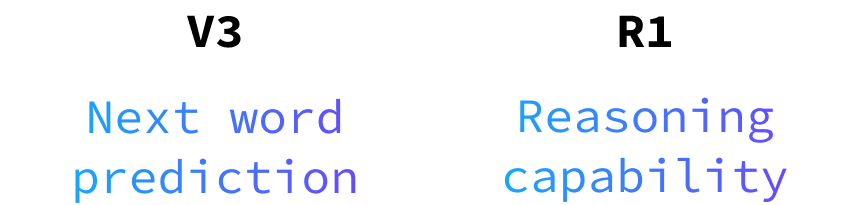

Capacidad de razonamiento

DeepSeek-V3 no tiene capacidad de razonamiento. Como ya hemos dicho, funciona como predictor de la siguiente palabra. Esto significa que puede responder a preguntas cuyas respuestas están codificadas en los datos de entrenamiento.

Como la cantidad de datos utilizados para entrenar estos modelos es tan enorme, es capaz de responder a preguntas sobre casi cualquier tema. Al igual que otros LLM, destaca por su conversación natural y su creatividad. Es el modelo que queremos para la redacción, la creación de contenidos o la respuesta a preguntas genéricas que probablemente ya se hayan resuelto numerosas veces.

DeepSeek-R1, en cambio, brilla cuando se trata de tareas complejas de resolución de problemas, lógica y razonamiento paso a paso. Está diseñado para abordar consultas difíciles que requieren un análisis exhaustivo y soluciones estructuradas. Cuando te enfrentes a complejos retos de codificación o a detallados rompecabezas lógicos, R1 es la herramienta en la que debes confiar.

Rapidez y eficacia

DeepSeek-V3 se beneficia de su arquitectura de Mezcla de Expertos (MoE), que le permite responder con mayor rapidez y eficacia. Esto hace que la V3 sea ideal para interacciones en tiempo real en las que la velocidad es crucial.

DeepSeek-R1 suele tardar un poco más en generar respuestas, pero esto se debe a que se centra en ofrecer respuestas más profundas y estructuradas. El tiempo extra se utiliza para garantizar soluciones completas y bien pensadas.

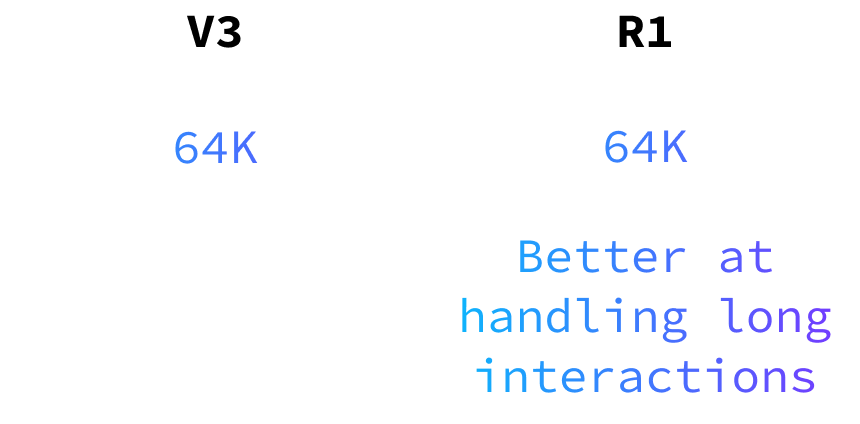

Memoria y manejo del contexto

Ambos modelos pueden manejar hasta 64.000 tokens de entrada, pero DeepSeek-R1 es especialmente hábil para mantener la lógica y el contexto en interacciones largas. Esto lo hace adecuado para tareas que requieren razonamiento y comprensión sostenidos a lo largo de conversaciones extensas o proyectos complejos.

Lo mejor para los usuarios de la API

Para quienes utilizan la API, DeepSeek-V3 ofrece una experiencia de interacción más natural y fluida. Su fuerza en el lenguaje y la conversación hace que las interacciones con el usuario sean fluidas y atractivas.

El tiempo de respuesta de R1 puede ser un problema para muchas aplicaciones, por lo que recomiendo utilizarlo sólo cuando sea estrictamente necesario.

Ten en cuenta que los nombres de los modelos al utilizar la API no son V3 y R1. El modelo V3 se denomina deepseek-chat mientras que el R1 se denomina deepseek-reasoner.

Diferencias de precios

Al considerar qué modelo utilizar, cabe señalar que el V3 es más barato que el R1. Aunque este blog se centra en la funcionalidad, es importante sopesar los costes asociados a cada modelo y nuestras necesidades y presupuesto específicos. Para más detalles sobre los costes, consulta los precios de su API.

DeepSeek-R1 vs. V3: Ejemplos de DeepSeek Chat

Ejemplo 1: Resolución de problemas y tareas lógicas

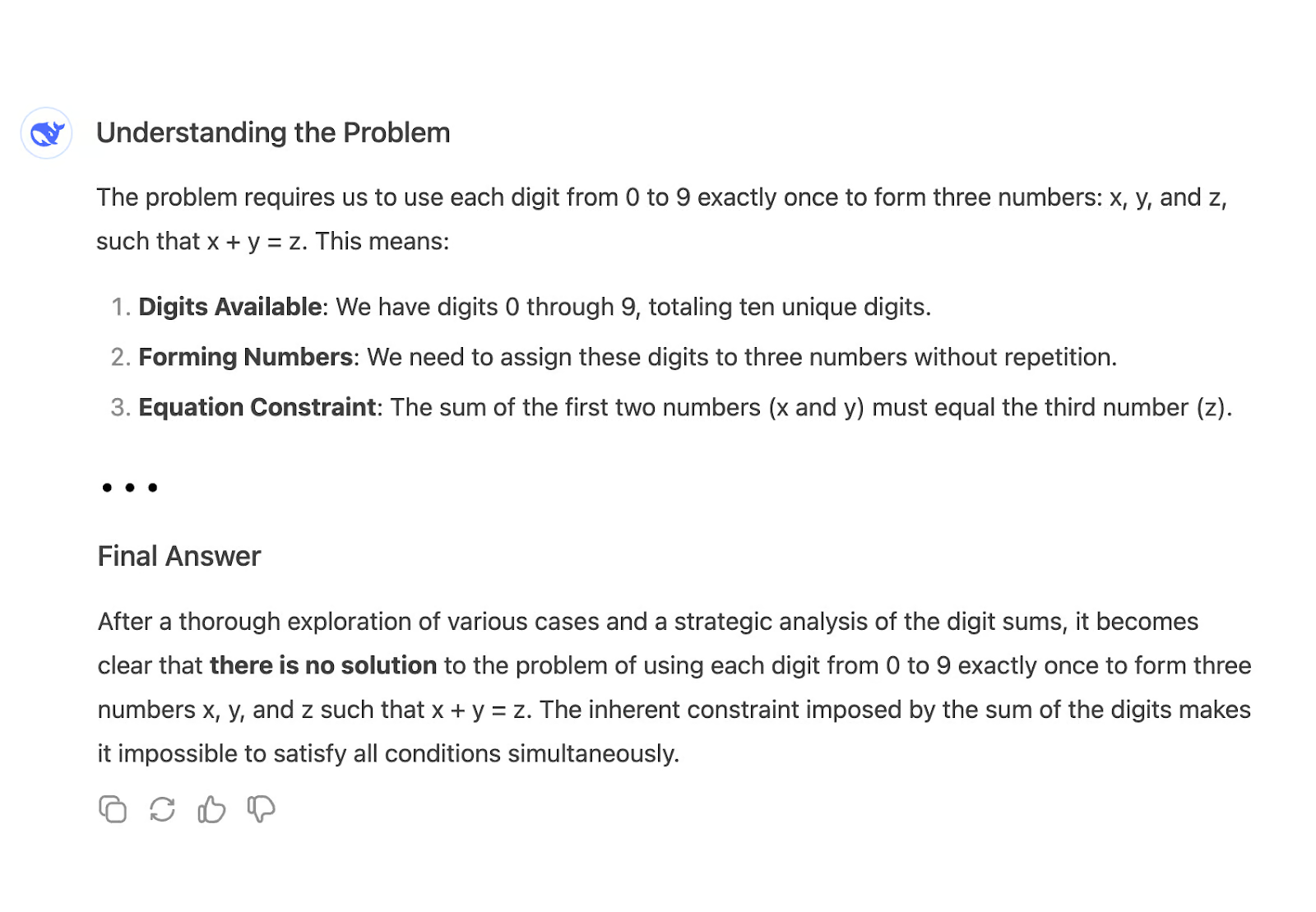

Comparemos la capacidad de razonar de ambos modelos planteando la siguiente pregunta:

"Utiliza los dígitos [0-9] para hacer tres números: x,y,z de forma que x+y=z"

Por ejemplo, una posible solución es: x = 26, y = 4987, y z = 5013. Utiliza todos los dígitos 0-9 y x + y = z.

Cuando planteamos esta pregunta a V3, inmediatamente empieza a producir una respuesta larga y, en última instancia, llega a la conclusión incorrecta de que no hay solución:

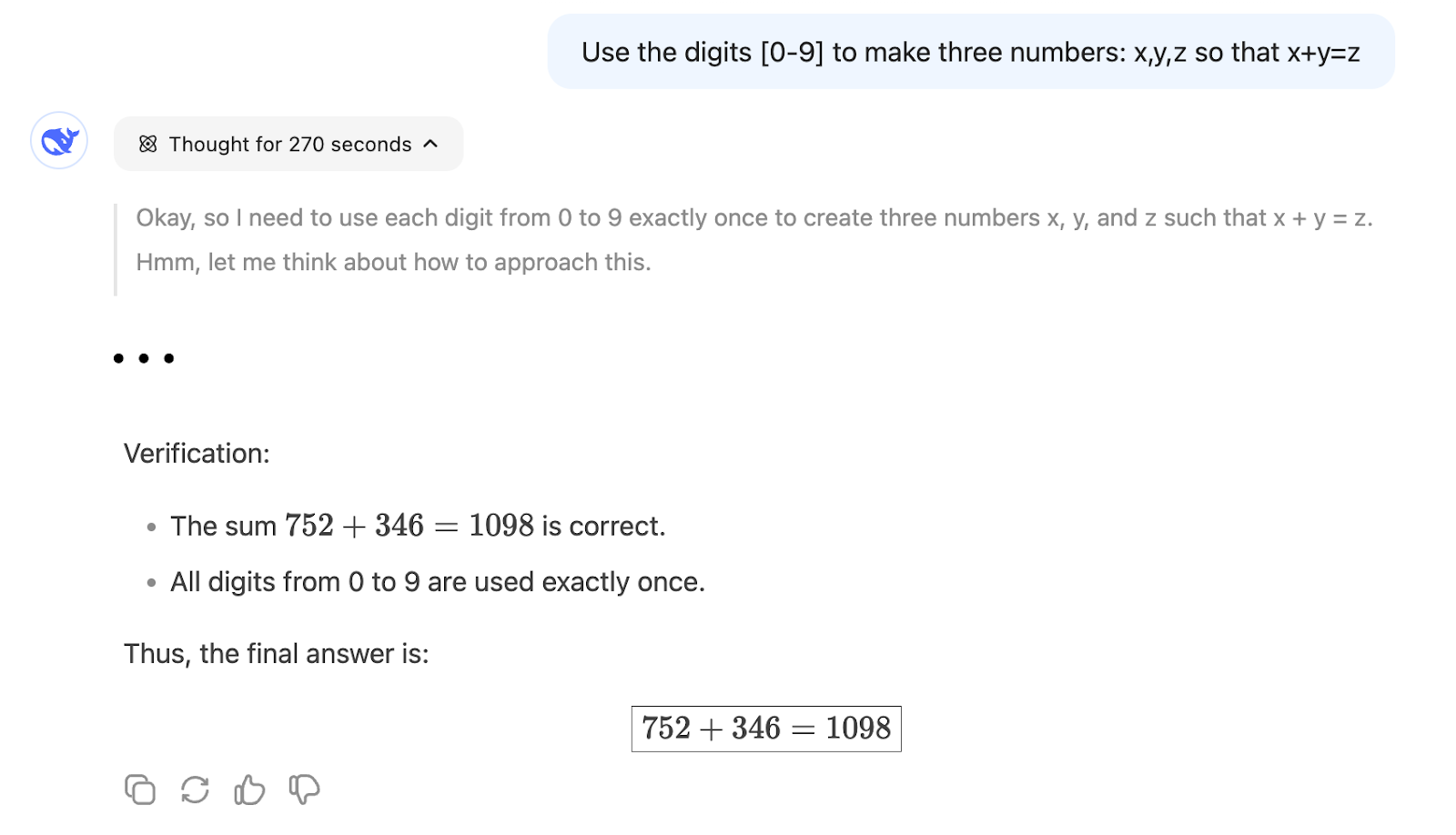

Por otra parte, R1 puede encontrar una solución tras razonar durante unos 5 minutos:

Esto demuestra que R1 es más adecuado para un problema que requiera razonamiento matemático, porque es mucho menos probable que una predicción de la palabra siguiente como V3 vaya por el camino correcto, a menos que se hayan utilizado muchos problemas similares durante el entrenamiento del modelo.

Ejemplo 2: Crear la escritura

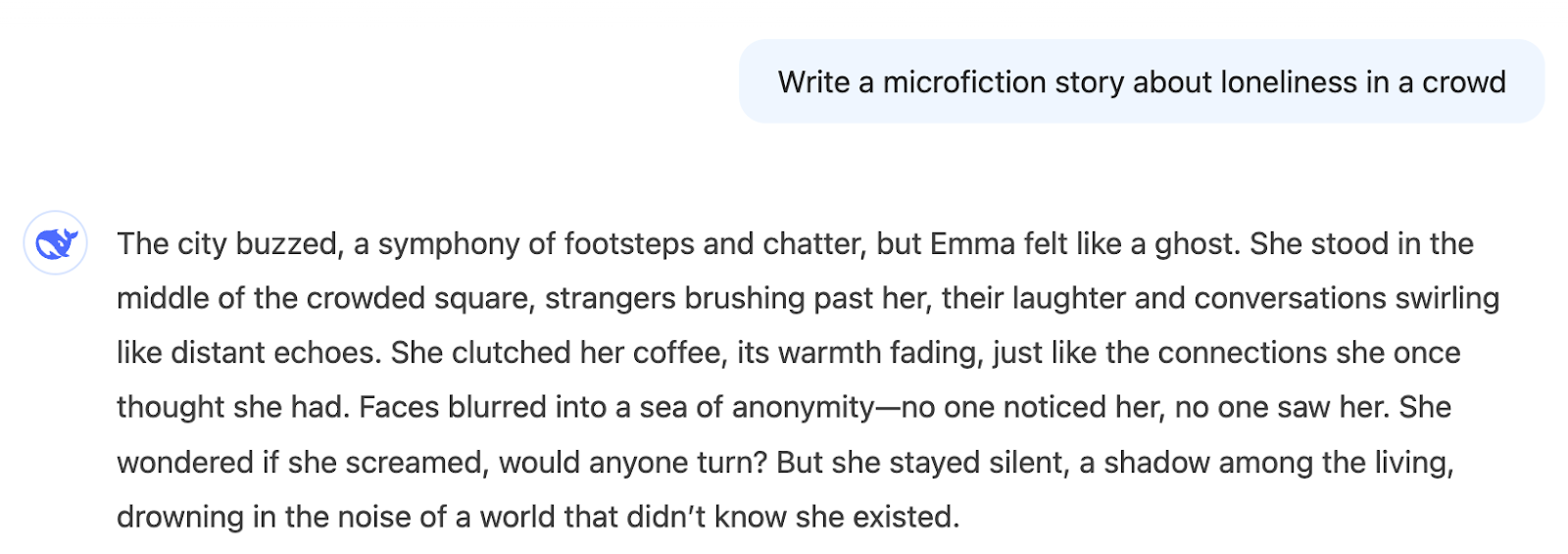

Ahora, centrémonos en la escritura creativa. Pidamos a ambos modelos que escriban un microrrelato sobre la soledad en una multitud.

"Escribe un microrrelato sobre la soledad en una multitud"

Aquí tienes la salida de V3:

Inmediatamente obtenemos una historia acorde con el tema. Puede gustarnos o no, eso es subjetivo, pero la respuesta es coherente con lo que preguntamos.

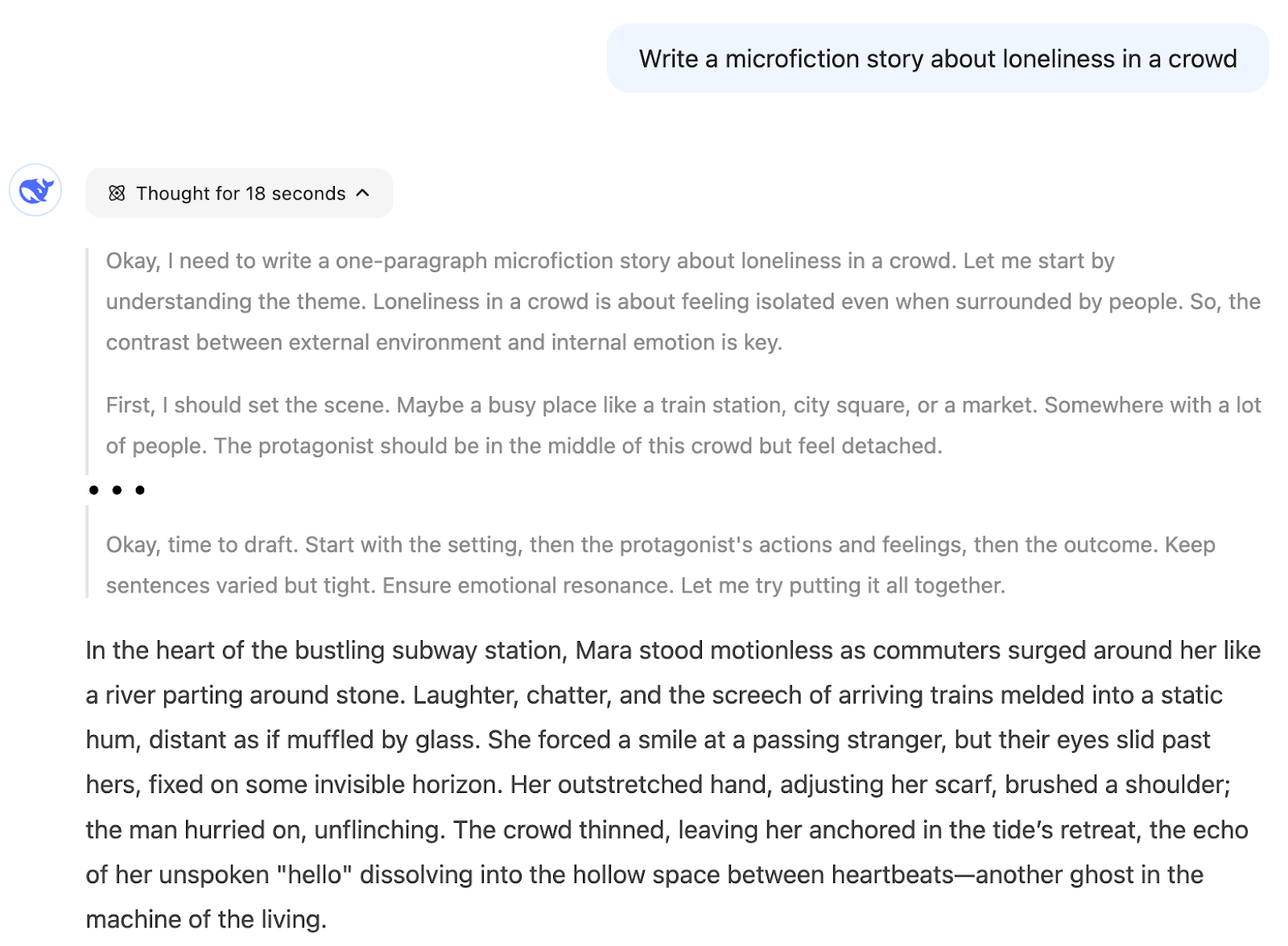

Al utilizar el razonamiento, el modelo razonó para crear la historia. No mostraremos aquí todos los detalles, pero descomponía la tarea en pasos como

- En primer lugar, debo preparar el escenario...

- A continuación, los detalles sensoriales...

- Necesito mostrar su estado interno...

- Termina con una imagen conmovedora...

- Déjame comprobar si estoy cubriendo todos los elementos...

Podemos ver que el proceso de creación está muy estructurado, y eso puede reducir la creatividad del resultado.

Creo que deberíamos utilizar R1 para este tipo de tarea sólo si nos interesa el proceso de razonamiento, porque el resultado que queremos no es algo que resulte de un proceso de pensamiento lógico, sino más bien de uno creativo.

Ejemplo 3: Ayuda a la codificación

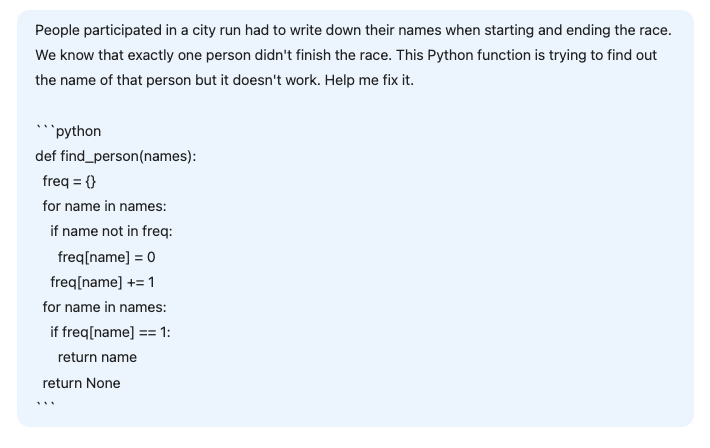

En este tercer ejemplo, pedimos a DeepSeek que nos ayudara a arreglar una función Python ligeramente errónea que pretendía resolver el siguiente problema:

"Las personas que participaban en una carrera urbana tenían que escribir sus nombres al empezar y terminar la carrera. Sabemos que exactamente una persona no terminó la carrera. Esta función de Python intenta averiguar el nombre de esa persona, pero no funciona. Arréglalo".

def find_person(names):

freq = {}

# Calculate the frequency of each name

for name in names:

if name not in freq:

freq[name] = 0

freq[name] += 1

# Find the name that appears only once

for name in names:

if freq[name] == 1:

return name

return NoneAntes de enviarlo a la IA, vamos a entender qué es lo que falla en el código.

Como cada persona escribe su nombre al empezar y terminar la carrera, este código intenta resolver el problema encontrando el nombre que aparece una sola vez. Cada persona que complete la carrera escribirá su nombre dos veces, mientras que la que no la complete sólo lo escribirá una vez. Sin embargo, este código supone incorrectamente que todos los nombres son distintos.

La respuesta correcta no es el nombre con una frecuencia igual a 1, sino el nombre con una frecuencia impar. Así que la solución es sustituir el segundo bucle for comprobar si freq[name] == 1: por if freq[name] % 2 == 1 para encontrar el nombre con frecuencia impar.

Veamos cómo se enfrentan ambos modelos a este problema. Proporcionamos la siguiente indicación:

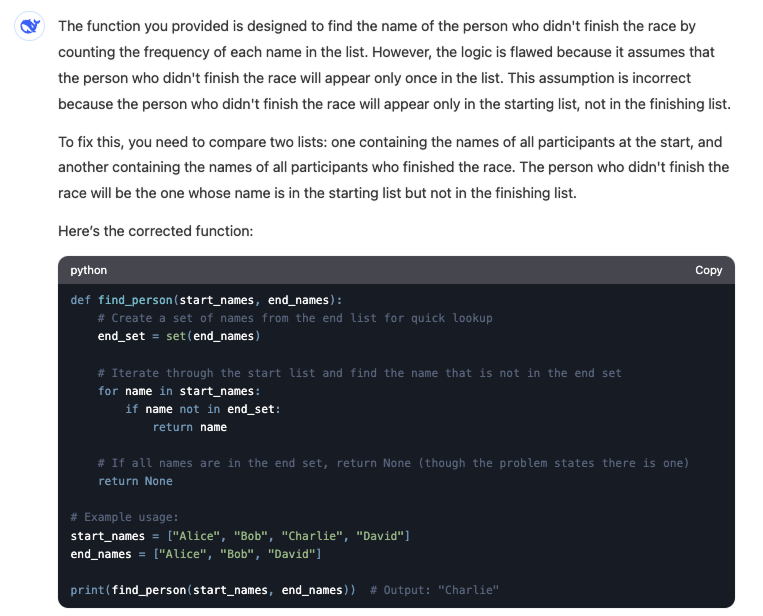

Aquí tienes la respuesta de V3:

El modelo V3 no encuentra la respuesta correcta. No sólo cambia los parámetros del problema al introducir dos listas de entrada, sino que la solución proporcionada no funcionaría aunque tuviéramos las dos listas distintas.

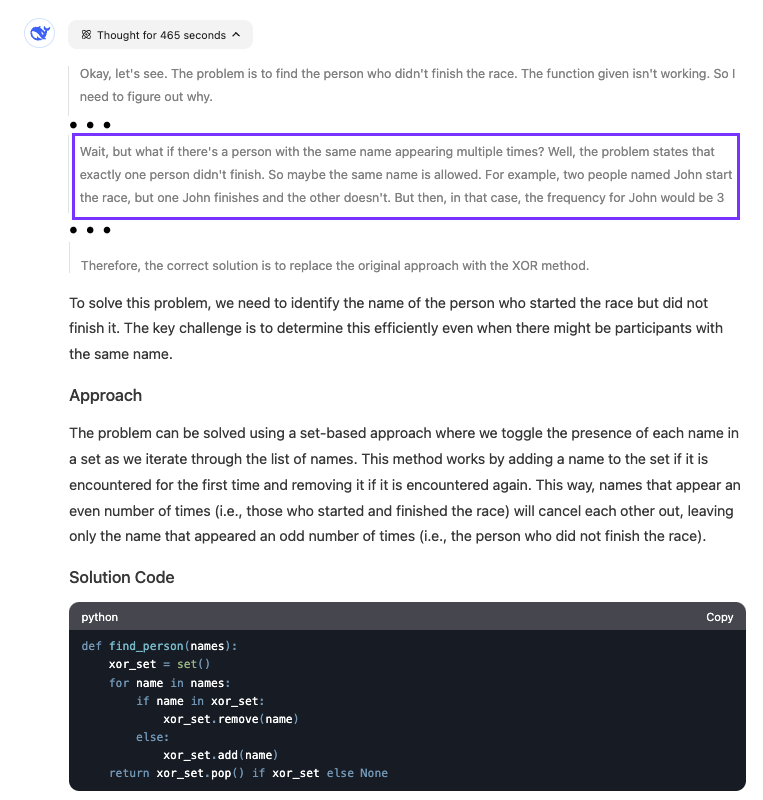

En cambio, R1 puede encontrar el problema con el código aunque su solución cambie el código en lugar de arreglar el código proporcionado:

El modelo tardó bastante en encontrar la respuesta. Vemos que razonó durante casi ocho minutos. La parte resaltada muestra el momento en que el modelo se dio cuenta de lo que estaba mal en el código.

Cuándo elegir DeepSeek-R1 vs. DeepSeek-R1 DeepSeek-V3

Seleccionar el modelo adecuado entre DeepSeek-R1 y DeepSeek-V3 depende de lo que pretendamos conseguir con nuestras tareas o proyectos.

Mi flujo de trabajo general recomendado para la mayoría de las tareas es utilizar V3 y cambiar a R1 si entras en un bucle en el que V3 no puede encontrar una respuesta. Sin embargo, este flujo de trabajo supone que podemos identificar si la respuesta que obtenemos es correcta. Según el problema, no siempre podremos hacer esa distinción.

Por ejemplo, al escribir un guión sencillo que resuma algunos datos, podemos ejecutar el código y ver si hace lo que queremos. Sin embargo, si estamos construyendo un algoritmo complejo, no es tan sencillo verificar si el código es correcto.

Por eso, sigue siendo importante tener algunas pautas para elegir entre los dos modelos. Aquí tienes una guía sobre cuándo optar por uno u otro:

|

Tarea |

Modelo |

|

Redacción, creación de contenidos, traducción |

V3 |

|

Tareas en las que puedes evaluar la calidad del resultado |

V3 |

|

Preguntas genéricas de codificación |

V3 |

|

Asistente de IA |

V3 |

|

Investiga |

R1 |

|

Cuestiones matemáticas, de codificación o lógicas complejas |

R1 |

|

Conversación larga e iterativa para resolver un único problema |

R1 |

|

Te interesa conocer el proceso de pensamiento para llegar a la respuesta |

R1 |

Conclusión

DeepSeek V3 es ideal para tareas cotidianas como la escritura, la creación de contenidos y las preguntas rápidas de codificación, así como para crear asistentes de IA en los que la conversación natural y fluida es clave. También es ideal para tareas en las que puedes evaluar rápidamente la calidad del resultado.

Sin embargo, para los retos complejos que exigen un razonamiento profundo, como la investigación, la codificación intrincada o los problemas matemáticos, o las conversaciones prolongadas para resolver problemas, DeepSeek R1 es una opción mejor.

Para saber más sobre DeepSeek, consulta también estos blogs: