Kurs

Man schätzt, dass es ungefähr 328,77 Millionen Terabyte an Daten erzeugt werden. Jeder Klick und jeder Kauf erzeugt Daten, die mit den richtigen Tools zu aussagekräftigen Erkenntnissen und Prognosen verarbeitet werden können.

Wir brauchen aber eine leistungsstarke Bibliothek, um diese Datenmenge zu verarbeiten. Hier kommt„ “ PySpark ins Spiel.

In diesem Leitfaden schauen wir uns an, wie du PySpark von Grund auf lernen kannst. Ich helfe dir dabei, einen Lernplan zu erstellen, gebe dir meine besten Tipps für effektives Lernen und stelle dir nützliche Ressourcen zur Verfügung, mit denen du Stellen finden kannst, für die PySpark erforderlich ist.

PySpark von Grund auf lernen

Was ist PySpark?

PySpark ist die Kombination aus zwei starken Technologien: Python und Apache Spark.

Python ist eine der beliebtesten Programmiersprachen in der Softwareentwicklung, vor allem für Data Science und maschinelles Lernen, weil sie einfach zu benutzen ist und eine klare Syntax hat.

Apache Spark ist dagegen ein Framework, das große Mengen unstrukturierter Daten verarbeiten kann. Spark wurde mit Scala entwickelt, einer Sprache, die uns mehr Kontrolle darüber gibt. Scala ist bei Datenfachleuten aber nicht so beliebt. Also wurde PySpark entwickelt, um diese Lücke zu schließen.

PySpark hat eine API und eine einfache Benutzeroberfläche, um mit Spark zu arbeiten. Es nutzt die Einfachheit und Flexibilität von Python, um die Verarbeitung von Big Data für mehr Leute zugänglich zu machen.

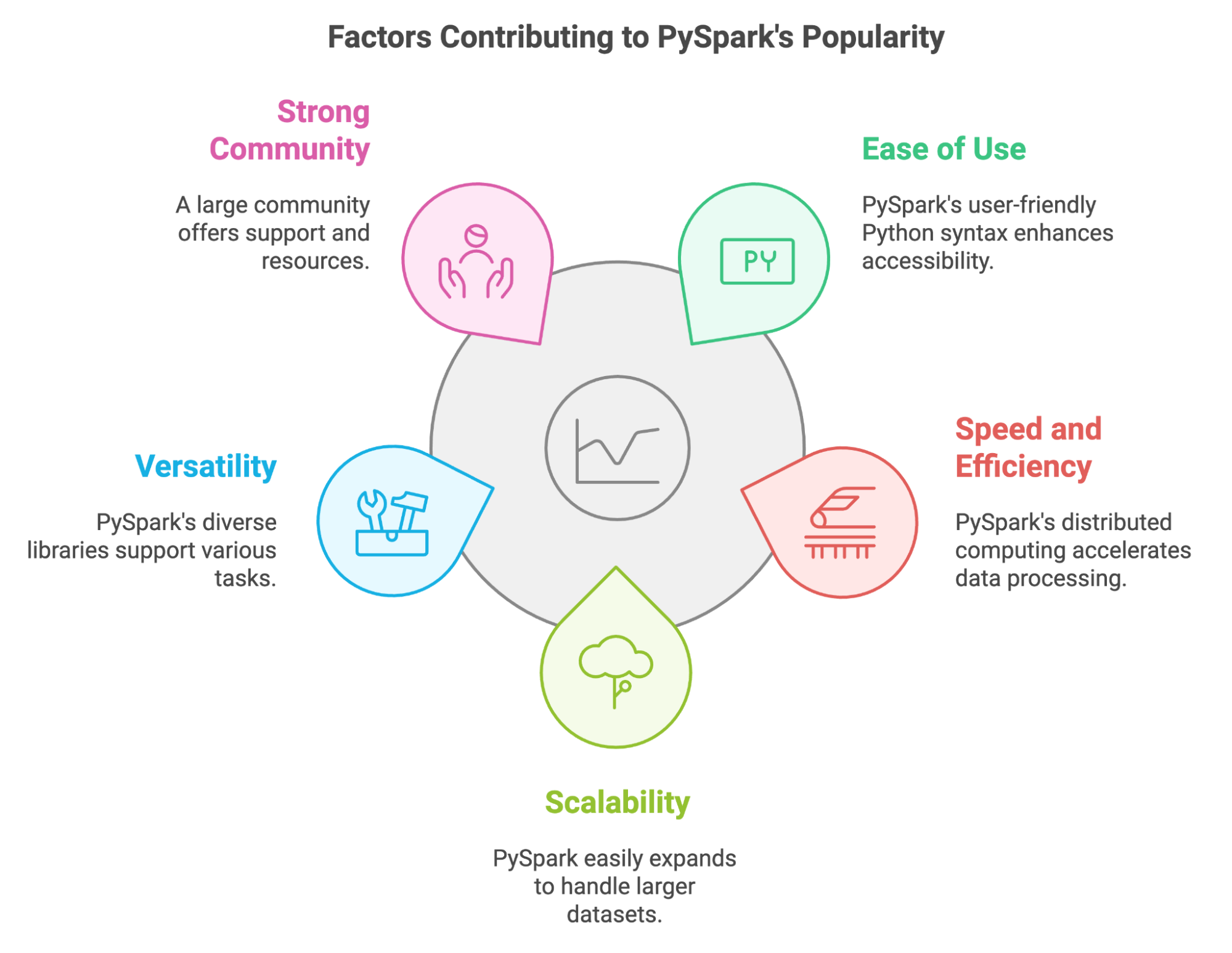

Was macht PySpark so beliebt?

In den letzten Jahren hat sich PySpark zu einem wichtigen Tool für Leute entwickelt, die mit riesigen Datenmengen arbeiten müssen. Wir können seine Beliebtheit mit ein paar wichtigen Sachen erklären:

- Einfach zu benutzen: PySpark nutzt die bekannte Python-Syntax, was es für Datenprofis wie uns einfacher macht.

- Schnelligkeit und Effizienz: Durch die Verteilung von Berechnungen auf mehrere Maschinen-Cluster kann PySpark riesige Datensätze super schnell verarbeiten.

- Skalierbarkeit: PySpark passt sich an wachsende Datenmengen an, sodass wir unsere Anwendungen durch Hinzufügen weiterer Rechenressourcen skalieren können.

- Vielseitigkeit: Es bietet ein breites Spektrum an Bibliotheken für verschiedene Aufgaben, von der Datenbearbeitung bis zum maschinellen Lernen.

- Starke Gemeinschaft: Wir können uns auf eine große und aktive Community verlassen, die uns bei Problemen und Herausforderungen mit Unterstützung und Ressourcen zur Seite steht.

Mit PySpark können wir auch unsere vorhandenen Python-Kenntnisse und -Bibliotheken nutzen. Wir können es ganz einfach mit beliebten Tools wie Pandas und Scikit-learn, und es lässt uns verschiedene Datenquellen nutzen.

Die wichtigsten Features von PySpark

PySpark wurde extra für Big-Data- und Machine-Learning-Entwicklungen entwickelt worden. Aber welche Funktionen machen es zu einem starken Tool für die Bearbeitung riesiger Datenmengen? Schauen wir sie uns mal an:

- Resiliente verteilte Datensätze (RDDs): Das sind die grundlegenden Datenstrukturen, die hinter PySpark stehen. Dank ihnenkönnen Datenumwandlung, Filterung und Aggregation parallel durchgeführt werden.

- DataFrame und SQL: In PySpark sind DataFrames eine höhere Abstraktionsebene, die auf RDDs basiert. Wir können sie mit Spark SQL und Abfragen nutzen, um Datenbearbeitung und Analyse durchzuführen.

- Bibliotheken für maschinelles Lernen: Mit PySpark's MLlib können wir skalierbare Machine-Learning-Modelle für Aufgaben wie Klassifizierung und Regression erstellen und nutzen.

- Unterstützt verschiedene Datenformate: PySpark hat Bibliotheken und APIs, um Daten in verschiedenen Formaten wie CSV, JSON, Parquet und Avro zu lesen, zu schreiben und zu bearbeiten.

- Fehlertoleranz: PySpark behält den Überblick über jedes RDD. Wenn ein Knoten während der Ausführung abstürzt, baut PySpark die verlorene RDD-Partition mit diesen Tracking-Infos wieder auf. Also, das Risiko von Datenverlusten ist gering.

- In-Memory-Verarbeitung: PySpark speichert Zwischendaten im Speicher, was die Notwendigkeit von Festplattenoperationen reduziert und dadurch die Datenverarbeitungsleistung verbessert.

- Streaming und Echtzeitverarbeitung: Wir können die Spark Streaming-Komponente nutzen, um Echtzeit-Datenströme zu verarbeiten und Analysen nahezu in Echtzeit durchzuführen.

Warum ist es so nützlich, PySpark zu lernen?

Die Datenmenge wird immer größer. Heutzutage geht's bei Datenverarbeitung, Datenanalyse und maschinellem Lernen darum, mit riesigen Datenmengen zu arbeiten. Wir brauchen starke Tools, die diese Daten schnell und effizient verarbeiten. PySpark ist eins dieser Tools.

PySpark hat viele verschiedene Anwendungsmöglichkeiten.

Wir haben schon die Vorteile von PySpark angesprochen, aber schauen wir uns mal ein paar konkrete Beispiele an, wo du sie nutzen kannst:

- Data ETL. Die PySpark-Funktion für effiziente Datenbereinigung und -umwandlung wird für die Verarbeitung von Sensordaten und Produktionsprotokollen in der Fertigung und Logistik genutzt.

- Maschinelles Lernen. Die MLlib-Bibliothek wird benutzt, um Modelle für personalisierte Empfehlungen, Kundensegmentierung und Umsatzprognosen im E-Commerce zu entwickeln und einzusetzen.

- Grafikverarbeitung. PySpark's GraphFrames werden benutzt, um soziale Netzwerke zu analysieren und die Beziehungen zwischen Nutzern zu verstehen.

- Stream-Verarbeitung. Die Structured Streaming API von PySpark macht es möglich, Finanztransaktionen in Echtzeit zu checken, um Betrug zu erkennen.

- SQL-Datenverarbeitung. Die SQL-Schnittstelle von PySpark macht es Forschern und Analysten im Gesundheitswesen einfacher, große Genomdatensätze abzufragen und zu analysieren.

Es gibt eine Nachfrage nach Fähigkeiten in PySpark.

Mit dem Aufkommen von Datenwissenschaft und maschinellem Lernen und der Zunahme verfügbarer Daten gibt's eine hohe Nachfrage nach Fachleuten mit Datenbearbeitung. Laut dem Bericht „The State of Data & AI Literacy Report 2024”schätzen 80 % der Führungskräfte Fähigkeiten in der Datenanalyse und -bearbeitung.

Das Lernen von PySpark kann dir viele neue Jobchancen bringen. Über 800 Stellenangebote auf Indeed, von Dateningenieuren bis hin zu Datenwissenschaftlern, zeigen, wie gefragt PySpark-Kenntnisse in der Datenbranche sind. Stellenangeboten im Datenbereich.

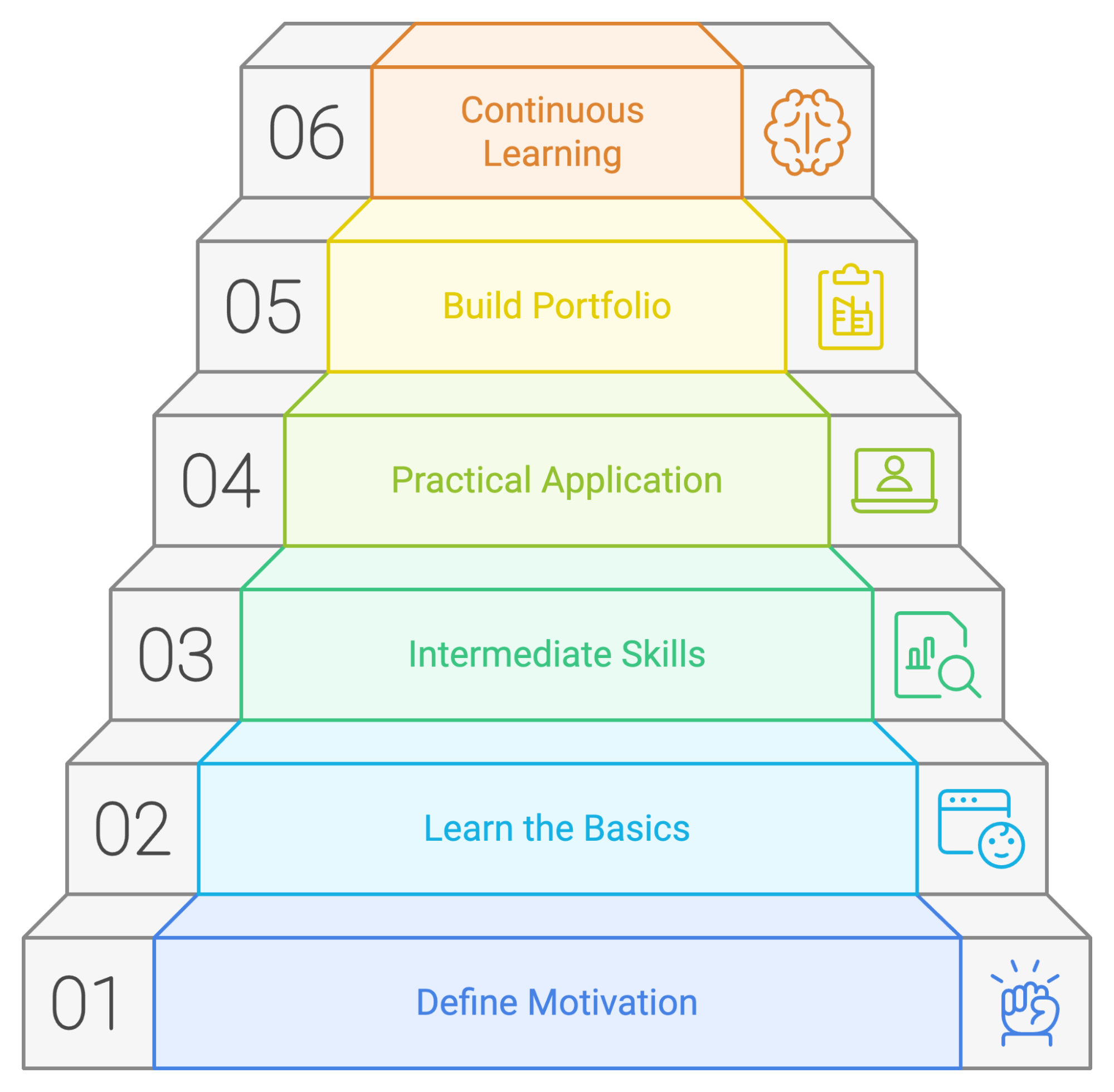

Wie man PySpark 2026 von Grund auf lernt

Wenn du PySpark systematisch lernst, hast du bessere Chancen auf Erfolg. Schauen wir uns ein paar Prinzipien an, die du auf deinem Lernweg nutzen kannst.

1. Verstehe, warum du PySpark lernst

Bevor du dich mit den technischen Details beschäftigst, überleg dir, warum du PySpark lernen willst. Frag dich mal:

- Was sind meine Karriereziele?

- Brauchst du PySpark, um in deinem jetzigen Job weiterzukommen oder deinen Traumjob zu kriegen?

- Welche Möglichkeiten eröffnen sich dir, wenn du PySpark beherrschst?

- Welche Probleme versuche ich zu lösen?

- Hast du Probleme mit der Verarbeitung großer Datensätze, die mit den dir bekannten Tools nicht zu bewältigen sind?

- Muss man komplexe Datentransformationen durchführen oder fortgeschrittene Machine-Learning-Modelle erstellen?

- Was interessiert mich?

- Findest du die Idee, skalierbare Datenpipelines aufzubauen, spannend?

- Interessierst du dich für Big Data und wie man damit neue Erkenntnisse gewinnen kann?

- Habe ich ein bestimmtes Projekt im Kopf, für das ich die Funktionen von PySpark brauche?

- Arbeitest du gerade an einem persönlichen Projekt, bei dem es um die Verarbeitung oder Analyse großer Datenmengen geht?

- Braucht dein Unternehmen für ein bevorstehendes Projekt PySpark-Know-how?

2. Fang mit den Grundlagen von PySpark an

Nachdem du deine Ziele festgelegt hast, lerne die Grundlagen von PySpark und wie sie funktionieren.

Python-Grundlagen

Da PySpark auf Python basiert, solltest du dich erst mal mit Python auskennen, bevor du PySpark benutzt. Du solltest dich mit Variablen und Funktionen gut auskennen. Außerdem könnte es hilfreich sein, sich mit Bibliotheken zur Datenbearbeitung wie Pandas auszukennen. DataCamps Einführungskurs in Python und Datenbearbeitung mit Pandas können dir helfen, dich schnell einzuarbeiten.

PySpark installieren und die Grundlagen lernen

Du musst PySpark installieren, um es nutzen zu können. Du kannst PySpark mit pip oder Conda runterladen, es manuell von der offiziellen Website holen oder mit DataLab an, um PySpark in deinem Browser auszuprobieren.

Wenn du eine ausführliche Erklärung zur Einrichtung von PySpark brauchst, schau dir diese Anleitung zur die Installation von PySpark unter Windows, Mac und Linux.

PySpark-DataFrames

Das erste Konzept, das du lernen solltest, ist, wie PySpark DataFrames funktionieren. Sie sind einer der Hauptgründe, warum PySpark so schnell und effizient läuft. Lerne, wie du sie erstellen, umwandeln (zuordnen und filtern) und bearbeiten kannst. Das Tutorial zum Thema die ersten Schritte mit PySpark hilft dir bei diesen Konzepten.

3. PySpark-Kenntnisse auf mittlerem Niveau meistern

Sobald du mit den Grundlagen vertraut bist, kannst du dich mit den fortgeschrittenen PySpark-Fähigkeiten beschäftigen.

Spark SQL

Einer der größten Vorteile von PySpark ist, dass man damit SQL-ähnliche Abfragen machen kann, um DataFrame zu lesen und zu bearbeiten, Aggregationen durchzuführen und Fensterfunktionen zu nutzen. Hinter den Kulissen nutzt PySpark Spark SQL. Das ist Einführung in Spark SQL in Python kann dir dabei helfen, diese Fähigkeit zu erlernen.

Datenaufbereitung und -umwandlung

Mit Daten zu arbeiten heißt, dass man sie richtig bereinigen, umwandeln und für die Analyse vorbereiten kann. Dazu gehört, mit fehlenden Werten umzugehen, verschiedene Datentypen zu verwalten und Aggregationen mit PySpark durchzuführen. Mach den Kurs „Datenbereinigung mit PySpark” von DataCamp, um praktische Erfahrungen zu sammeln und diese Fähigkeiten zu meistern.

Maschinelles Lernen mit MLlib

PySpark kann dank seiner MLlib-Bibliothek auch zum Entwickeln und Bereitstellen von Machine-Learning-Modellen genutzt werden. Du solltest lernen, wie man mit dieser Bibliothek Feature Engineering, Modellbewertung und Hyperparameter-Tuning macht. DataCamps Kurs „Machine Learning mit PySpark” bietet eine umfassende Einführung.

4. Lerne PySpark durch Ausprobieren

Kurse zu besuchen und Übungen mit PySpark zu machen, ist echt eine super Möglichkeit, um sich mit der Technologie vertraut zu machen. Um PySpark richtig gut zu beherrschen, musst du aber knifflige Probleme lösen, die deine Fähigkeiten fördern, so wie du sie auch in echten Projekten findest. Du kannst mit einfachen Datenanalyseaufgaben anfangen und dich dann nach und nach an komplexere Herausforderungen ranwagen.

Hier sind ein paar Möglichkeiten, deine Fähigkeiten zu trainieren:

- Mach bei Webinaren und Code-Alongs mit. Schau mal nach den kommende DataCamp-Webinare und Online-Events, bei denen du PySpark-Tutorials und Code-Beispiele mitverfolgen kannst. Das hilft dir, dein Verständnis der Konzepte zu vertiefen und dich mit Codierungsmustern vertraut zu machen.

- Mach eigene Projekte. Such dir Datensätze aus, die dich interessieren, und nutze deine PySpark-Kenntnisse, um sie zu analysieren. Das kann alles Mögliche sein, von der Analyse von Social-Media-Trends bis hin zur Untersuchung von Finanzmarktdaten.

- Mach bei Open-Source-Projekten mit. Mach bei PySpark-Projekten auf Plattformen wie GitHub mit, um Erfahrungen in der Zusammenarbeit mit anderen und in der Arbeit an echten Projekten zu sammeln.

- Mach dir einen persönlichen Blog. Schreib über deine PySpark-Projekte, teil deine Erkenntnisse und mach mit bei der PySpark-Community, indem du einen eigenen Blog startest.

5. Ein Projektportfolio aufbauen

Während du dich weiter durch deine PySpark-Lernreise bewegst, wirst du verschiedene Projekte abschließen. Um potenziellen Arbeitgebern deine PySpark-Kenntnisse und -Erfahrungen zu zeigen, solltest du sie in einem Portfolio zusammenfassen. Dieses Portfolio sollte deine Fähigkeiten und Interessen zeigen und auf den Job oder die Branche zugeschnitten sein, die dich interessieren.

Mach deine Projekte originell und zeig, wie gut du Probleme lösen kannst. Zeig Projekte, die zeigen, wie gut du dich mit verschiedenen Aspekten von PySpark auskennst, wie zum Beispiel Datenaufbereitung, maschinelles Lernen und Datenvisualisierung. Dokumentiere deine Projekte und gib dabei den Kontext, die Methodik, den Code und die Ergebnisse an. Du kannst DataLabverwenden, eine Online-IDE, mit der du Code schreiben, Daten gemeinsam analysieren und deine Erkenntnisse teilen kannst.

Hier sind zwei PySpark-Projekte, an denen du arbeiten kannst:

6. Fordere dich selbst immer wieder heraus

PySpark zu lernen ist ein ständiger Prozess. Die Technik entwickelt sich ständig weiter, und es kommen immer wieder neue Funktionen und Anwendungen dazu. PySpark ist da keine Ausnahme.

Sobald du die Grundlagen drauf hast, kannst du dich an anspruchsvollere Aufgaben und Projekte wie Performance-Optimierung oder GraphX wagen. Konzentrier dich auf deine Ziele und spezialisier dich auf Bereiche, die für deine Karrierepläne und Interessen wichtig sind.

Bleib auf dem Laufenden über die neuesten Entwicklungen und lerne, wie du sie in deinen aktuellen Projekten anwenden kannst. Mach weiter so, such dir neue Herausforderungen und Chancen und sieh Fehler als Chance, um was Neues zu lernen.

Lass uns mal zusammenfassen, was wir für einen erfolgreichen PySpark-Lernplan machen können:

Ein Beispiel für einen PySpark-Lernplan

Auch wenn jeder Mensch seine eigene Art zu lernen hat, ist es immer gut, einen Plan oder Leitfaden zu haben, an dem man sich beim Erlernen eines neuen Tools orientieren kann. Wir haben einen möglichen Lernplan erstellt, der zeigt, worauf du dich konzentrieren solltest, wenn du gerade erst mit PySpark anfängst.

Monat 1: PySpark-Grundlagen

- Kernkonzepte. Installier PySpark und schau dir die Syntax an. Lerne die wichtigsten Konzepte von Apache Spark, seine Architektur und wie es die verteilte Datenverarbeitung ermöglicht.

- PySpark-Grundlagen. Lerne, wie du deine PySpark-Umgebung einrichtest, SparkContexts und SparkSessions erstellst und grundlegende Datenstrukturen wie RDDs und DataFrame erkundest.

- Datenbearbeitung. Lerne die wichtigsten PySpark-Operationen für die Datenbearbeitung, wie Filtern, Sortieren, Gruppieren, Aggregieren und Verknüpfen von Datensätzen. Du kannst die Cleaning Orders mit PySpark.

Monat 2: PySpark für Datenanalyse und SQL

- Arbeiten mit verschiedenen Datenformaten: Lerne, wie du mit PySpark Daten in verschiedenen Formaten wie CSV, JSON, Parquet und Avro lesen und schreiben kannst.

- Spark SQL. Lerne, wie man Spark SQL zum Abfragen und Analysieren von Daten mit der bekannten SQL-Syntax zu nutzen. Lerne Konzepte wie DataFrame, Datensätze und SQL-Funktionen kennen.

- Datenvisualisierung und Feature Engineering: Entdecke Techniken zur Datenvisualisierung in PySpark mit Bibliotheken wie Matplotlib und Seaborn, um aus deinen Daten Erkenntnisse zu gewinnen. Lerne, wie du Daten bearbeitest und Feature Engineering machst, indem du den Kurs Feature Engineering mit PySpark.

Monat 3–4: PySpark für maschinelles Lernen und fortgeschrittene Themen

- Einführung in MLlib: Leg los mit der MLlib-Bibliothek von PySpark für maschinelles Lernen. Lerne grundlegende Algorithmen für Klassifizierung, Regression und Clustering kennen. Du kannst das Kurs „Machine Learning mit PySpark”.

- ML-Pipelines aufbauen. Lerne, wie du Machine-Learning-Pipelines in PySpark aufbaust und einsetzt, um Modelle effizient zu trainieren und zu bewerten.

- Mach ein Projekt. Arbeiten an der Entwicklung eines Nachfrageprognosemodell.

- Fortgeschrittene Konzepte. Lerne Techniken zur Optimierung von PySpark-Anwendungen kennen, darunter Datenpartitionierung, Caching und Leistungsoptimierung.

Fünf Tipps zum Lernen von PySpark

Ich denke, du bist jetzt bereit, dich mit PySpark zu beschäftigen und dich mit einem großen Datensatz zu beschäftigen, um deine neuen Fähigkeiten auszuprobieren. Bevor du das machst, lass mich dir noch ein paar Tipps geben, die dir helfen werden, den Weg zur PySpark-Kompetenz zu meistern.

1. Schränk deinen Fokus ein

PySpark ist ein Tool, das man für viele verschiedene Sachen nutzen kann. Um fokussiert zu bleiben und dein Ziel zu erreichen, solltest du herausfinden, was dich wirklich interessiert. Willst du dich auf Datenanalyse, Datenverarbeitung oder maschinelles Lernen konzentrieren? Wenn du dich auf das Wesentliche konzentrierst, kannst du die wichtigsten Aspekte und Kenntnisse von PySpark für deinen gewählten Weg besser verstehen.

2. Übe oft und regelmäßig

Um eine neue Fähigkeit richtig zu lernen, ist es wichtig, dranzubleiben. Du solltest dir Zeit nehmen, um PySpark zu üben. Ein bisschen Zeit jeden Tag reicht schon. Du musst dich nicht jeden Tag mit komplizierten Sachen rumschlagen. Du kannst das Gelernte wiederholen oder eine einfache Übung noch mal machen, um sie zu überarbeiten. Regelmäßiges Üben hilft dir, Konzepte besser zu verstehen und macht dich sicherer bei ihrer Anwendung.

3. Arbeite an echten Projekten

Das ist einer der wichtigsten Tipps, und du wirst ihn in diesem Leitfaden mehrmals lesen. Übungen zu machen ist super, um Selbstvertrauen zu gewinnen. Aber erst wenn du deine PySpark-Kenntnisse in echten Projekten anwendest, wirst du richtig gut darin. Such dir Datensätze, die dich interessieren, und nutze PySpark, um sie zu analysieren, Erkenntnisse zu gewinnen und Probleme zu lösen.

Fang mit einfachen Projekten und Fragen an und mach dich dann nach und nach an komplexere Sachen ran. Das kann so einfach sein wie das Lesen und Bereinigen eines echten Datensatzes und das Schreiben einer komplexen Abfrage, um Aggregationen durchzuführen und den Preis eines Hauses vorherzusagen.

4. Mach mit in einer Community

Gemeinsam lernt man oft besser. Wenn du deine Erfahrungen teilst und von anderen lernst, kannst du schneller vorankommen und wertvolle Einblicke gewinnen.

Um Wissen, Ideen und Fragen auszutauschen, kannst du Gruppen beitreten, die sich mit PySpark beschäftigen, und an Treffen und Konferenzen teilnehmen. Die Databricks-Community, die Firma, die von den Machern von Spark gegründet wurde, hat ein aktives Community-Forum, wo du dich an Diskussionen beteiligen und Fragen zu PySpark stellen kannst. Außerdem ist der Spark Summit, den Databricks organisiert, die größte Spark-Konferenz.

5. Mach Fehler

Wie bei jeder anderen Technologie ist auch das Lernen von PySpark ein schrittweiser Prozess. Und aus Fehlern zu lernen ist ein wichtiger Teil des Lernprozesses. Hab keine Angst davor, zu experimentieren, verschiedene Ansätze auszuprobieren und aus deinen Fehlern zu lernen. Probier verschiedene Funktionen und Alternativen zum Aggregieren der Daten aus, mach Unterabfragen oder verschachtelte Abfragen und schau dir die schnelle Antwort von PySpark an.

Die besten Methoden, um PySpark zu lernen

Schauen wir uns mal ein paar coole Methoden an, um PySpark zu lernen.

Mach Online-Kurse

Online-Kurse sind super, um PySpark in deinem eigenen Tempo zu lernen. DataCamp hat PySpark-Kurse für alle Niveaus, die zusammen das Big Data mit PySpark Lernpfad. Die Kurse behandeln einführende Konzepte zu Themen des maschinellen Lernens und sind mit praktischen Übungen ausgestattet.

Hier sind ein paar der PySpark-Kurse auf DataCamp:

- Feature Engineering mit PySpark

- Maschinelles Lernen mit PySpark

- Empfehlungsmaschinen mit PySpark erstellen

- Grundlagen von Big Data mit PySpark

Mach die Online-Tutorials

Tutorials sind auch super, um PySpark zu lernen, vor allem wenn du noch keine Erfahrung mit der Technologie hast. Sie haben Schritt-für-Schritt-Anleitungen, wie man bestimmte Aufgaben macht oder bestimmte Konzepte versteht. Schau dir mal diese Tutorials an:

Schau dir die PySpark-Spickzettel an

Spickzettel sind echt praktisch, wenn du schnell was zu PySpark-Themen nachschlagen willst. Hier sind zwei hilfreiche Spickzettel:

Fertige PySpark-Projekte

PySpark zu lernen braucht einfach praktische Übung. Du stellst dich Herausforderungen bei der Umsetzung von Projekten, bei denen du all deine erworbenen Fähigkeiten anwenden kannst. Wenn du anfängst, dich mit komplexeren Aufgaben zu beschäftigen, musst du Lösungen finden und neue Alternativen ausprobieren, um die gewünschten Ergebnisse zu erzielen und deine PySpark-Kenntnisse zu verbessern.

Schau mal bei DataCamp nach PySpark-Projekten, an denen du arbeiten kannst. Damit kannst du deine Fähigkeiten in der Datenbearbeitung und beim Erstellen von Machine-Learning-Modellen mit PySpark anwenden:

Lerne PySpark mit Büchern kennen

Bücher sind echt super, um PySpark zu lernen. Sie bieten fundiertes Wissen und Einblicke von Experten sowie Code-Schnipsel und Erklärungen. Hier sind ein paar der beliebtesten Bücher über PySpark:

- PySpark lernen, 2. Auflage, Jules S. Damji

- PySpark-Kochbuch, Denny Lee

- Der Funke für Python-Entwickler

Karriere bei PySpark

Die Nachfrage nach PySpark-Kenntnissen ist in vielen datenbezogenen Jobs gestiegen, von Datenanalysten bis hin zu Big-Data-Ingenieuren. Wenn du dich auf ein Vorstellungsgespräch vorbereitest, solltest du diese PySpark-Interviewfragen berücksichtigen:

Big-Data-Ingenieur

Als Big-Data-Ingenieur bist du der Architekt von Big-Data-Lösungen und dafür zuständig, die Infrastruktur zu entwerfen, aufzubauen und zu warten, die große Datensätze verarbeitet. Du wirst PySpark nutzen, um skalierbare Datenpipelines zu erstellen, die eine effiziente Datenerfassung, -verarbeitung und -speicherung sicherstellen.

Du brauchst ein gutes Verständnis von verteilten Rechensystemen und Cloud-Plattformen sowie Fachwissen in den Bereichen Data Warehousing und ETL-Prozesse.

- Wichtige Fähigkeiten:

- Gute Kenntnisse in Python und PySpark, Java und Scala

- Verständnis von Datenstrukturen und Algorithmen

- Gute Kenntnisse in SQL und nosql

- Know-how in ETL-Prozessen und beim Aufbau von Datenpipelines

- Verständnis von verteilten Systemen

- Wichtige Tools, die benutzt werden:

- Apache Spark, Hadoop Ecosystem

- Datenlagerungstools (z. B. Snowflake, Redshift oder BigQuery)

- Cloud-Plattformen (z. B. AWS, GCP, Databricks)

- Tools zur Workflow-Orchestrierung (z. B. Apache Airflow, Apache Kafka)

Lass dich für deine Traumrolle als Data Engineer zertifizieren

Unsere Zertifizierungsprogramme helfen dir, dich von anderen abzuheben und potenziellen Arbeitgebern zu beweisen, dass deine Fähigkeiten für den Job geeignet sind.

Datenwissenschaftler

Als Datenwissenschaftler nutzt du die Funktionen von PySpark, um Daten zu verarbeiten und zu manipulieren sowie Modelle für maschinelles Lernen zu entwickeln und einzusetzen. Deine Statistikkenntnisse und Programmierfähigkeiten helfen dir dabei, Modelle zu entwickeln, die den Entscheidungsprozess unterstützen.

- Wichtige Fähigkeiten:

- Gute Kenntnisse in Python, PySpark und SQL

- Verständnis von Konzepten des maschinellen Lernens und der künstlichen Intelligenz

- Gute Kenntnisse in statistischer Analyse, quantitativer Analytik und prädiktiver Modellierung

- Techniken zur Datenvisualisierung und Berichterstellung

- Gute Kommunikations- und Präsentationsfähigkeiten

- Wichtige Tools, die benutzt werden:

- Tools zur Datenanalyse (z. B. Pandas, NumPy)

- Bibliotheken für maschinelles Lernen (z. B. Scikit-learn)

- Tools zur Datenvisualisierung (z. B. Matplotlib, Tableau)

- Big-Data-Frameworks (z. B. Airflow, Spark)

- Befehlszeilentools (z. B. Git, Bash)

Ingenieur für maschinelles Lernen

Als Machine-Learning-Ingenieur wirst du PySpark nutzen, um Daten vorzubereiten, Machine-Learning-Modelle zu erstellen und diese zu trainieren und einzusetzen.

- Wichtige Fähigkeiten:

- Gute Kenntnisse in Python, PySpark und SQL

- Tiefes Verständnis von Algorithmen für maschinelles Lernen

- Kenntnisse über Deep-Learning-Frameworks

- Verständnis von Datenstrukturen, Datenmodellierung und Softwarearchitektur

- Wichtige Tools, die benutzt werden:

- Bibliotheken und Algorithmen für maschinelles Lernen (z. B. Scikit-learn, TensorFlow)

- Datenwissenschaftliche Bibliotheken (z. B. Pandas, NumPy)

- Cloud-Plattformen (z. B. AWS, Google Cloud Platform)

- Versionskontrollsysteme (z. B. Git)

- Deep-Learning-Frameworks (z. B. TensorFlow, Keras, PyTorch)

Datenanalyst

Als Datenanalyst nutzt du PySpark, um große Datensätze zu untersuchen und zu analysieren, Trends zu erkennen und deine Ergebnisse in Berichten und Visualisierungen zu präsentieren.

- Wichtige Fähigkeiten:

- Gute Kenntnisse in Python, PySpark und SQL

- Gute Kenntnisse in statistischer Analyse

- Erfahrung mit Business-Intelligence-Tools (z. B. Tableau, Power BI)

- Verständnis von Techniken zur Datenerfassung und Datenbereinigung

- Wichtige Tools, die benutzt werden:

- Tools zur Datenanalyse (z. B. Pandas, NumPy)

- Business-Intelligence-Datentools (z. B. Tableau, Power BI)

- SQL-Datenbanken (z. B. MySQL, PostgreSQL)

|

Rolle |

Was du machst |

Deine wichtigsten Fähigkeiten |

Die Tools, die du benutzt |

|

Big-Data-Ingenieur |

Entwickelt, baut und wartet die Infrastruktur für die Verarbeitung großer Datensätze. |

Python, PySpark, Java und Scala, Datenstrukturen, SQL und nosql, ETL, verteilte Systeme |

Apache Spark, Hadoop, Tools für Data Warehousing, Cloud-Plattformen, Tools für die Workflow-Orchestrierung |

|

Datenwissenschaftler |

Findet versteckte Muster und holt wertvolle Infos aus Daten raus. Nutzt Statistikwissen und Programmierkenntnisse, um Modelle zu erstellen, die bei der Entscheidungsfindung helfen. |

Python, PySpark, SQL, maschinelles Lernen, KI-Konzepte, statistische Analyse, Vorhersagemodelle, Datenvisualisierung, effektive Kommunikation |

Pandas, NumPy, Scikit-learn, Keras, Matplotlib, plotly, Airflow, Spark, Git |

|

Ingenieur für maschinelles Lernen |

Entwirft, entwickelt und setzt Machine-Learning-Systeme ein, um anhand von Unternehmensdaten Prognosen zu erstellen. |

Python, PySpark und SQL, Algorithmen für maschinelles Lernen, Deep Learning, Datenstrukturen, Datenmodellierung und Softwarearchitektur |

Scikit-learn, TensorFlow, Keras, PyTorch, Pandas, NumPy, AWS, Google Cloud Platform, Git |

|

Datenanalyst |

Schließt die Lücke zwischen Rohdaten und nützlichen Geschäftserkenntnissen. Teile die Ergebnisse über Berichte und Visualisierungen mit. |

Python, PySpark und SQL, statistische Analyse, Datenvisualisierung, Techniken zur Datenerfassung und Datenbereinigung |

Pandas, NumPy, Tableau, PowerBI, MySQL, PostgreSQL. |

Wie finde ich einen Job, bei dem PySpark oder in PySpark zum Einsatz kommt?

Ein Abschluss kann echt hilfreich sein, wenn du eine Karriere mit PySpark startest, aber es ist nicht der einzige Weg. Heutzutage fangen immer mehr Leute an, in Jobs mit Daten zu arbeiten, indem sie andere Wege einschlagen, zum Beispiel indem sie aus anderen Bereichen wechseln. Mit Engagement, kontinuierlichem Lernen und einer proaktiven Herangehensweise kannst du deinen Traumjob finden, bei dem du PySpark einsetzen kannst.

Lerne immer mehr über das Fachgebiet

Bleib auf dem Laufenden über die neuesten Entwicklungen bei PySpark. Folge einflussreichen Profis, die sich mit PySpark beschäftigen, auf Social Media, lies Blogs über PySpark und hör dir Podcasts zu diesem Thema an.

PySpark wurde von Matei Zaharia, der auch CTO bei Databricks, einer Plattform, die auf Apache Spark basiert. Du bekommst Einblicke in aktuelle Themen, neue Technologien und die zukünftige Ausrichtung von PySpark.

Du solltest dir auch Branchenveranstaltungen anschauen, egal ob es sich um Webinare bei DataCampoder Konferenzen zu Datenwissenschaft und KIoder Networking-Events.

Ein Portfolio aufbauen

Du musst dich von den anderen Bewerbern abheben. Eine gute Möglichkeit dafür ist, ein starkes Portfolio aufzubauen, das deine Fähigkeiten und abgeschlossenen Projekte zeigt. Du kannst bei Personalchefs einen guten Eindruck hinterlassen, indem du auf echte Herausforderungen eingehst.

Dein Portfolio sollte verschiedene Projekte haben, die zeigen, wie gut du dich mit PySpark auskennst und wie vielseitig es eingesetzt werden kann. Schau dir diesen Leitfaden an, wie du ein beeindruckendes Data-Science-Portfolio zusammenstellst.

Schreib einen guten Lebenslauf

In den letzten Jahren haben immer mehr Leute angefangen, sich mit Datenwissenschaft und datenbezogenen Jobs zu beschäftigen. Personalchefs müssen echt viele Lebensläufe durchgehen und die besten Kandidaten raussuchen. Außerdem wird dein Lebenslauf oft durch Bewerbermanagementsysteme (ATS) geschleust. Das sind automatisierte Softwaresysteme, die viele Firmen nutzen, um Lebensläufe zu checken und die, die bestimmte Kriterien nicht erfüllen, auszusortieren. Also, du solltest einen tollen Lebenslauf erstellen, um sowohl ATS als auch deine Personalvermittler zu beeindrucken.

Mach dich für das Vorstellungsgespräch bereit

Wenn du dem Personalchef auffällst oder dein guter Lebenslauf den Auswahlprozess übersteht, solltest du dich als Nächstes auf ein Fachgespräch vorbereiten. Um dich vorzubereiten, kannst du diesen Artikel zu den die häufigsten Fragen in PySpark-Vorstellungsgesprächen.

Fazit

PySpark zu lernen kann dir neue Möglichkeiten und bessere Karrierechancen eröffnen. Der Weg zum Erlernen von PySpark ist lohnenswert, erfordert aber Ausdauer und praktische Übungen. Das Experimentieren und Lösen von Herausforderungen mit diesem Tool kann deinen Lernprozess beschleunigen und dir Beispiele aus der Praxis liefern, die du bei der Jobsuche vorzeigen kannst.

FAQs

Was sind die wichtigsten Funktionen von PySpark?

PySpark hat eine einfache Python-API, mit der man Spark nutzen kann. Das sorgt für Schnelligkeit, Skalierbarkeit und Unterstützung für SQL, maschinelles Lernen und Stream-Verarbeitung bei großen Datenmengen.

Warum wird die Nachfrage nach PySpark-Kenntnissen immer größer?

Die einfache Handhabung, Skalierbarkeit und Vielseitigkeit von PySpark für die Verarbeitung von Big Data und maschinelles Lernen sorgen dafür, dass diese Fähigkeiten immer gefragter werden.

Was muss man beim Lernen von PySpark unbedingt beachten?

Konzentrier dich auf die Grundlagen von Python, die Kernkonzepte von Spark und Techniken zur Datenbearbeitung und schau dir fortgeschrittene Themen wie Spark SQL und MLlib an.

Wie kann man PySpark lernen?

Mach Online-Kurse und schau dir Tutorials an, arbeite mit echten Datensätzen, nutze Spickzettel und lerne PySpark mit Büchern kennen.

Welche Rollen nutzen PySpark?

Einige der Jobs, in denen PySpark zum Einsatz kommt, sind: Big-Data-Ingenieur, Machine-Learning-Ingenieur, Datenwissenschaftler und Datenanalyst.