Cours

On estime qu'environ 328,77 millions de téraoctets de données sont générés chaque jour. Chaque clic et chaque achat génèrent des données qui peuvent être transformées en informations et prévisions pertinentes à l'aide des outils appropriés.

Cependant, nous avons besoin d'une bibliothèque performante pour nous aider à traiter cette quantité de données. C'est là qu't PySpark entrent en jeu.

Dans ce guide, nous examinerons comment apprendre PySpark à partir de zéro. Je vous assisterai dans l'élaboration d'un plan d'apprentissage, je partagerai mes meilleurs conseils pour apprendre efficacement et je vous fournirai des ressources utiles pour vous aider à trouver des postes qui requièrent PySpark.

Apprendre PySpark à partir de zéro

Qu'est-ce que PySpark ?

PySpark est la combinaison de deux technologies performantes : Python et Apache Spark.

Python est l'un des langages de programmation les plus utilisés dans le développement de logiciels, en particulier pour la science des données et l'apprentissage automatique, principalement en raison de sa syntaxe simple et conviviale.

D'autre part, Apache Spark est un framework capable de traiter de grandes quantités de données non structurées. Spark a été développé à l'aide de Scala, un langage qui nous offre un plus grand contrôle sur le système. Cependant, Scala n'est pas un langage de programmation très répandu parmi les professionnels des données. PySpark a donc été créé pour combler cette lacune.

PySpark fournit une API et une interface conviviale pour interagir avec Spark. Il exploite la simplicité et la flexibilité de Python pour rendre le traitement des mégadonnées accessible à un public plus large.

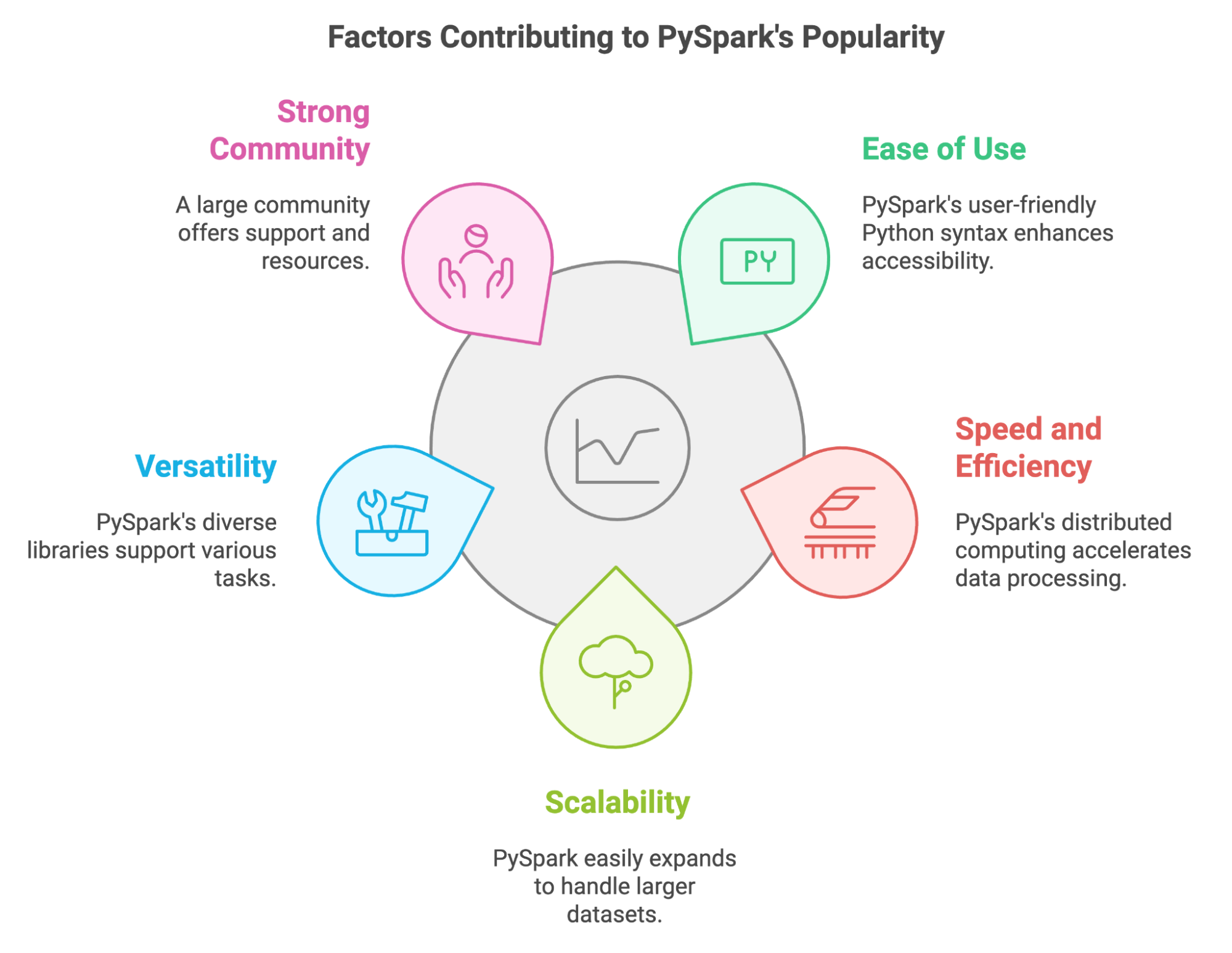

Quels sont les facteurs qui contribuent à la popularité de PySpark ?

Ces dernières années, PySpark est devenu un outil essentiel pour les professionnels des données qui doivent traiter d'énormes quantités de données. Nous pouvons expliquer sa popularité par plusieurs facteurs clés :

- Facilité d'utilisation : PySpark utilise la syntaxe familière de Python, ce qui le rend plus accessible aux professionnels des données comme nous.

- Rapidité et efficacité : En répartissant les calculs entre plusieurs clusters de machines, PySpark traite des ensembles de données volumineux à une vitesse élevée.

- Évolutivité : PySpark s'adapte à l'augmentation des volumes de données, ce qui nous permet de faire évoluer nos applications en ajoutant davantage de ressources informatiques.

- Polyvalence : Il propose un vaste écosystème de bibliothèques pour différentes tâches, de la manipulation de données à l'apprentissage automatique.

- Communauté forte : Nous pouvons compter sur une communauté importante et active pour nous apporter son soutien et nous fournir des ressources lorsque nous sommes confrontés à des problèmes et à des défis.

PySpark nous permet également de tirer parti des compétences et des bibliothèques Python existantes. Nous pouvons facilement l'intégrer à des outils populaires tels que Pandas et Scikit-learn, et il nous permet d'utiliser diverses sources de données.

Principales fonctionnalités de PySpark

PySpark a été spécialement conçu pour le traitement des mégadonnées. le big data et le machine learning. Quelles sont les fonctionnalités qui en font un outil performant pour traiter de grandes quantités de données ? Examinons-les :

- Ensembles de données distribués résilients (RDD) : Ce sont les structures de données fondamentales qui sous-tendent PySpark. Grâce à eux, la transformation, le filtrage et l'agrégation des données peuvent être effectués en parallèle.

- DataFrame et SQL : Dans PySpark, les DataFrame représentent une abstraction de niveau supérieur construite à partir des RDD. Nous pouvons les utiliser avec Spark SQL et des requêtes pour effectuer des manipulations et des analyses de données.

- Bibliothèques d'apprentissage automatique : Utilisation de bibliothèque MLlib de PySpark , nous pouvons créer et utiliser des modèles d'apprentissage automatique évolutifs pour des tâches telles que la classification et la régression.

- Prise en charge de différents formats de données : PySpark fournit des bibliothèques et des API permettant de lire, d'écrire et de traiter des données dans différents formats, tels que CSV, JSON, Parquet et Avro, entre autres.

- Tolérance aux défaillances : PySpark assure le suivi de chaque RDD. Si un nœud tombe en panne pendant l'exécution, PySpark reconstruit la partition RDD perdue à l'aide de ces informations de suivi. Il y a donc peu de risque de perte de données.

- Traitement en mémoire : PySpark stocke les données intermédiaires en mémoire, ce qui réduit le besoin d'opérations sur disque et améliore ainsi les performances de traitement des données.

- Diffusion en continu et traitement en temps réel : Nous pouvons utiliser le composant Spark Streaming pour traiter des flux de données en temps réel et effectuer des analyses quasi instantanées.

Pourquoi est-il si utile d'apprendre PySpark ?

Le volume de données ne cesse d'augmenter. De nos jours, les tâches de traitement et d'analyse des données, ainsi que d'apprentissage automatique, impliquent de travailler avec de grandes quantités de données. Il est nécessaire d'utiliser des outils performants qui traitent ces données de manière efficace et rapide. PySpark est l'un de ces outils.

PySpark offre une grande variété d'applications.

Nous avons déjà évoqué les points forts de PySpark, mais examinons quelques exemples concrets d'utilisation :

- ETL des données. La capacité de PySpark à nettoyer et transformer efficacement les données est utilisée pour traiter les données des capteurs et les journaux de production dans les domaines de la fabrication et de la logistique.

- Apprentissage automatique. La bibliothèque MLlib est utilisée pour développer et déployer des modèles destinés aux recommandations personnalisées, à la segmentation de la clientèle et aux prévisions de ventes dans le domaine du commerce électronique.

- Traitement des graphes. Les GraphFrames de PySpark sont utilisés pour analyser les réseaux sociaux et comprendre les relations entre les utilisateurs.

- Traitement des flux. L'API Structured Streaming de PySpark permet le traitement en temps réel des transactions financières afin de détecter les fraudes.

- Traitement des données SQL. L'interface SQL de PySpark facilite la consultation et l'analyse de grands ensembles de données génomiques pour les chercheurs et les analystes du secteur de la santé.

Il existe une forte demande pour les compétences en PySpark.

Avec l'essor de la science des données et de l'apprentissage automatique, ainsi que l'augmentation des données disponibles, il existe une forte demande pour des professionnels possédant des compétences en manipulation de données. Selon le rapport 2024 sur l'état des connaissances en matière de données et d'IA, 80 % des dirigeants accordent de l'importance aux compétences en analyse et en manipulation des données.

L'apprentissage de PySpark peut ouvrir de nombreuses opportunités professionnelles. Plus de 800 offres d'emploi sur Indeed, allant d'ingénieurs de données à des scientifiques de données, soulignent la demande en compétences PySpark dans le domaine des données. offres d'emploi liées aux données.

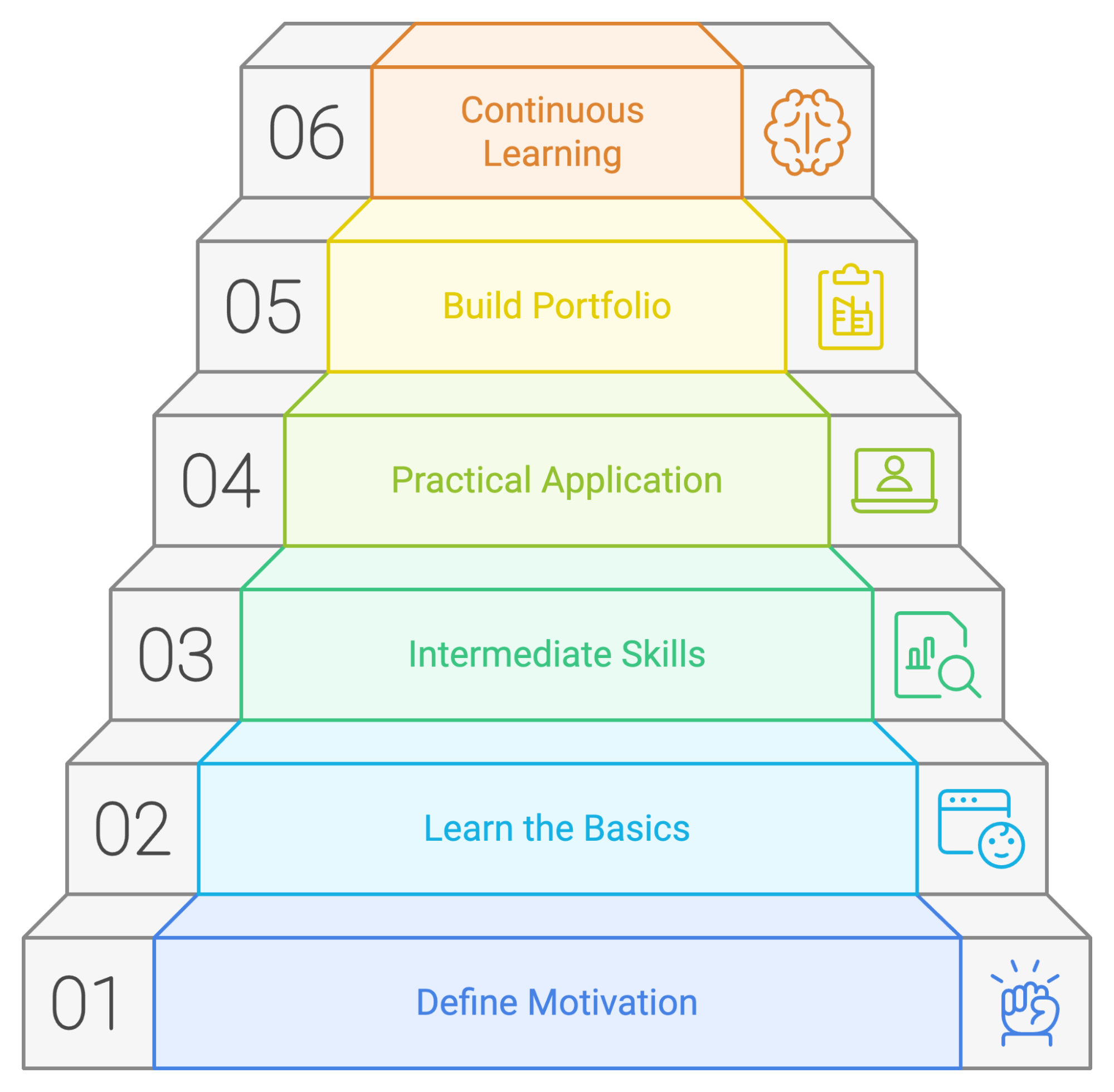

Comment apprendre PySpark à partir de zéro en 2026

Si vous apprenez PySpark de manière méthodique, vous aurez davantage de chances de réussir. Concentrons-nous sur quelques principes que vous pouvez appliquer dans votre parcours d'apprentissage.

1. Comprenez pourquoi vous apprenez PySpark

Avant d'aborder les détails techniques, veuillez définir votre motivation pour apprendre PySpark. Veuillez vous poser la question suivante :

- Quels sont mes objectifs professionnels ?

- PySpark est-il une compétence indispensable pour progresser dans votre poste actuel ou obtenir l'emploi de vos rêves ?

- Quelles opportunités envisagez-vous de saisir si vous maîtrisez PySpark ?

- Quels problèmes est-ce que je cherche à résoudre ?

- Rencontrez-vous des difficultés pour traiter des ensembles de données volumineux que les outils actuels dont vous disposez ne peuvent pas gérer ?

- Avez-vous besoin d'effectuer des transformations de données complexes ou de créer des modèles avancés d'apprentissage automatique ?

- Qu'est-ce qui m'intéresse ?

- L'idée de créer des pipelines de données évolutifs vous intéresse-t-elle ?

- Êtes-vous intéressé par le big data et son potentiel pour révéler des informations précieuses ?

- Ai-je un projet spécifique en tête qui nécessite les capacités de PySpark ?

- Travaillez-vous sur un projet personnel qui implique le traitement ou l'analyse de données à grande échelle ?

- Votre entreprise a-t-elle besoin d'une expertise PySpark pour un projet à venir ?

2. Commencer par les bases de PySpark

Une fois vos objectifs définis, veuillez acquérir les bases de PySpark et comprendre leur fonctionnement.

Principes fondamentaux de Python

Étant donné que PySpark est basé sur Python, il est nécessaire de se familiariser avec Python avant d'utiliser PySpark. Il est important que vous soyez à l'aise avec les variables et les fonctions. Il pourrait également être utile de se familiariser avec les bibliothèques de manipulation de données telles que Pandas. Cours d'introduction à Python de DataCamp Introduction à Python de DataCamp et Manipulation de données avec Pandas peuvent vous aider à vous familiariser avec ces outils.

Installation de PySpark et apprentissage des bases

Il est nécessaire d'installer PySpark pour pouvoir commencer à l'utiliser. Vous pouvez télécharger PySpark à l'aide de pip ou Conda, le télécharger manuellement depuis le site officiel ou commencer avec DataLab pour vous familiariser avec PySpark dans votre navigateur.

Si vous souhaitez obtenir des explications détaillées sur la configuration de PySpark, veuillez consulter ce guide sur comment installer PySpark sur Windows, Mac et Linux.

PySpark DataFrames

Le premier concept que vous devez acquérir est le fonctionnement des DataFrame PySpark. Ils constituent l'une des principales raisons pour lesquelles PySpark fonctionne de manière si rapide et efficace. Comprenez comment les créer, les transformer (mapper et filtrer) et les manipuler. Le tutoriel sur comment commencer à travailler avec PySpark vous aidera à comprendre ces concepts.

3. Maîtrisez les compétences intermédiaires en PySpark

Une fois que vous maîtrisez les bases, il est temps d'explorer les compétences intermédiaires de PySpark.

Spark SQL

L'un des principaux avantages de PySpark réside dans sa capacité à exécuter des requêtes de type SQL pour lire et manipuler des DataFrame, effectuer des agrégations et utiliser des fonctions de fenêtre. En arrière-plan, PySpark utilise Spark SQL. Cette introduction à Spark SQL en Python peut vous aider à acquérir cette compétence.

Manipulation et transformation des données

Travailler avec des données implique de maîtriser leur nettoyage, leur transformation et leur préparation en vue de leur analyse. Cela comprend le traitement des valeurs manquantes, la gestion de différents types de données et la réalisation d'agrégations à l'aide de PySpark. Veuillez consulter le cours « Nettoyage des données avec PySpark » de DataCamp pour acquérir une expérience pratique et maîtriser ces compétences.

Apprentissage automatique avec MLlib

PySpark peut également être utilisé pour développer et déployer des modèles d'apprentissage automatique, grâce à sa bibliothèque MLlib. Il est recommandé d'apprendre à effectuer l'ingénierie des caractéristiques, l'évaluation des modèles et le réglage des hyperparamètres à l'aide de cette bibliothèque. DataCamp's Le cours « Machine Learning with PySpark » de DataCamp de DataCamp propose une introduction complète.

4. Apprenez PySpark par la pratique

Suivre des cours et pratiquer des exercices à l'aide de PySpark constitue un excellent moyen de se familiariser avec cette technologie. Cependant, pour maîtriser PySpark, il est nécessaire de résoudre des problèmes complexes et stimulants, similaires à ceux que vous rencontrerez dans des projets réels. Vous pouvez commencer par effectuer des tâches simples d'analyse de données, puis passer progressivement à des défis plus complexes.

Voici quelques méthodes pour exercer vos compétences :

- Participez à des webinaires et à des sessions de codage en direct. Veuillez vérifier les les prochains webinaires DataCamp et les événements en ligne où vous pourrez suivre les tutoriels PySpark et les exemples de code. Cela vous aidera à renforcer votre compréhension des concepts et à vous familiariser avec les modèles de codage.

- Développez des projets de manière autonome. Identifiez les ensembles de données qui vous intéressent et utilisez vos compétences en PySpark pour les analyser. Cela peut inclure diverses activités, telles que l'analyse des tendances sur les réseaux sociaux ou l'examen des données relatives aux marchés financiers.

- Contribuez aux projets open source. Contribuez aux projets PySpark sur des plateformes telles que GitHub afin d'acquérir de l'expérience en matière de collaboration avec d'autres personnes et de travail sur des projets concrets.

- Créez un blog personnel. Écrivez sur vos projets PySpark, partagez vos idées et contribuez à la communauté PySpark en créant un blog personnel.

5. Construire un portefeuille de projets

Au fur et à mesure que vous progresserez dans votre apprentissage de PySpark, vous réaliserez différents projets. Afin de mettre en valeur vos compétences et votre expérience en PySpark auprès d'employeurs potentiels, il est recommandé de les compiler dans un portfolio. Ce portfolio doit refléter vos compétences et vos centres d'intérêt, et être adapté à la carrière ou au secteur qui vous intéresse.

Veuillez vous efforcer de rendre vos projets originaux et de mettre en avant vos compétences en matière de résolution de problèmes. Veuillez inclure des projets qui démontrent votre maîtrise de divers aspects de PySpark, tels que le traitement des données, l'apprentissage automatique et la visualisation des données. Veuillez documenter vos projets en fournissant le contexte, la méthodologie, le code et les résultats. Vous pouvez utiliser DataLab, un environnement de développement intégré en ligne qui vous permet d'écrire du code, d'analyser des données de manière collaborative et de partager vos conclusions.

Voici deux projets PySpark sur lesquels vous pouvez travailler :

- Nettoyage d'un ensemble de données de commandes avec PySpark

- Élaboration d'un modèle de prévision de la demande

6. Continuez à vous mettre au défi

L'apprentissage de PySpark est un processus continu. La technologie évolue constamment, et de nouvelles fonctionnalités et applications sont régulièrement développées. PySpark ne fait pas exception à cette règle.

Une fois que vous maîtrisez les principes fondamentaux, vous pouvez vous tourner vers des tâches et des projets plus complexes, tels que l'optimisation des performances ou GraphX. Concentrez-vous sur vos objectifs et spécialisez-vous dans des domaines pertinents pour vos objectifs de carrière et vos centres d'intérêt.

Restez informé des dernières évolutions et découvrez comment les appliquer à vos projets actuels. Continuez à vous exercer, recherchez de nouveaux défis et opportunités, et considérez les erreurs comme un moyen d'apprendre.

Récapitulons les étapes à suivre pour un plan d'apprentissage PySpark réussi :

Exemple de plan d'apprentissage PySpark

Même si chaque individu a sa propre méthode d'apprentissage, il est toujours judicieux de disposer d'un plan ou d'un guide à suivre pour apprendre à utiliser un nouvel outil. Nous avons élaboré un plan d'apprentissage potentiel qui indique où concentrer votre temps et vos efforts si vous débutez avec PySpark.

Mois 1 : Principes fondamentaux de PySpark

- . Veuillez installer PySpark et examiner sa syntaxe. Comprenez les concepts fondamentaux d'Apache Spark, son architecture et comment il permet le traitement distribué des données.

- Notions de base sur PySpark. Apprenez à configurer votre environnement PySpark, à créer des SparkContexts et des SparkSessions, et à explorer les structures de données de base telles que les RDD et les DataFrame.

- s de manipulation des données. Maîtrisez les opérations PySpark essentielles pour la manipulation des données, notamment le filtrage, le tri, le regroupement, l'agrégation et la jointure d'ensembles de données. Vous pouvez exécuter les projet Cleaning Orders avec PySpark.

Mois 2 : PySpark pour l'analyse de données et SQL

- Utilisation de différents formats de données: Apprenez à lire et à écrire des données dans divers formats, notamment CSV, JSON, Parquet et Avro, à l'aide de PySpark.

- Spark SQL. Apprenez à utiliser Spark SQL pour interroger et analyser des données à l'aide d'une syntaxe SQL familière. Découvrez des concepts tels que les DataFrame, les ensembles de données et les fonctions SQL.

- Visualisation des données et ingénierie des caractéristiques: Découvrez les techniques de visualisation des données dans PySpark à l'aide de bibliothèques telles que Matplotlib et Seaborn afin de tirer des enseignements de vos données. Apprenez à manipuler des données et à effectuer de l'ingénierie des caractéristiques en suivant le cours cours Ingénierie des caractéristiques avec PySpark.

Mois 3-4 : PySpark pour l'apprentissage automatique et les sujets avancés

- Présentation de MLlib:: Commencez à utiliser la bibliothèque MLlib de PySpark pour l'apprentissage automatique. Découvrez les algorithmes de base pour la classification, la régression et le regroupement. Vous pouvez utiliser le cours « Apprentissage automatique avec PySpark »..

- Création de pipelines ML. Apprenez à créer et à déployer des pipelines d'apprentissage automatique dans PySpark pour un entraînement et une évaluation efficaces des modèles.

- Développer un projet. Travailler à l'élaboration d'un modèle de prévision de la demande.

- Concepts avancés. Découvrez les techniques permettant d'optimiser les applications PySpark, notamment le partitionnement des données, la mise en cache et l'optimisation des performances.

Cinq conseils pour apprendre PySpark

J'imagine qu'à présent, vous êtes prêt à vous lancer dans l'apprentissage de PySpark et à vous procurer un ensemble de données volumineux afin de mettre en pratique vos nouvelles compétences. Cependant, avant de vous lancer, permettez-moi de vous présenter quelques conseils qui vous aideront à maîtriser PySpark.

1. Réduisez votre champ d'action

PySpark est un outil qui peut être utilisé dans de nombreuses applications différentes. Pour rester concentré et atteindre votre objectif, il est important d'identifier votre domaine d'intérêt. Souhaitez-vous vous concentrer sur l'analyse de données, l'ingénierie de données ou l'apprentissage automatique ? Adopter une approche ciblée peut vous aider à acquérir les connaissances et les aspects les plus pertinents de PySpark pour le parcours que vous avez choisi.

2. Veuillez vous entraîner fréquemment et régulièrement.

La constance est essentielle pour maîtriser toute nouvelle compétence. Il est recommandé de prévoir du temps dédié à la pratique de PySpark. Quelques instants chaque jour suffisent. Il n'est pas nécessaire d'aborder des concepts complexes quotidiennement. Vous pouvez revoir ce que vous avez appris ou revenir sur un exercice simple afin de le refactoriser. Une pratique régulière renforcera votre compréhension des concepts et vous permettra de gagner en assurance dans leur application.

3. Travaillez sur des projets concrets

Il s'agit d'un conseil essentiel, que vous retrouverez à plusieurs reprises dans ce guide. La pratique d'exercices est un excellent moyen de gagner en confiance. Cependant, c'est en appliquant vos compétences PySpark à des projets concrets que vous parviendrez à les maîtriser parfaitement. Recherchez les ensembles de données qui vous intéressent et utilisez PySpark pour les analyser, en extraire des informations et résoudre des problèmes.

Commencez par des projets et des questions simples, puis passez progressivement à des projets et des questions plus complexes. Cela peut être aussi simple que de lire et nettoyer un ensemble de données réelles et de rédiger une requête complexe pour effectuer des agrégations et prédire le prix d'une maison.

4. S'engager dans une communauté

L'apprentissage est souvent plus efficace lorsqu'il est effectué de manière collaborative. Partager vos expériences et apprendre des autres peut accélérer vos progrès et vous apporter des informations précieuses.

Pour échanger des connaissances, des idées et poser des questions, vous pouvez rejoindre des groupes liés à PySpark et participer à des rencontres et des conférences. La communauté Databricks, société fondée par les créateurs de Spark, dispose d'un forum communautaire actif où vous pouvez participer à des discussions et poser des questions sur PySpark. De plus, le Spark Summit, organisé par Databricks, est la plus grande conférence consacrée à Spark.

5. Faire des erreurs

Comme pour toute autre technologie, l'apprentissage de PySpark est un processus itératif. Et apprendre de ses erreurs est une partie essentielle du processus d'apprentissage. N'hésitez pas à expérimenter, à essayer différentes approches et à tirer des leçons de vos erreurs. Veuillez tester différentes fonctions et alternatives pour agréger les données, exécuter des sous-requêtes ou des requêtes imbriquées, et observer la rapidité de réponse offerte par PySpark.

Les meilleures méthodes pour apprendre PySpark

Examinons quelques méthodes efficaces pour apprendre PySpark.

Suivre des cours en ligne

Les cours en ligne constituent un excellent moyen d'apprendre PySpark à votre rythme. DataCamp propose des cours PySpark pour tous les niveaux, qui constituent ensemble le programme Big Data avec PySpark. Big Data avec PySpark cursus. Les cours couvrent les concepts introductifs aux thèmes de l'apprentissage automatique et sont conçus avec des exercices pratiques.

Voici quelques-uns des cours liés à PySpark proposés sur DataCamp :

- Ingénierie des caractéristiques avec PySpark

- Apprentissage automatique avec PySpark

- Développement de moteurs de recommandation avec PySpark

- Principes fondamentaux du Big Data avec PySpark

Suivez les tutoriels en ligne

Les tutoriels constituent un autre excellent moyen d'apprendre PySpark, en particulier si vous débutez avec cette technologie. Ils contiennent des instructions détaillées sur la manière d'effectuer des tâches spécifiques ou de comprendre certains concepts. Pour commencer, veuillez consulter ces tutoriels :

Veuillez consulter les fiches pratiques PySpark.

Les aide-mémoire sont utiles lorsque vous avez besoin d'un guide de référence rapide sur les sujets liés à PySpark. Voici deux aide-mémoire utiles :

Projets PySpark complets

L'apprentissage de PySpark nécessite une pratique approfondie. Relever des défis tout en menant à bien des projets qui vous permettront de mettre en pratique toutes les compétences acquises. À mesure que vous vous lancerez dans des tâches plus complexes, il sera nécessaire de trouver des solutions et d'explorer de nouvelles alternatives pour obtenir les résultats souhaités, ce qui vous permettra d'approfondir votre expertise PySpark.

Veuillez consulter les projets PySpark disponibles sur DataCamp. Ces exemples vous permettent de mettre en pratique vos compétences en matière de manipulation de données et de création de modèles d'apprentissage automatique à l'aide de PySpark :

- Nettoyage d'un ensemble de données de commandes avec PySpark

- Élaboration d'un modèle de prévision de la demande

Découvrez PySpark à travers des ouvrages

Les livres constituent une excellente ressource pour apprendre PySpark. Ils offrent des connaissances approfondies et des informations provenant d'experts, ainsi que des extraits de code et des explications. Voici quelques-uns des ouvrages les plus populaires sur PySpark :

- Apprendre PySpark, 2e édition, Jules S. Damji

- PySpark Cookbook, Denny Lee

- L'étincelle pour les développeurs Python

Carrières chez PySpark

La demande en compétences PySpark a augmenté dans plusieurs postes liés aux données, des analystes de données aux ingénieurs big data. Si vous vous préparez pour un entretien, veuillez prendre en considération ces questions d'entretien sur PySpark pour

Ingénieur en mégadonnées

En tant qu'ingénieur Big Data, vous êtes l'architecte des solutions Big Data, chargé de concevoir, de construire et de maintenir l'infrastructure qui traite les grands ensembles de données. Vous utiliserez PySpark pour créer des pipelines de données évolutifs, garantissant une ingestion, un traitement et un stockage efficaces des données.

Vous devrez posséder une solide compréhension des plateformes informatiques distribuées et cloud, ainsi qu'une expertise dans le domaine du stockage de données et des processus ETL.

- Compétences clés :

- Maîtrise de Python et PySpark, Java et Scala

- Compréhension des structures de données et des algorithmes

- Maîtrise de SQL et nosql

- Expertise dans les processus ETL et la création de pipelines de données

- Compréhension des systèmes distribués

- Principaux outils utilisés :

- Apache Spark, écosystème Hadoop

- Outils d'entreposage de données (par exemple, Snowflake, Redshift ou BigQuery)

- Plateformes cloud (par exemple, AWS, GCP, Databricks)

- Outils d'orchestration des flux de travail (par exemple, Apache Airflow, Apache Kafka)

Obtenez une certification pour le poste de Data Engineer de vos rêves

Nos programmes de certification vous aident à vous démarquer et à prouver aux employeurs potentiels que vos compétences sont adaptées à l'emploi.

Spécialiste en science des données

En tant que data scientist, vous utiliserez les fonctionnalités de PySpark pour effectuer le traitement et la manipulation des données, ainsi que pour développer et déployer des modèles d'apprentissage automatique. Vos connaissances en statistiques et vos compétences en programmation vous permettront de développer des modèles qui contribueront au processus décisionnel.

- Compétences clés :

- Excellente maîtrise de Python, PySpark et SQL

- Compréhension des concepts d'apprentissage automatique et d'intelligence artificielle

- Maîtrise de l'analyse statistique, de l'analyse quantitative et de la modélisation prédictive.

- Techniques de visualisation des données et de reporting

- Compétences efficaces en matière de communication et de présentation

- Principaux outils utilisés :

- Outils d'analyse de données (par exemple, pandas, NumPy)

- Bibliothèques d'apprentissage automatique (par exemple, Scikit-learn)

- Outils de visualisation des données (par exemple, Matplotlib, Tableau)

- Cadres de données massives (par exemple, Airflow, Spark)

- Outils en ligne de commande (par exemple, Git, Bash)

Ingénieur en apprentissage automatique

En tant qu'ingénieur en apprentissage automatique, vous utiliserez PySpark pour préparer les données, créer des modèles d'apprentissage automatique, puis les former et les déployer.

- Compétences clés :

- Maîtrise de Python, PySpark et SQL

- Compréhension approfondie des algorithmes d'apprentissage automatique

- Connaissance des cadres de deep learning

- Compréhension des structures de données, de la modélisation des données et de l'architecture logicielle

- Principaux outils utilisés :

- Bibliothèques et algorithmes d'apprentissage automatique (par exemple, Scikit-learn, TensorFlow)

- Bibliothèques de science des données (par exemple, Pandas, NumPy)

- Plateformes cloud (par exemple, AWS, Google Cloud Platform)

- Systèmes de contrôle de version (par exemple, Git)

- Cadres d'apprentissage profond (par exemple, TensorFlow, Keras, PyTorch)

Analyste de données

En tant qu'analyste de données, vous utiliserez PySpark pour explorer et analyser de grands ensembles de données, identifier des tendances et communiquer vos conclusions à travers des rapports et des visualisations.

- Compétences clés :

- Maîtrise de Python, PySpark et SQL

- Excellente maîtrise de l'analyse statistique

- Expérience avec les outils de veille économique (par exemple, Tableau, Power BI)

- Compréhension des techniques de collecte et de nettoyage des données

- Principaux outils utilisés :

- Outils d'analyse de données (par exemple, pandas, NumPy)

- Outils de données de veille économique (par exemple, Tableau, Power BI)

- Bases de données SQL (par exemple, MySQL, PostgreSQL)

|

Rôle |

Ce que vous faites |

Vos compétences clés |

Outils que vous utilisez |

|

Ingénieur Big Data |

Conçoit, développe et assure la maintenance de l'infrastructure nécessaire au traitement de grands ensembles de données. |

Python, PySpark, Java et Scala, structures de données, SQL et nosql, ETL, systèmes distribués |

Apache Spark, Hadoop, outils d'entreposage de données, plateformes cloud, outils d'orchestration des flux de travail |

|

Spécialiste en science des données |

Détecte les modèles cachés et extrait des informations précieuses à partir des données. Applique ses connaissances en statistiques et ses compétences en programmation pour élaborer des modèles facilitant la prise de décision. |

Python, PySpark, SQL, apprentissage automatique, concepts d'IA, analyse statistique, modélisation prédictive, visualisation de données, communication efficace |

Pandas, NumPy, Scikit-learn, Keras, Matplotlib, plotly, Airflow, Spark, Git |

|

Ingénieur en apprentissage automatique |

Conçoit, développe et déploie des systèmes d'apprentissage automatique afin de réaliser des prévisions à partir des données de l'entreprise. |

Python, PySpark et SQL, algorithmes d'apprentissage automatique, apprentissage profond, structures de données, modélisation de données et architecture logicielle. |

Scikit-learn, TensorFlow, Keras, PyTorch, Pandas, NumPy, AWS, Google Cloud Platform, Git |

|

Analyste de données |

Comble le fossé entre les données brutes et les informations commerciales exploitables. Communiquez vos conclusions à l'aide de rapports et de visualisations. |

Python, PySpark et SQL, analyse statistique, visualisation des données, techniques de collecte et de nettoyage des données. |

Pandas, NumPy, Tableau, PowerBI, MySQL, PostgreSQL. |

Comment trouver un emploi qui utilise PySpark ou dans PySpark

Un diplôme peut constituer un atout précieux pour débuter une carrière dans le domaine de PySpark, mais ce n'est pas la seule voie possible. De nos jours, un nombre croissant de professionnels commencent à occuper des postes liés aux données en empruntant des voies alternatives, notamment en effectuant une transition depuis d'autres domaines. Grâce à votre dévouement, à votre apprentissage continu et à votre approche proactive, vous pouvez décrocher l'emploi de vos rêves qui utilise PySpark.

Continuez à approfondir vos connaissances dans ce domaine.

Restez informé des dernières évolutions de PySpark. Suivez les professionnels influents impliqués dans PySpark sur les réseaux sociaux, consultez les blogs consacrés à PySpark et écoutez les podcasts liés à PySpark.

PySpark a été développé par Matei Zaharia, qui est également directeur technique chez Databricks, une plateforme construite sur Apache Spark. Vous obtiendrez des informations sur les sujets d'actualité, les technologies émergentes et l'orientation future de PySpark.

Nous vous recommandons également de consulter les événements du secteur, qu'il s'agisse de webinaires sur DataCamp, des conférences sur la science des données et l'IAou des événements de réseautage.

Élaborer un portfolio

Il est essentiel que vous vous démarquiez des autres candidats. Une bonne façon d'y parvenir est de constituer un solide portfolio qui met en valeur vos compétences et les projets que vous avez menés à bien. Vous pouvez faire bonne impression auprès des responsables du recrutement en abordant des défis concrets.

Votre portfolio devrait inclure divers projets qui reflètent votre expertise en PySpark et ses différentes applications. Veuillez consulter ce guide sur la manière de créer un portfolio convaincant en science des données. comment créer un portfolio impressionnant dans le domaine de la science des données.

Élaborez un CV efficace

Ces dernières années, on a observé une augmentation du nombre de personnes qui se réorientent vers des postes liés à la science des données et aux données. Les responsables du recrutement doivent examiner de nombreux CV et identifier les meilleurs candidats. De plus, votre CV est souvent soumis à des systèmes de suivi des candidats (ATS), des logiciels automatisés utilisés par de nombreuses entreprises pour examiner les CV et éliminer ceux qui ne répondent pas à des critères spécifiques. Il est donc important de rédiger un excellent CV pour impressionner à la fois les ATS et vos recruteurs.

Préparez-vous pour l'entretien

Si vous retenez l'attention du responsable du recrutement ou si votre CV convaincant passe le processus de sélection, vous devriez ensuite vous préparer à un entretien technique. Pour vous préparer, vous pouvez consulter cet article sur les questions les plus fréquemment posées lors des entretiens PySpark. les questions les plus fréquemment posées lors des entretiens d'embauche pour PySpark.

Conclusion

Apprendre PySpark peut vous ouvrir les portes vers de meilleures opportunités et perspectives de carrière. L'apprentissage de PySpark est enrichissant, mais nécessite de la constance et une pratique intensive. Expérimenter et résoudre des défis à l'aide de cet outil peut accélérer votre processus d'apprentissage et vous fournir des exemples concrets à présenter lorsque vous recherchez un emploi.

Questions fréquentes

Quelles sont les principales fonctionnalités de PySpark ?

PySpark fournit une API Python conviviale pour exploiter Spark, offrant vitesse, évolutivité et prise en charge du SQL, du machine learning et du traitement de flux pour les grands ensembles de données.

Pourquoi la demande en compétences PySpark est-elle en augmentation ?

La facilité d'utilisation, l'évolutivité et la polyvalence de PySpark pour le traitement des mégadonnées et l'apprentissage automatique stimulent la demande croissante pour ces compétences.

Quels sont les points clés à prendre en compte pour apprendre PySpark ?

Concentrez-vous sur les principes fondamentaux de Python, les concepts clés de Spark et les techniques de manipulation des données, et explorez des sujets avancés tels que Spark SQL et MLlib.

Quels sont les moyens disponibles pour apprendre PySpark ?

Suivez des cours en ligne et des tutoriels, travaillez sur des ensembles de données réels, utilisez des aide-mémoire et découvrez PySpark à travers des ouvrages spécialisés.

Quels sont les rôles qui utilisent PySpark ?

Parmi les postes qui utilisent PySpark, on peut citer : ingénieur big data, ingénieur en apprentissage automatique, scientifique des données et analyste de données.