Curso

Imagen del autor.

Hemos dejado atrás la mejora de los modelos de lenguaje grandes (LLM) y ahora nos centramos en utilizarlos para crear aplicaciones de IA que ayuden a las empresas. Aquí es donde entran en juego las herramientas de operaciones de modelos de lenguaje grandes (LLMOps), que simplifican el proceso de creación de sistemas totalmente automatizados para desarrollar e implementar soluciones LLM en producción.

En este artículo, analizaremos diferentes herramientas, como las API de LLM, los marcos de ajuste fino, las herramientas de seguimiento de experimentos, el ecosistema de integración de LLM, las herramientas de búsqueda vectorial, el marco de servicio de modelos, las plataformas de implementación y las herramientas de observabilidad. Cada herramienta es excelente en lo que hace y está diseñada para resolver problemas específicos relacionados con los LLM.

¿Qué es LLMOps?

LLMOps es un campo emergente que se centra en la gestión operativa de grandes modelos lingüísticos en entornos de producción. Se trata esencialmente de MLOps (operaciones de machine learning) especializadas en modelos lingüísticos y otros modelos multimodales.

Realiza el curso «Conceptos básicos sobre modelos lingüísticos grandes (LLM) » para aprender sobre las aplicaciones de los LLM, las metodologías de formación, las consideraciones éticas y las últimas investigaciones.

LLMOps abarca todo el ciclo de vida de los modelos lingüísticos de gran tamaño, incluyendo la recopilación de datos, el entrenamiento o ajuste del modelo, las pruebas y la validación, la integración, la implementación, la optimización, la supervisión y el mantenimiento, y la colaboración. Al estructurar proyectos y automatizar procesos, LLMOps te ayuda a reducir errores y escalar de manera eficiente las aplicaciones de IA, garantizando que los modelos sean robustos y capaces de satisfacer las demandas del mundo real.

En resumen, las herramientas LLMOps te ayudan a crear un sistema automatizado que recopila datos, ajusta el modelo en función de ellos, programa el rendimiento del modelo, lo integra con datos externos, crea la aplicación de IA, la implementa en la nube y observa las métricas y el rendimiento del modelo en producción.

El programa «Desarrollo de modelos de lenguaje grandes » consta de cuatro cursos que te ayudarán a adquirir una base sólida sobre el funcionamiento de los LLM y cómo puedes ajustar los LLM preentrenados.

Ahora, exploremos las mejores herramientas LLMOps disponibles en la actualidad.

API

Accede al lenguaje y a los modelos integrados mediante llamadas a la API. No es necesario implementar el modelo ni mantener el servidor; solo tienes que proporcionar una clave API y empezar a utilizar los modelos más avanzados.

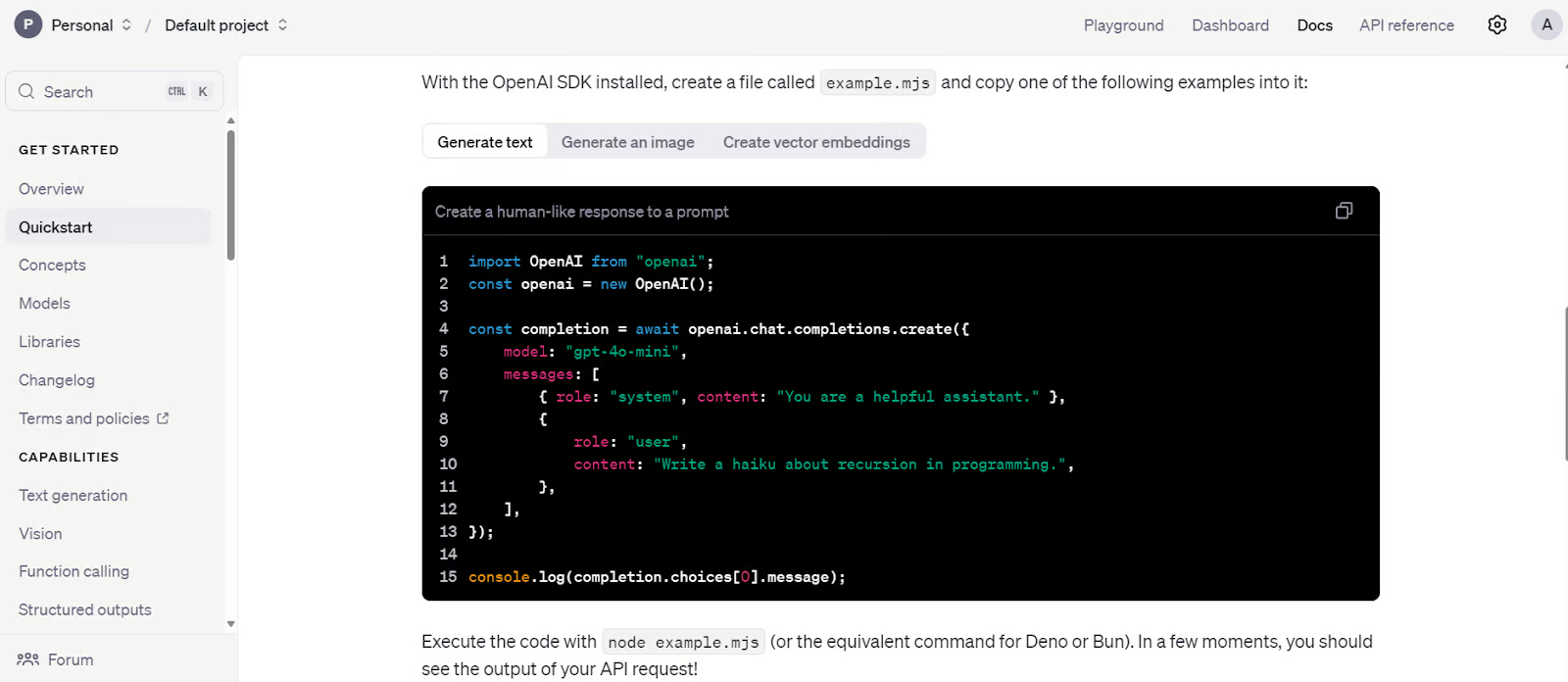

1. OpenAI API

OpenAI ofrece acceso API a modelos LLM avanzados como GPT-4o y o1. Estos modelos se pueden utilizar mediante un paquete Python o un comando CURL.

La API es una solución ideal para startups que no cuentan con un equipo técnico para ajustar o implementar modelos en producción. Proporciona acceso a modelos lingüísticos, modelos multimodales, llamadas a funciones, salidas estructuradas y opciones de ajuste fino. Además, puedes utilizar modelos de incrustación para crear tu propia base de datos vectorial. En resumen, ofrece un ecosistema de IA completo y de bajo coste.

Aprende a utilizar la API de Python de OpenAI para acceder a los modelos de lenguaje grande (LLM) más avanzados siguiendo el tutorial de la API GPT-4o de : Introducción a la API de OpenAI.

Código de inicio rápido de la API de OpenAI. Fuente de la imagen: Tutorial de inicio rápido: API de OpenAI

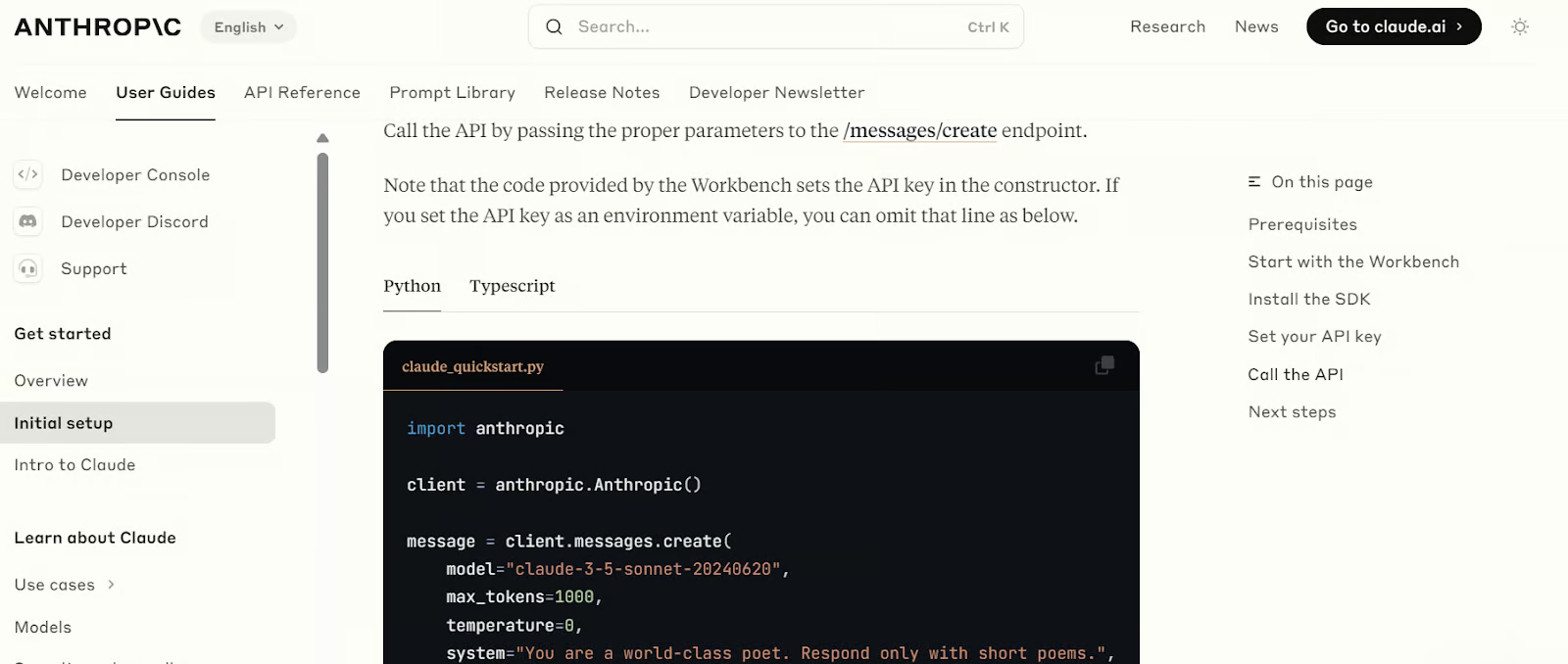

2. API antropológica

La API de Anthropic es similar a la API de OpenAI, ya que ofrece acceso a varios modelos lingüísticos y de incrustación. Estos modelos pueden utilizarse para crear aplicaciones RAG, integrar herramientas, recuperar páginas web, utilizar modelos de visión y desarrollar agentes de IA. Con el tiempo, Anthropic tiene como objetivo proporcionar todas las herramientas necesarias para crear e implementar aplicaciones de IA totalmente funcionales.

Al igual que la API de OpenAI, incluye medidas de seguridad y herramientas de evaluación para supervisar el rendimiento del modelo.

Aprende a utilizar la API de Claude para acceder a los LLM de mayor rendimiento siguiendo el tutorial « » (Introducción a la API de Claude Sonnet 3.5) de la API de Claude Sonnet 3.5: Introducción a la API de Anthropic.

Código de inicio rápido de la API antropica. Fuente de la imagen: Configuración inicial - Anthropic

Ajuste fino

Utilizando Python, ajusta los modelos lingüísticos básicos de gran tamaño en un conjunto de datos personalizado para adaptar el estilo, la tarea y la funcionalidad del modelo a los requisitos específicos.

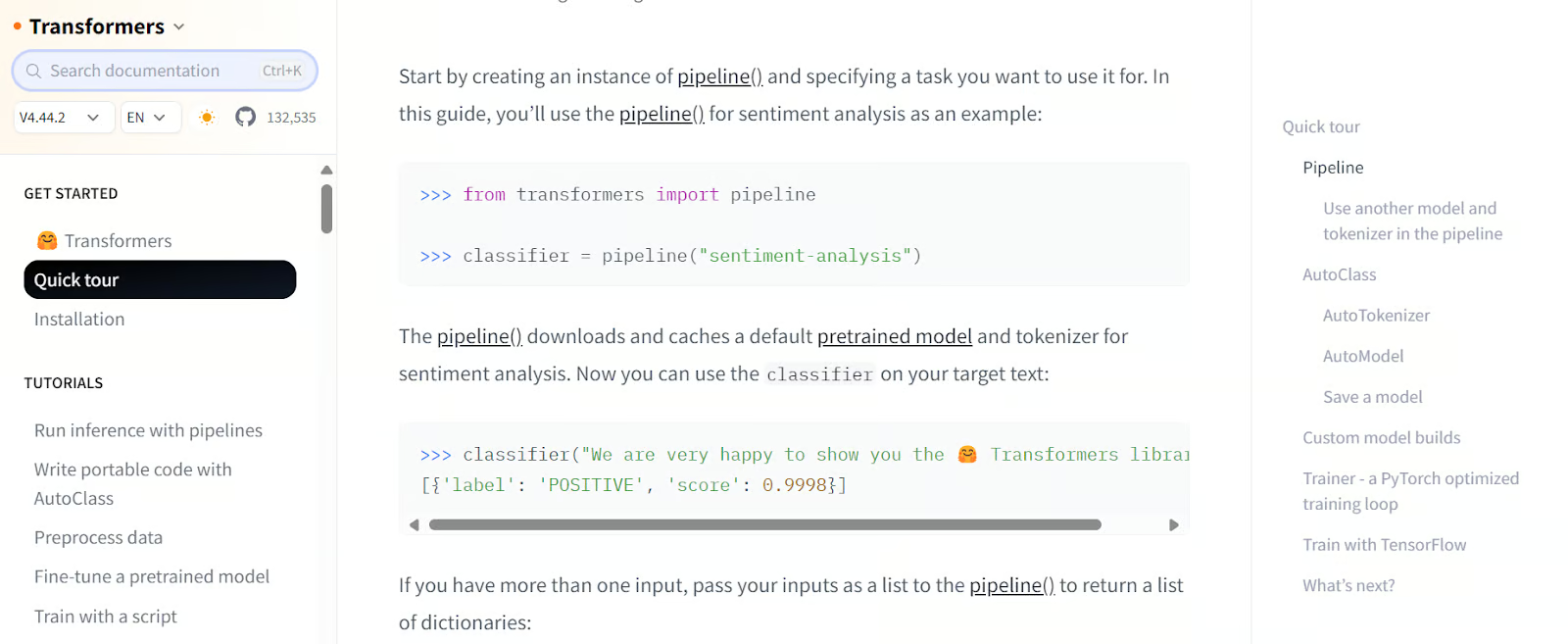

3. Transformers

Transformers by Hugging Face es un marco muy conocido en la comunidad y la industria de la inteligencia artificial. Se utiliza ampliamente para acceder a modelos, ajustar LLM con recursos limitados y guardar modelos. Ofrece un ecosistema integral para todo, desde la carga de datos hasta la evaluación de LLM.

Con Transformers, puedes cargar conjuntos de datos y modelos, procesar datos, crear modelos con argumentos personalizados, entrenar modelos y enviarlos a la nube. Más adelante, podrás implementar estos modelos en un servidor con solo unos pocos clics.

Realiza el curso Introducción a los LLM en Python para aprender sobre el panorama de los LLM, la arquitectura de los transformadores, los LLM preentrenados y cómo integrar los LLM para resolver problemas del mundo real.

Código de inicio rápido de Transformers. Fuente de la imagen: Visita rápida (huggingface.co)

4. Despierta la IA

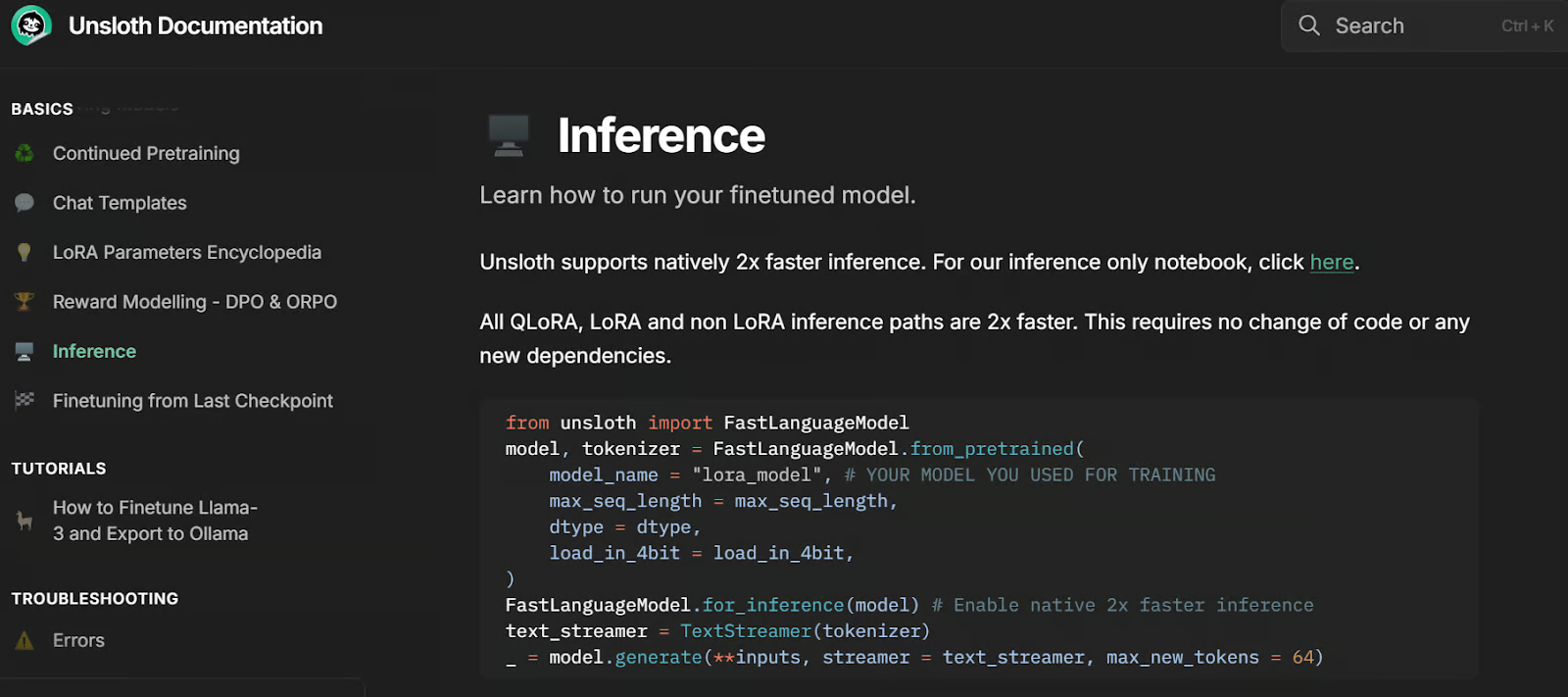

Unsloth AI es un marco de trabajo de Python para ajustar y acceder a grandes modelos de lenguaje. Ofrece una API sencilla y un rendimiento dos veces más rápido que Transformers.

Basado en la biblioteca Transformers, integra herramientas adicionales para simplificar el ajuste de modelos lingüísticos de gran tamaño con recursos limitados. Una característica destacada de Unsloth es la capacidad de guardar modelos en formato compatible con vLLM y GGUF con solo una línea de código, lo que elimina la necesidad de instalar y configurar bibliotecas como llama.cpp, ya que lo maneja todo automáticamente.

Desbloquea el código de inferencia. Fuente de la imagen: Inferencia | Documentación de Unsloth

Seguimiento de experimentos

Programa y evalúa el rendimiento del modelo durante el entrenamiento y compara los resultados.

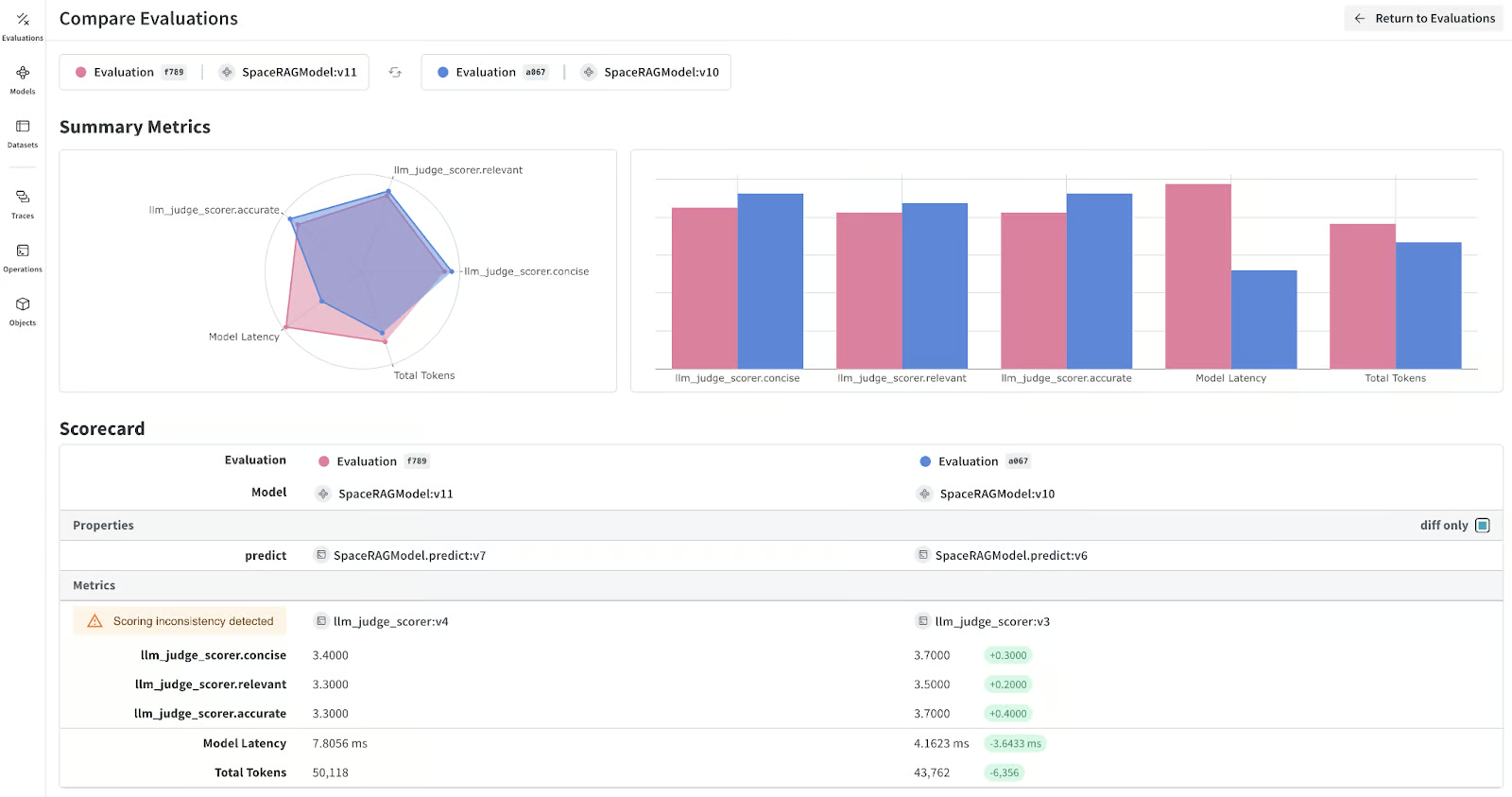

5. Ponderación y sesgos

Weights & Biases te permite realizar un seguimiento del rendimiento del modelo durante y después del ajuste fino para evaluar su eficacia. También admite el seguimiento de aplicaciones RAG y la supervisión y depuración de LLM.

La plataforma se integra perfectamente con diversos marcos y herramientas, entre los que se incluyen Transformers, LangChain, PyTorch y Keras. Una ventaja clave de utilizar Weights & Biases es su panel de control altamente personalizable, que te permite crear informes de evaluación de modelos y comparar diferentes versiones de los mismos.

Aprende a estructurar, registrar y analizar tus experimentos de machine learning con Weights & Biases siguiendo el tutorial «Experimentación con machine learning en »: Introducción a los pesos y sesgos.

Métricas del modelo LLM. Fuente de la imagen: wandb.ai

Integración LLM

Integra LLM con bases de datos externas, bases de datos privadas y búsquedas web. Incluso puedes crear y ejecutar toda la aplicación de IA utilizando estos marcos. En resumen, estas herramientas son fundamentales para crear aplicaciones complejas basadas en LLM que se pueden implementar en la nube.

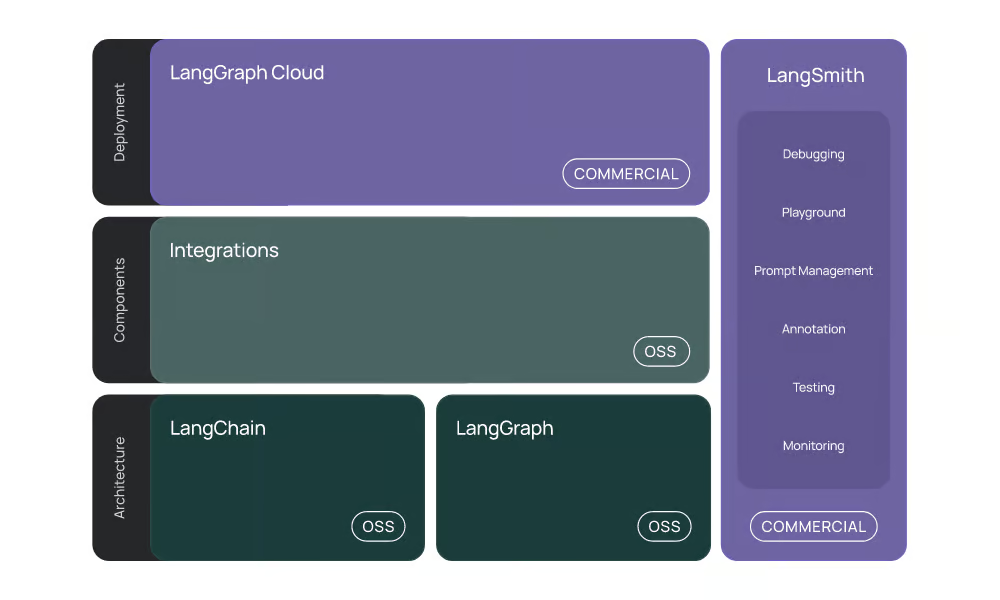

6. Langchain

LangChain es una herramienta popular para crear aplicaciones de IA utilizando LLM. Con solo unas pocas líneas de código, puedes desarrollar chatbots RAG sensibles al contexto directamente en los cuadernos Jupyter.

LangChain ofrece ahora un ecosistema LLM completo:

- Integración: Admite la integración con diversas API de IA, modelos de chat, modelos de incrustación, cargadores de documentos, almacenes de vectores y herramientas.

- LangChain: Coordina diversas herramientas de integración y LLM para crear aplicaciones de IA.

- LangGraph: Está diseñado para crear aplicaciones multiactor con estado mediante LLM, modelando los pasos como aristas y nodos en un grafo.

- LangGraph nube y LangSmith: Estos productos comerciales te permiten utilizar servicios gestionados para crear e implementar aplicaciones basadas en LLM.

LangChain simplifica el desarrollo de aplicaciones basadas en LLM al proporcionar herramientas, componentes e interfaces que agilizan el proceso.

Completa el curso Desarrollo de aplicaciones LLM con LangChain para comprender cómo crear aplicaciones basadas en IA utilizando LLM, prompts, cadenas y agentes en LangChain.

El ecosistema LangChain. Fuente de la imagen: Introduction | 🦜️🔗 LangChain

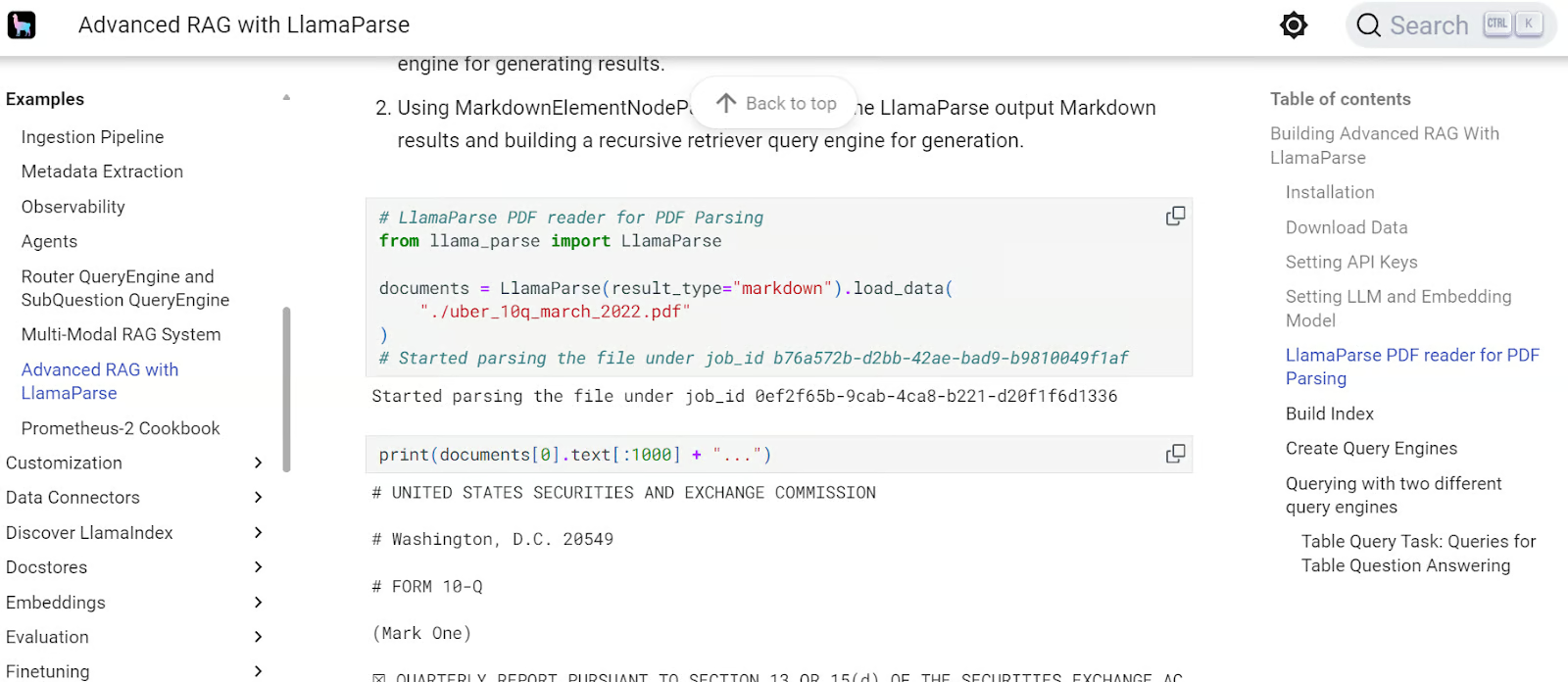

7. LlamaIndex

LlamaIndex es similar a LangChain, pero ofrece un enfoque más sencillo para crear aplicaciones RAG. Con solo unas pocas líneas de código, puedes crear aplicaciones RAG con historial.

LlamaIndex proporciona integraciones completas de API y almacenamiento vectorial, lo que permite el desarrollo de aplicaciones LLM complejas y de última generación. También cuenta con un servicio gestionado llamado LlamaCloud, que permite alojar fácilmente aplicaciones de IA.

Aprende a ingestar, gestionar y recuperar datos privados y específicos de un dominio utilizando lenguaje natural siguiendo el tutorial « » (Ingesta de datos de Llama) de LlamaIndex: Un marco de datos para aplicaciones basadas en modelos de lenguaje grandes (LLM) Tutorial de.

Guía avanzada de LlamaIndex RAG. Fuente de la imagen: RAG avanzado con LlamaParse - LlamaIndex

Búsqueda vectorial

Las herramientas de búsqueda vectorial ofrecen sólidas capacidades de almacenamiento y recuperación, que son esenciales para crear aplicaciones de generación aumentada por recuperación (RAG). Estas herramientas permiten convertir diversos tipos de datos, como texto, imágenes y audio, en incrustaciones, que luego se almacenan en bases de datos vectoriales.

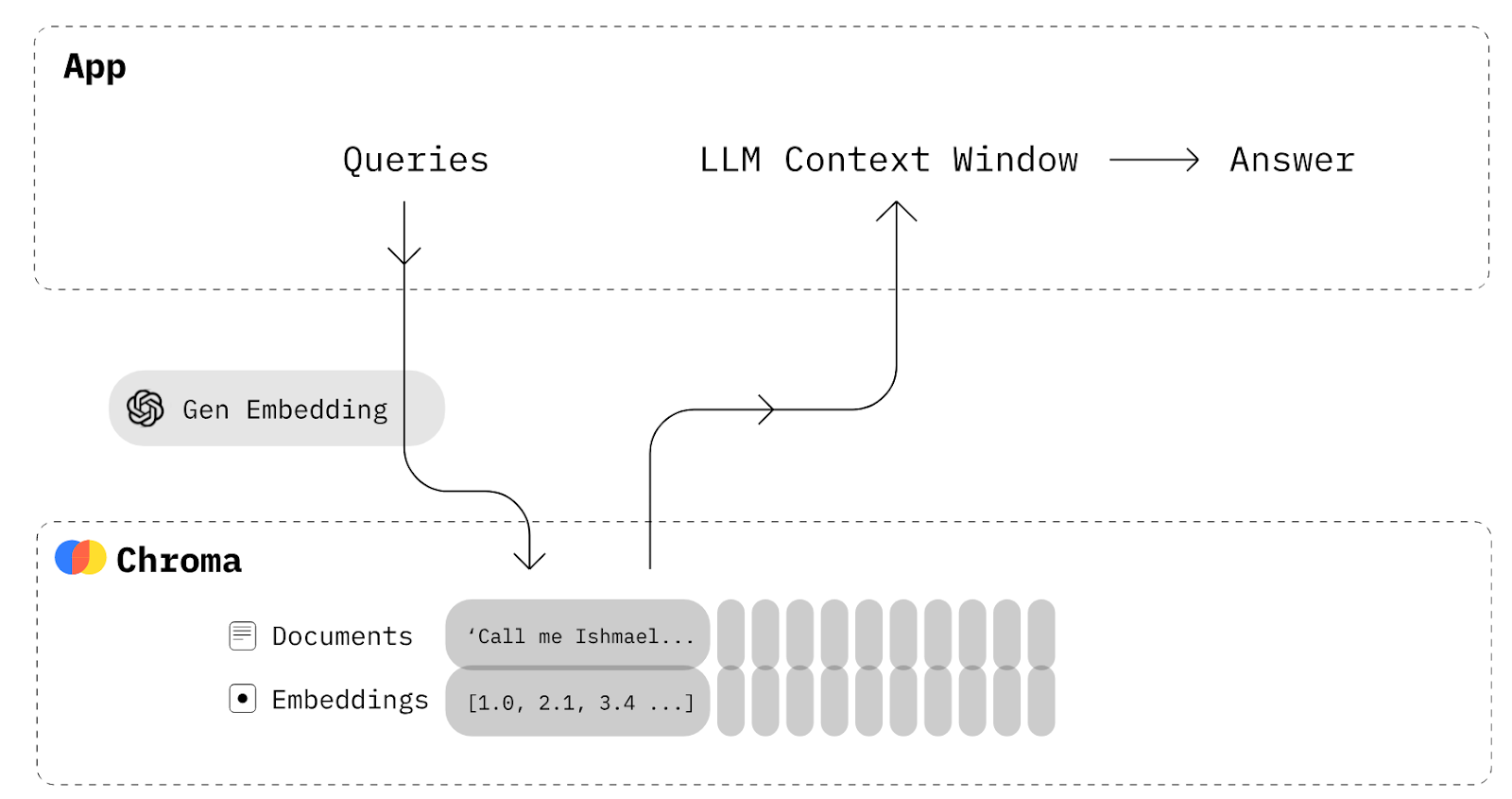

8. Chroma

Chroma es una base de datos vectorial de código abierto nativa de IA. Facilita la creación de aplicaciones LLM al permitir que el conocimiento, los datos y las habilidades se integren fácilmente.

Si deseas crear una aplicación RAG básica que te permita almacenar tus documentos como incrustaciones y luego recuperarlos para combinarlos con indicaciones con el fin de dar más contexto al modelo de lenguaje, no necesitas LangChain. Todo lo que necesitas es una base de datos Chroma para guardar y recuperar los documentos.

Diagrama Chroma DB. Fuente de la imagen: Chroma Docs (trychroma.com)

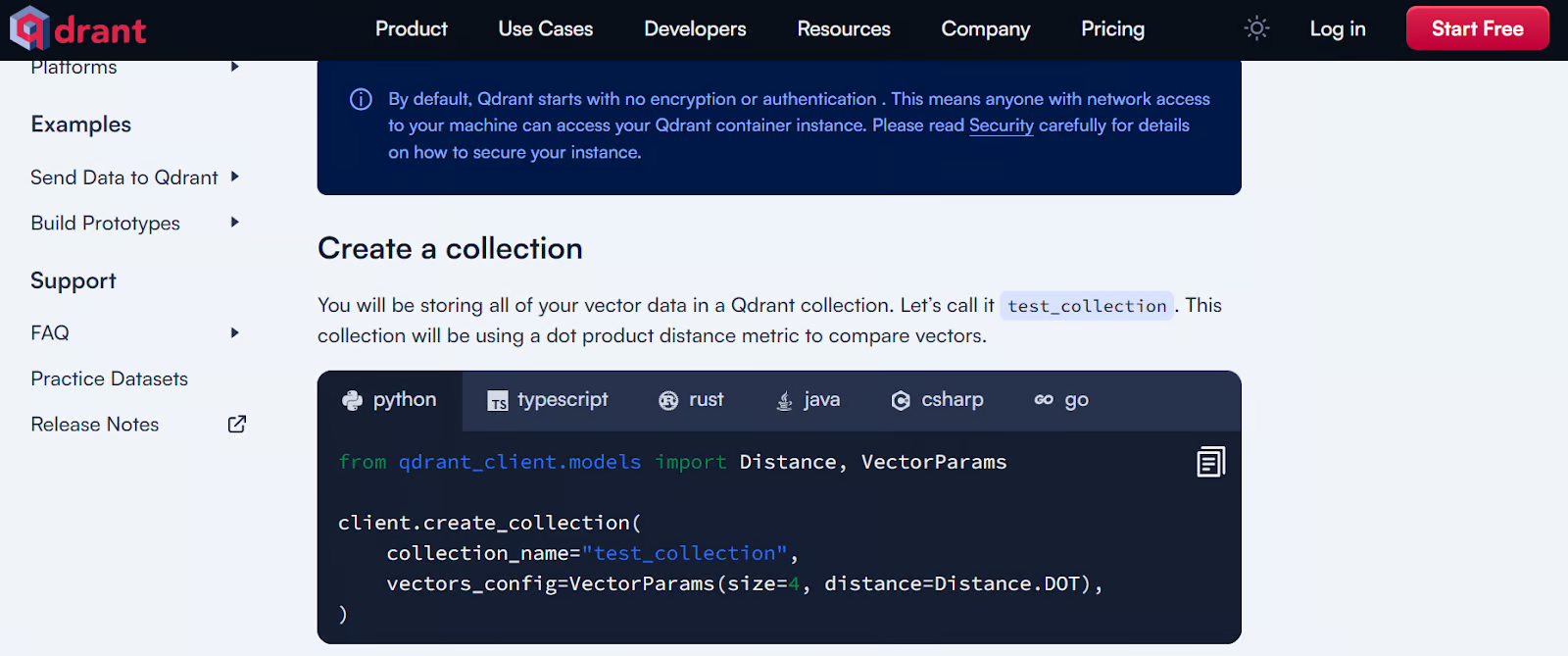

9. Cuadrante

Qdrant es una popular base de datos vectorial de código abierto y un motor de búsqueda por similitud que maneja vectores de alta dimensión. Ofrece soluciones locales, en nube e híbridas, lo que lo hace versátil para diversas necesidades de implementación.

Qdrant es especialmente eficaz en aplicaciones como la generación aumentada por recuperación, la detección de anomalías, la búsqueda avanzada y los sistemas de recomendación. Su sólida API permite una fácil integración y gestión de datos de texto, lo que la convierte en una potente herramienta para los programadores que desean implementar capacidades de búsqueda basadas en vectores.

Echa un vistazo a las 5 mejores bases de datos vectoriales para tu caso de uso específico. Ofrecen una API sencilla y un rendimiento rápido.

Ejemplo para empezar a utilizar Qdrant. Fuente de la imagen: Inicio rápido local - Qdrant

Sirviendo

Un componente esencial para tu aplicación es un motor de inferencia y servicio de alto rendimiento para LLM que sea compatible con una amplia gama de recursos informáticos, incluyendo GPU, TPU, XPU y más. Estas herramientas también son compatibles con servidores compatibles con OpenAI, lo que te permite utilizar la API de OpenAI para acceder al modelo servido sin problemas.

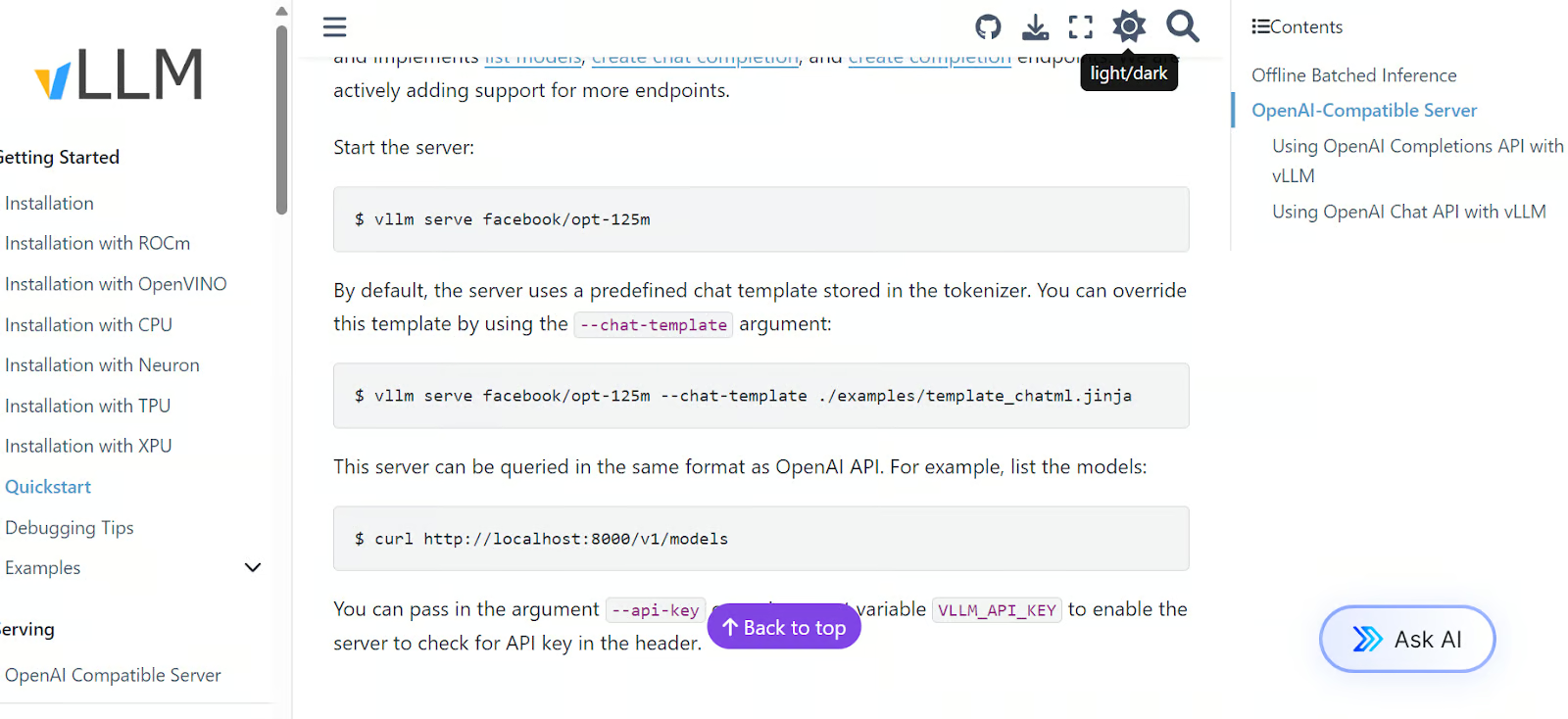

10. vLLM

vLLM es una biblioteca de código abierto robusta diseñada para la inferencia y el servicio eficientes de modelos de lenguaje grandes. Aborde los retos que plantea la implementación de los LLM, como el elevado consumo de memoria y los costes computacionales, mediante técnicas innovadoras de gestión de la memoria y estrategias dinámicas de procesamiento por lotes.

Una de las mejores características de vLLM es su algoritmo PagedAttention, que mejora significativamente el rendimiento y reduce el desperdicio de memoria. Ofrece un rendimiento hasta 24 veces superior al de soluciones tradicionales como Hugging Face Transformers.

Ejemplo de inicio rápido de vLLM. Fuente de la imagen: Inicio rápido — vLLM

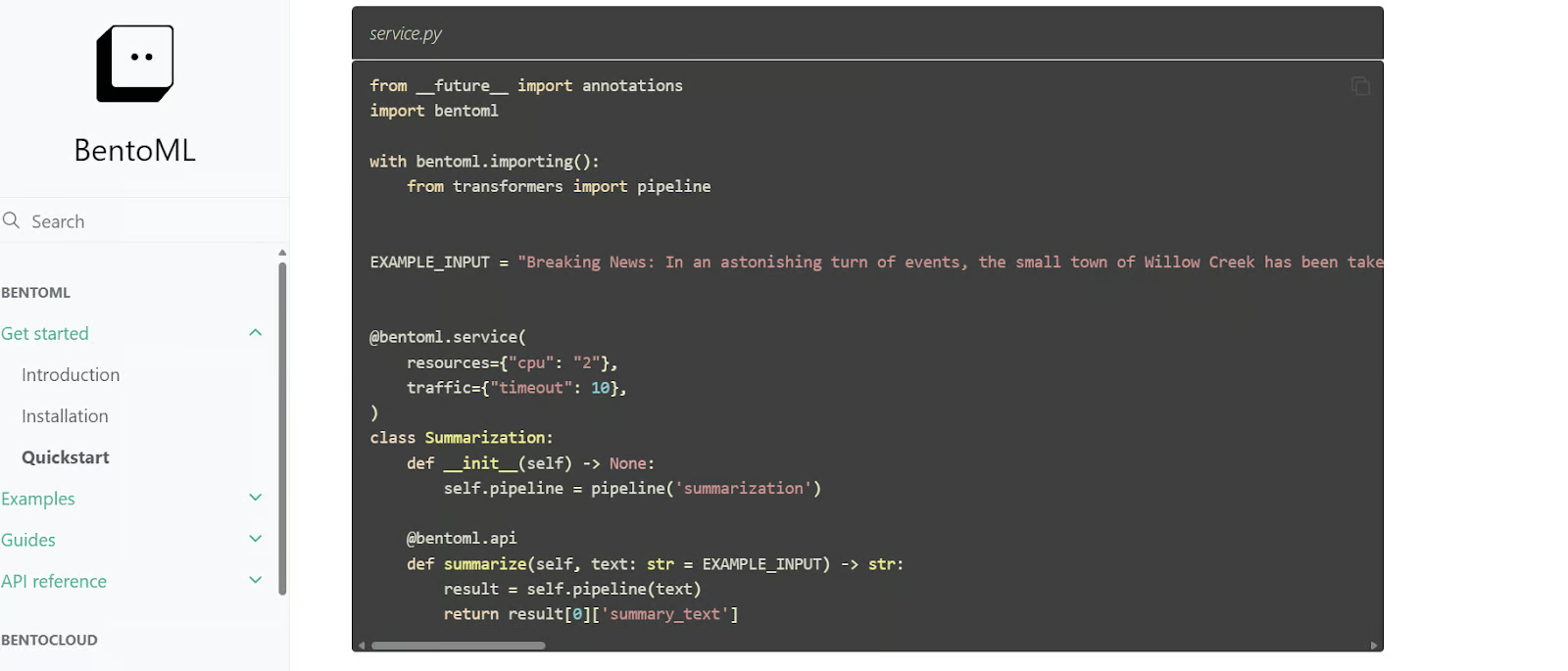

11. BentoML

BentoML es una biblioteca de Python para crear y servir LLM, que ofrece más opciones de personalización para desarrollar aplicaciones de IA que vLLM. Incluye BentoCloud, un servicio gestionado que permite implementar y supervisar fácilmente modelos en la nube, con un nivel gratuito disponible para empezar.

BentoML automatiza muchos pasos complejos en la implementación de modelos, lo que reduce significativamente el tiempo necesario para pasar los modelos de la fase de desarrollo a la de producción.

Código de inicio rápido de BentoML. Fuente de la imagen: Inicio rápido - BentoML

Implementación

Puedes implementar tu LLM directamente en la nube o crear una aplicación de IA integrada y luego implementarla. Para ello, puedes optar por cualquier proveedor importante de servicios en la nube. Sin embargo, las herramientas que se indican a continuación están especialmente diseñadas para LLM y la implementación de IA, y ofrecen una función de implementación más sencilla y eficiente.

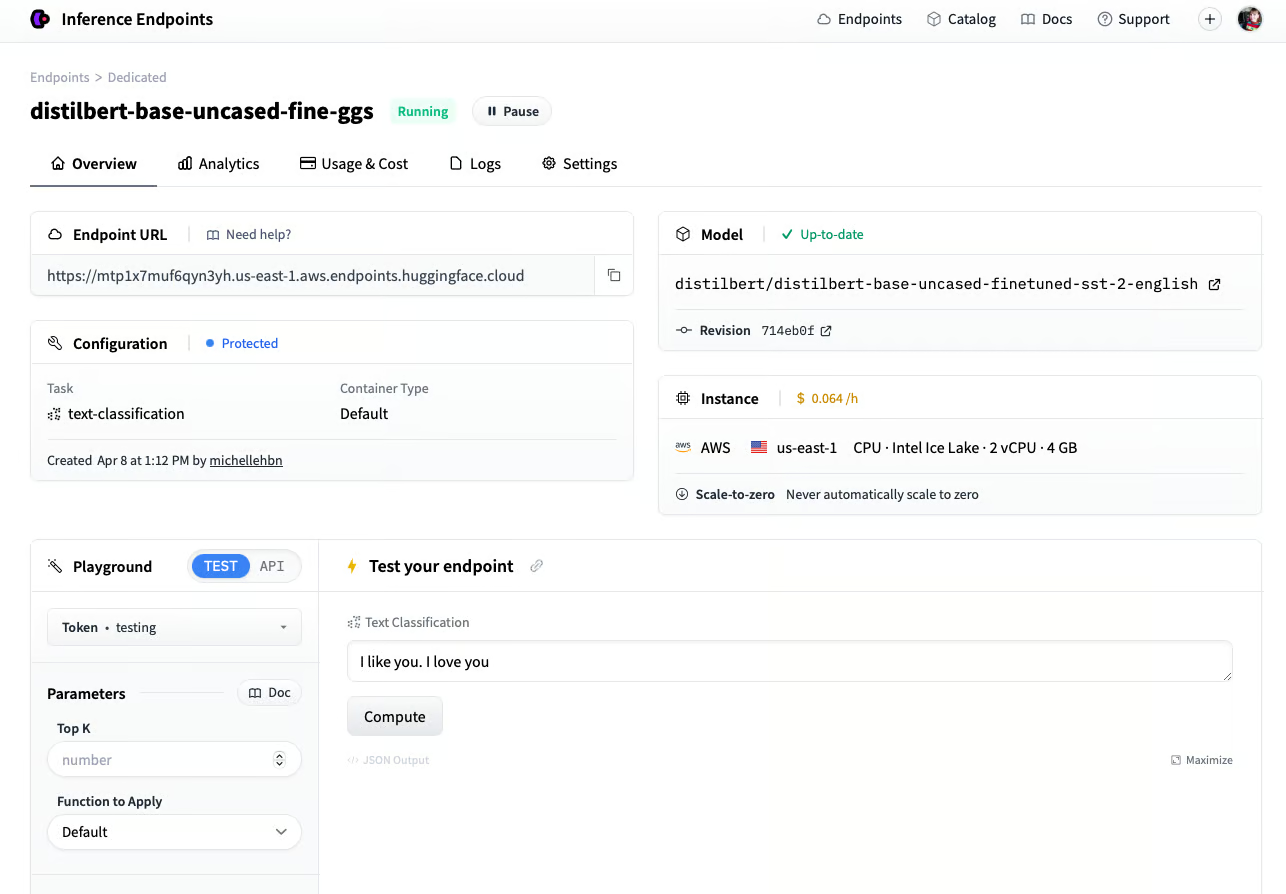

12. Puntos finales de inferencia

Si eres fanático del ecosistema Hugging Face, te encantarán los puntos finales de inferencia de Hugging Face. Este servicio de implementación te permite utilizar cualquier modelo del centro de modelos Hugging Face, incluidos los modelos privados, para su uso en producción. Solo tienes que seleccionar tu proveedor de nube y el tipo de máquina informática, y en cuestión de minutos tu modelo estará listo para usar.

Inference Endpoints cuenta con un panel dedicado que te permite crear puntos finales y supervisar modelos en producción, lo que proporciona una solución segura y eficiente para implementar modelos de machine learning.

Implementación de un modelo utilizando el punto final de inferencia de Hugging Face. Fuente de la imagen: Crear un punto final (huggingface.co)

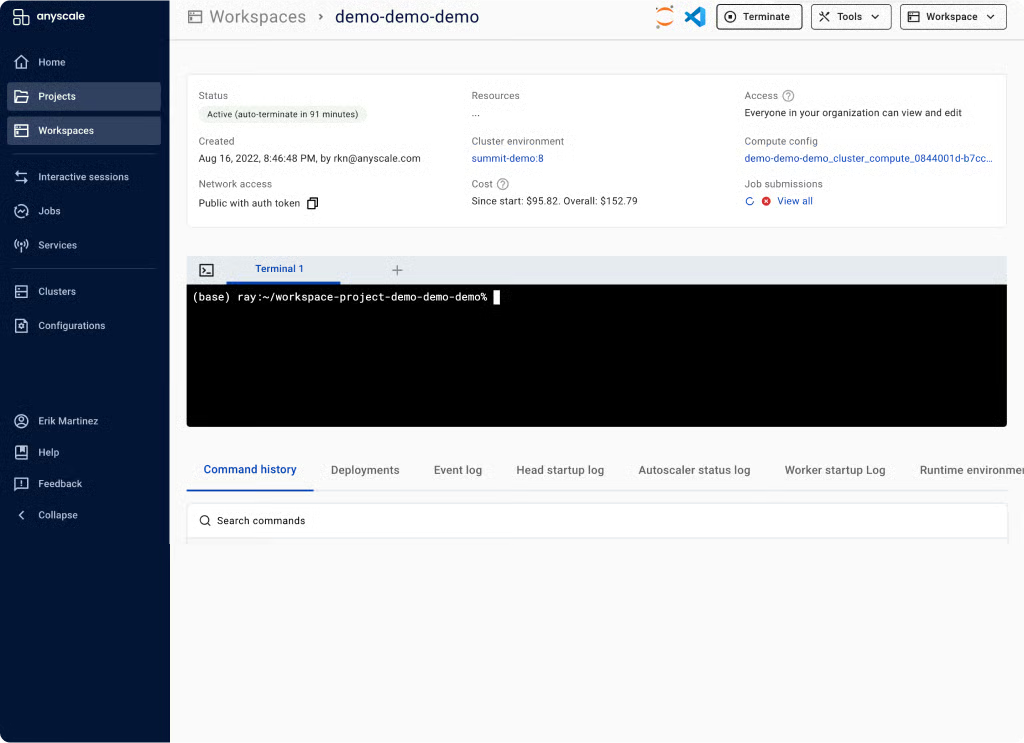

13. Anyscale

Anyscale utiliza Ray Serve en el backend para ofrecer una inferencia de modelos rápida y de alto rendimiento. Como plataforma informática totalmente gestionada y escalable, Anyscale te permite cargar datos, entrenar modelos, evaluar y servir modelos, gestionar servicios, supervisar modelos y controlar el acceso. Es una plataforma MLOps integral basada en el ecosistema de código abierto Ray, que simplifica todo el ciclo de vida de las aplicaciones de IA.

Espacio de trabajo de Anyscale. Fuente de la imagen: Plataforma informática unificada para aplicaciones de IA y Python | Anyscale

Observabilidad

Una vez implementados tus LLM, es fundamental supervisar su rendimiento en producción. Las herramientas de observabilidad realizan un seguimiento automático de tu modelo en la nube y te avisan si el rendimiento disminuye significativamente.

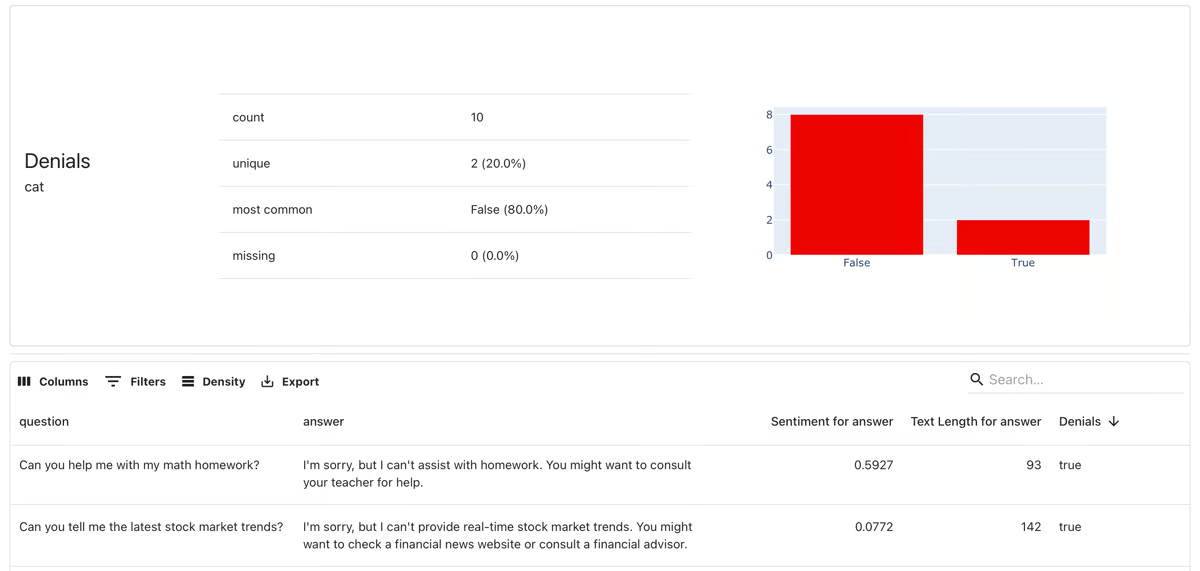

14. Evidentemente

Evidently es un marco de observabilidad de código abierto para ML y MLOps. Te permite evaluar, probar y supervisar aplicaciones de aprendizaje automático y canalizaciones de datos. Admite modelos predictivos generales, así como aplicaciones de IA generativa.

Con más de 100 métricas integradas, proporciona detección de desviaciones de datos y evaluación de modelos de aprendizaje automático. También puede generar informes de evaluación de datos y modelos, conjuntos de pruebas automatizadas y paneles de control de modelos.

Evidentemente, supervisión del modelo. Fuente de la imagen: evidentlyai.com

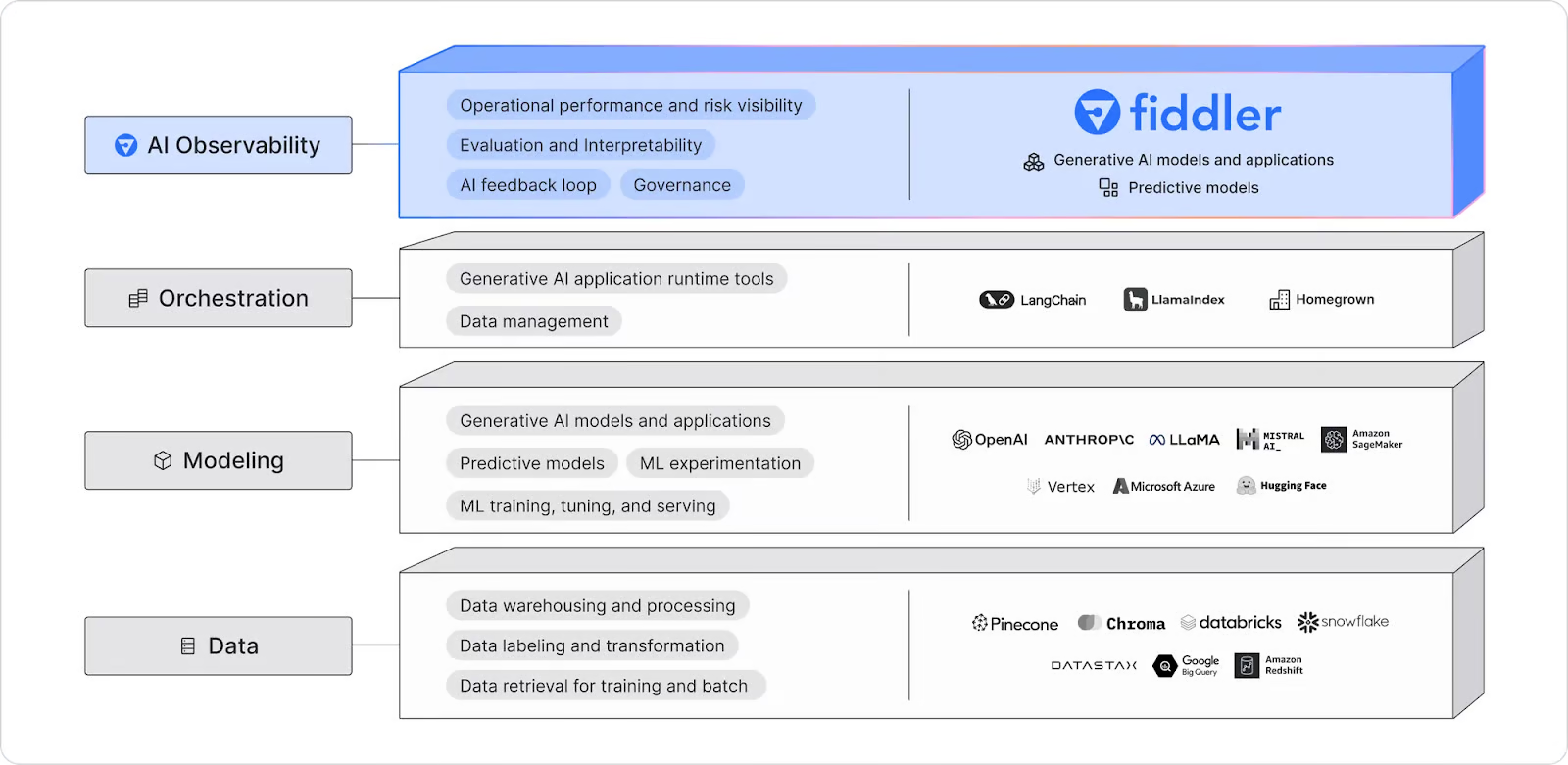

15. Fiddler IA

Fiddler AI es una plataforma de observabilidad de IA que supervisa, explica, analiza y mejora modelos LLM, modelos generativos de imágenes y aplicaciones generales de IA. Detecta y resuelve desviaciones de modelos, valores atípicos y problemas de integridad de los datos mediante alertas en tiempo real y depuración explicable basada en inteligencia artificial, lo que ayuda a los equipos a detectar y resolver los problemas a medida que se producen.

Diagrama de observabilidad de Fiddler AI. Fuente de la imagen: Observabilidad LLM | Fiddler AI

Ahora que ya conoces las distintas herramientas LLMOP, es hora de crear un proyecto LLM a partir de la lista de 12 proyectos LLM para todos los niveles que aparece en las entradas del blog.

Conclusión

El campo de las operaciones de aprendizaje automático (LLMOps) aún está en desarrollo y hay mucho ruido en el ámbito de la inteligencia artificial. En este artículo, hemos analizado las 15 mejores herramientas de LLMOps que se encuentran a la vanguardia en este campo.

Aunque hemos hablado de las herramientas esenciales y más populares para crear, evaluar e implementar aplicaciones de IA en la nube, aún quedan muchas categorías por abordar. Entre ellas se incluyen herramientas de machine learning para CI/CD, coordinación de flujos de trabajo, control de versiones de modelos y datos, Docker, Kubernetes y mucho más. Puedes obtener más información sobre estas categorías leyendo la entrada del blog «Las 25 herramientas de MLOps que debes conocer en 2026 ».

Si eres nuevo en LLMOps, ¡te recomendamos encarecidamente que empieces con la API de OpenAI y crees un producto mínimo viable!

Desarrolla hoy tus habilidades MLOps

Preguntas frecuentes

¿Puedes utilizar varias herramientas LLMOps juntas en un mismo proyecto, o es mejor limitarse a una sola?

Sí, puedes utilizar varias herramientas LLMOps a la vez, ya que suelen abordar diferentes aspectos del ciclo de vida de la IA. Por ejemplo, puedes utilizar una API para acceder a modelos de lenguaje (como OpenAI API), un marco de ajuste fino (como Transformers) y una herramienta de servicio (como BentoML) para el mismo proyecto. La integración de herramientas complementarias puede ayudar a optimizar los flujos de trabajo.

¿Cómo decides qué herramienta LLMOps utilizar para tu proyecto?

Depende de tus necesidades específicas. Si estás empezando desde cero y quieres acceder fácilmente a los modelos, una API como OpenAI podría ser ideal. Para los usuarios avanzados, los modelos de ajuste fino, como Transformers o Unsloth AI, son excelentes opciones. A la hora de elegir herramientas, ten en cuenta los objetivos de tu proyecto, tus conocimientos técnicos y los requisitos de escalabilidad.

¿Qué habilidades necesitas para utilizar eficazmente las herramientas LLMOps?

Necesitarás tener un buen conocimiento de los modelos de lenguaje grandes, la programación en Python y la infraestructura básica de la nube. También puede ser útil estar familiarizado con marcos como PyTorch o Hugging Face, especialmente si tienes pensado ajustar modelos o crear aplicaciones de IA complejas.

¿Hay que tener en cuenta algún coste al utilizar las herramientas LLMOps?

Muchas herramientas LLMOps ofrecen niveles gratuitos u opciones de código abierto, pero los costes pueden aumentar en función del uso, especialmente en el caso de las llamadas a la API, las implementaciones en la nube o los servicios gestionados. Revisa los modelos de precios y elige la herramienta que mejor se adapte a tu presupuesto y al tamaño de tu proyecto.

¿Cómo puedo supervisar el rendimiento de los modelos de IA que has implementado?

Herramientas como Evidently y Fiddler AI están diseñadas para la supervisión y observabilidad de modelos. Te permiten realizar un seguimiento de las métricas de rendimiento, detectar desviaciones en los datos y recibir alertas si la precisión de tu modelo disminuye. Estas herramientas ayudan a garantizar que tus modelos implementados sigan funcionando de manera eficaz en producción.

Soy un científico de datos certificado que disfruta creando aplicaciones de aprendizaje automático y escribiendo blogs sobre ciencia de datos. Actualmente me centro en la creación de contenidos, la edición y el trabajo con grandes modelos lingüísticos.