Kurs

Bild vom Autor

Wir haben es hinter uns, große Sprachmodelle (LLMs) zu verbessern, und konzentrieren uns jetzt darauf, sie zu nutzen, um KI-Anwendungen zu entwickeln, die Unternehmen helfen. Hier kommen Tools für große Sprachmodelloperationen (LLMOps) ins Spiel, die den Prozess der Erstellung vollautomatischer Systeme für die Entwicklung und Bereitstellung von LLM-Lösungen in der Produktion vereinfachen.

In diesem Artikel schauen wir uns verschiedene Tools an, wie LLM-APIs, Fine-Tuning-Frameworks, Tools zur Nachverfolgung von Experimenten, das LLM-Integrationsökosystem, Vektorsuchtools, Model-Serving-Frameworks, Bereitstellungsplattformen und Observability-Tools. Jedes Tool ist super in dem, was es macht, und wurde entwickelt, um bestimmte Probleme im Zusammenhang mit LLMs zu lösen.

Was ist LLMOps?

LLMOps ist ein aufstrebender Bereich, der sich mit dem operativen Management großer Sprachmodelle in Produktionsumgebungen beschäftigt. Im Grunde ist es MLOps (Machine Learning Operations), das auf Sprach- und andere multimodale Modelle spezialisiert ist.

Mach den Kurs „Master Large Language Models (LLMs) Concepts“, um mehr über LLM-Anwendungen, Trainingsmethoden, ethische Überlegungen und die neuesten Forschungsergebnisse zu erfahren.

LLMOps deckt den ganzen Lebenszyklus großer Sprachmodelle ab, also Daten sammeln, Modelle trainieren oder feinabstimmen, testen und validieren, integrieren, einsetzen, optimieren, überwachen und warten sowie zusammenarbeiten. Durch die Strukturierung von Projekten und die Automatisierung von Prozessen hilft dir LLMOps dabei, Fehler zu reduzieren und KI-Anwendungen effizient zu skalieren, sodass die Modelle robust sind und den Anforderungen der Praxis gerecht werden.

Kurz gesagt, mit den LLMOps-Tools kannst du ein automatisiertes System aufbauen, das Daten sammelt, das Modell darauf optimiert, die Leistung des Modells verfolgt, es mit externen Daten integriert, die KI-App erstellt, sie in der Cloud bereitstellt und die Metriken und die Leistung des Modells in der Produktion beobachtet.

Der Lernpfad „Entwicklung großer Sprachmodelle“ besteht aus vier Kursen, die dir dabei helfen, ein solides Fundament darüber aufzubauen, wie LLM funktionieren und wie du vortrainierte LLMs feinabstimmen kannst.

Schauen wir uns jetzt mal die besten LLMOps-Tools an, die es gerade gibt.

API

Du kannst über API-Aufrufe auf Sprach- und Einbettungsmodelle zugreifen. Du musst weder das Modell bereitstellen noch den Server warten. Du musst lediglich einen API-Schlüssel bereitstellen und kannst dann sofort mit den hochmodernen Modellen arbeiten.

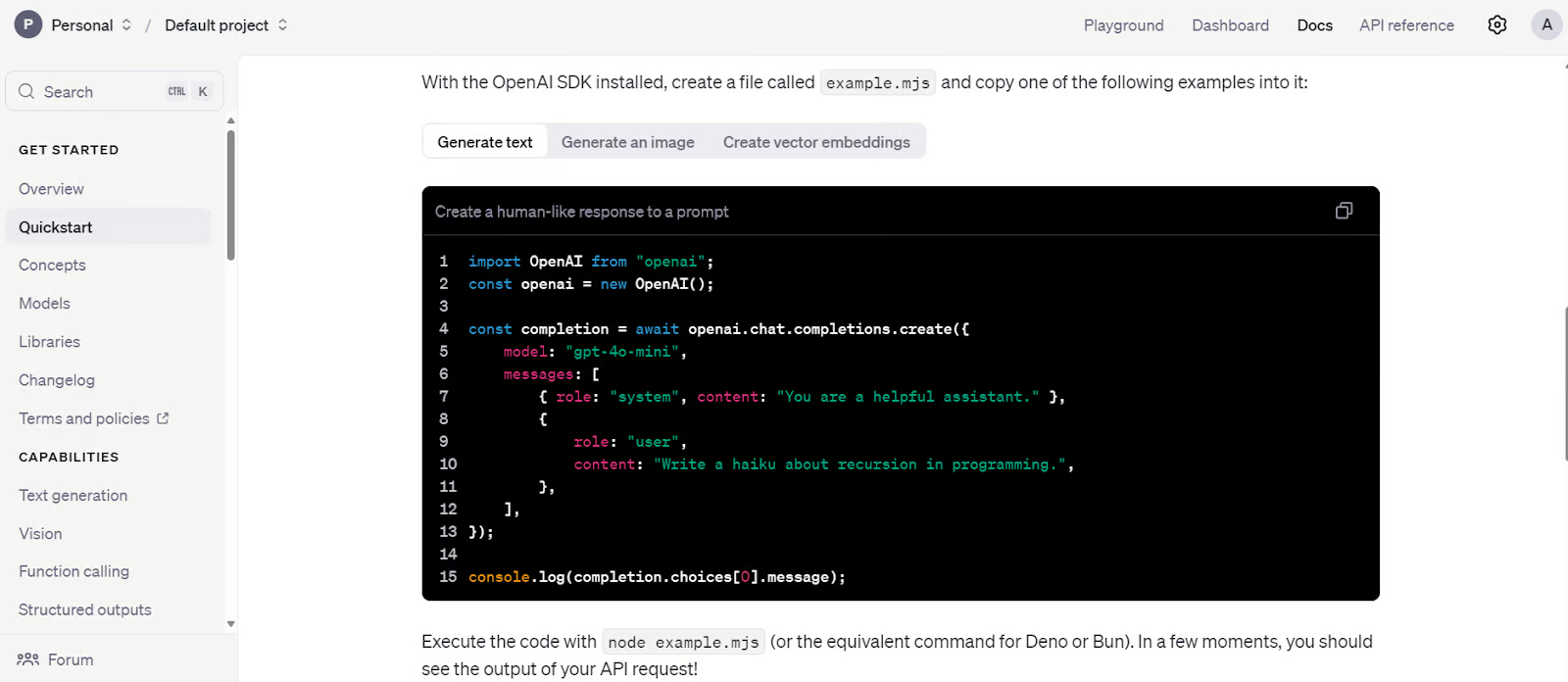

1. OpenAI-API

OpenAI bietet API-Zugriff auf fortschrittliche LLM-Modelle wie GPT-4o und o1. Diese Modelle kannst du über ein Python-Paket oder einen CURL-Befehl nutzen.

Die API ist super für Startups, die kein technisches Team haben, um Modelle in der Produktion anzupassen oder einzusetzen. Es bietet Zugriff auf Sprachmodelle, multimodale Modelle, Funktionsaufrufe, strukturierte Ausgaben und Feinabstimmungsoptionen. Außerdem kannst du Einbettungsmodelle nutzen, um deine eigene Vektordatenbank zu erstellen. Kurz gesagt, es bietet ein umfassendes, kostengünstiges KI-Ökosystem.

Lerne, wie du die OpenAI Python API nutzen kannst, um auf die neuesten LLMs zuzugreifen, indem du dem Tutorial „ “ zur GPT-4o API folgst: Erste Schritte mit der API von OpenAI.

Schnellstart-Code für die OpenAI-API. Bildquelle: Schnellstart-Tutorial – OpenAI-API

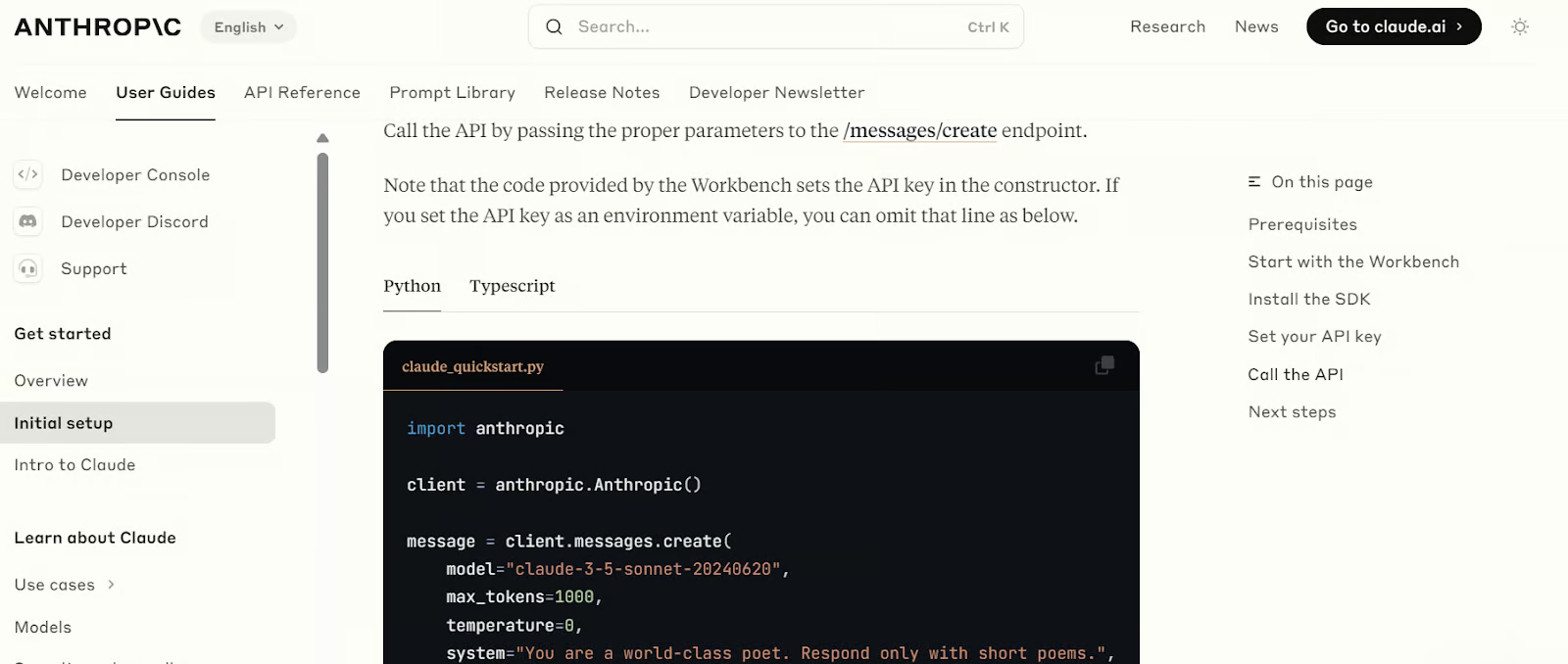

2. Anthropic-API

Die Anthropic API ist ähnlich wie die OpenAI API und bietet Zugriff auf verschiedene Sprach- und Einbettungsmodelle. Mit diesen Modellen kann man RAG-Anwendungen erstellen, Tools integrieren, Webseiten abrufen, Bildverarbeitungsmodelle nutzen und KI-Agenten entwickeln. Mit der Zeit will Anthropic alle Tools bereitstellen, die man braucht, um voll funktionsfähige KI-Anwendungen zu entwickeln und einzusetzen.

Genau wie die OpenAI-API hat es Sicherheitsvorkehrungen und Tools, um die Leistung des Modells zu checken.

Lerne, wie du die Claude-API nutzen kannst, um auf die besten LLMs zuzugreifen, indem du dem Tutorial „ “ zur Claude Sonnet 3.5 API folgst: Erste Schritte mit der API von Anthropic.

Schnellstart-Code für die Anthropic-API. Bildquelle: Erste Einrichtung – Anthropic

Feinabstimmung

Mit Python kannst du die großen Sprachmodelle auf einem benutzerdefinierten Datensatz feinabstimmen, um den Stil, die Aufgabe und die Funktionalität des Modells an bestimmte Anforderungen anzupassen.

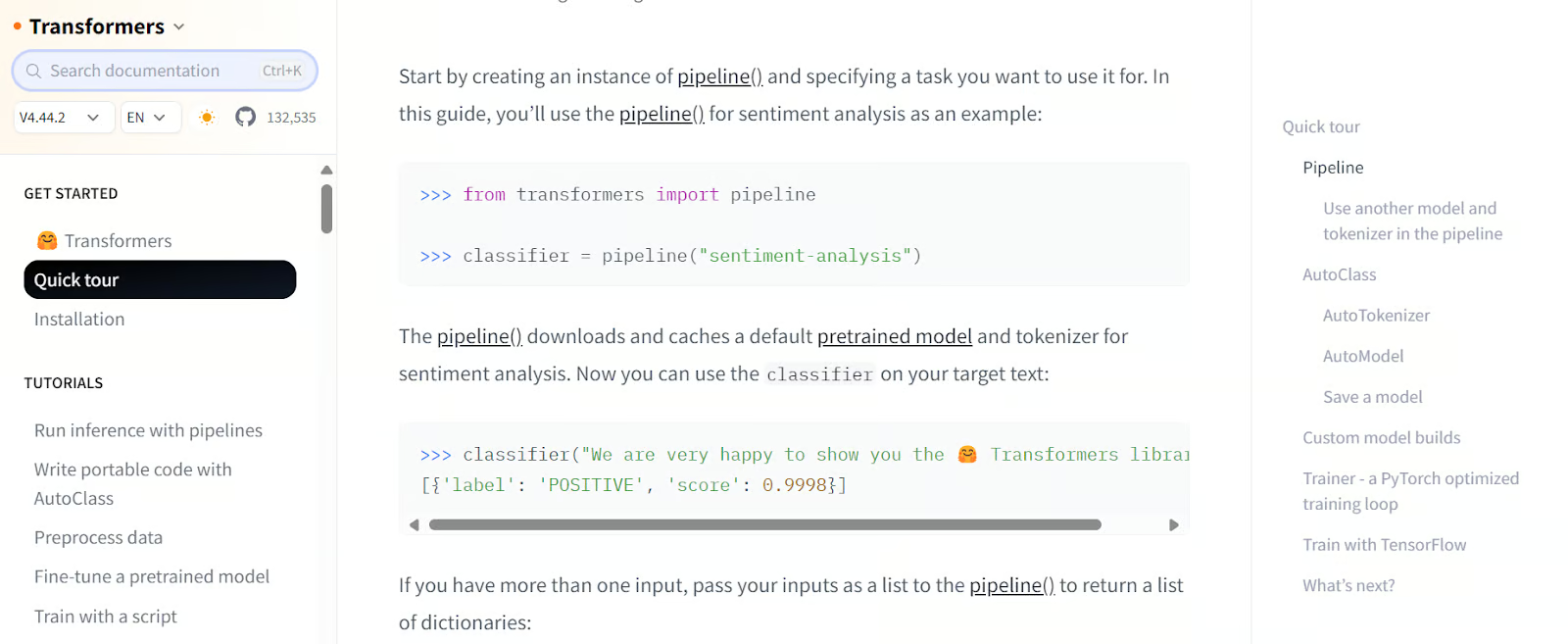

3. Transformatoren

Transformers von Hugging Face ist ein bekanntes Framework in der KI-Community und -Branche. Es wird oft benutzt, um auf Modelle zuzugreifen, LLMs mit begrenzten Ressourcen zu optimieren und Modelle zu speichern. Es bietet ein komplettes Ökosystem für alles, vom Laden von Daten bis zur Bewertung von LLMs.

Mit Transformers kannst du Datensätze und Modelle laden, Daten bearbeiten, Modelle mit benutzerdefinierten Argumenten erstellen, Modelle trainieren und sie in die Cloud übertragen. Später kannst du diese Modelle mit nur wenigen Klicks auf einem Server bereitstellen.

Mach den Kurs „Einführung in LLMs in Python“, um mehr über die LLM-Landschaft, die Transformer-Architektur, vortrainierte LLMs und die Integration von LLMs zur Lösung realer Probleme zu erfahren.

Transformers-Schnellstartcode. Bildquelle: Schnellübersicht (huggingface.co)

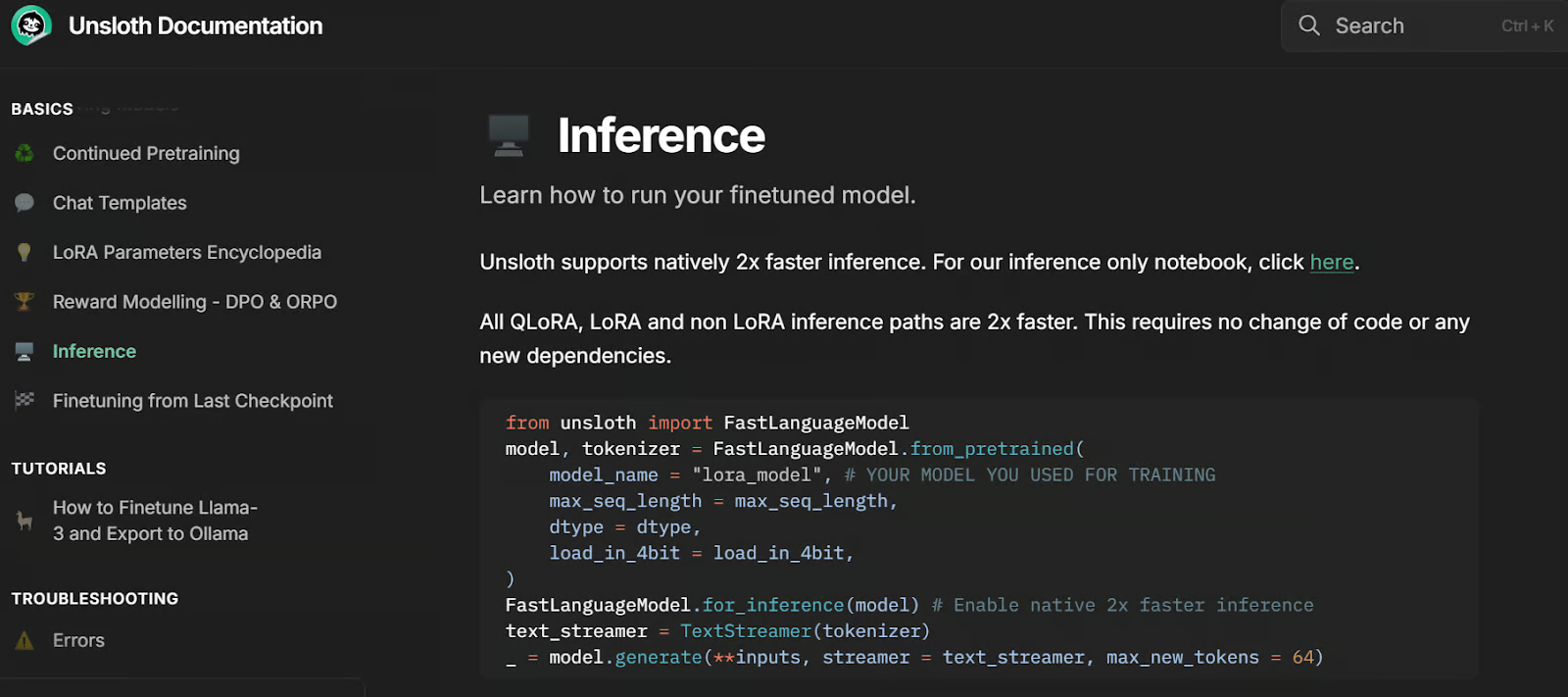

4. Unsloth KI

Unsloth AI ist ein Python-Framework zum Feinabstimmen und Zugreifen auf große Sprachmodelle. Es hat eine einfache API und ist doppelt so schnell wie Transformers.

Es basiert auf der Transformers-Bibliothek und hat zusätzliche Tools, die das Feintuning großer Sprachmodelle mit begrenzten Ressourcen einfacher machen. Eine coole Sache an Unsloth ist, dass man Modelle mit nur einer Zeile Code im vLLM- und GGUF-kompatiblen Format speichern kann. Man muss also keine Bibliotheken wie llama.cpp installieren und einrichten, weil alles automatisch läuft.

Entferne den Inferenzcode. Bildquelle: Inferenz | Unsloth-Dokumentation

Experimentverfolgung

Erstelle einen Lernpfad und bewerte die Modellleistung während des Trainings und vergleiche die Ergebnisse.

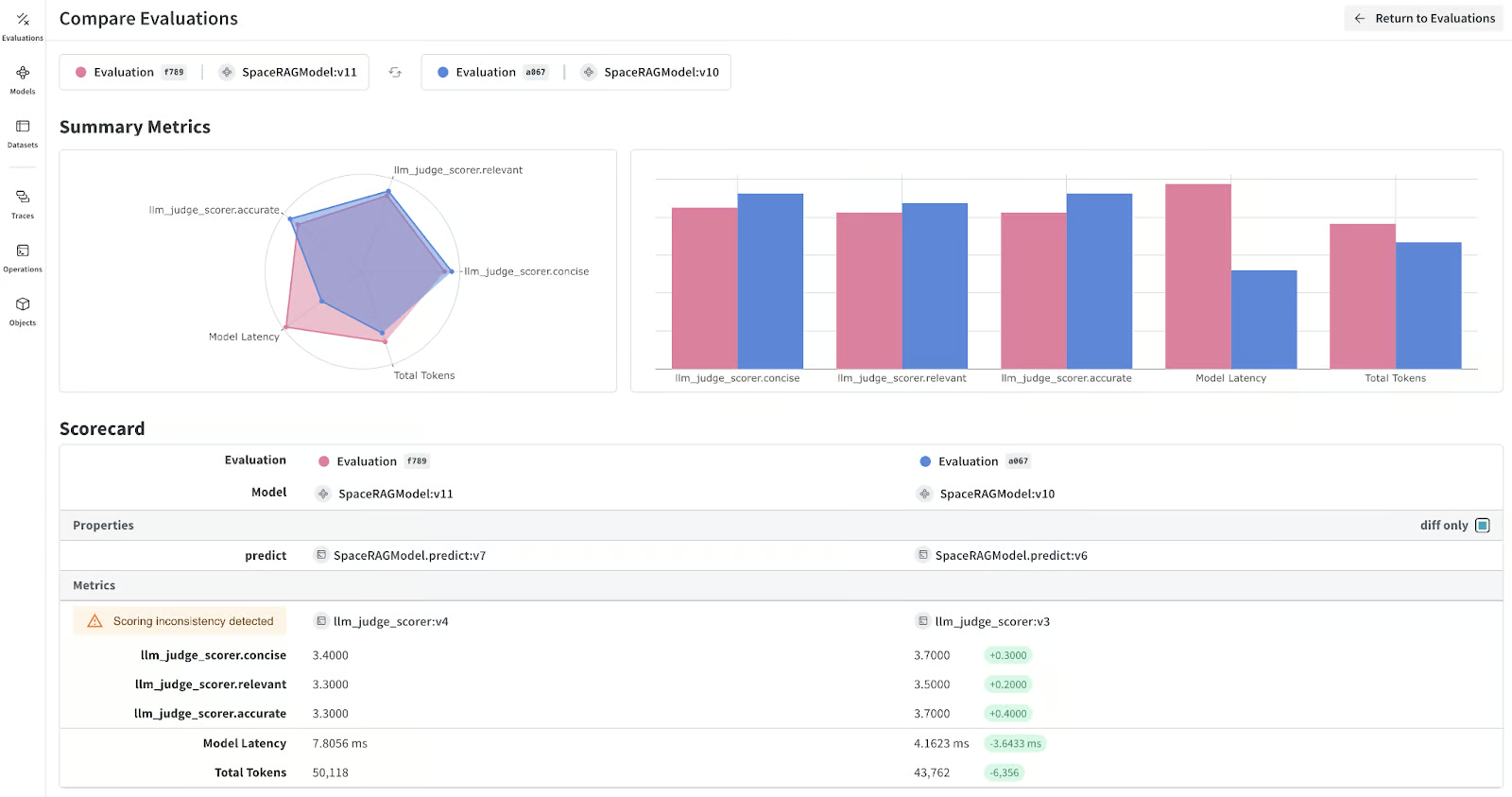

5. Gewichte & Verzerrungen

Mit Weights & Biases kannst du die Leistung des Modells während und nach der Feinabstimmung verfolgen, um die Effektivität zu checken. Es hilft auch dabei, RAG-Anwendungen zu verfolgen und LLMs zu überwachen und zu debuggen.

Die Plattform lässt sich super mit verschiedenen Frameworks und Tools verbinden, wie zum Beispiel Transformers, LangChain, PyTorch und Keras. Ein großer Vorteil von Weights & Biases ist das super anpassbare Dashboard, mit dem du Modellbewertungsberichte erstellen und verschiedene Modellversionen vergleichen kannst.

Lerne, wie du deine Experimente im Bereich maschinelles Lernen mit Weights & Biases strukturieren, protokollieren und analysieren kannst, indem du dem Tutorial „ “ (Experimente im Bereich maschinelles Lernen mit Weights & Biases strukturieren, protokollieren und analysieren) folgst: Eine Einführung in Gewichte und Verzerrungen.

LLM-Modellmetriken. Bildquelle: wandb.ai

LLM-Integration

Integriere LLM mit einer externen Datenbank, einer privaten Datenbank und einer Websuche. Du kannst sogar die ganze KI-Anwendung mit diesen Frameworks erstellen und bereitstellen. Kurz gesagt, diese Tools sind echt wichtig, um komplexe LLM-basierte Anwendungen zu entwickeln, die du in der Cloud einsetzen kannst.

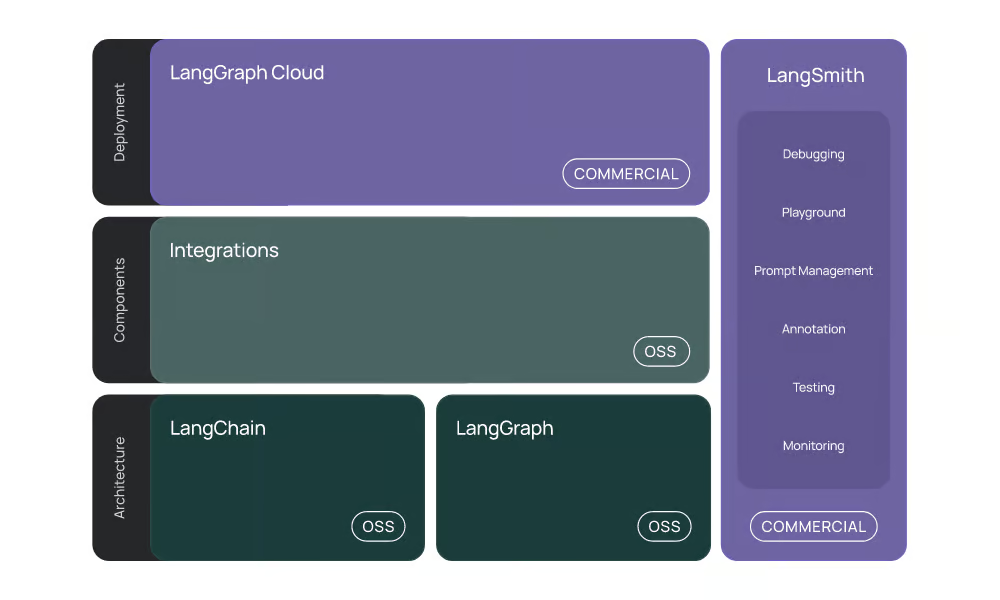

6. Langchain

LangChain ist ein beliebtes Tool zum Erstellen von KI-Anwendungen mit LLMs. Mit nur ein paar Zeilen Code kannst du direkt in Jupyter-Notebooks kontextbezogene RAG-Chatbots entwickeln.

LangChain hat jetzt ein komplettes LLM-Ökosystem:

- Integration: Es unterstützt die Integration mit verschiedenen KI-APIs, Chat-Modellen, Einbettungsmodellen, Dokumentenladern, Vektorspeichern und Tools.

- LangChain: Es bringt verschiedene Integrationstools und LLMs zusammen, um KI-Anwendungen zu entwickeln.

- LangGraph: Es ist dafür gemacht, zustandsbehaftete Multi-Akteur-Anwendungen mit LLMs zu entwickeln, indem Schritte als Kanten und Knoten in einem Graphen dargestellt werden.

- LangGraph Cloud and LangSmith: Mit diesen kommerziellen Produkten kannst du Managed Services nutzen, um LLM-basierte Anwendungen zu erstellen und bereitzustellen.

LangChain macht die Entwicklung von LLM-basierten Anwendungen einfacher, indem es Tools, Komponenten und Schnittstellen bereitstellt, die den Prozess optimieren.

Mach den Kurs „Entwickeln von LLM-Anwendungen mit LangChain”, um zu lernen, wie man KI-gestützte Anwendungen mit LLMs, Prompts, Chains und Agenten in LangChain erstellt.

Das LangChain-Ökosystem. Bildquelle: Einführung | 🦜️🔗 LangChain

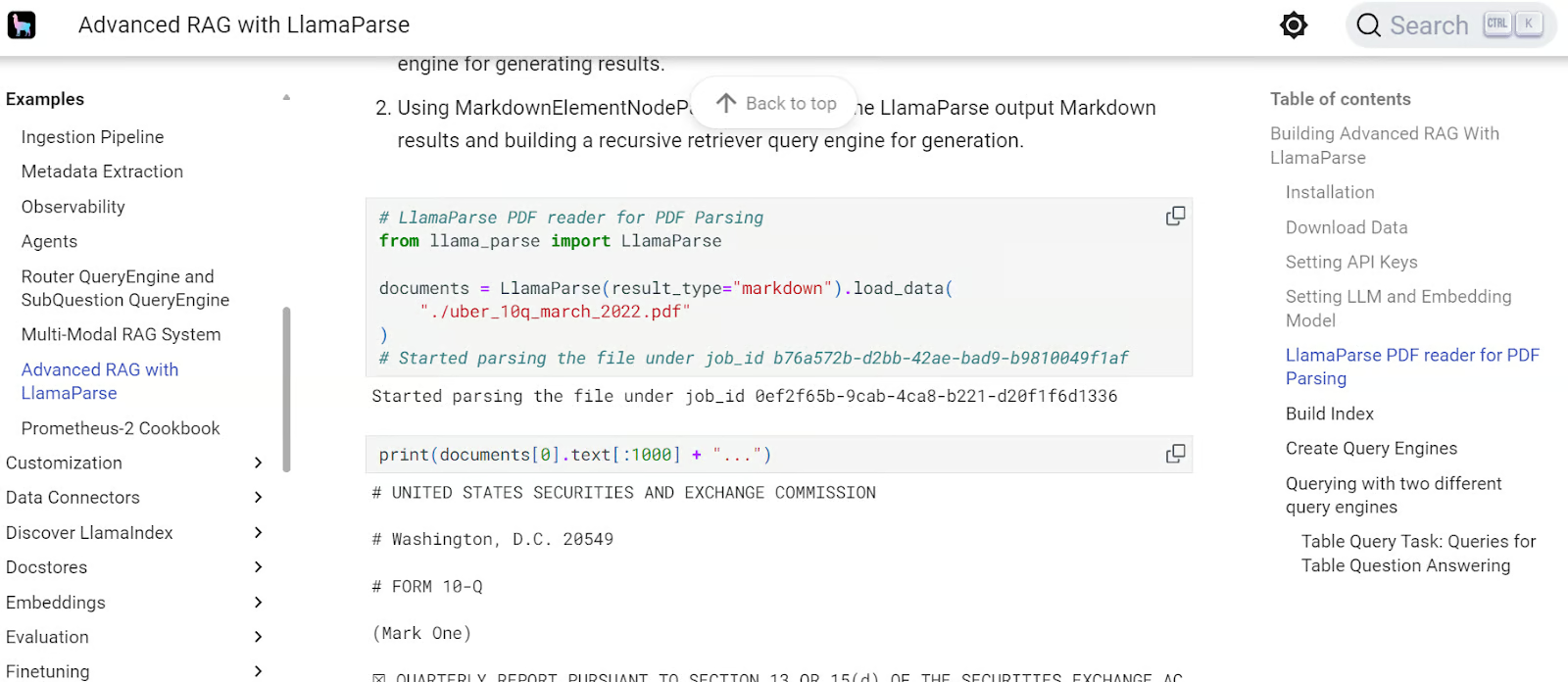

7. LlamaIndex

LlamaIndex ist ähnlich wie LangChain, macht es aber einfacher, RAG-Anwendungen zu erstellen. Mit nur ein paar Zeilen Code kannst du RAG-Anwendungen mit Verlauf erstellen.

LlamaIndex bietet umfassende API- und Vektorspeicher-Integrationen, die die Entwicklung komplexer, hochmoderner LLM-Anwendungen ermöglichen. Es hat auch einen Managed Service namens LlamaCloud, mit dem man KI-Anwendungen einfach hosten kann.

Lerne, wie du private und domänenspezifische Daten mit natürlicher Sprache erfassen, verwalten und abrufen kannst, indem du dem LlamaIndex „ ” folgst: Ein Daten-Framework für Anwendungen, die auf großen Sprachmodellen (LLMs) basieren Tutorial „ ”.

LlamaIndex-Vorschau RAG-Anleitung. Bildquelle: Erweitertes RAG mit LlamaParse – LlamaIndex

Vektorsuche

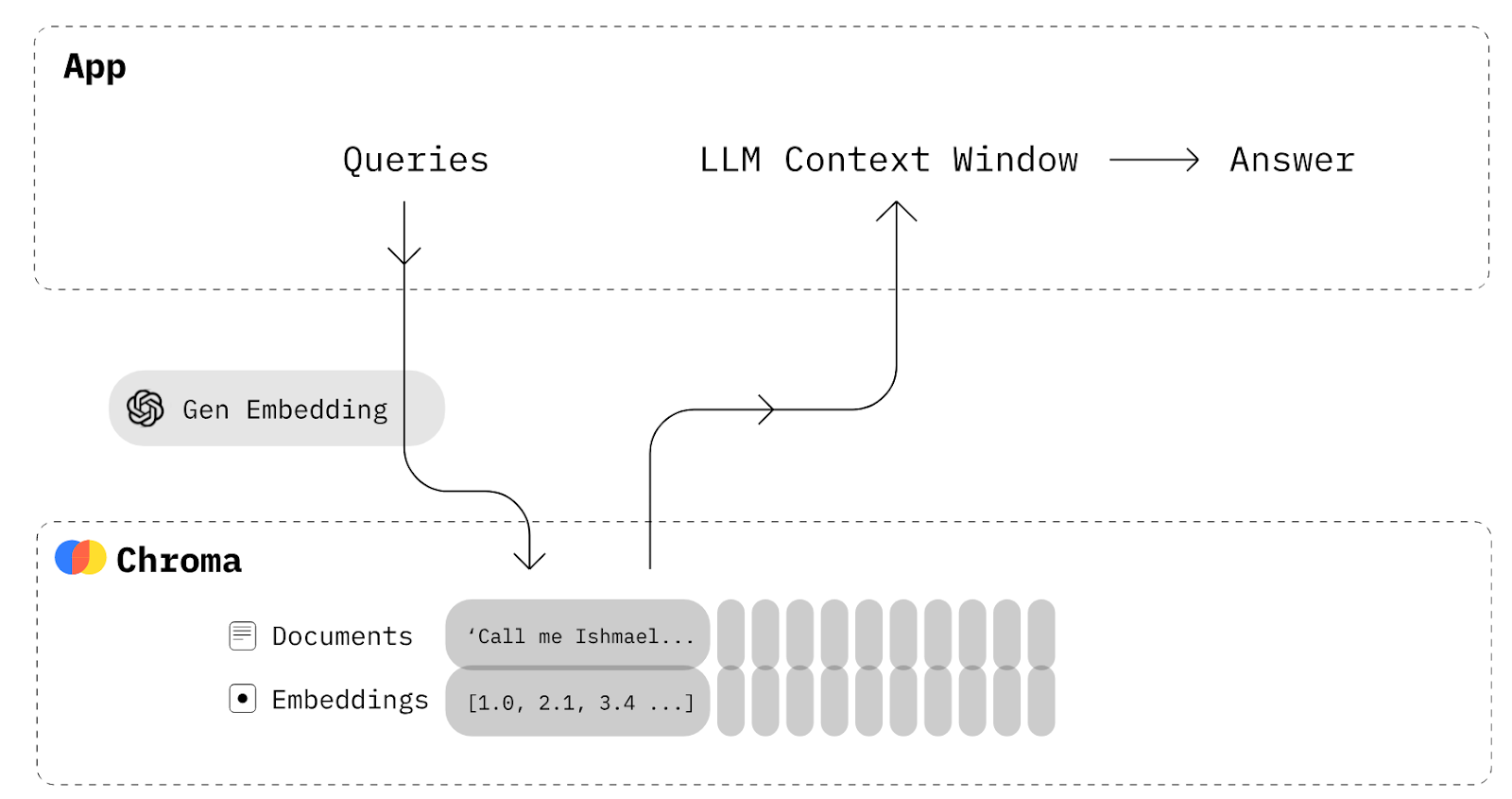

Vektorsuchwerkzeuge bieten starke Speicher- und Abrufmöglichkeiten, die für die Entwicklung von RAG-Anwendungen (Retrieval-Augmented Generation) echt wichtig sind. Mit diesen Tools kann man verschiedene Datentypen wie Text, Bilder und Audio in Einbettungen umwandeln, die dann in Vektordatenbanken gespeichert werden.

8. Chroma

Chroma ist eine KI-native Open-Source-Vektordatenbank. Es macht es einfach, LLM-Apps zu entwickeln, indem Wissen, Fakten und Fähigkeiten leicht integriert werden können.

Wenn du eine einfache RAG-Anwendung erstellen willst, mit der du deine Dokumente als Einbettungen speichern und dann abrufen kannst, um sie mit Eingabeaufforderungen zu kombinieren und so dem Sprachmodell mehr Kontext zu geben, brauchst du LangChain nicht. Du brauchst nur eine Chroma-Datenbank, um die Dokumente zu speichern und abzurufen.

Chroma-DB-Diagramm. Bildquelle: Chroma Docs (trychroma.com)

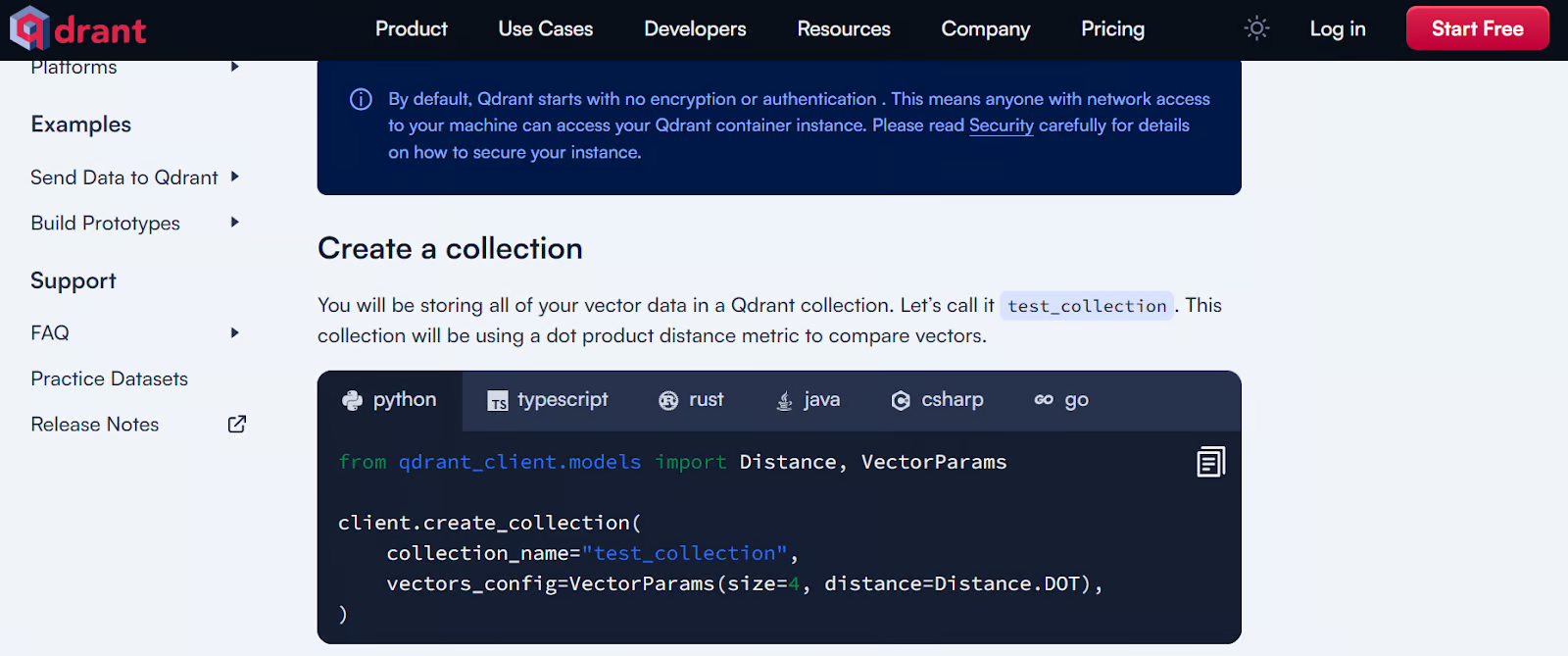

9. Qdrant

Qdrant ist eine beliebte Open-Source-Vektordatenbank und Ähnlichkeitssuchmaschine, die hochdimensionale Vektoren verarbeitet. Es bietet lokale, Cloud- und Hybrid-Lösungen und ist damit super flexibel für verschiedene Einsatzzwecke.

Qdrant ist besonders gut für Sachen wie Retrieval-Augmented Generation, Anomalieerkennung, erweiterte Suche und Empfehlungssysteme. Die robuste API macht es einfach, Textdaten zu integrieren und zu verwalten, was es zu einem starken Tool für Entwickler macht, die vektorbasierte Suchfunktionen einbauen wollen.

Schau dir die 5 besten Vektordatenbanken für deinen speziellen Anwendungsfall an. Sie bieten eine einfache API und schnelle Leistung.

Qdrant-Beispiel für den Einstieg. Bildquelle: Lokaler Schnellstart – Qdrant

Bedienen

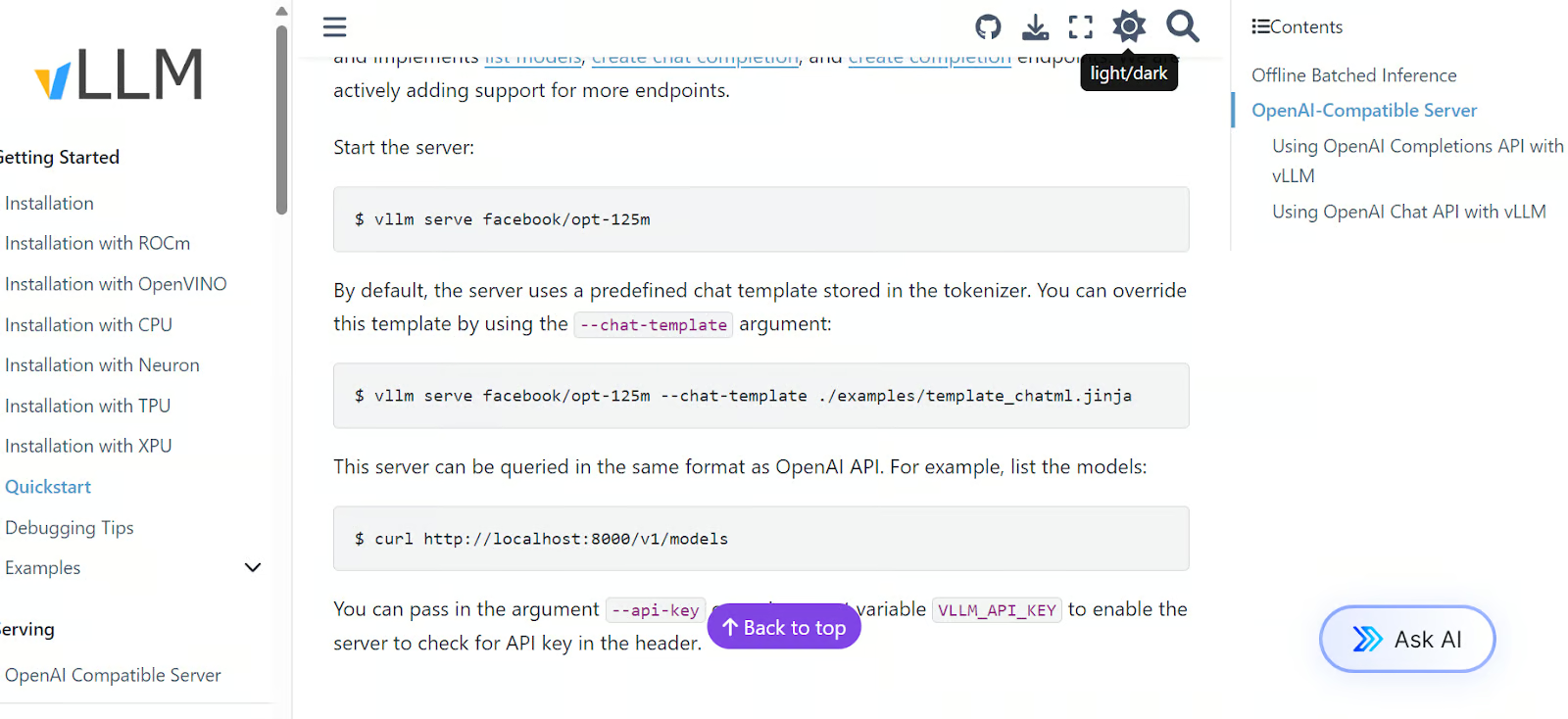

Ein wichtiger Teil deiner Anwendung ist eine Inferenz- und Serving-Engine mit hohem Durchsatz für LLMs, die mit vielen Rechenressourcen wie GPUs, TPUs, XPUs und anderen kompatibel ist. Diese Tools funktionieren auch mit OpenAI-kompatiblen Servern, sodass du die API von OpenAI nutzen kannst, um nahtlos auf das bereitgestellte Modell zuzugreifen.

10. vLLM

vLLM ist eine coole Open-Source-Bibliothek, die für effiziente Inferenz und Bereitstellung großer Sprachmodelle entwickelt wurde. Es geht die Probleme beim Einsatz von LLMs an, wie zum Beispiel hoher Speicherverbrauch und Rechenkosten, indem es innovative Speicherverwaltungstechniken und dynamische Batching-Strategien nutzt.

Eine der besten Funktionen von vLLM ist der PagedAttention-Algorithmus, der den Durchsatz deutlich verbessert und Speicherplatzverschwendung reduziert. Es bietet bis zu 24-mal höheren Durchsatz als herkömmliche Lösungen wie Hugging Face Transformers.

Schnellstart-Beispiel für vLLM. Bildquelle: Schnellstart – vLLM

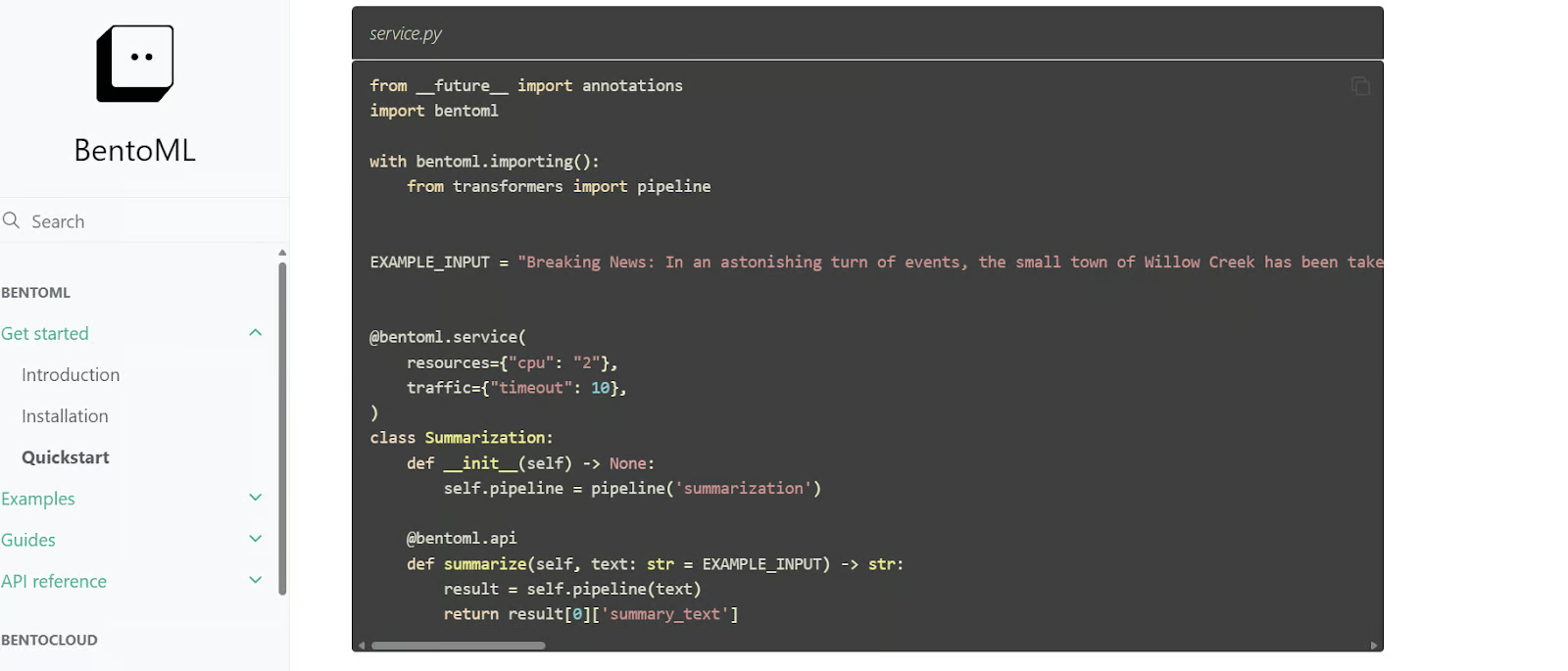

11. BentoML

BentoML ist eine Python-Bibliothek zum Erstellen und Bereitstellen von LLMs, die mehr Anpassungsmöglichkeiten für die Entwicklung von KI-Anwendungen bietet als vLLM. Es beinhaltet BentoCloud, einen verwalteten Dienst, mit dem man Modelle einfach in der Cloud bereitstellen und überwachen kann. Es gibt eine kostenlose Stufe, um loszulegen.

BentoML macht viele komplizierte Schritte beim Modell-Deployment automatisch und spart dadurch viel Zeit beim Übergang von der Entwicklung zur Produktion.

BentoML-Schnellstartcode. Bildquelle: Schnellstart – BentoML

Einsatz

Du kannst dein LLM entweder direkt in der Cloud bereitstellen oder eine integrierte KI-Anwendung erstellen und diese dann bereitstellen. Dafür kannst du dich für einen beliebigen großen Cloud-Dienstleister entscheiden. Die Tools unten sind aber extra für LLMs und KI-Implementierungen gemacht und bieten eine einfachere und effizientere Implementierungsfunktion.

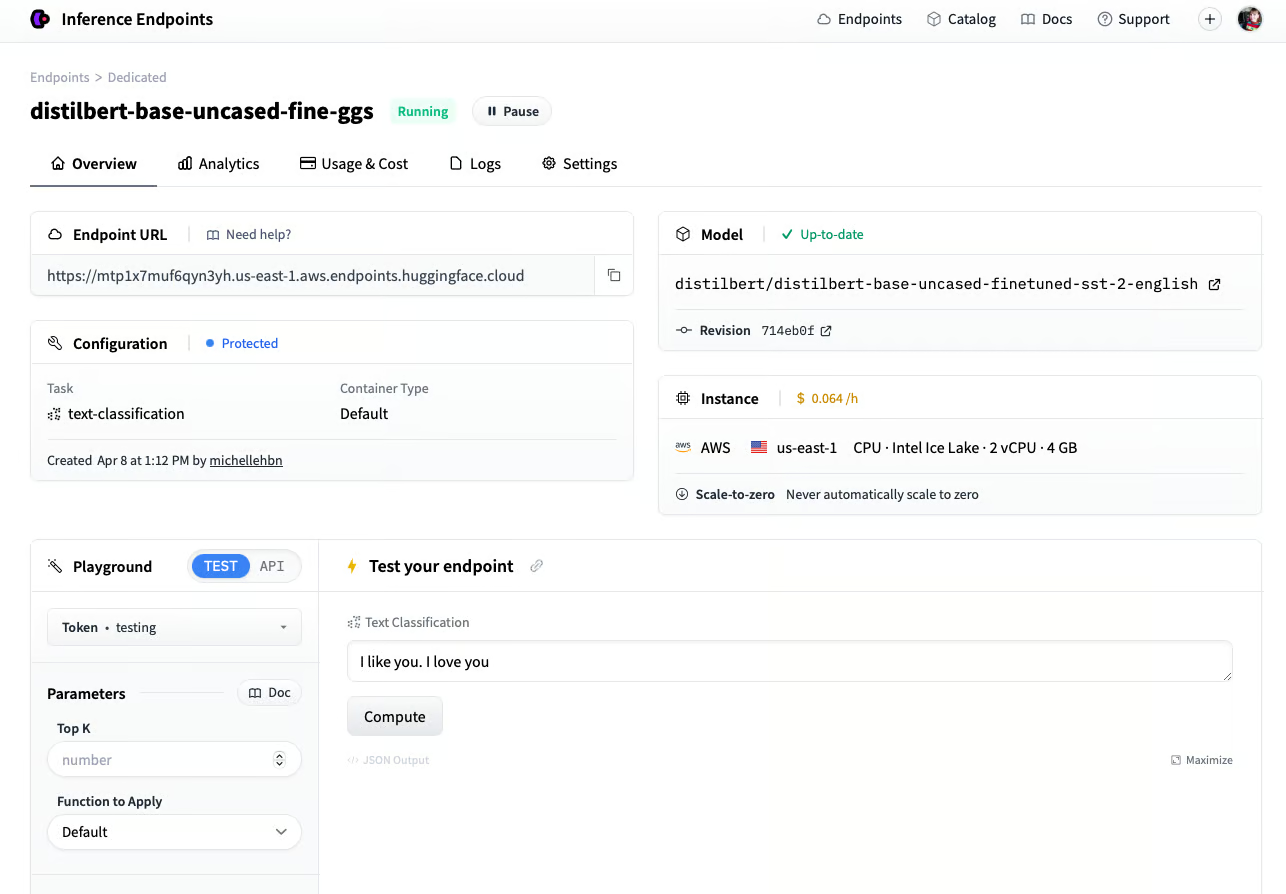

12. Inferenz-Endpunkte

Wenn du ein Fan des Hugging Face-Ökosystems bist, wirst du Hugging Face Inference Endpoints lieben. Mit diesem Bereitstellungsdienst kannst du jedes Modell aus dem Hugging Face Model Hub, auch private Modelle, für den Produktionsgebrauch nutzen. Wähl einfach deinen Cloud-Dienstleister und den Rechner-Typ aus, und schon in wenigen Minuten ist dein Modell einsatzbereit.

Inference Endpoints hat ein eigenes Dashboard, mit dem du Endpunkte erstellen und Modelle in der Produktion überwachen kannst. Damit bekommst du eine sichere und effiziente Lösung für die Bereitstellung von Machine-Learning-Modellen.

Ein Modell über den Hugging Face Inference-Endpunkt einsetzen. Bildquelle: Erstelle einen Endpunkt (huggingface.co)

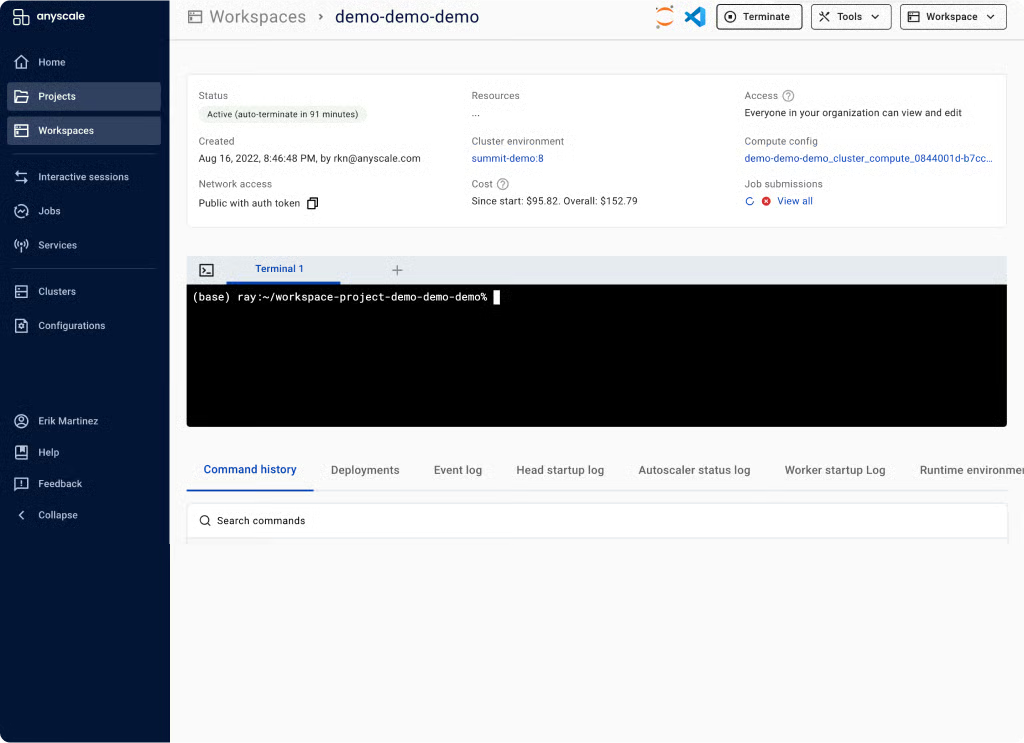

13. Anyscale

Anyscale nutzt Ray Serve im Hintergrund, um schnelle Modellinferenz mit hohem Durchsatz zu bieten. Als komplett verwaltete, skalierbare Rechenplattform kannst du mit Anyscale Daten laden, Modelle trainieren, Modelle bewerten und bereitstellen, Dienste verwalten, Modelle überwachen und den Zugriff kontrollieren. Es ist eine End-to-End-MLOps-Plattform, die auf dem Open-Source-Ökosystem Ray basiert und den ganzen Lebenszyklus von KI-Anwendungen vereinfacht.

Anyscale-Arbeitsbereich. Bildquelle: Einheitliche Rechenplattform für KI- und Python-Apps | Anyscale

Beobachtbarkeit

Sobald deine LLMs eingesetzt sind, ist es super wichtig, ihre Leistung im Betrieb im Auge zu behalten. Die Observability-Tools checken dein Modell automatisch in der Cloud und sagen dir Bescheid, wenn die Leistung stark nachlässt.

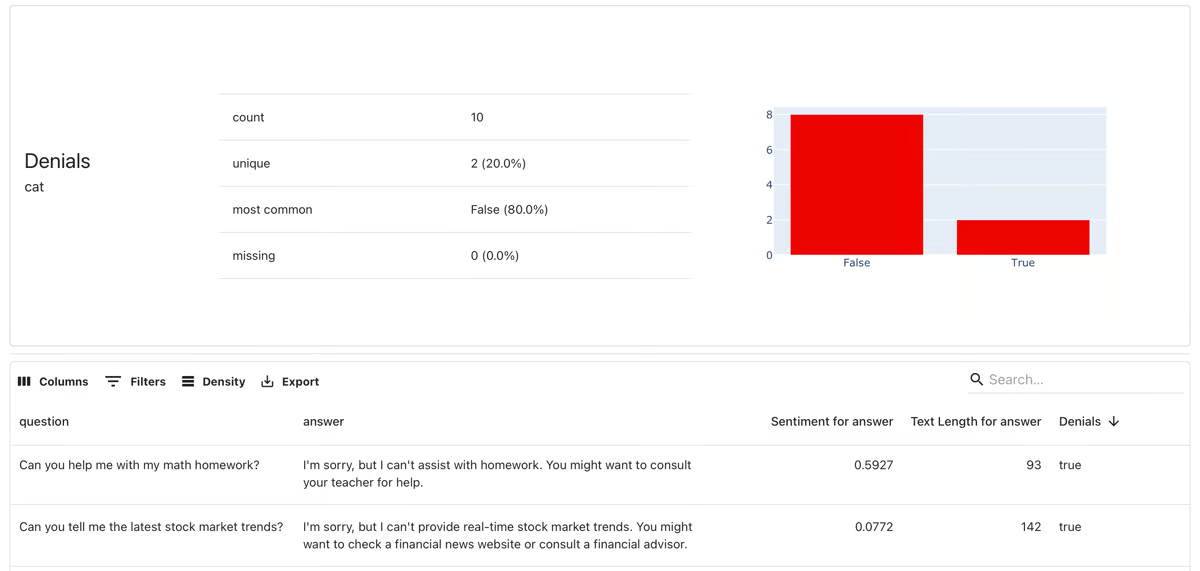

14. Offensichtlich

Evidently ist ein Open-Source-Framework für ML und MLOps-Beobachtbarkeit. Damit kannst du ML-Anwendungen und Datenpipelines bewerten, testen und überwachen. Es unterstützt allgemeine Vorhersagemodelle sowie generative KI-Anwendungen.

Mit über 100 eingebauten Metriken bietet es Datenabweichungserkennung und ML-Modellbewertung. Es kann auch Daten und Modellbewertungsberichte, automatisierte Testsuiten und Modellüberwachungs-Dashboards erstellen.

Offensichtlich Modellüberwachung. Bildquelle: evidentlyai.com

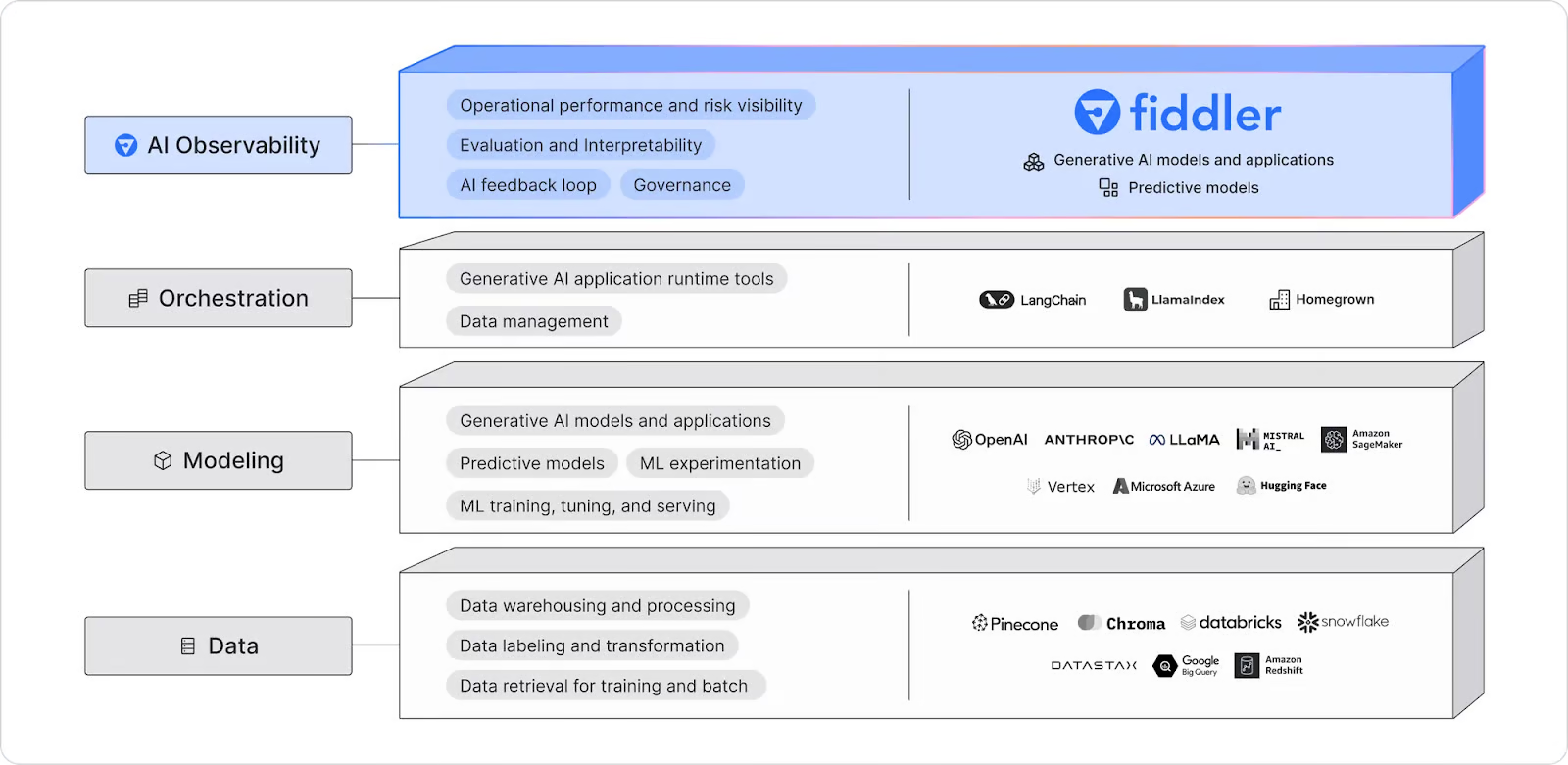

15. Fiddler KI

Fiddler AI ist eine KI-Beobachtungsplattform, die LLM-Modelle, bildgenerierende Modelle und allgemeine KI-Anwendungen überwacht, erklärt, analysiert und verbessert. Es erkennt und behebt Modellabweichungen, Ausreißer und Probleme mit der Datenintegrität durch Echtzeitwarnungen und verständliche KI-gestützte Fehlerbehebung, was Teams dabei hilft, Probleme sofort zu erkennen und zu lösen.

Fiddler AI-Beobachtbarkeitsdiagramm. Bildquelle: LLM-Beobachtbarkeit | Fiddler AI

Jetzt, wo du verschiedene LLMOPs-Tools kennengelernt hast, ist es Zeit, ein LLM-Projekt aus der Liste der 12 LLM-Projekte für alle Niveaus aus den Blog-Beiträgen zu erstellen.

Fazit

Der Bereich LLMOps ist noch in der Entwicklung und im KI-Bereich gibt's viel Trubel. In diesem Artikel haben wir die 15 besten LLMOps-Tools vorgestellt, die gerade total angesagt sind.

Wir haben zwar wichtige und beliebte Tools zum Erstellen, Bewerten und Bereitstellen von KI-Anwendungen in der Cloud behandelt, aber viele Kategorien wurden noch nicht angesprochen. Dazu gehören Tools für maschinelles Lernen für CI/CD, Workflow-Orchestrierung, Modell- und Datenversionierung, Docker, Kubernetes und mehr. Mehr über diese Kategorien erfährst du im Blogbeitrag „Die 25 wichtigsten MLOps-Tools, die du 2026 kennen solltest ”.

Wenn du noch nicht mit LLMOps vertraut bist, ist es echt empfehlenswert, mit der OpenAI-API anzufangen und ein minimal funktionsfähiges Produkt zu entwickeln!

MLOps-Fähigkeiten heute aufbauen

FAQs

Kann ich mehrere LLMOps-Tools zusammen in einem Projekt nutzen oder sollte ich mich auf eins beschränken?

Ja, du kannst mehrere LLMOps-Tools zusammen nutzen, weil sie oft verschiedene Aspekte des KI-Lebenszyklus abdecken. Du kannst zum Beispiel eine API nutzen, um auf Sprachmodelle (wie die OpenAI API) zuzugreifen, ein Feinabstimmungs-Framework (wie Transformers) und ein Serving-Tool (wie BentoML) für dasselbe Projekt. Die Integration von Tools, die sich gut ergänzen, kann dabei helfen, Arbeitsabläufe zu optimieren.

Wie entscheide ich, welches LLMOps-Tool ich für mein Projekt nehmen soll?

Das hängt von deinen spezifischen Bedürfnissen ab. Wenn du ganz von vorne anfängst und einfach auf Modelle zugreifen willst, könnte eine API wie OpenAI genau das Richtige für dich sein. Für fortgeschrittene Nutzer sind Feinabstimmungsmodelle wie Transformers oder Unsloth AI eine super Wahl. Denk bei der Auswahl der Tools an deine Projektziele, dein technisches Know-how und die Anforderungen an die Skalierbarkeit.

Welche Fähigkeiten brauche ich, um LLMOps-Tools effektiv zu nutzen?

Du solltest dich gut mit großen Sprachmodellen, Python-Programmierung und grundlegender Cloud-Infrastruktur auskennen. Kenntnisse von Frameworks wie PyTorch oder Hugging Face können auch nützlich sein, vor allem wenn du vorhast, Modelle zu optimieren oder komplexe KI-Anwendungen zu entwickeln.

Gibt's irgendwelche Kosten, die man bei der Nutzung von LLMOps-Tools beachten muss?

Viele LLMOps-Tools haben kostenlose Tarife oder Open-Source-Optionen, aber die Kosten können je nach Nutzung steigen, vor allem bei API-Aufrufen, Cloud-Bereitstellungen oder Managed Services. Schau dir die Preismodelle an und such dir das beste Tool für dein Budget und die Größe deines Projekts aus.

Wie kann ich die Leistung meiner eingesetzten KI-Modelle checken?

Tools wie Evidently und Fiddler AI sind für die Modellüberwachung und Beobachtbarkeit gedacht. Damit kannst du Leistungskennzahlen verfolgen, Datenabweichungen erkennen und Warnmeldungen bekommen, wenn die Genauigkeit deines Modells nachlässt. Diese Tools helfen dir dabei, sicherzustellen, dass deine eingesetzten Modelle in der Produktion weiterhin effektiv funktionieren.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.