Cours

Image par l'auteur

Nous avons dépassé le stade de l'amélioration des grands modèles linguistiques (LLM) et nous nous concentrons désormais sur leur utilisation pour créer des applications d'IA qui aident les entreprises. C'est là qu'interviennent les outils LLMOps (Large Language Model Operations), qui simplifient le processus de création de systèmes entièrement automatisés pour la conception et le déploiement de solutions LLM en production.

Dans cet article, nous examinerons différents outils tels que les API LLM, les cadres de réglage fin, les outils de suivi des expériences, l'écosystème d'intégration LLM, les outils de recherche vectorielle, le cadre de service de modèles, les plateformes de déploiement et les outils d'observabilité. Chaque outil est remarquable dans son domaine et est conçu pour résoudre des problèmes spécifiques liés aux LLM.

Qu'est-ce que LLMOps ?

LLMOps est un domaine émergent qui se concentre sur la gestion opérationnelle des grands modèles linguistiques dans les environnements de production. Il s'agit essentiellement de MLOps (opérations d'apprentissage automatique) spécialisées dans les modèles linguistiques et autres modèles multimodaux.

Suivez le cours « Master Large Language Models (LLMs) Concepts » pour découvrir les applications des LLM, les méthodologies de formation, les considérations éthiques et les dernières recherches dans ce domaine.

LLMOps englobe l'ensemble du cycle de vie des grands modèles linguistiques, y compris la collecte de données, l'entraînement ou le réglage fin des modèles, les tests et la validation, l'intégration, le déploiement, l'optimisation, la surveillance et la maintenance, ainsi que la collaboration. En structurant les projets et en automatisant les processus, LLMOps vous aide à réduire les erreurs et à adapter efficacement les applications d'IA, garantissant ainsi que les modèles sont robustes et capables de répondre aux exigences du monde réel.

En résumé, les outils LLMOps vous assistent dans la création d'un système automatisé qui collecte des données, ajuste le modèle en conséquence, suit les performances du modèle, l'intègre à des données externes, crée l'application IA, la déploie dans le cloud et observe les métriques et les performances du modèle en production.

Le cursus de compétences « Développement de grands modèles linguistiques » comprend quatre cours qui vous aideront à acquérir des bases solides sur le fonctionnement des LLM et sur la manière d'affiner les LLM pré-entraînés.

Maintenant, examinons les principaux outils LLMOps disponibles à l'heure actuelle.

API

Accédez aux modèles linguistiques et d'intégration à l'aide d'appels API. Il n'est pas nécessaire de déployer le modèle ou de gérer le serveur ; il suffit de fournir une clé API et de commencer à utiliser les modèles de pointe.

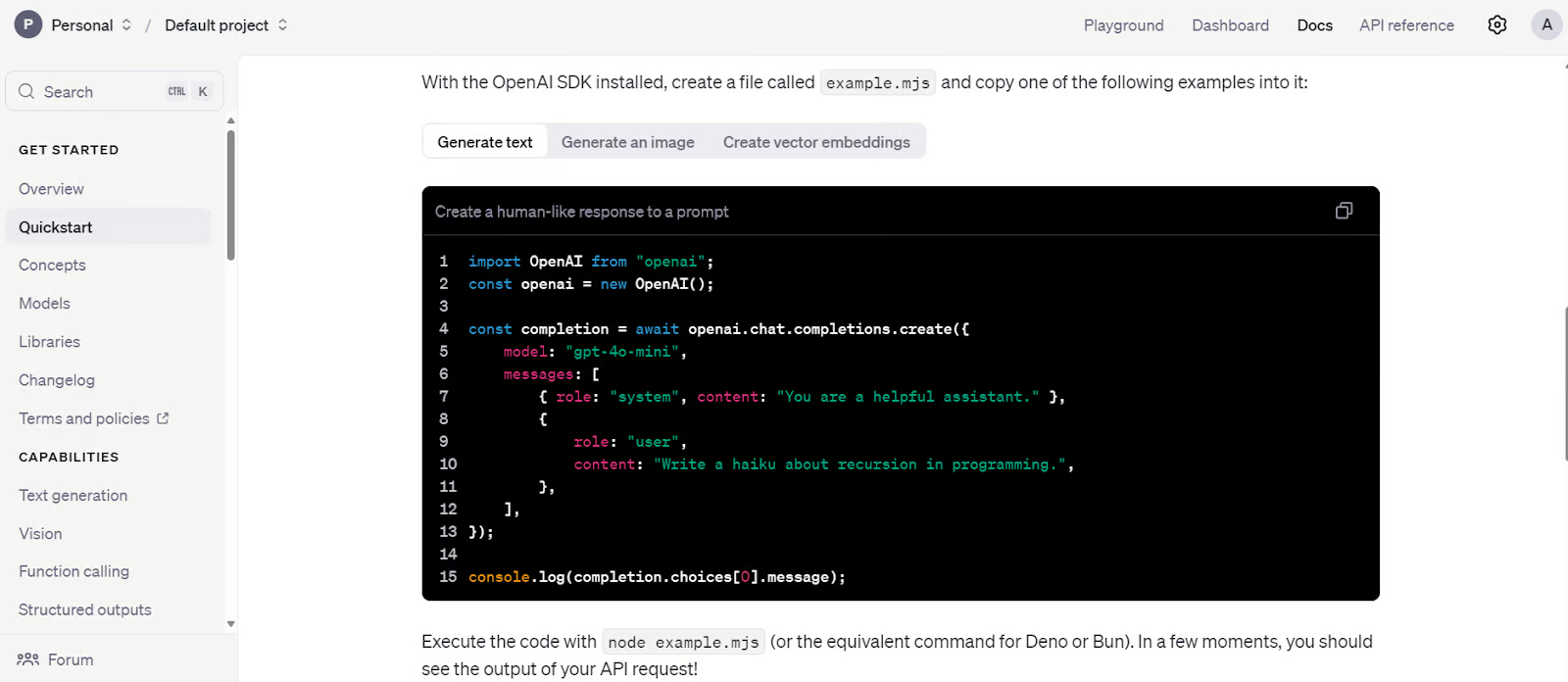

1. API OpenAI

OpenAI propose un accès API à des modèles LLM avancés tels que GPT-4o et o1. Ces modèles peuvent être utilisés via un package Python ou une commande CURL.

L'API constitue une solution idéale pour les start-ups qui ne disposent pas d'une équipe technique pour affiner ou déployer des modèles en production. Il permet d'accéder à des modèles linguistiques, des modèles multimodaux, des appels de fonctions, des sorties structurées et des options de réglage fin. De plus, vous pouvez utiliser des modèles d'intégration pour créer votre propre base de données vectorielle. En résumé, il propose un écosystème d'IA complet et peu coûteux.

Veuillez apprendre à utiliser l'API Python d'OpenAI pour accéder à des modèles d'apprentissage automatique de pointe en suivant le tutoriel sur l'API GPT-4o d'. Introduction à l'API d'OpenAI.

Code de démarrage rapide de l'API OpenAI. Source de l'image : Tutoriel de démarrage rapide - API OpenAI

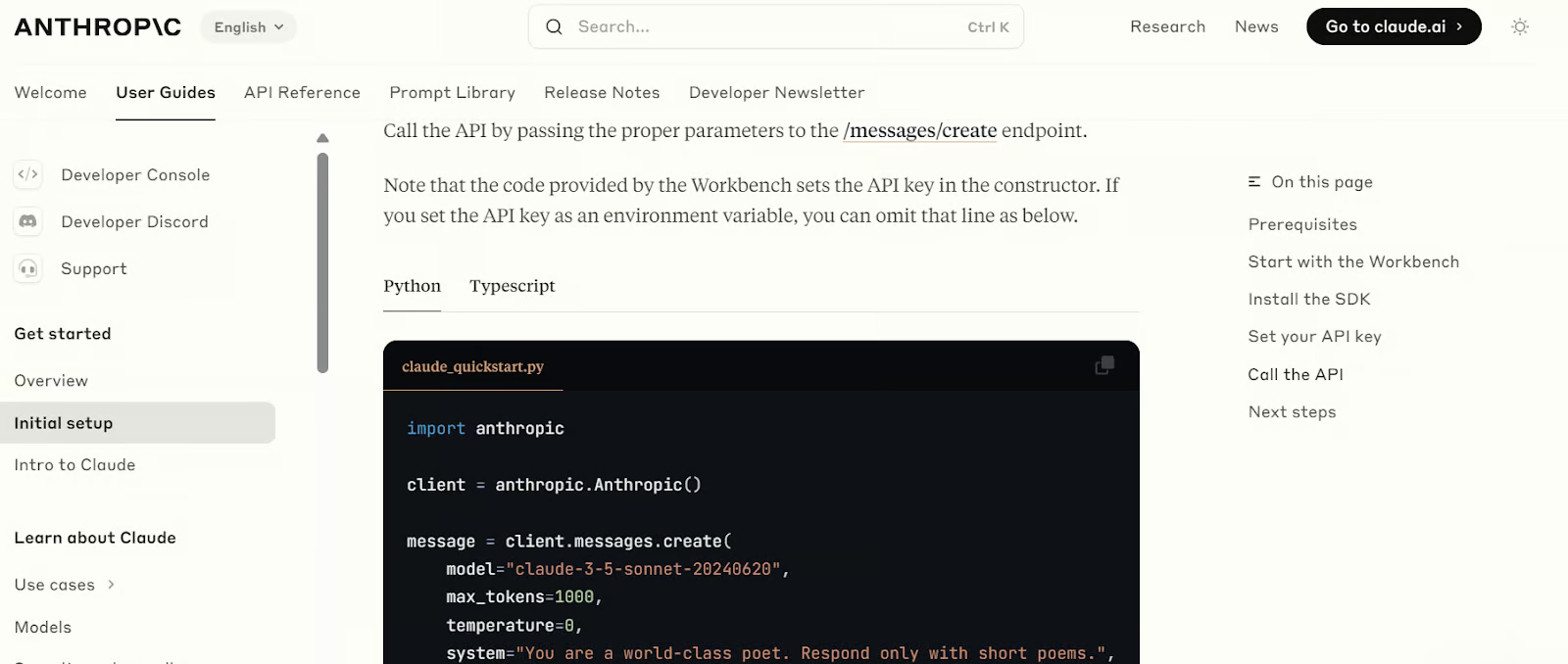

2. API Anthropic

L'API Anthropic est similaire à l'API OpenAI, offrant un accès à divers modèles linguistiques et d'intégration. Ces modèles peuvent être utilisés pour créer des applications RAG, intégrer des outils, récupérer des pages web, utiliser des modèles de vision et développer des agents IA. Au fil du temps, Anthropic vise à fournir tous les outils nécessaires pour créer et déployer des applications d'IA pleinement fonctionnelles.

À l'instar de l'API OpenAI, elle comprend des mesures de sécurité et des outils d'évaluation permettant de surveiller les performances du modèle.

Veuillez découvrir comment utiliser l'API Claude pour accéder aux modèles d'apprentissage automatique (LLM) les plus performants en suivant le tutoriel sur l'API Claude Sonnet 3.5 disponible à l'adresse suivante : . Introduction à l'API d'Anthropic.

Code de démarrage rapide de l'API Anthropic. Source de l'image : Configuration initiale - Anthropic

Réglage précis

À l'aide de Python, affinez les modèles linguistiques de base à partir d'un ensemble de données personnalisé afin d'adapter le style, la tâche et les fonctionnalités du modèle à des exigences spécifiques.

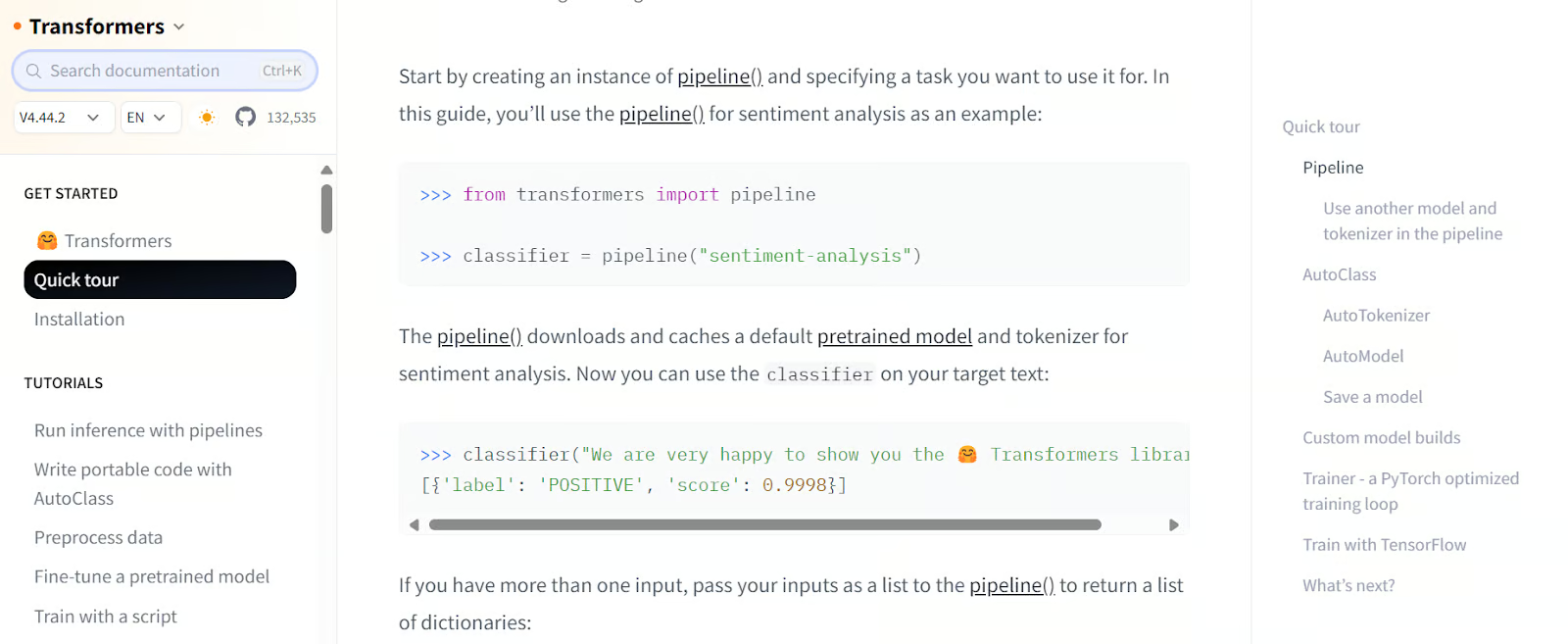

3. Transformateurs

Transformers by Hugging Face est un framework bien connu dans la communauté et l'industrie de l'IA. Il est largement utilisé pour accéder aux modèles, affiner les LLM avec des ressources limitées et enregistrer les modèles. Il offre un écosystème complet pour toutes les tâches, du chargement des données à l'évaluation des modèles d'apprentissage automatique (LLM).

Avec Transformers, vous pouvez charger des ensembles de données et des modèles, traiter des données, créer des modèles avec des arguments personnalisés, entraîner des modèles et les transférer vers le cloud. Par la suite, vous pourrez déployer ces modèles sur un serveur en quelques clics seulement.

Suivez le cours « Introduction aux LLM en Python » pour découvrir le paysage des LLM, l'architecture des transformateurs, les LLM pré-entraînés et comment intégrer les LLM pour résoudre des problèmes concrets.

Code de démarrage rapide des transformateurs. Source de l'image : Visite rapide (huggingface.co)

4. IA non paresseuse

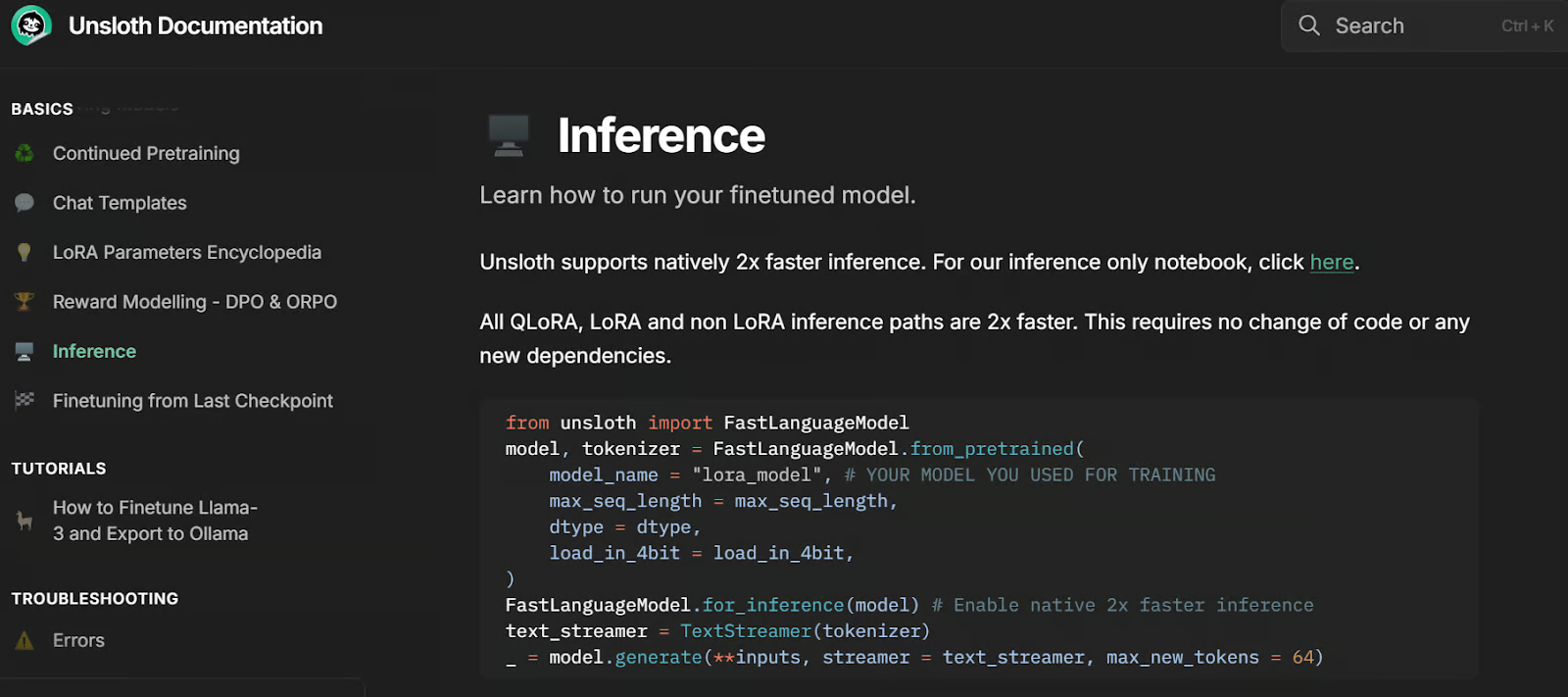

Unsloth AI est un framework Python permettant d'affiner et d'accéder à des modèles linguistiques de grande envergure. Il propose une API simple et des performances deux fois plus rapides que celles des Transformers.

Conçu à partir de la bibliothèque Transformers, il intègre des outils supplémentaires pour simplifier le réglage fin des grands modèles linguistiques avec des ressources limitées. Une caractéristique remarquable d'Unsloth est sa capacité à enregistrer des modèles dans un format compatible avec vLLM et GGUF à l'aide d'une seule ligne de code, éliminant ainsi le besoin d'installer et de configurer des bibliothèques telles qu'llama.cpp, car il gère tout automatiquement.

Décompiler le code d'inférence. Source de l'image : Inférence | Documentation Unsloth

Suivi des expériences

Suivez et évaluez les performances du modèle pendant l'entraînement et comparez les résultats.

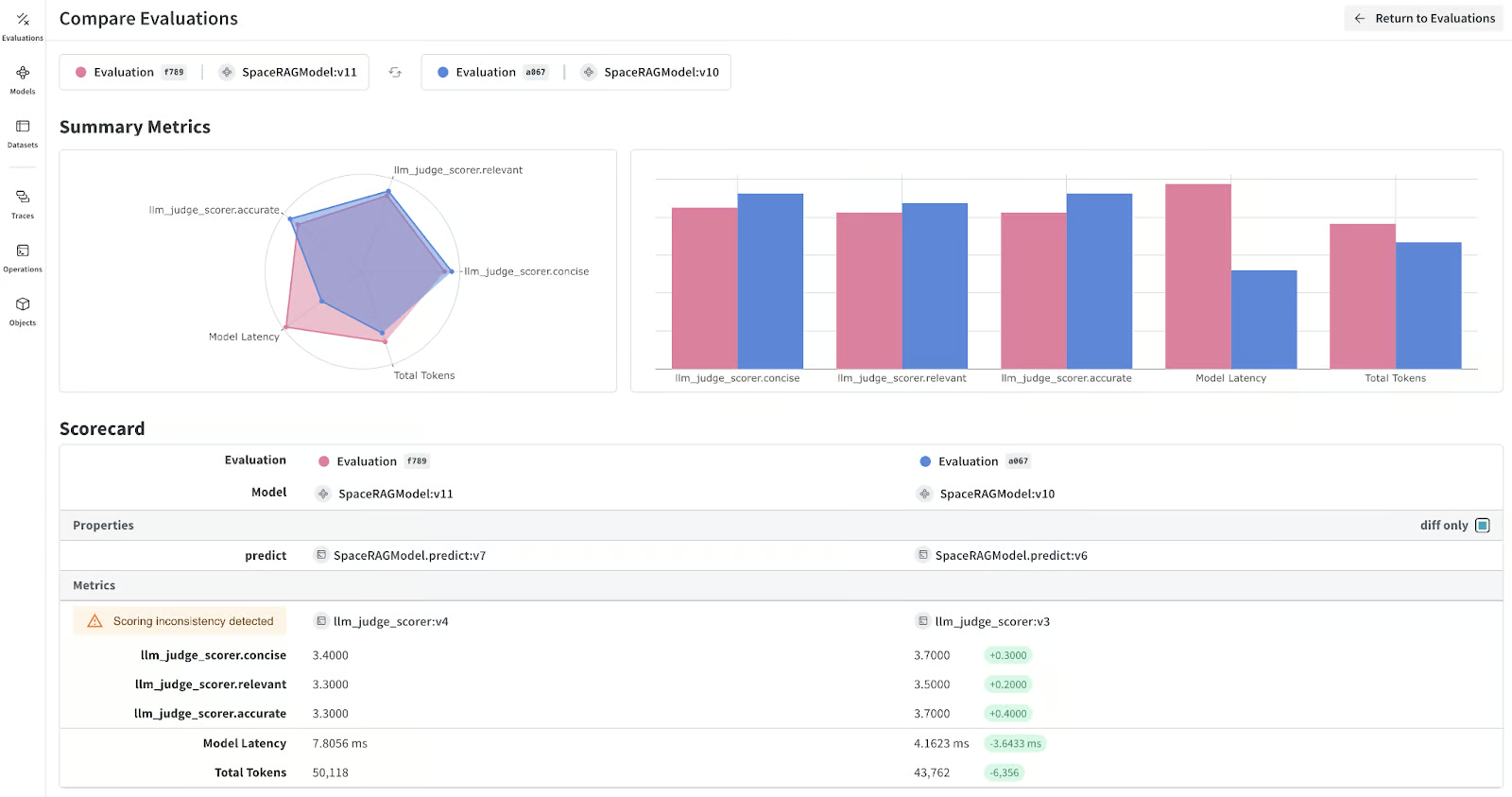

5. Poids et biais

Weights & Biases vous permet de suivre les performances du modèle pendant et après le réglage fin afin d'évaluer son efficacité. Il prend également en charge le suivi des applications RAG ainsi que la surveillance et le débogage des LLM.

La plateforme s'intègre parfaitement à divers frameworks et outils, notamment Transformers, LangChain, PyTorch et Keras. L'un des principaux avantages de Weights & Biases réside dans son tableau de bord hautement personnalisable, qui vous permet de créer des rapports d'évaluation de modèles et de comparer différentes versions de modèles.

Découvrez comment structurer, consigner et analyser vos expériences d'apprentissage automatique à l'aide de Weights & Biases en suivant le tutoriel « Expérimentation d'apprentissage automatique » d'. Présentation de Weights & Biases.

Mesures du modèle LLM. Source de l'image : wandb.ai

Intégration LLM

Intégrer LLM à une base de données externe, une base de données privée et une recherche sur le Web. Vous pouvez même créer et déployer l'intégralité de l'application IA à l'aide de ces frameworks. En résumé, ces outils sont essentiels pour développer des applications complexes basées sur le LLM que vous pouvez déployer sur le cloud.

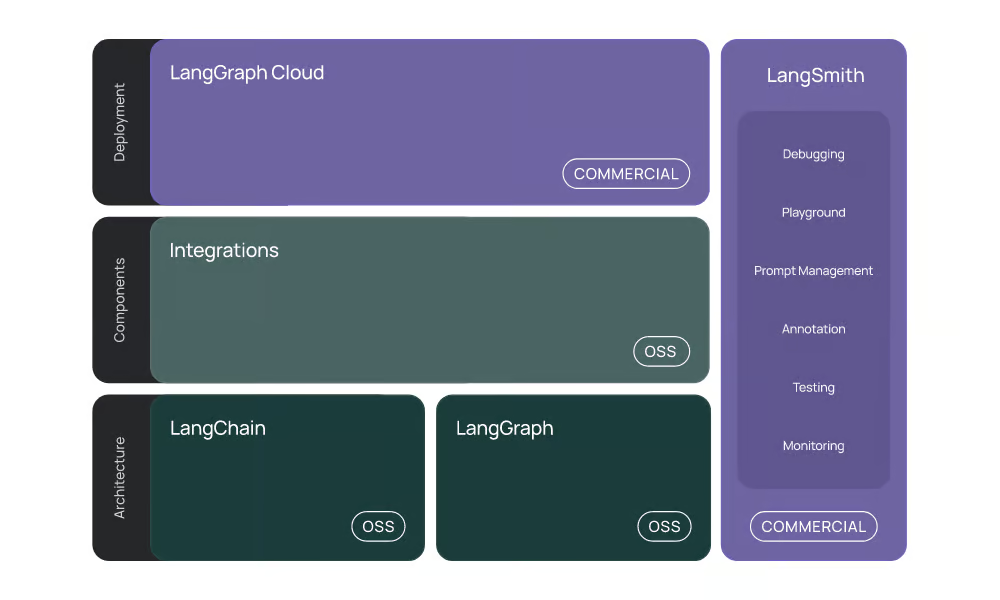

6. Langchain

LangChain est un outil très apprécié pour la création d'applications d'IA utilisant des modèles linguistiques à grande échelle (LLM). En quelques lignes de code seulement, vous pouvez développer des chatbots RAG contextuels directement dans les notebooks Jupyter.

LangChain propose désormais un écosystème LLM complet :

- Intégration : Il prend en charge l'intégration avec diverses API d'IA, modèles de chat, modèles d'intégration, chargeurs de documents, magasins de vecteurs et outils.

- LangChain : Il coordonne divers outils d'intégration et des modèles d'apprentissage profond (LLM) pour développer des applications d'intelligence artificielle.

- LangGraph: Il est conçu pour créer des applications multi-acteurs avec état à l'aide de LLM en modélisant les étapes sous forme d'arêtes et de nœuds dans un graphe.

- LangGraph Cloud et LangSmith : Ces produits commerciaux vous permettent d'utiliser des services gérés pour créer et déployer des applications basées sur le LLM.

LangChain simplifie le développement d'applications basées sur le LLM en fournissant des outils, des composants et des interfaces qui rationalisent le processus.

Veuillez suivre le cours « Développer des applications LLM avec LangChain » pour acquérir les connaissances nécessaires à la création d'applications basées sur l'IA à l'aide de LLM, de prompts, de chaînes et d'agents dans LangChain.

L'écosystème LangChain. Source de l'image : Introduction | LangChain

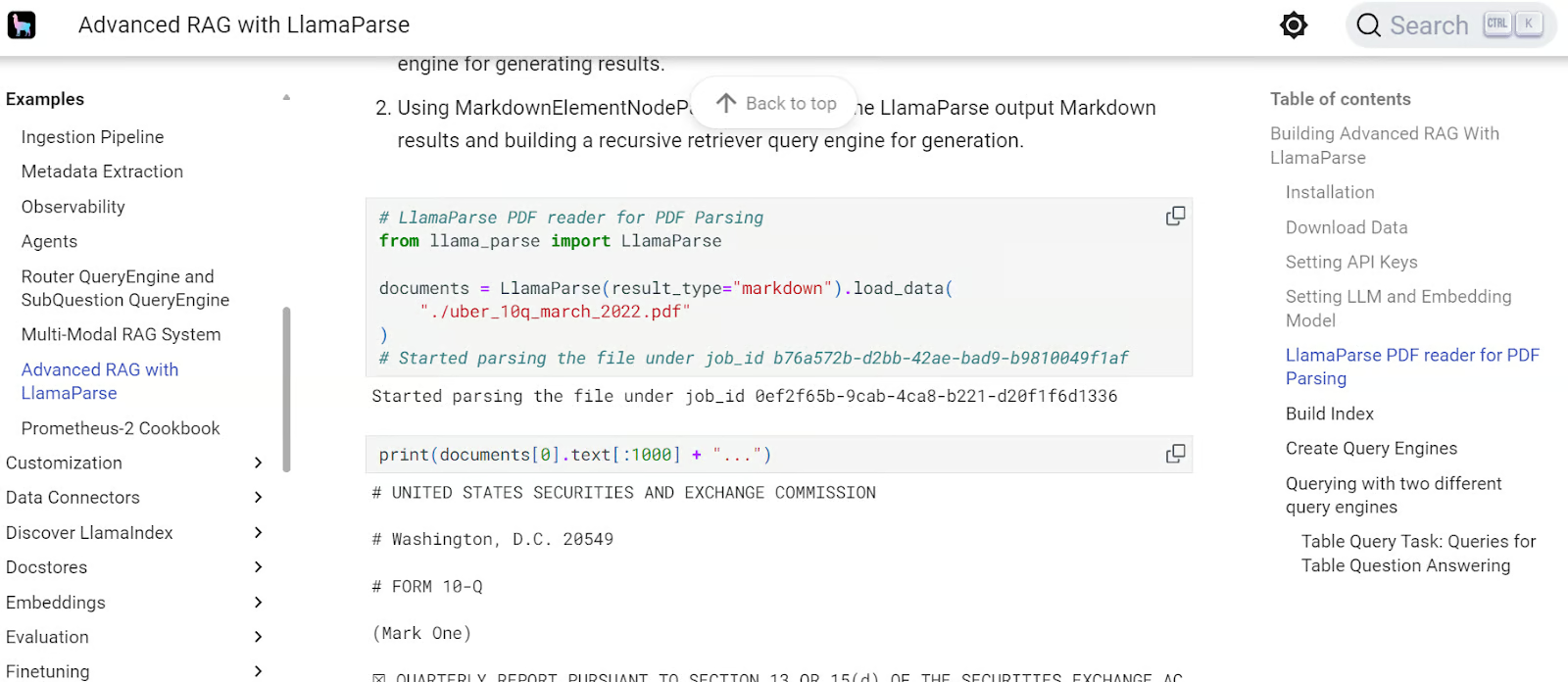

7. LlamaIndex

LlamaIndex est similaire à LangChain, mais offre une approche plus simple pour créer des applications RAG. Avec seulement quelques lignes de code, vous pouvez créer des applications RAG avec historique.

LlamaIndex offre des intégrations API et de stockage vectoriel complètes, permettant le développement d'applications LLM complexes et à la pointe de la technologie. Il propose également un service géré appelé LlamaCloud, qui facilite l'hébergement d'applications d'IA.

Veuillez découvrir comment ingérer, gérer et récupérer des données privées et spécifiques à un domaine à l'aide du langage naturel en suivant le guide LlamaIndex d': Cadre de données pour les applications basées sur les grands modèles linguistiques (LLM) Tutoriel sur l'.

Guide avancé LlamaIndex RAG. Source de l'image : RAG avancé avec LlamaParse - LlamaIndex

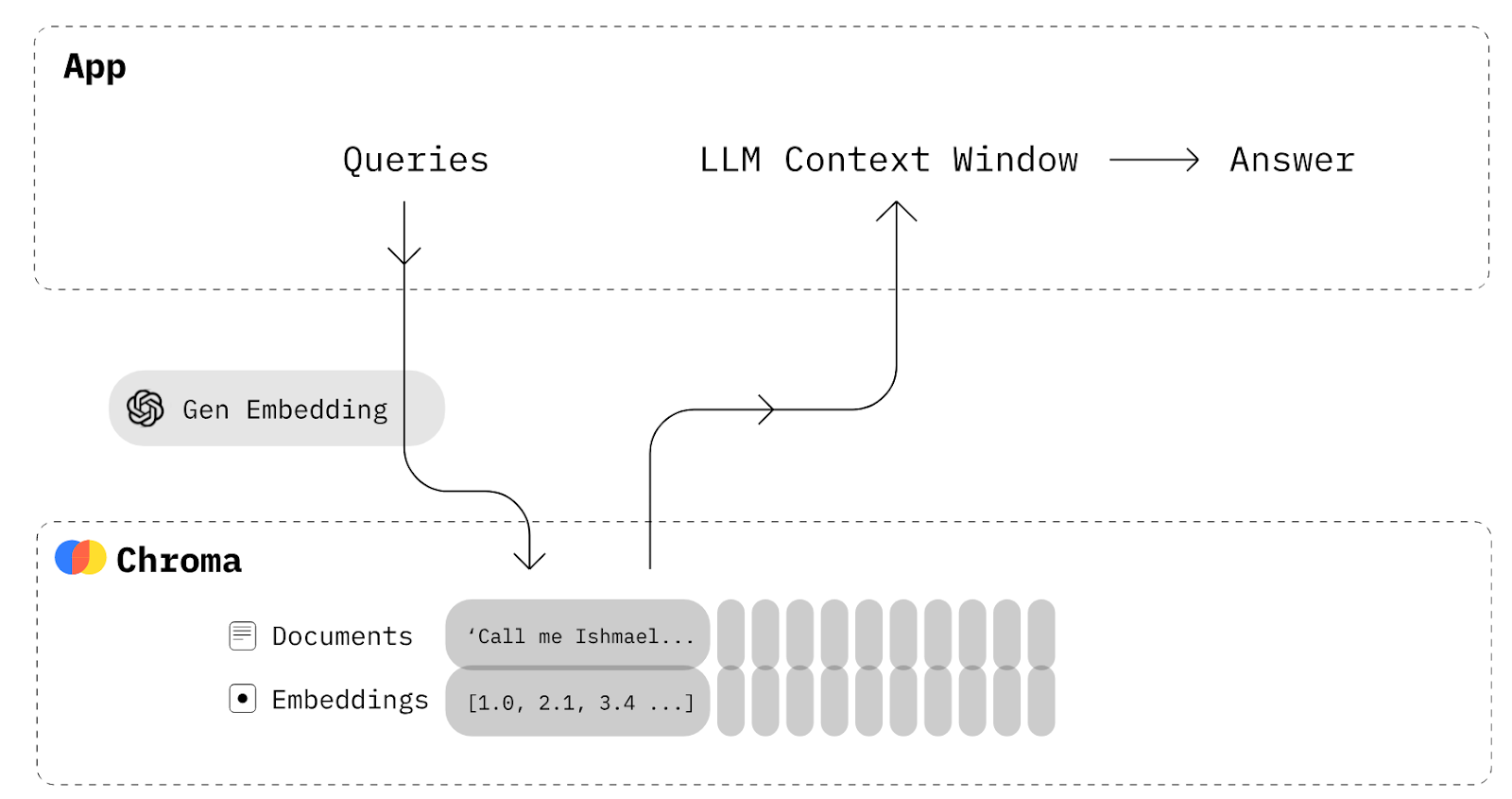

Recherche vectorielle

Les outils de recherche vectorielle offrent des capacités de stockage et de récupération robustes, qui sont essentielles pour créer des applications de génération augmentée par la récupération (RAG). Ces outils permettent de convertir divers types de données, tels que du texte, des images et des fichiers audio, en représentations, qui sont ensuite stockées dans des bases de données vectorielles.

8. Chroma

Chroma est une base de données vectorielle open source native pour l'IA. Il facilite la création d'applications LLM en permettant d'intégrer facilement des connaissances, des faits et des compétences.

Si vous souhaitez créer une application RAG de base qui vous permet de stocker vos documents sous forme d'intégrations, puis de les récupérer pour les combiner avec des invites afin de donner plus de contexte au modèle linguistique, vous n'avez pas besoin de LangChain. Tout ce dont vous avez besoin est une base de données Chroma pour enregistrer et récupérer les documents.

Chroma DB diagram. Source de l'image : Chroma Docs (trychroma.com)

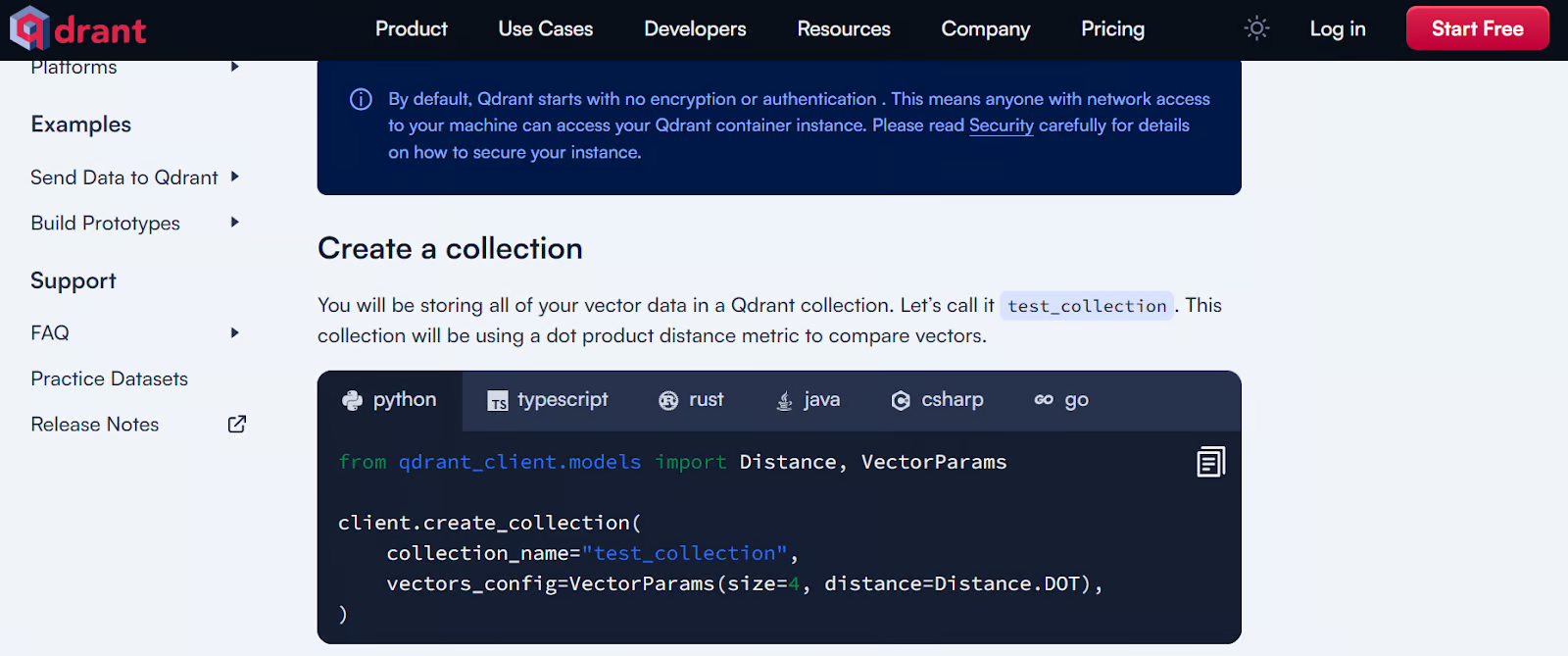

9. Qdrant

Qdrant est une base de données vectorielle open source et un moteur de recherche par similarité très appréciés, qui gèrent des vecteurs à haute dimension. Il propose des solutions locales, cloud et hybrides, ce qui le rend polyvalent pour divers besoins de déploiement.

Qdrant est particulièrement efficace dans des applications telles que la génération augmentée par la recherche, la détection d'anomalies, la recherche avancée et les systèmes de recommandation. Son API robuste facilite l'intégration et la gestion des données textuelles, ce qui en fait un outil puissant pour les développeurs qui souhaitent mettre en œuvre des fonctionnalités de recherche vectorielle.

Découvrez les 5 meilleures bases de données vectorielles adaptées à votre cas d'utilisation spécifique. Ils offrent une API simple et des performances rapides.

Exemple de démarrage avec Qdrant. Source de l'image : Démarrage rapide local - Qdrant

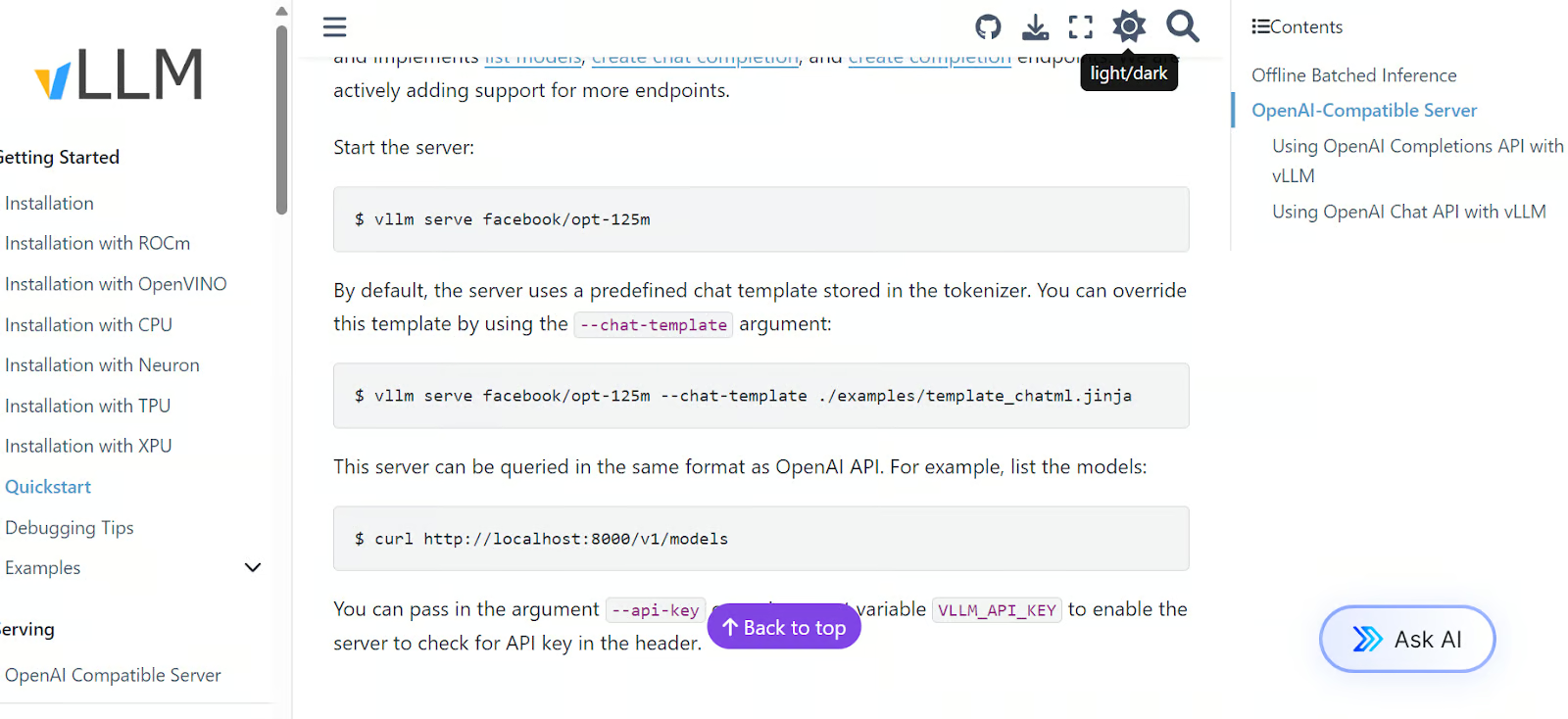

Service

Un composant essentiel pour votre application est un moteur d'inférence et de service à haut débit pour les LLM, compatible avec une large gamme de ressources informatiques, notamment les GPU, les TPU, les XPU, etc. Ces outils sont également compatibles avec les serveurs compatibles OpenAI, ce qui vous permet d'utiliser l'API d'OpenAI pour accéder de manière transparente au modèle servi.

10. vLLM

vLLM est une bibliothèque open source robuste conçue pour une inférence et une mise en service efficaces des modèles linguistiques de grande taille. Il aborde les défis liés au déploiement des LLM, tels que la consommation élevée de mémoire et les coûts de calcul, en utilisant des techniques innovantes de gestion de la mémoire et des stratégies de traitement par lots dynamiques.

L'une des principales fonctionnalités de vLLM est son algorithme PagedAttention, qui améliore considérablement le débit et réduit le gaspillage de mémoire. Il offre un débit jusqu'à 24 fois supérieur à celui des solutions traditionnelles telles que Hugging Face Transformers.

Exemple de démarrage rapide vLLM. Source de l'image : Quickstart — vLLM

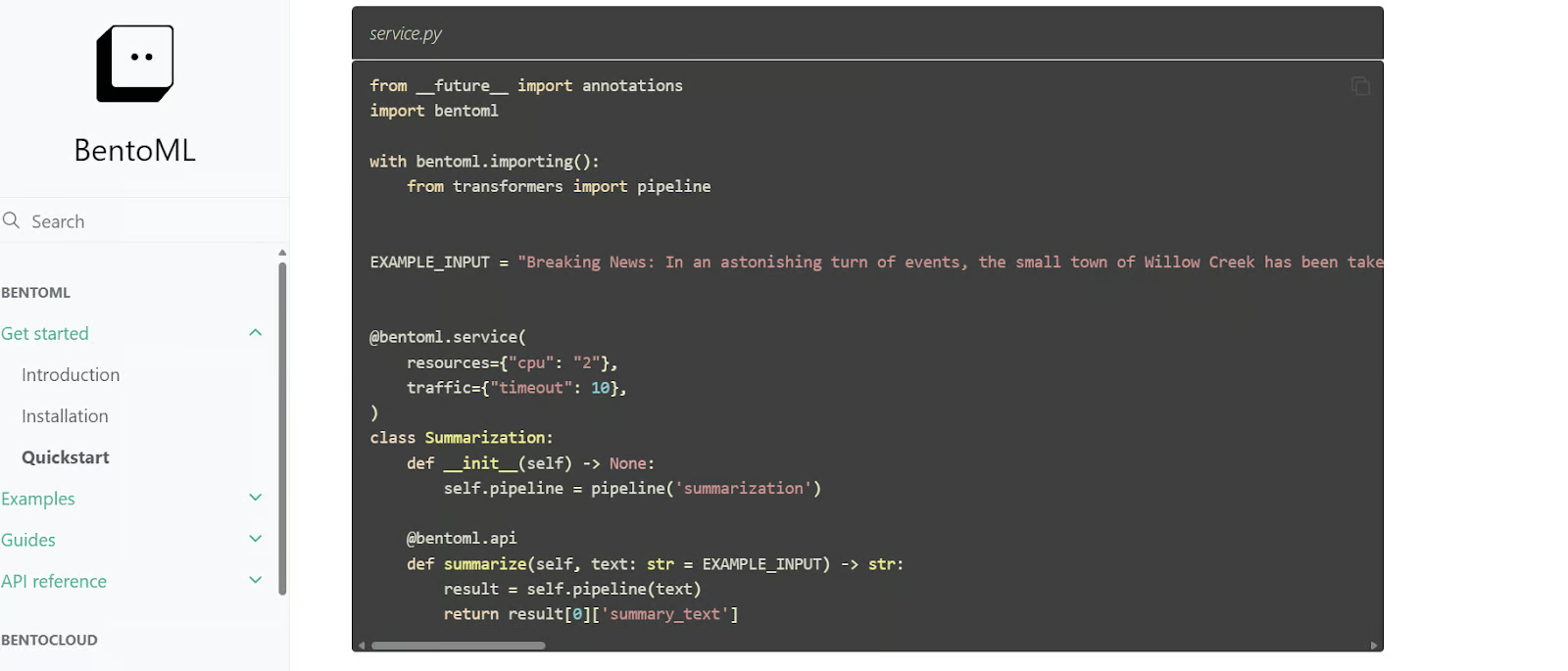

11. BentoML

BentoML est une bibliothèque Python permettant de créer et de fournir des modèles d'apprentissage automatique à grande échelle (LLM), offrant davantage d'options de personnalisation pour le développement d'applications d'intelligence artificielle que vLLM. Il comprend BentoCloud, un service géré qui facilite le déploiement et la surveillance des modèles dans le cloud, avec une offre gratuite pour débuter.

BentoML automatise de nombreuses étapes complexes du déploiement des modèles, réduisant ainsi considérablement le temps nécessaire à la transition des modèles du développement à la production.

Code de démarrage rapide BentoML. Source de l'image : Guide de démarrage rapide - BentoML

Déploiement

Vous pouvez soit déployer votre LLM directement dans le cloud, soit créer une application IA intégrée, puis la déployer. Pour ce faire, vous pouvez choisir n'importe quel grand fournisseur de services cloud. Cependant, les outils ci-dessous sont spécialement conçus pour les LLM et le déploiement de l'IA, offrant une fonctionnalité de déploiement plus simple et plus efficace.

12. Critères d'évaluation de l'inférence

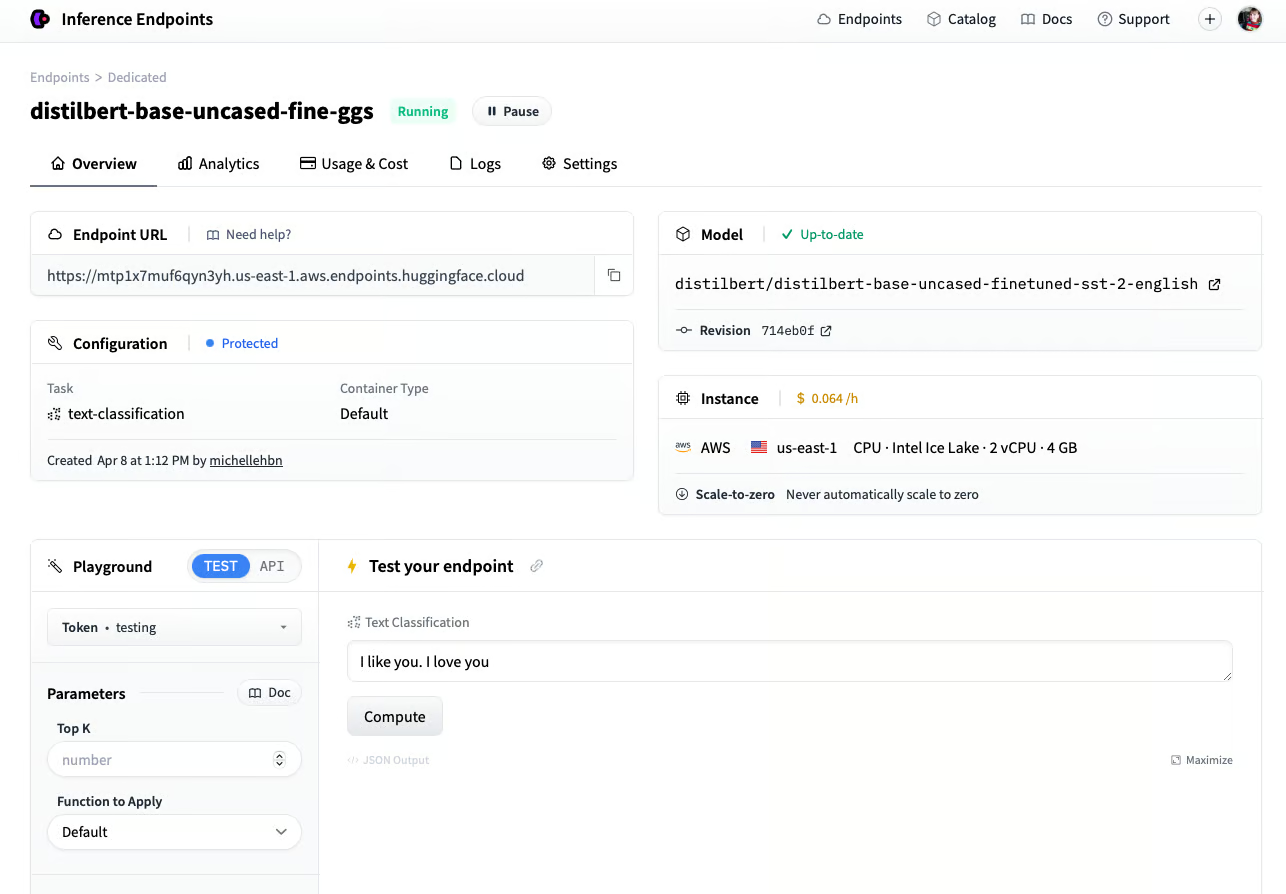

Si vous appréciez l'écosystème Hugging Face, vous apprécierez certainement les points de terminaison d'inférence Hugging Face. Ce service de déploiement vous permet d'utiliser n'importe quel modèle du hub Hugging Face, y compris les modèles privés, à des fins de production. Il vous suffit de sélectionner votre fournisseur de services cloud et le type de machine informatique, et en quelques minutes, votre modèle est prêt à être utilisé.

Inference Endpoints dispose d'un tableau de bord dédié qui vous permet de créer des points de terminaison et de surveiller les modèles en production, offrant ainsi une solution sécurisée et efficace pour le déploiement de modèles d'apprentissage automatique.

Déploiement d'un modèle à l'aide du point de terminaison Hugging Face Inference. Source de l'image : Créer un point de terminaison (huggingface.co)

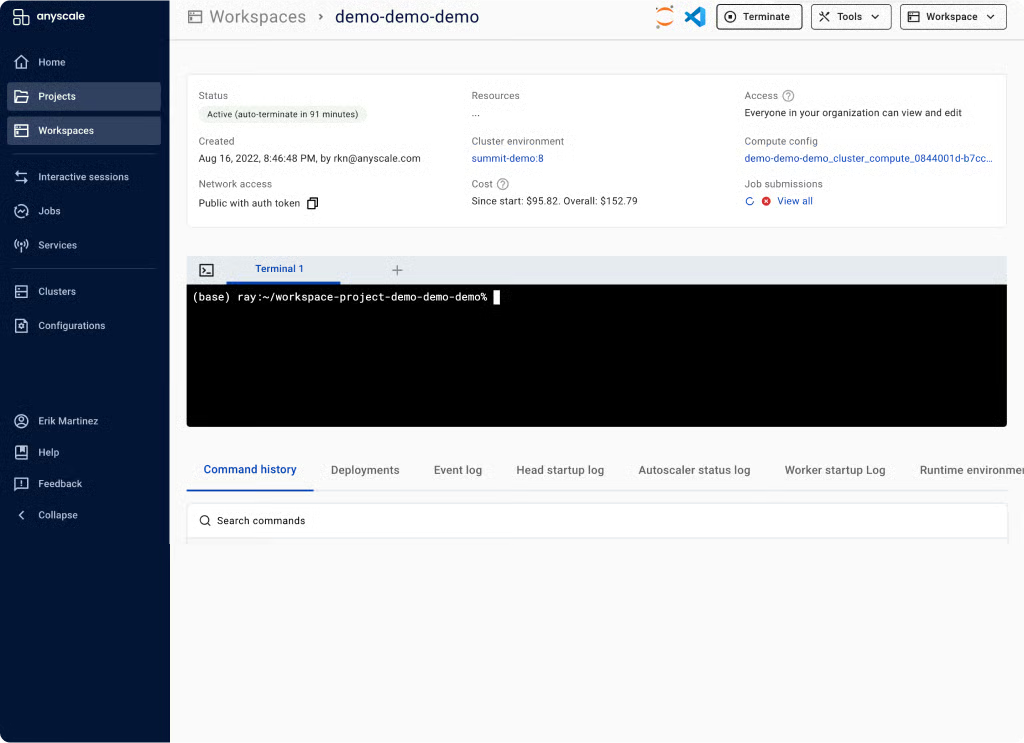

13. Anyscale

Anyscale utilise Ray Serve en arrière-plan pour offrir une inférence de modèle rapide et à haut débit. En tant que plateforme informatique entièrement gérée et évolutive, Anyscale vous permet de charger des données, de former des modèles, d'évaluer et de fournir des modèles, de gérer des services, de surveiller des modèles et de contrôler l'accès. Il s'agit d'une plateforme MLOps de bout en bout, construite sur l'écosystème open source Ray, qui simplifie l'ensemble du cycle de vie des applications d'IA.

Espace de travail Anyscale. Source de l'image : Plateforme informatique unifiée pour les applications IA et Python | Anyscale

Observabilité

Une fois vos LLM déployés, il est essentiel de surveiller leurs performances en production. Les outils d'observabilité surveillent automatiquement votre modèle dans le cloud et vous alertent en cas de baisse significative des performances.

14. Évidemment

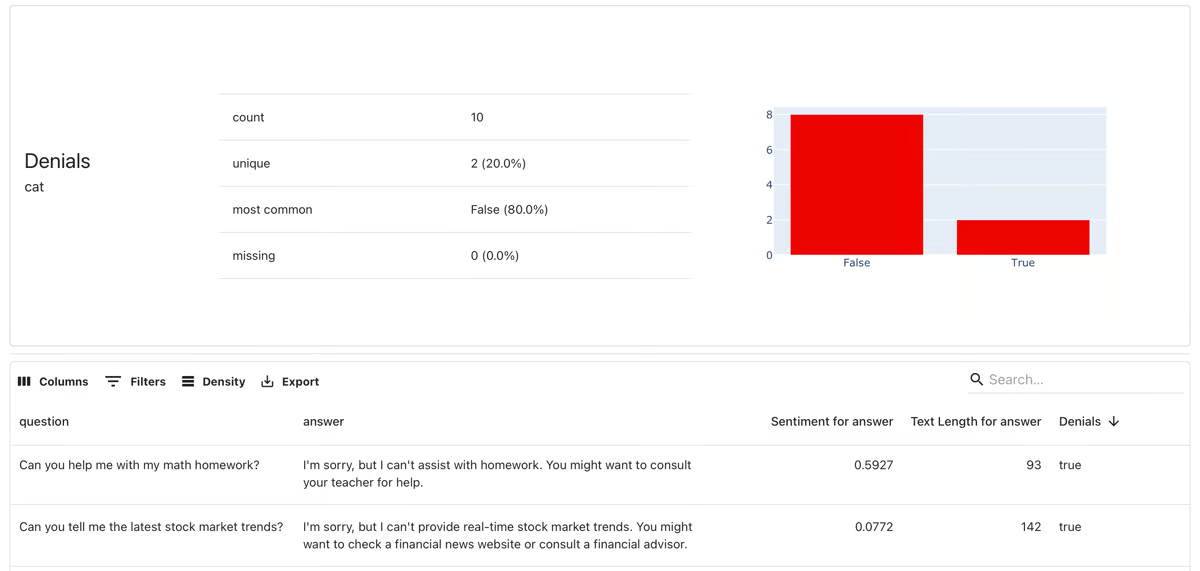

Evidently est un cadre open source d'observabilité ML et MLOps. Il vous permet d'évaluer, de tester et de surveiller les applications ML et les pipelines de données. Il prend en charge les modèles prédictifs généraux ainsi que les applications d'IA générative.

Avec plus de 100 indicateurs intégrés, il permet la détection des dérives de données et l'évaluation des modèles d'apprentissage automatique. Il est également capable de générer des rapports d'évaluation des données et des modèles, des suites de tests automatisés et des tableaux de bord de surveillance des modèles.

Il s'agit manifestement d'une surveillance de modèle. Source de l'image : evidentlyai.com

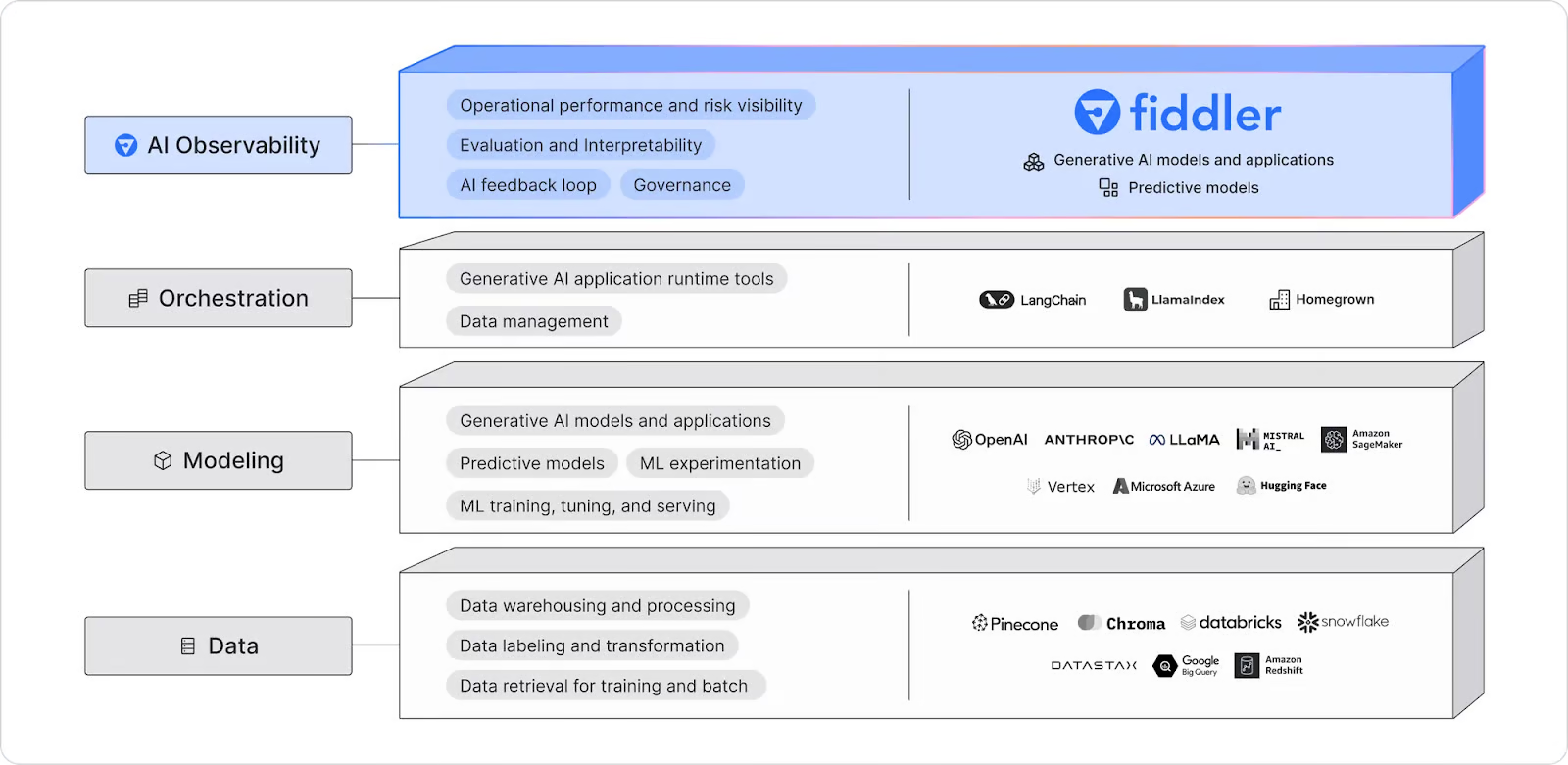

15. Fiddler IA

Fiddler AI est une plateforme d'observabilité IA qui surveille, explique, analyse et améliore les modèles LLM, les modèles génératifs d'images et les applications IA générales. Il détecte et résout les dérives de modèles, les valeurs aberrantes et les problèmes d'intégrité des données grâce à des alertes en temps réel et à un débogage explicable alimenté par l'IA, ce qui aide les équipes à détecter et à résoudre les problèmes dès qu'ils surviennent.

Schéma d'observabilité de Fiddler AI. Source de l'image : Observabilité LLM | Fiddler AI

Maintenant que vous avez découvert divers outils LLMOP, il est temps de créer un projet LLM à partir de la liste des 12 projets LLM pour tous les niveaux présentés dans les articles de blog.

Conclusion

Le domaine des LLMOps est encore en développement, et il y a beaucoup de bruit dans le domaine de l'IA. Dans cet article, nous avons examiné les 15 principaux outils LLMOps à la pointe dans ce domaine.

Bien que nous ayons abordé les outils essentiels et populaires pour créer, évaluer et déployer des applications d'IA dans le cloud, de nombreuses catégories n'ont pas encore été traitées. Il s'agit notamment d'outils d'apprentissage automatique pour le CI/CD, l'orchestration des flux de travail, la gestion des versions des modèles et des données, Docker, Kubernetes, etc. Vous pouvez en savoir plus sur ces catégories en consultant l'article de blog intitulé « Les 25 meilleurs outils MLOps à connaître en 2026 ».

Si vous débutez avec LLMOps, il est fortement recommandé de commencer par l'API OpenAI et de créer un produit minimum viable.

Développez dès aujourd'hui vos compétences en matière de MLOps

Questions fréquentes

Puis-je utiliser plusieurs outils LLMOps simultanément dans un même projet, ou est-il préférable de m'en tenir à un seul ?

Oui, il est possible d'utiliser plusieurs outils LLMOps simultanément, car ils traitent souvent différents aspects du cycle de vie de l'IA. Par exemple, vous pourriez utiliser une API pour accéder à des modèles linguistiques (tels que l'API OpenAI), un cadre de réglage fin (tel que Transformers) et un outil de service (tel que BentoML) pour le même projet. L'intégration d'outils complémentaires peut contribuer à rationaliser les flux de travail.

Comment puis-je déterminer quel outil LLMOps utiliser pour mon projet ?

Cela dépend de vos besoins spécifiques. Si vous débutez et souhaitez accéder facilement à des modèles, une API telle qu'OpenAI pourrait être la solution idéale. Pour les utilisateurs avancés, les modèles de réglage fin, tels que Transformers ou Unsloth AI, constituent d'excellents choix. Lors du choix des outils, veuillez prendre en considération les objectifs de votre projet, votre expertise technique et vos exigences en matière d'évolutivité.

Quelles compétences dois-je posséder pour utiliser efficacement les outils LLMOps ?

Il est nécessaire d'avoir une bonne compréhension des grands modèles linguistiques, de la programmation Python et des infrastructures cloud de base. La maîtrise de frameworks tels que PyTorch ou Hugging Face peut également s'avérer utile, en particulier si vous envisagez d'affiner des modèles ou de développer des applications d'IA complexes.

Y a-t-il des considérations financières à prendre en compte lors de l'utilisation des outils LLMOps ?

De nombreux outils LLMOps proposent des niveaux gratuits ou des options open source, mais les coûts peuvent augmenter en fonction de l'utilisation, en particulier pour les appels API, les déploiements cloud ou les services gérés. Veuillez examiner les modèles de tarification et sélectionner l'outil le mieux adapté à votre budget et à la taille de votre projet.

Comment puis-je surveiller les performances de mes modèles d'IA déployés ?

Des outils tels qu'Evidently et Fiddler AI sont conçus pour la surveillance et l'observabilité des modèles. Ils vous permettent de suivre les indicateurs de performance, de détecter les écarts dans les données et de recevoir des alertes si la précision de votre modèle diminue. Ces outils contribuent à garantir que vos modèles déployés continuent de fonctionner efficacement en production.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.