Cursus

Le dbt (data build tool) est devenu un cadre de développement largement utilisé dans les flux de travail modernes d'ingénierie et d'analyse des données. Les analystes de données dépendent principalement des ingénieurs de données pour écrire les transformations en SQL. Cependant, avec dbt, ils peuvent écrire des transformations et exercer un plus grand contrôle sur les données. Il permet également l'intégration avec des systèmes de contrôle de version populaires tels que Git, ce qui améliore la collaboration au sein de l'équipe.

Si vous vous préparez à occuper un poste dans le domaine des entrepôts de données, tel que celui d'ingénieur de données, d'analyste de données ou de scientifique de données, il est important de bien maîtriser les questions dbt de base et avancées.

Dans cet article, j'ai présenté les questions les plus fréquemment posées lors des entretiens afin de vous aider à acquérir les concepts de base et les compétences avancées en matière de résolution de problèmes.

Qu'est-ce que la TCD ?

dbt est un framework open source de transformation de données qui permet de transformer des données, de tester leur exactitude et de suivre les modifications au sein d'une seule et même plateforme. Contrairement à d'autres outils ETL (extraction, transformation, chargement), dbt ne s'occupe que de la partie transformation (le T).

D'autres outils ETL extraient les données de diverses sources, les transforment en dehors de l'entrepôt, puis les rechargent. Cela nécessite souvent des connaissances spécialisées en codage et des outils supplémentaires. Cependant, dbt simplifie ce processus : il permet d'effectuer des transformations dans l'entrepôt en utilisant uniquement SQL.

Plus de 40 000 grandes entreprises utilisent dbt pour rationaliser leurs données. Les recruteurs le considèrent donc comme l'une des compétences les plus importantes pour les postes liés aux données. Par conséquent, si vous parvenez à le maîtriser, même en tant que débutant dans le domaine des données, cela pourrait vous ouvrir de nombreuses opportunités professionnelles.

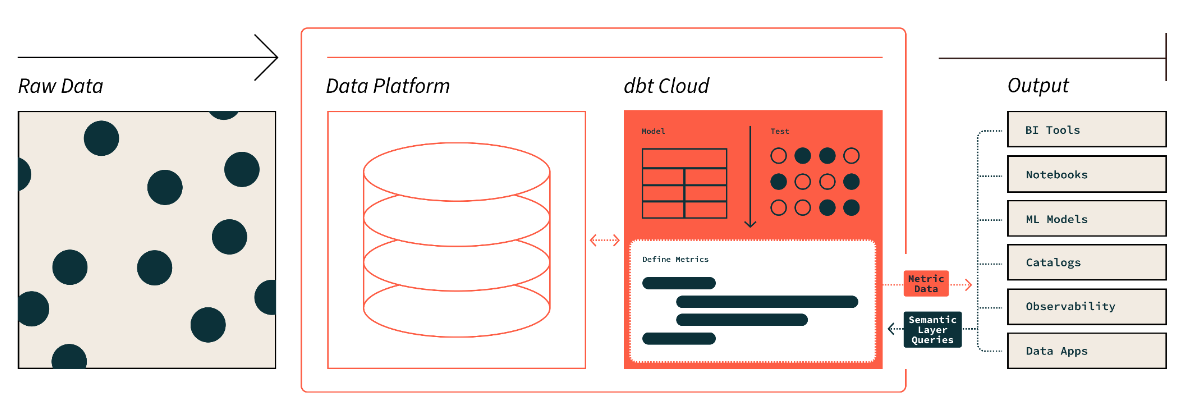

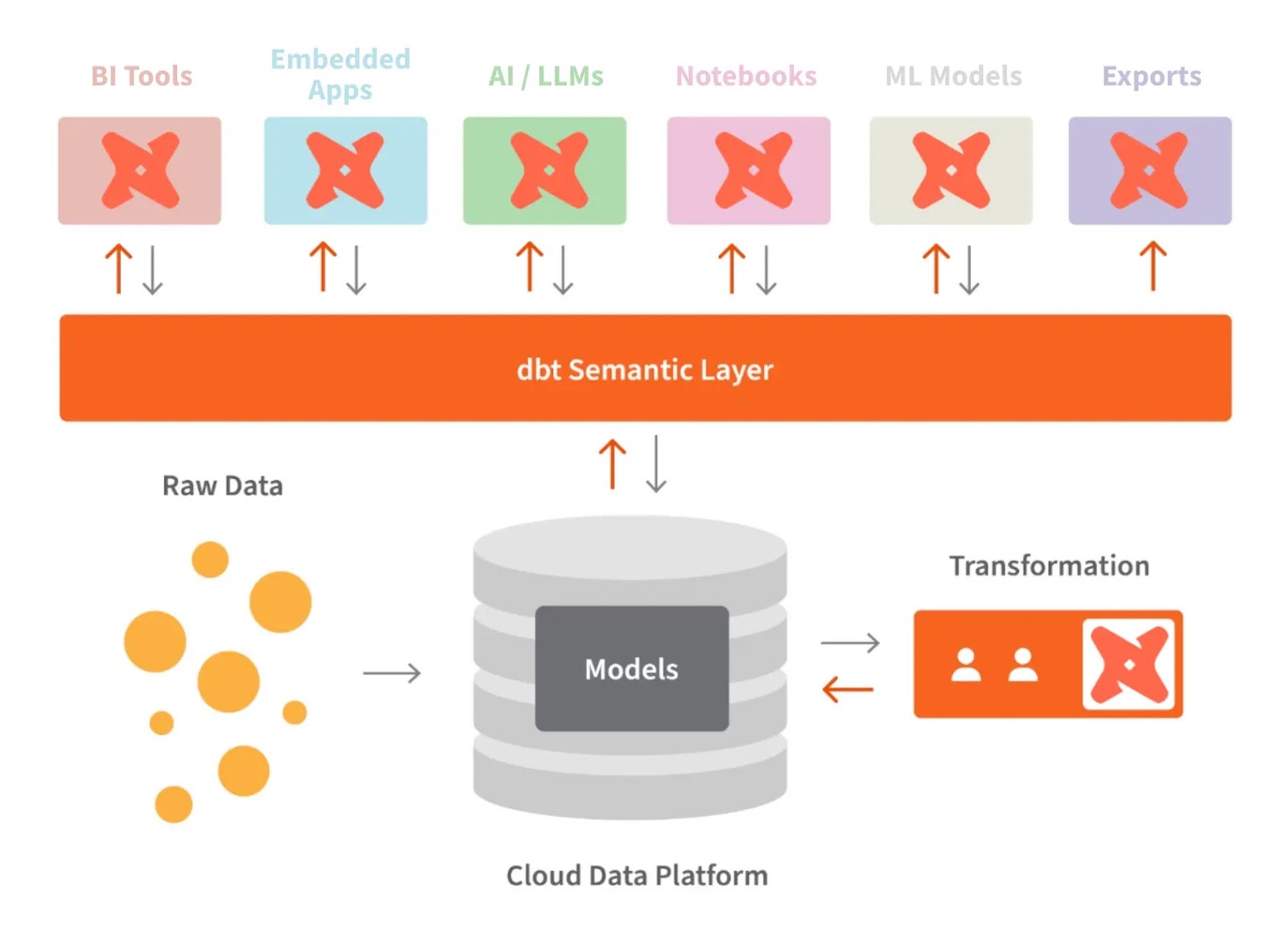

La couche sémantique dbt. Source de l'image : dbt

Questions d'entretien de base sur DBT

L'intervieweur évaluera vos connaissances de base au début du processus d'entretien. Pour cela, ils pourraient vous poser des questions fondamentales telles que celles-ci :

Quelles sont les utilisations courantes de dbt ?

dbt rassemble une équipe de données sur une seule page, où elle peut transformer, documenter et tester ses données. Cela contribue à garantir la fiabilité et la clarté des données. Les utilisations courantes de dbt comprennent :

- Transformation des données : Il s'agit du cœur du travail d'analyse. dbt gère tout, de la rédaction des requêtes SQL à la maintenance des pipelines techniques, ce qui réduit la charge de travail des analystes et ingénieurs de données.

- Test : Il est essentiel de valider le code avant le déploiement. Avec dbt, vous pouvez effectuer plusieurs tests afin de garantir l'exactitude et la fiabilité des données.

- Documentation : Cela permet aux autres membres de l'équipe de mieux comprendre les ensembles de données. Ici, nous pouvons ajouter une description de notre code, des tableaux, du DAG (graphe acyclique dirigé) et des tests que vous avez effectués.

- Migration fluide : dbt facilite le transfert des modèles de données entre les plateformes. Une fois le modèle construit, nous pouvons les migrer avec un minimum de modifications syntaxiques.

Le dbt est-il un langage de programmation ?

Non, dbt n'est pas un langage de programmation. Il s'agit d'un outil qui facilite les tâches de transformation des données dans l'entrepôt. Si vous maîtrisez le langage SQL, vous pouvez facilement utiliser dbt. Il a également commencé à prendre en charge Python pour des tâches spécifiques. Cependant, à la base, il gère et exécute des transformations basées sur SQL.

Pourriez-vous expliquer en quoi dbt diffère de Spark ?

dbt et Spark ont des objectifs différents et ciblent différents types de flux de travail. Voici une comparaison de leur rôle dans l'infrastructure des données :

|

Caractéristique |

dbt |

Spark |

|

Rôle |

Transformations et modélisation de données basées sur SQL |

Traitement et analyse distribués des données |

|

Langage de base |

SQL en priorité, avec une prise en charge limitée de Python |

Supports SQL, Python, Scala, Java, R |

|

Gouvernance des données |

Documentation et assistance à la filiation |

Fournit un contrôle d'accès, un audit et une traçabilité des données. |

|

Utilisateurs cibles |

Utilisateurs SQL, analystes et équipes sans compétences en ingénierie |

Ingénieurs de données, scientifiques de données, développeurs |

|

Complexité de la transformation |

Se concentre uniquement sur les transformations SQL et la modélisation. |

Peut également gérer des transformations complexes dans d'autres langues. |

|

Test et validation |

Dispose de capacités de test intégrées |

Il est nécessaire de mettre en place des stratégies de test personnalisées (unitaires et d'intégration). |

Quels sont les défis liés à la TCD ?

Bien que le DBT apporte une grande valeur ajoutée aux équipes chargées des données, il peut également présenter certains défis, en particulier lorsque l'échelle et la complexité augmentent. Par conséquent, voici quelques-uns des défis les plus courants :

- Courbe d'apprentissage abrupte: Les nouveaux utilisateurs peuvent rencontrer des difficultés avec des concepts tels que la modélisation des données, les modèles Jinja et la structuration de projets.

- Qualité des données et tests: Il peut être complexe de garantir une couverture de test adéquate et de maintenir les tests dans le cadre de projets de grande envergure.

- Problèmes de mise à l'échelle: Des goulots d'étranglement peuvent survenir avec des ensembles de données volumineux ou des transformations complexes.

- Gestion des dépendances: La gestion des dépendances et le dépannage du DAG à mesure que les projets prennent de l'ampleur peuvent s'avérer complexes.

- Orchestration: L'intégration de dbt dans des flux de travail plus larges peut s'avérer complexe, en particulier avec une planification personnalisée.

- Documentation: La mise à jour de la documentation et des tests des modèles peut s'avérer fastidieuse.

- Limitations spécifiques à la base de données: Les différentes plateformes de données peuvent présenter des niveaux de compatibilité et des fonctionnalités variables.

- Transition depuis les outils existants: L'adaptation des flux de travail à partir d'outils ETL existants peut s'avérer complexe.

- de logique métier complexe: La gestion de la logique avancée dans dbt peut nécessiter l'utilisation de macros, ce qui ajoute à la complexité.

Les employeurs recherchent des candidats capables de surmonter les défis potentiels mentionnés ci-dessus, il est donc important de ne pas négliger l'importance de cette question.

Quelle est la différence entre dbt Core et dbt Cloud ?

Il existe deux versions principales de dbt :

dbt Core est la version gratuite et open source de dbt qui permet aux utilisateurs de rédiger, d'exécuter et de gérer localement des transformations basées sur SQL. Il fournit une interface de ligne de commande (CLI) pour exécuter des projets dbt, tester des modèles et créer des pipelines de données. Étant donné qu'il s'agit d'un logiciel libre, dbt Core exige que les utilisateurs gèrent eux-mêmes le déploiement, l'orchestration et la configuration de l'infrastructure, généralement dans un environnement d'automatisation tel qu'Airflow ou Kubernetes.

, quant à lui, est un service cloud géré fourni par les créateurs de dbt (Fishtown Analytics). Il offre toutes les fonctionnalités de dbt Core, ainsi que des fonctionnalités supplémentaires telles qu'une interface Web, une planification intégrée, une gestion des tâches et des outils de collaboration. dbt Cloud comprend également des fonctionnalités CI/CD (intégration et déploiement continus) intégrées, un accès API et une conformité de sécurité renforcée, telle que SOC 2 et HIPAA, pour les organisations ayant des besoins de sécurité plus rigoureux.

Devenez ingénieur en données

Questions d'entretien intermédiaire sur la TCD

Maintenant que nous avons abordé les questions de base sur le dbt, voici quelques questions de niveau intermédiaire sur le dbt. Ces derniers se concentrent sur des aspects techniques et des concepts spécifiques.

Que sont les sources dans dbt ?

Dans dbt, les sources sont les tableaux de données brutes. Nous n'écrivons pas directement de requêtes SQL sur ces tableaux bruts — nous spécifions le schéma et le nom de la table et les définissons comme sources. Cela facilite la référence aux objets de données dans les tableaux.

Veuillez imaginer que vous disposez d'une table de données brutes dans votre base de données nommée « orders » dans le schéma « sales ». Au lieu d'interroger directement ce tableau, vous le définiriez comme source dans dbt de la manière suivante :

Veuillez définir la source dans votre fichier sources.yml:

version: 2

sources:

- name: sales

tables:

- name: ordersVeuillez utiliser la source dans vos modèles dbt :

Une fois définie, vous pouvez vous référer au tableau d' orders s brutes dans vos transformations comme suit :

SELECT *

FROM {{ source('sales', 'orders') }}Cette approche permet d'abstraire la définition brute du tableau, ce qui facilite sa gestion et garantit que, si la structure sous-jacente du tableau change, vous pouvez le mettre à jour à un seul endroit (la définition source) plutôt que dans chaque requête.

Avantages de l'utilisation de sources dans dbt :

- Organisation : Les sources organisent vos données brutes et facilitent leur gestion au sein d'un projet.

- Résumé : Vous abstrayez les détails du schéma, réduisant ainsi les erreurs et améliorant la flexibilité.

- Documentation : La définition des sources contribue à améliorer la documentation relative à vos entrées de données brutes.

Qu'est-ce qu'un modèle DBT ?

Un modèle DBT est essentiellement un fichier SQL ou Python qui définit la logique de transformation des données brutes. Dans dbt, les modèles constituent l'élément central dans lequel vous écrivez vos transformations, qu'il s'agisse d'agrégations, de jointures ou de tout autre type de manipulation de données.

- Modèles SQL dans dbt utilisent des instructions d'

SELECTation pour définir les transformations et sont enregistrés sous forme de fichiers .sql. - Les modèles Python, introduits avec la prise en charge de Python par dbt, sont enregistrés sous forme de fichiers

.pyet permettent d'utiliser des bibliothèques Python telles que pandas pour manipuler les données.

Exemple de modèle SQL :

Un modèle SQL transforme les données brutes à l'aide de requêtes SQL. Par exemple, pour créer un résumé des commandes à partir d'un tableau d' orders s :

--orders_summary.sql

WITH orders_cte AS (

SELECT

customer_id,

COUNT(order_id) AS total_orders,

SUM(order_amount) AS total_revenue

FROM {{ ref('orders') }}

GROUP BY customer_id

)

SELECT *

FROM orders_cteDans cet exemple :

- Le modèle

orders_summary.sqlgénère un récapitulatif du total des commandes et du chiffre d'affaires pour chaque client à l'aide de SQL. - Le modèle fait référence à la table

orders(déjà définie comme modèle ou source dbt).

Exemple de modèle Python :

Un modèle Python traite les données brutes à l'aide de code Python. Cela peut être particulièrement utile pour les logiques complexes qui pourraient s'avérer fastidieuses en SQL.

# orders_summary.py

import pandas as pd

def model(dbt, session):

# Load the source data

orders = dbt.ref("orders").to_pandas()

# Perform transformations using pandas

orders_summary = orders.groupby('customer_id').agg(

total_orders=('order_id', 'count'),

total_revenue=('order_amount', 'sum')

).reset_index()

return orders_summaryDans cet exemple :

- Le modèle Python utilise pandas pour transformer les données en regroupant les commandes par client et en calculant le nombre total de commandes et le chiffre d'affaires.

- Le résultat est ensuite renvoyé sous forme de DataFrame, que dbt peut intégrer dans son pipeline.

Comment créeriez-vous un modèle dbt ?

Voici comment créer un modèle dbt :

- Veuillez créer un répertoire dans ledossier

modelsdu projet dbt. - Veuillez ajouter un nouveau fichier texte avec l'extension

.sqldans le répertoire (ou.pys'il s'agit d'un modèle Python). - Veuillez maintenant rédiger une requête SQL ou un code pour transformer les données brutes.

- Veuillez exécuter lacommande

dbt runpour appliquer la transformation et créer le modèle.

Comment DBT gère-t-il les dépendances entre les modèles ?

dbt gère les dépendances entre les modèles à l'aide de la fonction « ref() », qui établit une chaîne de dépendances claire entre les modèles.

Lorsque vous définissez une transformation dans dbt, plutôt que de référencer directement les tableaux de votre entrepôt, vous référencez d'autres modèles dbt à l'aide de la fonction ref(). Cela garantit que dbt construit les modèles dans le bon ordre en identifiant ceux qui dépendent les uns des autres.

Par exemple, si vous disposez d'un modèle orders_summary qui dépend du modèle orders, vous le définiriez comme suit :

WITH orders AS (

SELECT * FROM {{ ref('orders') }}

)

SELECT

customer_id,

COUNT(order_id) AS total_orders,

SUM(order_amount) AS total_revenue

FROM orders

GROUP BY customer_idDans cet exemple, la fonction ` {{ ref('orders') }} ` garantit que le modèle ` orders ` est construit avant ` orders_summary`, car ` orders_summary ` dépend des donnéesdu modèle ` orders ` .

Que sont les macros dans dbt et comment les exécuter ?

Les macros dans dbt sont des blocs réutilisables de code SQL écrits à l'aide du moteur de modèles Jinja. Ils vous permettent d'automatiser les tâches répétitives, d'abstraire la logique complexe et de réutiliser le code SQL dans plusieurs modèles, rendant ainsi votre projet dbt plus efficace et plus facile à maintenir.

Les macros peuvent être définies dans les fichiers .sql situés dans le répertoire macros de votre projet dbt.

Les macros sont particulièrement utiles lorsque vous devez effectuer des transformations similaires sur plusieurs modèles ou que vous avez besoin d'une logique spécifique à l'environnement, comme l'utilisation de schémas différents ou la modification des formats de date en fonction des environnements de déploiement (par exemple, développement, mise en scène ou production).

Exemple de création de macros :

- Macro de formatage de la date : Vous pouvez créer une macro pour uniformiser le formatage des dates dans tous les modèles. Au lieu de répéter la logique du format de date, vous pouvez créer une macro comme celle-ci :

-- macros/date_format.sql

{% macro format_date(column) %}

FORMAT_TIMESTAMP('%Y-%m-%d', {{ column }})

{% endmacro %}Utilisation dans un modèle :

SELECT

customer_id,

{{ format_date('order_date') }} AS formatted_order_date

FROM {{ ref('orders') }}Dans cet exemple, la macro ` format_date ` est utilisée pour normaliser le format de la colonne ` order_date ` dans tout modèle où elle est appelée.

- Nom du schéma personnalisé macro : Cette macro modifie dynamiquement les noms de schémas en fonction de l'environnement (par exemple, développement ou production). Cela facilite la gestion des environnements sans avoir à modifier manuellement les noms de schémas.

-- macros/custom_schema.sql

{% macro custom_schema_name() %}

{% if target.name == 'prod' %}

'production_schema'

{% else %}

'dev_schema'

{% endif %}

{% endmacro %}Utilisation dans un modèle :

SELECT *

FROM {{ custom_schema_name() }}.ordersIci, la macro vérifie si l'environnement (target.name) est « prod » et renvoie le nom de schéma approprié en fonction de cela.

Comment exécuter des macros :

Les macros ne sont pas exécutées directement comme les modèles SQL. Ils sont plutôt référencés dans vos modèles ou autres macros et exécutés lorsque le projet dbt est lancé. Par exemple, si vous utilisez une macro dans un modèle, celle-ci s'exécutera lorsque vous lancerez la commande « dbt run ».

- Appel d'une macro dans un modèle : Lorsque vous incluez une macro dans un modèle SQL, celle-ci est exécutée pendant l'exécution du modèle.

- Exécution manuelle des macros: Vous pouvez également exécuter certaines macros manuellement en les appelant à l'aide de la commande

dbt run-operation. Ceci est généralement utilisé pour des tâches ponctuelles, telles que l'initialisation de données ou la réalisation d'opérations de maintenance.

Quels sont les deux types de tests dans le dbt ?

Les tests singuliers et les tests génériques sont les deux types de tests disponibles dans dbt :

- Les tests uniques se concentrent sur des conditions spécifiques dans un modèle dbt. Si la condition de test échoue, les lignes seront renvoyées.

Exemple : Supposons que vous souhaitiez vous assurer qu'aucune commande ne présente un order_amount négatif. Vous pouvez créer un test unique dans le répertoire tests comme suit :

-- tests/no_negative_order_amount.sql

SELECT *

FROM {{ ref('orders') }}

WHERE order_amount < 0Si ce test échoue, dbt renverra toutes les lignes de la table orders où l' order_amount est négatif.

- Les tests génériques sont des tests prédéfinis qui acceptent des arguments. Ils sont ensuite classés dans les catégories suivantes :

|

Tests génériques |

Définition |

|

Unique |

Vérifie si les valeurs de la colonne sont uniques. |

|

Non nul |

Vérifie s'il y a des champs vides. |

|

Valeurs disponibles |

Vérifie que les valeurs des colonnes correspondent à une liste de valeurs attendues afin de maintenir la normalisation. |

|

Relations |

Vérifie l'intégrité référentielle entre les tableaux afin d'éliminer toute donnée incohérente. |

Exemple : Vous pouvez facilement appliquer un test générique pour vous assurer que customer_id dans le tableau customers est unique et non nul en le définissant dans votre fichier schema.yml:

version: 2

models:

- name: customers

columns:

- name: customer_id

tests:

- unique

- not_nullDans cet exemple :

customer_idCe test unique vérifie que chaque entrée du tableaucustomersest unique.- Le test not_null vérifie qu'aucune valeur d'

customer_ids n'est manquante ou nulle.

Questions d'entretien avancées sur DBT

Au fur et à mesure de votre progression, vous pourriez rencontrer des scénarios plus complexes et des concepts avancés. Voici donc quelques questions d'entretien complexes qui vous aideront à évaluer votre expertise et à vous préparer à des postes de haut niveau dans le domaine de l'ingénierie des données.

Comment créer des modèles incrémentiels dans dbt et dans quelles circonstances les utiliseriez-vous ?

Les modèles incrémentiels dans dbt sont utilisés pour traiter uniquement les données nouvelles ou modifiées, au lieu de retraiter l'ensemble des données à chaque fois. Cela s'avère particulièrement utile lorsque l'on travaille avec des ensembles de données volumineux, pour lesquels la reconstruction complète du modèle à partir de zéro serait chronophage et nécessiterait d'importantes ressources.

Un modèle incrémentiel permet à dbt d'ajouter uniquement les nouvelles données (ou de mettre à jour les données modifiées) en fonction d'une condition, généralement une colonne d'horodatage (comme updated_at).

Comment créer un modèle incrémental :

1. Définissez le modèle comme incrémental en le spécifiant dans la configuration du modèle :

{{ config(

materialized='incremental',

unique_key='id' -- or another unique column

) }}2. Veuillez utiliser la fonction is_incremental() pour filtrer les lignes nouvelles ou modifiées :

SELECT *

FROM source_table

{% if is_incremental() %}

WHERE updated_at > (SELECT MAX(updated_at) FROM {{ this }})

{% endif %}3. Lorsque dbt exécute ce modèle pour la première fois, il traite l'ensemble des données. Pour les exécutions suivantes, il ne traitera que les lignes où l' updated_at est supérieure à la valeur la plus récente déjà présente dans le modèle.

Quand utiliser les modèles incrémentiels :

- s de grands ensembles de données: Lorsque vous disposez d'un tableau volumineux contenant des millions ou des milliards de lignes, il serait inefficace de reconstruire l'intégralité du tableau à chaque exécution.

- Mises à jour fréquentes: Si votre entrepôt de données est fréquemment mis à jour ou reçoit de nouvelles données, mais que vous n'avez pas besoin de retraiter l'ensemble du jeu de données, les modèles incrémentiels peuvent considérablement réduire le temps de traitement.

- s de données en continu: Dans les cas où les données sont diffusées en continu ou mises à jour régulièrement, les modèles incrémentiels permettent de maintenir les transformations à jour sans tout relancer.

Comment utilisez-vous Jinja pour améliorer votre code SQL ?

Jinja rend notre code SQL plus flexible. Avec Jinja, nous pouvons définir des modèles réutilisables pour les schémas SQL courants. Et comme les exigences changent constamment, nous pouvons utiliser les instructions Jinja if pour ajuster nos requêtes SQL en fonction des conditions. Cela permet généralement d'améliorer le code SQL en décomposant la logique complexe, ce qui le rend plus facile à comprendre.

Par exemple, si vous souhaitez convertir le format de date « AAAA-MM-JJ » en « MM/JJ/AAAA », voici un exemple de macro dbt pour cela, que nous avons vu dans une question précédente :

{% macro change_date_format(column_name) %}

to_char({{ column_name }}::date, 'MM/DD/YYYY')

{% endmacro %}Dans cet exemple de code, {{ column_name }} est l'endroit où Jinja insère le nom réel de la colonne lorsque vous utilisez la macro. Il sera remplacé par le nom réel de la colonne lors de l'exécution. Comme nous l'avons observé dans les exemples précédents, Jinja utilise l'{{ }} e pour indiquer où le remplacement aura lieu.

Comment créeriez-vous une matérialisation personnalisée dans dbt ?

Voici comment créer une matérialisation personnalisée dans dbt :

- Veuillez créer le fichier SQL pour la matérialisation personnalisée.

- Ensuite, définissez une macro de matérialisation comme suit :

materialization_name:

{% materialization materialization_name, default -%}- Veuillez utiliser les macros prédéfinies de dbt

adapter.get_relationpour configurer la table cible. C'est ici que les données seront chargées. - Veuillez maintenant définir et exécuter les commandes SQL pour créer et charger les données dans les tableaux :

{% set sql %}

SELECT * FROM {{ ref('your_source_table') }}

WHERE your_conditions = true

{% endset %}

{{ adapter.execute(sql) }}- Enfin, renvoyez la relation cible afin de mettre à jour le cache de dbt et d'optimiser l'exécution de la requête.

{{ return(target_relation) }}

{% endmaterialization %}Comment pouvez-vous déboguer vos modèles dbt ? Veuillez nous indiquer deux méthodes.

Voici deux méthodes pour déboguer nos modèles dbt :

1. Veuillez accéder aux fichiers SQL compilés dans le dossier cible afin d'identifier et de suivre les erreurs.

Lorsque vous exécutez un projet dbt, dbt compile vos modèles (rédigés à l'aide du système de modèles Jinja) en requêtes SQL brutes et les enregistre dans le répertoire target. Ce SQL compilé correspond exactement à ce que dbt exécute sur votre plateforme de données. Par conséquent, l'examen de ces fichiers peut vous aider à identifier les sources des problèmes :

- Veuillez exécuter vos modèles dbt (par exemple,

dbt runoudbt test). - Veuillez vous rendre dans le dossier «

target/compiled/» de votre répertoire de projet dbt. - Veuillez ouvrir le fichier SQL compilé pour le modèle que vous déboguez. Le fichier contiendra le code SQL brut exécuté par dbt, y compris toutes les transformations issues des macros Jinja et des références.

- Veuillez copier la requête SQL compilée et l'exécuter directement dans l'éditeur SQL de votre plateforme de données (par exemple, Postgres, BigQuery) afin d'obtenir des messages d'erreur détaillés ou d'observer le comportement réel de la requête.

2. Veuillez utiliserl'extension dbt Power User Extension pour VS Code d' afin d'examiner directement les résultats des requêtes.

L'extension dbt Power User pour Visual Studio Code (VS Code) est un outil utile pour le débogage des modèles dbt. Cette extension vous permet de réviser et de tester vos requêtes directement dans votre IDE, ce qui réduit le besoin de basculer entre dbt, le terminal et votre base de données.

Comment le dbt compile-t-il les requêtes ?

dbt compile les requêtes en suivant les étapes suivantes :

- Analyse: dbt lit tous les fichiers SQL, les configurations YAML et les macros du projet.

- Création de contexte: Il établit un contexte pour chaque modèle, y compris les configurations et les macros disponibles.

- s de rendu Jinja: Il traite ensuite les fichiers SQL comme des modèles Jinja afin de remplacer les balises et les expressions par les résultats évalués.

- s de compilation SQL: Des requêtes SQL pures sont générées pour chaque modèle.

- Génération d'artefacts : Le SQL compilé est enregistré dans le répertoire

target/compiled. - Préparation de l'exécution : Pour l'

dbt run, les requêtes sont préparées pour exécution, éventuellement avec un encapsulage supplémentaire.

Ce processus transforme le SQL modulaire et basé sur des modèles en requêtes exécutables spécifiques à votre entrepôt de données. Nous pouvons utiliser dbt compile ou consulter le répertoire target/compiled pour visualiser et déboguer le SQL final pour chaque modèle.

Questions d'entretien relatives au stockage et à l'intégration des données avec dbt

La plupart des ingénieurs de données ont pour mission de créer et d'intégrer des entrepôts de données avec dbt. Les questions relatives à ces scénarios sont fréquentes lors des entretiens. C'est pourquoi j'ai compilé les questions les plus courantes :

Veuillez expliquer trois avantages de l'intégration de dbt avec Airflow.

L'intégration de dbt à Airflow contribue à la création d'un pipeline de données rationalisé. Voici quelques-uns de ses avantages :

- Processus ETL : Airflow gère l'extraction et le chargement des données, permettant ainsi à dbt de se concentrer sur l'étape de transformation, ce qui se traduit par un flux de travail global plus fluide.

- Automatisation des tâches dbt : Airflow automatise la planification et l'exécution des modèles dbt, réduisant ainsi les interventions manuelles et améliorant l'efficacité de vos transformations de données.

- Exécution de tâches en parallèle : Airflow permet d'exécuter des tâches en parallèle, ce qui facilite le traitement de grands ensembles de données sans compromettre les performances, contribuant ainsi à maintenir des pipelines de données rapides et fiables.

Quelle est l'architecture de la couche sémantique de dbt ?

La couche sémantique de dbt nous permet de traduire les données brutes dans un langage que nous comprenons. Nous pouvons également définir des métriques et les interroger à l'aide d'une interface de ligne de commande (CLI).

Cela nous permet d'optimiser les coûts, car la préparation des données prend moins de temps. De plus, tous les collaborateurs utilisent les mêmes définitions de données, ce qui garantit la cohérence des indicateurs à l'échelle de l'organisation.

dbt et la couche sémantique. Source de l'image : dbt

Si vous utilisez BigQuery, dbt constitue-t-il une couche supplémentaire inutile de transformation des données ?

Bien que BigQuery soit très utile et puisse gérer de nombreuses transformations de manière native, dbt peut encore s'avérer nécessaire. Voici pourquoi :

- dbt vous permet de contrôler les versions de vos transformations, ce qui n'est pas pris en charge de manière native dans BigQuery.

- dbt fournit des cadres de test intégrés et une génération de documentation qui améliorent la qualité et la compréhension des données.

- La fonction et les macros dbt d'

ref()permettent d'obtenir un code SQL plus modulaire et réutilisable. - dbt simplifie la gestion de plusieurs environnements (développement, test, production) dans BigQuery.

- dbt offre une méthode cohérente pour gérer les dépendances entre les transformations.

La technologie dbt assure-t-elle la sécurité des données ?

Comme indiqué dans une question précédente, dbt existe en deux versions : dbt Core et dbt Cloud. dbt Core est open source et constitue la version gratuite. C'est pourquoi il ne propose aucune fonctionnalité de sécurité intégrée, et les utilisateurs sont responsables de son déploiement et de sa sécurité.

Cependant, dbt Cloud est conçu pour offrir une sécurité totale. Il est conforme à la loi HIPAA et à d'autres cadres réglementaires courants afin de garantir la protection de la vie privée. Par conséquent, en fonction de nos besoins, il est nécessaire de sélectionner une version de DBT qui répond aux exigences de conformité de notre entreprise.

Comment optimiser les performances des transformations dbt sur des ensembles de données volumineux ?

L'optimisation des transformations dbt pour les grands ensembles de données est essentielle pour améliorer les performances et réduire les coûts, en particulier lorsqu'il s'agit d'entrepôts de données basés sur le cloud tels que Snowflake, BigQuery ou Redshift. Voici quelques techniques clés pour optimiser les performances de dbt :

1. Utiliser des modèles incrémentiels

Les modèles incrémentiels permettent à dbt de traiter uniquement les données nouvelles ou mises à jour, au lieu de retraiter l'ensemble des données à chaque fois. Cela peut réduire considérablement les temps d'exécution pour les grands ensembles de données. Ce processus limite la quantité de données traitées, ce qui accélère les temps de transformation.

2. Tirez parti du partitionnement et du clustering (pour les bases de données telles que Snowflake et BigQuery).

Le partitionnement et le regroupement des grands tableaux dans des bases de données telles que Snowflake ou BigQuery contribuent à améliorer les performances des requêtes en organisant efficacement les données et en réduisant la quantité de données analysées lors des requêtes.

Le partitionnement garantit que seules les parties pertinentes d'un ensemble de données sont interrogées, tandis que le regroupement optimise la disposition physique des données pour une récupération plus rapide.

3. Optimiser les matérialisations (tableau, vue, incrémentielle)

Veuillez utiliser les matérialisations appropriées pour optimiser les performances :

- Les vues sont utiles pour les transformations légères, mais ne sont pas idéales pour les charges de travail importantes.

- Les tableaux stockent les données physiquement, ce qui améliore les performances mais nécessite davantage d'espace de stockage.

- Les modèles incrémentiels sont les plus adaptés aux grands ensembles de données qui font l'objet de mises à jour régulières.

4. Veuillez utiliser LIMIT pendant le développement.

Lors du développement de transformations, il est utile d'ajouter une clause d'LIMIT e aux requêtes afin de limiter le nombre de lignes traitées. Cela accélère les cycles de développement et évite de devoir manipuler des ensembles de données volumineux pendant les tests.

5. Exécutez des requêtes en parallèle

Tirez parti de la capacité de votre entrepôt de données à exécuter des requêtes en parallèle. Par exemple, dbt Cloud prend en charge le parallélisme, qui peut être ajusté en fonction de votre infrastructure.

6. Utiliser les fonctionnalités d'optimisation spécifiques à la base de données

De nombreux entrepôts de données dans le cloud offrent des fonctionnalités d'optimisation des performances telles que :

- BigQuery : Veuillez utiliser des vues matérialisées ou des tableaux partitionnés.

- Snowflake: Activez le regroupement automatique et la mise à l'échelle de l'entrepôt pour une exécution parallèle.

Comment optimisez-vous les exécutions dbt dans Snowflake ?

Pour optimiser les exécutions dbt dans Snowflake :

1. Veuillez utiliser le regroupement de tables :

{{ config(

cluster_by = ["date_column", "category_column"]

) }}

SELECT ...2. Tirez parti des entrepôts multi-clusters de Snowflake pour l'exécution parallèle de modèles :

models:

my_project:

materialized: table

snowflake_warehouse: transforming_wh3. Utilisez des modèles incrémentiels lorsque cela est approprié :

{{ config(materialized='incremental', unique_key='id') }}

SELECT *

FROM source_table

{% if is_incremental() %}

WHERE updated_at > (SELECT MAX(updated_at) FROM {{ this }})

{% endif %}Ces optimisations peuvent améliorer les performances et la rentabilité des exécutions dbt dans Snowflake.

Questions d'entretien sur le comportement et la résolution de problèmes (DBT)

À la fin du processus d'entretien, les recruteurs évaluent généralement vos capacités à résoudre des problèmes. Ils pourraient vous poser des questions afin d'évaluer votre réaction face à des situations réelles. Voici donc quelques questions relatives au comportement et à la résolution de problèmes :

Comment géreriez-vous le déploiement de DBT dans plusieurs environnements (développement, préproduction, production) ?

Voici comment vous pouvez gérer le déploiement dbt dans différents environnements :

1. Configurations spécifiques à l'environnement

dbt vous permet de définir différentes configurations pour chaque environnement (développement, préproduction et production) dans le fichier dbt_project.yml. Vous pouvez définir différents paramètres pour des éléments tels que les configurations de schéma, de base de données et d'entrepôt de données.

Exemple dans l'dbt_project.yml:

models:

my_project:

dev:

schema: dev_schema

staging:

schema: staging_schema

prod:

schema: prod_schemaDans cet exemple, dbt sélectionne automatiquement le schéma approprié en fonction de l'environnement cible (développement, préproduction ou production) lors de l'exécution du projet.

2. Utilisation de la variable cible

La variable target dans dbt est utilisée pour définir l'environnement dans lequel vous travaillez (développement, préproduction, production). Vous pouvez référencer cette variable dans vos modèles ou macros afin de personnaliser le comportement en fonction de l'environnement.

Exemple dans un modèle :

{% if target.name == 'prod' %}

SELECT * FROM production_table

{% else %}

SELECT * FROM {{ ref('staging_table') }}

{% endif %}Cette logique garantit que différentes tables ou différents schémas sont utilisés en fonction de l'environnement.

3. Contrôle des branches et des versions

Chaque environnement devrait disposer de sa propre branche dans le contrôle de version (par exemple, Git). Les développeurs travaillentsurk dans la branche dev, les testeurs et les analystes utilisent staging, et seules les modifications approuvées sont fusionnées dans la branche prod.

4. Intégration continue (CI) et déploiement continu (CD)

En production, il est essentiel de disposer d'un pipeline de déploiement automatisé qui exécute des tests et des validations avant de déployer les modèles. Dans dbt Cloud, il est possible de configurer des calendriers de tâches pour exécuter des tâches spécifiques en fonction de l'environnement. Pour dbt Core, cela peut être réalisé à l'aide d'outils CI/CD tels que GitHub Actions ou Jenkins.

Comment gérez-vous le contrôle des versions dans dbt, en particulier lorsque vous travaillez avec plusieurs membres de l'équipe ?

Le contrôle de version est essentiel lorsque l'on travaille sur des projets dbt, en particulier dans un environnement d'équipe où plusieurs personnes contribuent à la même base de code. Voici comment je gère le contrôle de version dans dbt :

1. Veuillez utiliser Git pour le contrôle de version.

Nous utilisons Git comme outil principal pour le contrôle de version dans nos projets dbt. Chaque membre de l'équipe travaille sur sa propre branche pour toutes les modifications ou fonctionnalités qu'il met en œuvre. Cela permet un développement isolé et évite les conflits entre les membres de l'équipe travaillant simultanément sur différentes tâches.

Exemple : Lorsque je travaille sur un nouveau modèle dbt, je crée une nouvelle branche de fonctionnalité telle que feature/customer_order_transformation.

2. Stratégie de ramification

Nous suivons une stratégie de branchement Git dans laquelle :

- La branche

devest utilisée pour le développement et les tests en cours. - La branche d'

stagingest utilisée pour préparer les modifications destinées à la production. - La branche

mainouprodest réservée à l'environnement de production.

Les membres de l'équipe transmettent leurs modifications à la branche d'dev s et ouvrent des demandes d'extraction (PR) pour les révisions de code. Une fois les modifications examinées et approuvées, elles sont fusionnées dans staging pour être testées plus avant, puis transférées vers production.

3. Intégration continue (CI)

Nous avons intégré un pipeline CI (par exemple, GitHub Actions, CircleCI) qui exécute automatiquement des tests dbt sur chaque pull request. Cela garantit que tout nouveau code passe les tests requis avant d'être fusionné dans la branche principale.

Le processus CI exécute dbt run pour créer des modèles et dbt test pour valider les données et vérifier s'il existe des erreurs ou des incohérences.

4. Résoudre les conflits de fusion

Lorsque plusieurs membres d'une équipe apportent des modifications au même modèle ou fichier, des conflits de fusion peuvent survenir. Pour y parvenir, j'examine d'abord les marqueurs de conflit dans le code et je détermine les modifications à conserver :

- Si les deux modifications sont valides, je les combine pour créer une nouvelle version.

- Si une seule série de modifications est correcte, je la conserve et j'ignore l'autre.

Après avoir résolu le conflit, je procède à des tests en local afin de m'assurer que la résolution du conflit n'a pas introduit de nouvelles erreurs. Une fois confirmé, je renvoie les modifications résolues vers la branche.

5. Documentation et collaboration

Nous veillons à ce que chaque demande de fusion ou d'extraction comprenne une documentation adéquate des modifications apportées. Nous mettons à jour la documentation dbt générée automatiquement afin que tous les membres de l'équipe aient une compréhension claire des modèles nouveaux ou mis à jour.

Comment intégreriez-vous dbt dans un pipeline de données existant ?

Voici comment j'implémenterais dbt dans un pipeline existant :

- Évaluer le pipeline actuel : Identifier les inefficacités et les domaines dans lesquels dbt peut améliorer les processus de transformation.

- Configurer dbt : Veuillez installer dbt, créer un nouveau projet et configurer les connexions à l'entrepôt de données.

- Convertir les transformations : Transférez la logique SQL ou de transformation existante vers des modèles dbt, en garantissant la modularité et la clarté.

- Veuillez ajouter les tests et la documentation : Mettre en œuvre les tests et la documentation intégrés à dbt afin de garantir la qualité et la transparence des données.

- Intégrer avec l'orchestration : Planifiez l'exécution de dbt à l'aide d'outils existants tels qu'Airflow ou Prefect.

- Commencez modestement : Mettre en œuvre dbt sur un petit sous-ensemble du pipeline afin de valider les modifications avant de passer à l'échelle supérieure.

- Surveiller et optimiser : Surveillez en permanence les performances et optimisez les modèles si nécessaire.

Veuillez imaginer qu'un modèle DBT échoue en raison de l'erreur « relation does not exist » (relation inexistante). Comment procédez-vous pour corriger une erreur de ce type ?

Lorsque vous rencontrez une erreur « relation does not exist » dans dbt, cela signifie généralement que le modèle tente de référencer une table ou un modèle qui n'a pas été créé ou qui comporte une erreur orthographique. Voici comment je procéderais pour le déboguer :

- Veuillez vérifier les éventuelles erreurs de frappe : Veuillez vous assurer que le nom de la table ou du modèle est correctement orthographié dans la fonction d'

ref(), et vérifiez que le modèle ou la table correct(e) est référencé(e).

SELECT * FROM {{ ref('orders') }} -- Ensure 'orders' is the correct model name- Vérifiez les dépendances du modèle: Si votre modèle dépend d'autres modèles, veuillez vérifier le DAG (graphe acyclique dirigé) dbt afin de vous assurer que les modèles en amont ont été correctement construits avant l'exécution du modèle défaillant.

- Exécutez dbt en mode débogage: Veuillez utiliser la commande `

dbt debug` et examiner les journaux pour obtenir des informations détaillées sur les actions que dbt a tenté d'effectuer et les raisons de l'échec. - Veuillez vérifier les autorisations de la plateforme de données: Veuillez vous assurer que dbt dispose des autorisations nécessaires pour accéder au tableau ou au modèle référencé dans l'entrepôt de données.

- Exécutez les modèles individuels: Veuillez essayer d'exécuter les modèles dépendants individuellement (par exemple,

dbt run --models orders) afin de vérifier qu'ils existent et qu'ils sont correctement construits avant le modèle défaillant.

Conseils pour se préparer à un entretien dbt

dbt est un nouveau cadre qui s'améliore progressivement. Il peut être difficile de suivre les nouvelles mises à jour tout en continuant à apprendre l'ancienne matière. C'est pourquoi il est important d'adopter une approche équilibrée et de commencer par les fonctionnalités essentielles. Une fois que vous les maîtrisez, veuillez examiner les ajouts afin de comprendre ce qui a changé.

Je comprends que les entretiens puissent être stressants, en particulier pour un outil spécialisé tel que dbt. Cependant, ne vous inquiétez pas, j'ai rassemblé quelques conseils pour vous aider à vous préparer et à vous sentir en confiance :

Fonctionnalités principales de DBT

Je ne saurais trop insister sur ce point : familiarisez-vous avec les concepts fondamentaux de DBT, notamment les modèles, les tests, la documentation et la manière dont ils s'articulent entre eux. Une bonne maîtrise de ces notions fondamentales vous sera très utile dans les discussions techniques.

DataCamp propose le cours idéal pour cela : Introduction à dbt

DataCamp propose également des cours adaptés aux débutants qui abordent en profondeur d'autres thèmes liés à l'ingénierie des données :

- Pour les principes fondamentaux de l'ingénierie des données : Comprendre l'ingénierie des données

- Pour la conception de bases de données : Conception de bases de données

- Pour les notions de base sur le stockage de données : Concepts de stockage de données

- Pour les notions de base sur Snowflake : Présentation de Snowflake

- Pour l'architecture des données : Comprendre l'architecture moderne des données

- Pour apprendre l'ETL et l'ELT en Python : ETL et ELT en Python

Acquérez une expérience pratique avec dbt

Il est utile de lire sur un sujet, mais il est encore plus efficace de le mettre en pratique. Il s'agit de l'une des méthodes les plus efficaces pour acquérir les compétences en matière de thérapie comportementale dialectique. Vous pouvez trouver une liste exhaustive de jeux de données brutes en ligne pour effectuer des transformations et exécuter des tests. Veuillez configurer votre propre projet dbt et explorer ses différentes fonctionnalités. Cela vous permettra de vous sentir beaucoup plus à l'aise pour discuter de la TCD lorsque vous l'aurez réellement utilisée.

Préparez des exemples concrets

Les recruteurs apprécient particulièrement les exemples concrets. Pourriez-vous citer un problème que vous avez résolu à l'aide de dbt ou expliquer comment vous pourriez l'utiliser dans un scénario hypothétique ? Veuillez préparer quelques exemples de ce type à partager. Pour recueillir quelques exemples, vous pouvez également étudier plusieurs études de cas sur le site officiel de dbt ou vous inspirer des projets dbt publics sur Git.

Conclusion

Nous avons abordé un large éventail de questions d'entretien DBT, des plus basiques aux plus avancées, qui vous aideront dans votre recherche d'emploi. En comprenant comment intégrer dbt aux entrepôts de données dans le cloud, vous acquerrez des compétences avancées en matière de transformation des données, qui sont au cœur de tout processus d'intégration des données.

Cependant, l'apprentissage du DBT et du SQL sont étroitement liés. Si vous débutez avec SQL, nous vous invitons à consulter les cours SQL de DataCamp.

Devenez certifié SQL

Questions fréquentes

Combien de temps faut-il pour maîtriser la thérapie comportementale dialectique (TCD) ?

Il peut être nécessaire de quelques mois pour maîtriser pleinement les compétences en matière de TCD. Cependant, si vous y consacrez quelques heures par jour, vous pouvez l'apprendre rapidement.

Comment puis-je apprendre la TCD par moi-même ?

Vous pouvez utiliser des ressources en ligne telles que les cours de DataCamp, les tutoriels YouTube et les articles de blog. De plus, essayez de développer vos projets en réécrivant des projets existants. Cela renforcera vos compétences pratiques.

La DBT élimine-t-elle le rôle des ingénieurs de données ?

Non, le dbt n'élimine pas le rôle des ingénieurs de données. Au contraire, cela les assiste dans leur travail. Ils peuvent utiliser ce cadre pour automatiser des tâches telles que les transformations et les tests.

Je suis un stratège du contenu qui aime simplifier les sujets complexes. J'ai aidé des entreprises comme Splunk, Hackernoon et Tiiny Host à créer un contenu attrayant et informatif pour leur public.