Lernpfad

dbt (Data Build Tool) ist mittlerweile ein echt beliebtes Entwicklungsframework in modernen Datenverarbeitungs- und Analyse-Workflows. Datenanalysten verlassen sich meistens auf Dateningenieure, um Transformationen in SQL zu schreiben. Aber mit dbt können sie Transformationen schreiben und haben mehr Kontrolle über die Daten. Außerdem kann man es mit beliebten Versionskontrollsystemen wie Git verbinden, was die Zusammenarbeit im Team echt verbessert.

Wenn du dich auf einen Job im Bereich Data Warehouse vorbereitest, wie zum Beispiel als Dateningenieur, Datenanalyst oder Datenwissenschaftler, solltest du dich mit grundlegenden und fortgeschrittenen dbt-Fragen gut auskennen!

In diesem Artikel habe ich die häufigsten Interviewfragen zusammengefasst, damit du dir grundlegende Konzepte und fortgeschrittene Problemlösungsfähigkeiten aneignen kannst.

Was ist DBT?

dbt ist ein Open-Source-Framework für die Datenumwandlung, mit dem du Daten umwandeln, auf Genauigkeit prüfen und Änderungen auf einer einzigen Plattform verfolgen kannst. Anders als andere ETL-Tools (Extrahieren, Transformieren, Laden) macht dbt nur den Transformationsteil (das T).

Einige andere ETL-Tools holen Daten aus verschiedenen Quellen, machen sie außerhalb des Data Warehouse fertig und laden sie dann wieder rein. Dafür braucht man oft spezielle Programmierkenntnisse und zusätzliche Tools. Aber dbt macht das einfacher – es ermöglicht Transformationen im Warehouse nur mit SQL.

Über 40.000 große Unternehmen nutzen dbt, um ihre Daten zu optimieren – deshalb sagen Personalvermittler, dass es eine der wichtigsten Fähigkeiten für Jobs im Datenbereich ist. Wenn du das also schon als Anfänger im Bereich Daten beherrschst, kann dir das viele Karrierechancen eröffnen!

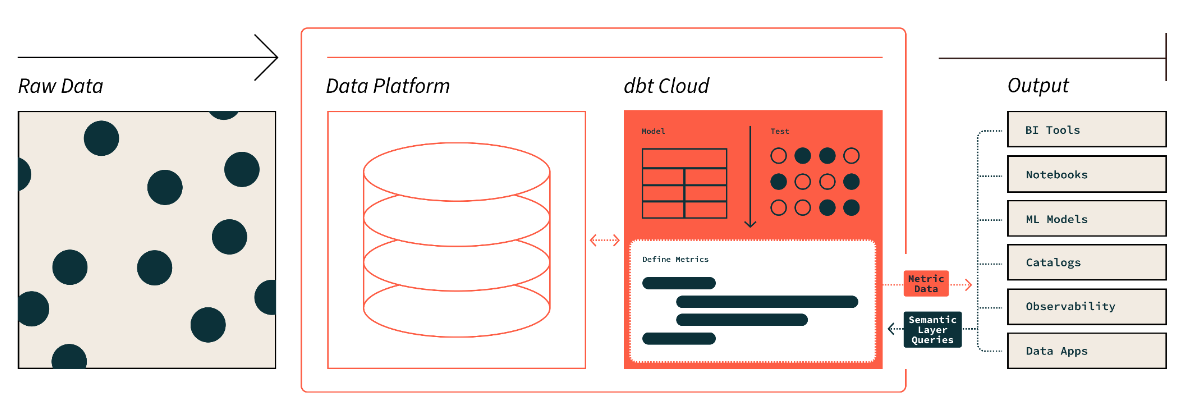

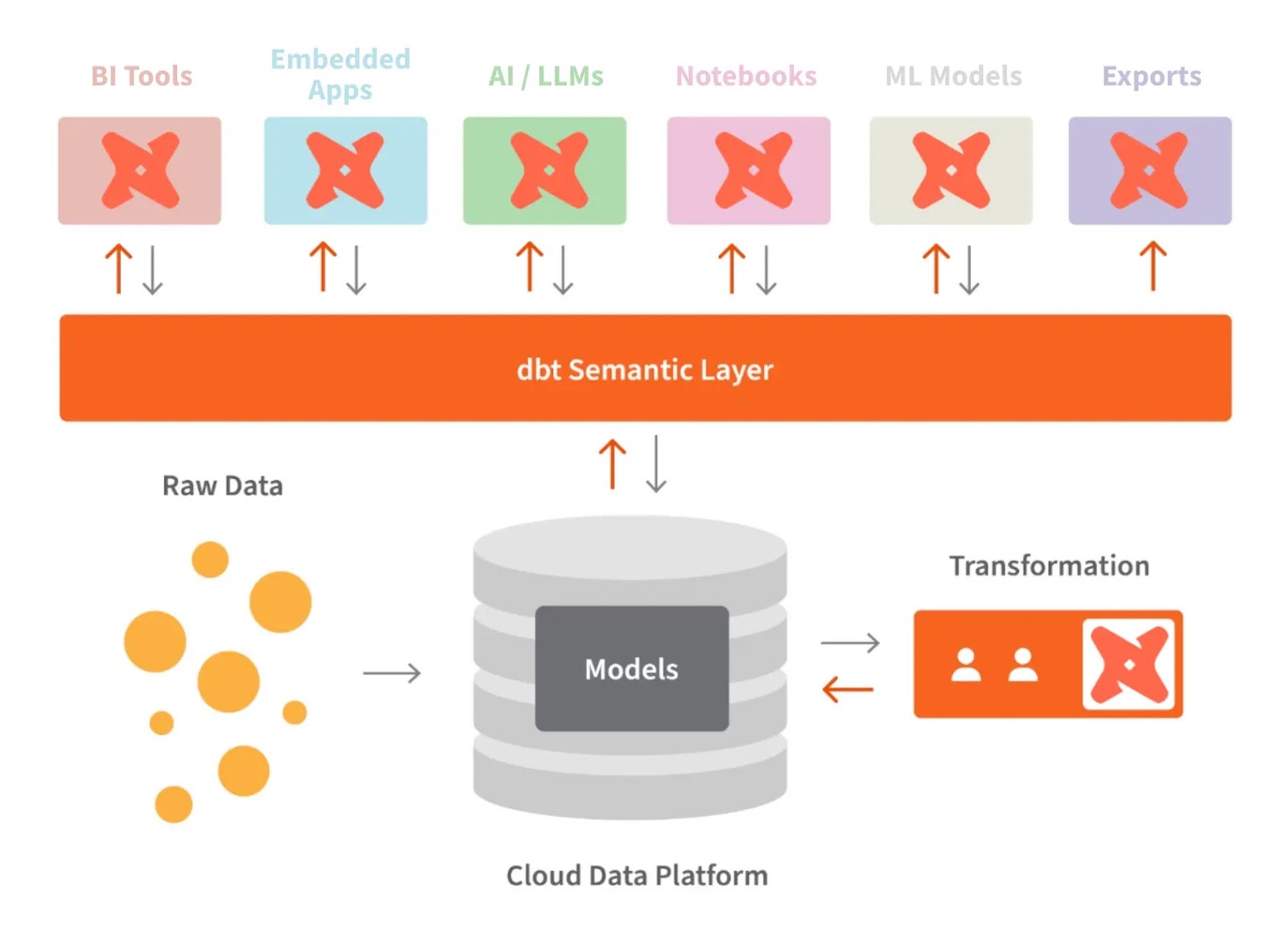

Die semantische Ebene von DBT. Bildquelle: dbt

Grundlegende Fragen zum DBT-Interview

Der Interviewer wird am Anfang des Vorstellungsgesprächs deine Grundkenntnisse checken. Dafür stellen sie dir vielleicht ein paar grundlegende Fragen wie diese:

Wofür wird DBT meistens benutzt?

dbt bringt ein Datenteam auf eine Seite, wo sie ihre Daten umwandeln, dokumentieren und testen können. Es hilft dabei, dass die Daten zuverlässig und leicht verständlich sind. Zu den gängigen Anwendungen von dbt gehören:

- Datenumwandlung: Das ist der Kern der Analysearbeit. dbt kümmert sich um alles, vom Schreiben von SQL-Abfragen bis zur Wartung technischer Pipelines, was die Arbeit von Datenanalysten und Ingenieuren erleichtert.

- Testen: Es ist wichtig, den Code vor dem Einsatz zu überprüfen. Mit dbt kannst du mehrere Tests machen, um die Genauigkeit und Zuverlässigkeit der Daten sicherzustellen.

- Dokumentation: So können die anderen Teammitglieder die Datensätze besser verstehen. Hier können wir eine Beschreibung unseres Codes, Tabellen, DAG (Directed Acyclic Graph) und von dir durchgeführte Tests hinzufügen.

- Reibungslose Migration: dbt macht es einfacher, Datenmodelle zwischen Plattformen zu verschieben. Sobald wir das Modell erstellt haben, können wir es mit minimalen Änderungen an der Syntax migrieren.

Ist DBT eine Programmiersprache?

Nein, dbt ist keine Programmiersprache. Das ist ein Tool, das bei der Datenumwandlung im Lager hilft. Wenn du SQL schreiben kannst, kannst du ganz einfach mit dbt arbeiten. Es unterstützt jetzt auch Python für bestimmte Aufgaben. Aber im Grunde genommen verwaltet und führt es SQL-basierte Transformationen aus.

Kannst du mal erklären, wie sich dbt im Vergleich zu Spark verhält?

dbt und Spark haben unterschiedliche Aufgaben und sind für verschiedene Arten von Arbeitsabläufen gedacht. Hier ist ein Vergleich ihrer Rolle in der Dateninfrastruktur:

|

Feature |

dbt |

Spark |

|

Rolle |

SQL-basierte Datenumwandlungen und Modellierung |

Verteilte Datenverarbeitung und -analyse |

|

Kernsprache |

SQL-first, mit eingeschränkter Python-Unterstützung |

Supports SQL, Python, Scala, Java, R |

|

Datenverwaltung |

Unterstützung bei Dokumentation und Abstammung |

Bietet Zugriffskontrolle, Überwachung und Datenherkunft |

|

Zielgruppe |

SQL-Nutzer, Analysten und Teams ohne technische Kenntnisse |

Dateningenieure, Datenwissenschaftler, Entwickler |

|

Komplexität der Transformation |

Konzentriert sich nur auf SQL-Transformationen und Modellierung |

Kann auch komplexe Umwandlungen in anderen Sprachen machen. |

|

Testen und Validieren |

Hat eingebaute Testfunktionen |

Benötige maßgeschneiderte Teststrategien (Unit- und Integrationstests) |

Was sind die Herausforderungen bei DBT?

Obwohl dbt für Datenteams echt nützlich ist, kann es auch ein paar Probleme mit sich bringen, vor allem wenn der Umfang und die Komplexität zunehmen. Einige der häufigsten Herausforderungen sind also:

- Steile Lernkurve: Neue Nutzer könnten Probleme mit Sachen wie Datenmodellierung, Jinja-Templating und Projektstrukturierung haben.

- Datenqualität und Test: Bei großen Projekten kann es echt kompliziert sein, eine ausreichende Testabdeckung sicherzustellen und die Tests zu pflegen.

- Skalierungsprobleme: Bei großen Datensätzen oder komplizierten Umwandlungen kann es zu Performance-Engpässen kommen.

- Abhängigkeitsmanagement-: Das Verwalten von Abhängigkeiten und das Beheben von Problemen mit der DAG kann bei wachsenden Projekten echt schwierig sein.

- Orchestrierung: Die Integration von dbt in größere Arbeitsabläufe kann schwierig sein, vor allem bei benutzerdefinierten Zeitplänen.

- Dokumentation: Die Modelldokumentation und Tests auf dem neuesten Stand zu halten, kann echt zeitaufwendig sein.

- Datenbankspezifische Einschränkungen: Verschiedene Datenplattformen können unterschiedliche Kompatibilitäten und Funktionen haben.

- Umstellung von alten Tools auf: Die Anpassung von Arbeitsabläufen aus alten ETL-Tools kann echt schwierig sein.

- Komplexe Geschäftslogik: Die Handhabung komplexer Logik innerhalb von dbt kann Makros erfordern, was die Komplexität erhöht.

Zu wissen, wie man mit den oben genannten möglichen Herausforderungen umgeht, ist etwas, worauf Arbeitgeber achten. Übersieh also nicht, wie wichtig diese Frage ist.

Was ist der Unterschied zwischen dbt Core und dbt Cloud?

Es gibt zwei Hauptversionen von dbt:

dbt Core ist die kostenlose Open-Source-Version von dbt, mit der man SQL-basierte Transformationen lokal schreiben, ausführen und verwalten kann. Es bietet eine Befehlszeilenschnittstelle (CLI) zum Ausführen von dbt-Projekten, Testen von Modellen und Erstellen von Datenpipelines. Da es sich um Open Source handelt, musst du bei dbt Core selbst für die Bereitstellung, Orchestrierung und Infrastrukturkonfiguration sorgen, normalerweise in einer Umgebung wie, die mit Tools wie Airflow oder Kubernetes für die Automatisierung integriert ist.

dbt Cloud ist dagegen ein Managed Service, den die Macher von dbt (Fishtown Analytics) anbieten. Es hat alle Funktionen von dbt Core und noch mehr Sachen wie eine Web-Oberfläche, integrierte Planung, Job-Management und Tools für die Zusammenarbeit. dbt Cloud hat auch baute CI/CD-Funktionen (Continuous Integration und Deployment), API-Zugriff und verbesserte Sicherheitsstandards wie SOC 2 und HIPAA für Unternehmen mit strengeren Sicherheitsanforderungen.

Werde Dateningenieur

Fragen für Vorstellungsgespräche für Fortgeschrittene im Bereich DBT

Nachdem wir jetzt die grundlegenden dbt-Fragen geklärt haben, kommen wir zu ein paar dbt-Fragen für Fortgeschrittene. Die konzentrieren sich auf bestimmte technische Sachen und Konzepte.

Was sind Quellen in dbt?

In dbt sind Quellen die Rohdaten-Tabellen. Wir schreiben keine SQL-Abfragen direkt in diese Rohdaten-Tabellen – wir geben das Schema und den Tabellennamen an und legen sie als Quellen fest. Das macht es einfacher, auf Datenobjekte in Tabellen zu verweisen.

Stell dir vor, du hast eine Rohdaten-Tabelle namens „ orders ” in deiner Datenbank im Schema „ sales ”. Anstatt diese Tabelle direkt abzufragen, würdest du sie in dbt wie folgt als Quelle definieren:

Leg die Quelle in deiner Datei „ sources.yml “ fest:

version: 2

sources:

- name: sales

tables:

- name: ordersBenutze die Quelle in deinen dbt-Modellen:

Sobald du das gemacht hast, kannst du in deinen Transformationen wie folgt auf die Tabelle „raw- orders ” zugreifen:

SELECT *

FROM {{ source('sales', 'orders') }}Dieser Ansatz abstrahiert die Roh-Tabellendefinition, was die Verwaltung vereinfacht und sicherstellt, dass du bei Änderungen an der zugrunde liegenden Tabellenstruktur diese an einer Stelle (der Quelldefinition) aktualisieren kannst, anstatt jede Abfrage einzeln anzupassen.

Vorteile der Verwendung von Quellen in dbt:

- Organisation: Quellen organisieren deine Rohdaten und machen es einfacher, sie innerhalb eines Projekts zu verwalten.

- Zusammenfassung: Du abstrahierst die Schemadetails, reduzierst Fehler und verbesserst die Flexibilität.

- Dokumentation: Das Festlegen von Quellen hilft dir dabei, deine Rohdateneingaben besser zu dokumentieren.

Was ist ein DBT-Modell?

Ein DBT-Modell ist im Grunde eine SQL- oder Python-Datei, die die Transformationslogik für Rohdaten festlegt. In dbt sind Modelle die Kernkomponente, in der du deine Transformationen schreibst, egal ob es sich um Aggregationen, Verknüpfungen oder irgendeine Art von Datenbearbeitung handelt.

- SQL-Modelle in dbt verwenden „

SELECT“-Anweisungen, um Transformationen zu definieren, und werden als „sql“-Dateien gespeichert. - Python-Modelle, die mit der Unterstützung von Python durch dbt eingeführt wurden, werden als „

.py“-Dateien gespeichert und ermöglichen es dir, Python-Bibliotheken wie pandas zur Datenbearbeitung zu nutzen.

Beispiel für ein SQL-Modell:

Ein SQL-Modell macht Rohdaten mit SQL-Abfragen fertig. Zum Beispiel, um eine Zusammenfassung der Bestellungen aus einer Tabelle „ orders ” zu erstellen:

--orders_summary.sql

WITH orders_cte AS (

SELECT

customer_id,

COUNT(order_id) AS total_orders,

SUM(order_amount) AS total_revenue

FROM {{ ref('orders') }}

GROUP BY customer_id

)

SELECT *

FROM orders_cteIn diesem Beispiel:

- Das Modell „

orders_summary.sql“ erstellt mit SQL eine Übersicht über die Gesamtbestellungen und den Gesamtumsatz für jeden Kunden. - Das Modell bezieht sich auf die Tabelle „

orders“ (die schon als dbt-Modell oder -Quelle definiert ist).

Python-Modellbeispiel:

Ein Python-Modell bearbeitet Rohdaten mit Python-Code. Das kann besonders nützlich sein, wenn es um komplizierte Logik geht, die in SQL echt nervig sein kann.

# orders_summary.py

import pandas as pd

def model(dbt, session):

# Load the source data

orders = dbt.ref("orders").to_pandas()

# Perform transformations using pandas

orders_summary = orders.groupby('customer_id').agg(

total_orders=('order_id', 'count'),

total_revenue=('order_amount', 'sum')

).reset_index()

return orders_summaryIn diesem Beispiel:

- Das Python-Modell nutzt pandas, um die Daten zu verarbeiten, indem es die Bestellungen nach Kunden gruppiert und die Gesamtzahl der Bestellungen sowie den Umsatz berechnet.

- Das Ergebnis wird dann als DataFrame zurückgegeben, den dbt in seine Pipeline einbauen kann.

Wie würdest du ein DBT-Modell erstellen?

So machst du ein dbt-Modell:

- Machim dbt-Projekt ein Verzeichnis unter demOrdner „

models“ an. - Füge eine neue Textdatei mit der Endung „

.sql“ in das Verzeichnis ein (oder „.py“, wenn es sich um ein Python-Modell handelt). - Schreib jetzt eine SQL-Abfrage oder einen Code, um die Rohdaten umzuwandeln.

- Mach denBefehl „

dbt run“ ab,um die Transformation anzuwenden und das Modell zu erstellen.

Wie geht dbt mit Abhängigkeiten zwischen Modellen um?

dbt regelt Modellabhängigkeiten mit der Funktion „ ref() “, die eine klare Abhängigkeitskette zwischen den Modellen aufbaut.

Wenn du eine Transformation in dbt definierst, verweist du nicht direkt auf Tabellen in deinem Warehouse, sondern auf andere dbt-Modelle mithilfe der Funktion „ ref() “. Dadurch wird sichergestellt, dass dbt die Modelle in der richtigen Reihenfolge erstellt, indem es erkennt, welche Modelle von anderen abhängig sind.

Wenn du zum Beispiel ein Modell namens „ orders_summary ” hast, das vom Modell „ orders ” abhängt, würdest du es so definieren:

WITH orders AS (

SELECT * FROM {{ ref('orders') }}

)

SELECT

customer_id,

COUNT(order_id) AS total_orders,

SUM(order_amount) AS total_revenue

FROM orders

GROUP BY customer_idIn diesem Beispiel sorgt die Funktion „ {{ ref('orders') }} ” dafür, dass das Modell „ orders ” vor „ orders_summary ” erstellt wird, weil „ orders_summary ” auf die Datenim Modell „ orders ” angewiesen ist .

Was sind Makros in dbt und wie kannst du sie ausführen?

Makros in dbt sind wiederverwendbare Blöcke von SQL-Code, die mit der Jinja-Template-Engine geschrieben wurden. Damit kannst du sich wiederholende Aufgaben automatisieren, komplexe Logik abstrahieren und SQL-Code in mehreren Modellen wiederverwenden, was dein dbt-Projekt effizienter und wartungsfreundlicher macht.

Makros kannst du in den Dateien „ .sql “ im Verzeichnis „ macros “ deines dbt-Projekts festlegen.

Makros sind echt praktisch, wenn du ähnliche Änderungen an mehreren Modellen vornehmen musst oder umgebungsabhängige Logik brauchst, wie zum Beispiel verschiedene Schemata verwenden oder Datumsformate je nach Einsatzumgebung (z. B. Entwicklung, Staging oder Produktion) anpassen.

Beispiel für die Erstellung von Makros:

- Makro für die Datumsformatierung: Du kannst ein Makro erstellen, um die Datumsformatierung in allen Modellen zu vereinheitlichen. Anstatt die Logik für das Datumsformat zu wiederholen, kannst du ein Makro wie dieses erstellen:

-- macros/date_format.sql

{% macro format_date(column) %}

FORMAT_TIMESTAMP('%Y-%m-%d', {{ column }})

{% endmacro %}Verwendung in einem Modell:

SELECT

customer_id,

{{ format_date('order_date') }} AS formatted_order_date

FROM {{ ref('orders') }}In diesem Beispiel wird das Makro „ format_date “ benutzt, um das Format der Spalte „ order_date “ in jedem Modell, in dem es aufgerufen wird, zu standardisieren.

- Benutzerdefiniertes Schema-Namensmakro: Dieses Makro ändert die Schemanamen je nach Umgebung (z. B. Entwicklung oder Produktion) dynamisch. Das hilft dabei, Umgebungen zu verwalten, ohne Schemanamen manuell ändern zu müssen.

-- macros/custom_schema.sql

{% macro custom_schema_name() %}

{% if target.name == 'prod' %}

'production_schema'

{% else %}

'dev_schema'

{% endif %}

{% endmacro %}Verwendung in einem Modell:

SELECT *

FROM {{ custom_schema_name() }}.ordersHier checkt das Makro, ob die Umgebung (target.name) „prod” ist, und gibt dann den richtigen Schemanamen zurück.

So führst du Makros aus:

Makros werden nicht direkt wie SQL-Modelle ausgeführt. Stattdessen werden sie in deinen Modellen oder anderen Makros referenziert und ausgeführt, wenn das dbt-Projekt läuft. Wenn du zum Beispiel ein Makro in einem Modell benutzt, wird das Makro ausgeführt, wenn du den Befehl „ dbt run “ (Modell ausführen) startest.

- Aufruf eines Makros innerhalb eines Modells: Wenn du ein Makro in ein SQL-Modell einbaust, wird das Makro während der Ausführung des Modells gemacht.

- Makros manuell ausführen: Du kannst bestimmte Makros auch manuell ausführen, indem du sie mit dem Befehl „

dbt run-operation“ aufrufst. Das wird meistens für einmalige Aufgaben benutzt, wie zum Beispiel das Einfügen von Daten oder Wartungsarbeiten.

Was sind die beiden Testarten in DBT?

Einzelne Tests und generische Tests sind die beiden Testtypen in dbt:

- Einzelne Tests konzentrieren sich auf bestimmte Bedingungen in einem DBT-Modell. Wenn die Testbedingung nicht stimmt, werden die Zeilen zurückgegeben.

Beispiel: Angenommen, du willst sicherstellen, dass keine Bestellungen einen negativen Wert für „ order_amount “ haben. Du kannst einen einzelnen Test im Verzeichnis „ tests ” wie folgt schreiben:

-- tests/no_negative_order_amount.sql

SELECT *

FROM {{ ref('orders') }}

WHERE order_amount < 0Wenn dieser Test nicht klappt, gibt dbt alle Zeilen aus der Tabelle „ orders ” zurück, bei denen „ order_amount ” negativ ist.

- Generische Tests sind vordefinierte Tests, die Argumente akzeptieren. Sie werden weiter in folgende Typen unterteilt:

|

Allgemeine Tests |

Definition |

|

Einzigartig |

Überprüft die Spalte auf eindeutige Werte. |

|

Nicht null |

Überprüft, ob irgendwelche Felder leer sind. |

|

Mögliche Werte |

Überprüft, ob die Spaltenwerte mit einer Liste erwarteter Werte übereinstimmen, um die Standardisierung aufrechtzuerhalten. |

|

Beziehungen |

Überprüft die Referenzintegrität zwischen Tabellen, um inkonsequente Daten zu entfernen. |

Beispiel: Du kannst ganz einfach einen generischen Test machen, um sicherzustellen, dass „ customer_id ” in der Tabelle „ customers ” eindeutig und nicht null ist, indem du das in deiner Datei „ schema.yml ” festlegst:

version: 2

models:

- name: customers

columns:

- name: customer_id

tests:

- unique

- not_nullIn diesem Beispiel:

- Der einzigartige Test checkt, ob jeder Eintrag „

customer_id” in der Tabelle „customers” einzigartig ist. - Der not_null-Test checkt, ob keine Werte von

customer_idfehlen oder null sind.

Fragen für Fortgeschrittene zum Thema DBT

Im Laufe deiner Arbeit wirst du vielleicht auf komplexere Szenarien und fortgeschrittene Konzepte stoßen. Hier sind ein paar knifflige Interviewfragen, die dir helfen sollen, dein Fachwissen einzuschätzen und dich auf leitende Positionen im Bereich Data Engineering vorzubereiten.

Wie kannst du in dbt inkrementelle Modelle erstellen und wann würdest du sie verwenden?

Inkrementelle Modelle in dbt werden verwendet, um nur neue oder geänderte Daten zu verarbeiten, anstatt jedes Mal den gesamten Datensatz neu zu verarbeiten. Das ist besonders praktisch, wenn man mit großen Datensätzen arbeitet, bei denen es echt zeitaufwendig und ressourcenintensiv wäre, das ganze Modell von Grund auf neu zu erstellen.

Ein inkrementelles Modell lässt dbt nur neue Daten anfügen (oder geänderte Daten aktualisieren), basierend auf einer Bedingung, normalerweise einer Zeitstempel-Spalte (wie updated_at).

Wie man ein inkrementelles Modell erstellt:

1. Mach das Modell in der Modellkonfiguration als inkrementell klar:

{{ config(

materialized='incremental',

unique_key='id' -- or another unique column

) }}2. Benutz die Funktion „ is_incremental() “, um neue oder geänderte Zeilen herauszufiltern:

SELECT *

FROM source_table

{% if is_incremental() %}

WHERE updated_at > (SELECT MAX(updated_at) FROM {{ this }})

{% endif %}3. Wenn dbt dieses Modell zum ersten Mal ausführt, verarbeitet es alle Daten. Bei den nächsten Durchläufen werden nur Zeilen bearbeitet, bei denen der Wert „ updated_at “ größer ist als der aktuellste Wert, der schon im Modell ist.

Wann man inkrementelle Modelle benutzt:

- Große Datensätze: Wenn du eine riesige Tabelle mit Millionen oder Milliarden von Zeilen hast, wäre es ziemlich ineffizient, die ganze Tabelle bei jedem Durchlauf neu aufzubauen.

- Regelmäßige Updates: Wenn dein Data Warehouse oft aktualisiert wird oder neue Daten bekommt, du aber nicht den ganzen Datensatz neu verarbeiten musst, können inkrementelle Modelle die Verarbeitungszeit echt verkürzen.

- Streaming-Daten: Wenn Daten regelmäßig gestreamt oder aktualisiert werden, helfen inkrementelle Modelle dabei, die Transformationen auf dem neuesten Stand zu halten, ohne alles neu ausführen zu müssen.

Wie nutzt du Jinja, um deinen SQL-Code zu verbessern?

Jinja macht unseren SQL-Code flexibler. Mit Jinja können wir wiederverwendbare Vorlagen für gängige SQL-Muster erstellen. Und weil sich die Anforderungen ständig ändern, können wir Jinjas Anweisungen „ if “ ( ) und „“ ( ) nutzen, um unsere SQL-Abfragen je nach den Bedingungen anzupassen. Dadurch wird der SQL-Code normalerweise verbessert, weil komplexe Logik aufgebrochen wird, was das Verständnis erleichtert.

Wenn du zum Beispiel das Datumsformat von „JJJJ-MM-TT“ in „MM/TT/JJJJ“ umwandeln willst, gibt's dafür ein Beispiel-Makro in dbt, das wir schon in einer früheren Frage gesehen haben:

{% macro change_date_format(column_name) %}

to_char({{ column_name }}::date, 'MM/DD/YYYY')

{% endmacro %}In diesem Code-Beispiel wird „ {{ column_name }} “ durch den tatsächlichen Spaltennamen ersetzt, wenn du das Makro verwendest. Es wird während der Laufzeit durch den tatsächlichen Spaltennamen ersetzt. Wie wir in den vorherigen Beispielen gesehen haben, zeigt Jinja mit „ {{ }} “ an, wo die Ersetzung stattfinden wird.

Wie würdest du eine benutzerdefinierte Materialisierung in dbt erstellen?

So machst du eine benutzerdefinierte Materialisierung in dbt:

- Erstell die SQL-Datei für die benutzerdefinierte Materialisierung.

- Als Nächstes definierst du ein Materialisierungsmakro als „

materialization_name“:

{% materialization materialization_name, default -%}- Benutze die vordefinierten Makros von dbt „

adapter.get_relation“, um die Tabelle einzurichten. Hier werden die Daten geladen. - Jetzt definierst und führst du die SQL-Befehle aus, um die Tabellen zu erstellen und Daten reinzuladen:

{% set sql %}

SELECT * FROM {{ ref('your_source_table') }}

WHERE your_conditions = true

{% endset %}

{{ adapter.execute(sql) }}- Schick am Ende die Zielrelation zurück, um den Cache von dbt zu aktualisieren und die Ausführung der Abfrage zu optimieren.

{{ return(target_relation) }}

{% endmaterialization %}Wie kannst du deine dbt-Modelle debuggen? Erzähl uns von zwei Möglichkeiten.

Hier sind zwei Möglichkeiten, um unsere dbt-Modelle zu debuggen:

1. Öffne die kompilierten SQL-Dateien im Zielordner, um Fehler zu finden und zu verfolgen.

Wenn du ein dbt-Projekt ausführst, kompiliert dbt deine Modelle (die mit Jinja-Vorlagen geschrieben wurden) zu rohen SQL-Abfragen und speichert sie im Verzeichnis „ target “. Dieses kompilierte SQL ist genau das, was dbt auf deiner Datenplattform ausführt. Wenn du diese Dateien durchsiehst, kannst du herausfinden, wo Probleme auftreten:

- Führ deine dbt-Modelle aus (z. B.

dbt runoderdbt test). - Geh zum Ordner „

target/compiled/” in deinem dbt-Projektverzeichnis. - Öffne die kompilierte SQL-Datei für das Modell, das du debuggen willst. Die Datei enthält das ausgeführte rohe SQL-dbt, einschließlich aller Transformationen aus den Jinja-Makros und Referenzen.

- Kopier die kompilierte SQL-Abfrage und führ sie direkt im SQL-Editor deiner Datenplattform aus (z. B. Postgres, BigQuery), um detaillierte Fehlermeldungen zu bekommen oder das tatsächliche Verhalten der Abfrage zu sehen.

2. Benutzdie dbt Power User Extension für VS Code von , um die Abfrageergebnisse direkt zu checken.

Die dbt Power User Extension für Visual Studio Code (VS Code) ist ein echt praktisches Tool zum Debuggen von dbt-Modellen. Mit dieser Erweiterung kannst du deine Abfragen direkt in deiner IDE überprüfen und testen, sodass du nicht mehr so oft zwischen dbt, dem Terminal und deiner Datenbank hin- und herwechseln musst.

Wie kompiliert das dbt Abfragen?

dbt macht Abfragen mit den folgenden Schritten:

- Parsing: dbt liest alle SQL-Dateien, YAML-Konfigurationen und Makros im Projekt.

- Kontext-Erstellungs: Es erstellt einen Kontext für jedes Modell, einschließlich Konfigurationen und verfügbaren Makros.

- Jinja-Rendering-: Dann verarbeitet es SQL-Dateien als Jinja-Vorlagen, um Tags und Ausdrücke durch ausgewertete Ergebnisse zu ersetzen.

- SQL-Kompilierungs: Für jedes Modell werden reine SQL-Abfragen erstellt.

- Erzeugung von Artefakten: Kompiliertes SQL wird im Verzeichnis „

target/compiled“ gespeichert. - Vorbereitung der Ausführung: Bei „

dbt run“ werden Abfragen für die Ausführung vorbereitet, eventuell mit zusätzlicher Umschreibung.

Dieser Prozess macht aus modularen, vorgefertigten SQL-Vorlagen Abfragen, die speziell für dein Data Warehouse funktionieren. Wir können „ dbt compile “ verwenden oder das Verzeichnis „ target/compiled “ überprüfen, um die endgültige SQL für jedes Modell anzuzeigen und zu debuggen.

Datenlagerung und integrationsbasierte dbt-Interviewfragen

Die meisten Dateningenieure beschäftigen sich hauptsächlich mit dem Aufbau und der Integration von Data Warehouses mit dbt. Fragen zu diesen Szenarien kommen in Vorstellungsgesprächen echt oft vor – deshalb hab ich die häufigsten mal zusammengestellt:

Sag mal drei Vorteile, die es hat, wenn man dbt mit Airflow zusammenbringt.

Die Integration von dbt mit Airflow hilft dabei, eine optimierte Datenpipeline aufzubauen. Hier sind ein paar Vorteile:

- ETL-Prozess: Airflow kümmert sich um das Abrufen und Laden von Daten, sodass sich dbt voll auf die Transformation konzentrieren kann. Das sorgt für einen reibungsloseren Arbeitsablauf.

- Automatisierung von dbt-Aufgaben: Airflow macht die Planung und Ausführung von dbt-Modellen automatisch, sodass du weniger manuell eingreifen musst und deine Datenumwandlungen effizienter werden.

- Parallele Aufgabenausführung: Airflow lässt Aufgaben parallel laufen, sodass große Datensätze ohne Leistungseinbußen verarbeitet werden können. Das hilft dabei, schnelle und zuverlässige Datenpipelines aufrechtzuerhalten.

Wie sieht die Architektur der semantischen Ebene von dbt aus?

Die semantische Ebene von dbt lässt uns Rohdaten in eine Sprache übersetzen, die wir verstehen. Wir können auch Metriken festlegen und sie über eine Befehlszeilenschnittstelle (CLI) abfragen.

Dadurch können wir die Kosten optimieren, weil die Datenvorbereitung weniger Zeit braucht. Außerdem arbeiten alle mit denselben Datendefinitionen, weil das die Metriken im ganzen Unternehmen einheitlich macht.

dbt und die semantische Ebene. Bildquelle: dbt

Wenn du BigQuery benutzt, ist dbt dann eine unnötige Ebene der Datenumwandlung?

Auch wenn BigQuery echt hilfreich ist und viele Transformationen von Haus aus hinkriegt, kann dbt trotzdem noch nötig sein. Hier ist der Grund:

- Mit dbt kannst du deine Transformationen versionieren, was in BigQuery nicht von Haus aus möglich ist.

- dbt hat eingebaute Test-Frameworks und Dokumentationserstellung, die die Datenqualität und das Verständnis verbessern.

- Die Funktion „

ref()” und die Makros von dbt machen SQL-Code modularer und wiederverwendbarer. - dbt macht es einfacher, mehrere Umgebungen (Entwicklung, Test, Produktion) in BigQuery zu verwalten.

- dbt bietet eine einheitliche Möglichkeit, Abhängigkeiten zwischen Transformationen zu verwalten.

Bietet dbt Datensicherheit?

dbt gibt's in zwei Versionen: dbt Core und dbt Cloud, wie in einer früheren Frage erwähnt. dbt Core ist Open Source und kostenlos. Deshalb hat es keine eingebauten Sicherheitsfunktionen und die Nutzer müssen sich selbst um die Installation und Sicherheit kümmern.

Aber dbt Cloud ist so gemacht, dass es voll auf Sicherheit setzt. Es hält sich an HIPAA und andere gängige Rahmenbedingungen, um sicherzustellen, dass die Privatsphäre nicht verletzt wird. Also müssen wir je nach unseren Bedürfnissen eine DBT-Version wählen, die zu unseren Anforderungen an die Geschäftskonformität passt.

Wie kannst du die Leistung von dbt-Transformationen bei großen Datensätzen verbessern?

Die Optimierung von dbt-Transformationen für große Datensätze ist super wichtig, um die Leistung zu verbessern und die Kosten zu senken, vor allem bei Cloud-basierten Data Warehouses wie Snowflake, BigQuery oder Redshift. Hier sind ein paar wichtige Techniken, um die Leistung von dbt zu verbessern:

1. Inkrementelle Modelle verwenden

Mit inkrementellen Modellen kann dbt nur neue oder aktualisierte Daten verarbeiten, anstatt jedes Mal den ganzen Datensatz neu zu verarbeiten. Das kann die Laufzeiten für große Datensätze echt verkürzen. Dieser Prozess reduziert die Menge der verarbeiteten Daten und beschleunigt so die Transformationszeiten.

2. Nutze Partitionierung und Clustering (für Datenbanken wie Snowflake und BigQuery)

Das Aufteilen und Clustern großer Tabellen in Datenbanken wie Snowflake oder BigQuery hilft dabei, die Abfrageleistung zu verbessern, indem die Daten effizient organisiert und die Menge der während der Abfragen gescannten Daten reduziert werden.

Partitionierung sorgt dafür, dass nur die relevanten Teile eines Datensatzes abgefragt werden, während Clustering die physische Anordnung der Daten optimiert, um sie schneller abrufen zu können.

3. Materialisierungen optimieren (Tabelle, Ansicht, inkrementell)

Nutze die richtigen Materialisierungen, um die Leistung zu verbessern:

- Ansichten sind super für leichte Transformationen, aber nicht so toll für schwere Aufgaben.

- Tabellen speichern die Daten physisch, was die Leistung verbessert, aber mehr Speicherplatz braucht.

- Inkrementelle Modelle sind am besten für große Datensätze geeignet, die regelmäßig aktualisiert werden.

4. Benutze LIMIT während der Entwicklung

Beim Entwickeln von Transformationen ist es praktisch, eine „ LIMIT “-Klausel zu Abfragen hinzuzufügen, um die Anzahl der verarbeiteten Zeilen zu begrenzen. Das beschleunigt die Entwicklungszyklen und man muss beim Testen nicht mit riesigen Datensätzen rumschleppen.

5. Führe Abfragen parallel aus

Nutze die Fähigkeit deines Data Warehouse, Abfragen parallel auszuführen. Zum Beispiel unterstützt dbt Cloud Parallelität, die je nach deiner Infrastruktur angepasst werden kann.

6. Nutze die Optimierungsfunktionen, die speziell für die Datenbank gedacht sind.

Viele Cloud-Data-Warehouses bieten Funktionen zur Leistungsoptimierung, wie zum Beispiel:

- BigQuery: Verwende materialisierte Ansichten oder partitionierte Tabellen.

- Snowflake: Aktiviere automatisches Clustering und Skalierung des Speichers für die parallele Ausführung.

Wie optimiert man dbt-Läufe in Snowflake?

Um dbt-Läufe in Snowflake zu optimieren:

1. Tabellen-Clustering verwenden:

{{ config(

cluster_by = ["date_column", "category_column"]

) }}

SELECT ...2. Nutze die Multi-Cluster-Warehouses von Snowflake für die parallele Ausführung von Modellen:

models:

my_project:

materialized: table

snowflake_warehouse: transforming_wh3. Nimm inkrementelle Modelle, wenn es passt:

{{ config(materialized='incremental', unique_key='id') }}

SELECT *

FROM source_table

{% if is_incremental() %}

WHERE updated_at > (SELECT MAX(updated_at) FROM {{ this }})

{% endif %}Diese Optimierungen können die Leistung und Kosteneffizienz von dbt-Läufen in Snowflake verbessern.

Verhaltensbezogene und problemlösungsorientierte DBT-Interviewfragen

Am Ende des Vorstellungsgesprächs checken die Leute, die dich interviewen, meistens deine Fähigkeiten, Probleme zu lösen. Sie könnten dir Fragen stellen, um zu sehen, wie du auf echte Probleme reagierst. Hier sind ein paar Fragen zum Verhalten und zur Problemlösung:

Wie würdest du die Bereitstellung von DBT in mehreren Umgebungen (Entwicklung, Staging, Produktion) organisieren?

So kannst du die Bereitstellung von dbt in verschiedenen Umgebungen verwalten:

1. Umgebungsspezifische Konfigurationen

Mit dbt kannst du in der Datei „ dbt_project.yml “ verschiedene Konfigurationen für jede Umgebung (Entwicklung, Staging und Produktion) festlegen. Du kannst verschiedene Einstellungen für Sachen wie Schema, Datenbank und Data Warehouse-Konfigurationen festlegen.

Beispiel in „ dbt_project.yml “:

models:

my_project:

dev:

schema: dev_schema

staging:

schema: staging_schema

prod:

schema: prod_schemaIn diesem Beispiel wählt dbt beim Ausführen des Projekts automatisch das richtige Schema basierend auf der Zielumgebung (Entwicklung, Staging oder Produktion) aus.

2. Die Zielvariable verwenden

Die Variable „ target ” in dbt wird benutzt, um festzulegen, in welcher Umgebung du arbeitest (Entwicklung, Staging, Produktion). Du kannst diese Variable in deinen Modellen oder Makros verwenden, um das Verhalten je nach Umgebung anzupassen.

Beispiel in einem Modell:

{% if target.name == 'prod' %}

SELECT * FROM production_table

{% else %}

SELECT * FROM {{ ref('staging_table') }}

{% endif %}Diese Logik sorgt dafür, dass je nach Umgebung unterschiedliche Tabellen oder Schemata verwendet werden.

3. Verzweigung und Versionskontrolle

Jede Umgebung sollte ihren eigenen Zweig in der Versionskontrolle haben (z. B. Git). Entwickler arbeitenank auf dem Zweig dev, Tester und Analysten nutzen staging, und nur genehmigte Änderungen werden in den Zweig prod übernommen.

4. Kontinuierliche Integration (CI) & Kontinuierliche Bereitstellung (CD)

In der Produktion ist es wichtig, eine automatisierte Bereitstellungspipeline zu haben, die Tests und Validierungen durchführt, bevor Modelle bereitgestellt werden. In dbt Cloud kannst du Job-Zeitpläne einrichten, um bestimmte Aufgaben je nach Umgebung auszuführen. Für dbt Core kann das mit CI/CD-Tools wie GitHub Actions oder Jenkins gemacht werden.

Wie handhabst du die Versionskontrolle in dbt, vor allem wenn du mit mehreren Teammitgliedern zusammenarbeitest?

Versionskontrolle ist super wichtig, wenn man an dbt-Projekten arbeitet, vor allem in einem Team, wo mehrere Leute an derselben Codebasis arbeiten. So mache ich das mit der Versionskontrolle in dbt:

1. Benutz Git für die Versionskontrolle

Wir nutzen Git als Hauptwerkzeug für die Versionskontrolle in unseren dbt-Projekten. Jedes Teammitglied arbeitet an seinem eigenen Zweig, wenn es um Änderungen oder Funktionen geht, die sie umsetzen. Das ermöglicht eine isolierte Entwicklung und verhindert Konflikte zwischen Teammitgliedern, die gleichzeitig an verschiedenen Aufgaben arbeiten.

Beispiel: Ich erstelle einen neuen Feature-Zweig wie feature/customer_order_transformation, wenn ich an einem neuen dbt-Modell arbeite.

2. Verzweigungsstrategie

Wir machen eine Git-Verzweigungsstrategie, bei der:

- Der Zweig „

dev“ wird für die laufende Entwicklung und das Testen genutzt. - Der Zweig „

staging“ wird benutzt, um Änderungen für die Produktion vorzubereiten. - Der Branch „

main“ oder „prod“ ist für die Produktionsumgebung reserviert.

Die Teammitglieder schicken ihre Änderungen an den „ dev “-Zweig und machen Pull-Anfragen (PRs) für Code-Reviews. Sobald die Änderungen überprüft und genehmigt sind, werden sie in staging für weitere Tests zusammengeführt und dann in production verschoben.

3. Kontinuierliche Integration (CI)

Wir haben eine CI-Pipeline eingebaut (z. B. GitHub Actions, CircleCI), die bei jedem Pull-Request automatisch dbt-Tests durchführt. So wird sichergestellt, dass jeder neue Code die erforderlichen Tests besteht, bevor er in den Hauptzweig integriert wird.

Der CI-Prozess läuft über „ dbt run “, um Modelle zu erstellen, und „ dbt test “, um die Daten zu überprüfen und nach Fehlern oder Unstimmigkeiten zu suchen.

4. Merge-Konflikte lösen

Wenn mehrere Teammitglieder Änderungen am selben Modell oder an derselben Datei vornehmen, kann es zu Konflikten beim Zusammenführen kommen. Um das zu regeln, schaue ich mir erst mal die Konfliktmarkierungen im Code an und entscheide, welche Änderungen ich behalten will:

- Wenn beide Änderungen okay sind, mache ich daraus eine neue Version.

- Wenn nur ein Satz von Änderungen richtig ist, behalte ich diesen und verwerfe den anderen.

Nachdem ich den Konflikt geklärt habe, mache ich ein paar Tests auf meinem Rechner, um sicherzugehen, dass die Konfliktlösung keine neuen Fehler verursacht hat. Sobald ich alles überprüft habe, schicke ich die erledigten Änderungen zurück zum Branch.

5. Dokumentation und Zusammenarbeit

Wir sorgen dafür, dass jede Zusammenführung oder jeder Pull-Request eine ordentliche Dokumentation der vorgenommenen Änderungen enthält. Wir halten die automatisch erstellte dbt-Dokumentation auf dem neuesten Stand, damit alle im Team die neuen oder aktualisierten Modelle gut verstehen.

Wie würdest du dbt in einer bestehenden Datenpipeline einbauen?

So würde ich dbt in einer bestehenden Pipeline einbauen:

- Schau dir mal die aktuelle Pipeline an: Finde raus, wo es Probleme gibt und wo dbt die Transformationsprozesse besser machen kann.

- Richte dbt ein: Installier dbt, leg ein neues Projekt an und richte die Verbindungen zum Data Warehouse ein.

- Transformationen umwandeln: Migriere vorhandene SQL- oder Transformationslogik in dbt-Modelle und sorge dabei für Modularität und Klarheit.

- Tests und Dokumentation hinzufügen: Nutze die integrierten Test- und Dokumentationsfunktionen von dbt, um die Datenqualität und Transparenz sicherzustellen.

- Integrieren mit Orchestrierung: Plan die Ausführung von dbt mit Tools wie Airflow oder Prefect.

- Fang klein an: Implementiere dbt auf einem kleinen Teil der Pipeline, um die Änderungen zu checken, bevor du sie ausweitest.

- Überwachen und optimieren: Die Leistung immer im Auge behalten und die Modelle nach Bedarf optimieren.

Stell dir vor, ein DBT-Modell klappt nicht wegen dem Fehler „Beziehung existiert nicht”. Wie fängst du an, so einen Fehler zu beheben?

Wenn du in dbt die Fehlermeldung „relation does not exist” (Beziehung existiert nicht) bekommst, heißt das meistens, dass das Modell versucht, auf eine Tabelle oder ein Modell zu verweisen, das noch nicht erstellt wurde oder falsch geschrieben ist. So würde ich das Problem beheben:

- Schau mal, ob da Tippfehler drin sind: Stell sicher, dass der Name der Tabelle oder des Modells in der Funktion „

ref()“ richtig geschrieben ist, und überprüfe, ob auf das richtige Modell oder die richtige Tabelle verwiesen wird.

SELECT * FROM {{ ref('orders') }} -- Ensure 'orders' is the correct model name- Überprüfe die Modellabhängigkeiten in der Datei „ “: Wenn dein Modell von anderen Modellen abhängt, schau dir den dbt DAG (Directed Acyclic Graph) an, um sicherzustellen, dass die vorgelagerten Modelle erfolgreich erstellt wurden, bevor das fehlerhafte Modell ausgeführt wird.

- Führ dbt im Debug-Modus aus: Schau mal unter „

dbt debug“ nach und check die Protokolle für genaue Infos darüber, was dbt versucht hat und warum es nicht geklappt hat. - Überprüfe die Berechtigungen für die Datenplattform: Stell sicher, dass dbt die richtigen Berechtigungen hat, um auf die Tabelle oder das Modell im Data Warehouse zuzugreifen.

- Einzelne Modelle ausführen: Probier mal, die abhängigen Modelle einzeln auszuführen (z. B.

dbt run --models orders), um zu checken, ob sie da sind und richtig aufgebaut sind, bevor das fehlerhafte Modell kommt.

Tipps zur Vorbereitung auf ein DBT-Interview

dbt ist ein neues Framework, das immer besser wird. Es kann echt anstrengend sein, mit den neuen Updates Schritt zu halten und gleichzeitig noch den alten Stoff zu lernen. Deshalb solltest du einen ausgewogenen Ansatz wählen und mit den Kernfunktionen anfangen. Wenn du sie drauf hast, schau dir die Neuerungen an, um zu sehen, was sich geändert hat.

Ich weiß, dass Vorstellungsgespräche echt nervenaufreibend sein können, vor allem bei einem speziellen Tool wie dbt. Aber keine Sorge – ich hab ein paar Tipps zusammengestellt, die dir bei der Vorbereitung helfen und dir Selbstvertrauen geben:

Die wichtigsten Funktionen von dbt

Ich kann das gar nicht genug betonen: Mach dich mit den grundlegenden Konzepten von DBT vertraut, einschließlich Modellen, Tests, Dokumentation und wie alles zusammenpasst. Wenn du diese Grundlagen gut verstehst, bist du in technischen Gesprächen gut aufgestellt.

DataCamp hat den perfekten Kurs dafür: Einführung in dbt

DataCamp hat auch ein paar Anfängerkurse, die sich eingehend mit anderen Themen aus dem Bereich Data Engineering beschäftigen:

- Für die Grundlagen des Data Engineering: Datenverarbeitung verstehen

- Für das Datenbankdesign: Datenbankdesign

- Für die Grundlagen des Data Warehousing: Konzepte des Data Warehousing

- Für Snowflake-Grundlagen: Einführung in Snowflake

- Für die Datenarchitektur: Moderne Datenarchitektur verstehen

- Um ETL und ELT in Python zu lernen: ETL und ELT in Python

Mach praktische Erfahrungen mit dbt

Über etwas zu lesen ist gut, aber es zu machen ist noch besser. Das ist eine der besten Methoden, um DBT-Fähigkeiten zu lernen. Du kannst online eine riesige Liste von Rohdatensätzen finden, um Transformationen durchzuführen und Tests zu machen. Mach dein eigenes dbt-Projekt und probier verschiedene Funktionen aus. Du wirst dich viel sicherer fühlen, wenn du über DBT redest, nachdem du es selbst benutzt hast.

Bereite Beispiele aus der Praxis vor

Interviewer hören gerne von praktischen Anwendungen. Fällt dir ein Problem ein, das du mit dbt gelöst hast, oder wie du es in einem hypothetischen Szenario einsetzen könntest? Halte ein paar dieser Beispiele bereit, um sie zu teilen. Um ein paar Beispiele zu sammeln, kannst du dir sogar mehrere Fallstudien auf der offiziellen Website von dbt anschauen oder dir Ideen aus öffentlichen dbt-Projekten auf Git holen.

Fazit

Wir haben ein breites Spektrum an grundlegenden bis fortgeschrittenen DBT-Interviewfragen abgedeckt, die dir bei deiner Jobsuche helfen werden. Wenn du weißt, wie man dbt mit Cloud-Data-Warehouses verbindet, hast du echt gute Kenntnisse in der Datenumwandlung, was der Kern jedes Datenintegrationsprozesses ist.

DBT und SQL zu lernen geht aber echt gut zusammen. Also, wenn du noch nicht so viel mit SQL zu tun hattest, schau dir mal die SQL-Kurse von DataCamp an.

Werde SQL-zertifiziert

FAQs

Wie lange dauert es, DBT zu lernen?

Es kann ein paar Monate dauern, bis du die DBT-Fähigkeiten richtig drauf hast. Aber wenn du jeden Tag ein paar Stunden investierst, kannst du es schnell lernen.

Wie kann ich DBT selbst lernen?

Du kannst Online-Ressourcen wie die Kurse von DataCamp, YouTube-Tutorials und Blogbeiträge nutzen. Versuch außerdem, deine Projekte aufzubauen, indem du bestehende Projekte umschreibst. Das wird deine praktischen Fähigkeiten verbessern.

Macht DBT Dateningenieure überflüssig?

Nein, dbt macht Dateningenieure nicht überflüssig. Stattdessen hilft es ihnen bei ihrer Arbeit. Mit diesem Framework können sie Aufgaben wie Transformationen und Tests automatisch erledigen.

Ich bin ein Inhaltsstratege, der es liebt, komplexe Themen zu vereinfachen. Ich habe Unternehmen wie Splunk, Hackernoon und Tiiny Host geholfen, ansprechende und informative Inhalte für ihr Publikum zu erstellen.