Cours

Le big data est une affaire importante. La numérisation rapide de notre société a entraîné une croissance sans précédent des données. Et avec l'avènement de nouvelles technologies et infrastructures, telles que la réalité virtuelle, le métavers, l'internet des objets (IoT) et la 5G, cette tendance devrait se poursuivre à l'avenir. Il est donc essentiel de savoir comment analyser les données.

Les données sont devenues l'un des biens les plus précieux de l'économie du XXIe siècle. Les gouvernements, les entreprises et les particuliers utilisent les données pour améliorer leurs processus de prise de décision. Il en résulte une forte demande de professionnels qualifiés pour traiter et analyser de grandes quantités de données.

Cependant, de nombreuses entreprises ont encore du mal à gérer les données et à leur donner un sens. Selon une étude réalisée par Splunk, 55 % de toutes les données collectées par les entreprises sont considérées comme des "données sombres", c'est-à-dire des données que les entreprises collectent dans le cadre de leurs activités normales, mais qu'elles n'utilisent pas. Si, parfois, les entreprises ne sont tout simplement pas conscientes de l'existence des données, dans la plupart des cas, elles n'analysent pas les données parce qu'elles n'ont pas les talents nécessaires pour le faire.

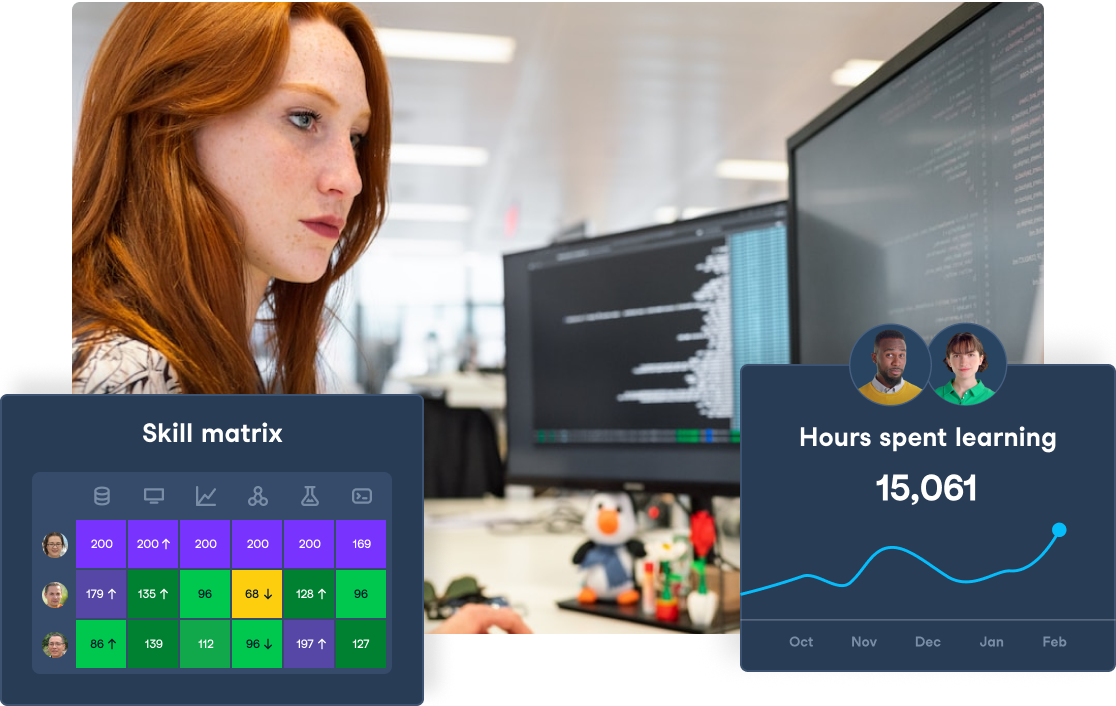

La formation des employés à l'aide de programmes internes de science des données est l'une des meilleures stratégies pour remédier à la pénurie de scientifiques des données. Contrairement à une idée reçue, vous n'avez pas besoin d'un diplôme supérieur en statistiques ou d'un doctorat en informatique pour commencer à analyser des données. Le marché offre de nombreuses options pour tous les types de personnes et de situations. Par exemple, chez DataCamp, nous proposons une formation complète sur les données pour les particuliers et les organisations.

Dans cet article, nous présenterons le processus d'analyse des données. Nous présenterons un cadre simple, le flux de travail de la science des données, avec des étapes simples que vous devez suivre pour passer des données brutes à des informations précieuses.

Comment analyser les données avec le flux de travail de la science des données

Lorsque les professionnels des données commencent un nouveau projet impliquant une analyse de données, ils suivent généralement un processus en cinq étapes. C'est ce que nous appelons le flux de travail de la science des données, dont vous pouvez voir les éléments ci-dessous :

- Identifier les questions commerciales

- Collecter et stocker des données

- Nettoyer et préparer les données

- Analyser les données

- Visualiser et communiquer les données

Le flux de travail de la science des données

Dans les sections suivantes, nous examinerons plus en détail chacune des étapes.

Bien qu'il puisse y avoir des variations dans le flux de travail de la science des données en fonction de la tâche, il est important de s'en tenir à un cadre cohérent et bien défini chaque fois que vous commencez un nouveau projet de données. Il vous aidera à planifier, à mettre en œuvre et à optimiser votre travail.

1. Identifier les questions commerciales

La qualité des données dépend des questions que vous posez. De nombreuses organisations dépensent des millions pour collecter des données de toutes sortes à partir de différentes sources, mais beaucoup d'entre elles ne parviennent pas à créer de la valeur à partir de ces données. En réalité, quelle que soit la quantité de données détenues par votre entreprise ou le nombre de data scientists au sein du département, les données ne changent la donne qu'une fois que vous avez identifié les bonnes questions commerciales.

La première étape pour transformer les données en connaissances consiste à définir un ensemble clair d'objectifs et de questions. Vous trouverez ci-dessous une liste d'exemples :

- Quels sont les besoins de l'entreprise ?

- Quel type de problème essayons-nous de résoudre ?

- Comment les données peuvent-elles aider à résoudre un problème ou une question commerciale ?

- Quel type de données est nécessaire ?

- Quels langages de programmation et quelles technologies allons-nous utiliser ?

- Quelle méthodologie ou technique allons-nous utiliser dans le processus d'analyse des données ?

- Comment allons-nous mesurer les résultats ?

- Comment les tâches liées aux données seront-elles partagées au sein de l'équipe ?

À la fin de cette première étape du flux de travail de la science des données, vous devriez avoir une idée claire et bien définie de la marche à suivre. Ce schéma vous aidera à vous y retrouver dans la complexité des données et à atteindre vos objectifs.

Ne vous inquiétez pas de passer plus de temps sur cette étape. Il est essentiel d'identifier les bonnes questions commerciales pour améliorer l'efficacité et permettre à votre entreprise d'économiser du temps et d'autres ressources.

2. Collecter et stocker des données

Maintenant que vous disposez d'une série de questions claires, il est temps de mettre la main à la pâte. Tout d'abord, vous devez collecter et stocker vos données dans un endroit sûr pour les analyser.

Dans notre société axée sur les données, une énorme quantité de données est générée chaque seconde. Les trois principales sources de données sont les suivantes :

- Données de l'entreprise. Il est créé par les entreprises dans le cadre de leurs activités quotidiennes. Il peut s'agir d'événements web, de données clients, de transactions financières ou de données d'enquête. Ces données sont normalement stockées dans des bases de données relationnelles.

- Données de la machine. Avec les récentes avancées en matière de sensibilisation et de technologies IoT, un nombre croissant d'appareils électroniques génèrent des données. Ils vont des caméras aux smartwatches en passant par les maisons intelligentes et les satellites.

- Données ouvertes. Compte tenu du potentiel des données à créer de la valeur pour les économies, les gouvernements et les entreprises publient des données qui peuvent être utilisées librement. Cela peut se faire par le biais d'un portail de données ouvert et d'API (interface de programmation d'applications).

Nous pouvons alors classer les données en deux types :

- Données quantitatives. Il s'agit d'informations qui peuvent être comptées ou mesurées à l'aide de valeurs numériques. Elle est normalement structurée dans des feuilles de calcul ou des bases de données SQL.

- Données qualitatives. La majeure partie des données générées aujourd'hui sont qualitatives. Parmi les exemples les plus courants, citons le texte, l'audio, la vidéo, les images ou les données des médias sociaux. Les données qualitatives sont souvent non structurées, ce qui les rend difficiles à stocker et à traiter dans des feuilles de calcul standard ou des bases de données relationnelles.

En fonction des questions commerciales auxquelles vous souhaitez répondre, différents types de données et de techniques seront utilisés. En général, la collecte, le stockage et l'analyse de données qualitatives nécessitent des méthodes plus avancées que les données quantitatives.

3. Nettoyer et préparer les données

Une fois que vous avez collecté et stocké vos données, l'étape suivante consiste à évaluer leur qualité. Il est important de se rappeler que le succès de votre analyse de données dépend en grande partie de la qualité de vos données. Vos perspectives seront erronées ou trompeuses si vos informations sont inexactes, incomplètes ou incohérentes. C'est pourquoi il est indispensable de consacrer du temps au nettoyage et à la préparation. Consultez notre article sur les signes de mauvaises données pour plus d'informations.

Les données brutes sont rarement prêtes à être analysées. L'évaluation de la qualité des données est essentielle pour trouver et corriger les erreurs dans vos données. Ce processus implique la correction d'erreurs telles que :

- Suppression des lignes, colonnes ou cellules en double.

- Suppression des lignes et des colonnes qui ne seront pas nécessaires lors de l'analyse. Ceci est particulièrement important si vous avez affaire à de grands ensembles de données qui consomment beaucoup de mémoire.

- Traiter les espaces blancs dans les ensembles de données, également connus sous le nom de valeurs nulles

- Gestion des valeurs anormales et extrêmes, également connues sous le nom de valeurs aberrantes

- Normaliser la structure et les types de données afin que toutes les données soient exprimées de la même manière.

Repérer les erreurs et les anomalies dans les données est en soi une analyse de données, communément appelée analyse exploratoire de données.

Analyse exploratoire des données

L'analyse exploratoire des données vise à étudier et à résumer les caractéristiques des données. Les principales méthodes pour y parvenir sont les statistiques et les visualisations de données :

- Les statistiques fournissent de brefs coefficients informatifs qui résument les données. Les statistiques les plus courantes sont la moyenne, la médiane, l'écart-type et les coefficients de corrélation.

- La visualisation des données est la représentation graphique des données. Selon le type de données, certains graphiques seront plus utiles que d'autres. Par exemple, un diagramme en boîte est un excellent graphique pour visualiser la distribution des données et séparer les valeurs extrêmes.

Le temps investi dans cette phase dépendra fortement du volume de données et de la qualité des données que vous souhaitez analyser. Pourtant, le nettoyage des données est généralement l'étape qui prend le plus de temps dans le flux de travail de la science des données. En fait, les scientifiques des données passent 80 % de leur temps dans cette phase du flux de travail de la science des données.

Si vous travaillez dans une entreprise où l'analyse des données fait partie des activités quotidiennes, la mise en œuvre d'une stratégie de gouvernance des données est un excellent moyen d'accroître l'efficacité de cette phase. Avec des règles et des politiques claires sur la manière de nettoyer et de traiter les données, votre entreprise sera mieux préparée à traiter les données et à réduire le temps nécessaire au nettoyage des données.

Si vous souhaitez savoir comment fonctionne le processus de nettoyage des données et quels sont les principaux types de problèmes liés aux données, consultez notre rubrique Cours sur le nettoyage des données en Python et cours sur le nettoyage des données en R. De plus, si vous souhaitez apprendre comment l'analyse exploratoire des données fonctionne en pratique, notre cours sur l 'analyse exploratoire des données en SQL vous aidera à démarrer.

4. Analyser les données

Maintenant que vos données ont l'air propres, vous êtes prêt à les analyser. La découverte de modèles, de connexions, d'idées et de prédictions est souvent la partie la plus satisfaisante du travail d'un scientifique des données.

Différentes techniques sont disponibles en fonction des objectifs de l'analyse et du type de données. Au fil des ans, de nouvelles techniques et méthodologies sont apparues pour traiter toutes sortes de données. Elles vont de simples régressions linéaires à des techniques avancées dans des domaines de pointe, tels que l'apprentissage automatique, le traitement du langage naturel (NLP) et la vision par ordinateur.

Vous trouverez ci-dessous une liste des méthodes d'analyse de données les plus populaires pour approfondir votre analyse :

Apprentissage automatique

Cette branche de l'intelligence artificielle fournit un ensemble d'algorithmes permettant aux machines d'apprendre des modèles et des tendances à partir des données historiques disponibles. Une fois les algorithmes formés, ils sont capables de faire des prédictions généralisables avec une précision croissante. Il existe trois types d'apprentissage automatique, en fonction du type de problème à résoudre :

- L'apprentissage supervisé consiste à enseigner à un modèle un ensemble de données historiques étiquetées à partir desquelles il apprend les relations entre les données d'entrée et de sortie. Il estime ensuite la précision des prédictions sur un ensemble de tests dont les valeurs de sortie sont connues à l'avance, afin que le modèle puisse être utilisé ultérieurement pour faire des prédictions sur des données inconnues. Pour en savoir plus sur l'apprentissage supervisé, suivez le cours de DataCamp sur l 'apprentissage supervisé avec scikit-learn.

- L'apprentissage non supervisé consiste à identifier la structure intrinsèque des données sans avoir de variable dépendante, à détecter des modèles communs, à classer les points de données en fonction de leurs attributs, puis, sur la base de ces informations, à faire des prédictions sur de nouvelles données. Si vous souhaitez approfondir vos connaissances en apprentissage non supervisé, pensez à notre cours sur l'apprentissage non supervisé en Python.

- L'apprentissage par renforcement implique qu'un algorithme apprend progressivement en interagissant avec un environnement, en décidant quelles actions peuvent le rapprocher de la solution, en identifiant celles qui peuvent l'en éloigner sur la base de son expérience passée, puis en exécutant la meilleure action pour cette étape particulière. Le principe est que l'algorithme reçoit des pénalités pour les actions erronées et des récompenses pour les actions correctes afin qu'il puisse déterminer la stratégie optimale pour ses performances. Vous souhaitez en savoir plus ? Consultez ce tutoriel d'introduction à l'apprentissage par renforcement.

Devenez un scientifique ML

Apprentissage en profondeur :

Un sous-domaine de l'apprentissage automatique qui traite des algorithmes appelés réseaux neuronaux artificiels inspirés de la structure du cerveau humain. Contrairement aux algorithmes d'apprentissage automatique classiques, les algorithmes d'apprentissage profond sont moins linéaires, plus complexes et hiérarchiques, capables d'apprendre à partir d'énormes quantités de données et de produire des résultats très précis, en particulier lorsqu'il s'agit de données non structurées, telles que des données audio et des images.

Traitement du langage naturel

Un domaine de l'apprentissage automatique qui étudie comment donner aux ordinateurs la capacité de comprendre le langage humain, à la fois écrit et parlé. La NPL est l'un des domaines de la science des données qui connaît la croissance la plus rapide. Pour commencer, vous pouvez vous inscrire à notre cursus de traitement du langage naturel en Python. Voici quelques-unes des techniques les plus populaires de la PNL :

- Classification des textes. C'est l'une des tâches importantes de l'exploration de texte. Il s'agit d'une approche supervisée. Il permet d'identifier la catégorie ou la classe d'un texte donné, comme les blogs, les livres, les pages web, les articles d'actualité et les tweets.

- Analyse des sentiments. Technique qui consiste à quantifier le contenu, les idées, les croyances ou les opinions des utilisateurs. L'analyse des sentiments permet de mieux comprendre les gens et de manière plus précise.

Vision par ordinateur

L'objectif de la vision par ordinateur est d'aider les ordinateurs à voir et à comprendre le contenu des images numériques. La vision par ordinateur est nécessaire pour permettre, par exemple, la conduite autonome des voitures. Un excellent moyen de débuter dans le domaine est de suivre notre cursus de compétences sur le traitement d'images avec Python.

Voici quelques-unes des techniques de vision par ordinateur les plus populaires :

- Classification des images. C'est la technique la plus simple de la vision par ordinateur. L'objectif principal est de classer l'image dans une ou plusieurs catégories.

- Détection d'objets. Cette technique nous permet de détecter les classes présentes dans l'image et leur emplacement dans l'image. L'approche la plus courante consiste à trouver cette classe dans l'image et à localiser cet objet à l'aide d'une boîte englobante.

5. Visualiser et communiquer les résultats

La dernière étape du flux de travail de la science des données consiste à visualiser et à communiquer les résultats de votre analyse de données. Pour que vos idées se transforment en décisions, vous devez vous assurer que votre public et les principales parties prenantes comprennent votre travail.

Dans cette dernière étape, la visualisation des données est la reine de la danse. Comme nous l'avons déjà mentionné, la visualisation de données est l'acte de traduire des données dans un contexte visuel. Pour ce faire, vous pouvez utiliser des graphiques, des diagrammes, des animations, des infographies, etc. L'idée sous-jacente est de permettre aux humains d'identifier plus facilement les tendances, les valeurs aberrantes et les modèles dans les données.

Qu'il s'agisse de diagrammes et de graphiques statiques ou de tableaux de bord interactifs, la visualisation des données est essentielle pour rendre votre travail compréhensible et communiquer vos idées de manière efficace. Voici une liste des outils de visualisation de données les plus populaires:

Paquets Python

Python est un langage de programmation interprété de haut niveau à usage général. Il propose plusieurs packages graphiques de qualité pour la visualisation des données, tels que :

- Matplotlib

- Seaborn

- Plotly

- Bokeh

- Geoplotlib

Le cursus de compétences Data Visualization with Python est une excellente séquence de cours pour supercharger vos compétences en science des données en utilisant les bibliothèques de visualisation de données les plus populaires et les plus robustes de Python.

Paquets R

R est un langage de programmation pour le calcul statistique et les graphiques. Il s'agit d'un outil idéal pour l'analyse des données, car vous pouvez créer presque tous les types de graphiques à l'aide de ses différents modules. Les logiciels de visualisation de données R les plus répandus sont les suivants :

- ggplot2

- Treillis

- haute charte

- Dépliant

- Plotly

Consultez le cours Data Visualization with R et le cursus Interactive Data Visualization in skill pour améliorer vos compétences en visualisation avec le langage de programmation R.

Outils libres de tout code

Les outils sans code constituent une solution accessible pour les personnes qui n'ont pas de connaissances en programmation - même si les personnes ayant des compétences en programmation peuvent quand même choisir de les utiliser. Plus formellement, les outils sans code sont des interfaces graphiques qui permettent d'exécuter des scripts natifs pour traiter et enrichir les données. Parmi les plus populaires, citons

- RAWGraphs

- DataWrapper

- Graphiques Google

Outils d'intelligence économique

Ces outils tout-en-un sont largement utilisés par les entreprises axées sur les données. Ils sont utilisés pour la collecte, le traitement, l'intégration, la visualisation et l'analyse de grands volumes de données brutes de manière à faciliter la prise de décision au sein de l'entreprise. Les outils de veille stratégique les plus courants sont les suivants :

- Tableau

- PowerBI

- Qlik

Pour en savoir plus sur ces outils, nous vous recommandons vivement nos cours d'introduction à Tableau et d'introduction à Power BI.

Ces dernières années, des approches innovantes ont été proposées pour améliorer la communication des données. L'une d'entre elles est la narration de données, une approche qui préconise l'utilisation de visuels, de récits et de données pour transformer les données en actions. Découvrez notre épisode du podcast DataFrame avec Brent Dykes, auteur de Effective Data Storytelling : How to Drive Change with Data, Narrative, and Visuals, pour en savoir plus sur cette approche.

Conclusion

Nous espérons que vous avez apprécié cet article et que vous êtes prêt à commencer votre propre analyse de données. Une excellente façon de commencer est de s'inscrire à notre cours Data Science pour tous. Grâce à des exercices pratiques, les participants découvriront les différents rôles des data scientists, des sujets fondamentaux tels que les tests A/B, l'analyse des séries chronologiques et l'apprentissage automatique, ainsi que la manière dont les data scientists extraient des informations à partir de données du monde réel.

Dans le cursus du cours d'introduction, nous proposons des pistes complètes pour que les apprenants poursuivent leur parcours d'apprentissage. Les étudiants peuvent choisir leur langage préféré(Data Scientist avec Python, R ou SQL) dans les filières professionnelles, où les compétences essentielles en matière de données sont enseignées par le biais d'exercices systématiques et interactifs sur des ensembles de données du monde réel.

Une fois que vous avez terminé l'un de ces cursus professionnels, vous pouvez passer au programme de certification en science des données pour faire valider et certifier vos nouvelles compétences techniques par des experts.

Faites progresser les compétences de votre équipe en matière de science des données

Exploitez tout le potentiel de la science des données avec DataCamp for Business. Accédez à des cours complets, des projets et des rapports centralisés pour des équipes de 2 personnes ou plus.

Comment analyser les données FAQ

Qu'est-ce que l'analyse des données ?

L'analyse des données est le processus de collecte, de nettoyage, de transformation et de modélisation des données afin de découvrir des informations utiles. Consultez notre guide complet "Qu'est-ce que l'analyse de données" pour une explication plus approfondie.

Qu'est-ce que le flux de travail de la science des données ?

Il s'agit d'un cadre en cinq étapes pour analyser les données. Les cinq étapes sont les suivantes : 1) Identifier les questions commerciales, 2) Collecter et stocker les données, 3) Nettoyer et préparer les données, 4) Analyser les données, et 5) Visualiser et communiquer les données.

Quel est l'objectif de l'étape de nettoyage des données ?

Pour repérer et corriger les anomalies dans vos données. Il s'agit d'une étape cruciale avant de commencer à analyser les données.

Qu'est-ce que la visualisation de données ?

Représentation graphique des données. Cela peut se faire par le biais de tracés, de graphiques, de cartes, etc.

Ai-je besoin d'une formation en STIM pour devenir analyste de données ?

Non ! Bien qu'apprendre à coder puisse être un défi, tout le monde est le bienvenu dans la science des données. Avec de la patience, de la détermination et la volonté d'apprendre, le ciel est la limite.