Cours

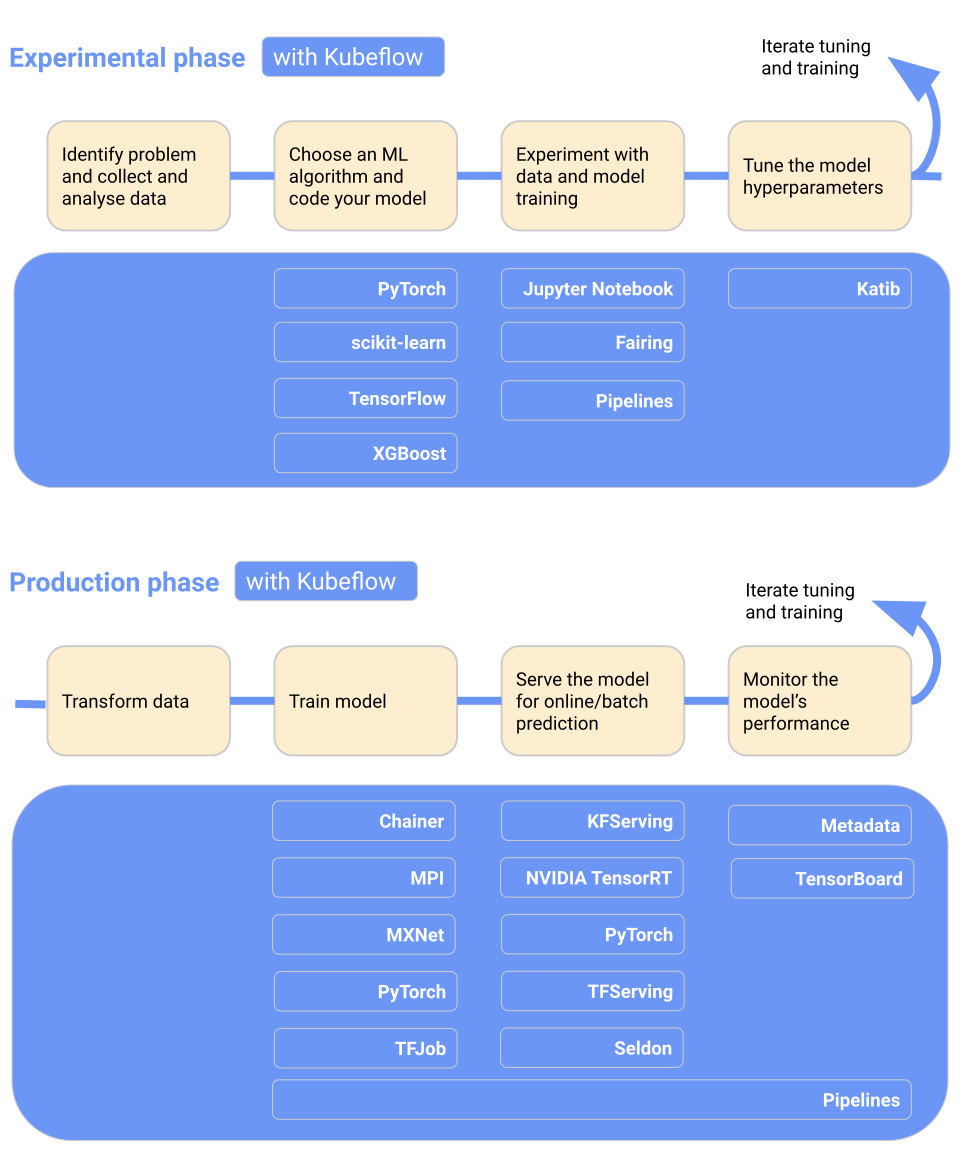

Comme nous l'explorons dans notre article sur le démarrage de MLOps, MLOps repose sur les fondamentaux de DevOps, la stratégie de développement logiciel visant à écrire, déployer et exécuter efficacement les applications d'entreprise.

Il s'agit d'une approche de la gestion des projets d'apprentissage automatique à grande échelle. Les MLOps améliorent la collaboration entre les équipes de développement, les équipes opérationnelles et les équipes chargées de la science des données. Vous bénéficiez ainsi d'un déploiement plus rapide des modèles, d'une optimisation de la productivité des équipes, d'une réduction des risques et des coûts, et d'un contrôle continu des modèles en production.

Découvrez pourquoi les MLOps sont importants et quels sont les problèmes qu'ils visent à résoudre en lisant notre blog sur le passé, le présent et l'avenir des MLOps.

Dans ce billet, nous allons découvrir les meilleurs outils MLOps pour le développement, le déploiement et la surveillance des modèles afin de standardiser, simplifier et rationaliser l'écosystème de l'apprentissage automatique. Pour une introduction approfondie aux principes fondamentaux de MLOps, consultez notre cursus de compétences.

Vous souhaitez vous lancer dans l'IA générative ?

Apprenez à travailler avec des LLM en Python directement dans votre navigateur

Cadre des grands modèles linguistiques (LLM)

Avec l'introduction de GPT-4 et, plus tard, de GPT-4o, la course a commencé pour produire de grands modèles linguistiques et réaliser le plein potentiel de l'IA moderne. Les LLM ont besoin de bases de données vectorielles et de cadres d'intégration pour créer des applications d'IA intelligentes.

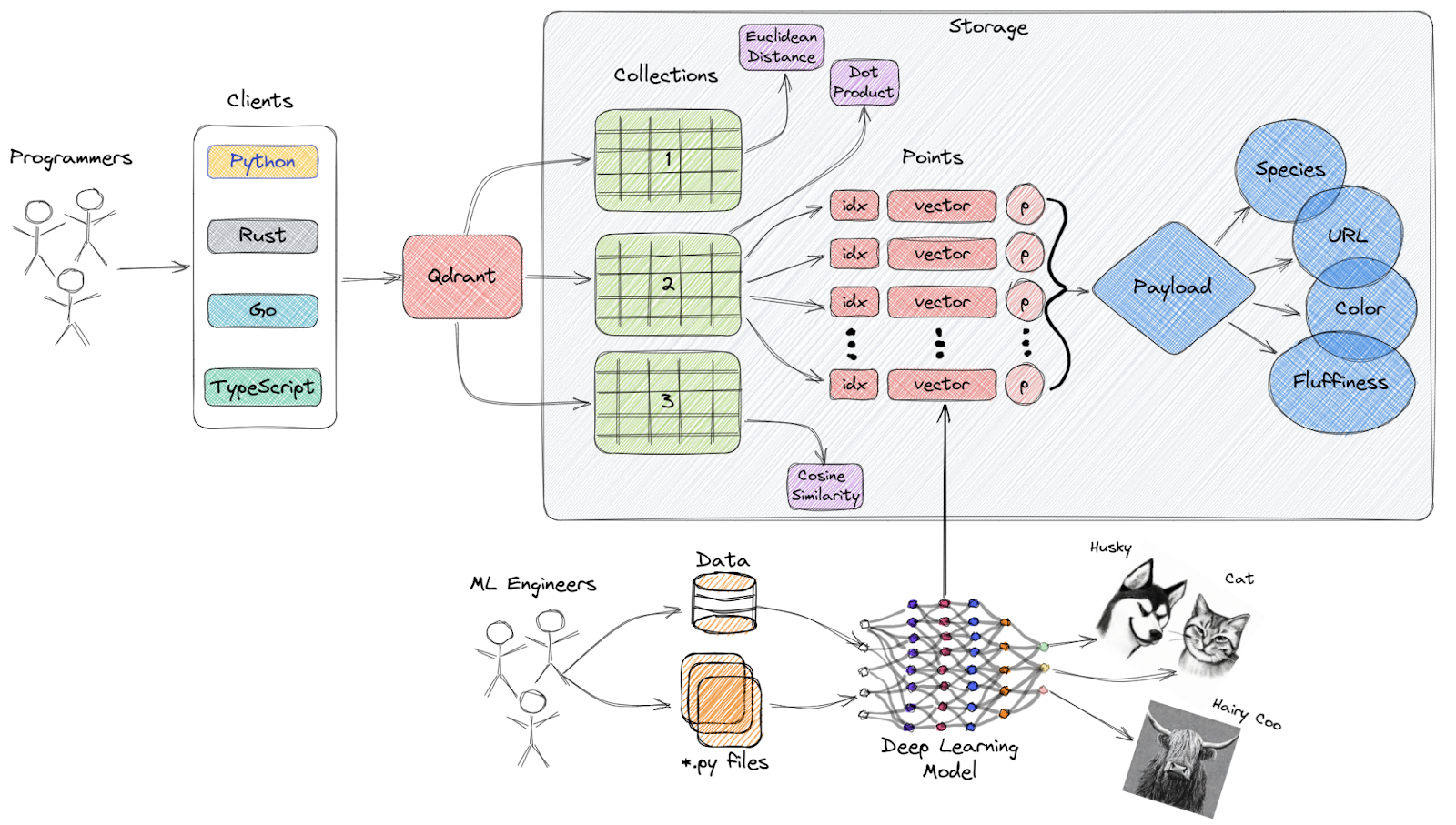

1. Qdrant

Qdrant est un moteur de recherche de similarités vectorielles et une base de données vectorielles open-source qui fournit un service prêt à la production avec une API pratique, vous permettant de stocker, de rechercher et de gérer des embeddings vectoriels.

Vue d'ensemble de l'architecture de Qdrant

Caractéristiques principales :

- API facile à utiliser: Il fournit une API Python facile à utiliser et permet également aux développeurs de générer des bibliothèques clientes dans plusieurs langages de programmation.

- Rapide et précis: Il utilise une modification personnalisée unique de l'algorithme HNSW pour la recherche approximative du plus proche voisin, offrant des vitesses de recherche de pointe sans compromettre la précision.

- Types de données riches: Qdrant supporte une grande variété de types de données et de conditions d'interrogation, y compris les chaînes de caractères, les plages numériques, les géolocalisations, etc.

- Distribué: Il est cloud-native et peut évoluer horizontalement, ce qui permet aux développeurs d'utiliser juste la bonne quantité de ressources de calcul pour n'importe quelle quantité de données qu'ils doivent servir.

- Efficace: Qdrant est entièrement développé en Rust, un langage connu pour ses performances et son efficacité en termes de ressources.

Découvrez les meilleures bases de données vectorielles en lisant Les 5 meilleures bases de données vectorielles - Une liste avec des exemples.

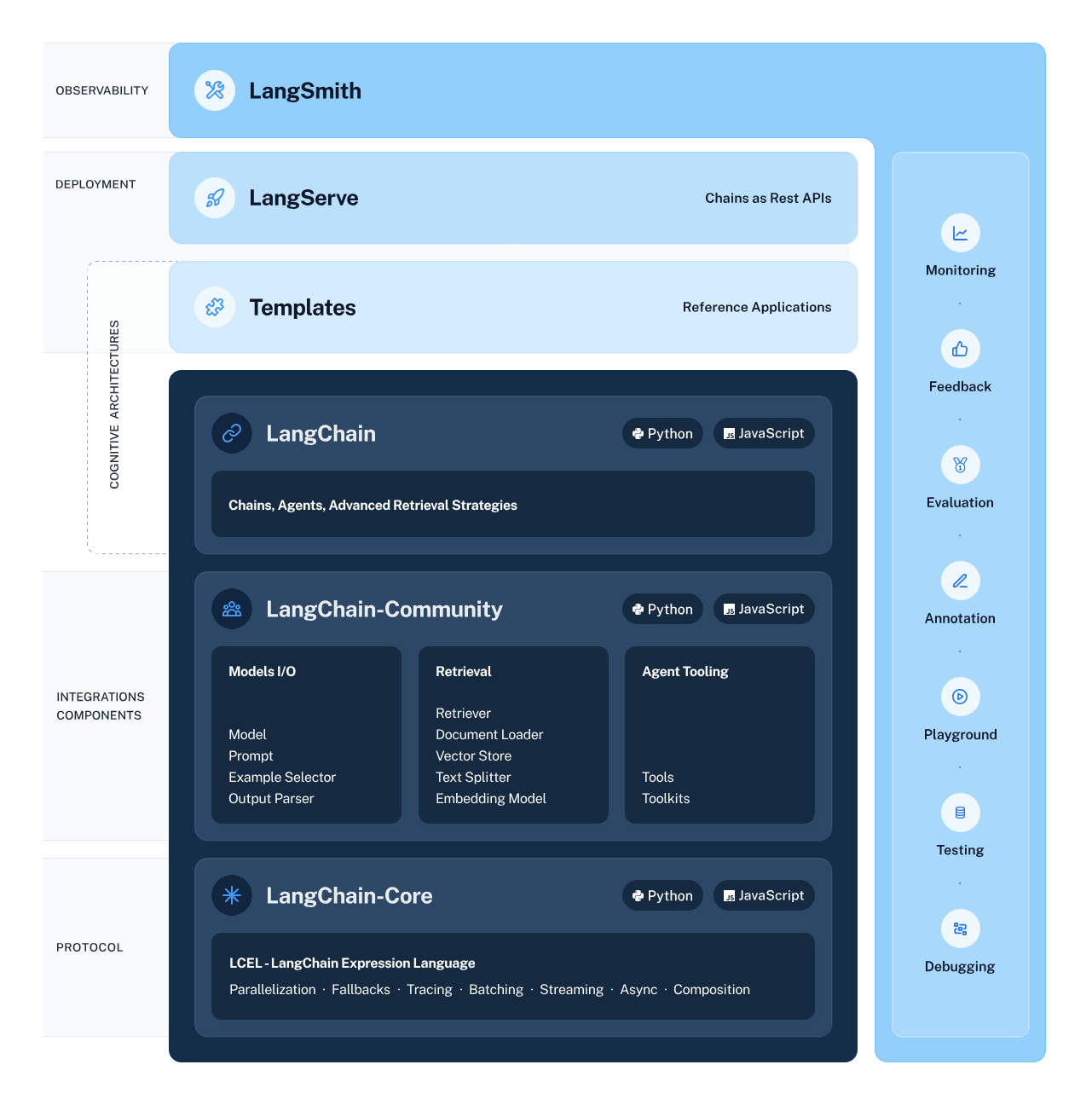

2. LangChain

LangChain est un cadre polyvalent et puissant pour le développement d'applications basées sur des modèles de langage. Il offre plusieurs composants permettant aux développeurs de créer, de déployer et de contrôler des applications contextuelles et basées sur le raisonnement.

Le cadre se compose de quatre éléments principaux :

- Bibliothèques LangChain: Les bibliothèques Python et JavaScript offrent des interfaces et des intégrations qui vous permettent de développer des applications de raisonnement contextuel.

- Modèles LangChain: Cette collection d'architectures de référence faciles à déployer couvre un large éventail de tâches, offrant aux développeurs des solutions préétablies.

- LangServe: Cette bibliothèque permet aux développeurs de déployer des chaînes LangChain sous la forme d'une API REST.

- LangSmith: Une plateforme qui vous permet de déboguer, de tester, d'évaluer et de surveiller les chaînes construites sur n'importe quel cadre LLM.

Écosystème LangChain

Apprenez à créer des applications LLM avec LangChain et exploitez le potentiel inexploité des grands modèles de langage.

Outils de suivi des expériences et de gestion des métadonnées des modèles

Ces outils vous permettent de gérer les métadonnées des modèles et facilitent le cursus des expériences :

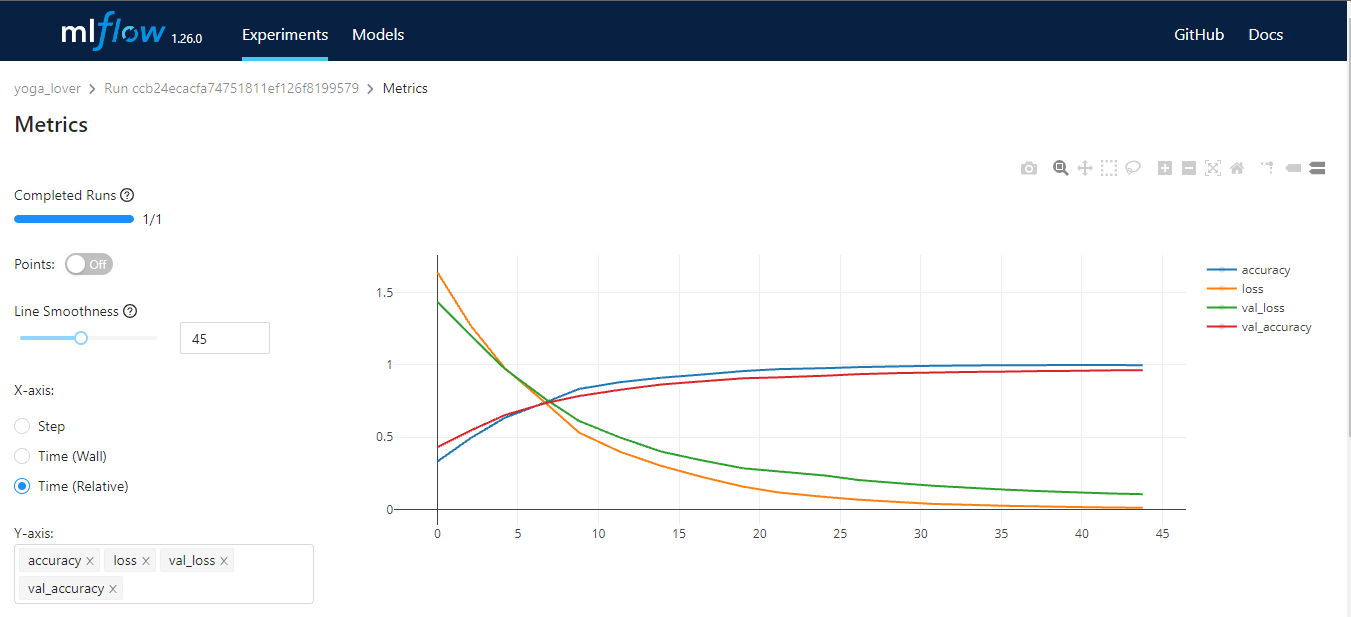

3. MLFlow

MLflow est un outil open-source qui vous aide à gérer les principales parties du cycle de vie de l'apprentissage automatique. Il est généralement utilisé pour le cursus des expériences, mais vous pouvez également l'utiliser pour la reproductibilité, le déploiement et le registre des modèles. Vous pouvez gérer les expériences d'apprentissage automatique et les métadonnées des modèles à l'aide de la CLI, de Python, de R, de Java et de l'API REST.

MLflow a quatre fonctions principales :

- Le cursus MLflow: stockage et accès au code, aux données, à la configuration et aux résultats.

- MLflow projects: package data science source for reproducibility (projets MLflow: package data science source for reproducibility).

- Modèles MLflow: déploiement et gestion de modèles d'apprentissage automatique dans divers environnements de service.

- Registre de modèles MLflow: un magasin de modèles central qui permet de gérer les versions, les transitions d'étapes, les annotations et les modèles d'apprentissage automatique.

Image par l'auteur

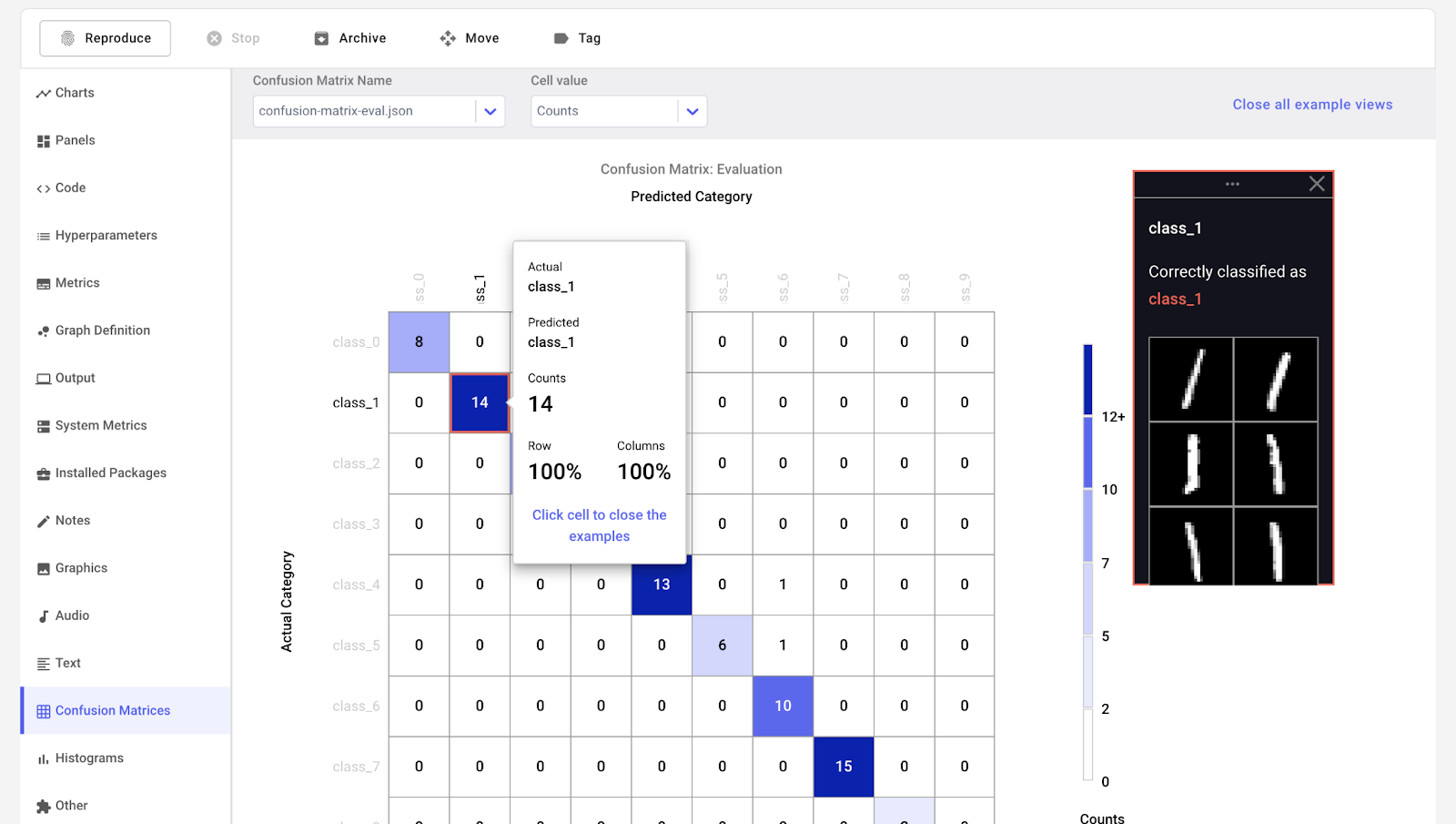

4. Comète ML

Comet ML est une plateforme de cursus, de comparaison, d'explication et d'optimisation des modèles et expériences d'apprentissage automatique. Vous pouvez l'utiliser avec n'importe quelle bibliothèque d'apprentissage automatique, comme Scikit-learn, Pytorch, TensorFlow et HuggingFace.

Comet ML s'adresse aux individus, aux équipes, aux entreprises et aux universités. Il permet à chacun de visualiser et de comparer facilement les expériences. En outre, il vous permet de visualiser des échantillons d'images, d'audio, de texte et de données tabulaires.

Image de Comet ML

5. Poids et biais

Weights & Biases est une plateforme ML pour le cursus des expériences, le versionnage des données et des modèles, l'optimisation des hyperparamètres et la gestion des modèles. En outre, vous pouvez l'utiliser pour enregistrer des artefacts (ensembles de données, modèles, dépendances, pipelines et résultats) et visualiser les ensembles de données (audio, visuel, texte et tableau).

Weights & Biases dispose d'un tableau de bord central convivial pour les expériences d'apprentissage automatique. Comme Comet ML, vous pouvez l'intégrer à d'autres bibliothèques d'apprentissage automatique, telles que Fastai, Keras, PyTorch, Hugging face, Yolov5, Spacy, et bien d'autres encore. Vous pouvez consulter notre introduction aux poids et aux bases dans un autre article.

Gif de Weights & Biases

Note: Vous pouvez également utiliser TensorBoard, Pachyderm, DagsHub et DVC Studio pour le suivi des expériences et la gestion des métadonnées ML.

Orchestration et Workflow Pipelines Outils MLOps

Ces outils vous aident à créer des projets de science des données et à gérer des flux de travail d'apprentissage automatique :

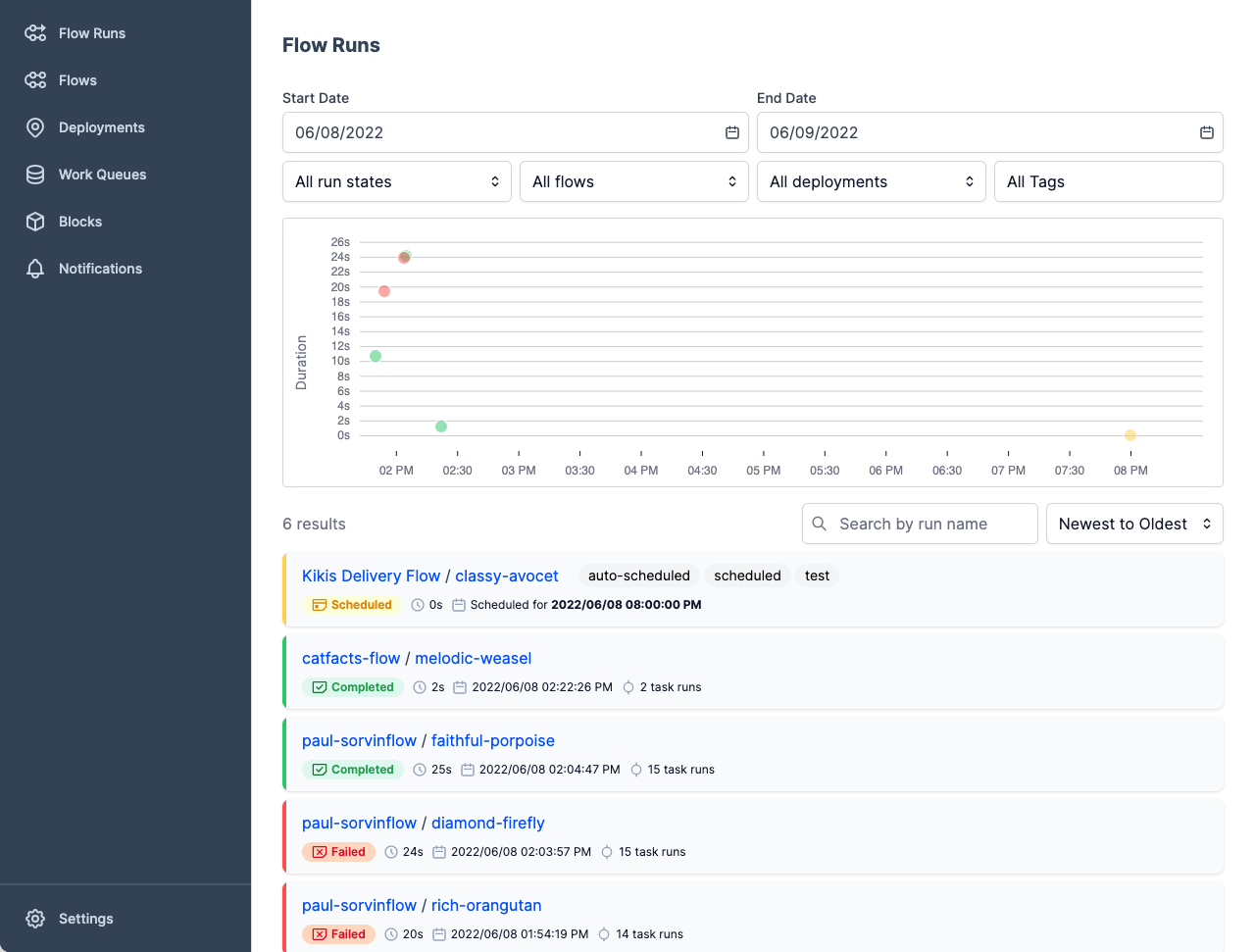

6. Préfet

The Prefect est une pile de données moderne permettant de surveiller, de coordonner et d'orchestrer les flux de travail entre et à travers les applications. Il s'agit d'un outil léger et open-source conçu pour les pipelines d'apprentissage automatique de bout en bout.

Vous pouvez utiliser soit l'interface utilisateur de Prefect Orion, soit Prefect Cloud pour les bases de données.

- Prefect Orion UI est un moteur d'orchestration et un serveur d'API open-source, hébergé localement. Il vous donne un aperçu de l'instance locale de Prefect Orion et des flux de travail.

- Prefect Cloud est un service hébergé pour vous permettre de visualiser les flux, les exécutions de flux et les déploiements. En outre, vous pouvez gérer les comptes, l'espace de travail et la collaboration au sein de l'équipe.

Image de Prefect

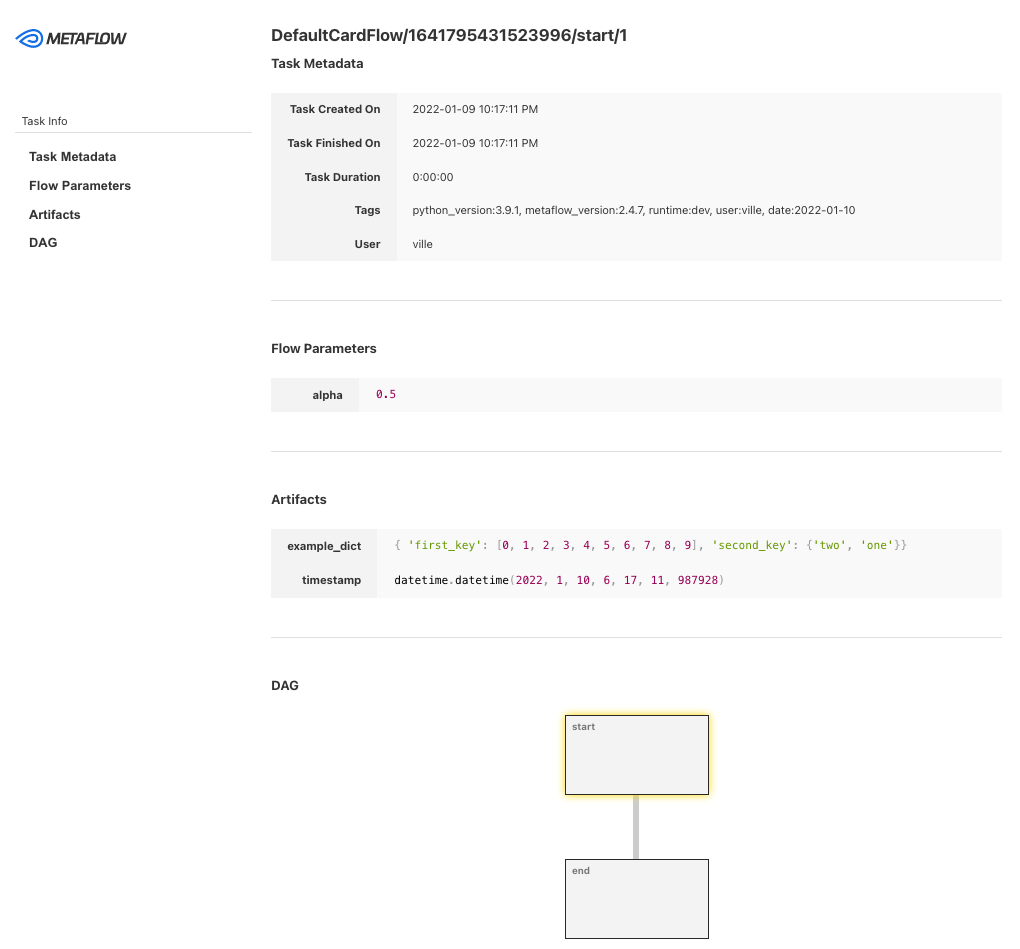

7. Metaflow

Metaflow est un outil de gestion de flux de travail puissant et robuste pour les projets de science des données et d'apprentissage automatique. Il a été conçu pour les scientifiques des données afin qu'ils puissent se concentrer sur la construction de modèles au lieu de se préoccuper de l'ingénierie MLOps.

Avec Metaflow, vous pouvez concevoir un flux de travail, l'exécuter à l'échelle et déployer le modèle en production. Il cursus et version des expériences et des données d'apprentissage automatique automatiquement. En outre, vous pouvez visualiser les résultats dans le carnet de notes.

Metaflow fonctionne avec plusieurs clouds (notamment AWS, GCP et Azure) et divers packages Python d'apprentissage automatique (comme Scikit-learn et Tensorflow), et l'API est également disponible pour le langage R.

Image de Metaflow

8. Kedro

Kedro est un outil d'orchestration de flux de travail basé sur Python. Vous pouvez l'utiliser pour créer des projets de science des données reproductibles, maintenables et modulaires. Il intègre les concepts de l'ingénierie logicielle dans l'apprentissage automatique, tels que la modularité, la séparation des préoccupations et le versionnage.

Avec Kedro, vous pouvez :

- Mettre en place les dépendances et la configuration.

- Établir les données.

- Créez, visualisez et exécutez les pipelines.

- L'enregistrement et le cursus des expériences.

- Déploiement sur une machine unique ou distribuée.

- Créez un code de science des données facile à maintenir.

- Créez un code modulaire et réutilisable.

- Collaborer avec des coéquipiers sur des projets.

Gif de Kedro

Remarque: vous pouvez également utiliser Kubeflow et DVC pour l'orchestration et les pipelines de flux de travail.

Outils de versionnement des données et du pipeline

Grâce à ces outils MLOps, vous pouvez gérer les tâches liées à la version des données et du pipeline :

9. Pachyderme

Pachyderm automatise la transformation des données avec le versionnage des données, le lignage et les pipelines de bout en bout sur Kubernetes. Vous pouvez intégrer n'importe quelles données (images, journaux, vidéos, CSV), n'importe quel langage (Python, R, SQL, C/C++) et à n'importe quelle échelle (Pétaoctets de données, milliers de tâches).

L'édition communautaire est open-source et destinée à une petite équipe. Les organisations et les équipes qui souhaitent bénéficier de fonctionnalités avancées peuvent opter pour l'édition Enterprise.

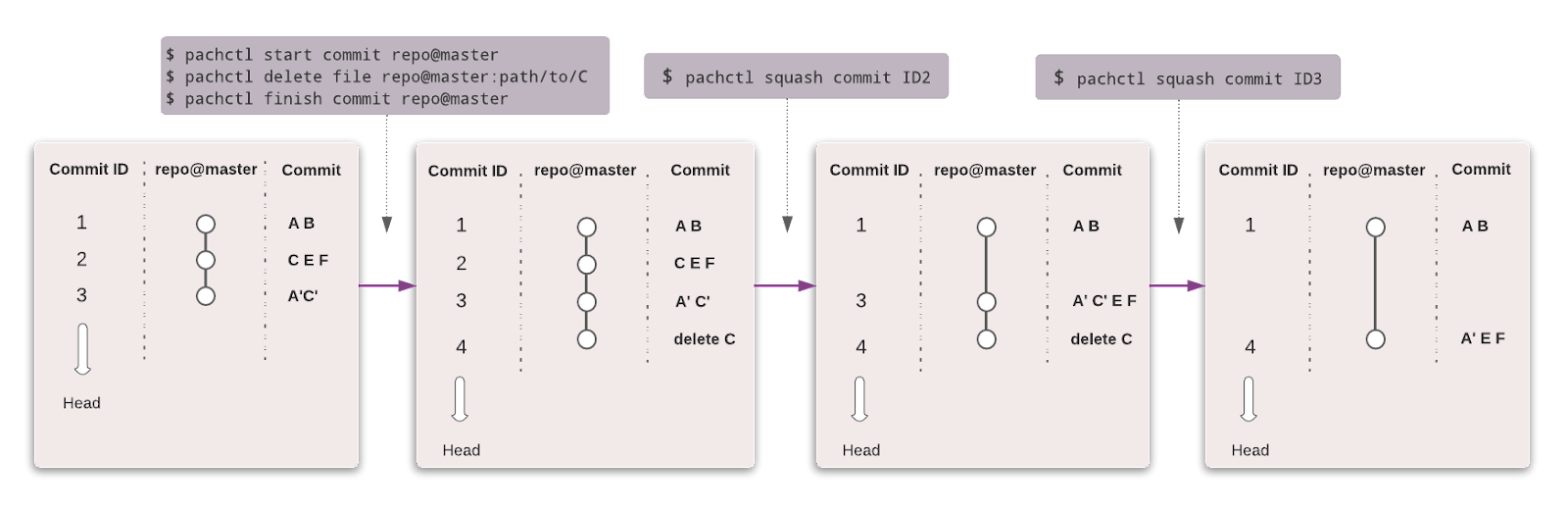

Tout comme Git, vous pouvez versionner vos données en utilisant une syntaxe similaire. Dans Pachyderm, le niveau le plus élevé de l'objet est Repository, et vous pouvez utiliser Commit, Branches, File, History et Provenance pour suivre et versionner le jeu de données.

Image de Pachyderm

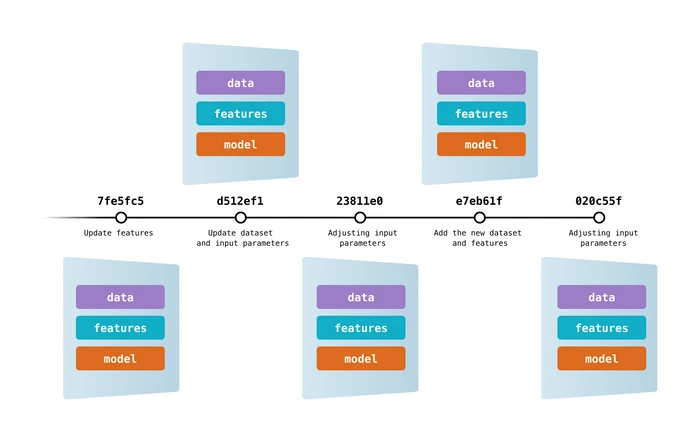

10. Contrôle de la version des données (DVC)

Data Version Control est un outil libre et populaire pour les projets d'apprentissage automatique. Il fonctionne de manière transparente avec Git pour vous fournir du code, des données, des modèles, des métadonnées et des versions de pipeline.

DVC est plus qu'un simple outil de suivi des données et de gestion des versions.

Vous pouvez l'utiliser pour :

- Le cursus de l'expérience (métriques du modèle, paramètres, versions).

- Créez, visualisez et exécutez des pipelines d'apprentissage automatique.

- Workflow pour le déploiement et la collaboration.

- Reproductibilité.

- Registre des données et des modèles.

- Intégration et déploiement continus pour l'apprentissage automatique à l'aide de CML.

Image de DVC

Note: DagsHub peut également être utilisé pour le versionnage des données et du pipeline.

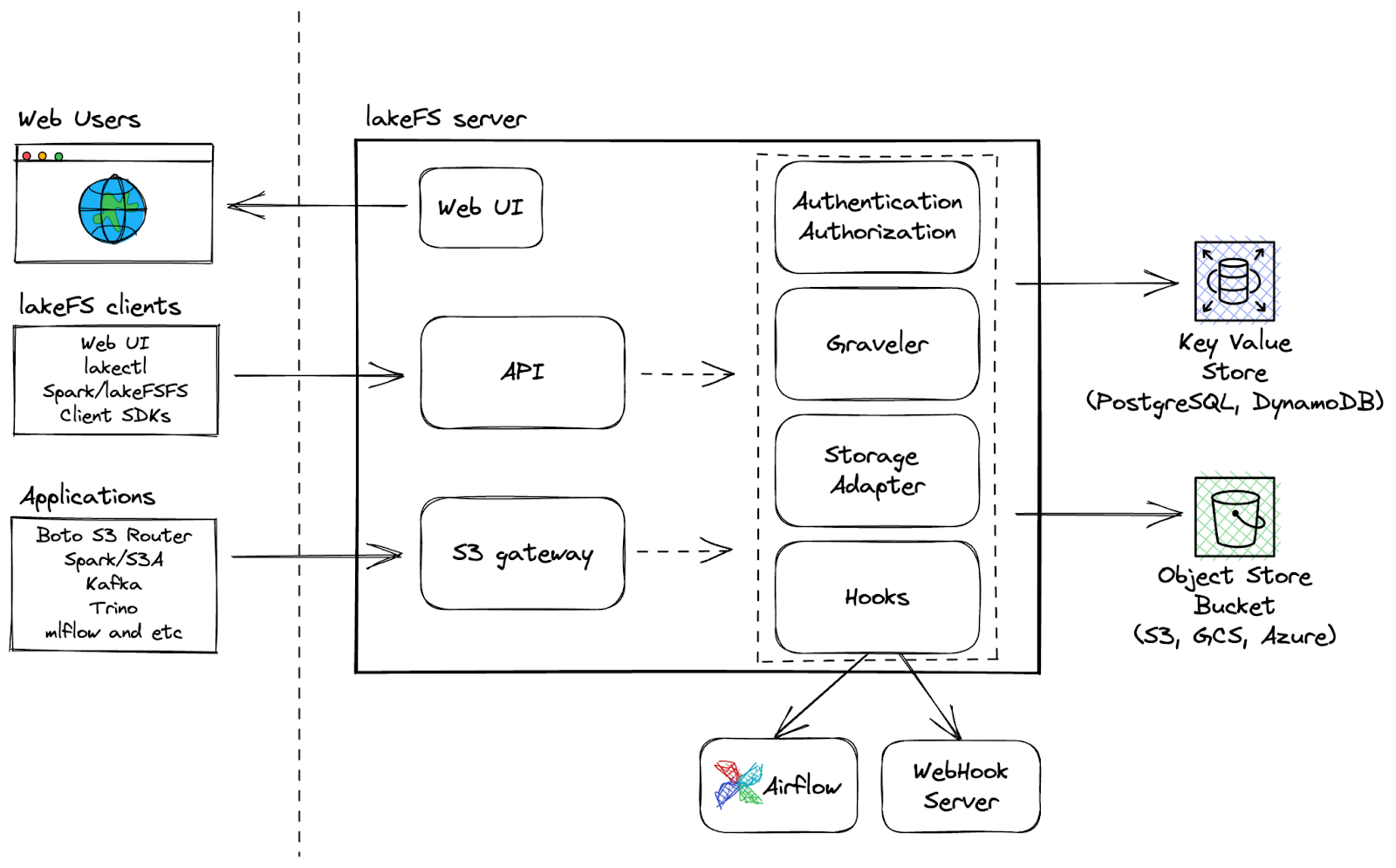

11. LakeFS

LakeFS est un outil open-source de contrôle de version de données évolutif qui fournit une interface de contrôle de version de type Git pour le stockage d'objets, permettant aux utilisateurs de gérer leurs lacs de données comme ils le feraient pour leur code. Avec LakeFS, les utilisateurs peuvent contrôler les versions des données à l'échelle d'un exaoctet, ce qui en fait une solution hautement évolutive pour la gestion de grands lacs de données.

Capacités supplémentaires:

- Effectuez des opérations Git telles que branch, commit et merge sur n'importe quel service de stockage.

- Développement plus rapide grâce à un branchement sans copie pour une expérimentation sans friction et une collaboration aisée

- Utilisez des crochets de pré-commission et de fusion pour les flux de travail CI/CD afin de garantir des flux de travail propres.

- La plateforme résiliente permet une récupération plus rapide des données grâce à la possibilité de revenir en arrière.

LakeFS Architecture

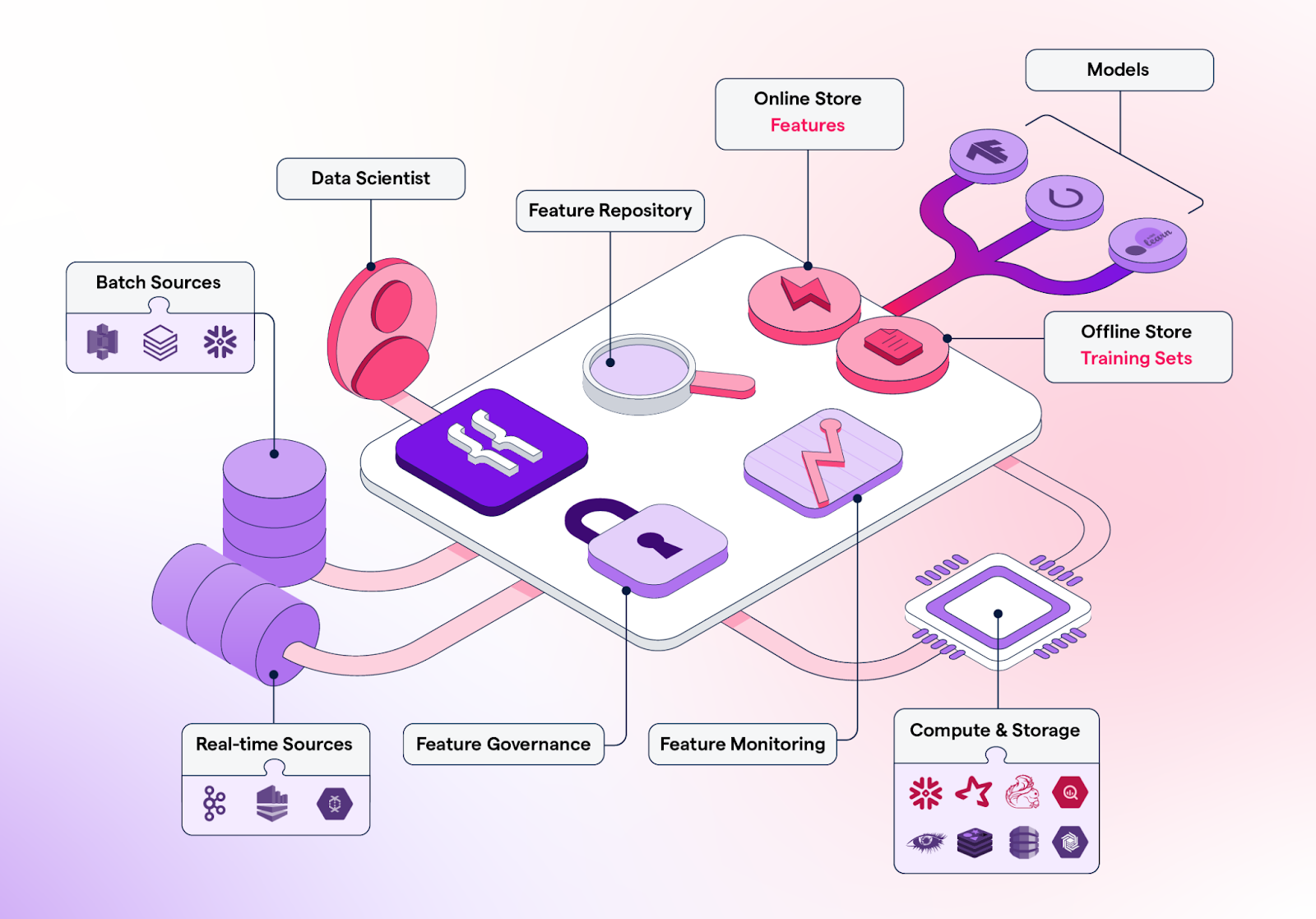

Magasins de détail

Les magasins d'entités sont des référentiels centralisés pour le stockage, la gestion des versions et la fourniture d'entités (attributs de données traitées utilisés pour l'apprentissage des modèles d'apprentissage automatique) pour les modèles d'apprentissage automatique en production ainsi qu'à des fins de formation.

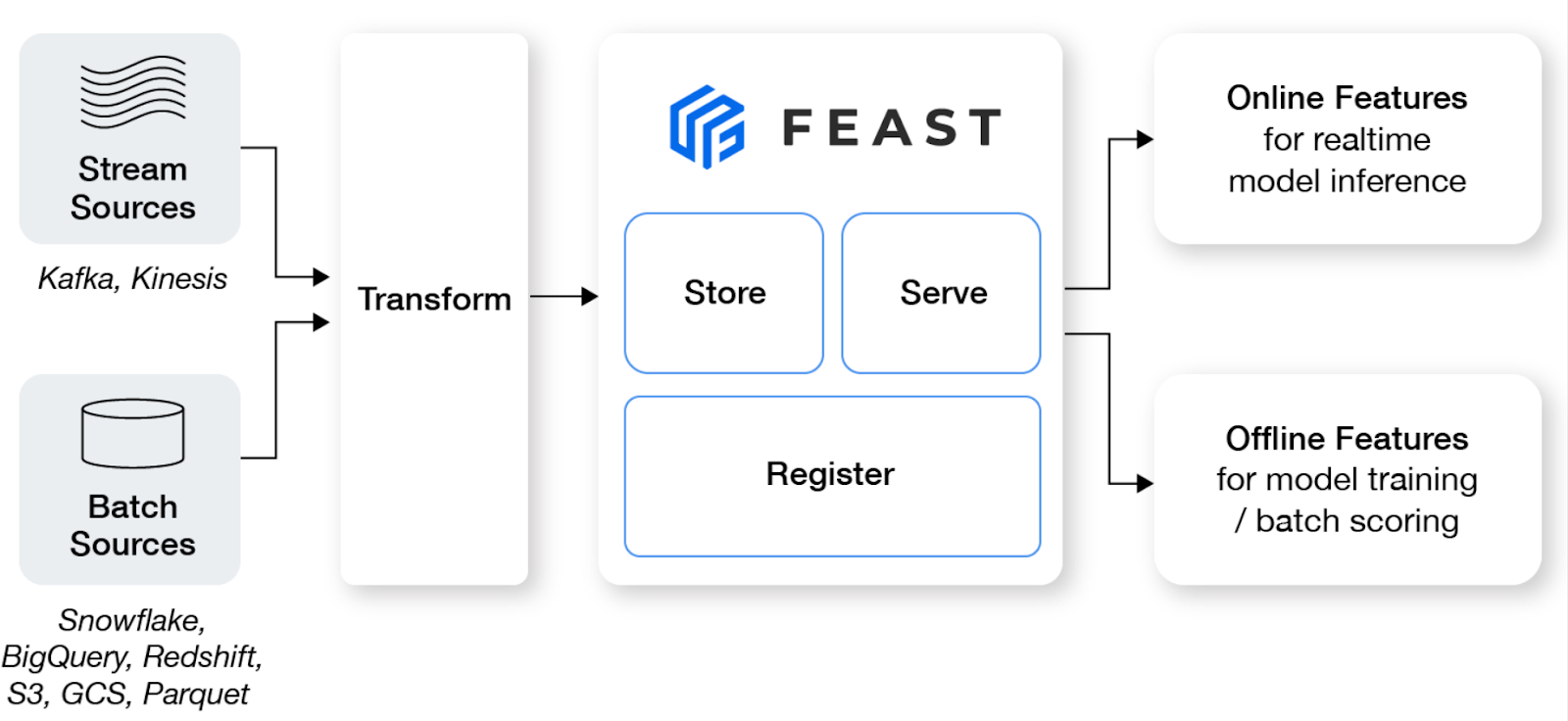

12. Festin

Feast est un magasin de fonctionnalités open-source qui aide les équipes d'apprentissage automatique à produire des modèles en temps réel et à construire une plateforme de fonctionnalités qui favorise la collaboration entre les ingénieurs et les scientifiques des données.

Caractéristiques principales:

- Gérez un magasin hors ligne, un magasin en ligne à faible latence et un serveur de fonctionnalités afin de garantir une disponibilité constante des fonctionnalités à des fins de formation et de service.

- Évitez les fuites de données en créant des ensembles d'éléments ponctuels précis, ce qui évite aux spécialistes des données d'avoir à joindre des ensembles de données sujets à des erreurs.

- Découpler la ML de l'infrastructure de données en ayant une seule couche d'accès.

Image de Feast

13. Formulaire d'information

Featureform est un magasin virtuel de fonctionnalités qui permet aux scientifiques des données de définir, de gérer et de servir les fonctionnalités de leur modèle ML. Il peut aider les équipes de science des données à améliorer la collaboration, à organiser l'expérimentation, à faciliter le déploiement, à accroître la fiabilité et à préserver la conformité.

Caractéristiques principales:

- Améliorez la collaboration en partageant, réutilisant et comprenant les fonctionnalités au sein de l'équipe.

- Lorsque votre fonctionnalité est prête à être déployée, Featureform orchestre votre infrastructure de données pour la préparer à la production.

- Le système garantit qu'aucune caractéristique, étiquette ou ensemble de formation ne peut être modifié pour améliorer la fiabilité.

- Grâce au contrôle d'accès intégré basé sur les rôles, aux journaux d'audit et aux règles de service dynamiques, Featureform peut directement mettre en œuvre votre logique de conformité.

Image de Featureform

Essai du modèle

Grâce à ces outils MLOps, vous pouvez tester la qualité des modèles et garantir la fiabilité, la robustesse et la précision des modèles d'apprentissage automatique :

14. Deepchecks ML Models Testing

Deepchecks est une solution open-source qui répond à tous vos besoins en matière de validation ML, garantissant que vos données et vos modèles sont testés de manière approfondie, de la recherche à la production. Il offre une approche holistique pour valider vos données et vos modèles grâce à ses différents composants.

Image de Deepchecks

Les vérifications approfondies se composent de trois éléments :

- Tests Deepchecks: vous permet de créer des vérifications et des suites personnalisées pour la validation tabulaire, le traitement du langage naturel et la vision par ordinateur.

- Gestion de l'analyse critique et des tests: fournit une gestion de l'analyse critique et des tests pour vous aider à collaborer avec votre équipe et à gérer les résultats des tests de manière efficace.

- Suivi des contrôles en profondeur: assure le suivi et la validation des modèles en production.

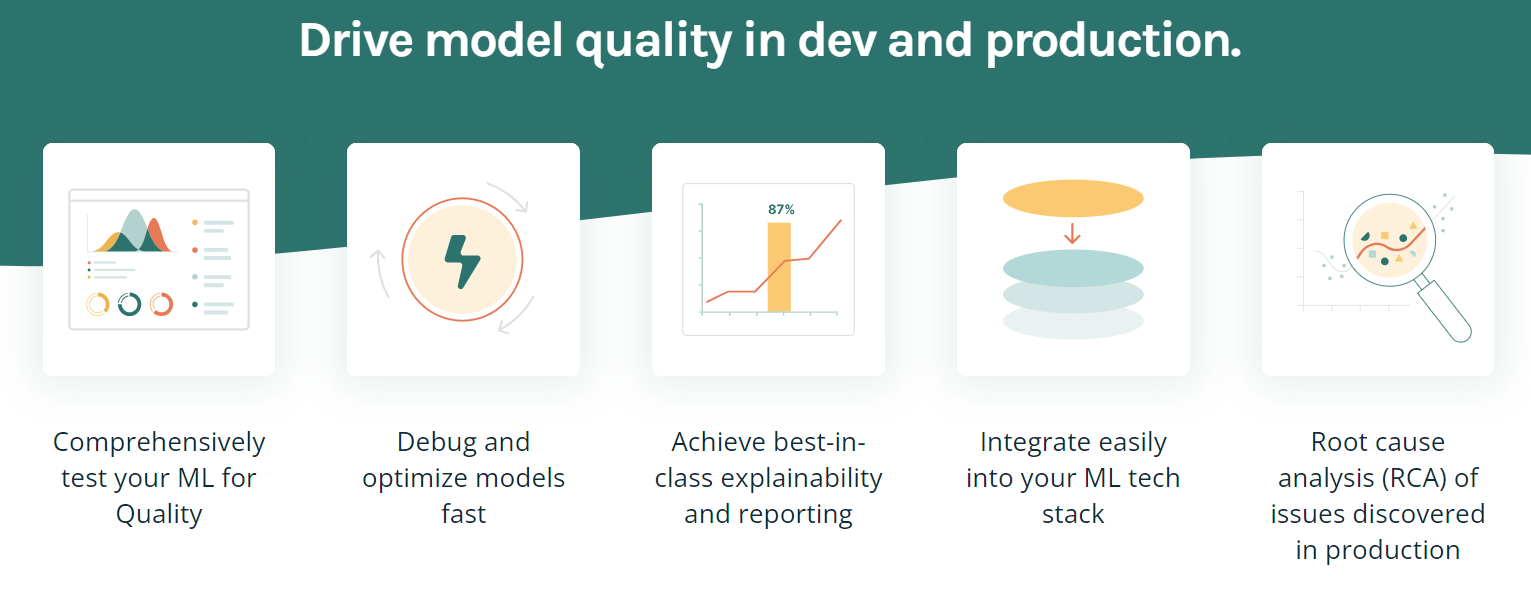

15. TruEra

TruEra est une plateforme avancée conçue pour améliorer la qualité et la performance des modèles grâce à des tests automatisés, à l'explicabilité et à l'analyse des causes profondes. Il offre diverses fonctionnalités permettant d'optimiser et de déboguer les modèles, d'obtenir la meilleure explicabilité possible et de s'intégrer facilement dans votre pile technologique de ML.

Caractéristiques principales:

- La fonction de test et de débogage des modèles vous permet d'améliorer la qualité des modèles pendant le développement et la production.

- Il peut effectuer des tests automatisés et systématiques pour garantir la performance, la stabilité et l'équité.

- Il comprend l'évolution des versions des modèles. Cela vous permet d'extraire des informations qui vous aideront à développer des modèles plus rapidement et plus efficacement.

- Identifier et préciser les caractéristiques spécifiques qui contribuent à la distorsion du modèle.

- TruEra s'intègre facilement dans votre infrastructure et votre flux de travail actuels.

Image par TruEra

Outils de déploiement et de mise à disposition de modèles

Lorsqu'il s'agit de déployer des modèles, ces outils MLOps peuvent s'avérer extrêmement utiles :

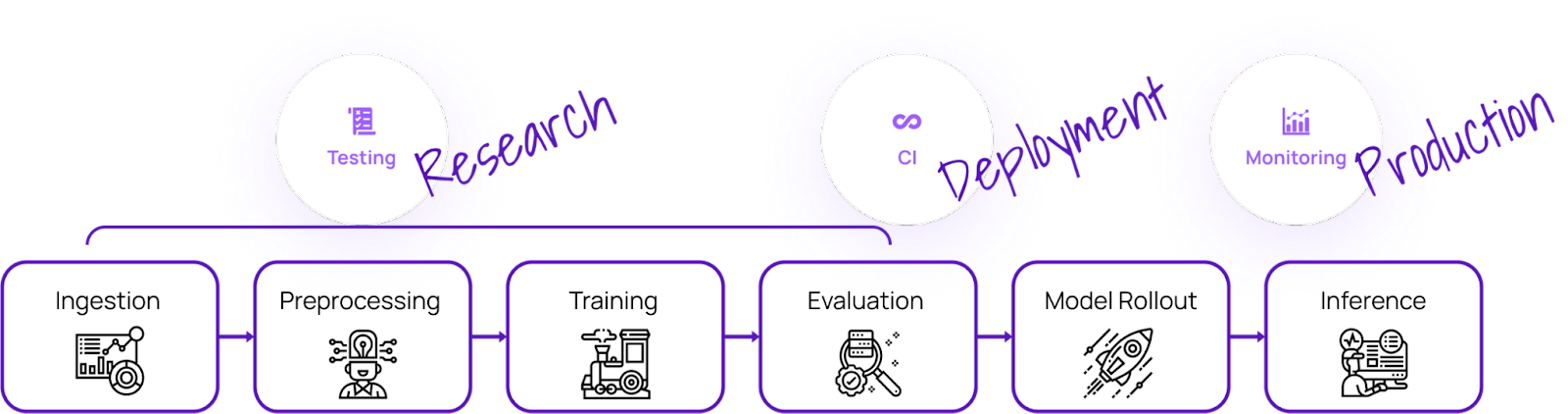

16. Kubeflow

Kubeflow rend le déploiement de modèles d'apprentissage automatique sur Kubernetes simple, portable et évolutif. Vous pouvez l'utiliser pour la préparation des données, l'entraînement des modèles, l'optimisation des modèles, la prédiction au service et la motorisation de la performance des modèles en production. Vous pouvez déployer le flux de travail d'apprentissage automatique localement, sur site, ou dans le cloud. En bref, il facilite l'utilisation de Kubernetes pour les équipes de science des données.

Caractéristiques principales:

- Tableau de bord centralisé avec interface utilisateur interactive.

- Pipelines d'apprentissage automatique pour la reproductibilité et la rationalisation.

- Prise en charge native de JupyterLab, RStudio et Visual Studio Code.

- Réglage des hyperparamètres et recherche d'architecture neuronale.

- Jobs de formation pour Tensorflow, Pytorch, PaddlePaddle, MXNet et XGboost.

- Planification des tâches.

- Fournir aux administrateurs une isolation multi-utilisateurs.

- Fonctionne avec tous les principaux fournisseurs de clouds.

Image de Kubeflow

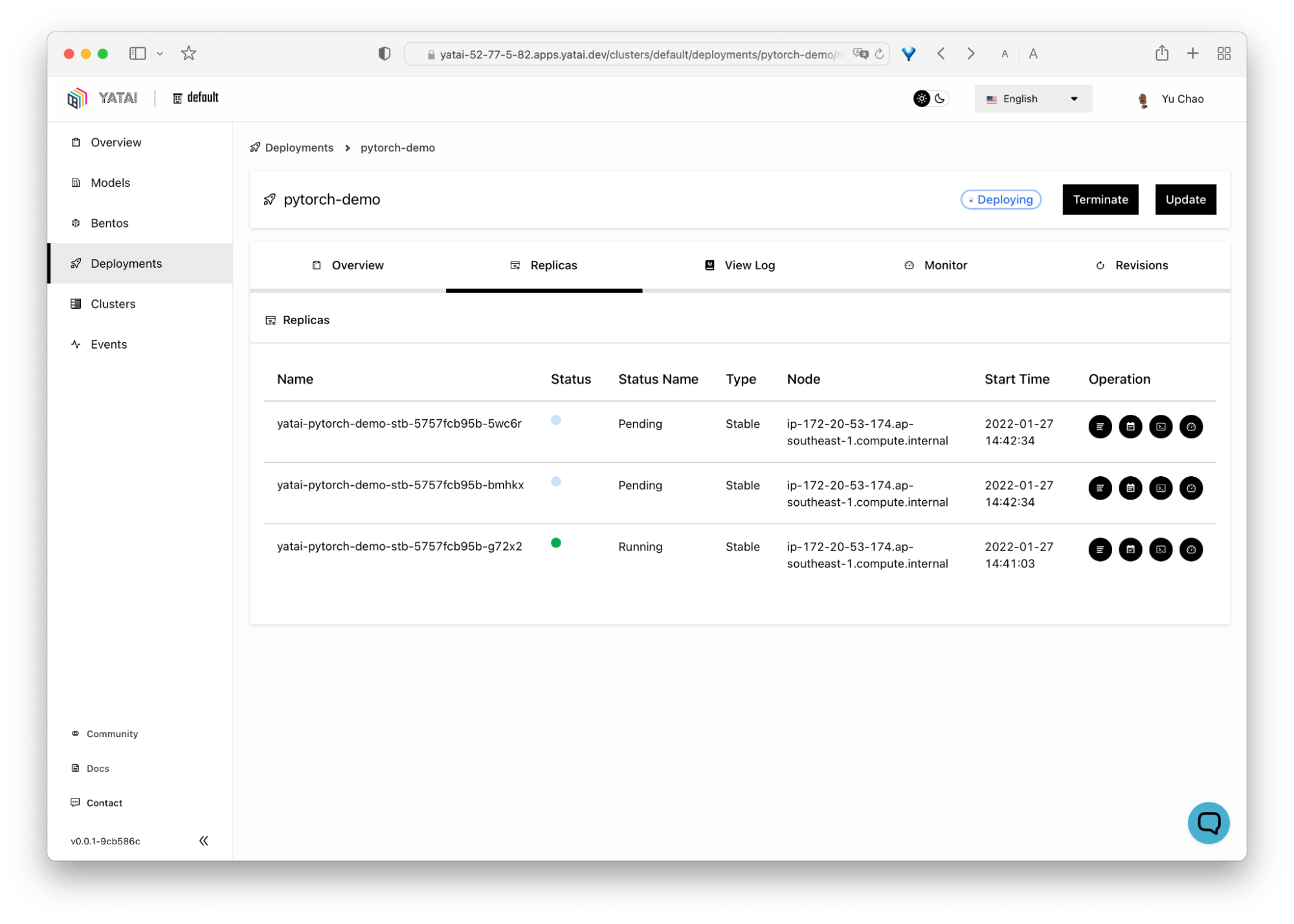

10. BentoML

BentoML facilite et accélère la mise en place d'applications d'apprentissage automatique. Il s'agit d'un outil Python-first pour le déploiement et la maintenance des API en production. Il s'adapte avec de puissantes optimisations en exécutant l'inférence parallèle et la mise en lots adaptative et fournit une accélération matérielle.

Le tableau de bord centralisé et interactif de BentoML facilite l'organisation et le suivi du déploiement des modèles d'apprentissage automatique. Le plus intéressant est qu'il fonctionne avec toutes sortes de cadres d'apprentissage automatique, tels que Keras, ONNX, LightGBM, Pytorch et Scikit-learn. En bref, BentoML fournit une solution complète pour le déploiement, le service et la surveillance des modèles.

Image de BentoML

18. Points finaux de l'inférence Hugging Face

Hugging Face Inference Endpoints est un service basé sur le cloud offert par Hugging Face, une plateforme ML tout-en-un qui permet aux utilisateurs d'entraîner, d'héberger et de partager des modèles, des ensembles de données et des démonstrations. Ces points finaux sont conçus pour aider les utilisateurs à déployer leurs modèles d'apprentissage automatique formés pour l'inférence sans avoir à mettre en place et à gérer l'infrastructure requise.

Caractéristiques principales:

- Maintenez le coût à un niveau aussi bas que 0,06 $ par cœur de CPU/heure et 0,6 $ par GPU/heure, en fonction de vos besoins.

- Facile à déployer en quelques secondes.

- Entièrement gérée et mise à l'échelle automatique.

- Fait partie de l'écosystème Hugging Face.

- Sécurité au niveau de l'entreprise.

Image tirée de Hugging Face

Note : Vous pouvez également utiliser MLflow et AWS Sagemaker pour le déploiement et la distribution des modèles.

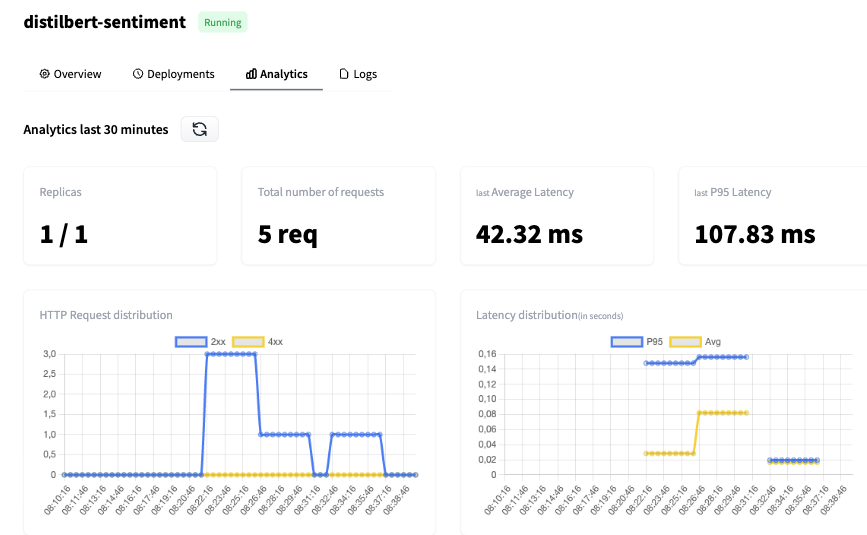

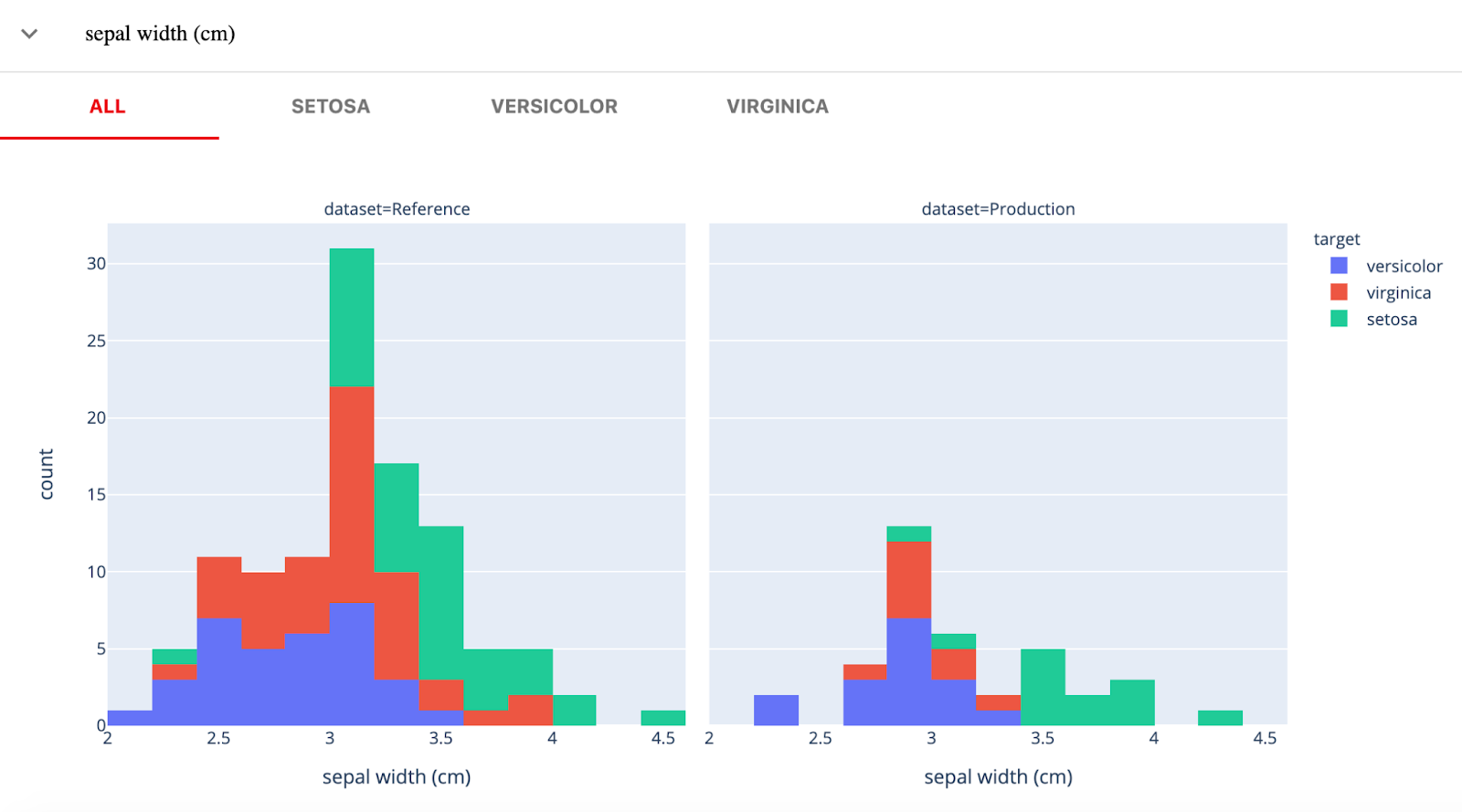

Surveillance des modèles en production ML Ops Tools

Que votre modèle de ML soit en cours de développement, de validation ou déployé en production, ces outils peuvent vous aider à contrôler une série de facteurs :

19. De toute évidence

Evidently AI est une bibliothèque Python open-source pour la surveillance des modèles ML pendant le développement, la validation et en production. Il vérifie la qualité des données et des modèles, la dérive des données, la dérive des cibles et les performances de régression et de classification.

Evidently a trois composantes principales :

- Tests (contrôles de modèles par lots) : pour effectuer des contrôles de qualité des données structurées et des modèles.

- Rapports (tableaux de bord interactifs) : dérive interactive des données, performance des modèles et virtualisation des cibles.

- Surveillance (surveillance en temps réel) : surveillance des données et des métriques de modèle du service ML déployé.

Image de Evidently

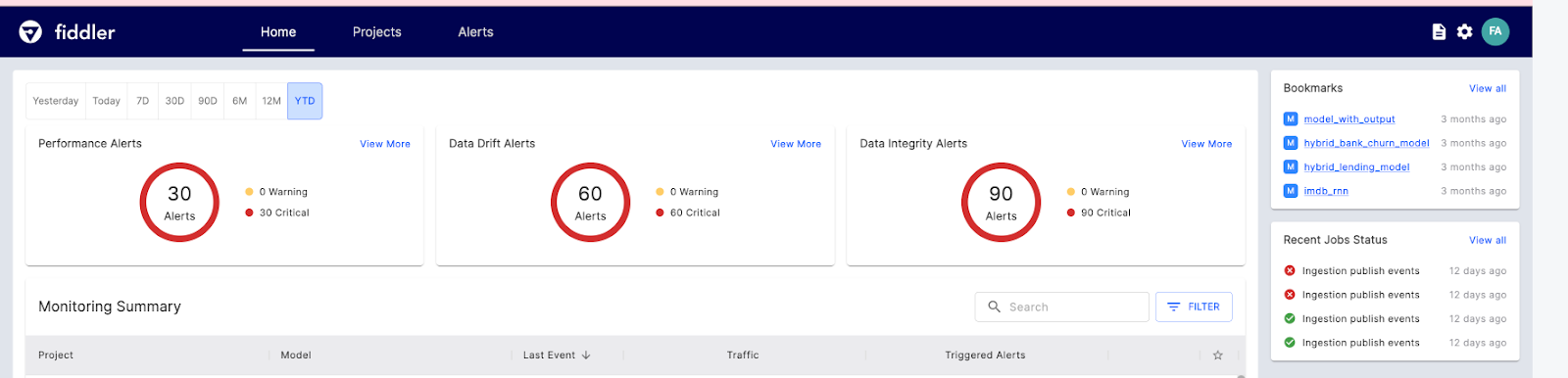

20. Violoniste

Fiddler AI est un outil de surveillance des modèles ML doté d'une interface utilisateur claire et facile à utiliser. Il vous permet d'expliquer et de déboguer les prédictions, d'analyser le comportement des modes pour l'ensemble des données, de déployer des modèles d'apprentissage automatique à grande échelle et de surveiller les performances des modèles.

Examinons les principales fonctionnalités de Fiddler AI pour la surveillance du ML :

- Surveillance des performances: visualisation approfondie de la dérive des données, du moment où elle se produit et de la manière dont elle se produit.

- Intégrité des données: évitez de fournir des données incorrectes pour l'entraînement du modèle.

- Cursus des valeurs aberrantes: montre les valeurs aberrantes univariées et multivariées.

- Métriques de service: elles donnent un aperçu des opérations de service de la ML.

- Alertes: définissez des alertes pour un modèle ou un groupe de modèles afin de signaler les problèmes en production.

Image de Fiddler

Moteurs d'exécution

Le moteur d'exécution est responsable du chargement du modèle, du prétraitement des données d'entrée, de l'exécution de l'inférence et du renvoi des résultats à l'application cliente.

21. Ray

Ray est un framework polyvalent conçu pour mettre à l'échelle les applications d'IA et de Python, facilitant ainsi la gestion et l'optimisation des projets d'apprentissage automatique par les développeurs.

La plateforme se compose de deux éléments principaux : un moteur d'exécution distribué et un ensemble de bibliothèques d'intelligence artificielle conçues pour simplifier le calcul ML.

Ray Core offre un ensemble limité d'éléments fondamentaux qui peuvent être utilisés pour construire et développer des applications distribuées.

- Les tâches sont des fonctions qui n'ont pas d'état et qui sont exécutées au sein du cluster.

- Les acteurs sont des processus de travail avec état qui sont créés au sein du cluster.

- Les objets sont des valeurs immuables auxquelles n'importe quel composant du cluster peut accéder.

Ray fournit également des bibliothèques d'IA pour les ensembles de données évolutifs pour la ML, l'entraînement distribué, l'ajustement des hyperparamètres, l'apprentissage par renforcement et les services évolutifs et programmables.

L'exemple suivant illustre la formation et l'utilisation d'un modèle de classification par renforcement du gradient.

import requests

from starlette.requests import Request

from typing import Dict

from sklearn.datasets import load_iris

from sklearn.ensemble import GradientBoostingClassifier

from ray import serve

# Train model.

iris_dataset = load_iris()

model = GradientBoostingClassifier()

model.fit(iris_dataset["data"], iris_dataset["target"])

@serve.deployment

class BoostingModel:

def __init__(self, model):

self.model = model

self.label_list = iris_dataset["target_names"].tolist()

async def __call__(self, request: Request) -> Dict:

payload = (await request.json())["vector"]

print(f"Received http request with data {payload}")

prediction = self.model.predict([payload])[0]

human_name = self.label_list[prediction]

return {"result": human_name}

# Deploy model.

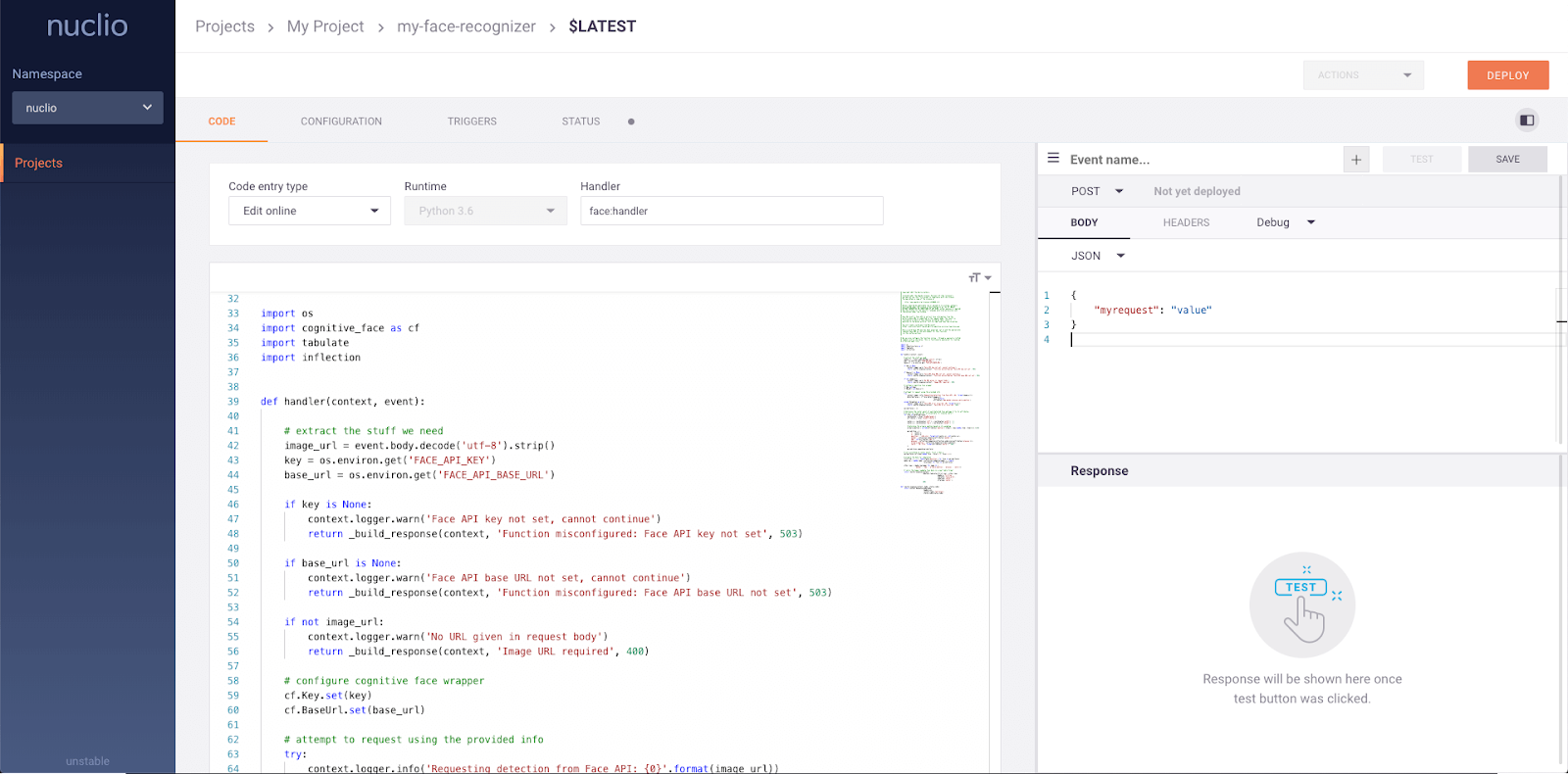

serve.run(BoostingModel.bind(model), route_prefix="/iris")22. Nuclio

Nuclio est un cadre puissant qui se concentre sur les charges de travail à forte intensité de données, d'E/S et de calcul. Il est conçu pour être sans serveur, ce qui signifie que vous n'avez pas à vous soucier de la gestion des serveurs. Nuclio est bien intégré aux outils de science des données les plus populaires, tels que Jupyter et Kubeflow. Il prend également en charge une grande variété de sources de données et de flux et peut être exécuté sur des CPU et des GPU.

Caractéristiques principales:

- Nécessite un minimum de ressources CPU/GPU et E/S pour effectuer un traitement en temps réel tout en maximisant le parallélisme.

- S'intègre à un large éventail de sources de données et de frameworks de ML.

- Fournit des fonctions d'état avec accélération du chemin de données

- Portabilité sur toutes sortes d'appareils et de plateformes cloud, en particulier les appareils à faible consommation d'énergie.

- Conçu pour l'entreprise.

Image de Nuclio

Plateformes MLOps de bout en bout

Si vous êtes à la recherche d'un outil MLOps complet qui peut vous aider tout au long du processus, voici quelques-uns des meilleurs :

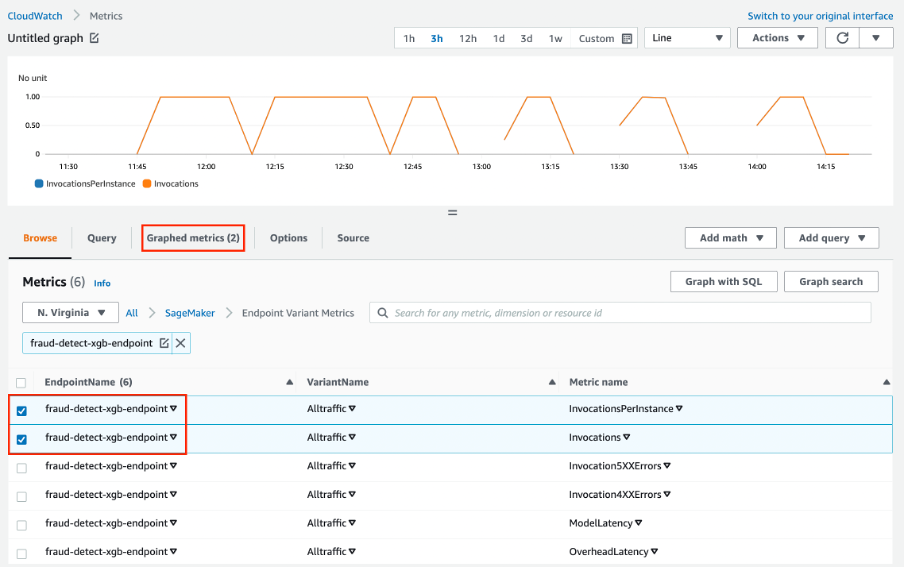

23. AWS SageMaker

Amazon Web Services SageMaker est une solution complète pour les MLOps. Vous pouvez former et accélérer le développement de modèles, suivre et versionner des expériences, cataloguer des artefacts ML, intégrer des pipelines ML CI/CD, et déployer, servir et surveiller des modèles en production de manière transparente.

Caractéristiques principales:

- Un environnement collaboratif pour les équipes de science des données.

- Automatisez les flux de formation en ML.

- Déployer et gérer des modèles en production.

- Cursus et mise à jour des versions du modèle.

- CI/CD pour l'intégration et le déploiement automatiques.

- Contrôle continu et maintien des modèles pour préserver la qualité.

- Optimisez les coûts et les performances.

Image de Amazon SageMaker

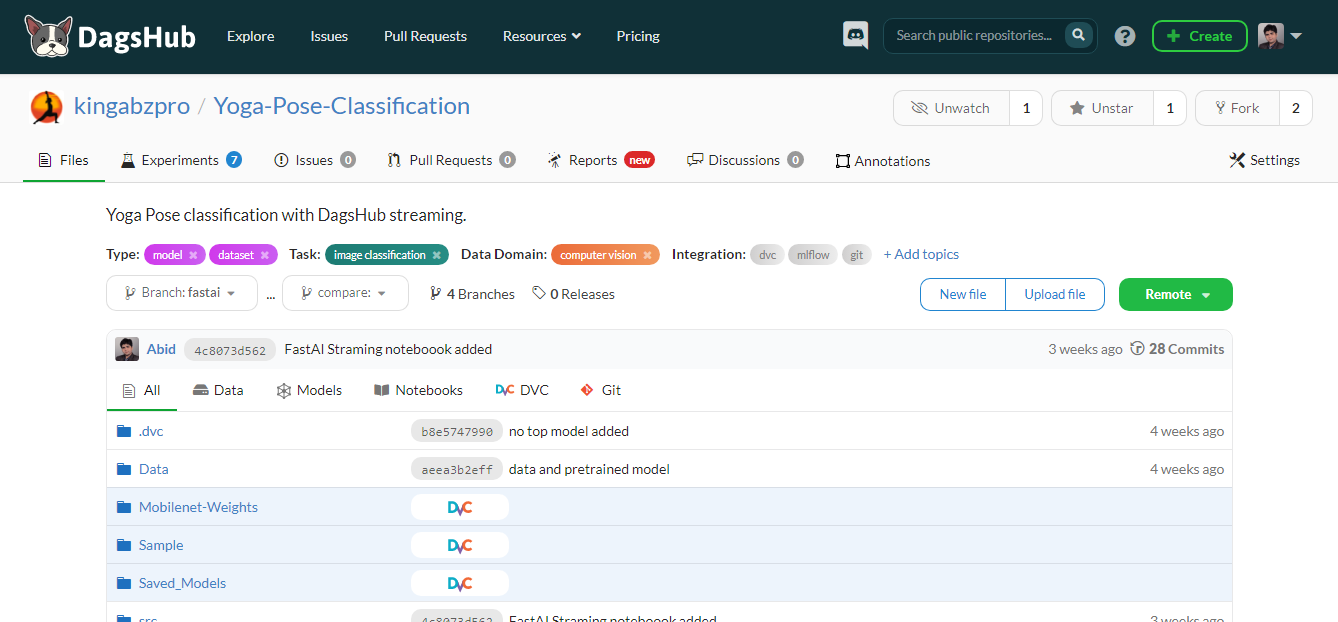

24. DagsHub

DagsHub est une plateforme faite pour la communauté de l'apprentissage automatique pour suivre et versionner les données, les modèles, les expériences, les pipelines ML, et le code. Il permet à votre équipe d'élaborer, de réviser et de partager des projets d'apprentissage automatique.

En d'autres termes, il s'agit d'un GitHub pour l'apprentissage automatique, et vous disposez de divers outils pour optimiser le processus d'apprentissage automatique de bout en bout.

Caractéristiques principales:

- Dépôt Git et DVC pour vos projets ML.

- Logger DagsHub et instance MLflow pour le cursus des expériences.

- Annotation d'un ensemble de données à l'aide d'une instance de Label Studio.

- Différencier les carnets Jupyter, le code, les ensembles de données et les images.

- Possibilité de commenter le fichier, la ligne de code ou l'ensemble de données.

- Créez un rapport pour le projet comme pour le wiki GitHub.

- Visualisation du pipeline de ML.

- Résultats reproductibles.

- Exécution de CI/CD pour la formation et le déploiement de modèles.

- Fusion de données.

- Assurez l'intégration avec GitHub, Google Colab, DVC, Jenkins, le stockage externe, les webhooks et New Relic.

Image par l'auteur

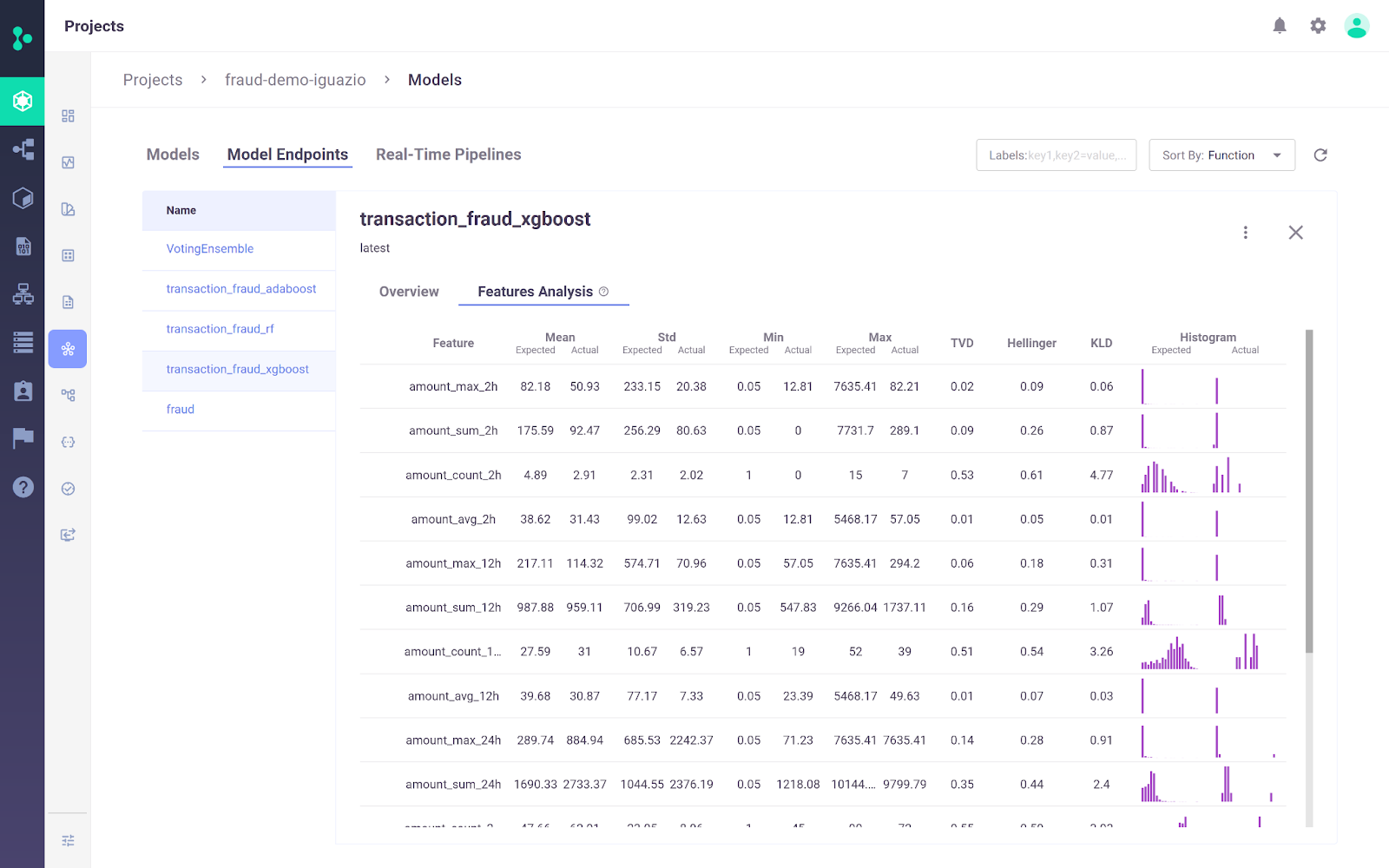

25. Plateforme MLOps d'Iguazio

La plateforme MLOps d 'Iguazio est une plateforme MLOps de bout en bout qui permet aux organisations d'automatiser le pipeline d'apprentissage automatique, de la collecte et de la préparation des données à l'entraînement, au déploiement et à la surveillance en production. Il s'agit d'une plateforme ouverte(MLRun) et gérée.

La plateforme MLOps d'Iguazio se distingue notamment par sa flexibilité en matière d'options de déploiement. Les utilisateurs peuvent déployer des applications d'IA n'importe où, y compris dans n'importe quel environnement cloud, hybride ou sur site. Ceci est particulièrement important pour des secteurs tels que la santé et la finance, où les préoccupations en matière de confidentialité des données peuvent imposer un déploiement sur site.

Image de la plateforme MLOps d'Iguazio

Caractéristiques principales:

- La plateforme permet aux utilisateurs d'ingérer des données à partir de n'importe quelle source et de créer des fonctionnalités réutilisables en ligne et hors ligne à l'aide du magasin de fonctionnalités intégré.

- Il prend en charge l'entraînement et l'évaluation continus des modèles à l'échelle à l'aide de serverless évolutifs avec un cursus automatisé, un versionnage des données, ainsi qu'une intégration et un déploiement continus.

- Il est facile de déployer des modèles en production en quelques clics, de surveiller en permanence les performances des modèles et d'atténuer leur dérive.

- La plateforme s'accompagne d'un tableau de bord simple pour la gestion, la gouvernance et le suivi des modèles et de la production en temps réel.

Aperçu des outils MLOps

Voici un tableau comparatif qui vous permettra d'évaluer ces outils côte à côte et de choisir ceux qui conviennent le mieux à vos projets :

| Outil | Fonctionnalité principale | Cadres pris en charge | Options de déploiement |

|---|---|---|---|

| Qdrant | Recherche de similarités vectorielles et gestion de bases de données | Python, plusieurs langues | Cloud-native, extensible horizontalement |

| LangChain | Développer des applications avec des modèles linguistiques | Python, JavaScript | API REST, modèles |

| MLFlow | Suivi des expériences, registre des modèles, déploiement | Python, R, Java, API REST | Local, cloud |

| Comète ML | Suivi et optimisation des expériences | Scikit-learn, PyTorch, TensorFlow, HuggingFace | Local, cloud |

| Poids et biais | Suivi des expériences, versionnement des données et des modèles | Fastai, Keras, PyTorch, HuggingFace, Yolov5, Spacy | Local, cloud |

| Préfet | Orchestration et surveillance du flux de travail | Python | Local (Orion UI), Cloud |

| Metaflow | Gestion du flux de travail pour la science des données | Scikit-learn, TensorFlow, Python, R | AWS, GCP, Azure, local |

| Kedro | Orchestration du flux de travail, reproductibilité | Python | Local, distribué |

| Pachyderme | Transformation, versionnement et lignage des données | Toutes les langues | Kubernetes |

| DVC | Versionnement des données et du pipeline | Git, Python | Local, cloud |

| LakeFS | Contrôle de version de type Git pour les lacs de données | Tout service de stockage | Local, cloud |

| Festin | Stockage centralisé des caractéristiques pour les modèles de ML | Python | Local, cloud |

| Formulaire d'information | Magasin virtuel de caractéristiques pour les modèles ML | Python | Local, cloud |

| Vérifications approfondies | Test et validation du modèle ML | Python | Local, cloud |

| TruEra | Qualité du modèle et tests de performance | Python | Local, cloud |

| Kubeflow | Déploiement et orchestration de modèles ML | TensorFlow, PyTorch, PaddlePaddle, MXNet, XGboost | Kubernetes, cloud |

| BentoML | Déploiement de modèles et gestion des API | Keras, ONNX, LightGBM, PyTorch, Scikit-learn | Local, cloud |

| Hugging Face | Inférence et déploiement de modèles | Tous les modèles | Cloud |

| De toute évidence | Contrôle de la dérive des données et des cibles des modèles ML | Python | Local, cloud |

| Violoniste | Surveillance et débogage du modèle ML | Python | Local, cloud |

| Ray | Mettre à l'échelle les applications d'IA et de Python. | Python | Local, cloud |

| Nuclio | Cadre sans serveur pour les charges de travail à forte intensité de données et de calcul. | Jupyter, Kubeflow | Cloud, sur site |

| AWS SageMaker | Gestion de bout en bout du cycle de vie des ML | Python, R, Java, TensorFlow, PyTorch | Cloud AWS |

| DagsHub | Version et collaboration pour les projets de ML | Git, DVC, MLflow | Local, cloud |

| Iguazio | Automatisation de bout en bout des pipelines de ML | Python, MLRun | Cloud, hybride, sur site |

Conclusion

Nous sommes à une époque où le secteur des MLOps est en plein essor. Chaque semaine, vous voyez de nouveaux développements, de nouvelles startups et de nouveaux outils lancés pour résoudre le problème fondamental de la conversion des ordinateurs portables en applications prêtes à la production. Même les outils existants élargissent leur horizon et intègrent de nouvelles fonctionnalités pour devenir de super outils MLOps.

Dans ce blog, nous avons découvert les meilleurs outils MLOps pour les différentes étapes du processus MLOps. Ces outils vous aideront pendant les phases d'expérimentation, de développement, de déploiement et de contrôle.

Si vous débutez dans l'apprentissage automatique et que vous souhaitez maîtriser les compétences essentielles pour décrocher un emploi de scientifique en apprentissage automatique, essayez de suivre notre cursus de carrière Scientifique en apprentissage automatique avec Python.

Si vous êtes un professionnel et que vous souhaitez en savoir plus sur les pratiques standard de MLOps, lisez notre article sur les meilleures pratiques de MLOps et la manière de les appliquer et consultez notre cursus de compétences MLOps Fundamentals .

Obtenez une certification de haut niveau en matière d'IA

FAQ sur les outils MLOps

Que sont les outils MLOps ?

Les outils MLOps permettent de normaliser, de simplifier et de rationaliser l'écosystème ML. Ces outils sont utilisés pour le cursus des expériences, la gestion des métadonnées des modèles, l'orchestration, l'optimisation des modèles, le versionnage des flux de travail, le déploiement et le service des modèles, et la surveillance des modèles en production.

Quelles sont les compétences requises pour un ingénieur MLOps ?

- Capacité à mettre en œuvre des solutions cloud.

- Expérience avec Docker et Kubernetes.

- Expérience de l'assurance qualité à l'aide du cursus d'expérimentation et du versionnage du flux de travail.

- Capacité à construire des pipelines MLOps.

- Familiarité avec le système d'exploitation Linux.

- Expérience avec des frameworks de ML tels que PyTorch, Tensorflow, et TFX.

- Expérience en matière de DevOps et de développement de logiciels.

- Expérience des tests unitaires et d'intégration, de la validation des données et des modèles, et du suivi post-déploiement.

Quel est le meilleur cloud pour les MLOps ?

AWS, GCP et Azure fournissent une variété d'outils pour le cycle de vie de l'apprentissage automatique. Ils fournissent tous des solutions de bout en bout pour les MLOps. AWS prend la tête en termes de popularité et de part de marché. Il fournit également des solutions simples pour la formation, le service et le suivi des modèles.

MLOps est-il facile à apprendre ?

Cela dépend de votre expérience antérieure. Pour maîtriser les MLOps, vous devez apprendre à la fois l'apprentissage automatique et les cycles de vie du développement logiciel. Outre une bonne maîtrise des langages de programmation, vous devez apprendre plusieurs outils MLOps. Il est facile pour les ingénieurs DevOps d'apprendre le MLOps car la plupart des outils et des stratégies sont axés sur le développement de logiciels.

Kubeflow est-il meilleur que MLflow ?

Cela dépend du cas d'utilisation. Kubeflow offre une reproductibilité à un niveau plus important que MLflow, car il gère l'orchestration.

- Kubeflow est généralement utilisé pour déployer et gérer des systèmes ML complexes à grande échelle.

- MLFlow est généralement utilisé pour le cursus des expériences de ML ainsi que pour le stockage et la gestion des métadonnées des modèles.

Quelle est la différence entre MLOps et DevOps ?

Il s'agit dans les deux cas de stratégies de développement de logiciels. DevOps se concentre sur le développement et la gestion de systèmes logiciels à grande échelle, tandis que MLOps se concentre sur le déploiement et la maintenance de modèles d'apprentissage automatique en production.

- DevOps : Intégration continue (CI) et livraison continue (CD).

- MLOps : Intégration continue, livraison continue, formation continue et surveillance continue.

Comment les outils MLOps s'intègrent-ils aux flux de travail existants en matière de science des données ?

Les outils MLOps sont conçus pour s'intégrer de manière transparente aux flux de travail existants dans le domaine de la science des données. Ils prennent généralement en charge divers outils et plateformes de science des données, fournissent des API pour l'intégration et proposent des plugins ou des extensions pour les environnements de science des données les plus courants. Cette intégration permet aux scientifiques des données de conserver leurs flux de travail actuels tout en tirant parti des avantages de MLOps pour améliorer l'évolutivité, la reproductibilité et l'efficacité du déploiement.

Les outils MLOps peuvent-ils contribuer à l'explicabilité et à l'équité des modèles ?

Oui, de nombreux outils MLOps comprennent des fonctions permettant d'améliorer l'explicabilité et l'équité des modèles. Ils offrent des fonctionnalités telles que l'interprétation des modèles, la détection des biais et les mesures d'équité, qui permettent de comprendre et d'améliorer la manière dont les modèles prennent des décisions. C'est essentiel pour déployer une IA responsable et maintenir la conformité avec les normes réglementaires.

Puis-je passer une certification MLOps ?

Les certifications spécifiques aux MLOps sont encore émergentes, mais il existe plusieurs certifications axées sur l'apprentissage automatique et la science des données qui couvrent les compétences MLOps. Lisez notre guide des certifications MLOps pour en savoir plus.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.