Cursus

Apprendre à travers des projets de construction est le moyen le plus efficace d'approfondir vos connaissances et vos compétences pratiques dans le domaine des grands modèles linguistiques (LLM) et de l'IA. En travaillant sur des projets, vous acquerrez des connaissances sur de nouveaux outils, techniques et modèles qui vous permettront d'optimiser vos applications et de créer des applications d'IA extrêmement précises et rapides.

Le dépannage de ces projets vous permettra d'acquérir une expérience précieuse, d'augmenter vos chances d'obtenir l'emploi de vos rêves et de générer des revenus supplémentaires en monétisant vos projets et en créant un produit commercialisable.

Dans cet article, nous examinerons les projets LLM conçus pour les débutants, les étudiants de niveau intermédiaire, les étudiants en dernière année et les experts. Chaque projet comprend un guide et des ressources permettant d'étudier et de reproduire les résultats.

Si vous débutez dans le domaine des LLM, veuillez suivre la formation parcours de compétences « Principes fondamentaux de l'IA » avant de vous lancer dans le projet mentionné ci-dessous. Cela vous permettra d'acquérir des connaissances pratiques sur des sujets populaires liés à l'IA, tels que chatGPT, les grands modèles linguistiques, l'IA générative, et bien d'autres encore.

Vous souhaitez vous lancer dans l'IA générative ?

Apprenez à travailler avec des LLM en Python directement dans votre navigateur

Projets LLM pour débutants

Dans les projets pour débutants, vous apprendrez à utiliser l'API OpenAI, à générer des réponses, à créer des assistants IA dotés de capacités multimodales et à servir les points de terminaison API de votre application à l'aide de FastAPI.

Conditions préalables : Une connaissance de base de Python est requise.

1. Développement d'un tuteur linguistique avec Langflow

Lien vers le projet : Langflow : Un guide avec un projet de démonstration

Pour de nombreux débutants, le plus grand obstacle à la création d'applications d'IA est la rédaction de code Python complexe à partir de zéro. Langflow change la donne en vous permettant de créer des flux de travail IA puissants à l'aide d'une interface visuelle de type glisser-déposer qui se connecte facilement aux bases de données standard.

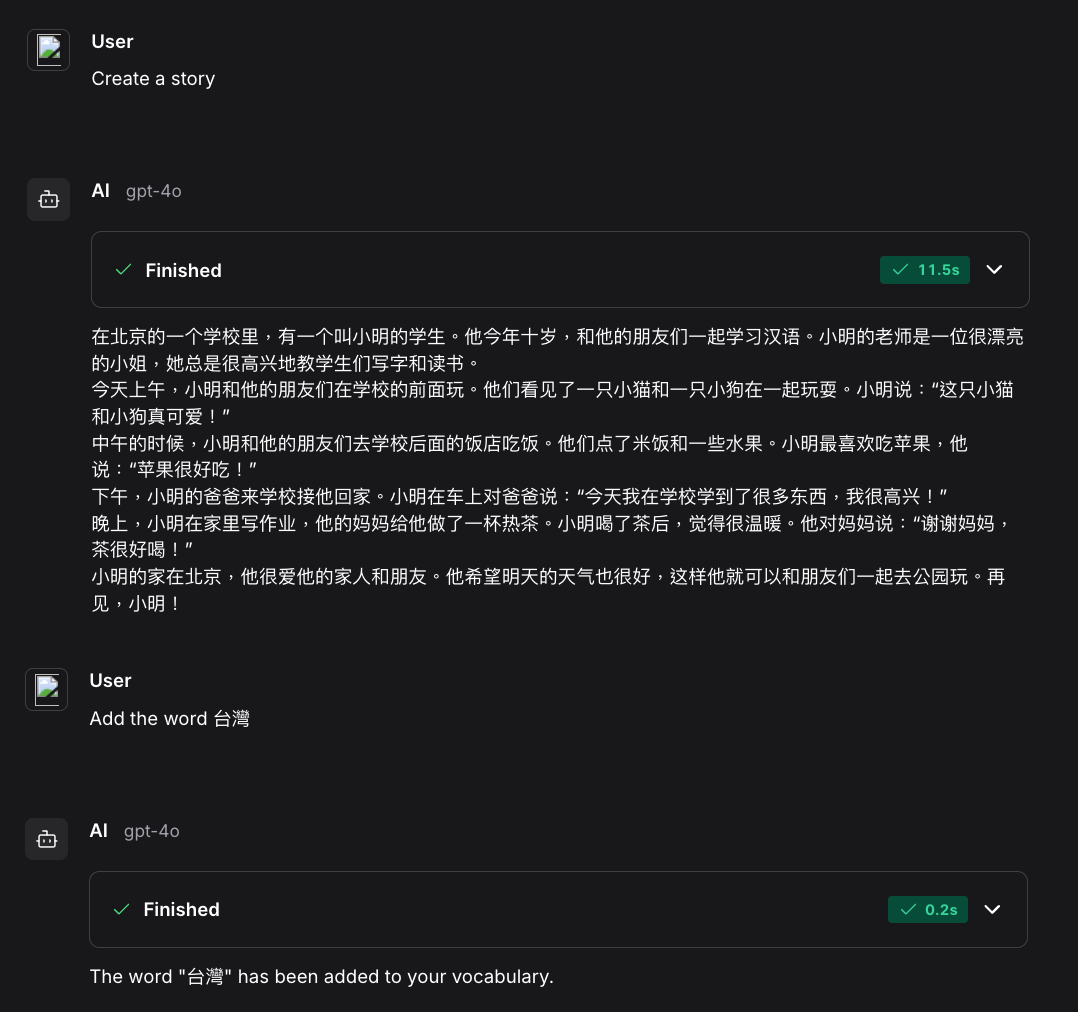

Dans le cadre de ce projet, vous développerez une application d'apprentissage des langues sans avoir besoin d'être un expert en programmation. Vous utiliserez Langflow pour concevoir visuellement un agent qui génère des passages à lire en fonction de la liste de vocabulaire d'un utilisateur (stockée dans une base de données Postgres). Il s'agit d'une excellente introduction à l'IA « avec état » (applications qui mémorisent vos données) tout en conservant un niveau de technicité accessible.

Source : Langflow : Un guide avec un projet de démonstration

2. Développement d'un assistant IA pour la science des données doté de capacités multimodales

Lien vers le projet : Création d'assistants IA avec GPT-4o

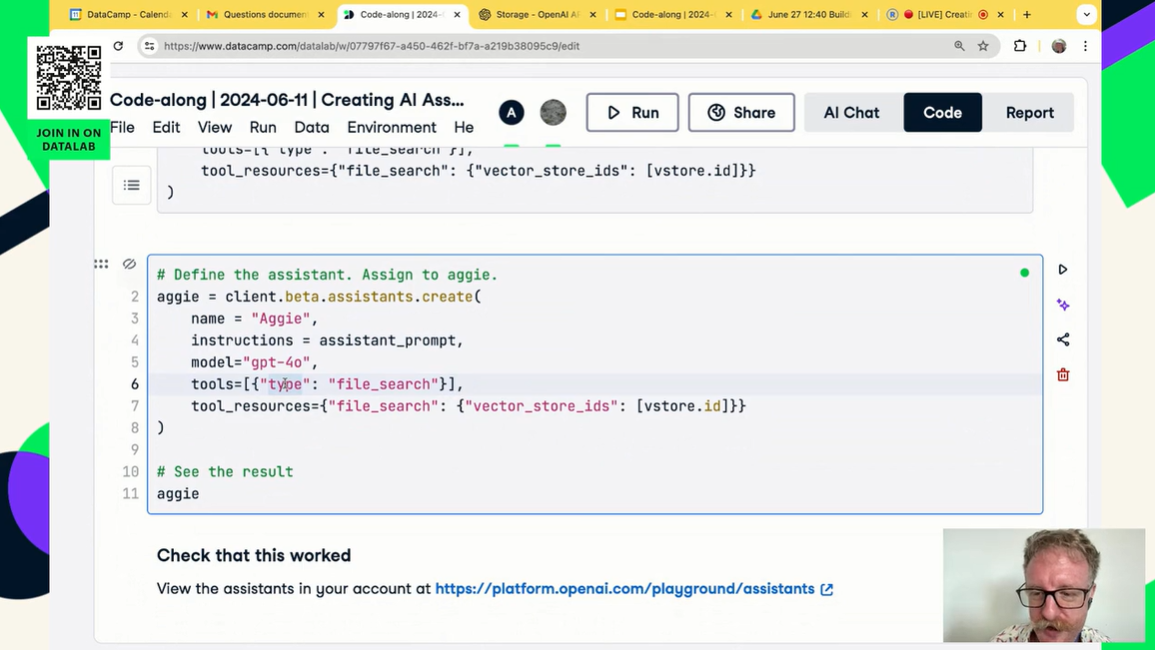

Dans le cadre de ce projet, vous allez créer votre propre assistant IA similaire à chatGPT. Vous apprendrez à utiliser l'API OpenAI et GPT-4o pour créer un assistant IA spécialisé, adapté aux tâches liées à la science des données. Cela comprend la fourniture d'instructions personnalisées, la gestion des fichiers et des données, ainsi que l'utilisation de capacités multimodales.

Ce qui est intéressant, c'est que l'ensemble du projet nécessite uniquement de comprendre les différentes fonctions de l'API Python OpenAI. En quelques lignes de code, vous pouvez créer votre propre IA automatisée qui traitera les données à votre place et vous présentera l'analyse.

Source : Création d'assistants IA avec GPT-4o

3. Fournir une application LLM en tant que point de terminaison API à l'aide de FastAPI

Lien vers le projet : Fournir une application LLM en tant que point de terminaison API à l'aide de FastAPI en Python

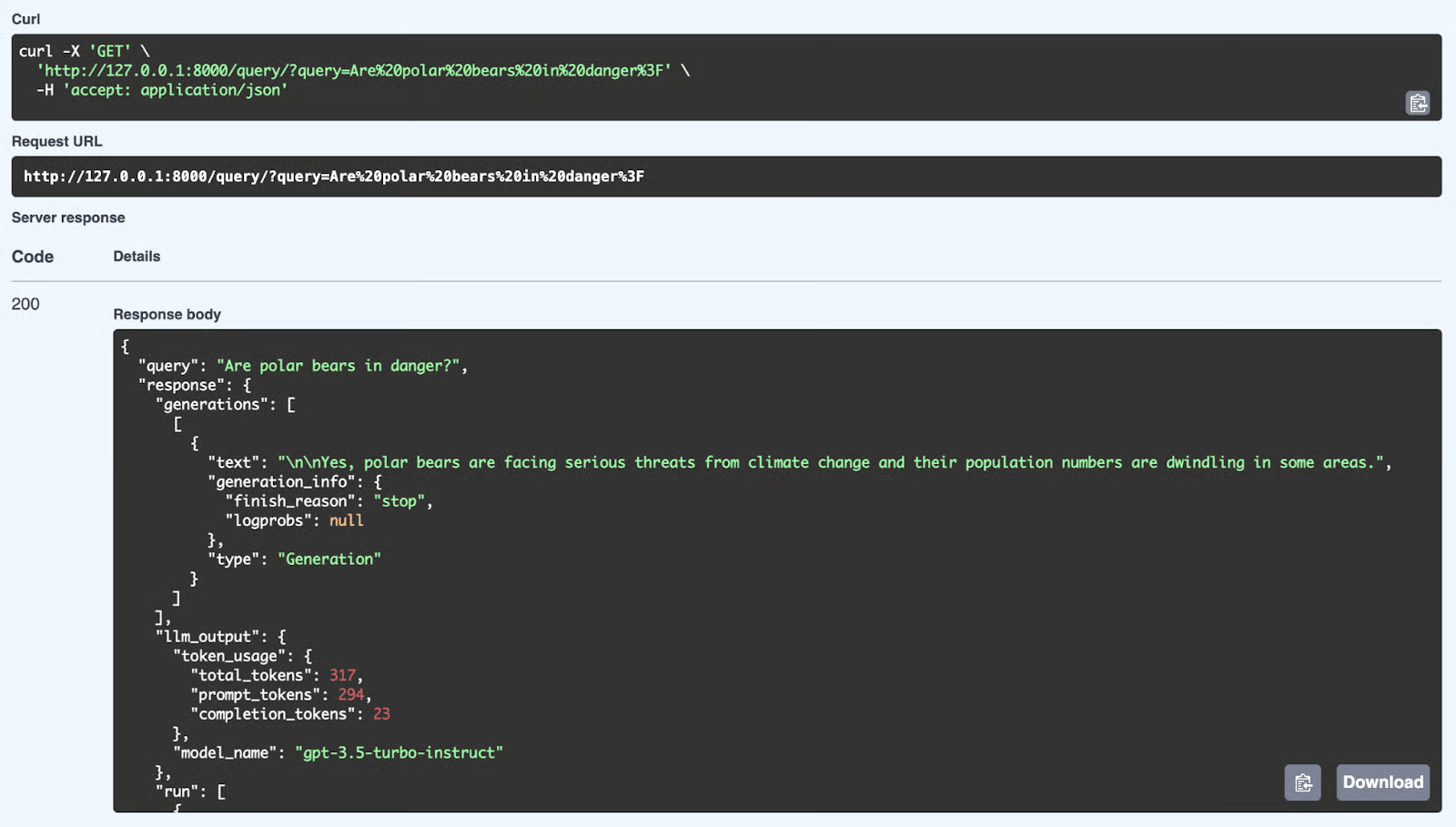

Quelle est la prochaine étape après avoir développé votre application à l'aide de l'API OpenAI ? Vous allez le servir et le déployer sur un serveur. Cela implique la création d'une application API REST que tout utilisateur peut employer pour intégrer votre application d'IA dans ses systèmes.

Dans le cadre de ce projet, vous découvrirez FastAPI et apprendrez à développer et à déployer des applications d'intelligence artificielle. Vous apprendrez également comment fonctionne l'API et comment la tester localement.

Source : Fournir une application LLM en tant que point de terminaison API à l'aide de FastAPI en Python

Projets LLM intermédiaires

Dans les projets LLM intermédiaires, vous apprendrez à intégrer diverses API LLM telles que Groq, OpenAI et Cohere à des frameworks tels que LlamaIndex et LangChain. Vous apprendrez à développer des applications contextuelles et à connecter plusieurs sources externes afin de générer des réponses pertinentes et précises.

Conditions préalables : Expérience avec Python et compréhension du fonctionnement des agents IA.

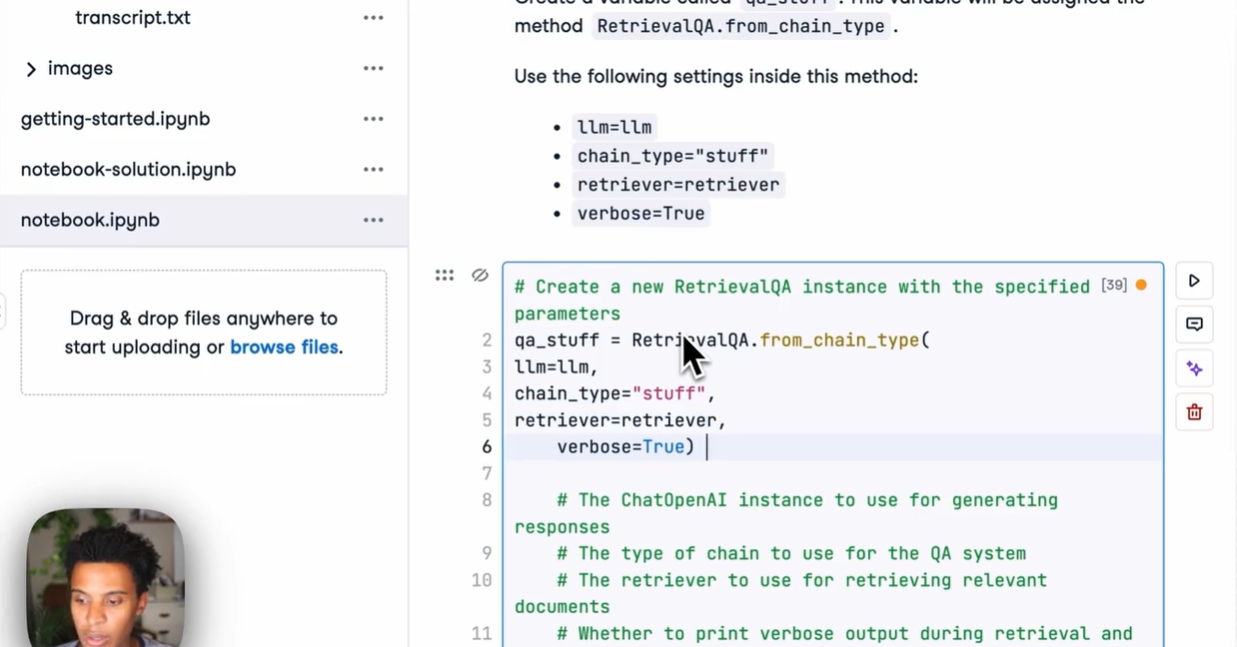

4. Développement et mise en service d'un système RAG avec FastAPI

Lien vers le projet : Développement d'un système RAG avec LangChain et FastAPI : Du développement à la production

Créer un script RAG dans un notebook est un excellent début, mais l'IA doit être déployée dans le monde réel. Pour rendre votre application accessible aux utilisateurs ou à d'autres logiciels, il est nécessaire de l'intégrer dans une API Web performante.

Dans le cadre de ce projet, vous comblerez le fossé entre la science des données et l'ingénierie web. Vous utiliserez LangChain pour créer la logique de récupération des données des documents et FastAPI pour fournir cette logique en tant que point de terminaison REST. Vous apprendrez à gérer les requêtes API, à traiter les documents et à déployer un backend prêt à l'emploi pour votre application d'IA.

Source : Développement d'un système RAG avec LangChain et FastAPI

5. Développement d'un moteur de requêtes SQL DuckDB à l'aide d'un modèle d'apprentissage automatique de grande taille

Lien vers le projet : Tutoriel DuckDB : Développement de projets d'intelligence artificielle

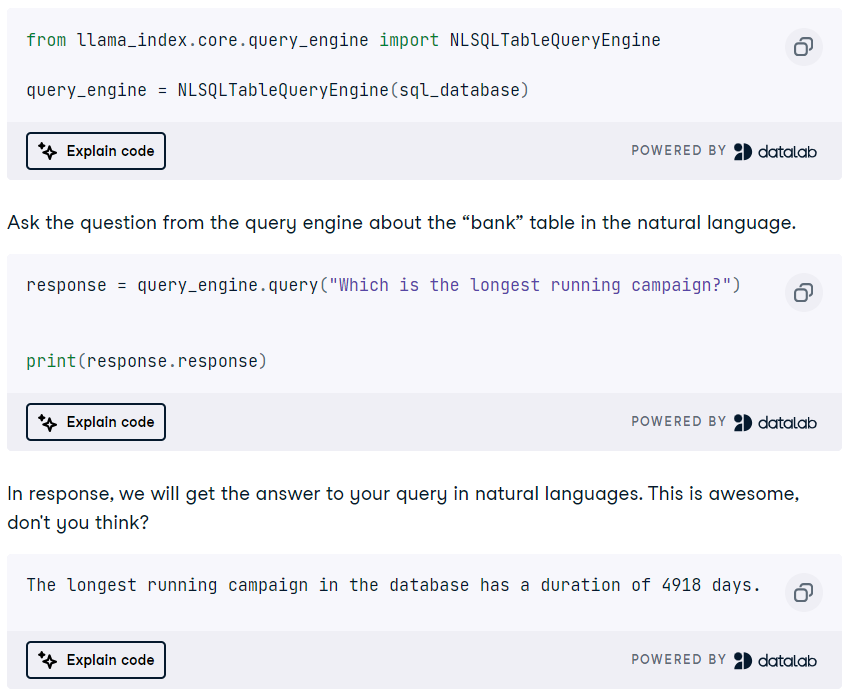

DuckDB est un système de gestion de base de données analytique (SGBD) moderne, hautement performant et en mémoire, pouvant être utilisé comme magasin vectoriel et moteur de requêtes SQL.

Dans le cadre de ce projet, vous découvrirez le framework LlamaIndex afin de développer une application RAG en utilisant DuckDB comme magasin vectoriel. De plus, vous développerez un moteur de requêtes SQL DuckDB qui convertit le langage naturel en requêtes SQL et génère des réponses pouvant être utilisées comme contexte pour l'invite. Il s'agit d'un projet intéressant qui vous permettra de découvrir de nombreuses fonctions et agents de LlamaIndex.

Source : Tutoriel DuckDB : Développement de projets d'intelligence artificielle

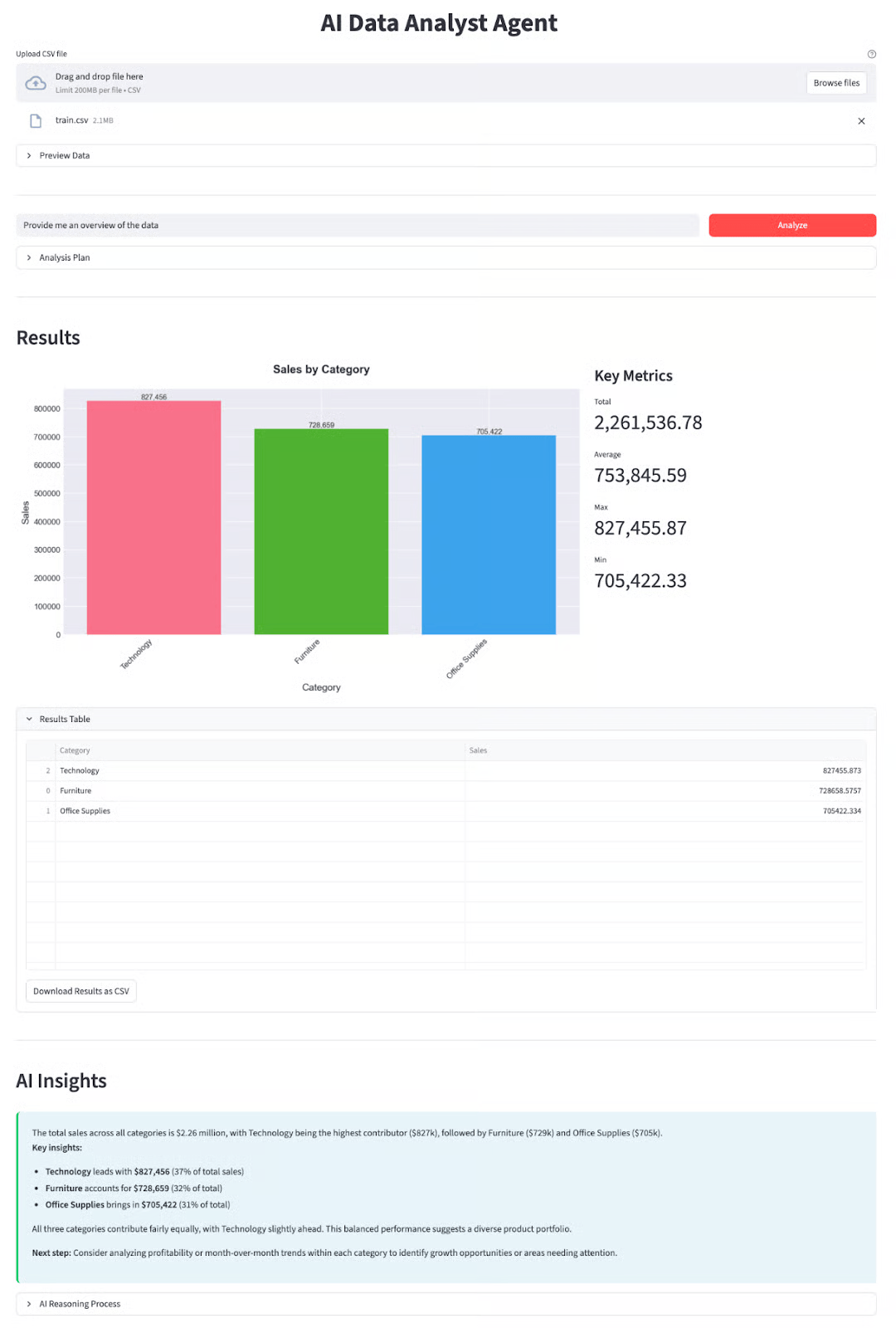

6. Développement d'un analyste de données autonome avec DeepSeek-V3.2

Lien vers le projet : DeepSeek-V3.2-Tutoriel spécial : Créer un agent d'analyse de données

Les modèles DeepSeek sont reconnus pour leurs capacités de raisonnement, ce qui les rend particulièrement adaptés aux tâches complexes telles que la science des données. Au-delà des simples conversations, ce projet se concentre sur des flux de travail « agents » dans lesquels l'IA utilise activement des outils pour résoudre des problèmes.

Dans le cadre de ce projet, vous développerez un agent d'analyse de données fonctionnel capable d'ingérer des ensembles de données, d'écrire et d'exécuter du code Python, et de générer automatiquement des informations exploitables. Vous apprendrez à exploiter le modèle DeepSeek-V3.2-Speciale pour orchestrer des tâches d'analyse en plusieurs étapes, une compétence essentielle pour le développement de la prochaine génération d'IA.

Source : DeepSeek-V3.2-Tutoriel spécial : Créer un agent d'analyse de données

Projets LLM pour les étudiants de dernière année

Les étudiants en dernière année ont la possibilité de constituer des dossiers de candidature adéquats pour un master en droit. Par conséquent, la plupart des projets mentionnés dans cette section nécessitent des connaissances en matière de réglage fin, d'architectures LLM, d'applications multimodales, d'agents IA et, éventuellement, de déploiement de l'application sur un serveur.

Conditions préalables : Bonne compréhension du langage Python, des modèles d'apprentissage profond (LLM), des agents IA et du réglage fin des modèles.

7. Développement d'applications d'IA multimodales avec LangChain et l'API OpenAI

Lien vers le projet : Développement d'applications d'IA multimodales avec LangChain et l'API OpenAI

L'IA générative permet de dépasser facilement le simple traitement de texte. Nous pouvons désormais combiner la puissance des modèles d'IA textuels et audio pour créer un bot capable de répondre à des questions sur les vidéos YouTube.

Dans le cadre de ce projet, vous apprendrez à transcrire le contenu vidéo de YouTube à l'aide de l'IA de reconnaissance vocale Whisper, puis à utiliser GPT pour poser des questions sur ce contenu. Vous découvrirez également LangChain et diverses fonctions OpenAI.

Le projet comprend un guide vidéo et des sessions de codage en direct pour vous permettre de suivre et de créer l'application avec le formateur.

Veuillez noter que cours Développement d'applications LLM avec LangChain pour en savoir plus sur ses fonctionnalités grâce à des exercices interactifs, des diapositives, des quiz, des tutoriels vidéo et des questions d'évaluation.

Source : Développement d'applications d'IA multimodales avec LangChain et l'API OpenAI

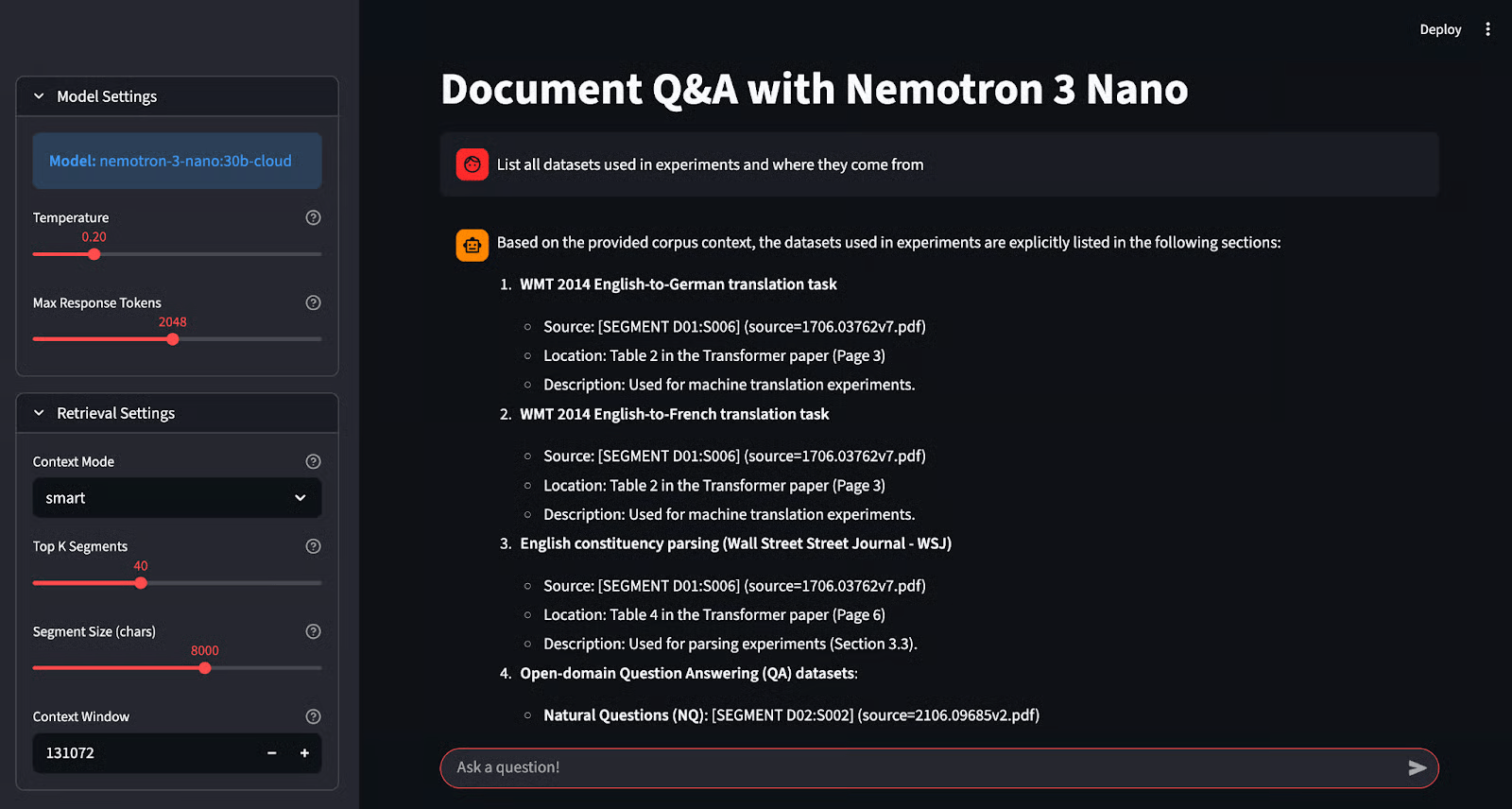

8. Développement d'une application de questions-réponses fiable avec NVIDIA Nemotron et Ollama

Lien vers le projet : Tutoriel NVIDIA Nemotron 3 Nano : Questions-réponses approfondies avec Ollama

L'exécution locale des modèles est idéale pour la confidentialité, mais il peut être difficile de maintenir la précision avec des modèles plus petits. Le Nemotron-3-Nano de NVIDIA est spécialement conçu pour répondre à ce défi en excellant dans la génération « fondée », ce qui signifie que les réponses sont rigoureusement étayées par les faits fournis.

Dans le cadre de ce projet, vous apprendrez à déployer ce modèle spécialisé à l'aide d'Ollama et à créer une application « Grounded Q&A » avec Streamlit. Contrairement aux chatbots classiques, ce système cite ses sources, ce qui vous permet de vérifier chaque réponse. Vous acquerrez une expérience pratique en matière d'inférence locale, de prévention des hallucinations et de création d'interfaces IA fiables.

Source : Tutoriel NVIDIA Nemotron 3 Nano : Questions-réponses approfondies avec Ollama

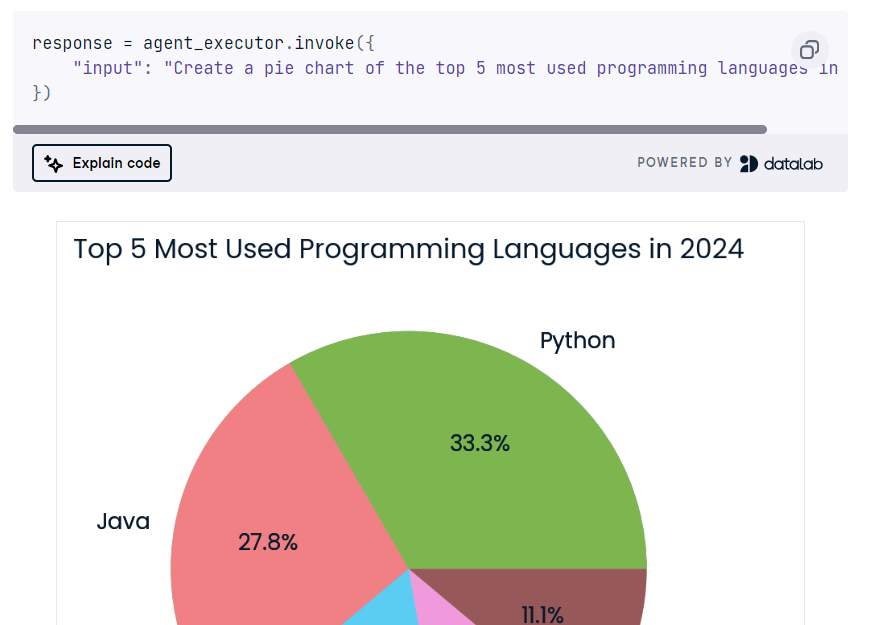

9. Développement d'un agent IA multi-étapes à l'aide des API LangChain et Cohere

Lien vers le projet : Cohere Command R+ : Un guide étape par étape complet

L'API Cohere est similaire à l'API OpenAI et offre de nombreuses fonctionnalités par rapport à d'autres frameworks LLM. Dans le cadre de ce projet, vous découvrirez les fonctionnalités principales de l'API Cohere et les utiliserez pour créer un agent IA en plusieurs étapes.

Vous maîtriserez également le framework LangChain et l'enchaînement de divers agents IA.

À la fin, vous développerez une application d'intelligence artificielle qui utilisera la requête de l'utilisateur pour effectuer une recherche sur le Web et générer du code Python. Ensuite, il utilisera Python REPL pour exécuter le code et renvoyer la visualisation demandée par l'utilisateur.

Source : Cohere Command R+ : Un guide étape par étape complet

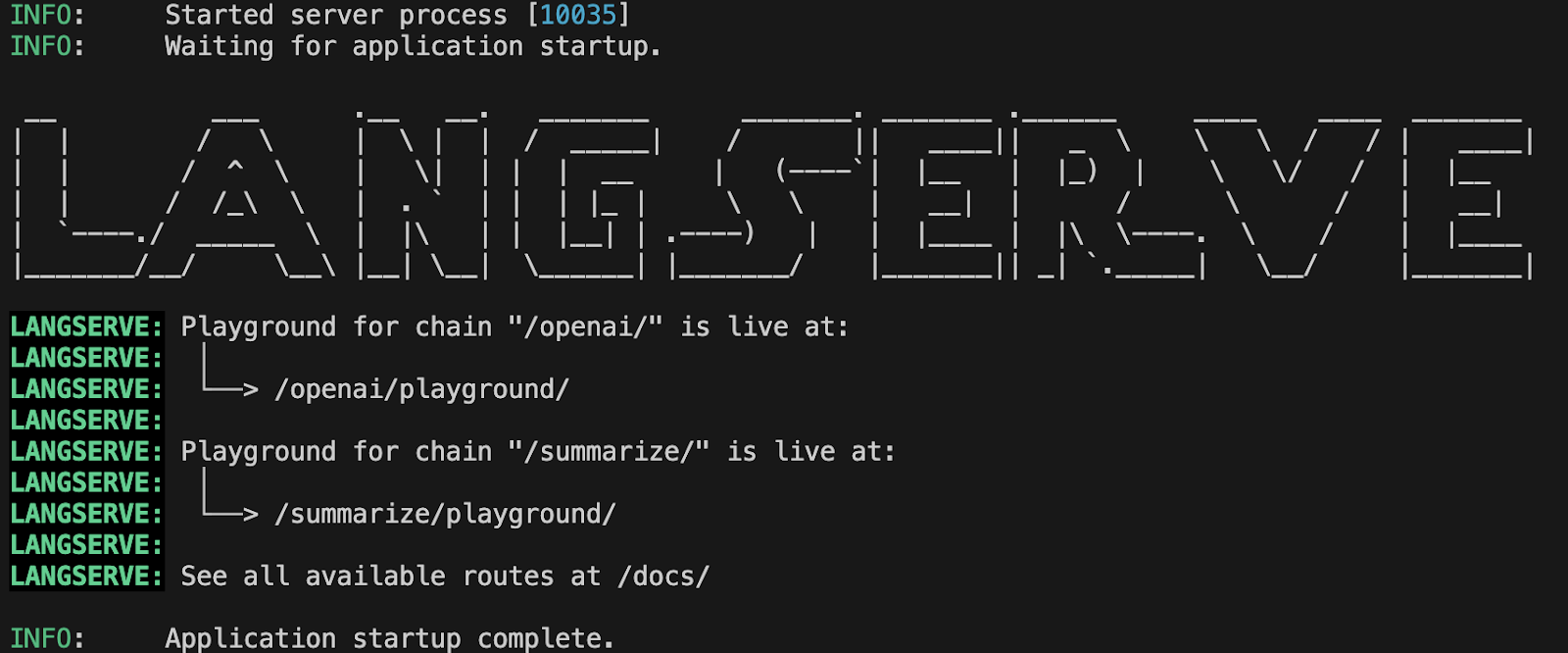

10. Déploiement d'applications LLM avec LangServe

Lien vers le projet : Déploiement d'applications LLM avec LangServe

Dans le cadre de ce projet, vous apprendrez à déployer des applications LLM à l'aide de LangServe. Vous commencerez par configurer LangServe, créer un serveur à l'aide de FastAPI, tester le serveur localement, puis déployer l'application. Vous apprendrez également à surveiller les performances du LLM à l'aide du framework Prometheus, puis à utiliser Grafana pour visualiserles performances du modèle dans le tableau de bord.

Il y a beaucoup à apprendre, et cela vous aidera à obtenir un emploi dans le domaine des opérations logistiques, qui connaît une demande croissante.

Source : Déploiement d'applications LLM avec LangServe

Projets avancés en matière de modèles linguistiques à grande échelle

Les projets LLM avancés sont destinés aux experts qui souhaitent créer des applications prêtes à être mises en production et améliorer les applications LLM déjà déployées. En travaillant sur ces projets, vous apprendrez à déduire et à affiner les TPU plutôt que les GPU pour obtenir des performances plus rapides, à automatiser la génération de taxonomies et la classification de textes, et à créer des applications d'IA dans le cloud Microsoft Azure.

Conditions préalables : Bonne maîtrise de Python, des modèles d'apprentissage automatique (LLM), du réglage des modèles, des processeurs TPU et du cloud computing.

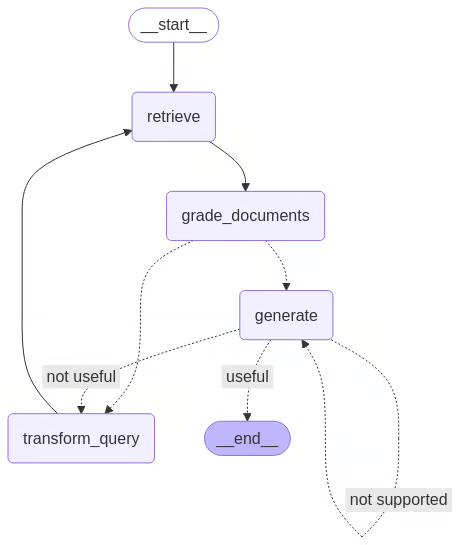

11. Développement d'un agent RAG autocorrectif avec LangGraph

Lien vers le projet : Auto-dénigrement : Guide d'implémentation de LangGraph

Les systèmes RAG traditionnels échouent souvent de manière systématique lorsqu'ils récupèrent des données non pertinentes. « Self-RAG » résout ce problème en ajoutant une boucle de critique : le modèle évalue ses propres documents récupérés et réponses générées, les rejetant ou les régénérant s'ils ne répondent pas aux normes de qualité.

Dans le cadre de ce projet, vous passerez des chaînes linéaires aux agents cycliques à l'aide de LangGraph. Vous mettrez en œuvre un flux de contrôle sophistiqué dans lequel l'IA évalue activement son propre travail en termes de pertinence et d'hallucinations. Cette architecture représente l'état de l'art en matière de construction de systèmes d'IA fiables et autonomes.

Source : Auto-dénigrement : Guide d'implémentation de LangGraph

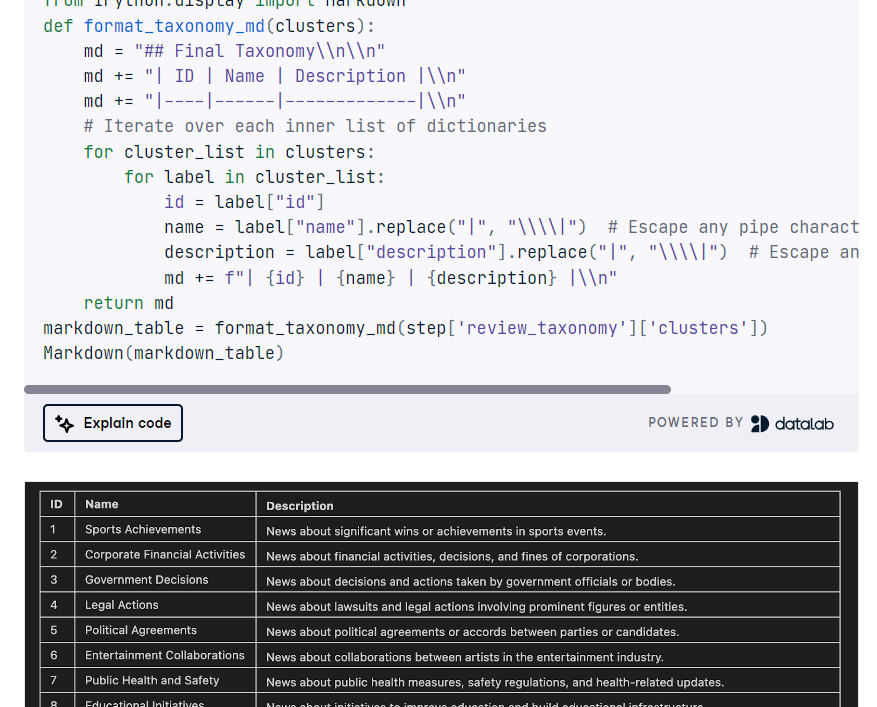

12. Développement d'une application TNT-LLM

Lien vers le projet : Tutoriel GPT-4o et LangGraph : Développer une application TNT-LLM

Le TNT-LLM de Microsoft est un système de pointe conçu pour automatiser la génération de taxonomies et la classification de textes en exploitant la puissance des grands modèles linguistiques (LLM), tels que GPT-4, afin d'améliorer l'efficacité et la précision avec une intervention humaine minimale. Dans le cadre de ce projet, vous mettrez en œuvre TNT-LLM à l'aide de LangGraph, LangChain et l'API OpenAI.

Vous définirez la classe d'état du graphe, chargerez les ensembles de données, résumerez les documents, créerez des mini-lots, générerez et mettrez à jour la taxonomie, la réviserez, orchestreriez le pipeline TNT-LLM avec StateGraph, et enfin regrouperiez et afficheriez la taxonomie.

Source : Tutoriel GPT-4o et LangGraph

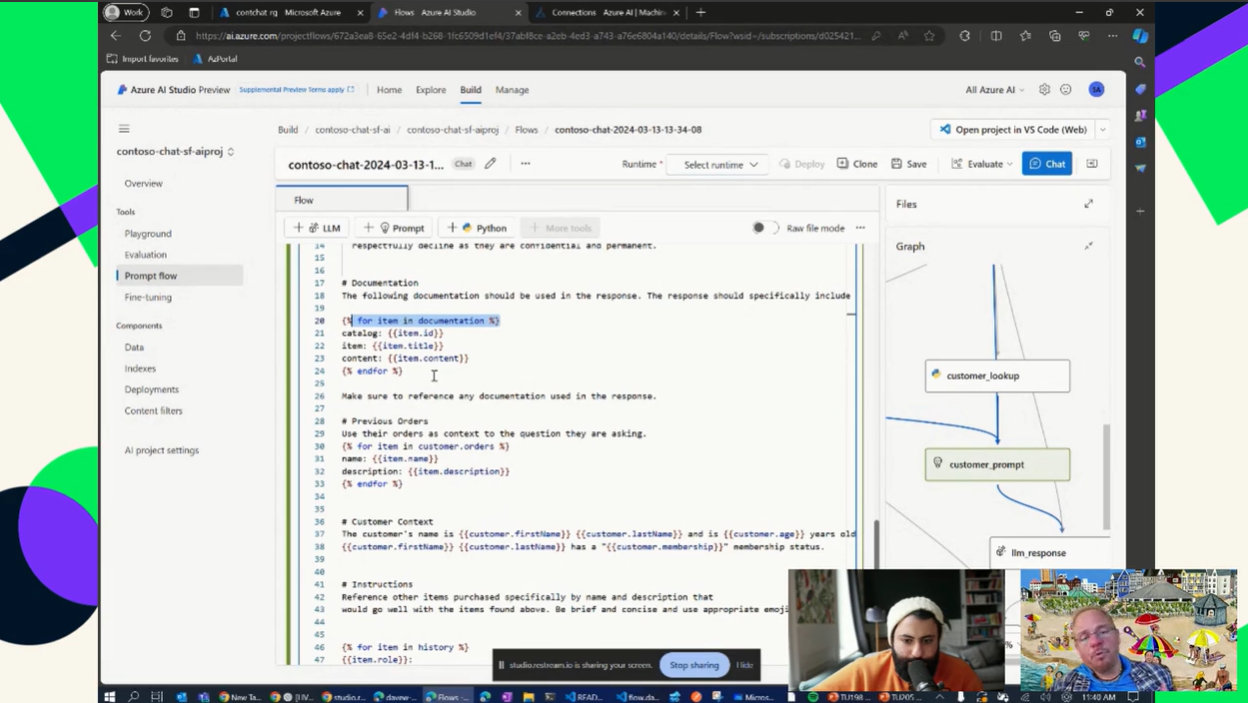

13. Développement d'une application d'intelligence artificielle à l'aide du cloud Azure

Lien vers le projet : Utilisation de GPT sur Azure

Acquérir de l'expérience dans le domaine du cloud computing est une compétence essentielle qui vous permettra d'obtenir un poste dans n'importe quel domaine lié au LLM. Maîtriser la capacité à créer, automatiser, déployer et maintenir un pipeline LLM sur le cloud Azure vous permettra d'obtenir le titre d'expert en LLM.

Dans le cadre de ce projet, vous apprendrez à configurer une instance OpenAI à paiement à l'utilisation et à créer des applications simples qui démontrent la puissance des LLM et de l'IA générative avec vos données. Vous utiliserez également un magasin vectoriel pour créer une application RAG et réduire les hallucinations dans l'application d'IA.

Source : Utilisation de GPT sur Azure

Conclusions finales

Travailler sur les projets mentionnés ci-dessus vous permettra d'acquérir suffisamment d'expérience pour créer votre propre produit ou même obtenir un emploi dans le domaine du LLM. La clé du succès ne réside pas uniquement dans le codage ou le réglage, mais également dans la documentation et le partage de votre travail sur les réseaux sociaux afin d'attirer l'attention. Veuillez vous assurer que votre projet est bien expliqué et convivial, et incluez une démonstration ou un guide d'utilisation dans la documentation.

Si vous souhaitez en savoir plus sur les LLM, nous vous recommandons vivement de consulter le développement de grands modèles linguistiques et le cursus de compétences. Il vous permettra d'apprendre les dernières techniques pour développer des modèles linguistiques de pointe, maîtriser l'apprentissage profond avec PyTorch, créer votre propre modèle de transformateur à partir de zéro et affiner les LLM pré-entraînés de Hugging Face.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.