Cours

Il est possible que de nombreuses charges de travail d'entreprise n'aient pas besoin de modèles à l'échelle de pointe, mais qu'elles aient plutôt besoin d'une inférence rapide et rentable sur des tâches spécifiques. Je réfléchis à l'acheminement du service client, à la classification des documents et à la complétion de code.

C'est sur cette approche que Mistral AI mise : des modèles compacts et à poids ouvert, qui peuvent être affinés à partir de données de domaine et qui peuvent fonctionner efficacement à grande échelle.

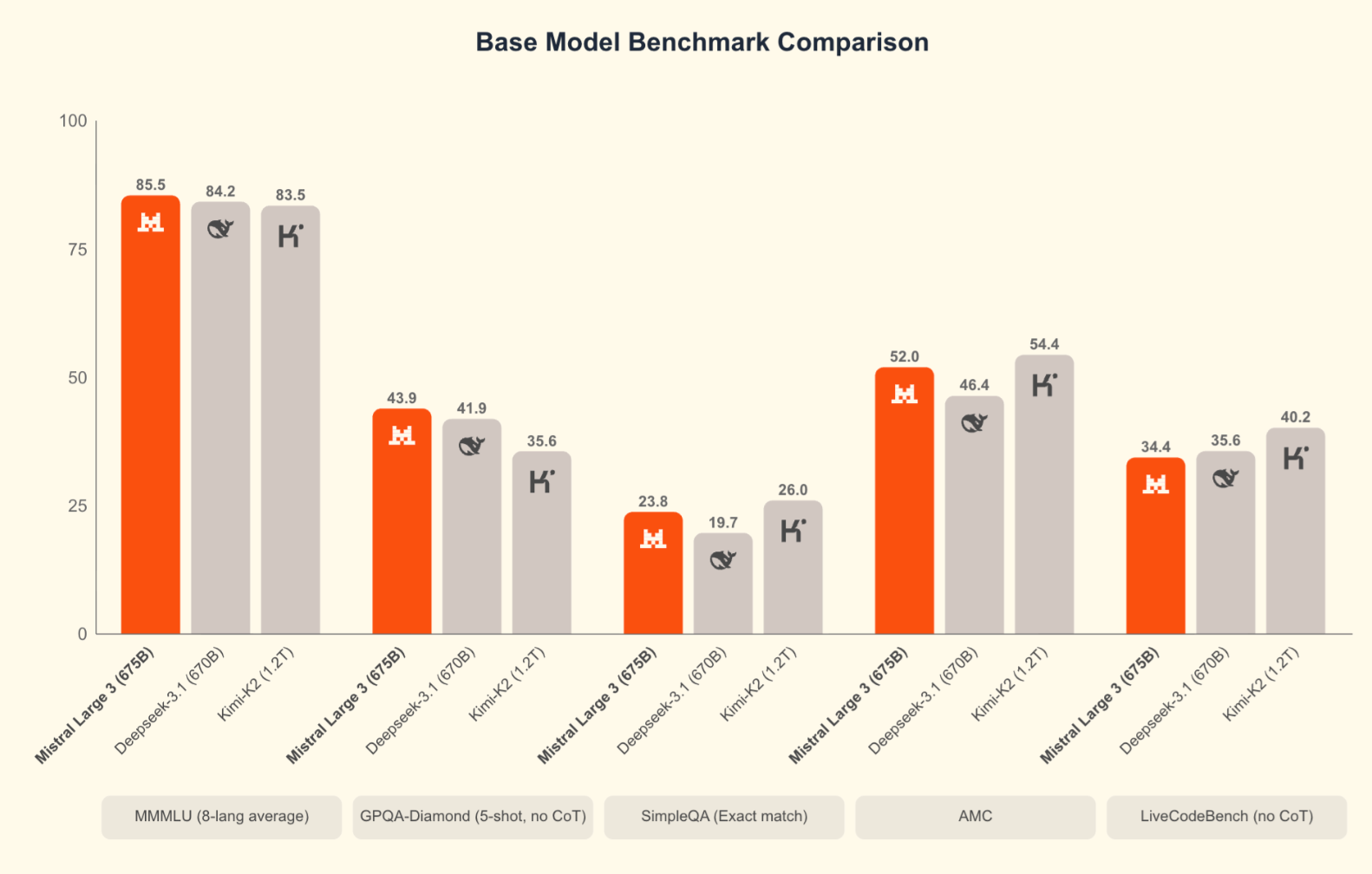

À cette fin, Mistral a lancé cette semaine Mistral 3, et je pense que cela contribue grandement à la réalisation de cet objectif. Tout d'abord, les modèles eux-mêmes sont prometteurs : Mistral Large 3, le produit phare, surpasse ses concurrents open source Kimi-K2 et Deepseek-3.1 lors de tests de performance importants. Deuxièmement, Mistral clarifie son offre de produits. Il convient de noter que c'est la première fois que Mistral AI publie une gamme complète de modèles. (Lorsque Medium 3 est sorti plus tôt cette année, il n'était pas immédiatement évident (d'après son nom seul) qu'il était censé surpasser Large 2, qui était sorti l'année dernière.)

Qu'est-ce que Mistral 3 ?

Mistral 3 est la dernière génération de modèles développés par Mistral AI, construits sur une architecture et un ensemble de fonctionnalités communes. , construits sur une architecture et un ensemble de fonctionnalités communs. Au lieu de commercialiser des variantes ponctuelles, Mistral a opté pour une gamme unifiée où chaque modèle prend en charge les invites multilingues, les entrées multimodales et les mêmes fonctionnalités de base. L'objectif est de fournir aux développeurs une base cohérente, quelle que soit la taille qu'ils choisissent.

Cette génération met également l'accent sur l'amélioration du raisonnement, de l'efficacité et de la facilité d'utilisation pratique à tous les niveaux. Que vous effectuiez des tests dans le cloud ou développiez des applications nécessitant une inférence plus rapide, Mistral 3 offre une base plus claire et plus prévisible sur laquelle vous appuyer.

Un aperçu de la famille modèle

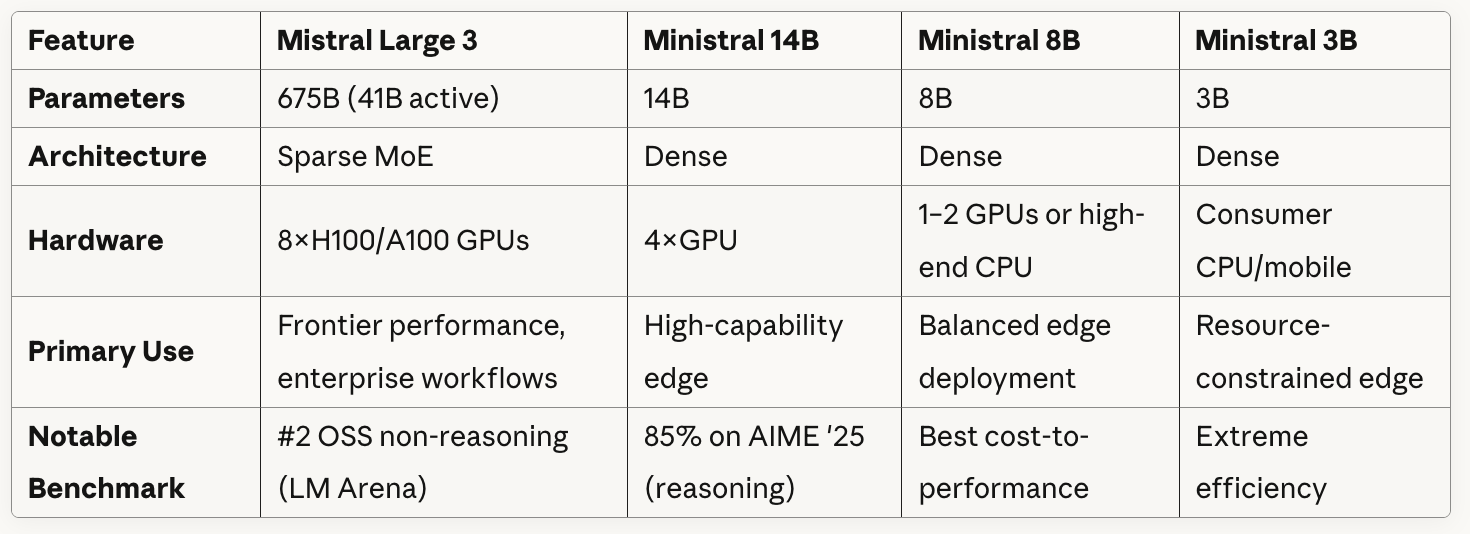

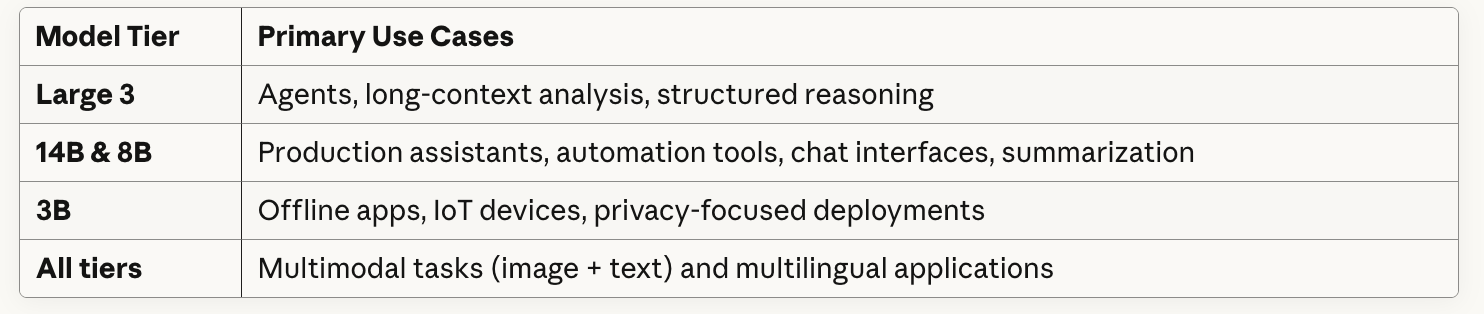

J'ai mentionné que Mistral 3 est en réalité une gamme de modèles. Il y en a quatre au total, et ils ciblent tous des contraintes différentes : profondeur de raisonnement, limites matérielles, latence et environnements de déploiement. Cela dit, un modèle se distingue particulièrement : Le niveau Large 3 est conçu pour une catégorie de charges de travail très différente de celle des niveaux inférieurs, qui sont conçus dans un souci de praticité et de flexibilité de déploiement.

Mistral Large 3

Le Mistral Large 3 est le modèle phare de cette génération. Il utilise une architecture MoE clairsemée avec 675 milliards de paramètres, dont environ 41 milliards sont actifs pendant l'inférence, ce qui implique naturellement des exigences matérielles plus élevées. Le modèle est conçu pour les charges de travail qui reposent sur un raisonnement solide, un traitement contextuel à long terme et une qualité de sortie constante. Il obtient de bons résultats dans les évaluations open source, notamment les meilleurs résultats dans le classement non raisonné de LMArena. L'efficacité du jeton est satisfaisante, bien que le coût de calcul reflète sa taille.

Ministral 14B

Il s'agit du modèle dense le plus performant de la gamme. C'est une option intéressante lorsque vous recherchez de réelles capacités sans entrer dans le domaine des clusters multi-GPU. Il fonctionne de manière optimale sur une seule configuration GPU haut de gamme (quatre GPU si vous souhaitez disposer d'une marge de manœuvre) et obtient d'excellents résultats sur des tâches telles que AIME '25. L'équilibre entre la qualité de la production et l'efficacité des jetons en fait un compromis pratique pour les équipes qui souhaitent bénéficier d'un raisonnement intelligent sans avoir recours à du matériel à l'échelle MoE.

Ministral 8B

Je considère le 8B comme un outil de travail essentiel. Il reste rapide, prévisible et peu coûteux tout en couvrant un large éventail de scénarios de production : systèmes de chat, outils internes, flux d'automatisation et applications RAG. Il n'égale pas le Large 3 ou le 14B en matière de raisonnement approfondi, mais son rapport coût-performance est le plus avantageux de la gamme. L'utilisation des jetons reste faible et les résultats restent cohérents.

Ministral 3B

Il s'agit du modèle le plus compact, conçu pour fonctionner dans presque tous les environnements. Il est compact, léger et performant sur les processeurs, les appareils mobiles ou le matériel IoT. Vous ne l'utiliserez pas lorsque vous aurez besoin d'un raisonnement complexe, mais il est idéal pour les applications hors ligne, les tâches de routage, les classificateurs légers et les assistants qui nécessitent des réponses immédiates. L'efficacité des jetons est remarquable.

Les quatre versions offrent une licence Apache 2.0, la prise en charge multimodale des images et du texte, ainsi qu'une large couverture multilingue. Étant donné que les modèles se comportent de manière cohérente, il est possible de les adapter à la hausse ou à la baisse sans avoir à réapprendre leurs particularités.

Tableau comparatif des modèles

Voici un aperçu comparatif des modèles :

Comme vous pouvez le constater dans le tableau, Mistral Large 3 utilise une architecture Sparse MoE avec 41 milliards de paramètres actifs sur un total de 675 milliards. Fondamentalement, le modèle contient plusieurs réseaux « experts » spécialisés et, pour chaque jeton ou tâche, il achemine de manière sélective uniquement un sous-ensemble de ces experts plutôt que d'utiliser tous les paramètres.

Les modèles Ministral utilisent tous des architectures denses, ce qui signifie que tous les paramètres sont actifs pour chaque inférence.

En examinant attentivement les informations fournies dans le tableau concernant la configuration matérielle requise, vous pouvez observer un compromis évident entre la taille des modèles et la flexibilité de déploiement : Mistral Large 3 nécessite huit processeurs graphiques haut de gamme, tandis que Ministral 3B peut fonctionner sur un processeur grand public/mobile.

Essai du Mistral 3

J'ai concentré mes tests sur Large 3. Étant donné que le Large 3 est le modèle phare, il s'agit à la fois du modèle le plus performant et de celui que la plupart des personnes utiliseront.

Test 1 : Multimodal et multilingue

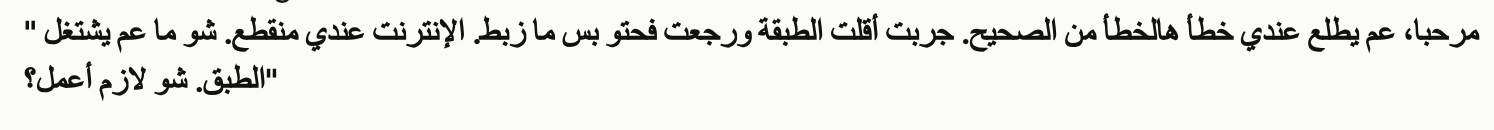

Pour mon premier test, j'ai fourni à Mistral 3 Large une capture d'écran en arabe avec l'invite suivante.

Dans ce scénario, un client décrit un problème avec son antenne parabolique. Ils indiquent qu'ils l'ont réinstallé ou repositionné, mais cela ne fonctionne pas correctement et leur connexion Internet est interrompue.

A customer sent the attached error message screenshot showing an error in Arabic.

Please:

1. Read and translate the error message from the screenshot

2. Write a troubleshooting guide in English for our support team (3-4 steps)

3. Translate that solution back to Levantine Arabic in a natural, conversational way the customer would understandTout d'abord, Large 3 a traduit le message, et j'ai craint que nous ne nous engagions dans une mauvaise direction. Il n'est pas nécessaire d'être de langue maternelle arabe pour comprendre que la version anglaise n'est pas correcte.

Large 3 a poursuivi et m'a fourni des instructions en arabe que je pouvais utiliser comme réponse.

Bien que la traduction de la question par Mistral ait été inexacte, les instructions qu'il m'a fournies et que j'ai pu transmettre au client (ce qui est la partie la plus utile) étaient pertinentes. Les points 1 à 3 se lisent bien en arabe (je le sais car j'ai sollicité une aide à la traduction), mais Mistral a généré une erreur au quatrième point en mentionnant « assistance artistique » au lieu de « assistance technique ».

Pour conclure, j'ai constaté que Mistral était fidèle au dialecte arabe demandé. La conversation était particulièrement levantine.

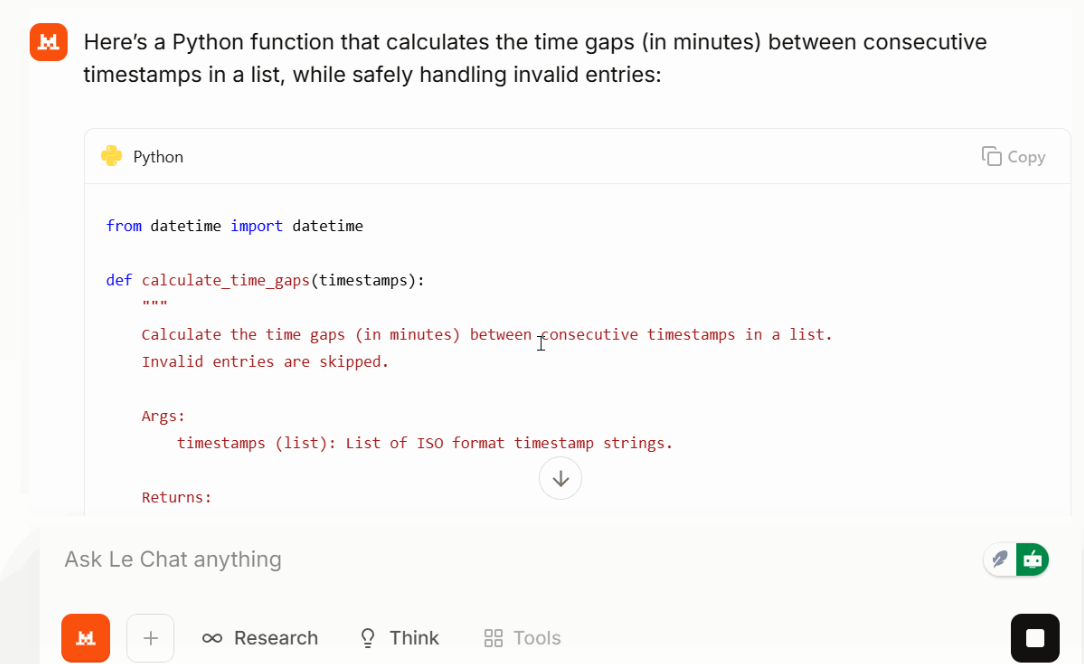

Test 2 : Tâche de codage dans le monde réel

Ensuite, je lui ai demandé de réaliser une tâche de codage simple mais réaliste :

Write a Python function that takes a list of timestops (ISO format) and returns time gaps between each consecutive time gap in minutes. Make the function safe against invalid entries.

Large 3 renvoie une fonction concise et lisible avec une gestion des erreurs appropriée et des entrées triées. Lors de mon essai, la solution était compacte et le résultat est resté précis. Selon l'invite et la tâche, cela pourrait contribuer à maintenir l'utilisation des jetons à un niveau inférieur à celui prévu.

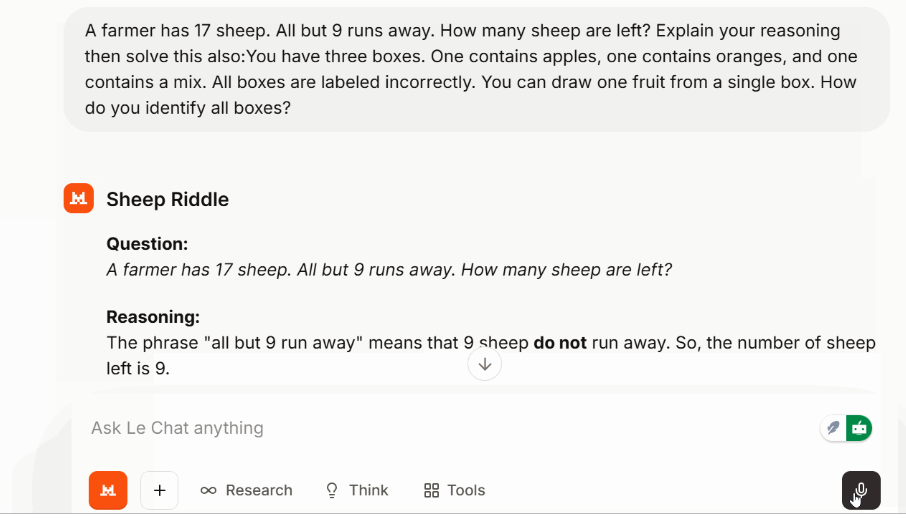

Test 3 : Défi de raisonnement

Pour vérifier le raisonnement en plusieurs étapes sans passer en mode dédié, j'ai utilisé un casse-tête classique :

Un casse-tête logique complémentaire concernant des caisses de fruits mal étiquetées a également été résolu de manière claire et sans détours.

Mistral 3 - Points de référence

Les repères ne sont pas tout, mais ils contribuent à replacer le modèle dans son contexte. Mistral compare principalement Large 3 à ses concurrents open source tels que DeepSeek-3.1 et Kimi-K2, ce qui est logique compte tenu de la licence Apache 2.0.

Large 3 obtient de bons résultats dans les évaluations de raisonnement, GSM8K, AIME et codage. Il s'agit actuellement du modèle de codage open source le mieux classé dans le classement LMArena. Les premiers résultats du SWE-Bench indiquent qu'il résout des tâches d'ingénierie logicielle à un niveau comparable à celui d'autres systèmes denses et MoE à haute capacité. Les modèles Ministral occupent également des positions solides par rapport à leur taille.

Mistral 3 par rapport à Concurrents

Les modèles Frontier lancés fin novembre sont notables par leur absence dans les comparaisons de Mistral : Gemini 3 Pro (qui obtient un score de 91,9 % sur GPQA Diamond et 1501 Elo sur LMArena), GPT-5.1et Claude Opus 4.5 (qui est en tête du classement SWE-bench Verified avec plus de 80 %). Lorsque l'on compare Large 3 à ces modèles, les systèmes propriétaires conservent un avantage dans les tests de raisonnement les plus difficiles et les tâches agentives complexes. C'est exact. Cependant, pour de nombreuses charges de travail pratiques, en particulier lorsque l'on tient compte de la possibilité d'auto-héberger, d'ajuster et de déployer sans dépendance vis-à-vis d'un fournisseur, Large 3 offre des performances compétitives.

|

Caractéristique |

Mistral Large 3 |

Gemini 3 Pro |

GPT-5.1 |

Claude Opus 4.5 |

|

Type |

MoE clairsemé, poids ouverts |

Multimodal exclusif |

Multimodal exclusif |

Axé sur le raisonnement exclusif |

|

Octroi de licences |

Apache 2.0 |

Fermé |

Fermé |

Fermé |

|

Déploiement |

API, hébergement entièrement autonome |

Hébergé uniquement |

Hébergé uniquement |

Hébergé uniquement |

|

Points forts |

Raisonnement, ouverture d'esprit, multilinguisme/multimodalité |

Multimodalité approfondie, vidéo |

Codage, utilisation d'outils, tâches générales |

Raisonnement détaillé et minutieux |

|

Capacité de raisonnement |

Élevé |

Élevé |

Très élevé |

Très élevé |

|

Capacité de codage |

Strong |

Solide |

Très fort |

Puissant mais plus lent |

|

Multimodal |

Image et texte |

Image, audio, vidéo |

Image et texte |

Image et texte |

|

Longueur du contexte |

Long |

Extrêmement long |

Très long |

Très long |

|

Efficacité des jetons |

Résultats allégés |

Plus détaillé |

Concis |

Souvent détaillé/plus long |

|

Auto-hébergement |

Oui |

Non |

Non |

Non |

|

Meilleur ajustement |

Équipes ayant besoin de performances et de contrôle |

Flux de travail vidéo/multimodaux |

Agents de production |

Tâches analytiques approfondies |

Quelle est la qualité du Mistral 3 ?

Mistral 3 est une version importante pour l'écosystème ouvert. La combinaison de l'efficacité des jetons, de la profondeur multilingue et de la gestion de contextes longs le rend remarquable. Il s'agit d'une combinaison de capacités et d'ouverture à une échelle sans précédent. Large 3 se rapproche des meilleurs systèmes propriétaires tout en restant accessible au téléchargement, à l'inspection et au déploiement selon vos préférences.

Si l'on souhaite maintenir des attentes raisonnables, il est essentiel de planifier de manière extrêmement approfondie. Large 3 fonctionne bien, mais des modèles tels qu'Opus et GPT gèrent le raisonnement à longue chaîne avec plus de cohérence. Cependant, pour la plupart des applications réelles, l'écart est minime.

Comment puis-je accéder à Mistral 3 ?

Il existe plusieurs façons de commencer, selon l'utilisation que vous prévoyez faire des modèles.

Si vous souhaitez simplement les essayer, l'API hébergée est la solution la plus simple. Les quatre niveaux — Large 3, 14B, 8B et 3B — sont accessibles avec une clé API standard. La facturation est basée sur des jetons, et c'est le moyen le plus rapide de tester le raisonnement, les invites multimodales ou les tâches multilingues.

Si vous préférez avoir un contrôle total, les poids ouverts sont disponibles en téléchargement. Lorsque Mistral qualifie ces modèles de « meilleurs modèles permissifs à poids libre », cela signifie :

- Vous pouvez télécharger les poids.

- Vous pouvez les utiliser à des fins commerciales.

- Vous pouvez les modifier ou les ajuster.

- Vous êtes responsable de la pile de déploiement de bout en bout.

Le modèle Large 3 nécessite un matériel performant, mais les modèles Ministral s'adaptent facilement. Vous pouvez également utiliser des plateformes partenaires si vous souhaitez tester différents backends sans avoir à gérer vos propres machines.

Cas d'utilisation de Mistral 3

J'ai présenté quelques cas d'utilisation dans cet article, mais je souhaite maintenant consacrer plus de temps à décrire comment, selon moi, les équipes pourraient utiliser chaque niveau dans la pratique. L'équipe de direction de Mistral est convaincue que la plupart des entreprises peuvent fonctionner avec des modèles légers et ouverts, qu'il est possible d'ajuster avec précision.

J'imagine comment un analyste d'un fonds spéculatif d' s pourrait télécharger 50 transcriptions de conférences téléphoniques sur les résultats financiers et demander à Mistral Large 3 de signaler les équipes de direction qui couvrent leurs prévisions ou changent de ton d'un trimestre à l'autre. La fenêtre contextuelle de 256 ko permettrait de traiter l'intégralité des transcriptions ainsi que les formulaires 10-K (documents financiers annuels) sans fragmentation. Ou si vous faites partie d'une société d'investissement européenne, Mistral fonctionnerait certainement en français, allemand, italien (ou arabe, comme nous l'avons testé).

Si cela semble peu probable, cela ne devrait peut-être pas l'être, car HSBC a annoncé un accord avec Mistral cette semaine.

Conclusions finales

Mistral 3 offre enfin à Mistral une structure cohérente et des modèles qui s'adaptent naturellement à différentes contraintes. Large 3 rivalise avec les principaux systèmes propriétaires, tandis que la gamme Ministral vous permet de choisir facilement un niveau adapté à votre matériel et à vos besoins en matière de latence.

Si vous envisagez de mener des essais, l'API hébergée constitue le moyen le plus rapide de commencer. Si vous souhaitez développer localement ou héberger vous-même, le téléchargement des poids vous offre un contrôle total.

Si vous souhaitez comprendre le fonctionnement interne de modèles tels que Mistral, notre cours « Concepts des grands modèles linguistiques » vous sera très utile. Si vous intégrez Mistral dans une application, le cours «Principes fondamentaux des API en Python » vous aidera sur le plan pratique.

Rédacteur technique spécialisé dans l'IA, la ML et la science des données, rendant les idées complexes claires et accessibles.

Je suis rédacteur et éditeur dans le domaine de la science des données. Je suis particulièrement intéressé par l'algèbre linéaire, les statistiques, R, etc. Je joue également beaucoup aux échecs !