Cursus

L'ingénierie des données est devenue l'un des rôles les plus importants dans le secteur technologique, constituant la colonne vertébrale de l'infrastructure de données pour les entreprises du monde entier. Les entreprises s'appuyant de plus en plus sur la prise de décision fondée sur les données, la demande en ingénieurs de données qualifiés continue d'augmenter.

Si vous vous préparez à un entretien pour un poste d'ingénieur de données, il est important de bien maîtriser les questions générales et techniques qui évaluent votre expérience, vos capacités à résoudre des problèmes et vos compétences techniques.

Dans cet article de blog, nous vous proposons un guide complet pour vous aider à vous préparer aux différentes étapes d'un entretien d'embauche dans le domaine de l'ingénierie des données, depuis la présélection initiale par les ressources humaines jusqu'aux évaluations techniques approfondies.

Devenez ingénieur en données

Questions d'entretien initiales pour le poste d'ingénieur en données RH

Lors du premier entretien avec les ressources humaines, le responsable des ressources humaines vous interrogera sur votre expérience professionnelle et la valeur que vous pouvez apporter à l'entreprise. Cette étape vise à évaluer votre parcours, vos compétences interpersonnelles et votre adéquation globale avec la culture de l'entreprise.

1. Quels sont les éléments qui font de vous le candidat idéal pour ce poste ?

Si le responsable du recrutement vous sélectionne pour un entretien téléphonique, c'est qu'il a dû remarquer quelque chose qui lui a plu dans votre profil. Abordez cette question avec assurance et parlez de votre expérience et de votre évolution professionnelle.

Il est important de prendre connaissance du profil de l'entreprise et de la description du poste avant l'entretien. Cela vous aidera à comprendre ce que le responsable du recrutement recherche et à adapter votre réponse en conséquence.

Veuillez mettre l'accent sur les compétences et les expériences spécifiques correspondant aux exigences du poste, telles que la conception et la gestion de pipelines de données, la modélisation et les processus ETL. Veuillez mettre en avant la manière dont votre combinaison unique de compétences, d'expérience et de connaissances vous distingue.

2. Quelles sont les responsabilités quotidiennes d'un ingénieur de données ?

Bien qu'il n'y ait pas de réponse absolue, partager vos expériences professionnelles antérieures et vous référer à la description du poste peut vous aider à fournir une réponse complète. En règle générale, les responsabilités quotidiennes des ingénieurs de données comprennent :

- Développement, test et maintenance de bases de données.

- Création de solutions de données basées sur les besoins des entreprises.

- Acquisition et intégration des données.

- Développer, valider et maintenir des pipelines de données pour les processus ETL, la modélisation, la transformation et la mise à disposition.

- Déployer et gérer des modèles d'apprentissage automatique dans certains cas.

- Maintenir la qualité des données en nettoyant, validant et surveillant les flux de données.

- Amélioration de la fiabilité, des performances et de la qualité du système.

- Respecter les directives en matière de gouvernance et de sécurité des données afin de garantir la conformité et l'intégrité des données.

3. Quelle est la difficulté la plus importante que vous rencontrez dans votre rôle d'ingénieur de données ?

Cette question varie en fonction des expériences individuelles, mais les défis courants incluent :

- Suivre le rythme rapide des avancées technologiques et intégrer de nouveaux outils pour améliorer les performances, la sécurité, la fiabilité et le retour sur investissement des systèmes de données.

- Compréhension et mise en œuvre de protocoles complexes en matière de gouvernance et de sécurité des données.

- Gérer les plans de reprise après sinistre et garantir la disponibilité et l'intégrité des données lors d'événements imprévus.

- Équilibrer les exigences commerciales et les contraintes techniques, et prévoir les besoins futurs en matière de données.

- Gérer efficacement de grands volumes de données et garantir la qualité et la cohérence des données.

4. Quels outils ou cadres de données avez-vous l'habitude d'utiliser ? Y en a-t-il certains que vous préférez aux autres ?

Votre réponse sera basée sur vos expériences. Une bonne connaissance des outils modernes et des intégrations tierces vous permettra de répondre à cette question en toute confiance. Veuillez discuter des outils liés à :

- Gestion de bases de données (par exemple, MySQL, PostgreSQL, MongoDB)

- Entreposage de données (par exemple, Amazon Redshift, Google BigQuery, Snowflake)

- Orchestration des données (par exemple, Apache Airflow, Prefect)

- Pipelines de données (par exemple, Apache Kafka, Apache NiFi)

- Gestion du cloud (par exemple, AWS, Google Cloud Platform, Microsoft Azure)

- Nettoyage, modélisation et transformation des données (par exemple, pandas, dbt, Spark)

- Traitement par lots et en temps réel (par exemple, Apache Spark, Apache Flink)

Veuillez noter qu'il n'y a pas de réponse incorrecte à cette question. L'intervieweur évalue vos compétences et votre expérience.

5. Comment vous tenez-vous informé des dernières tendances et avancées en matière d'ingénierie des données ?

Cette question évalue votre engagement envers l'apprentissage continu et votre volonté de rester à jour dans votre domaine.

Vous pouvez mentionner l'abonnement à des newsletters spécialisées, le suivi de blogs influents, la participation à des forums et communautés en ligne, la participation à des webinaires et conférences, ainsi que le suivi de cours en ligne. Veuillez indiquer les sources ou plateformes spécifiques que vous utilisez pour vous tenir informé.

6. Pourriez-vous décrire une situation où vous avez dû collaborer avec une équipe interfonctionnelle pour mener à bien un projet ?

L'ingénierie des données implique souvent de collaborer avec différentes équipes, notamment des scientifiques des données, des analystes et du personnel informatique.

Veuillez partager un exemple précis où vous avez collaboré avec succès avec d'autres personnes, en mettant l'accent sur vos compétences en communication, votre capacité à comprendre différents points de vue et la manière dont vous avez contribué à la réussite du projet. Veuillez décrire les défis auxquels vous avez été confronté et comment vous les avez surmontés pour atteindre le résultat souhaité.

Devenez ingénieur en données

Questions d'entretien pour le poste d'ingénieur en données techniques

L'ingénierie des données est un domaine hautement technique, il n'est donc pas surprenant que la majeure partie de votre processus d'entretien comprenne des questions et des exercices techniques. Dans cette section, nous aborderons différents types de questions et réponses techniques, en mettant l'accent sur les questions relatives aux débutants, à Python, à SQL, aux projets et à la gestion.

Questions d'entretien pour un poste de jeune ingénieur de données

Les entretiens pour les postes d'ingénieurs juniors se concentrent sur les outils, Python et les requêtes SQL. Ils peuvent également inclure des questions relatives à la gestion de bases de données et aux processus ETL, y compris des défis de codage et des tests à réaliser à domicile.

Lorsque les entreprises recrutent de jeunes diplômés, elles souhaitent s'assurer que vous êtes en mesure de gérer efficacement leurs données et leurs systèmes.

7. Pourriez-vous expliquer les schémas de conception pertinents pour la modélisation des données ?

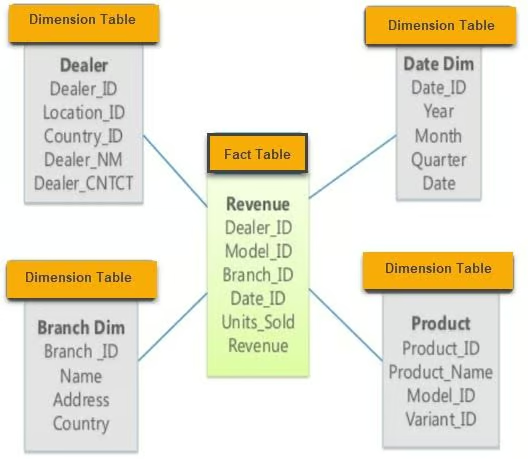

Il existe trois principaux schémas de conception de modélisation des données: étoile, flocon de neige et galaxie.

- Schéma en étoile : Ce schéma contient diverses tables de dimensions reliées à une table de faits centrale. Il est simple et facile à comprendre, ce qui le rend adapté aux requêtes simples.

Exemple de schéma en étoile. Image provenant de guru99

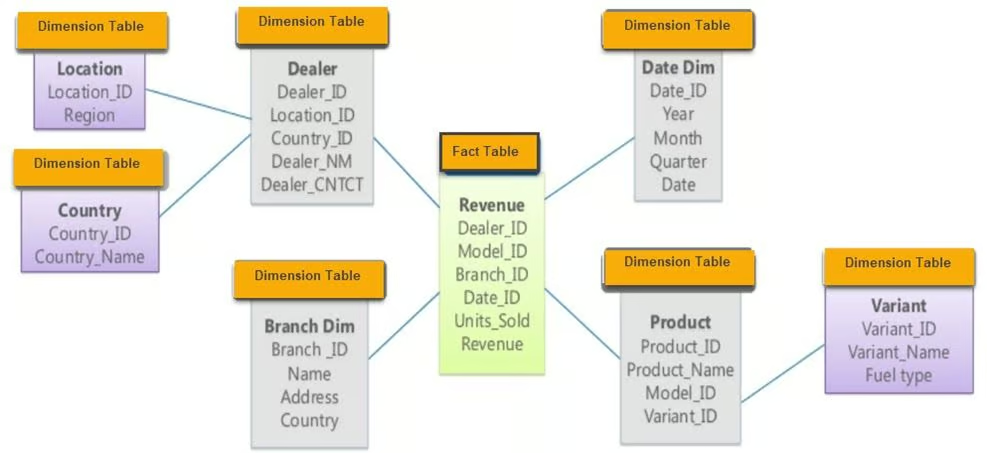

- Schéma Snowflake : Extension du schéma en étoile, le schéma en flocon de neige se compose d'une table de faits et de plusieurs tableaux de dimensions avec des couches supplémentaires de normalisation, formant une structure en forme de flocon de neige. Cela réduit la redondance et améliore l'intégrité des données.

Exemple de schéma Snowflake. Image provenant de guru99

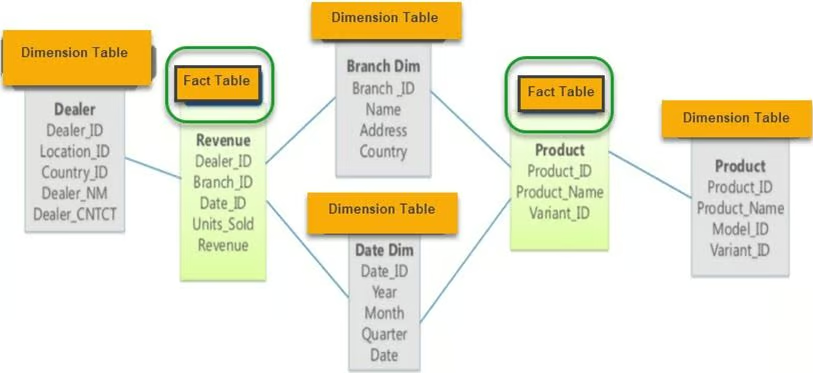

- Schéma de la galaxie : Également appelé schéma de constellation de faits, il contient deux tableaux de faits ou plus qui partagent des tableaux de dimensions. Ce schéma convient aux systèmes de bases de données complexes qui nécessitent plusieurs tableaux de faits.

Exemple de schéma Galaxy. Image provenant de guru99

8. Quels outils ETL avez-vous utilisés ? Quel est votre préféré et pourquoi ?

En répondant à cette question, veuillez mentionner les outils ETL que vous maîtrisez et expliquer pourquoi vous avez choisi des outils spécifiques pour certains projets. Veuillez examiner les avantages et les inconvénients de chaque outil et leur intégration dans votre flux de travail. Les outils open source populaires comprennent :

- dbt (outil de création de données) : Idéal pour transformer les données de votre entrepôt à l'aide de SQL.

- Apache Spark : Idéal pour le traitement de données à grande échelle et le traitement par lots.

- Apache Kafka : Utilisé pour les pipelines de données en temps réel et le streaming.

- Airbyte : Un outil open source d'intégration de données qui facilite l'extraction et le chargement des données.

Si vous avez besoin de rafraîchir vos connaissances en matière d'ETL, envisagez de suivre le cours Introduction à l'ingénierie des données.

9. Qu'est-ce que l'orchestration des données et quels outils pouvez-vous utiliser pour la mettre en œuvre ?

L'orchestration des données est un processus automatisé qui consiste à accéder à des données brutes provenant de plusieurs sources, à effectuer des opérations de nettoyage, de transformation et de modélisation des données, puis à les mettre à disposition pour des tâches analytiques. Il garantit la fluidité des flux de données entre les différents systèmes et étapes du traitement.

Les outils populaires pour l'orchestration des données comprennent :

- Apache Airflow : Largement utilisé pour la planification et le suivi des flux de travail.

- Monsieur le Préfet : Un outil d'orchestration moderne axé sur le flux de données.

- Dagster : Un outil d'orchestration conçu pour les charges de travail à forte intensité de données.

- AWS Glue : Un service ETL géré qui simplifie la préparation des données pour l'analyse.

10. Quels outils utilisez-vous pour l'ingénierie analytique ?

L'ingénierie analytique consiste à transformer les données traitées, à appliquer des modèles statistiques et à les visualiser à l'aide de rapports et de tableaux de bord.

Les outils populaires pour l'ingénierie analytique comprennent :

- dbt (outil de création de données) : Ceci est utilisé pour transformer les données de votre entrepôt à l'aide de SQL.

- BigQuery : Un entrepôt de données entièrement géré et sans serveur pour l'analyse de données à grande échelle.

- Postgres : Un système de base de données relationnelle open source performant.

- Métabase : Un outil open source qui vous permet de poser des questions sur vos données et d'afficher les réponses dans des formats compréhensibles.

- Google Data Studio : Ceci est utilisé pour créer des tableaux de bord et des rapports visuels.

- Tableau : Une plateforme de premier plan pour la visualisation des données.

Ces outils facilitent l'accès, la transformation et la visualisation des données afin d'en tirer des informations pertinentes et d'appuyer les processus décisionnels.

11. Quelle est la différence entre les systèmes OLAP et OLTP ?

OLAP (Online Analytical Processing) analyse les données historiques et prend en charge les requêtes complexes. Il est optimisé pour les charges de travail impliquant de nombreuses lectures et est fréquemment utilisé dans les entrepôts de données pour les tâches de veille économique. L'OLTP ( Online Transaction Processing) est conçu pour gérer les données transactionnelles en temps réel. Il est optimisé pour les charges de travail impliquant de nombreuses écritures et est utilisé dans les bases de données opérationnelles pour les opérations commerciales quotidiennes.

La principale différence réside dans leur objectif : OLAP facilite la prise de décision, tandis qu'OLTP soutient les opérations quotidiennes.

Si vous avez encore des doutes, je vous recommande de lire l'article de blog OLTP vs OLAP.

Questions d'entretien pour un poste d'ingénieur de données Python

Python est le langage le plus populaire dans le domaine de l'ingénierie des données en raison de sa polyvalence et de la richesse de son écosystème de bibliothèques disponibles pour le traitement, l'analyse et l'automatisation des données. Voici quelques questions relatives à Python que vous pourriez rencontrer lors d'un entretien d'embauche dans le domaine de l'ingénierie des données.

12. Quelles bibliothèques Python sont les plus efficaces pour le traitement des données ?

Les bibliothèques de traitement de données les plus populaires en Python comprennent :

- pandas: Idéal pour la manipulation et l'analyse de données, fournissant des structures de données telles que DataFrame.

- NumPy: Indispensable pour les calculs numériques, prenant en charge les grands tableaux et matrices multidimensionnels.

- Dask: Facilite le calcul parallèle et permet de traiter des calculs dépassant la capacité de la mémoire à l'aide d'une syntaxe similaire à celle de pandas.

- PySpark: Une API Python pour Apache Spark, particulièrement utile pour le traitement de données à grande échelle et l'analyse en temps réel.

Chacune de ces bibliothèques présente des avantages et des inconvénients, et le choix dépend des exigences spécifiques en matière de données et de l'ampleur des tâches de traitement des données.

13. Comment procéder au web scraping en Python ?

Le web scraping en Python implique généralement les étapes suivantes :

1. Veuillez accéder à la page Web en utilisant la bibliothèque requests:

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')2. Extraire des tableaux et des informations à l'aide de BeautifulSoup :

tables = soup.find_all('table')3. Veuillez le convertir en un format structuré à l'aide de pandas :

import pandas as pd

data = []

for table in tables:

rows = table.find_all('tr')

for row in rows:

cols = row.find_all('td')

cols = [ele.text.strip() for ele in cols]

data.append(cols)

df = pd.DataFrame(data)4. Nettoyez les données à l'aide de pandas et NumPy :

df.dropna(inplace=True) # Drop missing values5. Veuillez enregistrer les données sous forme de fichier CSV :

df.to_csv('scraped_data.csv', index=False)Dans certains cas, pandas.read_html peut simplifier le processus :

df_list = pd.read_html('http://example.com')

df = df_list[0] # Assuming the table of interest is the first one14. Comment gérez-vous les grands ensembles de données dans Python qui ne tiennent pas en mémoire ?

Le traitement de grands ensembles de données qui ne tiennent pas en mémoire nécessite l'utilisation d'outils et de techniques conçus pour le calcul hors mémoire :

- Dask : Permet le calcul parallèle et fonctionne avec des ensembles de données plus volumineux que la mémoire disponible, en utilisant une syntaxe similaire à celle de pandas.

import dask.dataframe as dd

df = dd.read_csv('large_dataset.csv')- PySpark : Permet le traitement distribué des données, ce qui est particulièrement utile pour gérer des données à grande échelle.

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName('data_processing').getOrCreate()

df = spark.read.csv('large_dataset.csv', header=True, inferSchema=True)- Chunking avec pandas : Veuillez lire les grands ensembles de données par segments.

import pandas as pd

chunk_size = 10000

for chunk in pd.read_csv('large_dataset.csv', chunksize=chunk_size):

process(chunk) # Replace with your processing function15. Comment vous assurez-vous que votre code Python est efficace et optimisé pour offrir les meilleures performances possibles ?

Afin de garantir l'efficacité et l'optimisation des performances du code Python, veuillez prendre en considération les pratiques suivantes :

- Profilage : Veuillez utiliser des outils de profilage tels que

cProfile,line_profileroumemory_profilerpour identifier les goulots d'étranglement dans votre code.

import cProfile

cProfile.run('your_function()')- Vectorisation : Veuillez utiliser

numpyoupandaspour les opérations vectorisées au lieu des boucles.

import numpy as np

data = np.array([1, 2, 3, 4, 5])

result = data * 2 # Vectorized operation- Structures de données efficaces : Veuillez sélectionner les structures de données appropriées (par exemple, listes, ensembles, dictionnaires) en fonction de votre cas d'utilisation.

data_dict = {'key1': 'value1', 'key2': 'value2'} # Faster lookups compared to lists- Traitement en parallèle : Utilisez le multithreading ou le multitraitement pour les tâches pouvant être parallélisées.

from multiprocessing import Pool

def process_data(data_chunk):

# Your processing logic here

return processed_chunk

with Pool(processes=4) as pool:

results = pool.map(process_data, data_chunks)- Éviter les calculs redondants : Mettre en cache les résultats des opérations coûteuses si elles doivent être réutilisées.

from functools import lru_cache

@lru_cache(maxsize=None)

def expensive_computation(x):

# Perform expensive computation

return result16. Comment garantissez-vous l'intégrité et la qualité des données dans vos pipelines de données ?

L'intégrité et la qualité des données sont essentielles pour garantir la fiabilité de l'ingénierie des données. Les meilleures pratiques comprennent :

- Validation des données : Mettre en place des contrôles à différentes étapes du pipeline de données afin de valider les formats, les plages et la cohérence des données.

def validate_data(df):

assert df['age'].min() >= 0, "Age cannot be negative"

assert df['salary'].dtype == 'float64', "Salary should be a float"

# Additional checks...- Nettoyage des données : Veuillez utiliser des bibliothèques telles que

pandaspour nettoyer et prétraiter les données en traitant les valeurs manquantes, en supprimant les doublons et en corrigeant les erreurs.

df.dropna(inplace=True) # Drop missing values

df.drop_duplicates(inplace=True) # Remove duplicates- Tests automatisés : Développer des tests unitaires pour les fonctions de traitement des données à l'aide de frameworks tels qu'

pytest.

import pytest

def test_clean_data():

raw_data = pd.DataFrame({'age': [25, -3], 'salary': ['50k', '60k']})

clean_data = clean_data_function(raw_data)

assert clean_data['age'].min() >= 0

assert clean_data['salary'].dtype == 'float64'- Surveillance et alertes : Configurez la surveillance de vos pipelines de données afin de détecter les anomalies et d'envoyer des alertes lorsque des problèmes de qualité des données surviennent.

from airflow import DAG

from airflow.operators.dummy_operator import DummyOperator

from airflow.operators.email_operator import EmailOperator

# Define your DAG and tasks...17. Comment gérez-vous les données manquantes dans vos ensembles de données ?

Le traitement des données manquantes est une tâche courante dans l'ingénierie des données. Les approches comprennent :

- Suppression : Veuillez simplement supprimer les lignes ou les colonnes contenant des données manquantes si elles ne sont pas significatives.

df.dropna(inplace=True)- Imputation : Veuillez compléter les valeurs manquantes à l'aide de mesures statistiques (moyenne, médiane) ou utiliser des méthodes plus sophistiquées telles que l'imputation KNN.

df['column'].fillna(df['column'].mean(), inplace=True)- Variable indicatrice : Veuillez ajouter une variable indicatrice pour préciser quelles valeurs étaient manquantes.

df['column_missing'] = df['column'].isnull().astype(int)- Imputation basée sur un modèle : Utilisez la modélisation prédictive pour estimer les valeurs manquantes.

from sklearn.impute import KNNImputer

imputer = KNNImputer(n_neighbors=5)

df = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)18. Comment gérez-vous les limites de débit des API lors de la récupération de données en Python ?

Pour gérer les limites de débit des API, il existe plusieurs stratégies, telles que :

- Retour en arrière et nouvelle tentative: Mise en œuvre d'un recul exponentiel lorsque les limites de débit sont atteintes.

- Pagination: Récupération de données par petits blocs à l'aide des options de pagination de l'API.

- Mise en cache: Stockage des réponses afin d'éviter les appels API redondants.

Exemple utilisant la bibliothèque Python time et le module requests:

import time

import requests

def fetch_data_with_rate_limit(url):

for attempt in range(5): # Retry up to 5 times

response = requests.get(url)

if response.status_code == 429: # Too many requests

time.sleep(2 ** attempt) # Exponential backoff

else:

return response.json()

raise Exception("Rate limit exceeded")Python est sans aucun doute l'un des langages les plus importants dans le domaine de l'ingénierie des données. Vous pouvez perfectionner vos compétences en suivant notre cursus Data Engineer in Python, qui propose un programme complet vous permettant d'acquérir les concepts, les langages de programmation, les outils et les frameworks modernes en matière d'ingénierie des données.

Questions d'entretien pour un poste d'ingénieur de données SQL

La phase de codage SQL constitue une partie importante du processus de recrutement en ingénierie des données. La pratique de divers scripts simples et complexes peut vous aider à vous préparer. Les examinateurs peuvent vous demander de rédiger des requêtes pour l'analyse de données, les expressions de table communes, le classement, l'ajout de sous-totaux et les fonctions temporaires.

19. Que sont les expressions de table communes (CTE) en SQL ?

Les CTE sont utilisées pour simplifier les jointures complexes et exécuter des sous-requêtes. Ils contribuent à rendre les requêtes SQL plus lisibles et plus faciles à maintenir. Voici un exemple de CTE qui affiche tous les étudiants ayant une spécialisation en sciences et une note A :

SELECT *

FROM class

WHERE id IN (

SELECT DISTINCT id

FROM students

WHERE grade = "A"

AND major = "Science"

);En utilisant une CTE, la requête devient :

WITH temp AS (

SELECT id

FROM students

WHERE grade = "A"

AND major = "Science"

)

SELECT *

FROM class

WHERE id IN (SELECT id FROM temp);Les CTE peuvent être utilisées pour des problèmes plus complexes et plusieurs CTE peuvent être enchaînées.

20. Comment classez-vous les données dans SQL ?

Les ingénieurs de données classent généralement les valeurs en fonction de paramètres tels que les ventes et les bénéfices. La fonction ` RANK() ` est utilisée pour classer les données en fonction d'une colonne spécifique :

SELECT

id,

sales,

RANK() OVER (ORDER BY sales DESC) AS rank

FROM bill;Vous pouvez également utiliser DENSE_RANK(), qui ne saute pas les rangs suivants si les valeurs sont identiques.

21. Est-il possible de créer une fonction temporaire simple et de l'utiliser dans une requête SQL ?

Tout comme en Python, vous pouvez créer des fonctions en SQL afin de rendre vos requêtes plus élégantes et d'éviter les instructions case répétitives. Voici un exemple de fonction temporaire get_gender:

CREATE TEMPORARY FUNCTION get_gender(type VARCHAR) RETURNS VARCHAR AS (

CASE

WHEN type = "M" THEN "male"

WHEN type = "F" THEN "female"

ELSE "n/a"

END

);

SELECT

name,

get_gender(type) AS gender

FROM class;Cette approche rend votre code SQL plus clair et plus facile à maintenir.

22. Comment peut-on ajouter des sous-totaux dans SQL ?

L'ajout de sous-totaux peut être réalisé à l'aide des fonctions GROUP BY et ROLLUP(). Voici un exemple :

SELECT

department,

product,

SUM(sales) AS total_sales

FROM sales_data

GROUP BY ROLLUP(department, product);Cette requête vous fournira un sous-total pour chaque département et un total général à la fin.

23. Comment gérez-vous les données manquantes dans SQL ?

La gestion des données manquantes est essentielle pour maintenir l'intégrité des données. Les approches courantes comprennent :

- Utilisation d'

COALESCE(): Cette fonction renvoie la première valeur non nulle de la liste.

SELECT id, COALESCE(salary, 0) AS salary FROM employees;- Utilisation des instructions «

CASE» : Pour traiter les valeurs manquantes de manière conditionnelle.

SELECT id,

CASE

WHEN salary IS NULL THEN 0

ELSE salary

END AS salary

FROM employees;24. Comment procédez-vous à l'agrégation de données dans SQL ?

L'agrégation de données implique l'utilisation de fonctions d'agrégation telles que SUM(), AVG(), COUNT(), MIN() et MAX(). Voici un exemple :

SELECT department,

SUM(salary) AS total_salary,

AVG(salary) AS average_salary,

COUNT(*) AS employee_count

FROM employees

GROUP BY department;25. Comment optimisez-vous les requêtes SQL pour améliorer les performances ?

Pour optimiser les requêtes SQL, vous pouvez :

- Veuillez utiliser des index sur les colonnes fréquemment interrogées afin d'accélérer les recherches.

- Veuillez éviter l'

SELECT *e en spécifiant uniquement les colonnes requises. - Veuillez utiliser les jointures de manière judicieuse et éviter celles qui ne sont pas nécessaires.

- Optimisez l'utilisation des sous-requêtes en les remplaçant par des CTE lorsque cela est approprié.

- Veuillez analyser les plans d'exécution des requêtes afin d'identifier les goulots d'étranglement. Exemple :

EXPLAIN ANALYZE

SELECT customer_id, COUNT(order_id)

FROM orders

GROUP BY customer_id;La résolution d'exercices de codage SQL constitue la méthode la plus efficace pour s'entraîner et réviser les concepts oubliés. Vous pouvez évaluer vos compétences en SQL en passant le test « Data Analysis in SQL » (Analyse de données en SQL ) de DataCamp (un compte est nécessaire pour accéder à cette évaluation).

Questions d'entretien pour le poste d'ingénieur de données lié à un projet

Après les entretiens généraux, vous passerez généralement à une étape technique qui comprend des défis de codage, des exercices de résolution de problèmes, la conception d'un système de base de données sur un tableau blanc, un examen à domicile et des questions analytiques.

Cette étape peut être assez intense, donc connaître certaines des questions et réponses habituelles des entretiens d'embauche en ingénierie des données peut vous aider à réussir votre entretien.

26. Veuillez me décrire un projet sur lequel vous avez travaillé du début à la fin.

Cette réponse devrait vous venir naturellement si vous avez déjà travaillé sur un projet d'ingénierie des données en tant qu'étudiant ou professionnel. Cela étant dit, il est toujours utile de se préparer à l'avance. Voici comment structurer votre réponse :

- Introduction et problématique commerciale :

- Veuillez commencer par expliquer le contexte du projet. Veuillez décrire le problème commercial que vous avez résolu et les objectifs du projet.

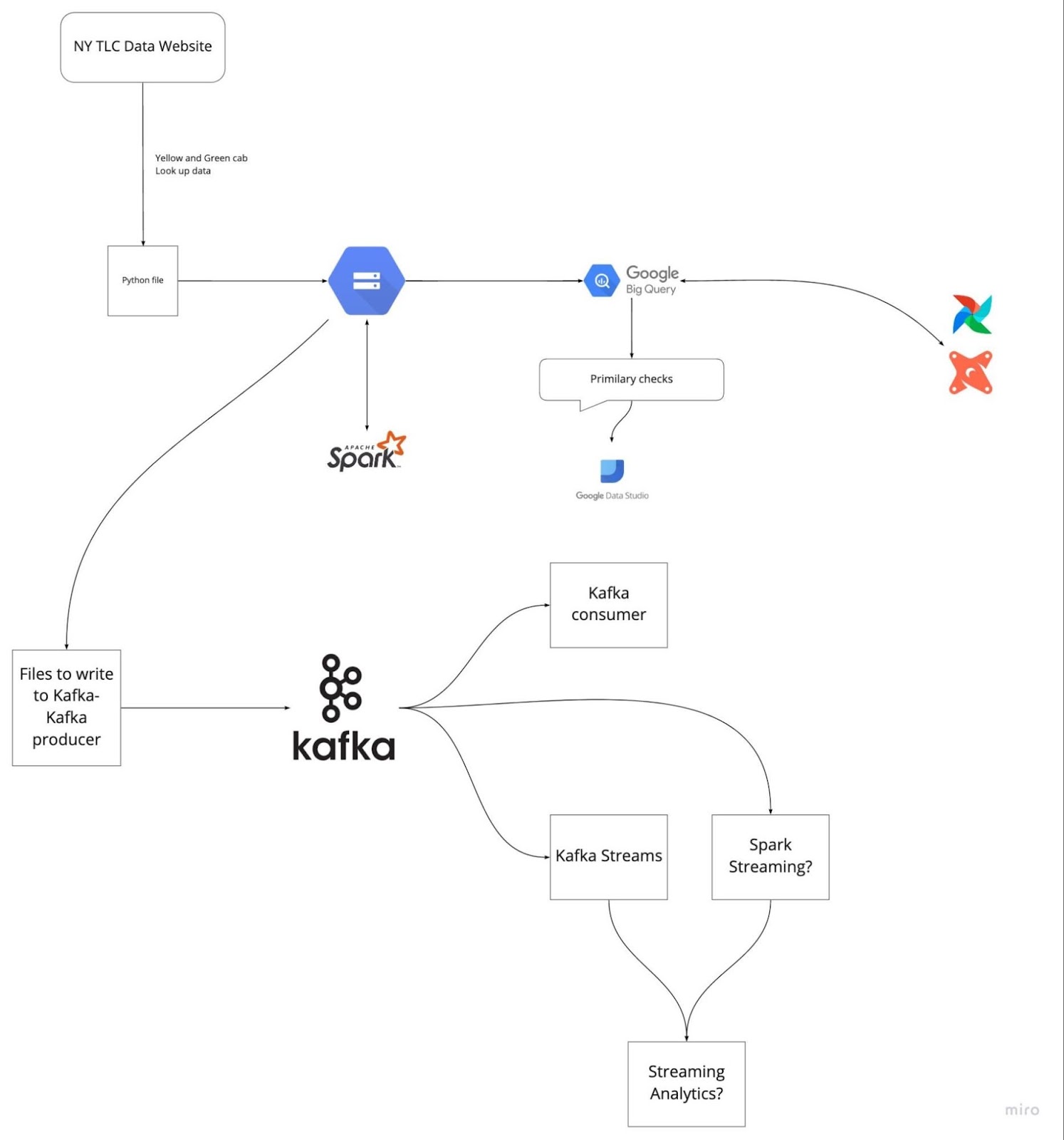

- Exemple : Dans le cadre de ce projet, nous avons cherché à optimiser le pipeline de données pour le traitement des données TLC Trip Record afin d'améliorer les performances des requêtes et la précision des données pour l'équipe d'analyse.

- Ingestion des données :

- Veuillez décrire comment vous avez accédé aux données brutes et comment vous les avez intégrées.

- Exemple : Nous avons intégré les données brutes du TLC Trip Record à l'aide de GCP, Airflow et PostgreSQL afin de garantir une collecte fiable des données provenant de plusieurs sources.

- Traitement et transformation des données :

- Veuillez expliquer les mesures prises pour nettoyer, transformer et structurer les données.

- Exemple : Nous avons utilisé Apache Spark pour le traitement par lots et Apache Kafka pour le streaming en temps réel afin de gérer la transformation des données. Les données ont été nettoyées, validées et converties dans un format structuré adapté à l'analyse.

- Stockage et entreposage des données :

- Veuillez discuter des solutions de stockage de données utilisées et expliquer pourquoi elles ont été choisies.

- Exemple : Les données traitées ont été stockées dans Google BigQuery, qui a fourni une solution de stockage de données évolutive et efficace. Airflow a été utilisé pour gérer les flux de données.

- Ingénierie analytique :

- Veuillez mettre en évidence les outils et les méthodes utilisés à des fins analytiques.

- Exemple : Nous avons utilisé dbt (outil de création de données), BigQuery, PostgreSQL, Google Data Studio et Metabase pour l'ingénierie analytique. Ces outils ont contribué à la création de modèles de données robustes et à la génération de rapports et de tableaux de bord pertinents.

- Environnement de déploiement et cloud :

- Veuillez mentionner les stratégies de déploiement et l'infrastructure cloud utilisées.

- Exemple : L'ensemble du projet a été déployé à l'aide de GCP, Terraform et Docker, garantissant ainsi un environnement cloud évolutif et fiable.

- Défis et solutions :

- Veuillez discuter des défis auxquels vous avez été confronté et comment vous les avez surmontés.

- Exemple : L'un des principaux défis consistait à traiter un volume important de données en temps réel. Nous avons résolu ce problème en optimisant nos tâches de streaming Kafka et en mettant en œuvre des transformations Spark efficaces.

- Résultats et impact :

- Veuillez conclure en décrivant les résultats et l'impact du projet.

- Exemple : Ce projet a considérablement amélioré les performances des requêtes et la précision des données pour l'équipe d'analyse, ce qui a permis d'accélérer la prise de décision et d'obtenir de meilleures informations.

Image provenant de DataTalksClub/data-engineering-zoomcamp

En vous préparant à l'avance en passant en revue les cinq derniers projets sur lesquels vous avez travaillé, vous éviterez de vous bloquer pendant l'entretien. Veuillez comprendre l'énoncé du problème et les solutions que vous avez mises en œuvre. Entraînez-vous à expliquer chaque étape de manière claire et concise.

Questions d'entretien pour le poste de responsable ingénieur de données

Pour les postes de responsable ingénierie, les questions portent généralement sur la prise de décision, la compréhension des activités commerciales, la gestion et la maintenance des ensembles de données, la conformité et les politiques de sécurité.

27. Quelle est la différence entre un entrepôt de données et une base de données opérationnelle ?

Un entrepôt de données fournit des données historiques pour les tâches d'analyse de données et la prise de décision. Il prend en charge le traitement analytique de volumes importants, tel que le traitement analytique en ligne (OLAP). Les entrepôts de données sont conçus pour traiter des requêtes complexes qui accèdent à plusieurs lignes et sont optimisés pour les opérations à forte intensité de lecture. Ils prennent en charge plusieurs utilisateurs simultanés et sont conçus pour récupérer rapidement et efficacement de grands volumes de données.

Les systèmes de gestion de bases de données opérationnelles (OLTP) gèrent des ensembles de données dynamiques en temps réel. Ils prennent en charge le traitement de transactions à haut volume pour des milliers de clients simultanés, ce qui les rend adaptés aux opérations quotidiennes. Les données comprennent généralement des informations actuelles et à jour sur les transactions et les opérations commerciales. Les systèmes OLTP sont optimisés pour les opérations impliquant de nombreuses écritures et le traitement rapide des requêtes.

28. Pourquoi pensez-vous que toutes les entreprises utilisant des systèmes de données ont besoin d'un plan de reprise après sinistre ?

La gestion des catastrophes relève de la responsabilité d'un responsable de l'ingénierie des données. Un plan de reprise après sinistre garantit que les systèmes de données peuvent être restaurés et continuer à fonctionner en cas de cyberattaque, de défaillance matérielle, de catastrophe naturelle ou d'autres événements catastrophiques. Les aspects pertinents comprennent :

- Sauvegarde en temps réel : Sauvegarde régulière des fichiers et des bases de données vers des emplacements de stockage sécurisés hors site.

- Redondance des données : Mettre en œuvre la réplication des données entre différents sites géographiques afin de garantir leur disponibilité.

- Protocoles de sécurité : Mettre en place des protocoles pour surveiller, tracer et restreindre le trafic entrant et sortant afin de prévenir les violations de données.

- Procédures de rétablissement : Procédures détaillées pour restaurer rapidement et efficacement les données et les systèmes afin de minimiser les temps d'arrêt.

- Tests et exercices : Tester régulièrement le plan de reprise après sinistre au moyen de simulations et d'exercices afin de garantir son efficacité et d'apporter les ajustements nécessaires.

29. Quelle est votre approche en matière de prise de décision lorsque vous dirigez une équipe d'ingénieurs de données ?

En tant que responsable de l'ingénierie des données, la prise de décision implique de trouver un équilibre entre les considérations techniques et les objectifs commerciaux. Certaines approches comprennent :

- Décisions fondées sur les données : Utiliser l'analyse des données pour éclairer les décisions, en veillant à ce qu'elles soient fondées sur des informations objectives plutôt que sur l'intuition.

- Collaboration entre les parties prenantes : Travailler en étroite collaboration avec les parties prenantes afin de comprendre les besoins de l'entreprise et d'aligner les efforts d'ingénierie des données sur les objectifs de l'entreprise.

- Évaluation des risques : Évaluer les risques potentiels et leur incidence sur les projets et élaborer des stratégies d'atténuation.

- Méthodologies agiles : Mettre en œuvre des pratiques agiles pour s'adapter à l'évolution des exigences et apporter une valeur ajoutée progressive.

- Mentorat et développement : Soutenir le développement des membres de l'équipe en leur offrant des possibilités de mentorat et de formation et en favorisant un environnement collaboratif.

30. Comment assurez-vous la conformité avec les réglementations en matière de protection des données dans vos projets d'ingénierie des données ?

La conformité aux réglementations en matière de protection des données implique plusieurs pratiques, par exemple :

- Comprendre les réglementations : Rester informé des réglementations en matière de protection des données telles que le RGPD, le CCPA et l'HIPAA.

- Cadre de gouvernance des données : Mettre en œuvre un cadre solide de gouvernance des données qui inclut des politiques relatives à la confidentialité, à la sécurité et au contrôle d'accès des données.

- Chiffrement des données : Chiffrage des données sensibles au repos et en transit afin d'empêcher tout accès non autorisé.

- Contrôles d'accès : La mise en place de contrôles d'accès rigoureux garantit que seul le personnel autorisé peut accéder aux données sensibles.

- Audits et surveillance : Effectuer régulièrement des audits et surveiller l'accès aux données et leur utilisation afin de détecter et de résoudre rapidement tout problème de conformité.

31. Pourriez-vous décrire un projet complexe en ingénierie des données que vous avez géré ?

Lorsque vous discutez d'un projet ambitieux, vous pouvez vous concentrer sur les aspects suivants :

- Portée et objectifs du projet : Définissez clairement les objectifs du projet et le problème commercial qu'il vise à résoudre.

- Difficultés rencontrées : Veuillez décrire les défis spécifiques tels que les contraintes techniques, les limitations en matière de ressources ou les problèmes d'alignement des parties prenantes.

- Stratégies et solutions : Veuillez expliquer les méthodes que vous utilisez pour surmonter ces défis, y compris les solutions techniques, les pratiques de gestion d'équipe et l'engagement des parties prenantes.

- Résultats et impact : Veuillez mettre en évidence les résultats positifs et l'impact sur l'entreprise, tels que l'amélioration de la qualité des données, l'optimisation des performances du système ou l'augmentation de l'efficacité opérationnelle.

32. Comment évaluez-vous et mettez-vous en œuvre les nouvelles technologies de données ?

L'évaluation et la mise en œuvre de nouvelles technologies de données impliquent :

- Étude de marché : Se tenir informé des dernières avancées et tendances en matière de technologies d'ingénierie des données.

- Preuve de concept (PoC) : Mener des projets PoC afin d'évaluer la faisabilité et les avantages des nouvelles technologies dans votre contexte spécifique.

- Analyse coûts-avantages : Évaluer les coûts, les avantages et le retour sur investissement potentiel de l'adoption de nouvelles technologies.

- Adhésion des parties prenantes : Présentation des conclusions et des recommandations aux parties prenantes afin d'obtenir leur adhésion et leur soutien.

- Plan de mise en œuvre : Élaborer un plan de mise en œuvre détaillé comprenant un calendrier, l'affectation des ressources et des stratégies de gestion des risques.

- Formation et assistance : Offrir une formation et un soutien à l'équipe afin d'assurer une transition harmonieuse vers les nouvelles technologies.

33. Comment établissez-vous les priorités parmi les tâches et les projets dans un environnement en constante évolution ?

Une méthode efficace pour hiérarchiser les tâches consiste à se baser sur leur impact sur les objectifs commerciaux et leur urgence. Vous pouvez utiliser des cadres tels que la matrice d'Eisenhower pour classer les tâches en quatre catégories : urgentes et importantes, importantes mais non urgentes, urgentes mais non importantes, et ni urgentes ni importantes. De plus, communiquez avec les parties prenantes afin d'harmoniser les priorités et de vous assurer que l'équipe se concentre sur les activités à forte valeur ajoutée.

Questions d'entretien pour les ingénieurs de données FAANG

Dans cette section, nous examinons les questions les plus fréquemment posées lors des entretiens d'embauche pour des postes d'ingénieur de données par les responsables de Facebook, Amazon et Google.

Questions d'entretien pour le poste d'ingénieur de données chez Facebook

34. Pourquoi utilisons-nous des clusters dans Kafka et quels en sont les avantages ?

Un cluster Kafka est constitué de plusieurs brokers qui distribuent les données sur plusieurs instances. Cette architecture offre évolutivité et tolérance aux pannes sans interruption de service. Si le cluster principal tombe en panne, d'autres clusters Kafka peuvent fournir les mêmes services, garantissant ainsi une haute disponibilité.

L'architecture du cluster Kafka comprend des sujets, des courtiers, ZooKeeper, des producteurs et des consommateurs. Il gère efficacement les flux de données pour les applications Big Data, permettant ainsi la création d'applications robustes basées sur les données.

35. Quels problèmes Apache Airflow permet-il de résoudre ?

Apache Airflow vous permet de gérer et de planifier des pipelines pour les workflows analytiques, la gestion des entrepôts de données, ainsi que la transformation et la modélisation des données. Il prévoit :

- Gestion des pipelines : Une plateforme permettant de définir, planifier et surveiller les flux de travail.

- Journalisation centralisée : Surveillez les journaux d'exécution à partir d'un seul endroit.

- Gestion des erreurs : Callbacks pour envoyer des alertes d'échec à des plateformes de communication telles que Slack et Discord.

- Interface utilisateur : Une interface utilisateur conviviale pour gérer et visualiser les flux de travail.

- Intégration : Intégrations solides avec divers outils et systèmes.

- Open source : Son utilisation est gratuite et largement soutenue par la communauté.

Questions d'entretien pour le poste d'ingénieur de données chez Amazon

36. Une adresse IP vous est fournie en tant qu'entrée sous forme de chaîne. Comment pourriez-vous déterminer si une adresse IP est valide ou non ?

Pour déterminer la validité d'une adresse IP, vous pouvez diviser la chaîne au niveau du « . » et créer plusieurs vérifications pour valider chaque segment. Voici une fonction Python permettant d'atteindre cet objectif :

def is_valid(ip):

ip = ip.split(".")

for i in ip:

if len(i) > 3 or int(i) < 0 or int(i) > 255:

return False

if len(i) > 1 and int(i) == 0:

return False

if len(i) > 1 and int(i) != 0 and i[0] == '0':

return False

return True

A = "255.255.11.135"

B = "255.050.11.5345"

print(is_valid(A)) # True

print(is_valid(B)) # False37. Quels sont les différents modes disponibles dans Hadoop ?

Hadoop fonctionne principalement selon trois modes :

- Mode autonome : Ce mode est utilisé à des fins de débogage. Il n'utilise pas HDFS et s'appuie sur le système de fichiers local pour les entrées et les sorties.

- Mode pseudo-distribué : Il s'agit d'un cluster à nœud unique dans lequel le NameNode et le DataNode résident sur la même machine. Il est principalement utilisé à des fins de test et de développement.

- Mode entièrement distribué : Il s'agit d'un mode prêt pour la production dans lequel les données sont réparties sur plusieurs nœuds, avec des nœuds distincts pour les démons maître (NameNode) et esclave (DataNode).

Questions d'entretien pour le poste d'ingénieur de données chez Google

38. Comment traiteriez-vous les données en double dans une requête SQL ?

Pour gérer les doublons dans SQL, vous pouvez utiliser le mot-clé « DISTINCT » ou supprimer les lignes en double à l'aide de « ROWID » avec la fonction « MAX » ou « MIN ». Voici quelques exemples :

Utilisation d'DISTINCT:

SELECT DISTINCT Name, ADDRESS

FROM CUSTOMERS

ORDER BY Name;Suppression des doublons à l'aide d'ROWID:

DELETE FROM Employee

WHERE ROWID NOT IN (

SELECT MAX(ROWID)

FROM Employee

GROUP BY Name, ADDRESS

);39. Étant donné une liste de n-1 nombres entiers, ces nombres sont compris entre 1 et n. Il n'y a pas de doublons dans la liste. L'un des nombres entiers est absent de la liste. Pourriez-vous rédiger un code efficace pour déterminer l'entier manquant ?

Ce défi de codage courant peut être résolu à l'aide d'une approche mathématique :

def search_missing_number(list_num):

n = len(list_num)

# Check if the first or last number is missing

if list_num[0] != 1:

return 1

if list_num[-1] != n + 1:

return n + 1

# Calculate the sum of the first n+1 natural numbers

total = (n + 1) * (n + 2) // 2

# Calculate the sum of all elements in the list

sum_of_L = sum(list_num)

# Return the difference, which is the missing number

return total - sum_of_L

# Validation

num_list = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 13]

print("The missing number is", search_missing_number(num_list)) # The missing number is 12Comment se préparer à un entretien pour un poste d'ingénieur de données

Avant de vous présenter à un entretien, il est recommandé de revoir tous les concepts et termes standard utilisés dans le domaine de l'ingénierie des données. Voici quelques-uns des domaines les plus importants sur lesquels il convient de se concentrer :

- Maîtrisez SQL : Il est recommandé de vous exercer à créer, modifier et gérer des bases de données. De plus, il est important de maîtriser l'analyse, la modélisation et la transformation des données.

- Résolvez des défis de codage : Résolvez des défis de codage en Python, Scala ou C++. La plupart des entreprises évaluent les compétences en programmation en proposant des examens à domicile et des défis de codage en direct.

- Concevez un pipeline ETL : pratiquez la création de pipelines de données, ETL ou de livraison. Il est essentiel de comprendre comment tester, valider, dimensionner et maintenir les pipelines de données.

- Ingénierie analytique : pratique du chargement, de la transformation et de l'analyse des données. Apprenez à créer un tableau de bord pour la qualité des données et les performances du système.

- Veuillez examiner les questions potentielles : Préparez-vous à l'entretien en passant en revue des exemples de questions types. Une simple recherche sur Google vous permettra d'accéder à des centaines de questions.

- Découvrez les outils modernes d'ingénierie des données : même si vous n'avez pas d'expérience avec ces outils, il est important de comprendre leur fonctionnement et leur intégration avec d'autres outils. Les entreprises sont constamment à la recherche de meilleurs outils pour améliorer leurs performances à moindre coût.

- Apprenez le traitement par lots et le streaming : Apache Spark est utilisé pour le traitement par lots, tandis qu'Apache Kafka est utilisé pour le streaming de données. Ces compétences sont très recherchées et vous aideront à obtenir un poste dans les meilleures entreprises.

- Environnement : Parfois, le recruteur posera des questions sur le cloud computing (GCP, AWS, Azure), Docker, les scripts, Terraform et Kubernetes. Vous pouvez utiliser ces outils pour configurer des ressources informatiques et de stockage dans le cloud ou sur site. Il est recommandé de bien comprendre ces technologies et de les intégrer dans les projets du portefeuille.

Se préparer à un entretien d'embauche dans le domaine de l'ingénierie des données peut s'avérer difficile, mais avec les bonnes ressources et de la pratique, vous pouvez exceller et décrocher l'emploi de vos rêves. Pour approfondir vos compétences et vos connaissances, veuillez consulter ces ressources utiles :

- Comprendre l'ingénierie des données: Acquérir une compréhension approfondie des concepts et principes de l'ingénierie des données.

- Ingénieur de données en Python: Maîtrisez l'ingénierie des données avec Python grâce à ce cursus professionnel, qui couvre les outils et les cadres essentiels.

- Conception de bases de données: Apprenez les principes fondamentaux de la conception de bases de données afin de créer des bases de données efficaces et évolutives.

Profitez de ces cours pour consolider vos bases et rester à la pointe dans votre carrière d'ingénieur de données. Nous vous souhaitons bonne chance pour vos entretiens.

Devenez ingénieur en données

Questions fréquentes

À quoi puis-je m'attendre lors d'un entretien pour un poste d'ingénieur de données ?

Vous pouvez vous attendre à un entretien téléphonique avec les ressources humaines, un entretien téléphonique technique, un examen à faire chez vous, un défi de codage, un entretien sur place, une conception de base de données et de systèmes sur tableau blanc, un entretien SQL et, enfin, un entretien « exécutif » visant à vérifier votre adéquation avec la culture de l'entreprise.

Certaines entreprises ont trois étapes d'entretiens, tandis que d'autres en ont jusqu'à neuf. Les organisations ont souvent des critères d'admission élevés pour évaluer les candidats à tous les niveaux.

Les ingénieurs de données sont-ils recherchés ?

Oui, toute entreprise qui génère des données a besoin d'ingénieurs de données pour créer des pipelines, gérer et fournir des données à divers services. D'ici 2025, nous produirons 463 exaoctets de données par jour et nous aurons besoin d'un nombre croissant d'ingénieurs pour extraire, transformer et gérer les pipelines et les systèmes de données - weforum.org.

Les ingénieurs de données écrivent-ils du code ?

Oui, toute personne travaillant dans le domaine informatique doit apprendre à coder, même au niveau managérial. Pour les ingénieurs de données, Python, SQL, Docker, Yaml et Bash sont des langages de programmation indispensables. Ils sont utilisés dans les infrastructures en tant que code, pipelines, gestion de bases de données, streaming, web scraping, traitement de données, modélisation et analyse.

Quelle est la différence entre un analyste de données et un ingénieur de données ?

L'ingénieur de données collecte, transforme et prépare les données afin que les analystes de données puissent en extraire des informations commerciales précieuses. Les ingénieurs de données gèrent l'ensemble des systèmes de bases de données et veillent à ce qu'ils fournissent des données de haute qualité pour les tâches d'analyse de données telles que les rapports analytiques, les tableaux de bord, les études de clientèle et les prévisions.

En quoi consiste réellement le travail d'un ingénieur de données ?

Collecter des données provenant de multiples sources, créer, valider et maintenir des pipelines de données, transformer les données à l'aide d'algorithmes, effectuer des travaux d'ingénierie analytique, garantir la conformité avec la gouvernance et la sécurité des données, et maintenir l'ensemble des systèmes de bases de données. Ils sont chargés de fournir des flux de données de haute qualité à divers services d'une entreprise. Vous pouvez en apprendre davantage sur l'ingénierie des données en lisant Qu'est-ce que l'ingénierie des données ? blog.

Quelles compétences sont nécessaires pour devenir ingénieur de données ?

Il est nécessaire de maîtriser le codage, le stockage de données, l'ETL (Extract Transform Load), les requêtes SQL, l'analyse et la modélisation de données, les aspects critiques et les compétences en communication. L'ingénierie des données s'acquiert par l'expérience et en surmontant des défis complexes sur le terrain. Notre certification en ingénierie des données est l'initiative idéale pour développer vos compétences et décrocher un poste d'ingénieur de données.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.