Cours

Alors que la technologie de l'apprentissage automatique progresse à un rythme sans précédent, les autoencodeurs variationnels (VAE) révolutionnent la façon dont nous traitons et générons les données. En combinant un encodage de données puissant avec des capacités génératives innovantes, les VAE offrent des solutions transformatrices pour relever des défis complexes sur le terrain.

Dans cet article, nous allons explorer les concepts fondamentaux des VAE, leurs applications et la manière dont elles peuvent être mises en œuvre efficacement à l'aide de PyTorch, étape par étape.

Qu'est-ce qu'un autoencodeur variationnel ?

Les autoencodeurs sont un type de réseau neuronal conçu pour apprendre des représentations de données efficaces, principalement à des fins de réduction de la dimensionnalité ou d'apprentissage de caractéristiques.

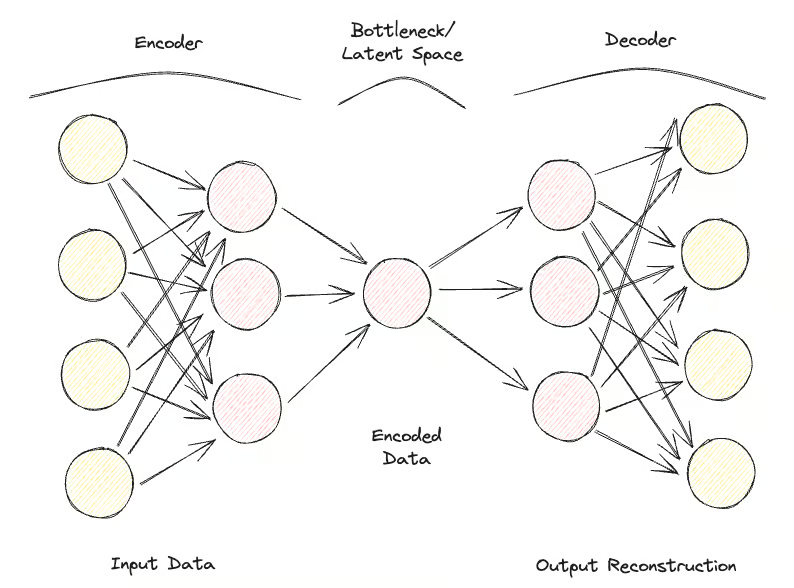

Les autoencodeurs se composent de deux parties principales :

- Le codeur: Comprime les données d'entrée dans un espace latent de dimension inférieure.

- Le décodeur: Reconstruit les données originales à partir de cette représentation compressée.

L'objectif principal des autoencodeurs est de minimiser la différence entre l'entrée et la sortie reconstruite, en apprenant ainsi une représentation compacte des données.

Les autoencodeurs variationnels (VAE) étendent les capacités du cadre traditionnel des autoencodeurs en incorporant des éléments probabilistes dans le processus d'encodage.

Alors que les autoencodeurs standard associent les entrées à des représentations latentes fixes, les VAE introduisent une approche probabiliste dans laquelle l'encodeur émet une distribution sur l'espace latent, généralement modélisée sous la forme d'une gaussienne multivariée. Cela permet aux VAE d'échantillonner cette distribution au cours du processus de décodage, ce qui conduit à la génération de nouvelles instances de données.

La principale innovation des VAE réside dans leur capacité à générer de nouvelles données de haute qualité en apprenant un espace latent structuré et continu. Ceci est particulièrement important pour la modélisation générative, où l'objectif n'est pas seulement de compresser les données mais de créer de nouveaux échantillons de données qui ressemblent à l'ensemble de données d'origine.

Les VAE ont démontré une efficacité significative dans des tâches telles que la synthèse d'images, le débruitage de données et la détection d'anomalies, ce qui en fait des outils pertinents pour améliorer les capacités des modèles et des applications d'apprentissage automatique.

Autoencodeurs variationnels Contexte théorique

Dans cette section, nous présenterons le contexte théorique et les mécanismes opérationnels des VAE, ce qui vous fournira une base solide pour explorer leurs applications dans les sections suivantes.

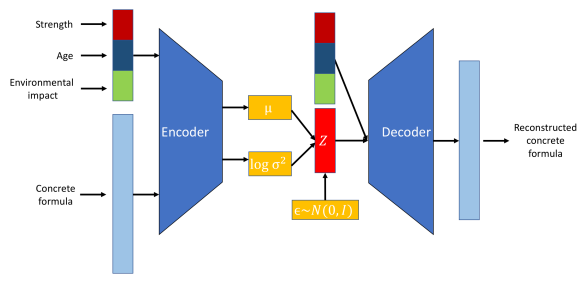

Commençons par les codeurs. L'encodeur est un réseau neuronal chargé de mettre en correspondance les données d'entrée avec un espace latent. Contrairement aux autoencodeurs traditionnels qui produisent un point fixe dans l'espace latent, l'encodeur d'une VAE produit les paramètres d'une distribution de probabilité, généralement la moyenne et la variance d'une distribution gaussienne. Cela permet à la VAE de modéliser efficacement l'incertitude et la variabilité des données.

Un autre réseau neuronal, appelé décodeur, est utilisé pour reconstruire les données originales à partir de la représentation de l'espace latent. Étant donné un échantillon de la distribution de l'espace latent, le décodeur vise à générer une sortie qui ressemble étroitement aux données d'entrée originales. Ce processus permet à la VAE de créer de nouvelles instances de données en échantillonnant la distribution apprise.

L'espace latent est un espace continu de dimension inférieure dans lequel les données d'entrée sont encodées.

Visualisation du rôle du codeur, du décodeur et de l'espace latent. Source de l'image.

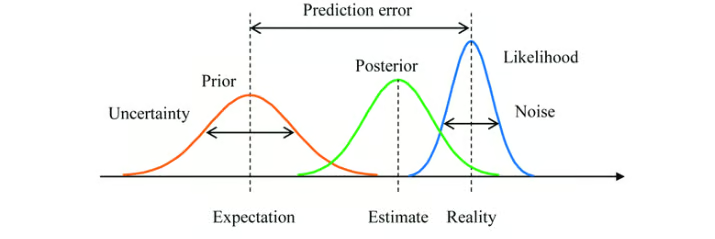

L'approche variationnelle est une technique utilisée pour approximer des distributions de probabilité complexes. Dans le contexte des VAE, il s'agit d'approximer la véritable distribution postérieure des variables latentes en fonction des données, ce qui est souvent difficile à réaliser.

La VAE apprend une distribution postérieure approximative. L'objectif est de faire en sorte que cette approximation soit aussi proche que possible de la véritable valeur postérieure.

L'inférence bayésienne est une méthode qui permet d'actualiser l'estimation de la probabilité d'une hypothèse au fur et à mesure que de nouvelles preuves ou informations sont disponibles. Dans les VAE, l'inférence bayésienne est utilisée pour estimer la distribution des variables latentes.

En intégrant les connaissances antérieures (distribution antérieure) aux données observées (vraisemblance), les VAE ajustent la représentation de l'espace latent par le biais de la distribution postérieure apprise.

Inférence bayésienne avec une distribution préalable, une distribution postérieure et une fonction de vraisemblance. Source de l'image.

Voici à quoi ressemble le déroulement de la procédure :

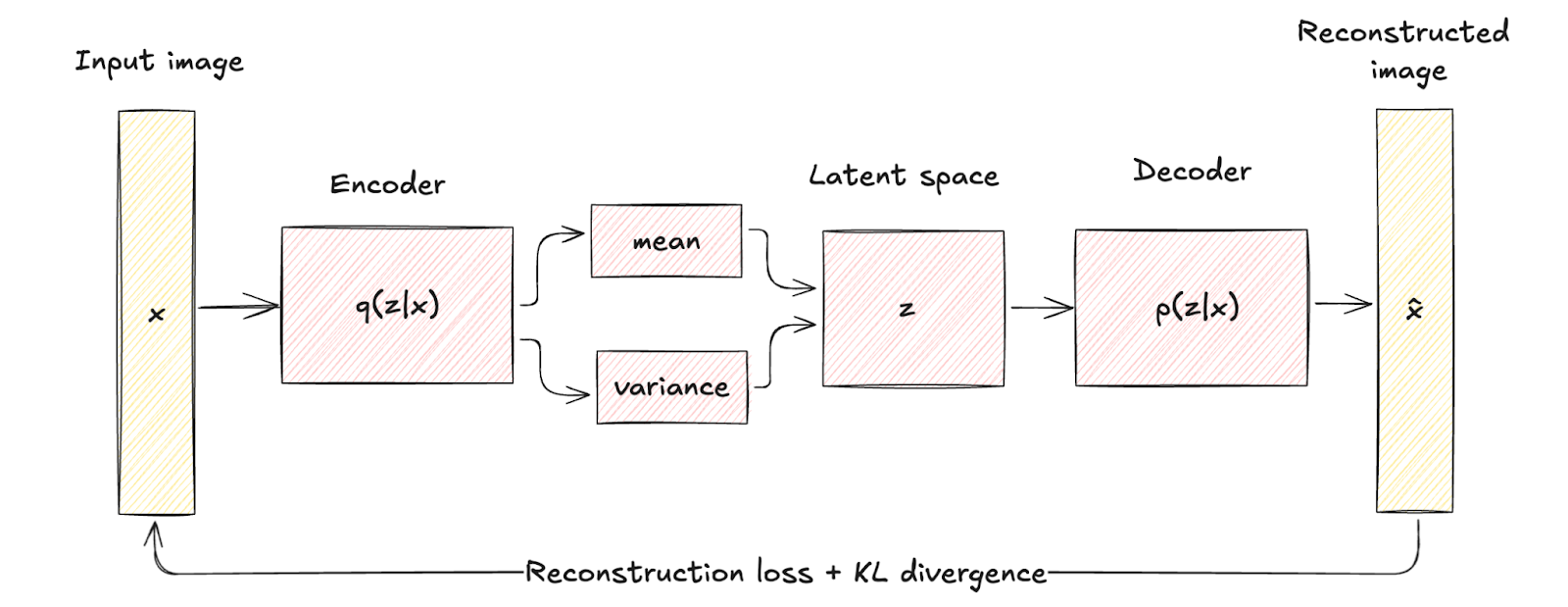

- Les données d'entrée x sont introduites dans le codeur, qui émet les paramètres de la distribution de l'espace latent q(z∣x) (moyenne μ et variance σ2).

- Variables latentes z sont échantillonnées à partir de la distribution q(z∣x) en utilisant des techniques telles que l'astuce de reparamétrage.

- L'échantillon de z passe par le décodeur pour produire les données reconstruites x̂qui doivent être similaires à l'entrée originale x.

Autoencodeur variationnel vs autoencodeur traditionnel

Examinons les différences et les avantages des VAE par rapport aux autoencodeurs traditionnels.

Comparaison des architectures

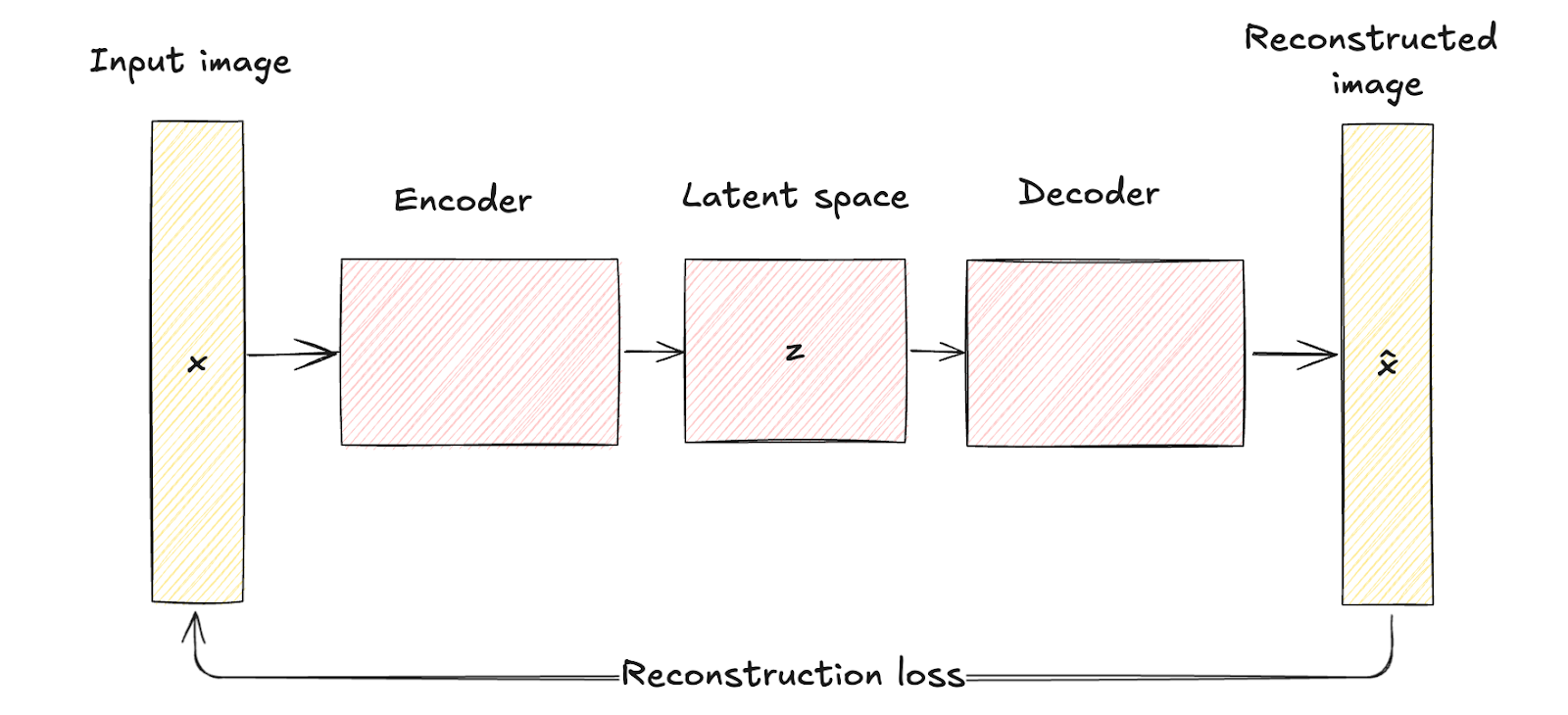

Comme nous l'avons vu précédemment, les autoencodeurs traditionnels se composent d'un réseau d'encodage qui fait correspondre les données d'entrée x à une représentation fixe de l'espace latent de dimension inférieure z. Ce processus est déterministe, ce qui signifie que chaque entrée est codée en un point spécifique de l'espace latent.

Le réseau décodeur reconstruit ensuite les données originales à partir de cette représentation latente fixe, en cherchant à minimiser la différence entre l'entrée et sa reconstruction.

L'espace latent des autoencodeurs traditionnels est une représentation comprimée des données d'entrée sans aucune modélisation probabiliste, ce qui limite leur capacité à générer des données nouvelles et diverses puisqu'ils ne disposent pas d'un mécanisme pour gérer l'incertitude.

Architecture de l'autoencodeur. Image de l'auteur

Les VAE introduisent un élément probabiliste dans le processus d'encodage. Le codeur d'une VAE fait correspondre les données d'entrée à une distribution de probabilité sur les variables latentes, généralement modélisée comme une distribution gaussienne avec moyenne. μ et une variance σ2.

Cette approche encode chaque entrée dans une distribution plutôt que dans un point unique, ce qui ajoute une couche de variabilité et d'incertitude.

Les différences architecturales sont représentées visuellement par le mappage déterministe des autoencodeurs traditionnels par rapport à l'encodage et à l'échantillonnage probabilistes des VAE.

Cette différence structurelle met en évidence la manière dont les VAE intègrent la régularisation par le biais d'un terme connu sous le nom de divergence KL, en façonnant l'espace latent de manière à ce qu'il soit continu et bien structuré.

La régularisation introduite améliore considérablement la qualité et la cohérence des échantillons générés, surpassant les capacités des autoencodeurs traditionnels.

Architecture de l'autoencodeur variationnel. Image de l'auteur

Comparaison des applications

La nature probabiliste des VAE élargit considérablement leur champ d'application par rapport à celui des autoencodeurs traditionnels. En revanche, les autoencodeurs traditionnels sont très efficaces dans les applications où une représentation déterministe des données est suffisante.

Examinons quelques applications de chacune d'entre elles pour mieux comprendre ce point.

Applications des VAE

- Modélisation générative. Le principal avantage des VAE réside dans leur capacité à générer de nouveaux échantillons de données qui sont similaires aux données d'apprentissage, mais qui ne sont pas identiques à une instance spécifique. Par exemple, dans la synthèse d'images, les VAE peuvent créer de nouvelles images qui ressemblent à l'ensemble d'apprentissage mais avec des variations, ce qui les rend utiles pour des tâches telles que la création de nouvelles œuvres d'art, la génération de visages réalistes ou la production de nouveaux designs dans les domaines de la mode et de l'architecture.

- Détection des anomalies. En apprenant la distribution des données normales, les VAE peuvent identifier les écarts par rapport à cette distribution comme des anomalies. Ceci est particulièrement utile dans des applications telles que la détection des fraudes, la sécurité des réseaux et la maintenance prédictive.

- Imputation et débruitage des données. L'un des points forts de la VAE est de reconstruire des données avec des parties manquantes ou bruyantes. En échantillonnant la distribution latente apprise, ils sont capables de prédire et de compléter les valeurs manquantes ou d'éliminer le bruit des données corrompues. Ils sont donc précieux dans des applications telles que l'imagerie médicale, où une reconstruction précise des données est essentielle, ou pour restaurer des données audio et visuelles corrompues.

- Apprentissage semi-supervisé. Dans les scénarios d'apprentissage semi-supervisé, les VAE peuvent améliorer les performances du classificateur en utilisant l'espace latent pour capturer les structures de données sous-jacentes, améliorant ainsi le processus d'apprentissage avec des données étiquetées limitées.

- Manipulation de l'espace latent. Les VAE fournissent un espace latent structuré et continu qui peut être manipulé pour diverses applications. Par exemple, dans l'édition d'images, des caractéristiques spécifiques (comme l'éclairage ou les expressions faciales) peuvent être ajustées en naviguant dans l'espace latent. Cette fonction est particulièrement utile dans les industries créatives pour modifier et améliorer les images et les vidéos.

Applications des autoencodeurs traditionnels

- Réduction de la dimensionnalité. Les autoencodeurs traditionnels sont largement utilisés pour réduire la dimensionnalité des données. En encodant les données dans un espace latent de dimension inférieure, puis en les reconstruisant, ils peuvent capturer les caractéristiques les plus importantes des données. Ceci est utile dans des scénarios tels que la visualisation de données, où les données à haute dimension doivent être projetées en deux ou trois dimensions, et dans les étapes de prétraitement pour d'autres modèles d'apprentissage automatique afin d'améliorer les performances et de réduire les coûts de calcul.

- Extraction de caractéristiques. En formant l'encodeur à capturer les aspects essentiels des données d'entrée, les représentations latentes peuvent être utilisées comme vecteurs de caractéristiques compacts pour des tâches en aval telles que la classification, le regroupement et la régression. Ceci est particulièrement utile dans des applications telles que la reconnaissance d'images, où l'espace latent peut révéler des modèles visuels importants.

- Le débruitage. Les autoencodeurs traditionnels sont efficaces pour débruiter les données en apprenant à reconstruire des entrées propres à partir de versions bruitées. Cette application est précieuse dans des scénarios tels que le traitement d'images, où l'élimination du bruit des images peut améliorer la qualité visuelle, et le traitement des signaux, où elle peut améliorer la clarté des signaux audio.

- Compression des données. Les vecteurs latents compacts peuvent être stockés ou transmis plus efficacement que les données originales à haute dimension, et le décodeur peut reconstruire les données en cas de besoin. Ceci est particulièrement utile dans des applications telles que la compression d'images et de vidéos.

- Reconstruction et repeintures d'images. Les autoencodeurs traditionnels peuvent être utilisés pour reconstruire les parties manquantes des images. Dans l'inpainting d'images, l'autoencodeur est entraîné à remplir les régions manquantes ou corrompues d'une image sur la base du contexte fourni par les pixels environnants. Ceci est utile dans des domaines tels que la vision par ordinateur et la restauration numérique.

- Apprentissage par séquences. Les autoencodeurs peuvent être adaptés pour travailler avec des données séquentielles en utilisant des couches récurrentes ou convolutives. Ils peuvent capturer des dépendances et des modèles temporels, ce qui les rend utiles pour des applications telles que la génération de texte, la synthèse vocale et les prévisions financières.

Types d'autoencodeurs variationnels

Les VAE ont évolué vers diverses formes spécialisées pour répondre aux différents défis et applications de l'apprentissage automatique. Dans cette section, nous examinerons les types les plus importants, en soulignant les cas d'utilisation, les avantages et les limites.

Autoencodeur variationnel conditionnel

Les autoencodeurs variationnels conditionnels (CVAE) sont une forme spécialisée de VAE qui améliore le processus génératif en conditionnant des informations supplémentaires.

Une VAE devient conditionnelle en incorporant des informations supplémentaires, désignées par c, dans les réseaux du codeur et du décodeur. Ces informations de conditionnement peuvent être des données pertinentes, telles que des étiquettes de classe, des attributs ou d'autres données contextuelles.

Structure du modèle CVAE. Source de l'image.

Les cas d'utilisation des CVAE sont les suivants

- Génération de données contrôlées. Par exemple, dans la génération d'images, un CVAE peut créer des images d'objets ou de scènes spécifiques sur la base d'étiquettes ou de descriptions données.

- Traduction d'image à image. Les CVAE peuvent transformer des images d'un domaine à l'autre tout en conservant des attributs spécifiques. Par exemple, ils peuvent être utilisés pour convertir des images en noir et blanc en images en couleur ou pour convertir des croquis en photos réalistes.

- Génération de texte. Les CVAE peuvent générer du texte conditionné par des invites ou des sujets spécifiques, ce qui les rend utiles pour des tâches telles que la génération d'histoires, les réponses des chatbots et la création de contenu personnalisé.

Les avantages et les inconvénients sont les suivants :

- Contrôle plus fin des données générées

- Amélioration de l'apprentissage de la représentation

- Risque accru de surajustement

Autres variantes

Autoencodeurs variationnels démêlés, souvent appelés Beta-VAE, sont un autre type de VAE spécialisés. Ils visent à apprendre des représentations latentes où chaque dimension capture un facteur de variation distinct et interprétable dans les données. Pour ce faire, l'objectif original de la VAE est modifié par un hyperparamètre β qui équilibre la perte de reconstruction et le terme de divergence KL.

Avantages et inconvénients des bêta-VAE :

- Amélioration de l'interprétabilité des facteurs latents.

- Amélioration de la capacité à manipuler les caractéristiques individuelles des données générées.

- Nécessite un réglage minutieux du paramètreβ.

- La qualité de la reconstruction peut être moins bonne si l'équilibre entre les termes n'est pas optimal.

Une autre variante des VAE est l'Autoencodeur Adversarial (AAEs). Les AAE combinent le cadre de la VAE avec les principes de formation contradictoire des réseaux adversoriels génératifs (GAN). Un réseau discriminant supplémentaire garantit que les représentations latentes correspondent à une distribution préalable, améliorant ainsi les capacités génératives du modèle.

Avantages et inconvénients des AAE :

- Produit des échantillons de données réalistes et de haute qualité.

- Efficace pour régulariser l'espace latent.

- Complexité accrue de la formation en raison de la composante contradictoire.

- Problèmes potentiels de stabilité de la formation, similaires à ceux des GAN.

Nous allons maintenant examiner deux autres extensions des autoencodeurs variationnels.

La première est celle des autoencodeurs récurrents variationnels (VRAE). Les VRAE étendent le cadre de la VAE aux données séquentielles en incorporant des réseaux neuronaux récurrents (RNN) dans les réseaux de codage et de décodage. Cela permet aux VRAE de saisir les dépendances temporelles et de modéliser des modèles séquentiels.

Avantages et inconvénients des VRAE :

- Efficace dans le traitement des données chronologiques et des modèles séquentiels.

- Utile dans des applications telles que la synthèse vocale, la génération de musique et la prévision de séries temporelles.

- Exigences de calcul plus élevées en raison de la nature récurrente du modèle.

La dernière variante que nous examinerons est la variante autoencodeurs variationnels hiérarchiques (HVAE). Les HVAE introduisent plusieurs couches de variables latentes disposées selon une structure hiérarchique, ce qui permet au modèle de saisir des dépendances et des abstractions plus complexes dans les données.

Avantages et inconvénients des HVAE :

- Capable de modéliser des distributions de données complexes avec des structures hiérarchiques.

- Fournit des représentations latentes plus expressives.

- Augmentation de la complexité du modèle et des coûts de calcul.

Implémentation d'un autoencodeur variationnel avec PyTorch

Dans cette section, nous allons mettre en œuvre un simple autoencodeur variationnel (VAE) à l'aide de PyTorch.

1. Mise en place de l'environnement

Pour mettre en œuvre une VAE, nous devons configurer notre environnement Python avec les bibliothèques et les outils nécessaires. Les bibliothèques que nous utiliserons sont les suivantes :

- PyTorch

- torchvision

- matplotlib

- numpy

Voici le code pour installer ces bibliothèques :

pip install torch torchvision matplotlib numpy2. Mise en œuvre

Découvrons étape par étape la mise en œuvre d'une VAE. Tout d'abord, nous devons importer les bibliothèques :

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

import matplotlib.pyplot as plt

import numpy as npEnsuite, il faut définir le codeur, le décodeur et la VAE. Voici le code :

class Encoder(nn.Module):

def __init__(self, input_dim, hidden_dim, latent_dim):

super(Encoder, self).__init__()

self.fc1 = nn.Linear(input_dim, hidden_dim)

self.fc_mu = nn.Linear(hidden_dim, latent_dim)

self.fc_logvar = nn.Linear(hidden_dim, latent_dim)

def forward(self, x):

h = torch.relu(self.fc1(x))

mu = self.fc_mu(h)

logvar = self.fc_logvar(h)

return mu, logvar

class Decoder(nn.Module):

def __init__(self, latent_dim, hidden_dim, output_dim):

super(Decoder, self).__init__()

self.fc1 = nn.Linear(latent_dim, hidden_dim)

self.fc2 = nn.Linear(hidden_dim, output_dim)

def forward(self, z):

h = torch.relu(self.fc1(z))

x_hat = torch.sigmoid(self.fc2(h))

return x_hat

class VAE(nn.Module):

def __init__(self, input_dim, hidden_dim, latent_dim):

super(VAE, self).__init__()

self.encoder = Encoder(input_dim, hidden_dim, latent_dim)

self.decoder = Decoder(latent_dim, hidden_dim, input_dim)

def forward(self, x):

mu, logvar = self.encoder(x)

std = torch.exp(0.5 * logvar)

eps = torch.randn_like(std)

z = mu + eps * std

x_hat = self.decoder(z)

return x_hat, mu, logvarNous devons également définir la fonction de perte. La fonction de perte pour les VAE se compose d'une perte de reconstruction et d'une perte de divergence KL. Voici à quoi cela ressemble dans PyTorch :

def loss_function(x, x_hat, mu, logvar):

BCE = nn.functional.binary_cross_entropy(x_hat, x, reduction='sum')

KLD = -0.5 * torch.sum(1 + logvar - mu.pow(2) - logvar.exp())

return BCE + KLDPour entraîner la VAE, nous chargerons l'ensemble de données MNIST, définirons l'optimiseur et entraînerons le modèle.

# Hyperparameters

input_dim = 784

hidden_dim = 400

latent_dim = 20

lr = 1e-3

batch_size = 128

epochs = 10

# Data loader

transform = transforms.Compose([transforms.ToTensor(), transforms.Lambda(lambda x: x.view(-1))])

train_dataset = datasets.MNIST(root='./data', train=True, transform=transform, download=True)

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

# Model, optimizer

vae = VAE(input_dim, hidden_dim, latent_dim)

optimizer = optim.Adam(vae.parameters(), lr=lr)

# Training loop

vae.train()

for epoch in range(epochs):

train_loss = 0

for x, _ in train_loader:

x = x.view(-1, input_dim)

optimizer.zero_grad()

x_hat, mu, logvar = vae(x)

loss = loss_function(x, x_hat, mu, logvar)

loss.backward()

train_loss += loss.item()

optimizer.step()

print(f"Epoch {epoch + 1}, Loss: {train_loss / len(train_loader.dataset)}")3. Test et évaluation du modèle

Après l'entraînement, nous pouvons évaluer la VAE en visualisant les sorties reconstruites et les échantillons générés.

Voici le code :

# visualizing reconstructed outputs

vae.eval()

with torch.no_grad():

x, _ = next(iter(train_loader))

x = x.view(-1, input_dim)

x_hat, _, _ = vae(x)

x = x.view(-1, 28, 28)

x_hat = x_hat.view(-1, 28, 28)

fig, axs = plt.subplots(2, 10, figsize=(15, 3))

for i in range(10):

axs[0, i].imshow(x[i].cpu().numpy(), cmap='gray')

axs[1, i].imshow(x_hat[i].cpu().numpy(), cmap='gray')

axs[0, i].axis('off')

axs[1, i].axis('off')

plt.show()

#visualizing generated samples

with torch.no_grad():

z = torch.randn(10, latent_dim)

sample = vae.decoder(z)

sample = sample.view(-1, 28, 28)

fig, axs = plt.subplots(1, 10, figsize=(15, 3))

for i in range(10):

axs[i].imshow(sample[i].cpu().numpy(), cmap='gray')

axs[i].axis('off')

plt.show()

Visualisation des résultats. La ligne du haut représente les données MNIST originales, la ligne du milieu les sorties reconstruites et la dernière ligne les échantillons générés - image de l'auteur.

Autoencodeurs variationnels Défis et solutions

Bien que les autoencodeurs variationnels (VAE) soient des outils puissants pour la modélisation générative, ils présentent plusieurs défis et limitations qui peuvent affecter leurs performances. Examinons certains d'entre eux et proposons des stratégies d'atténuation.

Effondrement du mode

Il s'agit d'un phénomène où la VAE ne parvient pas à capturer toute la diversité de la distribution des données. Il en résulte des échantillons générés qui ne représentent que quelques modes (régions distinctes) de la distribution des données, tout en ignorant les autres. Il en résulte un manque de variété dans les résultats générés.

Effondrement du mode causé par :

- Mauvaise exploration de l'espace latent : Si l'espace latent n'est pas exploré de manière adéquate pendant la formation, le modèle pourrait n'apprendre à générer des échantillons qu'à partir de quelques régions.

- Données de formation insuffisantes : Des données d'entraînement limitées ou non représentatives peuvent entraîner une suradaptation du modèle à des modes spécifiques.

L'effondrement du mode peut être atténué en utilisant :

- Techniques de régularisation : L'utilisation de techniques telles que l'exclusion et la normalisation des lots peut contribuer à améliorer la généralisation et à réduire l'effondrement des modes.

- Algorithmes de formation améliorés : Les autoencodeurs à pondération importante (IWAE) peuvent fournir de meilleures estimations du gradient et améliorer l'exploration de l'espace latent.

Espaces latents non informatifs

Dans certains cas, l'espace latent appris par une VAE peut devenir non informatif, lorsque le modèle n'utilise pas efficacement les variables latentes pour capturer des caractéristiques significatives des données d'entrée. Cela peut entraîner une mauvaise qualité des échantillons générés et des reconstructions.

Cela se produit généralement pour les raisons suivantes :

- Composants de perte déséquilibrés : Le compromis entre la perte de reconstruction et la divergence KL peut ne pas être bien équilibré, ce qui conduit à ignorer les variables latentes.

- Effondrement postérieur : Le codeur apprend à produire une distribution postérieure très proche de la distribution antérieure, ce qui entraîne une perte d'informations dans l'espace latent.

Les espaces latents non informatifs peuvent être corrigés en tirant parti de la stratégie d'échauffement, qui consiste à augmenter progressivement le poids de la divergence KL au cours de l'apprentissage, ou en modifiant directement le poids du terme de divergence KL dans la fonction de perte.

Instabilité de la formation

Les VAE de formation peuvent parfois être instables, la fonction de perte oscillant ou divergeant. Cela peut rendre difficile la convergence et l'obtention d'un modèle bien entraîné.

La raison en est la suivante :

- Un paysage de pertes complexe : La fonction de perte VAE combine des termes de reconstruction et de régularisation, ce qui conduit à un paysage d'optimisation complexe.

- Sensibilité des hyperparamètres : Les VAE sont sensibles au choix des hyperparamètres, tels que le taux d'apprentissage, le poids de la divergence KL et l'architecture des réseaux neuronaux.

Les mesures visant à atténuer l'instabilité de la formation consistent soit à utiliser :

- Réglage minutieux des hyperparamètres : L'exploration systématique des hyperparamètres peut aider à trouver des configurations stables pour la formation.

- Optimiseurs avancés : L'utilisation d'optimiseurs de taux d'apprentissage adaptatifs comme Adam peut aider à naviguer plus efficacement dans le paysage complexe des pertes.

Coûts de calcul

L'entraînement des VAE, en particulier avec des ensembles de données complexes et de grande taille, peut être coûteux en termes de calcul. Cela s'explique par la nécessité de procéder à un échantillonnage et à une rétropropagation à travers des couches stochastiques.

Les causes des coûts de calcul élevés sont les suivantes :

- Grands réseaux : Les réseaux de codage et de décodage peuvent devenir vastes et profonds, ce qui augmente la charge de calcul.

- Échantillonnage de l'espace latent : L'échantillonnage de l'espace latent et le calcul des gradients à travers ces échantillons peuvent augmenter le coût de calcul.

Il s'agit de quelques mesures d'atténuation :

- Simplification du modèle : La réduction de la complexité des réseaux de codage et de décodage peut contribuer à réduire les coûts de calcul.

- Techniques d'échantillonnage efficaces : L'utilisation de méthodes d'échantillonnage ou d'approximations plus efficaces peut réduire la charge de calcul.

Conclusion

Les autoencodeurs variationnels (VAE) se sont révélés être une avancée révolutionnaire dans le domaine de l'apprentissage automatique et de la génération de données.

En introduisant des éléments probabilistes dans le cadre traditionnel de l'autoencodeur, les VAE permettent de générer de nouvelles données de haute qualité et fournissent un espace latent plus structuré et plus continu. Cette capacité unique a ouvert la voie à un large éventail d'applications, allant de la modélisation générative et de la détection d'anomalies à l'imputation de données et à l'apprentissage semi-supervisé.

Dans cet article, nous avons abordé les principes fondamentaux des autoencodeurs variationnels, les différents types, la manière d'implémenter les VAE dans PyTorch, ainsi que les défis et les solutions lorsque vous travaillez avec des VAE.

Consultez ces ressources pour poursuivre votre apprentissage :

FAQ

Quelle est la différence entre un autoencodeur et un autoencodeur variationnel ?

Un autoencodeur est un réseau neuronal qui comprime les données d'entrée dans un espace latent de dimension inférieure, puis les reconstruit en faisant correspondre chaque entrée à un point fixe de cet espace de manière déterministe. Un autoencodeur variationnel (VAE) étend ce principe en codant les entrées dans une distribution de probabilité, généralement gaussienne, sur l'espace latent. Cette approche probabiliste permet aux VAE d'échantillonner la distribution latente, ce qui permet de générer de nouvelles instances de données diverses et de mieux modéliser la variabilité des données.

À quoi servent les VAE ?

Les autoencodeurs variationnels (VAE) sont utilisés pour générer de nouveaux échantillons de données de haute qualité, ce qui les rend précieux dans des applications telles que la synthèse d'images et l'augmentation des données. Ils sont également utilisés dans la détection des anomalies, où ils identifient les écarts par rapport aux distributions de données apprises, ainsi que dans le débruitage et l'imputation des données en reconstruisant les données manquantes ou corrompues.

Quels sont les avantages des autoencodeurs variationnels ?

Les VAE génèrent des échantillons de données diversifiés et de haute qualité en apprenant un espace latent continu et structuré. Ils renforcent également la robustesse de la représentation des données et permettent de gérer efficacement l'incertitude, ce qui est particulièrement utile dans des tâches telles que la détection d'anomalies, le débruitage des données et l'apprentissage semi-supervisé.

Pourquoi utiliser un VAE plutôt qu'un autoencodeur ?

Les autoencodeurs variationnels (VAE) offrent une approche probabiliste de l'encodage, ce qui leur permet de générer des échantillons de données divers et nouveaux en modélisant une distribution continue de l'espace latent. Contrairement aux autoencodeurs traditionnels, qui fournissent des représentations latentes fixes, les VAE améliorent les capacités de génération de données et peuvent mieux gérer l'incertitude et la variabilité des données.

Quels sont les inconvénients des autoencodeurs variationnels ?

Les autoencodeurs variationnels (VAE) peuvent souffrir de problèmes tels que l'effondrement de mode, où ils ne parviennent pas à capturer toute la diversité de la distribution des données, ce qui conduit à des échantillons générés moins variés. En outre, ils peuvent produire des résultats flous ou moins détaillés que d'autres modèles génératifs tels que les GAN, et leur apprentissage peut être coûteux en ressources informatiques et instable.

Vous souhaitez vous lancer dans l'IA générative ?

Apprenez à travailler avec des LLM en Python directement dans votre navigateur