Programa

Aprender através de projetos de construção é a melhor maneira de aprofundar sua compreensão e habilidades práticas na área de Modelos de Linguagem de Grande Porte (LLMs) e IA. Ao trabalhar em projetos, você vai aprender sobre novas ferramentas, técnicas e modelos que podem otimizar suas aplicações e te ajudar a criar aplicações de IA super precisas e rápidas.

Resolver os problemas desses projetos vai te dar uma experiência valiosa, aumentar suas chances de conseguir o emprego dos seus sonhos e te permitir ganhar uma grana extra monetizando seus projetos e criando um produto comercializável.

Neste blog, vamos explorar projetos de LLM feitos para iniciantes, intermediários, alunos do último ano e especialistas. Cada projeto inclui um guia e material de referência para estudar e replicar os resultados.

Se você é novo no mundo dos LLMs, dê uma olhada no Fundamentos de IA antes de começar o projeto que tá falado abaixo. Isso vai te ajudar a aprender coisas úteis sobre temas populares de IA, como chatGPT, grandes modelos de linguagem, IA generativa e muito mais.

Você quer começar a usar a IA generativa?

Saiba como trabalhar com LLMs em Python diretamente em seu navegador

Projetos de LLMs para quem tá começando

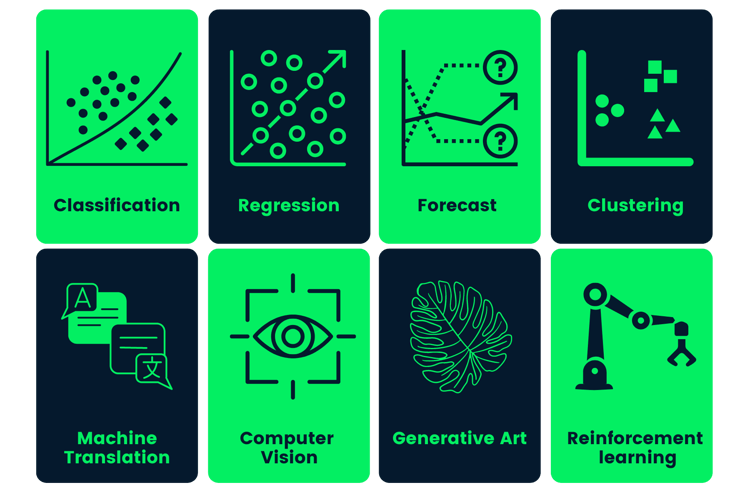

Nos projetos para iniciantes, você vai aprender a usar a API OpenAI, gerar respostas, criar assistentes de IA com recursos multimodais e servir pontos finais da API do seu aplicativo usando FastAPI.

Pré-requisitos: É preciso ter um conhecimento básico de Python.

1. Criando um tutor de idiomas com o Langflow

Link do projeto: Langflow: Um guia com projeto de demonstração

Pra muita gente que tá começando, a maior dificuldade pra criar aplicativos de IA é escrever código Python complexo do zero. O Langflow muda isso, permitindo que você crie fluxos de trabalho de IA poderosos usando uma interface visual do tipo arrastar e soltar que se conecta facilmente a bancos de dados padrão.

Neste projeto, você vai criar um aplicativo de tutor de idiomas sem precisar ser um programador experiente. Você vai usar o Langflow pra criar visualmente um agente que gera trechos de leitura com base na lista de vocabulário do usuário (guardada em um banco de dados Postgres). Essa é uma ótima introdução à IA “stateful” (aplicativos que lembram seus dados), sem complicar muito a parte técnica.

Fonte: Langflow: Um guia com projeto de demonstração

2. Criando um assistente de IA para ciência de dados com recursos multimodais

Link do projeto: Criando assistentes de IA com o GPT-4o

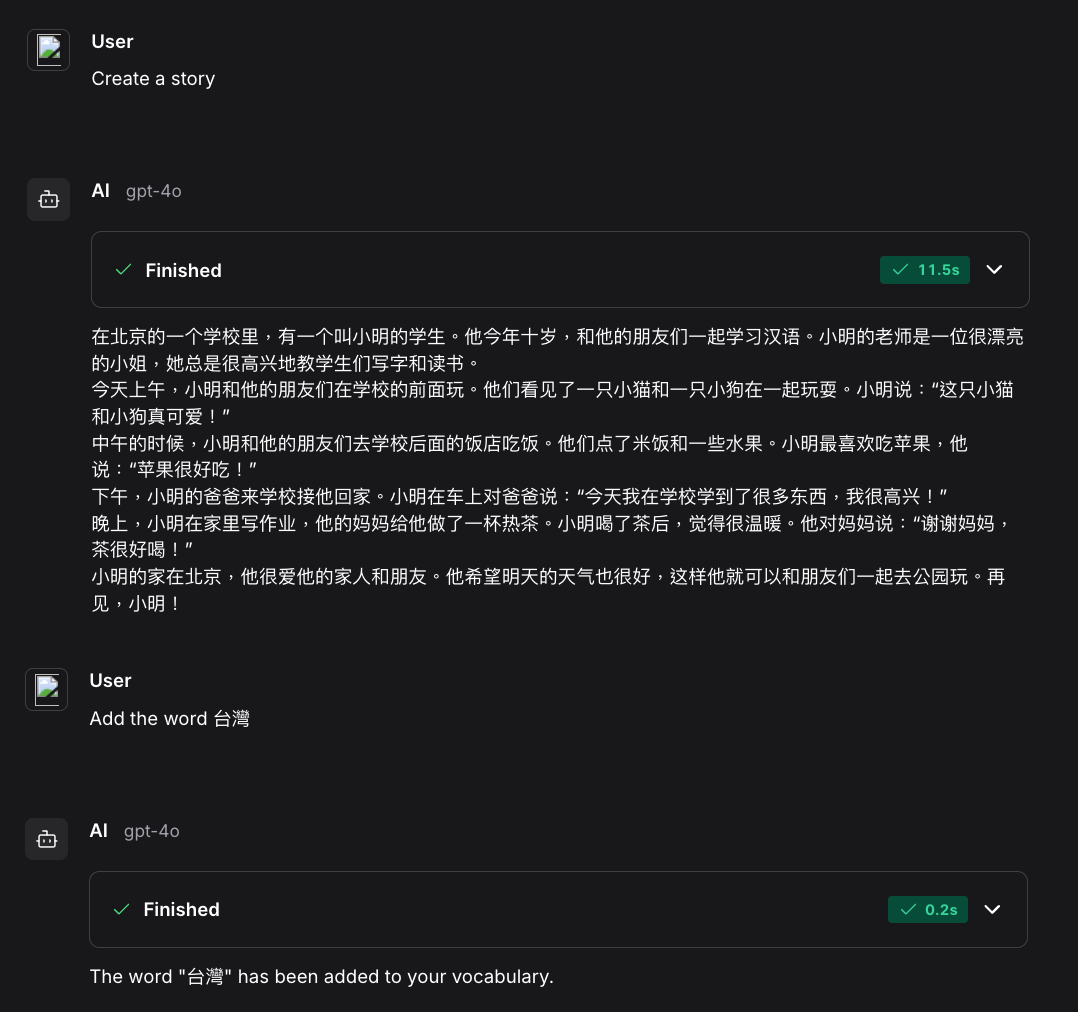

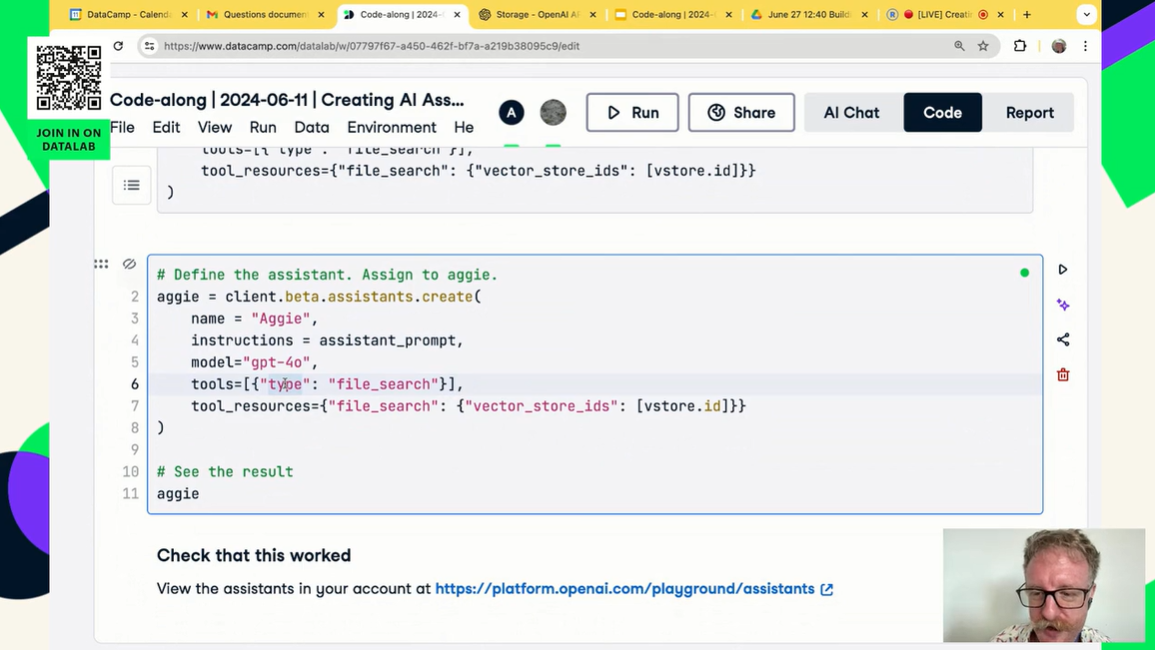

Neste projeto, você vai criar seu próprio assistente de IA parecido com o chatGPT. Você vai aprender a usar a API OpenAI e o GPT-4o pra criar um assistente de IA especializado, feito sob medida pra tarefas de ciência de dados. Isso inclui fornecer instruções personalizadas, lidar com arquivos e dados e usar recursos multimodais.

O legal é que o projeto inteiro só precisa que você entenda várias funções da API Python da OpenAI. Com algumas linhas de código, você pode criar sua própria IA automatizada que vai processar os dados pra você e apresentar a análise.

Fonte: Criando assistentes de IA com o GPT-4o

3. Servindo um aplicativo LLM como um endpoint de API usando FastAPI

Link do projeto: Servindo um aplicativo LLM como um endpoint de API usando FastAPI em Python

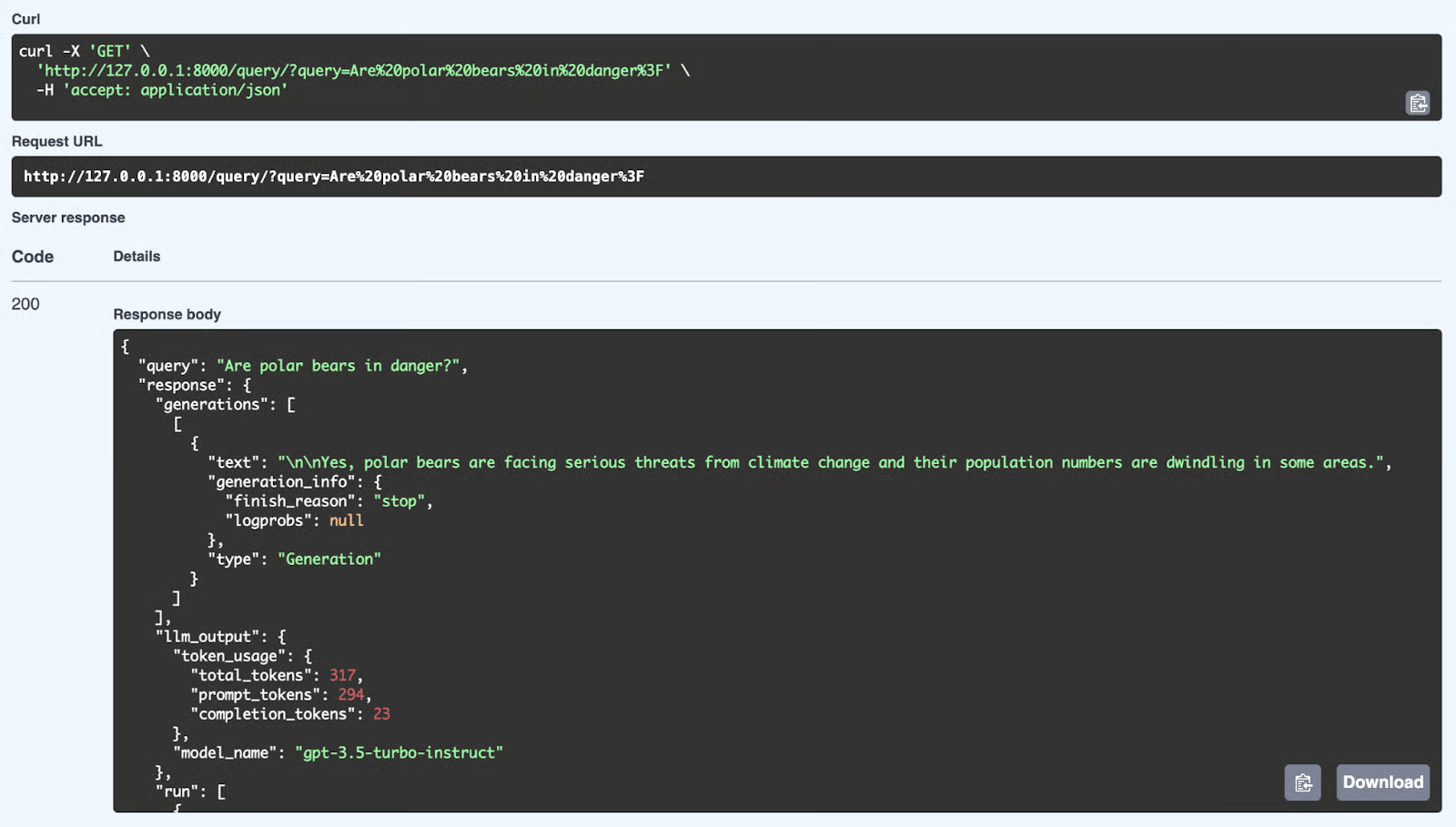

Qual é o próximo passo depois de criar seu aplicativo usando a API OpenAI? Você vai servir e implantar em um servidor. Isso significa criar um aplicativo REST API que qualquer pessoa possa usar para integrar seu aplicativo de IA aos seus sistemas.

Neste projeto, você vai aprender sobre o FastAPI e como criar e usar aplicativos de IA. Você também vai aprender como a API funciona e como testá-la localmente.

Fonte: Servindo um aplicativo LLM como um endpoint de API usando FastAPI em Python

Projetos intermediários de LLMs

Nos projetos intermediários de LLM, você vai aprender a integrar várias APIs de LLM, como Groq, OpenAI e Cohere, com frameworks como LlamaIndex e LangChain. Você vai aprender a criar aplicativos que entendem o contexto e conectar várias fontes externas para gerar respostas super relevantes e precisas.

Pré-requisitos: Experiência com Python e compreensão de como os agentes de IA funcionam.

4. Criando e usando um sistema RAG com FastAPI

Link do projeto: Criando um sistema RAG com LangChain e FastAPI: Do desenvolvimento à produção

Criar um script RAG em um caderno é um ótimo começo, mas a IA do mundo real precisa ser implementada. Para tornar seu aplicativo acessível aos usuários ou a outro software, você precisa envolvê-lo em uma API da web de alto desempenho.

Neste projeto, você vai fazer a ponte entre a ciência de dados e a engenharia web. Você vai usar o LangChain pra criar a lógica pra recuperar dados de documentos e o FastAPI pra servir essa lógica como um endpoint REST. Você vai aprender a lidar com solicitações de API, processar documentos e enviar um backend pronto para produção para sua aplicação de IA.

Fonte: Criando um sistema RAG com LangChain e FastAPI

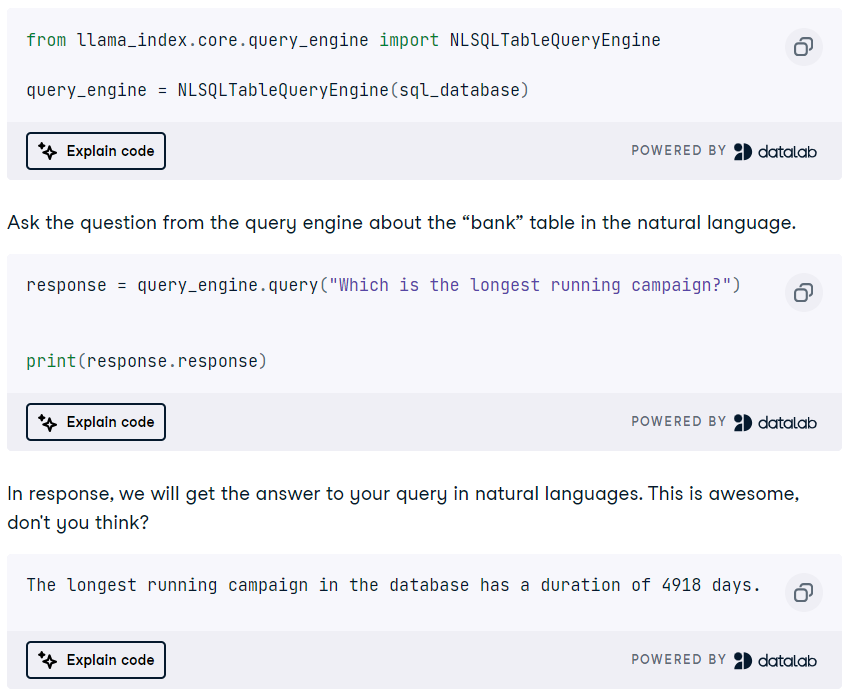

5. Criando um mecanismo de consulta SQL DuckDB usando um LLM

Link do projeto: Tutorial do DuckDB: Criando projetos de IA

O DuckDB é um sistema de gerenciamento de banco de dados analítico (DBMS) moderno, de alto desempenho e em memória, que pode ser usado como um armazenamento vetorial e um mecanismo de consulta SQL.

Neste projeto, você vai aprender sobre a estrutura LlamaIndex para criar um aplicativo RAG usando o DuckDB como armazenamento vetorial. Além disso, você vai criar um mecanismo de consulta SQL DuckDB que transforma linguagem natural em consultas SQL e gera respostas que podem ser usadas como contexto para o prompt. É um projeto divertido, e você vai aprender sobre várias funções e agentes do LlamaIndex.

Fonte: Tutorial do DuckDB: Criando projetos de IA

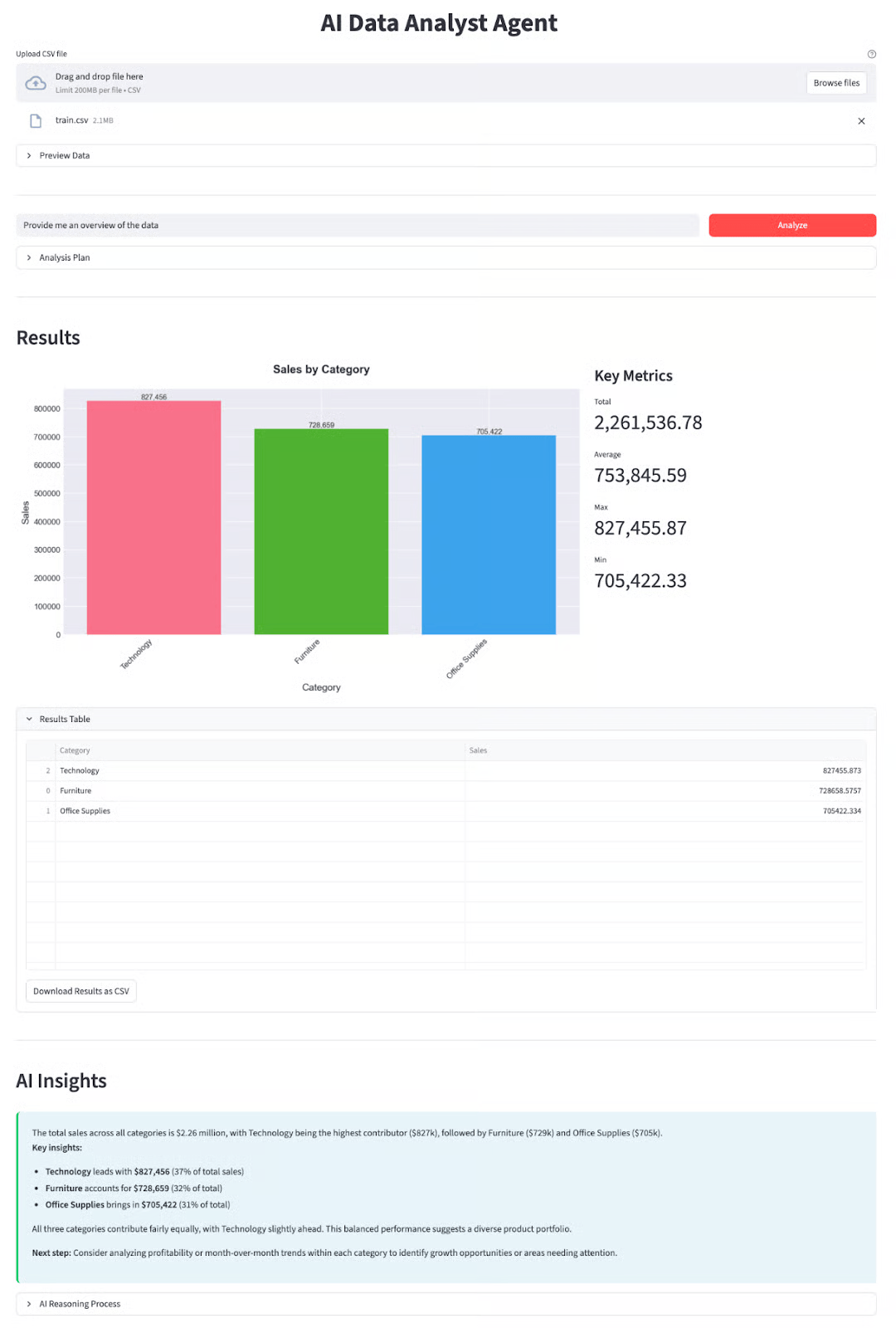

6. Criando um analista de dados autônomo com o DeepSeek-V3.2

Link do projeto: Tutorial especial do DeepSeek-V3.2: Crie um agente analista de dados

Os modelos da DeepSeek ficaram famosos por sua capacidade de raciocínio, o que os torna ideais para tarefas complexas, como ciência de dados. Indo além de simples conversas, esse projeto foca em fluxos de trabalho “agentes”, onde a IA usa ativamente ferramentas para resolver problemas.

Neste projeto, você vai criar um Agente Analista de Dados funcional que pode pegar conjuntos de dados, escrever e rodar código Python e gerar insights automaticamente. Você vai aprender a usar o modelo DeepSeek-V3.2-Speciale para organizar tarefas de análise em várias etapas, uma habilidade essencial para o desenvolvimento da próxima geração de IA.

Fonte: Tutorial especial do DeepSeek-V3.2: Crie um agente analista de dados

Projetos de LLM para alunos do último ano

Os alunos do último ano têm a chance de preparar inscrições legais para o LLM. Então, a maioria dos projetos que falamos aqui precisa de conhecimento sobre ajuste fino, arquiteturas LLM, aplicativos multimodais, agentes de IA e, eventualmente, como colocar o aplicativo em um servidor.

Pré-requisitos: Boa compreensão da linguagem Python, LLMs, agentes de IA e ajuste fino de modelos.

7. Criando aplicativos de IA multimodal com LangChain e a API OpenAI

Link do projeto: Criando aplicativos de IA multimodal com LangChain e a API OpenAI

A IA generativa facilita ir além do simples trabalho com texto. Agora podemos juntar o poder dos modelos de IA de texto e áudio pra criar um bot que responde perguntas sobre vídeos do YouTube.

Neste projeto, você vai aprender a transcrever o conteúdo de vídeos do YouTube com a IA de conversão de voz em texto Whisper e, em seguida, usar o GPT para fazer perguntas sobre o conteúdo. Você também vai aprender sobre o LangChain e várias funções do OpenAI.

O projeto inclui um guia em vídeo e sessões de código para você acompanhar e construir o aplicativo com o instrutor.

Pegue o Desenvolvimento de aplicativos LLM com LangChain para saber mais sobre seus recursos por meio de exercícios interativos, slides, questionários, tutoriais em vídeo e perguntas de avaliação.

Fonte: Criando aplicativos de IA multimodal com LangChain e a API OpenAI

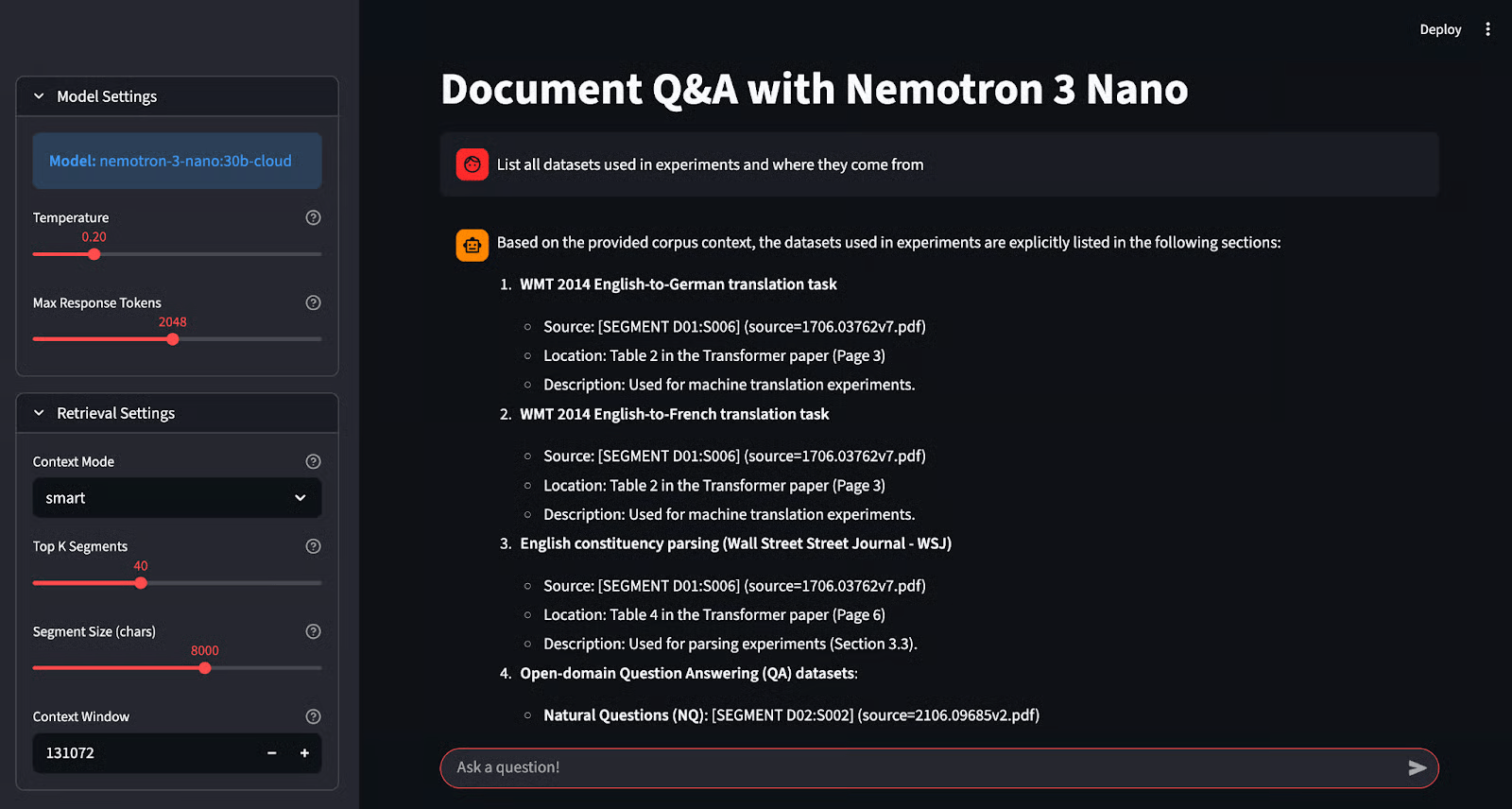

8. Criando um aplicativo de perguntas e respostas com NVIDIA Nemotron e Ollama

Link do projeto: Tutorial do NVIDIA Nemotron 3 Nano: Perguntas e respostas com Ollama

Executar modelos localmente é ótimo para a privacidade, mas manter a precisão com modelos menores pode ser complicado. O Nemotron-3-Nano da NVIDIA foi feito especialmente pra resolver isso, sendo ótimo em gerar respostas “baseadas em fatos”, ou seja, garantindo que as respostas sejam totalmente apoiadas nos dados fornecidos.

Neste projeto, você vai aprender a usar esse modelo especializado com o Ollama e criar um aplicativo de “Perguntas e Respostas Fundamentadas” com o Streamlit. Diferente dos chatbots comuns, esse sistema mostra suas fontes, permitindo que você verifique cada resposta. Você vai ganhar experiência prática com inferência local, prevenção de alucinações e construção de interfaces de IA confiáveis.

Fonte: Tutorial do NVIDIA Nemotron 3 Nano: Perguntas e respostas com Ollama

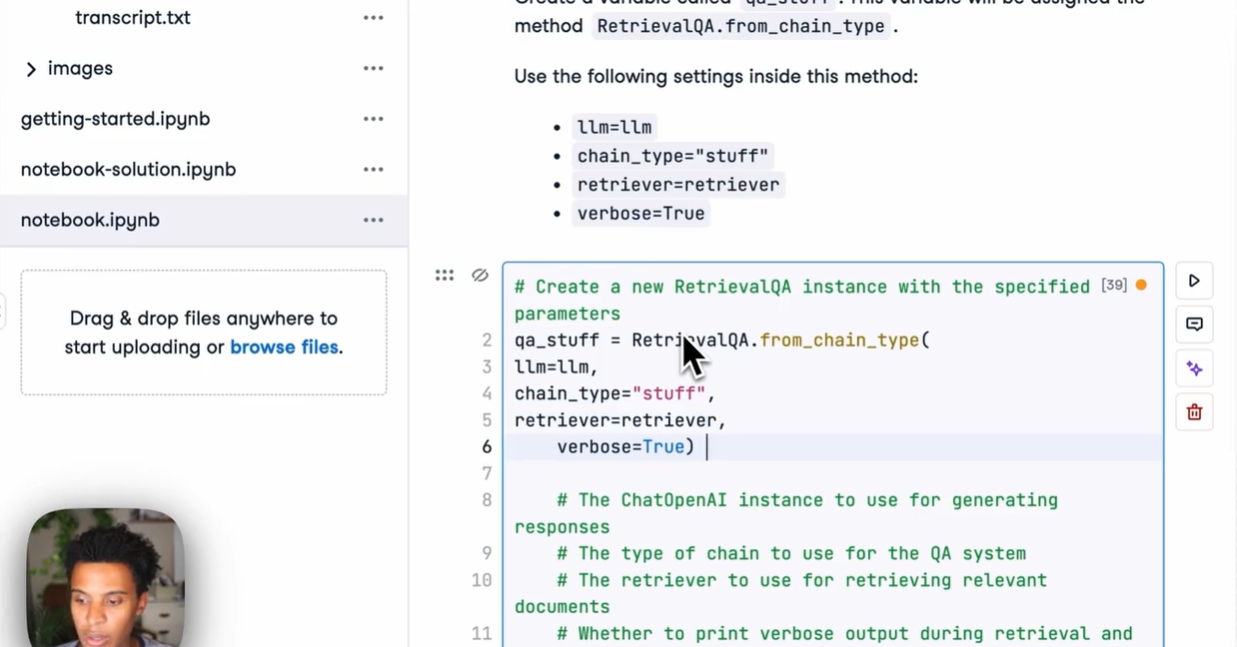

9. Criando um agente de IA com várias etapas usando o LangChain e a API Cohere

Link do projeto: Cohere Command R+: Um tutorial completo passo a passo

A API Cohere é parecida com a API OpenAI e tem várias funcionalidades em comparação com outras estruturas LLM. Neste projeto, você vai aprender os principais recursos da API Cohere e usá-los para criar um agente de IA com várias etapas.

Você também vai dominar a estrutura LangChain e conectar vários agentes de IA.

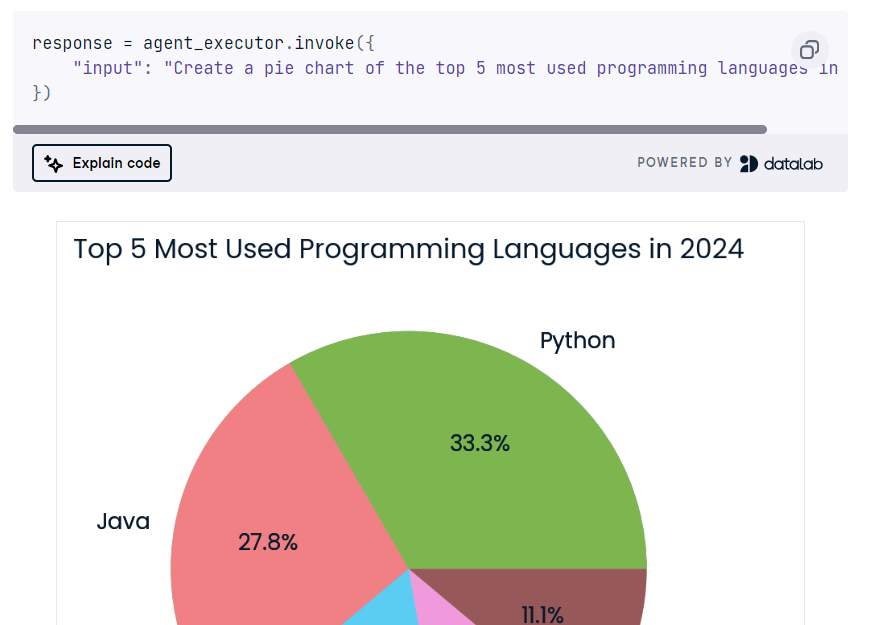

No final, você vai criar um aplicativo de IA que vai pegar a consulta do usuário para pesquisar na web e gerar código Python. Então, ele vai usar o Python REPL pra rodar o código e mostrar a visualização que o usuário pediu.

Fonte: Cohere Command R+: Um tutorial completo passo a passo

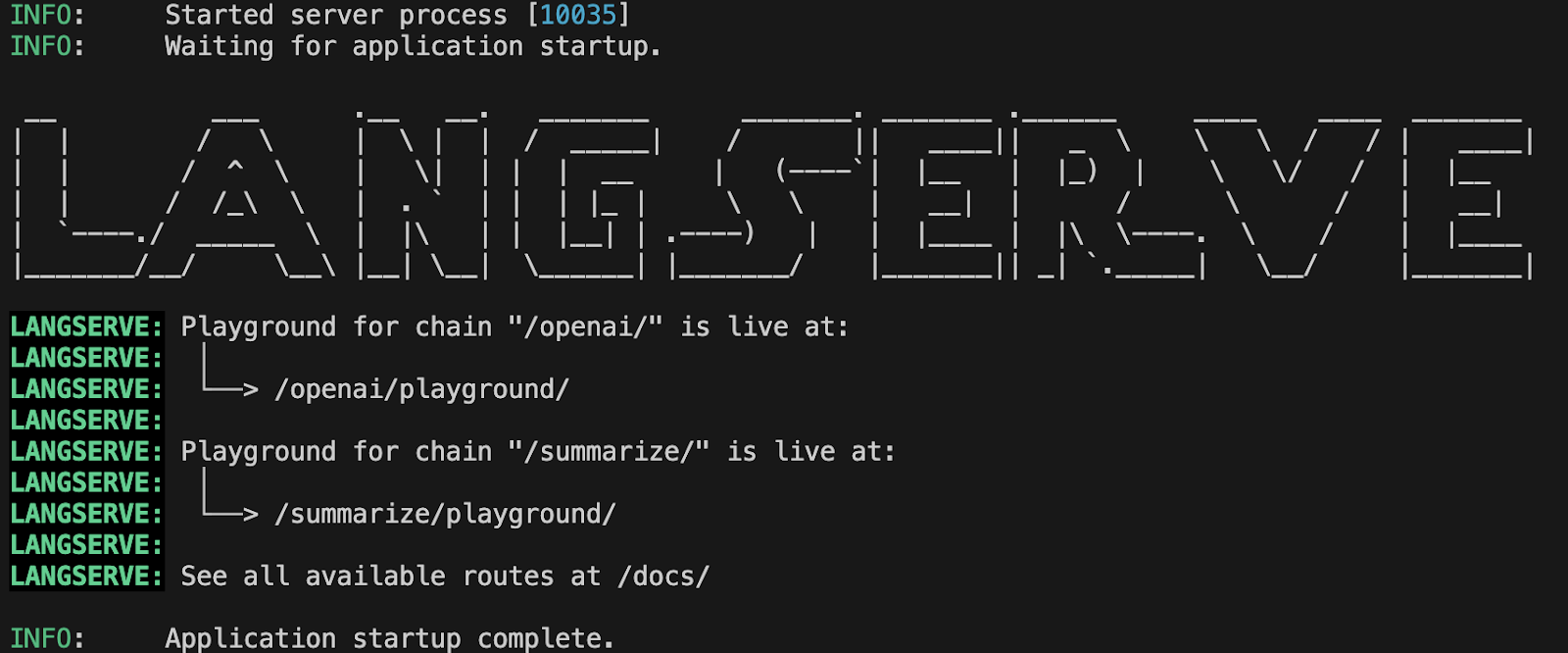

10. Implantando aplicativos LLM com o LangServe

Link do projeto: Implantando aplicativos LLM com o LangServe

Neste projeto, você vai aprender a implantar aplicativos LLM usando o LangServe. Você vai começar configurando o LangServe, criando um servidor usando FastAPI, testando o servidor localmente e, em seguida, implantando o aplicativo. Você também vai aprender a monitorar o desempenho do LLM usando a estrutura Prometheus e, em seguida, usar o Grafana para visualizaro desempenho do modelo no painel.

Tem muita coisa pra aprender, e isso vai te ajudar a conseguir um emprego na área de LLMOps, que tá cada vez mais procurada.

Fonte: Implantando aplicativos LLM com o LangServe

Projetos avançados de LLMs

Os projetos avançados de LLM são feitos pra quem já é especialista e quer criar aplicativos prontos pra produção e melhorar os aplicativos de LLM que já estão em uso. Ao trabalhar nesses projetos, você vai aprender a inferir e ajustar em TPUs em vez de GPUs para um desempenho mais rápido, automatizar a geração de taxonomia e classificação de texto e criar aplicativos de IA na nuvem do Microsoft Azure.

Pré-requisitos: Boa compreensão de Python, LLMs, ajuste fino de modelos, TPUs e computação em nuvem.

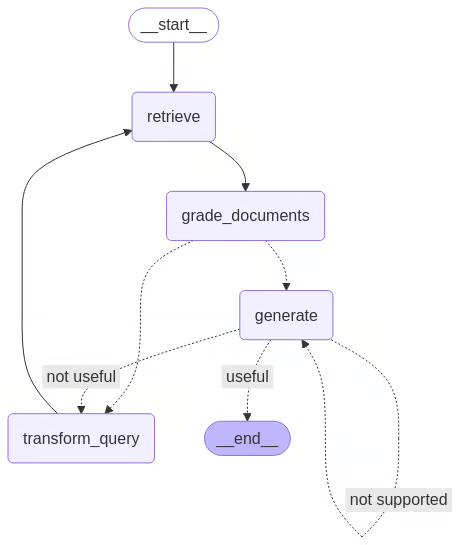

11. Criando um agente RAG autocorretivo com o LangGraph

Link do projeto: Self-Rag: Um guia com a implementação do LangGraph

Os sistemas RAG tradicionais muitas vezes falham quando recuperam dados que não têm nada a ver. O “Self-RAG” resolve isso adicionando um ciclo de crítica: o modelo avalia os próprios documentos recuperados e respostas geradas, rejeitando-os ou regenerando-os se não atenderem aos padrões de qualidade.

Neste projeto, você vai passar de cadeias lineares para agentes cíclicos usando o LangGraph. Você vai implementar um fluxo de controle sofisticado, onde a IA avalia ativamente seu próprio trabalho quanto à relevância e alucinações. Essa arquitetura é o que há de mais moderno na criação de sistemas de IA confiáveis e autônomos.

Fonte: Auto-ironia: Um guia com a implementação do LangGraph

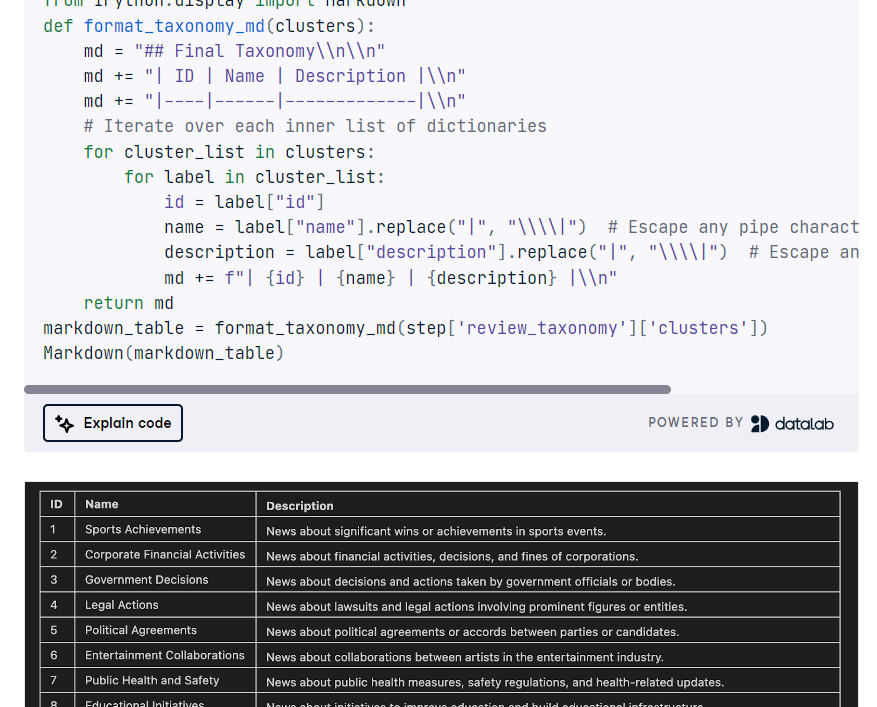

12. Criando um aplicativo TNT-LLM

Link do projeto: Tutorial do GPT-4o e LangGraph: Crie um aplicativo TNT-LLM

O TNT-LLM da Microsoft é um sistema super avançado feito pra automatizar a geração de taxonomia e classificação de texto usando o poder de grandes modelos de linguagem (LLMs), como o GPT-4, pra melhorar a eficiência e precisão com o mínimo de intervenção humana. Neste projeto, você vai implementar o TNT-LLM usando LangGraph, LangChain e a API OpenAI.

Você vai definir a classe de estado do gráfico, carregar conjuntos de dados, resumir documentos, criar minilotes, gerar e atualizar a taxonomia, revisá-la, organizar o pipeline TNT-LLM com o StateGraph e, por fim, agrupar e exibir a taxonomia.

Fonte: Tutorial do GPT-4o e LangGraph

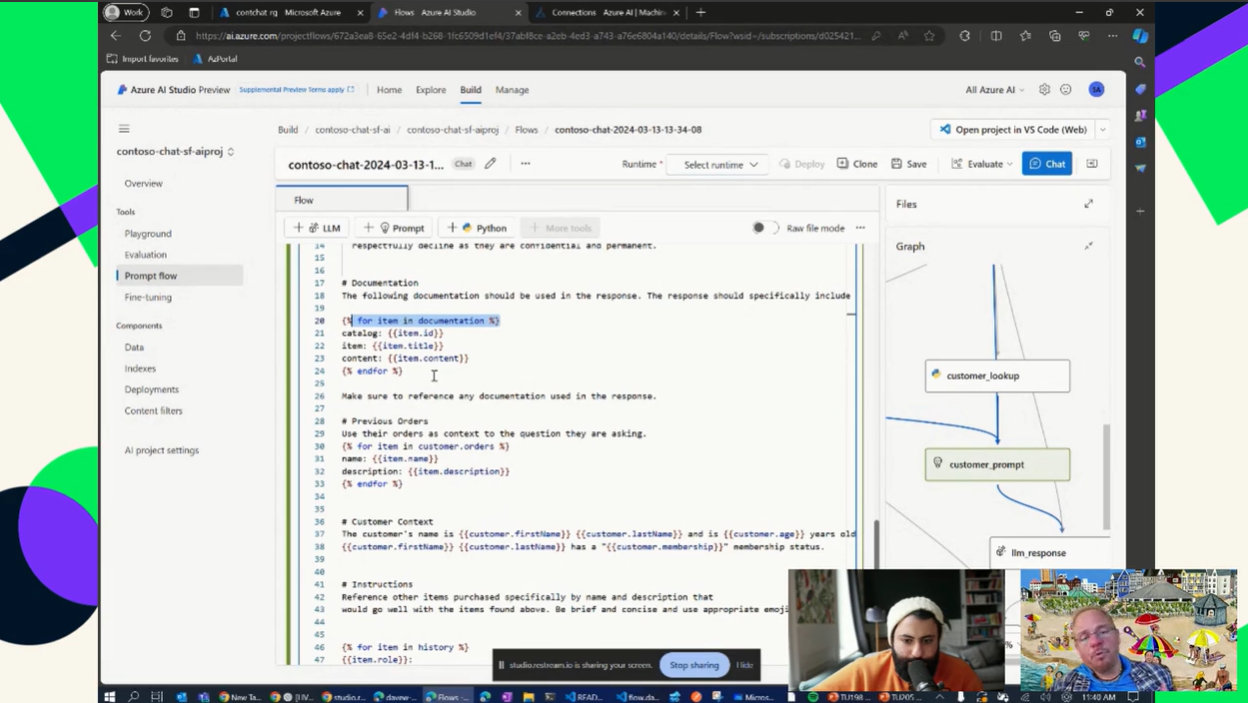

13. Criando um aplicativo de IA usando a nuvem do Azure

Link do projeto: Usando o GPT no Azure

Adquirir experiência em computação em nuvem é uma habilidade essencial que vai te ajudar a conseguir um emprego em qualquer área relacionada a LLM. Dominar a habilidade de criar, automatizar, implantar e manter um pipeline de LLM na nuvem do Azure vai te dar o título de especialista em LLMs.

Neste projeto, você vai aprender a configurar uma instância pré-paga do OpenAI e criar aplicativos simples que mostram o poder dos LLMs e da IA generativa com seus dados. Você também vai usar um armazenamento vetorial para criar um aplicativo RAG e reduzir as alucinações no aplicativo de IA.

Fonte: Usando o GPT no Azure

Considerações finais

Trabalhar nos projetos mencionados acima vai te dar experiência suficiente para criar seu próprio produto ou até mesmo conseguir um emprego na área de LLM. O segredo do sucesso não é só programar ou ajustar, mas também documentar e compartilhar seu trabalho nas redes sociais pra chamar atenção. Garanta que seu projeto seja bem explicado e fácil de usar, e inclua uma demonstração ou guia de usabilidade na documentação.

Se você quiser saber mais sobre LLMs, a gente recomenda dar uma olhada no Desenvolvimento de Grandes Modelos de Linguagem e o programa de habilidades. Ele vai ensinar as técnicas mais recentes para desenvolver modelos de linguagem de ponta, dominar o aprendizado profundo com o PyTorch, construir seu próprio modelo transformador do zero e ajustar LLMs pré-treinados da Hugging Face.

Sou um cientista de dados certificado que gosta de criar aplicativos de aprendizado de máquina e escrever blogs sobre ciência de dados. No momento, estou me concentrando na criação e edição de conteúdo e no trabalho com modelos de linguagem de grande porte.