Curso

A tecnologia de warehouse de dados foi recentemente consolidada para se tornar mais escalável e menos dispendiosa com a popularização dos serviços em nuvem. Uma das soluções mais comuns é o warehouse de dados BigQuery do Google Cloud Platform.

A pesquisa Stack Overflow 2024 mostra que ele tá cada vez mais popular, com uma taxa de adoção de 24,1% entre os usuários de nuvem do mundo todo. A procura por conhecimentos especializados em BigQuery aumentou bastante em vários setores, tornando a compreensão dos seus fundamentos uma necessidade profissional entre os profissionais de dados.

Neste artigo, você vai encontrar uma lista de perguntas sobre o BigQuery que costumam aparecer em entrevistas de emprego pra te ajudar a se preparar. Se você está começando a aprender sobre o BigQuery, recomendo dar uma olhada primeiro no guia sobre warehouse no GCP.

Perguntas básicas para entrevistas sobre o BigQuery

É essencial conhecer o básico do BigQuery antes de abordar temas complexos. Essas perguntas avaliam o seu entendimento dos conceitos básicos, da arquitetura e da funcionalidade. Se você não conseguir responder às perguntas a seguir, recomendo que comece do início, conferindo o Guia para iniciantes do BigQuery e se inscrevendo no nosso curso introdutório do BigQuery.

O que é o BigQuery e como ele é diferente dos bancos de dados tradicionais?

Por que isso é perguntado: Avaliar o seu entendimento sobre warehouses de dados modernos e suas vantagens em relação aos bancos de dados tradicionais.

O BigQuery é um warehouse totalmente gerenciado e sem servidor na nuvem Google, feito pra análise de dados em grande escala. Permite consultas SQL em alta velocidade em conjuntos de dados enormes sem precisar gerenciar a infraestrutura, e deixa os usuários se concentrarem nas informações, em vez de na manutenção.

Diferente dos bancos de dados relacionais locais tradicionais, que geralmente são baseados em linhas e limitados pelo hardware, o BigQuery é um sistema de armazenamento colunar nativo da nuvem que oferece escalabilidade quase infinita. Sua arquitetura distribuída e modelo de preços pré-pagos tornam-no mais eficiente para lidar com cargas de trabalho analíticas do que os bancos de dados convencionais.

O que é um conjunto de dados no BigQuery?

Por que isso é perguntado: Para testar seus conhecimentos sobre a organização de dados e a estrutura do BigQuery.

Um conjunto de dados, no BigQuery, é o recipiente principal que organiza tabelas, visualizações e outros recursos. Isso abre caminho para o controle de acesso e a localização dos dados. Ao organizar os dados de forma eficiente, os conjuntos de dados garantem um melhor desempenho das consultas e gerenciamento de acesso, tornando-os um componente fundamental da arquitetura do BigQuery.

Como você carrega dados no BigQuery?

Por que isso é perguntado: Para testar seus conhecimentos sobre os diferentes métodos de ingestão de dados.

O BigQuery oferece vários métodos de ingestão de dados para diferentes finalidades.

- Modo de carregamento em lote é normalmente usado para carregar um grande conjunto de dados históricos no BigQuery usando a interface do usuário da web do BigQuery, a ferramenta de linha de comando bq ou chamadas de API.

- Ingestão de streaming permite o processamento de dados em tempo real, enviando registros individuais ou pequenos lotes usando a API do BigQuery Streaming.

- O serviço de transferência de dados do BigQuery pode simplificar as importações programadas de dados do armazenamento da nuvem, do Google Ads e de fontes SaaS.

Para fluxos de trabalho ETL avançados, o Google Cloud Dataflow e outras ferramentas de pipeline facilitam a transferência contínua de dados para o BigQuery. Escolher o melhor jeito de fazer a ingestão depende do tamanho dos dados, da latência e do que você precisa processar.

Que tipos de dados o BigQuery suporta?

Por que isso é perguntado: Para testar seus conhecimentos sobre os recursos de tratamento de dados do BigQuery.

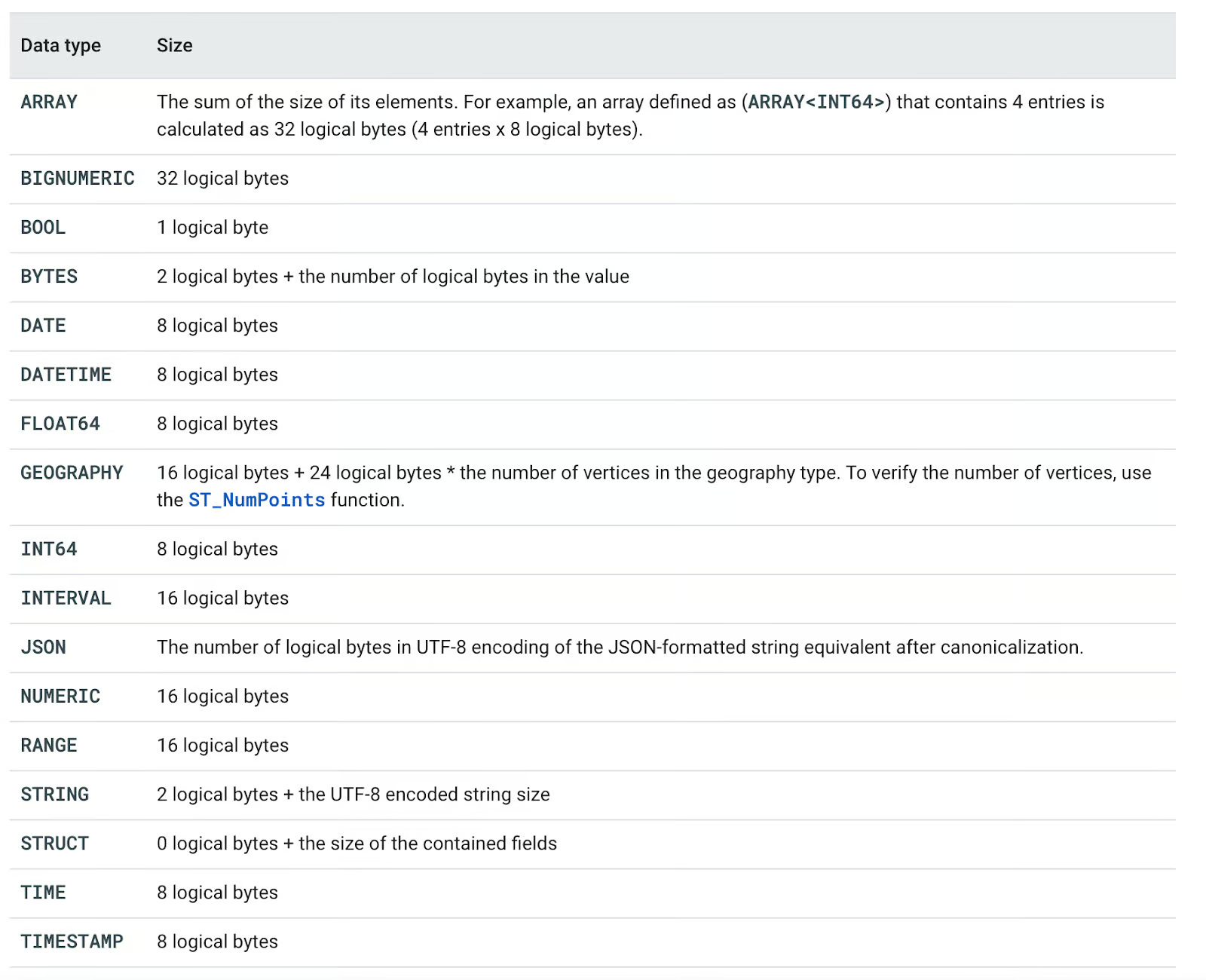

O BigQuery aceita vários tipos de dados, que são:

- Tipos básicos: BOOL, INT64, FLOAT64, STRING, BYTES, DATE, DATETIME, TIME, TIMESTAMP

- Tipos complexos: ARRAY, STRUCT, JSON

- Tipos especializados: NUMÉRICO, BIGNUMÉRICO, INTERVALO, GEOGRAFIA, INTERVALO

Cada tipo de dados tem um tamanho de armazenamento lógico definido, que afeta o desempenho e o custo da consulta. Por exemplo, o armazenamento STRING depende do comprimento codificado em UTF-8, enquanto ARRAY<INT64> precisa de 8 bytes por elemento. Entender esses tipos ajuda a otimizar consultas e gerenciar custos de forma eficiente.

Você pode ver todos os tipos de dados compatíveis na tabela a seguir.

Tipos de dados do BigQuery. Imagem da Documentação da Nuvem do Google.

Quais são as principais vantagens de usar o BigQuery?

Por que isso é perguntado: Para garantir que você entenda as principais vantagens de usar o BigQuery como um warehouse.

Usar os serviços do BigQuery traz cinco vantagens principais em relação às soluções tradicionais autogerenciadas:

- Escalabilidade: Todos os investimentos em hardware são adiados por enquanto. Isso nos permite aumentar ou diminuir facilmente os recursos, dependendo das necessidades do negócio.

- Flexibilidade: A infraestrutura pode ser ajustada de acordo com as necessidades do negócio.

- Alta segurança: Backups automáticos e recursos de recuperação de desastres são recursos padrão de soluções em nuvem como o GCP.

- Econômico: As opções de pagamento conforme o uso permitem que os clientes paguem apenas pelos serviços que estão usando.

- Compartilhamento de dados e colaboração: Usar serviços da nuvem ajuda a compartilhar dados e a colaborar.

Vantagens do BigQuery. Imagem do autor.

Perguntas técnicas para entrevistas sobre o BigQuery

Depois de entender os fundamentos do BigQuery, é hora de mergulhar em aspectos mais técnicos que os entrevistadores costumam avaliar.

Essas perguntas vão além das definições básicas e testam sua capacidade de otimizar o desempenho, gerenciar custos e trabalhar com recursos avançados, como particionamento, clustering e segurança.

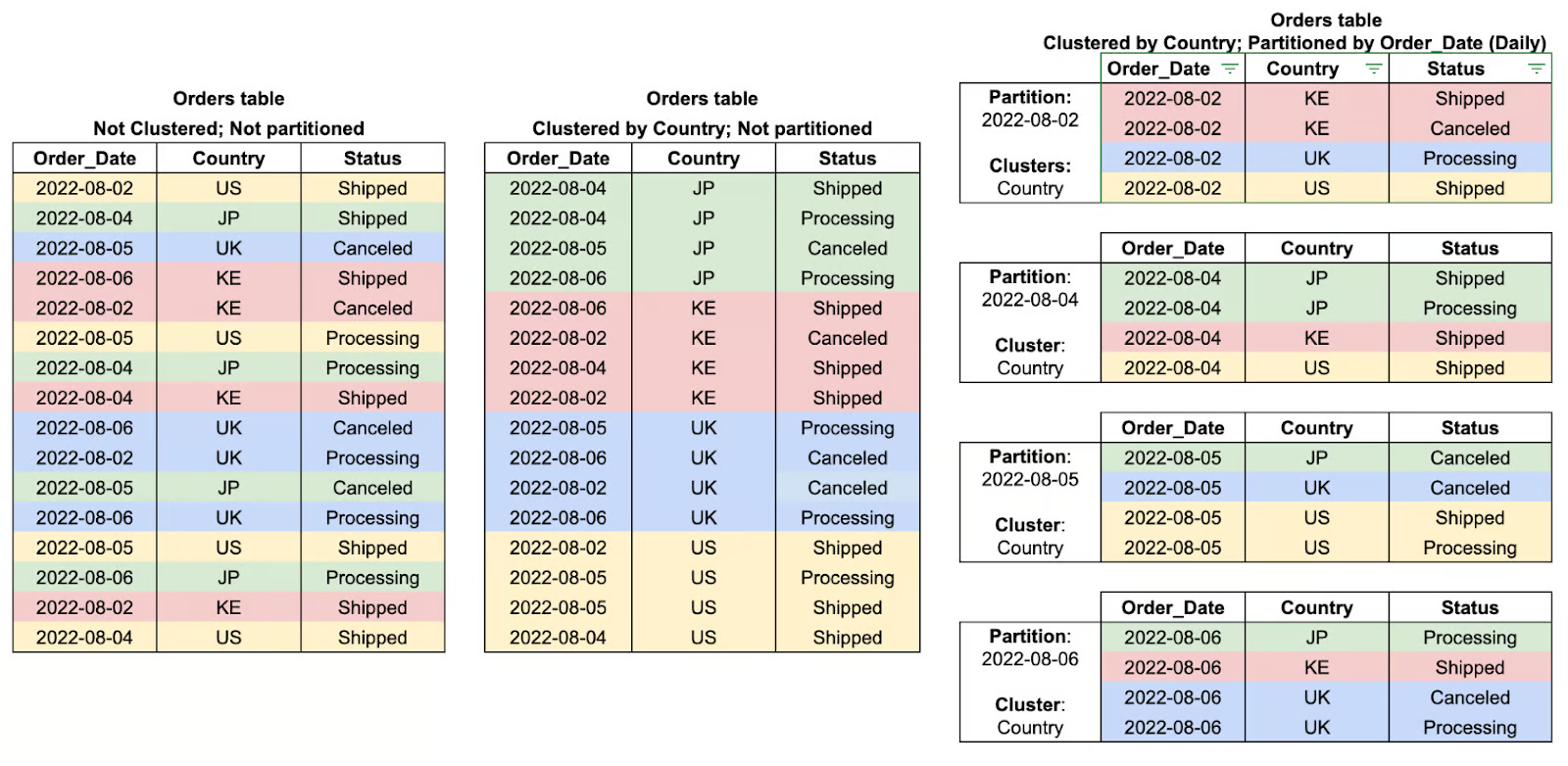

O que é particionamento no BigQuery e como ele melhora o desempenho?

Por que isso é perguntado: Avaliar o seu conhecimento sobre técnicas de organização de dados e o impacto delas na eficiência das consultas.

A partição no BigQuery é um jeito de dividir tabelas grandes em partes menores e mais fáceis de lidar, com base em um critério específico, como data, hora de ingestão ou valores de inteiros. Assim, ao dividir os dados em partições, o BigQuery consegue limitar a quantidade de dados que são verificados durante as consultas, melhorando o desempenho e reduzindo bastante os custos.

Por exemplo, uma tabela particionada que guarda dados de transações diárias permite que as consultas filtrem intervalos de datas específicos de forma eficiente, em vez de vasculhar todo o conjunto de dados. Isso torna o particionamento especialmente útil para análises de séries temporais e cargas de trabalho analíticas em grande escala.

O que é agrupamento no BigQuery e como ele melhora o desempenho das consultas?

Por que isso é perguntado: Avaliar sua compreensão das estratégias de organização de dados que otimizam a eficiência e o custo das consultas.

O agrupamento no BigQuery é quando a gente organiza os dados em partições com base nos valores de uma ou mais colunas específicas. Ao agrupar as linhas relacionadas por clustering, o BigQuery reduz a quantidade de dados que são verificados, melhorando assim o desempenho das consultas e diminuindo os custos gerais de processamento.

Essa forma de otimizar consultas tem se mostrado bem eficiente na hora de filtrar, classificar ou juntar dados com base em colunas agrupadas, onde o mecanismo de consulta pode pular todos os dados que não interessam, em vez de fazer uma varredura completa da partição. O agrupamento funciona melhor quando combinado com o particionamento e oferece ainda mais benefícios de desempenho ao trabalhar com grandes conjuntos de dados.

Qual é a diferença entre uma tabela e uma visualização no BigQuery?

Por que isso é perguntado: Avaliar o seu entendimento das estruturas de dados do BigQuery e seus casos de uso.

No BigQuery, uma tabela é uma unidade de armazenamento estruturada que guarda fisicamente os dados, enquanto uma visualização é uma tabela virtual que pega os dados de forma dinâmica com base em uma consulta SQL pré-definida. A principal diferença entre eles é que as visualizações não podem conter dados por si só, mas servem como um bloco de construção para escrever consultas grandes ou aplicar regras de segurança em torno do acesso aos dados, oferecendo acesso a um subconjunto de dados sem efetivamente duplicá-los. As visualizações também melhoram os tempos de execução das consultas, permitindo que os usuários acessem novamente os dados sem precisar recarregar ou reorganizar tabelas, o que as torna poderosas para análises, abstração de dados e aplicação de segurança.

Então, pra simplificar:

- A tabela é uma unidade de armazenamento estruturada que guarda fisicamente os dados

- A visualização é uma tabela virtual que pega dados de forma dinâmica com base em uma consulta SQL pré-definida, sem precisar armazená-los

Como o BigQuery lida com a segurança dos dados?

Por que isso é perguntado: Para testar seus conhecimentos sobre a segurança do BigQuery combinada com a proteção de dados confidenciais.

O BigQuery usa uma abordagem em camadas para a segurança dos dados, começando com um modelo seguro que protege os dados em todos os níveis do ciclo de vida dos dados.

- Os dados são criptografados em repouso usando chaves de criptografia gerenciadas pelo Google por padrão, ou através de chaves gerenciadas pelo cliente, se ele quiser manter o controle gerencial sobre elas.

- Os dados são criptografados durante o trânsito via HTTPS/TLS e em trânsito entre clientes e o BigQuery.

- O Gerenciamento de Identidade e Acesso (IAM) permite um controle de acesso bem detalhado, oferecendo funções e atribuições de contas de usuário e serviço para garantir que só quem tem autorização possa acessar ou alterar os dados.

- O registro de auditoria tem como objetivo acompanhar as atividades dos usuários e do sistema, fornecendo uma trilha de auditoria que pode ser usada para monitoramento e conformidade.

Esses recursos de segurança integrados ajudam as organizações a manter a confidencialidade, a integridade e a conformidade regulatória dos dados.

O que é o Serviço de Transferência de Dados do BigQuery e como ele simplifica a ingestão de dados?

Por que isso é perguntado: Para ver se você entendeu como funciona a movimentação e integração automáticas de dados no BigQuery.

O BigQuery Data Transfer Service (BQ DTS) automatiza e programa a importação de dados de várias fontes externas para o BigQuery, sem precisar de processos ETL manuais. Ele se integra nativamente com serviços do Google, como Google Ads, YouTube e Google Cloud Storage, além de aplicativos SaaS de terceiros.

Ao permitir transferências de dados automatizadas e programadas, o BQ DTS garante que os dados fiquem atualizados para análise sem precisar da intervenção do usuário. Esse serviço é super útil para organizações que gerenciamfluxos de trabalho de ingestão de dados recorrentes em grande escala , melhorando a eficiência e reduzindo as despesas operacionais.

O que são campos aninhados e repetidos no BigQuery e por que eles são úteis?

Por que isso é perguntado: Avaliar sua compreensão do suporte do BigQuery para dados semiestruturados e suas vantagens em relação aos modelos relacionais tradicionais.

O BigQuery permite campos aninhados e repetidos, o que torna o armazenamento e a consulta de dados hierárquicos ou baseados em matrizes mais eficientes. Campos aninhados usam o STRUCT , permitindo que uma coluna tenha subcampos, tipo um objeto JSON.

Os campos repetidos funcionam como MATRIZES, permitindo que uma única coluna armazene vários valores. Essas estruturas ajudamo a eliminar a necessidade de operações JOIN complexas, melhorar o desempenho das consultas e tornar o BigQuery adequado para processar dados semiestruturados, como logs, fluxos de eventos e conjuntos de dados semelhantes ao nosql.

Como você pode programar e automatizar tarefas no BigQuery?

Por que isso é perguntado: Para avaliar o seu conhecimento sobre automação da execução de consultas e gerenciamento de fluxo de trabalho no BigQuery.

O BigQuery tem várias maneiras de agendar e automatizar trabalhos, garantindo que tarefas recorrentes sejam executadas sem intervenção manual.

- Consultas programadas permitem que os usuários definam execuções recorrentes de consultas diretamente pela interface do usuário da web ou API do BigQuery.

- O Nuvem Scheduler oferece um serviço tipo cron totalmente gerenciado que aciona consultas em intervalos pré-definidos.

- Para automação orientada a eventos, Cloud Functions pode executar tarefas do BigQuery em resposta a gatilhos de outros serviços da Nuvem do Google.

Essas ferramentas de automação ajudam a otimizar os fluxos de dados, reduzir a carga de trabalho manual e garantir o processamento oportuno dos dados para análise e relatórios.

Como o Big Query lida com o particionamento e o agrupamento de dados?

Por que isso é perguntado: Avaliar o seu entendimento das estratégias de organização de dados no BigQuery e o impacto delas no desempenho das consultas e na eficiência de custos.

Particionamento divide tabelas grandes em segmentos menores, melhorando o desempenho da consulta ao escanear apenas os dados relevantes.

-

baseado em tempo: Por DATA, TIMESTAMP, DATETIME (por exemplo, partições diárias de data_de_venda).

-

Intervalo de inteiros: Por valores INTEGER (por exemplo, intervalos de

user_id). -

a no momento da ingestão: Por data e hora de carregamento dos dados (

_PARTITIONDATE).

É melhor para dados de séries temporais e para reduzir os custos de consulta ao filtrar por data ou intervalos numéricos.

O agrupamento organiza os dados dentro de uma tabela ou partição, classificando-os com base nas colunas selecionadas, o que acelera as consultas.

É ideal para filtrar e agregar por campos consultados com frequência, como região ou user_id.

Exemplos de agrupamento de tabelas e partições. Imagem por Google Nuvem.

Perguntas sobre a arquitetura do BigQuery

Como é que a arquitetura do Google BigQuery foi projetada e o que a torna única?

Por que isso é perguntado: Avaliar sua compreensão da arquitetura sem servidor do BigQuery e como ela difere dos warehouse tradicionais.

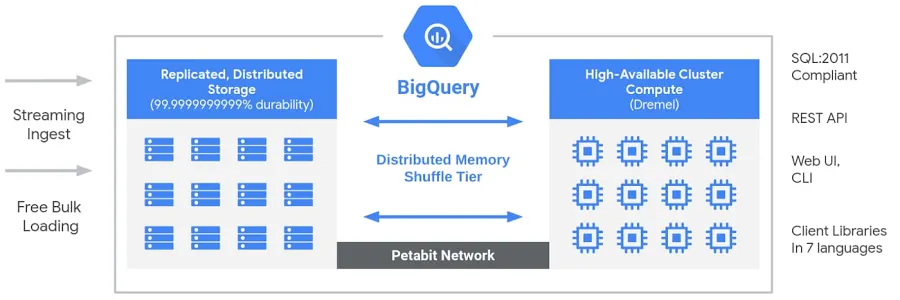

O BigQuery tem uma arquitetura sem servidor e totalmente gerenciada que separa o armazenamento e a computação, permitindo que eles sejam dimensionados de forma independente com base na demanda. Diferente dos warehouse em nuvem tradicionais oudos sistemas de processamento paralelo massivo (MPP) locais , essa separação oferece flexibilidade, eficiência de custos e alta disponibilidade sem que os usuários precisem gerenciar a infraestrutura. O mecanismo de computação do BigQuery é alimentado pelo Dremel, um cluster multitenant que executa consultas SQL de forma eficiente, enquanto os dados são armazenados no Colossus, o sistema de armazenamento distribuído global do Google. Esses componentes se comunicam através de uma rede em escala petabit da Google,a Jupiter , garantindo uma transferência de dados super rápida. Todo o sistema é orquestrado porum Borg ,, o sistema interno de gerenciamento de cluster do Google e um precursor do Kubernetes. Essa arquitetura permite que os usuários executemanálises escaláveis e de alto desempenho em conjuntos de dados enormes sem se preocupar com o gerenciamento da infraestrutura.

Arquitetura do Big Query. Imagem do Google.

Como o BigQuery separa armazenamento e computação, e por que isso é bom?

Por que isso é perguntado: Essa pergunta avalia sua compreensão da arquitetura do BigQuery, especificamente como seu modelo de armazenamento e computação desacoplado melhora a escalabilidade, a eficiência de custos e o desempenho.

O BigQuery segue uma arquitetura sem servidor e totalmente gerenciada, na qual o armazenamento e a computação são completamente separados:

- Armazenamento: Os dados são guardados no Colossus, o sistema de armazenamento distribuído global do Google. Isso garante alta disponibilidade, durabilidade e escalabilidade quase infinita, sem que os usuários precisem gerenciar a infraestrutura.

- Calcular: A execução da consulta é feita pelo Dremel, um mecanismo de consulta distribuído que aloca recursos computacionais (slots) de forma dinâmica, dependendo da demanda da carga de trabalho.

Principais benefícios da separação entre armazenamento e computação:

- Escalonamento independente: Você pode aumentar o armazenamento sem mexer na computação e vice-versa.

- Eficiência de custos: Você só paga pelos dados verificados durante as consultas, evitando custos desnecessários de computação.

- Desempenho otimizado: As consultas são mais rápidas, já que o armazenamento não atrapalha o processamento.

- Armazenamento em várias regiões: Os dados podem ser guardados em diferentes lugares sem afetar a velocidade das consultas.

Esse design permite que o BigQuery processe consultas na escala de petabytes de forma eficiente, mantendo os custos baixos, o que o torna uma escolha ideal para análises baseadas em nuvem.

O que é o Dremel e como ele ajuda o BigQuery a ter um desempenho rápido nas consultas?

Por que isso é perguntado: Avaliar o seu conhecimento sobre o Dremel, o mecanismo de consulta subjacente do BigQuery, e como o seu modelo de execução colunar baseado em árvore permite análises de dados de alto desempenho.

O Dremel é um mecanismo de execução de consultas distribuídas que alimenta o BigQuery. Diferente dos bancos de dados tradicionais que usam processamento baseado em linhas, o Dremel usa um formato de armazenamento em colunas e um modelo de execução de consultas baseado em árvores para otimizar a velocidade e a eficiência.

Como o Dremel permite consultas rápidas:

- Armazenamento em colunas: Em vez de ler linhas inteiras, o Dremel só verifica as colunas necessárias, diminuindo a quantidade de dados processados.

- Execução baseada em árvore: As consultas são divididas em fragmentos e executadas em paralelo em milhares de nós. Os resultados são agrupados numa estrutura hierárquica em árvore, minimizando a latência.

- Alocação de recursos sem servidor: O Dremel atribui dinamicamente slots de computação às consultas com base na complexidade, garantindo uma utilização eficiente dos recursos.

Principais benefícios da Dremel:

- Consultas super rápidas em conjuntos de dados na escala de petabytes.

- Processamento econômico, digitalizando só as colunas que importam.

- Paralelização automática para grandes cargas de trabalho sem ajustes manuais.

Você pode saber mais sobre o Dremel na documentação oficial do Google.

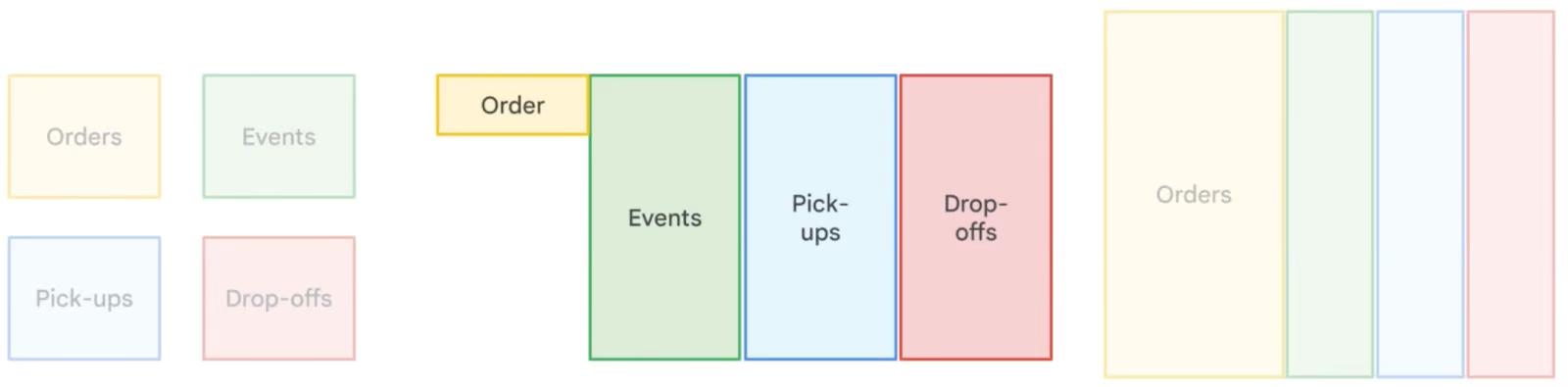

Como funciona a desnormalização no BigQuery e quando ela deve ser usada?

Por que isso é perguntado: Avaliar o seu entendimento das estratégias de modelagem de dados e o impacto delas no desempenho das consultas em bancos de dados analíticos.

A desnormalização no BigQuery faz issode propósito, criando redundância ao juntar tabelas e duplicar dados para melhorar o desempenho das consultas. Ao contrário da normalização, que minimiza a redundância por meio de tabelas menores e relacionadas, a desnormalização reduz a necessidade de junções complexas, resultando em tempos de leitura mais rápidos. Essa abordagem é especialmente útil emwarehouse e análise de dados de tipo “ ” (leitura intensiva), onde as operações de leitura são mais frequentes do que as de gravação. Mas, a desnormalização aumenta as necessidades de armazenamento, e é por isso que o BigQuery recomenda usar campos aninhados e repetidos para estruturar de forma eficiente os dados desnormalizados, minimizando a sobrecarga de armazenamento.

Comparando diferentes estratégias de normalização de dados. Imagem por Google Nuvem.

Perguntas específicas sobre SQL

Depois de entender bem a arquitetura e as técnicas de otimização do BigQuery, a próxima área importante a se concentrar é a proficiência em SQL. SQL é a espinha dorsal do trabalho com o BigQuery, e os entrevistadores costumam testar sua habilidade de escrever, otimizar e solucionar problemas em consultas. Pra ficar mais preparado, recomendo que você se inscreva nos cursos de SQL do DataCamp.

Como você faz uma operação JOIN no BigQuery?

Por que isso é perguntado: Avaliar sua capacidade de juntar dados de várias tabelas usando operações SQL JOIN.

O BigQuery aceita vários tipos de JOINs para juntar dados de várias tabelas com base em uma coluna compartilhada. Por exemplo, pra pegar os detalhes do produto junto com as informações de vendas, você pode usar um INNER JOIN entre a SALES TABELA e a PRODUCT TABELA no Product_Id:

SELECT

s.Id AS Sales_Id,

p.Product,

p.Price,

s.Purchase_date

FROM sales_table s

JOIN product_table p

ON s.Product_Id = p.Id;Para mais detalhes, tipo datas de entrega, dá uma olhada na TABELA DE ENTREGAS:

SELECT

s.Id AS Sales_Id,

p.Product,

p.Price,

s.Purchase_date,

d.Deliver_date

FROM sales_table s

JOIN product_table p ON s.Product_Id = p.Id

JOIN delivery_table d ON s.Id = d.Sales_Id;Escreva uma consulta SQL para selecionar os 10 produtos mais caros.

Por que isso é perguntado: Avaliar sua capacidade de recuperar e classificar dados de forma eficiente.

Pra achar os 10 produtos mais caros, usa ORDER BY pra ordenar por preço em ordem decrescente e LIMIT pra restringir o resultado:

SELECT

Product,

Price

FROM product_table

ORDER BY Price DESC

LIMIT 10;Escreva uma consulta SQL para calcular a média de vendas por mês.

Por que isso é perguntado: Avaliar sua capacidade de fazer agregações baseadas no tempo.

Para calcular a média de vendas por mês, use a função EXTRACT para agrupar as vendas por mês e COUNT para contar o número de vendas por mês:

SELECT

EXTRACT(MONTH FROM Purchase_date) AS Month,

COUNT(Id) AS Total_Sales,

AVG(COUNT(Id)) OVER () AS Average_Sales

FROM sales_table

GROUP BY Month;Escreva uma consulta SQL para descobrir o número total de entregas por produto.

Por que isso é perguntado: Para avaliar sua habilidade de juntar dados usando GROUP BY e COUNT.

Para contar as entregas de cada produto:

SELECT

p.Product,

COUNT(d.Id) AS Total_Deliveries

FROM delivery_table d

JOIN product_table p

ON d.Product_Id = p.Id

GROUP BY p.Product;Escreva uma consulta SQL para descobrir o número total de entregas para cada produto.

Por que isso é perguntado: Avaliar sua habilidade de filtrar dados baseados em tempo.

Para pegar os registros de vendas dos últimos 30 dias:

SELECT *

FROM sales_table

WHERE Purchase_date >= DATE_SUB(CURRENT_DATE(), INTERVAL 30 DAY);Escreva uma consulta SQL para contar o número de produtos únicos vendidos na última semana.

Por que isso é perguntado: Avaliar sua capacidade de fazer contagens distintas em dados baseados em tempo.

Para contar os produtos diferentes vendidos nos últimos 7 dias:

SELECT COUNT(DISTINCT Product_Id) AS Unique_Products_Sold

FROM sales_table

WHERE Purchase_date >= DATE_SUB(CURRENT_DATE(), INTERVAL 7 DAY);Escreva uma consulta SQL para agrupar os dados de vendas por produto e calcular a receita total de cada um.

Por que isso é perguntado: Para testar sua habilidade de usar GROUP BY e agregar vendas.

Para calcular a receita total por produto:

SELECT

p.Product,

SUM(p.Price) AS Total_Revenue

FROM sales_table s

JOIN product_table p

ON s.Product_Id = p.Id

GROUP BY p.Product;Escreva uma consulta SQL para calcular a porcentagem das vendas totais contribuída por cada produto.

Por que isso é perguntado: Avaliar sua habilidade de calcular porcentagens usando SQL.

Para calcular a porcentagem das vendas totais por produto:

SELECT

p.Product,

SUM(p.Price) AS Product_Sales,

(SUM(p.Price) / (SELECT SUM(Price) FROM product_table)) * 100 AS Sales_Percentage

FROM sales_table s

JOIN product_table p

ON s.Product_Id = p.Id

GROUP BY p.Product;Escreva uma consulta SQL para classificar os produtos com base no total de vendas.

Por que isso é perguntado: Para ver se você consegue usar funções de janela para classificação.

Para classificar os produtos com base nas vendas totais:

SELECT

p.Product,

SUM(p.Price) AS Total_Sales,

RANK() OVER (ORDER BY SUM(p.Price) DESC) AS Sales_Rank

FROM sales_table s

JOIN product_table p

ON s.Product_Id = p.Id

GROUP BY p.Product;Escreva uma consulta SQL para calcular o tempo médio de entrega de cada produto.

Por que isso é perguntado: Avaliar sua habilidade de trabalhar com diferenças de data no SQL.

Para calcular o tempo médio de entrega por produto:

SELECT

p.Product,

AVG(DATE_DIFF(d.Deliver_date, s.Purchase_date, DAY)) AS Avg_Delivery_Time

FROM sales_table s

JOIN delivery_table d

ON s.Id = d.Sales_Id

JOIN product_table p

ON s.Product_Id = p.Id

GROUP BY p.Product;Perguntas avançadas e baseadas em cenários

Além do conhecimento básico e da proficiência em SQL, habilidades de resolução de problemas do mundo real são essenciais para trabalhar com o BigQuery em grande escala.

As perguntas avançadas da entrevista geralmente focam em lidar com grandes conjuntos de dados, otimizar o desempenho, gerenciar pipelines de dados e resolver problemas comuns em ambientes de produção.

Você pode contar como foi sua experiência com a implementação de pipelines de dados no BigQuery?

Por que isso é perguntado: Avaliar seus conhecimentos práticos sobre como criar, gerenciar e otimizar pipelines de dados no BigQuery, incluindo ingestão, transformação, orquestração e monitoramento.

O entrevistador quer saber mais sobre sua experiência prática com o design e a implementação de pipelines de dados no BigQuery. Você deve discutir:

- Ingestão de dados: Métodos usados (, BigQuery Data Transfer Service, Cloud Storage, ingestão de streaming).

- Transformação de dados: Uso detransformações baseadas em SQL do , consultas programadas ou ferramentas como Dataflow e dbt.

- Orquestração: Como você gerencia fluxos de trabalho de pipeline usandoo Cloud Composer (Apache Airflow), Cloud Functions ou Cloud Scheduler.

- Monitoramento e otimização: Como programaro desempenho do pipeline d , resolver problemas e otimizar os custos das consultas.

Uma resposta forte deve incluir exemplos reais de desafios que você enfrentou e como você os superou, como lidar com grandes conjuntos de dados, otimizar o desempenho de consultas ou garantir a integridade dos dados em pipelines de produção.

Alguns recursos úteis para implementar um projeto desse tipo são:

- O seguinte guia do YouTubesobre pipelines de lote ETL usando o BigQuery.

- O seguinte repositório GitHub do pipeline completo.

- O seguinte pipeline ETL com Airflow e repositório GitHub do BigQuery.

Como você pode tirar registros duplicados de uma coluna em uma tabela grande do BigQuery sem mexer no nome da tabela?

Por que isso é perguntado: Avaliar sua capacidade de lidar com dados duplicados de forma eficiente no BigQuery sem alterar a estrutura da tabela.

Quando você tá lidando com uma tabela cheia de milhões de linhas e valores duplicados numa coluna específica, a melhor maneira de fazer isso é usar a função de janela ` ROW_NUMBER() ` pra identificar e manter só a primeira ocorrência de cada duplicata, removendo o resto.

Você pode fazer isso sobrescrevendo a tabela com uma versão desduplicada usando uma instrução ` CREATE OR REPLACE TABLE `:

CREATE OR REPLACE TABLE tableX AS

SELECT * EXCEPT(row_number)

FROM (

SELECT *,

ROW_NUMBER() OVER (PARTITION BY troubleColumn ORDER BY someOtherColumn) AS row_number

FROM tableX

)

WHERE row_number = 1;Funciona assim:

-

ROW_NUMBER()atribui um número de linha exclusivo a cada registro dentro do mesmo valor detroubleColumn, garantindo que apenas um registro por grupo duplicado seja mantido. -

O

PARTITION BYtroubleColumnagrupa as linhas com base nas duplicatas nessa coluna. -

O

ORDER BYsomeOtherColumn(por exemplo,Purchase_date) garante que um registro específico seja mantido. -

A consulta externa filtra só a primeira ocorrência (

row_number = 1), removendo efetivamente as duplicatas. -

A instrução

CREATE OR REPLACE TABLEgarante que a tabela continue com o mesmo nome enquanto a substitui pelos dados limpos.

Essa abordagem elimina duplicatas de forma eficiente, sem criar uma nova tabela ou afetar a estrutura geral das tabelas.

Como você usa o BigQuery para visualização de dados e relatórios, e quais são as ferramentas mais comuns para isso?

Por que isso é perguntado: Avaliar sua capacidade de integrar o BigQuery com ferramentas de visualização e comunicar insights de forma eficaz por meio de relatórios.

O BigQuery é um backend super útil para visualização de dados e relatórios, permitindo conexões diretas com ferramentas como o Google Looker Studio (antigo Data Studio), Tableau e Power BI.

Essas ferramentas permitem que os usuários consultem dados em tempo real e criem painéis, gráficos e relatórios personalizados sem precisar exportar os dados manualmente. As principais técnicas de visualização incluem:

- Agregando e transformando dados no BigQuery usando SQL antes da visualização.

- Criando painéis interativos com filtros dinâmicos e recursos de detalhamento.

- Otimizando consultas e visualizações materializadas para melhorar o desempenho do painel.

Uma resposta forte deve destacar casos de uso reais, como:

- Acompanhando os KPIs do negócio

- Acompanhando as tendências

- Gerando relatórios automáticos

Para implementar seu próprio projeto de visualização de dados, você pode seguir os projetos especializados do DataCamp sobre análise de hábitos de recarga de veículos elétricos e exploração da rede de transporte de Londres com o BigQuery.

Perguntas sobre as melhores práticas e otimização do BigQuery

Trabalhar de forma eficiente com o BigQuery vai além de escrever consultas SQL — é preciso otimizar o desempenho, gerenciar custos e implementar as melhores práticas para garantir operações de dados tranquilas. Como o BigQuery funciona com um modelo de pagamento por uso, entender como minimizar varreduras de dados, aproveitar o particionamento e o agrupamento e otimizar a execução de consultas é essencial tanto para o desempenho quanto para a eficiência de custos.

Quais são as melhores práticas para gerenciar os custos do BigQuery de forma eficiente?

Por que isso é perguntado: Avaliar sua habilidade de otimizar a eficiência de custos enquanto trabalha com grandes conjuntos de dados no BigQuery.

Para gerenciar os custos do BigQuery de forma eficaz, você deve:

-

Otimize as consultas para verificar só as colunas e linhas necessárias, evitando

SELECT *. -

Use tabelas particionadas e agrupadas para minimizar a varredura de dados e melhorar o desempenho das consultas.

-

Use ferramentas de monitoramento de custos como orçamentos, alertas e políticas de controle de custos no Google Nuvem.

-

Aproveite as reservas de vagas para ter preços mais previsíveis e economizar.

-

Limpe regularmente as tabelas e partições que não estão sendo usadas para otimizar os custos de armazenamento.

Uma estratégia de gerenciamento de custos bem estruturada ajuda a controlar as despesas e, ao mesmo tempo, manter a execução eficiente das consultas.

Quais são as melhores práticas para otimizar o desempenho das consultas no BigQuery?

Por que isso é perguntado: Avaliar sua habilidade de escrever consultas eficientes que diminuam o tempo e o custo de execução.

Para otimizar o desempenho das consultas no BigQuery:

-

Crie um esquema eficiente, escolhendo os tipos de dados certos e evitando normalização demais.

-

Use particionamento e agrupamento para reduzir a quantidade de dados verificados.

-

Evite

SELECT *, recuperando apenas as colunas necessárias. -

Otimize as operações JOIN e GROUP BY, garantindo que elas sigam as melhores práticas para consultas em grande escala.

-

Use o cache e as visualizações materializadas para armazenar resultados pré-calculados e melhorar o desempenho.

-

Use funções de agregação aproximadas, como

APPROX_COUNT_DISTINCT, quando não for necessária precisão exata.

Seguindo essas práticas, você pode acelerar as consultas, reduzir os custos de computação e melhorar a eficiência geral.

O que são slots do BigQuery e como eles afetam o desempenho das consultas?

Por que isso é perguntado: Avaliar sua compreensão dos recursos de computação do BigQuery e seu efeito na execução de consultas.

Os slotsdo BigQuery são unidades de capacidade computacional usadas para processar consultas SQL. Eles são alocados de forma dinâmica com base nas demandas da carga de trabalho, garantindo uma utilização eficiente dos recursos. As organizações podem escolher entre:

- Slots sob demanda, que se ajustam automaticamente de acordo com as necessidades de consulta.

- Slots reservados, que oferecem um desempenho mais previsível e economia de custos para cargas de trabalho consistentes.

Uma gestão eficiente dos slots pode reduzir o tempo de execução das consultas, otimizar a alocação de recursos e diminuir os custos gerais.

Como você pode monitorar e otimizar os custos do BigQuery de forma eficaz?

Por que isso é perguntado: Para avaliar sua capacidade de programar e controlar as despesas do BigQuery.

Para monitorar e otimizar os custos no BigQuery:

- Analise a execução da consulta usando o histórico de consultas e planos EXPLAIN para identificar operações dispendiosas.

- Ative os registros de auditoria para acompanhar os padrões de uso e detectar consultas ineficientes.

- Defina orçamentos e alertas de custos para evitar despesas inesperadas.

- Otimize o uso dos slots, aproveitando os slots reservados para cargas de trabalho estáveis para reduzir custos.

- Limpe regularmente as tabelas e partições que não usa pra evitar taxas de armazenamento desnecessárias.

Ao implementar essas estratégias, você pode garantir um processamento de dados econômico, mantendo o desempenho e a escalabilidade.

Dicas extras para arrasar na sua entrevista sobre o BigQuery

Aqui vão algumas dicas finais pra você arrasar na sua próxima entrevista sobre o BigQuery.

Domine os fundamentos. Entenda a arquitetura do BigQuery, incluindo o design sem servidor, a separação entre armazenamento e computação e o mecanismo de consulta Dremel com nossocurso introdutório ao BigQuery. Aprenda sobre conjuntos de dados, tabelas, visualizações e visualizações materializadas para gerenciar e estruturar dados de forma eficiente. Nossotutorial sobre visualizações materializadas SQL vai ajudar.

Melhore suas habilidades em SQL e otimização de consultas. Pratique funções SQL específicas do BigQuery (ARRAYs, STRUCTs, funções de janela) para consultas complexas com nosso código Getting Started with BigQuery. Otimize consultas com particionamento, agrupamento e funções aproximadas para reduzir custos e melhorar o desempenho, seguindo a documentação oficial do Google.

Ganhe experiência prática. Trabalhe em projetos reais usando conjuntos de dados públicos e crie relatórios com o Looker Studio, Tableau ou Power BI com os projetos do DataCamp. Experimentar nossas análises sobre hábitos de carregamento de veículos elétricos e explorar a rede de transportes de Londres são ótimas maneiras de melhorar suas habilidades em SQL.

Josep é cientista de dados e gerente de projetos no Conselho de Turismo da Catalunha, usando dados para melhorar a experiência dos turistas na Catalunha. Sua experiência inclui o gerenciamento de armazenamento e processamento de dados, juntamente com análises avançadas e a comunicação eficaz de insights de dados.

Ele também é um educador dedicado, lecionando no programa de mestrado em Big Data da Universidade de Navarra e contribuindo regularmente com artigos perspicazes sobre ciência de dados para o Medium e o KDNuggets.

Ele é bacharel em Engenharia Física pela Universidade Politécnica da Catalunha e mestre em Sistemas Interativos Inteligentes pela Universidade Pompeu Fabra.

Atualmente, ele está empenhado em tornar as tecnologias relacionadas a dados mais acessíveis a um público mais amplo por meio da publicação ForCode'Sake no Medium.

Perguntas frequentes

O que é o BigQuery e como ele é diferente dos bancos de dados tradicionais?

O BigQuery é um warehouse totalmente gerenciado e sem servidor na nuvem Google, feito pra análise de dados em grande escala. Diferente dos bancos de dados relacionais locais tradicionais, que geralmente são baseados em linhas e limitados pelo hardware, o BigQuery é um sistema de armazenamento colunar nativo da nuvem que oferece escalabilidade quase infinita. Sua arquitetura distribuída e modelo de preços pré-pagos tornam-no mais eficiente para lidar com cargas de trabalho analíticas do que os bancos de dados convencionais.

Quais são as principais vantagens de usar o BigQuery?

O BigQuery tem cinco vantagens principais: (1) Escalabilidade – aumenta ou diminui os recursos automaticamente, (2) Flexibilidade – a infraestrutura se adapta às necessidades do negócio, (3) Alta segurança – criptografia e controle de acesso integrados, (4) Custo-benefício – preços pagos conforme o uso e (5) Compartilhamento de dados e colaboração – as soluções baseadas na nuvem permitem acesso fácil entre as equipes.

O que é particionamento no BigQuery e como ele melhora o desempenho?

A partição no BigQuery divide tabelas grandes em partes menores e mais fáceis de gerenciar com base em critérios como data, hora de ingestão ou valores numéricos. Isso melhora o desempenho da consulta, verificando só as partições relevantes em vez de toda a tabela, reduzindo os custos da consulta e o tempo de execução. É especialmente útil para análises de séries temporais e grandes conjuntos de dados.

Qual é a diferença entre uma tabela e uma visualização no BigQuery?

Uma tabela guarda os dados fisicamente, enquanto uma visualização é uma tabela virtual que pega os dados de forma dinâmica com base em uma consulta SQL pré-definida. As visualizações ajudam a simplificar consultas complexas, reforçar os controles de acesso aos dados e melhorar os tempos de execução das consultas sem duplicar os dados.

Como o BigQuery lida com a segurança dos dados?

O BigQuery usa várias camadas de segurança: (1) Criptografia de dados em repouso e em trânsito, (2) Gerenciamento de identidade e acesso (IAM) para controle de acesso granular, (3) Registro de auditoria para monitorar o uso e a conformidade e (4) Chaves de criptografia gerenciadas pelo cliente para controle de segurança aprimorado.