Lernpfad

Meta hat kürzlich veröffentlicht Meta Movie Genveröffentlicht, was sowohl ein bedeutendes als auch ein unerwartetes Ereignis in der Landschaft der Text-zu-Video-Generierung ist - ich glaube nicht, dass viele Leute Meta auf dem Radar hatten, wenn es um die Videogenerierung geht.

Angesichts des wettbewerbsintensiven Umfelds, in dem mehrere renommierte Unternehmen wie OpenAI arbeiten bereits an robusten Modellen wie Soraarbeitet, ist die Veröffentlichung von Meta bemerkenswert.

Das Modell zeigt bei verschiedenen Aufgaben gute Leistungen und übertrifft die Qualität von Angeboten etablierter Anbieter wie Runway Gen3, LumaLabs und vor allem Sora von OpenAI.

In diesem Blog gehe ich darauf ein, was Meta Movie Gen ist, wie es funktioniert, welche Möglichkeiten und Grenzen es hat und welche Sicherheitsaspekte bei seiner Verwendung zu beachten sind.

Wenn du dir einen Überblick über den Bereich der Videogenerierung verschaffen willst, empfehle ich dir diesen Artikel über Top-KI-Video-Generatoren.

Was ist Meta Movie Gen?

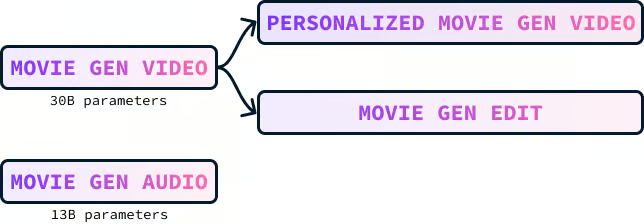

Meta Movie Gen ist eine Sammlung grundlegender Modelle für die Erstellung verschiedener Arten von Medien, einschließlich Text-zu-Video, Text-zu-Audio und Text-zu-Bild. Es besteht aus vier Modellen:

- Movie Gen Video

- Movie Gen Audio

- Personalisierter Film Gen Video

- Film Gen Bearbeiten

Movie Gen Video Modell

Movie Gen Video ist ein Modell mit 30 Milliarden Parametern, das entwickelt wurde, um Bilder und Videos auf der Grundlage von Textbeschreibungen zu erstellen. Das Modell kann qualitativ hochwertige Videos mit einer Länge von bis zu 16 Sekunden erzeugen, die der vorgegebenen Textaufforderung entsprechen. Es kann Inhalte in verschiedenen Größen, Auflösungen und Längen produzieren.

Hier ist ein Beispiel für ein Video, das mit der Aufforderung erstellt wurde:

"Ein Faultier mit rosa Sonnenbrille liegt auf einem Donut-Schwimmer in einem Pool. Das Faultier hält ein tropisches Getränk in der Hand. Die Welt ist tropisch. Das Sonnenlicht wirft einen Schatten."

Die Wasserreflexionen in dem Video sind bemerkenswert. Ich fand auch die Schatten auf dem Gesicht des Faultiers sehr interessant. Diese kleinen Details, wenn sie gut ausgeführt werden, bleiben oft unbemerkt. Sie sind jedoch auffällig und stören die Illusion, wenn sie schlecht gemacht sind.

Movie Gen Audio Modell

Movie Gen Audio ist ein 13-Milliarden-Parameter-Modell, das Videotonspuren erstellen kann, die zum Inhalt eines Videos passen. Es kann auch Audio aus einer Textaufforderung erzeugen.

Es erzeugt hochwertige 48kHz-Audiosignale, die mit Videos unterschiedlicher Länge synchronisiert werden können, sogar mit Videos, die mehrere Minuten lang sind. Das Modell kann auch Umgebungsgeräusche erzeugen, die zu unsichtbaren Quellen im Video passen, Soundeffekte, die sich mit Aktionen synchronisieren, und passende Hintergrundmusik.

Hier ist ein Beispiel für die Musik und die Soundeffekte, die mit Hilfe des Prompts für eines der Videos erstellt wurden:

"Raschelnde Blätter und knackende Zweige, mit einem orchestralen Lernpfad."

Beachte, dass die Stimmung des Lernpfads nicht in der Aufforderung enthalten war. Das Model war in der Lage, die Stimmung aus dem Inhalt des Videos aufzugreifen.

Personalisiertes Movie Gen Video Modell

Das Movie Gen Video-Modell kann Videos von einer ausgewählten Person auf der Grundlage einer Textbeschreibung und eines Bildes dieser Person erstellen. Im Video bleibt die Identität der Person erhalten, während sie der Textaufforderung folgt.

Das folgende Beispiel wurde erstellt, indem das Selfie der Person mit der Aufforderung kombiniert wurde:

"Eine weibliche DJane legt auf einer Dachterrasse in LA auf. Sie trägt eine rosa Jacke und riesige Kopfhörer. Neben der Frau steht ein Gepard. Der Hintergrund ist eine Stadtlandschaft."

Meiner Meinung nach ist dieses Modell ihr Kronjuwel, denn es hat großes Potenzial, wenn es in ihre anderen Produkte, wie z.B. Instagram, integriert wird. Stell dir vor, du erstellst Videos, in denen du dich in verschiedenen Szenarien zeigst, die alle aus einem einzigen Bild und einer Textaufforderung entstehen. Das könnte zu einer Explosion von kreativen und ansprechenden Inhalten führen.

Movie Gen Modell bearbeiten

Mit dem Movie Gen Edit Modell können wir ganz einfach detaillierte und kreative Änderungen an echten und erfundenen Videos vornehmen, indem wir nur Textanweisungen verwenden.

Das Modell hat das Potenzial, die Videoschnitt-Workflows in verschiedenen Branchen zu revolutionieren. Seine Fähigkeit, textbasierte Bearbeitungsanweisungen genau zu verstehen und auszuführen, könnte den Bearbeitungsprozess erheblich verbessern und ihn schneller, effizienter und für eine größere Zahl von Nutzern zugänglich machen. Diese Technologie könnte Filmemachern, Inhaltserstellern, Pädagogen und allen, die mit Videoinhalten arbeiten, zugutekommen.

Wie funktioniert Movie Gen Video?

Das Training des Movie Gen Video-Modells umfasste mehrere Schlüsselkomponenten: die Datenerfassung und -aufbereitung, den Trainingsprozess selbst, die Feinabstimmung für eine verbesserte Qualität und die Upsampling-Techniken, die verwendet werden, um hochauflösende Ergebnisse zu erzielen.

Daten und Vorverarbeitung

Das Movie Gen Video-Modell wurde auf einem riesigen Datensatz trainiert, der Hunderte von Millionen Video-Text-Paaren und über eine Milliarde Bild-Text-Paare enthält.

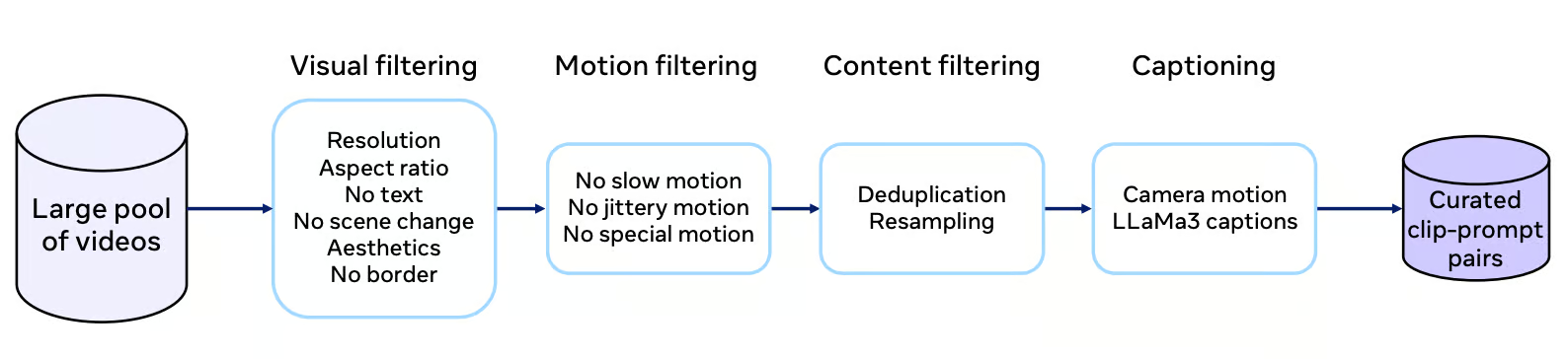

Jedes Video im Datensatz wird einem strengen Kuratierungsprozess unterzogen, der eine Filterung nach visueller Qualität, Bewegungsmerkmalen und inhaltlicher Relevanz beinhaltet. Der Filterprozess zielt darauf ab, Videos mit nicht-trivialen Bewegungen, Einzelaufnahmen und einer Vielzahl von Konzepten auszuwählen, einschließlich eines großen Anteils von Menschen.

Quelle: Film Gen Forschungspapier

Hochwertige Beschriftungen sind sehr wichtig, um das Modell effektiv zu trainieren. Movie Gen Video verwendet das LLaMa3-Videomodell, um detaillierte Untertitel zu erstellen, die den Videoinhalt genau beschreiben. Diese Beschriftungen gehen über die bloße Kennzeichnung von Objekten hinaus und enthalten Beschreibungen von Handlungen, Kamerabewegungen und sogar Informationen zur Beleuchtung. Diese reichhaltigen Textinformationen helfen dem Modell, ein differenzierteres Verständnis des visuellen Geschichtenerzählens zu erlernen.

Ausbildungsprozess

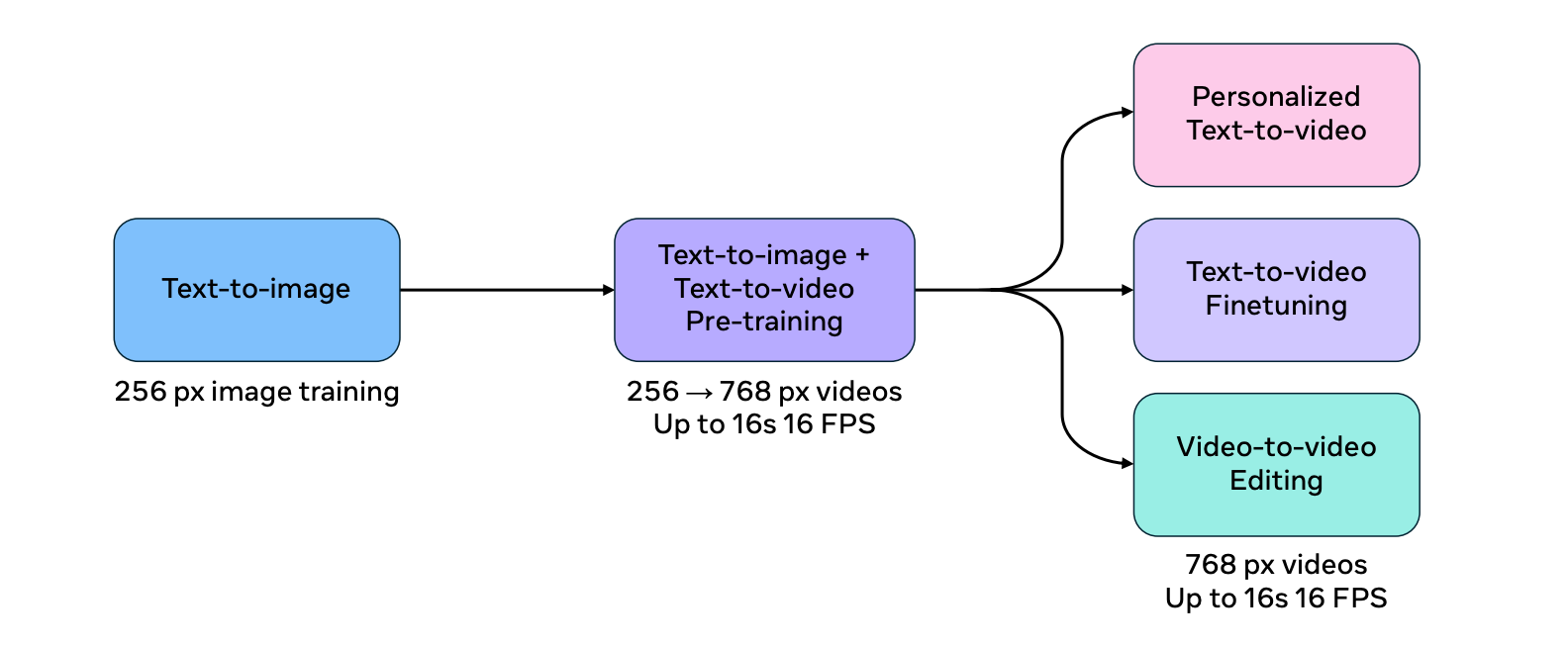

Der Trainingsprozess für Movie Gen Video ist in mehrere Stufen unterteilt, um die Effizienz und Skalierbarkeit des Modells zu verbessern.

Das Modell wird zunächst für die Text-zu-Bild-Aufgabe mit Bildern in niedrigerer Auflösung trainiert. Diese "Aufwärmphase" ermöglicht es dem Modell, grundlegende visuelle Konzepte zu lernen, bevor es die komplexere Aufgabe der Videogenerierung in Angriff nimmt.

Das Modell wird dann gemeinsam für die Text-zu-Bild- und die Text-zu-Video-Aufgabe trainiert, wobei die Auflösung der Eingabedaten schrittweise erhöht wird. Dieser gemeinsame Trainingsansatz hilft dem Modell, die Fülle und Vielfalt der Bild-Text-Datensätze zu nutzen und gleichzeitig die Komplexität der Videoerstellung zu lernen.

Quelle: Film Gen Forschungspapier

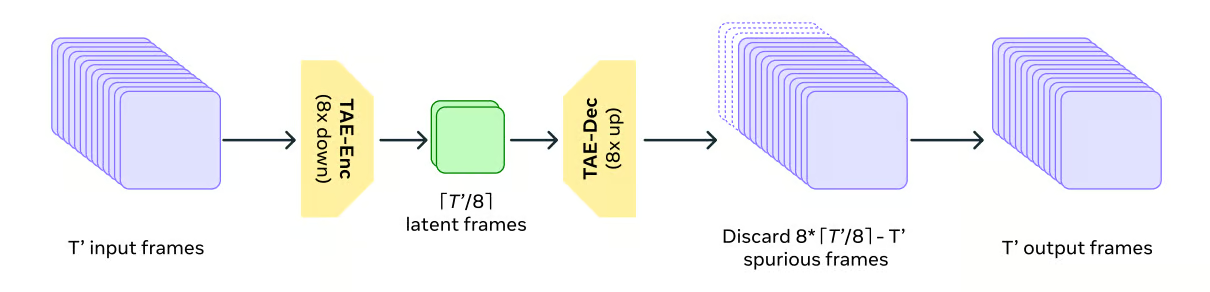

Zur Bewältigung der Berechnungsanforderungen von Videodaten zu bewältigen, verwendet Movie Gen Video ein Temporal Autoencoder Modell (TAE), um die Videos zeitlich zu komprimieren und zu dekomprimieren. Dies ist vergleichbar mit dem Verkleinern und Entkleinern von Dateien auf einem Computer und ermöglicht es dem Modell, mit einer handlicheren Darstellung der Videodaten zu arbeiten.

Quelle: Film Gen Forschungspapier

Movie Gen Video verwendet ein Trainingsziel namens Flow Matching. Anstatt das endgültige Video direkt zu generieren, leitet das Flow Matching das Modell dazu an, ein zufälliges Rauschmuster Schritt für Schritt in das gewünschte Video zu verwandeln.

Beim Flow Matching geht es darum, die Geschwindigkeit der Proben im latenten Raum vorherzusagen, anstatt die Proben selbst direkt vorherzusagen. Diese Methode ist effizienter und leistungsfähiger als traditionelle diffusionsbasierte Methoden.

Feinabstimmung

Um die Qualität und Ästhetik der erzeugten Videos zu verbessern, wird das Modell einer überwachten Feinabstimmung anhand einer kleineren Menge von manuell kuratierten Videos mit hochwertigen Untertiteln. Das ist wie bei einem Künstler, der seine Technik unter fachkundiger Anleitung verfeinert, was zu visuell ansprechenderen und realistischeren Videoergebnissen führt.

Das endgültige Movie Gen Video-Modell wird durch die Durchschnittsbildung mehrerer Modelle erstellt, die mit verschiedenen Datensätzen, Hyperparametern und Pretraining-Checkpoints trainiert wurden. Mit dieser Technik lassen sich die Stärken verschiedener Modelle kombinieren, was zu einer robusteren und zuverlässigeren Leistung führt.

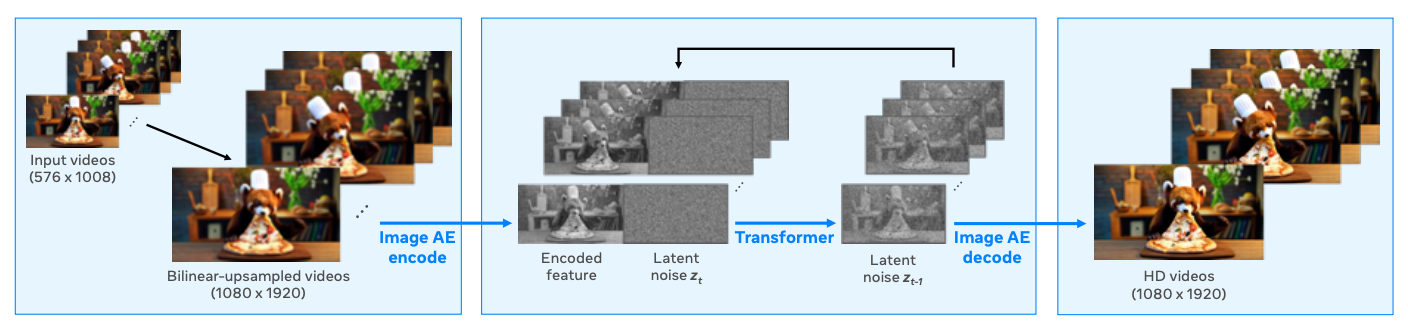

Upsampling

Das Modell produziert Videos mit einer Auflösung von 768 Pixeln und nutzt Upsampling, um die Auflösung auf Full HD 1080p zu ändern, was zu schärferen und optisch ansprechenderen Videos führt. Dieser Ansatz wird häufig verwendet, da er eine recheneffiziente Lösung darstellt, da das Basismodell weniger Token verarbeiten kann und trotzdem hochauflösende Ergebnisse liefert.

Der Spatial Upsampler funktioniert als Video-zu-Video-Erzeugungsmodell. Er nimmt das Video mit niedrigerer Auflösung als Input, rechnet es mit Hilfe von bilinearer Interpolation auf die Zielauflösung hoch und kodiert es dann mit einem frame-weisen Variational Autoencoder (VAE) in einen latenten Raum.

Ein Latent Space-Modell generiert dann die Latents des HD-Videos, abhängig von den kodierten Latents des Videos mit niedrigerer Auflösung. Schließlich wandelt der VAE-Decoder die resultierenden HD-Videolatenten zurück in den Pixelraum und erzeugt die endgültige hochauflösende Ausgabe.

Quelle: Film Gen Forschungspapier

Bewertung des Movie Gen Model

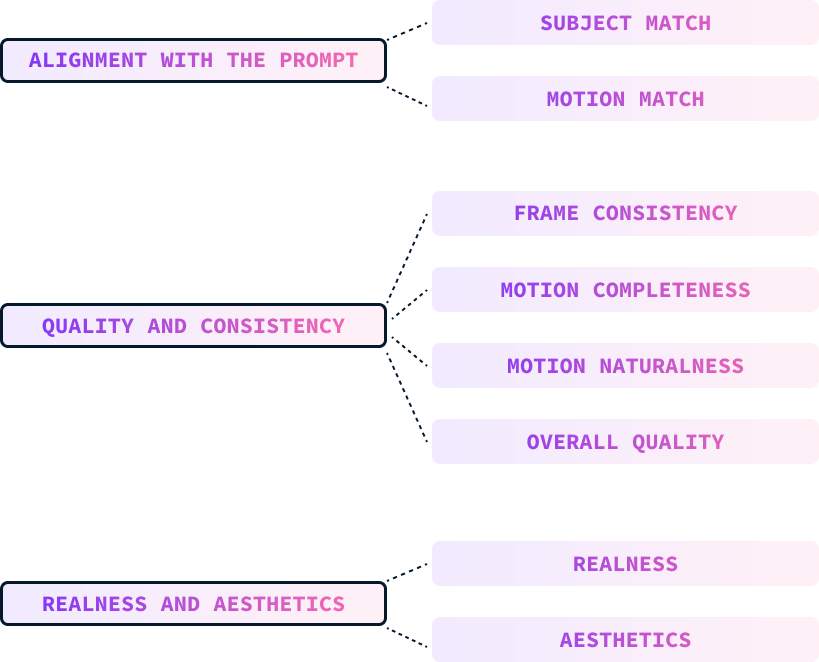

Die Bewertung eines Text-Videomodells ist aufgrund der zusätzlichen zeitlichen Dimension eine größere Herausforderung als die eines Text-Bild-Modells. Das Meta-Team hat das Modell anhand von drei Hauptkriterien bewertet:

- Ausrichtung auf die Aufforderung

- Qualität und Beständigkeit

- Realismus und Ästhetik

Diese Parameter werden manuell von Menschen bewertet, die die Videos nach diesen Parametern einstufen.

Ausrichtung auf die Aufforderung

Die Ausrichtung der Aufforderung misst, wie gut das generierte Video mit der eingegebenen Textaufforderung übereinstimmt, einschließlich der Beschreibungen des Motivs, der Bewegung, des Hintergrunds und anderer Details. Dies wird weiter untergliedert in:

- Das Thema passt: Konzentriert sich auf die Abstimmung von Aussehen, Hintergrund, Beleuchtung und Stil des Motivs.

- Antrag passt: Bewertet die Ausrichtung von bewegungsbezogenen Beschreibungen.

Qualität und Beständigkeit

Die Qualität und Konsistenz des erzeugten Videos wird unabhängig von der Textaufforderung bewertet. Diese Maßnahme ist unterteilt in:

- Rahmenkonsistenz: Überprüft auf Unstimmigkeiten oder Artefakte in der Darstellung von Objekten, der Beleuchtung und dem Hintergrund in verschiedenen Frames.

- Vollständigkeit des Antrags: Bewertet, ob das Video ausreichend Bewegung enthält, insbesondere bei ungewöhnlichen Themen oder Aktivitäten.

- Natürlichkeit der Bewegung: Beurteilt den Realismus und die Natürlichkeit der Bewegung und berücksichtigt dabei Aspekte wie die Bewegung der Gliedmaßen, die Mimik und die Einhaltung der Physik.

- Gesamtqualität: Ein ganzheitliches Urteil, das die Ausgewogenheit der drei vorangegangenen Unterachsen berücksichtigt, um die Gesamtgüte des Videos zu bestimmen.

Realismus und Ästhetik

Die Bewerter/innen wurden gebeten, die Fähigkeit des Modells zu bewerten, fotorealistische und ästhetisch ansprechende Videos zu produzieren. Diese Kriterien sind unterteilt in:

- Realness: Bewertet, wie sehr das Video einem realen Video ähnelt oder wie gut es einen realistischen Kunststil nachahmt, wenn es sich um fantastische Aufforderungen handelt.

- Ästhetik: Beurteilt die visuelle Attraktivität des Videos anhand von Faktoren wie Inhalt, Beleuchtung, Farbe und Kameraeffekte.

Bewertung Benchmark

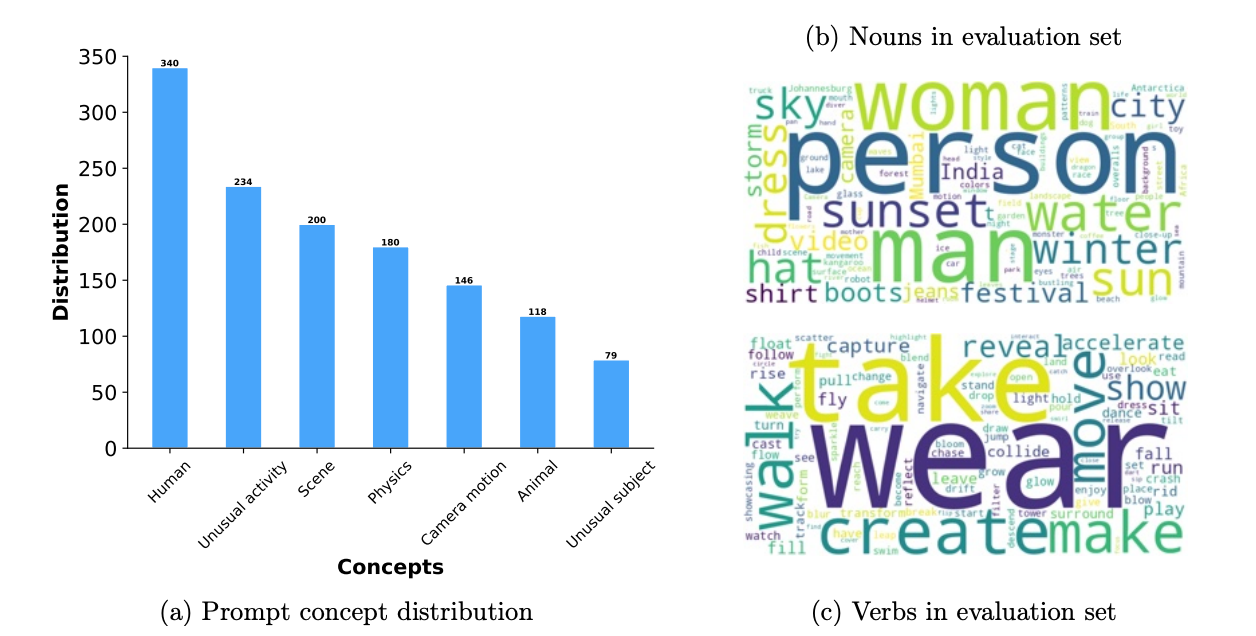

Die Benchmark-Daten wurden entwickelt, um Videogenerationen umfassend zu bewerten. Es enthält 1.000 Aufgaben, die verschiedene Prüfungsaspekte abdecken, wie zum Beispiel menschliche Aktivitäten, Tiere, Natur, Physik und ungewöhnliche Themen oder Aktivitäten.

Ihr Benchmark ist mehr als dreimal so groß wie die in früheren Studien verwendeten Werte. Jeder Prompt ist mit einer Bewegungsstufe (hoch, mittel, niedrig) versehen, um die Qualität der Erzeugung bei unterschiedlichen Bewegungsintensitäten zu bewerten.

Bei der Bewertung wird das gesamte Prompt-Set verwendet und es werden bestimmte Testmetriken untersucht, wobei der Schwerpunkt darauf liegt, wie gut die Modelle mit ungewöhnlichen Themen und Bewegungen umgehen, um ihre Generalisierungsfähigkeiten zu testen.

Das folgende Diagramm zeigt eine Aufschlüsselung der Aufforderungen, die bei der Bewertung verwendet wurden. Auf der linken Seite sehen wir die Verteilung der Begriffe in den Aufforderungen. Auf der rechten Seite sehen wir häufige Substantive und Verben, die in den Prompts verwendet werden (je größer das Wort, desto häufiger ist es):

Quelle: Film Gen Forschungspapier

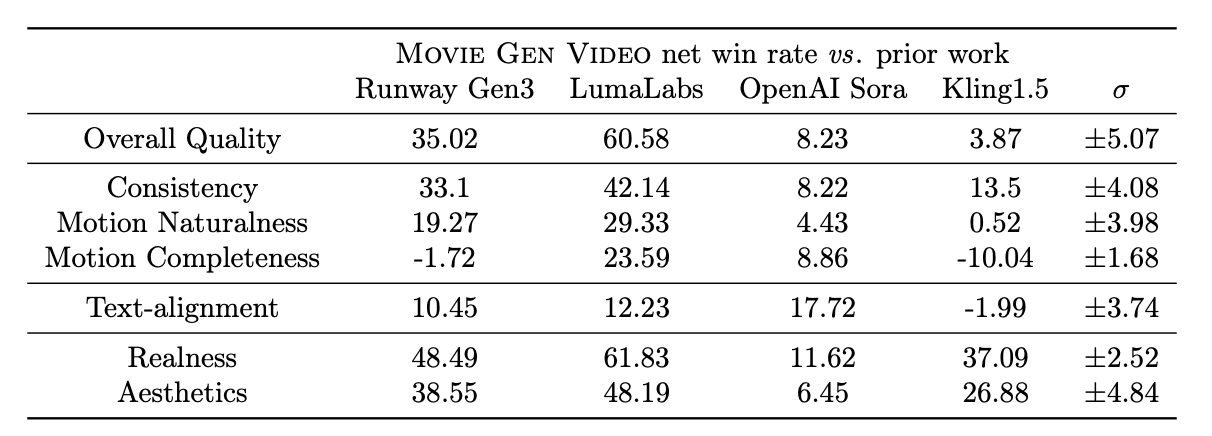

Die folgende Tabelle zeigt die Ergebnisse der menschlichen Bewertung der von verschiedenen Modellen produzierten Videos anhand verschiedener Bewertungskriterien. Die Zahlen stellen Nettogewinnraten dar, die als (Gewinn % - Verlust %) berechnet werden. Sie reicht von -100 (Totalverlust) bis 100 (Totalgewinn), wobei 0 ein Unentschieden bedeutet.

Quelle: Film Gen Forschungspapier

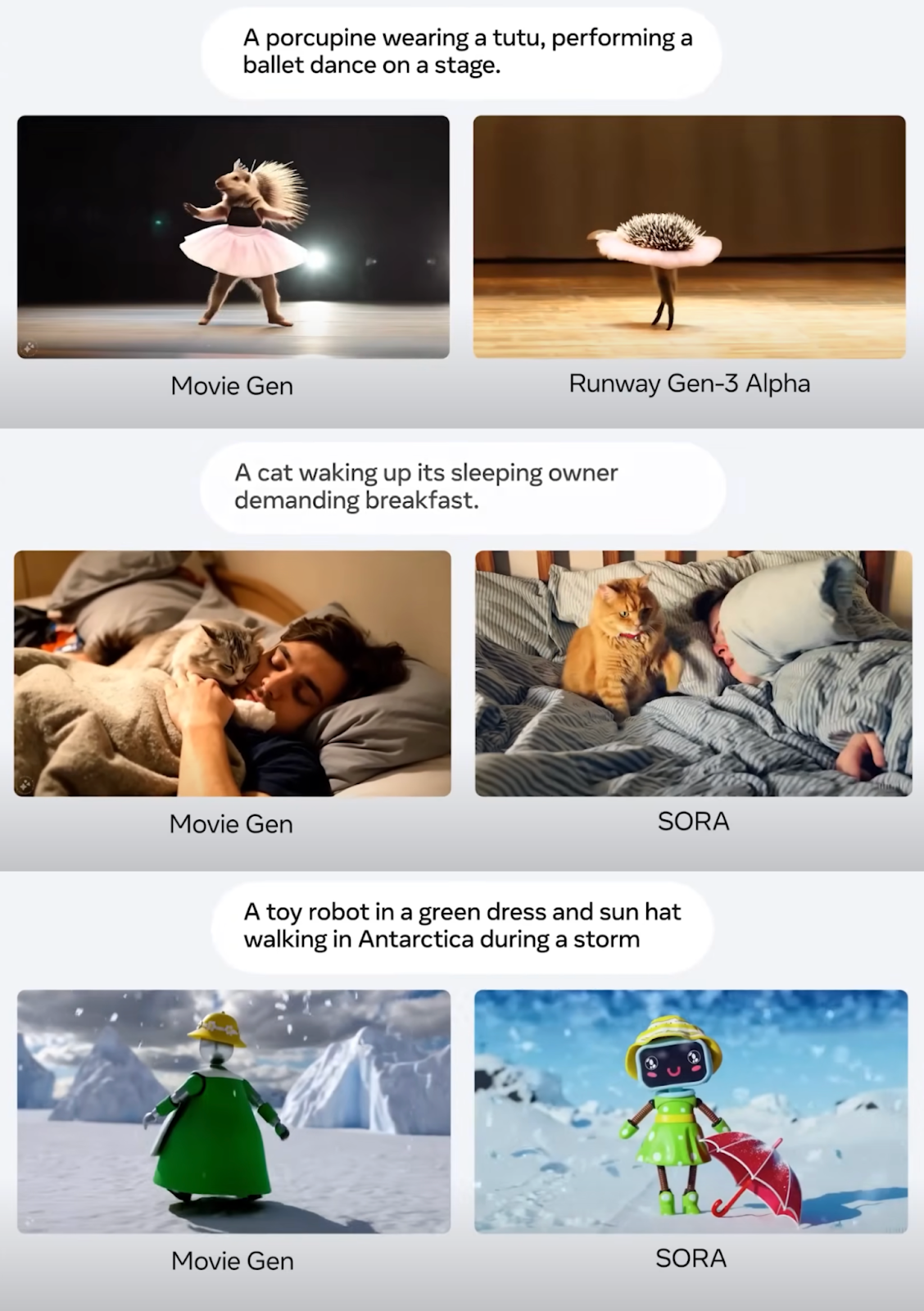

Meta Movie Gen vs. Sora vs. Startbahn Gen 3

Laut ihren Experimenten hat Movie Gen Video eine starke Leistung bei der Text-zu-Video-Generierung und übertrifft mehrere bestehende Modelle, einschließlich kommerzieller Systeme wie Runway Gen3 und LumaLabs, basierend auf menschlichen Bewertungen mit dem MovieGen Video Bench. Besonders Movie Gen Video zeigt deutliche Vorteile in

- Gesamtqualität: Die Bewerterinnen und Bewerter bewerteten die Ergebnisse von Movie Gen durchweg als qualitativ hochwertiger, insbesondere in Bezug auf die visuelle Wiedergabetreue, die Natürlichkeit der Bewegungen und die Übereinstimmung mit den Textanweisungen.

- Natürlichkeit und Konsistenz der Bewegung: Movie Gen zeigt einen deutlichen Vorsprung bei der Erstellung von Videos mit natürlichen und gleichmäßigen Bewegungen und übertrifft in diesen Aspekten Runway Gen3 und Sora von OpenAI. Diese Stärke ist wahrscheinlich auf die Fähigkeit des Modells zurückzuführen, durch sein Flow Matching-Trainingsziel und die umfangreiche Verwendung von Videodaten während des Trainings die reale Physik zu erlernen und zu simulieren.

- Realismus und Ästhetik: Movie Gen zeichnet sich auch dadurch aus, dass es im Vergleich zu Runway Gen3, LumaLabs und Kling1.5 Videos mit höherer Realitätsnähe und Ästhetik erzeugt.

Während MovieGen im Allgemeinen besser abschneidet als andere Modelle, erzeugt Kling1.5 manchmal Videos mit größeren Bewegungsgrößen, allerdings auf Kosten von Verzerrungen und Unstimmigkeiten. Dies verdeutlicht den Zielkonflikt zwischen der Vollständigkeit der Bewegungen und der visuellen Qualität, bei dem Movie Gen Video der Erzeugung realistischer und konsistenter Bewegungen den Vorrang vor der Maximierung der Bewegungsgröße gibt.

Unten findest du einige Screenshots aus der Meta Connect 2024-Präsentation, die ein paar Vergleichsbeispiele für die Videogenerierung zeigen:

Quelle: Film Gen Forschungspapier

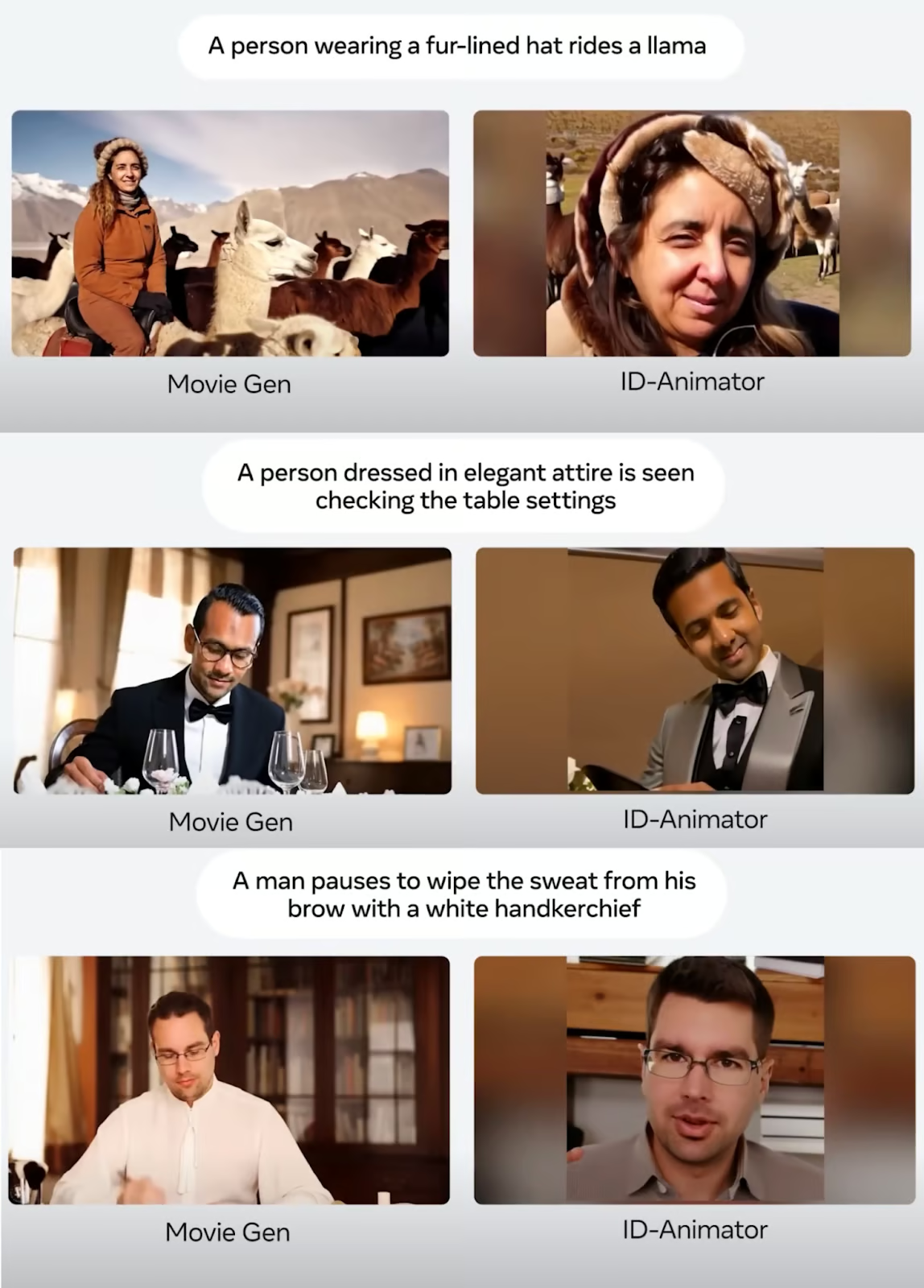

Hier sind einige Vergleichsbeispiele für Video-Personalisierung, bei denen ein Foto verwendet wird, um ein personalisiertes Video zu erstellen:

Quelle: Film Gen Forschungspapier

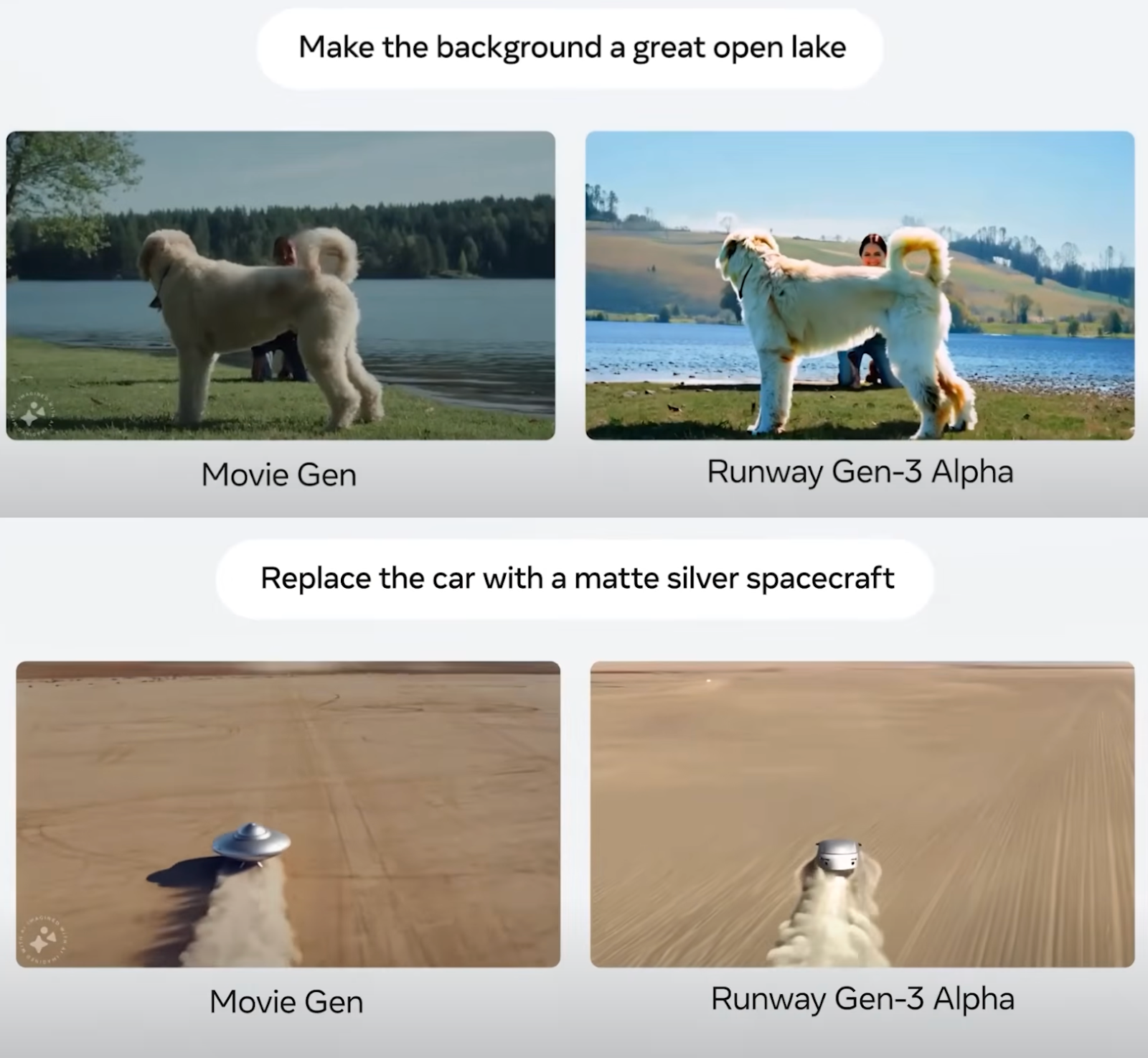

Die Screenshots unten zeigen Vergleichsbeispiele für die Videobearbeitung:

Quelle: Film Gen Forschungspapier

Insgesamt scheint es, dass Meta Movie Gen die Messlatte höher gelegt und einen neuen Standard für Text-zu-Video-Modelle gesetzt hat. Das in dem Papier beschriebene Bewertungsverfahren scheint fair zu sein, aber natürlich ist es schwer, sicher zu sein, solange diese Modelle nicht öffentlich zugänglich sind und neutrale Dritte sie vergleichen können.

Grenzen des Modells

Obwohl Meta Movie Gen bei der Medienerstellung gut aussieht, gibt es noch Bereiche, die verbessert werden können.

Das Modell hat manchmal mit komplexen Szenen zu kämpfen, die komplizierte Geometrie, Objektmanipulation und realistische Physiksimulationen beinhalten. Zum Beispiel können die Erzeugung überzeugender Interaktionen zwischen Objekten, die genaue Darstellung von Zustandsveränderungen (wie Schmelzen oder Zerbrechen) und die realistische Simulation der Auswirkungen von Schwerkraft oder Kollisionen immer noch eine Herausforderung für die Modelle darstellen.

Die Audiosynchronisation kann in bestimmten Szenarien problematisch sein. Insbesondere bei Bewegungen, die visuell klein sind, verdeckt werden oder ein hohes Maß an visuellem Verständnis erfordern, um den entsprechenden Ton zu erzeugen, können die Modelle Schwierigkeiten haben, eine perfekte Synchronisation zu erreichen. Beispiele für solche Herausforderungen sind das genaue Synchronisieren von Schritten mit einer gehenden Person, das Erzeugen geeigneter Geräusche für Objekte, die teilweise nicht sichtbar sind, und das Erkennen feiner Handbewegungen auf einer Gitarre, um die richtigen Musiknoten zu erzeugen.

Außerdem unterstützt das Movie Gen Audio-Modell in seiner jetzigen Form keine Spracherzeugung.

Sicherheitserwägungen und Modellfreigabe

Realistische KI-generierte Videos bergen erhebliche Risiken und ethische Herausforderungen, die berücksichtigt werden müssen. Zu diesen Risiken gehören die Manipulation von Vertrauen und die Verbreitung von Fehlinformationen durch Deepfakes, die den Ruf schädigen, die Öffentlichkeit falsch informieren und Unternehmen schaden können.

Einerseits kann es sich um eine Instagram-Funktion handeln, mit der ich ein cooles Video mit mir selbst darin erstellen kann, um es mit meinen Freunden zu teilen, aber andererseits kann ich mit derselben Funktion auch ein Fake-Video von jemand anderem erstellen. Wenn diese Technologien immer besser werden, kann es unmöglich werden, sie von den echten zu unterscheiden.

KI-generierte Inhalte gefährden Privatsphäre Bedrohungen für die Privatsphäre, die zu Erpressung oder Cybermobbing führen können.

Außerdem könnten diese KI-Tools die Kunst und das Urheberrecht untergraben, indem sie einzigartige Kunststile ohne Anerkennung imitieren. Zu den Lösungen gehören die Sensibilisierung und Aufklärung über Medienkompetenz, Investitionen in Erkennungstechnologie, die Einführung rechtlichen und ethischen Rahmen und die Verwendung von Wasserzeichen zur Authentifizierung.

Die Erstellung von KI-Videos birgt zwar großes Potenzial, erfordert aber eine sorgfältige Handhabung, um Vertrauen und Authentizität zu erhalten.

Meta ist offen mit seinen KI-Entwicklungen umgegangen und hat die Llama-Modelle. Aus Sicherheitsgründen werden die Meta Movie Gen Modelle jedoch noch nicht veröffentlicht. Laut ihrem Artikel sind zahlreiche Verbesserungen und Sicherheitsüberlegungen erforderlich, bevor sie eingesetzt werden können.

Fazit

In diesem Blogbeitrag haben wir die Movie Gen-Modelle von Meta vorgestellt, eine Reihe von KI-Modellen für die Erstellung und Bearbeitung von Videos mithilfe von Texteingaben.

Wir haben uns die vier verschiedenen Modelle, ihre Fähigkeiten und ihre Funktionsweise angesehen. In einer vergleichenden Analyse haben wir gezeigt, wie Meta Movie Gen im Vergleich zu anderen KI-Tools zur Videoerstellung abschneidet.

Meta Movie Gen hat zwar neue Maßstäbe in diesem Bereich gesetzt, aber der mögliche Missbrauch der Technologie gibt Anlass zu großer Sorge. Meta hat diese Risiken erkannt und geht bei der Veröffentlichung dieser Modelle sehr vorsichtig vor.

Um mehr über das Ökosystem von Meta AI zu erfahren, empfehle ich diese Blogs:

FAQs

Wann wird Meta Movie Gen veröffentlicht?

Meta hat noch kein genaues Datum für die Veröffentlichung von Movie Gen bekannt gegeben. Derzeit konzentriert sich das Unternehmen auf Forschung und Entwicklung, um die Fähigkeiten des Modells zu verbessern und mögliche Probleme zu beheben, bevor es auf breiter Front veröffentlicht wird. Es gibt zwar keinen offiziellen Zeitplan, aber ich halte es für möglich, dass Meta die Movie Gen-Funktionen zunächst in seine bestehenden Plattformen wie Instagram oder Facebook integriert, anstatt das vollständige Modell direkt zu veröffentlichen.

Wie lang kann der Meta Movie Gen sein?

Derzeit kann Meta Movie Gen Videos mit einer Länge von bis zu 16 Sekunden erstellen. Diese Einschränkung könnte auf den Rechenaufwand für die Erstellung längerer, qualitativ hochwertiger Videos zurückzuführen sein. Zukünftige Entwicklungen könnten die maximale Videolänge möglicherweise verlängern.

Wird Meta Movie Gen als Open Source verfügbar sein?

Meta hat noch nicht bestätigt, ob Movie Gen als Open Source verfügbar sein wird. Einige ihrer KI-Modelle, wie z.B. Llama, haben sie jedoch in der Vergangenheit offen zugänglich gemacht. Es ist möglich, dass sie sich dafür entscheiden, Teile von Movie Gen als Open Source zu veröffentlichen oder es unter einer speziellen Lizenz freizugeben, um die Forschung und Entwicklung der breiteren KI-Gemeinschaft zu fördern.

Wie ist die Videoqualität von Meta Movie Gen?

Meta Movie Gen generiert Videos in 1080p HD-Auflösung und bietet so eine hochwertige Ausgabe, die für verschiedene Anwendungen geeignet ist.