Cursus

Meta récemment sorti Meta Movie Genqui est à la fois un événement important et quelque peu inattendu dans le paysage de la génération de texte à partir de la vidéo - je ne pense pas que Meta était sur le radar de beaucoup de gens en ce qui concerne la génération de vidéo.

Compte tenu de l'environnement concurrentiel, avec plusieurs entreprises de premier plan telles que OpenAI travaillent déjà sur des modèles robustes comme Sorala publication de Meta est digne d'intérêt.

Le modèle est performant dans diverses tâches, surpassant ou égalant la qualité des offres d'acteurs établis tels que Runway Gen3LumaLabs et, notamment, Sora d'OpenAI.

Dans ce blog, je vais vous expliquer ce qu'est la Meta Movie Gen, comment elle fonctionne, quelles sont ses capacités et ses limites, et quelles sont les considérations de sécurité qui entourent son utilisation.

Si vous souhaitez avoir une vue d'ensemble du domaine de la génération de vidéos, je vous recommande de lire cet article sur les les meilleurs générateurs de vidéos d'IA.

Qu'est-ce que la Meta Movie Gen ?

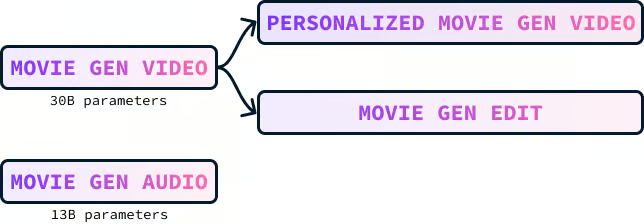

Meta Movie Gen est une collection de modèles fondamentaux pour la génération de divers types de médias, y compris le texte-vidéo, le texte-audio et le texte-image. Il se compose de quatre modèles :

- Movie Gen Video

- Movie Gen Audio

- Film personnalisé Gen Video

- Movie Gen Edit

Movie Gen Modèle vidéo

Movie Gen Video est un modèle de 30 milliards de paramètres conçu pour créer des images et des vidéos à partir de descriptions textuelles. Le modèle peut générer des vidéos de haute qualité d'une durée maximale de 16 secondes qui correspondent à l'invite textuelle donnée. Il peut produire des contenus de différentes tailles, résolutions et longueurs.

Voici un exemple de vidéo générée à l'aide de l'invite :

"Un paresseux avec des lunettes de soleil roses est allongé sur un donut flottant dans une piscine. Le paresseux tient une boisson tropicale. Le monde est tropical. La lumière du soleil projette une ombre".

Les reflets de l'eau dans la vidéo sont remarquables. J'ai également trouvé les ombres sur le visage du paresseux très intéressantes. Ces petits détails, lorsqu'ils sont bien exécutés, passent souvent inaperçus. Cependant, ils sont frappants et perturbent l'illusion lorsqu'ils sont mal exécutés.

Modèle audio Movie Gen

Movie Gen Audio est un modèle à 13 milliards de paramètres qui permet de créer des bandes sonores vidéo correspondant au contenu d'une vidéo. Il peut également générer du son à partir d'une invite textuelle.

Il génère un son de haute qualité, à 48 kHz, qui se synchronise avec des vidéos de différentes longueurs, même de plusieurs minutes. Le modèle peut également produire des sons ambiants, correspondant à des sources invisibles dans la vidéo, des effets sonores synchronisés avec les actions et une musique de fond adaptée.

Voici un exemple de la musique et des effets sonores générés pour l'une des vidéos à l'aide de l'invite :

"Des bruissements de feuilles et des claquements de brindilles, avec une piste musicale orchestrale".

Notez que l'ambiance de la piste musicale n'était pas présente dans le cursus. Le mannequin a su capter l'ambiance à partir du contenu de la vidéo.

Modèle de film personnalisé Gen Video

Le modèle Movie Gen Video peut générer des vidéos d'une personne choisie sur la base d'une description textuelle et d'une image de cette personne. La vidéo conserve l'identité de la personne tout en suivant le texte.

L'exemple suivant a été généré en combinant le selfie de la personne avec l'invite :

"Une femme DJ fait tourner des disques sur un toit de Los Angeles. Elle porte une veste rose et des écouteurs géants. Un guépard se trouve à côté de la femme. L'arrière-plan est un paysage urbain".

À mon avis, ce modèle est le joyau de la couronne, car il présente un énorme potentiel s'il est intégré à d'autres produits, tels qu'Instagram. Imaginez que des utilisateurs créent des vidéos les mettant en scène dans divers scénarios, tous générés à partir d'une seule image et d'une invite textuelle. Cela pourrait conduire à une explosion de contenu créatif et attrayant.

Movie Gen Edit model

Le modèle Movie Gen Edit nous permet d'apporter facilement des modifications détaillées et créatives à des vidéos réelles ou inventées, à l'aide de simples instructions textuelles.

Ce modèle a le potentiel de révolutionner les flux de travail de l'édition vidéo dans divers secteurs. Sa capacité à comprendre et à exécuter avec précision des instructions d'édition textuelles pourrait améliorer considérablement le processus d'édition, en le rendant plus rapide, plus efficace et accessible à un plus grand nombre d'utilisateurs. Cette technologie pourrait être utile aux cinéastes, aux créateurs de contenu, aux éducateurs et à tous ceux qui travaillent avec du contenu vidéo.

Comment fonctionne Movie Gen Video ?

La formation du modèle Movie Gen Video a comporté plusieurs éléments clés : la collecte et la préparation des données, le processus de formation lui-même, la mise au point pour améliorer la qualité et les techniques de suréchantillonnage utilisées pour obtenir des résultats à haute résolution.

Données et prétraitement

Le modèle Movie Gen Video a été entraîné sur un vaste ensemble de données contenant des centaines de millions de paires vidéo-texte et plus d'un milliard de paires image-texte.

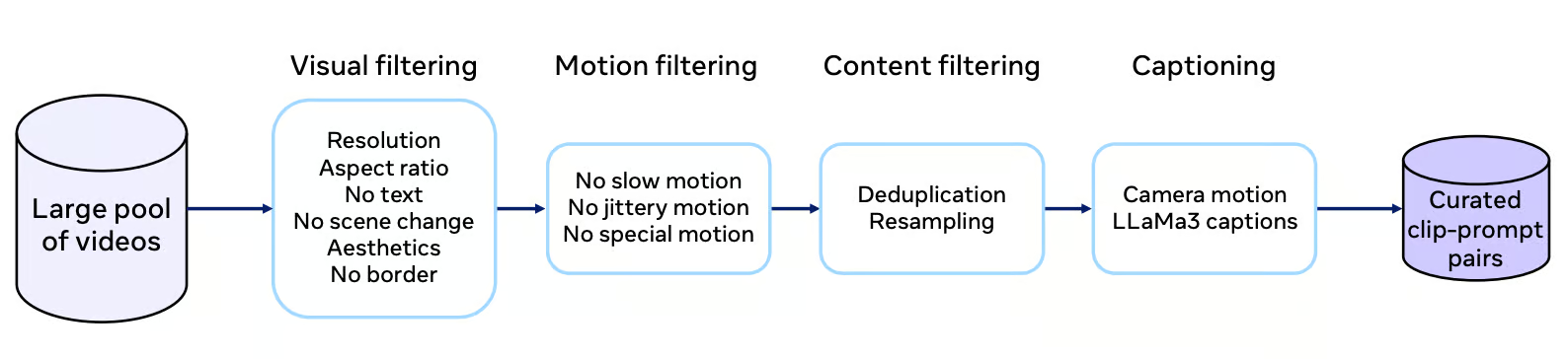

Chaque vidéo de l'ensemble de données est soumise à un processus de curation rigoureux qui implique un filtrage de la qualité visuelle, des caractéristiques de mouvement et de la pertinence du contenu. Le processus de filtrage vise à sélectionner des vidéos présentant des mouvements non triviaux, des prises de vue uniques et une gamme variée de concepts, y compris une part importante d'images humaines.

Source : Document de recherche sur le cinéma Gen

Des légendes de haute qualité sont très importantes pour former efficacement le modèle. Movie Gen Video utilise le modèle LLaMa3-Video pour générer des sous-titres détaillés qui décrivent avec précision le contenu de la vidéo. Ces légendes ne se limitent pas à l'étiquetage des objets ; elles comprennent des descriptions des actions, des mouvements de caméra et même des informations sur l'éclairage. Ces informations textuelles riches aident le modèle à acquérir une compréhension plus nuancée de la narration visuelle.

Processus de formation

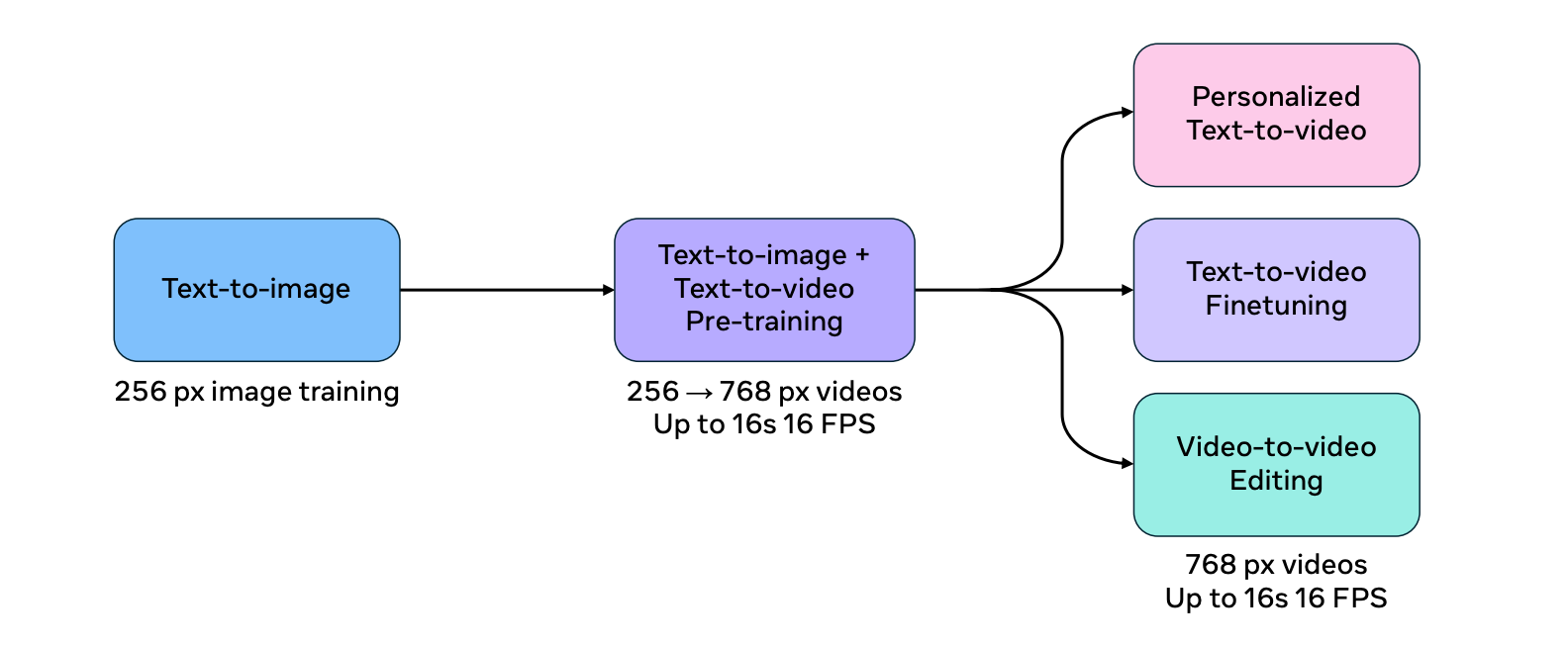

Le processus de formation pour Movie Gen Video est divisé en plusieurs étapes afin d'améliorer l'efficacité et l'extensibilité du modèle.

Le modèle est d'abord entraîné à la tâche de conversion texte-image à l'aide d'images à faible résolution. Cette phase d'échauffement permet au modèle d'apprendre les concepts visuels fondamentaux avant de s'attaquer à la tâche plus complexe de la génération de vidéos.

Le modèle est ensuite entraîné conjointement sur les tâches texte-image et texte-vidéo, en augmentant progressivement la résolution des données d'entrée. Cette approche de formation conjointe permet au modèle d'utiliser l'abondance et la diversité des ensembles de données image-texte tout en apprenant les complexités de la génération de vidéos.

Source : Document de recherche sur le cinéma Gen

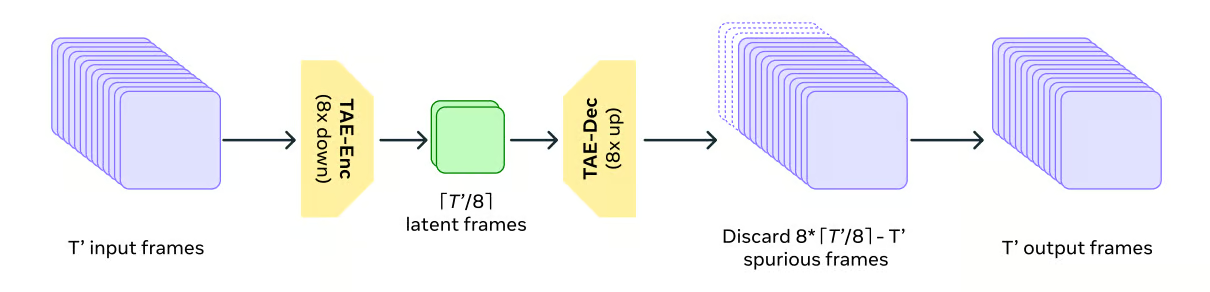

Pour répondre aux exigences de calcul des données vidéo, Movie Gen Video utilise un modèle d'autoencodeur temporel (TAE) pour compresser et décompresser les vidéos dans le temps. C'est un peu comme si l'on zippait et dézippait des fichiers sur un ordinateur, ce qui permet au modèle de travailler avec une représentation plus facile à gérer des données vidéo.

Source : Document de recherche sur le cinéma Gen

Movie Gen Video utilise un objectif de formation appelé Flow Matching. Au lieu de générer directement la vidéo finale, la correspondance des flux guide le modèle pour transformer progressivement un échantillon de bruit aléatoire en la sortie vidéo souhaitée, étape par étape.

Correspondance des flux implique de prédire la vitesse des échantillons dans l'espace latent plutôt que de prédire directement les échantillons eux-mêmes. Cette méthode est plus efficace et plus performante que les méthodes traditionnelles basées sur la diffusion.

Mise au point

Pour améliorer la qualité et l'esthétique des vidéos générées, le modèle fait l'objet d'une mise au point supervisée. supervisé à l'aide d'un ensemble plus restreint de vidéos à l'aide d'un ensemble plus restreint de vidéos sélectionnées manuellement et dotées de légendes de haute qualité. C'est comme si un artiste affinait sa technique grâce aux conseils d'un expert, ce qui permet d'obtenir des vidéos plus attrayantes et plus réalistes.

Le modèle Movie Gen Video final est créé en faisant la moyenne de plusieurs modèles entraînés avec différents ensembles de données, hyperparamètres et points de contrôle de pré-entraînement. Cette technique permet de combiner les points forts de différents modèles, ce qui se traduit par des performances plus robustes et plus fiables.

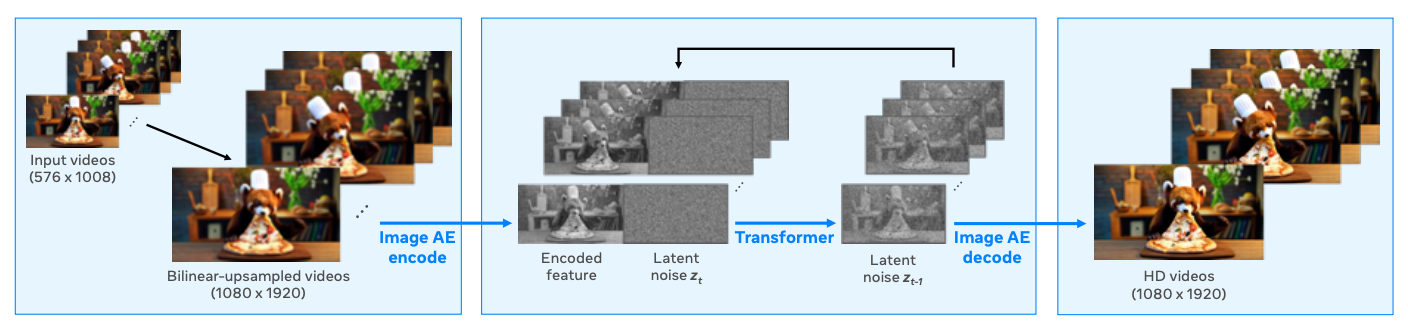

Suréchantillonnage

Le modèle produit des vidéos à une résolution de 768 pixels et utilise le suréchantillonnage pour passer à la résolution Full HD 1080p, ce qui permet d'obtenir des vidéos plus nettes et plus attrayantes sur le plan visuel. Cette approche est couramment utilisée car elle constitue une solution efficace en termes de calcul, le modèle de base pouvant traiter moins de jetons tout en produisant des résultats à haute résolution.

L'échantillonneur spatial fonctionne comme un modèle de génération de vidéo à vidéo. Il prend la vidéo basse résolution en entrée, la suréchantillonne à la résolution cible à l'aide d'une interpolation bilinéaire, puis l'encode dans un espace latent à l'aide d'unautoencodeur variationnel (VAE) à l'échelle de la trame .

Un modèle d'espace latent génère ensuite les latents de la vidéo HD, en fonction des latents encodés de la vidéo à plus faible résolution. Enfin, le décodeur VAE retransforme les latents vidéo HD résultants dans l'espace pixel, produisant ainsi la sortie haute résolution finale.

Source : Document de recherche sur le cinéma Gen

Évaluation du modèle Movie Gen

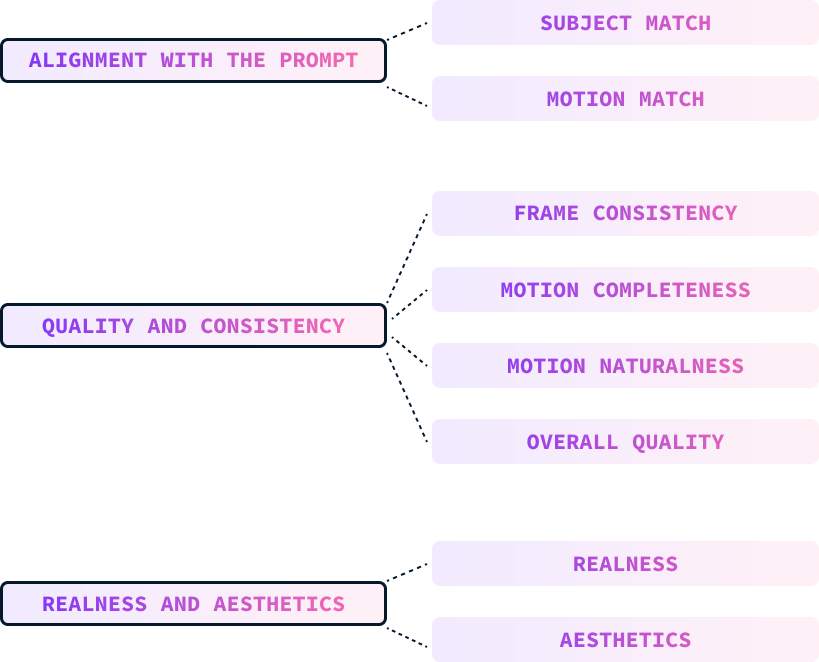

L'évaluation d'un modèle texte-vidéo est plus difficile que celle d'un modèle texte-image en raison de la dimension temporelle ajoutée. L'équipe Meta a utilisé trois mesures principales pour évaluer le modèle :

- Alignement sur l'invitation

- Qualité et cohérence

- Réalité et esthétique

Ces paramètres sont évalués manuellement par des humains qui classent les vidéos en fonction de ces paramètres.

Alignement sur l'invitation

L'alignement de l'invite mesure le degré d'adéquation entre la vidéo générée et l'invite du texte d'entrée, y compris les descriptions du sujet, du mouvement, de l'arrière-plan et d'autres détails. Il se décompose en deux parties :

- Correspondance des sujets : Se concentre sur l'alignement de l'apparence du sujet, de l'arrière-plan, de l'éclairage et du style.

- Motion match : Évalue l'alignement des descriptions liées au mouvement.

Qualité et cohérence

La qualité et la cohérence de la vidéo générée sont évaluées indépendamment de l'invite textuelle. Cette mesure se décompose en

- Cohérence du cadre : Vérifie les incohérences ou les artefacts dans l'apparence de l'objet, l'éclairage et l'arrière-plan d'une image à l'autre.

- Complétude de la motion : Détermine si la vidéo contient suffisamment de mouvement, en particulier pour les sujets ou activités inhabituels.

- Le mouvement est naturel : Juge le réalisme et le naturel du mouvement, en tenant compte d'aspects tels que le mouvement des membres, les expressions faciales et le respect de la physique.

- Qualité générale : Un jugement holistique qui prend en compte l'équilibre des trois sous-axes précédents pour déterminer la qualité globale de la vidéo.

Réalité et esthétique

Les évaluateurs ont été invités à noter la capacité du modèle à produire des vidéos photoréalistes et esthétiques. Ces critères sont divisés en plusieurs catégories :

- Réalité : Évalue le degré de ressemblance de la vidéo avec une vidéo réelle ou, dans le cas d'invites fantastiques, le degré d'imitation d'un style artistique réaliste.

- Esthétique : Jugez de l'attrait visuel de la vidéo en fonction de facteurs tels que le contenu, l'éclairage, la couleur et les effets de caméra.

Critères d'évaluation

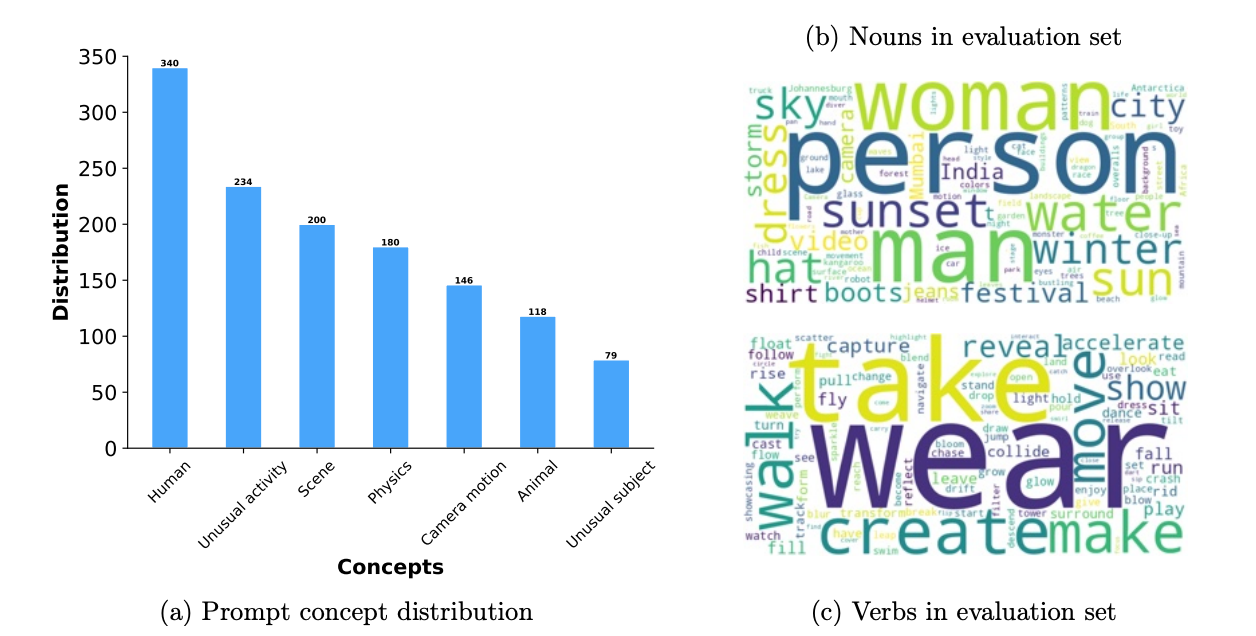

Les données de référence ont été conçues pour évaluer les générations de vidéos de manière exhaustive. Il comprend 1 000 questions qui couvrent divers aspects des tests, tels que l'activité humaine, les animaux, la nature, la physique et les sujets ou activités inhabituels.

Leur référence est plus de trois fois supérieure à celles utilisées dans les études précédentes. Chaque message est associé à un niveau de mouvement (élevé, moyen, faible) afin d'évaluer la qualité de la génération en fonction de l'intensité du mouvement.

L'évaluation utilise l'ensemble des invites et examine des paramètres de test spécifiques, en se concentrant particulièrement sur la manière dont les modèles gèrent les sujets et les mouvements inhabituels afin de tester leurs capacités de généralisation.

Le diagramme suivant présente une ventilation des questions posées dans le cadre de l'évaluation. Sur la gauche, on trouve la répartition des concepts des messages-guides. Sur le côté droit, nous voyons les noms et les verbes courants utilisés dans les messages-guides (plus le mot est grand, plus il est fréquent) :

Source : Document de recherche sur le cinéma Gen

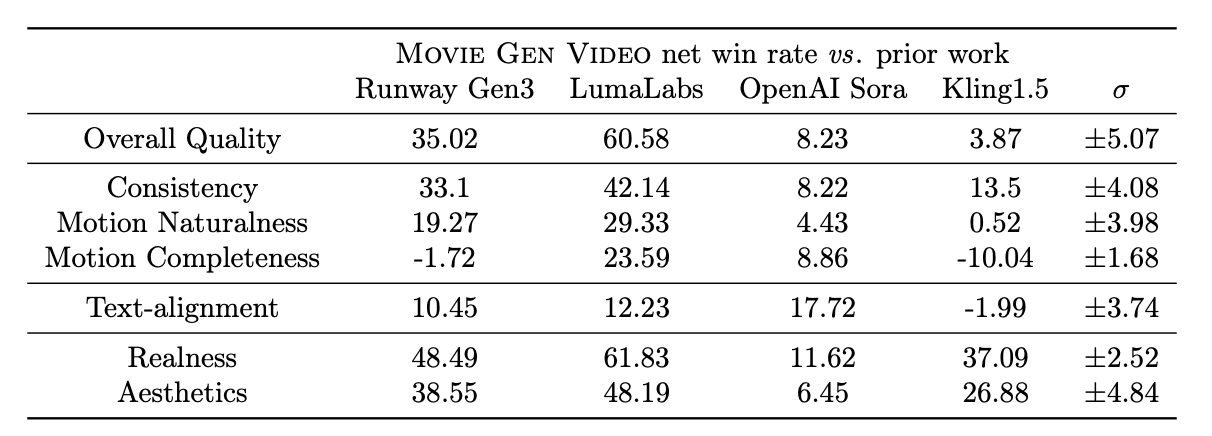

Le tableau ci-dessous présente les résultats de l'évaluation humaine des vidéos produites par différents modèles sur plusieurs critères d'évaluation. Les chiffres représentent les taux de gains nets qui sont calculés comme suit : (% de gains - % de pertes). Il va de -100 (perte totale) à 100 (victoire totale), 0 indiquant une égalité.

Source : Document de recherche sur le cinéma Gen

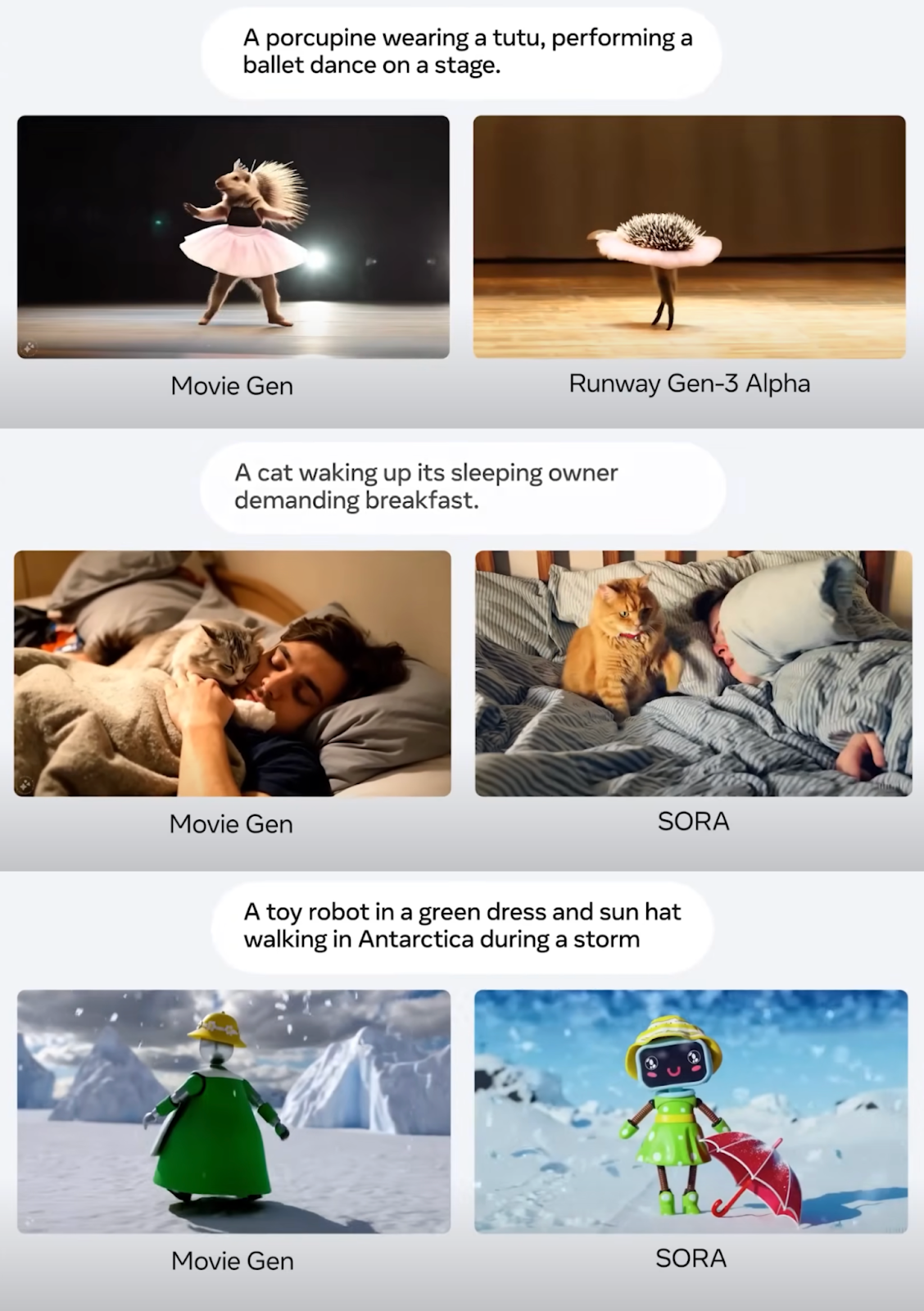

Meta Movie Gen vs. Sora vs. Piste Gen 3

D'après leurs expériences, Movie Gen Video est très performant dans la génération de texte à partir de vidéo, surpassant plusieurs modèles existants, y compris des systèmes commerciaux tels que Runway Gen3 et LumaLabs, sur la base d'évaluations humaines réalisées à l'aide du banc MovieGen Video. Plus précisément, Movie Gen Video présente des avantages significatifs dans les domaines suivants :

- Qualité générale : Les évaluateurs ont systématiquement estimé que les sorties de Movie Gen étaient de meilleure qualité, notamment en termes de fidélité visuelle, de naturel des mouvements et d'alignement avec les messages-guides.

- Le mouvement est naturel et cohérent : Movie Gen présente un avantage significatif dans la génération de vidéos avec des mouvements naturels et cohérents, surpassant Runway Gen3 et Sora d'OpenAI sur ces aspects. Cette force est probablement attribuée à la capacité du modèle à apprendre et à simuler la physique du monde réel grâce à son objectif d'apprentissage de la correspondance des flux et à l'utilisation intensive de données vidéo pendant l'apprentissage.

- Réalité et esthétique : Movie Gen excelle également dans la production de vidéos plus réalistes et plus esthétiques que Runway Gen3, LumaLabs et Kling1.5.

Si MovieGen est généralement plus performant que les autres modèles, Kling1.5 génère parfois des vidéos avec des amplitudes de mouvement plus importantes, mais au prix de distorsions et d'incohérences. Cela met en évidence le compromis entre l'exhaustivité du mouvement et la qualité visuelle, Movie Gen Video donnant la priorité à la génération de mouvements réalistes et cohérents plutôt qu'à la simple maximisation de l'amplitude des mouvements.

Vous trouverez ci-dessous quelques captures d'écran de la présentation de Meta Connect 2024 présentant quelques exemples d'invites de génération de vidéos :

Source : Document de recherche sur le cinéma Gen

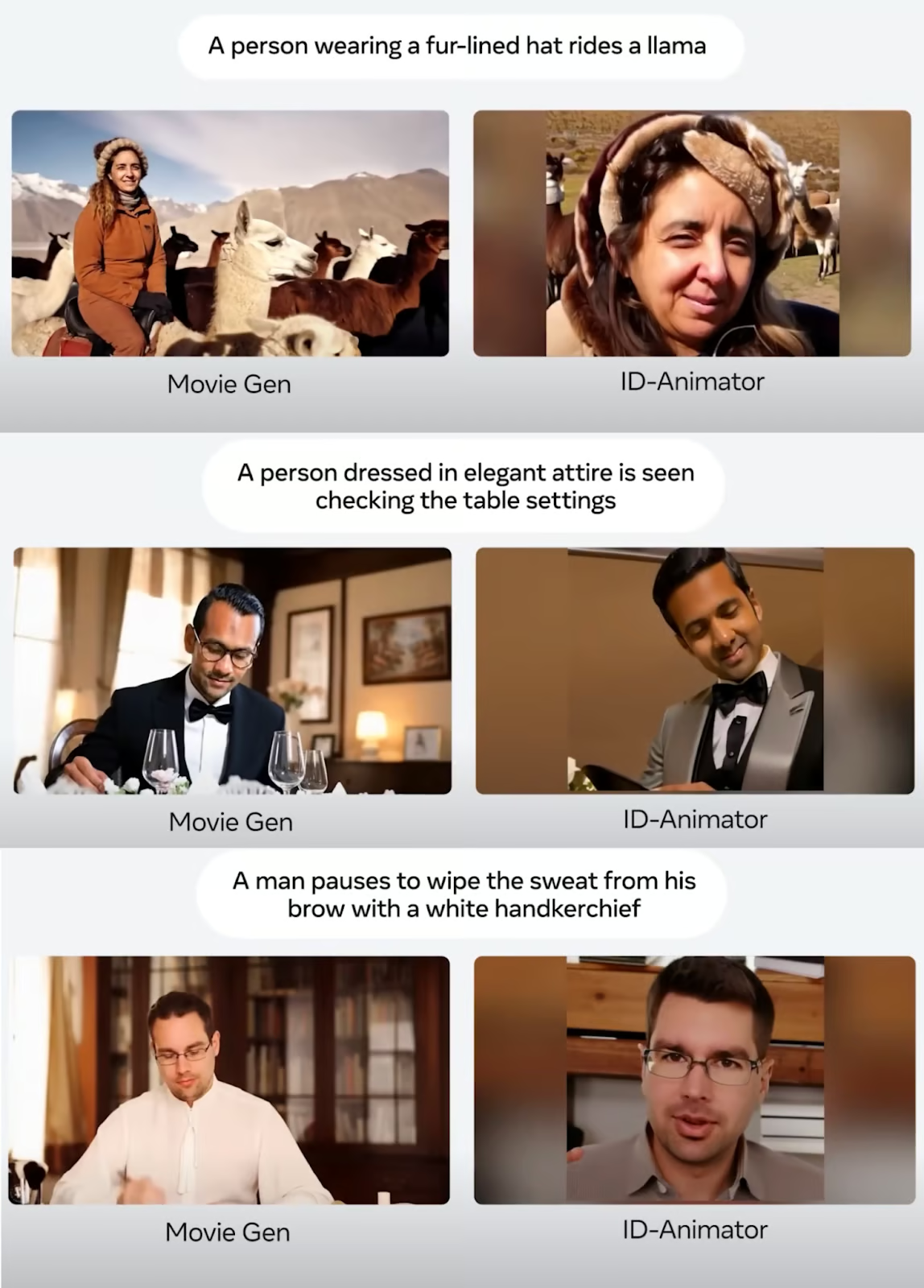

Voici quelques exemples de comparaison de la personnalisation de vidéos où une photo est utilisée pour générer une vidéo personnalisée :

Source : Document de recherche sur le cinéma Gen

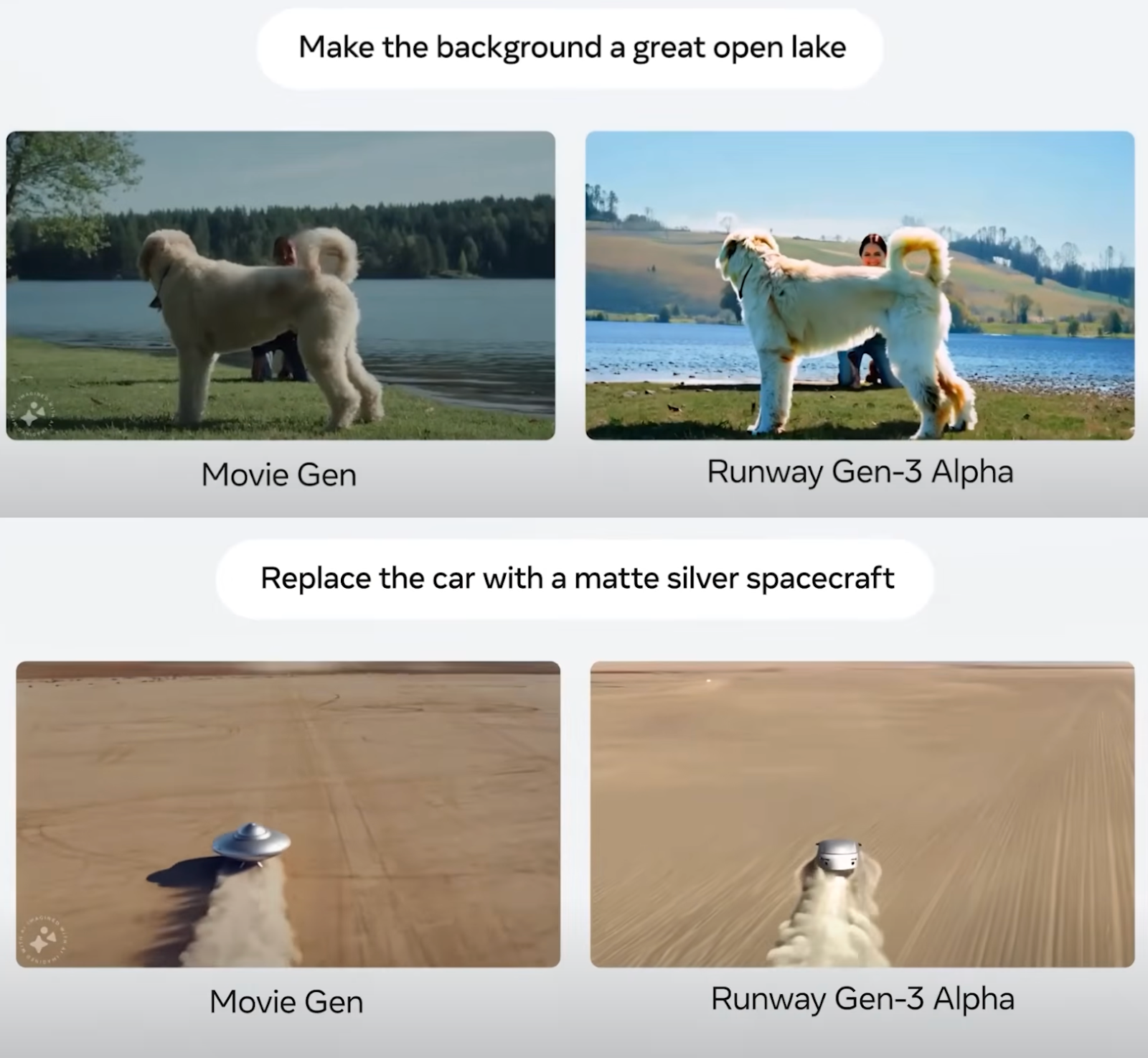

Enfin, les captures d'écran ci-dessous présentent des exemples comparatifs de montage vidéo :

Source : Document de recherche sur le cinéma Gen

Dans l'ensemble, il semble que Meta Movie Gen ait repoussé les limites et établi une nouvelle norme pour les modèles de conversion de texte en vidéo. La procédure d'évaluation décrite dans le document semble équitable mais, bien entendu, il est difficile d'en être certain tant que ces modèles ne seront pas rendus publics et que des tiers neutres ne pourront pas les comparer.

Limites du modèle

Bien que Meta Movie Gen soit très performant en matière de génération de médias, il y a encore des points à améliorer.

Le modèle a parfois du mal à gérer des scènes complexes impliquant une géométrie complexe, la manipulation d'objets et des simulations physiques réalistes. Par exemple, la génération d'interactions convaincantes entre les objets, la représentation précise des transformations d'état (comme la fusion ou l'éclatement) et la simulation réaliste des effets de la gravité ou des collisions peuvent encore constituer des défis pour les modèles.

La synchronisation audio peut être problématique dans certains scénarios. Plus précisément, lorsqu'il s'agit de mouvements qui sont visuellement petits, occultés ou qui nécessitent un niveau élevé de compréhension visuelle pour générer le son correspondant, les modèles peuvent avoir du mal à atteindre une synchronisation parfaite. Parmi les exemples de ces défis, citons la synchronisation précise des pas d'une personne qui marche, la génération de sons appropriés pour des objets partiellement cachés et la reconnaissance des mouvements subtils de la main sur une guitare pour produire les notes de musique correctes.

En outre, le modèle Movie Gen Audio, tel qu'il est conçu actuellement, ne prend pas en charge la génération de voix.

Considérations relatives à la sécurité et à la mise en circulation des modèles

Les vidéos réalistes générées par l'IA comportent des risques et éthiques éthiques qu'il convient de prendre en compte. Ces risques comprennent la manipulation de la confiance et la diffusion de fausses informations par le biais de "deepfakes", qui pourraient nuire à la réputation, désinformer le public et porter préjudice aux entreprises.

D'une part, il peut s'agir d'une fonctionnalité d'Instagram qui me permet de créer une vidéo sympa avec moi pour la partager avec mes amis, mais d'autre part, cette même fonctionnalité me permet de créer une fausse vidéo de quelqu'un d'autre. Au fur et à mesure que ces technologies s'améliorent, il pourrait devenir impossible de les distinguer de la réalité.

Les contenus générés par l'IA posent menaces pour la vie privée menace la vie privée et peut conduire à l'extorsion, au chantage ou à la cyberintimidation.

En outre, ces outils d'IA pourraient porter atteinte à l'art et aux droits d'auteur en imitant des styles artistiques uniques sans en être crédités. Les solutions passent par la sensibilisation et l'éducation aux médias, l'investissement dans les technologies de détection, la mise en place d'un cadre juridique pour la protection des droits de l'homme et des libertés fondamentales. cadres et éthiques, et l'utilisation du filigrane pour l'authentification.

Si la génération de vidéos par l'IA offre un grand potentiel, elle nécessite une manipulation prudente pour maintenir la confiance et l'authenticité.

Meta a fait preuve d'ouverture dans ses développements en matière d'IA en mettant à disposition les modèles modèles Llama. Toutefois, pour des raisons de sécurité, les modèles Meta Movie Gen ne seront pas encore commercialisés. Selon leur article, de nombreuses améliorations et considérations de sécurité sont nécessaires avant de les déployer.

Conclusion

Dans cet article de blog, nous avons présenté les modèles Movie Gen de Meta, une suite de modèles d'IA pour générer et éditer des vidéos à l'aide d'invites textuelles.

Nous avons exploré les quatre modèles distincts, leurs capacités et leur fonctionnement. Grâce à une analyse comparative, nous avons montré comment Meta Movie Gen se positionne par rapport à d'autres outils de génération de vidéos par IA.

Bien que Meta Movie Gen ait établi une nouvelle référence dans le domaine, l'utilisation abusive potentielle de la technologie soulève des préoccupations importantes. Meta a reconnu ces risques et adopte une approche prudente dans la diffusion de ces modèles.

Pour en savoir plus sur l'écosystème de Meta AI, je vous recommande ces blogs :

FAQ

Quand Meta Movie Gen sera-t-il publié ?

Meta n'a pas annoncé de date précise pour la sortie de Movie Gen, qui se concentre actuellement sur la recherche et le développement, dans le but d'améliorer les capacités du modèle et de résoudre les problèmes potentiels avant une diffusion plus large. Bien qu'il n'y ait pas de calendrier officiel, je pense qu'il est possible que Meta intègre dans un premier temps les fonctionnalités de Movie Gen dans leurs plateformes existantes telles qu'Instagram ou Facebook, plutôt que de publier directement le modèle complet.

Quelle est la durée de la Meta Movie Gen ?

Actuellement, Meta Movie Gen peut générer des vidéos d'une durée maximale de 16 secondes. Cette limitation pourrait être due aux exigences informatiques liées à la production de vidéos plus longues et de haute qualité. Des développements futurs pourraient potentiellement augmenter la longueur maximale des vidéos.

Meta Movie Gen sera-t-il ouvert à tous ?

Meta n'a pas confirmé si Movie Gen sera ouvert à tous. Cependant, l'entreprise a l'habitude d'ouvrir certains de ses modèles d'intelligence artificielle, comme le lama. Il est possible qu'ils choisissent d'ouvrir certaines parties de Movie Gen ou de le publier sous une licence spécifique afin d'encourager la recherche et le développement par la communauté de l'IA au sens large.

Quelle est la qualité vidéo de Meta Movie Gen ?

Meta Movie Gen génère des vidéos en résolution HD 1080p, offrant une sortie de haute qualité adaptée à diverses applications.