Lernpfad

Im Jahr 2017 erschütterte Google die KI-Gemeinschaft mit seinem bahnbrechenden Papier "Attention is All You Need". In diesem Beitrag wurde die Transformer-Architektur vorgestellt, die die Modellierung von Sequenzen durch die Verwendung von Selbstbeobachtungsmechanismen revolutioniert hat.

Vor kurzem hat Google ein neues Papier mit dem Titel "Titans" veröffentlicht : Learning to Memorize at Test Time ",, in dem sie eine neuartige Speicherarchitektur vorschlagen, mit der KI-Systeme Informationen besser speichern und nutzen können.

Inspiriert von den Feinheiten des menschlichen Gedächtnisses, zielt diese Forschung darauf ab, die Grenzen bestehender Gedächtnissysteme in KI-Modellen zu überwinden, insbesondere das eingeschränkte Kontextfenster von Transformers.

Die Titans-Architektur führt einen ausgeklügelten Ansatz ein, um verschiedene Arten von Gedächtnis - Kurzzeit-, Langzeit- und Langzeitgedächtnis - in KI-Modelle zu integrieren, so dass diese während der Testzeit dynamisch lernen und sich erinnern können.

Im Mittelpunkt steht dabei der "Überraschungs"-Mechanismus, der sich auf die Neigung des menschlichen Gehirns stützt, sich an unerwartete Ereignisse zu erinnern. Diese Architektur ermöglicht es den Modellen, das Gedächtnis effizient zu verwalten, indem sie aktuelle und vergangene Überraschungen einbeziehen und so ein effektives Einprägen und Abrufen von Daten gewährleisten.

In diesem Artikel werde ich die im Titans-Papier vorgestellten Konzepte und Mechanismen vereinfachen und die möglichen Auswirkungen dieser neuen Architektur auf die Zukunft der KI untersuchen.

Das Problem mit der Stromwandlerarchitektur

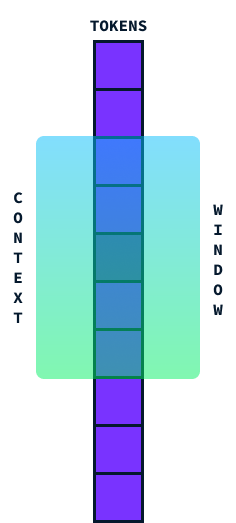

Transformatoren sind die Architektur, die heute in den meisten LLMs verwendet wird. Sie sind bekannt für ihre Fähigkeit, Datenfolgen zu verarbeiten, wie zum Beispiel Wörter in einem Satz. Sie arbeiten sehr effektiv, indem sie etwas nutzen, das "Aufmerksamkeit"die ihnen hilft, sich auf relevante Teile der Daten zu konzentrieren. Allerdings stehen sie vor einer großen Herausforderung: der Größe ihres Kontextfensters.

Das Kontextfenster gibt an, wie viele Informationen ein Transformer auf einmal berücksichtigen kann. Stell dir das wie ein Fenster vor, das entlang eines Satzes verläuft und ein Segment von Wörtern erfasst, um ihre Bedeutung im Kontext zu verstehen.

Idealerweise sollte dieses Fenster so groß wie möglich sein, damit wir große Textabschnitte auf einmal verarbeiten können, aber es gibt einen Haken. Wenn wir versuchen, dieses Kontextfenster größer zu machen, steigt der Rechenaufwand aufgrund der quadratischen Zeit- und Raumkomplexität der Transformer-Architektur.

Das heißt, wenn wir die Größe des Kontextfensters verdoppeln, verdoppelt sich nicht nur die Rechenleistung, sondern sie wird viermal so hoch! Das passiert, weil jedes Wort im Fenster mit jedem anderen Wort verglichen werden muss, sodass die Berechnungen schnell wachsen.

Die heutigen modernen Modelle (SOTA) haben 2 Millionen Token-Kontextfenster. Ihre Verarbeitung ist jedoch recht teuer, und einige Anwendungen, wie z. B. das Verstehen von Videos, erfordern größere Kontextfenster. Ein längeres Kontextfenster ohne einen enormen Anstieg der Rechenkosten würde es LLMs ermöglichen, längere Sequenzen effektiver zu verarbeiten und ihre Leistung bei Aufgaben zu verbessern, die das Verstehen größerer Datenmengen auf einmal erfordern. Deshalb ist die Überwindung des quadratischen Kostenproblems ein wichtiger Schwerpunkt bei der Weiterentwicklung dieser Modelle.

Was ist die Architektur der Titanen?

Titans ist eine neue Architektur, die die Fähigkeit von KI-Modellen verbessert, Informationen effektiv zu speichern und abzurufen, vor allem bei großen und komplexen Daten, indem sie sich von den Feinheiten des menschlichen Gedächtnisses inspirieren lässt.

Die Inspiration aus dem menschlichen Gedächtnis

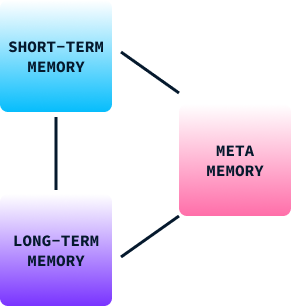

Das Gedächtnis spielt eine entscheidende Rolle beim menschlichen Lernen und Verhalten. Sie hilft uns, Informationen aus vergangenen Erfahrungen zu behalten, die wir nutzen, um Entscheidungen zu treffen, uns an neue Situationen anzupassen und Probleme zu lösen. Das menschliche Gedächtnis kann grob in drei Typen eingeteilt werden:

- Kurzzeitgedächtnis: Hier werden aktuelle Informationen verarbeitet. Es ist wie ein mentaler Arbeitsbereich, in dem wir Daten, die wir gerade brauchen, vorübergehend speichern und verwalten, z.B. wenn wir uns eine Telefonnummer gerade lange genug merken, um sie zu wählen.

- Langzeitgedächtnis: So werden Informationen über längere Zeiträume gespeichert. Sie umfasst unser Wissen, unsere Fähigkeiten und unsere persönlichen Erinnerungen, die es uns ermöglichen, uns an Erfahrungen zu erinnern und auch Jahre später noch daraus zu lernen.

- Meta-Speicher: Hier geht es darum, zu wissen, was wir wissen. Sie hilft uns einzuschätzen, wie gut wir uns an eine Aufgabe erinnern oder sie ausführen können, was unsere Entscheidungen und Urteile beeinflusst.

Im menschlichen Verhalten arbeiten diese Gedächtnistypen zusammen und ermöglichen es uns, aus unserer Umgebung zu lernen, Strategien anzupassen und unser Verhalten im Laufe der Zeit zu verbessern. Ohne sie wären wir auf Grundreflexe und stereotype Verhaltensweisen beschränkt.

Die Speicherstruktur von Titans

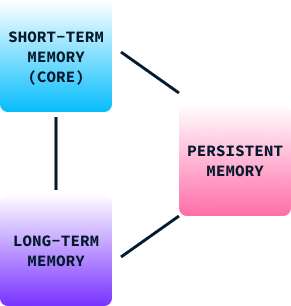

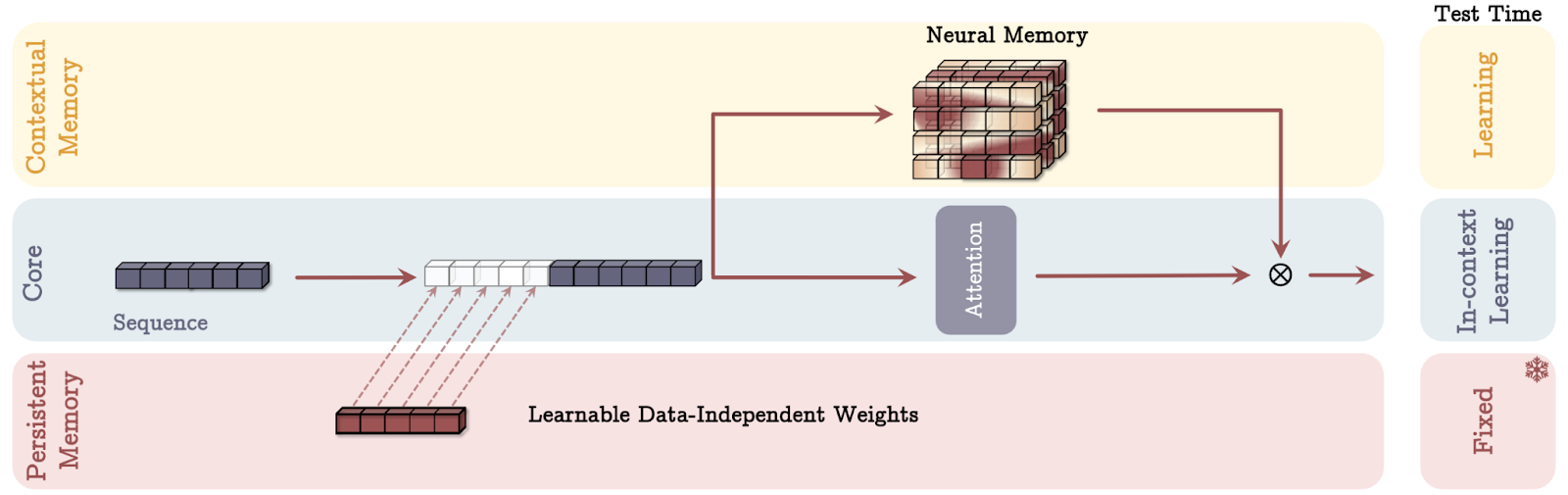

Genau wie das menschliche Gedächtnismodell besteht auch die Gedächtnisstruktur von Titan aus drei Teilen:

- Kurzzeitgedächtnis (Kern): Dieses Modul konzentriert sich auf die Bearbeitung aktueller Aufgaben, so dass die KI sofortige Daten mit Präzision verarbeiten kann. Ähnlich wie das Kurzzeitgedächtnis des Gehirns hilft diese Komponente dabei, relevante Informationen für eine schnelle Verarbeitung bereitzuhalten, speichert sie aber nicht für unbegrenzte Zeit.

- Langzeitgedächtnis: Dient als Aufbewahrungsort für Informationen über längere Zeiträume. Dieses Modul ist vergleichbar mit dem Langzeitgedächtnis des Menschen, das Erfahrungen, Wissen und Erinnerungen speichert, die nicht sofort benötigt werden, aber in der Zukunft von Bedeutung sein können. Sie ermöglicht es KI-Modellen, sich effektiv an vergangene Informationen zu erinnern und darauf zuzugreifen, was für Aufgaben, die das Verstehen von Zusammenhängen im Laufe der Zeit erfordern, entscheidend ist.

- Dauerhafte Erinnerung: Es funktioniert wie der Metaspeicher des Gehirns und bettet aufgabenbezogenes Wissen in das Modell ein. Diese Art von Speicher umfasst Parameter, die nicht von der aktuellen Eingabe abhängen, aber für das Verständnis und die Ausführung bestimmter Aufgaben entscheidend sind. Das Langzeitgedächtnis sorgt dafür, dass gelernte Muster und Rahmenbedingungen Teil des Modells bleiben, wodurch die Fähigkeit, vergangenes Lernen auf neue Situationen anzuwenden, verbessert wird.

Durch die Integration dieser drei Gedächtnisarten ermöglicht die Titans-Architektur den KI-Modellen, Informationen ähnlich wie unser Gehirn dynamisch zu verwalten und die unmittelbare Verarbeitung mit der Speicherung von vergangenen Erfahrungen und Wissen zu verbinden.

Der "Überraschungs"-Mechanismus

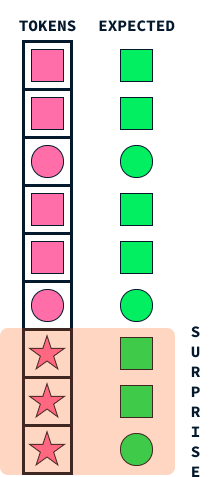

Der "Überraschungs"-Mechanismus in Titans ahmt einen grundlegenden Aspekt des menschlichen Gedächtnisses nach: unsere Tendenz, uns an überraschende oder unerwartete Ereignisse lebhafter zu erinnern. Dieser Ansatz hilft den KI-Modellen bei der Entscheidung, welche Informationen gespeichert werden sollen, indem Daten identifiziert werden, die sich von dem unterscheiden, was das Modell erwartet.

Stell dir vor, du gehst die Straße entlang und alles scheint gewöhnlich und routinemäßig zu sein. Vielleicht erinnerst du dich ein paar Wochen später nicht mehr an diesen täglichen Spaziergang. Wenn jedoch etwas Unerwartetes passiert, wie z.B. ein farbenfroher Umzug, der vorbeizieht, oder ein Anruf mit aufregenden Neuigkeiten, dann erregen diese überraschenden Elemente deine Aufmerksamkeit und machen sie noch einprägsamer.

Auch die Titanen nutzen diesen Überraschungseffekt, um die Informationen zu priorisieren, die sie sich einprägen wollen. Wenn das Modell auf Daten stößt, die erheblich von dem abweichen, was es erwartet hat (ähnlich wie unsere bunte Parade), markiert es diese Informationen als überraschend. Das Speichersystem in Titans speichert dann vorrangig diese unerwarteten Ereignisse und sorgt dafür, dass wichtige, aber ungewöhnliche Daten nicht übersehen werden.

Dieser Mechanismus ermöglicht es den Titans, ihre Speicherressourcen effizient zu verwalten, indem sie sich auf wichtige Informationen konzentrieren, anstatt zu versuchen, jedes einzelne Detail zu speichern. So wie sich Menschen eher an Unerwartetes erinnern, nutzen auch die Titanen diese natürliche Strategie, um wichtige Informationen effektiv zu verarbeiten und zu behalten, damit sie bei komplexen Aufgaben, bei denen es darum geht, große Datenmengen zu sortieren, besser abschneiden.

Formal ist das Überraschungskonzept definiert als der Gradient der Verlustfunktion in Bezug auf den Input. Damit wird gemessen, wie stark die Parameter des Modells als Reaktion auf die neue Eingabe geändert werden müssen, um den Verlust zu minimieren.

Die Intuition, die hinter der Verwendung des Gradienten als Maß für die Überraschung steht, ist, dass ein großer Gradient bedeutet, dass erhebliche Änderungen im Modell erforderlich sind, um die neue Eingabe aufzunehmen, was darauf hindeutet, dass sich die Eingabe von dem unterscheidet, was das Modell bisher gesehen hat, oder dass sie unerwartet und daher überraschend ist.

Der Mechanismus des Vergessens

Der Vergessensmechanismus in der Titans-Architektur ist eine wichtige Komponente, um das neuronale Langzeitgedächtnis effektiv zu verwalten und sicherzustellen, dass das Modell relevante Informationen behält, während es nicht mehr benötigte Informationen verwirft.

Dieser Mechanismus ist wichtig, wenn es um große Datenmengen geht, bei denen der Speicher mit veralteten oder irrelevanten Informationen überfordert sein könnte. In der Praxis funktioniert der Vergessensmechanismus, indem die Regel zur Aktualisierung des Gedächtnisses so angepasst wird, dass Informationen auf der Grundlage ihres Überraschungsfaktors und ihrer Relevanz, die während der Inferenz dynamisch bewertet wird, selektiv gelöscht werden.

Ein adaptiver Gating-Parameter legt fest, wie viel vom vorherigen Speicherzustand beibehalten werden soll, damit das Modell den Speicherinhalt adaptiv löschen oder erhalten kann. Ein solcher Mechanismus verhindert einen Speicherüberlauf und fördert die effiziente Nutzung des Speicherplatzes, so dass sich das Modell auf kritische und neuartige Eingaben konzentrieren kann, ohne durch eine Ansammlung unnötiger Daten behindert zu werden.

Dieser Ansatz spiegelt die menschlichen kognitiven Prozesse wider, bei denen unwichtige oder veraltete Erinnerungen mit der Zeit verblassen und so eine effizientere kognitive Verarbeitung und Informationsgewinnung ermöglichen.

Lernen zur Inferenzzeit

Unter traditionellen maschinellen Lern Modellen findet das Lernen während der Trainingsphase statt. Sobald das Modell trainiert ist, wird es eingesetzt, um Schlussfolgerungen zu ziehen und Vorhersagen auf der Grundlage neuer, ungesehener Daten zu treffen - ohne weitere Änderungen an den gelernten Parametern.

Die Titans-Architektur führt einen bahnbrechenden Wechsel in diesem Paradigma ein, indem sie es den Modellen ermöglicht, während der Inferenz, auch bekannt als Testzeit, dynamisch zu lernen. Diese Fähigkeit ermöglicht es den Titans, ihren Speicher und ihre Parameter zu aktualisieren, je nachdem, wie überraschend und bedeutsam die eingehenden Daten sind, während sie sie verarbeiten.

Die Fähigkeit, zum Zeitpunkt der Inferenz zu lernen, bietet mehrere bedeutende Vorteile:

- Dynamische Anpassung an neue Daten: Herkömmliche Modelle sind durch die statische Natur ihres Lernens eingeschränkt, da sie sich auf vorher festgelegte Parameter verlassen, die auf historischen Trainingsdaten basieren. Titanen können sich in Echtzeit an sich verändernde Muster und neue Eingaben anpassen, indem sie während der Inferenz lernen und so ihre Relevanz und Genauigkeit verbessern, wenn sie mit veränderten Umgebungen oder unerwarteten Daten konfrontiert werden.

- Verbesserte Datenrelevanz und Speicherverwaltung: Indem sie ihr Gedächtnis während der Prüfung ständig aktualisieren, können die Titanen vorrangig aus Daten lernen, die sie für überraschend halten oder die sich von ihrem bisherigen Wissen unterscheiden. Dieses dynamische Speichermanagement spiegelt die Fähigkeit des menschlichen Gehirns wider, sich auf neue oder wichtige Informationen zu konzentrieren und sich diese zu merken, während es die banalen Informationen ausblendet und so eine Informationsüberlastung verhindert.

- Bessere Verallgemeinerung: Da Titans sein Verständnis auf der Grundlage von Live-Daten verfeinern kann, kann es besser auf Daten verallgemeinert werden, die nicht Teil der ursprünglichen Trainingsmenge waren. Diese Fähigkeit ist wichtig für Anwendungen in der Praxis, bei denen die Eingaben stark von den Trainingsdaten abweichen.

- Erhöhte Kapazität für langfristige Abhängigkeiten: Durch das Lernen zur Inferenzzeit können Titans langfristige Abhängigkeiten in Daten besser erkennen und speichern. Dies ist besonders vorteilhaft für Aufgaben, die die Verarbeitung umfangreicher Sequenzen erfordern, wie z.B. das Verstehen langer Texte oder Videos.

- Anwendbarkeit in der realen Welt: Der Inferenz-Lernmechanismus ermöglicht es den Titans, sich ständig weiterzuentwickeln und neue Muster und Kenntnisse zu erlernen, sobald sie auftauchen. Diese Funktion entspricht genau den Anforderungen der realen Welt, in der Modelle in dynamischen und komplexen Datenumgebungen relevant bleiben müssen.

Speichermodi in Titanen

Die Titans-Architektur nutzt drei verschiedene Wege, um das Gedächtnis einzubinden, die jeweils von verschiedenen Aspekten der menschlichen Kognition inspiriert sind. Lasst uns jeden Speichermodus anhand einfacher Analogien aufschlüsseln.

Quelle: Behrouz et. al, 2024

Erinnerung als Kontext (MAC)

Stell dir vor, du hast einen persönlichen Assistenten während eines Meetings. Dieser Assistent macht sich umfassende Notizen zu früheren Gesprächen (Langzeitgedächtnis) und flüstert dir bei Bedarf relevante Informationen ins Ohr (Abruf).

Im MAC-Modus funktioniert das KI-Modell ganz ähnlich. Es speichert eine detaillierte Historie vergangener Daten und integriert sie mit aktuellen Daten, um fundierte Entscheidungen zu treffen. So wie dein Assistent dir hilft, vergangenes Wissen mit aktuellen Diskussionen zu verbinden, um deine Entscheidungsfindung zu verbessern, nutzt MAC das Langzeitgedächtnis, um den Kontext zu den unmittelbar verarbeiteten Informationen herzustellen.

Speicher als Tor (MAG)

Stell dir vor, du hast zwei Berater im Kopf. Die eine konzentriert sich ausschließlich auf das, was jetzt passiert, und liefert Erkenntnisse über unmittelbare Aufgaben (kurzfristige Aufmerksamkeit). Der andere schöpft aus jahrelang gesammelter Erfahrung und Weisheit (Langzeitgedächtnis).

Der MAG-Modus wirkt wie ein Torwächter, der entscheidet, wie viel Aufmerksamkeit er jedem Berater schenkt, indem er den Fokus dynamisch an die aktuellen Bedürfnisse und an das vergangene Lernen anpasst. Dadurch wird ein ausgewogener Ansatz gewährleistet, der es der KI ermöglicht, sich anzupassen, egal ob die Aufgabe sofortige Präzision oder Erkenntnisse aus vergangenen Erfahrungen erfordert.

Speicher als Schicht (MAL)

Stell dir diesen Modus als mehrere Ebenen des Verstehens vor, wobei jede Ebene Informationen auf einzigartige Weise verarbeitet:

- Die erste Schicht könnte als historischer Filter fungieren und sich auf langfristige Muster und Erinnerungen konzentrieren.

- Die zweite Ebene befasst sich mit unmittelbaren Zusammenhängen, wie kurzfristigen Beobachtungen.

- Während die Informationen jede Ebene durchlaufen, werden sie verfeinert und umgewandelt. So wird sichergestellt, dass das Modell sowohl den breiten Kontext als auch die feinen Details versteht, bevor es eine Entscheidung trifft.

Diese schichtweise Verarbeitung spiegelt wider, wie wir komplexe Informationen oft schrittweise verdauen, indem wir unser Verständnis Schritt für Schritt aufbauen und verfeinern. Jeder Modus bietet einzigartige Stärken, die es den Titanen ermöglichen, unterschiedliche Aufgaben effektiv zu bewältigen, indem sie verschiedene Aspekte der menschlichen Informationsverarbeitung und -speicherung nachahmen.

Auswirkungen auf die reale Welt und experimenteller Erfolg

Die experimentellen Ergebnisse zeigen die Überlegenheit der Titans-Architektur gegenüber traditionellen Transformatoren und modernen Modellen bei verschiedenen Aufgaben. Hier ist eine Aufschlüsselung der wichtigsten Ergebnisse:

- Sprachmodellierung und gesunder Menschenverstand: Titans, insbesondere die Memory-as-Context (MAC)-Variante, zeigt robuste Leistungen bei der Sprachmodellierung und bei Aufgaben des gesunden Menschenverstands.

- Aufgaben wie die Nadel im Heuhaufen: Bei Aufgaben, bei denen es darum geht, bestimmte Informationen aus langen Sequenzen abzurufen, so genannten Needle-in-a-Haystack-Aufgaben, schneiden die Titanen besonders gut ab.

- Umgang mit größeren Zusammenhängen: Titans sind in der Lage, auf Kontextfenstergrößen von mehr als 2 Millionen Token zu skalieren, ohne dass die Genauigkeit darunter leidet, was eine erhebliche Verbesserung gegenüber den aktuellen State-of-the-Art-Modellen darstellt.

- Zeitreihenprognosen: Das neuronale Speichermodul in Titans übertrifft bei Vorhersageaufgaben verschiedene Basismodelle, darunter Transformator-basierte und lineare Modelle.

- DNA-Modellierung: Die Architektur von Titans zeigt auch eine konkurrenzfähige Leistung bei DNA-Modellierungsaufgaben, was ihre Vielseitigkeit über die traditionellen Aufgaben der natürlichen Sprache hinaus beweist.

Insgesamt nutzen die Titanen einen neuartigen Ansatz für die Speicherverwaltung, der es ihnen ermöglicht, komplexe Aufgaben mit langem Kontext effektiver zu bewältigen und einen neuen Standard für KI-Modelle in Bezug auf Skalierbarkeit und Genauigkeit zu setzen.

Fazit

Die aktuelle Transformer-Architektur ist zwar leistungsfähig, hat aber aufgrund von Skalierungsproblemen Schwierigkeiten, extrem lange Kontexte zu verarbeiten. Die innovative Architektur von Titans, die vom menschlichen Gedächtnis inspiriert ist, überwindet diese Einschränkungen, indem sie den Kurzzeit-, Langzeit- und Permanentspeicher dynamisch verwaltet.

Ich glaube, dass die Fähigkeit der Titanen, während der Inferenzzeit zu lernen, sich an neue Daten anzupassen und den Speicher auf der Grundlage eines "Überraschungs"-Mechanismus zu priorisieren, das Potenzial hat, KI-Systeme zu schaffen, die in ihrer Informationsverarbeitung dem Menschen ähnlicher sind. Dies könnte die Leistung von KI-Systemen in komplexen und dynamischen Umgebungen verbessern, was sich für KI-Agenten wie OpenAIs Operator.