Cursus

En 2017, Google a secoué la communauté de l'IA en publiant un article révolutionnaire intitulé "L'attention est tout ce dont vous avez besoin". Cet article a présenté l'architecture Transformer, qui a révolutionné la modélisation des séquences en utilisant des mécanismes d'auto-attention.

Récemment, Google a publié un nouveau document intitulé "Titans" : Learning to Memorize at Test Time ",, dans lequel ils proposent une nouvelle architecture de mémoire conçue pour améliorer la façon dont les systèmes d'intelligence artificielle stockent et utilisent les informations.

S'inspirant des subtilités de la mémoire humaine, cette recherche vise à surmonter les limites des systèmes de mémoire existants dans les modèles d'IA, en particulier la fenêtre contextuelle restreinte de Transformers.

L'architecture Titans introduit une approche sophistiquée pour intégrer différents types de mémoire - à court terme, à long terme et persistante - dans les modèles d'IA, ce qui leur permet d'apprendre et de mémoriser dynamiquement pendant les tests.

Le mécanisme de "surprise" est essentiel à cet égard, car il s'appuie sur la tendance du cerveau humain à se souvenir d'événements inattendus. Cette architecture permet aux modèles de gérer efficacement la mémoire en incorporant les surprises du moment et du passé, garantissant ainsi une mémorisation et une récupération efficaces des données.

Dans cet article, je vais simplifier les concepts et les mécanismes introduits dans le document de Titans et explorer l'impact potentiel de cette nouvelle architecture sur l'avenir de l'IA.

Le problème de l'architecture des transformateurs de courant

Les transformateurs constituent l'architecture utilisée dans la plupart des LLM aujourd'hui. Ils sont connus pour leur capacité à traiter des séquences de données, comme les mots d'une phrase. Ils fonctionnent très efficacement en utilisant ce que l'on appelle l'"attention".attention"qui les aide à se concentrer sur les parties pertinentes des données. Cependant, ils sont confrontés à un problème majeur : la taille de leur fenêtre contextuelle.

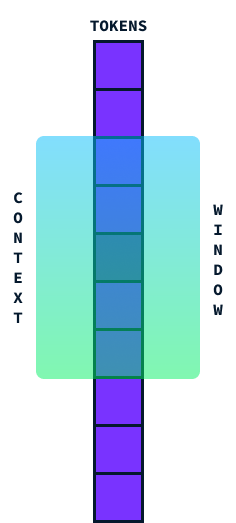

La fenêtre contextuelle représente essentiellement la quantité d'informations qu'un transformateur peut prendre en compte en même temps. Considérez-le comme une fenêtre qui court le long d'une phrase, capturant un segment de mots pour en comprendre le sens dans son contexte.

Idéalement, nous aimerions que cette fenêtre soit aussi grande que possible afin de pouvoir traiter de grandes sections de texte en une seule fois, mais il y a un problème. Lorsque nous essayons d'agrandir cette fenêtre contextuelle, la quantité de calcul nécessaire augmente de manière significative en raison de la complexité quadratique en termes de temps et d'espace. complexité quadratique en temps et en espace de l'architecture du transformateur.

Cela signifie que si nous doublons la taille de la fenêtre contextuelle, le calcul ne fait pas que doubler, il devient quatre fois plus exigeant ! Cela est dû au fait que chaque mot de la fenêtre doit être comparé à tous les autres mots, ce qui fait que les calculs augmentent rapidement.

Les modèles de pointe actuels (SOTA) comportent 2 millions de fenêtres contextuelles de jetons. Cependant, leur traitement est assez coûteux et certaines applications, telles que la compréhension de vidéos, nécessitent des fenêtres contextuelles plus larges. Le fait de disposer d'une fenêtre contextuelle plus longue sans augmentation considérable des coûts de calcul permettrait aux LLM de traiter des séquences plus longues de manière plus efficace, ce qui améliorerait leurs performances dans les tâches qui nécessitent la compréhension de plus grands ensembles de données en une seule fois. C'est pourquoi la résolution du problème du coût quadratique est une priorité majeure dans l'évolution de ces modèles.

Qu'est-ce que l'architecture des Titans ?

Titans est une nouvelle architecture qui améliore la capacité des modèles d'IA à stocker et à récupérer des informations de manière efficace, en particulier lorsqu'il s'agit de données volumineuses et complexes, en s'inspirant des subtilités de la mémoire humaine.

L'inspiration de la mémoire humaine

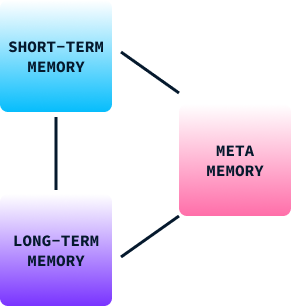

La mémoire joue un rôle crucial dans l'apprentissage et le comportement humains. Elle nous aide à retenir les informations issues de nos expériences passées, que nous utilisons pour prendre des décisions, nous adapter à de nouvelles situations et résoudre des problèmes. La mémoire humaine peut être classée en trois catégories :

- Mémoire à court terme : Il s'agit de traiter les informations courantes. Il s'agit d'un espace de travail mental où nous stockons et gérons temporairement les données dont nous avons besoin dans l'immédiat, par exemple en nous souvenant d'un numéro de téléphone juste le temps de le composer.

- Mémoire à long terme : Il stocke les informations sur de longues périodes. Il comprend nos connaissances, nos compétences et nos souvenirs personnels, ce qui nous permet de nous remémorer des expériences et d'en tirer des enseignements, même des années plus tard.

- Métamémoire : Il s'agit de savoir ce que nous savons. Elle nous aide à évaluer notre capacité à nous souvenir ou à effectuer une tâche, ce qui influence nos décisions et nos jugements.

Dans le comportement humain, ces types de mémoire fonctionnent ensemble pour nous permettre d'apprendre de nos environnements, d'adapter nos stratégies et d'améliorer nos comportements au fil du temps. Sans elle, nous serions limités à des réflexes de base et à des comportements stéréotypés.

La structure de la mémoire des Titans

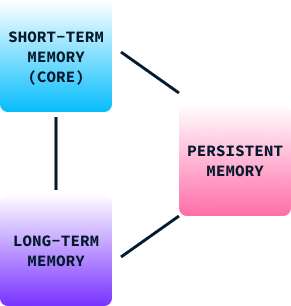

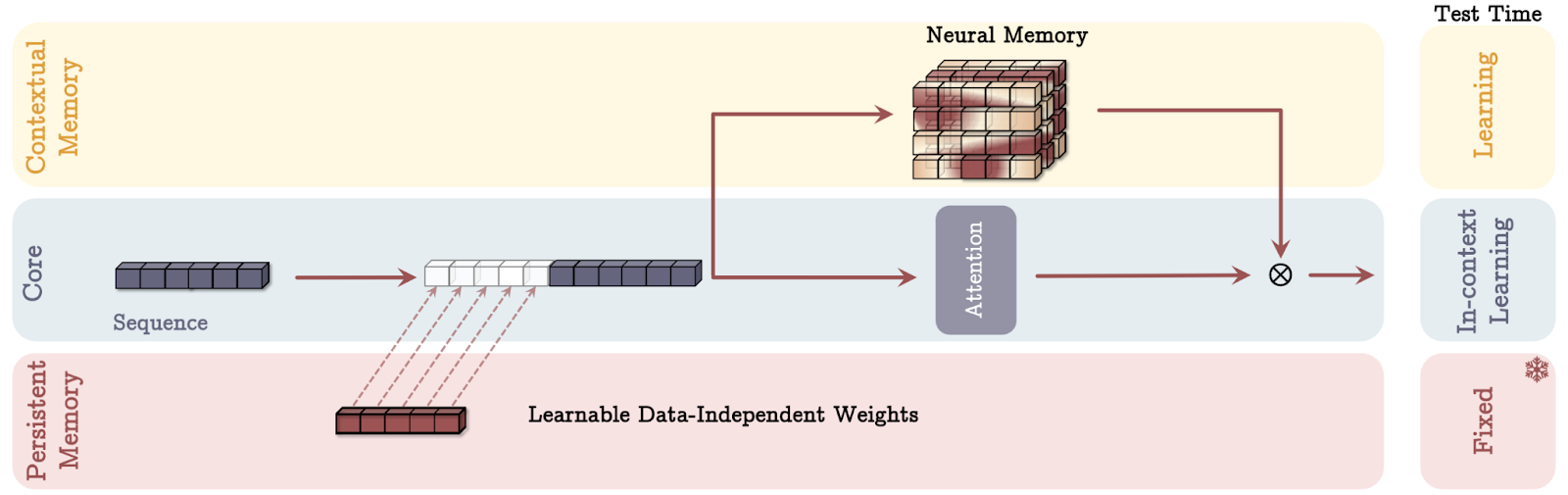

Tout comme le modèle de mémoire humaine, la structure de la mémoire de Titan est composée de trois parties :

- Mémoire à court terme (noyau) : Ce module se concentre sur le traitement des tâches courantes, ce qui permet à l'IA de traiter les données immédiates avec précision. Semblable à la mémoire à court terme du cerveau, cette composante permet de garder les informations pertinentes facilement accessibles pour un traitement rapide, mais ne les conserve pas indéfiniment.

- Mémoire à long terme : Il s'agit d'un référentiel permettant de stocker des informations sur de longues périodes. Ce module s'apparente à la mémoire à long terme des êtres humains, qui conserve les expériences, les connaissances et les souvenirs qui ne sont pas immédiatement nécessaires mais qui peuvent devenir importants dans le futur. Il permet aux modèles d'IA de se souvenir des informations passées et d'y accéder efficacement, ce qui est crucial pour les tâches nécessitant de comprendre le contexte au fil du temps.

- Mémoire persistante : Il agit comme la métamémoire d'un cerveau, en intégrant les connaissances liées à la tâche dans le modèle. Ce type de mémoire implique des paramètres qui ne dépendent pas de l'entrée actuelle mais qui sont cruciaux pour la compréhension et l'exécution de tâches spécifiques. La mémoire persistante garantit que les schémas et les cadres appris restent intégrés au modèle, ce qui renforce sa capacité à appliquer l'apprentissage passé à de nouvelles situations.

En intégrant ces trois types de mémoire, l'architecture Titans permet aux modèles d'IA de gérer dynamiquement les informations, à l'instar de notre cerveau, en combinant le traitement immédiat avec la rétention des expériences et des connaissances passées.

Le mécanisme de la surprise

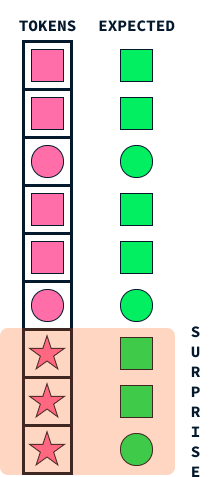

Le mécanisme de "surprise" chez les Titans imite un aspect fondamental de la mémoire humaine : notre tendance à nous souvenir plus intensément d'événements surprenants ou inattendus. Cette approche aide les modèles d'IA à décider des informations à stocker en identifiant les données qui se distinguent de celles auxquelles le modèle s'attend.

Imaginez que vous marchez dans la rue et que tout vous semble ordinaire et routinier. Vous ne vous souviendrez peut-être pas de cette promenade quotidienne quelques semaines plus tard. En revanche, si un événement inattendu se produit, comme le passage d'un défilé coloré ou la réception d'un appel téléphonique annonçant une nouvelle passionnante, ces éléments surprenants attirent votre attention, ce qui les rend plus mémorables.

De la même manière, les Titans utilisent cette idée de surprise pour hiérarchiser les informations à mémoriser. Lorsque le modèle rencontre des données qui diffèrent sensiblement de ce qu'il avait prévu (un peu comme notre défilé coloré), il signale ces informations comme surprenantes. Le système de mémoire de Titans donne alors la priorité au stockage de ces événements inattendus, en veillant à ce que les données importantes mais inhabituelles ne soient pas négligées.

Ce mécanisme permet aux Titans de gérer efficacement les ressources de leur mémoire en se concentrant sur les informations significatives et aberrantes au lieu d'essayer de retenir chaque détail. Tout comme les humains sont plus enclins à se souvenir de l'inattendu, les Titans appliquent cette stratégie naturelle pour traiter et retenir efficacement les informations vitales, ce qui leur permet d'être plus performants dans les tâches complexes qui impliquent de trier de grandes quantités de données.

Formellement, le concept de surprise est défini comme le gradient de la fonction de perte par rapport à l'entrée. Il s'agit essentiellement de mesurer l'ampleur de la modification des paramètres du modèle en réponse à la nouvelle entrée afin de minimiser la perte.

L'intuition qui sous-tend l'utilisation du gradient comme mesure de la surprise est qu'un gradient important implique que des changements significatifs sont nécessaires dans le modèle pour s'adapter à la nouvelle entrée, ce qui indique que l'entrée est très différente de ce que le modèle a vu auparavant ou qu'elle est inattendue et, par conséquent, surprenante.

Le mécanisme d'oubli

Le mécanisme d'oubli dans l'architecture de Titans est un élément essentiel conçu pour gérer efficacement la mémoire neuronale à long terme, en veillant à ce que le modèle conserve les informations pertinentes tout en éliminant ce qui n'est plus nécessaire.

Ce mécanisme est vital lorsqu'il s'agit de traiter de grandes quantités de données, où la mémoire pourrait être submergée par des informations obsolètes ou non pertinentes. Dans la pratique, le mécanisme d'oubli fonctionne en ajustant la règle de mise à jour de la mémoire pour effacer sélectivement les informations en fonction de leur facteur de surprise et de leur pertinence, qui est évaluée de manière dynamique pendant l'inférence.

Plus précisément, un paramètre de déclenchement adaptatif détermine la quantité de l'état antérieur de la mémoire à conserver, ce qui permet au modèle d'effacer ou de préserver le contenu de la mémoire de manière adaptative. Un tel mécanisme empêche le débordement de la mémoire et favorise une utilisation efficace de l'espace mémoire, améliorant ainsi la capacité du modèle à se concentrer sur les données critiques et nouvelles sans être encombré par une accumulation de données inutiles.

Cette approche reflète étroitement les processus cognitifs humains, dans lesquels les souvenirs sans importance ou périmés s'estompent avec le temps, ce qui permet un traitement cognitif et une récupération des informations plus efficaces.

Apprentissage au moment de l'inférence

Dans le cadre de l'apprentissage automatique modèles traditionnels d'apprentissage automatique traditionnels, l'apprentissage a lieu pendant la phase de formation. Une fois le modèle formé, il est déployé pour effectuer des inférences, c'est-à-dire des prédictions basées sur de nouvelles données inédites, sans autre modification des paramètres qu'il a appris.

L'architecture Titans introduit un changement révolutionnaire dans ce paradigme en permettant aux modèles d'apprendre dynamiquement pendant l'inférence, également connue sous le nom de temps de test. Cette capacité permet aux Titans de mettre à jour leur mémoire et leurs paramètres en fonction de la surprise et de l'importance des données reçues tout en les traitant.

La possibilité d'apprendre au moment de l'inférence offre plusieurs avantages significatifs :

- Adaptation dynamique aux nouvelles données : Les modèles traditionnels sont limités par la nature statique de leur apprentissage, car ils s'appuient sur des paramètres préétablis basés sur des données d'apprentissage historiques. Les titans peuvent s'adapter en temps réel à des modèles changeants et à de nouvelles données en apprenant au cours de l'inférence, ce qui améliore leur pertinence et leur précision lorsqu'ils sont confrontés à des environnements changeants ou à des données inattendues.

- Amélioration de la pertinence des données et de la gestion de la mémoire : En actualisant continuellement leur mémoire pendant les tests, les Titans peuvent donner la priorité à l'apprentissage à partir de données jugées surprenantes ou différentes des connaissances existantes. Cette gestion dynamique de la mémoire reflète la capacité du cerveau humain à se concentrer sur des informations nouvelles ou importantes et à s'en souvenir, tout en écartant les informations banales, ce qui permet d'éviter la surcharge d'informations.

- Généralisation améliorée : Étant donné que Titans peut affiner sa compréhension sur la base de données réelles, il peut mieux se généraliser à des données non distribuées, c'est-à-dire des données qui ne faisaient pas partie de l'ensemble d'apprentissage initial. Cette capacité est importante dans les applications réelles où les données d'entrée varient considérablement par rapport aux données d'apprentissage.

- Capacité accrue pour les dépendances à long terme : L'apprentissage au moment de l'inférence permet aux Titans de reconnaître et de stocker plus efficacement les dépendances à long terme dans les données. Ceci est particulièrement utile pour les tâches nécessitant le traitement de séquences étendues, telles que la compréhension de longs textes ou de vidéos.

- Applicabilité dans le monde réel : Le mécanisme d'apprentissage par inférence permet aux Titans d'évoluer continuellement, en apprenant de nouveaux modèles et de nouvelles connaissances au fur et à mesure qu'ils apparaissent. Cette caractéristique est en parfaite adéquation avec les exigences des applications réelles où les modèles doivent rester pertinents dans des environnements de données dynamiques et complexes.

Modes de mémoire des Titans

L'architecture de Titans intègre la mémoire de trois manières distinctes, chacune inspirée de différents aspects de la cognition humaine. Décortiquons chaque mode de mémoire à l'aide d'analogies simples.

Source : Behrouz et. al, 2024

La mémoire en tant que contexte (MAC)

Imaginez que vous ayez un assistant personnel pendant une réunion. Cet assistant prend des notes détaillées des conversations précédentes (mémoire à long terme) et vous chuchote des informations pertinentes à l'oreille en cas de besoin (récupération).

En mode MAC, le modèle AI fonctionne de la même manière. Il conserve un historique détaillé des données passées et les intègre aux données actuelles pour prendre des décisions éclairées. Tout comme votre assistant vous aide à combiner les connaissances passées avec les discussions présentes pour améliorer votre prise de décision, le MAC utilise la mémoire à long terme pour fournir un contexte à l'information immédiate en cours de traitement.

La mémoire comme porte (MAG)

Imaginez que vous ayez deux conseillers en tête. La première se concentre uniquement sur ce qui se passe dans l'instant, ce qui permet d'obtenir des informations sur les tâches immédiates (attention à court terme). L'autre s'appuie sur des années d'expérience et de sagesse accumulées (mémoire à long terme).

Le mode MAG agit comme un gardien qui décide de l'attention à accorder à chaque conseiller, en ajustant dynamiquement l'attention en fonction des besoins actuels par rapport à l'apprentissage passé. Cela garantit une approche équilibrée, permettant à l'IA de s'adapter, que la tâche à accomplir exige une précision immédiate ou des connaissances tirées des expériences passées.

La mémoire en tant que couche (MAL)

Considérez ce mode comme de multiples couches de compréhension, où chaque couche traite l'information de manière unique :

- La première couche peut agir comme un filtre historique, en se concentrant sur les modèles et les souvenirs à long terme.

- La deuxième couche concerne les contextes immédiats, comme les observations à court terme.

- Au fur et à mesure que les informations passent par chaque couche, elles sont affinées et transformées, ce qui permet au modèle de comprendre à la fois le contexte général et les détails les plus fins avant de prendre une décision.

Ce traitement en couches reflète la manière dont nous assimilons souvent des informations complexes par étapes, en construisant et en affinant notre compréhension pas à pas. Chaque mode offre des atouts uniques, permettant aux Titans de traiter efficacement des tâches variées en imitant les différents aspects de la façon dont les humains traitent et retiennent les informations.

Implications dans le monde réel et succès expérimental

Les résultats expérimentaux mettent en évidence la supériorité de l'architecture Titans par rapport aux transformateurs traditionnels et aux modèles modernes dans diverses tâches. Voici un aperçu des principaux résultats :

- Modélisation linguistique et raisonnement de bon sens : Titans, en particulier la variante "memory-as-context" (MAC), montre de solides performances dans les tâches de modélisation du langage et de raisonnement par le bon sens.

- Tâches de type "aiguille dans une botte de foin" : Dans les tâches qui impliquent de retrouver des éléments d'information spécifiques dans de longues séquences, connues sous le nom de "needle-in-a-haystack", les Titans excellent de manière significative.

- Traiter des contextes plus larges : Les Titans sont capables de s'adapter à des fenêtres contextuelles de plus de 2 millions de tokens sans compromettre la précision, ce qui constitue une amélioration substantielle par rapport aux modèles actuels les plus avancés.

- Prévision des séries temporelles : Le module de mémoire neuronale de Titans est plus performant que divers modèles de base, y compris les modèles linéaires et à base de transformateurs, dans les tâches de prévision.

- Modélisation de l'ADN : L'architecture de Titans montre également des performances compétitives dans les tâches de modélisation de l'ADN, ce qui prouve sa polyvalence au-delà des tâches traditionnelles liées au langage naturel.

Dans l'ensemble, les Titans exploitent une nouvelle approche de gestion de la mémoire qui leur permet de traiter plus efficacement les tâches complexes à contexte long, établissant ainsi une nouvelle norme pour les modèles d'IA en termes d'évolutivité et de précision.

Conclusion

L'architecture actuelle de Transformer, bien que puissante, a du mal à gérer des contextes extrêmement longs en raison de problèmes de mise à l'échelle. L'architecture innovante de Titans, inspirée de la mémoire humaine, surmonte ces limites en gérant dynamiquement la mémoire à court terme, la mémoire à long terme et la mémoire persistante.

Je pense que la capacité des Titans à apprendre au moment de l'inférence, à s'adapter aux nouvelles données et à hiérarchiser la mémoire sur la base d'un mécanisme de "surprise" a le potentiel de créer des systèmes d'IA qui ressemblent davantage à l'homme dans leur traitement de l'information. Cela pourrait améliorer les performances des systèmes d'IA dans des environnements complexes et dynamiques, ce qui pourrait changer la donne pour les agents d'IA tels que l'Opérateur de l'OpenAI. l'opérateur d'OpenAI.