Lernpfad

Die Welt der Datenwissenschaft entwickelt sich schnell weiter, und es gibt viele Tools, die Datenwissenschaftlern bei ihrer Arbeit helfen. In diesem Beitrag schauen wir uns die 10 besten Data-Science-Tools an, die du 2026 nutzen kannst. Diese Tools helfen dir beim Importieren, Bereinigen, Verarbeiten, Analysieren, Visualisieren und Modellieren von Daten. Außerdem bieten einige Tools auch Machine-Learning-Ökosysteme für die Modellverfolgung, -entwicklung, -bereitstellung und -überwachung an.

Die Rolle von Data-Science-Tools

Data-Science-Tools sind echt wichtig, damit Datenwissenschaftler und Analysten aus Daten wertvolle Erkenntnisse gewinnen können. Diese Tools sind super für die Datenbereinigung, -bearbeitung, -visualisierung und -modellierung.

Seit chatGPT gibt's immer mehr Tools, die mit den Modellen GPT-3.5 und GPT-4 zusammenarbeiten. Durch die Integration von KI-gestützten Tools können Datenwissenschaftler Daten noch einfacher analysieren und Modelle erstellen.

Zum Beispiel haben generative KI-Funktionen (PandasAI) ihren Weg in einfachere Tools wie Pandas gefunden, sodass Leute Ergebnisse bekommen können, indem sie Eingabeaufforderungen in natürlicher Sprache schreiben. Allerdings sind diese neuen Tools bei Datenprofis noch nicht so weit verbreitet.

Außerdem können Data-Science-Tools mehr als nur eine Aufgabe erledigen. Sie bieten zusätzliche Funktionen für anspruchsvolle Aufgaben und bringen in manchen Fällen auch Datenwissenschaft ins Ökosystem ein. MLFlow wird zum Beispiel hauptsächlich für die Modellverfolgung genutzt. Man kann es aber auch für die Modellregistrierung, Bereitstellung und Inferenz nutzen.

Kriterien für die Auswahl von Data-Science-Tools

Die Liste der Top-10-Tools basiert auf den folgenden Hauptmerkmalen:

- Beliebtheit und Akzeptanz: Tools mit vielen Nutzern und Community-Support haben mehr Ressourcen und Dokumentation. Beliebte Open-Source-Tools werden ständig verbessert.

- Einfach zu benutzen: Intuitive Arbeitsabläufe ohne viel Programmieraufwand machen schnelleres Prototyping und Analysen möglich.

- Skalierbarkeit: Die Fähigkeit, mit großen und komplizierten Datensätzen umzugehen.

- End-to-End-Fähigkeiten: Tools, die verschiedene Aufgaben wie Datenvorbereitung, Visualisierung, Modellierung, Bereitstellung und Inferenz unterstützen.

- Datenverbindung: Flexibilität beim Verbinden mit verschiedenen Datenquellen und Formaten wie SQL, nosql-Datenbanken, APIs, unstrukturierten Daten usw.

- Interoperabilität: Lässt sich super mit anderen Tools verbinden.

Umfassender Überblick über die besten Data-Science-Tools für 2026

In diesem Testbericht schauen wir uns neue und bewährte Tools an, die für Datenwissenschaftler am Arbeitsplatz echt wichtig geworden sind. Diese Tools haben ein paar Sachen gemeinsam: Sie sind leicht zugänglich, benutzerfreundlich und bieten starke Funktionen für die Datenanalyse und maschinelles Lernen.

Python-basierte Tools für die Datenwissenschaft

Python wird oft für Datenanalyse, Datenverarbeitung und maschinelles Lernen benutzt. Seine Einfachheit und die große Entwickler-Community machen es zu einer beliebten Wahl.

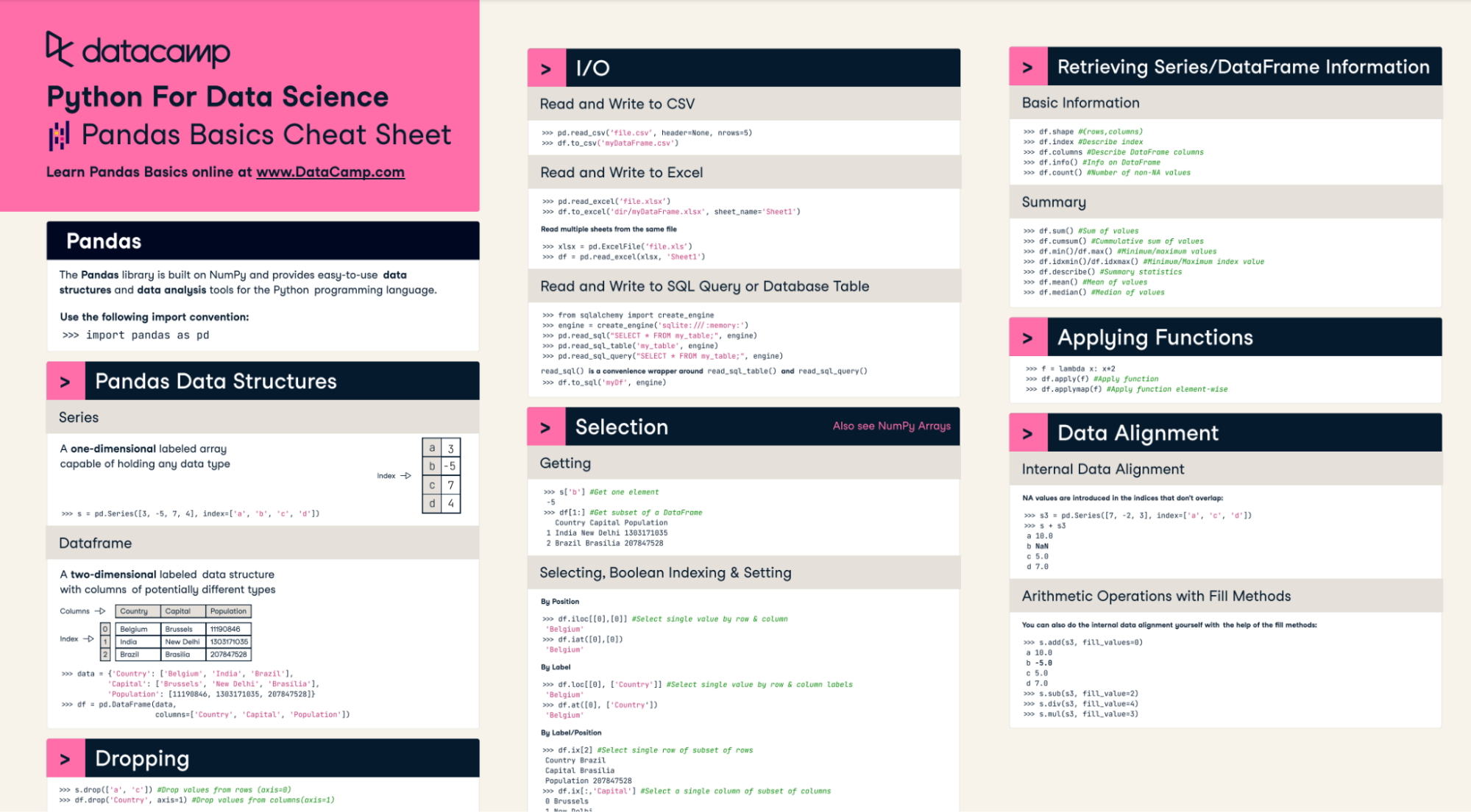

1. Pandas

Pandas macht Datenbereinigung, -bearbeitung, -analyse und Feature Engineering in Python echt einfach. Es ist die Bibliothek, die von Datenprofis für alle möglichen Aufgaben am häufigsten genutzt wird. Du kannst es jetzt auch für die Datenvisualisierung nutzen.

Unser Panda-Spickzettel hilft dir dabei, dieses Data-Science-Tool zu meistern.

2. Seaborn

Seaborn ist eine leistungsstarke Bibliothek zur Datenvisualisierung, die auf Matplotlib basiert. Es hat eine Reihe von coolen und gut gestalteten Standarddesigns und ist besonders praktisch, wenn du mit Pandas-DataFrames arbeitest. Mit Seaborn kannst du schnell und einfach übersichtliche und aussagekräftige Visualisierungen erstellen.

3. Scikit-learn

Scikit-learn ist die Python-Bibliothek, die man für maschinelles Lernen einfach haben muss. Diese Bibliothek bietet eine einheitliche Schnittstelle zu gängigen Algorithmen, darunter Regression, Klassifizierung, Clustering und Dimensionsreduktion. Es ist auf Leistung optimiert und wird von Datenwissenschaftlern oft benutzt.

Open-Source-Tools für die Datenwissenschaft

Open-Source-Projekte haben echt dazu beigetragen, die Datenwissenschaft voranzubringen. Sie bieten eine Menge Tools und Ressourcen, die Datenwissenschaftlern helfen können, effizienter und effektiver zu arbeiten.

4. Jupyter-Notebooks

Jupyter Notebooks ist eine beliebte Open-Source-Webanwendung, mit der Datenwissenschaftler Dokumente erstellen können, die Live-Code, Visualisierungen, Gleichungen und Textbeschreibungen kombinieren und geteilt werden können. Perfekt für explorative Analysen, Zusammenarbeit und Berichterstellung.

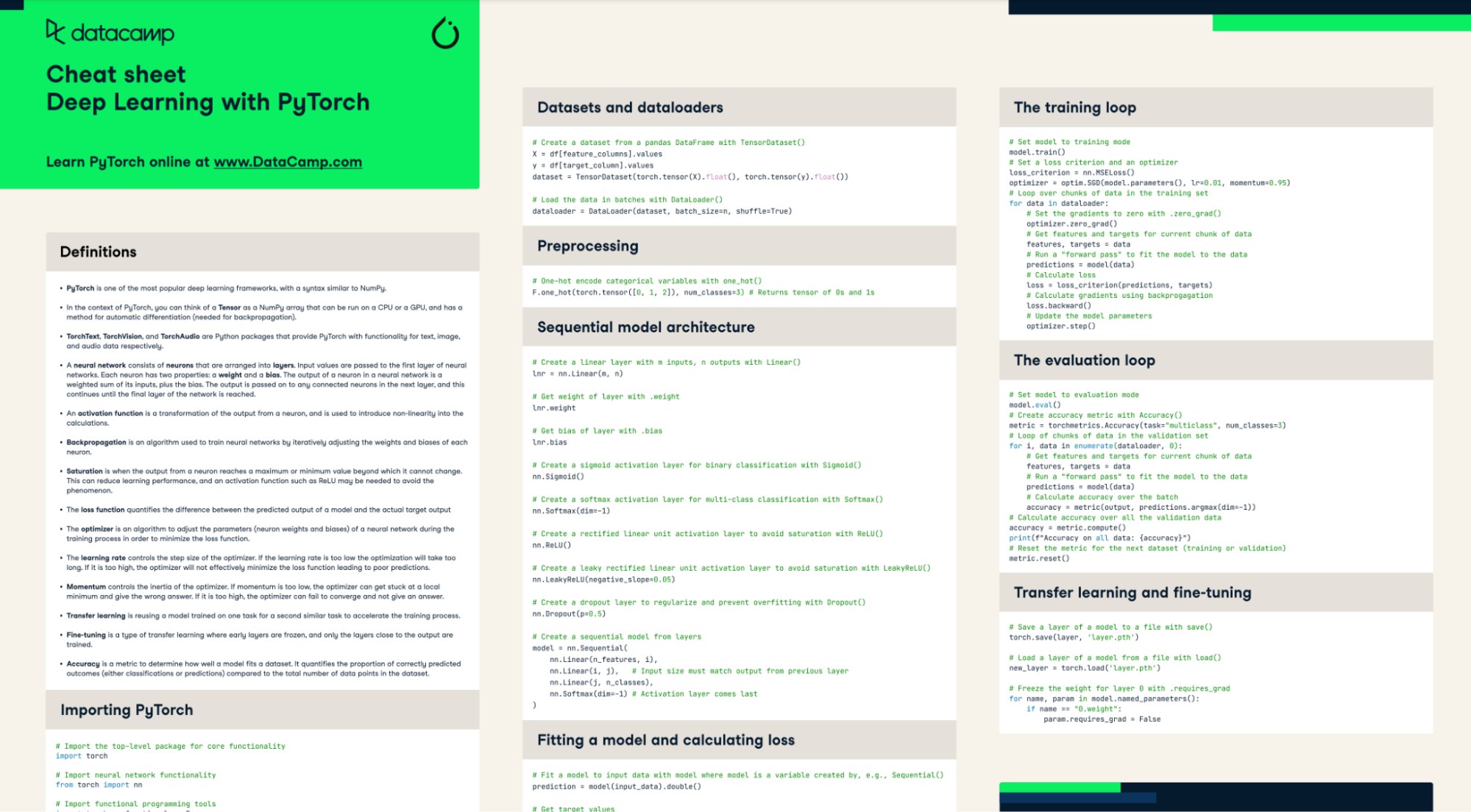

5. Pytorch

Pytorch ist ein echt flexibles und quelloffenes Framework für maschinelles Lernen, das oft für die Entwicklung von neuronalen Netzmodellen genutzt wird. Es bietet Modularität und ein riesiges Ökosystem an Tools für die Verarbeitung verschiedener Datentypen wie Text, Audio, Bild und tabellarische Daten. Mit GPU- und TPU-Unterstützung kannst du dein Modelltraining um das Zehnfache beschleunigen.

Lerne Pytorch mit unserem praktischen Spickzettel

6. MLFlow

MLFlow ist eine Open-Source-Plattform von Databricks, mit der man den ganzen Lebenszyklus des maschinellen Lernens verwalten kann. Es verfolgt Experimente, Paketmodelle und die Bereitstellung in der Produktion und sorgt dabei für Reproduzierbarkeit. Es funktioniert auch mit Lernpfad-LLMs und hat sowohl eine Befehlszeilenschnittstelle als auch eine grafische Benutzeroberfläche. Es gibt auch eine API für Python, Java, R und Rest.

7. Hugging Face

Hugging Face ist jetzt die zentrale Anlaufstelle für die Entwicklung von Open-Source-Lösungen im Bereich maschinelles Lernen. Es macht es einfach, auf Datensätze, moderne Modelle und Inferenz zuzugreifen, sodass du deine Modelle mit verschiedenen Tools aus dem Hugging Face-Ökosystem bequem trainieren, bewerten und einsetzen kannst. Außerdem gibt's Zugang zu High-End-GPUs und Lösungen für Unternehmen. Egal, ob du dich mit maschinellem Lernen beschäftigst, forschst oder beruflich damit zu tun hast – das ist die einzige Plattform, die du brauchst, um erstklassige Lösungen für deine Projekte zu entwickeln.

Eigene Tools für die Datenwissenschaft

Robuste, eigene Plattformen bieten Funktionen für Unternehmen, Einrichtung mit einem Klick und sind einfach zu bedienen. Sie bieten auch Unterstützung und Sicherheit für deine Daten.

8. Tableau

Tableau ist ein führender Anbieter von Business-Intelligence-Software. Es ermöglicht intuitive interaktive Datenvisualisierungen und Dashboards, die Erkenntnisse aus Daten in großem Maßstab liefern. Mit Tableau können Leute sich mit vielen verschiedenen Datenquellen verbinden, die Daten für die Analyse aufbereiten und dann coole Visualisierungen wie Diagramme, Grafiken und Karten erstellen. Die Software ist einfach zu bedienen, sodass auch Leute ohne technische Kenntnisse Berichte und Dashboards per Drag-and-Drop erstellen können.

9. RapidMiner

RapidMiner ist eine komplette Plattform für fortgeschrittene Analysen, mit der man Machine Learning und Datenpipelines aufbauen kann. Sie hat einen visuellen Workflow-Designer, der den Prozess einfacher macht. Von der Datenvorbereitung bis zur Modellbereitstellung bietet RapidMiner alle Tools, die du brauchst, um jeden Schritt des ML-Workflows zu verwalten. Mit dem visuellen Workflow-Designer, der das Herzstück von RapidMiner bildet, kannst du ganz einfach Pipelines erstellen, ohne Code schreiben zu müssen.

KI-Tools

Im letzten Jahr sind KI-Tools für die Datenanalyse echt wichtig geworden. Sie werden für die Codegenerierung, Validierung, Ergebnisauswertung, Berichterstellung und vieles mehr verwendet.

10. ChatGPT

chatGPT ist ein KI-basiertes Tool, das dir bei verschiedenen Aufgaben im Bereich Data Science helfen kann. Es kann Python-Code erstellen und ausführen und auch komplette Analyseberichte machen. Aber das ist noch nicht alles. chatGPT hat eine Reihe von Plugins, die echt nützlich sein können für Forschung, Experimente, Mathe, Statistik, Automatisierung und die Überprüfung von Dokumenten. Zu den wichtigsten Funktionen gehören DALLE-3 (Bilderzeugung), Browser mit Bing und chatGPT Vision (Bilderkennung).

Du kannst dir den Leitfaden zur Verwendung von chatGPT für Data-Science-Projekte ansehen, um zu lernen, wie man chatGPT benutzt und komplette Data-Science-Projekte aufbaut.

Praktische Projekte und Ressourcen

Suchst du nach Möglichkeiten, diese Datentools auf echte Datensätze anzuwenden? Bei DataCamp bist du genau richtig. Es gibt sowohl geführte als auch ungeführte Projekte, die du auf ein KI-basiertes Notebook namens DataLab laden kannst, sodass du sofort mit der Arbeit an einem Projekt loslegen kannst. Die Projektliste von DataCamp ist riesig und deckt viele Themen ab, wie Datenverarbeitung, maschinelles Lernen, Data Engineering, MLOps, LLMs, NLP und mehr.

Hier sind die Links zu weiteren Projekten, die dir dabei helfen, modernste Tools auf deinen Datensatz anzuwenden:

- 7 spannende KI-Projekte für Anfänger, Fortgeschrittene und Profis

- 5 Projekte, die mit generativen Modellen und Open-Source-Tools erstellt wurden

- Über 60 Python-Projekte für alle Kenntnisstufen

- 6 Tableau-Projekte, die dir helfen, deine Fähigkeiten zu verbessern

- 10 SQL-Projekte für dein Portfolio, für alle Niveaus

- 20 Datenanalyseprojekte für alle Niveaus

- 25 Projekte zum maschinellen Lernen für alle Niveaus

Fazit

Im spannenden Bereich der Datenwissenschaft, wo Innovation ganz normal ist, gibt's gerade aufregende Entwicklungen. Dieser Blogbeitrag gibt einen guten Überblick über die Top 10 der Data-Science-Tools, die gerade immer beliebter werden und wahrscheinlich 2026 noch mehr genutzt werden.

Python-basierte Bibliotheken wie Pandas, Seaborn und Scikit-learn bieten coole Funktionen für die Datenvorbereitung, Analyse, Visualisierung und Modellierung. Open-Source-Plattformen wie MLflow, Pytorch und Hugging Face machen das Experimentieren, Entwickeln und Bereitstellen schneller. Mit proprietären Lösungen wie Tableau und RapidMiner kannst du Business Intelligence auf Unternehmensebene und ein durchgängiges Management des Machine-Learning-Lebenszyklus machen. Und neue KI-Assistenten wie chatGPT machen Codes und geben Einblicke, was die Produktivität steigert.

Wenn du ein super Data Scientist werden und richtig gut mit diesen Tools umgehen lernen willst, dann mach doch den Lernpfad „Data Scientist mit Python“ mit. Dieses Programm gibt dir die wichtigsten Fähigkeiten, die du brauchst, um als Datenwissenschaftler richtig gut zu sein, von der Datenbearbeitung bis zum maschinellen Lernen.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.