Kurs

Nachdem du die Grundlagen der Datenanalyse gelernt hast, ist es Zeit, deine Fähigkeiten bei Projekten anzuwenden. Firmen suchen lieber Studenten mit viel Projekterfahrung und wollen Leute, die sich mit Datenerfassung und -bereinigung, Datenbearbeitung, Probabilistik & Statistik, Predictive Analytics und Berichterstellung auskennen.

Es geht nicht darum, eine neue Sprache oder neue Tools zu lernen. Es geht darum, die Daten zu verstehen und wichtige Infos rauszuziehen. Du musst an mehreren Projekten arbeiten, um die Daten besser zu verstehen und Berichte für Leute zu erstellen, die nicht technisch versiert sind.

In diesem Blog geht's um Datenanalyseprojekte für Leute, die gerade anfangen, Profis und Studenten im letzten Studienjahr. Außerdem lernst du alles über End-to-End-Projekte, die alle wichtigen Schritte abdecken, vom Datenimport bis zur Berichterstellung.

Wenn du nach Projekten suchst, die sich mehr auf künstliche Intelligenz konzentrieren, schau dir unseren separaten Leitfaden zu einigen der besten KI-Projekte an, mit denen du noch heute loslegen kannst.

KI-Upskilling für Einsteiger

Warum Datenanalyseprojekte wählen?

Datenanalyseprojekte sind echt wichtige Sprungbretter für alle, die in der heutigen datenorientierten Welt was erreichen wollen. Hier ist der Grund, warum sie wichtig sind:

- Praktische Anwendung der Fähigkeiten: Sie bieten praktische Erfahrungen und schließen die Lücke zwischen theoretischem Wissen und der Praxis.

- Vielseitigkeit in der Industrie: Datenanalyse ist in vielen Branchen echt wichtig. An verschiedenen Projekten zu arbeiten, macht dich flexibler und hilft dir, Dinge besser zu verstehen.

- Kritisches Denken: Diese Projekte helfen dir dabei, komplexe Probleme zu analysieren, Muster zu erkennen und datengestützte Lösungen zu entwickeln.

- Technische Kompetenz: Durch die Arbeit an Projekten verbesserst du deine Fähigkeiten im Umgang mit wichtigen Tools und Sprachen und wirst so zu einem kompetenteren und vielseitigeren Analysten.

- Effektive Kommunikation: Sie bringen dir bei, wie du komplexe Datenerkenntnisse in verständliche und umsetzbare Infos umwandelst – eine Fähigkeit, die in jedem beruflichen Umfeld echt geschätzt wird.

- Karriere: Wenn du Projekte abschließt, wird dein Portfolio besser, du zeigst potenziellen Arbeitgebern, was du kannst, und erweiterst deine Karrierechancen.

Im Grunde genommen verbessern Datenanalyseprojekte nicht nur deine technischen Fähigkeiten, sondern machen dich auch fit für die Herausforderungen und Anforderungen der modernen Arbeitswelt.

Datenanalyseprojekte für Leute, die gerade erst anfangen

Als Anfänger solltest du dich darauf konzentrieren, die Daten zu importieren, zu bereinigen, zu bearbeiten und zu visualisieren.

- Datenimport: Lerne, wie du Daten mit SQL, Python, R oder Web Scraping importierst.

- Datenbereinigung: Nutze verschiedene Python- und R-Bibliotheken, um die Daten zu bereinigen und zu verarbeiten.

- Datenbearbeitung: Man nimmt verschiedene Techniken, um den Datensatz für die Datenanalyse und -visualisierung vorzubereiten.

- Datenvisualisierung: Zeig die Daten mit Diagrammen und Grafiken an.

Projekte zum Importieren und Bereinigen von Daten

1. Den Airbnb-Markt in NYC erkunden

Im Projekt „Exploring the NYC Airbnb Market“ wirst du deine Fähigkeiten im Bereich Datenimport und -bereinigung anwenden, um den Airbnb-Markt in New York zu analysieren. Du wirst Daten aus verschiedenen Dateiformaten zusammenführen, Zeichenfolgen bereinigen und Datumsangaben formatieren, um genaue Infos zu bekommen.

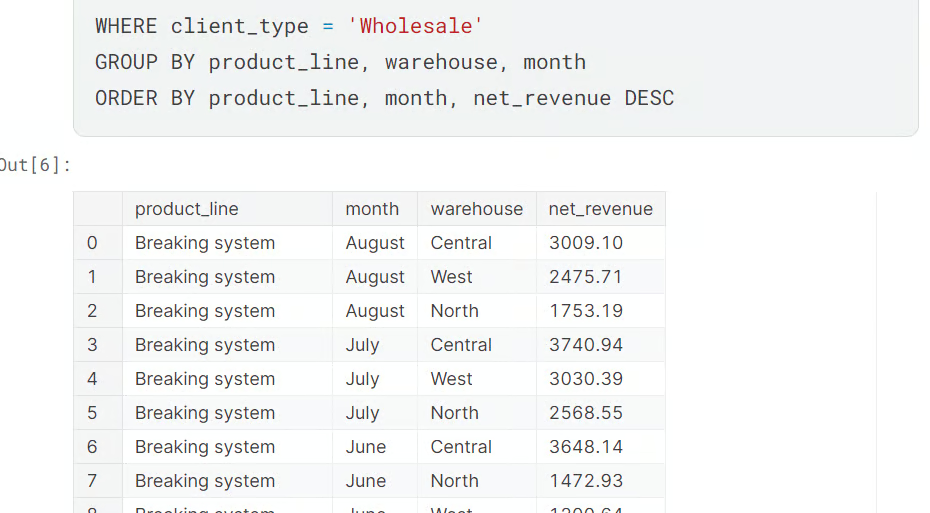

Bild vom Autor | Code aus dem Projekt

Das Projekt ist super für Leute, die gerade anfangen und Erfahrungen mit der Datenimport/-bereinigung sammeln wollen. Du kannst ähnliche Methoden auf diesen Datensatz zum Online-Ticketverkauf anwenden, um die Daten noch besser zu verarbeiten und zu bearbeiten.

Lerne in kurzen Kursen mehr über den Import und die Bereinigung von Daten:

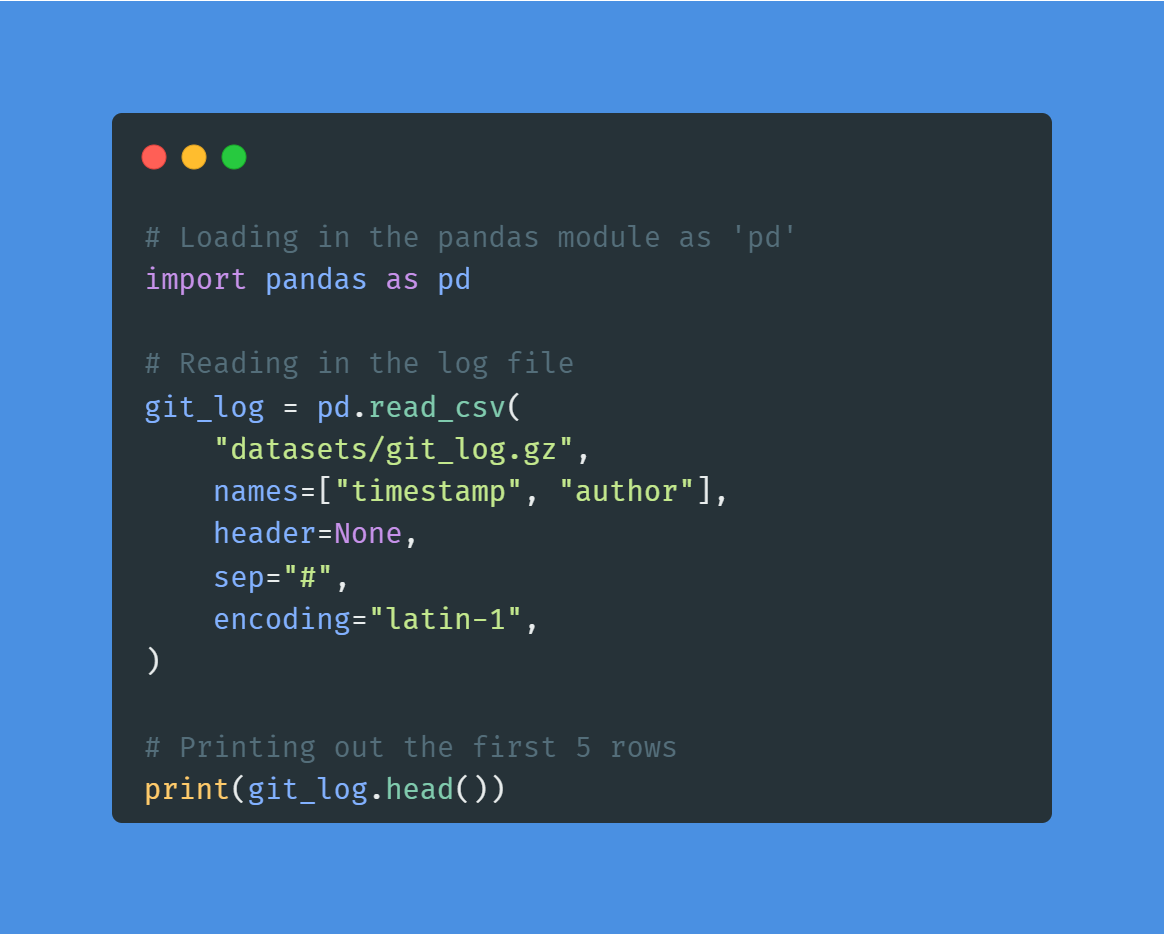

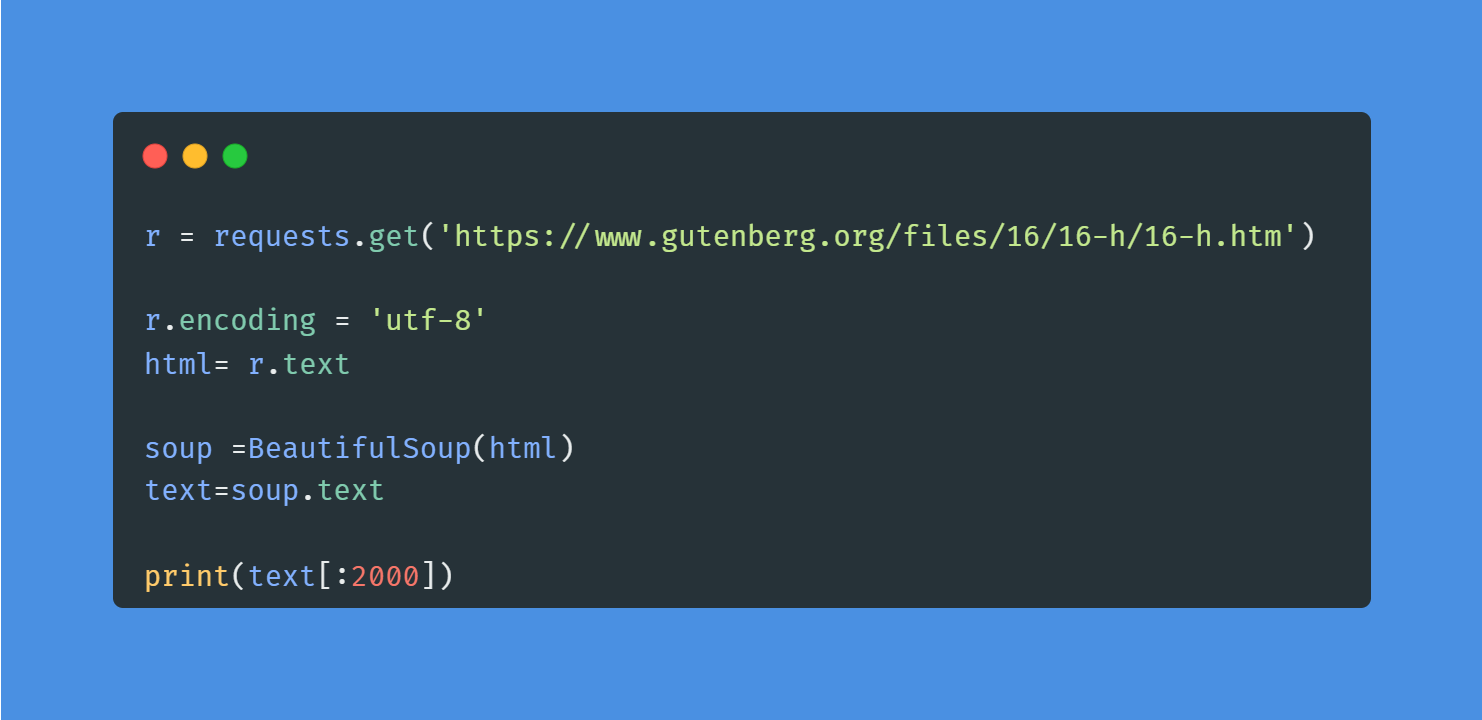

2. Wortfrequenz in klassischen Romanen

Im Projekt „Wortfrequenz in klassischen Romanen” wirst du die Tools „ requests ” und „ BeautifulSoup ” nutzen, um einen Roman von der Website „Project Gutenberg” zu scrapen. Nachdem du die Textdaten gesammelt und bereinigt hast, wirst du mit NLP die häufigsten Wörter in Moby Dick finden. Das Projekt zeigt dir die Welt des Python-Web-Scrapings und der Verarbeitung natürlicher Sprache.

Bild vom Autor | Code aus dem Projekt

Für Datenanalysten und Datenwissenschaftler ist Web Scraping eine wichtige Fähigkeit, die man lernen sollte. Du kannst einen kurzen Kurs zum Thema „Web Scraping mit Python“ machen, um die Tools und Bestandteile einer HTML-Webseite zu verstehen.

NLP in Python heute meistern

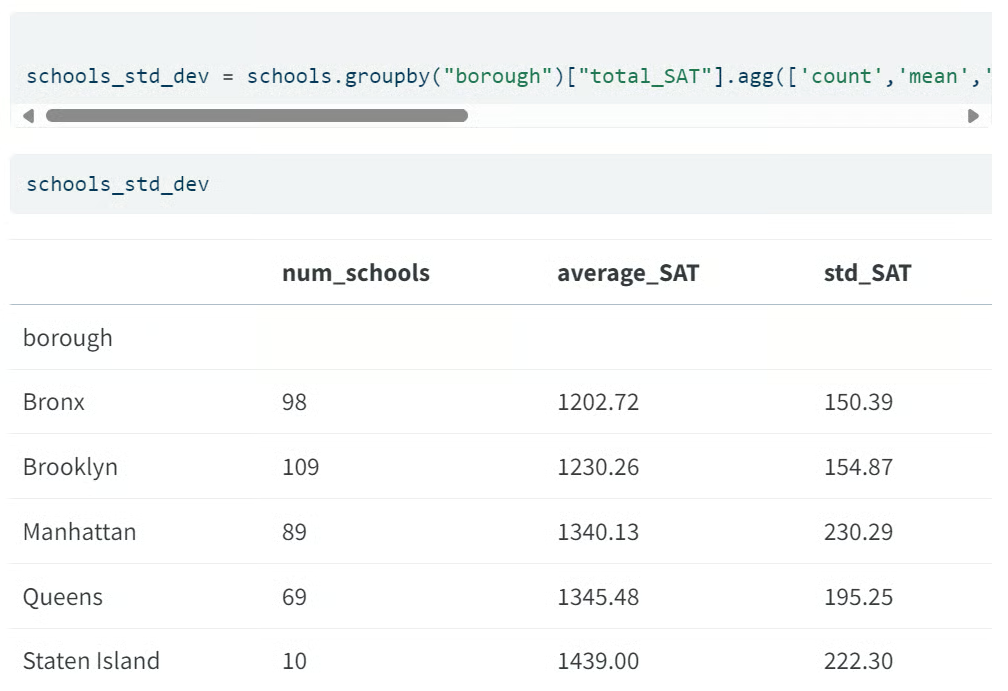

3. Die Testergebnisse der öffentlichen Schulen in NYC anschauen

In der Projekt „Untersuchung der Testergebnisse an öffentlichen Schulen in NYC” analysierst du die standardisierten SAT-Leistungen an den öffentlichen Schulen von New York City. Du wirst die Spalten (Mathematik, Lesen, Schreiben) bereinigen und zusammenfassen, die Ergebnisse der Stadtbezirke vergleichen, die Schulen nach ihren Mathematiknoten bewerten und die zehn besten Schulen der Stadt ermitteln. Dabei lernst du die wichtigsten Schritte eines Analysten: Typen festlegen, mit fehlenden Werten umgehen, Gruppenstatistiken berechnen und rohe Daten auf Schulebene in klare, entscheidungsrelevante Erkenntnisse umwandeln.

Bild vom Autor | Code aus dem Projekt

Dieses Projekt ist super für Leute, die gerade anfangen und eine realistische, geschäftsorientierte explorative Datenanalyse (EDA) mit Ranking, Benchmarking und geografischer Aufteilung machen wollen. Du kannst die gleiche Methode für ähnliche Datensätze wie „Faktoren, die die Leistung von Schülern beeinflussen“ oder die offenen Daten deines lokalen Schulbezirks nutzen, um dein Portfolio mit vergleichbaren und reproduzierbaren Analysen zu verbessern.

Projekte der Datenbearbeitung

4. Verkäufe von Motorradteilen analysieren

In der Projekt „Analyse des Motorradteilverkaufs” fragest du eine Vertriebsdatenbank mit mehreren Lagern ab, um Umsatzmuster über Zeiträume, Produktlinien und Standorte hinweg zu ermitteln. Du berechnest den Nettoumsatz (unter Berücksichtigung von Rabatten/Rückgaben, wo das nötig ist), teilst ihn nach Lager und Datum auf, ordnest die Produktkategorien mit der besten Leistung und erstellst Vergleichsschnitte, um Wachstum und Rückgang zu zeigen.

Mach dich auf jede Menge praktische SQL-Kenntnisse gefasst: Joins, Datumsabschnitte, bedingte Aggregation und Fensterfunktionen, um aus rohen Transaktionen klare, für Führungskräfte geeignete Berichte zu machen.

Bild vom Autor | Code aus dem Projekt

Dieses Projekt ist super für Analysten, die praktische SQL-Erfahrung sammeln wollen, die echtem Arbeitsalltag entspricht: KPI-Definitionen, Umsatz-Rollups, Lager-Benchmarking und zeitbasierte Leistungsüberwachung, die du in ein Dashboard oder eine wöchentliche Betriebsauswertung einbinden kannst.

5. Den Bitcoin-Kryptowährungsmarkt erkunden

Im Projekt „Den Bitcoin-Kryptowährungsmarkt erkunden “ wirst du dich mit Daten zu Bitcoin und anderen Kryptowährungen beschäftigen. Du wirst den Datensatz bereinigen, indem du Kryptowährungen ohne Marktkapitalisierung rauswirfst, Bitcoin mit anderen Währungen vergleichst und die Daten für die Visualisierung vorbereitest.

vom Autor | Code aus dem Projekt

vom Autor | Code aus dem Projekt

Du kannst ähnliche Methoden auf Börsendaten anwenden und lernen, wie man die Daten für die Datenanalyse bearbeitet. Außerdem kannst du im Kurs „Datenbearbeitung mit pandas“ lernen, wie man Daten umwandelt, zusammenfasst, aufteilt und indexiert.

6. Die Geschichte der Nobelpreisträger anschaulich machen

Im Projekt „Visualisierung der Geschichte der Nobelpreisträger“ schaust du dir über ein Jahrhundert Nobelpreisgeschichte an. Mit Python analysierst und visualisierst du Daten, um Muster und mögliche Verzerrungen bei der Vergabe renommierter Auszeichnungen in Kategorien wie Physik, Chemie, Literatur und Frieden aufzudecken.

Du wirst Datenbearbeitung mit Pandas anwenden und mit Seaborn coole Visualisierungen erstellen, um mit den Daten eine Geschichte zu erzählen. Dieses Projekt ist super, um deine Fähigkeiten in der Datenanalyse und -visualisierung zu verbessern und gleichzeitig eine der bekanntesten Auszeichnungen der Welt zu erkunden.

Datenvisualisierungsprojekte

7. Mit Plotly die Trends an der Börse checken

In der Projekt „Aktienmarkttrends mit Plotly erkunden” verwandelst du Rohpreisdaten von Fast-Food-Giganten (z. B. McDonald's, Starbucks) in interaktive Diagramme, die die Dynamik und Muster des Sektors aufzeigen. Du kannst Candlestick- und Liniendiagramme erstellen, gleitende Durchschnitte und rollierende Statistiken hinzufügen, mehrere Ticker vergleichen und wichtige Ereignisse kommentieren. Dabei konzentrierst du dich auf visuelles Storytelling, das Volatilität, Saisonalität und relative Performance hervorhebt.

Das ist ein Projekt, bei dem die Visualisierung im Vordergrund steht. Es ist perfekt, wenn du ein übersichtliches, portfoliofähiges Dashboard willst, das Marktkenntnisse durch Interaktivität (Hover, Zoom, Bereichsregler) statt durch aufwendige Modellierung zeigt.

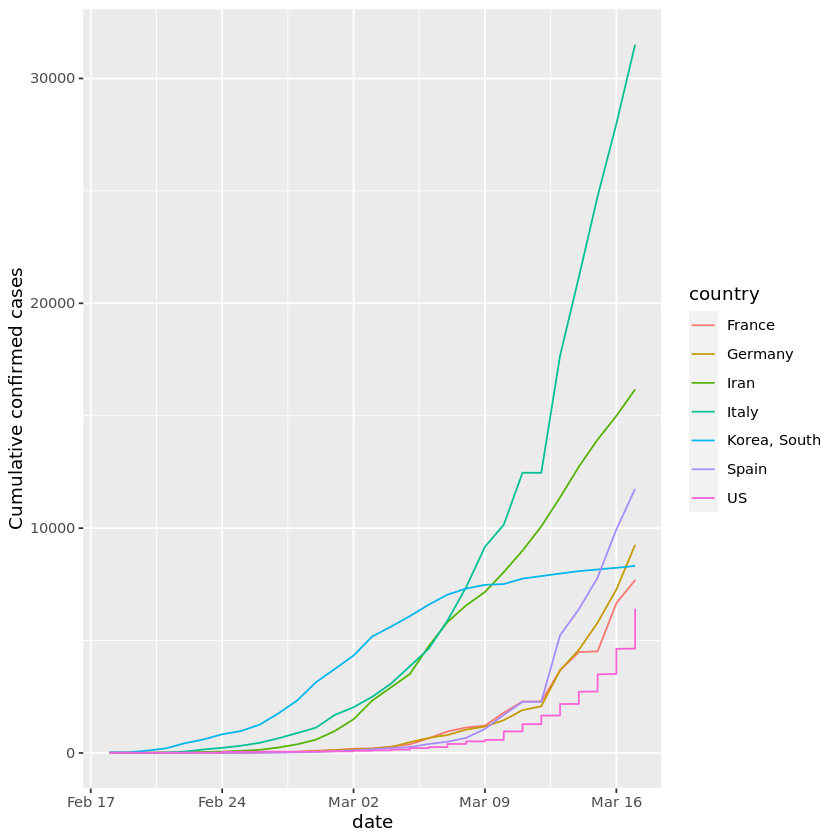

8. COVID-19 anschaulich machen

Im Projekt „Visualisierung von COVID-19 “ visualisierst du COVID-19-Daten mit der beliebten R-Bibliothek „ ggplot “. Du wirst bestätigte Fälle weltweit analysieren, China mit anderen Ländern vergleichen, lernen, wie man den Graphen mit Anmerkungen versieht, und eine logarithmische Skala hinzufügen. Das Projekt bringt dir Fähigkeiten bei, die bei R-Programmierern echt gefragt sind.

Bild aus dem Projekt

Du kannst die ggplot-Methoden auf die Masern-Daten anwenden und so mehr Erfahrung in der Datenvisualisierung und -analyse sammeln. Außerdem kannst du den Kurs „Intermediate Data Visualization with ggplot2 ” machen, um die besten Praktiken der Datenvisualisierung zu lernen.

9. Analyse der Zuschauerzahlen und Werbung beim Super Bowl

Im Projekt „Analyse der Zuschauerzahlen und Werbung beim Super Bowl “ schaust du dir die ganze Geschichte hinter dem Super Bowl an – von den Spielen und Werbespots bis hin zu den Halbzeitshows. Mit R kannst du Daten bearbeiten und visualisieren, um herauszufinden, wie diese Elemente miteinander interagieren. Perfekt, um deine Fähigkeiten in der Datenanalyse mit Tools wie ggplot2 und dplyr zu verbessern.

Den Code zu benutzen, um interaktive Datenvisualisierungen anzuzeigen, ist einfach, aber die Daten zu verstehen und zu interpretieren ist schwierig. Mach den Kurs „Datenvisualisierung verstehen“, um zu lernen, wie man Visualisierungen verbreitet und welche Techniken am besten geeignet sind, um komplexe Daten zu vermitteln.

Projekte zur fortgeschrittenen Datenanalyse

Für anspruchsvollere Datenanalyseprojekte musst du dich mit Mathe, Wahrscheinlichkeitsrechnung und Statistik auskennen. Außerdem machst du explorative Daten- und prädiktive Analysen, um die Daten richtig zu verstehen.

- Probabilistik & Statistik: Berechne den Mittelwert, den Median, die Standardabweichung, Wahrscheinlichkeitsverteilungsalgorithmen und die Korrelation der Daten.

- Explorative Datenanalyse: Schau dir die Datenverteilung an, lerne verschiedene Spaltentypen kennen und finde heraus, welche Trends und Muster es gibt.

- Predictive Analytics: Mach Regression, Klassifizierung, Clustering und Prognosen mit Algorithmen für maschinelles Lernen.

Probabilistik & Statistik Projekte

10. Modellierung der Ergebnisse von Kfz-Versicherungsansprüchen

Im Projekt „Modellierung von Versicherungsansprüchen bei Autounfällen “ wirst du Python und logistische Regression nutzen, um Versicherungsansprüche vorherzusagen. Mit den Daten von On the Road Car Insurance findest du die wichtigsten Merkmale, die zu den genauesten Vorhersagen führen. Dieses Projekt hilft dir dabei, Techniken des maschinellen Lernens auf echte Geschäftsprobleme in der Versicherungsbranche anzuwenden.

11. Hypothesentests mit Fußballspielen von Männern und Frauen

Im Projekt „Hypothesentests mit Fußballspielen von Männern und Frauen “ schaust du dir alte Fußballdaten an, um zu checken, ob bei internationalen Frauenspielen mehr Tore fallen als bei Männerspielen. Mit Python kannst du deine Fähigkeiten im Bereich statistischer Tests verbessern und Muster in globalen Fußballtrends entdecken.

Wenn du dich für die gängigsten statistischen Verfahren, Wahrscheinlichkeit, Datenverteilung, Korrelation und Versuchsplanung interessierst, dann mach den Kurs „Einführung in die Statistik mit Python “.

Explorative Datenanalyse (EDA)-Projekte

12. Internationale Schuldenstatistiken checken

Im Projekt „Analyse internationaler Schuldenstatistiken” wirst du SQL-Abfragen schreiben, um internationale Schulden anhand des Datensatzes der Weltbank zu untersuchen und zu analysieren. SQL ist das beliebteste und wichtigste Tool, um unterwegs Datenanalysen zu machen.

In dem Projekt wirst du Folgendes finden:

- Verschiedene Länder

- Unterschiedliche Schuldenindikatoren

- Gesamtbetrag der Schulden der Länder

- Land mit der höchsten Verschuldung

- Durchschnittliche Verschuldung über alle Indikatoren

- Die höchste Summe an Tilgungszahlungen

- Der häufigste Schuldenindikator

Bild vom Autor | Code aus dem Projekt

Du wirst den World Nations MariaDB-Datensatz verbinden und ähnliche Abfragen machen, um mehr Erfahrung im Umgang mit und der Analyse von SQL-Datenbanken zu sammeln. Außerdem kannst du den Kurs „Explorative Datenanalyse in SQL” machen, um deine Techniken und Abfragen beim Umgang mit verschiedenen SQL-Datenbanken zu verbessern.

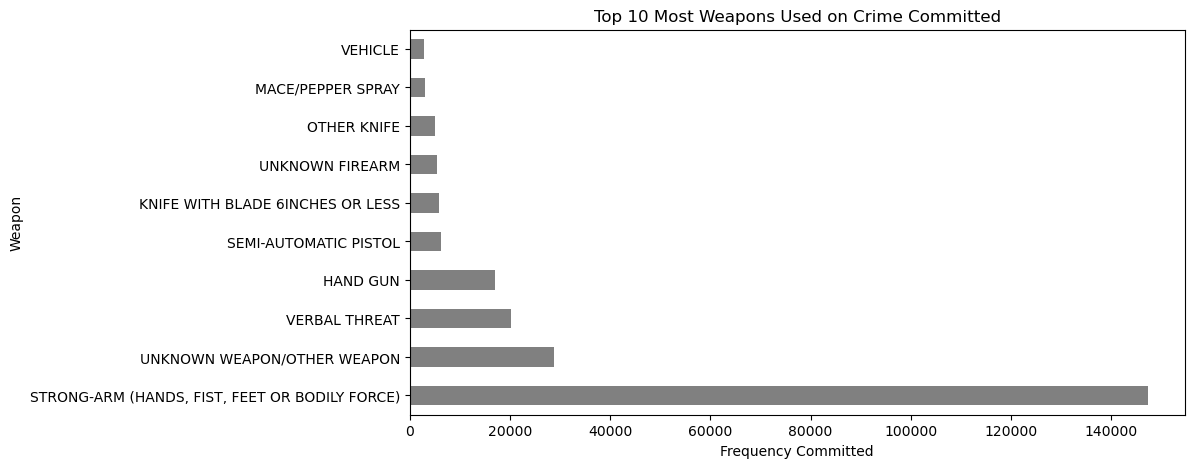

13. Analyse der Kriminalität in Los Angeles

In der Projekt „Analyse der Kriminalität in Los Angeles“ wirst du als Datendetektiv für die LAPD arbeiten und Vorfalldaten bereinigen und segmentieren, um herauszufinden, wann und wo Verbrechen am wahrscheinlichsten auftreten und welche Arten von Straftaten vorherrschen. Du kannst nach Tageszeit, Wochentag, Nachbarschaft und Kategorie filtern, Hotspot-Zusammenfassungen erstellen und Vergleichsdaten zusammenstellen, die dir direkt Einblicke in die Ressourcenzuteilung geben.

Bild aus dem Projekt

Du wirst dich mit folgenden Themen beschäftigen: Datenbereinigung, Gruppierung und Aggregation, zeitbasierte Bucketing, Normalisierung von Raten (pro Kopf oder pro Zeitfenster), Rangliste der Top-N-Stadtteile/Straftaten und Erstellung verständlicher Tabellen/Diagramme für die Entscheidungsfindung.

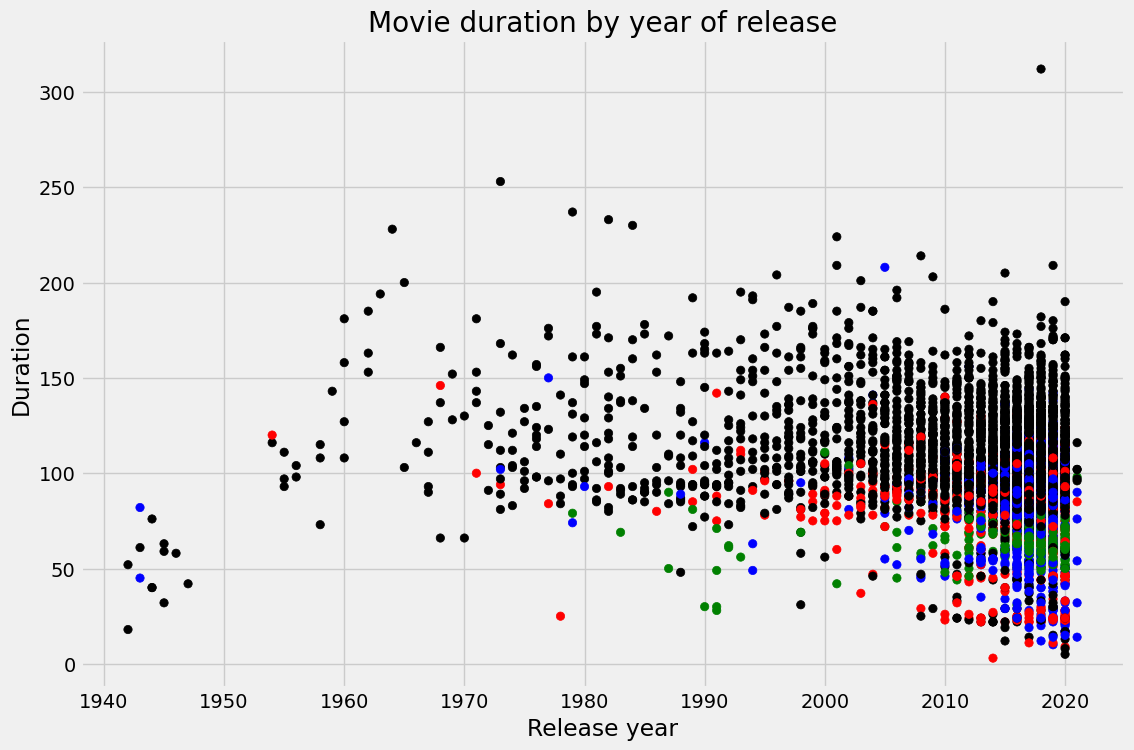

14. Netflix-Filme und Gaststars in „The Office“ unter die Lupe genommen

Im Projekt „Untersuchung von Netflix-Filmen und Gaststars in The Office“ wirst du Datenbearbeitung und -visualisierung nutzen, um ein echtes datenwissenschaftliches Problem zu lösen. Du machst eine gründliche Datenanalyse und ziehst Schlussfolgerungen aus detaillierten Grafiken.

Bild aus dem Projekt

Du kannst an einem Portfolio-Projekt arbeiten, indem du ähnliche Fähigkeiten auf einen neuen Datensatz anwendest: Netflix Movie Data. Außerdem kannst du den Kurs „Exploratory Data Analysis in Python” machen, um mehr über Datenbereinigung und -validierung zu lernen, Zusammenhänge und Verteilungen zu verstehen und multivariate Beziehungen zu erkunden.

Prognoseanalyse-Projekte

15. Prognose der zukünftigen Verkäufe von Fast-Food-Menüartikeln

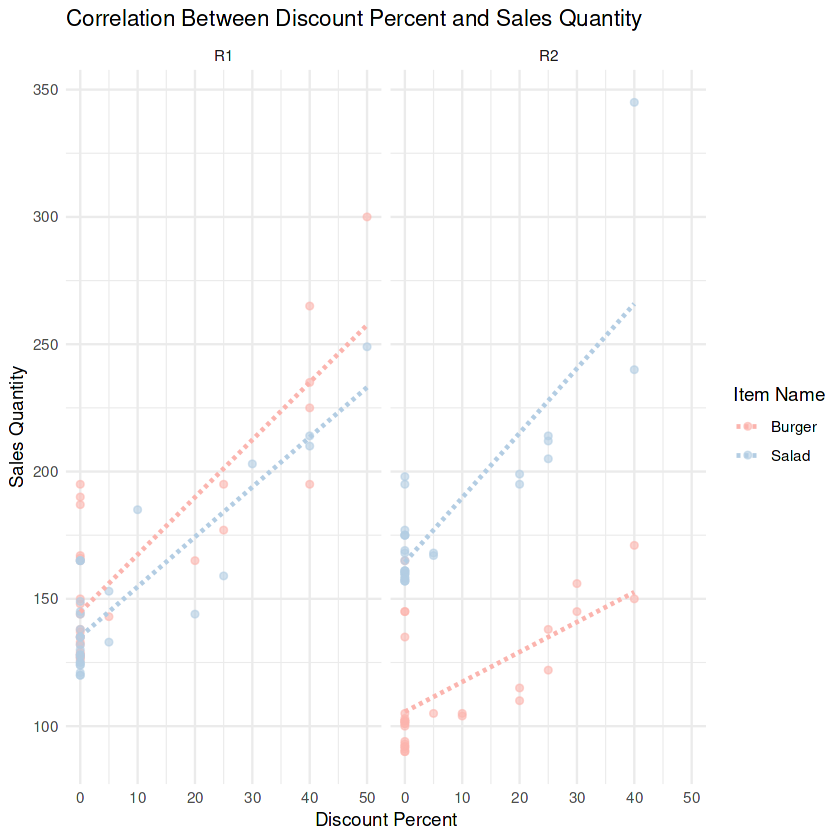

In der Projekt „Vorhersage zukünftiger Umsätze von Fast-Food-Menüartikeln” hilfst du einer Fast-Food-Kette dabei, zu hohe Ausgaben und überstürzte Bestellungen zu vermeiden, indem du ein Modell zur Umsatzprognose für die beliebtesten Menüartikel entwickelst. Du wirst das geschäftliche Problem definieren, Kalender-/Werbefunktionen entwickeln, zeitbezogene Aufteilungen erstellen, Regressionsmodelle in R anpassen und vergleichen sowie die Auswirkungen mit RMSE/MAE quantifizieren, um historische POS-Daten in genauere und kostengünstigere Bestellpläne umzuwandeln.

Bild aus dem Projekt

Du wirst Feature Engineering üben, zum Beispiel mit Wochentagen, Feiertagen und Werbeaktionen; leckagesichere Train/Test-Aufteilungen; Baseline- versus optimierte Modelle; Kreuzvalidierung; RMSE/MAE-Berichterstattung; einfaches Backtesting; und die Umwandlung von Modellergebnissen in Bestellempfehlungen.

16. Wird dieser Kunde dein Produkt kaufen?

Im Projekt „Wird dieser Kunde dein Produkt kaufen? “ analysierst du das Kaufverhalten von Kunden mithilfe von Statistik und Wahrscheinlichkeitstechniken. Mit Python bekommst du Einblicke in die Unterschiede zwischen neuen und wiederkehrenden Kunden, was Marketingteams dabei hilft, das Engagement auf E-Commerce-Plattformen besser zu verstehen.

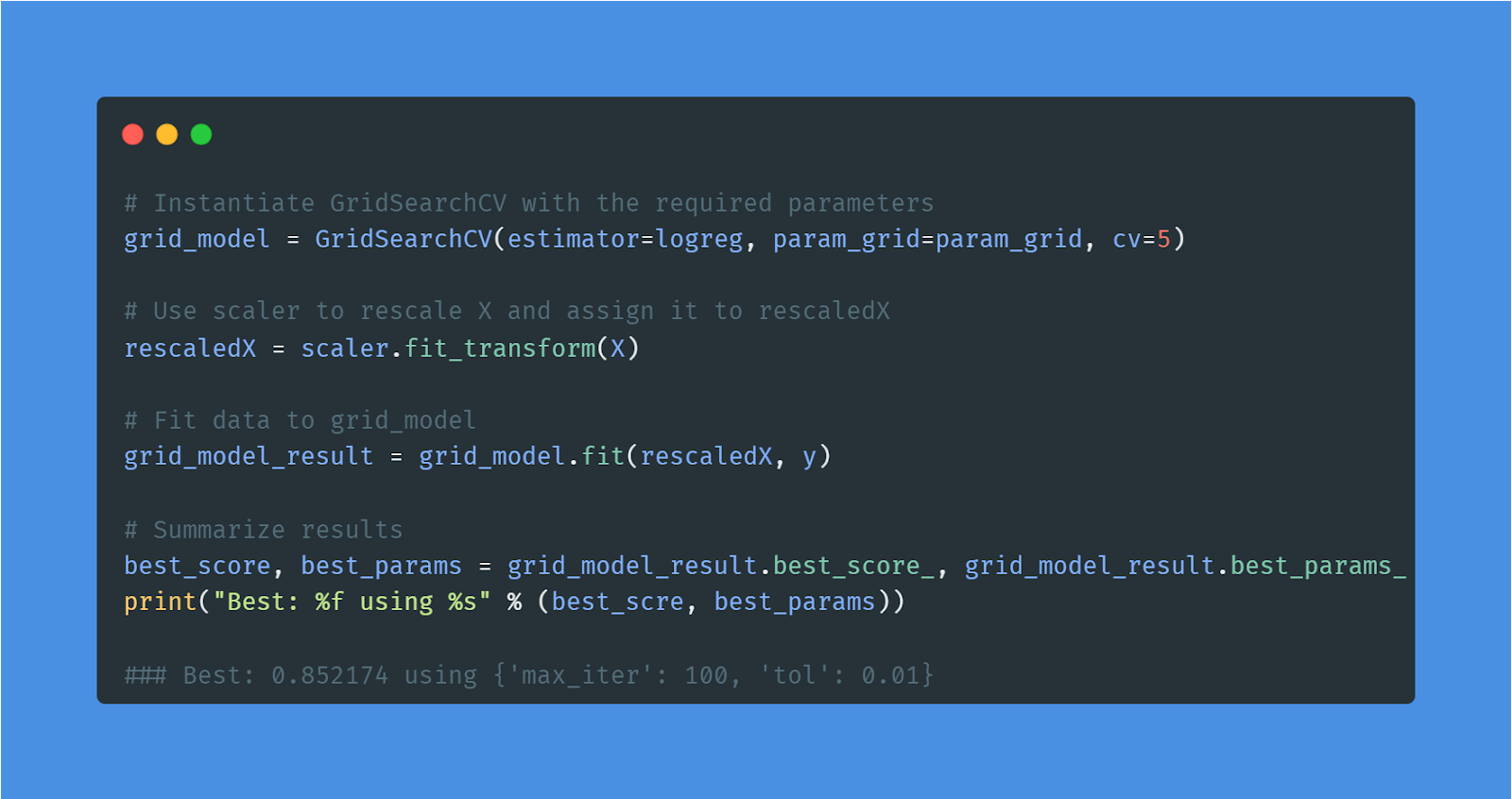

17. Vorhersage von Kreditkartenbewilligungen

Im Projekt „Vorhersage von Kreditkartenbewilligungen ” entwickelst du das leistungsstärkste Machine-Learning-Modell zur Vorhersage von Kreditkartenbewilligungen.

Zuerst wirst du die Daten verstehen und fehlende Werte ergänzen. Danach machst du die Daten fertig und trainierst ein logistisches Regressionsmodell auf dem Trainingssatz. Am Ende wirst du die Ergebnisse checken und die Modellleistung mit Hilfe von Grid-Searching verbessern.

Bild vom Autor | Code aus dem Projekt

Einfache Algorithmen für maschinelles Lernen anzuwenden, ist ein wichtiger Teil des Jobs eines Datenanalysten. Du kannst mehr Erfahrung sammeln, indem du ähnliche Methoden auf einen neuen Datensatz anwendest: Bankmarketing.

Lerne mehr über Klassifizierung, Regression, Feinabstimmung und Vorverarbeitung, indem du einen kurzen Kurs zum Thema „Überwachtes Lernen mit scikit-learn” machst.

Werde ein ML-Wissenschaftler

Datenanalyseprojekte für Studierende im letzten Studienjahr

Die Abschlussprojekte der Studenten sind meistens forschungsbasiert und brauchen mindestens 2-3 Monate, bis sie fertig sind. Du wirst an einem bestimmten Thema arbeiten und versuchen, die Ergebnisse mit verschiedenen statistischen und Wahrscheinlichkeitstechniken zu verbessern.

Anmerkung: Es gibt einen zunehmenden Trend zu Machine-Learning-Projekten für Abschlussarbeiten im Bereich Datenanalyse.

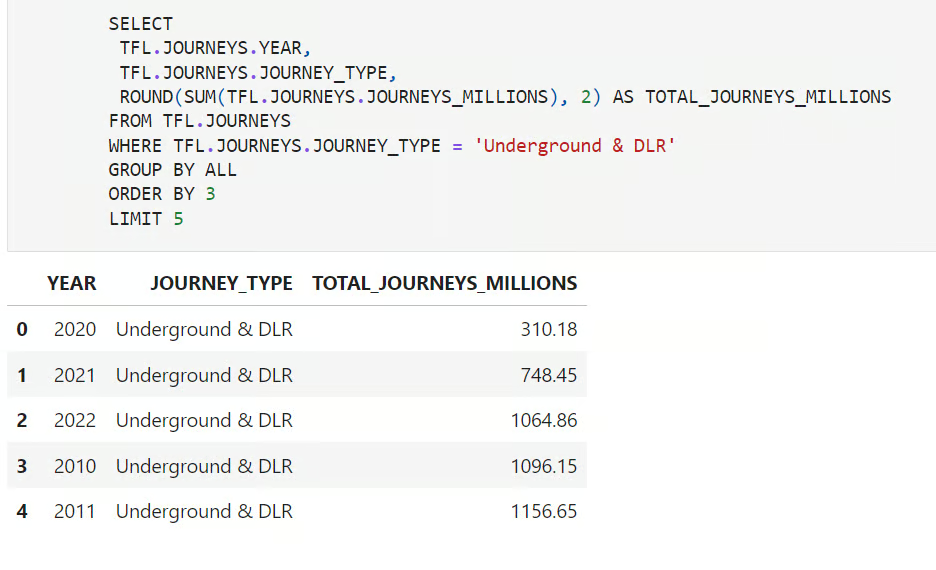

18. Entdecke Londons Verkehrsnetz

Im Projekt „Exploring London’s Travel Network“ wirst du eine Datenbank (Snowflake/Redshift/BigQuery/Databricks) mit 12 Jahren Fahrten von TfL (2010–2022) abfragen, um zu verstehen, wie sich die Londoner fortbewegen. Du wirst die beliebtesten Verkehrsmittel bewerten, Zeiten herausfinden, in denen die Londoner Seilbahn besonders voll war, und seltene Momente erkennen, in denen die U-Bahn ruhiger als sonst war. So verwandelst du reine Fahrten in Einblicke für die Betriebsplanung und Kapazitätsplanung.

Bild aus dem Projekt

Du wirst dich mit Zeitfenstern (Monat/Jahr), Fenster- und Aggregatfunktionen, bedingter Aggregation nach Modus/Zeile, dem Erkennen von Anomalien (ungewöhnlich geschäftige oder ruhige Zeiten), der Überprüfung auf Saisonalität (Veranstaltungen/Feiertage) und der Erstellung übersichtlicher KPI-Tabellen für den Transportbetrieb beschäftigen.

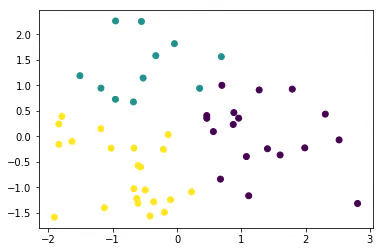

19. Weniger Verkehrstote in den USA

Für das Projekt „Reduzierung der Verkehrstoten in den USA“ findest du hier eine gute Strategie, um die Zahl der Verkehrstoten in den USA runterzubringen. Du wirst die Daten importieren, bereinigen, bearbeiten und visualisieren. Außerdem machst du Feature Engineering und probierst verschiedene Machine-Learning-Modelle aus (multivariate lineare Regression, KMeans-Clustering), um die Ergebnisse zu präsentieren und zu kommunizieren.

Bild aus dem Projekt

Wenn du mehr über unüberwachtes Lernen erfahren willst, schau dir den Kurs „Clusteranalyse in Python” an.

20. Wie man die Wirksamkeit von medizinischen Behandlungen checkt

Im Projekt „Bewertung der Wirksamkeit medizinischer Behandlungen “ schaust du dir den spannenden Fall des Simpson-Paradoxons in einer Studie zur Behandlung von Nierensteinen an. Mit R kannst du Regressionsanalysen machen, um versteckte Erkenntnisse zu finden und besser zu verstehen, wie sich die Ergebnisse bei verschiedenen Patientengruppen unterscheiden.

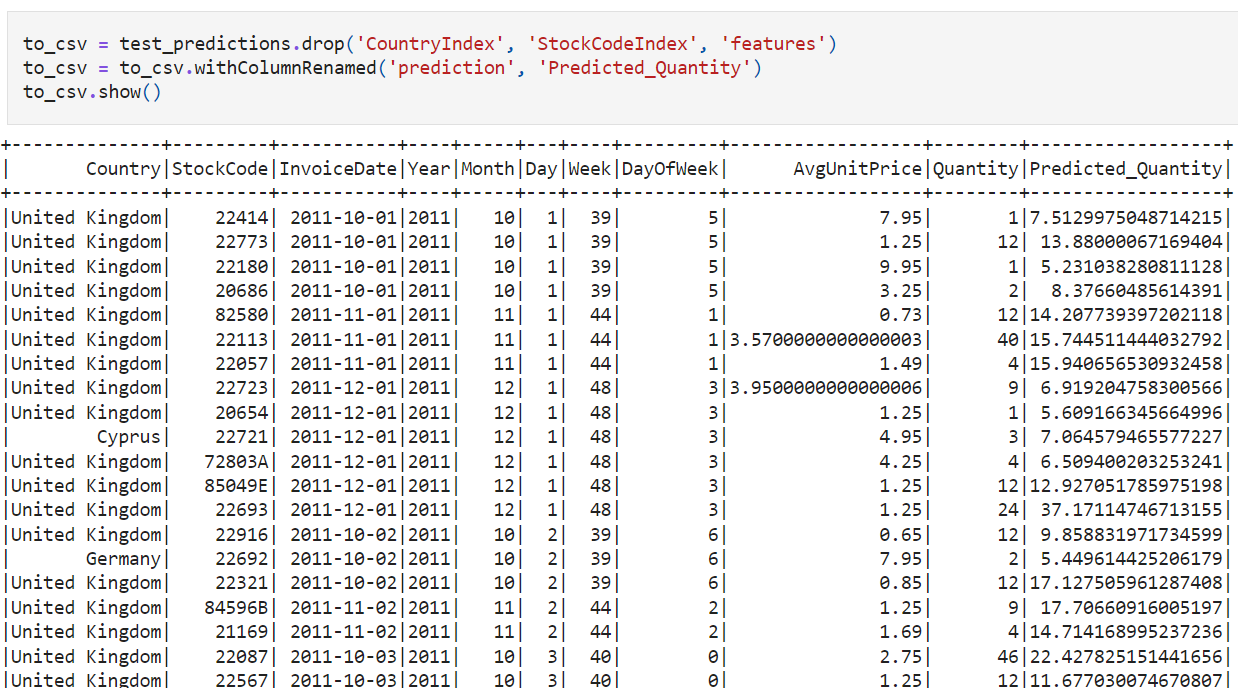

21. Ein Modell zur Nachfrageprognose erstellen

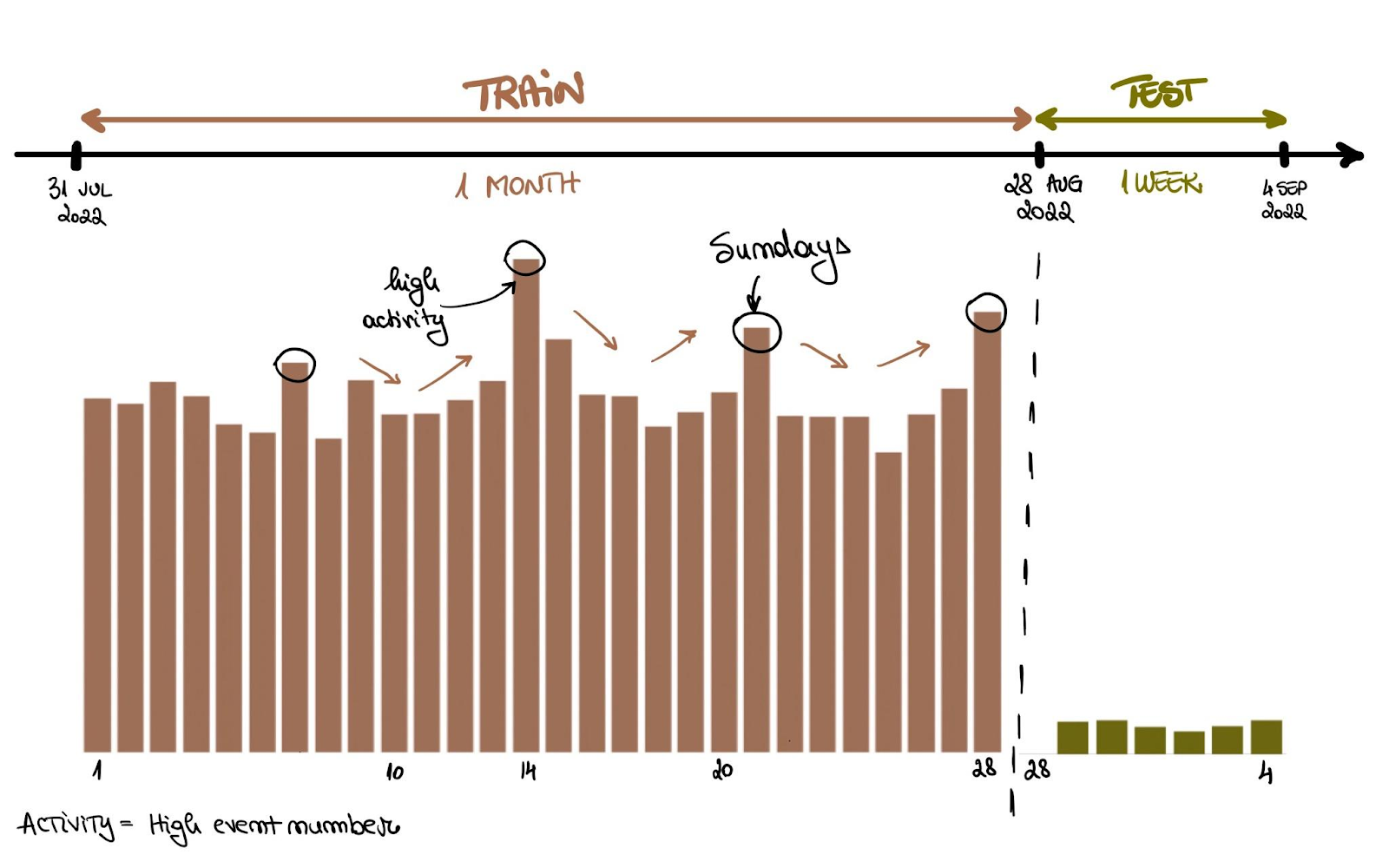

Im Projekt „Erstellen eines Bedarfsprognosemodells“ erstellen Sie mit PySpark eine Prognose für die Nachfrage nach E-Commerce-Produkten und beantworten dabei reale Fragen zur Lieferkette, wie z. B. zur Bestandsplanung und Nachschubhäufigkeit. Du entwickelst zeitliche Merkmale (Wochentag, Saisonabhängigkeit, Feiertage), erstellst zeitbewusste Validierungssplits, trainierst und vergleichst Prognosebasislinien mit ML-Modelle in großem Maßstab und führen fortlaufende Backtests durch, um die Stabilität zu messen und die Bestellhistorie in umsetzbare Einkaufspläne zu verwandeln.

Bild aus dem Projekt

Du wirst dich mit groß angelegten Feature-Engineering-Prozessen, Spark-Verbindungen/Fensteroperationen, leckagesicherer Validierung, Basis- und optimierten Modellen, RMSE/MAE-Fehleranalysen, rollierenden/blockierten Backtests und Szenarioanalysen beschäftigen, einschließlich Werbeaktionen und Saisonalitäten.

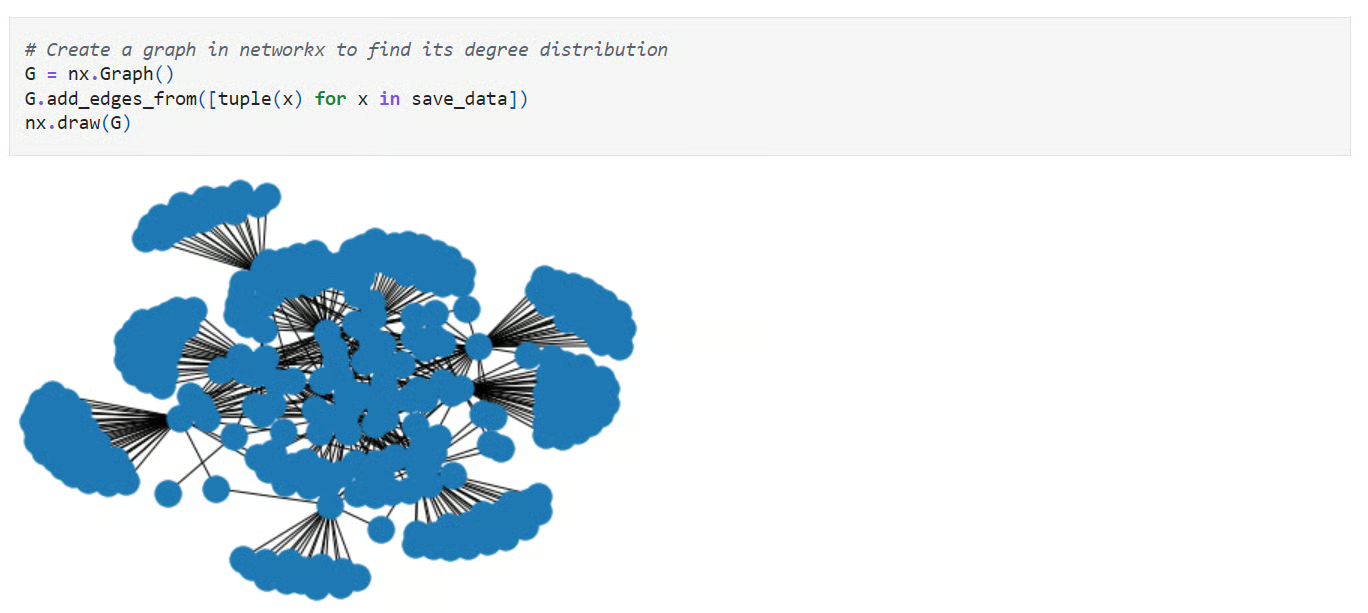

22. Soziale Netzwerke: Eine Twitter-Netzwerkanalyse

In den sozialen Netzwerken von „ “: Ein Twitter-Netzwerkanalyse-Projekt „ “, bei dem du Follower-Daten mit Pandas und NetworkX analysierst, um Influencer, Brücken und Community-Strukturen zu entdecken. Du wirst wiederverwendbare Funktionen zum Laden/Bereinigen von Kantenlisten erstellen, Graphen konstruieren, Zentralitätsmetriken (Grad, Zwischenheit, Eigenvektor) berechnen, Gemeinschaften erkennen, Ego-Netze untersuchen und die Netzwerktopologie visualisieren, um aus rohen Verbindungen klare, umsetzbare Erkenntnisse zu gewinnen.

Du lernst, wie man aus Follower-Daten Diagramme erstellt, Daten mit Pandas bereinigt, Zentralität und Communitys erkennt, einflussreiche Accounts bewertet, Ego-Netzwerke erkundet und verständliche Netzwerkvisualisierungen mit klaren Erkenntnissen erstellt.

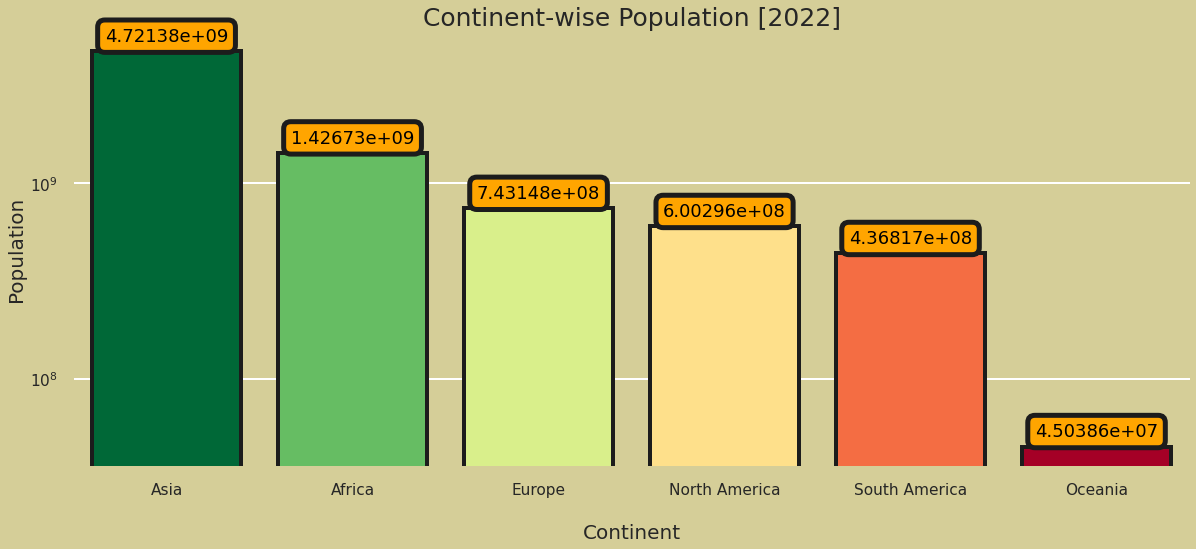

23. Analyse der Weltbevölkerung

Das Projekt „World Population Analysis“ ist das beste Beispiel für eine gründliche explorative Analyse. Du wirst verschiedene Spalten anschauen, die Länder mit der geringsten und höchsten Bevölkerungsdichte anschauen und die Bevölkerungsdichte und Wachstumsrate checken. Außerdem zeigst du die Verteilung der Länderränge und die Korrelationskarte an.

Bild aus dem Projekt

Lerne einfache Methoden zum Erstellen von Datenvisualisierungen in Python, indem du den Kurs „Datenvisualisierung für Fortgeschrittene mit Seaborn ” machst.

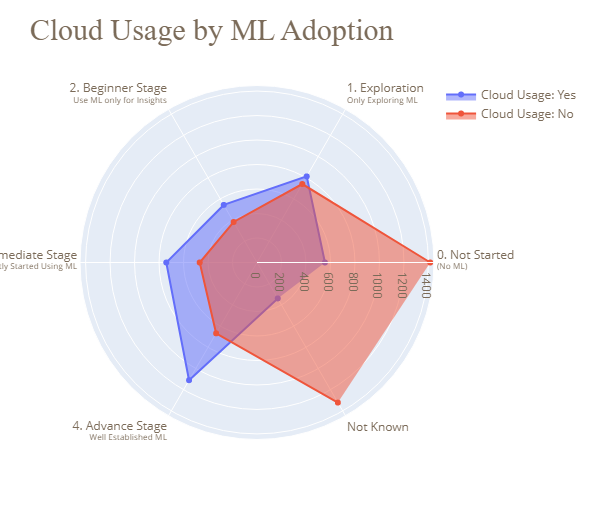

24. Die Lage von Data Science und MLOps in der Industrie

Das Projekt „Data Science and MLOps Landscape in Industry ” ist der heilige Gral für alle, die sich mit Datenbearbeitung, Visualisierungen sowie explorativen und georäumlichen Analysen beschäftigen. Du lernst, Boxplots, Donut-Diagramme, Balkendiagramme, Heatmaps, parallele kategoriale Diagramme, Blasendiagramme, Trichterdiagramme, Radardiagramme, Eiszapfen-Diagramme und Karten effektiv zu nutzen. Außerdem lernst du, verschiedene Arten von Diagrammen zu verstehen.

Bild aus dem Projekt

Mach den Kurs „Einführung in die Datenvisualisierung mit Plotly in Python“, um mehr über die erweiterten Funktionen und Anpassungsmöglichkeiten von Plotly zu erfahren.

End-to-End-Datenanalyseprojekte

End-to-End-Projekte sind super für deinen Lebenslauf und helfen dir, den Lebenszyklus von Datenanalyseprojekten besser zu verstehen.

Im Allgemeinen wirst du:

- Umgang mit mehreren Datensätzen

- Die Datenverteilung verstehen

- Datenbereinigung und -bearbeitung anwenden

- Wahrscheinlichkeits- und Statistikmethoden anwenden

- Datenanalyse und -visualisierung machen

- Einsatz von Machine-Learning-Modellen für die prädiktive Analyse

- Erstellen des Berichts oder Dashboards

25. Unicorn-Unternehmen analysieren

Im Projekt „Analyse von Einhorn-Unternehmen ” wirst du SQL nutzen, um Einhorn-Unternehmen mit einem Wert von über 1 Milliarde Dollar zu untersuchen. Du schaust dir an, welche Branchen die höchsten Bewertungen haben, und findest neue Trends, wie zum Beispiel das jährliche Wachstum neuer Einhörner zwischen 2019 und 2021.

26. Überwachung eines Modells zur Erkennung von Finanzbetrug

Im Projekt „Überwachung eines Modells zur Aufdeckung von Finanzbetrug “ bist du als Datenwissenschaftler für eine große britische Bank nach der Implementierung zuständig. Mit Python checkst du, wie gut ein Modell zur Betrugserkennung funktioniert, und schaust nach, warum es vielleicht nicht so läuft, wie es soll, um die Finanzen der Kunden zu schützen.

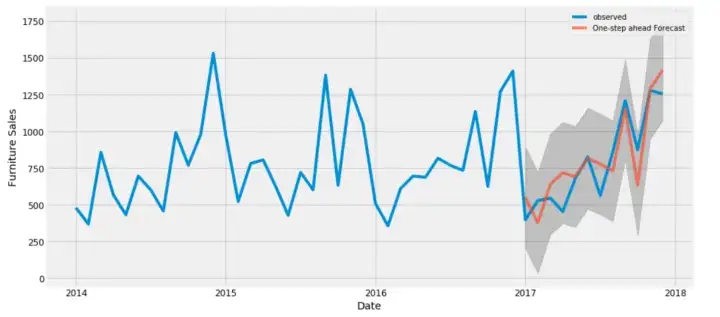

27. Ein komplettes Projekt zur Zeitreihenanalyse und -prognose mit Python

Im Projekt „Zeitreihenanalyse und Prognosen“ wirst du dich intensiv mit der Analyse von Trends beschäftigen, das ARIMA-Modell für Prognosen anwenden, die Ergebnisse vergleichen und visualisieren, um die Umsätze sowohl für Möbel als auch für Bürobedarf zu verstehen.

Projekte zur Zeitreihenanalyse und -prognose sind im Finanzsektor echt gefragt und helfen dir dabei, einen gut bezahlten Job zu finden. Du musst nur verschiedene Trends interpretieren und die Zahlen genau prognostizieren.

Bild aus dem Projekt

Wenn du Probleme mit der Analyse und Prognose hast, versuch doch mal den Kurs „ARIMA-Modelle in Python“, um mehr über ARMA-Modelle, die Anpassung an die Zukunft, die Auswahl der besten Modelle und das Training saisonaler ARIMA-Modelle zu lernen.

28. Ein Empfehlungssystem mit mehreren Zielen entwickeln

Das Ziel des Projekts „Aufbau eines Empfehlungssystems mit mehreren Zielen “ ist es, Klicks, Warenkorb-Hinzufügungen und Bestellungen im E-Commerce vorherzusagen. Kurz gesagt, du wirst ein Empfehlungssystem mit mehreren Zielen erstellen, das auf früheren Ereignissen in einer Benutzersitzung basiert.

Wenn du das Projekt fertig hast, wirst du Folgendes draufhaben:

- Datenbearbeitung und -analyse

- Sitzungen und Ereignisse verstehen

- Datenvisualisierung und Berichterstellung

- Umgang mit Zeitreihendaten

- Analysiere Zeitreihendaten, um das Nutzerverhalten zu checken.

- Vorhersage der Top-Klicks, Warenkörbe und Bestellungen

Bild aus dem Projekt

Unterstütze das Wachstum deines Teams mit DataCamp for Business

Auch wenn einzelne Projekte super wichtig für die persönliche Weiterentwicklung sind, müssen Unternehmen auch dafür sorgen, dass ihre Teams gut gerüstet sind, um mit den Herausforderungen der Datenanalyse klarzukommen. DataCamp for Business hat maßgeschneiderte Lösungen, die Firmen dabei helfen, ihre Leute in Sachen Datenwissenschaft, Analytik und maschinelles Lernen weiterzubilden. Mit einer riesigen Auswahl an interaktiven Kursen, individuellen Lernpfaden und realen Projekten können Teams ihre Fähigkeiten in den Bereichen Datenerfassung, -bereinigung, -visualisierung und prädiktive Analytik verbessern – alles wichtige Themen, die in diesem Blog behandelt werden.

Egal, ob du ein kleines Start-up oder ein großes Unternehmen bist, DataCamp for Business bietet dir die Tools, um deine Fähigkeiten zu verbessern, dich neu zu qualifizieren und eine datengesteuerte Kultur zu schaffen, damit du auf dem heutigen Markt wettbewerbsfähig bleibst. Du kannst noch heute eine Demo anfordern, um mehr zu erfahren.

Fazit

Nachdem du die wichtigsten Fähigkeiten gelernt hast, musst du ein starkes Portfolio aufbauen, um dein Wissen zu zeigen. Außerdem lernst du neue Tools, Funktionen und Konzepte kennen, die dir in deinem Berufsleben helfen werden.

In diesem Beitrag haben wir uns mit Projekten für Anfänger, fortgeschrittenen Projekten, Abschlussprojekten von Studenten und End-to-End-Datenanalyseprojekten beschäftigt. Außerdem haben wir Projekte zu Datenerfassung und -bereinigung, Probabilistik & Statistik, Datenbearbeitung und -visualisierung sowie explorativer Datenanalyse und prädiktiver Analyse gemacht.

Also, was kommt als Nächstes? Wenn du mindestens 12 Projekte gemacht hast, versuch doch mal, dich als professioneller Datenanalyst zertifizieren zu lassen. Das erhöht deine Chancen, eingestellt zu werden. Du kannst dir auch unseren Beitrag darüber anschauen, wie man Datenanalyst wird, um weitere Karrieretipps zu bekommen.

Werde ein ML-Wissenschaftler

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.