Cursus

Le domaine de la science des données connaît une croissance rapide, et de nombreux outils sont disponibles pour assister les scientifiques des données dans leur travail. Dans cet article, nous aborderons les 10 meilleurs outils de science des données que vous pourrez utiliser en 2026. Ces outils vous aideront à ingérer, nettoyer, traiter, analyser, visualiser et modéliser les données. De plus, certains outils proposent également des écosystèmes d'apprentissage automatique pour le suivi, le développement, le déploiement et la surveillance des modèles.

Le rôle des outils de science des données

Les outils de science des données sont essentiels pour aider les scientifiques et les analystes de données à extraire des informations précieuses à partir des données. Ces outils sont utiles pour le nettoyage, la manipulation, la visualisation et la modélisation des données.

Avec l'arrivée de chatGPT, de plus en plus d'outils sont intégrés aux modèles GPT-3.5 et GPT-4. L'intégration d'outils basés sur l'intelligence artificielle facilite encore davantage l'analyse des données et la création de modèles par les scientifiques des données.

Par exemple, les capacités d'IA générative (PandasAI) ont été intégrées à des outils plus simples tels que pandas, permettant aux utilisateurs d'obtenir des résultats en rédigeant des invites en langage naturel. Cependant, ces nouveaux outils ne sont pas encore largement utilisés par les professionnels des données.

De plus, les outils de science des données ne se limitent pas à remplir une seule fonction. Ils offrent des fonctionnalités supplémentaires pour effectuer des tâches avancées et, dans certains cas, apportent des compétences en science des données à l'écosystème. Par exemple, MLFlow est principalement utilisé pour le suivi des modèles. Cependant, il peut également être utilisé pour l'enregistrement, le déploiement et l'inférence de modèles.

Critères de sélection des outils de science des données

La liste des 10 meilleurs outils est établie en fonction des caractéristiques clés suivantes :

- Popularité et adoption: Les outils bénéficiant d'une large base d'utilisateurs et du soutien de la communauté disposent de ressources et d'une documentation plus importantes. Les outils open source populaires bénéficient d'améliorations continues.

- Facilité d'utilisation: Des flux de travail intuitifs, sans codage complexe, permettent un prototypage et une analyse plus rapides.

- Évolutivité: La capacité à traiter des ensembles de données volumineux et complexes.

- Capacités de bout en bout: Outils qui prennent en charge diverses tâches telles que la préparation des données, la visualisation, la modélisation, le déploiement et l'inférence.

- Connectivité des données: Flexibilité pour se connecter à diverses sources et formats de données tels que les bases de données SQL, nosql, les API, les données non structurées, etc.

- Interopérabilité: S'intègre parfaitement avec d'autres outils.

Examen complet des principaux outils de science des données pour 2026

Dans cette analyse, nous examinerons les outils nouveaux et établis qui sont devenus indispensables pour les scientifiques des données dans leur environnement professionnel. Ces outils partagent plusieurs caractéristiques communes : ils sont facilement accessibles, conviviaux et offrent des fonctionnalités robustes pour l'analyse des données et l'apprentissage automatique.

Outils Python pour la science des données

Python est largement utilisé pour l'analyse et le traitement des données, ainsi que pour l'apprentissage automatique. Sa simplicité et sa vaste communauté de développeurs en font un choix très apprécié.

1. pandas

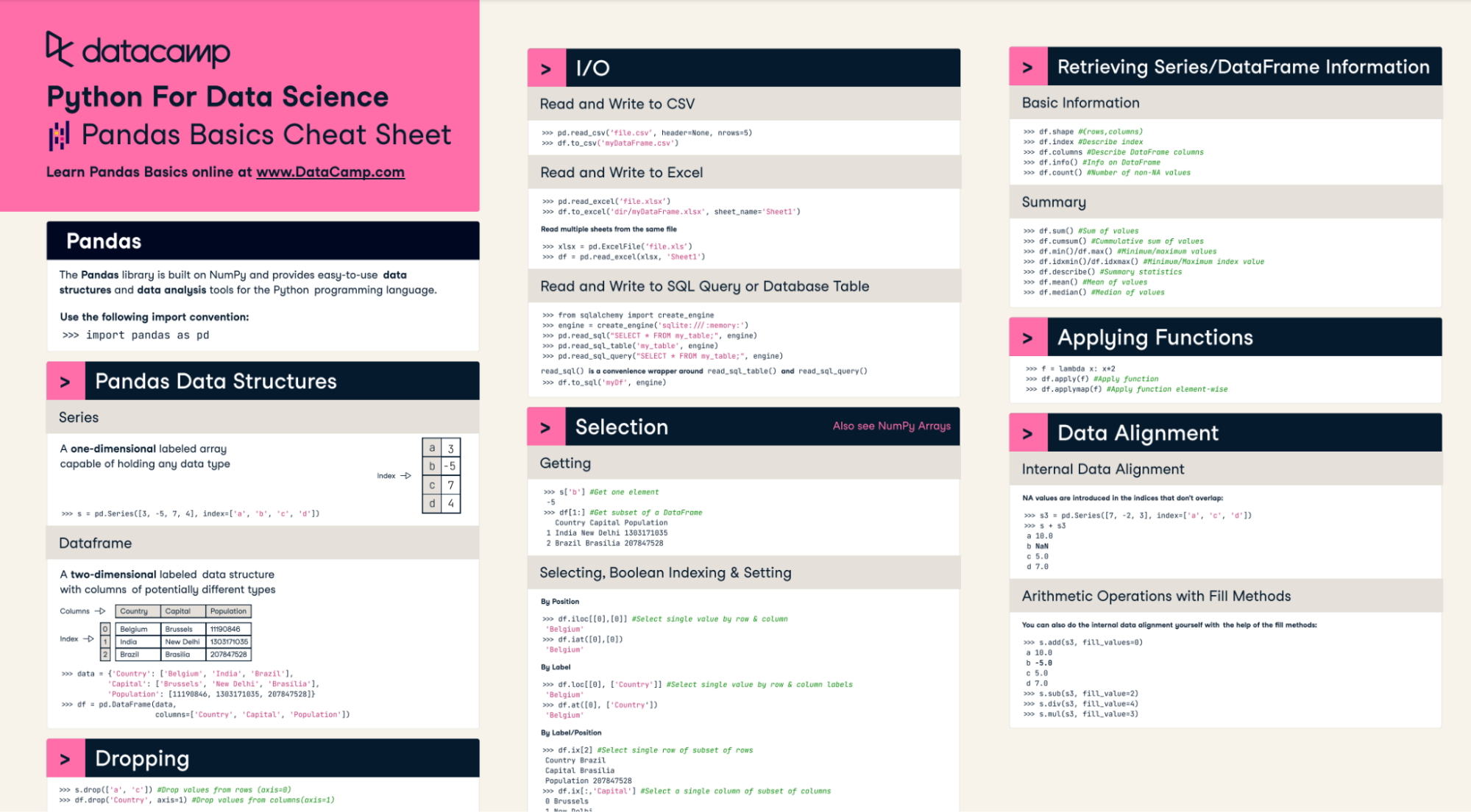

pandas facilite le nettoyage, la manipulation, l'analyse et l'ingénierie des fonctionnalités des données dans Python. Il s'agit de la bibliothèque la plus utilisée par les professionnels des données pour toutes sortes de tâches. Vous pouvez désormais l'utiliser également pour la visualisation de données.

Notre aide-mémoire sur les pandas peut vous aider à maîtriser cet outil de science des données.

2. Seaborn

Seaborn est une bibliothèque puissante de visualisation de données qui s'appuie sur Matplotlib. Il est fourni avec une gamme de thèmes par défaut esthétiques et bien conçus, et s'avère particulièrement utile lorsque l'on travaille avec des DataFrame pandas. Avec Seaborn, vous pouvez créer rapidement et facilement des visualisations claires et expressives.

3. Scikit-learn

Scikit-learn est la bibliothèque Python incontournable pour l'apprentissage automatique. Cette bibliothèque fournit une interface cohérente pour les algorithmes courants, notamment la régression, la classification, le regroupement et la réduction de dimensionnalité. Il est optimisé pour la performance et largement utilisé par les scientifiques des données.

Outils open source pour la science des données

Les projets open source ont joué un rôle déterminant dans l'avancement du domaine de la science des données. Ils fournissent une multitude d'outils et de ressources qui peuvent aider les scientifiques des données à travailler de manière plus efficace et efficiente.

4. Carnets Jupyter

Jupyter Notebooks est une application web open source très appréciée qui permet aux scientifiques des données de créer des documents partageables combinant du code en direct, des visualisations, des équations et des explications textuelles. Idéal pour l'analyse exploratoire, la collaboration et la création de rapports.

5. Pytorch

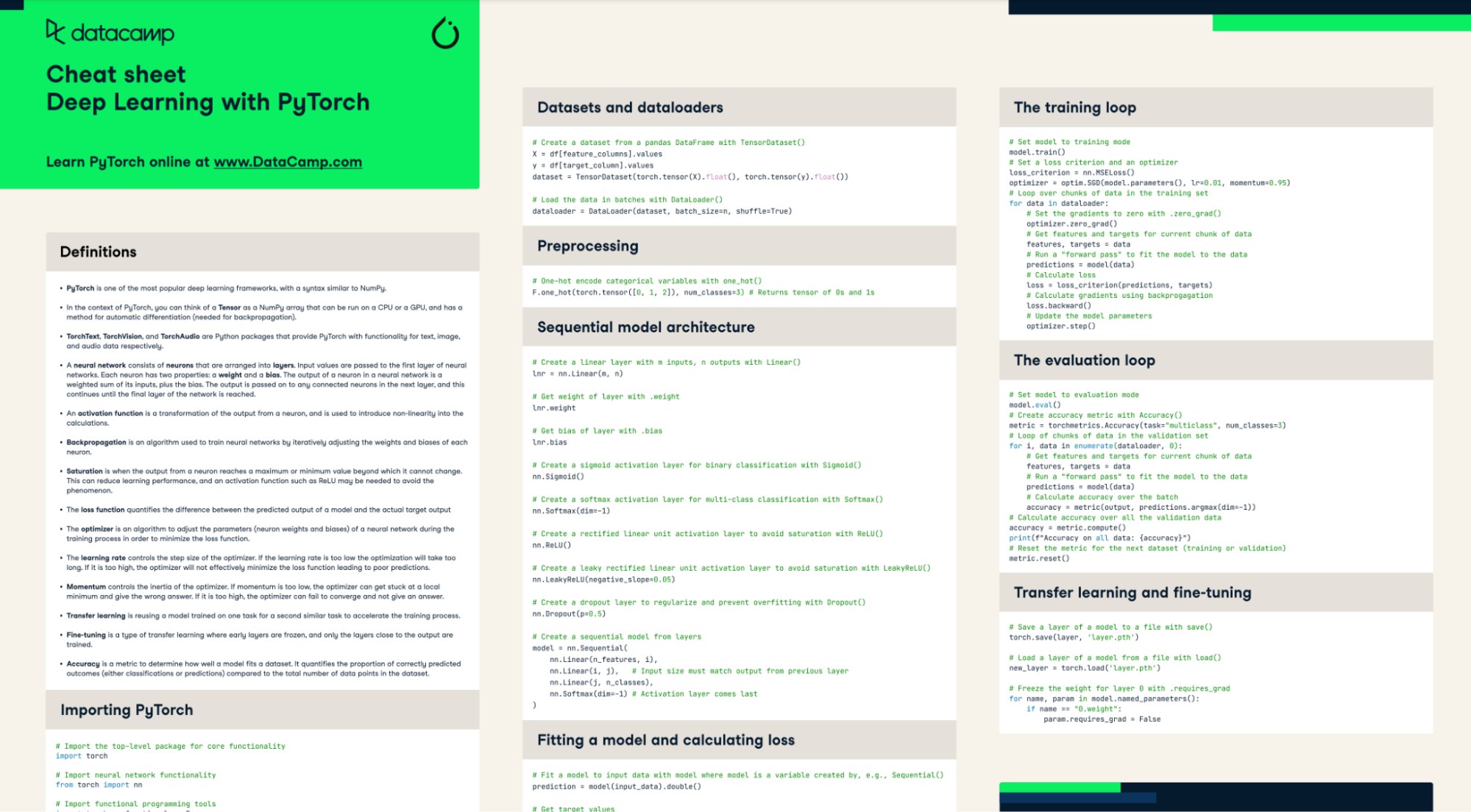

Pytorch est un framework d'apprentissage automatique open source très flexible, largement utilisé pour le développement de modèles de réseaux neuronaux. Il offre une grande modularité et un vaste écosystème d'outils permettant de traiter divers types de données, telles que les données textuelles, audio, visuelles et tabulaires. Grâce à la prise en charge des GPU et des TPU, vous pouvez accélérer la formation de vos modèles jusqu'à 10 fois.

Maîtrisez Pytorch grâce à notre aide-mémoire pratique

6. MLFlow

MLFlow est une plateforme open source développée par Databricks pour gérer le cycle de vie complet du machine learning. Il assure le suivi des expériences, des modèles de paquets et du déploiement en production tout en garantissant la reproductibilité. Il est également compatible avec le suivi des LLM et prend en charge à la fois l'interface de ligne de commande et l'interface utilisateur graphique. Il fournit également des API pour Python, Java, R et Rest.

7. Hugging Face

Hugging Face est devenu une solution unique pour le développement open source dans le domaine de l'apprentissage automatique. Il offre un accès simplifié aux ensembles de données, aux modèles de pointe et à l'inférence, ce qui facilite la formation, l'évaluation et le déploiement de vos modèles à l'aide de divers outils de l'écosystème Hugging Face. De plus, il permet d'accéder à des processeurs graphiques haut de gamme et à des solutions d'entreprise. Que vous soyez étudiant, chercheur ou professionnel dans le domaine de l'apprentissage automatique, cette plateforme est la seule dont vous avez besoin pour développer des solutions de premier ordre pour vos projets.

Outils propriétaires de science des données

Des plateformes propriétaires robustes offrent des fonctionnalités adaptées aux entreprises, une configuration en un clic et une grande facilité d'utilisation. Ils assurent également le soutien et la sécurité de vos données.

8. Tableau

Tableau est un leader dans le domaine des logiciels de veille économique. Il permet des visualisations de données et des tableaux de bord interactifs intuitifs qui révèlent des informations à partir de données à grande échelle. Avec Tableau, les utilisateurs peuvent se connecter à une grande variété de sources de données, nettoyer et préparer les données pour l'analyse, puis générer des visualisations riches telles que des tableaux, des graphiques et des cartes. Le logiciel est conçu pour être facile à utiliser, permettant aux utilisateurs non techniciens de créer des rapports et des tableaux de bord par simple glisser-déposer.

9. RapidMiner

RapidMiner est une plateforme d'analyse avancée de bout en bout permettant de créer des pipelines de données et d'apprentissage automatique, qui propose un concepteur de flux de travail visuel pour rationaliser le processus. De la préparation des données au déploiement du modèle, RapidMiner fournit tous les outils nécessaires pour gérer chaque étape du flux de travail ML. Le concepteur visuel de flux de travail au cœur de RapidMiner permet aux utilisateurs de créer facilement des pipelines, sans avoir à écrire de code.

Outils d'intelligence artificielle

Au cours de l'année dernière, les outils d'intelligence artificielle sont devenus indispensables pour l'analyse des données. Ils sont utilisés pour la génération de code, la validation, la compréhension des résultats, la génération de rapports, et bien plus encore.

10. ChatGPT

chatGPT est un outil alimenté par l'intelligence artificielle qui peut vous assister dans diverses tâches liées à la science des données. Il permet de générer du code Python et de l'exécuter, et peut également générer des rapports d'analyse complets. Cependant, ce n'est pas tout. chatGPT est équipé d'une variété de plugins qui peuvent être très utiles pour la recherche, l'expérimentation, les mathématiques, les statistiques, l'automatisation et la révision de documents. Parmi les fonctionnalités les plus remarquables, citons DALLE-3 (génération d'images), le navigateur avec Bing et chatGPT Vision (reconnaissance d'images).

Vous pouvez consulter le Guide d'utilisation de chatGPT pour les projets de science des données afin d'apprendre à utiliser chatGPT et à créer des projets de science des données de bout en bout.

Projets pratiques et ressources

Vous recherchez des moyens d'appliquer ces outils de données à des ensembles de données réels ? DataCamp est là pour vous aider. Ils proposent des projets guidés et non guidés qui peuvent être chargés sur un ordinateur portable alimenté par l'IA appelé DataLab, vous permettant de commencer immédiatement à travailler sur un projet. La liste des projets de DataCamp est exhaustive et couvre un large éventail de sujets, notamment le traitement des données, l'apprentissage automatique, l'ingénierie des données, les MLOps, les LLM, le NLP, et bien d'autres encore.

Voici les liens vers d'autres projets qui vous aideront à appliquer des outils de pointe à votre ensemble de données :

- Sept projets d'intelligence artificielle passionnants pour les apprenants débutants, intermédiaires et avancés

- Cinq projets réalisés à l'aide de modèles génératifs et d'outils open source

- Plus de 60 projets Python pour tous les niveaux d'expertise

- 6 projets Tableau pour vous aider à développer vos compétences

- 10 projets SQL prêts à être intégrés à votre portfolio, pour tous les niveaux

- 20 projets d'analyse de données pour tous les niveaux

- 25 projets d'apprentissage automatique pour tous les niveaux

Conclusion

Des développements passionnants ont lieu dans le domaine dynamique de la science des données, où l'innovation est la norme. Cet article de blog présente un aperçu complet des 10 principaux outils de science des données qui gagnent en popularité et devraient connaître une adoption croissante en 2026.

Les bibliothèques basées sur Python telles que Pandas, Seaborn et Scikit-learn offrent des fonctionnalités robustes pour la préparation, l'analyse, la visualisation et la modélisation des données. Les plateformes open source telles que MLflow, Pytorch et Hugging Face accélèrent l'expérimentation, le développement et le déploiement. Des solutions propriétaires telles que Tableau et RapidMiner permettent une intelligence économique à l'échelle de l'entreprise et une gestion complète du cycle de vie de l'apprentissage automatique. De nouveaux assistants IA tels que chatGPT génèrent du code et des informations, ce qui améliore la productivité.

Si vous souhaitez devenir un data scientist compétent et acquérir une expertise dans l'utilisation de ces outils, nous vous recommandons de vous inscrire au cursus Data Scientist avec Python. Ce programme vous permettra d'acquérir les compétences essentielles requises pour exceller en tant que data scientist, de la manipulation des données à l'apprentissage automatique.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.