Kurs

Wenn du nie wieder mit inkonsistenten, doppelten Daten rumschnüffeln willst, ist Datenbank-Normalisierung genau das Richtige für dich.

Du kennst das frustrierende Gefühl, wenn du Kundendaten in einer Tabelle aktualisierst und dann feststellst, dass veraltete Versionen in fünf anderen Tabellen verstreut sind. Deine Abfragen liefern widersprüchliche Ergebnisse, deine Berichte zeigen unterschiedliche Zahlen, je nachdem, aus welcher Tabelle du sie ziehst, und du verbringst Stunden damit, Datenintegritätsprobleme zu beheben, die gar nicht existieren sollten. Diese Probleme werden mit zunehmender Größe deiner Datenbank immer größer.

Die Datenbank-Normalisierung macht Schluss mit solchen Problemen, indem sie deine Daten nach bewährten mathematischen Prinzipien organisiert. Der Prozess nutzt Normalformen, um sicherzustellen, dass jede Information genau an einem Ort gespeichert ist, wodurch deine Datenbank zuverlässig und effizient bleibt.

Ich zeige dir den kompletten Normalisierungsprozess, von den Grundlagen bis hin zu fortgeschrittenen Normalformen, mit praktischen Beispielen, die unübersichtliche Daten in übersichtliche, pflegbare Datenbankstrukturen verwandeln.

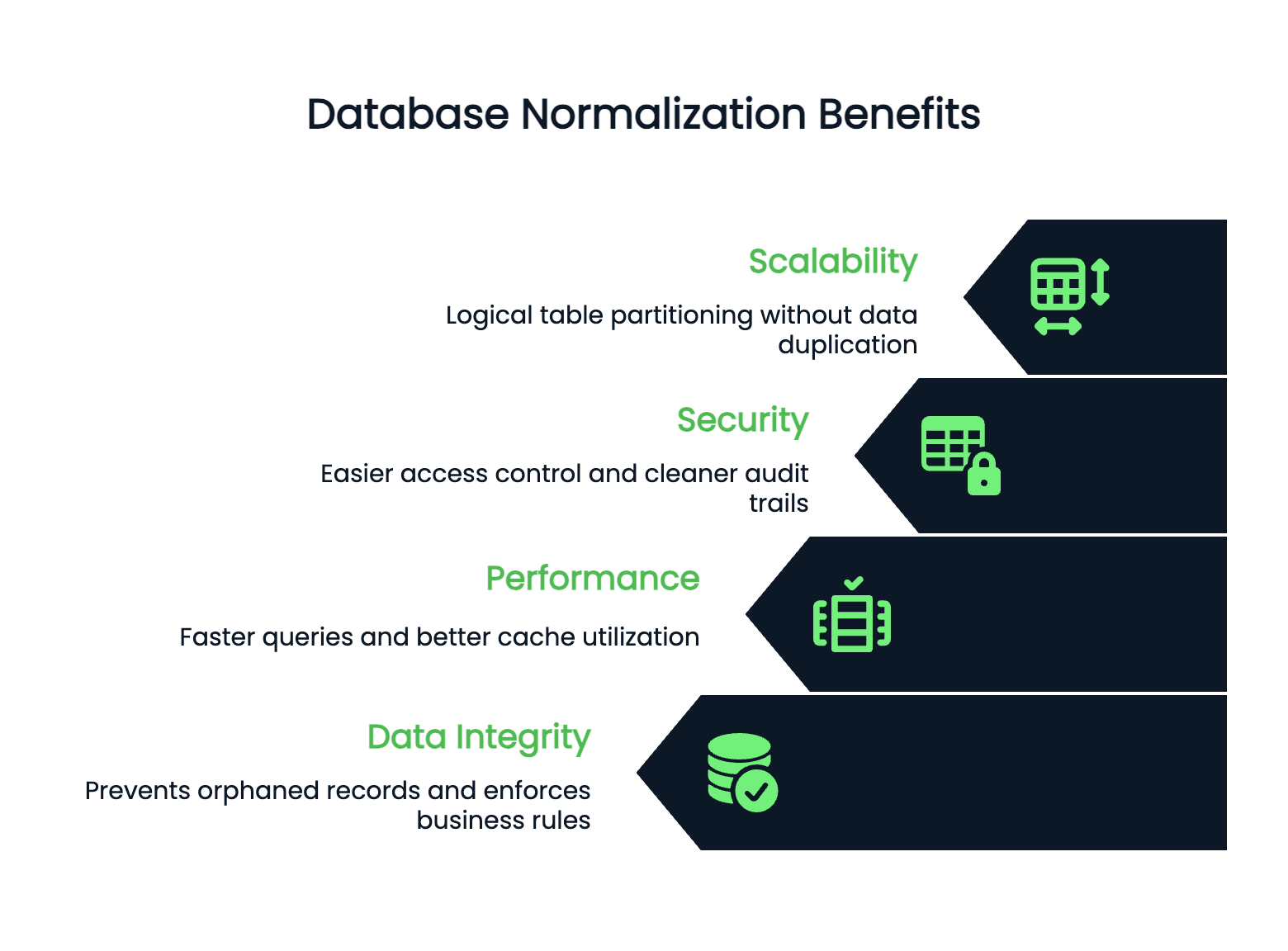

Warum ist Normalisierung wichtig?

Normalisierung verhindert, dass deine Datenbank zu einem Wartungsalbtraum wird. Schauen wir mal, warum die richtige Normalisierung für echte Anwendungen wichtig ist.

Datenredundanz

Redundanz ist der heimliche Feind der Datenbankleistung. Wenn du dieselben Infos an mehreren Orten speicherst, verschwendest du nicht nur Speicherplatz, sondern riskierst auch, dass deine App-Logik durch Inkonsistenzen durcheinandergerät.

Ohne Normalisierung musst du für die Aktualisierung der Adresse eines Kunden alle Tabellen durchsuchen, in denen Adressdaten gespeichert sind. Wenn du eins vergisst, zeigen deine Berichte widersprüchliche Infos. Deine Benutzer sehen auf verschiedenen Bildschirmen unterschiedliche Adressen. Deine Analysen werden unzuverlässig.

Die Normalisierung behebt das, indem sie sicherstellt, dass jedes Datenelement genau an einem Ort gespeichert wird. Wenn du die Adresse des Kunden aktualisierst, wird sie automatisch überall geändert, weil alles auf dieselbe Quelle verweist.

Datenintegrität

Integrität wird unverwüstlich, wenn du sie richtig normalisierst. Fremdschlüsselbeschränkungen verhindern verwaiste Datensätze. Du kannst keinen Kunden löschen, der noch aktive Bestellungen hat. Deine Datenbank hält sich an die Geschäftsregeln auf Datenebene, nicht nur im Anwendungscode.

Das heißt weniger Fehler, sauberer Code und Programme, die auch dann wie erwartet funktionieren, wenn mehrere Systeme auf dieselben Daten zugreifen.

Datenanomalien

Änderungsanomalien verschwinden bei korrekter Normalisierung. Das passiert, wenn du Daten einfügst, aktualisierst oder löschst und dabei Inkonsistenzen verursachst oder komplizierte Workarounds erforderlich machst.

Durch Einfügefehler musst du Dummy-Daten hinzufügen, nur um einen Datensatz zu erstellen. Bei Aktualisierungsanomalien musst du dieselben Infos in mehreren Zeilen ändern. Beim Löschen von Anomalien werden mehr Infos gelöscht als beabsichtigt, wenn du einen einzelnen Datensatz löschst.

Normalisierte Datenbanken machen Schluss mit diesen Problemen, indem sie die Daten so organisieren, dass jede Info nur einmal vorkommt.

Leistung und Skalierbarkeit

Die Leistung und Skalierbarkeit werden besser, wenn deine Datenbankstruktur übersichtlich ist. Normalisierte Tabellen sind normalerweise kleiner, was schnellere Abfragen und eine bessere Cache-Nutzung bedeutet. Indizes funktionieren besser bei kleineren, fokussierten Tabellen.

Deine Datenbank kann horizontal skaliert werden, weil normalisierte Daten klare Grenzen haben. Du kannst Tabellen logisch partitionieren, ohne Infos über Shards zu duplizieren.

Sicherheit

In normalisierten Datenbanken ist die Sicherheit einfacher zu verwalten. Du kannst den Zugriff auf Tabellen sicher regeln, weil sensible Daten an bestimmten, klar definierten Orten gespeichert sind. Du musst dir keine Sorgen machen, dass Kreditkartennummern von Kunden in unerwarteten Tabellen versteckt sind.

Auch die Audit-Trails sind übersichtlicher – du weißt immer genau, wo Änderungen vorgenommen wurden, und kannst sie auf einem Lernpfad verfolgen, ohne dich durch überflüssige Daten in deinem Schema wühlen zu müssen.

Kurz gesagt, die Normalisierung macht aus chaotischen Daten eine zuverlässige Basis, die mit deiner Anwendung mitwächst.

Schauen wir mal, was man für die Normalisierung braucht.

Wichtige Begriffe und Voraussetzungen

Bevor du mit der Normalisierung von Tabellen anfängst, solltest du wissen, wie das Ganze funktioniert. Lass uns die wichtigsten Sachen durchgehen, die dir bei deinen Entscheidungen helfen werden.

Schlüssel in der Datenbanknormalisierung verstehen

Schlüssel sind das A und O beim Entwerfen relationaler Datenbanken – sie identifizieren Datensätze und verbinden Tabellen miteinander.

Ein Primärschlüssel t ein eindeutiges ID für jede Zeile in einer Tabelle. Keine zwei Zeilen dürfen denselben Primärschlüsselwert haben, und dieser darf nicht null sein. Stell dir das wie eine Sozialversicherungsnummer für deine Daten vor – jeder Datensatz hat genau eine, und es gibt keine Duplikate.

CREATE TABLE customers (

customer_id INT PRIMARY KEY,

email VARCHAR(255),

name VARCHAR(100)

);Hier ist „ customer_id “ der Primärschlüssel. Jeder Kunde bekommt eine eindeutige ID, die du verwenden kannst, um diesen bestimmten Kunden in anderen Tabellen zu finden.

Ein Kandidatenschlüssel ist eine Spalte (oder eine Kombination von Spalten), die als Primärschlüssel dienen könnte. Deine Tabelle „ customers “ könnte sowohl „ customer_id “ als auch „ email “ als Kandidatenschlüssel haben, da beide Kunden eindeutig identifizieren. Du wählst eins als Primärschlüssel aus, und die anderen bleiben Kandidatenschlüssel.

Fremdschlüssel verbinden Tabellen miteinander. Sie verweisen auf den Primärschlüssel einer anderen Tabelle und stellen Verbindungen her, die die Datenintegrität aufrechterhalten.

CREATE TABLE orders (

order_id INT PRIMARY KEY,

customer_id INT,

order_date DATE,

FOREIGN KEY (customer_id) REFERENCES customers(customer_id)

);Der Feld „ customer_id “ in der Tabelle „ orders “ ist ein Fremdschlüssel. Sie muss mit einem „ customer_id ” übereinstimmen, der in der Tabelle „ customers ” vorhanden ist. Das verhindert, dass Bestellungen verloren gehen, und stellt sicher, dass jede Bestellung zu einem echten Kunden gehört.

Schlüssel sorgen dafür, dass Geschäftsregeln auf Datenbankebene eingehalten werden, was deine Daten zuverlässiger macht als eine Validierung nur auf Anwendungsebene.

Die Rolle funktionaler Abhängigkeiten

Funktionale Abhängigkeiten zeigen, wie Spalten in einer Tabelle miteinander verbunden sind. Sie sind die mathematische Grundlage, die Normalisierungsentscheidungen vorantreibt.

Eine funktionale Abhängigkeit ist da, wenn der Wert einer Spalte den Wert einer anderen Spalte bestimmt. Wir schreiben das als „ A → B ”, was so viel heißt wie „A bestimmt B” oder „B hängt von A ab”.

customer_id → email In einer Tabelle „ customers “ heißt die Tabelle „customer_email“, weil jede Kunden-ID genau einer E-Mail-Adresse zugeordnet ist. Wenn du die Kunden-ID kennst, kannst du die E-Mail ganz sicher finden.

Bild 1 – Beispiel für funktionale Abhängigkeit

Hier sind „ customer_id → email “ und „ customer_id → name “, weil die Kunden-ID sowohl die E-Mail-Adresse als auch den Namen bestimmt.

Funktionale Abhängigkeiten zeigen, wo es Probleme mit Redundanz gibt.

Wenn du eine Tabelle hast, in der „ order_id → customer_name ” steht, du aber den Kundennamen in jeder Bestellzeile speicherst, hast du Redundanz. Der Name des Kunden hängt von seiner ID ab, nicht von der Bestellnummer.

Mit der Abhängigkeitserhaltungs, bleiben in deinen normalisierten Tabellen alle ursprünglichen funktionalen Abhängigkeiten erhalten. Wenn du eine Tabelle während der Normalisierung aufteilst, solltest du nicht die Möglichkeit verlieren, die in der ursprünglichen Tabelle vorhandenen Geschäftsregeln durchzusetzen.

Die verlustfreie Zerlegungs garantiert, dass du die ursprüngliche Tabelle durch Zusammenführen der normalisierten Tabellen wiederherstellen kannst. Beim Teilen von Tabellen gehen keine Infos verloren – die Verknüpfungen bringen genau die Daten zurück, mit denen du angefangen hast.

Diese Konzepte hängen zusammen: Funktionale Abhängigkeiten zeigen, was getrennt werden muss, während die Erhaltung von Abhängigkeiten und die verlustfreie Zerlegung dafür sorgen, dass dabei nichts kaputt geht.

Wenn du diese Zusammenhänge verstehst, kannst du kluge Entscheidungen zur Normalisierung treffen, die deine Datenbank verbessern, ohne dass dabei Funktionen verloren gehen.

Schritt für Schritt zur Normalisierung

Lass uns jetzt den eigentlichen Normalisierungsprozess durchgehen, beginnend mit unordentlichen Daten, die wir Schritt für Schritt umwandeln. Jede Normalform baut auf der vorherigen auf, sodass du nicht direkt von unnormalisierten Daten zur 3NF springen kannst.

Erste Normalform (1NF)

Die erste Normalform räumt wiederholte Gruppen auf und sorgt dafür, dass jede Spalte nur einzelne Werte hat. Mehr über „” erfährst du in unserem ausführlichen Leitfaden zur ersten Normalform (1NF).

Atomare Werte bedeuten, dass jede Zelle genau eine Information enthält – keine Listen, keine durch Kommas getrennten Werte, keine mehreren Datenpunkte, die in ein einziges Feld gepackt sind. Das ist die Basis, die alles andere möglich macht.

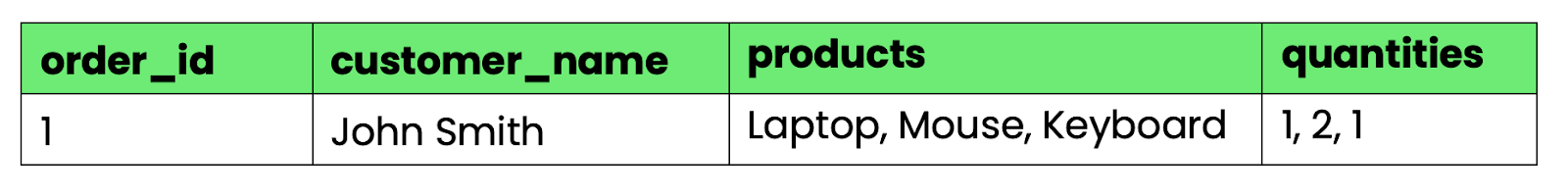

Hier ist, was gegen 1NF verstößt:

CREATE TABLE orders_bad (

order_id INT,

customer_name VARCHAR(100),

products VARCHAR(500),

quantities VARCHAR(50)

);

Bild 2 – Tabelle, die gegen 1NF verstößt

Die Spalten „ products “ und „ quantities “ haben mehrere Werte, die durch Kommas getrennt sind. Ohne String-Parsing kannst du nicht einfach „alle Bestellungen mit Laptops” abfragen oder Gesamtmengen berechnen.

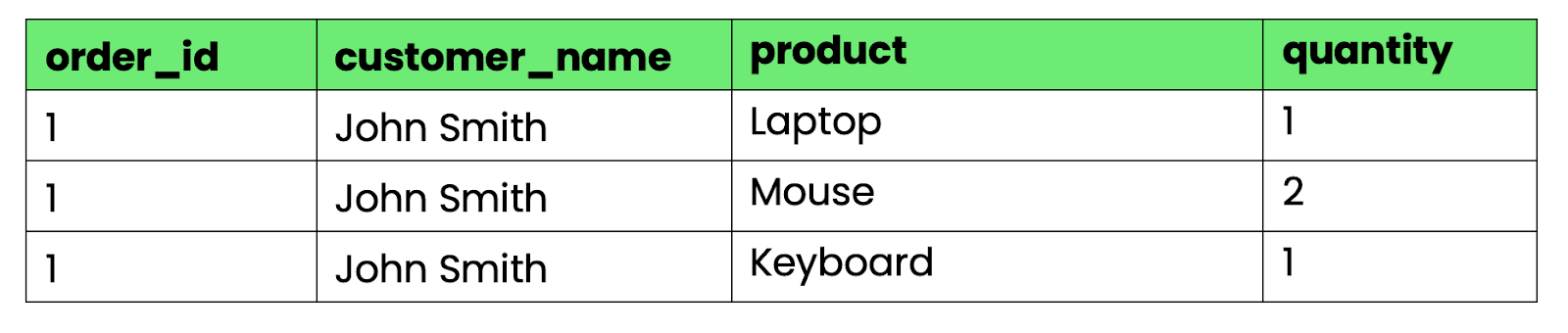

Um das in 1NF umzuwandeln, teil die sich wiederholenden Gruppen in separate Zeilen auf:

-- First normal form (1NF)

CREATE TABLE orders_1nf (

order_id INT,

customer_name VARCHAR(100),

product VARCHAR(100),

quantity INT

);

Bild 3 – Tabelle, die 1NF erfüllt

Jetzt hat jede Zelle genau einen Wert. Du kannst die Daten mit Standard-SQL-Operationen abfragen, sortieren und zusammenfassen.

Zweite Normalform (2NF)

Die zweite Normalform beseitigt Teilabhängigkeiten – wenn Spalten, die keine Schlüssel sind, nur von einem Teil eines zusammengesetzten Primärschlüssels abhängen.

Die zweite Normalform (2NF) hat mehr zu bieten, als man auf den ersten Blick sieht. Mehr Infos zu „“ findest du in unserem ausführlichen Leitfaden.

Eine Tabelle ist in 2NF, wenn sie in 1NF ist und jede Nicht-Schlüsselspalte vom ganzen Primärschlüssel abhängt, nicht nur von einem Teil davon.

Unsere 1NF-Tabelle hat ein Problem. Wenn wir „ order_id “ und „ product “ als zusammengesetzten Primärschlüssel verwenden, hängt „ customer_name “ nur von „ order_id “ ab, nicht vom Produkt. Das führt zu Redundanz – der Kundenname wird für jedes Produkt in einer Bestellung wiederholt.

-- Still has partial dependencies

-- customer_name depends only on order_id, not on (order_id, product)

CREATE TABLE orders_1nf (

order_id INT,

customer_name VARCHAR(100), -- Partial dependency!

product VARCHAR(100),

quantity INT,

PRIMARY KEY (order_id, product)

);Um 2NF zu erreichen, teil die Tabelle anhand der Abhängigkeiten auf:

-- Orders table (customer info depends on order_id)

CREATE TABLE orders (

order_id INT PRIMARY KEY,

customer_name VARCHAR(100)

);

-- Order items table (quantity depends on both order_id and product)

CREATE TABLE order_items (

order_id INT,

product VARCHAR(100),

quantity INT,

PRIMARY KEY (order_id, product),

FOREIGN KEY (order_id) REFERENCES orders(order_id)

);Jetzt kommt „ customer_name “ nur noch einmal pro Bestellung vor, was Redundanzen vermeidet. Jede Tabelle hat Spalten, die vom gesamten Primärschlüssel abhängen.

Dritte Normalform (3NF)

Die dritte Normalform beseitigt transitive Abhängigkeiten, die auftreten, wenn Nicht-Schlüsselspalten von anderen Nicht-Schlüsselspalten statt vom Primärschlüssel abhängen. Tauch ein in die dritte Normalform (3NF) und lerne mehr als nur die Grundlagen.

Eine transitive Abhängigkeit ist da, wenn „Spalte A“ „Spalte B“ bestimmt und „Spalte B“ „Spalte C“ bestimmt, sodass eine indirekte Abhängigkeit von A zu C entsteht.

Erweitern wir unsere Tabelle „Bestellungen” um die Adressdaten der Kunden:

-- Has transitive dependencies

CREATE TABLE orders_2nf (

order_id INT PRIMARY KEY,

customer_name VARCHAR(100),

customer_city VARCHAR(50),

customer_state VARCHAR(50),

customer_zip VARCHAR(10)

);Hier ist das Problem: customer_name → customer_city und customer_city → customer_state. Der Staat hängt von der Stadt ab, nicht direkt von der Bestellung. Das führt zu Redundanz – bei jeder Bestellung aus derselben Stadt werden die Angaben zum Bundesland doppelt angegeben.

Um 3NF zu erreichen, musst du transitive Abhängigkeiten loswerden, indem du separate Tabellen erstellst:

-- Customers table (removes transitive dependencies)

CREATE TABLE customers (

customer_id INT PRIMARY KEY,

customer_name VARCHAR(100),

city_id INT,

FOREIGN KEY (city_id) REFERENCES cities(city_id)

);

-- Cities table

CREATE TABLE cities (

city_id INT PRIMARY KEY,

city_name VARCHAR(50),

state VARCHAR(50),

zip VARCHAR(10)

);

-- Orders table (now references customer, not customer details)

CREATE TABLE orders (

order_id INT PRIMARY KEY,

customer_id INT,

order_date DATE,

FOREIGN KEY (customer_id) REFERENCES customers(customer_id)

);Jetzt sind alle geografischen Infos an einem Ort. Wenn eine Stadt den Bundesstaat wechselt (selten, aber möglich), musst du nur eine Zeile aktualisieren, anstatt alle Bestellungen aus dieser Stadt durchsuchen zu müssen.

Jede Normalform beseitigt bestimmte Redundanzprobleme und sorgt dafür, dass du deine Originaldaten über Verknüpfungen wieder zusammenfügen kannst.

Erweiterte Normalformen

Die ersten drei Normalformen klären die meisten echten Datenbankprobleme, aber manchmal braucht man eine genauere Normalisierung. Diese fortgeschrittenen Formen kümmern sich um bestimmte Abhängigkeitsprobleme, die mit 3NF nicht gelöst werden können.

Boyce-Codd-Normalform (BCNF)

BCNF behebt ein kleines Problem, das 3NF übersieht: wenn sich in einer Tabelle Kandidatenschlüssel überschneiden.

3NF lässt zu, dass Spalten, die keine Schlüssel sind, von Kandidaten-Schlüsseln abhängen, aber BCNF ist da strenger. In BCNF muss jeder Determinante (eine Spalte, die eine andere Spalte bestimmt) ein Superkey sein – entweder ein Primärschlüssel oder ein Kandidatenschlüssel.

Hier bricht die 3NF zusammen:

-- Table in 3NF but violates BCNF

CREATE TABLE course_instructors (

student_id INT,

course VARCHAR(50),

instructor VARCHAR(50),

PRIMARY KEY (student_id, course)

);Die Geschäftsregeln lauten:

- Jeder Student kann mehrere Kurse belegen.

- Jeder Kurs hat genau einen Dozenten.

- Jeder Dozent unterrichtet genau einen Kurs.

Dadurch werden Abhängigkeiten zu „ course → instructor “ und „ instructor → course “ erstellt. Sowohl „ (student_id, course) ” als auch „ (student_id, instructor) ” sind Kandidatenschlüssel, aber „ course ” und „ instructor ” bestimmen sich gegenseitig, ohne selbst Superkeys zu sein.

Das Problem tritt auf, wenn du versuchst, einen neuen Dozenten ohne Studierende hinzuzufügen. Du kannst nicht einfach „Professor Smith unterrichtet Datenbankdesign” hinzufügen, ohne auch einen Studenten für diesen Kurs hinzuzufügen.

Um BCNF zu erreichen, zerlegst du die Abhängigkeiten anhand der problematischen Abhängigkeit:

-- BCNF solution

CREATE TABLE course_assignments (

course VARCHAR(50) PRIMARY KEY,

instructor VARCHAR(50) UNIQUE

);

CREATE TABLE student_enrollments (

student_id INT,

course VARCHAR(50),

PRIMARY KEY (student_id, course),

FOREIGN KEY (course) REFERENCES course_assignments(course)

);Jetzt kannst du Lehrer ohne Schüler hinzufügen, und die Datenbankstruktur passt genau zu den Geschäftsregeln.

Vierte Normalform (4NF)

4NF beseitigt mehrwertige Abhängigkeiten – also wenn eine Spalte mehrere unabhängige Wertesätze bestimmt.

Eine mehrwertige Abhängigkeit liegt vor, wenn „Spalte A“ mehrere Werte in „Spalte B“ bestimmt und diese Werte unabhängig von anderen Spalten in der Tabelle sind.

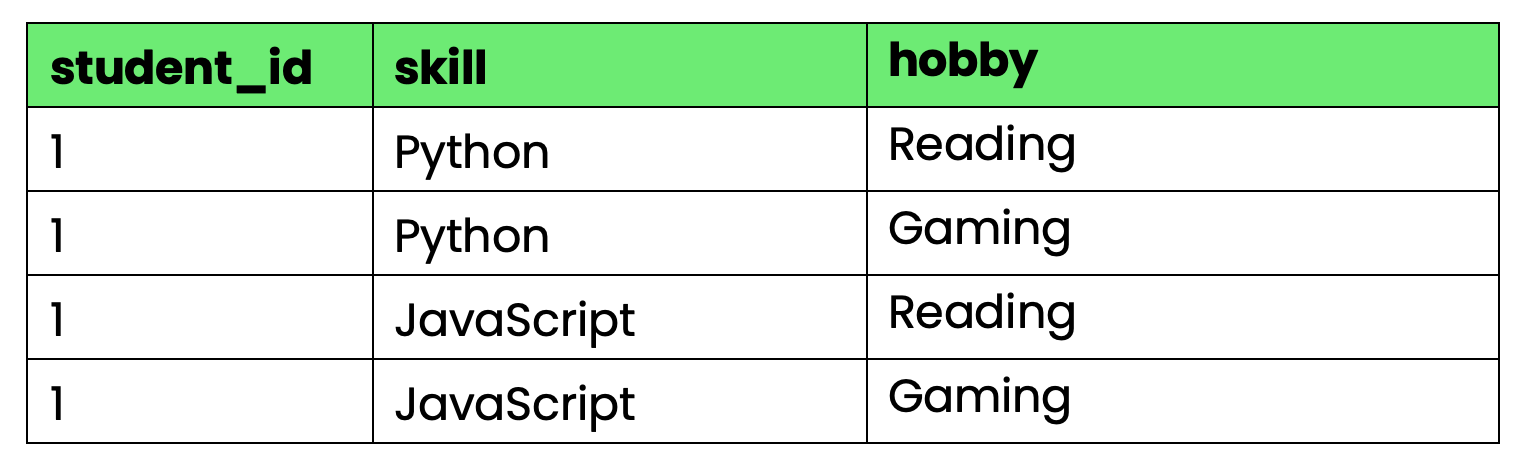

Schau dir mal diese Tabelle an, in der die Fähigkeiten und Hobbys von Schülern erfasst sind:

-- Violates 4NF due to multi-valued dependencies

CREATE TABLE student_info (

student_id INT,

skill VARCHAR(50),

hobby VARCHAR(50),

PRIMARY KEY (student_id, skill, hobby)

);

Bild 4 – Tabelle, die gegen die 4NF verstößt

Das Problem: „ student_id “ (Fähigkeiten und Hobbys) legt sowohl Fähigkeiten als auch Hobbys fest, aber Fähigkeiten und Hobbys sind voneinander unabhängig. Wenn Schüler 1 eine neue Fähigkeit lernt, musst du für jede Hobbykombination eine Zeile erstellen. Wenn sie ein neues Hobby anfangen, brauchst du Reihen für jede Kombination von Fähigkeiten.

Das führt zu einer explosiven Redundanz, wenn die Anzahl der Fähigkeiten und Hobbys wächst.

Um 4NF zu erreichen, trennst du die unabhängigen mehrwertigen Abhängigkeiten:

-- 4NF solution

CREATE TABLE student_skills (

student_id INT,

skill VARCHAR(50),

PRIMARY KEY (student_id, skill)

);

CREATE TABLE student_hobbies (

student_id INT,

hobby VARCHAR(50),

PRIMARY KEY (student_id, hobby)

);Jetzt kannst du Fähigkeiten und Hobbys ganz einfach hinzufügen, ohne dass du dabei alles durcheinander bringst.

Fünfte und sechste Normalform (5NF und 6NF)

5NF (Projekt-Join-Normalform) macht Join-Abhängigkeiten überflüssig: komplexe Beziehungen, bei denen man drei oder mehr Tabellen braucht, um Daten ohne Verluste wieder zusammenzufügen.

Eine Join-Abhängigkeit liegt vor, wenn du die ursprüngliche Tabelle nicht durch Verknüpfen zweier zerlegter Tabellen wiederherstellen kannst, aber durch Verknüpfen von drei oder mehr Tabellen.

Beachte bei Lieferanten, Teilen und Projekten diese Regel: „Ein Lieferant kann ein Teil nur dann für ein Projekt liefern, wenn er dieses Teil liefert UND an diesem Projekt arbeitet.“

-- Original table with join dependency

CREATE TABLE supplier_part_project (

supplier_id INT,

part_id INT,

project_id INT,

PRIMARY KEY (supplier_id, part_id, project_id)

);Um 5NF zu erreichen, zerlegst du das Ganze in drei binäre Beziehungen:

-- 5NF decomposition

CREATE TABLE supplier_parts (supplier_id INT, part_id INT);

CREATE TABLE supplier_projects (supplier_id INT, project_id INT);

CREATE TABLE project_parts (project_id INT, part_id INT);Du kannst gültige Lieferanten-Teil-Projekt-Kombinationen nur wiederherstellen, indem du alle drei Tabellen zusammenführst, wodurch die Geschäftsregel auf Schemaebene durchgesetzt wird.

6NF geht bei der Normalisierung richtig weit, indem jedes Attribut in eine eigene Tabelle mit temporären Schlüsseln kommt.

6NF ist für Data Warehouses und temporäre Datenbanken gedacht, wo du verfolgen musst, wie sich jedes Attribut im Laufe der Zeit unabhängig voneinander verändert.

-- 6NF example for temporal data

CREATE TABLE customer_names (

customer_id INT,

name VARCHAR(100),

valid_from DATE,

valid_to DATE

);

CREATE TABLE customer_addresses (

customer_id INT,

address VARCHAR(200),

valid_from DATE,

valid_to DATE

);So kannst du verfolgen, wann sich jedes Attribut geändert hat, ohne andere zu beeinflussen. Das macht Abfragen aber kompliziert und wird außerhalb spezieller temporärer Datenbanksysteme kaum benutzt.

Die meisten Anwendungen bleiben bei 3NF oder BCNF stehen. Diese fortgeschrittenen Formen lösen bestimmte Sonderfälle, machen das Ganze aber komplizierter, was sich für normale Geschäftsanwendungen nicht lohnt.

SQL Upskilling für Einsteiger

Vorteile und Nachteile der Normalisierung

Normalisierung ist kein Allheilmittel – sie löst zwar wichtige Probleme, bringt aber auch neue Herausforderungen mit sich, vor allem in Bezug auf die Komplexität von SQL-Abfragen. Hier sind die Vorteile und Nachteile, wenn du deine Datenbank normalisierst.

Vorteile der Normalisierung

- Dank reduziertem Redundanz us wird jeder Fakt nur einmal in deiner Datenbank gespeichert, was die Speicherkosten senkt und Synchronisierungsprobleme vermeidet. Wenn Kundendaten in einer einzigen Tabelle gespeichert sind und nicht über Dutzende verteilt, ist das Aktualisieren einer Adresse nur noch eine Zeile Arbeit. Kein Suchen in anderen Tabellen, keine Sorge um verpasste Updates oder inkonsistente Daten in Berichten.

- Das Datenkonsistenz wird automatisch, wenn es nur eine einzige Quelle gibt, auf die man sich verlassen kann. Deine Anwendung kann keine widersprüchlichen Infos anzeigen, weil es gar keine widersprüchlichen Infos geben kann.

- Updates werden schnell und zuverlässig, weil du nur eine Zeile statt Dutzende änderst. Füge einen neuen Kunden einmal ein und verweise überall sonst mit Fremdschlüsseln auf ihn. Lösch einen Auftrag, ohne dir Gedanken über verwaisten Daten in verbundenen Tabellen zu machen.

- Sicherheit wird einfacher, wenn sensible Daten klar abgegrenzt sind. Die Zahlungsinfos der Kunden sind in einer speziellen Tabelle mit bestimmten Zugriffskontrollen gespeichert. Du musst dir keine Sorgen machen, dass Kreditkartennummern an unerwarteten Stellen auftauchen.

- Die Skalierbarkeit verbessert die Daten, weil normalisierte Tabellen kleiner und fokussierter sind. Indizes funktionieren besser bei kleineren Tabellen. Du kannst Daten logisch aufteilen, ohne Infos über Shards zu duplizieren.

- Die Zusammenarbeit im Team läuft besser, wenn alle wissen, wo die Daten sind. Neue Entwickler können sich schneller im Schema zurechtfinden. Datenbankadministratoren können die Leistung ganz einfach optimieren. Business-Analysten können zuverlässige Abfragen schreiben, ohne die Datenqualität anzuzweifeln.

- Backup- und Wiederherstellungsstrategien werden übersichtlicher, weil die Daten nicht über mehrere getrennte Tabellen verteilt sind. Fremdschlüsselbeschränkungen sorgen dafür, dass du keine Daten teilweise wiederherstellen kannst, die die Referenzintegrität beeinträchtigen.

Nachteile und Herausforderungen der Normalisierung

- Die Komplexität von Abfragen steigt, wenn einfache Fragen mehrere Verknüpfungen brauchen, um beantwortet zu werden. Willst du die Bestellhistorie eines Kunden mit den Produktnamen sehen? In einer denormalisierten Tabelle ist das eine Abfrage. In einer normalisierten Datenbank verbindest du die Tabellen „Kunden”, „Bestellungen”, „Bestellpositionen” und „Produkte”. Mehr Verknüpfungen bedeuten mehr Fehlerquellen und langsamere Abfragen.

- Die Leistung kann durch „ “ beeinträchtigt werden, wenn du ständig Tabellen verknüpfst, anstatt aus einzelnen, breiten Tabellen zu lesen. Jeder Join verursacht zusätzlichen Aufwand, vor allem wenn deine Datenbank auf Daten aus verschiedenen Speicherorten zugreifen muss.

- Die Entwicklungszeit wird länger, weil Entwickler erst die Beziehungen zwischen den Tabellen verstehen müssen, bevor sie Abfragen schreiben können. Was früher eine einfache Tabelle „

SELECT” war, wird zu einer Multi-Tabellen-JOINmit ordentlicher Fremdschlüsselverwaltung. - Eine übermäßige Normalisierung führt zu unnötiger Komplexität ( ), wenn Daten, die eigentlich zusammengehören, getrennt werden. Wenn du den vollständigen Namen einer Person in separate Tabellen für Vorname, zweiter Vorname und Nachname aufteilst, bist du wahrscheinlich zu weit gegangen.

Hier ein echtes Beispiel: Eine E-Commerce-Website hat Produktkategorien in sechs Hierarchieebenen sortiert. Einfache Abfragen wie „Alle Elektronikartikel anzeigen“ wurden zu Verknüpfungen von sieben Tabellen, die statt Millisekunden nun Sekunden dauerten. Die theoretische Reinheit war die praktischen Probleme nicht wert.

- Anwendungen mit vielen Lesevorgängen haben Probleme mit der „ “, wenn die Normalisierung für Schreibvorgänge optimiert ist, die meisten Vorgänge aber Lesevorgänge sind. Social-Media-Feeds, Analyse-Dashboards und Berichtssysteme funktionieren oft besser, wenn man sie ein bisschen strategisch entnormalisiert.

- Der Wartungsaufwand steigt mit der Anzahl der Tabellen im „ “. Mehr Tabellen bedeuten mehr Indizes, die gepflegt werden müssen, mehr Fremdschlüsselbeschränkungen, die überprüft werden müssen, und kompliziertere Sicherungsverfahren.

Der Schlüssel liegt darin, die richtige Balance für deinen speziellen Anwendungsfall zu finden – normalisiere genug, um Probleme mit der Datenintegrität zu vermeiden, aber nicht so viel, dass du Leistung und Entwicklerproduktivität opferst.

Leistung und Optimierung

Die Normalisierung wirkt sich auf verschiedene Arten von Systemen unterschiedlich aus – was für Transaktionssysteme gut ist, kann für Analysesysteme schlecht sein. So kannst du die Leistung je nach deinen Arbeitsmustern optimieren.

Was man bei OLTP- und OLAP-Systemen beachten sollte

OLTP-Systeme profitieren von der Normalisierung , weil sie viele kleine, fokussierte Transaktionen verarbeiten, die bestimmte Datensätze ändern.

Wenn ein Kunde in einer E-Commerce-App seine Lieferadresse ändert, änderst du eine Zeile in der Tabelle „Kunden”. Ohne Normalisierung müsstest du die Adressinfos in den Tabellen für Kunden, Bestellungen, Lieferadressen und Rechnungsadressen aktualisieren, was mehrere Schreibvorgänge mit höheren Sperrkonflikten zur Folge hätte.

Normalisierte Tabellen reduzieren die Sperrkonflikte, weil Transaktionen nur kleinere, fokussiertere Datensätze betreffen. Wenn „Benutzer A“ sein Profil aktualisiert, während „Benutzer B“ eine Bestellung aufgibt, greifen sie wahrscheinlich auf völlig unterschiedliche Tabellen zu. Das heißt, es gibt weniger Probleme mit der Gleichzeitigkeit und die Transaktionen werden schneller abgewickelt.

Schreibvorgänge werden in normalisierten Systemenatomar und vorhersehbar ( ). Füge eine neue Bestellung ein, indem du in die Tabellen orders und order_items schreibst. Wenn einer der Vorgänge nicht klappt, kannst du alles sauber zurücksetzen, ohne dir Gedanken über teilweise Aktualisierungen in den denormalisierten Strukturen machen zu müssen.

OLAP-Systeme sind da anders– sie brauchen schnelle Lesevorgänge in großen Datensätzen und aggregieren oft Daten aus mehreren miteinander verbundenen Tabellen.

Schau dir mal eine Abfrage zur Verkaufsanalyse an: „Zeig die monatlichen Einnahmen der letzten zwei Jahre nach Produktkategorien an.“ Ein normalisiertes System erfordert das Zusammenführen von Tabellen für Bestellungen, Bestellpositionen, Produkte und Kategorien – möglicherweise Millionen von Zeilen mit aufwendigen Aggregationen.

Eine denormalisierte Data Warehouse-Tabelle mit vorberechneten Monatssummen beantwortet dieselbe Frage mit einer einfachen Abfrage „ GROUP BY “. Der Kompromiss ist Speicherplatz und etwas kompliziertere Updates für eine viel schnellere Abfrage.

Hybride Ansätze funktionieren gut in einer verteilten Datenbank ( ), wenn sowohl Transaktionsintegrität als auch analytische Leistung gefragt sind. Halte dein OLTP-System für die Datenintegrität normalisiert und führe dann ETL in denormalisierte OLAP-Systeme durch, um schnelle Berichte zu erstellen.

Techniken zur Reduzierung des Normalisierungsaufwands

- Mit der richtigen Indexierungs -Strategie kannst du die Join-Performance in normalisierten Datenbanken echt verbessern. Fremdschlüssel-Spalten brauchen immer Indizes. Wenn du Tabellen für Kunden und Bestellungen anhand der Kunden-ID zusammenführst, sollten beide Tabellen Indizes für diese Spalte haben. Ohne sie führt die Datenbank vollständige Tabellen-Scans durch, die die Leistung beeinträchtigen.

-- Must-have indexes for normalized tables

CREATE INDEX idx_orders_customer_id ON orders(customer_id);

CREATE INDEX idx_order_items_order_id ON order_items(order_id);

CREATE INDEX idx_order_items_product_id ON order_items(product_id);- Zusammengesetzte Indizes helfen bei Abfragen über mehrere Spalten, die in normalisierten Schemata häufig vorkommen:

-- For queries filtering by customer and date range

CREATE INDEX idx_orders_customer_date ON orders(customer_id, order_date);- Das Zwischenspeichern von Abfrageergebnissen (Query Result Caching) macht den wiederholten Join-Overhead für häufig abgerufene Datenkombinationen überfl Redis oder Memcached können vorab berechnete Ergebnisse für aufwendige Abfragen in mehreren Tabellen speichern.

- Datenbankverbindungs-Pooling reduziert den Aufwand für das Einrichten von Verbindungen für Anwendungen, die viele kleine, normalisierte Abfragen machen.

- Materialisierte Ansichten berechnen komplexe Verknüpfungen im Voraus und speichern die Ergebnisse als physische Tabellen:

-- Pre-computed customer order summary

CREATE MATERIALIZED VIEW customer_order_summary AS

SELECT

c.customer_id,

c.name,

COUNT(o.order_id) as total_orders,

SUM(o.total_amount) as lifetime_value

FROM customers c

LEFT JOIN orders o ON c.customer_id = o.customer_id

GROUP BY c.customer_id, c.name;- Horizontales Sharding funktioniert gut mit normalisierten Daten, weil Tabellenbeziehungen natürliche Sharding-Grenzen bieten. Die Shards nach customer_id und die dazugehörigen Bestelldaten bleiben zusammen.

- Replikate lesen verarbeiten analytische Abfragen getrennt von Transaktions-Workloads. Leite komplexe Berichtsabfragen an schreibgeschützte Replikate weiter, während die Schreibvorgänge in der Primärdatenbank bleiben.

- Datenbankspezifische Optimierungen machen einen großen Unterschied:

- PostgreSQL: Mit „

EXPLAIN ANALYZE“ kannst du langsame Joins finden und „work_mem“ für Sortiervorgänge optimieren. - MySQL: Aktiviere den Abfrage-Cache für wiederholte „

SELECT“-Anweisungen und optimiere die Größe des „JOIN“-Puffers. - SQL Server: Mit Abfrageausführungsplänen fehlende Indizes finden und Seitenkomprimierung für große Tabellen aktivieren

- PostgreSQL: Mit „

Das Wichtigste ist, erst mal zu messen, bevor man optimiert. Analysier deine aktuellen Abfragen, um Engpässe zu finden, und nimm dann gezielte Korrekturen vor, anstatt zu raten, was helfen könnte.

Denormalisierung: Strategische Kompromisse

Manchmal macht es Sinn, Normalisierungsregeln zu brechen – zum Beispiel, wenn das Lesen schneller gehen soll als die perfekte Organisation der Daten. Hier erfährst du, wann und wie du Daten denormalisieren kannst, ohne dass dir die Wartung auf dem Hals sitzt.

- Anwendungen mit vielen Lesevorgängen und aufwendigen Verknüpfungen sind super Kandidaten für eine strategische Denormalisierung.

- Echtzeit-Dashboards und Analyse en brauchen oft denormalisierte Daten, um die Leistungsziele zu erreichen. Wenn Führungskräfte alle paar Sekunden aktuelle Verkaufszahlen sehen wollen, kannst du dir komplexe Aggregationen über normalisierte Tabellen nicht leisten.

- E-Commerce-Produktkataloge machen Kategorieinfos oft unübersichtlich. Anstatt Produkte → Unterkategorien → Kategorien → Hauptkategorien zu verknüpfen, speichern viele Websites den kompletten Kategoriepfad direkt mit jedem Produkt: „Elektronik > Computer > Laptops > Gaming.“

- Gängige Techniken zur Denormalisierung sind zum Beispiel:

- Gespeicherte Werte: Halte Summen, Zählungen oder Durchschnittswerte im Auge, die sonst mit Aggregationsabfragen berechnet werden müssten.

- Hierarchien abflachen: Speichere Pfade von Shop-Kategorien, Organisationsstrukturen oder verschachtelte Daten als flache Felder.

- Häufig verwendete Daten kopieren: Kundennamen in Bestelldaten und Produkttitel in Warenkorbartikel kopieren

- Daten vor dem Beitritt: Benutzerprofilinfos mit Posts, Kommentaren oder Aktivitätsaufzeichnungen speichern

Es kommt drauf an, wie du deine Daten nutzt. Wenn du Kundenbestellungen 100 Mal öfter durchliest als die Kundendaten aktualisierst, ist es sinnvoll, den Kundennamen in den Bestelldaten doppelt zu haben.

Aber nur, wenn es wirklich nötig ist. Mach nicht dein ganzes Schema platt, nur weil ein Bericht langsam läuft – bring den einen Bericht in Ordnung und lass den Rest normalisiert.

Fang normal an und mach dann weiter, je nachdem, wie es läuft. Eine zu frühe Denormalisierung macht Updates kompliziert, bevor du überhaupt weißt, ob du die Performance-Steigerung brauchst.

Zusammenfassung der Datenbanknormalisierung

Einfach gesagt, sorgt die Datenbanknormalisierung dafür, dass Daten nicht doppelt da sind und alles zusammenpasst.

Das hat natürlich seine Vor- und Nachteile bei der Komplexität und Geschwindigkeit der Abfragen. Das Wichtigste ist, dass du das richtige Niveau für deinen Arbeitsaufwand wählst. OLTP-Systeme profitieren von einer vollständigen Normalisierung durch 3NF, während leseintensive Anwendungen oft eine strategische Denormalisierung brauchen, um schneller zu sein.

Du musst dich nicht für einen Ansatz entscheiden. Halte deine Transaktionsdatenbank für die Datenintegrität normalisiert und nutze dann denormalisierte Ansichten oder separate analytische Datenbanken für die Berichterstellung. Mit dieser hybriden Strategie kriegst du sowohl Zuverlässigkeit als auch Leistung, wo du sie am meisten brauchst.

Fang mit einer ordentlichen Normalisierung an und denormalisier dann gezielt, wenn es echte Performance-Probleme gibt, statt nur aus theoretischen Gründen.

Wenn dudeine Datenbankkenntnisse verbessern willst, sind diese Kurse der perfekte nächste Schritt:

Häufig gestellte Fragen

Was sind die wichtigsten Vorteile der Normalisierung in der Datenbankverwaltung?

Durch die Normalisierung werden doppelte Daten vermieden, was die Speicherkosten senkt und Inkonsistenzen in deiner Datenbank verhindert. Das macht Aktualisierungen schneller und zuverlässiger, weil du nur an einer Stelle was ändern musst, statt in mehreren Tabellen rumzusuchen. Normalisierte Datenbanken bieten außerdem eine bessere Datenintegrität durch Fremdschlüsselbeschränkungen, klarere Sicherheitskontrollen, da sensible Daten in bestimmten Tabellen gespeichert werden, und eine verbesserte Skalierbarkeit, da kleinere, fokussierte Tabellen mit Indizes und Partitionierung besser funktionieren.

Wie verbessert die Normalisierung die Datenintegrität?

Normalisierung sorgt für Datenintegrität auf Datenbankebene durch Fremdschlüsselbeschränkungen und das Entfernen von doppelten Daten. Wenn du einen Kunden mit aktiven Bestellungen nicht aus Versehen löschen oder eine Bestellung ohne gültigen Kunden einfügen kannst, bleibt die Referenzintegrität deiner Datenbank automatisch erhalten. Da jede Info nur an einem Ort gespeichert ist, gibt's keine widersprüchlichen Versionen derselben Daten in verschiedenen Tabellen, was Inkonsistenzen verhindert, die die Anwendungslogik durcheinanderbringen könnten.

Was sind die typischen Probleme bei der Normalisierung?

Eine übermäßige Normalisierung macht die Dinge unnötig kompliziert, wenn du Daten aufteilst, die eigentlich zusammengehören, wie zum Beispiel den Namen einer Person in mehrere Tabellen. Das führt zu vielen Joins bei einfachen Abfragen und macht die Leistung langsamer. Ein weiterer Fallstrick ist die Normalisierung ohne Berücksichtigung Ihrer tatsächlichen Zugriffsmuster – wenn Sie für häufige Abfragen ständig dieselben Tabellen verknüpfen, ist möglicherweise eine strategische Denormalisierung erforderlich. Eine schlechte Indizierung von Fremdschlüsselspalten beeinträchtigt auch die Leistung in normalisierten Datenbanken, wodurch Verknüpfungen viel langsamer als nötig sind.

Wie wirkt sich die Denormalisierung auf die Datenbankleistung aus?

Durch Denormalisierung wird die Leseleistung verbessert, weil Joins wegfallen. Das kann bei Anwendungen mit viel Traffic die Geschwindigkeit von gängigen Abfragen von 50 ms auf 5 ms bringen. Allerdings werden Schreibvorgänge dadurch komplizierter, weil Aktualisierungen über mehrere denormalisierte Kopien derselben Daten hinweg konsistent bleiben müssen. Das erhöht das Risiko von Dateninkonsistenzen und man braucht mehr Anwendungslogik, um alles synchron zu halten. Die Denormalisierung braucht auch mehr Speicherplatz, weil du Daten über Tabellen hinweg duplizierst.

Was sind die besten Vorgehensweisen, um zu entscheiden, wann eine Datenbank normalisiert oder denormalisiert werden sollte?

Fang mit einer ordentlichen Normalisierung zur dritten Normalform (3NF) an, um die Datenintegrität sicherzustellen, und denormalisiere dann gezielt, basierend auf echten Performance-Problemen und nicht auf theoretischen Überlegungen. Schau dir deine Abfragemuster an – wenn du Daten 100 Mal öfter liest als aktualisierst, könnte eine Denormalisierung für diese Tabellen sinnvoll sein. Hybride Ansätze nutzen: Halte deine Transaktionsdatenbank für Schreibvorgänge normalisiert und erstelle dann denormalisierte Ansichten oder separate analytische Datenbanken für die Berichterstellung. Profilier immer die Leistung, bevor du Änderungen machst, weil eine gute Indizierung und Abfrageoptimierung oft Probleme mit der Normalisierung lösen, ohne dass du das Schema ändern musst.