Curso

Como todos los modelos de aprendizaje automático, los sistemas de IA se entrenan para minimizar una función de error. Una formación adecuada es necesaria, pero no suficiente, para que un modelo de IA se integre en la vida cotidiana de los usuarios y en los flujos de trabajo de las organizaciones.

Para que las interacciones humano-inteligencia artificial tengan éxito, los modelos de IA deben ser capaces de responder descifrando la intención del usuario y actuando según las directrices de seguridad y equidad. Por ejemplo, un chatbot debe abstenerse de dar instrucciones para hacerse daño a sí mismo o a otros, y un modelo para ayudar a los reclutadores no debe discriminar entre los solicitantes.

Los sistemas de IA son cada vez más potentes y están más integrados en la vida cotidiana. Así pues, los desarrolladores deben asegurarse de que el comportamiento de la IA a escala siga la ética, los valores y la moral humanos. Esto se llama superalineación. El curso Ética de la IA entra en los detalles de los aspectos éticos de la IA.

En este artículo explicamos la superalineación de los modelos de IA , discutimos distintos métodos para conseguir la superalineación de los modelos de IA en general y de los LLM en particular, y tratamos las consideraciones éticas y los retos prácticos de la superalineación.

Alineación de la IA: Una rápida visión general

La alineación se refiere al proceso y a los métodos para garantizar que un sistema de IA se comporta de acuerdo con la intención del usuario de una manera libre de prejuicios, al tiempo que sigue las directrices de seguridad. Este artículo explica los conceptos y métodos utilizados en la alineación.

Además de la supervisión humana, los desarrolladores adoptan métodos como el filtrado y los sistemas basados en reglas para garantizar la alineación en los sistemas de IA. Las técnicas utilizadas para alinear un modelo con una base de usuarios pequeña se vuelven poco prácticas cuando se aplican a un modelo más potente y popular. Por ejemplo:

- El filtrado de contenidos utiliza algoritmos para garantizar que el modelo no produce contenidos perjudiciales. Estos algoritmos filtran contenidos no deseados, como lenguaje soez e imágenes explícitas. Sin embargo, se limitan a lo que filtra el algoritmo y no pueden proteger contra nuevos tipos de contenidos indeseables.

- Los sistemas basados en reglas utilizan un conjunto de reglas predefinidas para evitar casos de uso no deseados, como instrucciones para hacerse daño a uno mismo o a los demás. Sin embargo, no pueden adaptarse a comportamientos inesperados de los usuarios o de los modelos de IA.

- Los métodos tradicionales de mitigación de sesgos, como la reponderación de los datos de entrenamiento, son eficaces para evitar los sesgos conocidos. Aun así, pueden ser insuficientes para detectar sesgos nuevos y más sutiles que surgen cuando se utilizan sistemas complejos de IA en nuevos contextos.

Así pues, los potentes modelos de IA que funcionan a mayor escala y con un alcance más amplio necesitan un nuevo enfoque de la alineación. Esto se llama superalineación.

¿Qué es la Superalineación?

El alcance, la escala, la complejidad y el uso generalizado de potentes modelos de IA conducen a un conjunto totalmente nuevo de retos de alineación.

Los métodos y enfoques para alinear los modelos de IA a gran escala con los valores humanos, la ética y la moral se engloban bajo el paraguas de la superalineación. Abarca muchas subáreas.

En general, los sistemas superalineados deben

- Busca activamente la colaboración humana para permanecer alineado más allá de la alineación inicial.

- Alinea y realinea continuamente para tener en cuenta los nuevos casos de uso y los valores humanos no escritos. Este es el conducto de alineación.

- Explica sus acciones y actualiza sus respuestas en función de las reacciones humanas.

La superalineación es un campo en evolución. Aborda los modelos actuales de IA más avanzados y considera métodos para modelos de IA aún más potentes que se espera que se desarrollen.

A medida que la IA se hace más potente, se espera que gestione muchos aspectos de la vida humana, como la agricultura, el transporte y otros. Un sistema de IA de este tipo debe priorizar siempre los intereses de los seres humanos por encima de cualquier otra consideración.

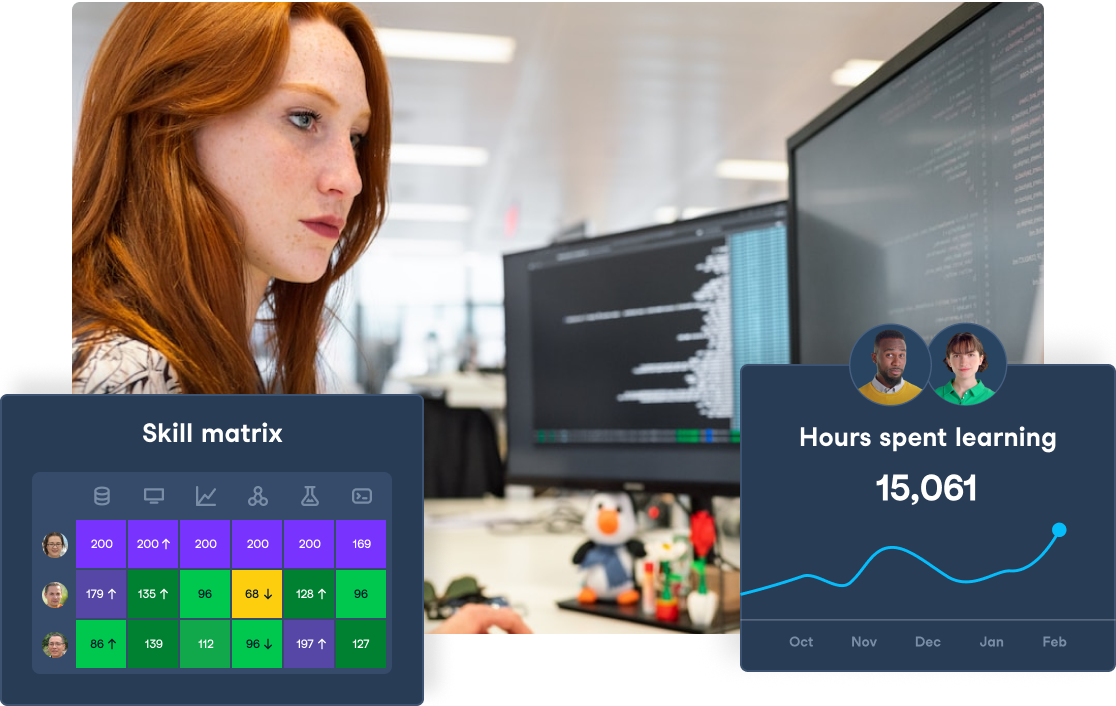

Mejora las habilidades de tu equipo en IA

Transforma tu empresa dotando a tu equipo de conocimientos avanzados de IA a través de DataCamp for Business. Consigue mejores conocimientos y eficacia.

Técnicas para lograr la superalineación

En esta sección, explicamos algunos de los métodos y técnicas utilizados para conseguir la superalineación. La filosofía subyacente a estos enfoques es que deben ser escalables.

Formación contenciosa

En la alineación, como con cualquier formación, los desarrolladores deben comprobar si el sistema ha aprendido a demostrar comportamientos deseables. Una forma de probar la superalineación es presentar a la IA contraejemplos. Los grandes sistemas de IA deben ser entrenados para identificar qué solicitudes no se hacen de buena fe y tratarlas adecuadamente.

Un enfoque habitual de la superalineación es utilizar dos IAs como adversarios. Esto es análogo al enfoque del equipo rojo y el equipo azul utilizado habitualmente en la investigación sobre seguridad, en el que el equipo rojo intenta penetrar en la seguridad y las defensas del equipo azul.

En el contexto del entrenamiento adversario para la superalineación, cada IA intenta encontrar entradas que confundan a la otra IA. Por ejemplo, considera una IA (equipo azul) que ha sido alineada para no responder con palabrotas. En el entrenamiento adversario, el objetivo de la IA adversaria (equipo rojo) es encontrar indicaciones que provoquen que la IA del equipo azul dé respuestas inadecuadas. El objetivo es garantizar que, incluso cuando sea puesta a prueba por la IA del equipo rojo, la IA del equipo azul siga generando respuestas aceptables.

Ilustración del concepto de formación contradictoria. Imagen creada con DALL-E

Formación en robustez

La robustez se refiere a ser capaz de distinguir entre entradas que en realidad son diferentes, pero que superficialmente parecen similares. Debe ser capaz de reconocer los casos de esquina y los casos límite. Por ejemplo, un sistema para identificar acciones humanas en videoclips debería ser capaz de distinguir una pelea callejera real de una pelea coreografiada en una película. Confundir una cosa con la otra puede tener consecuencias perjudiciales.

Por tanto, los grandes modelos deben exponerse específicamente a escenarios superficialmente similares. Esto enseñará al modelo a reconocer matices y rasgos sutiles.

Supervisión escalable

A medida que los modelos de IA encuentran nuevos usuarios y se utilizan en más aplicaciones, su supervisión debe escalar en paralelo. La participación humana es el quid de la supervisión y alineación de la IA. Ampliar la supervisión humana es más difícil que ampliar una solución tecnológica. Por tanto, para mantener una supervisión escalable de la IA, se necesitan nuevos métodos:

- Supervisión automatizada en tiempo real: Los sistemas automatizados pueden seguir continuamente las respuestas de la IA y controlar su comportamiento para comprobar que se ajusta a los valores humanos. Las desviaciones significativas de las normas previstas pueden marcarse para la intervención humana.

- Revisiones programáticas: Es factible revisar y auditar manualmente todos los resultados de la IA. Esto puede hacerse desarrollando nuevos programas y algoritmos que comprueben la adecuación de la IA a la ética humana. Los casos dudosos pueden marcarse para que los moderadores humanos los juzguen manualmente.

Aprendizaje por refuerzo con retroalimentación humana (RLHF)

Como se explica en el artículo sobre el aprendizaje por refuerzo ( RL), en las implementaciones tradicionales de RL, el sistema de IA aprende a modificar su comportamiento observando a un humano. Utiliza un proceso de prueba y error para maximizar la recompensa. La RLHF combina la RL con la aportación humana para guiar las acciones de la IA durante el entrenamiento.

RLHF comienza con un modelo preentrenado. Los revisores humanos asignan al modelo un conjunto de tareas y proporcionan información sobre los resultados, como calificar o corregir las respuestas del modelo.

El modelo utiliza la información para afinar su comportamiento con el fin de alinearse con la retroalimentación humana y maximizar la recompensa (retroalimentación humana positiva). Este proceso se repite hasta que los resultados del modelo se consideran pertinentes, adecuados y precisos.

Aprendizaje por refuerzo inverso (IRL)

En el aprendizaje por refuerzo (RL) tradicional, los desarrolladores del modelo declaran explícitamente la función de recompensa (también llamada función de utilidad). El objetivo del modelo es maximizar el incentivo según esta función de recompensa.

En la RL inversa, el modelo infiere la función de recompensa basándose en el comportamiento de un modelo entrenado o de un humano. Por ejemplo, un coche autónomo basado en RL podría recibir incentivos positivos para circular por el carril, parar en los semáforos en rojo, etc. Un sistema de autoconducción basado en IRL averigua los incentivos observando de cerca y siguiendo las acciones de un conductor humano experimentado o de una IA entrenada.

Los valores humanos no pueden enumerarse explícitamente para todos los contextos, lo que dificulta el RL tradicional para los problemas de alineación.

Un enfoque más eficaz es hacer que la IA observe y reproduzca el comportamiento humano en diferentes contextos. Observando el comportamiento del humano, la IA aprende cuáles de las distintas respuestas posibles (o cursos de acción) se parecen más a cómo podría actuar un humano en ese escenario. Esto ayuda a alinear el comportamiento de la IA con los valores humanos.

Ilustración del concepto de aprendizaje por refuerzo inverso. Imagen creada con DALL-E

Debate

Muchos métodos de alineación implican que un humano entrene a la IA sobre qué comportamiento es aceptable y cuál no, pero utilizar a un humano puede no ser siempre la solución ideal.

Para muchos problemas complejos, como la programación óptima de un sistema ferroviario nacional, ningún ser humano puede ser capaz de juzgar si una solución propuesta es la mejor. Una solución es aprovechar la propia IA para la superalineación. En el método de debate:

- Una IA propone una solución y da una explicación detallada de cada paso.

- A continuación, se utiliza la misma IA o una IA diferente para criticar (aportar argumentos en contra) cada explicación.

- Un humano decide qué argumento es más correcto. Como cada argumento tiene un alcance limitado, es más fácil para los humanos juzgar su validez.

El proceso de razonamiento lógico se gamifica, y gana el argumento más válido. Así, a lo largo de una serie de debates, la IA aprende qué líneas de razonamiento son aceptables y cuáles no. Para las tareas futuras, los resultados de la IA se ajustan mejor a los valores humanos.

Amplificación iterada

En los sistemas tradicionales de aprendizaje automático y aprendizaje profundo, el entrenamiento se basa en si la salida del modelo coincide con la salida esperada.

A medida que aumenten las capacidades de la IA, se utilizará para tareas cada vez más complejas. Para muchas de estas tareas, los humanos no conocen de antemano el resultado esperado. Las únicas opciones pueden ser las soluciones generadas por la IA. Para tareas tan complejas, alinear la IA en función del resultado final es difícil, porque los humanos no pueden juzgar el resultado final.

Por ejemplo, al diseñar un horario de transporte, el sistema debe equilibrar la viabilidad financiera con la prestación de un servicio público útil. Muchas de estas consideraciones hacen difícil determinar qué diseño final del sistema se ajusta mejor a los valores humanos.

En estos casos, es más fácil aprovechar la supervisión humana para garantizar la alineación en subtareas más pequeñas. Más adelante en el proceso, las tareas ligeramente más grandes se dividen en subtareas más pequeñas y luego se alinean bajo supervisión humana. Este proceso continúa iterativamente hasta que las tareas se hacen demasiado grandes para ser juzgadas directamente por humanos.

La amplificación iterada supone que, puesto que las subtareas más pequeñas y sencillas se han alineado basándose en la validación humana, la tarea principal más grande también está alineada. Esto se llama amplificación iterada. La amplificación iterativa también se aplica en combinación con técnicas como el debate.

Valorar el aprendizaje

Las interacciones humanas son complejas y matizadas. En muchos casos, las acciones humanas son ambiguas cuando se consideran aisladamente: sólo tienen sentido en el contexto adecuado. Así pues, las funciones de utilidad tradicionales y el aprendizaje por refuerzo son inadecuados para imbuir a la IA de valores humanos.

Una alternativa propuesta es que el modelo tenga acceso a un conjunto de funciones de utilidad en lugar de a una única función de utilidad. Es probable que cada función de utilidad se elija en función del contexto. El modelo aprende a elegir la función de utilidad correcta observando las acciones humanas en diferentes contextos. Esto se llama aprendizaje de valores.

El aprendizaje de valores es una técnica en la que la IA observa directamente el comportamiento humano en distintos escenarios y aprende el comportamiento adecuado para cada contexto. Esto implica exponer a la IA al comportamiento humano a través de una amplia variedad de interacciones de la vida real.

Ilustración del concepto de aprendizaje de valores. Imagen creada con DALL-E

Los humanos del entrenamiento de alineación deben comportarse de un modo que se considere aceptable. Por ejemplo, un humano que conduce un coche no debe ceder a la furia de la carretera mientras intenta alinear a una IA. Sin embargo, cuando se queda atascado detrás de un conductor lento, el humano debe intentar adelantar con seguridad al vehículo más lento.

Superalineación en grandes modelos lingüísticos (LLM)

Los LLM son actualmente los modelos de IA a gran escala más populares. Se utilizan en una gran variedad de tareas. Teniendo en cuenta su gran base de usuarios y casos de uso, la superalineación en el contexto de los LLM merece un examen más detenido.

Los LLM y los retos de la alineación

Los grandes modelos lingüísticos como GPT-4, Gemini y Meta AI están empezando a utilizarse en la vida cotidiana. Dada su escala y alcance, los LLM conllevan nuevos retos de alineación, como:

- Perpetuación de prejuicios: Estos modelos se han entrenado con grandes cantidades de datos procedentes de Internet abierto y otras bibliotecas. Cualquier sesgo en los datos de entrenamiento se refleja directamente en los resultados del modelo. El sesgo debido a deficiencias en los datos de entradaa se considera sesgo algorítmico.

- Sistemas complejos: El gran tamaño de estos modelos, la inmensidad de sus datos de entrenamiento y la gran variedad de casos de uso hacen que sea un reto predecir el comportamiento del sistema. Esto dificulta garantizar que los resultados del modelo se ajustan a los valores humanos en todos los casos de uso.

- Problemas de escala: Dada su amplia base de usuarios y el gran número de consultas que gestionan:

- Aunque el porcentaje de respuestas no alineadas con los valores humanos sea pequeño, sigue siendo una cifra importante.

- Resulta difícil garantizar que el comportamiento de la IA se ajuste sistemáticamente a los valores humanos y a la ética de todos los usuarios.

Esto hace que sea necesario adoptar nuevos métodos para comprobar la adecuación de estos modelos y afinarlos continuamente para garantizar que se ajustan a los valores humanos y a las normas éticas.

Evaluación de los resultados del LLM

Se han propuesto e intentado muchos enfoques para evaluar los resultados de los LLM con el fin de garantizar su alineación con los valores humanos. Estos métodos deben ser escalables. Algunos ejemplos son:

- Filtra la salida no deseada: Un enfoque pragmático para eliminar las respuestas inadecuadas de un LLM consiste en utilizar una capa de filtrado sobre el modelo lingüístico. Entrenar sistemas separados para las tareas de generación y filtrado de texto es más eficaz. El filtro en sí puede ser otra IA que escanee la salida del generador LLM en busca de lenguaje inapropiado y temas delicados.

- Detección de sesgos: Los conjuntos de datos de entrenamiento contienen invariablemente algún sesgo, lo que da lugar a modelos sesgados. Algunos métodos para detectar sesgos en los resultados del LLM son:

- Los desarrolladores de modelos auditan los modelos para detectar resultados sesgados. Las auditorías de sesgo consisten en probar un modelo con diversas entradas y comparar la respuesta en cada caso.

- A veces se utilizan algoritmos especializados de detección de sesgos para buscar e identificar sistemáticamente distintos tipos de sesgos.

- Comprobación de hechos: La alucinación ha sido la pesadilla de los LLM desde el principio. Un LLM sólo sabe predecir qué palabras deben seguir a una cadena de palabras basándose en lo que vio en el conjunto de datos de entrenamiento. No tiene concepto de los hechos. Para un LLM, la frase "Dell fabrica ordenadores personales" tiene el mismo significado que "Dell fabrica patatas fritas". Por tanto, cuando se utilizan LLM para generar texto basado en hechos , es fundamental comprobar que el texto generado es correcto desde el punto de vista de los hechos.

- Explicabilidad: Los sistemas y programas informáticos tradicionales se basan en reglas. Puedes depurar el sistema para determinar con precisión qué reglas son responsables de una salida concreta. En cambio, los LLM tienen miles de millones de parámetros. Es imposible averiguar qué pesos contribuyen a las distintas partes del resultado.

Afortunadamente, el razonamiento es una propiedad emergenteent e de los grandes modelos lingüísticos. Una propiedad emergente es una propiedad de un sistema complejo que no puede explicarse como la suma de sus partes.

A menudo se observa que los LLM son capaces de explicar sus respuestas y razonar a través de problemas de varios pasos. Pedir a un LLM que explique una solución compleja y evaluar manualmente cada paso puede permitir a los humanos validar la respuesta del LLM.

Los LLM y la interacción humana

Los LLM que se utilizan de forma interactiva deben comprender los matices y sutilezas de las conversaciones humanas. Deben ser capaces de responder en función del contexto de la conversación.

El tono, la intención, el sarcasmo y las señales emocionales son difíciles de representar matemáticamente. Sin embargo, los modelos de IA deben tener en cuenta estos aspectos para comunicarse eficazmente con los humanos. Sólo un LLM que esté alineado para ser empático será eficaz en la interacción con las personas. Puede generar confianza y promover compromisos productivos con los seres humanos, y la única forma de conseguirlo es aplicando diversas técnicas de superalineación.

Consideraciones éticas en la Superalineación

El objetivo último de la superalineación es que la IA poderosa se ajuste a las normas éticas de la sociedad humana.

Esta sección explica el papel de la ética en la superalineación y los retos asociados a garantizar un comportamiento ético en los grandes modelos.

Garantizar un comportamiento ético

Una IA desalineada con los valores humanos nunca podrá ser segura para que la utilicen los humanos. Un sistema mal alineado puede producir contenidos dañinos que los actores malignos pueden utilizar indebidamente. Puede perpetuar las desigualdades sociales y amplificar los prejuicios existentes.

En el peor de los casos, un sistema mal alineado puede abusar de esta capacidad y provocar un comportamiento manipulador. Así pues, las preocupaciones éticas se encuentran en el centro mismo de todos los esfuerzos de superalineación. Sólo garantizando un comportamiento ético en todas las circunstancias se podrá considerar que las herramientas de IA son fiables y dignas de confianza para un uso generalizado y a largo plazo.

Equilibrio entre utilidad y seguridad

Imbuir el comportamiento ético en los sistemas de IA tiene un coste importante. Para lograr la superalineación, los desarrolladores de modelos necesitan:

- Humanos para auditar las respuestas y proporcionar información a la IA

- Tiempo adicional para asegurar la superalineación antes de liberar el modelo

- Recursos informáticos adicionales para afinar y alinear el modelo

Además, mientras ejecuta la inferencia, el modelo necesita realizar cálculos adicionales para asegurarse de que sus respuestas se ajustan a los valores humanos. A veces, imponer la alineación como restricción puede limitar las capacidades del modelo. Así, un modelo superalineado puede ser menos eficaz.

Por tanto, debe haber un equilibrio entre el rendimiento técnico del modelo y las consideraciones de alineación. Dar prioridad a las consideraciones de alineación y seguridad sobre las métricas de rendimiento tradicionales puede dar lugar a modelos poco útiles en la práctica.

Imparcialidad y parcialidad

Los modelos de IA a gran escala tienen muchos usuarios y casos de uso variados. Cualquier sesgo presente en los resultados del modelo puede tener consecuencias de gran alcance. Por tanto, los desarrolladores deben procurar que sus modelos estén lo menos sesgados posible.

Eliminar el sesgo de los LLM es un reto porque estos modelos se someten a un entrenamiento no supervisado basado en un enorme corpus de datos de texto. La IA capta todos los diferentes sesgos y prejuicios presentes en el texto del conjunto de datos de entrenamiento. Esto puede hacer que el resultado del modelo sea injusto y discriminatorio. Los desarrolladores pueden emplear varios métodos para solucionarlo:

- Detección de sesgos: Antes de poder tomar contramedidas, primero debes identificar los casos de comportamiento tendencioso. Las auditorías periódicas y las evaluaciones de imparcialidad sobre muestras de los resultados del modelo pueden ayudar a identificar los tipos de sesgo que presenta el modelo y las situaciones que desencadenan estos sesgos.

- Eliminación de prejuicios: Hay tres enfoques principales para eliminar el sesgo:

- Programar el modelo para corregir sesgos específicos en la salida.

- Mejorar el conjunto de datos de entrenamiento completándolo con datos sintéticos. Por ejemplo, si el conjunto de datos de entrenamiento de un sistema de reconocimiento de imágenes tiene muy pocos animales de una especie concreta, se reduce la probabilidad marginal de identificar a este animal. Esto se suele solucionar aumentando el conjunto de datos de entrenamiento con imágenes generadas sintéticamente de esta especie y/o aumentando su peso en el proceso de entrenamiento.

- Actualizar los pesos de los subconjuntos infrarrepresentados de los datos de entrenamiento. Esto implica ajustar el peso de distintos subconjuntos de los datos de entrenamiento de forma que las categorías infrarrepresentadas (es decir, las categorías con pocos ejemplos) en los datos de entrenamiento tengan el mismo peso que otras categorías.

- Seguimiento continuo: Los modelos se reentrenan periódicamente con nuevos conjuntos de datos. Además, el comportamiento de las futuras versiones está influido por las interacciones pasadas del modelo con los usuarios. El comportamiento del usuario también cambia en función de la exposición e interacción prolongadas con modelos de IA. Por tanto, la detección y eliminación de sesgos no es una tarea que se realice una sola vez. Tiene que formar parte del ciclo de desarrollo del modelo.

Retos para lograr la superalineación

Como hemos explicado en las secciones anteriores, conseguir la superalineación es un reto. Algunas de las principales dificultades son

- Complejidad y escala de los modelos: Los modelos modernos de IA tienen miles de millones de parámetros. Esto hace que sea difícil predecir sus respuestas o comprender su proceso de toma de decisiones desde los primeros principios. Por lo tanto, garantizar que el modelo esté en consonancia con los valores humanos es todo un reto. Pequeñas actualizaciones de los parámetros del modelo pueden perturbar su alineación.

- Escalabilidad de las técnicas de alineación: La supervisión humana es fundamental en el proceso de alineación. A medida que los modelos crecen en alcance y utilidad, necesitan alinearse en más y más escenarios. Esto plantea cuestiones sobre la eficacia y la economía con que los humanos pueden supervisar los esfuerzos de alineación del modelo.

- Generalización y robustez: Los modelos de IA manejan rutinariamente nuevos escenarios y entradas novedosas. Por otra parte, el entrenamiento y la alineación del modelo se basan en un conjunto amplio pero limitado de datos y escenarios de entrenamiento. El modelo debe ser capaz de ampliar su alineación a escenarios que no se hayan cubierto explícitamente durante la formación. Debe ser capaz de distinguir los casos límite y comportarse éticamente en nuevas circunstancias.

- Desajuste de valores: La IA no tiene una comprensión nativa de los valores humanos. Sólo aprende en función de su entrenamiento. Los valores humanos son complejos y a veces contradictorios. Lo que sería perfectamente aceptable en una situación podría ser completamente inapropiado en otra. La desalineación puede producirse cuando el modelo entiende los valores de forma distinta a la prevista. Esto puede dar lugar a respuestas inadecuadas y a un comportamiento potencialmente poco ético.

- Cumplimiento de la normativa: Los organismos nacionales y supranacionales están empezando a establecer normas reguladoras y jurídicas para garantizar que los potentes modelos de IA no obstaculicen el interés público. Cumplir esta nueva normativa requerirá un esfuerzo adicional por parte de los desarrolladores de modelos.

- Integración con otros sistemas informáticos: La mayoría de los esfuerzos de alineación se centran en la interacción directa entre el ser humano y la IA. Surgen nuevos retos cuando la IA se integra con otros sistemas. Las entradas y salidas de la IA en estos sistemas integrados ya no se basan en lenguajes humanos. Esto dificulta la interpretación de las respuestas de la IA. Garantizar la superalineación de un sistema informático complejo que incluya IA presenta retos imprevistos. Una posibilidad es confiar todo el sistema integrado a otra IA, que ayude a los humanos a comprenderlo y supervisarlo.

- Seguimiento y actualización: Es necesario supervisar continuamente las respuestas del modelo para garantizar que actúa éticamente en la práctica. Esto suele hacerse muestreando aleatoriamente la salida del modelo con entradas de la vida real. La actualización de los parámetros del modelo también puede alterar su alineación. Por tanto, la alineación debe mantenerse y actualizarse como parte del ciclo de vida de desarrollo del modelo.

Conclusión

Un sistema de IA que no esté alineado con los valores humanos y la ética es inadecuado para el uso público. De hecho, podría tener consecuencias perjudiciales.

En este artículo hablamos de la superalineación, un conjunto de métodos y enfoques utilizados para alinear sistemas de IA grandes y potentes. Además, exploramos la superalineación en el contexto de los LLM. Por último, como la superalineación es un campo en evolución, abordamos los principales retos asociados a su aplicación.

Obtén una certificación superior en IA

Preguntas frecuentes

¿En qué se diferencia la superalineación de la alineación?

Conceptualmente, son similares, pero difieren en su alcance. La alineación se refiere a que los sistemas de IA tengan en cuenta la intención del usuario, actúen según el contexto y estén libres de prejuicios.

El término "superalineación" se refiere a los modelos de IA a gran escala que están alineados no sólo con la intención y el contexto, sino también, de forma más amplia, con los valores humanos, la moral y la ética.

El quid de la diferencia reside en los métodos utilizados. La alineación puede conseguirse mediante métodos más sencillos basados en reglas, que son inadecuados para la superalineación.

¿En qué se diferencia la alineación de la formación?

El entrenamiento del modelo se basa en minimizar el valor de la función de pérdida. La alineación va más allá de la formación. Garantiza que el modelo entrenado actúe de acuerdo con las intenciones, los valores y la ética humanos.

Si los datos de entrenamiento están sesgados, el modelo resultante también lo estará. El modelo no actúa conforme a normas éticas. La alineación consiste en corregir el modelo para tener en cuenta las deficiencias del proceso de entrenamiento.

¿Todo superalineamiento implica esfuerzos humanos?

Dado el enorme volumen de entradas y salidas de los modelos de IA, la supervisión manual no siempre es posible. Es más pragmático adoptar enfoques automatizados y programáticos para auditar y controlar el comportamiento de la IA. Por supuesto, la intervención humana es necesaria en los casos límite.

¿Es estrictamente necesaria la superalineación? ¿No basta con un modelo entrenado?

Para los modelos de cara al público a gran escala, sí, es estrictamente necesario. Cuando se da un uso práctico a los resultados de los modelos de IA, éstos deben ajustarse a las mismas normas éticas y morales que tendría un ser humano. Los conjuntos de datos de entrenamiento, por defecto, contienen diversos sesgos que luego se reflejan en el modelo entrenado. Por tanto, el modelo entrenado debe estar alineado con los valores y las normas humanas.

¿Existen módulos de superalineación o paquetes de software que pueda utilizar?

La superalineación sigue siendo un problema sin resolver y se están estudiando muchos enfoques diferentes. Los investigadores de IA experimentan con distintas técnicas adecuadas a sus modelos. Por ello, no existen módulos de producción populares para la superalineación.