Curso

Como todos os modelos de aprendizado de máquina, os sistemas de IA são treinados para minimizar uma função de erro. O treinamento adequado é necessário, mas não suficiente, para que um modelo de IA seja integrado ao dia a dia dos usuários e aos fluxos de trabalho das organizações.

Para que as interações entre humanos e IA sejam bem-sucedidas, os modelos de IA devem ser capazes de responder decifrando a intenção do usuário e agindo de acordo com as diretrizes de segurança e justiça. Por exemplo, um chatbot deve se abster de dar instruções para prejudicar a si mesmo ou a outros, e um modelo para auxiliar recrutadores não deve discriminar entre candidatos.

Os sistemas de IA estão se tornando mais poderosos e integrados à vida cotidiana. Assim, os desenvolvedores devem garantir que o comportamento da IA em escala siga a ética, os valores e a moral humanos. Isso é chamado de superalinhamento. O curso AI Ethics aborda os detalhes dos aspectos éticos da IA.

Neste artigo, explicamos o superalinhamento de modelos de IA, discutimos diferentes métodos para obter o superalinhamento para modelos de IA em geral e LLMs em particular, e abordamos as considerações éticas e os desafios práticos do superalinhamento.

Alinhamento de IA: Uma visão geral rápida

O alinhamento refere-se ao processo e aos métodos para garantir que um sistema de IA se comporte de acordo com a intenção do usuário, de maneira livre de preconceitos e seguindo as diretrizes de segurança. Este artigo explica os conceitos e métodos usados no alinhamento.

Além da supervisão humana, os desenvolvedores adotam métodos como filtragem e sistemas baseados em regras para garantir o alinhamento dos sistemas de IA. As técnicas usadas para alinhar um modelo com uma pequena base de usuários tornam-se impraticáveis quando aplicadas a um modelo mais poderoso e popular. Por exemplo:

- A filtragem de conteúdo usa algoritmos para garantir que o modelo não produza conteúdo prejudicial. Esses algoritmos filtram o conteúdo indesejável, como linguagem imprópria e imagens explícitas. No entanto, eles estão limitados ao que o algoritmo filtra e não podem proteger contra novos tipos de conteúdo indesejável.

- Os sistemas baseados em regras usam um conjunto de regras predefinidas para evitar casos de uso indesejáveis, como instruções para prejudicar a si mesmo ou a outros. No entanto, eles não podem se adaptar a comportamentos inesperados de usuários ou modelos de IA.

- Os métodos tradicionais de atenuação de distorção, como a reponderação dos dados de treinamento, são eficazes para evitar distorções conhecidas. Ainda assim, eles podem ser insuficientes para detectar vieses novos e mais sutis que surgem quando sistemas complexos de IA são usados em novos contextos.

Assim, modelos avançados de IA que funcionam em uma escala maior e com um escopo mais amplo precisam de uma nova abordagem para o alinhamento. Isso é chamado de superalinhamento.

O que é superalinhamento?

O escopo, a escala, a complexidade e o uso generalizado de modelos avançados de IA levam a um conjunto totalmente novo de desafios de alinhamento.

Métodos e abordagens para alinhar modelos de IA em larga escala a valores humanos, ética e moral são cobertos pelo superalinhamento. Ela abrange muitas subáreas.

Em geral, os sistemas superalinhados devem:

- Busque ativamente a colaboração humana para permanecer alinhado além do alinhamento inicial.

- Alinhe-se e realinhe-se continuamente para levar em conta novos casos de uso e valores humanos não escritos. Esse é o pipeline de alinhamento.

- Explique suas ações e atualize suas respostas com base no feedback humano.

O superalinhamento é um campo em evolução. Ele aborda os modelos atuais de IA de última geração e considera métodos para modelos de IA ainda mais avançados que deverão ser desenvolvidos.

À medida que a IA se torna mais poderosa, espera-se que ela gerencie muitos aspectos da vida humana, como agricultura, transporte e muito mais. Esse sistema de IA deve sempre priorizar os interesses dos seres humanos acima de todas as outras considerações.

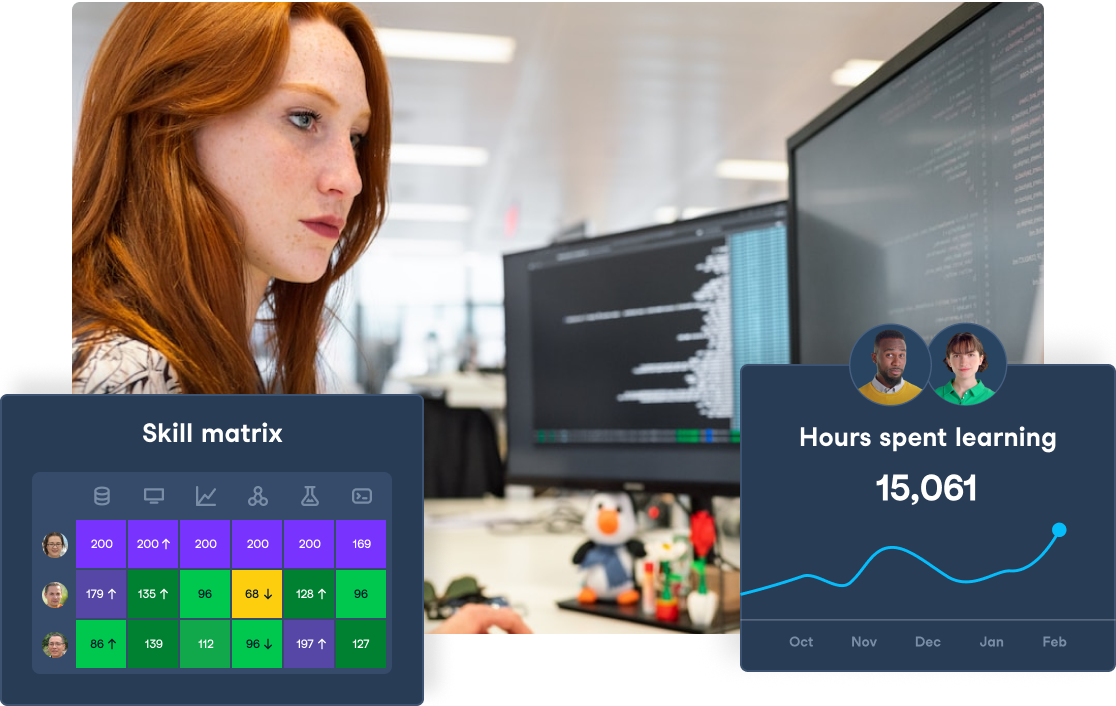

Melhore as habilidades de IA da sua equipe

Transforme seus negócios capacitando sua equipe com habilidades avançadas de IA por meio do DataCamp for Business. Obtenha melhores insights e eficiência.

Técnicas para alcançar o superalinhamento

Nesta seção, explicamos alguns dos métodos e técnicas usados para obter o superalinhamento. A filosofia subjacente a essas abordagens é que elas devem ser escalonáveis.

Treinamento contraditório

No alinhamento, como em qualquer treinamento, os desenvolvedores devem testar se o sistema aprendeu a demonstrar os comportamentos desejados. Uma maneira de testar o superalinhamento é apresentar à IA contraexemplos. Os grandes sistemas de IA devem ser treinados para identificar quais solicitações não são feitas de boa-fé e tratá-las adequadamente.

Uma abordagem comum para o superalinhamento é usar duas IAs como adversários. Isso é análogo à abordagem da equipe vermelha e da equipe azul comumente usada em pesquisas de segurança, em que a equipe vermelha tenta penetrar na segurança e nas defesas da equipe azul.

No contexto do treinamento contraditório para superalinhamento, cada IA tenta encontrar entradas que confundam a outra IA. Por exemplo, considere uma IA (equipe azul) que tenha sido alinhada para não responder com palavrões. No treinamento contraditório, o objetivo da IA adversária (equipe vermelha) é encontrar prompts que acionem a IA da equipe azul para dar respostas inadequadas. O objetivo é garantir que, mesmo quando testada pela IA da equipe vermelha, a IA da equipe azul continue a gerar respostas aceitáveis.

Ilustração do conceito de treinamento contraditório. Imagem criada com DALL-E

Treinamento de robustez

A robustez refere-se à capacidade de distinguir entre entradas que são realmente diferentes, mas que superficialmente parecem semelhantes. Ele deve ser capaz de reconhecer os casos extremos e os casos extremos. Por exemplo, um sistema para identificar ações humanas em clipes de vídeo deve ser capaz de distinguir uma briga de rua real de uma briga coreografada em um filme. Se você confundir um com o outro, poderá ter consequências prejudiciais.

Assim, modelos grandes devem ser especificamente expostos a cenários superficialmente semelhantes. Isso ensinará o modelo a reconhecer nuances e recursos sutis.

Supervisão escalonável

À medida que os modelos de IA encontram novos usuários e são usados em mais aplicativos, sua supervisão precisa ser dimensionada em paralelo. O envolvimento humano é o ponto crucial da supervisão e do alinhamento da IA. Ampliar a supervisão humana é mais difícil do que ampliar uma solução tecnológica. Portanto, para manter uma supervisão escalonável da IA, são necessários novos métodos:

- Monitoramento automatizado em tempo real: Os sistemas automatizados podem rastrear continuamente as respostas da IA e monitorar seu comportamento para verificar se ele está em conformidade com os valores humanos. Desvios significativos dos padrões esperados podem ser sinalizados para intervenção humana.

- Revisões programáticas: É possível revisar e auditar manualmente todos os resultados de IA. Isso pode ser feito por meio do desenvolvimento de novos programas e algoritmos que verifiquem o alinhamento da IA com a ética humana. Casos duvidosos podem ser sinalizados para que moderadores humanos julguem manualmente.

Aprendizagem por reforço com feedback humano (RLHF)

Conforme discutido no artigo sobre aprendizagem por reforço (RL), nas implementações tradicionais de RL, o sistema de IA aprende a modificar seu comportamento observando um ser humano. Ele usa um processo de tentativa e erro para maximizar a recompensa. A RLHF combina a RL com informações humanas para orientar as ações da IA durante o treinamento.

O RLHF começa com um modelo pré-treinado. Os revisores humanos atribuem ao modelo um conjunto de tarefas e fornecem feedback sobre os resultados, como a classificação ou a correção das respostas do modelo.

O modelo usa as informações para ajustar seu comportamento de modo a se alinhar com o feedback humano e maximizar a recompensa (feedback humano positivo). Esse processo é repetido até que os resultados do modelo sejam considerados relevantes, apropriados e precisos.

Aprendizagem por reforço inverso (IRL)

No aprendizado por reforço (RL) tradicional, os desenvolvedores do modelo declaram explicitamente a função de recompensa (também chamada de função de utilidade). O objetivo do modelo é maximizar o incentivo de acordo com essa função de recompensa.

Na RL inversa, o modelo infere a função de recompensa com base no comportamento de um modelo treinado ou de um ser humano. Por exemplo, um carro autônomo baseado em RL pode receber incentivos positivos para dirigir na faixa, parar em sinais vermelhos, etc. Um sistema de direção autônoma baseado em IRL descobre os incentivos observando de perto e seguindo as ações de um motorista humano experiente ou de uma IA treinada.

Os valores humanos não podem ser listados explicitamente para todos os contextos, o que dificulta a RL tradicional para problemas de alinhamento.

Uma abordagem mais eficaz é fazer com que a IA observe e replique o comportamento humano em diferentes contextos. Ao observar o comportamento humano, a IA aprende quais das diferentes respostas possíveis (ou cursos de ação) são mais semelhantes a como um ser humano pode agir naquele cenário. Isso ajuda a alinhar o comportamento da IA com os valores humanos.

Ilustração do conceito de aprendizado por reforço inverso. Imagem criada com DALL-E

Debate

Muitos métodos de alinhamento envolvem um humano treinando a IA sobre qual comportamento é aceitável e qual não é, mas usar um humano nem sempre é a solução ideal.

Para muitos problemas complexos, como a programação ideal de um sistema nacional de trens, nenhum ser humano pode ser capaz de julgar se uma solução proposta é a melhor. Uma solução é aproveitar a própria IA para o superalinhamento. No método de debate:

- Uma IA propõe uma solução e fornece uma explicação detalhada de cada etapa.

- A mesma IA ou uma IA diferente é então usada para criticar (fornecer argumentos contra) cada explicação.

- Um ser humano decide qual argumento é o mais correto. Como cada argumento tem um escopo limitado, é mais fácil para os humanos julgarem sua validade.

O processo de raciocínio lógico torna-se gamificado, e o argumento mais válido vence. Assim, em uma série de debates, a IA aprende quais linhas de raciocínio são aceitáveis e quais não são. Para tarefas futuras, o resultado da IA está mais alinhado com os valores humanos.

Amplificação iterada

Nos sistemas tradicionais de aprendizado de máquina e aprendizado profundo, o treinamento se baseia no fato de o resultado do modelo corresponder ao resultado esperado.

À medida que os recursos da IA aumentam, ela será usada para tarefas cada vez mais complexas. Em muitas dessas tarefas, os seres humanos não sabem antecipadamente o resultado esperado. As únicas opções podem ser as soluções geradas pela IA. Para essas tarefas complexas, alinhar a IA com base no resultado final é difícil porque os humanos não podem julgar o resultado final.

Por exemplo, ao projetar uma programação de transporte, o sistema deve equilibrar a viabilidade financeira com o fornecimento de um serviço público útil. Muitas dessas considerações dificultam a determinação do projeto final do sistema que melhor se alinha aos valores humanos.

Nesses casos, é mais fácil aproveitar a supervisão humana para garantir o alinhamento em subtarefas menores. Posteriormente, no processo, tarefas um pouco maiores são divididas em subtarefas menores e, em seguida, alinhadas sob supervisão humana. Esse processo continua de forma iterativa até que as tarefas se tornem grandes demais para serem avaliadas diretamente por humanos.

A amplificação iterada pressupõe que, como as subtarefas menores e mais simples foram alinhadas com base na validação humana, a tarefa principal maior também está alinhada. Isso é chamado de amplificação iterativa. A amplificação iterada também é aplicada em combinação com técnicas como o debate.

Valorizar o aprendizado

As interações humanas são complexas e cheias de nuances. Em muitos casos, as ações humanas são ambíguas quando consideradas isoladamente - elas só fazem sentido no contexto certo. Assim, as funções de utilidade tradicionais e o aprendizado por reforço são inadequados para imbuir a IA de valores humanos.

Uma alternativa proposta é que o modelo tenha acesso a um conjunto de funções de utilidade em vez de uma única função de utilidade. É provável que cada função de utilidade seja escolhida, dependendo do contexto. O modelo aprende a escolher a função de utilidade correta observando as ações humanas em diferentes contextos. Isso é chamado de aprendizado de valor.

O aprendizado de valor é uma técnica na qual a IA observa diretamente o comportamento humano em diferentes cenários e aprende o comportamento correto para cada contexto. Isso envolve expor a IA ao comportamento humano por meio de uma ampla variedade de interações na vida real.

Ilustração do conceito de aprendizagem de valores. Imagem criada com DALL-E

Os humanos no treinamento de alinhamento devem se comportar de uma maneira considerada aceitável. Por exemplo, um ser humano dirigindo um carro não deve se deixar levar pela raiva na estrada ao tentar alinhar uma IA. No entanto, quando estiver preso atrás de um motorista lento, o ser humano deve tentar ultrapassar com segurança o veículo mais lento.

Superalinhamento em modelos de idiomas grandes (LLMs)

Atualmente, os LLMs são os modelos de IA em larga escala mais populares. Eles são usados em uma ampla variedade de tarefas. Considerando sua grande base de usuários e casos de uso, o superalinhamento no contexto dos LLMs merece uma análise mais detalhada.

LLMs e desafios de alinhamento

Grandes modelos de linguagem, como GPT-4, Gemini e Meta AI, estão começando a ser usados na vida cotidiana. Devido à sua escala e escopo, os LLMs apresentam novos desafios de alinhamento, como

- Perpetuação de preconceitos: Esses modelos foram treinados em grandes quantidades de dados obtidos na Internet aberta e em outras bibliotecas. Quaisquer vieses nos dados de treinamento são refletidos diretamente nos resultados do modelo. O viés devido a deficiências nos dados de entradaa é considerado viés algorítmico.

- Sistemas complexos: O grande tamanho desses modelos, a vastidão de seus dados de treinamento e a grande variedade de casos de uso tornam difícil prever o comportamento do sistema. Isso dificulta a garantia de que o resultado do modelo esteja alinhado com os valores humanos para todos os casos de uso.

- Problemas de escala: Dada a sua vasta base de usuários e o grande número de consultas que eles processam:

- Mesmo que a porcentagem de respostas não alinhadas aos valores humanos seja pequena, ela ainda se traduz em um grande número.

- Torna-se difícil garantir que o comportamento da IA se alinhe consistentemente com os valores humanos e a ética de todos os usuários.

Isso faz com que seja necessário adotar novos métodos para testar o nível de alinhamento desses modelos e ajustá-los continuamente para garantir que estejam alinhados com os valores humanos e os padrões éticos.

Avaliação dos resultados do LLM

Muitas abordagens foram propostas e tentaram avaliar os resultados do LLM para garantir o alinhamento com os valores humanos. Esses métodos precisam ser escalonáveis. Alguns exemplos são:

- Filtragem de saída indesejável: Uma abordagem pragmática para eliminar respostas inadequadas por um LLM é usar uma camada de filtragem sobre o modelo de linguagem. O treinamento de sistemas separados para tarefas de geração e filtragem de texto é mais eficiente. O próprio filtro pode ser outra IA que examina a saída do LLM gerador em busca de linguagem inadequada e tópicos sensíveis.

- Detecção de viés: Os conjuntos de dados de treinamento invariavelmente contêm algum viés, o que leva a modelos tendenciosos. Alguns métodos para detectar distorções nos resultados do LLM são:

- Os desenvolvedores de modelos auditam os modelos quanto a resultados tendenciosos. As auditorias de viés envolvem o teste de um modelo com diversas entradas e a comparação da resposta em cada caso.

- Algoritmos especializados de detecção de viés às vezes são usados para procurar e identificar sistematicamente diferentes tipos de viés.

- Verificação de fatos: A alucinação tem sido a desgraça dos LLMs desde o início. Um LLM só sabe como prever quais palavras devem seguir uma sequência de palavras com base no que ele viu no conjunto de dados de treinamento. Ele não tem nenhum conceito de fatos. Para um LLM, a frase "A Dell fabrica computadores pessoais" tem o mesmo significado que "A Dell fabrica batatas fritas". Portanto, ao usar LLMs para gerar textos baseados em fatos, é fundamental verificar se o texto gerado está factualmente correto.

- Explicabilidade: Os sistemas e programas tradicionais de TI são baseados em regras. Você pode depurar o sistema para identificar quais regras são responsáveis por uma determinada saída. Por outro lado, os LLMs têm bilhões de parâmetros. É impossível rastrear quais pesos contribuem para diferentes partes do resultado.

Felizmente, o raciocínio é uma propriedade emergente de grandes modelos de linguagem. Uma propriedade emergente é uma propriedade de um sistema complexo que não pode ser explicada como a soma de suas partes.

Observa-se com frequência que os LLMs são capazes de explicar suas respostas e raciocinar em problemas de várias etapas. Pedir a um LLM que explique uma solução complexa e avaliar manualmente cada etapa pode permitir que os humanos validem a resposta do LLM.

LLMs e interação humana

Os LLMs usados de forma interativa devem compreender as nuances e sutilezas das conversas humanas. Eles devem ser capazes de responder com base no contexto da conversa.

O tom, a intenção, o sarcasmo e os sinais emocionais são difíceis de representar matematicamente. No entanto, os modelos de IA devem levar em conta esses aspectos para se comunicar de forma eficaz com os seres humanos. Somente um LLM que esteja alinhado para ser empático será eficaz na interação com as pessoas. Ele pode criar confiança e promover compromissos produtivos com os seres humanos, e a única maneira de conseguir isso é aplicando várias técnicas de superalinhamento.

Considerações éticas sobre o superalinhamento

O objetivo final do superalinhamento é que a IA poderosa esteja em conformidade com os padrões éticos da sociedade humana.

Esta seção explica a função da ética no superalinhamento e os desafios associados à garantia do comportamento ético em modelos de grande porte.

Garantir o comportamento ético

Uma IA desalinhada com os valores humanos nunca será segura para ser usada por humanos. Um sistema desalinhado pode produzir conteúdo prejudicial que pode ser usado indevidamente por agentes malignos. Ela pode perpetuar as desigualdades sociais e ampliar os preconceitos existentes.

Na pior das hipóteses, um sistema desalinhado pode fazer mau uso dessa capacidade e levar a um comportamento manipulador. Portanto, as preocupações éticas estão no centro de todos os esforços de superalinhamento. Somente garantindo o comportamento ético em todas as circunstâncias é que as ferramentas de IA podem ser consideradas confiáveis para uso generalizado e de longo prazo.

Equilíbrio entre utilidade e segurança

A incorporação do comportamento ético nos sistemas de IA tem um custo significativo. Para obter o superalinhamento, os desenvolvedores de modelos precisam:

- Humanos para auditar as respostas e fornecer feedback para a IA

- Tempo adicional para garantir o superalinhamento antes de liberar o modelo

- Recursos computacionais adicionais para ajustar e alinhar o modelo

Além disso, durante a execução da inferência, o modelo precisa realizar cálculos adicionais para garantir que suas respostas estejam alinhadas com os valores humanos. Às vezes, impor o alinhamento como uma restrição pode limitar os recursos do modelo. Assim, um modelo superalinhado pode ter menos desempenho.

Portanto, deve haver um equilíbrio entre o desempenho técnico do modelo e as considerações de alinhamento. Priorizar o alinhamento e as considerações de segurança em relação às métricas de desempenho tradicionais pode levar a modelos que não são muito úteis na prática.

Equidade e preconceito

Os modelos de IA em grande escala têm muitos usuários e casos de uso variados. Qualquer viés presente no resultado do modelo pode ter consequências de longo alcance. Portanto, os desenvolvedores devem cuidar para que seus modelos sejam o mais livre possível de vieses.

Eliminar o viés dos LLMs é um desafio porque esses modelos passam por treinamento não supervisionado com base em um enorme corpus de dados de texto. A IA capta todos os diferentes vieses e preconceitos presentes no texto do conjunto de dados de treinamento. Isso pode fazer com que o resultado do modelo seja injusto e discriminatório. Os desenvolvedores podem empregar vários métodos para resolver isso:

- Detecção de viés: Antes de poder tomar contramedidas, você deve primeiro identificar os casos de comportamento tendencioso. Auditorias regulares e avaliações de imparcialidade em amostras de resultados do modelo podem ajudar a identificar os tipos de tendências que o modelo apresenta e as situações que desencadeiam essas tendências.

- Eliminação de preconceitos: Há três abordagens principais para eliminar o viés:

- Programar o modelo para corrigir distorções específicas no resultado.

- Aprimorar o conjunto de dados de treinamento, complementando-o com dados sintéticos. Por exemplo, se o conjunto de dados de treinamento de um sistema de reconhecimento de imagens tiver muito poucos animais de uma determinada espécie, isso reduzirá a probabilidade marginal de identificação desse animal. Isso geralmente é resolvido aumentando o conjunto de dados de treinamento com imagens geradas sinteticamente dessa espécie e/ou aumentando seu peso no processo de treinamento.

- Atualizar os pesos de subconjuntos sub-representados dos dados de treinamento. Isso envolve o ajuste do peso de diferentes subconjuntos dos dados de treinamento, de modo que as categorias sub-representadas (ou seja, categorias com poucos exemplos) nos dados de treinamento tenham o mesmo peso que outras categorias.

- Monitoramento contínuo: Os modelos são periodicamente retreinados em novos conjuntos de dados. Além disso, o comportamento de versões futuras é influenciado pelas interações anteriores do modelo com os usuários. O comportamento do usuário também muda com base na exposição prolongada e na interação com modelos de IA. Portanto, a detecção e a eliminação de preconceitos não é uma tarefa única. Ele precisa se tornar parte do ciclo de desenvolvimento do modelo.

Desafios para alcançar o superalinhamento

Como explicamos nas seções anteriores, alcançar o superalinhamento é um desafio. Algumas das principais dificuldades são:

- Complexidade e escala dos modelos: Os modelos modernos de IA têm bilhões de parâmetros. Isso dificulta a previsão de suas respostas ou a compreensão de seu processo de tomada de decisão a partir dos primeiros princípios. Assim, garantir que o modelo esteja consistentemente alinhado com os valores humanos é um desafio. Pequenas atualizações nos parâmetros do modelo podem perturbar seu alinhamento.

- Escalabilidade das técnicas de alinhamento: A supervisão humana é fundamental para o processo de alinhamento. À medida que os modelos crescem em escopo e usabilidade, eles precisam ser alinhados em cada vez mais cenários. Isso levanta questões sobre a eficácia e a economia com que os seres humanos podem supervisionar os esforços de alinhamento do modelo.

- Generalização e robustez: Os modelos de IA lidam rotineiramente com novos cenários e novas entradas. O treinamento e o alinhamento do modelo, por outro lado, baseiam-se em um conjunto grande, porém limitado, de dados e cenários de treinamento. O modelo precisa ser capaz de estender seu alinhamento a cenários que não foram explicitamente abordados durante o treinamento. Ele deve ser capaz de distinguir entre casos extremos e se comportar eticamente em novas circunstâncias.

- Desalinhamento de valores: A IA não tem uma compreensão nativa dos valores humanos. Ele só aprende com base em seu treinamento. Os valores humanos são complexos e, às vezes, contraditórios. O que seria perfeitamente aceitável em uma situação pode ser completamente inadequado em outra. O desalinhamento pode ocorrer quando o modelo entende os valores de forma diferente da pretendida. Isso pode levar a respostas inadequadas e a um comportamento potencialmente antiético.

- Conformidade regulatória: Órgãos nacionais e supranacionais estão começando a definir padrões regulatórios e legais para garantir que modelos poderosos de IA não prejudiquem o interesse público. A conformidade com esses novos regulamentos exigirá um esforço adicional dos desenvolvedores de modelos.

- Integração com outros sistemas de TI: A maioria dos esforços de alinhamento está centrada na interação direta entre humanos e IA. Novos desafios surgem quando a IA é integrada a outros sistemas. As entradas e saídas da IA em tais sistemas integrados não são mais baseadas em linguagens humanas. Isso dificulta a interpretação das respostas da IA. Garantir o superalinhamento de um sistema de TI complexo, incluindo IA, apresenta desafios imprevistos. Uma possibilidade é confiar todo o sistema integrado a outra IA, que ajuda os humanos a entender e monitorar o sistema.

- Monitoramento e atualização: O monitoramento contínuo das respostas do modelo é necessário para garantir que ele aja de forma ética na prática. Normalmente, isso é feito por meio de amostragem aleatória da saída do modelo para entradas reais. A atualização dos parâmetros do modelo também pode perturbar seu alinhamento. Portanto, o alinhamento precisa ser mantido e atualizado como parte do ciclo de vida do desenvolvimento do modelo.

Conclusão

Um sistema de IA que não esteja alinhado aos valores humanos e à ética não é adequado para uso público. Na verdade, isso pode ter consequências prejudiciais.

Neste artigo, discutimos o superalinhamento, um conjunto de métodos e abordagens usados para alinhar sistemas de IA grandes e avançados. Além disso, exploramos o superalinhamento no contexto dos LLMs. Por fim, como o superalinhamento é um campo em evolução, abordamos os principais desafios associados à sua implementação.

Obtenha uma das melhores certificações de IA

Perguntas frequentes

Como o superalinhamento é diferente do alinhamento?

Conceitualmente, eles são semelhantes, mas diferem no escopo. O alinhamento refere-se aos sistemas de IA que consideram a intenção do usuário, agem de acordo com o contexto e são livres de preconceitos.

O termo "superalinhamento" refere-se a modelos de IA em larga escala que estão alinhados não apenas com a intenção e o contexto, mas também, de forma mais ampla, com os valores humanos, a moral e a ética.

O ponto crucial da diferença está nos métodos usados. O alinhamento pode ser obtido usando métodos mais simples baseados em regras, que são inadequados para o superalinhamento.

Como o alinhamento é diferente do treinamento?

O treinamento do modelo é baseado na minimização do valor da função de perda. O alinhamento vai além do treinamento. Ele garante que o modelo treinado aja de acordo com as intenções, os valores e a ética humanos.

Se os dados de treinamento forem tendenciosos, o modelo resultante também será tendencioso. O modelo não age de acordo com os padrões éticos. O alinhamento envolve a correção do modelo para levar em conta as deficiências do processo de treinamento.

Todo superalinhamento envolve esforços humanos?

Dado o enorme volume de entradas e saídas dos modelos de IA, a supervisão manual nem sempre é possível. É mais pragmático adotar abordagens automatizadas e programáticas para auditar e monitorar o comportamento da IA. É claro que a intervenção humana é necessária em casos extremos.

O superalinhamento é estritamente necessário? Um modelo treinado não é suficiente?

Para modelos de grande escala voltados para o público, sim, é estritamente necessário. Quando o resultado dos modelos de IA é colocado em uso prático, ele deve estar em conformidade com os mesmos padrões éticos e morais que um ser humano teria. Os conjuntos de dados de treinamento, por padrão, contêm várias tendências que são refletidas no modelo treinado. Portanto, o modelo treinado deve estar alinhado com os valores e padrões humanos.

Existem módulos de superalinhamento ou pacotes de software que eu possa usar?

O superalinhamento ainda é um problema não resolvido, com muitas abordagens diferentes sendo estudadas. Os pesquisadores de IA experimentam diferentes técnicas adequadas aos seus modelos. Dessa forma, não há módulos populares de nível de produção para superalinhamento.