programa

Imagina que intentas enseñar a un ordenador la diferencia entre una manzana y una naranja. Para nosotros es fácil de comprender, pero para una máquina diseñada para entender sólo números, es un reto complejo.

Aquí es donde entran en juegolas incrustaciones vectoriales. Estos trucos de magia matemática transforman palabras, imágenes y otros datos en representaciones numéricas que los ordenadores pueden comprender y manipular fácilmente.

Las incrustaciones vectoriales abren un universo de posibilidades al mapear el mundo de la información en un espacio numérico.

¿Qué son las incrustaciones vectoriales?

Las incrustaciones vectoriales son huellas digitales de palabras u otros datos. En lugar de utilizar letras o imágenes, utilizan números dispuestos en una estructura específica llamada vector, que es como una lista ordenada de valores.

Imagina cada vector como un punto en un espacio multidimensional, donde su ubicación conlleva información vital sobre la palabra o los datos representados.

Puede que recuerdes los vectores de tus clases de matemáticas como flechas con dirección y magnitud. Aunque las incrustaciones vectoriales comparten este concepto fundamental, operan en espacios con innumerables dimensiones.

Esta dimensionalidad extrema es esencial para captar los complicados matices del lenguaje humano, como el tono, el contexto y los rasgos gramaticales. Imagina un vector que no sólo diferencie entre "feliz" y "triste", sino también variaciones sutiles como "extático", "contento" o "melancólico".

Las incrustaciones vectoriales son una técnica valiosa para transformar datos complejos en un formato adecuado para los algoritmos de aprendizaje automático. Al convertir los datos categóricos y de alta dimensión en representaciones continuas de menor dimensión, las incrustaciones mejoran el rendimiento del modelo y la eficiencia computacional, al tiempo que preservan los patrones de datos subyacentes.

Para que veas de forma simplificada cómo podría definirse un espacio vectorial multidimensional, aquí tienes una tabla con ocho dimensiones ejemplares y su respectivo rango de valores:

|

Función |

Descripción |

Gama |

|

Concreción |

Una medida de lo tangible o abstracta que es una palabra |

0 a 1 |

|

Valencia emocional |

La positividad o negatividad asociada a la palabra |

-1 a 1 |

|

Frecuencia |

Con qué frecuencia aparece la palabra en un corpus de texto amplio |

0 a 1 |

|

Longitud |

El número de caracteres de la palabra |

0 a 1 |

|

Parte de la oración |

Conjunto de valores codificados de un solo golpe que representan sustantivo, verbo, adjetivo, otros |

4x [0,1] |

|

Formalidad |

El nivel de formalidad asociado a la palabra |

0 a 1 |

|

Especificidad |

Lo específica o general que es la palabra |

0 a 1 |

|

Asociación sensorial |

El grado en que la palabra se asocia a experiencias sensoriales |

0 a 1 |

Por ejemplo, la palabra "gato" podría tener un vector como éste [0,9, 0,2, 0,7, 0,3, 1, 0, 0, 0, 0,4, 0,8, 0,9] y "libertad" podría ser: [0.1, 0.8, 0.6, 0.7, 1, 0, 0, 0, 0.7, 0.3, 0.2].

Relaciones entre palabras

Cada vector es como un identificador único que no sólo encierra el significado de una palabra, sino que también refleja cómo esta palabra se relaciona con otras. Las palabras con definiciones similares suelen tener vectores próximos en este espacio numérico, como puntos vecinos en un mapa. Esta proximidad revela las conexiones semánticas entre las palabras.

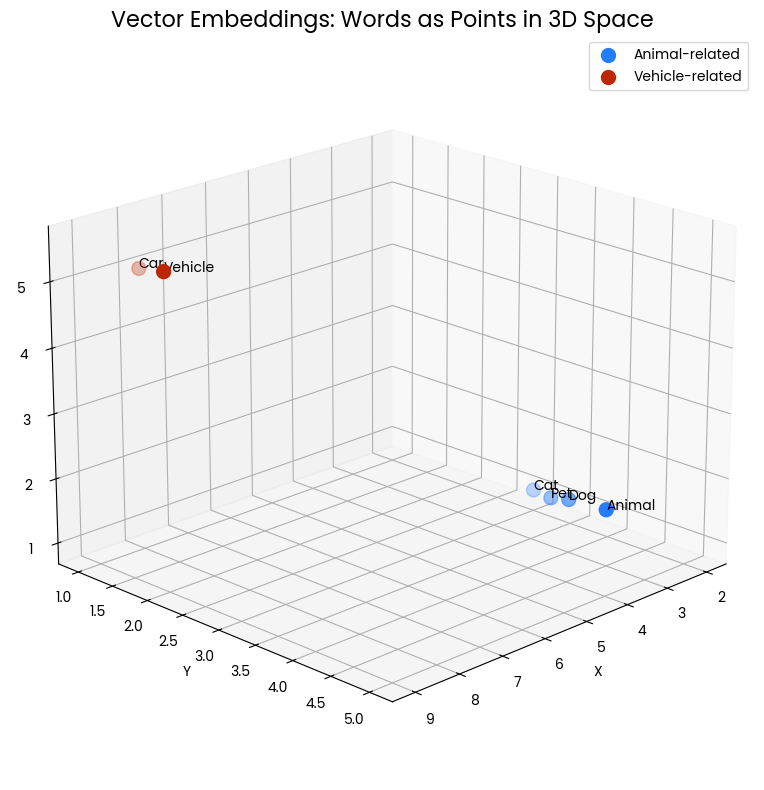

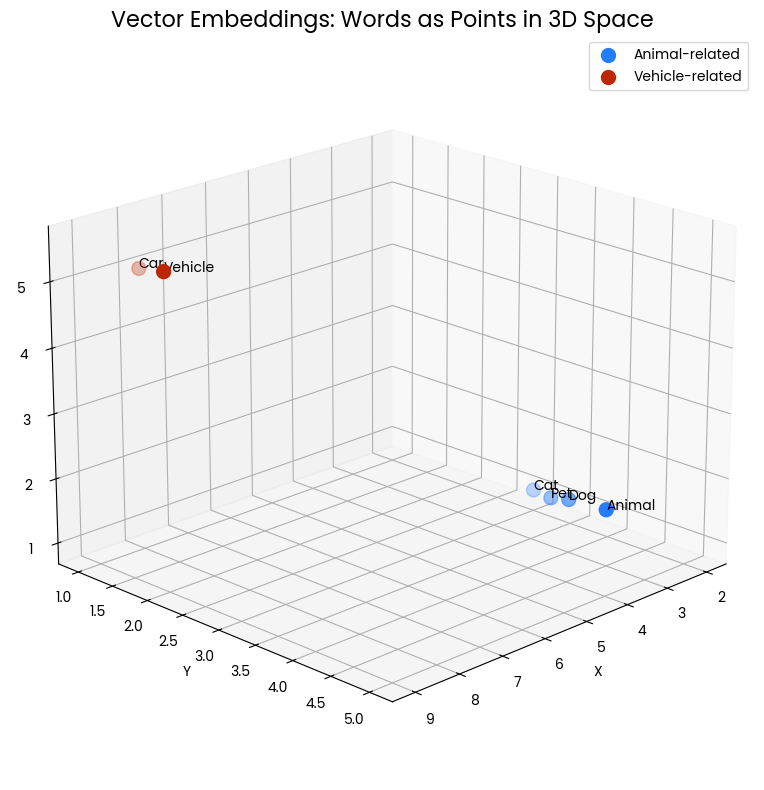

El siguiente gráfico de dispersión en 3D visualiza el concepto de incrustación vectorial de las palabras. Cada punto del espacio representa una palabra, cuya posición viene determinada por su incrustación vectorial. Los puntos azules agrupados representan palabras relacionadas con animales ("Gato", "Perro", "Mascota", "Animal"), mientras que los puntos rojos representan palabras relacionadas con vehículos ("Coche", "Vehículo"). La proximidad de los puntos indica similitud semántica: las palabras con significados relacionados se sitúan más cerca en este espacio vectorial.

Figura 1: Dos grupos de palabras dentro de un espacio tridimensional. La proximidad indica similitud semántica.

Por ejemplo, "Gato" y "Perro" están cerca el uno del otro, lo que refleja sus características compartidas como mascotas comunes. Del mismo modo, "Coche" y "Vehículo" están próximos, mostrando sus significados relacionados. Sin embargo, el grupo de animales está lejos del grupo de vehículos, lo que demuestra que estos grupos de conceptos son semánticamente distintos.

Esta representación espacial nos permite captar visualmente cómo las incrustaciones vectoriales captan y representan las relaciones entre las palabras. Transforma el significado lingüístico en relaciones geométricas que pueden medirse y analizarse matemáticamente.

Cómo captan el significado las incrustaciones vectoriales

Las incrustaciones vectoriales son especialmente comunes en Procesamiento del Lenguaje Natural (PLN)que se centra en representar palabras individuales. Estas representaciones numéricas no se asignan al azar, sino que se aprenden a partir de grandes cantidades de datos de texto. Veamos cómo funciona.

Procesamiento del lenguaje natural mediante Word2Vec

Una de las técnicas de PNL para asignar vectores a las palabras es Word2Vec. Es un modelo de aprendizaje automático que aprende a asociar palabras basándose en su contexto dentro de un gran corpus de texto. Puedes considerarlo como un modelo lingüístico que intenta predecir una palabra basándose en las palabras que la rodean.

Al hacerlo, aprende implícitamente las relaciones entre las palabras, captando información semántica y sintáctica. A continuación, estas relaciones aprendidas se codifican en vectores numéricos, que pueden utilizarse para diversas tareas de PNL. Por último, las palabras que aparecen juntas con frecuencia o en contextos similares tendrán vectores más próximos en el espacio de incrustación.

Word2Vec emplea dos arquitecturas principales para capturar las relaciones entre palabras: Bolsa Continua de Palabras (CBOW) y Skip-gram.

|

Arquitectura |

Procedimiento |

Eficiencia computacional |

Relaciones capturadas |

Sensibilidad a las palabras frecuentes |

|

CBOW |

Predice la palabra objetivo basándose en las palabras contextuales circundantes |

Entrenamiento más rápido |

Capta mejor las relaciones sintácticas (reglas gramaticales) |

Más sensible a las palabras frecuentes |

|

Skip-gram |

Predice las palabras contextuales circundantes basándose en la palabra objetivo |

Entrenamiento más lento |

Mejor captación de las relaciones semánticas (significado del texto) |

Menos sensible a las palabras frecuentes |

Puede que el entrenamiento de Skip-gram sea más lento que el de CBOW, pero en general se considera que su enfoque generativo produce incrustaciones más precisas, sobre todo para las palabras raras.

Veamos un ejemplo: Imagina un vasto corpus de texto. Word2Vec comienza analizando cómo co-ocurren las palabras dentro de una ventana específica de texto. Por ejemplo, considera la frase "El rey y la reina gobernaban el reino". Aquí, "rey" y "reina" aparecen juntos dentro de una pequeña ventana. Word2Vec captura esta información de co-ocurrencia.

A lo largo de innumerables frases, el algoritmo construye un modelo estadístico. Aprende que palabras como "rey" y "reina" aparecen con frecuencia en contextos similares y codifica esta información en vectores numéricos. Como resultado, los vectores de "rey" y "reina" se situarán más cerca en el espacio de incrustación que el vector de "manzana", que rara vez aparece en el mismo contexto.

Esta proximidad en el espacio vectorial refleja la similitud semántica entre "rey" y "reina", lo que demuestra el poder de Word2Vec para captar las relaciones lingüísticas.

Por qué son potentes las incrustaciones vectoriales

Ahora que hemos descubierto qué son las incrustaciones vectoriales y cómo captan el significado, es hora de ir un paso más allá y ver qué tareas permiten.

Como ya hemos visto, las incrustaciones vectoriales son excelentes para cuantificar la similitud semántica. Midiendo la distancia entre los vectores de palabras, podemos determinar lo estrechamente relacionadas que están las palabras en cuanto a significado.

Esta capacidad facilita tareas como la búsqueda de sinónimos y antónimos. Las palabras con definiciones similares tienen vectores agrupados, mientras que los antónimos suelen compartir muchas dimensiones, pero están muy alejados en las dimensiones clave que describen su diferencia.

La magia se extiende a la resolución de complejos rompecabezas lingüísticos. Las incrustaciones vectoriales nos permiten realizar operaciones aritméticas sobre vectores de palabras, descubriendo relaciones ocultas. Por ejemplo, la analogía "el rey es a la reina lo que el hombre es a la mujer" puede resolverse restando el vector de "hombre" a "rey" y sumándolo a "mujer". El vector resultante debería coincidir estrechamente con el vector de "reina", lo que demuestra el poder de las incrustaciones vectoriales para captar patrones lingüísticos.

Incrustación de frases

La versatilidad de las incrustaciones va más allá del ámbito de las palabras individuales. Las incrustaciones de frases captan el significado global de frases enteras. Al representar las frases como vectores densos, podemos medir la similitud semántica entre distintos textos.

Al igual que las incrustaciones de palabras son puntos en un espacio de alta dimensión, las incrustaciones de frases también son vectores. Sin embargo, suelen ser de mayor dimensionalidad para tener en cuenta la mayor complejidad de la información a nivel de frase. Podemos realizar operaciones matemáticas con los vectores resultantes para medir la similitud semántica, lo que permite realizar tareas más complejas como la recuperación de información, la clasificación de textos y el análisis de sentimientos.

Un método sencillo consiste en promediar las incrustaciones de todas las palabras de una frase. Aunque simple, a menudo proporciona una base de referencia decente. Para captar información semántica y sintáctica más compleja, se utilizan técnicas más avanzadas como Redes neuronales recurrentes (RNN) y modelos basados en transformadores transformadores:

|

Arquitectura |

Procesando |

Comprensión contextual |

Eficiencia computacional |

|

RNNs |

Secuencial |

Centrarse en el contexto local |

Menos eficaz para secuencias largas |

|

Modelos basados en transformadores |

En paralelo |

Puede captar dependencias de largo alcance |

Gran eficacia, también para secuencias largas |

Aunque las RNN fueron la arquitectura dominante durante mucho tiempo,los Transformadores las han superado en cuanto a rendimiento y eficacia para muchas tareas de PNL, incluida la generación de frases incrustadas.

Sin embargo, las RNN siguen teniendo su lugar en aplicaciones específicas en las que el procesamiento secuencial es crucial. Además, hay disponibles muchos modelos de incrustación de frases preentrenados, que ofrecen soluciones listas para usar para diversas tareas, como el resumen de textos, la respuesta a preguntas basadas en el conocimiento o el Reconocimiento de Entidades Nombradas (NER).

Más allá del texto

Las incrustaciones vectoriales no se limitan al texto. Las siguientes aplicaciones ponen de relieve el amplio impacto de las incrustaciones en diversos ámbitos:

- Las imágenes pueden transformarse en representaciones numéricas, lo que permite la búsqueda de imágenes, el reconocimiento de objetos y la generación de imágenes.

- Las incrustaciones de productos facilitan las recomendaciones personalizadas en el ámbito del comercio electrónico, encontrando productos similares según las preferencias del usuario y su historial de compras.

- Los datos de audio pueden transformarse en incrustaciones para revolucionar el descubrimiento musical y el reconocimiento del habla.

- Tos datos de series de imágenescomo los precios de las acciones o las lecturas de los sensores, pueden convertirse en incrustaciones para descubrir patrones ocultos y hacer predicciones precisas.

- Los datos gráficoscomo las redes sociales o las bases de conocimiento, pueden representarse como vectores para analizar relaciones complejas y extraer información valiosa.

- Documentos pueden transformarse en incrustaciones para potenciar motores de búsqueda eficientes y la organización inteligente de documentos.

- Los fragmentos de código pueden representarse como incrustaciones, lo que permite sistemas avanzados de búsqueda y recomendación de código.

Usos prácticos de las incrustaciones vectoriales

Ahora que hemos establecido cómo funcionan las incrustaciones vectoriales y qué tipos de datos pueden manejar, podemos examinar casos de uso concretos. Empecemos por uno de los ejemplos más famosos: los grandes modelos lingüísticos (LLM).

LLMs como ChatGPT, Claudo Google Gemini se basan en gran medida en incrustaciones vectoriales como componente fundamental. Estos modelos aprenden a representar palabras, frases e incluso oraciones enteras como vectores densos en un espacio de alta dimensión. Esencialmente, las incrustaciones vectoriales proporcionan a los modelos lingüísticos una comprensión semántica de las palabras y sus relaciones, formando la columna vertebral de sus impresionantes capacidades.

La representación numérica del texto permite a los LLM comprender y generar texto similar al humanopermitiendo tareas como la traducción, el resumen y la respuesta a preguntas. Esto abre un amplio abanico de campos con aplicaciones potenciales, desde la creación de contenidos y la atención al cliente hasta la educación y la investigación.

Más allá de los LLM

Las incrustaciones vectoriales también pueden proporcionar un enfoque alternativo a los motores de búsqueda tradicionales, que a menudo se basan en la concordancia de palabras clave. Sus limitaciones pueden superarse representando tanto las consultas de búsqueda como las páginas web como incrustaciones, lo que ayuda a los motores de búsqueda a comprender el significado semántico de las consultas y las posibles páginas de destino. Esto les permite identificar páginas relevantes más allá de las coincidencias exactas de palabras clave, ofreciendo resultados más precisos e informativos.

Otro punto fuerte de las incrustaciones vectoriales reside en la identificación de puntos de datos o patrones inusuales. Los algoritmos pueden calcular las distancias entre los puntos de datos representados como vectores y marcar los que se alejan significativamente de la norma. Esta técnica encuentra aplicaciones en detección del fraudeseguridad de redes y control de procesos industriales.

Las incrustaciones vectoriales también desempeñan un papel crucial para salvar la brecha lingüística. De forma similar a nuestro ejemplo con "rey" y "reina", los vectores que representan las relaciones semánticas y sintácticas entre las palabras pueden captarse en todas las lenguas. En consecuencia, es posible encontrar las palabras o frases correspondientes en la lengua de destino basándose en su similitud vectorial, lo que ayuda a los sistemas de traducción automática como DeepL a generar traducciones más precisas y fluidas.

Por último, las incrustaciones vectoriales son fundamentales para crear sistemas de recomendación eficaces. Al representar a los usuarios y los objetos como incrustaciones, los sistemas de recomendación pueden identificar usuarios o objetos similares basándose en su proximidad vectorial. Esto permite recomendaciones personalizadas de productos, películas, música y otros contenidos. Por ejemplo, un usuario al que le gusten películas similares a una determinada película probablemente disfrutará de otras películas con incrustaciones similares.

Conclusión

Como puedes ver, las incrustaciones vectoriales se han convertido en una herramienta muy potente. Al transformar datos complejos en un formato fácilmente comprensible para los algoritmos de aprendizaje automático, desbloquean un vasto abanico de posibilidades en diversos campos.

Estos son los puntos clave de este artículo:

- Las incrustaciones vectoriales actúan como huellas digitales de los datos, traduciendo palabras, imágenes e incluso sonidos en representaciones numéricas.

- Estas representaciones capturan relaciones semánticas entre puntos de datos, permitiendo tareas como encontrar elementos similares o descubrir patrones ocultos.

- Técnicas como Word2Vec utilizan grandes cantidades de datos de texto para aprender asociaciones de palabras y codificar estas relaciones en vectores.

- Estos vectores no sólo alimentan los LLM, sino que también permiten obtener resultados más precisos en los motores de búsqueda, las traducciones y los algoritmos de detección del fraude.

- Una comprensión sólida de las incrustaciones vectoriales constituye una base sólida para explorar campos como el procesamiento del lenguaje natural (PLN), la visión por ordenador y los sistemas de recomendación.

Puedes seguir aprendiendo más sobre las incrustaciones vectoriales con estos recursos:

- ¿Qué es la incrustación de texto para la IA? Transformar la PNL con IA

- Introducción a las Bases de Datos Vectoriales para el Aprendizaje Automático

- El poder de las bases de datos vectoriales y la búsqueda semántica con Elan Dekel, vicepresidente de producto de Pinecone

- Las 5 mejores bases de datos vectoriales | Una lista con ejemplos