programa

El panorama de la arquitectura de datos está evolucionando, impulsado por el creciente uso de tecnologías en la nube y la adopción de la pila de datos moderna. Como resultado, los procesos ELT se están utilizando cada vez más. Pero, ¿qué implica exactamente este proceso?

En este artículo exploraremos la ELT y su papel en la arquitectura avanzada de datos.

¿Qué es ELT?

ELT significa Extraer, Cargar, Transformar. Es un proceso de integración de datos que consiste en extraer datos de diversas fuentes, cargarlos en un sistema de almacenamiento de datos y transformarlos en un formato que pueda analizarse fácilmente.

El proceso ELT se utiliza mucho en pila de datos moderna en la que los datos se almacenan, transforman y analizan en un lago o almacén de datos.

¿Cómo funciona la ELT?

Como su nombre indica, el ELT implica tres pasos principales: Extraer, Cargar y Transformar. Examinemos cada paso con más detalle.

1. Extraer

El primer paso del proceso ELT consiste en extraer datos de diversas fuentes, como bases de datos, archivos, API o servicios web. Esto puede hacerse utilizando herramientas como el software ELT o guiones personalizados escritos por desarrolladores.

Algunos ejemplos de plataformas de extracción de datos son Airbyte y Fivetran. Para escribir scripts personalizados, Apache Spark y Python.

Los datos extraídos pueden ser estructurados, semiestructurados o no estructurados, y pueden proceder de distintos tipos de sistemas, como las bases de datos relacionales, bases de datos NoSQLo almacenamiento en la nube.

2. Carga

Una vez extraídos los datos, se cargan en un sistema centralizado de almacenamiento de datos como un lago de datos o un almacén de datos. Este paso consiste en organizar y almacenar los datos extraídos en su formato bruto, sin ninguna transformación.

Los ingenieros de datos suelen participar en este paso, en el que cargan los datos en plataformas como:

Estas plataformas de datos permiten la carga rápida de grandes cantidades de datos y proporcionan una única fuente de verdad para todos los diferentes tipos de datos recogidos de diversas fuentes.

3. Transforma

El último paso del proceso ELT es transformar los datos brutos en un formato optimizado para el análisis y la elaboración de informes. Esto implica limpiar, filtrar, agregar y estructurar los datos de forma adecuada para que puedan trabajar con ellos las herramientas de inteligencia empresarial y análisis.

Los ingenieros de datos o los científicos de datos suelen ser los responsables de este paso, y pueden utilizar herramientas como:

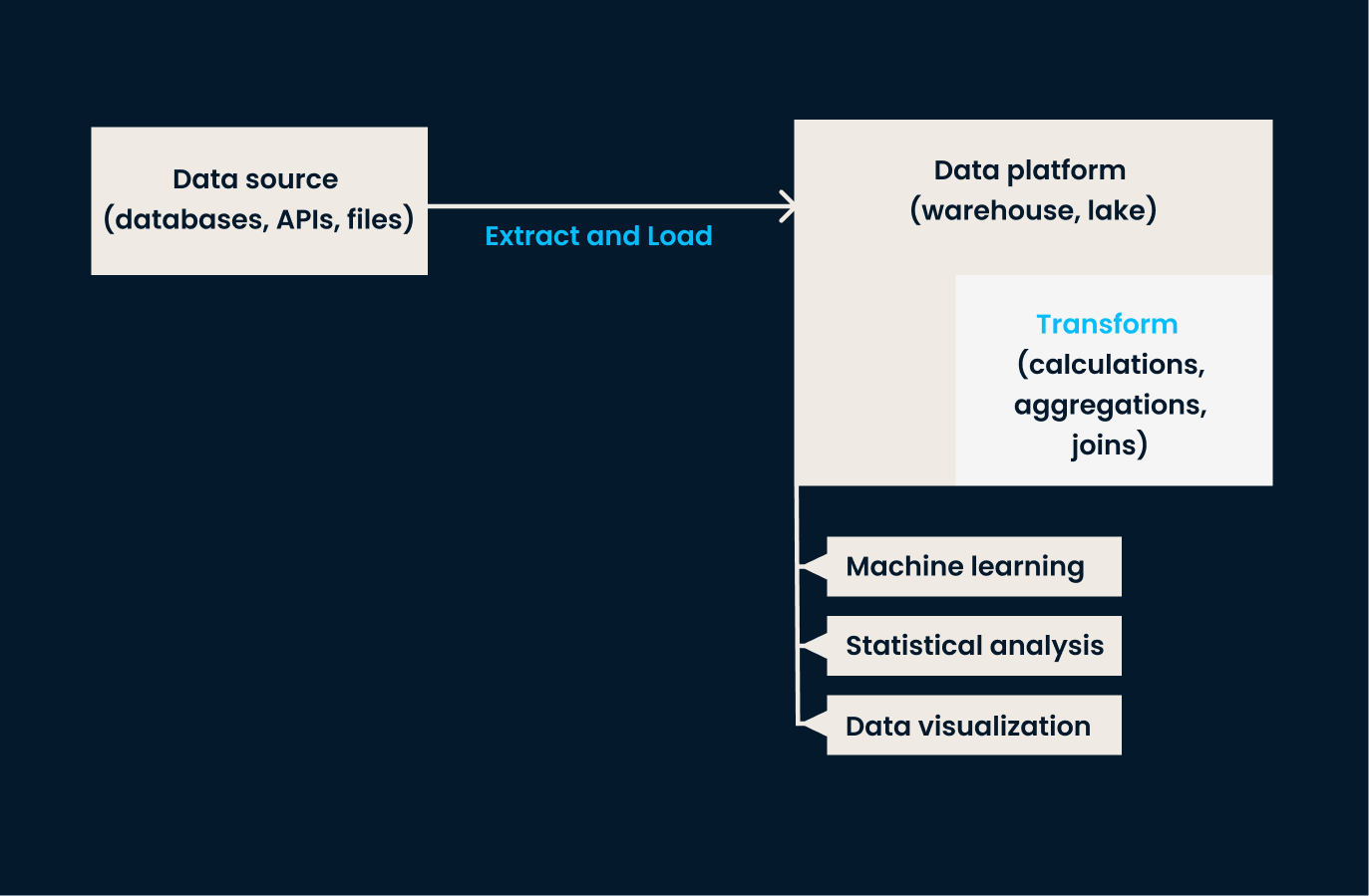

Canalización de datos ELT: Las fases de extracción y carga tienen lugar antes de aplicar ninguna transformación a los datos. El paso de transformación se realiza dentro de la plataforma de datos.

La transformación de datos se realiza dentro del almacén o lago de datos, lo que permite manejar más fácilmente grandes volúmenes de datos. Con tecnologías modernas en la nubeeste proceso puede realizarse casi en tiempo real, proporcionando a las organizaciones acceso a datos frescos y precisos para su análisis.

¿Quieres saber más sobre el uso de Python para ELT? El curso ETL y ELT en Python puede ser exactamente lo que necesitas.

Ventajas del ELT

El ELT conlleva muchas ventajas, y aquí tienes algunas notables:

- Escalabilidad: ELT permite extraer, cargar y transformar grandes cantidades de datos más rápidamente que los procesos ETL tradicionales, gracias a la potencia de la computación en nube.

- Flexibilidad: La ELT permite integrar datos de diversas fuentes, incluidos datos estructurados, semiestructurados y no estructurados.

- Velocidad de la información en tiempo real: Los datos brutos almacenados en un lago de datos o almacén de datos pueden transformarse rápidamente a petición, proporcionando información en tiempo real para una toma de decisiones más rápida.

ELT vs ETL

Comparemos ahora las diferencias entre ELT y ETL.

Como ya se ha dicho, la ELT es un enfoque más reciente del tratamiento de datos, en el que éstos se cargan primero en un repositorio central, permitiendo que las transformaciones se produzcan después de la carga.

Por el contrario, ETL (Extraer, Transformar, Cargar) es una metodología tradicional en la que los datos se transforman antes de cargarse en el sistema de destino. Estas diferencias fundamentales afectan no sólo al proceso, sino también a la velocidad, los costes y la seguridad.

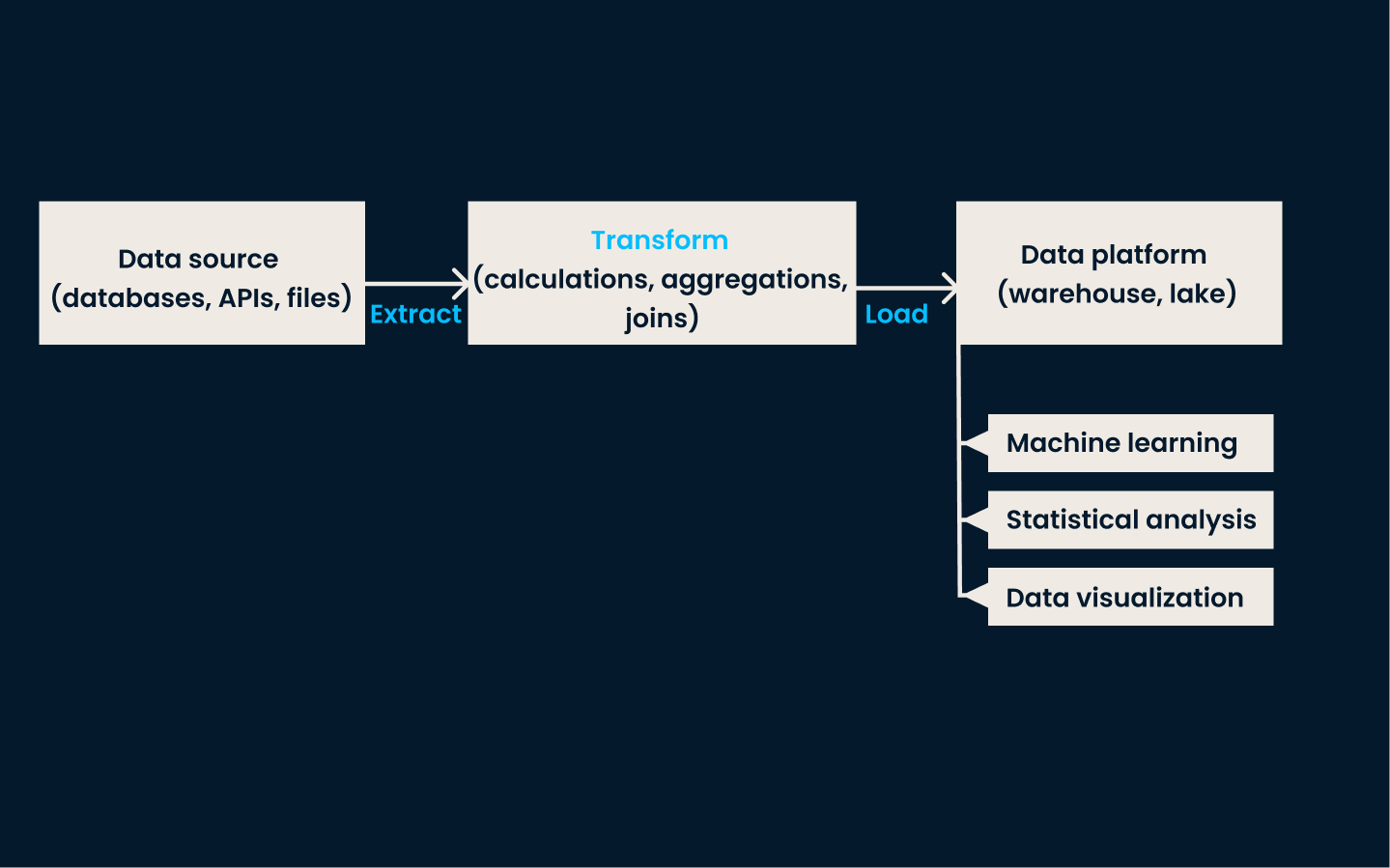

Canal ETL: El paso de transformación se produce antes de cargar los datos en una plataforma de destino. Normalmente, la transformación se produce en un servidor independiente y no en la propia plataforma de datos.

Proceso

La ELT sigue un enfoque de "carga primero, transformación después", en el que los datos se cargan en un sistema de almacenamiento en su forma bruta y luego se transforman para su análisis.

Por otra parte, el ETL sigue un enfoque de "extracción-transformación-carga", en el que los datos se extraen de varias fuentes, luego se transforman y, por último, se cargan en un almacén de datos.

Velocidad

El enfoque ELT es conocido por su mayor velocidad de procesamiento de datos, ya que elimina la necesidad de una zona intermedia de preparación. Esto permite el análisis de datos en tiempo real o análisis de datos casi en tiempo real.

Por el contrario, el ETL a menudo puede llevar más tiempo debido a los múltiples pasos necesarios para transformar y cargar los datos.

Costes

Además, ELT elimina la necesidad de un costoso software ETL, ya que las transformaciones pueden realizarse mediante consultas SQL u otras herramientas de código abierto.

En cambio, los procesos ETL tradicionales suelen encajar mejor en infraestructuras locales, donde las fuentes de datos son limitadas y los recursos de hardware son menos escalables que en entornos basados en la nube. La infraestructura local suele tener costes más elevados que la infraestructura en la nube.

Seguridad

Por último, el ELT permite la encriptación de datos y el enmascaramiento de información personal identificable (IPI) durante el proceso de carga, ya que se realiza en un repositorio central seguro.

Los procesos ETL deben garantizar la seguridad de los datos durante todo el proceso de extracción y transformación. Sin embargo, eso resulta difícil, dado que los datos tienen que trasladarse a un almacenamiento adicional y a menudo se procesan en servidores distintos.

Casos prácticos de ELT

Con su mayor velocidad de procesamiento de datos y su analítica de computación en nube, el proceso ELT ha visto algunos casos de uso en los que brilla en comparación con ETL.

He aquí algunos usos comunes del proceso ELT:

- Informes de la app en tiempo real: ELT permite a las empresas obtener información en tiempo real sobre el comportamiento de los usuarios de las aplicaciones.

- Almacenamiento de datos: Muchas organizaciones utilizan ELT para cargar y transformar datos en un almacén de datos centralizado con fines de elaboración de informes y análisis.

- Integración de datos en la nube: Con el auge de las tecnologías en la nube, ELT se ha convertido en una opción popular para integrar fuentes de datos de diversas aplicaciones locales y en la nube.

Herramientas y tecnologías ELT

Existen varias herramientas y tecnologías a disposición de las organizaciones para implantar procesos ELT. Entre ellas están:

Almacenes y lagos de datos

En el paso de carga del proceso ELT, los lagos de datos y los almacenes de datos son esenciales para proporcionar un espacio centralizado de almacenamiento de datos dentro de una empresa.

Éstas son las plataformas de datos en la nube más populares:

- Amazon Redshift: Un servicio de almacén de datos en la nube que puede manejar grandes cantidades de datos con rapidez y eficacia.

- Google BigQuery: Un almacén de datos en la nube escalable y sin servidor que permite consultar rápidamente grandes conjuntos de datos.

- Copo de nieve: Un almacén de datos basado en la nube que soporta los procesos ELT y proporciona seguridad y rendimiento avanzados.

- Amazon S3: Un servicio de almacenamiento en la nube que puede utilizarse como lago de datos para almacenar datos en bruto, que luego pueden transformarse mediante consultas SQL u otras herramientas.

Herramientas ELT de código abierto

Muchas organizaciones también aprovechan las herramientas de código abierto para sus procesos ELT por su rentabilidad.

Estas herramientas pueden ayudar en distintas fases del proceso de ELT:

- Flujo de aire Apache: Se utiliza para la automatización del flujo de trabajo y la programación de procesos ETL/ELT.

- dbt: Software de código abierto para transformar datos en un almacén de datos mediante SQL.

- Airbyte: Plataforma de integración de datos de código abierto que admite procesos ELT y ETL.

- Cantante: Herramienta de código abierto utilizada tanto en procesos ELT como ETL mediante un enfoque modular.

- Apache NiFi: Herramienta de integración de datos de código abierto que admite el enrutamiento de datos, la transformación y la lógica de mediación del sistema.

Las herramientas de código abierto son un complemento excelente para los procesos ELT porque ofrecen flexibilidad, soporte para desarrolladores y muchas opciones de integración.

Guiones a medida

Los desarrolladores también pueden optar por utilizar scripts creados con lenguajes de programación para una mayor personalización. Suelen implicar el uso de paquetes y bibliotecas para procesar y transformar datos.

Algunos lenguajes de programación comunes utilizados para estos guiones son:

- Pitón: Utilizando bibliotecas como Pandas, NumPy y SQLAlchemy puede ayudar en la extracción, carga y transformación de datos.

- Apache Spark: Se utiliza para el procesamiento y análisis de grandes datos, a menudo aprovechando lenguajes como Python (PySpark), Java y Scala.

- R: El tidyverse junto con otras bibliotecas de R como dplyr y data.table, pueden utilizarse para la extracción y transformación de datos.

- SQL: Las consultas SQL pueden utilizarse para tareas de transformación, y SQL Server Integration Services (SSIS) es una popular herramienta ETL que también admite procesos ELT.

- Scala: A menudo se utiliza con Apache Spark para tareas de procesamiento de big data y ELT.

- Java: Se utiliza habitualmente con marcos de big data como Apache Hadoop y Apache Spark para procesos ELT.

Reflexiones finales

En conclusión, la ELT es una tendencia nueva y emergente en el tratamiento de datos que ofrece muchas ventajas sobre los métodos ETL tradicionales. Permite una transformación de datos más rápida y eficaz, y proporciona mayor flexibilidad y escalabilidad.

Si estás pensando en aprender más sobre ELT u otros conceptos de ingeniería de datos, puede que te guste nuestra Certificación de Ingeniero de Datos o nuestro Carrera de Ingeniero de Datos en Python.

Preguntas frecuentes

¿Cómo gestiona ELT los problemas de calidad y coherencia de los datos?

ELT gestiona la calidad y coherencia de los datos aprovechando las capacidades del almacén o lago de datos donde se almacenan. Durante la fase de transformación se aplican procesos de comprobación, limpieza y validación de la calidad de los datos para garantizar su coherencia y precisión. Se pueden utilizar herramientas como dbt (data build tool) para crear conductos de transformación que incluyan estas comprobaciones de calidad, ayudando a mantener altos niveles de integridad de los datos.

¿Puede utilizarse la ELT para la transmisión de datos en tiempo real y, en caso afirmativo, cómo?

Sí, el ELT puede utilizarse para la transmisión de datos en tiempo real. Esto se consigue integrando herramientas de ingesta de datos en tiempo real como Apache Kafka o AWS Kinesis con el canal de ELT. Estas herramientas pueden transmitir datos continuamente a un lago de datos o almacén, donde pueden aplicarse transformaciones casi en tiempo real utilizando herramientas como Apache Spark o transformaciones basadas en SQL, lo que permite un análisis y una toma de decisiones oportunos.

¿Cómo se integra la ELT con los flujos de trabajo de aprendizaje automático?

La ELT se integra con los flujos de trabajo de aprendizaje automático proporcionando una sólida canalización de datos que introduce datos limpios y transformados en modelos de aprendizaje automático. Una vez cargados los datos en un almacén de datos, se pueden transformar y preparar para el aprendizaje automático utilizando herramientas como Apache Spark MLlib o bibliotecas de Python como scikit-learn. Esta integración permite el preprocesamiento de datos, el entrenamiento de modelos y la evaluación sin fisuras dentro del mismo entorno, mejorando la eficacia y la escalabilidad.

¿Cuáles son las consideraciones de seguridad al implantar ELT en entornos de nube?

Al implantar ELT en entornos de nube, las consideraciones de seguridad incluyen el cifrado de datos, el control de acceso y el enmascaramiento de datos. Los datos deben encriptarse en tránsito y en reposo para proteger la información sensible. Deben implantarse mecanismos de control de acceso, como el control de acceso basado en roles (RBAC), para garantizar que sólo los usuarios autorizados puedan acceder a los datos y manipularlos. Se pueden aplicar técnicas de enmascaramiento de datos para proteger la información personal identificable (IPI) durante los procesos de carga y transformación.

¿Cómo manejan los ingenieros de datos el reto de la evolución de esquemas en los procesos ELT?

Los profesionales de los datos gestionan la evolución de los esquemas en los procesos ELT mediante herramientas y prácticas de gestión de esquemas que se adaptan a los cambios a lo largo del tiempo. Esto incluye el uso de herramientas como Apache Avro o el esquema JSON para la serialización flexible de datos y la evolución del esquema. Además, pueden emplearse estrategias de versionado y scripts automatizados de migración de esquemas para gestionar los cambios sin interrumpir la cadena de datos. Los catálogos de datos y las herramientas de gestión de metadatos también desempeñan un papel crucial en el seguimiento y la documentación de los cambios de esquema para garantizar la coherencia y fiabilidad de los datos.