Programa

O cenário da arquitetura de dados está evoluindo, impulsionado pelo uso crescente de tecnologias de nuvem e pela adoção da pilha de dados moderna. Como resultado, os processos de ELT estão se tornando mais amplamente utilizados. Mas o que exatamente está envolvido nesse processo?

Neste artigo, exploraremos o ELT e sua função na arquitetura de dados avançada.

O que é ELT?

ELT significa Extract, Load, Transform (extrair, carregar, transformar). É um processo de integração de dados que envolve a extração de dados de várias fontes, o carregamento em um sistema de armazenamento de dados e a transformação em um formato que possa ser facilmente analisado.

O processo ELT é amplamente usado em arquitetura moderna de pilha de dados em que os dados são armazenados, transformados e analisados em um lago ou armazém de dados.

Como a ELT funciona?

Como o próprio nome sugere, o ELT envolve três etapas principais: Extrair, carregar e transformar. Vamos examinar cada etapa com mais detalhes.

1. Extrair

A primeira etapa do processo de ELT é extrair dados de várias fontes, como bancos de dados, arquivos, APIs ou serviços da Web. Isso pode ser feito usando ferramentas como o software ELT ou scripts personalizados escritos por desenvolvedores.

Alguns exemplos de plataformas de extração de dados são a Airbyte e a Fivetran. Para escrever scripts personalizados, Apache Spark e Python são amplamente utilizados.

Os dados extraídos podem ser estruturados, semiestruturados ou não estruturados e podem vir de diferentes tipos de sistemas, como bancos de dados relacionais, bancos de dados NoSQLou armazenamento em nuvem.

2. Carga

Depois que os dados são extraídos, eles são carregados em um sistema de armazenamento de dados centralizado, como um data lake ou um armazém de dados. Essa etapa envolve a organização e o armazenamento dos dados extraídos em seu formato bruto, sem nenhuma transformação.

Normalmente, os engenheiros de dados estão envolvidos nessa etapa, em que carregam os dados para plataformas como:

Essas plataformas de dados permitem o carregamento rápido de grandes quantidades de dados e fornecem uma única fonte de verdade para todos os diferentes tipos de dados coletados de várias fontes.

3. Transformar

A etapa final do processo ELT é transformar os dados brutos em um formato otimizado para análise e geração de relatórios. Isso envolve a limpeza, a filtragem, a agregação e a estruturação dos dados de forma adequada para que as ferramentas de business intelligence e análise possam trabalhar com eles.

Os engenheiros de dados ou cientistas de dados geralmente são responsáveis por essa etapa e podem usar ferramentas como:

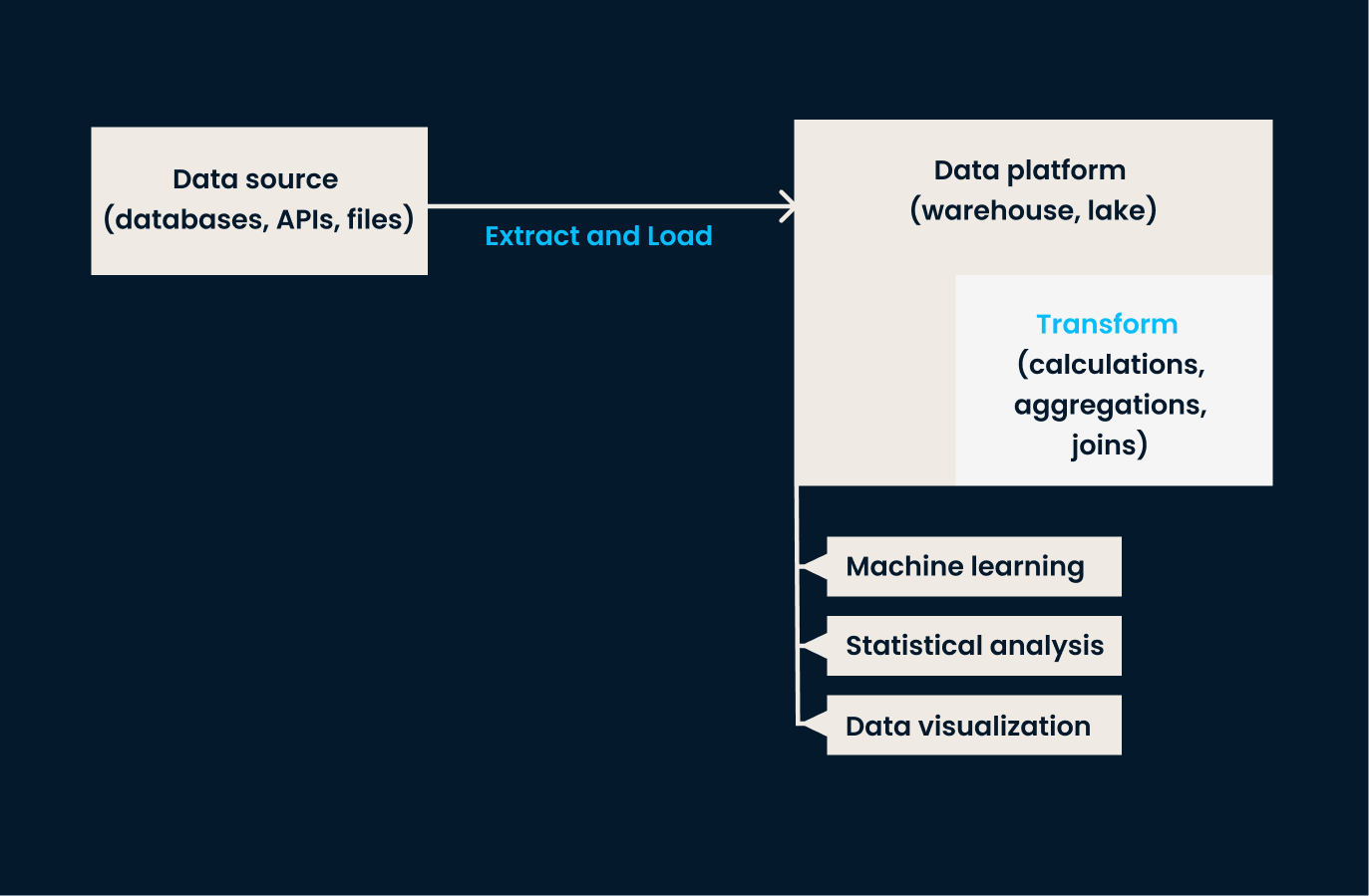

Pipeline de dados ELT: As fases de extração e carregamento ocorrem antes que qualquer transformação seja aplicada aos dados. A etapa de transformação é realizada na plataforma de dados.

A transformação de dados é feita dentro do data warehouse ou do data lake, o que permite o manuseio mais fácil de grandes volumes de dados. Com as modernas tecnologias de nuvemesse processo pode ser feito quase em tempo real, proporcionando às organizações acesso a dados novos e precisos para análise.

Você quer saber mais sobre como usar Python para ELT? O curso ETL e ELT no curso Python pode ser exatamente o que você precisa.

Vantagens do ELT

A ELT traz muitos benefícios, e aqui estão alguns notáveis:

- Escalabilidade: O ELT permite a extração, o carregamento e a transformação de grandes quantidades de dados com mais rapidez do que os processos tradicionais de ETL, graças ao poder da computação em nuvem.

- Flexibilidade: O ELT permite a integração de dados de várias fontes, incluindo dados estruturados, semiestruturados e não estruturados.

- Velocidade de insights em tempo real: Os dados brutos armazenados em um data lake ou data warehouse podem ser transformados rapidamente sob demanda, fornecendo insights em tempo real para uma tomada de decisão mais rápida.

ELT vs ETL

Vamos agora comparar as diferenças entre ELT e ETL.

Conforme mencionado anteriormente, o ELT é uma abordagem mais recente para o processamento de dados, em que os dados são carregados primeiro em um repositório central, permitindo que as transformações ocorram após o carregamento.

Por outro lado, ETL (Extract, Transform, Load) é uma metodologia tradicional na qual os dados são transformados antes de serem carregados no sistema de destino. Essas diferenças fundamentais afetam não apenas o processo, mas também a velocidade, os custos e a segurança.

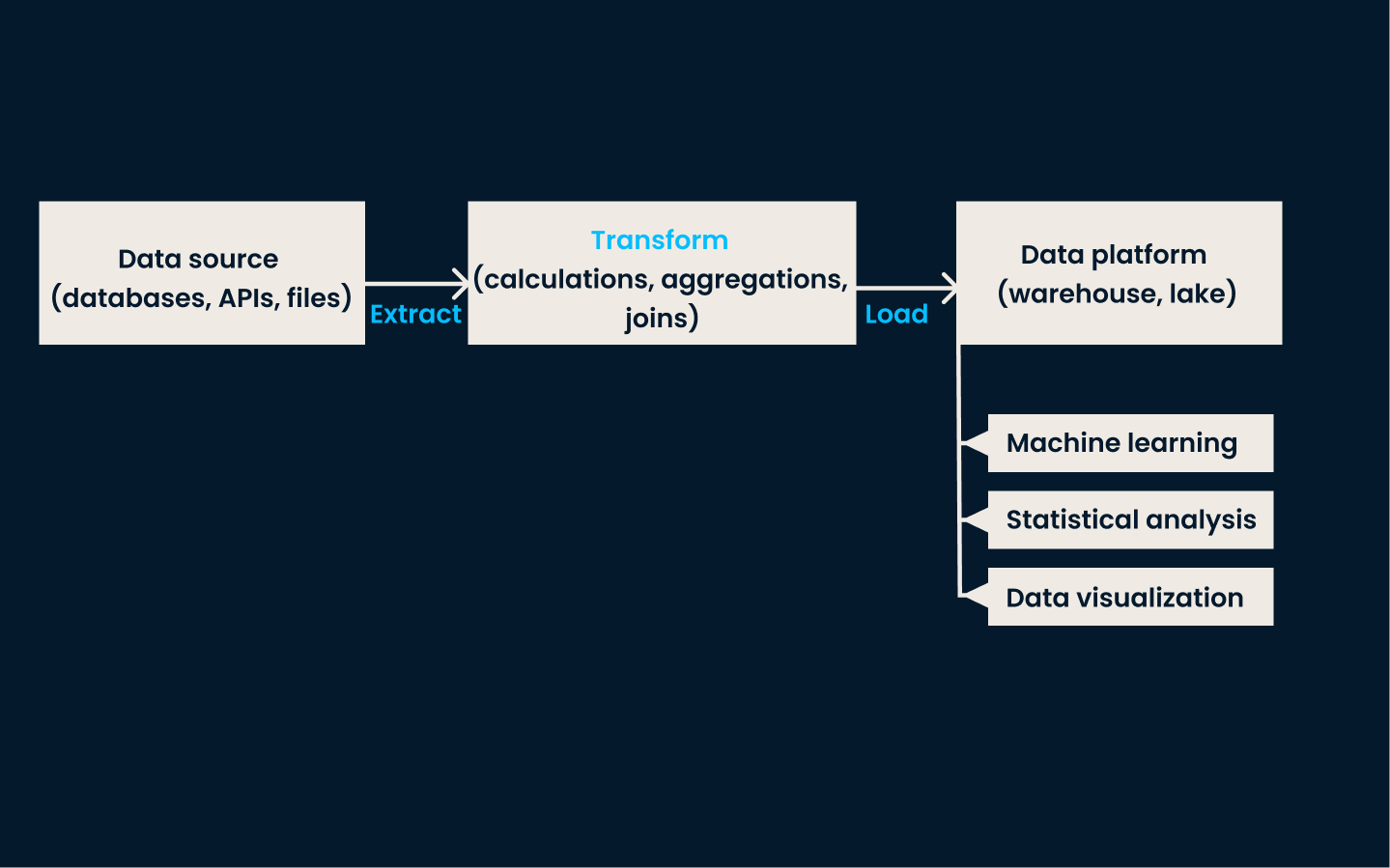

Pipeline de ETL: A etapa de transformação ocorre antes de carregar os dados em uma plataforma de destino. Normalmente, a transformação ocorre em um servidor separado, e não na própria plataforma de dados.

Processo

A ELT segue a abordagem "carregar primeiro, transformar depois", em que os dados são carregados em um sistema de armazenamento em sua forma bruta e, em seguida, transformados para análise.

Por outro lado, a ETL segue uma abordagem de "extração-transformação-carregamento", em que os dados são extraídos de várias fontes, transformados e, por fim, carregados em um data warehouse.

Velocidade

A abordagem ELT é conhecida por sua maior velocidade de processamento de dados, pois elimina a necessidade de uma área de preparação intermediária. Isso permite a análise de dados em tempo real ou análise de dados em tempo real ou quase real.

Por outro lado, o ETL pode levar mais tempo devido às várias etapas envolvidas na transformação e no carregamento dos dados.

Custos

Além disso, o ELT elimina a necessidade de um software ETL caro, pois as transformações podem ser feitas usando consultas SQL ou outras ferramentas de código aberto.

Em contrapartida, os processos tradicionais de ETL tendem a se adequar melhor à infraestrutura local, onde as fontes de dados são limitadas e os recursos de hardware são menos dimensionáveis do que em ambientes baseados em nuvem. A infraestrutura local geralmente tem custos mais altos do que a infraestrutura em nuvem.

Segurança

Por fim, o ELT permite a criptografia e o mascaramento de dados de informações de identificação pessoal (PII) durante o processo de carregamento, pois isso é feito em um repositório central seguro.

Os processos de ETL devem garantir a segurança dos dados durante todo o processo de extração e transformação. No entanto, isso é difícil, pois os dados precisam ser movidos para um armazenamento de preparação adicional e geralmente são processados em servidores separados.

Casos de uso de ELT

Com sua velocidade de processamento de dados mais rápida e análise de computação em nuvem, o processo ELT tem visto alguns casos de uso em que se destaca em comparação com o ETL.

Aqui estão alguns usos comuns do processo ELT:

- Relatórios de aplicativos em tempo real: O ELT permite que as empresas obtenham insights em tempo real sobre o comportamento do aplicativo do usuário.

- Armazenamento de dados: Muitas organizações usam o ELT para carregar e transformar dados em um data warehouse centralizado para fins de relatórios e análises.

- Integração de dados baseada em nuvem: Com o aumento das tecnologias de nuvem, o ELT se tornou uma opção popular para integrar fontes de dados de vários aplicativos locais e de nuvem.

Ferramentas e tecnologias de ELT

Há várias ferramentas e tecnologias disponíveis para que as organizações implementem processos de ELT. Isso inclui:

Data warehouses e data lakes

Na etapa de carregamento do processo ELT, os data lakes e os data warehouses são essenciais para fornecer um espaço de armazenamento de dados centralizado em uma empresa.

Aqui estão as plataformas de dados em nuvem mais populares:

- Amazon Redshift: Um serviço de data warehouse na nuvem que pode lidar com grandes quantidades de dados de forma rápida e eficiente.

- Google BigQuery: Um data warehouse em nuvem escalável e sem servidor que permite a consulta rápida de grandes conjuntos de dados.

- Snowflake: Um data warehouse baseado na nuvem que oferece suporte a processos ELT e fornece segurança e desempenho avançados.

- Amazon S3: Um serviço de armazenamento em nuvem que pode ser usado como um lago de dados para armazenar dados brutos, que podem ser transformados usando consultas SQL ou outras ferramentas.

Ferramentas ELT de código aberto

Muitas organizações também aproveitam as ferramentas de código aberto para seus processos de ELT por sua relação custo-benefício.

Essas ferramentas podem ajudar em diferentes estágios do processo de ELT:

- Fluxo de ar Apache: Usado para automação de fluxo de trabalho e agendamento de processos ETL/ELT.

- dbt: Software de código aberto para transformar dados em um data warehouse usando SQL.

- Airbyte: Plataforma de integração de dados de código aberto que oferece suporte aos processos ELT e ETL.

- Cantor: Ferramenta de código aberto usada nos processos de ELT e ETL por meio de uma abordagem modular.

- Apache NiFi: Ferramenta de integração de dados de código aberto que suporta roteamento de dados, transformação e lógica de mediação do sistema.

As ferramentas de código aberto são uma excelente combinação para os processos de ELT porque oferecem flexibilidade, suporte ao desenvolvedor e muitas opções de integração.

Scripts personalizados

Os desenvolvedores também podem optar por usar scripts criados com linguagens de programação para aumentar a capacidade de personalização. Isso tende a envolver o uso de pacotes e bibliotecas para processar e transformar dados.

Algumas linguagens de programação comuns usadas para esses scripts incluem:

- Python: Usando bibliotecas como Pandas, NumPy e SQLAlchemy pode ajudar na extração, no carregamento e na transformação de dados.

- Apache Spark: Usado para processamento e análise de big data, geralmente utilizando linguagens como Python (PySpark), Java e Scala.

- R: O tidyverse juntamente com outras bibliotecas do R, como dplyr e data.table, podem ser usadas para extração e transformação de dados.

- SQL: As consultas SQL podem ser usadas para tarefas de transformação, e você pode usar o SQL Server Integration Services (SSIS) é uma ferramenta ETL popular que também oferece suporte a processos ELT.

- Scala: Geralmente usado com o Apache Spark para processamento de big data e tarefas de ELT.

- Java: Comumente usado com estruturas de big data, como o Apache Hadoop e o Apache Spark, para processos de ELT.

Considerações finais

Concluindo, o ELT é uma tendência nova e emergente no processamento de dados que oferece muitas vantagens em relação aos métodos tradicionais de ETL. Ele permite uma transformação de dados mais rápida e eficiente e oferece maior flexibilidade e escalabilidade.

Se estiver pensando em aprender mais sobre ELT ou outros conceitos de engenharia de dados, você pode gostar da nossa Certificação de engenheiro de dados ou nosso Programa de carreira de engenheiro de dados em Python.

Perguntas frequentes

Como o ELT lida com problemas de qualidade e consistência de dados?

A ELT lida com a qualidade e a consistência dos dados, aproveitando os recursos do data warehouse ou do data lake onde os dados estão armazenados. Os processos de verificação, limpeza e validação da qualidade dos dados são aplicados durante a fase de transformação para garantir a consistência e a precisão. Ferramentas como a dbt (ferramenta de construção de dados) podem ser usadas para criar pipelines de transformação que incluem essas verificações de qualidade, ajudando a manter altos padrões de integridade dos dados.

O ELT pode ser usado para transmissão de dados em tempo real e, em caso afirmativo, como?

Sim, o ELT pode ser usado para transmissão de dados em tempo real. Isso é feito por meio da integração de ferramentas de ingestão de dados em tempo real, como o Apache Kafka ou o AWS Kinesis, com o pipeline ELT. Essas ferramentas podem transmitir dados continuamente para um lago ou armazém de dados, onde as transformações podem ser aplicadas quase em tempo real usando ferramentas como o Apache Spark ou transformações baseadas em SQL, permitindo análises e tomadas de decisão em tempo hábil.

Como o ELT se integra aos fluxos de trabalho de machine learning?

O ELT se integra aos fluxos de trabalho de machine learning, fornecendo um pipeline de dados robusto que alimenta os modelos de machine learning com dados limpos e transformados. Depois que os dados são carregados em um data warehouse, eles podem ser transformados e preparados para machine learning usando ferramentas como Apache Spark MLlib ou bibliotecas Python, como scikit-learn. Essa integração permite o pré-processamento de dados, o treinamento de modelos e a avaliação contínuos no mesmo ambiente, aumentando a eficiência e o dimensionamento.

Quais são as considerações de segurança ao implementar o ELT em ambientes de nuvem?

Ao implementar o ELT em ambientes de nuvem, as considerações de segurança incluem criptografia de dados, controle de acesso e mascaramento de dados. Os dados devem ser criptografados em trânsito e em repouso para proteger informações confidenciais. Mecanismos de controle de acesso, como o controle de acesso baseado em função (RBAC), devem ser implementados para garantir que somente usuários autorizados possam acessar e manipular os dados. Técnicas de mascaramento de dados podem ser aplicadas para proteger informações de identificação pessoal (PII) durante os processos de carregamento e transformação.

Como os engenheiros de dados lidam com o desafio da evolução do esquema nos processos de ELT?

Os profissionais de dados lidam com a evolução do esquema nos processos de ELT usando ferramentas e práticas de gerenciamento de esquema que acomodam as mudanças ao longo do tempo. Isso inclui o uso de ferramentas como o Apache Avro ou o esquema JSON para serialização flexível de dados e evolução do esquema. Além disso, estratégias de controle de versão e scripts de migração de esquemas automatizados podem ser empregados para gerenciar as alterações sem interromper o pipeline de dados. Os catálogos de dados e as ferramentas de gerenciamento de metadados também desempenham um papel crucial no rastreamento e na documentação das alterações de esquema para garantir a consistência e a confiabilidade dos dados.