Curso

El aprendizaje por transferencia es una técnica que permite a las máquinas explotar los conocimientos adquiridos en una tarea anterior para mejorar la generalización sobre otra. Es un concepto fundamental detrás del desarrollo de modelos como ChatGPT y Google Gemini, y ayuda en muchas tareas importantes y útiles, como resumir documentos largos, redactar ensayos complejos, organizar viajes o incluso escribir poemas y canciones.

En esta guía, exploraremos en profundidad el aprendizaje por transferencia. Discutiremos su definición, por qué es relevante para el aprendizaje profundo y los modelos modernos de IA generativa, y los retos y limitaciones de esta técnica. También te sugeriremos recursos para que puedas seguir aprendiendo. ¿Estás preparado? Empecemos.

¿Qué es el aprendizaje por transferencia en la IA?

El aprendizaje por transferencia es una técnica en la que un modelo desarrollado para una tarea concreta se reutiliza como punto de partida para un modelo sobre una segunda tarea. En otras palabras, vuelves a aplicar los componentes de un modelo de aprendizaje automático preentrenado a nuevos modelos destinados a algo diferente pero relacionado.

El concepto es similar a la forma en que los seres humanos aprenden nuevas habilidades. Pongamos un ejemplo: Imagina que eres un consumado guitarrista y decides aprender a tocar el ukelele. Tu experiencia previa con la guitarra acelerará tu proceso de aprendizaje. Esto se debe a que muchas de las habilidades y conocimientos necesarios para tocar la guitarra -como las posiciones de los dedos, los patrones de rasgueo, la comprensión del diapasón, la teoría musical y el ritmo- también son aplicables para tocar el ukelele.

En IA, el aprendizaje por transferencia te permite aprovechar el entrenamiento previo para resolver problemas nuevos relacionados de forma más eficiente, reduciendo así el tiempo y los recursos computacionales.

¿Por qué se utiliza el aprendizaje por transferencia?

Hay varias razones de peso para adoptar técnicas de aprendizaje por transferencia al desarrollar redes neuronales, entre ellas:

- Eficacia de la formación: El aprendizaje por transferencia reduce el tiempo de entrenamiento al evitar la necesidad de entrenar los modelos desde cero y permite afinarlos con conjuntos de datos más pequeños.

- Rendimiento del modelo: El aprendizaje por transferencia mejora el rendimiento del modelo aprovechando el conocimiento preentrenado, reduciendo el sobreajuste y permitiendo un entrenamiento más rápido y eficaz con datos limitados.

- Reducir los costes operativos: El aprendizaje por transferencia reduce los costes al evitar la necesidad de entrenar modelos desde cero, donde tanto la adquisición de los datos como el uso de recursos informáticos para entrenar un modelo pueden resultar caros.

- Adaptabilidad y reutilización mejoradas: El aprendizaje por transferencia es una técnica clave que permite a los modelos adaptarse a múltiples escenarios y tareas, aumentando así su potencial y utilidad.

Cómo funciona el aprendizaje por transferencia

Exploremos tres conceptos relacionados con el aprendizaje por transferencia: el aprendizaje multitarea, la extracción de características y el ajuste fino.

Aprendizaje multitarea

En el aprendizaje multitarea, un único modelo se entrena para realizar varias tareas al mismo tiempo. El modelo tiene un conjunto compartido de capas iniciales que procesan los datos de forma común, seguido de capas separadas para cada tarea específica. Esto permite que el modelo aprenda características generales que son útiles para todas las tareas, a la vez que aprende características específicas de la tarea que son más exclusivas.

Este paradigma se utiliza mucho en los LLM modernos. Consulta nuestro Curso de Introducción a los LLM para conocer todos los detalles.

Extracción de rasgos

La extracción de características consiste en utilizar un modelo preentrenado para extraer características o representaciones significativas de los datos. Estas características se utilizan luego como entrada para un nuevo modelo centrado en algo específico.

El aprendizaje por transferencia basado en características aprovecha las capacidades únicas de las redes neuronales para extraer características de los datos. Con la extracción de características, el modelo "averigua", por así decirlo, qué parte de la entrada es importante para, por ejemplo, clasificar una imagen. En términos prácticos, esto significa que, cuando se aplica un modelo a una nueva tarea, sólo se aplican las capas primera e intermedia preentrenadas del modelo que contienen los conocimientos más generalizables.

Ajuste fino

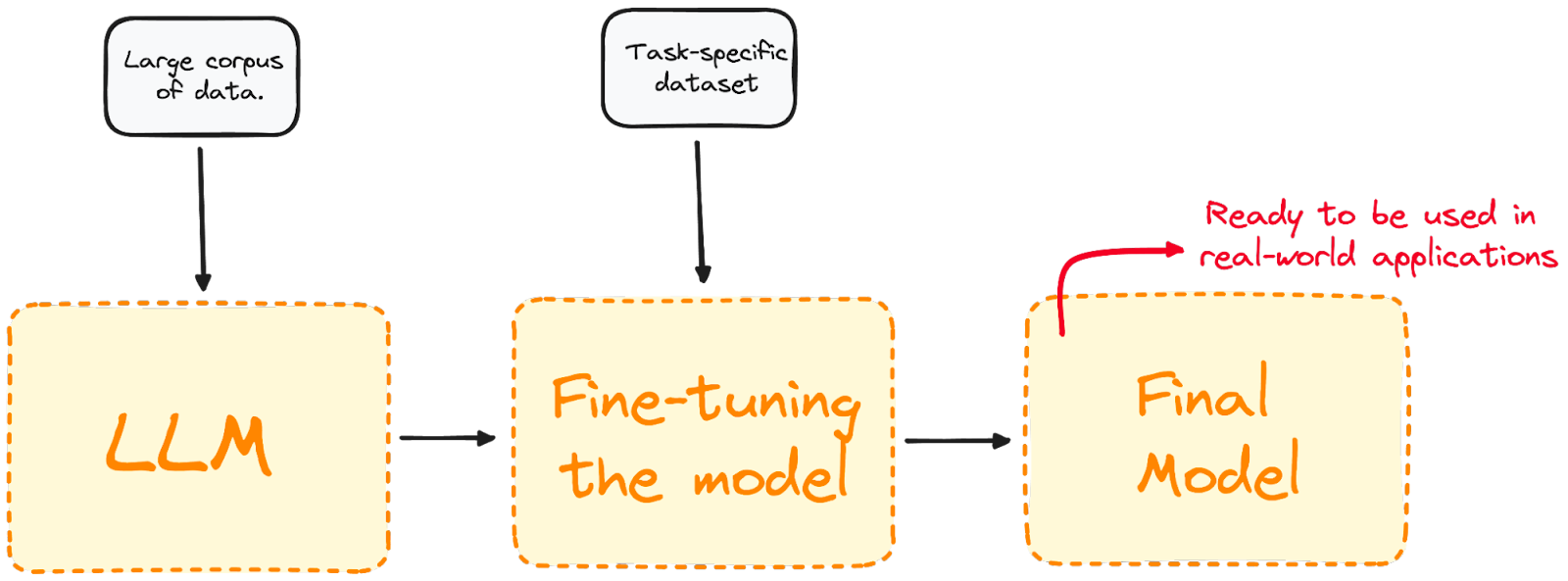

El ajuste fino va más allá de la extracción de rasgos y se suele utilizar cuando ambas tareas no están estrechamente relacionadas. Consiste en tomar un modelo preentrenado y seguir entrenándolo en un conjunto de datos específico del dominio.

La mayoría de los modelos LLM actuales tienen un rendimiento global muy bueno, pero suelen fallar en problemas específicos orientados a tareas concretas. El ajuste fino adapta el modelo para que funcione mejor en tareas específicas, haciéndolo más eficaz y versátil en aplicaciones del mundo real. Si quieres saber más sobre el perfeccionamiento, consulta nuestra Guía introductoria a los LLM de perfeccionamiento.

Visualizar el proceso de ajuste finoVisualizar el proceso de ajuste fino.[DataCamp]

Visualizar el proceso de ajuste finoVisualizar el proceso de ajuste fino.[DataCamp]

Aplicaciones del aprendizaje por transferencia

El aprendizaje por transferencia es una técnica habitual para abordar múltiples tareas de la ciencia de datos, incluidas las de visión por ordenador y procesamiento del lenguaje natural.

Visión por ordenador

La visión por ordenador es uno de los campos en los que el aprendizaje por transferencia ha sido especialmente fructífero. Las redes neuronales desarrolladas en este campo necesitan grandes cantidades de datos para abordar tareas como la detección de objetos y la clasificación de imágenes.

En visión por ordenador, las capas iniciales de las redes neuronales detectan bordes en las imágenes, mientras que las capas intermedias identifican formas y figuras. Las capas finales se adaptan a tareas específicas. El aprendizaje por transferencia nos permite crear nuevos modelos reentrenando sólo las capas finales, manteniendo sin cambios los pesos y sesgos de las capas inicial y media. Gracias al aprendizaje por transferencia, es posible crear nuevos modelos que sólo reentrenen las últimas capas de la red, manteniendo los pesos y sesgos de las capas primera e intermedia.

Hoy en día, hay un buen número de redes neuronales públicas preentrenadas en visores informáticos, por ejemplo:

- Grupo de Geometría Visual: El VGG es un modelo preentrenado para la clasificación de imágenes que se utiliza ampliamente como punto de partida para muchas tareas de clasificación de imágenes.

- Sólo se mira una vez: YOLO es un modelo preentrenado de última generación para la detección de objetos que destaca por su velocidad y capacidad para detectar una amplia gama de objetos.

Procesamiento del lenguaje natural

La PNL es una rama de la IA que se centra en la interacción entre los ordenadores y los seres humanos a través del lenguaje natural. El objetivo es programar ordenadores para que procesen y analicen grandes cantidades de datos de lenguaje natural, ya sea en forma de texto o de audio.

El aprendizaje por transferencia desempeña un papel crucial en el desarrollo de modelos de PNL. Permite utilizar modelos lingüísticos preentrenados que se han utilizado para la comprensión general del lenguaje o la traducción, y luego afinarlos para problemas específicos de PNL, como el análisis de sentimientos o la traducción lingüística. Las aplicaciones de la PNL son prácticamente infinitas e incluyen los asistentes de voz y el reconocimiento del habla.

El aprendizaje por transferencia está detrás de algunos de los modelos de PNL más populares, entre ellos:

- Representaciones codificadoras bidireccionales a partir de transformadores: BERT, creado por investigadores de Google en 2018, es uno de los primeros LLM basados en la arquitectura de transformadores. Es un modelo público preentrenado que destaca en muchos problemas de PNL, como el modelado del lenguaje, la clasificación de textos y la traducción automática.

- Transformador Generativo Pre-entrenado: GPT, desarrollado por OpenAI, comprende una serie de potentes LLM a la vanguardia de la revolución GenAI. Los modelos GPT, como el GPT-3.5 y el GPT-4, son los modelos básicos del famoso ChatGPT. OpenAI también ha lanzado recientemente GPT-4o, la versión más potente hasta la fecha.

Buenas prácticas y retos

En esencia, el aprendizaje por transferencia es un enfoque de diseño para mejorar la eficacia. En lugar de entrenar modelos desde cero -lo que requiere una gran cantidad de recursos, dinero y tiempo en el caso de los modelos de IA generativa de vanguardia-, el aprendizaje por transferencia permite a los modelos aprender más rápida y eficazmente en nuevas tareas aprovechando los conocimientos adquiridos en el pasado.

El aprendizaje por transferencia brilla cuando se dispone de pocos datos para entrenar un modelo en una segunda tarea. Al utilizar los conocimientos de un modelo preentrenado, el aprendizaje por transferencia puede ayudar a evitar el sobreajuste y aumentar la precisión general. Sin embargo, el aprendizaje por transferencia no es a prueba de balas y tiene limitaciones y escollos potenciales que deben abordarse con cuidado. Algunos de los retos más comunes en el aprendizaje por transferencia son:

- Desajuste de dominio: Es más probable que el aprendizaje por transferencia funcione bien cuando las tareas de origen y de destino están relacionadas. Si la nueva tarea es muy diferente, los conocimientos generalizables transferidos pueden no ser suficientes para realizar la nueva tarea con precisión.

- Escasez de datos: Siempre se necesita una cierta cantidad de datos de entrenamiento. Si los datos de entrenamiento son muy limitados o la calidad de los datos es mala, es probable que el modelo no se ajuste lo suficiente.

- Sobreajuste: El aprendizaje por transferencia tampoco es inmune al sobreajuste. Si el modelo se afina demasiado en una tarea, puede aprender características específicas de la tarea que no se generalicen bien a los nuevos datos.

- Complejidad: A veces, la tarea objetivo es tan compleja que el proceso de ajuste puede ser difícil, costoso y llevar mucho tiempo.

Conclusión y otros recursos

El aprendizaje por transferencia es un enfoque de diseño fundamental para aumentar la eficacia y el potencial de las redes neuronales. Es justo decir que la actual revolución de la IA no habría sido posible sin las numerosas técnicas de aprendizaje por transferencia disponibles.

Si quieres saber más sobre los detalles del aprendizaje por transferencia, DataCamp está aquí para ayudarte. Consulta nuestros materiales dedicados a los LLM y las redes neuronales para empezar hoy mismo.

Preguntas frecuentes

¿Qué es el aprendizaje por transferencia?

El aprendizaje por transferencia es una técnica muy utilizada en el aprendizaje profundo, en la que un modelo entrenado en una tarea se utiliza como punto de partida para un modelo en una segunda tarea. El aprendizaje por transferencia brilla especialmente cuando la segunda tarea es similar a la primera, o cuando hay pocos datos disponibles para la segunda tarea.

¿Cuáles son las ventajas del aprendizaje por transferencia?

El aprendizaje por transferencia es una gran técnica de optimización, que puede aumentar la eficacia de la formación y el rendimiento de los modelos, y reducir los costes operativos.

¿Qué es el ajuste fino?

El ajuste fino va es una aplicación del aprendizaje por transferencia se utiliza normalmente cuando las dos tareas no están estrechamente relacionadas. El ajuste fino es el proceso de tomar un modelo preentrenado y seguir entrenándolo en un conjunto de datos específico del dominio.

¿Cuáles son las aplicaciones del aprendizaje por transferencia?

El aprendizaje por transferencia es un método de vanguardia para diseñar redes neutras en dominios como la visión por ordenador y el procesamiento del lenguaje natural.