Curso

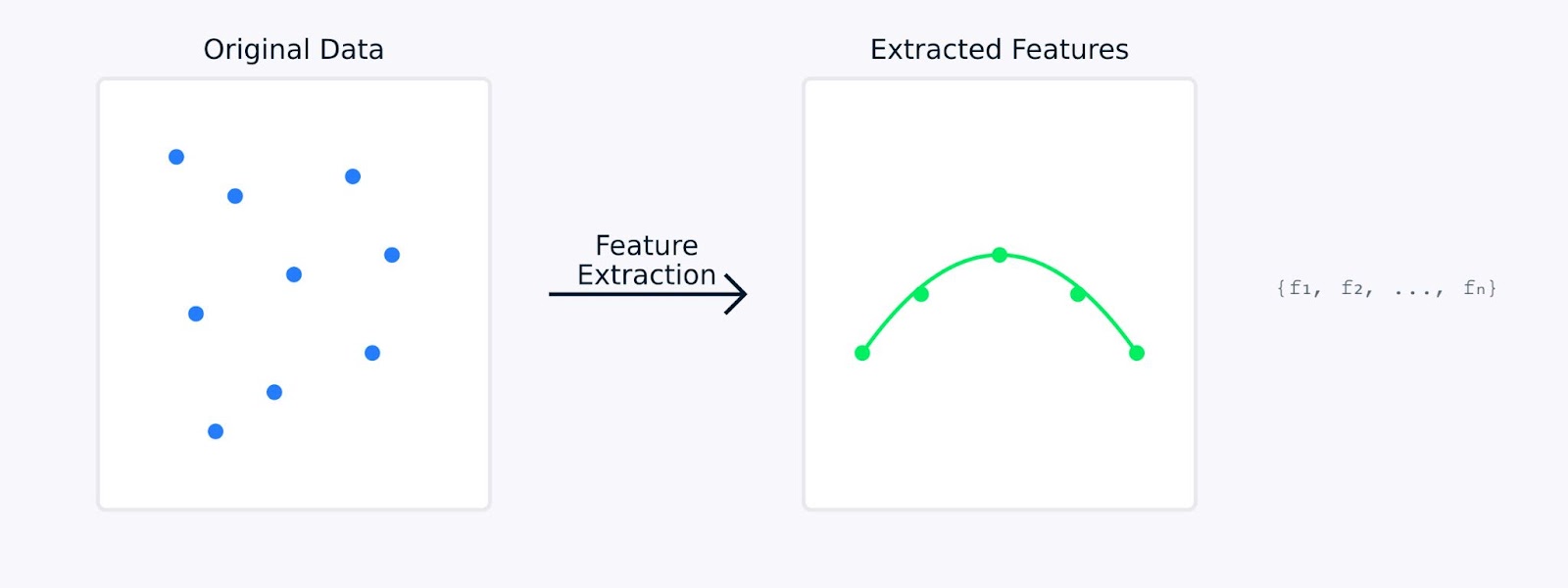

La extracción de características en el aprendizaje automático transforma los datos brutos en un conjunto de características significativas, captando la información esencial y reduciendo al mismo tiempo la redundancia. Puede implicar técnicas de reducción de la dimensionalidad y métodos que crean nuevas características a partir de los datos existentes.

Imagina que intentas identificar frutas en un mercado. Aunque podrías tener en cuenta innumerables atributos (peso, color, textura, forma, olor, etc.), quizá te des cuenta de que bastan unas pocas características clave, como el color y el tamaño, para distinguir entre manzanas y naranjas. Esto es exactamente lo que hace la extracción de características. Te ayuda a centrarte en las características más informativas de tus datos.

Al realizar la extracción de características, los datos originales se transforman matemáticamente en un nuevo conjunto de características. Estas nuevas funciones están diseñadas para captar los aspectos más importantes de los datos, al tiempo que reducen potencialmente su complejidad. Las características extraídas suelen representar patrones o estructuras subyacentes que podrían no ser evidentes de inmediato en los datos originales.

Extracción de características

En las siguientes secciones, exploraremos por qué la extracción de características es tan importante en el aprendizaje automático y estudiaremos varios métodos para extraer características de distintos tipos de datos, junto con su código. Si quieres algunos ejemplos prácticos, consulta nuestro Curso de reducción dimensional en Pythonque tiene un capítulo dedicado a la extracción de características.

¿Por qué es importante la Extracción de Características en el Aprendizaje Automático?

La extracción de características desempeña un papel importante en el aprendizaje automático. Puede marcar la diferencia entre un modelo que fracasa y otro que tiene éxito. Veamos por qué esto es tan fundamental para construir modelos de aprendizaje automático eficaces.

Mejorar la precisión y la eficacia del modelo

Al trabajar con datos brutos aprendizaje automático a menudo les cuesta distinguir entre patrones significativos y ruido. La extracción de características es un paso del preprocesamiento de datos que puede mejorar significativamente el aprendizaje y el rendimiento de tus modelos.

Rendimiento del modelo frente al tiempo de entrenamiento

Por ejemplo, cuando un modelo alcanza un 85% de precisión con datos brutos, el mismo modelo podría alcanzar un 95% de precisión cuando se entrena con características extraídas cuidadosamente. Esta mejora no proviene de cambiar el modelo, sino de darle datos de entrada de mejor calidad con los que aprender.

Gestión de conjuntos de datos de alta dimensión

Los conjuntos de datos modernos suelen contener cientos o miles de características. Esto conlleva varios retos que la extracción de características ayuda a resolver.

- La maldición de la dimensionalidad: A medida que aumenta el número de características, los datos se vuelven cada vez más dispersos en el espacio de características. Esto dificulta que los modelos encuentren patrones significativos. La extracción de rasgos crea una representación más compacta que conserva las relaciones importantes al tiempo que reduce la dimensionalidad.

- Uso elevado de memoria: Los datos de alta dimensión requieren más almacenamiento y memoria durante el procesamiento. Extrayendo sólo las características más relevantes, podemos reducir significativamente la huella de memoria de nuestros conjuntos de datos, manteniendo su valor informativo.

- Visualización de datos: Es imposible visualizar datos con más de tres dimensiones directamente. La extracción de características puede reducir la dimensionalidad a dos o tres características, lo que permite trazar y comprender visualmente la estructura de los datos.

La extracción de características aborda estos retos reduciendo la dimensionalidad y conservando la información esencial. Esta reducción transforma los datos dispersos y de alta dimensión en una forma más compacta y manejable, lo que aumenta el rendimiento del modelo.

Reducir la complejidad computacional y evitar el sobreajuste

La extracción de rasgos proporciona dos ventajas fundamentales para los modelos de aprendizaje automático:

- Menores requisitos computacionales

- Menos funciones significan tiempos de entrenamiento más rápidos

- Reducción del uso de memoria durante el despliegue del modelo

- Generación de predicciones más eficaz

- Mejor generalización

- Los espacios de características más sencillos ayudan a evitar el sobreajuste

- Los modelos aprenden patrones más robustos

- Rendimiento mejorado en datos nuevos y no vistos

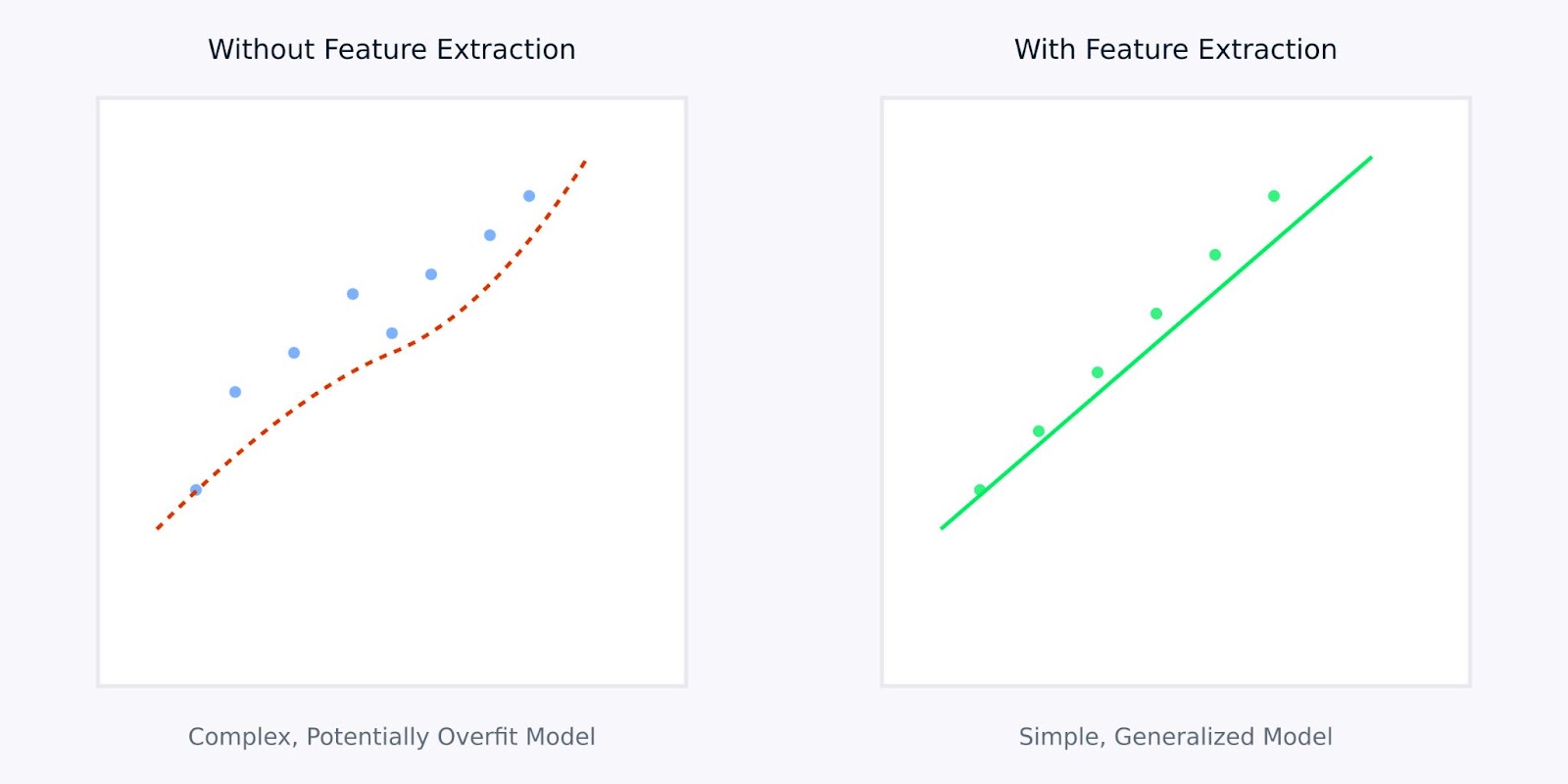

Extracciones de rasgos frente a sin extracción de rasgos

La visualización anterior ilustra cómo la extracción de características puede conducir a modelos más sencillos y robustos. El gráfico de la izquierda muestra un modelo complejo que intenta ajustarse a datos ruidosos y de alta dimensión, mientras que el gráfico de la derecha muestra cómo la extracción de rasgos puede revelar un patrón más claro y generalizable.

Trabajar con características extraídas en lugar de con datos brutos es como dar a tu modelo una versión clara y destilada de la información de la que necesita aprender. Esto no sólo hace que el proceso de aprendizaje sea más eficaz, sino que también conduce a modelos que tienen más probabilidades de funcionar bien en aplicaciones del mundo real.

A continuación, vamos a ver distintos métodos de extracción de rasgos.

Métodos de extracción de características

Los métodos de extracción de rasgos pueden clasificarse a grandes rasgos en dos enfoques principales: la ingeniería manual de rasgos y la extracción automatizada de rasgos. Veamos estos dos métodos para comprender cómo ayudan a transformar los datos brutos en características significativas.

Ingeniería manual de funciones

La ingeniería manual de rasgos implica utilizar la experiencia del dominio para identificar y crear rasgos relevantes a partir de datos brutos. Este enfoque práctico se basa en nuestra comprensión del problema y de los datos para elaborar características significativas.

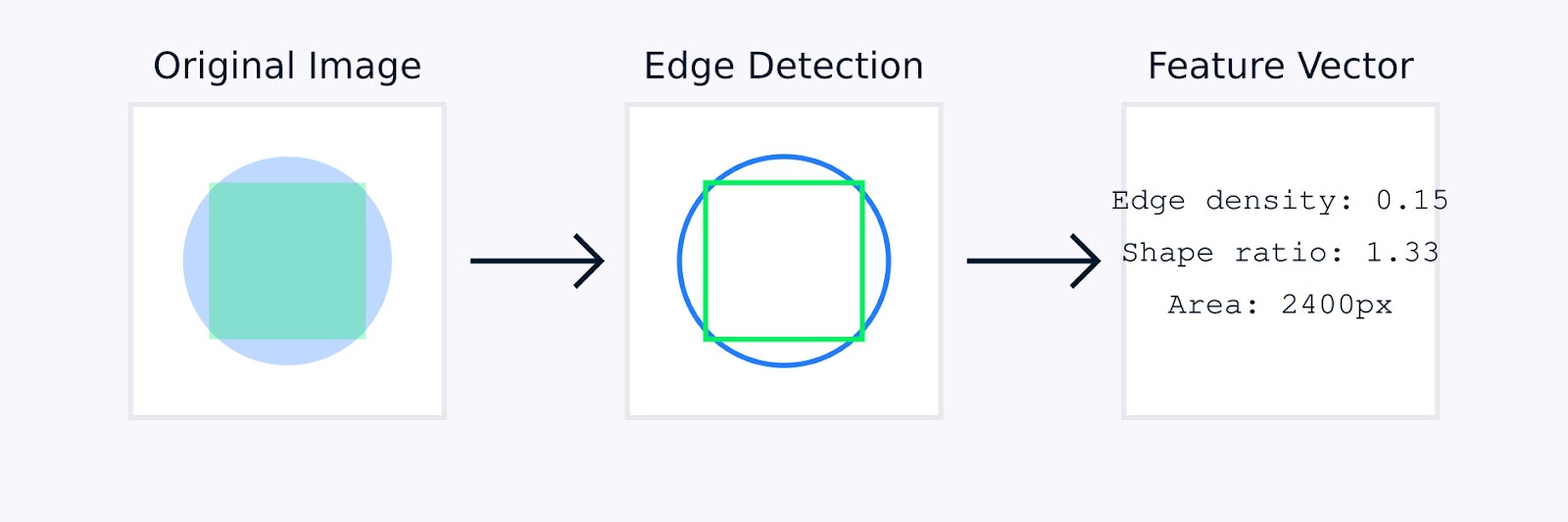

En procesamiento de imágenesla ingeniería manual de rasgos puede implicar técnicas como la detección de bordes para identificar los límites del objeto, histogramas de color para captar la distribución del color, análisis de texturas para cuantificar patrones y descriptores de forma para caracterizar la geometría del objeto.

Extracción de características de la imagen

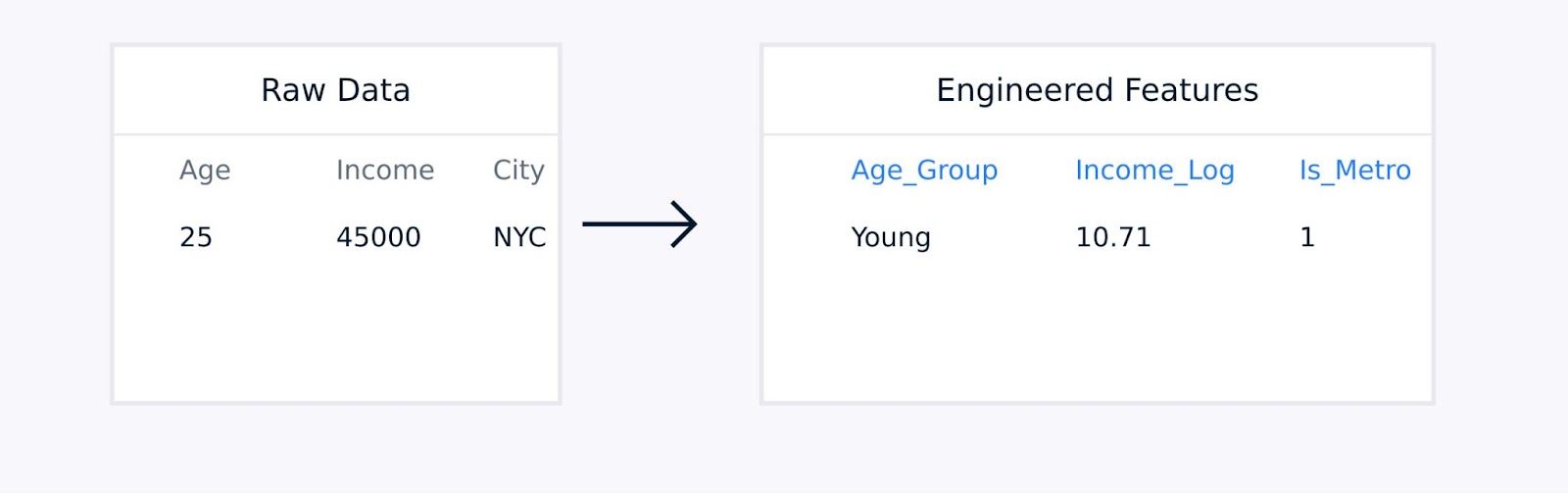

Para los datos tabulares, la ingeniería manual de características implica crear términos de interacción entre las características existentes, transformar las variables mediante funciones logarítmicas o polinómicas, agregar puntos de datos en estadísticas significativas y codificar variables categóricas.

Extracción de características de datos tabulares

Estas técnicas, guiadas por la experiencia en el dominio, aumentan la calidad de la representación de los datos y pueden mejorar significativamente el rendimiento del modelo.

Extracción automatizada de rasgos

La extracción automatizada de rasgos utiliza algoritmos para descubrir y crear rasgos sin orientación humana explícita. Estos métodos son especialmente útiles cuando se trata de conjuntos de datos complejos en los que la ingeniería manual de rasgos puede resultar poco práctica o ineficaz.

Entre los enfoques automatizados habituales se incluyen:

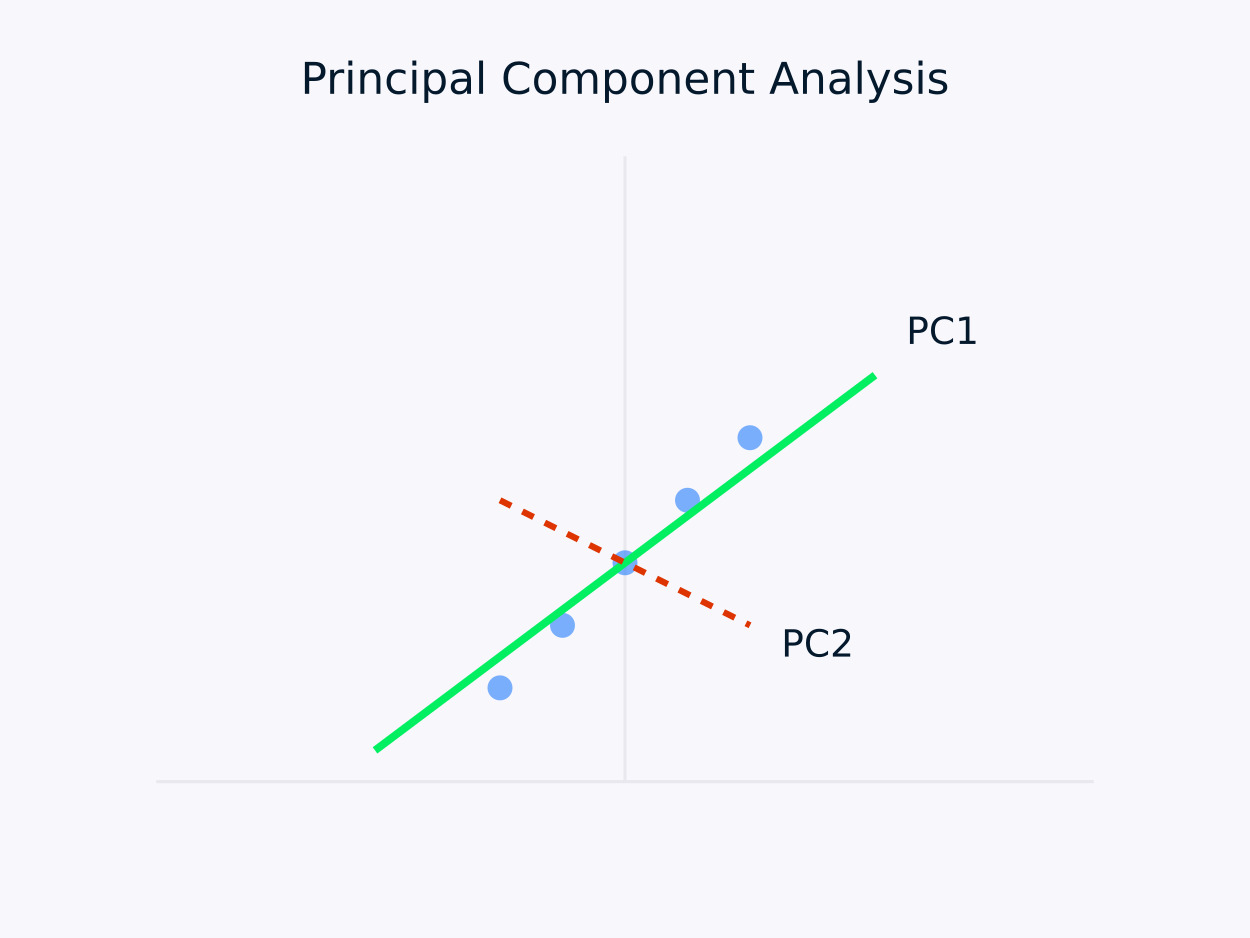

Análisis de Componentes Principales (ACP): Transforma los datos en un conjunto de componentes no correlacionados, en el que cada componente capta la máxima varianza restante. Este enfoque es especialmente útil para reducción de la dimensionalidadya que conserva la información esencial de los datos simplificando su estructura.

Análisis de Componentes Principales (ACP)

Autocodificadores: Son redes neuronales que aprenden representaciones comprimidas de los datos, captando relaciones no lineales. Son especialmente eficaces para conjuntos de datos de alta dimensión, donde los métodos lineales tradicionales podrían quedarse cortos.

Han surgido varias herramientas y bibliotecas para simplificar las tareas de ingeniería de características. Por ejemplo, el módulo de descomposición de Scikit-learn ofrece una serie de métodos para la reducción de la dimensionalidad, y PyCaret proporciona capacidades de selección automatizada de características.

Tanto los enfoques manuales como los automatizados tienen sus puntos fuertes. Veamos los puntos fuertes de cada enfoque.

|

Ingeniería manual |

Extracción automatizada |

|

Integración de conocimientos de dominio |

Escalabilidad |

|

Características interpretables |

Maneja patrones complejos |

|

Control detallado |

Reduce los prejuicios humanos |

|

Adaptado a necesidades específicas |

Descubre relaciones ocultas |

La elección entre métodos manuales y automatizados suele depender de factores como la complejidad del conjunto de datos, la disponibilidad de conocimientos especializados, los requisitos de interpretabilidad, los recursos informáticos y las limitaciones de tiempo.

Para conjuntos de datos muy complejos o cuando el tiempo y los recursos son limitados, los métodos automatizados pueden generar rápidamente características útiles. Por el contrario, los métodos manuales pueden ser preferibles cuando se dispone de experiencia en el dominio y la interpretabilidad es una prioridad, permitiendo una ingeniería de características a medida que se ajuste estrechamente al problema en cuestión.

En la práctica, muchos proyectos de aprendizaje automático de éxito combinan ambos enfoques, utilizando la experiencia en el dominio para guiar la ingeniería de características, al tiempo que aprovechan los métodos automatizados para descubrir patrones adicionales que podrían no ser inmediatamente evidentes para los expertos humanos.

En la siguiente sección, veremos varias técnicas de extracción de rasgos en diversos dominios.

Técnicas de extracción de características

Cada tipo de datos requiere técnicas específicas de extracción de rasgos optimizadas para sus características únicas. Veamos las técnicas más comunes para distintos tipos de datos.

Técnicas de extracción de características

Extracción de características de la imagen

La extracción de características de la imagen transforma los datos de píxeles en bruto en representaciones significativas que captan la información visual esencial. Hay tres categorías principales de técnicas utilizadas en la visión por ordenador moderna. Son los métodos tradicionales, los métodos basados en el aprendizaje profundo y los métodos estadísticos.

Métodos de extracción de características de la imagen

Veamos cada uno de los métodos.

Métodos tradicionales de visión por ordenador

La Transformada de Características Invariantes de Escala (SIFT) es un método robusto que detecta características locales distintivas en las imágenes. Funciona identificando puntos clave y generando descriptores que son:

- Invariante a la escala y rotación de la imagen

- Parcialmente invariable a los cambios de iluminación

- Resistente a la distorsión geométrica local

El algoritmo SIFT procesa las imágenes a través de varias etapas. Comienza con la detección de los extremos del espacio de escala para identificar posibles puntos clave invariantes con la escala. A continuación, la localización de puntos clave refina estos candidatos señalando sus ubicaciones precisas y descartando los puntos inestables.

A continuación, la asignación de orientación determina una orientación coherente para cada punto clave, garantizando la invariancia de la rotación. Por último, la generación de descriptores de puntos clave crea descriptores distintivos basados en los gradientes locales de la imagen, lo que facilita el emparejamiento robusto entre imágenes.

Otro método es el Histograma de Gradientes Orientados (HOG). Capta la información de forma local analizando los patrones de gradiente de una imagen. El proceso comienza calculando gradientes en toda la imagen para resaltar los detalles de los bordes.

A continuación, la imagen se divide en pequeñas celdas y, para cada celda, se crea un histograma de orientaciones de gradiente que resume la estructura local. Por último, estos histogramas se normalizan en bloques más grandes para garantizar su solidez frente a variaciones de iluminación y contraste, lo que da como resultado un descriptor de rasgos robusto para tareas como la detección y el reconocimiento de objetos.

Métodos de aprendizaje profundo

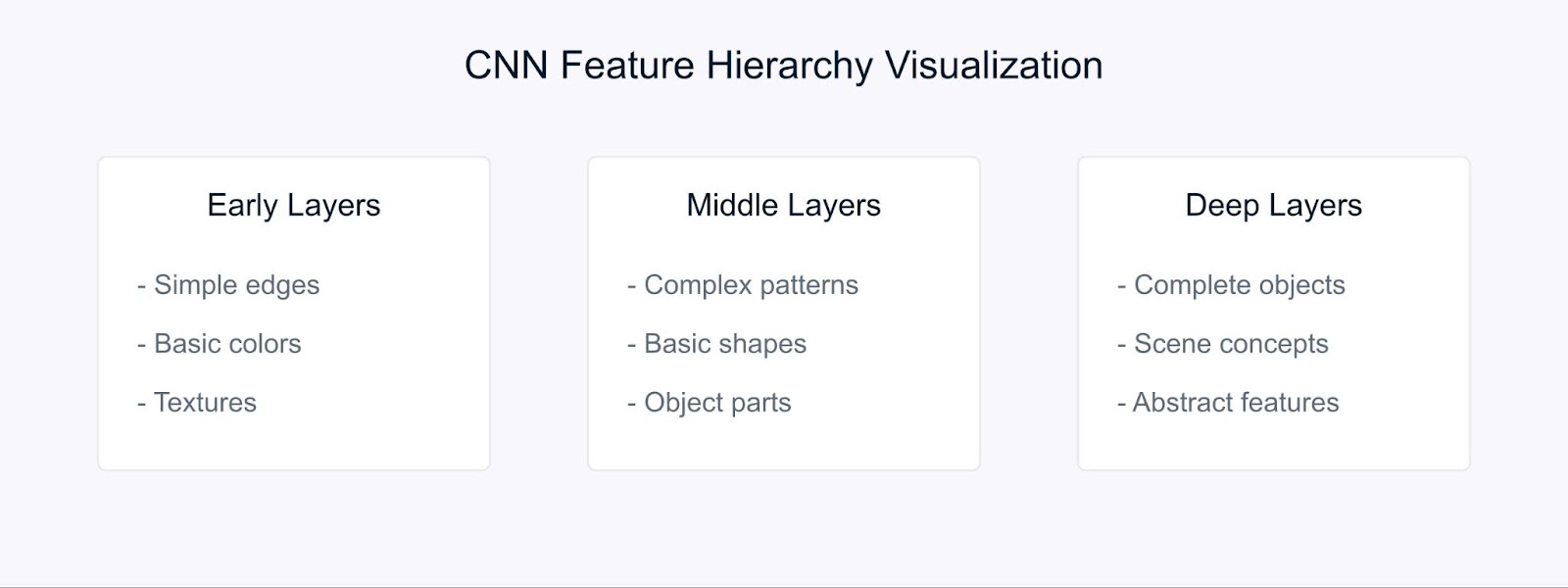

Las redes neuronales convolucionales (CNN) han cambiado nuestra forma de extraer características, al aprender automáticamente representaciones jerárquicas.

Extracción de características con CNN

Las CNN aprenden características a través de su estructura jerárquica. En las primeras capas, detectan elementos visuales básicos, como bordes y colores. A continuación, las capas intermedias combinan estos elementos para reconocer patrones y formas, mientras que las capas más profundas captan objetos complejos y permiten comprender la escena.

El aprendizaje por transferencia nos permite utilizar estas características preaprendidas de modelos entrenados en grandes conjuntos de datos, lo que las hace especialmente valiosas cuando se trabaja con datos limitados.

Métodos estadísticos

Los métodos estadísticos extraen patrones globales y locales de las imágenes, facilitando un análisis y una interpretación sólidos de las mismas.

Por ejemplo histogramas de color representan la distribución de los colores dentro de una imagen y proporcionan características invariantes de rotación y escala, lo que los hace especialmente útiles para tareas como la clasificación y recuperación de imágenes.

El análisis de texturas capta patrones repetidos y características de la superficie mediante técnicas como las matrices de co-ocurrencia de nivel de gris (GLCM), que son eficaces para aplicaciones como el reconocimiento de materiales y la clasificación de escenas.

Además, detección de bordes identifica los límites y los cambios de intensidad significativos mediante métodos como los operadores Sobel, Canny y Laplaciano, que desempeñan un papel crucial en la detección de objetos y el análisis de formas.

La elección del método de extracción de rasgos depende de varios factores. Debe ajustarse a los requisitos específicos de tu tarea, considerar los recursos informáticos disponibles y tener en cuenta la necesidad de interpretabilidad.

Además, las características de tu conjunto de datos -como su tamaño, niveles de ruido y complejidad- desempeñan un papel crucial, al igual que las propiedades de invariancia necesarias, como la escala, la rotación y la iluminación.

Extracción de características de audio

Imagina intentar enseñar a un ordenador a entender el habla como lo hacen los humanos. Aquí es donde entran en juego los Coeficientes Cepstrales de Frecuencia Mel (MFCC).

Los MFCC son características de audio especiales que descomponen el sonido de forma similar a como lo procesan nuestros oídos. Son especialmente eficaces porque se centran en las frecuencias a las que el ser humano es más sensible. Piensa que traducen el sonido a un formato que tanto los ordenadores como el oído humano encontrarían significativo.

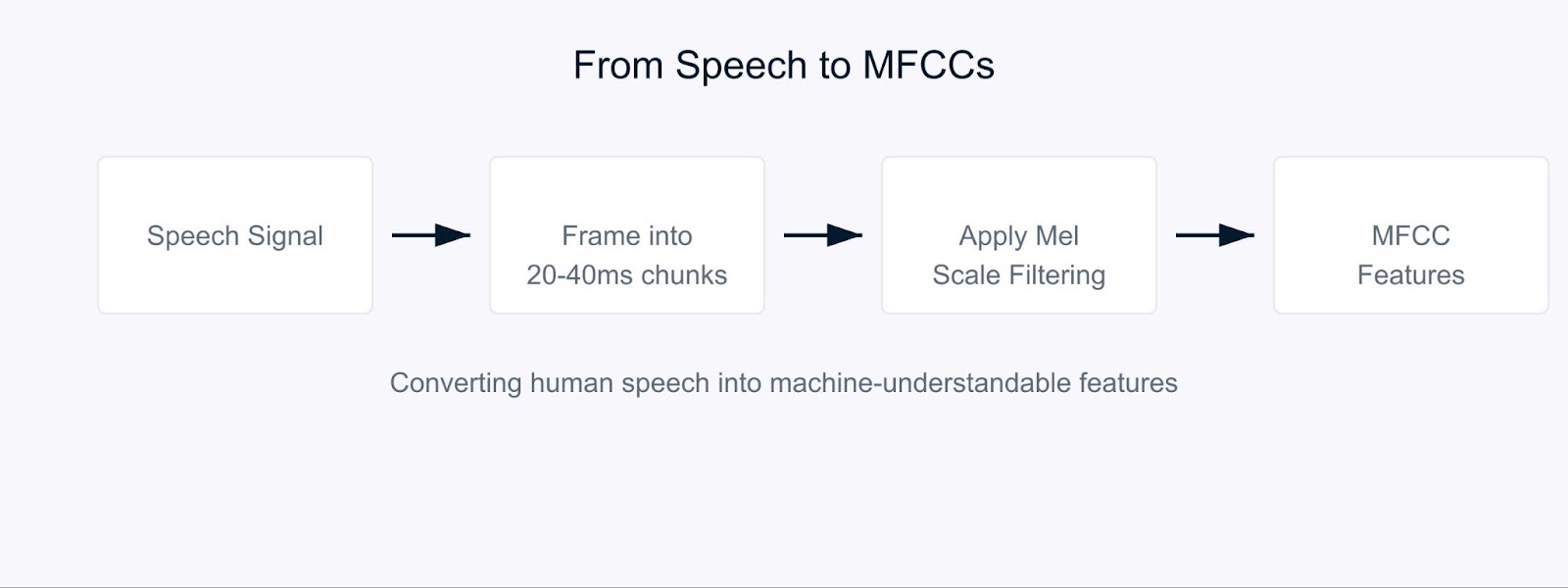

Coeficientes Cepstrales de Frecuencia Mel

El proceso comienza descomponiendo la señal de audio en trozos cortos, normalmente de 20-40 milisegundos. Para cada trozo, aplicamos una serie de transformaciones matemáticas que convierten las ondas sonoras brutas en componentes de frecuencia. Aquí es donde se pone interesante. En lugar de tratar todas las frecuencias por igual, utilizamos algo llamado escala de Mel.

![]()

Esta fórmula puede parecer compleja, pero no es más que mapear las frecuencias para que coincidan con la forma en que los humanos percibimos el sonido. Nuestros oídos detectan mejor las diferencias en las frecuencias bajas que en las altas, y la escala Mel tiene en cuenta este sesgo natural.

En el reconocimiento de voz, los MFCC sirven de base para entender quién habla y qué dice. Cuando hablas con el asistente virtual de tu teléfono, es probable que utilice MFCC para procesar tu voz. Estos coeficientes ayudan a captar las características únicas de la voz de cada persona, lo que los hace muy valiosos para los sistemas de identificación de locutores.

Para el análisis de sentimientos en el habla, los MFCC ayudan a detectar variaciones sutiles en la voz que indican emociones. Pueden captar cambios en el tono, el timbre y la velocidad del habla que pueden indicar si alguien está contento, triste, enfadado o neutro. Por ejemplo, al analizar las llamadas de atención al cliente, los MFCC pueden ayudar a identificar los niveles de satisfacción de los clientes basándose en cómo hablan, no sólo en lo que dicen.

Extracción de características de series temporales

Cuando trabajes con series temporales datos, extraer características significativas nos ayuda a captar pautas y tendencias que evolucionan con el tiempo. Veamos algunas técnicas clave utilizadas para transformar los datos brutos de las series temporales en características útiles.

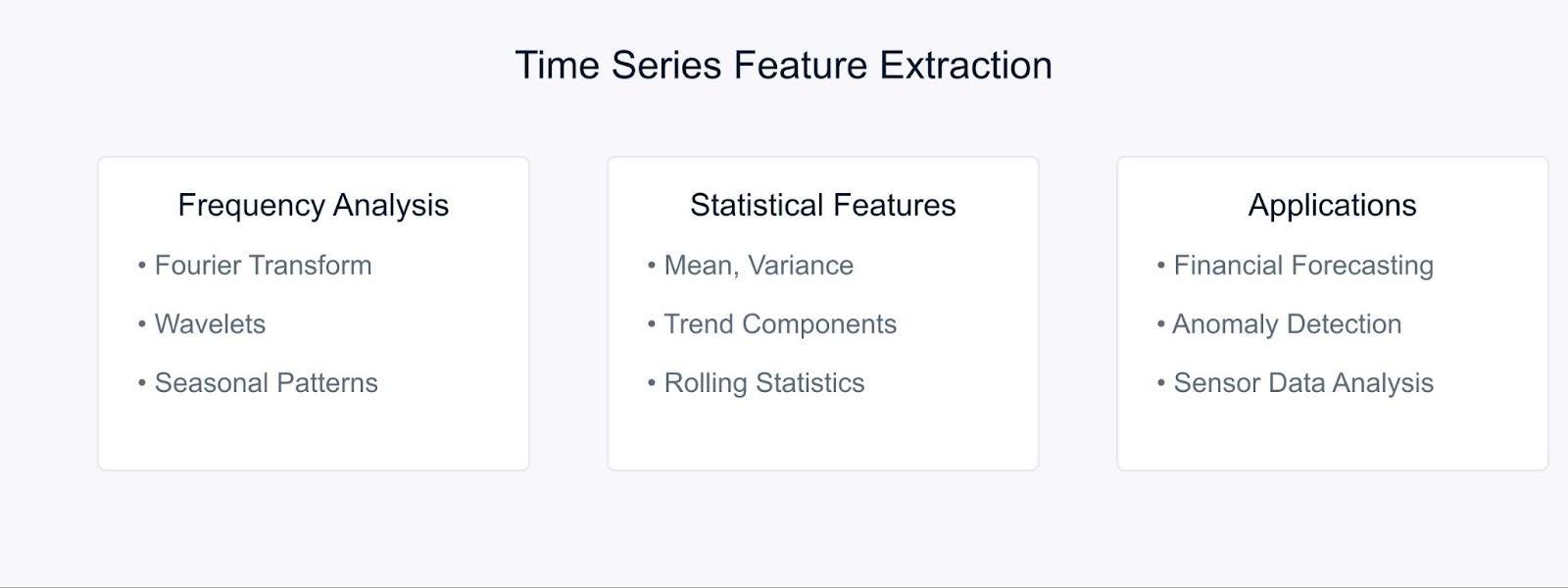

Métodos de extracción de características de series temporales

La Transformada de Fourier descompone los datos de las series temporales en sus componentes de frecuencia, revelando patrones periódicos ocultos. La fórmula es:

Los métodos estadísticos complementan el análisis de frecuencias captando las características temporales. Entre las características más comunes están las medias móviles, las desviaciones típicas y los componentes de tendencia. Estas técnicas son especialmente potentes en previsión financieradonde ayudan a identificar tendencias y anomalías del mercado.

Por ejemplo, en el análisis bursátil, la combinación de características de Fourier con medidas estadísticas puede revelar tanto tendencias a largo plazo como patrones cíclicos. Del mismo modo, en entornos industriales, estos métodos ayudan a detectar anomalías en los equipos analizando los patrones de datos de los sensores a lo largo del tiempo.

Herramientas y bibliotecas para la extracción de rasgos

Veamos algunas herramientas esenciales que hacen que la aplicación de estos métodos de extracción de rasgos sea sencilla y eficaz.

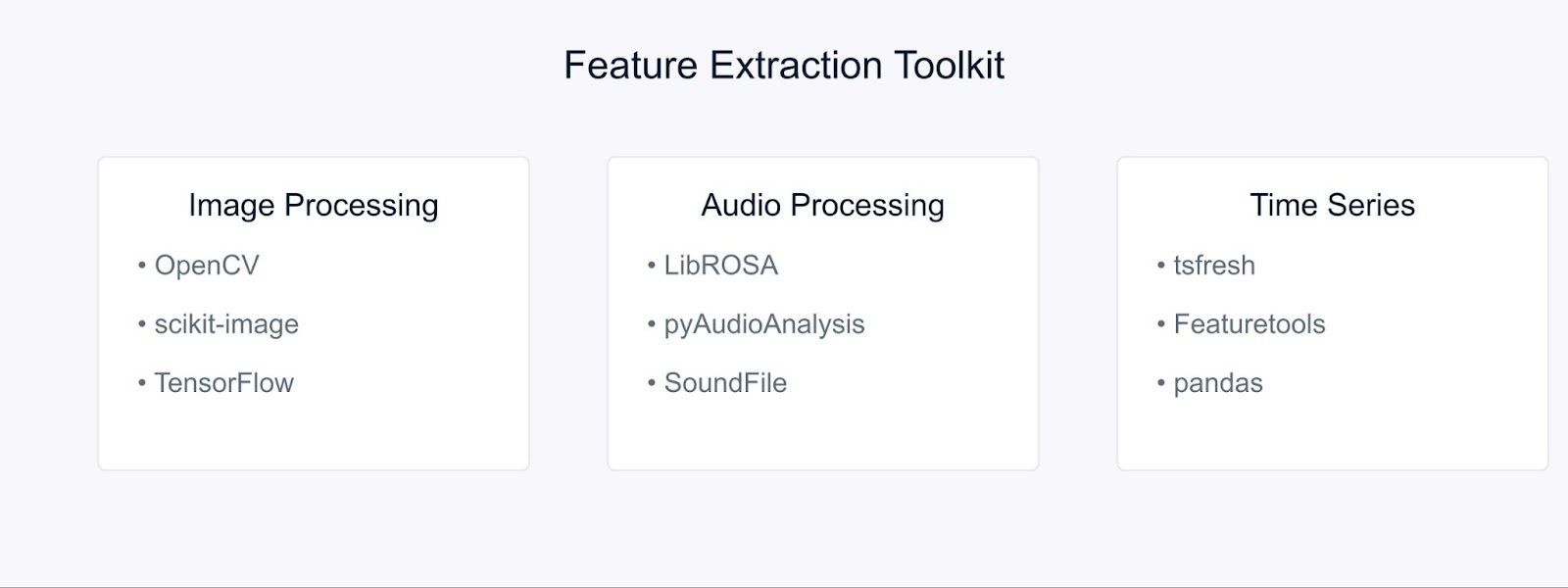

Herramientas y bibliotecas para la extracción de rasgos

Para el procesamiento de imágenes, OpenCV y scikit-image proporcionan herramientas completas para aplicar diversas técnicas de extracción de características. Estas bibliotecas ofrecen implementaciones eficientes de SIFT, HOG y otros algoritmos de los que hemos hablado antes. Cuando se trabaja con enfoques de aprendizaje profundo, marcos como TensorFlow y PyTorch adquieren un valor incalculable. Puedes empezar con nuestro tutorial de OpenCV para aprender más.

Las tareas de procesamiento de audio se simplifican con bibliotecas como LibROSA, que destaca en la extracción de MFCC y otras características acústicas. PyAudioAnalysis amplía estas capacidades con interfaces de alto nivel para tareas de análisis de audio.

Para los datos de series temporales, tsfresh y Featuretools automatizan el proceso de extracción de características. Estas bibliotecas pueden generar y seleccionar automáticamente características relevantes a partir de tus datos temporales, facilitando que te centres en el desarrollo de modelos en lugar de en la ingeniería de características.

Ejemplo de extracción de características

Pongamos en práctica nuestros conocimientos con algunos ejemplos prácticos. Empezaremos con la extracción de características de la imagen, una de las aplicaciones más comunes en visión por ordenador.

Extracción de características de imagen con OpenCV

En primer lugar, vamos a importar las bibliotecas necesarias

# Import required libraries

import cv2

import numpy as np

import matplotlib.pyplot as pltAhora, vamos a cargar una imagen para extraer las características relevantes. Para este ejemplo, utilizaremos una imagen de Godzilla descargada de Internet.

# Load the image

image = cv2.imread('godzilla.jpg')

# Convert BGR to RGB (OpenCV loads in BGR format)

image_rgb = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

# Display the original image

plt.imshow(image_rgb)

plt.title('Original Image')

plt.axis('off')

plt.show()Salida:

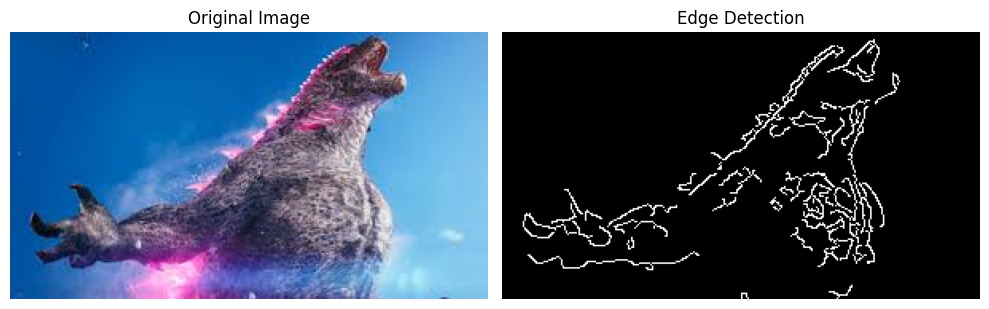

Antes de aplicar la detección de bordes, necesitamos preprocesar nuestra imagen. Lo hacemos de la siguiente manera:

# Convert the image to grayscale

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# Apply Gaussian blur to reduce noise

blurred = cv2.GaussianBlur(gray_image, (5, 5), 0)Por último, apliquemos el algoritmo de detección de bordes Canny y visualicemos los resultados:

# Apply Canny edge detection

edges = cv2.Canny(blurred, threshold1=100, threshold2=200)

# Display the results

plt.figure(figsize=(10, 5))

plt.subplot(1, 2, 1)

plt.imshow(image_rgb)

plt.title('Original Image')

plt.axis('off')

plt.subplot(1, 2, 2)

plt.imshow(edges, cmap='gray')

plt.title('Edge Detection')

plt.axis('off')

plt.tight_layout()

plt.show()Salida:

El detector de bordes Canny nos ayuda a identificar límites y rasgos importantes en nuestra imagen, que pueden utilizarse para análisis posteriores o como entrada para modelos de aprendizaje automático.

Extraer el MFCC del audio con LibROSA

Antes de empezar a procesar archivos de audio, tenemos que instalar las bibliotecas necesarias. Como LibROSA no está incluido en la biblioteca estándar de Python, utilizaremos pip para instalarlo:

# Install required libraries

# Run these commands in your terminal or command prompt

pip install librosa

pip install numpy

pip install matplotlibLibROSA es una potente biblioteca diseñada para el análisis de música y audio, así que vamos a empezar por importarla junto con otras bibliotecas necesarias:

# Import required libraries

import librosa

import librosa.display

import numpy as np

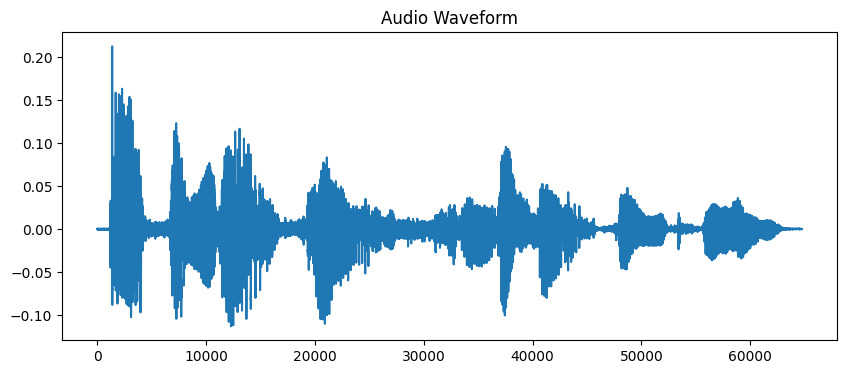

import matplotlib.pyplot as pltLos archivos de sonido contienen mucha información en formato de forma de onda. Para trabajar con estos datos, primero tenemos que cargarlos en nuestro programa. LibROSA nos ayuda a hacerlo convirtiendo el archivo de audio a un formato que podamos analizar:

# Load the audio file

# Duration is limited to 10 seconds for this example

audio_path = 'audio_sample.wav'

y, sr = librosa.load(audio_path, duration=10)

# Display the waveform

plt.figure(figsize=(10, 4))

plt.plot(y)

plt.title('Audio Waveform')

plt.show()Salida:

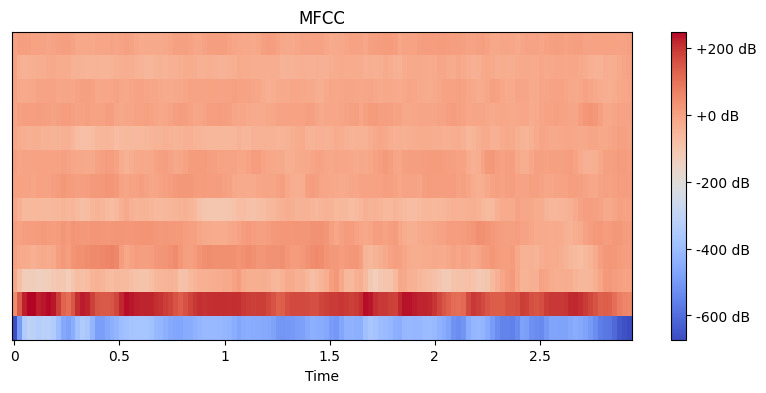

Ahora que tenemos nuestro audio cargado, tenemos que extraer características significativas de él. Nuestros oídos descomponen naturalmente el sonido en diferentes componentes de frecuencia, y la MFCC imita este proceso. Utilizamos la función de extracción de rasgos de Librosa para calcular estos coeficientes:

# Extract MFCC features

mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13)

# Display the MFCC

plt.figure(figsize=(10, 4))

librosa.display.specshow(mfccs, x_axis='time')

plt.colorbar(format='%+2.0f dB')

plt.title('MFCC')

plt.show()Salida:

Aquí fijamos n_mfcc=13 porque los 13 primeros coeficientes suelen captar los aspectos más importantes del sonido que ayudan en tareas como el reconocimiento del habla. La visualización resultante muestra cómo cambian estas características a lo largo del tiempo, donde los colores más vivos representan valores más altos.

Extracción de características de datos de series temporales con tsfresh

En primer lugar, vamos a instalar las bibliotecas necesarias. Utilizaremos yfinance para obtener datos financieros, junto con tsfresh para la extracción de características:

# Install required libraries

# Run these commands in your terminal or command prompt

pip install tsfresh

pip install pandas

pip install numpy

pip install matplotlib

pip install yfinanceAhora vamos a importar nuestras bibliotecas y a obtener algunos datos financieros reales:

# Import required libraries

import pandas as pd

import numpy as np

from tsfresh import extract_features

from tsfresh.feature_extraction import MinimalFCParameters

import matplotlib.pyplot as plt

import yfinance as yfConsigamos datos bursátiles reales. Utilizaremos los datos de las acciones de Apple como ejemplo:

# Download Apple's stock data for the last 2 years

aapl = yf.Ticker("AAPL")

df = aapl.history(period="2y")

# Prepare the data in the format tsfresh expects

df_tsfresh = pd.DataFrame({

'id': [0] * len(df), # Each time series needs an ID

'time': range(len(df)),

'closing_price': df['Close'] # We'll use closing prices

})

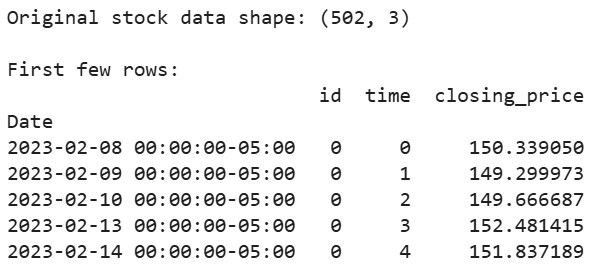

# Display first few rows of our data

print("Original stock data shape:", df_tsfresh.shape)

print("\nFirst few rows:")

print(df_tsfresh.head())Salida:

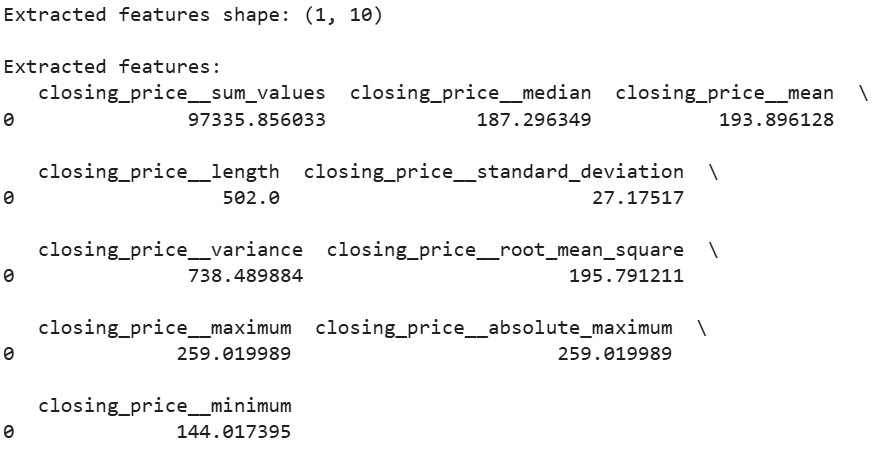

Ahora vamos a extraer características de nuestros datos de series temporales financieras:

# Set up the feature extraction parameters

extraction_settings = MinimalFCParameters()

# Extract features automatically

extracted_features = extract_features(df_tsfresh,

column_id='id',

column_sort='time',

column_value='values',

default_fc_parameters=extraction_settings)

# Display the extracted features

print("\nExtracted features shape:", extracted_features.shape)

print("\nExtracted features:")

print(extracted_features.head())Salida:

Aquí utilizamos MinimalFCParameters() para especificar qué características extraer. Esto nos proporciona un conjunto básico de características significativas de las series temporales, como la media, la varianza y las características de tendencia, que son esenciales para comprender los patrones de nuestros datos.

Retos en la extracción de características

Cuando trabajamos con la extracción de rasgos, a menudo nos encontramos con desafíos.

La alta dimensionalidad y las limitaciones computacionales surgen a menudo al tratar con grandes conjuntos de datos. Por ejemplo, extraer características de imágenes de alta resolución o archivos de audio largos puede consumir mucha memoria y potencia de procesamiento.

El sobreajuste debido a características irrelevantes o redundantes es otro reto común. Cuando se extraen demasiadas características, los modelos pueden aprender ruido en lugar de patrones significativos. Esto es especialmente común en el procesamiento de imágenes y audio, donde se pueden generar miles de características.

Para superar estos retos, considera estas estrategias:

- Utiliza el conocimiento del dominio para seleccionar las características relevantes

- Aplicar métodos de selección de rasgos para reducir la dimensionalidad

- Aplica técnicas adecuadas de ingeniería de características basadas en tu tipo de datos

Estos retos requieren una cuidadosa consideración y un equilibrio entre la riqueza de características y la eficiencia computacional.

Conclusión

La extracción de características es una habilidad fundamental en el aprendizaje automático que transforma los datos brutos en representaciones significativas. A través de nuestros ejemplos prácticos con OpenCV, LibROSA y tsfresh, hemos visto cómo extraer características de distintos tipos de datos. Comprendiendo estas técnicas y sus retos, podemos construir modelos de aprendizaje automático eficaces.

¿Listo para profundizar? Consulta estos recursos:

Preguntas frecuentes sobre la extracción de rasgos

¿Qué diferencia hay entre extracción de rasgos y selección de rasgos?

La extracción de rasgos crea nuevos rasgos a partir de los datos existentes, mientras que la selección de rasgos elige los rasgos existentes más relevantes.

¿Puede la extracción de características reducir el sobreajuste?

Sí, la extracción de rasgos puede reducir el sobreajuste al crear una representación más compacta de los datos.

¿Cómo mejora la extracción de características el rendimiento del modelo?

Reduce la complejidad de los datos y resalta los patrones importantes, lo que conduce a una mayor precisión y eficacia del modelo.

¿Cuándo debo utilizar la extracción de rasgos?

Utiliza la extracción de características cuando trates con datos de alta dimensión o cuando necesites captar patrones esenciales en tus datos.

Soy redactora de contenidos de ciencia de datos. Me encanta crear contenidos sobre temas de IA/ML/DS. También exploro nuevas herramientas de IA y escribo sobre ellas.