Cours

Si vous vous préparez à un entretien d'embauche dans le domaine de l'ingénierie cloud, vous êtes au bon endroit. Cet article aborde certaines des questions les plus fréquemment posées afin de vous aider à vous exercer et à renforcer votre confiance. Que vous aspiriez à un poste dans l'ingénierie cloud, le DevOps ou le MLOps, ces questions évalueront votre compréhension des concepts, de l'architecture et des meilleures pratiques du cloud.

Afin de rendre ce guide encore plus pratique, j'ai inclus des exemples de services proposés par les principaux fournisseurs de cloud computing (AWS, Azure et GCP) afin que vous puissiez observer comment différentes plateformes abordent les solutions cloud. Commençons sans plus attendre.

Questions d'entretien pour les ingénieurs cloud débutants

Ces questions fondamentales évaluent votre compréhension des concepts, des services et des modèles de déploiement du cloud computing. Votre entretien commencera généralement par quelques questions similaires.

1. Quels sont les différents types de modèles de cloud computing ?

Les trois principaux modèles de cloud sont les suivants :

- Infrastructure en tant que service (IaaS) : Fournit des ressources informatiques virtualisées sur Internet (par exemple, Amazon EC2, Google Compute Engine).

- Plateforme en tant que service (PaaS) : Fournit un environnement de développement avec des outils, des frameworks et une infrastructure pour la création d'applications (par exemple, AWS Elastic Beanstalk, Google App Engine).

- Logiciel en tant que service (SaaS) : Fournit des applications logicielles sur Internet sur la base d'un abonnement (par exemple, Google Workspace, Microsoft 365).

2. Quels sont les avantages du cloud computing ?

Voici quelques-uns des principaux avantages du cloud computing :

- Réduction des coûts : Aucun matériel sur site n'est nécessaire, ce qui réduit les coûts d'infrastructure.

- Évolutivité : Augmentez ou réduisez facilement vos ressources en fonction de la demande.

- Fiabilité : Les fournisseurs de cloud offrent une haute disponibilité grâce à plusieurs centres de données.

- Sécurité : Mesures de sécurité avancées, cryptage et certifications de conformité.

- Accessibilité : Accédez aux ressources depuis n'importe quel endroit disposant d'une connexion Internet.

3. Quels sont les différents types de modèles de déploiement cloud ?

Il existe quatre modèles principaux :

- Cloud public : Les services sont partagés entre plusieurs organisations et gérés par des fournisseurs tiers (par exemple, AWS, Azure, GCP).

- Cloud privé : Exclusif à une seule organisation, offrant un contrôle et une sécurité accrus.

- Cloud hybride : Une combinaison de clouds publics et privés, permettant le partage de données et d'applications entre eux.

- Multi-cloud: Utilise plusieurs fournisseurs de services cloud afin d'éviter la dépendance vis-à-vis d'un seul fournisseur et d'améliorer la résilience.

Modèles de déploiement dans le cloud. Image fournie par l'auteur.

4. Qu'est-ce que la virtualisation et quel est son lien avec le cloud computing ?

La virtualisation est le processus qui consiste à créer des instances virtuelles de ressources informatiques, telles que des serveurs, des systèmes de stockage et des réseaux, sur une seule machine physique. Il facilite le cloud computing en permettant une allocation efficace des ressources, la mutualisation et l'évolutivité.

Les technologies telles que Hyper-V, VMware et KVM sont couramment utilisées pour la virtualisation dans les environnements cloud.

5. Que sont les régions cloud et les zones de disponibilité ?

Une région cloud est une zone géographique distincte où les fournisseurs de services cloud hébergent plusieurs centres de données. Une zone de disponibilité (AZ) est un centre de données physiquement distinct au sein d'une région, conçu pour offrir redondance et haute disponibilité.

Par exemple, AWS dispose de plusieurs régions à travers le monde, chacune contenant au moins deux zones de disponibilité (AZ) pour la reprise après sinistre et la tolérance aux pannes.

6. En quoi l'élasticité du cloud diffère-t-elle de l'évolutivité du cloud ?

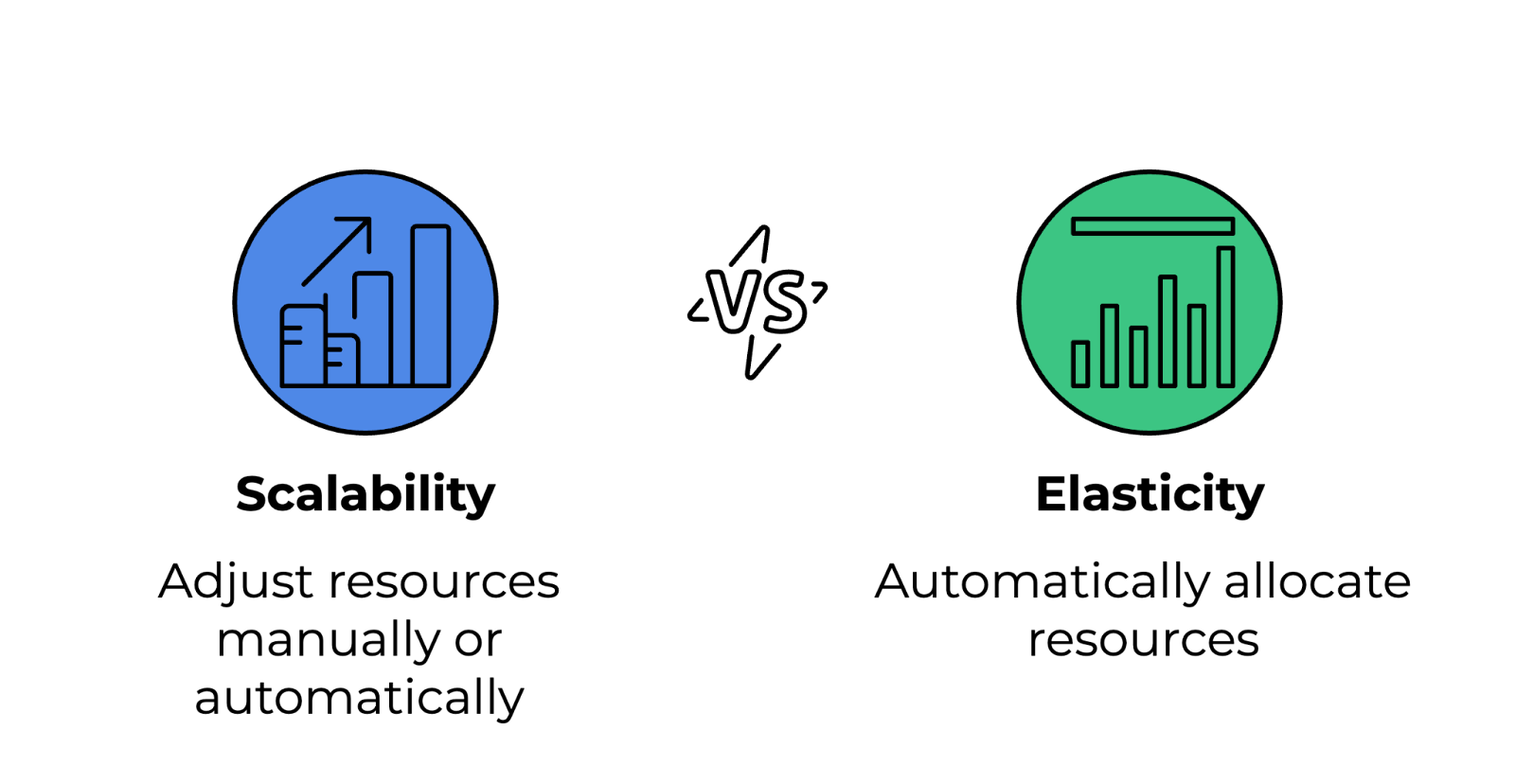

Voici les différences entre ces deux concepts :

- Évolutivité : La capacité d'augmenter ou de réduire les ressources manuellement ou automatiquement afin de s'adapter à la croissance. Il peut être vertical (augmentation/réduction de la puissance en ajoutant davantage de puissance aux instances existantes) ou horizontal (augmentation/réduction en ajoutant ou en supprimant des instances).

- Élasticité : La capacité d'allouer et de désallouer automatiquement des ressources en réponse aux changements de la demande en temps réel. L'élasticité est une caractéristique essentielle de l'informatique sans serveur et des services à dimensionnement automatique.

Différence entre évolutivité et élasticité. Image fournie par l'auteur.

7. Quels sont les principaux fournisseurs de services cloud et comment se comparent-ils ?

Le tableau suivant répertorie les principaux fournisseurs de services cloud, leurs points forts et leurs cas d'utilisation :

|

Fournisseur de services cloud |

Points forts |

Cas d'utilisation |

|

Amazon Web Services (AWS) |

Le plus important fournisseur de services cloud proposant une vaste gamme de services. |

Informatique en cloud à usage général, sans serveur, DevOps. |

|

Microsoft Azure |

Spécialisé dans les solutions cloud d'entreprise et hybrides. |

Applications d'entreprise, cloud hybride, intégration de l'écosystème Microsoft. |

|

Plateforme Google Cloud (GCP) |

Spécialisé dans le big data, l'IA/ML et Kubernetes. |

Apprentissage automatique, analyse de données, orchestration de conteneurs. |

|

IBM Cloud |

Spécialisé dans l'intelligence artificielle et les solutions cloud pour les entreprises. |

Applications basées sur l'intelligence artificielle, transformation cloud des entreprises. |

|

Oracle Cloud |

Fort en bases de données et applications d'entreprise. |

Gestion de bases de données, applications ERP, charges de travail d'entreprise. |

8. Qu'est-ce que l'informatique sans serveur et comment fonctionne-t-elle ?

Le calcul sans serveur est un modèle d'exécution dans le cloud où le fournisseur de cloud gère automatiquement l'infrastructure, permettant ainsi aux développeurs de se concentrer sur l'écriture de code. Les utilisateurs ne paient que pour le temps d'exécution réel plutôt que pour la mise à disposition de ressources fixes. Voici quelques exemples :

- AWS Lambda

- Fonctions Azure

- Fonctions Google Cloud

9. Qu'est-ce que le stockage d'objets dans le cloud ?

Le stockage objet est une architecture de stockage de données dans laquelle les fichiers sont stockés sous forme d'objets distincts dans un espace de noms plat plutôt que dans des systèmes de fichiers hiérarchiques. Il est hautement évolutif et utilisé pour les données non structurées, les sauvegardes et le stockage multimédia. Voici quelques exemples :

- Amazon S3 (AWS)

- Stockage Blob Azure (Azure)

- Stockage Google Cloud (GCP)

10. Qu'est-ce qu'un réseau de diffusion de contenu (CDN) dans le cloud computing ?

Un CDN est un réseau de serveurs distribués qui mettent en cache et fournissent du contenu (par exemple, des images, des vidéos, des pages Web) aux utilisateurs en fonction de leur emplacement géographique. Cela permet de réduire la latence, d'améliorer les performances du site Web et d'augmenter la disponibilité. Les CDN les plus populaires sont les suivants :

- Amazon CloudFront

- Azure CDN

- Cloudflare

Questions d'entretien pour les ingénieurs cloud intermédiaires

Ces questions approfondissent les thèmes du réseau cloud, de la sécurité, de l'automatisation et de l'optimisation des performances, évaluant votre capacité à concevoir, gérer et dépanner efficacement des environnements cloud.

11. Qu'est-ce qu'un cloud privé virtuel (VPC) et pourquoi est-il important ?

Un cloud privé virtuel (VPC) est une section logiquement isolée d'un cloud public qui permet aux utilisateurs de déployer des ressources dans un environnement réseau privé. Il offre un contrôle accru sur les configurations réseau, les politiques de sécurité et la gestion des accès.

Dans un VPC, les utilisateurs peuvent définir des plages d'adresses IP à l'aide de blocs CIDR. Des sous-réseaux peuvent être créés pour séparer les ressources publiques et privées, tandis que les groupes de sécurité et les listes de contrôle d'accès réseau contribuent à appliquer les politiques d'accès au réseau.

12. Comment fonctionne un équilibreur de charge dans le cloud ?

Les équilibreurs de charge répartissent le trafic réseau entrant entre plusieurs serveurs afin de garantir une haute disponibilité, une tolérance aux pannes et de meilleures performances.

Il existe différents types d'équilibreurs de charge :

- Équilibreurs de charge applicatifs (ALB) : Fonctionne au niveau de la couche 7 (HTTP/HTTPS), acheminant le trafic en fonction de règles de contenu.

- Équilibreurs de charge réseau (NLB) : Fonctionne à la couche 4 (TCP/UDP), offrant un routage à très faible latence.

- Équilibreurs de charge classiques (CLB) : Option héritée pour l'équilibrage entre les couches 4 et 7.

13. Qu'est-ce que l'IAM (gestion des identités et des accès) et comment est-il utilisé ?

IAM est un cadre qui contrôle qui peut accéder aux ressources cloud et quelles actions ils peuvent effectuer. Il contribue à appliquer le principe du moindre privilège et sécurise les environnements cloud.

Dans l'IAM, les utilisateurs et les rôles définissent des identités avec des autorisations spécifiques, les politiques accordent ou refusent l'accès à l'aide de règles basées sur JSON, et l'authentification multifactorielle (MFA) ajoute une couche de sécurité supplémentaire pour les opérations critiques.

14. Que sont les groupes de sécurité et les listes de contrôle d'accès réseau, et en quoi diffèrent-ils ?

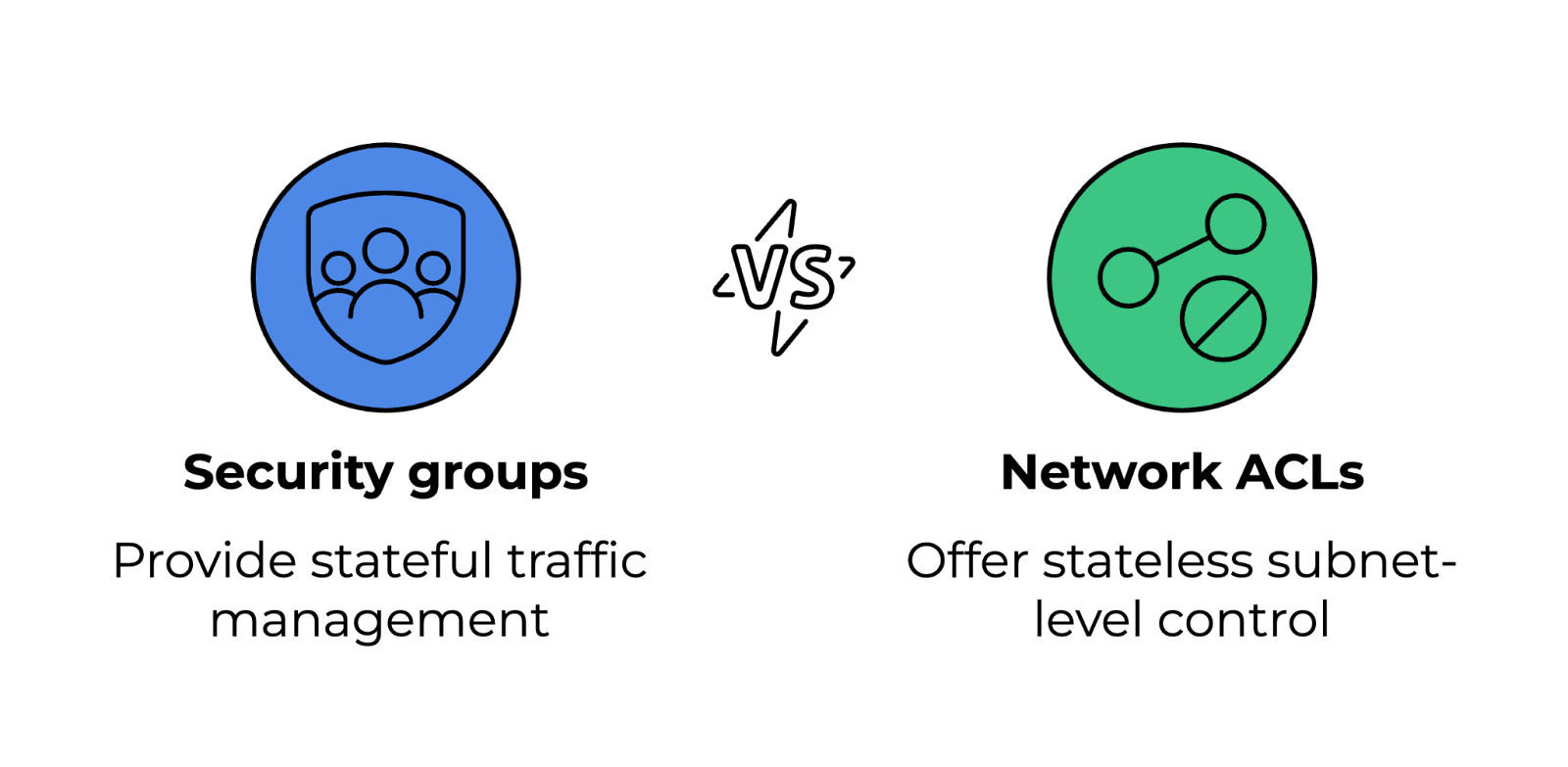

Les groupes de sécurité et les listes de contrôle d'accès réseau (ACL) gèrent le trafic entrant et sortant vers les ressources cloud, mais fonctionnent à différents niveaux.

- Groupes de sécurité : Agissent comme des pare-feu, autorisant ou refusant le trafic en fonction de règles. Ils sont avec état, ce qui signifie que les modifications apportées aux règles entrantes se reflètent automatiquement dans les règles sortantes.

- ACL réseau : Contrôlent le trafic au niveau du sous-réseau et sont sans état. Ils nécessitent des règles explicites pour le trafic entrant et sortant afin de permettre un échange bidirectionnel.

Comparaison des groupes de sécurité et des listes de contrôle d'accès réseau. Image fournie par l'auteur.

15. Qu'est-ce qu'un hôte bastion et pourquoi est-il utilisé ?

Un hôte bastion est un serveur relais sécurisé permettant d'accéder aux ressources cloud dans un réseau privé. Au lieu d'exposer tous les serveurs à Internet, il agit comme une passerelle pour les connexions à distance.

Afin de renforcer la sécurité, il est recommandé de mettre en place des règles de pare-feu strictes, n'autorisant l'accès SSH ou RDP qu'à partir d'adresses IP fiables. L'authentification multifactorielle (MFA) et l'authentification par clé doivent être utilisées pour sécuriser l'accès, et la journalisation et la surveillance doivent être activées afin de suivre les tentatives de connexion non autorisées.

16. Comment fonctionne l'autoscaling dans le cloud ?

L'autoscaling permet aux environnements cloud d'ajuster dynamiquement les ressources en fonction de la demande, garantissant ainsi rentabilité et performances. Il fonctionne de deux manières :

- Mise à l'échelle horizontale (scaling out/in) : Ajoute ou supprime des instances en fonction de la charge.

- Mise à l'échelle verticale (augmentation/réduction) : Permet d'ajuster les ressources (CPU, mémoire) d'une instance existante.

Les fournisseurs de cloud proposent des groupes à dimensionnement automatique qui fonctionnent avec des équilibreurs de charge afin de répartir efficacement le trafic.

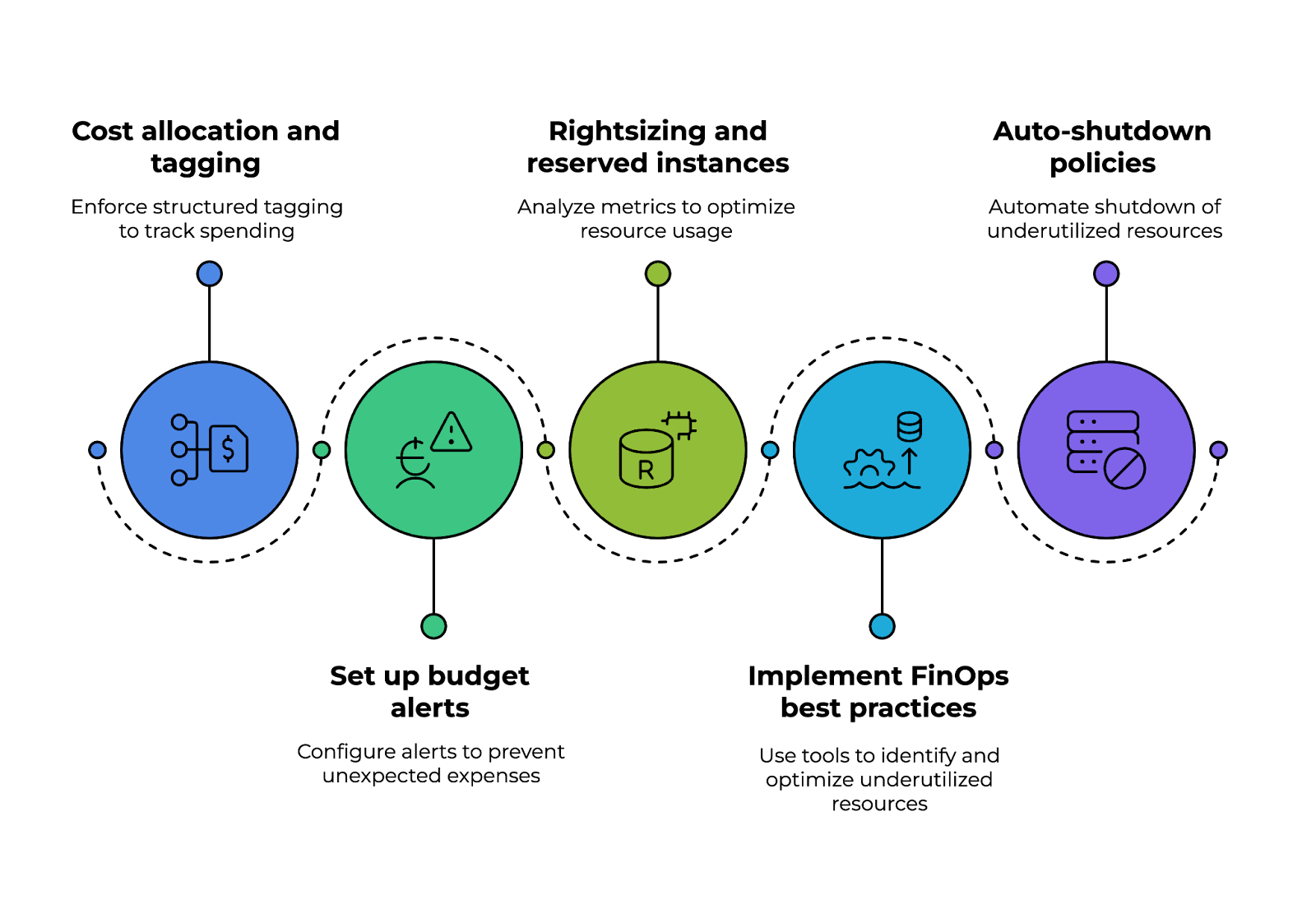

17. Comment garantissez-vous l'optimisation des coûts du cloud ?

Une gestion efficace des coûts du cloud nécessite de surveiller l'utilisation et de sélectionner les modèles de tarification appropriés. Les stratégies d'optimisation des coûts comprennent :

- Utilisation d'instances réservées pour les charges de travail à long terme afin d'obtenir des remises.

- Utilisation des instances spot pour les charges de travail de courte durée.

- Mise en place d'alertes budgétaires et d'outils de surveillance des coûts tels qu'AWS Cost Explorer ou Azure Cost Management.

- Optimisation de la taille des instances grâce à l'analyse de l'utilisation du processeur, de la mémoire et du réseau.

Souhaitez-vous maîtriser la sécurité AWS et optimiser les coûts liés au cloud ? Nous vous invitons à consulter le cours AWS Security and Cost Management pour découvrir les meilleures pratiques essentielles.

Optimisation des coûts du cloud : quatre piliers. Image fournie par l'auteur.

18. Quelles sont les différences entre Terraform et CloudFormation ?

Terraform et AWS CloudFormation sont tous deux des outils d'infrastructure en tant que code (IaC), mais ils présentent certaines différences :

|

Caractéristique |

Terraform |

AWS CloudFormation |

|

Assistance cloud |

Indépendant du cloud, compatible avec AWS, Azure, GCP et d'autres. |

Spécifique à AWS, conçu exclusivement pour les ressources AWS. |

|

Langage de configuration |

Utilise le langage de configuration HashiCorp (HCL). |

Utilise des modèles JSON/YAML. |

|

Gestion de l'État |

Gère un fichier d'état pour suivre les modifications apportées à l'infrastructure. |

Utilise des piles pour gérer et suivre les déploiements. |

19. Comment surveillez-vous les performances du cloud et résolvez-vous les problèmes ?

Les outils de surveillance permettent de détecter les goulots d'étranglement en matière de performances, les menaces de sécurité et la surutilisation des ressources. Les solutions de surveillance courantes comprennent :

- AWS CloudWatch: Surveille les mesures, les journaux et les alarmes.

- Azure Monitor : Fournit des informations sur les applications et l'infrastructure.

- Google Cloud Operations (anciennement Stackdriver) : Permet la journalisation et la surveillance en temps réel.

20. Comment la conteneurisation améliore-t-elle les déploiements cloud ?

Les conteneurs regroupent des applications avec leurs dépendances, ce qui les rend légers, portables et évolutifs. Par rapport aux machines virtuelles, les conteneurs utilisent moins de ressources, car plusieurs conteneurs peuvent fonctionner sur un seul système d'exploitation.

Docker et Kubernetes permettent un déploiement et une restauration plus rapides. De plus, ils s'adaptent facilement à des outils d'orchestration tels que Kubernetes et Amazon ECS/EKS.

Souhaitez-vous perfectionner vos compétences en matière de conteneurisation ? , le cursus « Conteneurisation et virtualisation » couvreDocker, Kubernetes et bien d'autres thèmes pour vous aider à créer des applications cloud évolutives.

21. Qu'est-ce qu'un maillage de services et pourquoi est-il utilisé dans les applications cloud ?

Un maillage de services est une couche d'infrastructure qui gère la communication entre services dans les applications cloud basées sur des microservices. Il prévoit :

- Gestion du trafic : Permet un routage intelligent et un équilibrage de charge.

- Sécurité : Implémente le chiffrement TLS mutuel pour une communication sécurisée.

- Observabilité : Suivi des cursus de demandes et des journaux à des fins de débogage.

Parmi les solutions de maillage de services les plus populaires, on peut citer Istio, Linkerd et AWS App Mesh.

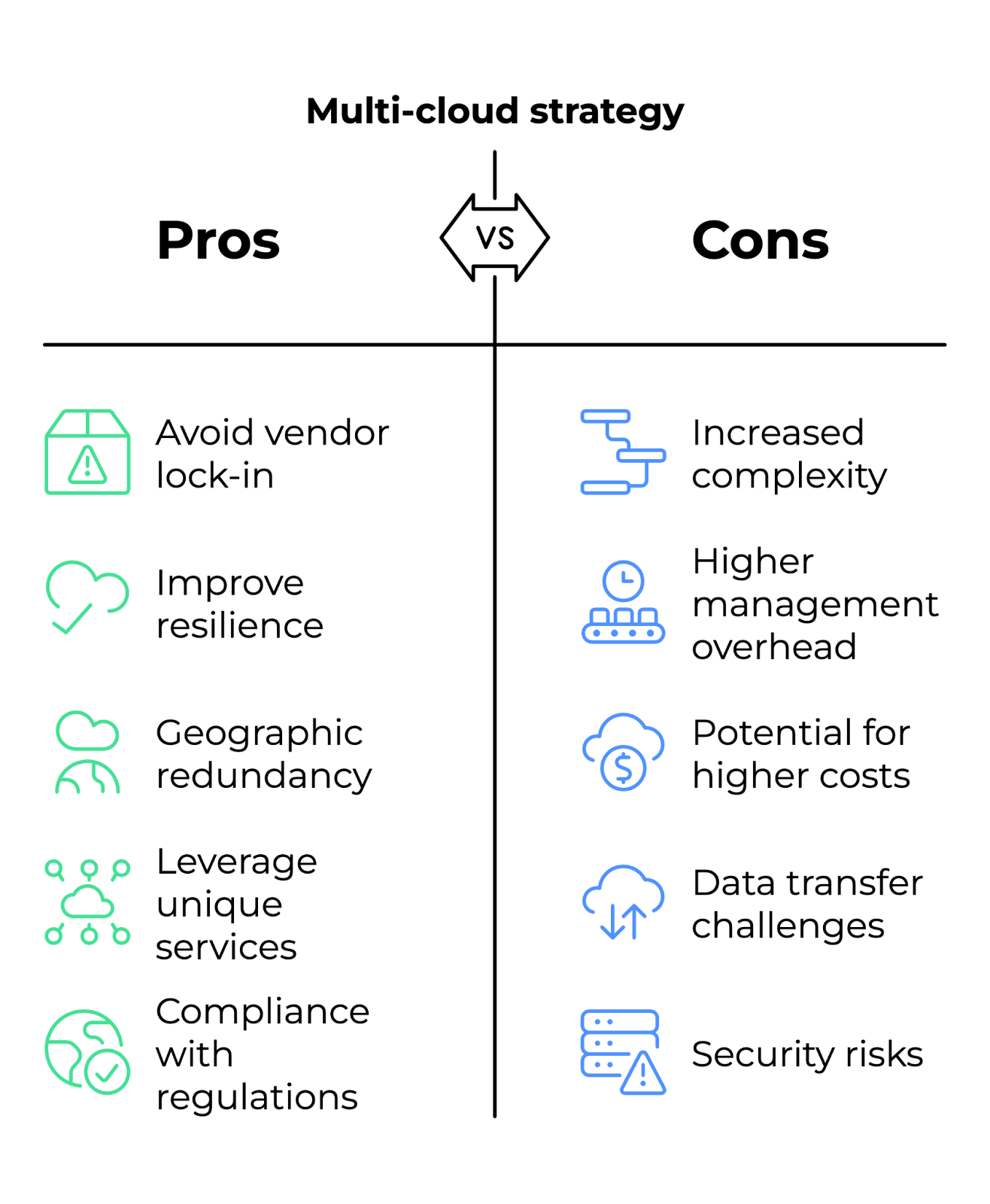

22. Qu'est-ce qu'une stratégie multi-cloud, et dans quelles circonstances une entreprise devrait-elle l'adopter ?

Une stratégie multicloud consiste à utiliser plusieurs fournisseurs de cloud (AWS, Azure, GCP) afin d'éviter la dépendance vis-à-vis d'un seul fournisseur et d'améliorer la résilience.

Les entreprises optent pour cette approche lorsqu'elles ont besoin d'une redondance géographique pour la reprise après sinistre, souhaitent tirer parti des services uniques de différents fournisseurs (par exemple, AWS pour le calcul, GCP pour l'IA) ou doivent se conformer à des réglementations régionales qui limitent le choix des fournisseurs de cloud.

Avantages et inconvénients de la stratégie multicloud. Image fournie par l'auteur.

Questions d'entretien pour les ingénieurs cloud avancés

Ces questions évaluent votre capacité à concevoir des solutions évolutives, à gérer des infrastructures cloud complexes et à traiter des scénarios critiques.

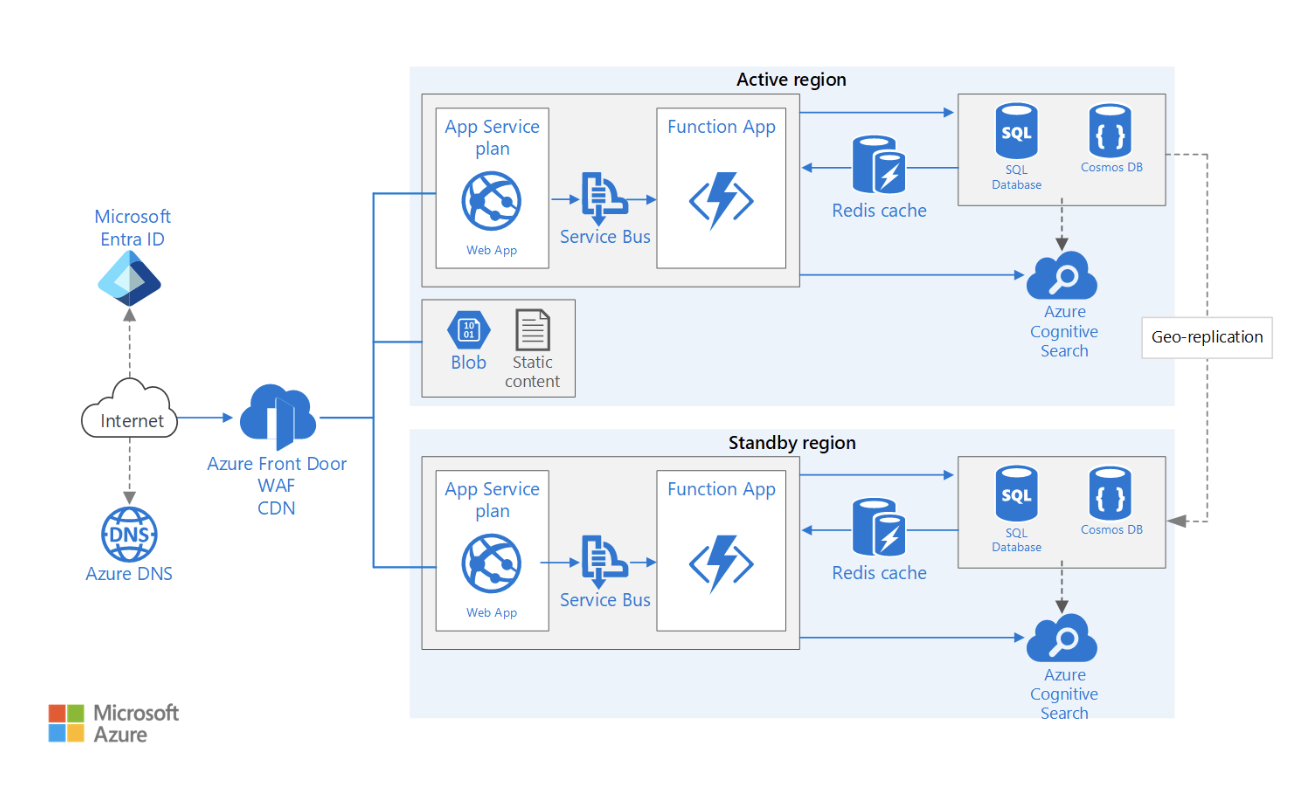

23. Comment concevez-vous une architecture cloud multirégionale à haute disponibilité ?

Une architecture multirégionale garantit un temps d'indisponibilité minimal et la continuité des activités en répartissant les ressources sur plusieurs sites géographiques.

Lors de la conception d'une telle architecture, plusieurs facteurs doivent être pris en compte. Voici quelques-uns d'entre eux :

- Réplication des données : Utilisez des bases de données mondiales (par exemple, Amazon DynamoDB Global Tables, Azure Cosmos DB) pour synchroniser les données entre les régions tout en conservant une faible latence en lecture et en écriture.

- Répartition du trafic : Déployez des équilibreurs de charge mondiaux (par exemple, AWS Global Accelerator, Azure Traffic Manager) pour diriger les utilisateurs vers la région la plus proche et la plus performante.

- Stratégie de basculement : Mettez en œuvre des modèles de basculement actif-actif (les deux régions gèrent le trafic) ou actif-passif (une région en veille) avec le basculement DNS Route 53.

- Applications avec état et sans état : Pour permettre une transition fluide entre les régions, veuillez vous assurer que les données de session sont stockées de manière centralisée (par exemple, ElastiCache, Redis ou une base de données partagée) plutôt que sur des instances individuelles.

- Considérations relatives à la conformité et à la latence : Évaluer les lois relatives à la souveraineté des données (par exemple, le RGPD, la loi HIPAA) et optimiser la proximité des utilisateurs afin de réduire la latence.

Exemple d'architecture d'application web multirégionale à haute disponibilité. Source de l'image : Microsoft Learn

24. Comment gérez-vous la sécurité dans une application cloud native avec un modèle « zero trust » ?

Le modèle « zero trust » part du principe qu'aucune entité, qu'elle soit interne ou externe au réseau, ne doit être considérée comme fiable par défaut.

Pour mettre en œuvre le modèle Zero Trust dans les environnements cloud :

- Vérification d'identité : Appliquez une authentification forte à l'aide de l'authentification multifactorielle (MFA) et de fournisseurs d'identité fédérés (par exemple, Okta, AWS IAM Identity Center).

- Accès avec privilèges minimaux : Appliquez le contrôle d'accès basé sur les rôles (RBAC) ou le contrôle d'accès basé sur les attributs (ABAC) pour accorder des autorisations en fonction des rôles professionnels et du contexte en temps réel.

- Micro-segmentation : Utilisez des pare-feu, des politiques réseau et des maillages de services (par exemple, Istio, Linkerd) pour isoler les charges de travail et appliquer des règles de communication strictes.

- Surveillance et audit continus : Déployez des solutions de gestion des informations et des événements de sécurité (SIEM) (par exemple, AWS GuardDuty, Azure Sentinel) afin de détecter et de réagir aux anomalies.

- Chiffrement de bout en bout : Veuillez garantir le chiffrement TLS pour toutes les communications et mettre en œuvre des clés gérées par le client (CMK) pour le chiffrement des données au repos.

25. Comment mettre en œuvre une stratégie efficace de gouvernance des coûts du cloud ?

Une stratégie efficace commence par répartition et au marquage des coûts, où les organisations appliquent un étiquetage structuré (par exemple, département, projet, propriétaire) pour suivre les dépenses entre les équipes et améliorer la visibilité financière.

Il est recommandé de configurerdes alertes budgétairesautomatisées à l'aide d'outils tels que AWS Budgets, Azure Cost Management ou GCP Billing Alerts afin d'éviter les dépenses imprévues. Ces solutions offrent une surveillance en temps réel et des notifications lorsque l'utilisation approche des seuils prédéfinis.

Un autre aspect concerne le dimensionnement optimal et les instances réservées. En analysant en permanence les indicateurs d'utilisation des instances, tels que le CPU et la mémoire, les équipes peuvent déterminer si les charges de travail doivent être ajustées ou migrées vers des instances réservées ou des instances spot, qui permettent de réaliser des économies significatives.

La mise en œuvre des meilleures pratiques FinOps améliore encore davantage la rentabilité. Les outils automatisés de détection des anomalies de coûts, tels que Kubecost (pour les environnements Kubernetes) et AWS Compute Optimizer, permettent d'identifier de manière proactive les ressources sous-utilisées et de les optimiser.

Enfin, les politiques d'arrêt automatique jouent un rôle essentiel dans la réduction des déchets. Les fonctions sans serveur, telles qu'AWS Lambda ou Azure Functions, peuvent automatiquement désactiver les ressources sous-utilisées en dehors des heures de bureau, évitant ainsi des dépenses inutiles.

Piliers de la mise en œuvre de la stratégie de gouvernance des coûts du cloud. Image fournie par l'auteur.

26. Comment optimisez-vous les performances de stockage des données dans un lac de données basé sur le cloud ?

Un lac de données nécessite un stockage, une récupération et un traitement efficaces de données à l'échelle du pétaoctet. Certaines stratégies d'optimisation comprennent :

- Hiérarchisation du stockage : Veuillez utiliser Amazon S3 Intelligent-Tiering et Azure Blob Storage Tiers pour transférer les données rarement consultées vers des classes de stockage plus économiques.

- Partitionnement et indexation : Mettez en œuvre un partitionnement de type Hive pour accélérer les requêtes et utilisez AWS Glue Data Catalog et les partitions Google BigQuery pour améliorer l'indexation.

- Sélection du format de compression et de fichier : Veuillez utiliser Parquet ou ORC plutôt que CSV/JSON pour un stockage efficace et un traitement analytique plus rapide.

- Optimisation des requêtes sur les lacs de données : Veuillez utiliser des moteurs de requête sans serveur tels qu', Amazon Athena, Google BigQuery ou Presto pour un accès plus rapide aux données sans avoir à provisionner d'infrastructure.

27. Quels sont les éléments à prendre en compte lors de la conception d'un pipeline CI/CD cloud natif ?

L'un des aspects fondamentauxd'un pipeline CI/CD est la gestion des versions de code et des référentiels, qui permet une collaboration efficace et le suivi des modifications. Des outils tels que GitHub Actions, AWS CodeCommit ou Azure Repos facilitent la gestion du code source, la mise en œuvre de stratégies de branchement et la rationalisation des workflows de pull request.

Les s d'automatisationde la construction et de gestion des artefacts jouent un rôle crucial dans le maintien de la cohérence et de la fiabilité des constructions logicielles. Grâce aux builds basés sur Docker, JFrog Artifactory ou AWS CodeArtifact, les équipes peuvent créer des builds reproductibles, stocker des artefacts en toute sécurité et garantir le contrôle des versions dans tous les environnements de développement.

La sécurité est un autre aspect essentiel à prendre en considération. L'intégration d'outils SAST (tests de sécurité statiques des applications) tels que SonarQube ou Snyk permet une détection précoce des vulnérabilités dans le code source. De plus, l'application des images de conteneur signées garantit que seuls les artefacts vérifiés et fiables sont déployés.

Une stratégie de déploiementrobuste en plusieurs étapes contribue à minimiser les risques associés aux versions logicielles. Des approches telles que les déploiements canary, bleu-vert ou progressifs permettent des mises en œuvre graduelles, réduisant ainsi les temps d'arrêt et permettant une surveillance des performances en temps réel. Grâce aux indicateurs de fonctionnalité, les équipes peuvent déterminer quels utilisateurs auront accès aux nouvelles fonctionnalités avant leur lancement complet.

Enfin, l'intégration de l'infrastructure en tant que code (IaC) est essentielle pour automatiser et standardiser les environnements cloud. En utilisant Terraform, AWS CloudFormation ou Pulumi, les équipes peuvent définir l'infrastructure dans le code, maintenir la cohérence entre les déploiements et permettre l'approvisionnement des ressources cloud.

Mise en œuvre d'un pipeline CI/CD natif du cloud. Image fournie par l'auteur.

28. Comment mettez-vous en œuvre la reprise après sinistre (DR) pour une application cloud critique pour l'entreprise ?

La reprise après sinistre (DR) est essentielle pour assurer la continuité des activités en cas de pannes, d'attaques ou de défaillances matérielles. Un plan de reprise après sinistre efficace comprend les éléments suivants :

- Objectif de point de reprise (RPO) et objectif de temps de reprise (RTO) : Définissez la perte de données acceptable (RPO) et la durée d'indisponibilité acceptable (RTO).

- Sauvegarde et réplication : Veuillez utiliser la réplication inter-régions, AWS Backup ou Azure Site Recovery pour maintenir des sauvegardes à jour.

- Stratégies de basculement : Mettez en œuvre des architectures actives-actives (hot standby) ou actives-passives (warm/cold standby).

- Tests et automatisation : Veuillez tester régulièrement les plans de reprise après sinistre à l'aide d'outils d'ingénierie du chaos tels que AWS Fault Injection Simulator ou Gremlin.

29. Quels sont les défis liés à la gestion de Kubernetes à grande échelle dans un environnement cloud ?

La gestion de clusters Kubernetes (K8s) à grande échelle présente des défis opérationnels et de performance. Les principaux domaines à traiter sont les suivants :

- Auto-scaling des clusters : Veuillez utiliser Cluster Autoscaler ou Karpenter pour ajuster de manière dynamique le nombre de nœuds en fonction des exigences de la charge de travail.

- Optimisation de la charge de travail : Mettre en œuvre un autoscaler horizontal (HPA) et un autoscaler vertical (VPA) pour une allocation efficace des ressources.

- Réseautage et maillage de services : Utilisez Istio ou Linkerd pour gérer la communication et la sécurité entre les services.

- Observabilité et dépannage : Déployez Prometheus, Grafana et Fluentd pour surveiller les journaux, les métriques et les traces.

- Renforcement de la sécurité : Utilisez les politiques de sécurité des pods (PSP), le contrôle d'accès basé sur les rôles (RBAC) et l'analyse des images de conteneurs pour atténuer les vulnérabilités.

Questions d'entretien pour les ingénieurs cloud basées sur des scénarios

Les questions basées sur des scénarios évaluent votre capacité à analyser les défis réels du cloud, à résoudre les problèmes et à prendre des décisions architecturales dans le cadre de différentes contraintes.

Vos réponses doivent démontrer votre expérience pratique, votre capacité à prendre des décisions et à faire des compromis lors de la résolution de problèmes liés au cloud. Étant donné qu'il n'existe pas de bonnes ou de mauvaises réponses, j'ai inclus quelques exemples pour vous aider dans votre réflexion.

30. Votre entreprise rencontre une latence élevée dans une application web hébergée dans le cloud. Comment diagnostiqueriez-vous et résoudriez-vous ce problème ?

Exemple de réponse :

Une latence élevée dans une application cloud peut être causée par plusieurs facteurs, notamment la congestion du réseau, des requêtes de base de données inefficaces, un placement d'instance sous-optimal ou des erreurs de configuration de l'équilibrage de charge.

Pour diagnostiquer le problème, je commencerais par isoler le goulot d'étranglement à l'aide d'outils de surveillance cloud. La première étape consisterait à analyser les temps de réponse des applications et la latence du réseau en examinant les journaux, les temps de réponse aux requêtes et les codes d'état HTTP. Si le problème est lié au réseau, je recommanderais d'utiliser un test traceroute ou ping afin de vérifier si les temps d'aller-retour entre les utilisateurs et l'application ont augmenté. Si un problème se présente, l'activation d'un CDN pourrait contribuer à mettre en cache le contenu statique plus près des utilisateurs et à réduire la latence.

Si les requêtes de la base de données entraînent des retards, je recommanderais de profiler les requêtes lenteset de les optimiser à l'aide d's ajoutant un indexage approprié ou en dénormalisant les tables. De plus, si l'application est soumise à un trafic important, l'activation de la mise à l'échelle horizontale avec des groupes de mise à l'échelle automatique ou des répliques en lecture peut réduire la charge sur la base de données principale.

Si les problèmes de latence persistent, je recommanderais de vérifier les ressources informatiques de l'application, en s'assurant qu'elle fonctionne dans la zone de disponibilité appropriée la plus proche des utilisateurs finaux. Si nécessaire, je transférerais les charges de travail vers une configuration multirégionale ou j'utiliserais des solutions informatiques de pointe pour traiter les demandes plus près de la source.

31. Votre entreprise envisage de migrer une application locale existante vers le cloud. Quels facteurs prendriez-vous en considération et quelle stratégie de migration adopteriez-vous ?

Exemple de réponse :

La première étape consiste à réaliser une évaluation de la préparation au cloud, afin de déterminer si l'application peut être migrée telle quelle ou si des modifications sont nécessaires. Une approche consiste à appliquer les « 6 R de la migration vers le cloud » :

- Réhébergement (lift-and-shift)

- Replateformage

- Rachat

- Refactoring

- Prendre sa retraite

- Conserver

Une approche « lift-and-shift » serait idéale si l'objectif est une migration rapide avec un minimum de changements. Si l'optimisation des performances et la rentabilité sont des priorités, je recommanderais de envisager une refonte de la plateforme en transférant l'application vers des conteneurs ou un environnement informatique sans serveur, ce qui permettrait une meilleure évolutivité. Pour les applications dotées d'architectures monolithiques, une refonte en microservices peut s'avérer nécessaire afin d'améliorer les performances et la maintenabilité.

Je me concentrerais également sur la migration des données, en veillant à ce que les bases de données soient répliquées dans le cloud avec un temps d'arrêt minimal.

La sécurité et la conformité constitueraient une autre préoccupation majeure. Avant le déploiement, je m'assurerais que l'application respecte les exigences réglementaires (par exemple, HIPAA, RGPD) en mettant en œuvre le chiffrement, les politiques IAM et l'isolation VPC.

Enfin, je procéderais à des tests et à une validation dans un environnement de préproduction avant de transférer le trafic de production.

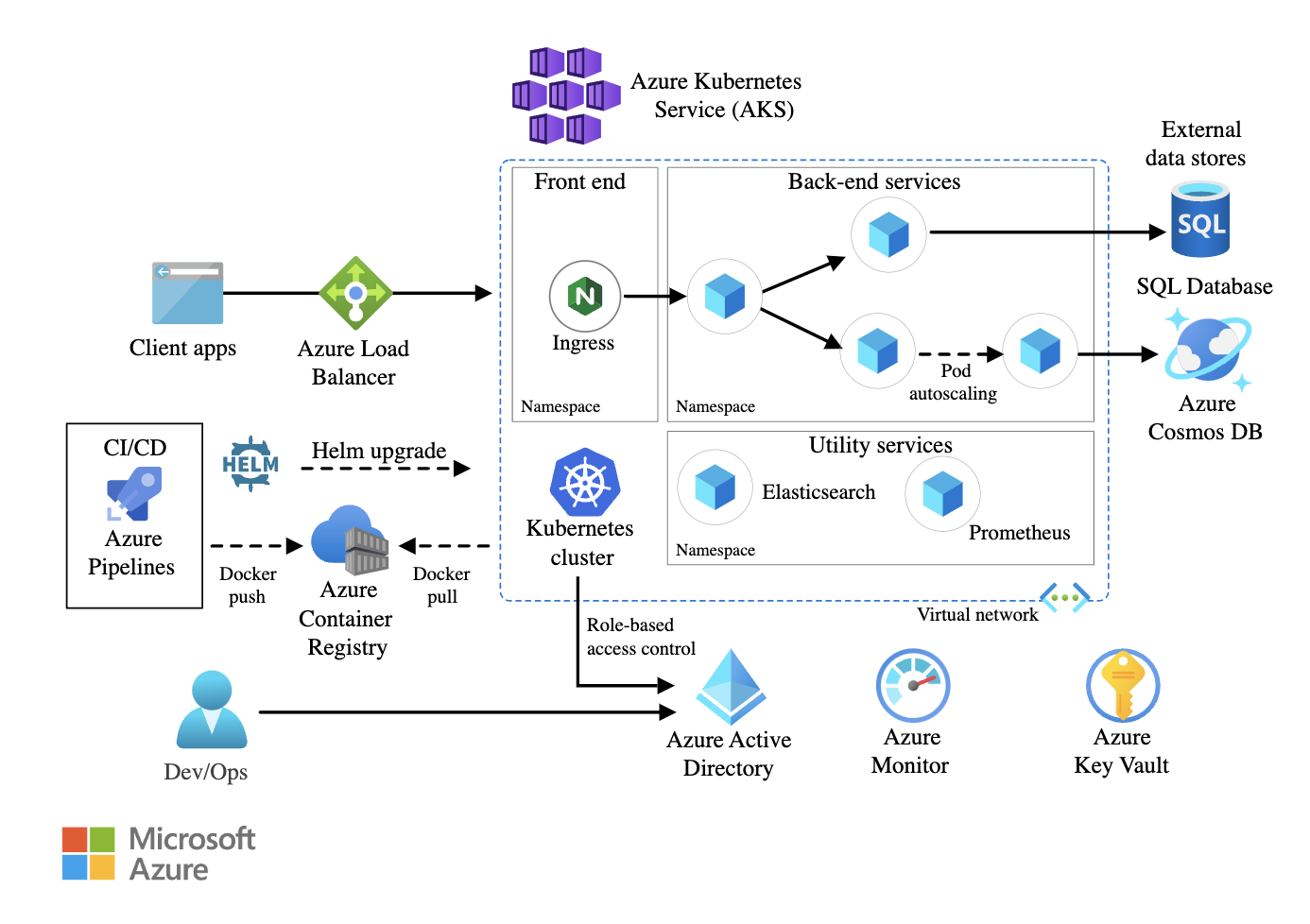

32. Il est nécessaire de garantir une haute disponibilité pour une application de microservices critique pour l'entreprise fonctionnant sur Kubernetes. Comment concevriez-vous l'architecture ?

Exemple de réponse :

Au niveau de l'infrastructure, je déploierais le cluster Kubernetes sur plusieurs zones de disponibilité (AZ). Cela garantit que le trafic peut être redirigé vers une autre zone si une zone de disponibilité tombe en panne. J'utiliserais Kubernetes Federation pour gérer les déploiements multi-clusters pour les configurations sur site ou hybrides.

Au sein du cluster, je mettrais en œuvre la résilience au niveau des pods en configurant des ReplicaSets et des autoscalers horizontaux de pods (HPA) afin de faire évoluer les charges de travail de manière dynamique en fonction de l'utilisation du processeur et de la mémoire. De plus, les budgets de perturbation des pods (PDB) garantiraient qu'un nombre minimum de pods reste disponible pendant les mises à jour ou la maintenance.

Pour la mise en réseau, je recommanderais d'utiliser un maillage de services afin de gérer la communication entre les services, en appliquant des politiques de réessais, de coupure de circuit et de régulation du trafic. Un équilibreur de charge mondial permettrait de répartir efficacement le trafic externe entre plusieurs régions.

Le stockage persistant est un autre aspect essentiel. Si les microservices nécessitent la persistance des données, je recommanderais d'utiliser des solutions de stockage natives pour conteneurs. Je configurerais des sauvegardes interrégionales et des politiques de snapshots automatisés afin de prévenir toute perte de données.

Enfin, la surveillance et la journalisation sont essentielles pour maintenir une haute disponibilité. J'intégrerais Prometheus et Grafana pour la surveillance des performances en temps réel et j'utiliserais ELK stack ou AWS CloudWatch Logs pour suivre la santé des applications et détecter les défaillances de manière proactive.

Exemple d'architecture de microservices utilisant Azure Kubernetes Service (AKS). Source de l'image : Microsoft Learn

33. Une faille de sécurité a été détectée dans votre environnement cloud. Comment envisageriez-vous d'étudier et d'atténuer cet impact ?

Exemple de réponse :

En cas de détection d'une faille de sécurité, ma réponse immédiate serait de contenir l'incident, d'identifier le vecteur d'attaque et d'empêcher toute nouvelle exploitation. Je commencerais par isoler les systèmes affectés afin de limiter les dommages en révoquant les identifiants IAM compromis, en restreignant l'accès aux ressources concernées et en appliquant les règles du groupe de sécurité.

La prochaine étape consisterait en une analyse des journaux et une enquête. Les journaux d'audit permettraient de détecter les activités suspectes telles que les tentatives d'accès non autorisées, les élévations de privilèges ou les appels API inattendus. Si un attaquant exploitait une politique de sécurité mal configurée, je procéderais à l'identification et à la correction de la vulnérabilité.

Afin d'atténuer l'impact, je recommanderais de changer régulièrement les identifiants, de révoquer les clés API compromises et d'appliquer l'authentification multifactorielle (MFA) pour tous les comptes privilégiés. Si la violation impliquait l'exfiltration de données, j'analyserais les journaux pour retracer les mouvements de données et informerais les autorités compétentes si la conformité réglementaire était affectée.

Une fois le confinement confirmé, je procéderais à un examen post-incident afin de renforcer les politiques de sécurité.

34. Votre entreprise envisage de mettre en œuvre une stratégie multi-cloud. Comment concevriez-vous et géreriez-vous une telle architecture ?

Exemple de réponse :

Pour concevoir une architecture multicloud, je commencerais par un cadre commun de gestion des identités et des accès (IAM), tel qu'Okta, AWS IAM Federation ou Azure AD, afin de garantir l'authentification entre les clouds. Cela permettrait d'éviter un contrôle d'accès cloisonné et de réduire la prolifération des identités.

La mise en réseau représente un défi majeur dans les environnements multi-cloud. Je recommanderais d'utiliser des services d'interconnexion tels qu'AWS Transit Gateway, Azure Virtual WAN ou Google Cloud Interconnect afin de faciliter une communication sécurisée entre les clouds. De plus, je mettrais en place un maillage de services afin de standardiser la gestion du trafic et les politiques de sécurité.

La cohérence des données entre les clouds est un autre facteur essentiel. Je garantirais la réplication inter-cloud à l'aide de bases de données mondiales telles que Spanner, Cosmos DB ou AWS Aurora Global Database. Si des applications sensibles à la latence nécessitent la localisation des données, je recommanderais d'utiliser des solutions d'informatique en périphérie afin de réduire le transfert de données entre les clouds.

Enfin, le contrôle des coûts et la gouvernance seraient essentiels pour éviter la prolifération du cloud. À l'aide d'outils FinOps tels que CloudHealth, AWS Cost Explorer et Azure Cost Management, je suivrais les dépenses, appliquerais les limites budgétaires et optimiserais l'allocation des ressources de manière dynamique.

Conclusion

La préparation à un entretien pour un poste d'ingénieur cloud nécessite une solide compréhension des principes fondamentaux du cloud, de son architecture, de sa sécurité et des meilleures pratiques. Continuez à explorer les services cloud, restez informé des tendances du secteur et, surtout, acquérez une expérience pratique avec AWS, Azure ou GCP.

Le cursus AWS Cloud Practitioner constitue un excellent point de départ si vous souhaitez approfondir vos connaissances sur AWS. Si vous débutez avec Microsoft Azure, le cursus Azure Fundamentals (AZ-900) vous aidera à acquérir des bases solides. Pour ceux qui souhaitent se familiariser avec Google Cloud Platform (GCP), le cours Introduction à GCP constitue un excellent point de départ.

Nous vous souhaitons bonne chance pour votre entretien.

Thalia Barrera est rédactrice senior en science des données chez DataCamp. Elle est titulaire d'un master en informatique et a plus de dix ans d'expérience dans l'ingénierie des logiciels et des données. Thalia aime simplifier les concepts techniques pour les ingénieurs et les scientifiques des données à travers des articles de blog, des tutoriels et des cours vidéo.