Cours

OpenAI a récemment publié GPT-4.1, une nouvelle famille de modèles conçus spécifiquement pour les tâches de codage. Comme tout le monde, je ne comprends pas le changement de nom de GPT-4.5 à GPT-4.1, mais heureusement, les benchmarks ne régressent pas non plus, bien au contraire.

Le déploiement a commencé le 14 avril avec un accès API uniquement. Puis, le 14 mai, OpenAI a commencé à intégrer GPT-4.1 dans l'application ChatGPT. Les utilisateurs de systèmes Free-tier ne pourront pas choisir manuellement la norme GPT-4.1, mais ils bénéficieront désormais de la norme GPT-4.1 Mini en tant que nouvelle solution de repli par défaut, en remplacement de la norme GPT-4o Mini.

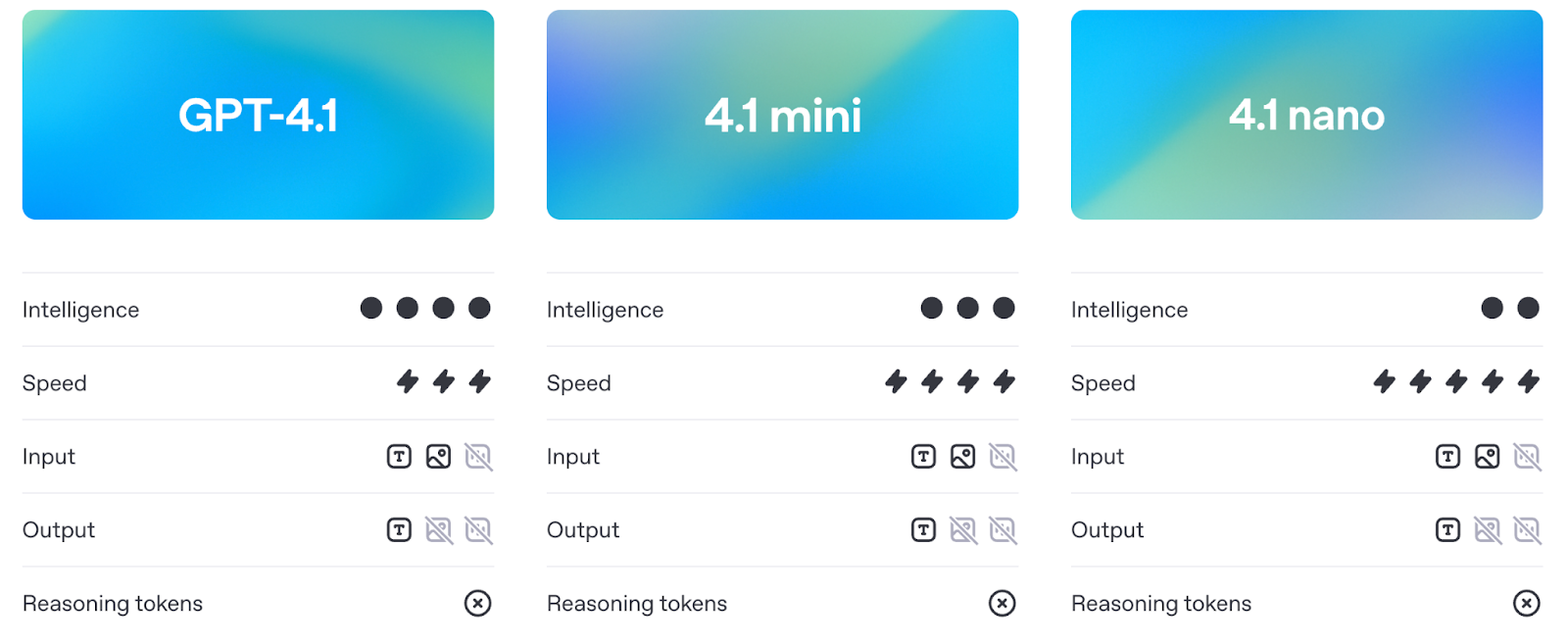

GPT-4.1 est disponible en trois tailles : GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano. Tous trois prennent en charge jusqu'à 1 million de tokens de contexte et apportent des améliorations notables en matière de codage, de suivi des instructions et de compréhension des contextes longs. Ils sont également moins chers et plus rapides que les versions précédentes.

Dans cet article, je vous expliquerai ce que chaque modèle peut faire, comment il se compare au GPT-4o et au GPT-4.5, et où il se situe dans les benchmarks et dans l'utilisation réelle.

Nous tenons nos lecteurs informés des dernières nouveautés en matière d'IA en leur envoyant The Median, notre lettre d'information gratuite du vendredi qui analyse les principaux sujets de la semaine. Abonnez-vous et restez à la pointe de la technologie en quelques minutes par semaine :

Qu'est-ce que GPT-4.1 ?

La suite de modèles GPT-4.1 se compose de trois modèles : GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano. Ils sont destinés aux développeurs qui ont besoin de meilleures performances, d'un contexte plus long et d'un suivi des instructions plus prévisible. Chaque modèle prend en charge jusqu'à 1 million de jetons de contexte, ce qui représente un grand bond en avant par rapport à la limite de 128 000 jetons des versions précédentes, telles que GPT-4o.

Source : OpenAI

Malgré l'architecture commune, chaque version est adaptée à des cas d'utilisation différents. Examinons chacun d'entre eux plus en détail.

GPT-4.1

Il s'agit du modèle phare. Si vous souhaitez obtenir les meilleures performances globales en matière de codage, de suivi des instructions et de tâches en contexte long, c'est celui qu'il vous faut. Il est conçu pour gérer des flux de codage complexes ou pour traiter des documents volumineux en une seule fois.

Dans les benchmarks, il surpasse GPT-4o en ingénierie logicielle réelle (SWE-bench), en suivi d'instructions (MultiChallenge) et en raisonnement sur des contextes longs (MRCR, Graphwalks). Il respecte également beaucoup mieux la structure et le formatage - pensez aux réponses XML, aux instructions ordonnées et aux contraintes négatives telles que "ne répondez pas à moins que...".

Vous pouvez également peaufiner GPT-4.1 dès le jour du lancement, ce qui lui permet de s'adapter à davantage de cas d'utilisation en production où le contrôle du ton, du format ou de la connaissance du domaine est important.

GPT-4.1 Mini

GPT-4.1 Mini est l'option de milieu de gamme, offrant pratiquement les mêmes capacités que le modèle complet, mais avec une latence et un coût moindres. Il égale ou surpasse le GPT-4o dans de nombreux domaines de référence, notamment le suivi des instructions et le raisonnement à partir d'images.

Il est susceptible de devenir le choix par défaut pour de nombreux cas d'utilisation : suffisamment rapide pour les outils interactifs, suffisamment intelligent pour suivre des instructions détaillées et nettement moins cher que le modèle complet.

Comme la version complète, elle prend en charge 1 million de tokens de contexte et est d'ores et déjà disponible pour une mise au point.

GPT-4.1 Nano

Nano est le plus petit, le plus rapide et le moins cher de tous. Il est conçu pour des tâches telles que l'autocomplétion, la classification et l'extraction d'informations à partir de documents volumineux. Malgré sa légèreté, il prend en charge la fenêtre contextuelle complète de 1 million de jetons.

Il s'agit également du modèle le plus petit, le plus rapide et le moins cher d'OpenAI, avec seulement 10 cents par million de jetons. Vous ne bénéficiez pas de toutes les capacités de raisonnement et de planification des grands modèles, mais pour certaines tâches, ce n'est pas la peine.

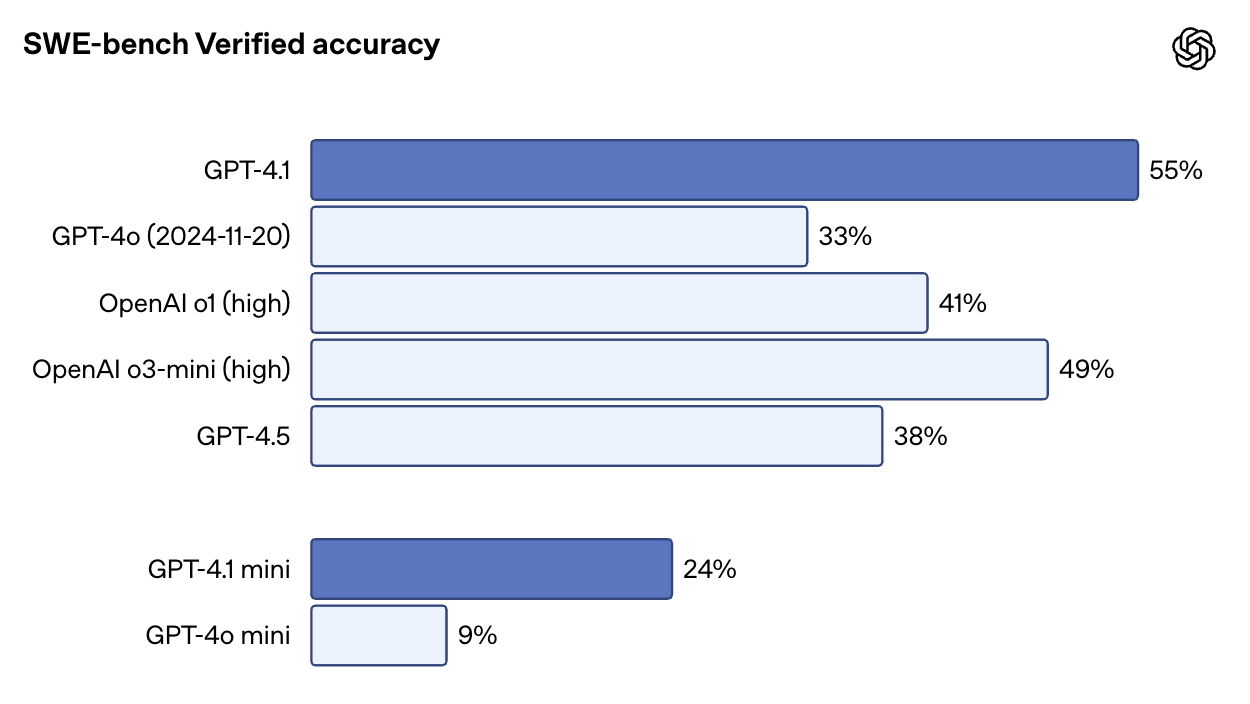

GPT-4.1 vs GPT-4o et GPT-4.5

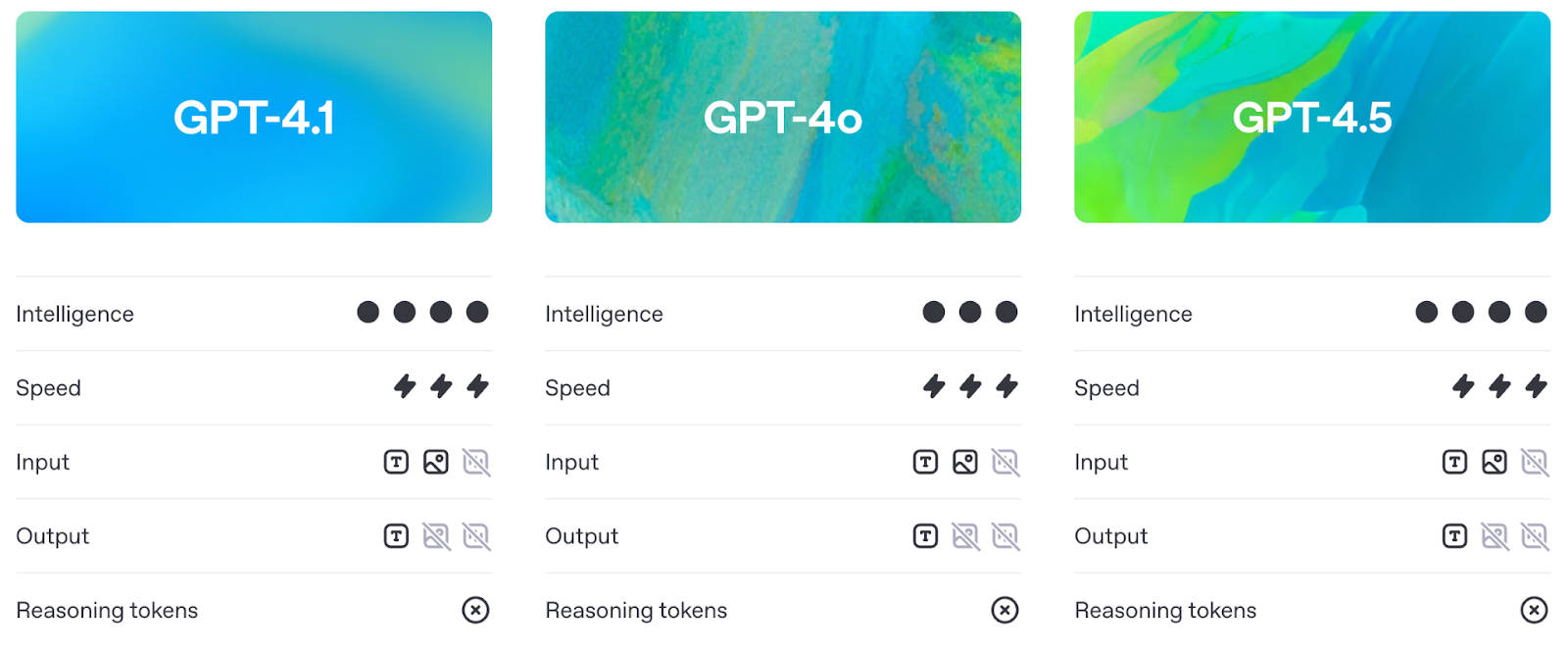

Avant d'entrer dans les benchmarks (que nous aborderons en détail dans la section suivante), il convient de comprendre en quoi GPT-4.1 diffère en pratique de GPT-4o et de GPT-4.5.

Plus intelligent que le GPT-4o, plus pratique que le GPT-4.5

GPT-4.1 améliore les capacités de GPT-4o tout en maintenant la latence à peu près au même niveau. En pratique, cela signifie que les développeurs bénéficient désormais de meilleures performances sans avoir à payer un coût en termes de réactivité.

Source : OpenAI

Analysons le graphique ci-dessus :

- GPT-4.1 et GPT-4o sont à peu près au même niveau pour la latence, mais GPT-4.1 prend l'avantage en termes d'intelligence. Vous obtenez donc un modèle plus intelligent (et moins cher) à une vitesse similaire.

- GPT-4.1 Mini est également plus performant que GPT-4o Mini, mais cette amélioration s'accompagne d'un léger compromis : une légère augmentation de la latence.

- GPT-4.1 Nano est le vainqueur incontesté en termes de vitesse, et se situe le plus à gauche sur le graphique. Elle n'est pas aussi performante en MMLU, mais c'est normal : elle est conçue pour des tâches légères où la vitesse compte plus que le raisonnement brut.

Le GPT-4.5, quant à lui, a toujours été positionné comme un avant-goût de la recherche. Bien qu'il soit doté d'un raisonnement et d'une qualité d'écriture solides, il s'accompagne de plus de frais généraux. GPT-4.1 donne des résultats similaires ou meilleurs sur les principaux critères de référence, mais il est moins cher et plus réactif, à tel point qu'OpenAI prévoit de retirer entièrement la version 4.5 d'ici la mi-juillet afin de libérer davantage de GPU.

1 million de jetons de contexte

Les trois modèles GPT-4.1 - standard, Mini et Nano - prennent en charge jusqu'à 1 million de jetons de contexte. C'est plus de 8 fois ce qu'offrait le GPT-4o.

Cette capacité de contexte long permet des cas d'utilisation pratiques tels que le traitement de journaux entiers, l'indexation de référentiels de code, la gestion de flux de travail juridiques multi-documents ou l'analyse de longues transcriptions, le tout sans avoir besoin de procéder à un découpage ou à un résumé au préalable.

Meilleur suivi de l'instruction

GPT-4.1 marque également un changement dans la fiabilité avec laquelle les modèles suivent les instructions. Il gère les invites complexes impliquant des étapes ordonnées, des contraintes de formatage et des conditions négatives (comme le refus de répondre si le formatage est erroné).

En pratique, cela signifie deux choses : moins de temps consacré à l'élaboration des invites et moins de temps consacré au nettoyage de la sortie par la suite.

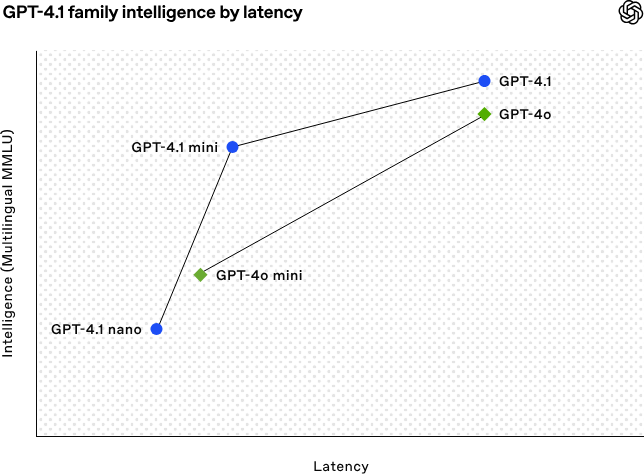

GPT-4.1 Benchmarks

Le GPT-4.1 montre des progrès dans quatre domaines essentiels : le codage, le suivi des instructions, la compréhension de contextes longs et les tâches multimodales.

Performance de codage

Sur SWE-bench Verified, un benchmark qui introduit le modèle dans une base de code réelle et lui demande de résoudre les problèmes de bout en bout, GPT-4.1 obtient un score de 54,6 %. Cela représente 33,2 % pour le GPT-4o et 38 % pour le GPT-4.5. Il est également très impressionnant de constater que GPT-4.1 obtient de meilleurs résultats que o1 et o3-mini.

Source : OpenAI

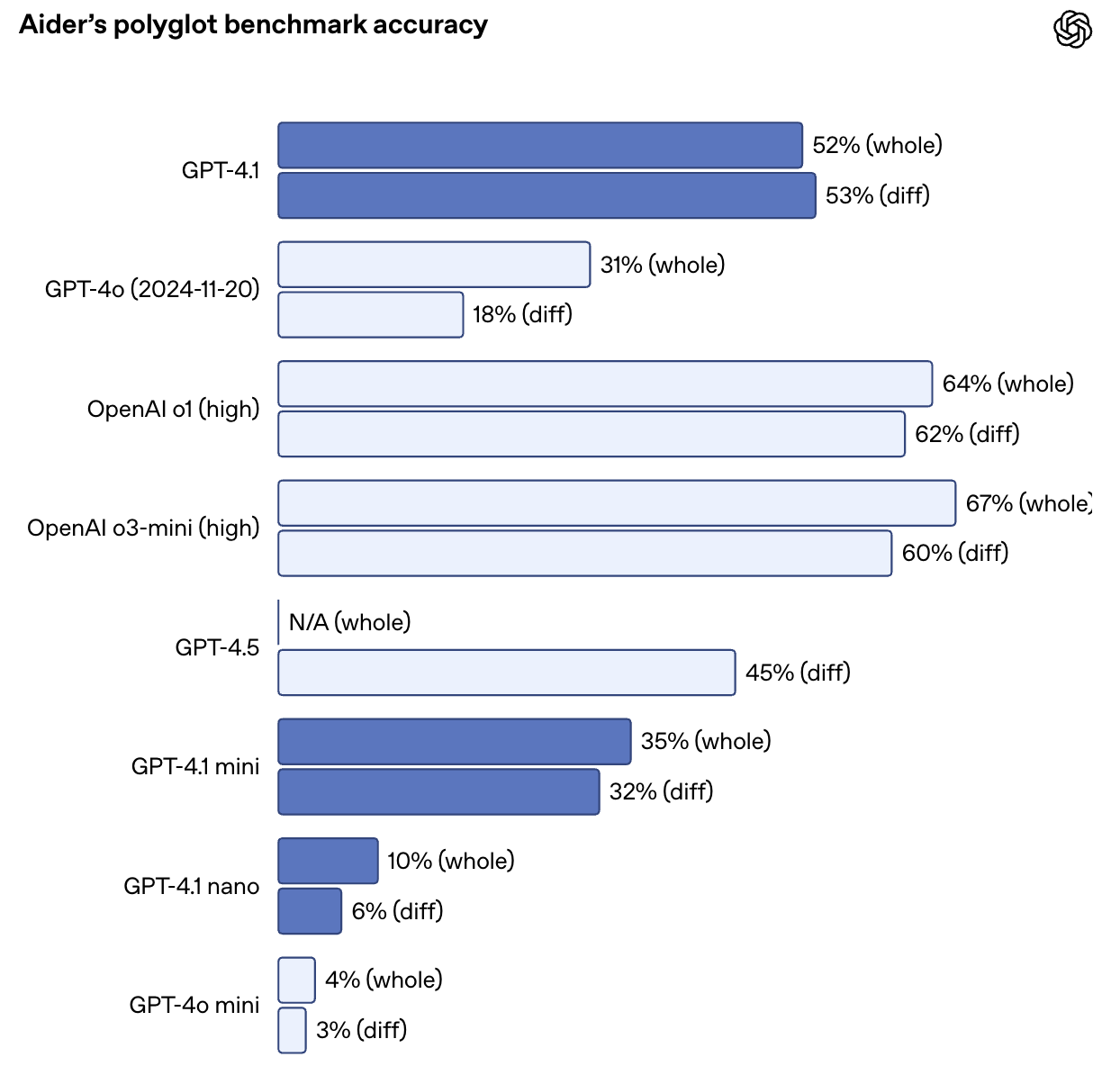

Il a également plus que doublé les performances de GPT-4o sur le benchmark de diff polyglotte d'Aider, atteignant une précision de 52,9 % sur les différences de code à travers de multiples langages et formats. GPT-4.5 a obtenu un score de 44,9 % pour la même tâche. La version GPT-4.1 est également plus précise : lors des évaluations internes, les modifications de code non nécessaires sont passées de 9 % (GPT-4o) à seulement 2 %.

Source : OpenAI

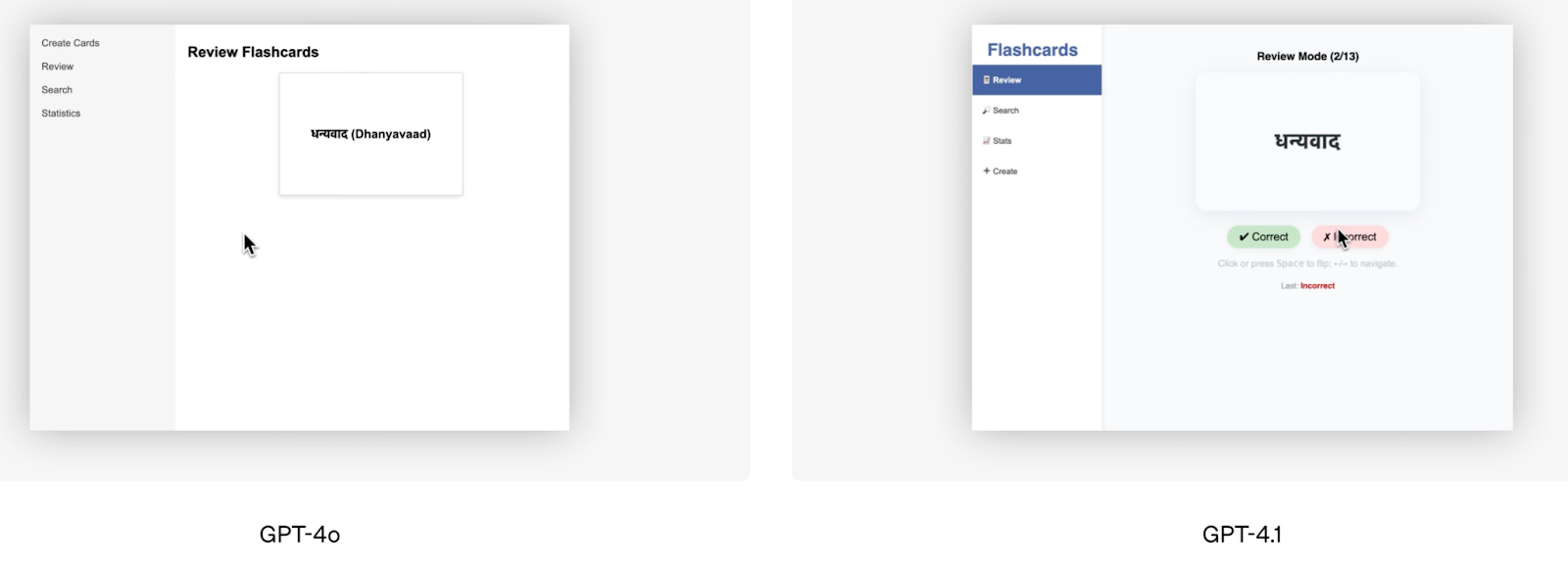

En dehors des scores de référence, la démo de codage frontale proposée par OpenAI est un bon exemple visuel des performances supérieures de la GPT-4.1. L'équipe d'OpenAI a demandé aux deux modèles de créer la même application de cartes-éclair, et les évaluateurs humains ont préféré le résultat de GPT-4.1 dans 80 % des cas.

Source : OpenAI

Windsurf, l'un des testeurs alpha, a fait état d'une amélioration de 60 % par rapport à sa propre référence interne en matière de codage. Une autre société, Qodo, a testé GPT-4.1 sur des demandes d'extraction GitHub réelles et a constaté qu'il produisait de meilleures suggestions dans 55 % des cas, avec moins de modifications non pertinentes ou trop verbeuses.

Instruction suivante

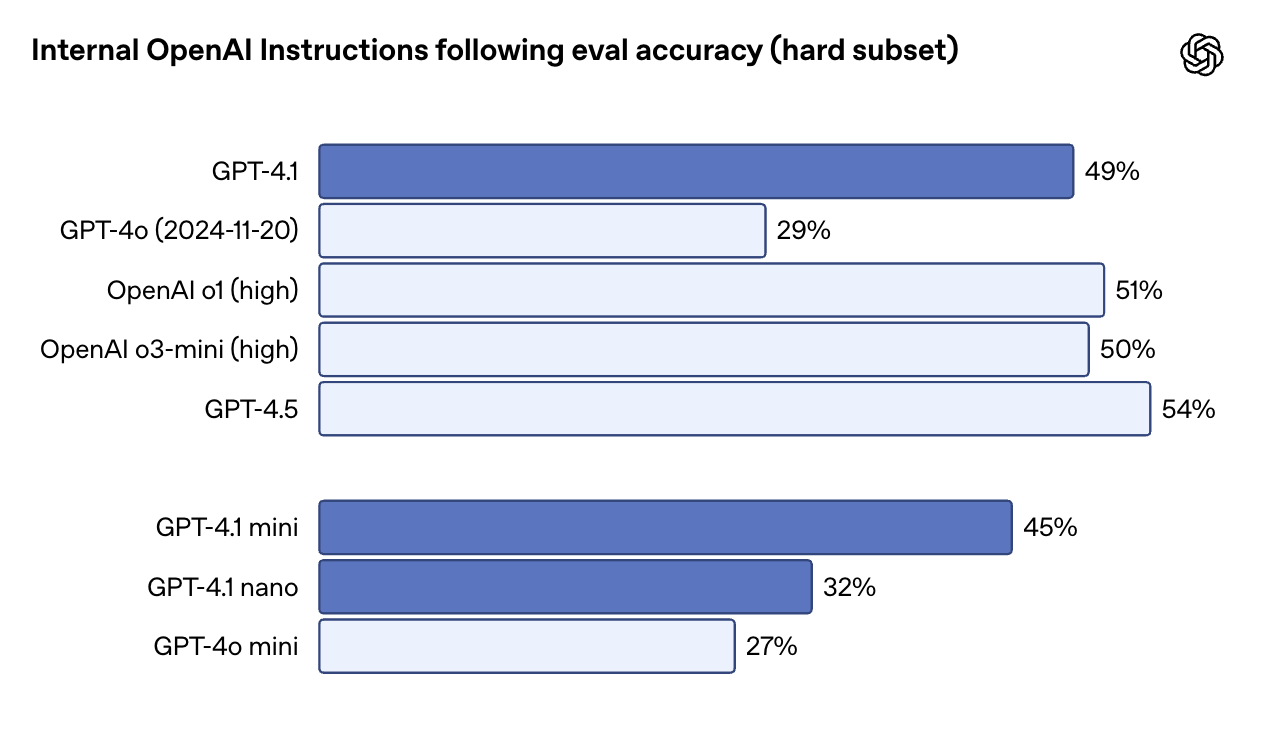

GPT-4.1 est plus littéral - et plus fiable - lorsqu'il s'agit de suivre des instructions, en particulier pour des tâches impliquant plusieurs étapes, des règles de formatage ou des conditions. Sur l'instruction interne d'OpenAI suivant l'évaluation (hard subset), GPT-4.1 a obtenu un score de 49,1 %, contre seulement 29,2 % pour GPT-4o. GPT-4.5 est légèrement en tête avec 54 %, mais l'écart entre 4.1 et 4o est important.

Source : OpenAI

Sur le MultiChallenge, qui teste la capacité d'un modèle à suivre des instructions à plusieurs tours et à se souvenir des contraintes introduites plus tôt dans la conversation, le GPT-4.1 obtient un score de 38,3 %, contre 27,8 % pour le GPT-4o. Et sur IFEval, qui teste la conformité avec des exigences de sortie clairement spécifiées, GPT-4.1 atteint 87,4 %, ce qui représente une solide amélioration par rapport aux 81 % de GPT-4o.

En pratique, cela signifie que GPT-4.1 s'en tient mieux aux étapes ordonnées, rejette les entrées mal formées et répond dans le format que vous avez demandé, en particulier dans les sorties structurées comme XML, YAML ou markdown. Cela facilite également la mise en place de flux de travail fiables pour les agents, sans qu'il y ait beaucoup de tentatives de relance.

Raisonnement à long terme

Les trois modèles GPT-4.1 - standard, Mini et Nano - prennent en charge jusqu'à 1 million de jetons de contexte. Cela représente une augmentation de 8 fois par rapport à GPT-4o, qui plafonnait à 128 Ko. Tout aussi important : l'utilisation de cette fenêtre contextuelle n'entraîne aucun coût supplémentaire. Son prix est le même que celui de n'importe quel autre produit.

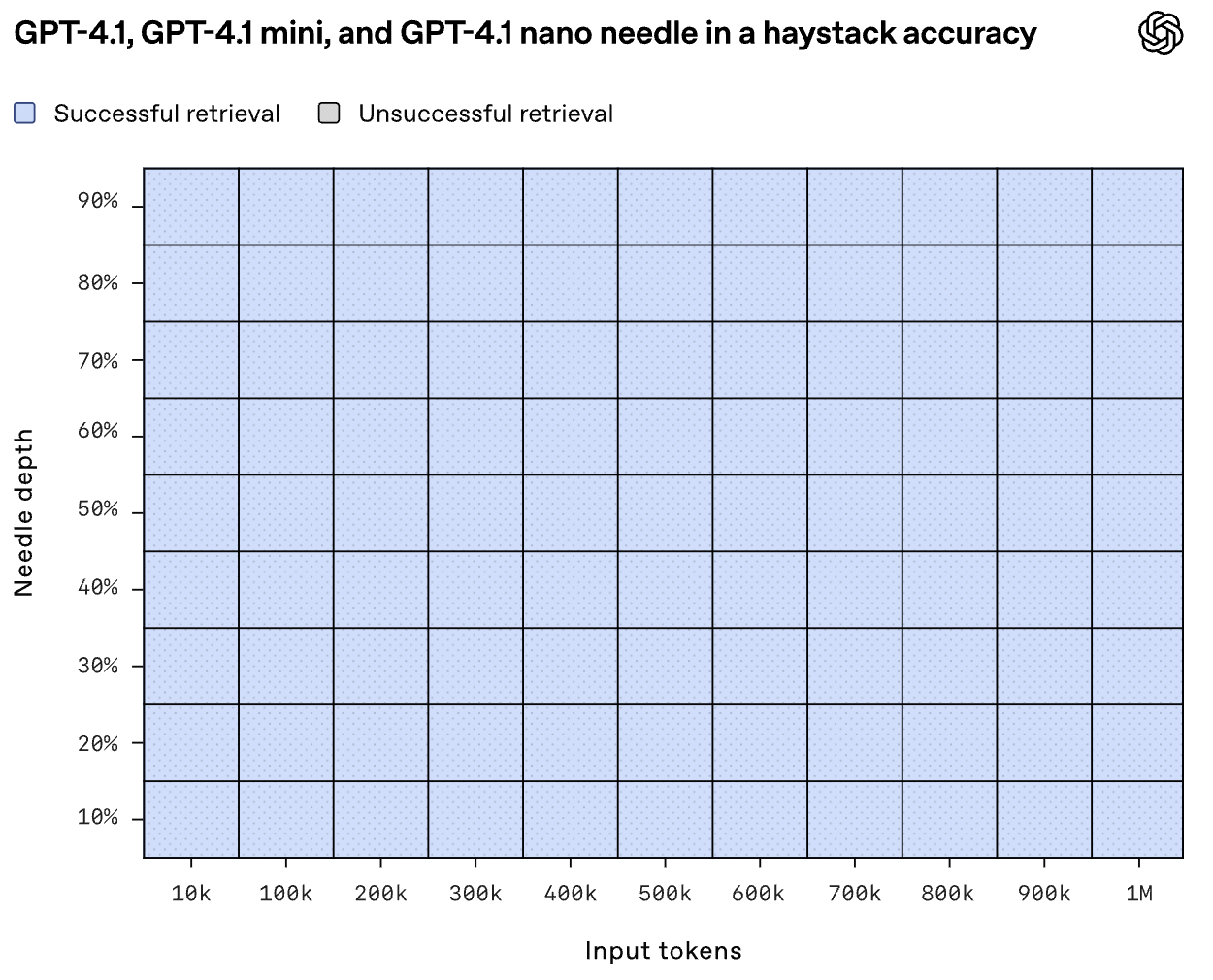

Mais les modèles peuvent-ils réellement utiliser tout ce contexte ? Lors de l'évaluation de l'aiguille dans la botte de foin d'OpenAI, GPT-4.1 a trouvé de manière fiable le contenu inséré placé à n'importe quel point - début, milieu ou fin - dans l'entrée complète d'un million de jetons.

Source : OpenAI

Graphwalks, un benchmark qui teste le raisonnement multi-sauts dans des contextes longs, place GPT-4.1 à 61,7 % - un bond solide par rapport aux 41,7 % de GPT-4o, mais toujours en deçà de GPT-4.5, qui atteint 72,3 %.

Ces améliorations se retrouvent également dans les tests en conditions réelles. Thomson Reuters a constaté une augmentation de 17 % dans l'analyse juridique multi-documents grâce à GPT-4.1. dans l'analyse juridique multi-documents en utilisant GPT-4.1, tandis que Carlyle a constaté une amélioration de 50 % dans l'extraction de données granulaires à partir de rapports financiers denses.

Tâches multimodales et visuelles

En ce qui concerne les tâches multimodales, le GPT-4.1 progresse également. Il a obtenu un score de 72,0 % sur le test de référence Video-MME, qui consiste à répondre à des questions sur des vidéos de 30 à 60 minutes sans sous-titres, contre 65,3 % avec le GPT-4o.

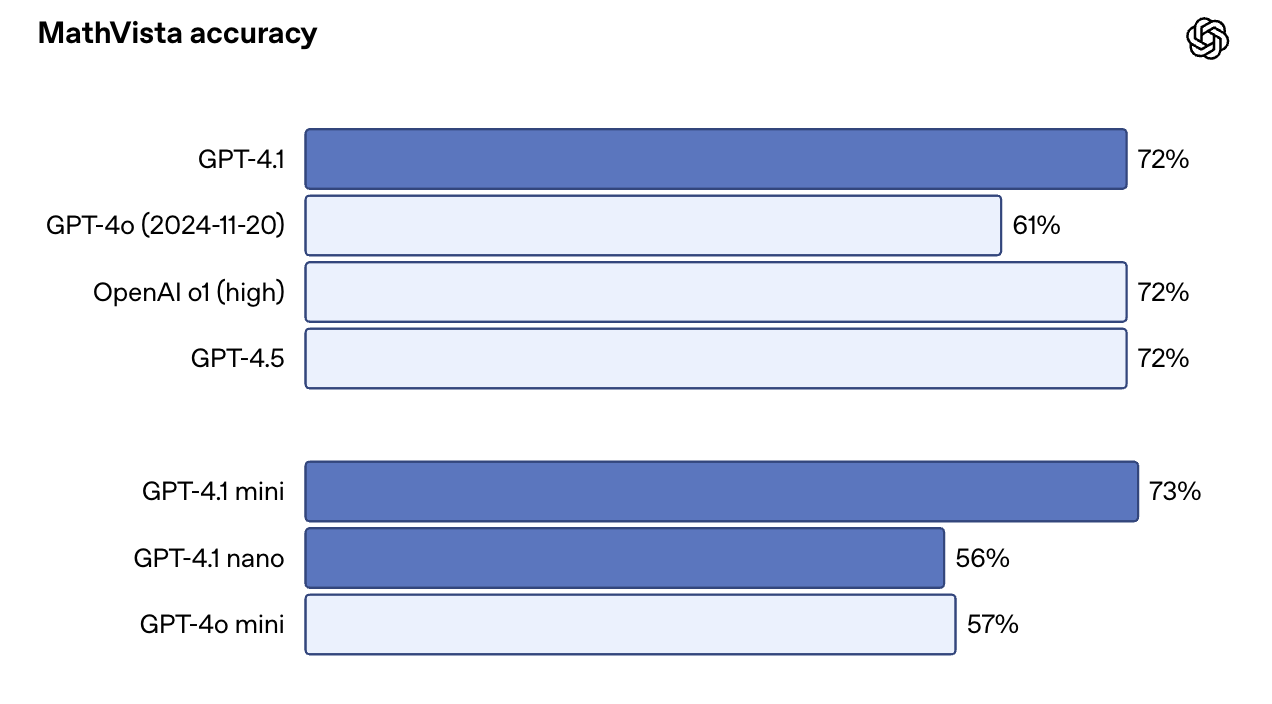

Sur des benchmarks à forte intensité d'images comme MMMU, il a atteint 74,8 % vs. 68,7 % pour le GPT-4o. Sur MathVista, qui comprend des tableaux, des graphiques et des illustrations mathématiques, le GPT-4.1 a atteint 72,2 %.

Une surprise : GPT-4.1 Mini est presque aussi performant que la version complète sur certains de ces benchmarks. Sur MathVista, par exemple, il a légèrement dépassé GPT-4.1 avec 73,1 %. Il s'agit donc d'un choix convaincant pour les cas d'utilisation qui associent la vitesse à des invites à forte intensité visuelle.

Source : OpenAI

Comment accéder à GPT-4.1

Vous pouvez désormais accéder à GPT-4.1 et GPT-4.1 Mini directement dans l'application ChatGPT, et non plus seulement via l'API. Les abonnés Plus, Pro et Team peuvent sélectionner manuellement GPT-4.1 dans le menu du modèle, tandis que les utilisateurs gratuits reviennent automatiquement à GPT-4.1 Mini-remplaçant GPT-4o Mini comme valeur par défaut en coulisses. Les plans d'entreprise et d'éducation devraient être accessibles dans les semaines à venir.

Pour les développeurs, l OpenAI API et le terrain de jeu continuent de prendre en charge les trois variantes - GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano. Cela reste la meilleure façon de tester les messages-guides, d'explorer le comportement en contexte long et de comparer les modèles avant de les intégrer dans la production.

Si vous travaillez avec de longs documents (journaux, PDF, dossiers juridiques ou articles universitaires), vous pouvez envoyer jusqu'à 1 million de jetons en un seul appel, sans paramètre particulier. Il n'y a pas non plus d'écart de prix pour les contextes longs : les coûts des jetons sont fixes, quelle que soit la taille de l'entrée.

Mise au point de GPT-4.1

Vous pouvez régler avec précision les trois variantes GPT-4.1. Cela ouvre la voie à des instructions personnalisées, à un vocabulaire spécifique à un domaine ou à des sorties spécifiques à une tonalité. Notez que le réglage fin a un pricing légèrement plus important :

|

Modèle |

Entrée |

Entrée en cache |

Sortie |

Formation |

|

GPT-4.1 |

3,00 $ / 1 million de jetons |

0,75 $ / 1 million de jetons |

12,00 $ / 1M de jetons |

25,00 $ / 1M de jetons |

|

GPT-4.1 Mini |

0,80 $ / 1 million de jetons |

0,20 $ / 1 million de jetons |

3,20 $ / 1 million de jetons |

5,00 $ / 1M de jetons |

|

GPT-4.1 Nano |

0,20 $ / 1 million de jetons |

0,05 $ / 1 million de jetons |

0,80 $ / 1 million de jetons |

1,50 $ / 1 million de jetons |

Si vousavez déjà peaufiné des modèles GPT-3.5 ou GPT-4, le processus reste pratiquement le même - il suffit de choisir la base la plus récente. Si vous voulez en savoir plus, je vous recommande ce tutoriel sur le réglage fin de GPT-4o mini.

Tarification GPT-4.1

L'une des mises à jour les plus appréciées de GPT-4.1 est qu'il n'est pas seulement plus intelligent, il est aussi moins cher. OpenAI explique que l'objectif était de rendre ces modèles plus utilisables dans des flux de travail plus réels, ce qui se reflète dans la structure des prix.

Voici comment les trois modèles sont évalués pour l'inférence:

|

Modèle |

Entrée |

Entrée en cache |

Sortie |

Mélangé Moyenne Coût* |

|

GPT-4.1 |

2,00 $ / 1 million de jetons |

0,50 $ / 1 million de jetons |

8,00 $ / 1M de jetons |

$1.84 |

|

GPT-4.1 Mini |

0,40 $ / 1 million de jetons |

0,10 $ / 1 million de jetons |

1,60 $ / 1 million de jetons |

$0.42 |

|

GPT-4.1 Nano |

0,10 $ / 1 million de jetons |

0,025 $ / 1 million de jetons |

0,40 $ / 1 million de jetons |

$0.12 |

*Le chiffre "mixte" est basé sur l'hypothèse de l'OpenAI concernant les ratios d'entrée et de sortie typiques.

Conclusion

GPT-4.1 est doté d'une génération de code plus fiable, d'un meilleur suivi des instructions, d'un véritable traitement des contextes longs et d'une itération plus rapide.

La dénomination peut prêter à confusion, mais les modèles eux-mêmes sont clairement plus performants que les modèles précédents. Ils sont également plus abordables et plus utilisables, en particulier dans les environnements de production où la latence, le coût et la prévisibilité sont importants.

Si vous travaillez avec GPT-4o aujourd'hui, cela vaut la peine de tester GPT-4.1.

FAQ

Est-ce que GPT-4.1 est disponible pour les utilisateurs du ChatGPT ?

Oui. GPT-4.1 est disponible pour les abonnés Plus, Pro et Team via le menu du modèle. Les utilisateurs gratuits utilisent automatiquement GPT-4.1 Mini, et les plans Entreprise/Edu devraient y avoir accès prochainement.

Le GPT-4.1 permet-il de générer des images ou de produire de la voix ?

Non. GPT-4.1 est multimodal en termes d'entrée - ilpeut traiter des images - mais il ne produit que du texte.

Puis-je utiliser GPT-4.1 dans des applications comme Cursor ou Windsurf ?

Vous pouvez utiliser GPT-4.1 dans Windsurf, qui l'offre actuellement avec un essai gratuit limité dans le temps. Cursor a également ajouté la prise en charge de GPT-4.1.

Je suis rédacteur et écrivain et je couvre les blogs, les tutoriels et les actualités sur l'IA, en m'assurant que tout est conforme à une stratégie de contenu solide et aux meilleures pratiques en matière de référencement. J'ai rédigé des cours de science des données sur Python, les statistiques, les probabilités et la visualisation des données. J'ai également publié un roman primé et je consacre mon temps libre à l'écriture de scénarios et à la réalisation de films.