Cours

Dans cet article, nous avons présenté certaines des questions les plus courantes relatives à l'apprentissage automatique que vous pourriez rencontrer lorsque vous postulez à un poste dans ce secteur ou lorsque vous interviewez un candidat. En vous entraînant à répondre à ces questions et en préparant vos réponses, vous contribuerez à garantir le bon déroulement de l'entretien.

Développer des applications d'IA

Questions d'entretien de base sur l'apprentissage automatique

Les questions fondamentales concernent la terminologie, les algorithmes et les méthodologies. Les examinateurs posent ces questions afin d'évaluer les connaissances techniques du candidat.

Qu'est-ce que l'apprentissage automatique semi-supervisé ?

L'apprentissage semi-supervisé est une combinaison d'apprentissage supervisé et non supervisé. L'algorithme est entraîné à partir d'un mélange de données étiquetées et non étiquetées. En général, cette méthode est utilisée lorsque nous disposons d'un ensemble de données étiquetées très restreint et d'un ensemble de données non étiquetées volumineux.

En termes simples, l'algorithme non supervisé est utilisé pour créer des clusters et, à partir des données étiquetées existantes, étiqueter le reste des données non étiquetées. Un algorithme semi-supervisé repose sur les hypothèses de continuité, de regroupement et de variété.

Il est généralement utilisé pour réduire les coûts liés à l'acquisition de données étiquetées. Par exemple, la classification des séquences protéiques, la reconnaissance vocale automatique et les véhicules autonomes.

Comment sélectionnez-vous l'algorithme à utiliser pour un ensemble de données ?

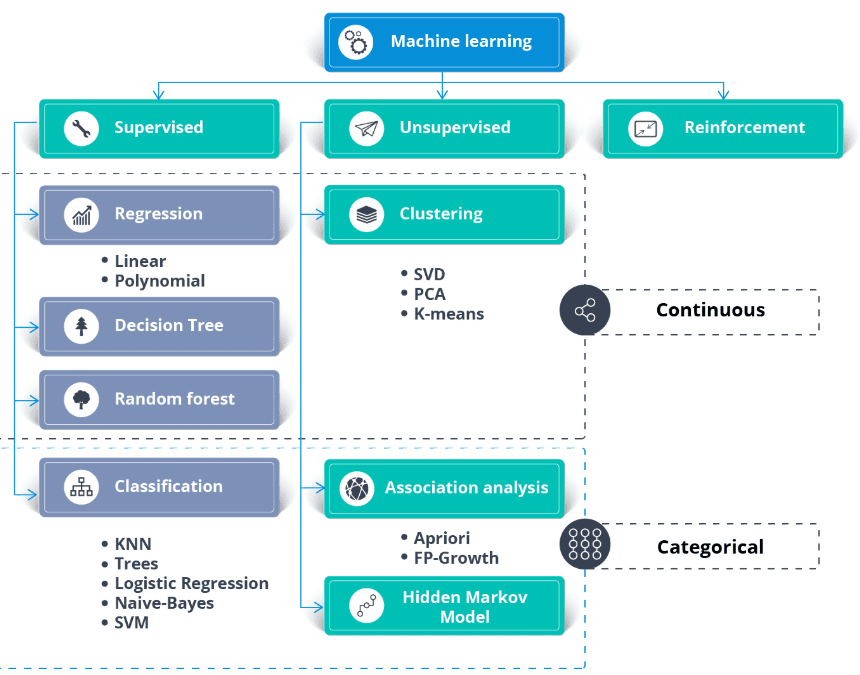

Outre l'ensemble de données, il est nécessaire de disposer d'un cas d'utilisation commerciale ou d'exigences applicatives. Il est possible d'appliquer l'apprentissage supervisé et non supervisé aux mêmes données.

En général :

- Les algorithmes d'apprentissage supervisé nécessitent des données étiquetées.

- Les algorithmes de régression nécessitent des cibles numériques continues.

- Les algorithmes de classification nécessitent des cibles catégorielles.

- Les algorithmes d'apprentissage non supervisé nécessitent des données non étiquetées.

- L'apprentissage semi-supervisé nécessite la combinaison d'ensembles de données étiquetés et non étiquetés.

- Les algorithmes d'apprentissage par renforcement nécessitent des données relatives à l'environnement, à l'agent, à l'état et à la récompense.

Image provenant de thecleverprogrammer

Veuillez suivre notre cours pour acquérir les bases de l'apprentissage automatique.

Veuillez expliquer l'algorithme K Nearest Neighbor.

Le K Nearest Neighbor (KNN) est un classificateur d'apprentissage supervisé. Il utilise la proximité pour classer les étiquettes ou prédire le regroupement de points de données individuels. Nous pouvons l'utiliser pour la régression et la classification. L'algorithme KNN est non paramétrique, ce qui signifie qu'il ne repose pas sur une hypothèse sous-jacente concernant la distribution des données.

Dans le classificateur KNN :

- Nous identifions les K voisins les plus proches du point blanc. Dans l'exemple ci-dessous, nous avons choisi k=5.

- Pour déterminer les cinq voisins les plus proches, nous calculons la distance euclidienne entre le point blanc et les autres. Ensuite, nous avons sélectionné les 5 points les plus proches du point blanc.

- Il y a trois points rouges et deux points verts à K=5. Étant donné que le rouge est majoritaire, nous lui attribuons une étiquette rouge.

Image tirée de l'histoire du développement de Codesigner

Découvrez tout ce qu'il faut savoir sur les modèles de classification et de régression par apprentissage supervisé en suivant un cours de courte durée.

Qu'est-ce que l'importance des caractéristiques dans l'apprentissage automatique et comment la déterminez-vous ?

L'importance des caractéristiques fait référence aux techniques qui attribuent une note aux caractéristiques d'entrée en fonction de leur utilité pour prédire une variable cible. Il joue un rôle essentiel dans la compréhension de la structure sous-jacente des données, du comportement du modèle et dans l'amélioration de l'interprétabilité du modèle.

Il existe plusieurs méthodes pour déterminer l'importance des caractéristiques :

- Importance basée sur le modèle: Certains algorithmes, tels que les arbres de décision et les forêts aléatoires, fournissent des méthodes intégrées pour évaluer l'importance des caractéristiques. Par exemple, les forêts aléatoires calculent la diminution de l'impureté des nœuds pondérée par la probabilité d'atteindre ce nœud, en faisant la moyenne sur tous les arbres.

- Importance de la permutation: Cela implique de mélanger les variables individuelles dans l'ensemble de validation et d'observer l'effet sur les performances du modèle. Une diminution significative des performances du modèle indique une importance élevée.

- SHAP (explications additives de Shapley): Cette approche utilise la théorie des jeux pour évaluer la contribution de chaque caractéristique à la prédiction dans un modèle complexe. Les valeurs SHAP fournissent un aperçu approfondi du comportement du modèle et sont particulièrement utiles pour les modèles complexes tels que les machines à gradient boosting ou les réseaux neuronaux.

- Coefficients de corrélation: Des mesures statistiques simples telles que la corrélation de Pearson ou de Spearman peuvent fournir des informations sur la relation linéaire entre chaque caractéristique et la variable cible.

Il est essentiel de comprendre l'importance des caractéristiques pour optimiser les modèles, réduire le surajustement en supprimant les caractéristiques non informatives et améliorer l'interprétabilité des modèles, en particulier dans les domaines où il est crucial de comprendre le processus décisionnel du modèle.

Qu'est-ce que le surapprentissage dans l'apprentissage automatique et comment peut-on l'éviter ?

Le surajustement se produit lorsqu'un modèle fonctionne bien sur les données d'apprentissage, mais ne parvient pas à généraliser à des données inconnues, car il a mémorisé les données d'apprentissage au lieu d'apprendre les modèles sous-jacents. Il est possible de l'éviter en :

- Utilisation de techniques de validation croisée.

- Application de la régularisation (L1, L2).

- Réduire la complexité des modèles.

- Collecte de données d'entraînement supplémentaires ou utilisation de l'augmentation des données.

Quelle est la différence entre l'apprentissage supervisé et l'apprentissage non supervisé ?

- Apprentissage supervisé : Le modèle est entraîné sur des données étiquetées, où la variable cible est connue. Parmi les exemples, on peut citer la classification et la régression.

- Apprentissage non supervisé : Le modèle est entraîné sur des données non étiquetées afin d'identifier des modèles ou des regroupements. Parmi les exemples, on peut citer le regroupement et la réduction de dimensionnalité.

Qu'est-ce qu'une matrice de confusion et en quoi est-elle utile ?

Une matrice de confusion est un tableau utilisé pour évaluer la performance d'un modèle de classification. Il indique le nombre de vrais positifs, de vrais négatifs, de faux positifs et de faux négatifs. Il est utile pour calculer des mesures telles que l'exactitude, la précision, le rappel et le score F1.

Quelle est la différence entre les modèles paramétriques et non paramétriques ?

Modèles paramétriques : Ces modèles émettent des hypothèses sur la distribution sous-jacente des données et ont un nombre fixe de paramètres (par exemple, la régression linéaire).

Modèles non paramétriques : Ces méthodes ne font aucune hypothèse sur la distribution des données et peuvent s'adapter à la complexité à mesure que de nouvelles données sont ajoutées (par exemple, K-Nearest Neighbors).

Qu'est-ce que le compromis biais-variance dans l'apprentissage automatique ?

Le compromis biais-variance fait référence à l'équilibre entre la capacité d'un modèle à saisir des schémas complexes (faible biais) et sa sensibilité aux fluctuations dans les données d'apprentissage (faible variance). Un modèle performant atteint un équilibre en minimisant à la fois le biais et la variance afin d'éviter le sous-ajustement et le surajustement.

Questions techniques relatives à l'apprentissage automatique pour un entretien d'embauche

La session d'entretien technique vise davantage à évaluer vos connaissances des processus et votre capacité à gérer l'incertitude. Le responsable du recrutement posera des questions relatives à l'apprentissage automatique concernant le traitement des données, la formation et la validation des modèles, ainsi que les algorithmes avancés.

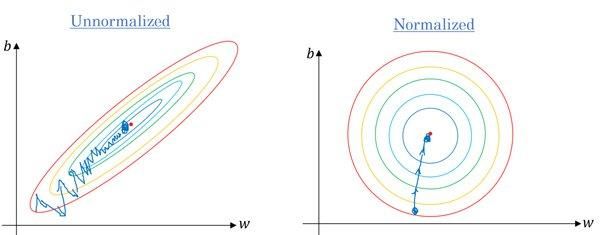

Est-il exact que nous devons mettre à l'échelle les valeurs de nos caractéristiques lorsqu'elles varient considérablement ?

Oui. La plupart des algorithmes utilisent la distance euclidienne entre les points de données, et si la valeur des caractéristiques varie considérablement, les résultats seront très différents. Dans la plupart des cas, les valeurs aberrantes entraînent une baisse des performances des modèles d'apprentissage automatique sur l'ensemble de données de test.

Nous utilisons également la mise à l'échelle des caractéristiques afin de réduire le temps de convergence. Il faudra plus de temps à la descente de gradient pour atteindre les minima locaux lorsque les caractéristiques ne sont pas normalisées.

Gradient sans et avec mise à l'échelle | Quora

Les compétences en ingénierie des caractéristiques sont très recherchées. Vous pouvez acquérir toutes les connaissances nécessaires sur le sujet en suivant un cours DataCamp, tel que « Feature Engineering for Machine Learning in Python » (Ingénierie des fonctionnalités pour l'apprentissage automatique en Python).

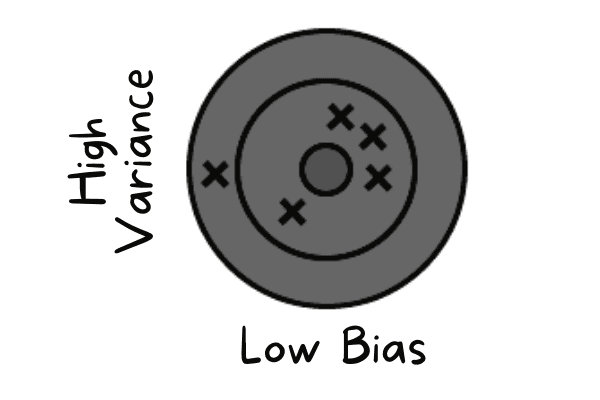

Le modèle que vous avez formé présente un faible biais et une variance élevée. Comment réagiriez-vous dans cette situation ?

Un biais faible se produit lorsque le modèle prédit des valeurs proches de la valeur réelle. Il reproduit l'ensemble de données d'entraînement. Le modèle ne dispose d'aucune généralisation, ce qui signifie que s'il est testé sur des données non observées, il produira des résultats peu satisfaisants.

Faible biais et variance élevée | Auteur

Pour résoudre ces problèmes, nous utiliserons des algorithmes de bagging, car ils divisent un ensemble de données en sous-ensembles à l'aide d'un échantillonnage aléatoire. Ensuite, nous générons des ensembles de modèles à partir de ces échantillons à l'aide d'un algorithme unique. Ensuite, nous combinons les prédictions du modèle à l'aide d'une classification par vote ou d'une moyenne.

Pour une variance élevée, nous pouvons recourir à des techniques de régularisation. Il a pénalisé les coefficients de modèle plus élevés afin de réduire la complexité du modèle. De plus, nous pouvons sélectionner les caractéristiques les plus importantes à partir du graphique d'importance des caractéristiques et entraîner le modèle.

Qu'est-ce que la dérive du modèle et comment la détecter en production ?

La dérive du modèle se produit lorsque les performances d'un modèle se dégradent au fil du temps en raison de l'évolution des données réelles par rapport aux données d'apprentissage. Il existe deux types principaux :

- Dérive des données (changement de covariables) : La distribution des données d'entrée change (par exemple, les utilisateurs commencent à télécharger des images la nuit plutôt que pendant la journée). Vous pouvez détecter cela en surveillant la distance statistique (telle que la divergence KL) entre les distributions des caractéristiques de formation et de production.

- Déviation conceptuelle : La relation entre les entrées et les sorties évolue (par exemple, les définitions du « spam » changent au fil du temps). Vous pouvez détecter cela en surveillant les indicateurs commerciaux en aval (tels que le taux de clics) ou la précision des données de terrain, si elles sont disponibles.

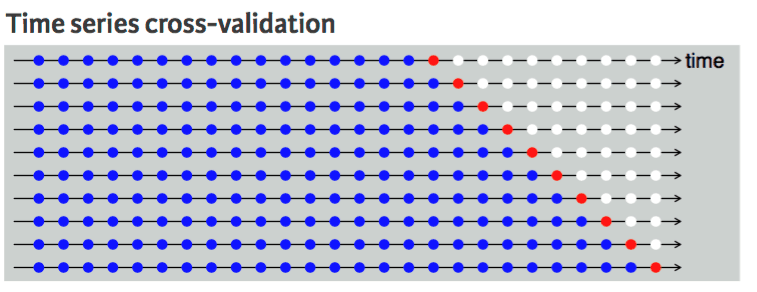

Quelle technique de validation croisée recommanderiez-vous pour un ensemble de données chronologiques et pour quelle raison ?

La validation croisée est utilisée pour évaluer de manière fiable les performances d'un modèle et éviter le surajustement. En règle générale, les techniques de validation croisée sélectionnent de manière aléatoire des échantillons à partir des données et les divisent en ensembles de données d'apprentissage et de test. Le nombre de divisions est basé sur la valeur K.

Par exemple, si K = 5, il y aura quatre plis pour l'apprentissage et un pour le test. Il sera répété cinq fois afin d'évaluer le modèle sur des plis distincts.

Nous ne pouvons pas procéder ainsi avec un ensemble de données chronologiques, car il n'est pas pertinent d'utiliser une valeur future pour prévoir une valeur passée. Il existe une dépendance temporelle entre les observations, et nous ne pouvons diviser les données que dans un seul sens, de sorte que les valeurs de l'ensemble de données de test se trouvent après l'ensemble d'apprentissage.

Le diagramme montre que la division en k parties des données chronologiques est unidirectionnelle. Les points bleus représentent l'ensemble d'apprentissage, le point rouge représente l'ensemble de test et les points blancs représentent les données non utilisées. Comme nous pouvons l'observer à chaque itération, nous progressons avec l'ensemble d'apprentissage tandis que l'ensemble de test reste en amont de l'ensemble d'apprentissage, sans être sélectionné de manière aléatoire.

Validation croisée des séries chronologiques | Guide de programmation R pour l'analyse commerciale à l'université de Californie

Découvrez la manipulation, l'analyse, la visualisation et la modélisation des données chronologiques en suivant le cours « Time Series with Python » (Séries chronologiques avec Python).

Questions d'entretien sur l'ingénierie de la vision par ordinateur

La plupart des offres d'emploi dans le domaine de l'apprentissage automatique publiées sur LinkedIn, Glassdoor et Indeed sont spécifiques à un poste. Par conséquent, au cours de l'entretien, ils se concentreront sur des questions spécifiques au poste. Pour le poste d'ingénieur en vision par ordinateur, le responsable du recrutement se concentrera sur les questions relatives au traitement d'images.

Pourquoi les entrées dans les problèmes de vision par ordinateur peuvent-elles devenir considérables ? Veuillez l'expliquer à l'aide d'un exemple.

Veuillez envisager une image de 250 x 250 et une première couche cachée entièrement connectée avec 1 000 unités cachées. Pour cette image, les caractéristiques d'entrée sont 250 X 250 X 3 = 187 500, et la matrice de poids au premier niveau caché sera une matrice de dimension 187 500 X 1000. Ces chiffres sont considérables en termes de stockage et de calcul. Pour remédier à ce problème, nous utilisons des opérations de convolution.

Apprenez le traitement d'images en suivant un cours abrégé sur le traitement d'images en Python.

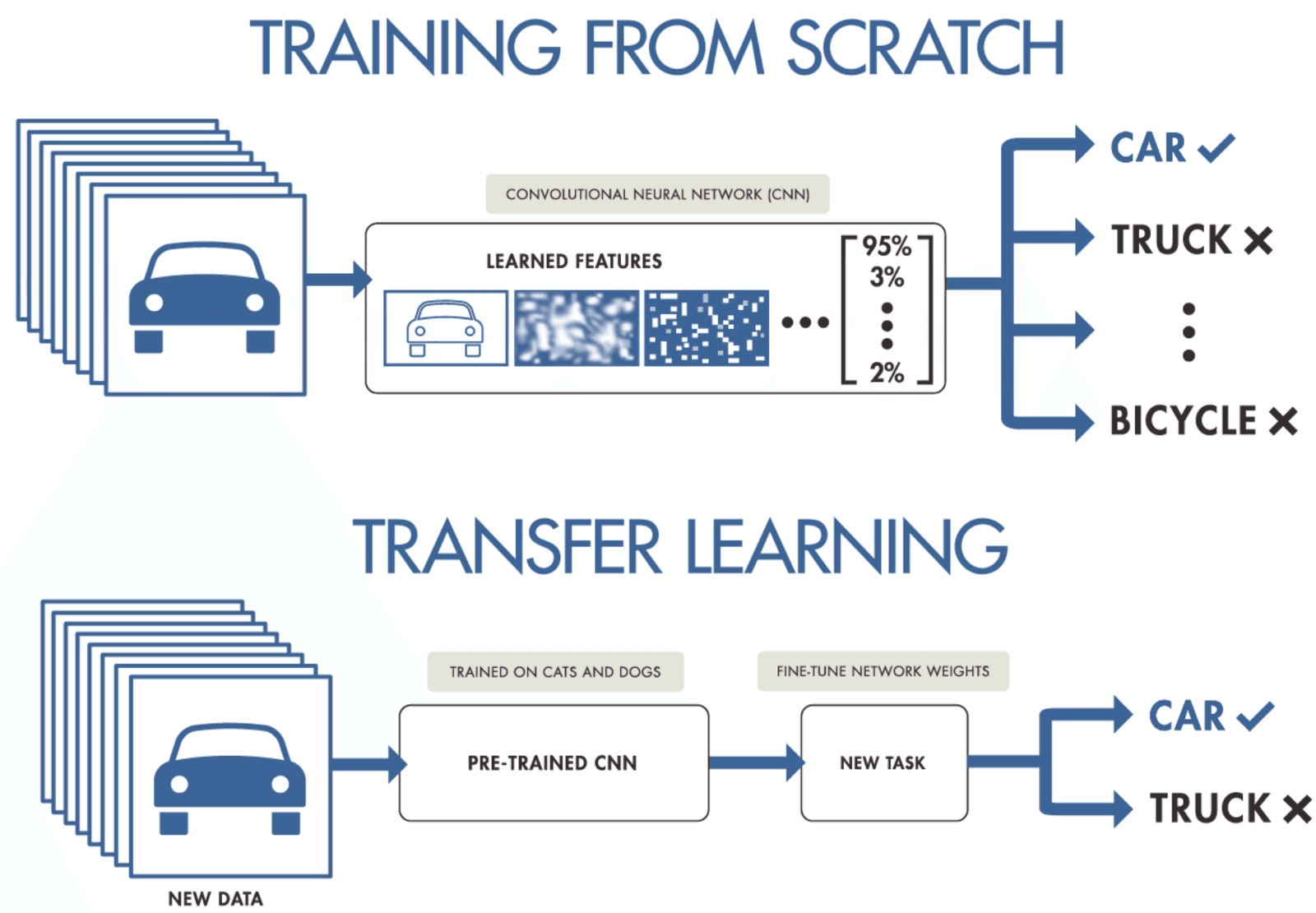

Lorsque vous disposez d'un petit ensemble de données, veuillez proposer une méthode pour entraîner un réseau neuronal convolutif.

Si vous ne disposez pas de suffisamment de données pour entraîner un réseau neuronal convolutif, vous pouvez recourir à l'apprentissage par transfert pour entraîner votre modèle et obtenir des résultats de pointe. Il est nécessaire de disposer d'un modèle pré-entraîné qui a été formé sur un ensemble de données général mais plus vaste. Par la suite, vous l'affinerez à l'aide de données plus récentes en entraînant les dernières couches des modèles.

L'apprentissage par transfert permet aux scientifiques des données de former des modèles à partir de données plus restreintes en utilisant moins de ressources, de puissance de calcul et de stockage. Vous pouvez facilement trouver des modèles open source pré-entraînés pour divers cas d'utilisation, et la plupart d'entre eux disposent d'une licence commerciale, ce qui signifie que vous pouvez les utiliser pour créer votre application.

Apprentissage par transfert par Purnasai Gudikandula

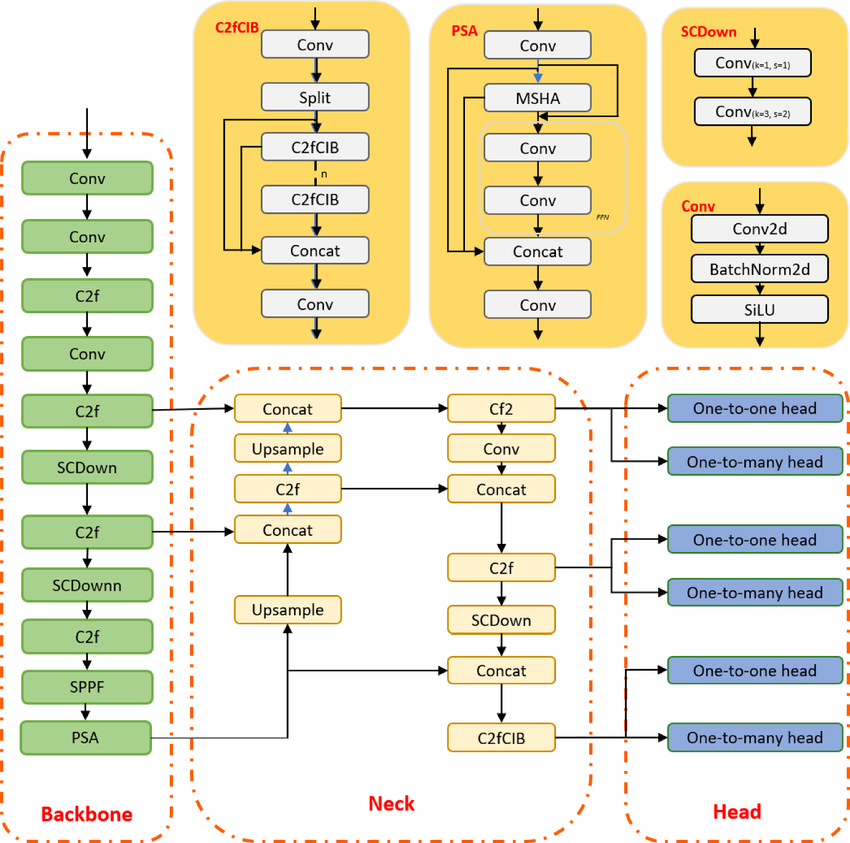

Qu'est-ce que l'algorithme de détection d'objets de pointe YOLO, et comment son architecture a-t-elle évolué récemment ?

YOLO est un algorithme de détection d'objets basé sur des réseaux neuronaux convolutifs, capable de fournir des résultats en temps réel. L'algorithme YOLO nécessite un seul passage en avant à travers le CNN pour reconnaître l'objet. Il prédit à la fois diverses probabilités de classe et des boîtes limites.

Le modèle a été formé pour détecter divers objets, et les entreprises utilisent l'apprentissage par transfert pour l'ajuster à de nouvelles données pour des applications modernes telles que la conduite autonome, la préservation de la faune sauvage et la sécurité.

Architecture du modèle YOLOv10 | researchgate

Questions d'entretien d'embauche en ingénierie NLP

Le traitement du langage naturel (NLP) constitue l'un des fondements des applications modernes de l'intelligence artificielle. Préparez-vous à des questions qui font le lien entre la théorie linguistique et la mise en œuvre pratique, et qui évaluent votre capacité à traiter, analyser et extraire du sens à partir de données textuelles non structurées à l'aide de techniques classiques et d'approches modernes d'apprentissage profond.

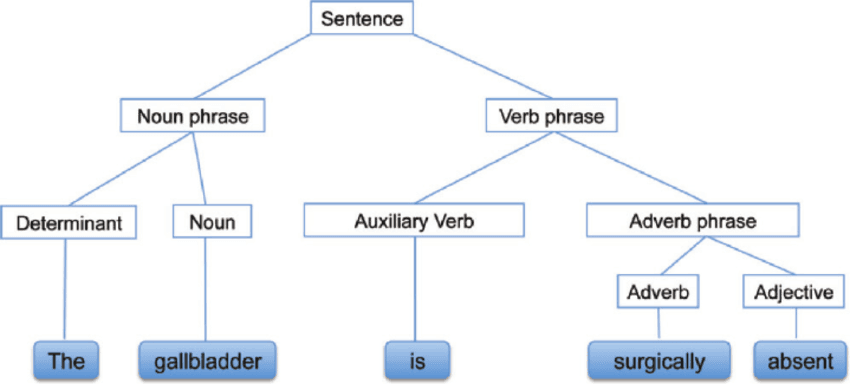

Qu'est-ce que l'analyse syntaxique ?

L'analyse syntaxique, également appelée analyse de la syntaxe ou parsing, est une analyse de texte qui nous permet de comprendre la signification logique d'une phrase ou d'une partie de phrase. Il se concentre sur la relation entre les mots et la structure grammaticale des phrases. On peut également dire qu'il s'agit du traitement consistant à analyser le langage naturel à l'aide de règles grammaticales.

Analyse syntaxique | researchgate

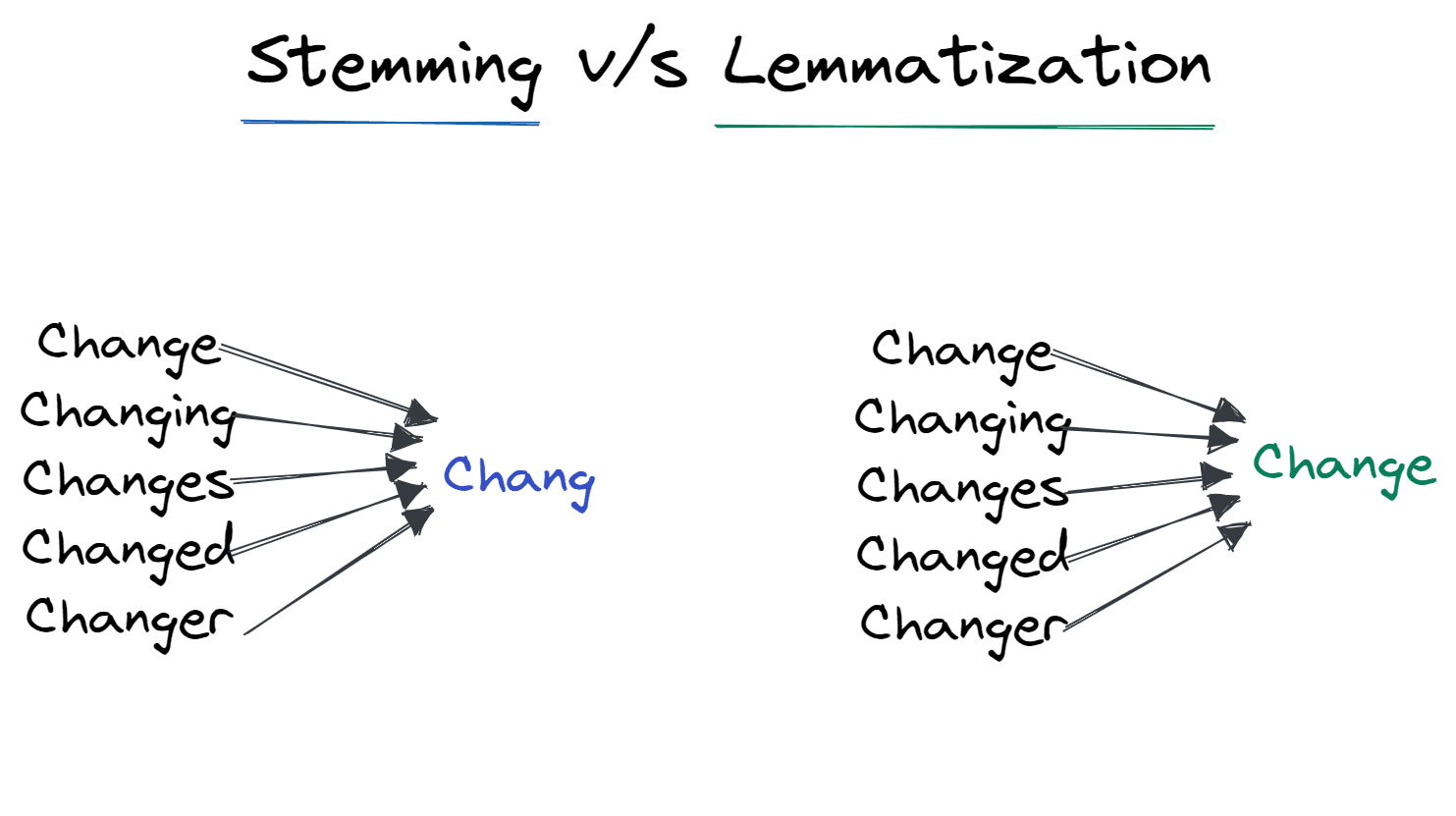

Qu'est-ce que le stemming et la lemmatisation ?

La lemmatisation est une technique de normalisation utilisée pour minimiser la variation structurelle des mots dans une phrase.

La dérivation supprime les affixes ajoutés au mot et le laisse sous sa forme de base. Par exemple, passer de « Changing » à « Chang ».

Il est largement utilisé par les moteurs de recherche pour optimiser le stockage. Au lieu de stocker toutes les formes des mots, il stocke uniquement les racines.

La lemmatisation transforme le mot en sa forme lemmatisée. Le résultat est le mot racine plutôt que le mot de base. Après la lemmatisation, nous obtenons le mot valide qui a un sens. Par exemple, Changer pour évoluer.

Stemming vs. Lemmatisation | Auteur

Quelles sont les techniques modernes permettant d'optimiser la vitesse d'inférence des modèles LLM en production ?

L'optimisation des grands transformateurs nécessite de prendre en compte à la fois la bande passante mémoire et les goulots d'étranglement informatiques :

- Quantification : Réduire le poids des modèles de FP16 (16 bits) à INT8 ou INT4 avec une perte de précision minimale. Cela permet d'intégrer des modèles plus volumineux dans une mémoire GPU plus restreinte.

- PagedAttention (vLLM) : Une technique de gestion de la mémoire qui traite le cache KV (clé-valeur) comme des pages de mémoire virtuelle, permettant un débit 2 à 4 fois supérieur en éliminant la fragmentation de la mémoire.

- Décodage spéculatif : Utilisation d'un petit modèle « provisoire » pour prédire rapidement les prochains jetons, qui sont ensuite vérifiés en parallèle par le grand modèle. Cela tire parti du fait que la lecture/écriture en mémoire est souvent plus lente que le calcul pour les jetons individuels.

Apprenez les bases du TALN en suivant le cursus « Traitement automatique du langage naturel en Python ».

Questions d'entretien pour le master en ingénierie

Les modèles d'apprentissage profond (LLM) occupant une place prépondérante dans le paysage actuel de l'intelligence artificielle, les recruteurs privilégient les candidats qui maîtrisent leur déploiement efficace. Cette section se concentre sur certains des plus grands défis techniques pratiques de 2026.

Qu'est-ce qu'une fenêtre contextuelle LLM et comment gérez-vous les tâches qui nécessitent plus de contexte que le modèle ne peut en traiter à la fois ?

La fenêtre contextuelle d'un LLM correspond à la quantité maximale de texte (mesurée en tokens) que le modèle peut prendre en compte à un moment donné lors de la génération d'une réponse, et elle limite directement la quantité de « mémoire de travail » dont dispose effectivement le modèle.

Même si les fenêtres contextuelles de grande taille deviennent plus courantes, les performances et les coûts n'évoluent pas de manière linéaire : les invites longues augmentent la latence et peuvent encore entraîner des problèmes de fiabilité lorsque les informations pertinentes sont enfouies au cœur du contexte.

Lors des entretiens, je répondais en expliquant des stratégies pratiques pour les tâches impliquant des documents longs :

- Utilisez le découpage (divisez les documents en sections sémantiquement significatives) et récupérez uniquement les segments les plus pertinents pour une question donnée.

- Privilégiez la génération augmentée par la recherche (RAG) lorsque vous avez besoin d'une base factuelle et d'une recherche ciblée plutôt que d'envoyer un document entier à chaque fois, ce qui peut réduire les coûts et éviter les pertes d'informations.

- Veuillez utiliser des notes hiérarchiques ou des résumés (résumé des sections → résumé des résumés) lorsque vous avez besoin d'une vue d'ensemble, puis récupérez les détails à la demande.

Comment atténuer les hallucinations dans les grands modèles linguistiques ?

Les hallucinations surviennent lorsqu'un LLM génère des informations plausibles mais factuellement incorrectes. En 2026, l'atténuation nécessite une approche à plusieurs niveaux :

- Génération augmentée par la récupération (RAG) : Ancrer le modèle en l'obligeant à répondre uniquement sur la base de documents extraits d'une base de connaissances fiable.

- Ingénierie rapide : Des techniques telles que la chaîne de pensée (demander au modèle d'expliquer son raisonnement étape par étape) et le Few-Shot Prompting (fournir des exemples vérifiés) réduisent considérablement les erreurs.

- Évaluation de la confiance et cohérence interne : Générer plusieurs réponses pour la même question et sélectionner la plus cohérente, ou demander au modèle d'évaluer son propre niveau de confiance avant de répondre.

- Barrières de sécurité: Mettre en œuvre des couches de post-traitement (telles que NeMo Guardrails) afin de vérifier la véracité des résultats par rapport à des règles définies avant de les présenter à l'utilisateur.

Quand est-il préférable d'opter pour la génération augmentée par la récupération (RAG) plutôt que pour le réglage fin ?

Il s'agit d'une question classique de compromis. La décision dépend de la fraîcheur des données et de la spécificité du domaine :

- Veuillez choisir RAG lorsque : Vous avez besoin du modèle pour accéder à des informations actualisées (par exemple, cours boursiers, actualités récentes) ou à des données privées qui changent fréquemment. Le RAG est plus économique et réduit les erreurs, car il fournit au modèle la réponse exacte dans le contexte.

- Veuillez sélectionner l'option « Réglage fin » lorsque : Vous avez besoin que le modèle apprenne uncomportement spécifique, un style ou un format (par exemple, parler comme un pirate ou écrire du code dans un langage interne propriétaire). Le réglage fin intègre les connaissances dans les poids, mais ne résout pas le problème de la « coupure des connaissances ».

- Approche hybride : Dans de nombreux systèmes de production, vous affinez un modèle afin qu'il comprenne le jargon spécifique à un domaine, puis vous utilisez RAG pour lui fournir les informations les plus récentes.

Cette question est abordée plus en détail dans notre blog consacré à la comparaison entre RAG et Fine-Tuning.

Questions d'entretien d'embauche en ingénierie sur l'apprentissage par renforcement

L'apprentissage par renforcement (RL) traite des problèmes dans lesquels un agent apprend en interagissant avec un environnement plutôt qu'à partir d'ensembles de données statiques. Soyez prêt à discuter du fonctionnement de RL et à expliquer des concepts fondamentaux tels que les politiques.

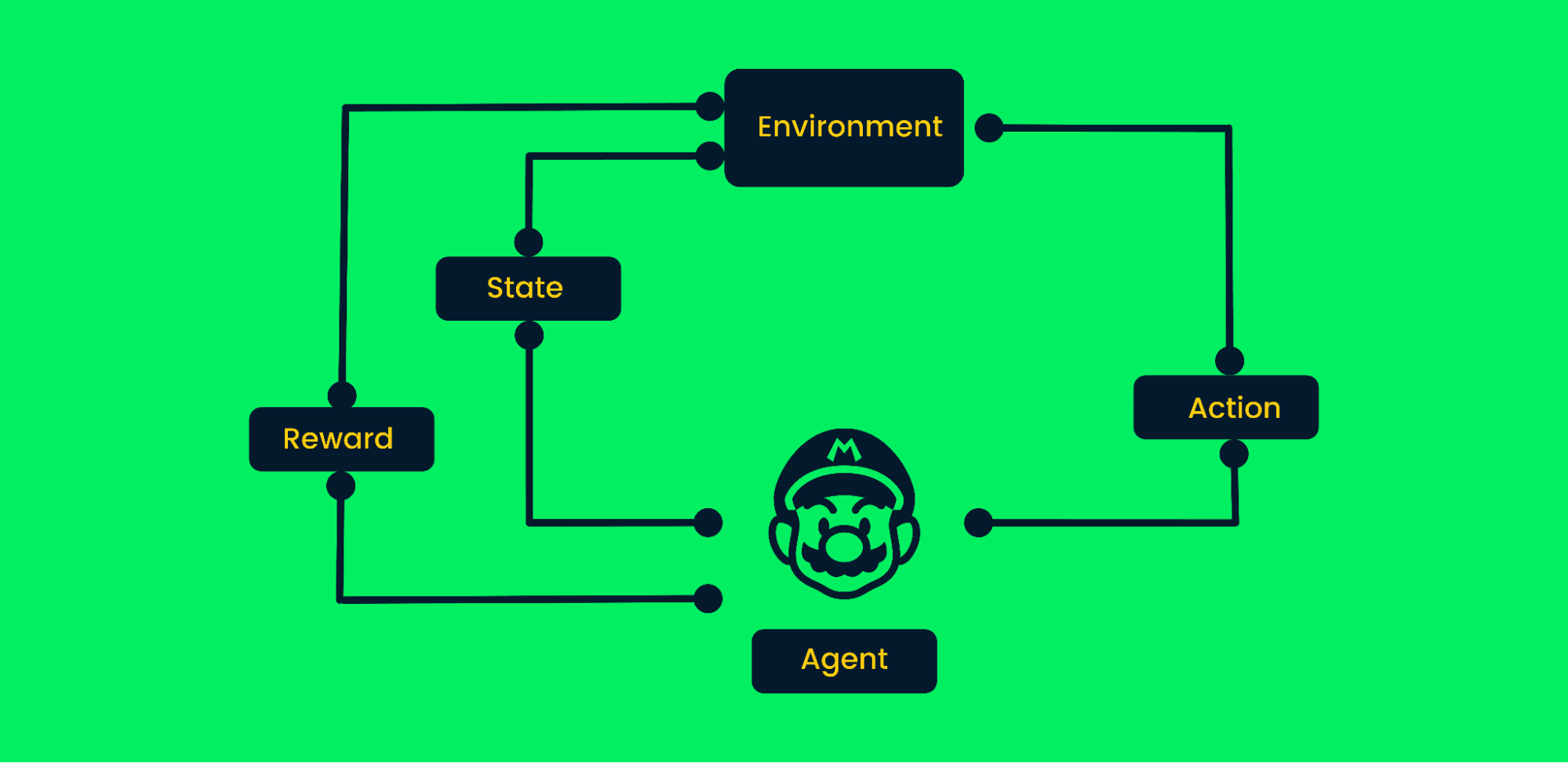

Quelles sont les étapes d'un algorithme d'apprentissage par renforcement classique ?

L'apprentissage par renforcement utilise la méthode d'essais et d'erreurs pour atteindre des objectifs. Il s'agit d'un algorithme orienté vers les objectifs qui apprend de l'environnement en prenant les mesures appropriées pour maximiser la récompense cumulative.

Dans l'apprentissage par renforcement classique :

- Au début, l'agent reçoit l'état zéro de l'environnement.

- En fonction de la situation, l'agent prendra une mesure.

- La situation a évolué et l'agent se trouve désormais dans un nouvel environnement.

- L'agent reçoit la récompense s'il a effectué le bon choix.

- Le processus se répétera jusqu'à ce que l'agent ait appris le meilleur chemin possible pour atteindre l'objectif en maximisant les récompenses cumulées.

Cadre d'apprentissage par renforcement | Auteur

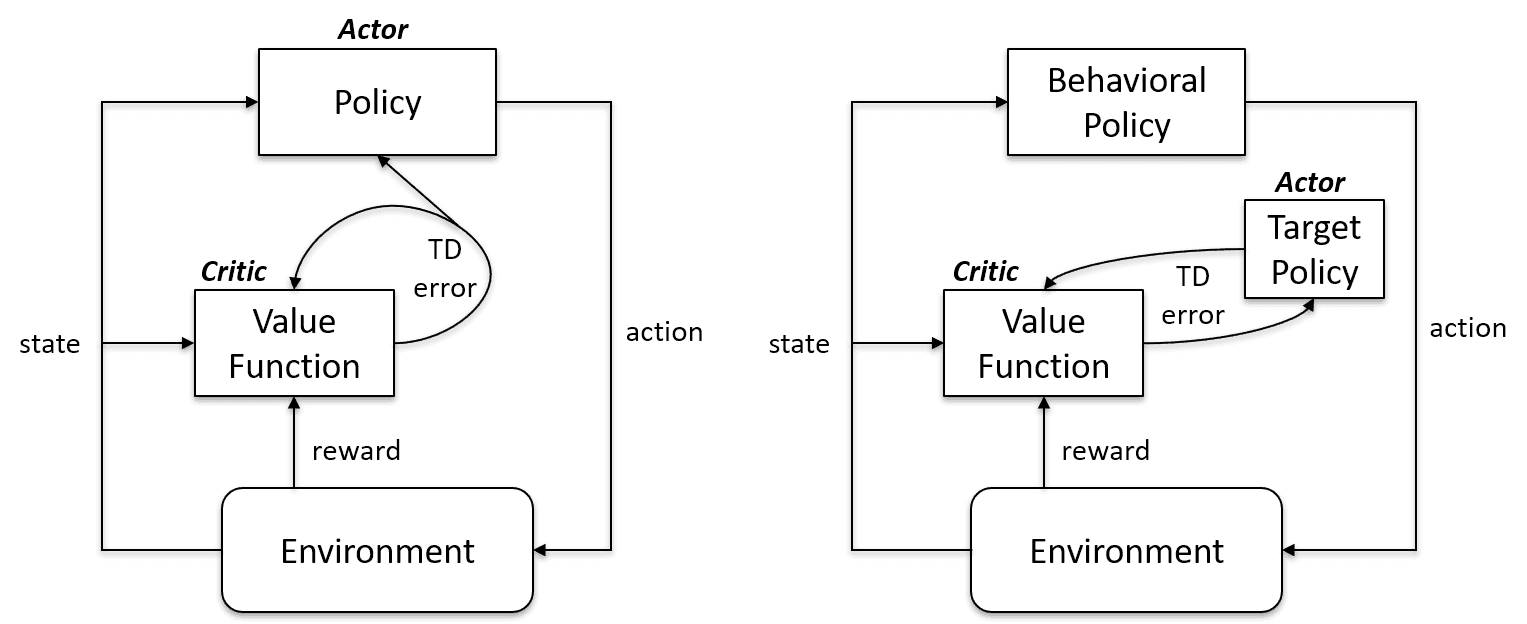

Quelle est la différence entre l'apprentissage hors politique et l'apprentissage conforme à la politique ?

Les algorithmes d'apprentissage sur politique évaluent et améliorent la même politique pour agir et la mettre à jour. En d'autres termes, la politique utilisée pour la mise à jour et celle utilisée pour prendre des mesures sont identiques.

Politique cible == Politique comportementale

Les algorithmes on-policy sont Sarsa, Monte Carlo for On-Policy, Value Iteration et Policy Iteration.

Les algorithmes d'apprentissage hors politique sont totalement différents, car la politique mise à jour diffère de la politique comportementale. Par exemple, dans l'apprentissage Q, l'agent apprend à partir d'une politique optimale à l'aide d'une politique avide et agit en utilisant d'autres politiques.

Politique cible ≠ Politique comportementale

Conforme à la politique vs. Cas hors politique | Artificial Intelligence Stack Exchange

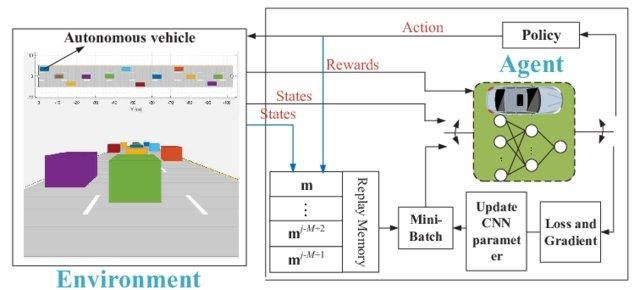

Pourquoi avons-nous besoin de l'apprentissage profond Q ?

L'apprentissage simple par Q est remarquable. Cela résout le problème à petite échelle, mais à plus grande échelle, cela ne fonctionne pas.

Considérons que l'environnement comporte 1 000 états et 1 000 actions par état. Nous aurons besoin d'un tableau Q contenant des millions de cellules. Le jeu d'échecs et le jeu de go nécessitent un tableau encore plus grand. C'est là que l'apprentissage profond Q intervient.

Il utilise un réseau neuronal pour estimer la fonction de valeur Q. La recette des réseaux neuronaux indique en entrée et en sortie la valeur Q de toutes les actions possibles.

Réseau Q profond pour la conduite autonome | researchgate

Questions pour les ingénieurs en apprentissage automatique FAANG

Ci-dessous, nous avons répertorié quelques questions que le recruteur pourrait vous poser dans certaines des plus grandes entreprises technologiques :

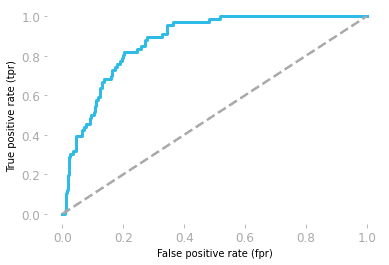

Quelle est l'interprétation d'une aire ROC sous la courbe ?

Les caractéristiques de fonctionnement du récepteur (ROC) illustrent le compromis entre la sensibilité et la spécificité.

- Sensibilité : il s'agit de la probabilité que le modèle prédise un résultat positif lorsque la valeur réelle est également positive.

- Spécificité : il s'agit de la probabilité que le modèle prédise un résultat négatif lorsque la valeur réelle est également négative.

Le graphique est réalisé à l'aide du taux de faux positifs (FP/(TN + FP)) et du taux de vrais positifs (TP/(TP + FN)).

L'aire sous la courbe (AUC) indique la performance du modèle. Si l'aire sous la courbe ROC est égale à 0,5, cela signifie que notre modèle est entièrement aléatoire. Le modèle dont l'AUC est proche de 1 est le modèle le plus performant.

Courbe ROC par Hadrien Jean

Comment évaluez-vous les modèles d'IA générative lorsqu'il n'existe pas de « vérité terrain » unique ?

Contrairement à la classification (où une réponse est correcte ou incorrecte), l'IA générative nécessite souvent une évaluation humaine ou des cadres « LLM-as-a-Judge » :

- Mesures sans référence : Utilisation d'un modèle plus puissant (tel que GPT-4) pour évaluer la réponse d'un modèle plus petit selon des critères tels que « l'utilité », « la sécurité » et « la cohérence ».

- RAGAS (Évaluation de la génération augmentée par la récupération) : Un cadre standard qui mesure spécifiquement la « fidélité » (la réponse provient-elle du contexte ?) et la « pertinence de la réponse » (répond-elle à la question de l'utilisateur ?).

- Évaluation humaine (classement Elo) : Pour la validation finale, comparer les résultats de deux modèles côte à côte (test A/B) et calculer un classement Elo, similaire au classement LMArena.

Quelles sont les méthodes permettant de réduire la dimensionnalité ?

Pour la réduction de dimensionnalité, nous pouvons recourir à des méthodes de sélection ou d'extraction de caractéristiques.

La sélection des caractéristiques est un processus qui consiste à choisir les caractéristiques optimales et à éliminer celles qui ne sont pas pertinentes. Nous utilisons les méthodes Filter, Wrapper et Embedded pour analyser l'importance des caractéristiques et supprimer celles qui sont moins importantes afin d'améliorer les performances du modèle.

L'extraction de caractéristiques transforme l'espace à plusieurs dimensions en un espace à moins de dimensions. Aucune information n'est perdue au cours du processus, et celui-ci utilise moins de ressources pour traiter les données. Les techniques d'extraction les plus courantes sont l'analyse discriminante linéaire (LDA), l'ACP à noyau et l'analyse discriminante quadratique.

Comment déterminez-vous les seuils pour un classificateur ?

Dans le cas d'un classificateur de spam, un modèle de régression logistique renverra la probabilité. Nous utilisons soit la probabilité de 0,8999, soit nous la convertissons en classe (spam/non spam) à l'aide d'un seuil.

Généralement, le seuil d'un classificateur est de 0,5, mais dans certains cas, il est nécessaire de l'ajuster pour améliorer la précision. Le seuil de 0,5 signifie que si la probabilité est égale ou supérieure à 0,5, il s'agit de spam, et si elle est inférieure, il ne s'agit pas de spam.

Pour déterminer le seuil, nous pouvons utiliser les courbes de précision-rappel et les courbes ROC, effectuer une recherche par grille et modifier manuellement la valeur afin d'obtenir un meilleur CV.

Devenez un ingénieur professionnel en apprentissage automatique en suivant le cursus « Machine Learning Scientist with Python » (Scientifique en apprentissage automatique avec Python).

Quelles sont les hypothèses de la régression linéaire ?

La régression linéaire est utilisée pour comprendre la relation entre les caractéristiques (X) et la cible (y). Avant de procéder à l'entraînement du modèle, il est nécessaire de respecter certaines conditions préalables :

- Les résidus sont indépendants.

- Il existe une relation linéaire entre la variable indépendante X et la variable dépendante y.

- Variance résiduelle constante à tous les niveaux de X

- Les résidus sont normalement distribués.

Remarque : les résidus dans la régression linéaire correspondent à la différence entre les valeurs réelles et les valeurs prédites.

Écrivez une fonction find_bigrams qui prend une chaîne de caractères et renvoie une liste de tous les bigrammes.

Au cours des entretiens de codage, on vous posera des questions sur les problèmes liés à l'apprentissage automatique, mais dans certains cas, on évaluera vos compétences en Python en vous posant des questions générales sur le codage. Devenez un programmeur Python expert en suivant le cursus Programmeur Python.

Créer une fonction bigramme est relativement simple. Il est nécessaire d'utiliser deux boucles avec la fonction zip.

- Dans la fonction bigramme, nous utilisons une liste de phrases comme entrée.

- Création d'une boucle pour accéder à une seule phrase

- Réduire et diviser la phrase en une liste de mots

- Utilisation de

zippour créer une combinaison du mot précédent et du mot suivant - Ajouter la sortie au résultat

- Impression des résultats.

Il est relativement simple de résoudre ce problème en le décomposant et en utilisant les fonctions zip.

def bigram(text_list:list):

result = []

for ls in text_list:

words = ls.lower().split()

for bi in zip(words, words[1:]):

result.append(bi)

return result

text = ["Data drives everything", "Get the skills you need for the future of work"]

print(bigram(text))Résultats :

[('Data', 'drives'), ('drives', 'everything'), ('Get', 'the'), ('the', 'skills'), ('skills', 'you'), ('you', 'need'), ('need', 'for'), ('for', 'the'), ('the', 'future'), ('future', 'of'), ('of', 'work')]Quelle est la fonction d'activation dans l'apprentissage automatique ?

La fonction d'activation est une transformation non linéaire dans les réseaux neuronaux. Nous transmettons l'entrée à la fonction d'activation avant de la transmettre à la couche suivante.

La valeur d'entrée nette peut être comprise entre -inf et +inf, et le neurone ne sait pas comment limiter les valeurs, ce qui l'empêche de déterminer le modèle de déclenchement. La fonction d'activation détermine si un neurone doit être activé ou non afin de limiter les valeurs d'entrée du réseau.

Types les plus courants de fonctions d'activation :

- Fonction échelon

- Fonction sigmoïde

- ReLU

- Leaky ReLu

Comment élaboreriez-vous une recommandation de restaurant sur Facebook ?

La réponse dépend entièrement de vous. Cependant, avant de répondre, il est nécessaire de déterminer l'objectif commercial que vous souhaitez atteindre afin de définir un indicateur de performance et la manière dont vous allez acquérir les données.

Dans une conception classique de système d'apprentissage automatique, nous :

- Veuillez collecter, nettoyer et analyser les données.

- Effectuer l'ingénierie des caractéristiques

- Veuillez sélectionner une méthodologie, un algorithme ou un modèle d'apprentissage automatique.

- Veuillez entraîner et évaluer les performances sur les ensembles de données de test et de validation.

- Optimisez les processus et déployez le modèle en production.

Il est important de vous concentrer sur la conception plutôt que sur la théorie ou l'architecture du modèle. Veuillez aborder le sujet de l'inférence des modèles et expliquer comment son amélioration augmentera les revenus globaux.

Veuillez également expliquer pourquoi vous avez choisi une méthodologie plutôt qu'une autre.

Pour en savoir plus sur la création de systèmes de recommandation, nous vous invitons à suivre un cours sur DataCamp.

Étant donné deux chaînes A et B, veuillez créer une fonction can_shift qui indique si A peut être décalée d'un certain nombre de places pour obtenir B.

Résoudre des défis de codage et perfectionner vos compétences en Python augmentera vos chances de réussir l'étape de l'entretien de codage.

Avant de vous lancer dans la résolution d'un problème, il est nécessaire de bien comprendre la question. Il vous suffit de créer une fonction booléenne qui renverra True si, en décalant les lettres de la chaîne B, vous obtenez la chaîne A.

A = 'abid'

B = 'bida'

can_shift(A, B) == True- Renvoie « false » si la longueur de la chaîne n'est pas similaire.

- Effectuer une boucle sur la longueur de la chaîne A

- Créer mut_a pour générer diverses combinaisons de caractères à partir de la chaîne A.

- Au cours de la boucle, si mut_a est égal à la chaîne B, la fonction renvoie True, sinon elle renvoie false.

def can_shift(a, b):

if len(a) != len(b):

return False

for i in range(len(a)):

mut_a = a[i:] + a[:i]

if mut_a == b:

return True

return False

A = 'abid'

B = 'bida'

print(can_shift(A, B))

>>> TrueQu'est-ce que l'apprentissage en ensemble ?

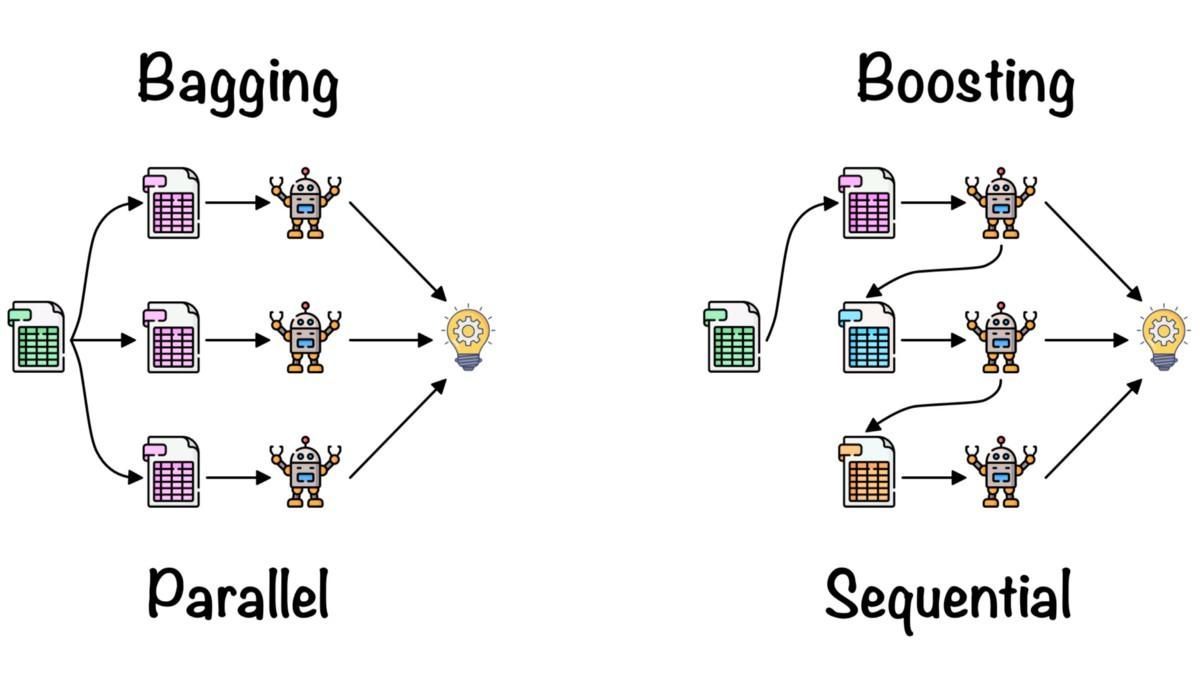

L'apprentissage d'ensemble est utilisé pour combiner les informations issues de plusieurs modèles d'apprentissage automatique afin d'améliorer la précision et les indicateurs de performance.

Méthodes d'ensemble simples :

- Moyenne : nous calculons la moyenne des prédictions issues de plusieurs modèles performants.

- Moyenne pondérée : nous attribuons différentes pondérations aux modèles d'apprentissage automatique en fonction de leurs performances, puis nous les combinons.

Méthodes d'ensemble avancées :

- L'ensachage est utilisé pour minimiser les erreurs de variance. Il génère de manière aléatoire un sous-ensemble de données d'apprentissage et l'applique aux modèles. La combinaison de modèles réduit la variance et rend le résultat plus fiable par rapport à un modèle unique.

- Le boosting est utilisé pour réduire les erreurs de biais et produire des modèles prédictifs de qualité supérieure. Il s'agit d'une technique d'ensemble itérative qui ajuste les poids en fonction de la dernière classification. Les algorithmes de renforcement accordent davantage d'importance aux observations que le modèle précédent avait prédites de manière inexacte.

Emballage et optimisation par Fernando López

Pour en savoir plus sur le calcul de la moyenne, le bagging, le stacking et le boosting, veuillez suivre le cours Méthodes d'ensemble en Python.

Conclusion

Alors que nous terminons notre exploration des questions essentielles à poser lors d'un entretien d'embauche dans le domaine du machine learning, il apparaît clairement que pour réussir un tel entretien, il est nécessaire de posséder à la fois des connaissances théoriques, des compétences pratiques et une bonne connaissance des dernières tendances et technologies dans ce domaine. De la compréhension des concepts de base tels que l'apprentissage semi-supervisé et la sélection d'algorithmes, à l'étude approfondie de la complexité d'algorithmes spécifiques tels que KNN, en passant par la maîtrise des défis spécifiques à chaque rôle dans le domaine du traitement automatique du langage naturel, de la vision par ordinateur ou de l'apprentissage par renforcement, le champ d'application est vaste.

Que vous soyez débutant et souhaitiez vous lancer dans ce domaine ou praticien expérimenté cherchant à progresser, l'apprentissage et la pratique continus sont essentiels. DataCamp propose un cursus complet intitulé « Machine Learning Scientist with Python » (Scientifique en apprentissage automatique avec Python) qui vous permet d'améliorer vos compétences de manière structurée et approfondie.

Obtenez une certification de haut niveau en matière d'IA

Questions fréquentes

À quoi ressemble un entretien d'embauche dans le domaine de l'apprentissage automatique ?

En général, les entretiens techniques sur l'apprentissage automatique sont divisés en plusieurs parties :

- Entretien de codage

- Algorithmes et traitement des données

- Entretien spécifique au poste

- Entretien sur la conception de systèmes d'apprentissage automatique

- Opérations d'apprentissage automatique et meilleures pratiques

Les entretiens non techniques ou sur site font également partie du processus d'entretien lié à l'apprentissage automatique, mais ils sont plus généraux et spécifiques à l'entreprise.

Est-il facile de réussir les entretiens d'embauche chez Amazon dans le domaine de l'apprentissage automatique ?

Non, il est nécessaire de se préparer pour les différentes étapes de l'entretien. Il est nécessaire de vous préparer pour un test d'évaluation en ligne, un entretien téléphonique avec un recruteur, un entretien téléphonique technique et un entretien sur place. Chaque étape évalue vos compétences et vos connaissances.

Les ingénieurs en apprentissage automatique passent-ils des entretiens portant sur le codage ?

Oui. Il évaluera vos compétences en résolution de problèmes Python et en analyse de données SQL. De plus, vous serez interrogé sur les outils d'apprentissage automatique. Il est recommandé de s'exercer au codage en relevant des défis tels que les tests d'évaluation DataCamp.

Quelles sont les principales tâches d'un ingénieur en IA/ML ?

En général, les ingénieurs en IA/ML effectuent des recherches, conçoivent et développent des systèmes d'apprentissage automatique, mais cela varie d'un poste à l'autre et d'une entreprise à l'autre.

De plus :

- Ils procèdent au nettoyage des données, à leur validation et à leur enrichissement à partir de l'entraînement des modèles.

- Optimisez l'architecture du modèle et les hyperparamètres pour obtenir de meilleurs résultats.

- Comprendre les activités commerciales et la disponibilité des données.

- Indicateurs de performance, algorithmes et stratégie de déploiement.

- Parfois, ils sont également impliqués dans le cloud computing et les opérations de développement.

Comment dois-je me préparer pour un entretien d'embauche dans le domaine de l'apprentissage automatique ?

Veuillez vous informer sur l'entreprise et les responsabilités liées au poste, résoudre des défis de codage, examiner les projets précédents, concevoir et vous familiariser avec le cycle de vie complet de l'apprentissage automatique, vous entraîner à répondre à des questions d'entretien et vous renseigner sur les derniers développements dans le domaine de l'IA/ML. Ceci est important, que vous soyez nouvellement devenu ingénieur en apprentissage automatique ou que vous ayez plusieurs années d'expérience professionnelle dans ce domaine.