Curso

Neste artigo, a gente falou sobre algumas das perguntas mais comuns em entrevistas sobre machine learning que você pode encontrar quando se candidatar a uma vaga no setor ou entrevistar um candidato. Praticar essas perguntas e preparar respostas pode te ajudar a garantir que a entrevista corra bem.

Desenvolver aplicativos de IA

Perguntas básicas sobre machine learning para entrevistas

As perguntas básicas têm a ver com terminologias, algoritmos e metodologias. Os entrevistadores fazem essas perguntas para avaliar o conhecimento técnico do candidato.

O que é machine learning semi-supervisionado?

A aprendizagem semi-supervisionada é uma mistura de aprendizagem supervisionada e não supervisionada. O algoritmo é treinado com uma mistura de dados rotulados e não rotulados. Geralmente, é usado quando temos um conjunto de dados rotulados bem pequeno e um conjunto de dados não rotulados grande.

Em termos simples, o algoritmo não supervisionado é usado para criar clusters e, usando os dados rotulados existentes, rotular o resto dos dados não rotulados. Um algoritmo semi-supervisionado assume a suposição de continuidade, a suposição de agrupamento e a suposição de variedade.

Geralmente é usado para economizar o custo de aquisição de dados rotulados. Por exemplo, classificação de sequências de proteínas, reconhecimento automático de voz e carros autônomos.

Como você escolhe qual algoritmo usar para um conjunto de dados?

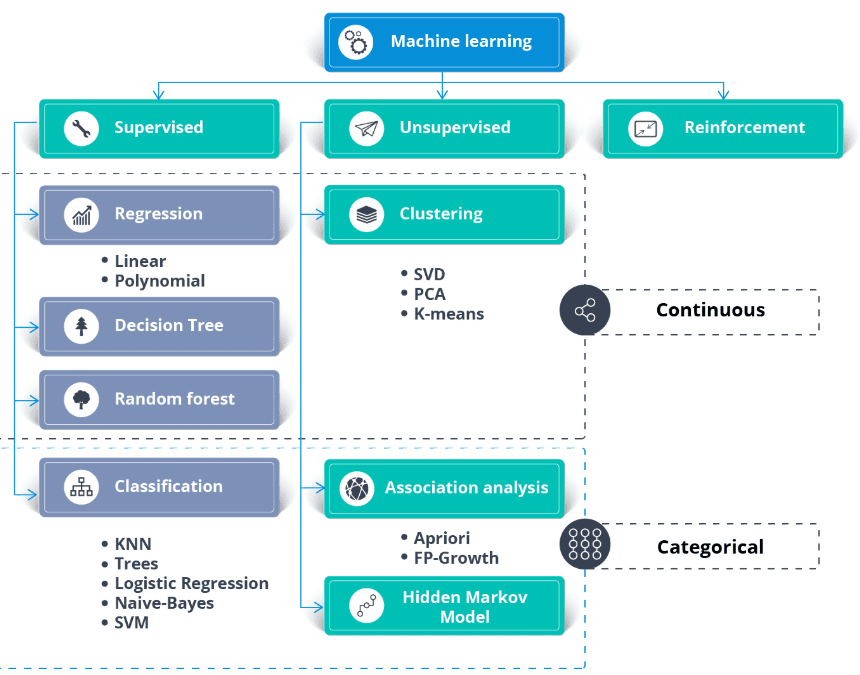

Além do conjunto de dados, você precisa de um caso de uso comercial ou requisitos de aplicação. Você pode aplicar o aprendizado supervisionado e não supervisionado aos mesmos dados.

Em geral:

- Os algoritmos de aprendizagem supervisionada precisam de dados rotulados.

- Os algoritmos de regressão precisam de alvos numéricos contínuos.

- Os algoritmos de classificação precisam de alvos categóricos.

- Os algoritmos de aprendizagem não supervisionada precisam de dados sem rótulos.

- O aprendizado semi-supervisionado precisa de conjuntos de dados rotulados e não rotulados.

- Os algoritmos de aprendizagem por reforço precisam de dados sobre o ambiente, o agente, o estado e a recompensa.

Imagem de thecleverprogrammer

Aprenda os fundamentos do machine learning fazendo nosso curso.

Explique o algoritmo K Nearest Neighbor.

O K Nearest Neighbor (KNN) é um classificador de aprendizagem supervisionada. Ele usa a proximidade para classificar rótulos ou prever o agrupamento de pontos de dados individuais. Podemos usá-lo para regressão e classificação. O algoritmo KNN é não paramétrico, ou seja, não faz nenhuma suposição sobre como os dados estão distribuídos.

No classificador KNN:

- A gente encontra os K vizinhos mais próximos do ponto branco. No exemplo abaixo, escolhemos k=5.

- Para encontrar os cinco vizinhos mais próximos, calculamos a distância euclidiana entre o ponto branco e os outros. Depois, escolhemos os 5 pontos mais próximos do ponto branco.

- Tem três pontos vermelhos e dois verdes em K=5. Como o vermelho tem maioria, a gente coloca uma etiqueta vermelha nele.

Imagem da história de desenvolvimento do Codesigner

Aprenda tudo sobre modelos de classificação e regressão de aprendizado supervisionado fazendo um curso rápido.

O que é a importância dos recursos no machine learning e como você determina isso?

A importância dos recursos se refere a técnicas que atribuem uma pontuação aos recursos de entrada com base na sua utilidade para prever uma variável-alvo. Ele é super importante pra entender a estrutura dos dados, o comportamento do modelo e deixar o modelo mais fácil de entender.

Tem vários jeitos de ver qual é a importância de cada característica:

- Importância baseada no modelo: Alguns algoritmos, como árvores de decisão e florestas aleatórias, têm métodos integrados para avaliar a importância dos recursos. Por exemplo, as Random Forests calculam a redução na impureza do nó ponderada pela probabilidade de chegar a esse nó, com a média de todas as árvores.

- Importância da permutação: Isso envolve embaralhar variáveis individuais no conjunto de validação e ver como isso afeta o desempenho do modelo. Uma queda significativa no desempenho do modelo mostra que isso é super importante.

- SHAP (Explicações Aditivas de Shapley): Essa abordagem usa a teoria dos jogos para medir a contribuição de cada característica para a previsão em um modelo complexo. Os valores SHAP dão uma visão detalhada do comportamento do modelo e são super úteis para modelos complexos, como máquinas de reforço de gradiente ou redes neurais.

- Coeficientes de correlação: Medidas estatísticas simples, como a correlação de Pearson ou Spearman, podem ajudar a entender a relação linear entre cada característica e a variável-alvo.

Entender a importância dos recursos é essencial para otimizar o modelo, reduzir o sobreajuste removendo recursos que não trazem informação e melhorar a interpretabilidade do modelo, principalmente em áreas onde entender o processo de decisão do modelo é superimportante.

O que é sobreajuste no machine learning e como ele pode ser evitado?

O sobreajuste rola quando um modelo se sai bem nos dados de treinamento, mas não consegue generalizar para dados que não viu antes porque memorizou os dados de treinamento em vez de aprender os padrões por trás deles. Isso pode ser evitado:

- Usando técnicas de validação cruzada.

- Aplicando regularização (L1, L2).

- Reduzindo a complexidade do modelo.

- Coletando mais dados de treinamento ou usando aumento de dados.

Qual é a diferença entre aprendizagem supervisionada e não supervisionada?

- Aprendizagem supervisionada: O modelo é treinado com dados rotulados, onde a variável alvo é conhecida. Exemplos incluem classificação e regressão.

- Aprendizagem não supervisionada: O modelo é treinado com dados sem rótulos para encontrar padrões ou agrupamentos. Exemplos incluem agrupamento e redução de dimensionalidade.

O que é uma matriz de confusão e por que ela é útil?

Uma matriz de confusão é uma tabela usada para avaliar o desempenho de um modelo de classificação. Mostra o número de verdadeiros positivos, verdadeiros negativos, falsos positivos e falsos negativos. É útil para calcular métricas como exatidão, precisão, recall e pontuação F1.

Qual é a diferença entre modelos paramétricos e não paramétricos?

Modelos paramétricos: Elas fazem suposições sobre a distribuição subjacente dos dados e têm um número fixo de parâmetros (por exemplo, regressão linear).

Modelos não paramétricos: Eles não fazem suposições sobre a distribuição dos dados e podem se adaptar à complexidade à medida que mais dados são adicionados (por exemplo, K-Nearest Neighbors).

O que é o compromisso entre viés e variância no machine learning?

O compromisso entre viés e variância é o equilíbrio entre a capacidade de um modelo de capturar padrões complexos (baixo viés) e sua sensibilidade às flutuações nos dados de treinamento (baixa variância). Um bom modelo consegue um equilíbrio minimizando tanto o viés quanto a variância para evitar o subajuste e o sobreajuste.

Perguntas técnicas sobre machine learning para entrevistas

A entrevista técnica é mais pra ver o quanto você sabe sobre processos e como você lida com incertezas. O gerente de contratação vai fazer perguntas sobre machine learning relacionadas a processamento de dados, treinamento e validação de modelos e algoritmos avançados.

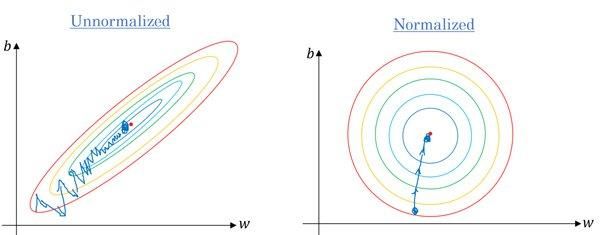

É verdade que precisamos ajustar os valores dos nossos recursos quando eles variam muito?

Sim. A maioria dos algoritmos usa a distância euclidiana entre pontos de dados e, se o valor da característica variar muito, os resultados serão bem diferentes. Na maioria dos casos, os outliers fazem com que os modelos de machine learning tenham um desempenho pior no conjunto de dados de teste.

Também usamos o dimensionamento de recursos para reduzir o tempo de convergência. Vai demorar mais tempo para o gradiente descendente chegar aos mínimos locais quando as características não estiverem normalizadas.

Gradiente sem e com escala | Quora

As habilidades de engenharia de recursos estão em alta demanda. Você pode aprender tudo sobre o assunto fazendo um curso do DataCamp, como Engenharia de Recursos para Machine Learning em Python.

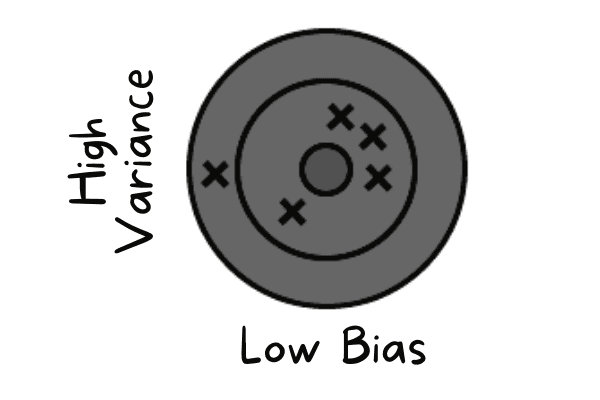

O modelo que você treinou tem um viés baixo e uma variância alta. Como você lidaria com isso?

O viés baixo rola quando o modelo tá prevendo valores próximos do valor real. Está imitando o conjunto de dados de treinamento. O modelo não tem generalização, o que significa que, se for testado em dados não vistos, vai dar resultados ruins.

Baixo viés e alta variância | Autor

Para resolver esses problemas, vamos usar algoritmos de bagging, que dividem um conjunto de dados em subconjuntos usando amostragem aleatória. Depois, a gente gera conjuntos de modelos usando essas amostras com um único algoritmo. Depois disso, juntamos a previsão do modelo usando classificação por votação ou média.

Para alta variância, podemos usar técnicas de regularização. Isso penalizou coeficientes de modelo mais altos para diminuir a complexidade do modelo. Além disso, podemos escolher as principais características do gráfico de importância das características e treinar o modelo.

O que é desvio do modelo e como você o detecta na produção?

O desvio do modelo acontece quando o desempenho de um modelo piora com o tempo porque os dados do mundo real mudam em relação aos dados de treinamento. Existem dois tipos principais:

- Desvio de dados (mudança de covariável): A distribuição dos dados de entrada muda (por exemplo, os usuários começam a enviar imagens à noite, em vez de durante o dia). Você detecta isso monitorando a distância estatística (como a divergência KL) entre as distribuições de recursos de treinamento e produção.

- Desvio conceitual: A relação entre entradas e saídas muda (por exemplo, as definições de “spam” mudam com o tempo). Você detecta isso monitorando métricas de negócios a jusante (como taxa de cliques) ou precisão da verdade fundamental, se disponível.

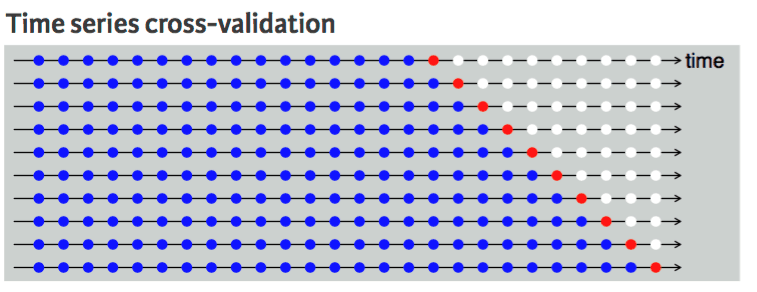

Que técnica de validação cruzada você sugeriria para um conjunto de dados de séries temporais e por quê?

A validação cruzada é usada para avaliar o desempenho do modelo de forma robusta e evitar o sobreajuste. Geralmente, as técnicas de validação cruzada escolhem amostras aleatoriamente dos dados e as dividem em conjuntos de dados de treinamento e teste. O número de divisões é baseado no valor K.

Por exemplo, se K = 5, vai ter quatro dobras para o treinamento e uma para o teste. Ele vai repetir cinco vezes para medir o modelo executado em dobras separadas.

Não dá pra fazer isso com um conjunto de dados de séries temporais porque não faz sentido usar o valor do futuro pra prever o valor do passado. Tem uma dependência temporal entre as observações, e só dá pra dividir os dados numa direção, de forma que os valores do conjunto de dados de teste fiquem depois do conjunto de treinamento.

O diagrama mostra que a divisão em k partes dos dados da série temporal é unidirecional. Os pontos azuis são o conjunto de treinamento, o ponto vermelho é o conjunto de teste e o branco são dados não utilizados. Como dá pra ver em cada repetição, estamos avançando com o conjunto de treinamento, enquanto o conjunto de teste continua na frente do conjunto de treinamento, sem ser escolhido aleatoriamente.

Validação cruzada de séries temporais | Guia de programação R para análise de negócios da UC

Aprenda sobre manipulação, análise, visualização e modelagem de dados de séries temporais fazendo o curso Séries temporais com Python.

Perguntas para entrevistas de engenharia de visão computacional

A maioria das vagas de machine learning oferecidas no LinkedIn, Glassdoor e Indeed são específicas para cada função. Então, durante a entrevista, eles vão focar em perguntas específicas sobre a função. Para a função de engenheiro de visão computacional, o gerente de contratação vai se concentrar em questões relacionadas ao processamento de imagens.

Por que as entradas em problemas de visão computacional podem ficar tão grandes? Explique com um exemplo.

Imagina uma imagem de 250 x 250 e uma primeira camada oculta totalmente conectada com 1000 unidades ocultas. Para essa imagem, as características de entrada são 250 X 250 X 3 = 187.500, e a matriz de pesos na primeira camada oculta será uma matriz dimensional de 187.500 X 1000. Esses números são enormes para armazenamento e computação, e para resolver esse problema, usamos operações de convolução.

Aprenda processamento de imagens fazendo um curso rápido de Processamento de Imagens em Python.

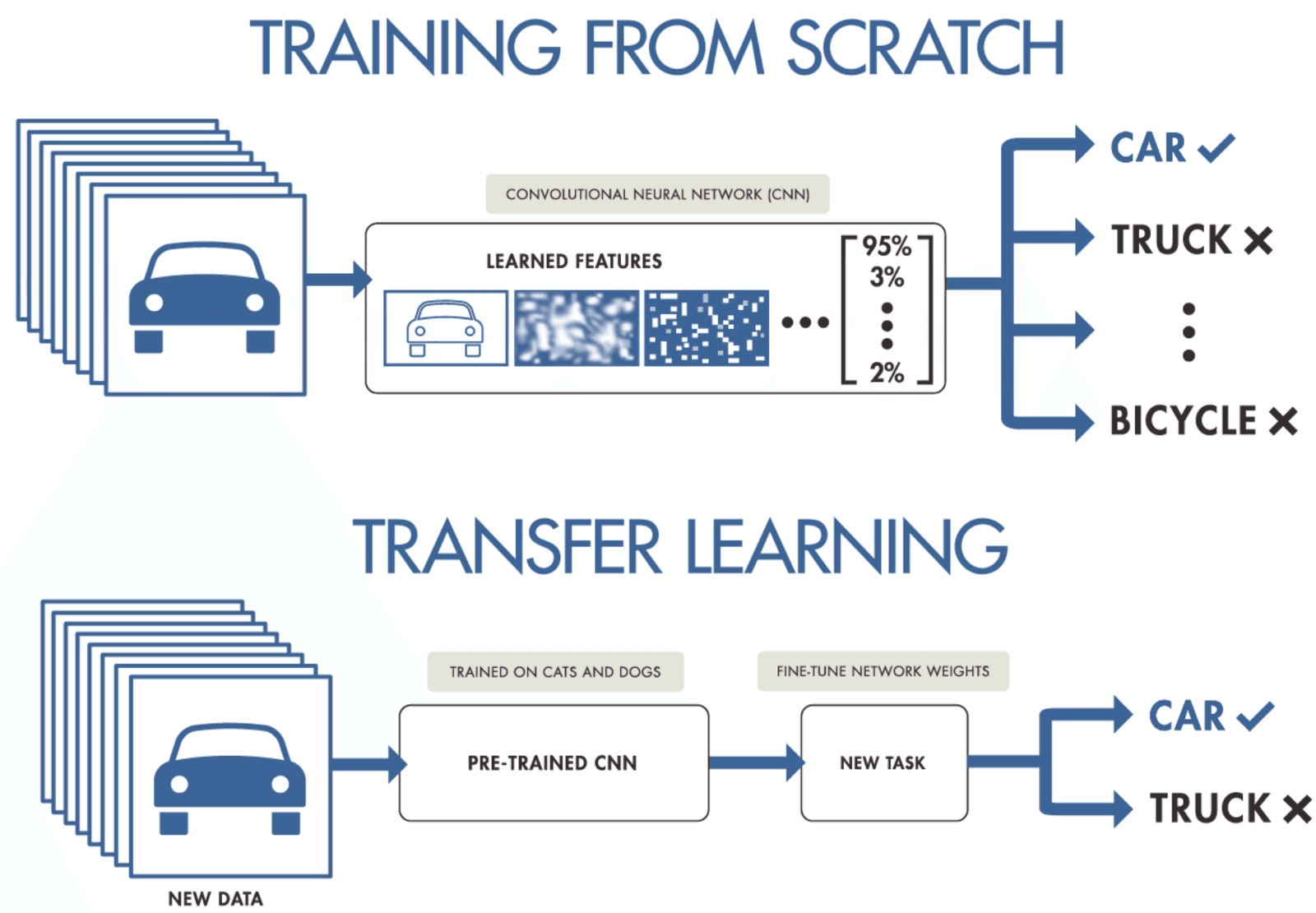

Quando você tiver um conjunto de dados pequeno, sugira uma maneira de treinar uma rede neural convolucional.

Se você não tiver dados suficientes para treinar uma rede neural convolucional, pode usar o aprendizado por transferência para treinar seu modelo e obter resultados de última geração. Você precisa de um modelo pré-treinado que tenha sido treinado em um conjunto de dados geral, mas maior. Depois disso, você vai ajustar tudo com dados mais recentes, treinando as últimas camadas dos modelos.

A aprendizagem por transferência permite que os cientistas de dados treinem modelos com menos dados, usando menos recursos, computação e armazenamento. Você pode encontrar facilmente modelos pré-treinados de código aberto para vários casos de uso, e a maioria deles tem uma licença comercial, o que significa que você pode usá-los para criar seu aplicativo.

Aprendizado por transferência por Purnasai Gudikandula

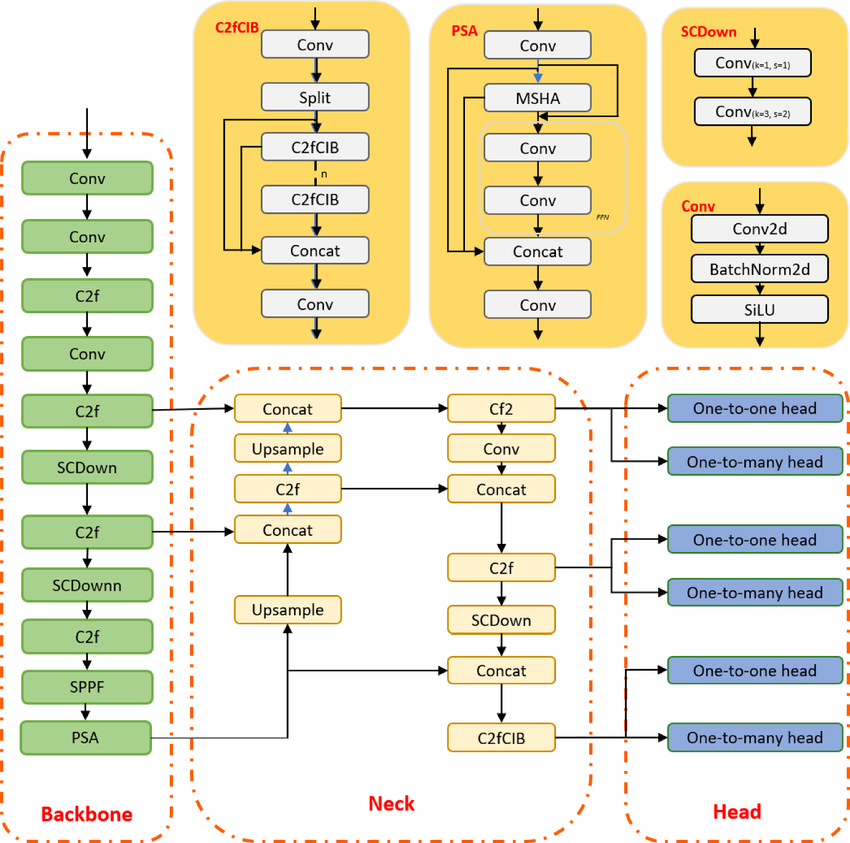

O que é o algoritmo de detecção de objetos de última geração YOLO e como sua arquitetura evoluiu recentemente?

O YOLO é um algoritmo de detecção de objetos baseado em redes neurais convolucionais e pode fornecer resultados em tempo real. O algoritmo YOLO precisa de uma única passagem pela CNN para reconhecer o objeto. Ele prevê várias probabilidades de classe e caixas de limite.

O modelo foi treinado para detectar vários objetos, e as empresas estão usando o aprendizado por transferência para ajustá-lo em novos dados para aplicações modernas, como direção autônoma, preservação da vida selvagem e segurança.

Arquitetura do modelo YOLOv10 | researchgate

Perguntas para entrevistas de engenharia em PNL

O Processamento de Linguagem Natural (NLP) é uma das bases das aplicações modernas de IA. Espere perguntas que ligam a teoria linguística com a prática, testando sua habilidade de processar, analisar e extrair significado de dados de texto não estruturados usando tanto técnicas clássicas quanto abordagens modernas de aprendizado profundo.

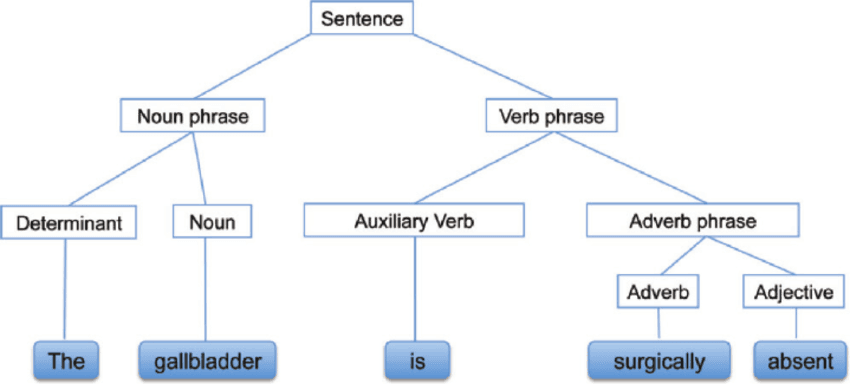

O que é análise sintática?

A análise sintática, também conhecida como análise de sintaxe ou parsing, é uma análise de texto que nos mostra o significado lógico por trás de uma frase ou parte de uma frase. Ele foca na relação entre as palavras e a estrutura gramatical das frases. Também dá pra dizer que é o processo de analisar a linguagem natural usando regras gramaticais.

Análise sintática | researchgate

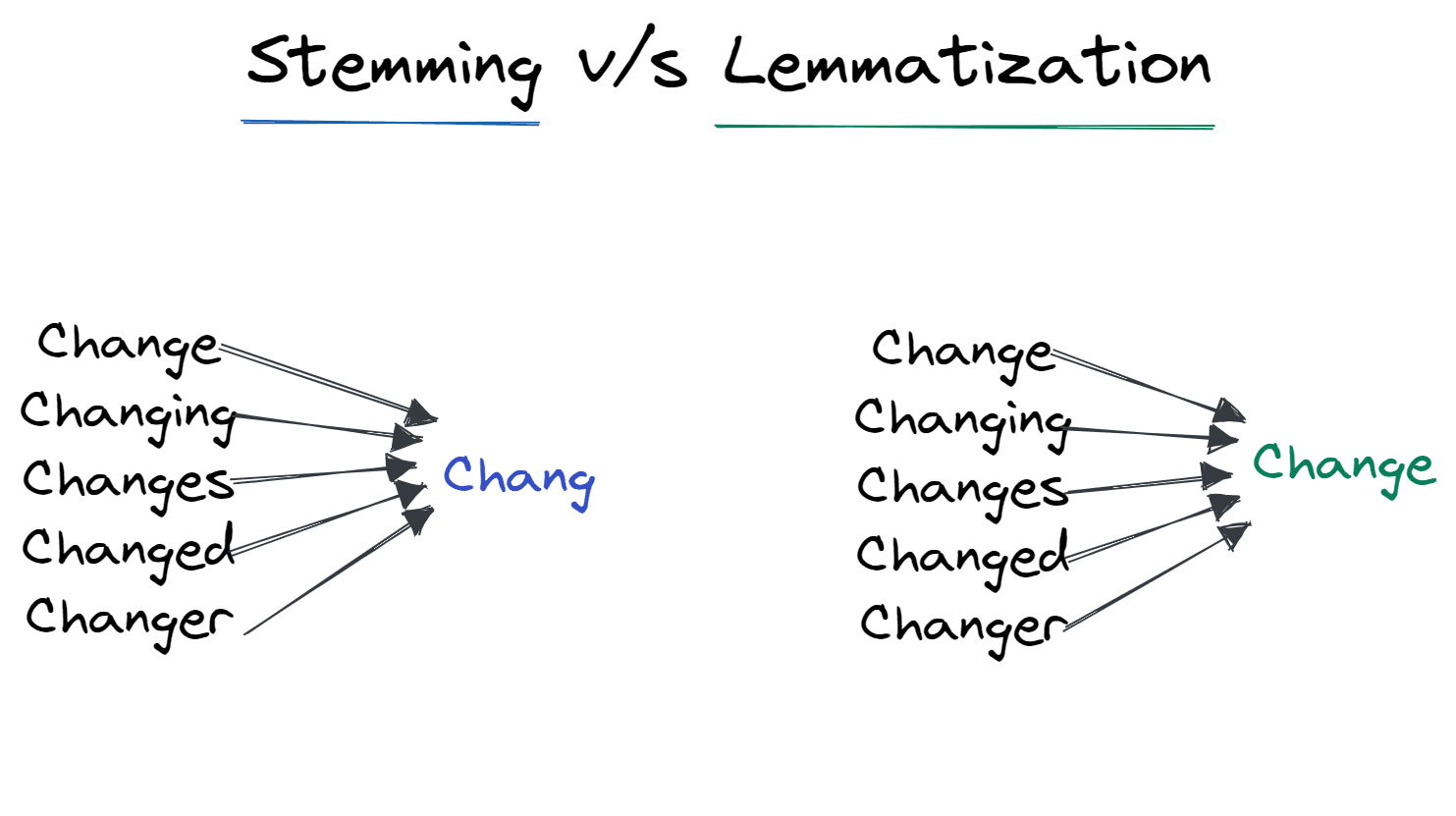

O que são stemming e lematização?

A derivação morfológica e a lematização são técnicas de normalização usadas para minimizar a variação estrutural das palavras em uma frase.

A derivação tira os afixos que foram adicionados à palavra e deixa ela na forma básica. Por exemplo, mudar para Chang.

É muito usado pelos mecanismos de busca pra otimizar o armazenamento. Em vez de guardar todas as formas das palavras, ele só guarda os radicais.

A lematização transforma a palavra na sua forma lematizada. O resultado é a raiz da palavra, em vez do radical. Depois da lematização, a gente consegue a palavra válida que tem algum significado. Por exemplo, Mudar para mudar.

Derivação vs. Lematização | Autor

Quais são as técnicas modernas para otimizar a velocidade de inferência do LLM na produção?

Otimizar grandes transformadores exige resolver os gargalos de largura de banda de memória e computação:

- Quantização: Reduzindo o peso dos modelos de FP16 (16 bits) para INT8 ou INT4 com perda mínima de precisão. Isso faz com que modelos maiores caibam em uma memória GPU menor.

- PagedAttention (vLLM): Uma técnica de gerenciamento de memória que trata o cache KV (Key-Value) como páginas de memória virtual, permitindo um rendimento 2 a 4 vezes maior ao eliminar a fragmentação da memória.

- Decodificação especulativa: Usando um modelo “rascunho” pequeno pra prever rapidamente os próximos tokens, que depois são verificados em paralelo pelo modelo grande. Isso aproveita o fato de que a leitura/gravação da memória costuma ser mais lenta do que o processamento para tokens individuais.

Aprenda o básico de PNL completando o programa de Processamento de Linguagem Natural em Python .

Perguntas da entrevista de engenharia LLM

Como os LLMs dominam o cenário atual da IA, os entrevistadores priorizam os candidatos que entendem como usá-los de forma eficaz. Essa seção fala sobre alguns dos maiores desafios práticos de engenharia de 2026.

O que é uma janela de contexto LLM e como você lida com tarefas que exigem mais contexto do que o modelo pode suportar de uma só vez?

A janela de contexto de um LLM é a quantidade máxima de texto (medida em tokens) que o modelo pode considerar de uma vez só ao gerar uma resposta, e isso limita diretamente a quantidade de “memória de trabalho” que o modelo tem efetivamente.

Mesmo com as janelas de contexto grandes ficando mais comuns, o desempenho e o custo não aumentam de forma linear: prompts longos aumentam a latência e ainda podem causar problemas de confiabilidade quando as informações relevantes estão bem no meio do contexto.

Nas entrevistas, eu respondia explicando estratégias práticas para tarefas de documentos longos:

- Use chunking (divida os documentos em seções que façam sentido) e pegue só as partes mais relevantes para uma determinada pergunta.

- Prefira a geração aumentada por recuperação (RAG) quando precisar de fundamentação factual e recuperação direcionada, em vez de enviar um documento inteiro todas as vezes, o que pode reduzir custos e evitar o comportamento de “perda no meio”.

- Use resumos ou notas hierárquicas (resumo das seções → resumo dos resumos) quando precisar de uma visão geral e, em seguida, recupere os detalhes quando precisar.

Como você diminui as alucinações em grandes modelos de linguagem?

As alucinações acontecem quando um LLM gera informações que parecem certas, mas que na verdade estão erradas. Em 2026, a mitigação precisa de uma abordagem em várias camadas:

- Geração aumentada por recuperação (RAG): Fundamentar o modelo, fazendo com que ele responda só com base nos documentos que foram recuperados de uma base de conhecimento confiável.

- Engenharia rápida: Técnicas como Chain-of-Thought (pedir ao modelo para explicar seu raciocínio passo a passo) e Few-Shot Prompting (fornecer exemplos verificados) reduzem significativamente os erros.

- Pontuação de confiança e autoconsistência: Gerar várias respostas para a mesma pergunta e escolher a mais consistente, ou pedir ao modelo para avaliar sua própria confiança antes de responder.

- Guarda-corpos: Implementar camadas de pós-processamento (como o NeMo Guardrails) para verificar os resultados em relação a regras definidas antes de mostrá-los ao usuário.

Quando você deve escolher a geração aumentada por recuperação (RAG) em vez do ajuste fino?

Essa é uma clássica questão de “compromisso”. A decisão depende da atualidade dos dados e da especificidade do domínio:

- Escolha RAG quando: Você precisa do modelo para acessar informações atualizadas (por exemplo, preços de ações, notícias recentes) ou dados privados que mudam com frequência. O RAG é mais barato e reduz as alucinações porque fornece ao modelo a resposta exata no contexto.

- Escolha o ajuste fino quando: Você precisa que o modelo aprenda umcomportamento específico, estilo ou formato (por exemplo, falar como um pirata ou escrever código em uma linguagem interna proprietária). O ajuste fino incorpora o conhecimento nos pesos, mas não resolve o problema do “corte de conhecimento”.

- Abordagem híbrida: Em muitos sistemas de produção, você ajusta um modelo para entender o jargão específico do domínio e, em seguida, usa o RAG para alimentá-lo com os fatos mais recentes.

A questão é discutida com mais detalhes em nosso blog sobre RAG vs. Ajuste fino.

Perguntas para entrevistas de engenharia sobre aprendizado por reforço

A Aprendizagem por Reforço (RL) lida com problemas em que um agente aprende interagindo com um ambiente, em vez de aprender a partir de conjuntos de dados estáticos. Esteja pronto pra falar sobre como o RL funciona e explicar conceitos básicos, tipo políticas.

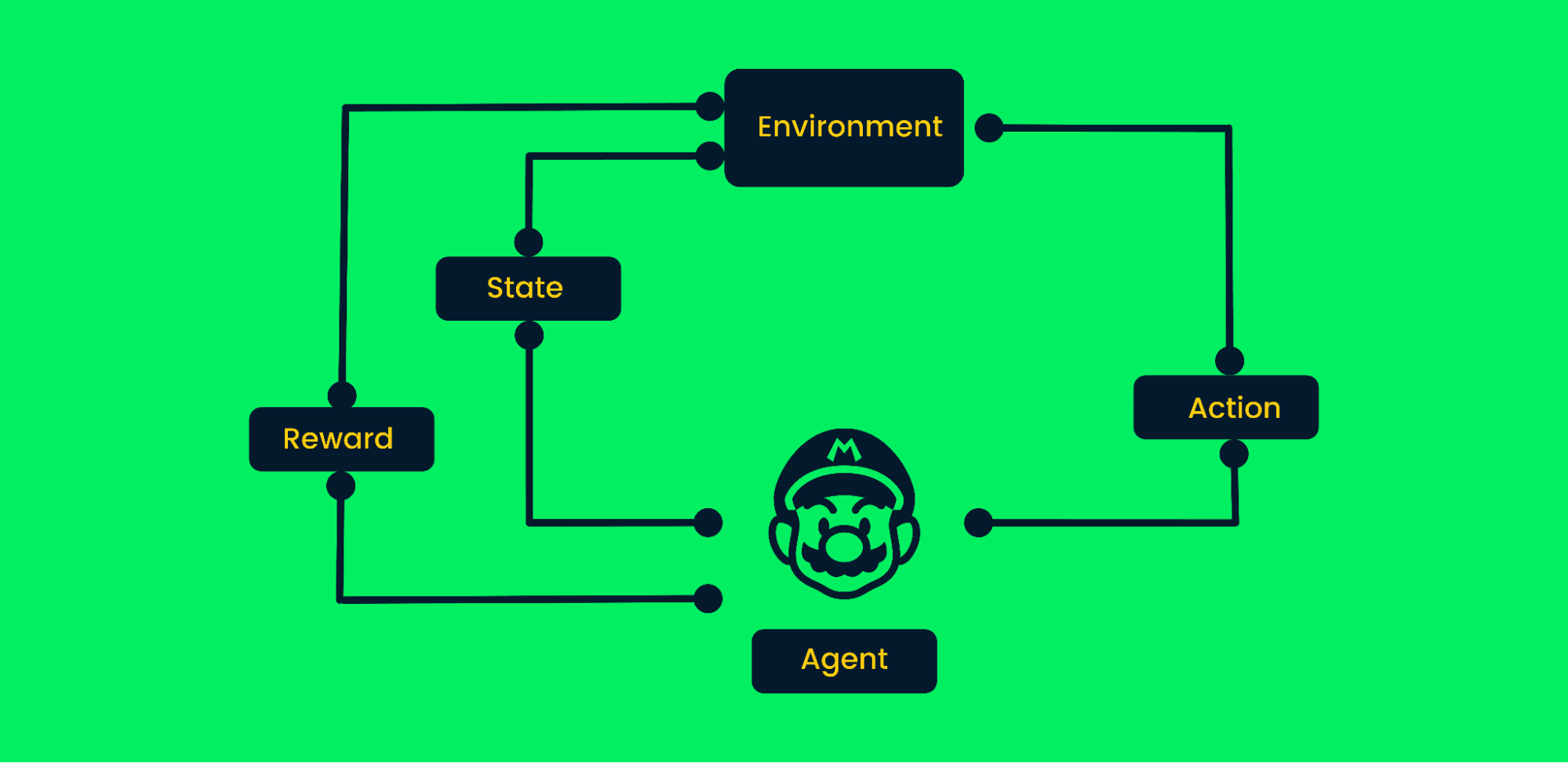

Quais são as etapas envolvidas em um algoritmo típico de Aprendizado por Reforço?

O aprendizado por reforço usa tentativa e erro para alcançar objetivos. É um algoritmo focado em objetivos e aprende com o ambiente, tomando as medidas certas para maximizar a recompensa acumulada.

No aprendizado por reforço típico:

- No começo, o agente recebe o estado zero do ambiente.

- Dependendo da situação, o agente vai tomar uma atitude.

- O estado mudou e o agente está em um novo lugar no ambiente.

- O agente recebe a recompensa se tiver feito a jogada certa.

- O processo vai continuar até que o agente aprenda o melhor caminho possível para chegar ao objetivo, maximizando as recompensas acumuladas.

Estrutura de Aprendizado por Reforço | Autor

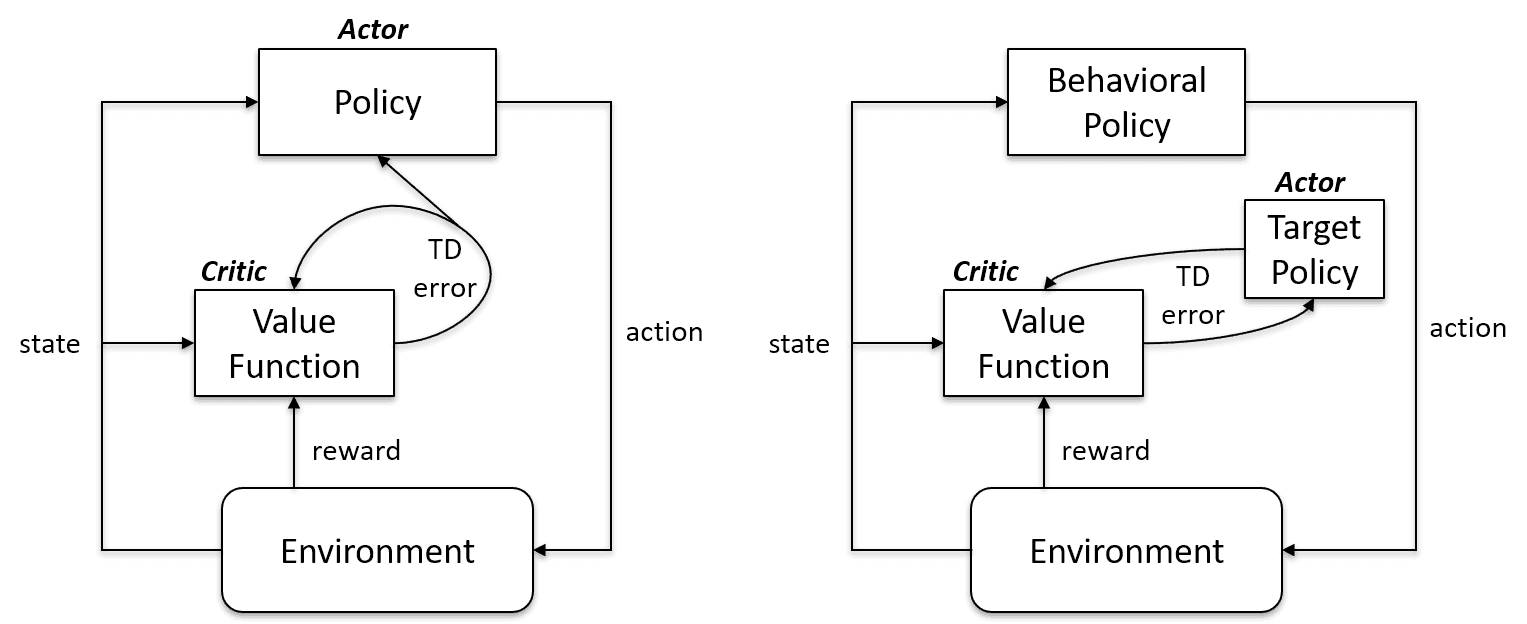

Qual é a diferença entre aprendizagem fora da política e aprendizagem dentro da política?

Os algoritmos de aprendizagem On-Policy avaliam e melhoram a mesma política para agir e atualizá-la. Ou seja, a política que usamos para atualizar e a política que usamos para agir são a mesma coisa.

Política de metas == Política de comportamento

Os algoritmos on-policy são Sarsa, Monte Carlo para On-Policy, Iteração de Valor e Iteração de Política.

Os algoritmos de aprendizagem fora da política são completamente diferentes, pois a política atualizada é diferente da política de comportamento. Por exemplo, no aprendizado Q, o agente aprende com uma política ideal com a ajuda de uma política gananciosa e age usando outras políticas.

Política de metas != Política de comportamento

Na política vs. Caso fora da política | Artificial Intelligence Stack Exchange

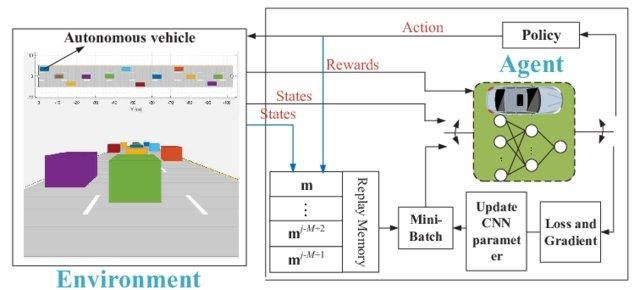

Por que precisamos do aprendizado “profundo” Q?

O aprendizado simples Q é ótimo. Resolve o problema em menor escala, mas em maior escala, não funciona.

Imagina se o ambiente tem 1000 estados e 1000 ações por estado. Vamos precisar de uma tabela Q com milhões de células. O jogo de xadrez e Go vai precisar de uma tabela ainda maior. É aí que o Deep Q-learning entra em cena.

Ele usa uma rede neural pra aproximar a função do valor Q. A receita das redes neurais define como entrada e saída o valor Q de todas as ações possíveis.

Rede Q profunda para direção autônoma | researchgate

Perguntas para engenheiros de machine learning da FAANG

Abaixo, listamos algumas perguntas que o entrevistador pode fazer em algumas das principais empresas de tecnologia:

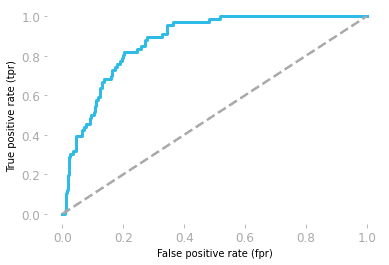

Qual é a interpretação da área ROC sob a curva?

As características operacionais do receptor (ROC) mostram o equilíbrio entre sensibilidade e especificidade.

- Sensibilidade: é a chance de o modelo prever um resultado positivo quando o valor real também é positivo.

- Especificidade: é a probabilidade de o modelo prever um resultado negativo quando o valor real também é negativo.

A curva é traçada usando a taxa de falsos positivos (FP/(TN + FP)) e a taxa de verdadeiros positivos (TP/(TP + FN)).

A área sob a curva (AUC) mostra o desempenho do modelo. Se a área sob a curva ROC for 0,5, então nosso modelo é completamente aleatório. O modelo com AUC próximo a 1 é o melhor modelo.

Curva ROC por Hadrien Jean

Como você avalia modelos de IA generativa onde não existe uma única “verdade fundamental”?

Diferente da classificação (onde uma resposta é certa ou errada), a GenAI geralmente precisa de uma avaliação humana ou de estruturas do tipo “LLM como juiz”:

- Métricas sem referência: Usar um modelo mais robusto (como o GPT-4) para avaliar a resposta de um modelo menor com base em critérios como “utilidade”, “segurança” e “coerência”.

- RAGAS (Avaliação da Geração Aumentada por Recuperação): Uma estrutura padrão que mede especificamente a “fidelidade” (a resposta veio do contexto?) e a “relevância da resposta” (ela respondeu à pergunta do usuário?).

- Avaliação humana (Classificações Elo): Para a validação final, comparar os resultados de dois modelos lado a lado (teste A/B) e calcular uma classificação Elo, parecida com o ranking da LMArena.

Quais são os métodos para reduzir a dimensionalidade?

Para reduzir a dimensionalidade, dá pra usar métodos de seleção ou extração de características.

A seleção de características é um processo de escolher as características ideais e descartar as que não são relevantes. Usamos métodos de filtro, wrapper e incorporados para analisar a importância dos recursos e remover os menos importantes para melhorar o desempenho do modelo.

A extração de características transforma o espaço com várias dimensões em menos dimensões. Nenhuma informação é perdida durante o processo, e ele usa menos recursos para processar os dados. As técnicas de extração mais comuns são a análise discriminante linear (LDA), a PCA do kernel e a análise discriminante quadrática.

Como você encontra os limites para um classificador?

No caso de um classificador de spam, um modelo de regressão logística vai mostrar a probabilidade. Usamos a probabilidade de 0,8999 ou convertemos em classe (Spam/Não Spam) usando um limite.

Normalmente, o limite de um classificador é 0,5, mas, em alguns casos, precisamos ajustá-lo para melhorar a precisão. O limite de 0,5 quer dizer que, se a probabilidade for igual ou maior que 0,5, é spam, e se for menor, não é spam.

Para encontrar o limite, podemos usar curvas de precisão-recall e curvas ROC, pesquisa em grade e alterar manualmente o valor para obter um CV melhor.

Torne-se um engenheiro profissional de machine learning ao concluir o programa de Cientista de Machine Learning com Python.

Quais são as suposições da regressão linear?

A regressão linear é usada pra entender a relação entre as características (X) e o alvo (y). Antes de treinarmos o modelo, precisamos atender a algumas premissas:

- Os resíduos são independentes

- Tem uma relação linear entre a variável independente X e a variável dependente y.

- Variação residual constante em todos os níveis de X

- Os resíduos têm distribuição normal.

Observação: os resíduos na regressão linear são a diferença entre os valores reais e os valores previstos.

Escreva uma função find_bigrams para pegar uma string e devolver uma lista de todos os bigramas.

Durante as entrevistas de programação, vão te perguntar sobre problemas de machine learning, mas, às vezes, vão avaliar suas habilidades em Python com perguntas gerais sobre programação. Torne-se um programador Python experiente seguindo o programa de Programador Python.

Criar uma função bigram é bem fácil. Você precisa usar dois loops com a função zip.

- Na função bigram, pegamos uma lista de frases como entrada.

- Criando um loop para acessar uma única frase

- Reduzindo e dividindo a frase em uma lista de palavras

- Usando

zippara criar uma combinação da palavra anterior e da palavra seguinte - Anexando a saída ao resultado

- Imprimindo os resultados.

É bem fácil se você dividir o problema e usar funções zip.

def bigram(text_list:list):

result = []

for ls in text_list:

words = ls.lower().split()

for bi in zip(words, words[1:]):

result.append(bi)

return result

text = ["Data drives everything", "Get the skills you need for the future of work"]

print(bigram(text))Resultados:

[('Data', 'drives'), ('drives', 'everything'), ('Get', 'the'), ('the', 'skills'), ('skills', 'you'), ('you', 'need'), ('need', 'for'), ('for', 'the'), ('the', 'future'), ('future', 'of'), ('of', 'work')]O que é a função de ativação no machine learning?

A função de ativação é uma transformação não linear em redes neurais. Passamos a entrada pela função de ativação antes de mandá-la para a próxima camada.

O valor líquido de entrada pode ser qualquer coisa entre -inf e +inf, e o neurônio não sabe como limitar os valores, sendo assim incapaz de decidir o padrão de disparo. A função de ativação decide se um neurônio deve ser ativado ou não para limitar os valores de entrada da rede.

Tipos mais comuns de funções de ativação:

- Função escalonada

- Função sigmoide

- ReLU

- Leaky ReLu

Como você criaria uma recomendação de restaurante no Facebook?

A resposta depende totalmente de você. Mas, antes de responder, você precisa pensar em qual meta de negócios quer atingir para definir uma métrica de desempenho e como vai conseguir os dados.

Em um projeto típico de sistema de machine learning, nós:

- Colete, limpe e analise os dados.

- Fazer engenharia de recursos

- Escolha uma metodologia, algoritmo ou modelo de machine learning

- Treine e avalie o desempenho em conjuntos de dados de teste e validação.

- Simplifique os processos e coloque o modelo em produção.

Você precisa se certificar de que está focando no design, e não na teoria ou na arquitetura do modelo. Não esqueça de falar sobre a inferência do modelo e como melhorá-la vai aumentar as receitas gerais.

Além disso, explique por que você escolheu uma determinada metodologia em vez de outra.

Aprenda mais sobre como criar sistemas de recomendação fazendo um curso no DataCamp.

Dadas duas cadeias de caracteres A e B, escreva uma função can_shift para indicar se A pode ou não ser deslocada um determinado número de posições para obter B.

Resolver desafios de programação e trabalhar suas habilidades em Python vai aumentar suas chances de passar na etapa da entrevista de programação.

Antes de começar a resolver um problema, você precisa entender a questão. Você só precisa criar uma função booleana que vai retornar Verdadeiro se, ao mudar as letras na String B, você conseguir a String A.

A = 'abid'

B = 'bida'

can_shift(A, B) == True- Retorne falso se o comprimento da string não for igual.

- Faça um loop pelo comprimento da String A

- Crie mut_a para criar várias combinações de caracteres usando a String A

- Durante o loop, se mut_a for igual a String B, retorna True, caso contrário, retorna false.

def can_shift(a, b):

if len(a) != len(b):

return False

for i in range(len(a)):

mut_a = a[i:] + a[:i]

if mut_a == b:

return True

return False

A = 'abid'

B = 'bida'

print(can_shift(A, B))

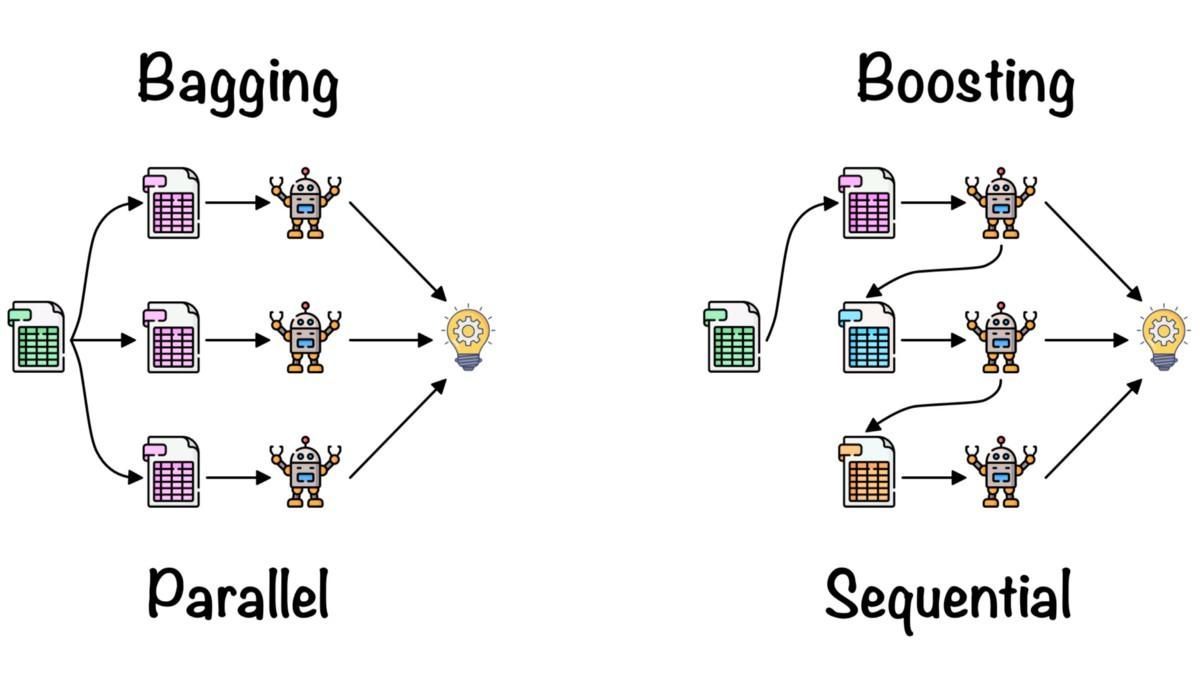

>>> TrueO que é aprendizagem em conjunto?

O aprendizado conjunto é usado pra juntar as ideias de vários modelos de machine learning e melhorar a precisão e as métricas de desempenho.

Métodos simples de conjunto:

- Média: calculamos a média das previsões de vários modelos de alto desempenho.

- Média ponderada: a gente dá pesos diferentes para os modelos de machine learning com base no desempenho e depois junta tudo.

Métodos avançados de conjunto:

- O ensacamento é usado para minimizar erros de variação. Ele cria aleatoriamente o subconjunto de dados de treinamento e o treina nos modelos. A combinação de modelos reduz a variação e torna-os mais confiáveis em comparação com um único modelo.

- O boosting é usado pra reduzir erros de viés e criar modelos preditivos melhores. É uma técnica iterativa de conjunto que ajusta os pesos com base na última classificação. Os algoritmos de reforço dão mais peso às observações que o modelo anterior previu de forma imprecisa.

Bagging e Boosting por Fernando López

Saiba mais sobre média, agrupamento, empilhamento e reforço fazendo o curso Métodos Ensemble em Python.

Conclusão

Ao concluirmos nossa exploração das perguntas essenciais para entrevistas sobre machine learning, fica claro que, para se dar bem nessas entrevistas, é preciso ter uma mistura de conhecimento teórico, habilidades práticas e estar por dentro das últimas tendências e tecnologias da área. Desde entender conceitos básicos como aprendizado semi-supervisionado e seleção de algoritmos, até mergulhar nas complexidades de algoritmos específicos como KNN, e lidar com desafios específicos em NLP, visão computacional ou aprendizado por reforço, o escopo é enorme.

Seja você um novato querendo entrar na área ou um profissional experiente querendo avançar ainda mais, o aprendizado e a prática contínuos são essenciais. DataCamp oferece um programa completo de Cientista de Machine Learning com Python que te ajuda a melhorar suas habilidades de um jeito estruturado e detalhado.

Obtenha uma das melhores certificações de IA

Perguntas frequentes

Como é uma entrevista sobre machine learning?

Normalmente, as entrevistas técnicas sobre machine learning são divididas em várias partes:

- Entrevista de programação

- Algoritmos e processamento de dados

- Entrevista específica para a função

- Entrevista sobre design de sistemas de ML

- Operações de machine learning e melhores práticas

As entrevistas não técnicas ou presenciais também fazem parte do processo de entrevista de machine learning, mas são mais gerais e específicas da empresa.

É fácil passar nas entrevistas de machine learning na Amazon?

Não, você precisa se preparar para as várias etapas da entrevista. Você precisa se preparar para um teste de avaliação online, uma entrevista por telefone com o recrutador, uma entrevista técnica por telefone e a entrevista presencial. Cada etapa testa suas habilidades e conhecimentos.

Os engenheiros de machine learning têm entrevistas de codificação?

Sim. Ele vai testar suas habilidades de resolução de problemas em Python e análise de dados em SQL. Além disso, você vai ser questionado sobre ferramentas de machine learning. É melhor praticar programação fazendo desafios de programação, como os testes de avaliação do DataCamp.

Quais são as principais tarefas de um engenheiro de IA/ML?

Em geral, os engenheiros de IA/ML pesquisam, projetam e desenvolvem sistemas de machine learning, mas isso varia de acordo com o trabalho e a empresa.

Além disso:

- Eles limpam os dados, fazem a validação e aumentam os dados do treinamento do modelo.

- Ajuste a arquitetura do modelo e os hiperparâmetros para obter melhores resultados.

- Entendendo os negócios e a disponibilidade de dados.

- Métricas de desempenho, algoritmos e estratégia de implantação.

- Às vezes, eles também estão envolvidos em computação em nuvem e operações de desenvolvimento.

Como me preparar para uma entrevista sobre machine learning?

Conheça a empresa e as responsabilidades do cargo, resolva desafios de codificação, analise projetos anteriores, projete e aprenda sobre o ciclo de vida completo do machine learning, pratique perguntas simuladas de entrevista e leia sobre os últimos desenvolvimentos na área de IA/ML. Isso é importante, seja você um engenheiro de machine learning iniciante ou alguém com anos de experiência profissional nessa área.