Kurs

Wenn du mit großen Sprachmodellen arbeitest, weißt du, dass Prompt-Engineering eine ziemliche Herausforderung sein kann. Du kannst Stunden damit verbringen, die Aufforderungen anzupassen, nur um dann gemischte Ergebnisse zu erhalten. Es ist frustrierend, nimmt viel Zeit in Anspruch und erfordert oft viel Ausprobieren, um optimale Ergebnisse zu erzielen.

Eine Lösung für dieses Problem ist DSPy- ein neues Framework, das die Art und Weise, wie wir Prompt Engineering kennen, verändert. Anstatt uns auf die Erstellung perfekter Prompts zu konzentrieren, können wir mit DSPy die Modelle direkt programmieren.

In diesem Tutorial erkläre ich DSPy und warum es sich von älteren Methoden unterscheidet. Du lernst die wichtigsten Funktionen und Vorteile kennen und erfährst, wie es funktioniert. Ich führe dich durch deine ersten Schritte mit DSPy und verweise dich auf hilfreiche Ressourcen und Communities.

Lass uns loslegen!

Was ist DSPy?

DSPy ist ein von der Stanford University entwickeltes Open-Source-Tool, das "deklarative Sprachmodellaufrufe zu selbstverbessernden Pipelines kompiliert". Anstatt Zeit damit zu verbringen, perfekte Prompts zu erstellen, kannst du mit DSPy die KI-Modelle direkt programmieren.

Das macht KI-Apps zuverlässiger und einfacher zu skalieren. DSPy trennt die Logik deiner App von dem Text, den sie verwendet, damit du dich darauf konzentrieren kannst, was deine KI tun soll. In der Zwischenzeit optimiert DSPy die Prompts hinter den Kulissen.

Sehen wir uns einige seiner wichtigsten Funktionen an.

Deklarative Programmierung

Mit DSPy definierst du die Aufgabe, die du erfüllen willst, und die Kennzahlen, mit denen du den Erfolg messen kannst. Das Framework optimiert dann das Verhalten des Modells für dich. Sie verwendet eine leicht verständliche Python-Syntax, damit du dich darauf konzentrieren kannst, was deine Anwendung tun soll, und nicht darauf, wie du das Modell aufforderst.

Aufforderungen zur Selbstverbesserung

Eine der herausragenden Eigenschaften von DSPy ist die Fähigkeit, die Prompts im Laufe der Zeit automatisch zu verbessern. DSPy verfeinert die Eingabeaufforderungen kontinuierlich und erspart dir so die lästigen manuellen Anpassungen. Dies wird durch Feedback und Bewertung erreicht, damit das Modell mit jeder Iteration besser wird.

Modulare Architektur

DSPy bietet außerdem eine modulare Architektur, die es dir ermöglicht, vorgefertigte Module für verschiedene Aufgaben der natürlichen Sprachverarbeitung (NLP) zu kombinieren. Dank dieser Modularität lässt sich das System in hohem Maße an deine spezifischen Bedürfnisse anpassen, was Flexibilität und Wiederverwendbarkeit fördert. Das Framework enthält nützliche Module wie ChainOfThought und ReAct, die sich leicht in deine Anwendungen integrieren lassen.

Wie DSPy funktioniert

In diesem Abschnitt gehe ich auf die wichtigsten Teile von DSPy ein und zeige, wie es die Arbeit mit LLMs erleichtert.

Aufgabenstellung

Mit DSPy geben die Nutzer zunächst das Ziel der Aufgabe und die Kennzahlen an, für die optimiert werden soll. Das heißt, du legst fest, was du mit dem Modell erreichen willst und wie du seinen Erfolg messen willst.

DSPy verwendet Beispieleingaben, mit oder ohne Kennzeichnung, um den Lernprozess zu steuern. Diese Beispiele helfen dem Framework, die Aufgabe besser zu verstehen und seine Leistung zu verbessern. Außerdem führt DSPy das Konzept der Module ein, die wiederverwendbare Bausteine für verschiedene NLP-Aufgaben sind. Diese Module können kombiniert und an unterschiedliche Bedürfnisse angepasst werden.

Rohrleitungsbau

Sobald die Aufgabe definiert ist, wählen die Nutzer/innen die entsprechenden Module für ihre spezielle Aufgabe aus und konfigurieren sie. Dazu gehört, dass du die richtigen Module auswählst, die zu den Anforderungen der Aufgabe passen, und sie entsprechend einrichtest. Mit DSPy kannst du diese Module miteinander verketten, um komplexe Pipelines zu erstellen, die anspruchsvolle Arbeitsabläufe ermöglichen. Jedes Modul hat Signaturen, die die Ein- und Ausgabespezifikationen festlegen und sicherstellen, dass die Module nahtlos zusammenarbeiten können.

Optimierung und Kompilierung

DSPy optimiert die Prompts durch kontextbezogenes Lernen und automatische wenige Schüsse Beispielen. Das bedeutet, dass der Rahmen die Prompts kontinuierlich verfeinert, um die Leistung des Modells zu verbessern. DSPy kann auch kleinere Modelle für Aufgaben, die eine spezifischere Abstimmung erfordern, feinabstimmen.

Schließlich kompiliert DSPy die gesamte Pipeline in ausführbaren Python-Code, sodass sie leicht in deine Anwendungen integriert werden kann. Dieser Kompilierungsprozess stellt sicher, dass die Pipeline effizient und effektiv läuft.

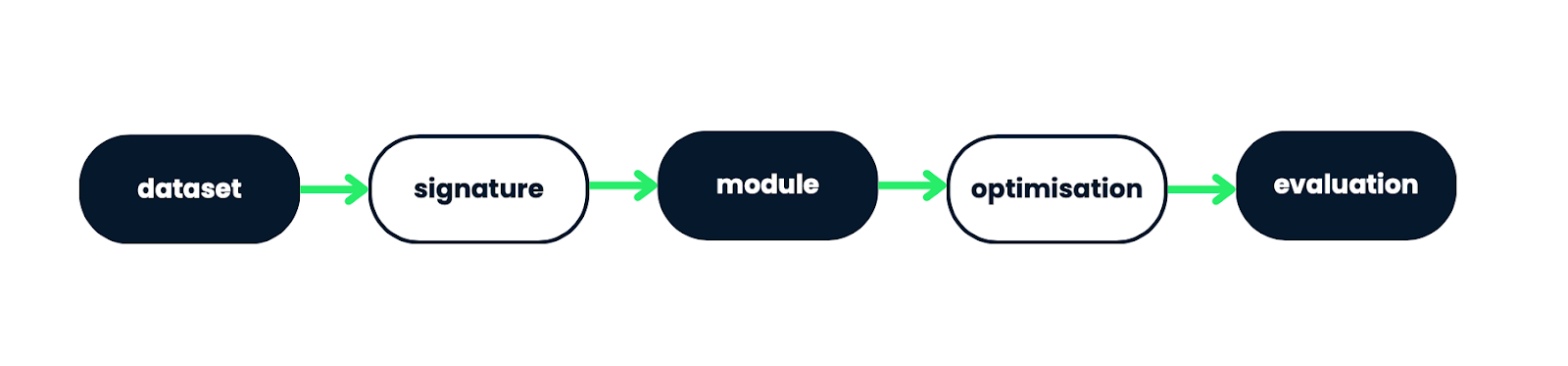

Abbildung 1: DSPy Workflow: Von den Daten zum optimierten KI-Modell

Dieses Diagramm veranschaulicht den zentralen Arbeitsablauf von DSPy und zeigt, wie es Rohdaten in ein optimiertes KI-Modell umwandelt. Der Prozess beginnt mit einem Datensatz, der die Signatur (die Eingangs-/Ausgangsstruktur) bestimmt. Diese Signatur wird verwendet, um ein Modul zu erstellen, das dann mit den fortschrittlichen Techniken von DSPy optimiert wird. Zum Schluss wird das optimierte Modul einer Bewertung unterzogen, um sicherzustellen, dass es die gewünschten Leistungskriterien erfüllt.

Dank dieses schlanken Ansatzes kannst du dich auf das High-Level-Design konzentrieren, während DSPy die Komplexität des Prompt-Engineering und der Modelloptimierung übernimmt.

Vorteile von DSPy

DSPy bietet mehrere wichtige Vorteile, die es zu einem leistungsstarken Werkzeug für die Arbeit mit LLMs machen:

Verbesserte Zuverlässigkeit

Der deklarative Ansatz von DSPy führt zu einem zuverlässigeren und vorhersehbaren LLM-Verhalten. Anstatt die Prompts manuell zu erstellen, legst du fest, was das Modell tun soll. DSPy findet dann heraus, wie man es konsequent umsetzen kann. Das bedeutet weniger unerwartete Ergebnisse und eine stabilere Leistung bei verschiedenen Aufgaben.

Nehmen wir an, du baust einen Chatbot für den Kundensupport. Anstatt spezifische Prompts zu schreiben, kannst du mit DSPy deine Absicht wie folgt definieren:

- Verstehe die Frage deines Kunden.

- Rufe relevante Informationen aus der Wissensdatenbank ab.

- Gib eine hilfreiche, einfühlsame Antwort.

- Prüfe, ob die Antwort die ursprüngliche Frage beantwortet.

- Wenn nicht, verfeinere die Antwort.

DSPy würde sich dann darum kümmern:

- Optimale Aufforderungen für jeden Schritt erstellen.

- Steuerung des Informationsflusses zwischen den einzelnen Schritten.

- Optimierung des Gesamtprozesses für Genauigkeit und Konsistenz.

DSPy könnte zum Beispiel lernen, dass Antworten, die mit "Ich verstehe Ihr Anliegen bezüglich..." beginnen, zu einer besseren Kundenzufriedenheit in Schritt 3 führen. Oder für Schritt 4 könnte sie eine effektive Methode entwickeln, um die Antwort mit der ursprünglichen Frage zu vergleichen.

Das Wichtigste ist, dass du dich darauf konzentrierst, die übergeordnete Struktur und die Ziele zu definieren. DSPy kümmert sich um prompte Konstruktions- und Optimierungsdetails, was zu einem zuverlässigeren und vorhersehbaren Verhalten des LLM bei verschiedenen Kundenanfragen führt.

Auf diese Weise kannst du das Verhalten des Chatbots leicht anpassen (z. B. formeller werden oder einen neuen Schritt hinzufügen, um nach sensiblen Informationen zu suchen), ohne dass du alle Prompts manuell umschreiben musst. DSPy würde sich automatisch an die neuen Anforderungen anpassen und optimieren.

Vereinfachte Entwicklung

Die modulare Architektur und die automatische Prompt-Optimierung in DSPy machen die LLM-Entwicklung viel einfacher. Du kannst komplexe Anwendungen erstellen, indem du vorgefertigte Module kombinierst, so wie man Bausteine zusammensetzt. DSPy kümmert sich um den kniffligen Teil der Optimierung von Prompts im Hintergrund, damit du dich auf die Logik deiner Anwendung konzentrieren kannst, anstatt die Prompts endlos zu optimieren.

Stell dir vor, du erstellst einen Assistenten zur Erstellung von Inhalten für einen Blog. Ohne zu programmieren, könntest du dir deine Anwendung so vorstellen:

1. Topic Generator Module

- Input: Blog niche and target audience

- Output: List of potential blog topics

2. Outline Creator Module

- Input: Selected blog topic

- Output: Detailed outline for the blog post

3. Content Writer Module

- Input: Blog outline

- Output: Full blog post draft

4. Editor Module

- Input: Blog post draft

- Output: Edited and polished blog post

5. SEO Optimizer Module

- Input: Edited blog post

- Output: SEO-optimized version of the postIn diesem Szenario würde DSPy:

- Biete diese vorgefertigten Module an, die du einfach auswählen und anordnen kannst.

- Optimiere die Prompts für jedes Modul automatisch im Hintergrund.

- Verwalte den Informationsfluss zwischen den Modulen.

Du musst keinen Code schreiben oder Prompts basteln. Stattdessen wählst du einfach die Module aus, die du brauchst, ordnest sie in der gewünschten Reihenfolge an und gibst deine Eingaben ein (z. B. Blog-Nische und Zielgruppe).

Anpassungsfähigkeit

Wenn es darum geht, sich an neue Aufgaben und Bereiche anzupassen, ist DSPy großartig. Du passt einfach die Aufgabendefinition und die Metriken an, und DSPy konfiguriert sich neu, um die neuen Anforderungen zu erfüllen. Diese Flexibilität bedeutet, dass du dein LLM schnell auf verschiedene Anwendungsfälle anwenden kannst, ohne jedes Mal bei Null anfangen zu müssen.

Angenommen, du hast mit DSPy einen Chatbot für den Kundensupport eines Technologieunternehmens entwickelt. Zunächst besteht die Aufgabe des Chatbots darin, technische Supportfragen zu beantworten, wobei der Schwerpunkt auf der Genauigkeit der Antworten und der Relevanz der Lösungen liegt, und zwar im Bereich Computerhardware und -software.

Nun willst du diesen Chatbot für ein Unternehmen im Gesundheitswesen anpassen. Dazu passt du die Aufgabendefinition auf "Beantwortung von gesundheitsbezogenen Kundenanfragen" an und änderst die Metriken, um "medizinische Genauigkeit" und einen "Empathie-Score" für den Umgang mit sensiblen Gesundheitsfragen einzubeziehen. Du legst auch den neuen Bereich fest, der nun die allgemeine Gesundheitsversorgung, medizinische Verfahren und Versicherungen umfasst.

Mit diesen Änderungen konfiguriert sich DSPy automatisch neu. Es passt seine internen Prozesse an, um sich auf medizinische Wissensgrundlagen zu konzentrieren, passt seine Spracherzeugung an, um einfühlsamere und medizinisch korrekte Begriffe zu verwenden, und ändert seine Bewertungskriterien, um medizinische Genauigkeit und Einfühlungsvermögen in den Vordergrund zu stellen.

Dann stellst du eine kleine Reihe von Q&A-Beispielen aus dem Gesundheitswesen vor. DSPy nutzt diese Beispiele, um seinen Ansatz zu verfeinern, ohne dass du irgendwelche Prompts neu schreiben musst.

Als Ergebnis bearbeitet dein Chatbot jetzt effektiv Gesundheitsfragen, liefert medizinisch korrekte Informationen und kommuniziert mit dem richtigen Einfühlungsvermögen für gesundheitsbezogene Anliegen.

Auf diese Weise musstest du nichts neu programmieren. Die Neudefinition der Aufgabe, die Anpassung der Metriken und die Bereitstellung neuer Beispiele genügten DSPy, um die zugrundeliegenden LLM-Interaktionen neu zu konfigurieren und die neuen Anforderungen zu erfüllen.

Skalierbarkeit

Die Optimierungstechniken von DSPy zeigen ihren Wert, wenn es darum geht, große Aufgaben zu bewältigen. Das Framework kann die LLM-Leistung bei großen Datensätzen oder komplexen Problemen verbessern, indem es die Prompts automatisch verfeinert und das Verhalten des Modells anpasst. Diese Skalierbarkeit sorgt dafür, dass deine Anwendungen bei Bedarf wachsen und anspruchsvollere Aufgaben bewältigen können.

Angenommen, du entwickelst ein Empfehlungssystem für eine E-Commerce-Plattform. Zu Beginn muss dein System einen großen Datensatz mit Nutzerinteraktionen und Produktdetails verarbeiten, um personalisierte Empfehlungen zu erstellen.

Ohne DSPy müsstest du die Prompts für jeden Schritt manuell erstellen, z. B. für die Abfrage der Benutzerhistorie, die Analyse der Vorlieben und die Produktvorschläge. Dieser Prozess würde eine Menge Versuch und Irrtum erfordern, um die Eingabeaufforderungen genau richtig zu machen, vor allem wenn der Datensatz wächst und die Komplexität zunimmt.

Mit DSPy ist der Prozess viel einfacher und effizienter.

Du beginnst damit, die Aufgabe zu definieren: personalisierte Produktempfehlungen zu erstellen. Du gibst die Kennzahlen an, nach denen optimiert werden soll, z. B. die Empfehlungsgenauigkeit und die Nutzerzufriedenheit.

Als Nächstes übergibst du DSPy einen Datensatz mit Nutzerinteraktionen und Produktdetails. Dieser Datensatz hilft DSPy, die Aufgabe zu verstehen und seine Leistung zu verbessern.

DSPy nutzt dann seine modulare Architektur, um die Aufgabe in kleinere, überschaubare Module zu zerlegen. Ein Modul könnte zum Beispiel die Benutzerhistorie abrufen, ein anderes könnte die Vorlieben analysieren und ein drittes könnte Produktvorschläge erstellen.

DSPy optimiert automatisch die Eingabeaufforderungen und passt das Verhalten des Modells an, wenn du mehr Daten bereitstellst und deine Aufgabendefinition verfeinerst. Du musst nicht jede Eingabeaufforderung manuell anpassen - SPPy erledigt das im Hintergrund für dich.

Wenn zum Beispiel der Datensatz wächst oder die Komplexität der Benutzerinteraktionen zunimmt, konfiguriert sich DSPy neu, um den größeren Umfang zu bewältigen. Sie wird die Aufforderungen verfeinern und die Parameter des Modells anpassen, um eine gleichbleibende und zuverlässige Leistung zu gewährleisten.

Diese Skalierbarkeit stellt sicher, dass dein Empfehlungssystem bei Bedarf wachsen und anspruchsvollere Aufgaben bewältigen kann, ohne dass du jedes Mal bei Null anfangen musst. Die Optimierungstechniken von DSPy ermöglichen es, große Aufgaben effizient zu bewältigen, so dass du dich auf die High-Level-Logik deiner Anwendung konzentrieren kannst und nicht auf die Feinheiten des Prompt Engineering.

Anwendungsfälle von DSPy

DSPy kann für eine breite Palette von Aufgaben zur Verarbeitung natürlicher Sprache eingesetzt werden. Sehen wir uns ein paar davon an.

Frage beantworten

DSPy ist wirklich gut darin, robuste Systeme zur Beantwortung von Fragen (QA) zu bauen. Sie kann kombinieren Retrieval-augmented Generation (RAG) mit der Gedankenkettenabfrage kombinieren, um leistungsstarke QA-Tools zu erstellen. Das bedeutet, dass du Systeme entwickeln kannst, die relevante Informationen finden und komplexe Fragen Schritt für Schritt durchdenken, um genauere und aufschlussreichere Antworten zu geben.

Text-Zusammenfassung

Mit DSPy wird das Erstellen von Zusammenfassungspipelines viel einfacher. Du kannst ganz einfach Systeme einrichten, die sich an unterschiedliche Eingabelängen und Schreibstile anpassen. Dank dieser Flexibilität kannst du von kurzen Artikeln bis hin zu langen Dokumenten alles zusammenfassen und dabei die wichtigsten Punkte beibehalten, während du den Stil der Zusammenfassung an deine Bedürfnisse anpasst.

Code-Erstellung

DSPy kann dabei helfen, Code-Schnipsel aus Beschreibungen zu generieren. Das ist besonders nützlich für Entwickler, die schnell einen Prototyp erstellen wollen, oder für Nicht-Programmierer, die einfache Skripte erstellen müssen.

Sprachübersetzung

DSPy kann die maschinelle Übersetzung viel besser machen. Es hilft, intelligentere Übersetzungssysteme zu schaffen, die nicht nur Wörter übersetzen, sondern auch den Kontext und die Kultur verstehen.

Mit DSPy kannst du einen Übersetzer erstellen, der Redewendungen und Sprichwörter richtig wiedergibt, den Stil und den Ton des Originaltextes beibehält und für bestimmte Bereiche wie Recht, Medizin oder Technik gut funktioniert. Sie kann sogar erklären, warum sie bestimmte Übersetzungen ausgewählt hat.

Chatbots und Konversations-KI

Mit DSPy können Chatbots das Gefühl vermitteln, mit einem echten Menschen zu sprechen. Anstatt vorgefertigte Antworten zu geben, kann sich ein DSPy-Chatbot merken, worüber du gesprochen hast, und so sinnvolle Konversationen führen. Er gibt dir Antworten, die besser zu deiner Frage passen und kann die Art und Weise, wie er spricht, an deine Wünsche anpassen. Diese Chatbots können sogar knifflige Aufgaben erledigen, die Denken und Entscheidungen erfordern. Diese Verbesserungen machen Chatbots hilfsbereiter und einfacher zu sprechen, fast so, als würdest du dich mit einem sachkundigen Freund unterhalten.

Erste Schritte mit DSPy

Du kannst DSPy mit pip installieren. Öffne dein Terminal oder die Eingabeaufforderung und führe sie aus:

pip install dspy-aiMit diesem Befehl wird die neueste stabile Version von DSPy installiert.

Wenn du die Funktionen von DSPy mit zusätzlichen Integrationen erkunden möchtest, kannst du es mit Extras installieren. Zum Beispiel, um Kiefernzapfen zu unterstützen, verwenden Sie:

pip install "dspy-ai[pinecone]"Ähnliche Befehle gibt es auch für andere Integrationen wie Qdrant, ChromaDBund Marqo.

DSPy Ressourcen

Um mehr über die Verwendung von DSPy zu erfahren, schau dir die offiziellen Dokumentation. Es enthält detaillierte Anleitungen und Beispiele, die dir den Einstieg erleichtern und dir helfen, die Möglichkeiten des Frameworks optimal zu nutzen.

Das offizielle GitHub-Repositorium enthält den Quellcode, den Issue Tracker und zusätzliche Beispiele.

Obwohl DSPy noch ein relativ neues Framework ist, wächst seine Community. Auf GitHub findest du Diskussionen und bekommst Hilfe. Dort kannst du Fragen öffnen oder an Diskussionen teilnehmen. Je größer die Gemeinschaft wird, desto mehr Ressourcen und gemeinsame Erfahrungen werden wahrscheinlich zur Verfügung stehen, um deine Reise mit DSPy zu unterstützen.

Vergiss nicht, dass DSPy aktiv weiterentwickelt wird. Halte also Ausschau nach Updates und neuen Funktionen, die deine Projekte verbessern könnten.

Diese Seite findest du Installationsanweisungen und Versionsinformationen für das DSPy-Paket.

Wenn du ein Fan der Arbeit in Notebooks bist, DSPy Colab Notebook ist ein interaktives Colab-Notizbuch, das dir hilft, schnell mit DSPy zu arbeiten.

Schließlich kannst du dem Discord-Server beitreten, um dich mit anderen DSPy-Nutzern zu verbinden, Fragen zu stellen und Erfahrungen auszutauschen.

Fazit

Insgesamt bietet DSPy einen intuitiveren und leistungsfähigeren Weg, mit KI zu arbeiten, weg vom Sofortengineering und hin zur Programmierung von Basismodellen. Lass uns noch einmal zusammenfassen, was wir in diesem Artikel behandelt haben:

- DSPy ist ein deklaratives, selbstverbesserndes Framework, das die Entwicklung von LLM-Anwendungen vereinfacht.

- Es zeichnet sich durch deklarative Programmierung, selbstverbessernde Prompts und eine modulare Architektur aus, die es einfacher macht, komplexe KI-Systeme zu entwickeln.

- Mit DSPy kannst du Aufgaben definieren, Pipelines erstellen und Prompts automatisch optimieren.

- Das Framework bietet im Vergleich zu herkömmlichen Prompt-Engineering-Methoden mehr Zuverlässigkeit, vereinfachte Entwicklung, Anpassungsfähigkeit und Skalierbarkeit.

- DSPy kann für eine Vielzahl von Anwendungsfällen eingesetzt werden, z. B. für die Beantwortung von Fragen, die Textzusammenfassung, die Codegenerierung und eigene NLP-Aufgaben.

Wenn du weiter mit DSPy arbeitest, vergiss nicht, die Ressourcen der Community zu nutzen. Bleib außerdem auf dem Laufenden, was es Neues in diesem sich entwickelnden Bereich gibt - ich empfehle dir, diese Blogbeiträge zu lesen, wenn du etwas über die neuesten Entwicklungen erfahren möchtest:

FAQs

Was sind die Systemanforderungen für die Installation und den Betrieb von DSPy?

DSPy erfordert Python 3.7 oder höher. Es wird empfohlen, ein modernes Betriebssystem (Windows, macOS oder Linux) und ausreichend Arbeitsspeicher (mindestens 8 GB) für die Bearbeitung großer Sprachmodelle zu verwenden. Ein Grafikprozessor ist für eine schnellere Verarbeitung von Vorteil, aber nicht zwingend erforderlich.

Gibt es Einschränkungen oder bekannte Probleme mit DSPy, die die Nutzer/innen kennen sollten?

Zu den bekannten Einschränkungen von DSPy gehören potenzielle Leistungsschwankungen zwischen verschiedenen Sprachmodellen, der Bedarf an umfangreichen Rechenressourcen für umfangreiche Aufgaben und die laufende Entwicklung von Community-Support und Dokumentation. Die Nutzerinnen und Nutzer sollten sich über die neuesten Versionen und Diskussionen in der Community auf dem Laufenden halten, um diese Probleme zu entschärfen.

Unterstützt DSPy mehrsprachige Aufgaben und wie effektiv ist es?

DSPy unterstützt mehrsprachige Aufgaben durch den Einsatz von Sprachmodellen, die in mehreren Sprachen trainiert wurden. Du kannst die Sprache in der Aufgabendefinition angeben, und DSPy optimiert die Eingabeaufforderungen entsprechend. Die Effektivität kann jedoch je nach den Trainingsdaten des Sprachmodells variieren.

Funktioniert DSPy mit allen Sprachmodellen?

DSPy wurde entwickelt, um mit einer Vielzahl von großen Sprachmodellen zu arbeiten. Er ist mit den gängigen Modellen wie GPT-3, GPT-4 und anderen OpenAI-Modellen kompatibel. Es kann auch mit Open-Source-Modellen verwendet werden. Für die aktuellsten Informationen zur Modellkompatibilität solltest du jedoch in der aktuellen Dokumentation nachsehen.

Kann ich DSPy für kommerzielle Projekte nutzen?

Ja, DSPy ist quelloffen und unter der Apache License 2.0 erhältlich, die auch eine kommerzielle Nutzung erlaubt. Überprüfe jedoch unbedingt die Lizenzbedingungen der spezifischen Sprachmodelle, die du mit DSPy verwendest, da diese unterschiedliche Einschränkungen haben können.

Ana Rojo Echeburúa ist KI- und Datenspezialistin und hat einen Doktortitel in angewandter Mathematik. Sie liebt es, Daten in verwertbare Erkenntnisse umzuwandeln und hat umfangreiche Erfahrung in der Leitung technischer Teams. Ana arbeitet gerne eng mit ihren Kunden zusammen, um deren Geschäftsprobleme zu lösen und innovative KI-Lösungen zu entwickeln. Sie ist für ihre Problemlösungsfähigkeiten und ihre klare Kommunikation bekannt und hat eine Leidenschaft für KI, insbesondere für generative KI. Ana widmet sich dem kontinuierlichen Lernen und der ethischen KI-Entwicklung sowie der Vereinfachung komplexer Probleme und der Erklärung von Technologien auf verständliche Weise.