Lernpfad

Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) gibt's schon seit über siebzig Jahren. Es fing mit einfachen Sprachmethoden an und hat sich dann nach und nach auf Bereiche wie künstliche Intelligenz und Datenwissenschaft ausgeweitet, was zeigt, dass sich diese Technologie des maschinellen Lernens (ML) stark weiterentwickelt hat.

Seine Bedeutung stieg 2011 mit der Einführung von Siri, einem erfolgreichen NLP-gestützten Assistenten, stark an. NLP ist echt wichtig für viele KI-Anwendungen, wie Chatbots, Stimmungsanalyse, maschinelle Übersetzung und so weiter.

In diesem Artikel erkläre ich dir, wie du NLP lernen kannst und wie du als Datenfachmann davon profitieren kannst. Ich werde auch diese breitere Nische in leicht verständliche Konzepte aufschlüsseln und einen Lernplan bereitstellen, damit du von Null anfangen kannst.

Warum NLP lernen?

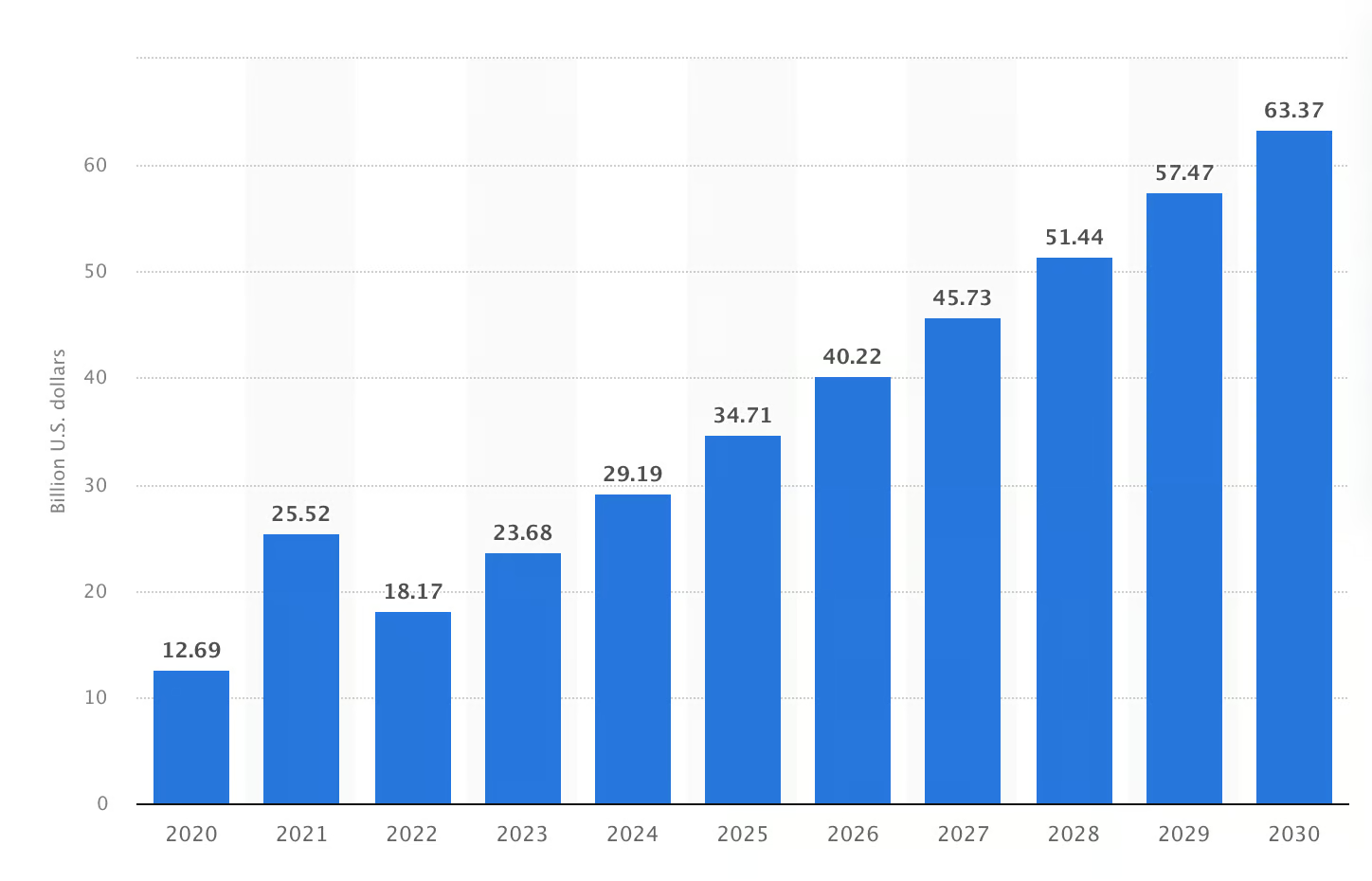

Der NLP-Markt ist 2023 auf über 23 Milliarden Dollar gewachsen und soll bis 2030 die 60-Milliarden-Dollar-Marke knacken. Weißt du aber, warum dieser Anstieg vorhergesagt wird? NLP macht die Kommunikation zwischen Technik und Menschen einfacher. Unternehmen nutzen es, um unstrukturierte Daten schneller zu verarbeiten und so bessere Entscheidungen zu treffen.

Die Größe des NLP-Marktes weltweit wird von 2020 bis 2030 voraussichtlich so viel betragen (in Milliarden US-Dollar). Bildquelle: Statista

Jetzt wird es in verschiedenen echten Anwendungen genutzt:

- Du kannst Krankenakten im Gesundheitswesen analysieren oder Markttrends im Finanzbereich verstehen.

- Sechs von zehn Leuten in den USA sagen, dass Chatbots mit NLP ihnen Zeit sparen, wenn sie sich E-Commerce-Produkte anschauen.

- Die Sentimentanalyse ist eine weitere wichtige Anwendung von NLP – sie findet heraus, welche Gefühle hinter Kommentaren in sozialen Medien stecken.

Das zeigt, dass NLP in fast allen Bereichen eingesetzt wird, von der Gesundheitsbranche über die Finanzwelt bis hin zum E-Commerce und Marketing. Also, wenn du das lernst, kannst du deine Karrierechancen verbessern, vor allem in den Bereichen Datenwissenschaft, KI und Softwareentwicklung.

Da KI immer mehr zum Alltag gehört, steigt auch die Nachfrage nach NLP-Experten, die komplexe Aufgaben lösen können, die allgemeine Modelle nicht schaffen, jedes Jahr. Einfach gesagt: Wenn du NLP lernst, kannst du dir eine Karriere mit vielen Möglichkeiten und langfristiger Relevanz aufbauen.

NLP in Python heute meistern

Wichtige Konzepte, die man in NLP verstehen sollte

Wenn du ein absoluter Neuling im Bereich NLP bist und weder die Grundlagen noch die fortgeschrittenen Themen kennst, findest du hier einige zentrale NLP-Konzepte, die du lernen solltest. Damit willst du dir ein Bild davon machen, wie die Arbeit mit NLP aussehen könnte.

Textvorverarbeitung

Die Textvorverarbeitung macht Rohdaten so auf, dass Computermodelle sie verstehen und verarbeiten können. Es verarbeitet alle Daten und behält dabei die eigentliche Bedeutung und den Kontext der menschlichen Sprache in Zahlen bei. Diese Vorverarbeitung läuft in mehreren Schritten ab, aber wie viele das sind, hängt davon ab, was für ein Text das ist und was du mit NLP erreichen willst.

Die häufigsten Schritte sind:

- Tokenisierung: Es zerlegt Text in kleinere Einheiten, die man Token nennt. Diese Token können Wörter, Zeichen oder Satzzeichen sein. Zum Beispiel würde der Satz „Ich will NLP lernen.“ in folgende Token zerlegt werden:

I,want,to,learn,NLP,.. - Entfernung von Stoppwörtern: Stoppwörter sind Wörter, die im Text keine Bedeutung haben, wie zum Beispiel „ist“, „der“ und „und“. Wenn man diese Wörter rausnimmt, kann man sich besser auf die wichtigen Wörter konzentrieren.

- Stemming: Stemming entfernt Endungen und bringt Wörter auf ihre Grundform zurück. Zum Beispielwird „going“ zu „go“ gekürzt.

- Lemmatisierung: Lemmatisierung macht Wörter zu Lemmas, die immer Sinn ergeben. Das ist ein ziemlich zeitaufwendiger Prozess mit einem Algorithmus, der komplizierter ist als Stemming.

Bag-of-Words (BoW) und TF-IDF

Sowohl Bag-of-Words als auch TF-IDF sind wichtige Konzepte in der NLP für die Informationsgewinnung. Hier ist ein Überblick über beide Konzepte:

- Bag-of-Words- t ein Dokument, das eine Sammlung von Wörtern enthält. Dieser Ansatz erstellt ein Merkmal, das jedes Wort aus dem Korpus (einer organisierten Sammlung von Datensätzen) repräsentiert. Dann gibt es jedem Merkmal einen Wert, je nachdem, wie oft ein Wort im Text vorkommt. Du kannst es nutzen, um Wortvorkommen in großen Datenmengen zu erfassen.

- TF-IDF- s baut auf dem BoW-Modell auf. Allerdings legt es mehr Wert auf Wörter, die im ganzen Textkorpus oft vorkommen. Du kannst dieses Modell nutzen, um wichtige Wörter im Inhalt eines Dokuments hervorzuheben.

Wort-Embeddings

Wort-Embeddings sind Darstellungen von Wörtern in einem kontinuierlichen Vektorraum. Maschinelle Lernmodelle brauchen sie, um Textdaten zu verstehen und damit zu arbeiten. Drei häufig verwendete Einbettungstechniken sind Word2Vec, GloVe und FasText. Schauen wir mal, was sie auszeichnet:

- Word2Vec nutzt Wörter in der Nähe, um den Kontext zu verstehen und die semantische Bedeutung zu erfassen. Allerdings hat es Probleme mit Wörtern, die nicht im Wortschatz sind (OOV-Wörter), und lernt nur Einbettungen für Wörter, die in den Trainingsdaten vorkommen.

- GloVe ( ) erstellt eine Ko-Auftrittsmatrix, um festzuhalten, wie oft ein Wort in einem Datensatz vorkommt. Wenn man ähnliche Wörter an einem Ort zusammenfasst, kann man die Beziehungen zwischen diesen Wörtern besser verstehen.

- FastText zerlegt Wörter in Teilwörter und lernt Einbettungen für diese kleineren Teile, wodurch die semantische Bedeutung erhalten bleibt.

Sprachmodelle

Bei jeder NLP-Aufgabe – egal ob Textgenerierung oder Spracherkennung – muss man zuerst die Wahrscheinlichkeit einer Wortfolge einschätzen. Da helfen Sprachmodelle. Sie ordnen Wortfolgen Wahrscheinlichkeiten zu und bringen Computern bei, wie man menschliche Sprache versteht. Zwei gängige Sprachmodelle sind:

- Traditionelle N-Gram-Modelle: Diese Modelle nutzen N-Gramme, also die Wahrscheinlichkeit, mit der ein Wort nach bestimmten vorherigen Wörtern in einer Sequenz kommt. Weil sie sich auf das Zählen von Wortfolgen aus großen Datensätzen verlassen, haben sie Probleme mit der Datenknappheit.

- Moderne Modelle, die auf Deep Learning basieren: Deep Learning hat sich mit der Einführung von Word2Vec und GloVe komplett verändert. Diese neuronalen Modelle machen Wort-Embeddings, die semantische Beziehungen erfassen, aber mit Wörtern, die nicht im Vokabular sind (OOV-Wörter), kommen sie nicht klar.

Moderne Deep-Learning-Modelle auf Transformer-Basis wie Bert und GPT wurden entwickelt, um Probleme früherer Modelle zu lösen. Diese Modelle erfassen den Kontext und die Bedeutung ganzer Sätze. So geht's:

- Googles BERT- m liest den Text in beide Richtungen, um den Textkontext besser zu verstehen. Es nutzt semantische und syntaktische Funktionen, um Aufgaben wie das Beantworten von Fragen und das Analysieren von Dokumenten super zu meistern.

- GPT nutzt einen unidirektionalen Ansatz, um das nächste Wort in der Sequenz vorherzusagen, deshalb kann es menschenähnliche und kontextuell korrekte Inhalte erstellen.

Textklassifizierung und Clustering

Bei der Textklassifizierung werden Textdaten mithilfe von Bag-of-Words- und N-Gram-Modellen in vordefinierte Kategorien eingeteilt. Wenn du zum Beispiel die Wörter „BERT“ und „GPT“ hast, werden anhand dieser Wörter zwei Kategorien erstellt. Dann wird das benutzt, um das Modell zu trainieren, die Kategorie von unbekanntem Text vorherzusagen.

Beim Clustering werden ähnliche Elemente ohne vordefinierte Bezeichnungen gruppiert. Der Algorithmus schaut sich die Merkmale jedes Elements an, um Gemeinsamkeiten zu finden und ähnliche Elemente zusammenzufassen. Marketingteams können zum Beispiel Clustering nutzen, um Verbrauchergruppen anhand von demografischen Daten zu identifizieren und relevantere Anzeigen zu schalten, um das Wachstum anzukurbeln.

NLP in Python lernen

Python ist wegen seiner Einfachheit und den nützlichen Bibliotheken bei NLP echt beliebt. Also, egal ob du gerade erst anfängst oder schon ein bisschen Programmiererfahrung hast, lass uns schauen, wie man mit Python eine solide NLP-Grundlage aufbaut.

Warum Python für NLP?

Python hat echt viele Bibliotheken, wie NLTK, spaCy und TextBlob, die Tools für die Verarbeitung, Tokenisierung und mehr bieten. Die aktive Community fügt ständig neue Funktionen hinzu und behebt Fehler, um diese Tools zu verbessern. Das heißt, du kannst dich auf aktuelle Ressourcen und Online-Support verlassen.

Neben Bibliotheken gibt es in Python auch Frameworks, die in der NLP genutzt werden. TensorFlow und PyTorch-NLP sind zwei Frameworks, die du für Textklassifizierung, Beantwortung von Fragen und Stimmungsanalyse nutzen kannst.

Python-Bibliotheken für NLP

Einige der am häufigsten verwendeten Python-Bibliotheken für NLP-Aufgaben sind:

- NLTK (Natural Language Toolkit): Es hat Funktionen, um benannte Entitäten zu erkennen und Parsing-Bäume zu erstellen. Du kannst es nutzen, um Wortarten zu kennzeichnen und Texte zu klassifizieren. Diese Funktionen machen es zu einer ersten Wahl für Anfänger und erfahrene Nutzer.

- spaCy: Während NLTK super für einfache Sachen wie Tokenisierung und das Arbeiten mit Stoppwörtern ist, macht spaCy diese Aufgaben schneller und genauer. Außerdem ist es super beim Parsen von Abhängigkeiten, was bedeutet, dass du damit die Beziehungen zwischen Wörtern in einem Satz verstehen kannst. Du kannst es für Anwendungen auf Produktionsebene nutzen.

- Gensim: Wenn du mit Wort-Embeddings wie Word2Vec arbeiten willst, ist Gensim die richtige Bibliothek für dich. Es findet Wortähnlichkeiten und Wörter, die in Clustern vorkommen. Du kannst es auch für die Bearbeitung großer Korpora nutzen, weil es große Textdatensätze verarbeiten kann.

- Transformatoren (Hugging Face): Diese Bibliotheken machen es einfach, auf besser trainierte Modelle wie BERT und GPT zuzugreifen. Du kannst diese Bibliotheken nutzen, um Modelle für deine eigenen Datensätze zu optimieren. Du kannst zum Beispiel Aufgaben wie die Erkennung benannter Entitäten und die Generierung von Songtexten in deinem gewünschten Stil erledigen.

Wie man NLP von Grund auf lernt

Da NLP ein riesiges Gebiet ist, scheint es für Anfänger schwierig, es von Grund auf zu lernen. Du solltest aber mit den Grundlagen anfangen, wie Textvorverarbeitung und Wort-Embedding, und dann zu fortgeschrittenen Themen wie Deep Learning übergehen.

Ich hab dir eine Schritt-für-Schritt-Anleitung zusammengestellt, damit du deine NLP-Reise von Null an starten kannst:

Schritt 1: Verstehe die Grundlagen von Textdaten

Da die Datenvorbereitung das Herzstück jeder NLP-Aufgabe ist, solltest du damit anfangen, die Struktur der Textdaten zu verstehen und lernen, verschiedene Datentypen wie Sätze, Absätze oder Dokumente zu analysieren.

Schritt 2: Lerne Techniken zur Textvorverarbeitung

Als Nächstes lernst du was über die Textvorverarbeitung (Vorbereitung der Daten für die Analyse). So verstehst du, wie Satzzeichen entfernt werden, wie Text in Kleinbuchstaben umgewandelt wird und wie Sonderzeichen behandelt werden. Auch wenn diese Aufgaben einfach klingen mögen, helfen dir die dahinter stehende Wissenschaft und Logik dabei, zu verstehen, wie NLP-Modelle Text verarbeiten.

Wenn du alles verstanden hast, probier's mal mit Beispielen aus der Praxis aus. Such Textbeispiele auf Websites oder Social-Media-Plattformen. Probier dann verschiedene Reinigungsmethoden an diesem Text aus. Mit diesem praktischen Ansatz kannst du selbst sehen, wie durch die Vorverarbeitung unübersichtliche Daten in ein Format umgewandelt werden, das für die Analyse bereit ist.

Während du übst, wirst du verstehen, warum jeder Schritt wichtig ist und wie er zum Gesamtziel der Textvorbereitung für NLP-Aufgaben beiträgt.

Schritt 3: Textdarstellungsmethoden erkunden

Um mit Textdaten in NLP effektiv arbeiten zu können, musst du verschiedene Arten der Datendarstellung verstehen. Fang damit an, dich mit grundlegenden Methoden wie Bag-of-Words und TF-IDF vertraut zu machen. Dann schau dir fortgeschrittene Techniken wie Wort-Embeddings an und lerne, wie sie die Bedeutung von Wörtern erfassen.

Probier diese Methoden mal an echten Texten aus, wie zum Beispiel Nachrichtenartikeln oder Social-Media-Beiträgen. Schau mal, wie jede Technik die Art und Weise verändert, wie Text analysiert wird, und die Ergebnisse des NLP-Modells beeinflusst.

Schritt 4: Arbeiten an NLP-Aufgaben

Als Nächstes solltest du Konzepte wie Sentimentanalyse, Textklassifizierung und Named Entity Recognition (NER) verstehen. Fang mit einer Stimmungsanalyse an, um herauszufinden, welche Stimmung der Text hat – positiv, negativ oder neutral.

Um diese Konzepte besser zu verstehen, probier doch mal das Projekt „ “ von DataCamp aus. Wer twittert? Trump oder Trudeau. Wenn du das durch hast, kannst du Tweets und die darin ausgedrückten Gefühle analysieren.

Dann mach dich mit Klassifizierung klar und lerne, Texte in verschiedene Kategorien zu sortieren.

Schritt 5: Lerne fortgeschrittene NLP-Themen

Lerne jetzt fortgeschrittene Fähigkeiten wie Deep Learning, Sprachmodelle und Transferlernen kennen. Modelle von Grund auf neu zu bauen kann teuer und zeitaufwendig sein. Deshalb solltest du lernen, wie man vortrainierte Modelle wie BERT benutzt.

Optimiere diese Modelle, um Artikel zusammenzufassen, Fragen zum Text zu beantworten und verschiedene Artikel zu sortieren. Diese Beispiele aus der Praxis helfen dir dabei, bei bestimmten Texttypen bessere Leistungen zu erzielen.

Ein Beispiel für einen Lernplan für NLP

Jetzt weißt du, welche Schritte du machen musst, um loszulegen. Also halte dich an diesen Wochenplan und fang mit dem Lernen an:

|

Woche |

Schwerpunktbereich |

Lernziele |

Ressourcen |

|

Woche 1 |

NLP-Konzepte |

Lerne was über Syntax, Semantik, Pragmatik und grundlegende Textdarstellungen (Zeichenfolgen, Listen, Wörterbücher, Mengen). |

|

|

Woche 2 |

Textdarstellung |

Lerne mehr über Methoden zur Textdarstellung und Techniken zur Wort-Einbettung wie Word2Vec oder GloVe. |

|

|

Woche 3 |

NLP-Aufgaben |

Wende dein Wissen auf Sentimentanalyse, Textklassifizierung und NER an. Mach dich mit Python-Bibliotheken vertraut. |

|

|

Woche 4 |

Sprachmodelle lernen |

Lerne mehr über Sprachmodelle und optimiere BERT für Textzusammenfassungen und die Beantwortung von Fragen. |

|

|

Woche 5 |

Ein NLP-Projekt erstellen |

Mach ein NLP-Projekt (z. B. einen Chatbot oder ein Tool zur Stimmungsanalyse). |

Du kannst auch den NLP-Lernpfad von DataCamp in Python machen, der mehrere Kurse hat, die dich vom Anfänger zum Profi bringen.

Die besten Ressourcen zum Lernen von NLP

Egal, ob du die Grundlagen oder fortgeschrittene Konzepte lernen willst, es gibt viele Ressourcen, von Online-Kursen bis hin zu YouTube-Tutorials, die dir einen guten Start ermöglichen. Hier sind meine Favoriten:

Online-Kurse

Online-Kurse bieten dir die Möglichkeit, dein Leben lang zu lernen. DataCamp hat ein paar echt coole Kurse, die dir tiefes Wissen über NLP vermitteln. Hier sind ein paar der coolen NLP-Kurse auf DataCamp:

- Für NLP-Grundlagen: Einführung in die Verarbeitung natürlicher Sprache

- Für Anwendungen auf Produktionsebene mit NLP: Fortgeschrittene NLP mit SpaCy

- Zum Trainieren von Modellen mit SpaCy: Natürliche Sprachverarbeitung mit SpaCy

- Entdecke die grundlegenden Tools für NLP in R: Einführung in die Verarbeitung natürlicher Sprache in R

- Benutz Python, um Text in ein Format zu verwandeln, das für maschinelles Lernen passt: Feature Engineering für NLP in Python

Bücher und Lehrbücher

Bücher und Lehrbücher sind super, um praktische NLP-Probleme und -Lösungen zu lernen. Die sind echt praktisch, wenn du an längeren Projekten arbeitest und neue Konzepte verstehen musst.

Du kannst diese Bücher lesen, um dich mit den NLP-Konzepten vertraut zu machen:

- Für die Grundlagen: Sprachverarbeitung

- Für fortgeschrittene NLP-Konzepte: Natürliche Sprachverarbeitung mit Python

YouTube-Kanäle und Tutorials

Wenn es ums selbstständige Lernen geht, sind YouTube-Tutorials meine erste Wahl. Es gibt ein paar coole YouTube-Kanäle, die sich nur mit NLP und wie man es anwendet beschäftigen. Du kannst sie also benutzen und damit üben.

Hier sind ein paar meiner Top-Empfehlungen für dich:

- Für die Grundlagen: Playlist „Natürliche Sprachverarbeitung (NLP)“

- Für Wort-Embeddings: Ein kompletter Überblick über Wort-Embeddings

- Für das transformatorbasierte Modell: Was ist BERT und wie funktioniert es?

- Für die Grundlagen von Transformatoren: Transformatoren für Anfänger

Übungsplattformen

Wenn du eher ein Praxis-Fan bist, probier mal Plattformen wie Kaggle und Hugging Face aus. Sie bieten Tausende von Datensätzen, mit denen man an echten Anwendungsfällen arbeiten kann. Manche Personalvermittler bitten dich vielleicht sogar, NLP-Aufgaben in einem Einzelspieler-Wettbewerb von Kaggle zu erledigen. Also, das Üben auf diesen Plattformen lohnt sich echt.

Schau dir mal die folgenden Ressourcen an:

- Für einfache Datensätze: Die besten 25 Datensätze für NLP-Projekte

- Für komplizierte Datensätze: IMDB-Datensätze bei Hugging Face

- Für Kundenbewertungen: Amazon-Rezensionen für die Sentimentanalyse

Tipps, um NLP zu meistern

Um NLP richtig zu meistern, braucht's konsequente Anstrengung und einen praxisorientierten Ansatz. Ich hab auf meiner NLP-Reise echt viel gelernt und würde gern ein paar Tipps teilen, die mir dabei geholfen haben. Regelmäßiges Training mit Konsequenz ist echt ein super Weg, um immer besser zu werden. Aber hier sind ein paar wichtige Tipps, die du beachten solltest, wenn du schnell vorankommen willst:

- Mach regelmäßig was: Übe weiter, um das breite Spektrum der NLP-Konzepte und -Aufgaben zu verstehen. Versuche außerdem, NLP-Übungen in deinen Alltag einzubauen, sei es durch Programmieraufgaben oder die Arbeit mit textbasierten Datensätzen.

- Mach bei Lerngruppen oder Foren mit: Bei Tech-Projekten hab ich immer von Online-Communities profitiert. Sie bringen Anfänger, Datenpraktiker, Forscher und KI-Experten zusammen. Tritt also unbedingt Foren bei, damit du Lösungen für alle Probleme im Zusammenhang mit NLP findest.

- Arbeite an echten NLP-Projekten: Um dich von anderen abzuheben, musst du Konzepte wie Word Embedding und Modellvalidierung in echte Software umsetzen. Mach deine eigenen Projekte oder hilf bei Open-Source-Initiativen mit, um praktische Erfahrungen zu sammeln und ein Portfolio aufzubauen.

- Bleib neugierig und lerne immer weiter: Weil sich NLP schnell weiterentwickelt, sieht die Zukunft vielversprechend aus. Mach es dir zur Gewohnheit, die neuesten Forschungsberichte zu lesen, Vordenkern zu folgen und Fortgeschrittenenkurse zu besuchen, um immer auf dem Laufenden zu bleiben.

Abschließende Gedanken

Egal, wer du bist – ob Informatikabsolvent oder jemand mit langjähriger Erfahrung – wenn du NLP beherrschst, kannst du spezialisierte Jobs bekommen.

Aber denk dran, NLP-Aufgaben sind echt unterschiedlich. Was bei einem Problem funktioniert, klappt vielleicht bei einem anderen nicht. Du musst also deine Herangehensweise an die spezifischen Herausforderungen und Daten anpassen. Und das lernt man, indem man theoretisches Wissen in der Praxis anwendet.

Wenn du heute mit NLP von Grund auf anfangen willst, schau dir unseren Lernpfad „Natural Language Processing in Python ” an.

Fähigkeiten im Bereich Machine Learning aufbauen

FAQs

Braucht man für NLP Programmierkenntnisse?

Ja, für NLP musst du ein bisschen programmieren können, aber du musst kein Profi sein. Ein grundlegendes Verständnis von Python reicht aus, um mit NLP-Tools und -Bibliotheken zu arbeiten. Du wirst auch auf Konzepte aus den Bereichen maschinelles Lernen, Deep Learning und Statistik stoßen, die für NLP super wichtig sind.

Wie viel kann ich mit NLP-Fähigkeiten verdienen?

Laut ZipRecruiterverdienen NLP-Fachleute im Schnitt etwa 122.738 Dollar pro Jahr, je nachdem, wie viel Erfahrung sie haben und wo sie arbeiten.

Ist NLP ein Teil von KI oder ML?

NLP ist ein Teilbereich der KI, der stark auf Techniken des maschinellen Lernens (ML) setzt. Es lässt Computer menschliche Sprache verstehen und verarbeiten.

Kann ich NLP auch ohne maschinelles Lernen lernen?

Nein, maschinelles Lernen ist für NLP echt wichtig. Viele NLP-Aufgaben brauchen ML-Algorithmen, um Sprachdaten gut zu verarbeiten und zu analysieren.

Ich bin ein Inhaltsstratege, der es liebt, komplexe Themen zu vereinfachen. Ich habe Unternehmen wie Splunk, Hackernoon und Tiiny Host geholfen, ansprechende und informative Inhalte für ihr Publikum zu erstellen.