Cursus

Le traitement du langage naturel (NLP) existe depuis plus de sept décennies. Cela a commencé par des méthodes linguistiques simples, puis s'est progressivement étendu à des domaines tels que l'intelligence artificielle et la science des données, ce qui démontre que cette technologie d'apprentissage automatique (ML) a considérablement évolué.

Son importance a augmenté en 2011 avec le lancement de Siri, un assistant alimenté par le traitement du langage naturel qui a rencontré un grand succès. Le traitement automatique du langage naturel (TALN) est au cœur de nombreuses applications d'intelligence artificielle, telles que les chatbots, l'analyse des sentiments, la traduction automatique, etc.

Dans cet article, je vais vous expliquer comment vous pouvez apprendre le NLP et en quoi cela peut vous être utile en tant que professionnel des données. Je vais également décomposer ce vaste domaine en concepts faciles à comprendre et vous proposer un plan d'apprentissage afin que vous puissiez commencer à partir de zéro.

Pourquoi apprendre la PNL ?

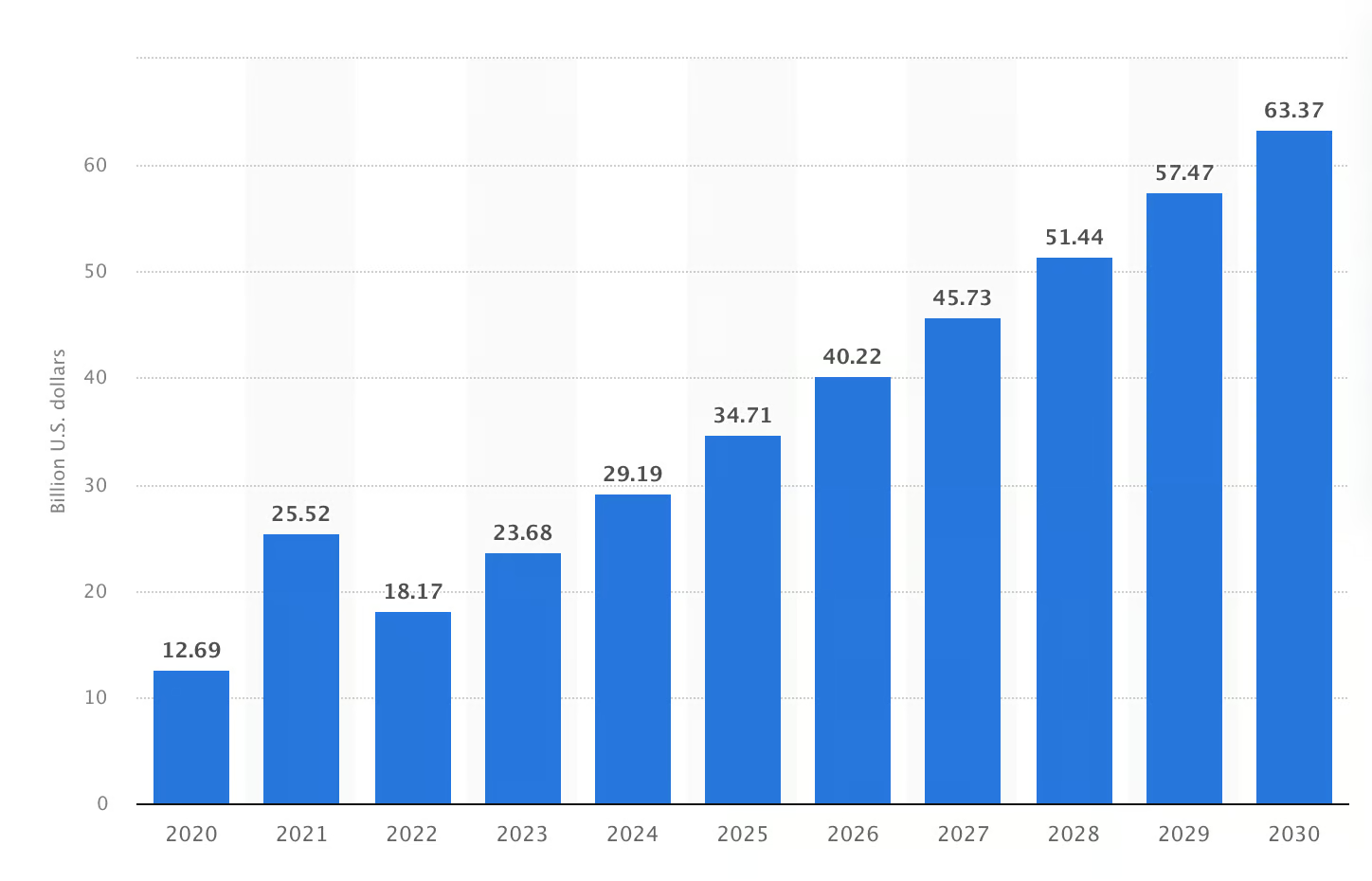

Le marché du NLP a dépassé les 23 milliards de dollars en 2023 et devrait dépasser les 60 milliards de dollars d'ici 2030. Cependant, savez-vous pourquoi cette augmentation est prévue ? Le NLP comble le fossé communicationnel entre la technologie et les êtres humains. Les organisations s'appuient sur cette technologie pour traiter plus rapidement les données non structurées et prendre ainsi de meilleures décisions.

La taille prévue du marché mondial du NLP sera comprise entre 2020 et 2030 (en milliards de dollars américains). Source de l'image : Statista

À l'heure actuelle, il est utilisé dans diverses applications concrètes :

- Vous pouvez analyser des dossiers médicaux dans le secteur de la santé ou appréhender les tendances du marché dans le domaine financier.

- Six consommateurs américains sur dix affirment que les chatbots basés sur le traitement du langage naturel leur permettent de gagner du temps lorsqu'ils explorent des produits en ligne.

- L'analyse des sentiments est une autre application clé du TALN : elle interprète les émotions qui se cachent derrière les commentaires publiés sur les réseaux sociaux.

Cela démontre que le TALN est utilisé dans presque tous les domaines, des soins de santé et de la finance au commerce électronique et au marketing. Par conséquent, l'acquérir peut élargir vos perspectives de carrière, en particulier dans les domaines de la science des données, de l'intelligence artificielle et du développement logiciel.

L'intelligence artificielle devenant de plus en plus courante, la demande en experts en TALN capables de traiter des tâches complexes que les modèles généraux ne peuvent pas résoudre augmente également chaque année. En résumé, en apprenant la PNL, vous pouvez vous préparer à une carrière offrant de nombreuses opportunités et une pertinence à long terme.

Maîtrisez la PNL en Python dès aujourd'hui

Concepts fondamentaux à comprendre en PNL

Si vous êtes un débutant complet en PNL et que vous ne connaissez pas les notions de base et les sujets avancés qu'elle implique, voici quelques concepts fondamentaux de la PNL que vous devez apprendre. Ceci a pour but de vous donner une idée de ce à quoi pourrait ressembler le travail dans le domaine du NLP.

Pré-traitement du texte

Le prétraitement du texte consiste à convertir les données brutes dans un format adapté aux modèles informatiques afin qu'ils puissent les comprendre et les traiter. Il traite toutes les données tout en préservant la signification réelle et le contexte du langage humain sous forme de chiffres. Ce prétraitement s'effectue en plusieurs étapes, mais le nombre d'étapes peut varier en fonction de la nature du texte et des objectifs que vous souhaitez atteindre avec le TALN.

Les étapes les plus courantes comprennent :

- Tokenisation : Il décompose le texte en unités plus petites appelées tokens. Ces jetons peuvent être des mots, des caractères ou des signes de ponctuation. Par exemple, la phrase « Je souhaite apprendre le NLP » serait tokenisée comme suit :

I,want,to,learn,NLP,.. - Suppression des mots vides : Les mots vides sont des mots dépourvus de sens dans le texte, tels que « est », « le » et « et ». En supprimant ces mots, il est plus facile de se concentrer sur les mots significatifs.

- Tronçonnage : La dérivation élimine les suffixes et ramène les mots à leur forme de base. Par exemple, « going » sera réduit à « go ».

- Lemmatisation : La lemmatisation réduit les mots à des lemmes qui sont toujours significatifs. Il s'agit d'un processus qui demande beaucoup de temps et dont l'algorithme est plus complexe que celui du stemming.

Sac de mots (BoW) et TF-IDF

Les concepts de « sac de mots » et TF-IDF sont tous deux importants en TALN pour la recherche d'informations. Voici un aperçu des deux concepts :

- Les documents de type « bag-of-words » ( ) sont des documents contenant des mots collectés. Cette approche crée une caractéristique représentant chaque mot du corpus (une collection organisée d'ensembles de données). Ensuite, il attribue à chaque caractéristique une valeur basée sur le nombre d'occurrences d'un mot dans le texte. Vous pouvez l'utiliser pour détecter les occurrences de mots dans de grandes quantités de données.

- L'e TF-IDF s'appuie sur le modèle BoW. Cependant, il accorde davantage d'importance aux mots qui apparaissent fréquemment dans l'ensemble du corpus. Vous pouvez utiliser ce modèle pour mettre en évidence les mots importants dans le contenu d'un document.

Embeddings de mots

Les plongements de mots sont des représentations de mots dans un espace vectoriel continu. Les modèles d'apprentissage automatique s'appuient sur ces derniers pour comprendre et traiter les données textuelles. Les trois techniques d'intégration couramment utilisées sont Word2Vec, GloVe et FasText. Examinons ce qui les distingue :

- Word2Vec utilise les mots proches pour comprendre le contexte et saisir le sens sémantique. Cependant, il rencontre des difficultés avec les mots hors vocabulaire (OOV) et n'apprend que les plongements pour les mots trouvés dans les données d'entraînement.

- GloVe ( ) construit une matrice de cooccurrence afin d'enregistrer la fréquence d'apparition d'un mot dans un ensemble de données. Le regroupement de mots similaires en un seul endroit permet de saisir les relations sémantiques entre ces mots.

- FastText divise les mots en sous-mots et apprend les intégrations pour ces parties plus petites, ce qui lui permet de conserver la signification sémantique.

Modèles linguistiques

Toute tâche de traitement du langage naturel (TALN), qu'il s'agisse de génération de texte ou de reconnaissance vocale, doit d'abord prédire la probabilité d'une séquence de mots. C'est là que les modèles linguistiques apportent leur aide. Ils attribuent des probabilités à des séquences de mots et permettent aux ordinateurs de comprendre le langage humain. Deux modèles linguistiques courants comprennent :

- Modèles N-Gram traditionnels : Ces modèles utilisent des N-grammes, qui sont les probabilités d'un mot basées sur les mots précédents dans une séquence. Comme ils s'appuient sur le comptage de séquences de mots provenant de grands ensembles de données, ils sont confrontés à des défis liés à la rareté des données.

- Modèles modernes basés sur l'apprentissage profond : L'apprentissage profond a connu une transformation radicale avec l'introduction de Word2Vec et GloVe. Ces modèles neuronaux créent des plongements lexicaux qui capturent les relations sémantiques, mais ne peuvent pas traiter les mots hors vocabulaire (OOV).

Les modèles modernes basés sur le deep learning et les transformateurs, tels que Bert et GPT, ont été développés pour résoudre les problèmes rencontrés dans les modèles précédents. Ces modèles capturent le contexte et la signification de phrases entières. Voici comment procéder :

- L' e BERT de Google lit le texte dans les deux sens afin de mieux comprendre le contexte. Il intègre des fonctionnalités sémantiques et syntaxiques qui lui permettent d'exceller dans des tâches telles que répondre à des questions et analyser des documents.

- GPT utilise une approche unidirectionnelle pour prédire le mot suivant dans la séquence, ce qui lui permet de créer un contenu similaire à celui produit par un humain et contextuellement correct.

Classification et regroupement de textes

La classification de texte attribue des catégories prédéfinies aux données textuelles à l'aide de modèles bag-of-words et N-Gram. Par exemple, si vous avez les mots « BERT » et « GPT », deux catégories seront créées à partir de ces mots. Ensuite, cela sera utilisé pour entraîner le modèle à prédire la catégorie de texte inconnu.

Lors du regroupement , les éléments similaires sont regroupés sans étiquettes prédéfinies. L'algorithme examine les caractéristiques de chaque élément afin de trouver des similitudes et de regrouper les éléments similaires. Par exemple, les équipes marketing peuvent intégrer le regroupement pour identifier les groupes de consommateurs en fonction de données démographiques et diffuser des publicités plus pertinentes afin de stimuler la croissance.

Apprendre le NLP en Python

Python est très apprécié pour le traitement du langage naturel en raison de sa simplicité et de ses bibliothèques utiles. Ainsi, que vous soyez débutant ou que vous ayez déjà une certaine expérience en programmation, nous allons examiner comment établir des bases solides en NLP à l'aide de Python.

Pourquoi Python pour le TALN ?

Python dispose de bibliothèques complètes, telles que NLTK, spaCy et TextBlob, qui fournissent des outils pour le traitement, la tokenisation et bien plus encore. Sa communauté active ajoute constamment de nouvelles fonctionnalités et corrige les bugs afin d'améliorer ces outils. Cela signifie que vous pouvez compter sur lui pour obtenir des ressources actualisées et une assistance en ligne.

En plus des bibliothèques, Python dispose également de frameworks utilisés en NLP. TensorFlow et PyTorch-NLP sont deux frameworks que vous pouvez utiliser pour la classification de texte, la réponse à des questions et l'analyse des sentiments.

Bibliothèques Python pour le traitement du langage naturel

Parmi les bibliothèques Python les plus utilisées pour les tâches de TALN, on peut citer :

- NLTK (Natural Language Toolkit) : Il dispose de fonctions permettant d'identifier les entités nommées et de créer des arbres d'analyse syntaxique. Vous pouvez l'utiliser pour baliser les parties du discours et classer le texte. Ces fonctionnalités en font un outil incontournable pour les débutants comme pour les utilisateurs expérimentés.

- spaCy : Alors que NLTK est très performant pour les tâches de base telles que la tokenisation et le traitement des mots vides, spaCy effectue ces tâches plus rapidement et avec plus de précision. De plus, il excelle dans l'analyse syntaxique des dépendances, ce qui signifie qu'il permet de comprendre les relations entre les mots dans une phrase. Vous pouvez l'utiliser pour des applications de niveau production.

- Gensim : Si vous souhaitez travailler avec des plongements de mots tels que Word2Vec, Gensim sera votre bibliothèque de référence. Il identifie les similitudes entre les mots et les mots associés à un groupe. Vous pouvez également l'utiliser pour traiter de grands corpus, car il est capable de gérer de grands ensembles de données textuelles.

- Transformateurs (Hugging Face) : Ces bibliothèques facilitent l'accès à des modèles plus perfectionnés, tels que BERT et GPT. Vous pouvez utiliser ces bibliothèques pour affiner les modèles sur vos propres ensembles de données. Par exemple, vous pouvez effectuer des tâches telles que la reconnaissance d'entités nommées et la génération de paroles de chansons dans le style de votre choix.

Comment apprendre la PNL à partir de zéro

Étant donné que le NLP est un domaine très vaste, il peut sembler difficile pour les débutants de l'apprendre à partir de zéro. Cependant, il est recommandé de commencer par les bases, telles que le prétraitement du texte et l'intégration de mots, avant de passer à des sujets plus avancés comme l'apprentissage profond.

J'ai élaboré un guide étape par étape pour vous aider à démarrer votre parcours en PNL à partir de zéro :

Étape 1 : Comprendre les principes fondamentaux des données textuelles

Étant donné que la préparation des données est au cœur de toute tâche de TALN, il est recommandé de commencer par comprendre la structure des données textuelles et d'apprendre à analyser différents types de données, tels que les phrases, les paragraphes ou les documents.

Étape 2 : Apprendre les techniques de prétraitement de texte

Ensuite, découvrez le prétraitement de texte (préparation des données pour l'analyse). De cette manière, vous comprendrez comment les signes de ponctuation sont supprimés, comment le texte est converti en minuscules et comment les caractères spéciaux sont traités. Bien que ces tâches puissent sembler simples, la science et la logique qui les sous-tendent vous aideront à comprendre comment les modèles de NLP traitent le texte.

Une fois que vous avez bien compris tous les concepts, veuillez vous exercer à l'aide d'exemples concrets. Veuillez rechercher des exemples de textes provenant de sites Web ou de plateformes de réseaux sociaux. Ensuite, veuillez appliquer différentes méthodes de nettoyage à ce texte. Cette approche pratique vous permettra de constater par vous-même comment le prétraitement transforme des données désordonnées en un format prêt à être analysé.

Au fur et à mesure de votre pratique, vous comprendrez l'importance de chaque étape et comment elle contribue à l'objectif global de préparation du texte pour les tâches de TALN.

Étape 3 : Découvrez les méthodes de représentation du texte

Pour travailler efficacement avec des données textuelles en TALN, il est nécessaire de comprendre les différentes manières de représenter les données. Commencez par vous familiariser avec les méthodes de base telles que le sac de mots et TF-IDF. Ensuite, passez aux techniques avancées, telles que les plongements de mots, et découvrez comment elles capturent la signification sémantique des mots.

Veuillez appliquer ces méthodes à des textes réels, tels que des articles de presse ou des publications sur les réseaux sociaux. Veuillez noter comment chaque technique modifie la manière dont le texte est analysé et influence les résultats du modèle NLP.

Étape 4 : Travail sur des tâches de traitement du langage naturel

Ensuite, veuillez vous familiariser avec des concepts tels que l'analyse des sentiments, la classification de texte et la reconnaissance d'entités nommées (NER). Commencez par analyser le sentiment afin d'identifier l'émotion exprimée par le texte : positive, négative ou neutre.

Pour mieux appréhender ces concepts, nous vous invitons à vous exercer avec le projet DataCamp intitulé « » (Qui tweete ?). Trump ou Trudeau. Une fois que vous l'aurez terminé, vous serez en mesure d'analyser les tweets et les sentiments qu'ils expriment.

Ensuite, veuillez travailler sur la classification et apprendre à classer les textes dans différentes catégories.

Étape 5 : Apprenez les thèmes avancés du NLP

Découvrez maintenant des compétences avancées telles que l'apprentissage profond, les modèles linguistiques et l'apprentissage par transfert. Construire des modèles à partir de zéro peut s'avérer coûteux et prendre beaucoup de temps. C'est pourquoi il est important d'apprendre à utiliser des modèles pré-entraînés tels que BERT.

Ajustez ces modèles afin de résumer des articles, de répondre à des questions basées sur du texte et de classer différents articles. Ces exemples concrets vous aideront à améliorer vos performances sur des types de textes spécifiques.

Exemple de plan d'apprentissage pour le NLP

Maintenant que vous connaissez les étapes à suivre pour vous lancer, veuillez suivre ce programme hebdomadaire et commencer votre apprentissage :

|

Semaine |

Domaine d'intérêt |

Objectifs pédagogiques |

Ressources |

|

Semaine 1 |

Concepts de la PNL |

Découvrez la syntaxe, la sémantique, la pragmatique et les représentations textuelles de base (chaînes, listes, dictionnaires, ensembles). |

|

|

Semaine 2 |

Représentation textuelle |

Découvrez les méthodes de représentation textuelle et les techniques d'intégration de mots telles que Word2Vec ou GloVe. |

|

|

Semaine 3 |

Tâches de traitement du langage naturel |

Appliquez vos connaissances à l'analyse des sentiments, à la classification de textes et à la reconnaissance des entités nommées. Familiarisez-vous avec les bibliothèques Python. |

|

|

Semaine 4 |

Étudier les modèles linguistiques |

Découvrez les modèles linguistiques et affinez BERT pour la synthèse de texte et la réponse aux questions. |

|

|

Semaine 5 |

Développer un projet de traitement du langage naturel |

Mettre en œuvre un projet de traitement du langage naturel (par exemple, un chatbot ou un outil d'analyse des sentiments). |

Vous pouvez également suivre le cursus de compétences NLP in Python de DataCamp, qui comprend plusieurs cours pour vous accompagner du niveau débutant au niveau avancé.

Les meilleures ressources pour apprendre le NLP

Que vous souhaitiez acquérir des connaissances de base ou approfondir des concepts avancés, de nombreuses ressources sont à votre disposition, des cours en ligne aux tutoriels YouTube, pour vous permettre de démarrer sur de bonnes bases. Voici mes préférés :

Cours en ligne

Les cours en ligne vous offrent une opportunité d'apprentissage tout au long de la vie. DataCamp propose d'excellents cours qui permettent d'acquérir des connaissances approfondies en matière de NLP. Voici quelques-uns des excellents cours sur le NLP proposés par DataCamp :

- Pour les bases du NLP : Introduction au traitement du langage naturel

- Pour les applications de niveau production avec le traitement du langage naturel (NLP) : NLP avancé avec SpaCy

- Pour former des modèles avec SpaCy : Traitement du langage naturel avec SpaCy

- Découvrez les outils de base pour le TALN dans R : Introduction au traitement du langage naturel dans R

- Veuillez utiliser Python pour traiter le texte dans un format adapté à l'apprentissage automatique : Ingénierie des caractéristiques pour le traitement du langage naturel en Python

Livres et manuels scolaires

Les livres et les manuels sont excellents pour apprendre les problèmes et les solutions pratiques liés à la PNL. Ils sont utiles lorsque vous travaillez sur des projets de longue haleine et que vous devez assimiler de nouveaux concepts.

Vous pouvez consulter ces ouvrages pour approfondir vos connaissances en matière de concepts de la PNL :

- Pour les éléments fondamentaux : Traitement de la parole et du langage

- Pour les concepts avancés de la PNL : Traitement du langage naturel avec Python

Chaînes YouTube et tutoriels

En matière d'apprentissage autonome, les tutoriels YouTube constituent mon choix privilégié. Il existe plusieurs chaînes YouTube de qualité consacrées exclusivement au NLP et à ses applications. Vous pouvez donc les utiliser et vous exercer avec eux.

Voici quelques-unes de mes meilleures suggestions pour vous :

- Pour les éléments fondamentaux : Liste de lecture sur le traitement du langage naturel (NLP)

- Pour les plongements de mots : Présentation complète des plongements de mots

- Pour le modèle basé sur un transformateur : Qu'est-ce que BERT et comment fonctionne-t-il ?

- Pour les notions de base sur les transformateurs : Transformateurs pour débutants

Plateformes d'entraînement

Si vous êtes davantage intéressé par la pratique, nous vous recommandons d'essayer des plateformes telles que Kaggle et Hugging Face. Ils proposent des milliers d'ensembles de données pour travailler sur des cas d'utilisation réels. Certains recruteurs peuvent même vous demander de réaliser des tâches de PNL dans le cadre d'un concours Kaggle en solo. Il est donc utile de s'entraîner sur ces plateformes.

Veuillez consulter les ressources suivantes :

- Pour les ensembles de données simples : Les 25 meilleurs ensembles de données pour les projets de traitement du langage naturel

- Pour les ensembles de données complexes : Ensembles de données IMDB sur Hugging Face

- Pour les avis clients : Analyse des sentiments à partir des avis clients sur Amazon

Conseils pour maîtriser la PNL

La maîtrise de la PNL nécessite des efforts constants et une approche pratique. J'ai beaucoup appris au cours de mon parcours en PNL, et je souhaiterais partager quelques conseils qui m'ont été utiles tout au long de ce parcours. Une pratique régulière et constante constitue un excellent moyen de continuer à progresser. Cependant, voici quelques conseils essentiels à suivre si vous souhaitez exceller rapidement :

- Veuillez vous entraîner régulièrement : Continuez à vous exercer afin de bien comprendre le large éventail de concepts et de tâches liés à la PNL. De plus, nous vous recommandons d'intégrer des exercices de PNL à votre routine, que ce soit par le biais de défis de codage ou en travaillant sur des ensembles de données textuelles.

- Rejoignez des groupes d'étude ou des forums : J'ai toujours tiré profit des communautés en ligne pour mes projets technologiques. Ils réunissent des débutants, des praticiens des données, des chercheurs et des experts en IA sur une même plateforme. C'est pourquoi il est important de rejoindre des forums afin de trouver des solutions à tous les problèmes liés au NLP.

- Travaillez sur des projets concrets de traitement du langage naturel : Pour vous démarquer, il est nécessaire de transformer des concepts tels que l'intégration de mots et la validation de modèles en logiciels concrets. Lancez vos propres projets ou participez à des initiatives open source afin d'acquérir une expérience pratique et de constituer un portfolio.

- Restez curieux et continuez à apprendre : Étant donné que le NLP évolue rapidement, son avenir semble prometteur. Par conséquent, prenez l'habitude de lire les derniers articles de recherche, de suivre les leaders d'opinion et de suivre des cours avancés afin de rester à la pointe de l'innovation.

Conclusions finales

Peu importe votre profil — que vous soyez diplômé en informatique ou que vous ayez plusieurs années d'expérience, la maîtrise du NLP peut vous permettre d'accéder à des postes spécialisés.

Cependant, il est important de noter que les tâches du TALN sont très variées. Ce qui fonctionne pour un problème peut ne pas fonctionner pour un autre, vous devez donc adapter votre approche en fonction des défis spécifiques et des données impliquées. Et c'est quelque chose que l'on apprend en mettant en pratique les connaissances théoriques.

Pour commencer à apprendre le TALN dès aujourd'hui, veuillez consulter notre cursus de compétences « Traitement automatique du langage naturel en Python ».

Renforcer les compétences en matière d'apprentissage automatique

Questions fréquentes

Le codage est-il nécessaire pour le TALN ?

Oui, le traitement du langage naturel nécessite un certain niveau de codage, mais il n'est pas nécessaire d'être un expert. Une connaissance de base de Python est suffisante pour utiliser les outils et bibliothèques NLP. Vous découvrirez également des concepts issus du machine learning, du deep learning et des statistiques, qui font partie intégrante du TALN.

Quel revenu puis-je obtenir grâce à mes compétences en PNL ?

Selon ZipRecruiter, les professionnels du NLP gagnent en moyenne environ 122 738 dollars par an, en fonction de leur expérience et de leur lieu de travail.

Le NLP relève-t-il de l'IA ou du ML ?

Le NLP est un sous-ensemble de l'IA qui s'appuie fortement sur les techniques d'apprentissage automatique (ML). Il permet aux ordinateurs de comprendre et de traiter le langage humain.

Est-il possible d'apprendre le NLP sans recourir à l'apprentissage automatique ?

Non, l'apprentissage automatique est essentiel pour le traitement automatique du langage naturel. De nombreuses tâches de traitement du langage naturel (NLP) dépendent d'algorithmes d'apprentissage automatique (ML) pour traiter et analyser efficacement les données linguistiques.

Je suis un stratège du contenu qui aime simplifier les sujets complexes. J'ai aidé des entreprises comme Splunk, Hackernoon et Tiiny Host à créer un contenu attrayant et informatif pour leur public.