Lernpfad

Kannst du dir einen Klempner ohne Werkzeugkasten vorstellen? Nein, oder? Das Gleiche gilt für Datenpraktiker. Ohne ihre Datenanalyse-Tools könnten Datenfachleute keine Daten analysieren, visualisieren, aus Daten Wert schöpfen und all die coolen Sachen machen, die sie in ihrer täglichen Arbeit so machen.

Deine Data-Science-Toolbox wird je nach dem Beruf, der dich am meisten interessiert–Datenanalyst, Datenwissenschaftler, Dateningenieur usw. –ein bisschen anders aussehen.

In diesem Artikel zeigen wir dir ein paar der wichtigsten Datenanalyse-Tools, die jeder erfahrene Datenanalyst haben sollte. Im Grunde kümmert sich ein Datenanalyst um:

- Sammeln, Bearbeiten und Auswerten von statistischen Daten, um wichtige Muster zu erkennen.

- Große Datenmengen in brauchbare Formen wie Berichte oder Präsentationen umwandeln und bearbeiten.

- Datenerkenntnisse mit Datenvisualisierungen und Techniken zum Daten-Storytelling rüberbringen.

Jetzt, wo du weißt, was ein Datenanalyst macht, schauen wir uns mal sein Werkzeug an!

Kriterien für die Auswahl eines Datenanalyse-Tools

Die Datenwissenschaft ist eine Branche, die sich schnell weiterentwickelt. Jeden Tag kommen neue Software und Tools raus, auch solche für die Datenanalyse. Bei so einem dynamischen Ökosystem kann es echt schwierig sein, die richtigen Tools zu finden, vor allem wenn du noch nicht so viel Erfahrung mit Data Science hast.

Wie bei jedem Werkzeugkasten gibt's kein Werkzeug, das absolut perfekt ist, um alle Probleme zu lösen, mit denen du als Datenanalyst konfrontiert wirst. Stattdessen ist es wichtig, ein komplettes und ausgewogenes Toolset zu haben, das dir hilft, in jeder Situation erfolgreich zu sein.

Jeder Fall ist anders, und du oder die Firma, für die du arbeitest, müsst ein paar Sachen bedenken, um die beste Lösung für eure Bedürfnisse zu finden. Hier findest du eine Liste von Dingen, die du checken solltest, bevor du dich für ein Datenanalyse-Tool entscheidest:

Geschäftliche Anforderungen erkennen

Das ist wahrscheinlich der wichtigste Punkt. Es ist zwar wichtig, sich zu fragen, welche Tools du lernen möchtest und welche dir am besten gefallen, aber du solltest nie vergessen, dich zu fragen, was dein Unternehmen – oder das Unternehmen, in dem du gerne arbeiten würdest – braucht. Das macht Sinn: Wenn der Rest vom Team Python nutzt, ist es vielleicht nicht die beste Idee, zuerst R zu lernen.

Gleichzeitig solltest du immer die neuesten Trends und modernsten Datentechnologien im Auge behalten, damit du sie lernen und deinen Wert im Team steigern kannst.

Skalierbarkeit und Flexibilität

Die Big-Data-Landschaft hat sich in den letzten Jahren echt stark verändert. Heutzutage arbeiten datengesteuerte Unternehmen mit riesigen Datenmengen in verschiedenen Formaten, die oft fast in Echtzeit verarbeitet werden.

Vor diesem Hintergrund sind Skalierbarkeit und Flexibilität echt wichtig für den Erfolg. Die Datenwissenschaftstechnologie entwickelt sich schnell weiter, mit vielen Tools und Anwendungen, die speziell dafür gemacht sind, die Herausforderungen durch immer mehr Daten, höhere Geschwindigkeiten und größere Variabilität zu meistern. Denk also bei der Auswahl deiner Tools immer daran, wie viel Flexibilität und Skalierbarkeit du oder dein Team braucht.

Einfach zu bedienen und leicht zu lernen

Die Benutzerfreundlichkeit und Komplexität von Datenanalyse-Tools ist ziemlich unterschiedlich. Je mehr Funktionen und erweiterte Möglichkeiten, desto schwieriger ist es, sich zurechtzufinden. Einfachere Datenanalyse-Tools sind dagegen besser für Leute ohne technischen Hintergrund, die damit schnell loslegen können.

DataLab

Überspringe den Installationsprozess und experimentiere mit DataLab, dem KI-gestützten Notizbuch von DataCamp, mit Data Science Code in deinem Browser.

Die 9 besten Tools für die Datenanalyse

Unter Berücksichtigung der oben genannten Punkte gibt's hier die Liste der 9 besten Datenanalyse-Tools für Datenanalysten.

1. Python

Python ist bei den Beliebtheitsrankings für verschiedene Programmiersprachen ganz oben und ein echtes Muss für Datenanalysten. Python ist eine Open-Source-Programmiersprache, die echt vielseitig ist und in der Datenwissenschaft und anderen Bereichen wie Webentwicklung und Videospielentwicklung super nützlich ist. Mehr darüber , wofür Python genutzt wird, kannst du in einem separaten Beitrag lesen.

Python kann jede Aufgabe im Bereich Data Science erledigen. Das liegt vor allem an seinem umfangreichen Ökosystem an Bibliotheken. Mit Tausenden von leistungsstarken Paketen, die von einer riesigen Community unterstützt werden, kann Python alles machen, von der Datenvorverarbeitung, Visualisierung und statistischen Analyse bis hin zum Einsatz von Machine-Learning- und Deep-Learning-Modellen.

Wegen seiner einfachen und übersichtlichen Syntax wird Python oft als eine der am leichtesten zu lernenden Programmiersprachen für Anfänger bezeichnet.

Wenn es aber darum geht, riesige Datenmengen zu verarbeiten, können andere Programmiersprachen und Lösungen wie Julia oder Spark eine bessere Leistung und Effizienz bieten als Python.

Wenn du ein Python-Experte werden willst, hilft dir DataCamp dabei. In unserem Kurskatalog findest du viele Python-Kurse für alle Niveaus. Schau dir unseren Lernpfad „Datenanalyst mit Python “ an und mach dich bereit für deine Python-Lernreise.

2. R-Programmierung

Auch wenn es nicht so angesagt ist wie Python, ist R immer noch eine Top-Option für Datenanalysten. Oft als Hauptkonkurrent von Python gesehen, ist es echt wichtig, eine (oder beide) dieser Sprachen zu lernen, um Datenanalyst zu werden. Schau dir unseren Vergleich zwischen Python und R an, um mehr zu erfahren.

R ist eine Open-Source-Sprache, die speziell für Datenwissenschaft und anspruchsvolle Berechnungen entwickelt wurde. R ist in der Finanzwelt und in der Wissenschaft echt beliebt und eignet sich super für Datenbearbeitung, -verarbeitung, -visualisierung, statistische Berechnungen und maschinelles Lernen.

R hat eine große Community von Nutzern und eine riesige Sammlung von speziellen Bibliotheken für Datenanalyse und maschinelles Lernen. Einige der bekanntesten gehören zur Tidyverse-Familie, einer Sammlung von Data-Science-Paketen. Es enthält dplyr für die Datenbearbeitung und das leistungsstarke ggplot2, die Standardbibliothek für die Datenvisualisierung in R.

Im Vergleich zu Python finden Anfänger R vielleicht schwieriger und weniger vielseitig. Wenn du aber noch nicht so viel mit Datenwissenschaft zu tun hattest oder neue Sprachen lernen willst, ist R genau das Richtige für dich. Schau dir unseren umfangreichen Katalog an R-Kursen an, darunter auch unseren beliebten Einführungskurs in R, um deine Fähigkeiten noch heute zu verbessern. Du kannst auch unseren Lernpfad als Datenanalyst mit R einschlagen.

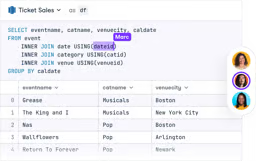

3. SQL

Ein Großteil der Daten auf der Welt wird in Datenbanken gespeichert. SQL (Structured Query Language) ist eine spezielle Sprache, mit der Programmierer mit Datenbanken kommunizieren, sie bearbeiten und Daten daraus holen können. Wenn du Datenanalyst werden willst, musst du unbedingt über fundierte Datenbank- und SQL-Kenntnisse verfügen.

Wenn du SQL kannst, kannst du mit verschiedenen relationalen Datenbanken arbeiten, darunter beliebte Systeme wie SQLite, MySQL und PostgreSQL.

Egal, ob du Python oder R wählst, um deine Karriere als Datenanalyst zu starten, solltest du auch darüber nachdenken, SQL zu lernen. Wegen seiner einfachen Syntax ist SQL im Vergleich zu anderen Sprachen echt leicht zu lernen und wird dir auf deinem Weg echt helfen.

Auch wenn die SQL-Syntax einfach und rudimentär wirkt, kann das Schreiben fortgeschrittener SQL-Abfragen schwierig sein, vor allem bei großen und komplexen Datenbanken.

Willst du mit SQL anfangen? Schau dir unseren Lernpfad zum Datenanalysten in SQL an, um ein Query-Experte zu werden.

4. Julia

Obwohl Julia eine ziemlich junge Sprache ist – sie kam erst 2011 raus –, hat sie die Welt der numerischen Berechnung schon beeindruckt.

Julia ist eine neue und spannende Programmiersprache, die von Grund auf als die perfekte Sprache für wissenschaftliche Berechnungen, maschinelles Lernen und Data Mining entwickelt wurde. Julia schafft das, indem sie die Geschwindigkeit von C, die allgemeine Programmierfähigkeit von Python und die statistischen Fähigkeiten von R vereint.

In den letzten Jahren hat Julia immer mehr an Fahrt gewonnen, weil immer mehr Leute, die mit Daten arbeiten, wegen der tollen Leistung Julia statt Python nehmen. Mehr darüber , wofür Julia genutzt wird, kannst du in unserem separaten Leitfaden nachlesen.

Allerdings ist Julia noch nicht so weit verbreitet wie Sprachen wie Python und R. Die Community ist kleiner und es gibt nicht so viele Bibliotheken wie bei den Hauptkonkurrenten.

DataCamp hat hart daran gearbeitet, seinen Katalog mit neuen Julia-Kursen aufzufrischen. Um mit diesem aufstrebenden Star der Datenwissenschaft loszulegen, check doch mal unseren Skill Track„Julia Fundamentals“ aus.

5. Excel

Microsoft Excel muss man nicht groß vorstellen, weil es jeder kennt. Ein echtes Klassiker-Tool in der Datenanalyse, und viele Experten haben in den letzten Jahrzehnten schon sein Ende vorhergesagt. Die Vorhersagen könnten aber nicht falscher sein. Auch wenn es mittlerweile flexiblere und leistungsstärkere Tools gibt, ist Excel immer noch das Tool der Wahl für viele alltägliche Datenanalyseaufgaben.

Excel hat echt coole Funktionen und eine einfache Benutzeroberfläche, was es super für erfahrene Datenanalysten und Leute macht, die nicht so technisch sind. Dank der reibungslosen Integration in die Microsoft BI-Plattform, einschließlich PowerBI, ist es auch ein super Tool.

Excel ist extra so gemacht, dass es leicht zugänglich und einfach zu benutzen ist. Das hat aber seinen Preis: Excel ist nicht so flexibel wie andere Tools wie Python oder R, und manche komplizierten Vorgänge sind vielleicht nicht so einfach.

Trotzdem ist es echt schlau, Excel zu lernen, weil du als Datenanalyst wahrscheinlich oft mit Excel-Tabellen arbeiten musst. Schau dir mal unseren Katalog an, da findest du Kurse zu diesem Thema, wie zum Beispiel Datenanalyse in Excel, Datenaufbereitung in Excel und Datenvisualisierung in Excel.

Bringe deine Karriere mit Excel voran

Erwerbe die Fähigkeiten, um Excel optimal zu nutzen - keine Erfahrung erforderlich.

6. Spark

Herkömmliche Datenanalyse-Tools wie Python oder R können bei der Verarbeitung riesiger Datensätze schnell an ihre Grenzen stoßen. Man braucht ganz andere Tools, um Datensätze mit Millionen von Zeilen schnell zu verarbeiten, und muss dabei moderne Techniken nutzen, um eine hohe Leistung zu erreichen.

Unter diesen Lösungen ist Apache Spark wahrscheinlich die beliebteste. Spark ist eine Plattform für Cluster-Computing. Mit Spark kannst du Daten und Berechnungen auf Cluster mit mehreren Knoten verteilen (stell dir jeden Knoten wie einen separaten Computer vor). Wenn du deine Daten aufteilst, wird das Arbeiten mit riesigen Datensätzen einfacher, weil jeder Knoten nur mit einer kleinen Datenmenge arbeitet.

Ein wichtiger Punkt bei Spark ist, dass es sich mit anderen Datenanalyse-Tools, wie Python, verbinden lässt. PySpark ist das Python-Paket, das die Magie möglich macht. Diese Integrationen machen es Datenanalysten einfacher, mit Spark loszulegen.

Willst du Spark lernen? Unser Einführungskurs zu PySpark ist ein super Einstieg,

7. Power BI

Power BI ist eine Cloud-basierte Business-Analytics-Lösung, mit der du verschiedene Datenquellen zusammenführen, analysieren und die Ergebnisse über Visualisierungen, Berichte und Dashboards präsentieren kannst.

Laut dem Gartner Magic Quadrant ist Microsofts PowerBI der Branchenführer bei BI-Lösungen. Mit Power BI kannst du ganz einfach auf Daten zugreifen, egal ob du gerade im Büro bist oder unterwegs.

Zu den wichtigsten Funktionen von Power BI gehören:

- Direkte Verbindung zu Excel und einfache Integration mit anderen Microsoft-Produkten

- Die Fähigkeit, Daten zu komprimieren und Erkenntnisse aus großen Datensätzen zu gewinnen

- Anpassbarkeit mit R und Python

- Mit Power Query Daten importieren, filtern und übersetzen

- Eine flexible und benutzerfreundliche Erfahrung.

Aber genau wie bei Excel geht bei Power BI manchmal die Flexibilität zugunsten der Zugänglichkeit drauf. Manche Vorgänge können schwierig sein und die Funktionen in bestimmten Bereichen können eingeschränkt sein. Auch wenn PowerBI eine intuitive Benutzeroberfläche hat, kann es trotzdem kompliziert sein, vor allem wenn man es zusammen mit anderen Tools benutzt, die damit zusammenhängen.

Jeder angehende Datenanalyst sollte mindestens ein BI-Tool gut beherrschen. Power BI ist echt einer der besten Kandidaten. DataCamp hat jede Menge Materialien zu diesem Tool, von unserem Einführungskurs zu Power BI bis hin zu fortgeschritteneren Themen, wie zum Beispiel unserem Kurs zu Berichten in Power BI.

Power BI von Grund auf beherrschen

8. Tableau

Tableau wurde 2003 an der Stanford University gegründet und ist ein leistungsstarkes und beliebtes Tool zur Datenvisualisierung, mit dem du Daten aus mehreren Quellen gleichzeitig analysieren kannst.

Tableau ist echt eines der besten BI-Tools auf dem Markt. Es wird von führenden Unternehmen genutzt, um aus riesigen Mengen an Rohdaten Erkenntnisse zu gewinnen. Dank der intuitiven und leistungsstarken Plattform können sowohl Leute mit als auch ohne technische Kenntnisse visuelle Dashboards und Arbeitsblätter erstellen.

In vielen Punkten hat Tableau die gleichen Funktionen wie Power BI. Für Anfänger ist es aber ein ziemlich kompliziertes Tool. Wenn du also nur einfache Diagramme erstellen willst, solltest du dich für weniger komplexe Optionen entscheiden. Ein großer Nachteil von Tableau ist, dass es keine kostenlose Version gibt, sodass du ein ziemlich teures Abonnement abschließen musst, um es nutzen zu können.

Trotzdem entscheiden sich viele Unternehmen wegen der einzigartigen und leistungsstarken Funktionen für Tableau. Schau dir unseren Kurs „Einführung in Tableau“ und unseren Kurs „Erstellen von Dashboards in Tableau“ an, um dieses tolle Tool kennenzulernen.

Tableau von Grund auf beherrschen

Beschleunige deine Karriere mit Tableau - du brauchst keine Erfahrung.

9. DataLab

Die Arbeit eines Datenanalysten wäre ohne IDEs (Integrated Development Environments) nicht möglich. Diese Programmiertools haben coole, intuitive Oberflächen, die das Schreiben, Debuggen und Testen deines Codes einfacher machen.

Es gibt viele beliebte IDEs wie JupyterLab oder RStudio, aber wir wollen dir unbedingt DataCamps eigenes DataLab vorstellen.

Entwickelt mit dem Ziel der Demokratisierung von Daten, ist DataLab ein super Tool für die Zusammenarbeit im Team und das Lernen in Unternehmen aus verschiedenen Branchen.

Mit dem neuen KI-Assistenten will DataLab die Datenwissenschaft für seine Nutzer noch zugänglicher und produktiver machen. Zu den wichtigsten Funktionen des KI-Assistenten gehört die Schaltfläche „Fehler beheben“, die nicht nur Codefehler korrigiert, sondern auch erklärt, sodass du daraus lernen und Fehler in Zukunft vermeiden kannst.

Mit der Funktion „Code generieren“ kannst du Code basierend auf Abfragen in natürlicher Sprache erstellen und wichtige Fragen zu einem Datensatz beantworten. Außerdem macht der KI-Assistent coole Vorschläge, die auf dem vorhandenen Code und dem Kontext basieren, sodass das Schreiben von Code smarter und effizienter wird.

Der KI-Assistent ist sowohl im kostenlosen als auch im kostenpflichtigen DataLab-Tarif verfügbar und verspricht eine nahtlosere Integration in die Tool-Umgebung moderner Datenwissenschaftler, sodass jeder, der mit Daten arbeitet, fundierte Entscheidungen treffen kann. Du kannst DataLab kostenlos ausprobieren.

10. Google BigQuery

Google BigQuery ist ein komplett verwaltetes, serverloses Data Warehouse, das eine skalierbare Analyse großer Datensätze ermöglicht. Es ist Teil der Google Cloud und wurde für die schnelle Abfrage großer Datenmengen entwickelt.

BigQuery ist super praktisch für Unternehmen, die riesige Datenmengen schnell und effizient analysieren wollen, ohne sich um die Infrastruktur kümmern zu müssen.

BigQuery ist besonders nützlich für Unternehmen, die mit großen Datenmengen arbeiten, vor allem für die, die schon Google Cloud-Dienste nutzen. Allerdings können die Kosten je nach der Menge der verarbeiteten Daten steigen, deshalb ist es wichtig, deine Abfragen effizient zu verwalten, um die Kosten zu optimieren.

Wenn du diese Tools in deinen Werkzeugkasten aufnimmst, kannst du ein breiteres Spektrum an Datenanalyseaufgaben bewältigen, vor allem in speziellen Bereichen oder bei der Verarbeitung großer Datenmengen.

Schau dir unseren Kurs „Einführung in BigQuery“ an, um mehr über dieses tolle Tool zu erfahren.

Zukünftige Trends bei Datenanalyse-Tools

In der Datenwissenschaft geht alles ziemlich schnell. Jeder kleine Innovationsdurchbruch kann die Technologielandschaft komplett verändern. Die Tools und Lösungen, die heute noch total angesagt sind, können morgen schon veraltet sein, wenn neue Technologien mit coolen Funktionen auf den Markt kommen.

Das zeigt sich ganz klar an der KI-Revolution, die nach der Einführung von chatGPT passiert ist. Mit ihren beeindruckenden Fähigkeiten, chatGPT und den vielen anderen generativen KI-Technologien, die auf großen Sprachmodellen basieren, verändert KI gerade schnell, wie Datenwissenschaft und Softwareentwicklung gesehen werden.

Diese Tools werden bald ein wichtiger Teil des Werkzeugkastens von Datenanalysten sein. Deshalb ist es echt wichtig, sie zu lernen. Zum Glück bist du bei DataCamp genau richtig. Wir geben echt alles, um euch erstklassige Kurse und Materialien für die KI-Revolution zu bieten, darunter unseren beliebten Kurs „Generative AI Concepts“ und unseren „AI Essentials Skill Track“.

Abschließende Gedanken

Datenanalyst zu werden ist eine der besten Entscheidungen, die man treffen kann, wenn man sich für Datenwissenschaft interessiert. Das Erlernen der richtigen Datenanalyse-Tools wird ein wichtiger Teil deiner Reise sein. Wir wünschen dir eine gute Reise und hoffen, dass dir unsere Kurse, Tutorials, Spickzettel und anderen Materialien helfen können.

Hier ist eine Liste mit unseren Lernempfehlungen für den Einstieg:

Datenanalyst mit Python

Dieser Lernpfad fängt mit den Grundlagen der Programmiersprache Python für die Datenanalyse an. Nachdem du die Grundlagen kennengelernt hast, wirst du dich näher mit Techniken zum Datenmanagement und zur Datenvisualisierung beschäftigen.

Du lernst auch, wie du Daten aus verschiedenen Quellen wie dem Internet, Datenbanken und JSON-Dateien beschaffen kannst. Schließlich gibt dieser Lernpfad einen Überblick über Techniken zur explorativen Datenanalyse und verbessert die Kenntnisse der Lernenden in relationalen Datenbanken und SQL-Konzepten.

Datenanalyst mit R

Dieser Lernpfad geht auf die wichtigsten Fähigkeiten ein, die Datenanalysten brauchen, die mit der Programmiersprache R arbeiten. Es bietet umfassende Inhalte zu den am häufigsten verwendeten R-Paketen wie tidyverse, ggplot und dplyr.

Genau wie der Python-Lernpfad hilft dir dieser Kurs dabei, ein mittleres Verständnis für die Fähigkeiten eines Datenanalysten zu entwickeln, wie zum Beispiel Datenbeschaffung, -bearbeitung und -visualisierung.

Datenanalyst mit SQL

Dieser Lernpfad hilft den Lernenden, ein tiefes Verständnis von SQL Server, den Konzepten relationaler Datenbanken, deren Design und Leistungsoptimierung zu entwickeln.

FAQs

Wie finde ich die richtige Balance zwischen dem Lernen mehrerer Tools und der Spezialisierung auf ein Tool?

Es ist zwar wichtig, ein breites Verständnis für verschiedene Tools zu haben, aber wenn du dich erst mal darauf konzentrierst, ein oder zwei wichtige Tools wie Python oder SQL richtig zu beherrschen, kannst du dir eine solide Grundlage schaffen. Sobald du diese beherrschst, kannst du deine Fähigkeiten nach und nach erweitern, indem du zusätzliche Tools lernst, die dein Hauptfachwissen ergänzen. Die richtige Balance hängt von deinen Karrierezielen und den spezifischen Anforderungen der Branche oder des Unternehmens ab, in dem du arbeiten möchtest.

Was sollte ich bedenken, wenn ich mich zwischen kostenlosen und kostenpflichtigen Tools für die Datenanalyse entscheide?

Wenn du zwischen kostenlosen und kostenpflichtigen Tools wählst, denk daran, welche Funktionen du brauchst, wie gut das Tool skalierbar ist und wie groß die Datensätze sind, mit denen du arbeiten wirst. Kostenlose Tools wie Python oder R können echt leistungsstark sein, vor allem mit ihren umfangreichen Bibliotheken. Aber kostenpflichtige Tools wie Tableau oder Power BI bieten vielleicht bessere Unterstützung, erweiterte Funktionen und Integrationsmöglichkeiten, die ihre Kosten rechtfertigen, vor allem in einem professionellen Umfeld.

Wie wichtig ist es, immer auf dem Laufenden zu bleiben, was die neuesten Tools und Trends in der Datenanalyse angeht?

Im schnelllebigen Bereich der Datenwissenschaft ist es echt wichtig, immer auf dem Laufenden zu bleiben, was die neuesten Tools und Trends angeht. Neue Tools bieten oft eine bessere Leistung, bessere Integration oder neue Funktionen, die deine Produktivität und die Qualität deiner Analysen deutlich steigern können. Wenn du regelmäßig mit Fachkreisen in Kontakt bleibst, an Webinaren teilnimmst und Auffrischungskurse machst, kannst du deine Fähigkeiten auf dem neuesten Stand halten.

Was sind die typischen Probleme, mit denen Datenanalysten konfrontiert sind, wenn sie neue Tools in ihren Arbeitsablauf integrieren?

Zu den üblichen Herausforderungen gehören Probleme mit der Kompatibilität zu den Tools, die man schon hat, die steile Lernkurve bei neuen Tools und der Widerstand von Teammitgliedern, die an bestimmte Tools gewöhnt sind. Außerdem kann der Wechsel zu einem neuen Tool viel Zeit und Mühe bei der Einrichtung, Datenmigration und Prozessanpassung kosten.

Wie kann ein Datenanalyst seinem Team oder der Geschäftsleitung am besten klar machen, dass neue Tools gebraucht werden?

Um die Notwendigkeit neuer Tools gut rüberzubringen, sollte ein Datenanalyst klar zeigen, wo die aktuellen Tools nicht so gut sind und wie die neuen Tools diese Probleme lösen können. Dazu kann gehören, dass man zeigt, wie viel Zeit man sparen kann, dass die Genauigkeit besser wird, dass die Skalierbarkeit besser ist und welche langfristigen Vorteile das für die Firma hat. Fallstudien oder Beispiele von anderen Firmen können deine Argumentation auch untermauern.

Ich bin freiberufliche Datenanalystin und arbeite mit Unternehmen und Organisationen auf der ganzen Welt an Data-Science-Projekten zusammen. Ich bin auch Ausbilder für Data Science mit mehr als 2 Jahren Erfahrung. Ich schreibe regelmäßig datenwissenschaftliche Artikel in englischer und spanischer Sprache, von denen einige auf etablierten Websites wie DataCamp, Towards Data Science und Analytics Vidhya veröffentlicht wurden. Als Datenwissenschaftlerin mit einem Hintergrund in Politik- und Rechtswissenschaften ist es mein Ziel, an der Schnittstelle von Politik, Recht und Technologie zu arbeiten und die Macht der Ideen zu nutzen, um innovative Lösungen und Erzählungen voranzutreiben, die uns dabei helfen können, dringende Herausforderungen wie die Klimakrise anzugehen. Ich betrachte mich als Autodidakt, der ständig lernt und ein überzeugter Verfechter der Multidisziplinarität ist. Es ist nie zu spät, neue Dinge zu lernen.