Cursus

Pourriez-vous imaginer un plombier sans boîte à outils ? Non, n'est-ce pas ? Il en va de même pour les professionnels des données. Sans leurs outils d'analyse de données, les professionnels des données ne pourraient pas analyser les données, les visualiser, en extraire de la valeur et accomplir les nombreuses tâches intéressantes qu'ils réalisent dans leur travail quotidien.

Votre boîte à outils en science des données variera légèrement en fonction de la carrière qui vous intéresse le plus:analyste de données, scientifique des données, ingénieur de données, etc.

Dans cet article, nous présenterons quelques-uns des outils d'analyse de données indispensables que tout analyste de données expérimenté devrait posséder. En substance, un analyste de données se concentre sur :

- Collecte, traitement et analyse de données statistiques afin d'identifier des tendances significatives.

- Transformer et manipuler de grands ensembles de données pour les rendre exploitables, par exemple sous forme de rapports ou de présentations.

- Communiquer des informations issues des données à l'aide de visualisations et de techniques de narration.

Maintenant que vous comprenez le rôle d'un analyste de données, examinons les outils à sa disposition.

Critères de sélection d'un outil d'analyse de données

La science des données est un secteur en pleine évolution. De nouveaux logiciels et outils, notamment des outils d'analyse de données, sont lancés quotidiennement. Avec un écosystème aussi dynamique, choisir les bons outils peut s'avérer difficile, en particulier si vous êtes novice en science des données.

Comme dans toute boîte à outils, aucun outil n'est idéal en soi pour résoudre tous les problèmes auxquels vous serez confronté en tant qu'analyste de données. Au contraire, la clé réside dans le fait de disposer d'un ensemble complet et équilibré d'outils pour vous aider à réussir dans tous les scénarios.

Chaque cas est unique, et il est important que vous ou l'entreprise pour laquelle vous travaillez preniez en compte plusieurs facteurs afin de trouver la solution la mieux adaptée à vos besoins. Vous trouverez ci-dessous une liste des facteurs à évaluer avant de choisir vos outils d'analyse de données :

Identification des besoins commerciaux

Il s'agit probablement du facteur le plus important. Bien qu'il soit important de vous demander quels outils vous souhaitez apprendre et quels outils vous préférez, vous ne devez jamais oublier de vous interroger sur les besoins de votre entreprise, ou de l'entreprise dans laquelle vous aimeriez travailler. Cela est logique : si le reste de l'équipe utilise Python, apprendre d'abord le langage R n'est peut-être pas la décision la plus judicieuse.

Parallèlement, il est important de rester informé des dernières tendances et des technologies de données de pointe afin de pouvoir les acquérir et accroître votre valeur au sein de l'équipe.

Évolutivité et flexibilité

Le paysage du big data a considérablement évolué au cours des dernières années. De nos jours, les entreprises axées sur les données traitent d'énormes quantités de données dans divers formats, souvent en temps quasi réel.

Dans ce contexte, l'évolutivité et la flexibilité sont essentielles pour réussir. Le domaine des technologies liées à la science des données connaît une croissance rapide, avec de nombreux outils et applications spécialement conçus pour relever les défis liés à l'augmentation du volume, de la vitesse et de la variabilité des données. Par conséquent, lorsque vous choisissez vos outils, veuillez toujours tenir compte du niveau de flexibilité et d'évolutivité dont vous ou votre équipe avez besoin.

Facilité d'utilisation et courbe d'apprentissage

La facilité d'utilisation et la complexité des outils d'analyse de données varient considérablement. Plus il y a de fonctionnalités et de capacités avancées, plus la courbe d'apprentissage est abrupte. En revanche, les outils d'analyse de données plus simples conviennent mieux aux utilisateurs non techniques, qui pourront se familiariser rapidement avec leur utilisation.

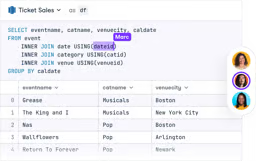

DataLab

Sautez le processus d'installation et expérimentez le code de la science des données dans votre navigateur avec DataLab, le carnet de notes de DataCamp alimenté par l'IA.

Les 9 meilleurs outils d'analyse de données

Compte tenu des facteurs susmentionnés, voici la liste des 9 meilleurs outils d'analyse de données pour les analystes de données.

1. Python

Classé en tête des indices de popularité pour plusieurs langages de programmation, Python est un outil indispensable pour les analystes de données. Python est un langage de programmation open source extrêmement polyvalent qui trouve de nombreuses applications dans le domaine de la science des données et dans d'autres disciplines, telles que le développement web et le développement de jeux vidéo. Vous pouvez en savoir plus sur les utilisations de Python dans un article séparé.

Python est capable d'effectuer toutes les tâches liées à la science des données. Ceci est principalement dû à son riche écosystème de bibliothèques. Grâce à des milliers de packages performants soutenus par une vaste communauté d'utilisateurs, Python est capable d'effectuer toutes sortes d'opérations, du prétraitement des données à la visualisation et à l'analyse statistique, en passant par le déploiement de modèles d'apprentissage automatique et d'apprentissage profond.

En raison de sa syntaxe simple et lisible, Python est souvent considéré comme l'un des langages de programmation les plus faciles à apprendre pour les débutants.

Cependant, lorsqu'il s'agit de traiter des volumes considérables de données, d'autres langages de programmation et solutions, tels que Julia ou Spark, peuvent offrir de meilleures performances et une plus grande efficacité que Python.

Si vous souhaitez devenir un expert en Python, DataCamp est là pour vous aider. Vous trouverez de nombreux cours Python pour tous les niveaux dans notre catalogue de cours. Découvrez notre cursus professionnel d'analyste de données avec Python et préparez-vous à votre apprentissage de Python.

2. Programmation R

Bien qu'il ne soit pas aussi populaire que Python, R reste un choix de premier ordre pour les analystes de données. Souvent présenté comme le principal concurrent de Python, l'apprentissage de l'un de ces deux langages (ou des deux) est une étape essentielle pour devenir analyste de données. Veuillez consulter notre comparaison entre Python et R pour plus de détails.

R est un langage open source spécifique à un domaine, explicitement conçu pour la science des données et le calcul avancé. Très populaire dans les domaines de la finance et de l'enseignement supérieur, R est un langage idéal pour la manipulation, le traitement et la visualisation des données, ainsi que pour le calcul statistique et l'apprentissage automatique.

R dispose d'une importante communauté d'utilisateurs et d'une vaste collection de bibliothèques spécialisées pour l'analyse de données et l'apprentissage automatique. Certains des plus remarquables appartiennent à la famille Tidyverse, une collection de paquets destinés à la science des données. Il comprend dplyr pour la manipulation des données et le puissant ggplot2, la bibliothèque standard pour la visualisation des données dans R.

Par rapport à Python, les débutants peuvent trouver R plus complexe et moins polyvalent. Cependant, si vous débutez dans le domaine de la science des données ou si vous souhaitez enrichir vos compétences linguistiques, l'apprentissage du langage R constitue un choix idéal. Nous vous invitons à consulter notre catalogue complet de cours sur R, notamment notre cours très apprécié « Introduction à R », afin de perfectionner vos compétences dès aujourd'hui. Vous pouvez également suivre notre cursus professionnel d'analyste de données avec R.

3. SQL

Une grande partie des données mondiales est stockée dans des bases de données. SQL (Structured Query Language) est un langage spécifique qui permet aux programmeurs de communiquer avec des bases de données, de les modifier et d'en extraire des données. Une solide connaissance des bases de données et du langage SQL est indispensable si vous souhaitez devenir analyste de données.

La maîtrise du langage SQL vous permettra de travailler avec différentes bases de données relationnelles, y compris des systèmes populaires tels que SQLite, MySQL et PostgreSQL.

Que vous choisissiez Python ou R pour débuter votre parcours d'analyste de données, il est également recommandé d'envisager l'apprentissage du langage SQL. Grâce à sa syntaxe déclarative et simple, le langage SQL est très facile à apprendre par rapport à d'autres langages et vous sera d'une grande utilité tout au long de votre parcours.

Cependant, bien que la syntaxe SQL semble simple et rudimentaire, la rédaction de requêtes SQL avancées peut s'avérer complexe, en particulier lorsqu'il s'agit de bases de données volumineuses et complexes.

Souhaitez-vous vous initier au langage SQL ? Veuillez consulter notre cursus professionnel d'analyste de données en SQL pour devenir un expert en requêtes.

4. Julia

Bien qu'il s'agisse d'un langage relativement récent – il n'a été lancé qu'en 2011 –, Julia a déjà impressionné le monde du calcul numérique.

Julia est un nouveau langage de programmation prometteur, conçu dès le départ pour être le langage idéal pour le calcul scientifique, l'apprentissage automatique et l'exploration de données. Julia atteint cet objectif en combinant la rapidité de C, les capacités de programmation générales de Python et les prouesses statistiques de R.

Ces dernières années, Julia a connu une croissance constante, de plus en plus de professionnels des données choisissant Julia plutôt que Python en raison de ses performances remarquables. Vous pouvez en savoir plus sur les utilisations de Julia dans notre guide dédié.

Cependant, Julia n'est pas encore aussi largement adopté que des langages tels que Python et R. Sa communauté est plus restreinte et il ne dispose pas d'autant de bibliothèques que ses principaux concurrents.

DataCamp s'est efforcé de mettre à jour son catalogue avec de nouveaux cours Julia. Pour vous initier à cette discipline émergente de la science des données, veuillez consulter notre cursus de compétencesJulia Fundamentals.

5. Excel

Microsoft Excel n'a pas besoin d'être présenté, car il est connu de tous. Outil classique dans l'analyse des données, de nombreux experts ont prédit sa disparition au cours des dernières décennies. Cependant, les prévisions ne pouvaient être plus erronées. Malgré l'émergence d'outils plus flexibles et plus puissants, Excel reste l'outil de référence pour de nombreuses tâches quotidiennes d'analyse de données.

Excel combine des fonctionnalités puissantes avec une interface conviviale, ce qui le rend idéal pour les analystes de données expérimentés et les utilisateurs moins techniques. Il s'agit également d'un outil remarquable grâce à son intégration fluide avec la suite Microsoft BI, y compris PowerBI.

Excel est spécialement conçu pour être accessible et facile à utiliser. Cependant, cela a un coût : Excel n'est pas aussi flexible que d'autres outils tels que Python ou R, et certaines opérations complexes peuvent s'avérer moins simples.

Cependant, apprendre à utiliser Excel est un choix judicieux, car il est fort probable qu'une partie de votre travail en tant qu'analyste de données implique de manipuler des feuilles de calcul Excel. Nous vous invitons à consulter notre catalogue, où vous trouverez des cours sur ce sujet, tels que « Analyse de données dans Excel », « Préparation de données dans Excel » et « Visualisation de données dans Excel ».

Faites progresser votre carrière avec Excel

Acquérir les compétences nécessaires pour optimiser Excel - aucune expérience n'est requise.

6. Spark

Les outils d'analyse de données conventionnels, tels que Python ou R, peuvent s'avérer insuffisants lorsqu'il s'agit de traiter des ensembles de données volumineux. Un ensemble d'outils distinct est nécessaire pour traiter à grande vitesse des ensembles de données comportant des millions de lignes, en intégrant des techniques avancées afin d'offrir des performances élevées.

Parmi ces solutions, Apache Spark est probablement la plus répandue. Spark est une plateforme destinée au calcul distribué. Spark vous permet de répartir les données et les calculs sur des clusters comportant plusieurs nœuds (considérez chaque nœud comme un ordinateur distinct). Le fractionnement de vos données facilite le traitement de très grands ensembles de données, car chaque nœud ne traite qu'une petite quantité de données.

L'un des aspects clés de Spark réside dans son intégration avec d'autres outils d'analyse de données, notamment Python. PySpark est le package Python qui rend cela possible. Ces intégrations facilitent la prise en main de Spark par les analystes de données.

Souhaitez-vous apprendre Spark ? Notre cours d'introduction à PySpark constitue un excellent point de départ.

7. Power BI

Power BI est une solution d'analyse commerciale basée sur le cloud qui vous permet de combiner différentes sources de données, de les analyser et de présenter les résultats de ces analyses sous forme de visualisations, de rapports et de tableaux de bord.

Selon le Magic Quadrant de Gartner, PowerBI de Microsoft est le leader du secteur des solutions BI. Power BI facilite l'accès aux données sur presque tous les appareils, tant à l'intérieur qu'à l'extérieur de l'organisation.

Parmi ses fonctionnalités essentielles, Power BI comprend :

- Connexion directe à Excel et intégration aisée avec d'autres produits Microsoft

- Capacité à compresser des données et à extraire des informations pertinentes à partir de grands ensembles de données

- Personnalisation à l'aide de R et Python

- Utilisation de Power Query pour importer, filtrer et traduire des données

- Une expérience utilisateur adaptative et conviviale.

Cependant, comme pour Excel, Power BI privilégie parfois l'accessibilité au détriment de la flexibilité. Certaines opérations peuvent s'avérer difficiles à réaliser et les fonctionnalités dans certains domaines peuvent être limitées. De même, malgré son interface intuitive, PowerBI peut s'avérer complexe, en particulier lorsqu'il est utilisé avec d'autres outils interdépendants.

Tout aspirant analyste de données devrait maîtriser au moins un outil BI. Power BI est sans aucun doute l'un des meilleurs candidats. DataCamp propose de nombreux supports sur cet outil, allant de notre cours d'introduction à Power BI à des sujets plus avancés, tels que notre cours sur les rapports dans Power BI.

Maîtriser Power BI de A à Z

8. Tableau

Fondé en 2003 à l'université de Stanford, Tableau est un outil de visualisation de données puissant et très apprécié qui permet d'analyser simultanément des données provenant de plusieurs sources.

Tableau est l'un des meilleurs outils BI de sa catégorie. Il est utilisé par les grandes entreprises pour extraire des informations pertinentes à partir d'énormes quantités de données brutes. Grâce à sa plateforme intuitive et performante, les utilisateurs, qu'ils soient techniciens ou non, peuvent créer des tableaux de bord et des feuilles de calcul visuels.

À bien des égards, Tableau offre les mêmes fonctionnalités que Power BI. Cependant, cet outil est considéré comme plus complexe pour les débutants. Par conséquent, si vous souhaitez simplement créer des graphiques simples, il est conseillé de choisir des options moins complexes. De plus, un inconvénient majeur de Tableau est qu'il n'existe pas de version gratuite. Il est donc nécessaire de souscrire à un abonnement assez coûteux pour pouvoir l'utiliser.

Néanmoins, de nombreuses organisations choisissent Tableau pour ses fonctionnalités uniques et performantes. Nous vous invitons à consulter notre cours « Introduction à Tableau » et notre cours « Création d'un tableau de bord dans Tableau » pour découvrir cet outil remarquable.

Maîtriser Tableau de A à Z

Accélérez votre carrière avec Tableau - aucune expérience n'est requise.

9. DataLab

Le travail d'un analyste de données ne serait pas possible sans les IDE (environnements de développement intégrés). Ces outils de codage offrent des interfaces puissantes et intuitives qui facilitent l'écriture, le débogage et le test de votre code.

Il existe de nombreux IDE populaires, tels que JupyterLab ou RStudio, mais nous souhaitons profiter de cette occasion pour vous présenter DataLab, le propre IDE de DataCamp.

Conçu dans une optique de démocratisation des données, DataLab est un outil précieux pour la collaboration en équipe et l'apprentissage organisationnel dans divers secteurs.

Avec le nouvel assistant IA, DataLab vise à rendre la science des données encore plus accessible et productive pour ses utilisateurs. Parmi les principales fonctionnalités de l'assistant IA, on trouve le bouton « Corriger l'erreur », qui non seulement corrige les erreurs de code, mais les explique également, permettant ainsi aux utilisateurs d'apprendre et d'éviter de répéter les mêmes erreurs.

La fonctionnalité « Générer du code » vous permet de générer du code à partir de requêtes en langage naturel et de répondre à des questions clés concernant un ensemble de données. De plus, l'assistant IA fournit des suggestions intelligentes basées sur le code existant et le contexte, rendant ainsi l'écriture de code plus intelligente et plus efficace.

Disponible dans les formules gratuites et payantes de DataLab, l'assistant IA promet une intégration plus fluide dans l'ensemble des outils utilisés par les data scientists modernes, permettant ainsi à toute personne travaillant avec des données de prendre des décisions éclairées. Vous pouvez commencer à utiliser DataLab gratuitement.

10. Google BigQuery

Google BigQuery est un entrepôt de données entièrement géré et sans serveur qui permet l'analyse évolutive de grands ensembles de données. Il fait partie de la plateforme Google Cloud et est conçu pour permettre l'interrogation à grande vitesse de volumes importants de données.

BigQuery est particulièrement utile pour les organisations qui analysent rapidement et efficacement des ensembles de données volumineux sans avoir à gérer l'infrastructure sous-jacente.

BigQuery est particulièrement utile pour les entreprises qui traitent des analyses de données à grande échelle, notamment celles qui utilisent déjà les services Google Cloud. Cependant, les coûts peuvent s'accumuler en fonction de la quantité de données traitées. Il est donc essentiel de gérer efficacement vos requêtes afin d'optimiser les coûts.

L'ajout de ces outils à votre boîte à outils peut vous aider à accomplir un plus large éventail de tâches d'analyse de données, en particulier dans des domaines spécialisés ou lors du traitement de données à grande échelle.

Veuillez consulter notre cours Introduction à BigQuery pour en savoir plus sur cet outil remarquable.

Tendances futures des outils d'analyse de données

Tout évolue rapidement dans le secteur de la science des données. Toute petite avancée en matière d'innovation peut transformer radicalement le paysage technologique. Les outils et les solutions qui semblent courants aujourd'hui peuvent devenir obsolètes demain, à mesure que de nouvelles technologies dotées de capacités innovantes et puissantes arrivent sur le marché.

La révolution de l'IA qui a suivi le lancement de chatGPT en est une illustration claire. Grâce à leurs capacités impressionnantes, chatGPT et les nombreuses autres technologies d'IA générative alimentées par de grands modèles linguistiques, l'IA transforme rapidement la manière dont la science des données et le développement logiciel sont envisagés.

Ces outils deviendront bientôt indispensables dans la boîte à outils de l'analyste de données. Il est donc essentiel de les apprendre. Heureusement, DataCamp est là pour vous aider. Nous nous efforçons de vous proposer les meilleurs cours et supports pédagogiques pour vous aider à appréhender la révolution de l'IA, notamment notre courstrès apprécié sur les concepts de l'IA générativeet notre cursus de compétences « AI Essentials ».

Conclusions finales

Devenir analyste de données est l'une des meilleures décisions que toute personne intéressée par la science des données puisse prendre. L'apprentissage des outils d'analyse de données appropriés constituera un élément central de votre parcours. Nous vous souhaitons un excellent voyage et espérons que nos cours, tutoriels, aide-mémoire et autres ressources vous seront utiles.

Voici une liste de nos recommandations d'apprentissage pour débuter :

Analyste de données avec Python

Ce cursus commence par les bases du langage de programmation Python pour l'analyse de données. Après avoir abordé les notions fondamentales, vous approfondirez vos connaissances en matière de traitement et de visualisation des données.

Vous apprendrez également à collecter des données provenant de différentes sources telles que le Web, des bases de données et des fichiers JSON. Enfin, ce cursus offre une vue d'ensemble des techniques d'analyse exploratoire des données et permet à l'apprenant d'approfondir ses connaissances en matière de bases de données relationnelles et de concepts SQL.

Analyste de données avec R

Ce cursus se concentre sur les compétences principales requises pour les analystes de données travaillant avec le langage de programmation R. Il propose un contenu complet couvrant les packages R les plus couramment utilisés, tels que tidyverse, ggplot et dplyr.

Tout comme le cursus Python, ce cours permet d'acquérir des connaissances intermédiaires en matière d'analyse de données, telles que la recherche, la manipulation et la visualisation de données.

Analyste de données avec SQL

Ce cursus professionnel permet à l'apprenant d'acquérir une compréhension approfondie de SQL Server, des concepts des bases de données relationnelles, de leur conception et de l'optimisation des performances.

Questions fréquentes

Comment puis-je déterminer le juste équilibre entre l'apprentissage de plusieurs outils et la spécialisation dans un seul ?

Bien qu'il soit essentiel d'avoir une compréhension générale des différents outils, il est recommandé de se concentrer d'abord sur la maîtrise d'un ou deux outils clés, tels que Python ou SQL, afin d'acquérir des bases solides. Une fois que vous maîtriserez ces outils, vous pourrez progressivement élargir vos compétences en apprenant à utiliser d'autres outils qui complètent votre expertise principale. Le juste équilibre dépend de vos objectifs de carrière et des besoins spécifiques du secteur ou de l'entreprise dans lequel vous souhaitez travailler.

Quels sont les éléments à prendre en considération lorsque l'on doit choisir entre des outils gratuits et des outils payants pour l'analyse de données ?

Lorsque vous choisissez entre des outils gratuits et payants, veuillez prendre en considération les fonctionnalités spécifiques dont vous avez besoin, l'évolutivité de l'outil et la taille des ensembles de données avec lesquels vous travaillerez. Les outils gratuits tels que Python ou R peuvent être très performants, notamment grâce à leurs bibliothèques étendues. Cependant, les outils payants tels que Tableau ou Power BI peuvent offrir une meilleure assistance, des fonctionnalités avancées et des capacités d'intégration qui justifient leur coût, en particulier dans un contexte professionnel.

Dans quelle mesure est-il important de se tenir informé des derniers outils et tendances en matière d'analyse de données ?

Il est essentiel de se tenir informé des derniers outils et tendances dans le domaine en constante évolution de la science des données. Les nouveaux outils offrent souvent des performances améliorées, une meilleure intégration ou de nouvelles fonctionnalités qui peuvent considérablement améliorer votre productivité et la qualité de vos analyses. Participer régulièrement à des communautés professionnelles, assister à des webinaires et suivre des cours de remise à niveau peut vous aider à maintenir vos compétences à jour.

Quels sont les défis courants auxquels sont confrontés les analystes de données lorsqu'ils intègrent de nouveaux outils dans leur flux de travail ?

Les défis courants incluent les problèmes de compatibilité avec les outils existants, la courbe d'apprentissage abrupte associée aux nouveaux outils et la résistance des membres de l'équipe habitués à utiliser certains outils. De plus, la transition vers un nouvel outil peut nécessiter un investissement important en termes de temps et d'efforts pour la configuration, la migration des données et l'ajustement des processus.

Comment un analyste de données peut-il communiquer efficacement la nécessité d'adopter de nouveaux outils à son équipe ou à la direction ?

Afin de communiquer efficacement la nécessité de nouveaux outils, un analyste de données devrait présenter un argumentaire clair qui souligne les limites des outils actuels et explique comment les nouveaux outils peuvent combler ces lacunes. Cela peut inclure la démonstration des gains de temps potentiels, d'une précision accrue, d'une meilleure évolutivité et des avantages à long terme pour l'entreprise. Fournir des études de cas ou des exemples provenant d'autres entreprises peut également renforcer votre argumentation.

Je suis analyste de données indépendant et je collabore avec des entreprises et des organisations du monde entier dans le cadre de projets de science des données. Je suis également formateur en science des données avec plus de 2 ans d'expérience. Je rédige régulièrement des articles sur les sciences des données en anglais et en espagnol, dont certains ont été publiés sur des sites web réputés tels que DataCamp, Towards Data Science et Analytics Vidhya En tant que scientifique des données ayant une formation en sciences politiques et en droit, mon objectif est de travailler à l'interaction des politiques publiques, du droit et de la technologie, en tirant parti du pouvoir des idées pour faire avancer des solutions et des récits innovants qui peuvent nous aider à relever des défis urgents, à savoir la crise climatique. Je me considère comme un autodidacte, un apprenant permanent et un fervent partisan de la pluridisciplinarité. Il n'est jamais trop tard pour apprendre de nouvelles choses.