Kurs

In Zusammenarbeit mit mehreren akademischen Forschern und Non-Profit-Organisationen hat das 2019 gegründete Startup Stability AI das Modell Stable Diffusion entwickelt, das 2022 erstmals veröffentlicht wurde.

Stable Diffusion ist ein Open-Source-Deep-Learning-Modell, das entwickelt wurde, um aus Textbeschreibungen hochwertige, detaillierte Bilder zu generieren. Es kann auch bestehende Bilder verändern oder Bilder mit niedriger Auflösung durch Texteingaben verbessern. Das Modell hat sich ständig weiterentwickelt und die neuesten Entwicklungen haben seine Leistung und Fähigkeiten verbessert.

In diesem Artikel erfahren wir, wie Stable Diffusion funktioniert und welche Methoden es gibt, um es auszuführen.

Was ist Stabile Diffusion?

Stable Diffusion ist ein fortschrittliches, quelloffenes Deep-Learning-Modell, das von Stability AI entwickelt wurde. Es wurde 2022 veröffentlicht und zeichnet sich dadurch aus, dass es aus Textbeschreibungen qualitativ hochwertige und detaillierte Bilder erzeugt. Dieses vielseitige Modell kann bestehende Bilder verändern oder Bilder mit niedriger Auflösung durch Texteingaben verbessern.

Stable Diffusion wurde zunächst auf einem riesigen Datensatz von 2,3 Milliarden Bildern trainiert und nutzt die Prinzipien der generativen Modellierung und der Diffusionsprozesse. So kann es neue, realistische Bilder erstellen, indem es Muster und Strukturen aus den Trainingsdaten lernt. Seine Fähigkeiten sind mit denen anderer moderner Modelle vergleichbar und machen es zu einem leistungsstarken Werkzeug für eine breite Palette von Anwendungen in der Bilderzeugung und -bearbeitung.

Im Februar 2024 kündigte Stability AI Stable Diffusion 3 in einer frühen Vorschau an, die eine stark verbesserte Leistung zeigte, insbesondere bei der Handhabung von Aufforderungen mit mehreren Themen, der Bildqualität und der Rechtschreibung. Die Stable Diffusion 3 Suite reicht von 800 Millionen bis zu 8 Milliarden Parametern und legt Wert auf Skalierbarkeit und Qualität, um verschiedene kreative Anforderungen zu erfüllen. Im Juni 2024 wurde mit der Veröffentlichung von Stable Diffusion 3 Medium, einem Modell mit 2 Milliarden Parametern, ein bedeutender Fortschritt erzielt, der außergewöhnliche Details, Farben und Fotorealismus bietet und gleichzeitig effizient auf Standard-GPUs läuft.

Stable Diffusion 3 beinhaltet eine neue Multimodal Diffusion Transformer (MMDiT)-Architektur, die getrennte Gewichtungen für Bild- und Sprachrepräsentationen verwendet. Diese Innovation verbessert das Textverständnis und die Rechtschreibfähigkeiten im Vergleich zu früheren Versionen des Modells. Basierend auf der Auswertung menschlicher Präferenzen übertrifft Stable Diffusion 3 andere führende Text-zu-Bild-Generierungssysteme wie DALL-E 3, Midjourney v6 und Ideogram v1 in Bezug auf Typografie und Prompt-Adhärenz.

Stability AI hat ein umfassendes Forschungspapier veröffentlicht, das die zugrunde liegende Technologie von Stable Diffusion 3 detailliert beschreibt und seine Fortschritte und überlegene Leistung hervorhebt. Diese Verbesserungen machen Stable Diffusion 3 zu einem leistungsstarken Werkzeug für die Erstellung von qualitativ hochwertigen Bildern aus Textbeschreibungen, mit bemerkenswerten Verbesserungen im Umgang mit komplexen Aufforderungen und realistischen Ergebnissen.

Wie funktioniert die stabile Diffusion?

Stable Diffusion ist ein anspruchsvolles Beispiel für eine Klasse von Deep Learning-Modellen, die als Diffusionsmodelle bekannt sind. Genauer gesagt, fällt es unter die Kategorie der generativen Modelle. Diese Modelle sind so konzipiert, dass sie neue Daten generieren, die den Daten, auf denen sie trainiert wurden, ähnlich sind. So können sie neue, realistische Ergebnisse auf der Grundlage gelernter Muster und Strukturen erzeugen.

Diffusionsmodelle orientieren sich an dem Konzept der Diffusion in der Physik, bei dem sich Partikel im Laufe der Zeit von Bereichen mit hoher Konzentration in Bereiche mit niedriger Konzentration ausbreiten. Im Kontext des Deep Learning simulieren Diffusionsmodelle diesen Prozess in einem hochdimensionalen Datenraum. Das Modell beginnt mit zufälligem Rauschen und verfeinert dieses Rauschen iterativ durch eine Reihe von Schritten, um kohärente und hochwertige Bilder zu erzeugen.

Bei der generativen Modellierung, einer Art des unüberwachten Lernens, werden Modelle trainiert, um die Muster in den Eingabedaten automatisch zu entdecken und zu lernen. Einmal trainiert, können diese Modelle neue Beispiele erzeugen, die den ursprünglichen Daten ähneln. Diese Fähigkeit macht generative Modelle besonders nützlich für Aufgaben wie die Bildsynthese, die Datenerweiterung und mehr.

Wenn du mehr über diese Modelle erfahren möchtest, solltest du unseren Kurs Deep Learning in Python besuchen.

Der Diffusionsprozess

Der Diffusionsprozess bei Stable Diffusion umfasst zwei Hauptphasen: den Vorwärtsdiffusionsprozess und den Rückwärtsentrauschungsprozess.

1. Vorwärtsdiffusionsprozess:

In dieser Phase wird den Trainingsdaten (Bildern) in mehreren Schritten Rauschen hinzugefügt, bis die Bilder zu reinem Rauschen werden. Dieser Prozess ist mathematisch so konzipiert, dass er umkehrbar ist.

2. Umgekehrter Entrauschungsprozess:

In dieser Phase lernt das Modell, den Prozess der Lärmaddition umzukehren. Ausgehend von zufälligem Rauschen entrauscht das Modell das Bild iterativ in mehreren Schritten und rekonstruiert so nach und nach ein kohärentes und hochwertiges Bild. Dieser umgekehrte Prozess orientiert sich an den Mustern und Strukturen, die aus den Trainingsdaten gelernt wurden.

Multimodaler Diffusionstransformator (MMDiT) Architektur

Stable Diffusion 3 führt eine neue Architektur ein, den sogenannten Multimodal Diffusion Transformer (MMDiT). Diese Architektur verwendet getrennte Gewichtungen für Bild- und Sprachrepräsentationen, um die Fähigkeit des Modells zu verbessern, textbasierte Aufforderungen zu verstehen und zu generieren. Durch die Verwendung unterschiedlicher Pfade für die Verarbeitung von Bildern und Textinformationen verbessert MMDiT die Kohärenz und Genauigkeit der erzeugten Bilder, insbesondere bei der Verarbeitung komplexer Aufforderungen und Typografie.

Stabile Diffusion Praktische Anwendungen

Stabile Diffusion kann für eine Vielzahl von praktischen Anwendungen genutzt werden, z. B:

- Bilderzeugung: Erstellen neuer Bilder aus Textbeschreibungen.

- Bildbearbeitung: Ändern vorhandener Bilder auf der Grundlage von Textanweisungen.

- Bildverbesserung: Verbessere die Qualität von Bildern mit niedriger Auflösung.

Diese Fähigkeiten machen Stable Diffusion zu einem leistungsstarken Werkzeug für Künstler, Designer, Forscher und alle, die das Potenzial der generativen KI erforschen wollen.

KI-Upskilling für Einsteiger

Wie man Stabile Diffusion online betreibt

Wenn du das Stabile Diffusionsmodell sofort einsetzen möchtest, kannst du es mit den folgenden Tools online ausführen.

1. DreamStudio

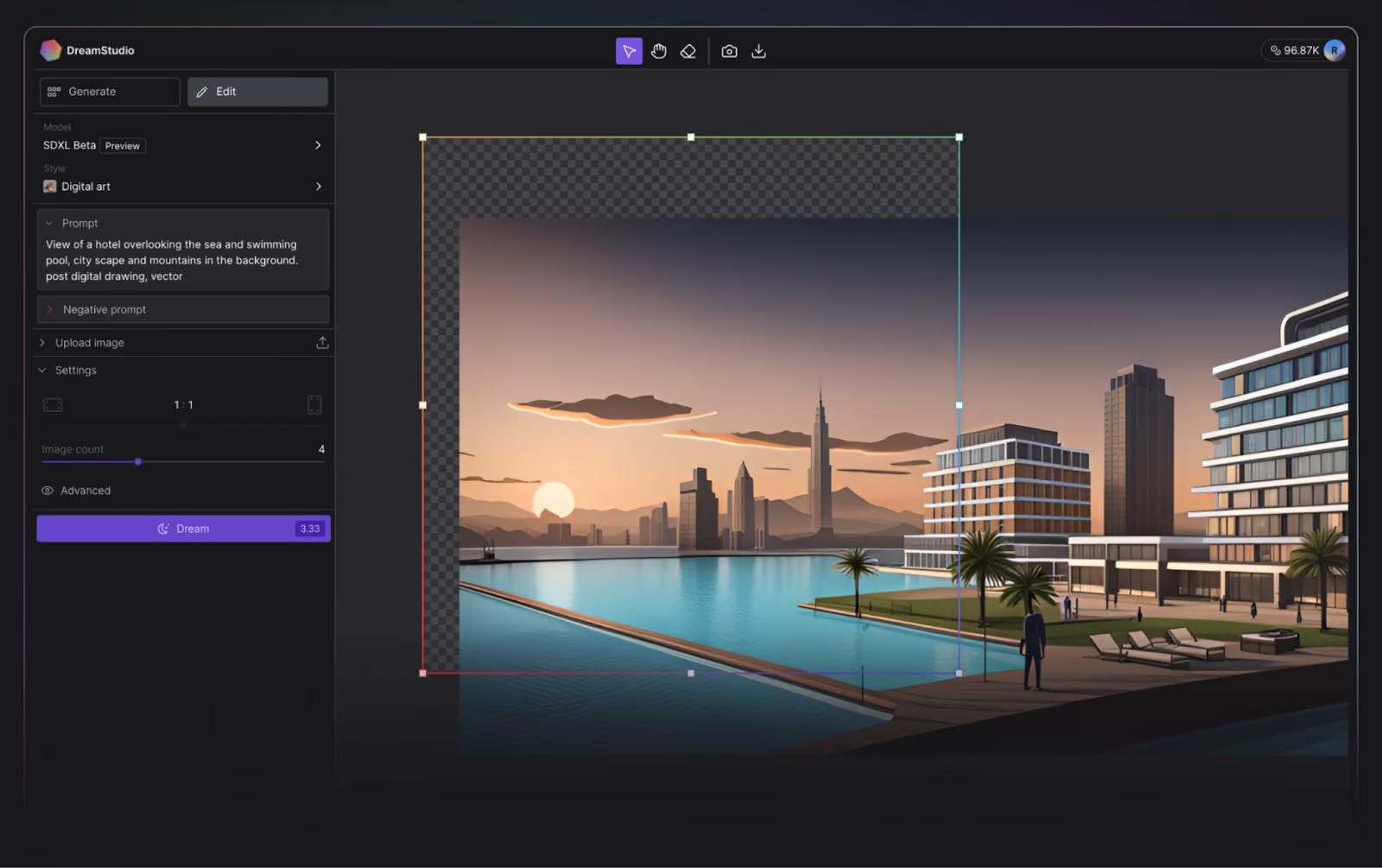

Stability AI, die Macher von Stable Diffusion, haben es Neugierigen mit ihrem Online-Tool DreamStudio extrem einfach gemacht, ihr Text-zu-Bild-Modell zu testen.

DreamStudio gewährt den Nutzern Zugang zur neuesten Version der Stable Diffusion Modelle und ermöglicht es ihnen, ein Bild in bis zu 15 Sekunden zu erstellen.

DreamStudio Benutzeroberfläche. Bildquelle: DreamStudio.

Wenn du dieses Tutorial schreibst, erhalten neue Benutzer 100 kostenlose Credits, um DreamStudio auszuprobieren. Das reicht für 500 Bilder mit den Standardeinstellungen! Zusätzliche Credits können innerhalb der Anwendung erworben werden und kosten nur $10,00 pro 1000 Credits.

2. Umarmendes Gesicht

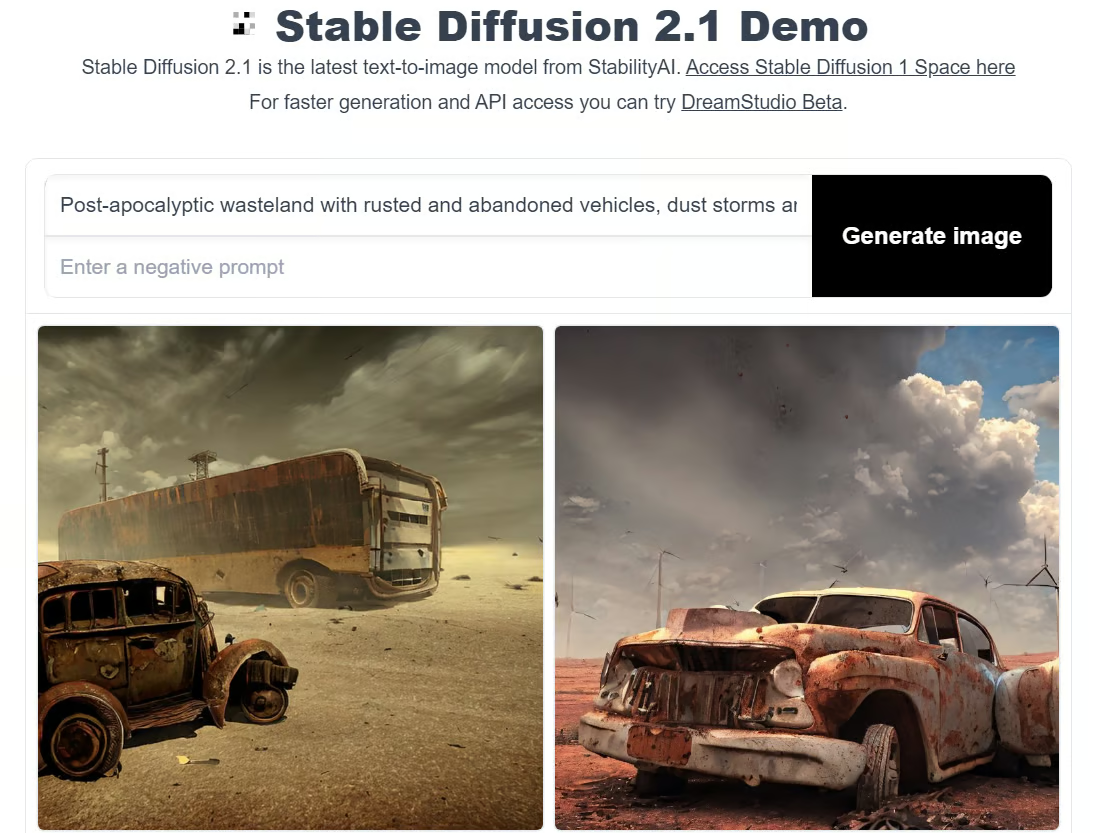

Hugging Face ist eine KI-Community und Plattform, die Open-Source-Beiträge fördert. Obwohl Hugging Face vor allem für seine Transformer-Modelle bekannt ist, bietet es auch Zugriff auf das neueste Stable-Diffusionsmodell, und wie es sich für einen echten Open-Source-Liebhaber gehört, ist es kostenlos.

Um die stabile Diffusion in Hugging Face auszuführen, kannst du eine der Demos ausprobieren, z. B. die Demo Stable Diffusion 2.1.

Der Nachteil von Hugging Face ist, dass du die Eigenschaften nicht wie in DreamStudio anpassen kannst und dass es deutlich länger dauert, ein Bild zu erstellen.

Stabile Diffusionsdemo im umarmenden Gesicht. Bild vom Autor.

Wie man stabile Diffusion lokal betreibt

Was aber, wenn du mit Stable Diffusion auf deinem lokalen Computer experimentieren möchtest? Wir haben das Richtige für dich.

Wenn du Stable Diffusion lokal ausführst, kannst du mit verschiedenen Texteingaben experimentieren, um Bilder zu erzeugen, die besser auf deine Anforderungen zugeschnitten sind. Du kannst das Modell auch auf deine Daten abstimmen, um die Ergebnisse anhand der von dir bereitgestellten Eingaben zu verbessern.

Haftungsausschluss: Du musst einen Grafikprozessor haben, um Stable Diffusion lokal zu betreiben.

Schritt 1: Python und Git installieren

Um Stable Diffusion auf deinem lokalen Computer auszuführen, benötigst du Python 3.10.6. Diese kann von der offiziellen Python-Website installiert werden. Wenn du nicht weiterkommst, sieh dir unser Tutorial zur Installation von Python an.

Überprüfe, ob die Installation richtig funktioniert hat, indem du die Eingabeaufforderung öffnest, python eingibst und den Befehl ausführst. Dies sollte die Version von Python ausgeben, die du verwendest.

Haftungsausschluss: Die empfohlene Version für die Ausführung von Stable Diffusion ist Python 3.10.6. Wir empfehlen, nicht ohne diese Version fortzufahren, um Probleme zu vermeiden.

Als nächstes musst du das Code-Repository-Management-System Git installieren. Das Git-Installationstutorial kann dir dabei helfen, und unser Kurs Einführung in Git kann dein Wissen über Git vertiefen.

Schritt 2: Erstelle ein GitHub- und Hugging Face-Konto

GitHub ist ein Hosting-Dienst für die Softwareentwicklung, bei dem Entwickler ihren Code hosten, damit sie Projekte verfolgen und mit anderen Entwicklern zusammenarbeiten können. Wenn du noch keinen Github-Account hast, ist jetzt auch ein guter Zeitpunkt, einen zu erstellen - schau dir Github und Git Tutorial for Beginners an, um Hilfe zu bekommen.

Hugging Face hingegen ist eine KI-Community, die sich für Open-Source-Beiträge einsetzt. Sie ist die Drehscheibe für verschiedene KI-Modelle aus unterschiedlichen Bereichen, darunter natürliche Sprachverarbeitung, Computer Vision und mehr. Du brauchst ein Konto, um die neueste Version von Stable Diffusion herunterzuladen. Zu diesem Schritt kommen wir später.

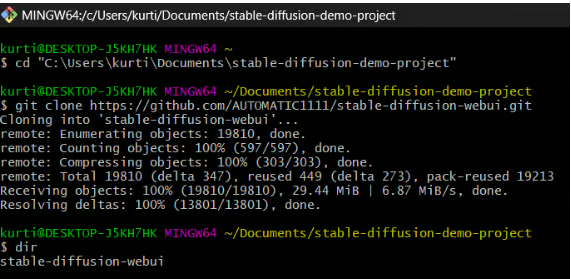

Schritt 3: Stabile Diffusion Web-UI klonen

In diesem Schritt lädst du die Stable Diffusion Web-UI auf deinen lokalen Computer herunter. Es ist zwar hilfreich, einen eigenen Ordner (z. B. stable-diffusion-demo-project) für diesen Zweck anzulegen, aber nicht zwingend notwendig.

1. Öffne die Git Bash:

- Stelle sicher, dass du Git Bash auf deinem Computer installiert hast.

2. Navigiere zu deinem gewünschten Ordner:

- Öffne Git Bash und benutze den Befehl

cd, um zu dem Ordner zu navigieren, in den du die Stable Diffusion Web-UI klonen willst. Zum Beispiel:

cd path/to/your/folder3. Klone das Repository:

- Führe den folgenden Befehl aus, um das Stable Diffusion Web-UI Repository zu klonen:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

4. Überprüfe den Klon:

- Wenn der Befehl erfolgreich ausgeführt wird, solltest du einen neuen Ordner mit dem Namen

stable-diffusion-webuiin deinem gewählten Verzeichnis sehen.

Hinweis: Genauere Anweisungen für deine Hardware und dein Betriebssystem findest du im Github-Repository der Stable Diffusion Web UI.

Schritt 4: Lade das neueste Stable Diffusion Modell herunter

1. Melde dich bei Hugging Face an:

- Greife auf dein Hugging Face-Konto zu.

2. Lade das Modell der stabilen Diffusion herunter:

- Suche das gewünschte Stable Diffusion Modell und lade es von Hugging Face herunter. Diese Dateien sind groß, daher kann der Download ein paar Minuten dauern.

3. Finde den Modellordner:

- Navigiere zu dem folgenden Ordner auf deinem Computer:

stable-diffusion-webui\models\Stable-diffusion

4. Verschiebe das heruntergeladene Modell:

- Im Ordner

Stable-diffusionfindest du eine Textdatei namensPut Stable Diffusion Checkpoints here. - Verschiebe die heruntergeladene Datei des Stabilen Diffusionsmodells in diesen Ordner.

Schritt 5: Einrichten der Stable Diffusion Web UI

In diesem Schritt installierst du die notwendigen Tools, um Stable Diffusion zu starten.

1. Öffne die Eingabeaufforderung oder das Terminal.

2. Navigiere zum Ordner "Stable Diffusion web UI":

- Verwende den Befehl

cd, um zu dem Ordnerstable-diffusion-webuizu navigieren, den du zuvor geklont hast. Zum Beispiel:

cd path/to/stable-diffusion-webui3. Führe das Setup-Skript aus:

- Sobald du dich im Ordner

stable-diffusion-webuibefindest, führe den folgenden Befehl aus:

webui-user.batDieses Skript erstellt eine virtuelle Umgebung und installiert alle erforderlichen Abhängigkeiten für die Ausführung von Stable Diffusion. Der Vorgang kann etwa 10 Minuten dauern, also sei geduldig.

Hinweis: Genauere Anweisungen für deine Hardware und dein Betriebssystem findest du im Github-Repository der Stable Diffusion Web UI.

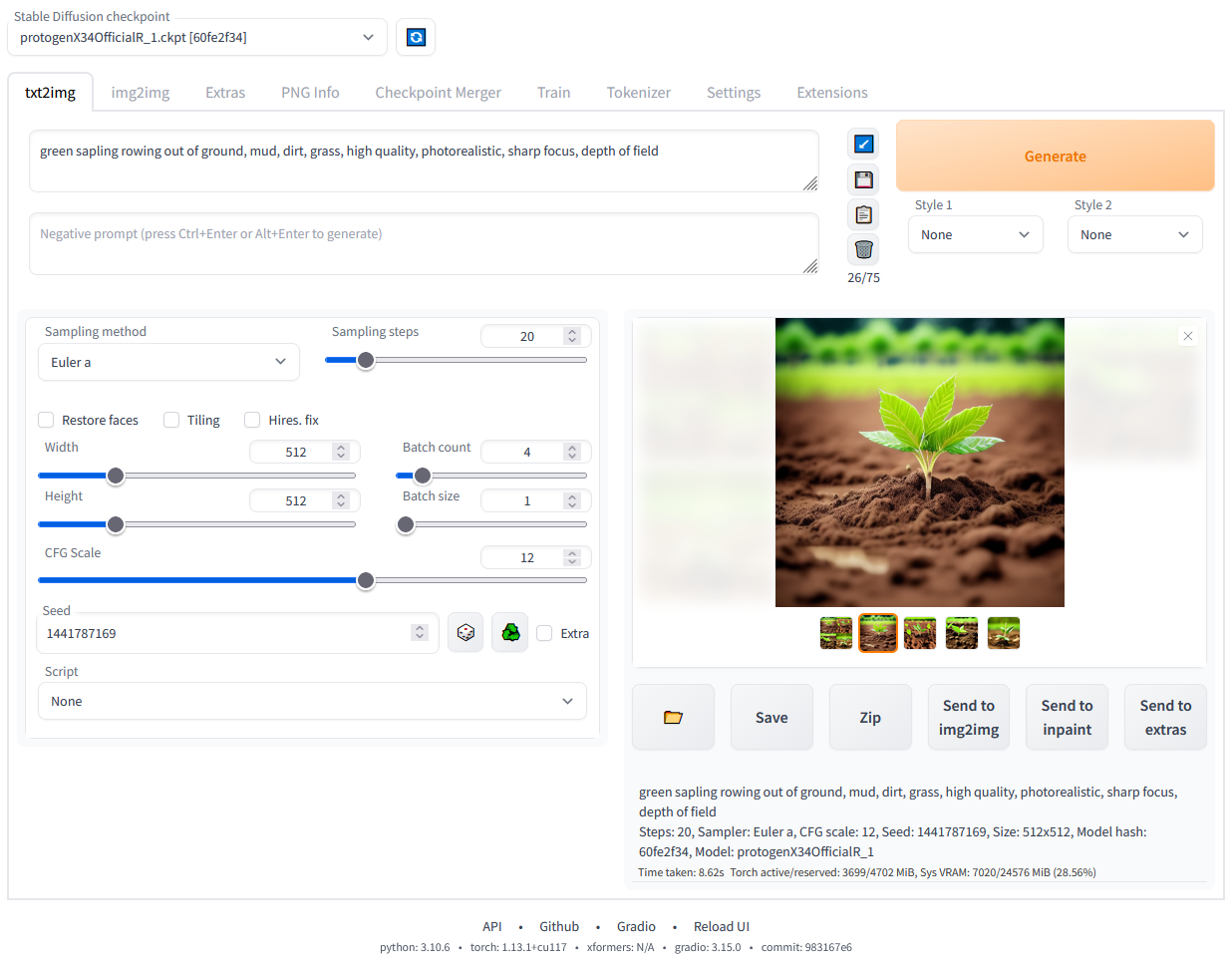

Schritt 6: Stabile Diffusion lokal ausführen

Nachdem die Abhängigkeiten installiert wurden, wird eine URL in deiner Eingabeaufforderung angezeigt: http://127.0.0.1:7860.

- Kopiere diesen Text und füge ihn in deinen Webbrowser ein, um die Stable Diffusion Web UI zu starten.

- Jetzt kannst du anfangen, Prompts auszuführen und Bilder zu erstellen!

Stabile Diffusion Web-UI, die lokal läuft. Bild vom Autor.

Fazit

Stable Diffusion ist ein bedeutender Fortschritt auf dem Gebiet der generativen KI. Es bietet die Möglichkeit, aus Textbeschreibungen hochwertige, detaillierte Bilder zu erstellen. Ganz gleich, ob du bestehende Bilder verändern, Bilder mit niedriger Auflösung verbessern oder ganz neue Bilder erstellen möchtest, Stable Diffusion bietet dir ein leistungsstarkes und vielseitiges Werkzeugset.

Mit den jüngsten Aktualisierungen und Verbesserungen in Stable Diffusion 3 und Medium wurden die Fähigkeiten des Modells weiter ausgebaut, was es zu einem der führenden Modelle im Bereich der generativen KI macht.

Wenn du Stable Diffusion lokal oder über verschiedene Online-Plattformen wie DreamStudio und Hugging Face betreibst, kannst du sein volles Potenzial entdecken und nutzen. Wenn du die in diesem Leitfaden beschriebenen Schritte befolgst, kannst du Stable Diffusion einrichten und nutzen, um deine kreativen und praktischen Bedürfnisse zu erfüllen!

Erfahre mehr über generative KI

Generative KI ist eine bahnbrechende Form des Deep Learning, die auf der Grundlage der trainierten Daten hochwertige Texte, Bilder und andere Inhalte erstellt. Tools wie Stable Diffusion, ChatGPT und DALL-E sind hervorragende Beispiele dafür, wie generative KI verschiedene Branchen verändert, indem sie neue Formen von Kreativität und Innovation ermöglicht. Mit der Weiterentwicklung dieser Technologien eröffnen sie Künstlern, Entwicklern und Forschern neue Möglichkeiten, die Grenzen des Machbaren zu erweitern.

Für diejenigen, die tiefer in die Welt der generativen KI eintauchen wollen, gibt es hier einige Ressourcen, die du erkunden kannst:

Verdiene eine Top-KI-Zertifizierung

FAQs

Kann ich Stable Diffusion auf einem Computer ohne eigenen Grafikprozessor ausführen?

Die Ausführung von Stable Diffusion erfordert eine erhebliche Rechenleistung, die in der Regel von einem dedizierten Grafikprozessor bereitgestellt wird. Es ist zwar theoretisch möglich, es auf einer CPU laufen zu lassen, aber der Prozess wäre extrem langsam und ineffizient. Für ein optimales Erlebnis wird empfohlen, einen Rechner mit einem leistungsstarken Grafikprozessor zu verwenden, der mindestens 6 GB VRAM hat.

Wie kann ich Stable Diffusion mit meinem eigenen Datensatz feinabstimmen?

Bei der Feinabstimmung von Stable Diffusion wird das Modell auf deinem spezifischen Datensatz neu trainiert, um seine Leistung für deinen Anwendungsfall zu verbessern. Dieser Prozess erfordert ein gutes Verständnis von maschinellem Lernen und Zugang zu einer geeigneten Computerumgebung. In der Regel musst du deinen Datensatz vorbereiten, die Trainingsskripte anpassen, um deine Daten einzubeziehen, und dann den Trainingsprozess mit einer leistungsstarken GPU durchführen. Detaillierte Anleitungen zur Feinabstimmung von Modellen findest du oft in der Dokumentation von Machine Learning Frameworks wie PyTorch.

Schau dir unser Tutorial an, Feinabstimmung von Stable Diffusion XL mit DreamBooth und LoRA, für weitere Informationen.

Was sind häufige Probleme, die beim lokalen Betrieb von Stable Diffusion auftreten können, und wie kann ich sie beheben?

Zu den häufigsten Problemen gehören:

- Installationsfehler: Stelle sicher, dass alle Abhängigkeiten korrekt installiert und mit deinem System kompatibel sind.

- Fehler bei Speicherplatzmangel: Verringere die Bildgröße oder die Stapelgröße, wenn dein Grafikprozessor nicht genug VRAM hat.

- Langsame Leistung: Vergewissere dich, dass deine GPU-Treiber auf dem neuesten Stand sind und dass auf deinem System keine anderen intensiven Prozesse laufen.

Auf der Problemseite des GitHub-Repositorys und in den Community-Foren findest du Tipps und Lösungen zur Fehlerbehebung.

Wie kann ich die Leistung von Stable Diffusion auf meinem Grafikprozessor optimieren?

So optimierst du die Leistung von Stable Diffusion auf deinem Grafikprozessor:

- Aktualisiere die Treiber: Stelle sicher, dass deine GPU-Treiber auf dem neuesten Stand sind.

- Einstellungen anpassen: Reduziere die Bildauflösung oder die Stapelgröße, um sie an die VRAM-Grenzen deines Grafikprozessors anzupassen.

- Verwende optimierte Bibliotheken: Nutze optimierte Bibliotheken und Frameworks wie CUDA und cuDNN für NVIDIA GPUs.

- Beende Hintergrundprozesse: Setze Systemressourcen frei, indem du unnötige Hintergrundprozesse schließt.

- Überwache die Leistung: Verwende Überwachungstools, um die GPU-Nutzung zu verfolgen und die Einstellungen für eine optimale Leistung entsprechend anzupassen.

Kann ich Stable Diffusion verwenden, um Animationen oder Videos zu erstellen?

Stable Diffusion ist zwar in erster Linie für die Erstellung von Standbildern gedacht, aber es ist auch möglich, Animationen oder Videos zu erstellen, indem du eine Folge von Bildern generierst und sie kombinierst. Das kannst du tun, indem du:

- Frame-by-Frame-Generierung: Erstelle einzelne Frames, indem du die Eingabeaufforderung oder den Seed für jedes Frame leicht variierst.

- Interpolation: Verwende Techniken, um zwischen Keyframes zu interpolieren, die durch stabile Diffusion erzeugt wurden.

- Videobearbeitungssoftware: Kombiniere die Bilder mit einer Videobearbeitungssoftware, um flüssige Animationen oder Videos zu erstellen. Beachte, dass die Erstellung von qualitativ hochwertigen Animationen eine umfangreiche Nachbearbeitung und Erfahrung in der Videobearbeitung erfordern kann.