Curso

La gestión de datos ha visto surgir nuevas soluciones para hacer frente a las limitaciones de las arquitecturas tradicionales, como los lagos de datos y los almacenes de datos. Aunque ambas arquitecturas han sido fundamentales para el almacenamiento y el análisis de datos, pueden presentar retos a la hora de abordar las necesidades modernas de procesamiento de datos.

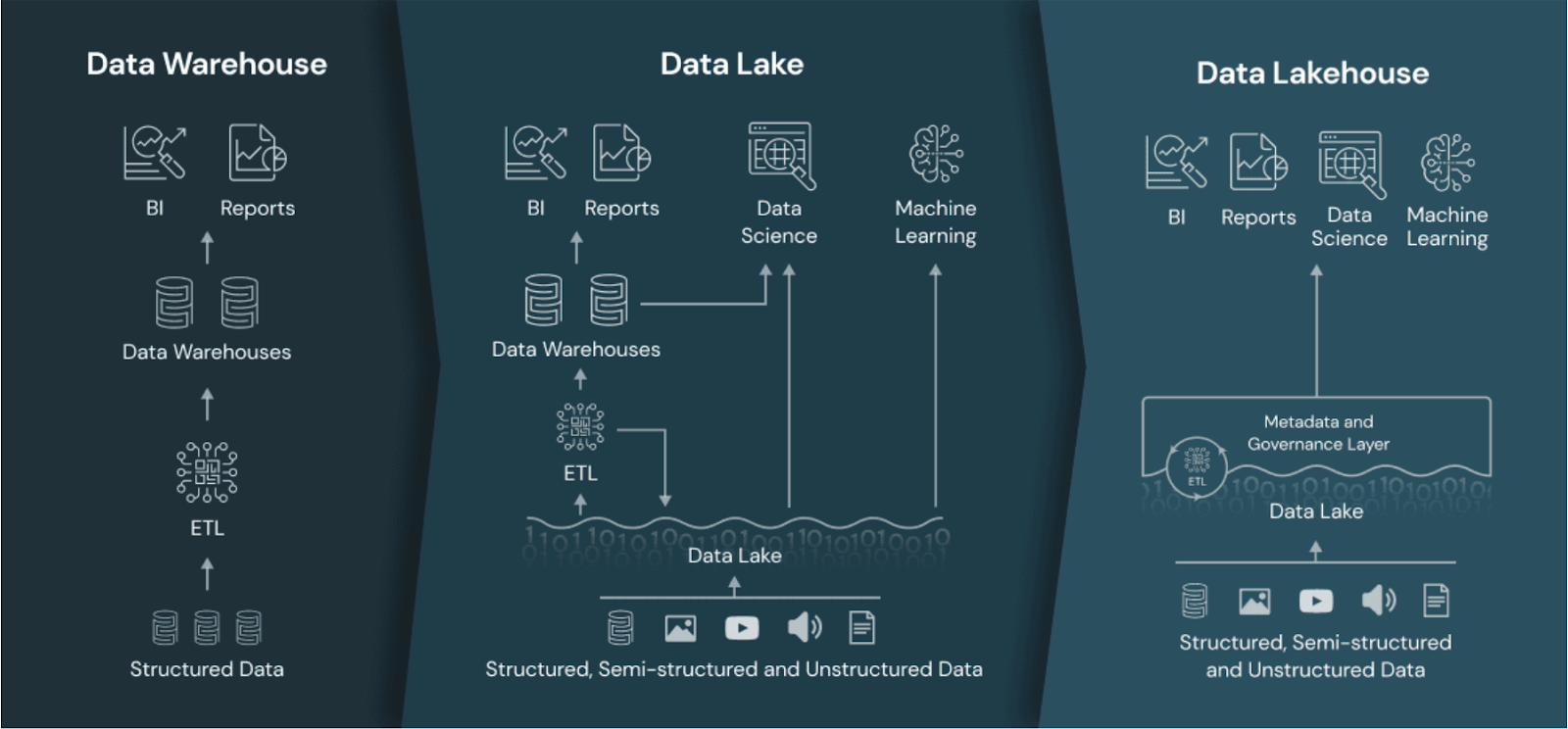

A pesar de ser escalables y flexibles, los lagos de datos a menudo se enfrentan a problemas de gobernanza y rendimiento. Por otra parte, los almacenes de datos, aunque potentes para el análisis, son costosos y menos flexibles. El lago de datos pretende resolver estos problemas combinando los puntos fuertes de los lagos de datos y los almacenes, y minimizando al mismo tiempo sus puntos débiles.

En esta guía, te explicaré qué es un lago de datos, en qué se diferencia de las arquitecturas de datos tradicionales y por qué está ganando popularidad entre los profesionales de datos que buscan una solución unificada de gestión de datos.

¿Qué es un Data Lakehouse?

Un lago de datos es una arquitectura que combina la escalabilidad y el almacenamiento de bajo coste de los lagos de datos con las capacidades de rendimiento, fiabilidad y gobernanza de los almacenes de datos.

Al integrar los puntos fuertes de ambas arquitecturas, un lago de datos ofrece una plataforma unificada para almacenar, procesar y analizar todo tipo de datos: estructurados, semiestructurados y no estructurados.

El enfoque unificado permite una mayor flexibilidad en el procesamiento de datos y admite una amplia gama de casos de uso analítico, desde la inteligencia empresarial al aprendizaje automático.

El lago de datos comparado con el almacén de datos y el lago de datos. Fuente de la imagen: Databricks.

Conviértete en Ingeniero de Datos

Data Lakehouse frente a Lago de datos vs. Almacén de datos

Antes de explorar la arquitectura del lago de datos con más detalle, es importante entender cómo se compara con los almacenes de datos y los lagos de datos.

Almacén de datos

Los almacenes de datos se construyen para almacenar datos estructurados y proporcionar análisis e informes de alto rendimiento.

Uno de sus mayores puntos fuertes es la capacidad de ejecutar consultas rápidas, lo que las hace muy adecuadas para inteligencia empresarial e informes casos de uso.

Los almacenes de datos utilizan un esquema bien definido que respalda una sólida gobernanza de los datos. Esto garantiza que los datos sean precisos, coherentes y fácilmente accesibles para su análisis.

Sin embargo, estas ventajas tienen un coste. Los almacenes de datos suelen ser caros de mantener porque dependen de hardware especializado y amplios procesos de transformación de datos, que suelen requerir canalizaciones ETL (extraer, transformar, cargar).

La estructura rígida de los almacenes de datos también los hace menos adecuados para manejar datos no estructurados o adaptarse rápidamente a los cambios de formato de los datos. Estafalta de flexibilidad de puede ser una limitación importante para las organizaciones que pretenden trabajar con fuentes de datos que evolucionan rápidamente o con datos que no se ajustan a un esquema predefinido, como texto, imágenes, audio, etc.

Para saber más sobre los fundamentos del almacenamiento de datos, consulta el curso gratuito Introducción al almacenamiento de datos.

Lago de datos

Los lagos de datos están diseñados para almacenar grandes cantidades de datos semiestructurados o no estructurados. Su principal ventaja reside en su capacidad para escalar, lo que las convierte en una opción atractiva para los equipos que trabajan con diversos tipos de datos y volúmenes de datos masivos.

La flexibilidad de los lagos de datos te permite almacenar datos sin procesar en su formato nativo, lo que los hace ideales para exploración de datos y proyectos científicos.

Sin embargo, los lagos de datos suelen tener problemas con la gobernanza y la calidad de los datos. Como los datos se almacenan en bruto, sin mucha estructura, garantizar una calidad coherente de los datos puede ser todo un reto.

La falta de gobernanza puede conducir a lo que comúnmente se conoce como un "pantano de datos", donde las ideas valiosas quedan enterradas bajo datos mal organizados.

El rendimiento es otra preocupación crítica en los lagos de datos, sobre todo para ejecutar consultas analíticas complejas. Los lagos de datos no están optimizados para realizar consultas rápidas ni para combinar distintos tipos de datos, como imágenes, texto y audio.

Data lakehouse

Un data lakehouse pretende combinar lo mejor de los data lakes y los data warehouses. Ofrece una solución más equilibrada al integrar las capacidades de escalabilidad y almacenamiento de bajo coste de los lagos de datos con los puntos fuertes de rendimiento y gobernanza de los almacenes de datos.

En teoría, en un lago puedes almacenar datos estructurados y no estructurados a un coste menor, al tiempo que aprovechas las capacidades necesarias para un análisis de alto rendimiento.

Los lagos de datos admiten transacciones ACID, lo que significa que las actualizaciones y eliminaciones de datos pueden gestionarse de forma fiable, algo de lo que suelen carecer los lagos de datos tradicionales. Esto permite una mejor integridad y gobernanza de los datos, lo que hace que los lagos de datos sean más adecuados para las aplicaciones de nivel empresarial.

Los lagos de datos también admiten el procesamiento de datos en tiempo real, lo que permite a las organizaciones manejar datos en flujo y obtener información en tiempo real, lo que es importante en algunos entornos.

Características y componentes de un Data Lakehouse

¿Cómo es posible tener lo mejor de ambos mundos en una sola plataforma? En esta sección, te explicaré los componentes que hacen posible la arquitectura de la casa del lago.

1. Separación de almacenamiento y cálculo con gestión unificada de datos

En un lago de datos, el almacenamiento y la informática están separados pero estrechamente integrados, lo que permite un uso flexible y escalable de los recursos.

Los datos se almacenan en un rentable almacén de objetos en la nube, mientras que los recursos informáticos pueden escalarse independientemente en función de las demandas de carga de trabajo. Este enfoque reduce la necesidad de mover datos entre sistemas, permitiendo a los usuarios procesar los datos in situ sin necesidad de realizar grandes extracciones y cargas.

Al integrar el almacenamiento y la informática de este modo, los lagos de datos agilizan la gestión de los datos, mejoran la eficiencia y reducen la latencia, lo que permite obtener información más rápidamente.

La asignación dinámica de recursos también permite optimizar mejor los costes y garantiza que los recursos informáticos se utilicen eficazmente.

2. Aplicación del esquema y gobernanza

Los lagos de datos aplican esquemas para mantener la calidad de los datos, al tiempo que ofrecen funciones de gobernanza para el cumplimiento de los datos.

La aplicación de esquemas garantiza que los datos se organicen en un formato estructurado, lo que facilita su consulta y análisis. Esto ayuda a evitar incoherencias en los datos y favorece una mejor calidad de los mismos en toda la organización.

Las funciones de gobernanza de los lagos de datos te permiten gestionar el acceso, el linaje y el cumplimiento de los datos. Con herramientas de gobernanza integradas, los lagos de datos pueden cumplir los requisitos normativos y proteger los datos confidenciales. Esto es especialmente importante para sectores como la sanidad y las finanzas, donde la privacidad de los datos y el cumplimiento de la normativa son fundamentales.

3. Soporte para transacciones ACID

Las transacciones ACID garantizan la fiabilidad de los datos, permitiéndote gestionar con confianza las actualizaciones y eliminaciones.

En un almacén de lago de datos, las transacciones ACID proporcionan el mismo nivel de integridad de los datos que se espera de un almacén de datos tradicional, pero con la flexibilidad añadida de manejar datos no estructurados.

La capacidad de soportar transacciones ACID significa que los lagos de datos pueden utilizarse para cargas de trabajo de misión crítica en las que la precisión de los datos es esencial. Esta característica hace que los lagos de datos sean una opción atractiva para las empresas que deben mantener la coherencia de los datos en diferentes operaciones de datos.

4. Procesamiento de datos en tiempo real

Los lagos de datos pueden procesar datos en tiempo real, lo que permite casos de uso como el análisis en tiempo real y la información en tiempo real. El procesamiento de datos en tiempo real permite a los equipos tomar decisiones basadas en datos más rápidamente, mejorando la capacidad de respuesta y la adaptabilidad.

Por ejemplo, el procesamiento de datos en tiempo real puede utilizarse para controlar las interacciones con los clientes, hacer un seguimiento de los niveles de inventario o detectar anomalías en las transacciones financieras. Al permitir una visión inmediata, los lagos de datos te ayudan a adelantarte a las cambiantes condiciones del mercado y a responder de forma proactiva a las nuevas oportunidades.

5. Soporte de arquitectura híbrida y multi-nube

Los lagos de datos pueden funcionar en entornos multi-nube o híbridos, ofreciendo flexibilidad y escalabilidad.

La compatibilidad con múltiples nubes permite a los equipos de datos evitar la dependencia de un proveedor y aprovechar los mejores servicios de distintos proveedores de nubes. La compatibilidad con arquitecturas híbridas garantiza que los sistemas locales se integren con los entornos en la nube, proporcionando una experiencia unificada de gestión de datos.

Esta flexibilidad beneficia especialmente a los equipos con necesidades de infraestructura complejas o a los que están migrando a la nube.

Ventajas de utilizar un lago de datos

En esta sección, hablaremos de las ventajas de utilizar un lago de datos para gestionar diversas necesidades de procesamiento de datos.

1. Escalabilidad y flexibilidad

Los almacenes de lagos de datos heredan la escalabilidad de los lagos de datos, por lo que son capaces de gestionar las crecientes necesidades de datos. Puedes añadir fácilmente más datos sin preocuparte por las limitaciones de almacenamiento, garantizando que tu arquitectura de datos crezca con la empresa.

Por ejemplo, Apache Hudi, Delta Lake y Apache Iceberg pueden escalar el almacenamiento de miles de archivos en sistemas de almacenamiento de objetos como Amazon S3, Azure Blob Storage o Google Cloud Storage.

La flexibilidad es otra ventaja significativa, ya que los lagos de datos admiten datos estructurados (por ejemplo, registros de transacciones) y no estructurados (por ejemplo, archivos de registro, imágenes y vídeos). Esto significa que puedes almacenar todos tus datos en un solo lugar, independientemente del formato, y utilizarlos para diversos casos de uso de análisis y aprendizaje automático.

2. Rentabilidad

Los lagos de datos almacenan datos a un coste menor que los almacenes de datos, al tiempo que admiten análisis avanzados.

Por ejemplo, los lagos de datos construidos sobre almacenamiento de objetos en la nube (como Amazon S3 o Google Cloud Storage) aprovechan sus rentables niveles de almacenamiento. Combinados con los formatos de archivo Apache Parquet y ORC -que comprimen los datos para minimizar los costes de almacenamiento-, los almacenes de lago de datos te permiten conseguir ahorros sustanciales.

La naturaleza unificada de los lagos de datos significa que no hay necesidad de mantener sistemas separados para el almacenamiento y el análisis, lo que redunda en eficiencia de costes y hace de los lagos de datos una opción atractiva.

3. Mayor rapidez en la obtención de información

Las capacidades unificadas de almacenamiento y procesamiento de datos reducen el tiempo necesario para obtener información. Los lagos de datos eliminan la necesidad de mover los datos entre los entornos de almacenamiento y computación, agilizando los flujos de trabajo y minimizando la latencia.

Tecnologías como Apache Spark y Databricks permiten procesar los datos directamente dentro del lago, eliminando la necesidad de trasladarlos a entornos analíticos separados.

Al tener todos los datos en un solo lugar y procesarlos eficazmente, puedes generar rápidamente perspectivas que impulsen una mejor toma de decisiones. Esta mayor rapidez es especialmente valiosa para los sectores en los que la información puntual es crucial, como las finanzas, el comercio minorista y la sanidad.

4. Gobernanza y seguridad de los datos

Las funciones de aplicación de esquemas y gobierno de datos cumplen las normas de calidad y conformidad de datos. Los lagos de datos proporcionan herramientas para gestionar el acceso a los datos, las pistas de auditoría y el linaje de los datos, esenciales para mantener la integridad de los datos y cumplir los requisitos normativos.

Herramientas como AWS Lake Formation, Azure Purview y Apache Ranger proporcionan un control centralizado sobre el acceso a los datos, los permisos y los registros de auditoría, lo que te permite gestionar los datos de forma segura y evitar accesos no autorizados

Estas características de gobernanza y seguridad hacen que los almacenes de lago de datos sean adecuados para las empresas que necesitan cumplir la normativa sobre privacidad de datos, como la GDPR o la HIPAA. Al garantizar que los datos se gestionan y protegen adecuadamente, los lagos de datos contribuyen a generar confianza en los datos y en su información.

Casos de uso de Data Lakehouse

En esta sección, vamos a repasar todos los posibles casos de uso del lago de datos.

Análisis de datos modernos

Los equipos de datos utilizan los lagos de datos para análisis en tiempo real, inteligencia empresarial y flujos de trabajo de aprendizaje automático. Al proporcionar una plataforma de datos unificada, los lagos de datos permiten a los profesionales analizar datos históricos y en tiempo real, obteniendo perspectivas que impulsan mejores resultados empresariales.

Por ejemplo, los minoristas pueden utilizar los lagos de datos para analizar los datos de ventas en tiempo real, identificar tendencias y ajustar su inventario en consecuencia. Las instituciones financieras pueden aprovechar los lagos de datos para realizar análisis de riesgos y detección de fraudes, combinando datos de transacciones históricos y en tiempo real para obtener una visión completa.

Consulta el curso gratuito Comprender la Arquitectura Moderna de Datos para saber más sobre cómo funcionan las plataformas de datos modernas, desde la ingesta y el servicio hasta la gobernanza y la orquestación.

Canalizaciones de IA y aprendizaje automático

Los lagos de datos proporcionan la infraestructura para construir y escalar modelos de IA y ML, con fácil acceso a datos estructurados y no estructurados. Los modelos de aprendizaje automático suelen requerir diversos tipos de datos, y los lagos de datos permiten reunir todos los datos relevantes en un solo lugar.

Este acceso unificado a los datos simplifica el proceso de entrenamiento, prueba y despliegue de los modelos de aprendizaje automático. Los científicos de datos pueden experimentar rápidamente con diferentes conjuntos de datos, iterar sobre modelos y escalarlos para la producción sin tener que preocuparse por los silos de datos o el movimiento entre sistemas.

Aplicaciones basadas en datos

Los lagos de datos alimentan aplicaciones basadas en datos que requieren información en tiempo real y capacidad de toma de decisiones. Estas aplicaciones suelen basarse en información actualizada para ofrecer a los usuarios experiencias personalizadas o recomendaciones automatizadas.

Por ejemplo, un motor de recomendación de un sitio de comercio electrónico puede utilizar un lago de datos para analizar el comportamiento de los usuarios en tiempo real y ofrecer sugerencias de productos relevantes. Del mismo modo, las empresas de logística pueden utilizar los lagos de datos para optimizar las rutas de reparto basándose en datos de tráfico en tiempo real y en patrones de reparto históricos.

Plataformas populares de Data Lakehouse

Ha llegado el momento de conocer las tecnologías que hacen posible la arquitectura del lago de datos. En esta sección, te explico las más populares.

1. Databricks Lakehouse

Databricks ha sido pionera en la arquitectura de lagos de datos, ofreciendo Delta Lake como componente central de su plataforma. Delta Lake añade mejoras de fiabilidad y rendimiento a los lagos de datos, permitiendo transacciones ACID y garantizando la calidad de los datos.

Databricks Lakehouse combina la escalabilidad de los lagos de datos con las funciones de gestión de datos de los almacenes de datos, proporcionando una plataforma unificada para la analítica y el aprendizaje automático. Su integración con Apache Spark lo convierte en una opción atractiva para las organizaciones que aprovechan las capacidades de procesamiento de big data.

Si quieres conocer la plataforma Databricks Lakehouse y cómo puede modernizar las arquitecturas de datos y mejorar los procesos de gestión de datos, consulta el curso gratuito Introducción a Databricks.

2. Google BigLake

BigLake de Google integra los principios de los lagos de datos con su actual ecosistema en la nube, proporcionando una plataforma unificada de almacenamiento y análisis de datos. BigLake permite a los usuarios gestionar datos estructurados y no estructurados, lo que facilita la realización de análisis de distintos tipos de datos.

Con la integración con los servicios de Google Cloud, BigLake proporciona una solución completa para los equipos de datos que buscan utilizar herramientas nativas de la nube para sus necesidades de datos. Admite el procesamiento por lotes y en tiempo real, por lo que es adecuado para una amplia gama de casos de uso.

3. Formación Lago AWS

AWS Lake Formation proporciona herramientas para crear un lago de datos utilizando los servicios en la nube de AWS, ofreciendo una integración y administración perfectas. Con AWS Formación de Lagos, puedes ingestar, catalogar y proteger datos fácilmente, creando un lago de datos unificado.

AWS Lake Formation también se integra con otros servicios de análisis de AWS, como Amazon Redshift y AWS Glue, proporcionando un conjunto completo de herramientas para el procesamiento y análisis de datos. Esto lo convierte en una opción atractiva para las organizaciones que ya utilizan AWS para su infraestructura.

4. Copo de nieve

La arquitectura de Snowflake está evolucionando para dar soporte a las capacidades de los lagos de datos, permitiendo a los usuarios gestionar eficazmente datos estructurados y semiestructurados. Snowflake proporciona análisis de alto rendimiento, al tiempo que ofrece flexibilidad en el almacenamiento y la gestión de datos.

Las funciones de lago de datos de Snowflake te permiten combinar distintos tipos de datos y realizar análisis avanzados sin necesidad de varios sistemas. Su diseño nativo en la nube y su compatibilidad con despliegues en múltiples nubes lo convierten en una opción popular para los equipos que buscan modernizar su infraestructura de datos.

Si te interesa Snowflake, consulta el curso Introducción a Snowflake.

5. Azure Synapse Analytics

Azure Synapse Analytics de Microsoft combina las capacidades de big data y almacenamiento de datos en una solución unificada de lago de datos.

Synapse permite a los equipos analizar datos estructurados y no estructurados utilizando diversas herramientas, como SQL, Apache Spark y Data Explorer. Su profunda integración con otros servicios de Azure, como Azure Data Lake Storage y Power BI, proporciona una experiencia sin fisuras para el procesamiento, análisis y visualización de datos de extremo a extremo, lo que lo convierte en una opción ideal para las organizaciones dentro del ecosistema Azure.

6. Apache Hudi

Apache Hudi es un proyecto de código abierto que aporta capacidades transaccionales a los lagos de datos. Admite transacciones ACID, upserts y versionado de datos.

Hudi se integra bien con plataformas de almacenamiento en la nube como Amazon S3 yd Google Cloud Storage, lo que lo hace adecuado para análisis en tiempo real y pipelines de aprendizaje automático. Al ser compatible con motores de big data populares como Apache Spark y Presto, Hudi ofrece flexibilidad para construir un lago de datos personalizado con tecnología de código abierto.

7. Dremio

Dremio proporciona una plataforma abierta de lagos de datos para cargas de trabajo de análisis y BI rápidas directamente en lagos de datos en la nube.

Con su enfoque basado en SQL y su integración con Apache Arrow, Dremio permite a los equipos realizar análisis de alto rendimiento sin mover los datos. Es beneficioso para las organizaciones que desean realizar consultas basadas en SQLen sus lagos de datos, por lo que es una opción popular para los equipos de datos que priorizan la velocidad y la eficiencia.

Comparación de plataformas de Data Lakehouse

Como puedes imaginar, no todas las tecnologías que soportan la arquitectura del lago de datos son iguales. La tabla siguiente los compara en varias categorías:

|

Plataforma |

Tipo de almacenamiento primario |

Admite datos estructurados y no estructurados |

Motor de cálculo |

Transacciones ACID |

Procesamiento en tiempo real |

Integración con ML/AI |

Caso de uso ideal |

|

Databricks Lakehouse |

Delta Lake (Apache Parquet) |

Sí |

Apache Spark |

Sí |

Sí |

Fuerte (MLflow, Spark ML) |

Análisis de grandes datos, IA/ML |

|

Google BigLake |

Almacenamiento en la nube de Google |

Sí |

Google BigQuery |

Sí |

Sí |

Integrado con Google Cloud AI |

Analítica nativa en la nube |

|

Formación Lago AWS |

Amazon S3 |

Sí |

Amazon Redshift / AWS Glue |

Sí |

Limitado |

Amazon SageMaker Integration |

Lakehouse de datos centrado en AWS |

|

Copo de nieve |

Propietario (basado en la nube) |

Principalmente estructurado |

Cálculo en copo de nieve |

Sí |

Limitado |

Limitado |

Análisis de alto rendimiento en múltiples nubes |

|

Azure Synapse Analytics |

Almacenamiento Azure Data Lake |

Sí |

SQL, Apache Spark, Explorador de datos |

Sí |

Sí |

Strong (Azure ML, Power BI) |

Análisis del ecosistema Microsoft |

|

Apache Hudi |

Almacenamiento de objetos en la nube (por ejemplo, S3, GCS) |

Sí |

Apache Spark, Presto |

Sí |

Sí |

Soporte ML externo |

Lagos de datos en tiempo real de código abierto |

|

Dremio |

Lagos de datos en la nube |

Sí |

Dremio (Flecha Apache) |

No |

Sí |

Sin integración nativa |

SQL de alto rendimiento en lagos en la nube |

Retos y consideraciones para implantar un Data Lakehouse

Algunas cosas son demasiado buenas para ser verdad, y el lago de datos no es una excepción. Aparentemente lo ofrece todo, pero también tiene algunos inconvenientes. Vamos a repasarlos en esta sección.

1. Integración con los sistemas existentes

Integrar un lago de datos con sistemas heredados puede ser complejo y requiere una planificación cuidadosa. Los equipos pueden tener que migrar datos de lagos de datos o almacenes existentes, lo que puede llevar mucho tiempo y consumir muchos recursos.

También pueden surgir problemas de compatibilidad al integrarse con sistemas antiguos que no están diseñados para funcionar con las arquitecturas de datos modernas. Para implantar con éxito un lago de datos, debes evaluar tu infraestructura actual, planificar la migración de datos y asegurarte de que todos los sistemas pueden trabajar juntos en armonía.

2. Gestionar la gobernanza y la seguridad de los datos

Equilibrar la escalabilidad con la gobernanza y la seguridad puede ser un reto, especialmente en los sectores regulados. Los lagos de datos deben proporcionar sólidas herramientas de gobernanza para gestionar el acceso, el linaje y el cumplimiento de los datos, manteniendo al mismo tiempo la escalabilidad necesaria para manejar grandes conjuntos de datos.

Otra consideración crítica es garantizar que los datos sensibles estén debidamente protegidos. Necesitas implantar controles de acceso, encriptación y auditoría para proteger tus datos y cumplir los requisitos normativos. Esto puede ser especialmente difícil en entornos híbridos y multi-nube, donde los datos están distribuidos en diferentes ubicaciones.

3. Compromisos entre coste y rendimiento

Cuando se implanta un lago de datos, encontrar el equilibrio adecuado entre rentabilidad y rendimiento puede ser todo un reto. Mientras que los almacenes de lagos de datos ofrecen un almacenamiento rentable, conseguir un análisis de alto rendimiento puede requerir una inversión adicional en recursos informáticos.

Tienes que evaluar cuidadosamente los requisitos de la carga de trabajo y determinar la forma más rentable de satisfacer tus necesidades de rendimiento. Esto puede implicar la optimización de la asignación de recursos, la elección de los servicios en la nube adecuados o el ajuste de la configuración del lago de datos para garantizar que se cumplen los objetivos tanto de coste como de rendimiento.

Conclusión

Los lagos de datos representan una evolución significativa en la arquitectura de datos, ¡combinando los puntos fuertes de los lagos de datos y los almacenes de datos en una única plataforma unificada!

Con la aplicación de esquemas, la compatibilidad con transacciones ACID, la escalabilidad y el procesamiento de datos en tiempo real, los lagos de datos ofrecen una potente solución para las necesidades modernas de datos.

Los lagos de datos proporcionan una opción atractiva para los equipos de datos que buscan simplificar su panorama de datos y mejorar las capacidades analíticas.

Explora el curso gratuito Comprender la Ingeniería de Datos para saber más sobre los lagos de datos y otras tecnologías emergentes de ingeniería de datos.

Certifícate en el puesto de Ingeniero de Datos de tus sueños

Nuestros programas de certificación te ayudan a destacar y a demostrar que tus aptitudes están preparadas para el trabajo a posibles empleadores.

Preguntas frecuentes

¿Por qué se están popularizando los lagos de datos?

Los lagos de datos combinan la escalabilidad con un análisis robusto, lo que los hace rentables para las empresas que buscan flexibilidad, alto rendimiento y conocimiento de los datos en tiempo real.

¿A qué retos se enfrentan los lagos de datos en comparación con las arquitecturas de datos tradicionales?

Los lagos de datos deben equilibrar el rendimiento de los datos estructurados y no estructurados, que pueden ser complejos. La implantación de la gobernanza y la seguridad en diversos tipos de datos y la integración con sistemas heredados también plantean retos.

¿Cómo gestiona los metadatos un lago de datos?

Los almacenes de lago de datos utilizan capas de metadatos (como el manejo de metadatos de Delta Lake) para organizar, aplicar esquemas y optimizar las consultas, mejorando el descubrimiento, la gobernanza y el rendimiento de los datos.

¿Pueden los data lakehouses sustituir tanto a los data lakes como a los data warehouses?

Aunque los lakehouses pueden sustituir a menudo a los lagos y almacenes de datos, algunos casos de uso especializado pueden seguir requiriendo sistemas dedicados. Para la mayoría de las necesidades, las casas lago ofrecen una solución unificada y flexible.

¿Cómo soportan los lagos de datos el versionado de datos?

Tecnologías como Delta Lake y Apache Hudi permiten versionar los datos, lo que permite a los usuarios rastrear los cambios, realizar reversiones y garantizar la coherencia de los datos a lo largo del tiempo.

¿Qué papel desempeñan los lagos de datos en la democratización de los datos?

Los Lakehouses promueven la democratización de los datos ofreciendo una plataforma única en la que todos los datos son accesibles y están gobernados, lo que permite a equipos más amplios acceder a los datos y aprovecharlos de forma segura.