Curso

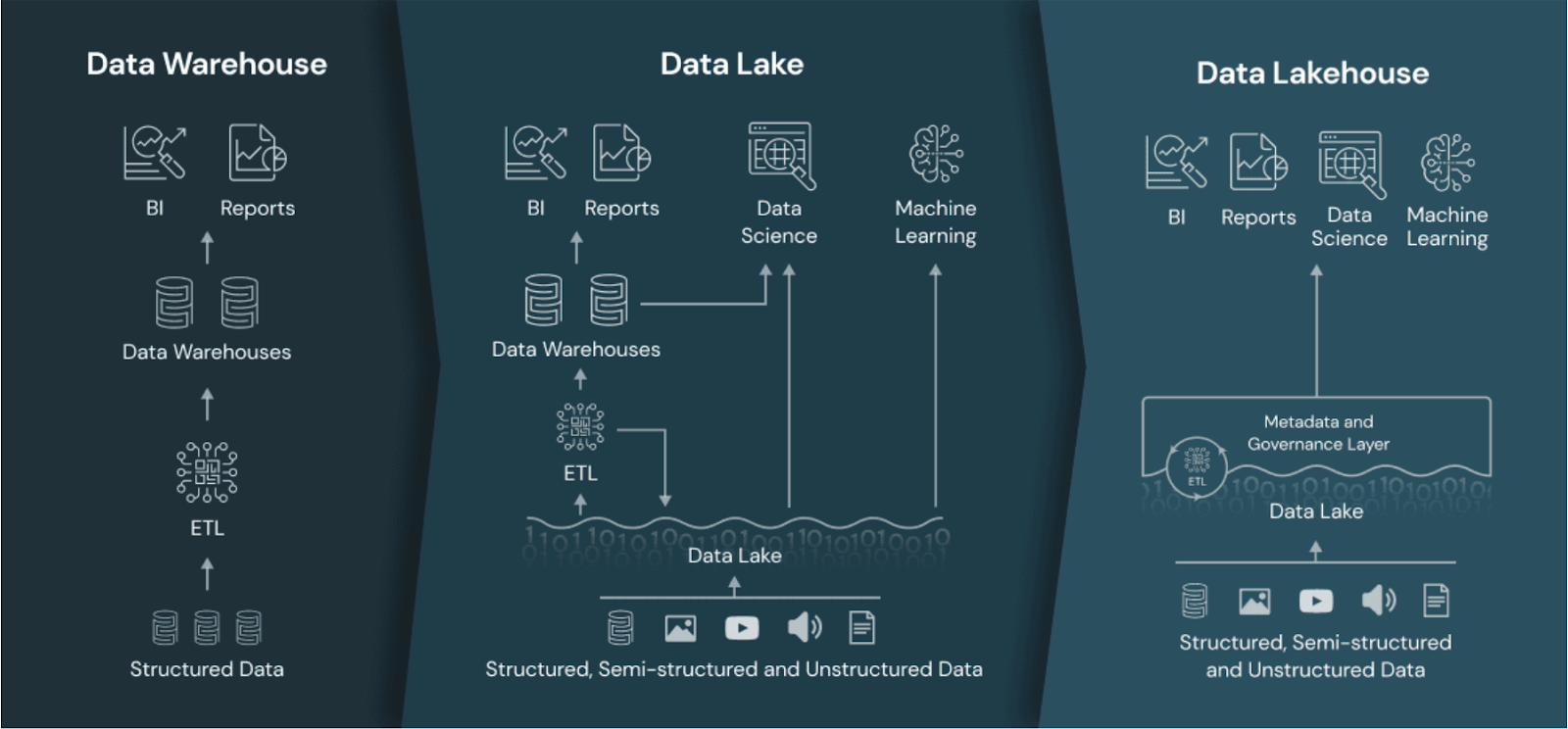

O gerenciamento de dados tem visto o surgimento de novas soluções para lidar com as limitações das arquiteturas tradicionais, como data lakes e data warehouses. Embora ambas as arquiteturas tenham sido fundamentais para o armazenamento e a análise de dados, elas podem apresentar desafios para atender às necessidades modernas de processamento de dados.

Apesar de serem dimensionáveis e flexíveis, os data lakes geralmente enfrentam problemas de governança e desempenho. Por outro lado, os data warehouses, embora sejam poderosos para a análise, são caros e menos flexíveis. O objetivo do data lakehouse é resolver esses problemas combinando os pontos fortes dos data lakes e dos data warehouses e minimizando seus pontos fracos.

Neste guia, mostrarei a você o que é um data lakehouse, como ele difere das arquiteturas de dados tradicionais e por que ele está ganhando popularidade entre os profissionais de dados que buscam uma solução unificada de gerenciamento de dados.

O que é um Data Lakehouse?

Um data lakehouse é uma arquitetura que combina a escalabilidade e o armazenamento de baixo custo dos data lakes com os recursos de desempenho, confiabilidade e governança dos data warehouses.

Ao integrar os pontos fortes de ambas as arquiteturas, um data lakehouse oferece uma plataforma unificada para armazenar, processar e analisar todos os tipos de dados - estruturados, semiestruturados e não estruturados.

A abordagem unificada permite maior flexibilidade no processamento de dados e oferece suporte a uma ampla variedade de casos de uso de análise, desde business intelligence até aprendizado de máquina.

O data lakehouse em comparação com o data warehouse e o data lake. Fonte da imagem: Databricks.

Torne-se um engenheiro de dados

Data Lakehouse vs. Data Lakehouse. Lago de dados vs. Armazém de dados

Antes de explorar a arquitetura de data lakehouse em mais detalhes, é importante entender como ela se compara aos data warehouses e data lakes.

Armazém de dados

Os data warehouses são criados para armazenar dados estruturados e fornecer análises e relatórios de alto desempenho.

Um de seus maiores pontos fortes é a capacidade de executar consultas rápidas, o que os torna adequados para inteligência de negócios e relatórios casos de uso.

Os data warehouses usam um esquema bem definido que dá suporte a uma forte governança de dados. Isso garante que os dados sejam precisos, consistentes e facilmente acessíveis para análise.

No entanto, essas vantagens têm um custo. Geralmente, a manutenção dos data warehouses é cara porque eles dependem de hardware especializado e de processos extensos de transformação de dados, geralmente exigindo pipelines de ETL (extração, transformação e carregamento).

A estrutura rígida dos data warehouses também os torna menos adequados para lidar com dados não estruturados ou para se adaptar rapidamente às mudanças no formato dos dados. Essa falta de flexibilidade pode ser uma limitação significativa para as organizações que pretendem trabalhar com fontes de dados em rápida evolução ou com dados que não estejam em conformidade com um esquema predefinido, como texto, imagens, áudio etc.

Para saber mais sobre os fundamentos do armazenamento de dados, confira o curso gratuito Introduction to Data Warehousing (Introdução ao armazenamento de dados ).

Lago de dados

Os data lakes são projetados para armazenar grandes quantidades de dados semiestruturados ou não estruturados. Sua principal vantagem está na capacidade de dimensionamento, o que os torna uma opção atraente para equipes que lidam com diversos tipos de dados e grandes volumes de dados.

A flexibilidade dos data lakes permite que você armazene dados brutos em seu formato nativo, tornando-os ideais para exploração de dados e projetos científicos.

No entanto, os data lakes geralmente têm dificuldades com a governança e a qualidade dos dados. Como os dados são armazenados em sua forma bruta, sem muita estrutura, garantir a qualidade consistente dos dados pode ser um desafio.

A falta de governança pode levar ao que é comumente conhecido como "pântano de dados", em que insights valiosos são enterrados sob dados mal organizados.

O desempenho é outra preocupação fundamental nos lagos de dados, especialmente para a execução de consultas analíticas complexas. Os data lakes não são otimizados para consultas rápidas ou para combinar diferentes tipos de dados, como imagens, texto e áudio.

Lago de dados

O objetivo de um data lakehouse é combinar o melhor dos data lakes e dos data warehouses. Ele oferece uma solução mais equilibrada, integrando a escalabilidade e os recursos de armazenamento de baixo custo dos data lakes com os pontos fortes de desempenho e governança dos data warehouses.

Em teoria, em uma lakehouse, você pode armazenar dados estruturados e não estruturados a um custo menor e, ao mesmo tempo, aproveitar os recursos necessários para a análise de alto desempenho.

Os data lakehouses oferecem suporte para transações ACID, o que significa que as atualizações e exclusões de dados podem ser gerenciadas de forma confiável, o que geralmente não ocorre nos data lakes tradicionais. Isso permite melhor integridade e governança dos dados, tornando os data lakehouses mais adequados para aplicativos de nível empresarial.

Os data lakehouses também oferecem suporte ao processamento de dados em tempo real, permitindo que as organizações lidem com dados de fluxo contínuo e obtenham insights em tempo real, o que é importante em algumas configurações.

Recursos e componentes de um Data Lakehouse

Como é possível ter o melhor dos dois mundos em uma única plataforma? Nesta seção, explicarei os componentes que tornam possível a arquitetura da casa do lago.

1. Separação de armazenamento e computação com gerenciamento de dados unificado

Em um data lakehouse, o armazenamento e a computação são separados, mas totalmente integrados, permitindo o uso flexível e escalonável dos recursos.

Os dados são armazenados em um econômico armazenamento de objetos na nuvem, enquanto os recursos de computação podem ser dimensionados de forma independente com base nas demandas de carga de trabalho. Essa abordagem reduz a necessidade de mover dados entre sistemas, permitindo que os usuários processem dados no local sem extração e carregamento extensivos.

Ao integrar o armazenamento e a computação dessa forma, os data lakehouses simplificam o gerenciamento de dados, aumentam a eficiência e reduzem a latência, o que leva a insights mais rápidos.

A alocação dinâmica de recursos também permite uma melhor otimização de custos e garante que os recursos de computação sejam usados de forma eficaz.

2. Aplicação e governança do esquema

Os data lakehouses aplicam esquemas para manter a qualidade dos dados e oferecem recursos de governança para a conformidade dos dados.

A aplicação do esquema garante que os dados sejam organizados em um formato estruturado, facilitando a consulta e a análise. Isso ajuda a evitar inconsistências de dados e oferece suporte a uma melhor qualidade de dados em toda a organização.

Os recursos de governança nos data lakehouses permitem que você gerencie o acesso, a linhagem e a conformidade dos dados. Com ferramentas de governança integradas, os data lakehouses podem atender aos requisitos normativos e proteger dados confidenciais. Isso é particularmente importante para setores como o de saúde e o financeiro, em que a privacidade e a conformidade dos dados são fundamentais.

3. Suporte para transações ACID

As transações ACID garantem a confiabilidade dos dados, permitindo que você gerencie atualizações e exclusões com confiança.

Em um data lakehouse, as transações ACID oferecem o mesmo nível de integridade de dados esperado de um data warehouse tradicional, mas com a flexibilidade adicional de lidar com dados não estruturados.

A capacidade de suportar transações ACID significa que os data lakehouses podem ser usados para cargas de trabalho de missão crítica em que a precisão dos dados é essencial. Esse recurso torna os data lakehouses uma opção atraente para empresas que precisam manter a consistência dos dados em diferentes operações de dados.

4. Processamento de dados em tempo real

Os data lakehouses podem processar dados em tempo real, permitindo casos de uso como análise em tempo real e insights de streaming. O processamento de dados em tempo real permite que as equipes tomem decisões baseadas em dados com mais rapidez, melhorando a capacidade de resposta e a adaptabilidade.

Por exemplo, o processamento de dados em tempo real pode ser usado para monitorar as interações com os clientes, rastrear os níveis de estoque ou detectar anomalias em transações financeiras. Ao possibilitar insights imediatos, os data lakehouses ajudam você a ficar à frente das mudanças nas condições do mercado e a responder proativamente a novas oportunidades.

5. Suporte a arquitetura híbrida e de várias nuvens

Os data lakehouses podem operar em ambientes híbridos ou de várias nuvens, oferecendo flexibilidade e escalabilidade.

O suporte a várias nuvens permite que as equipes de dados evitem a dependência de fornecedores e aproveitem os melhores serviços de diferentes provedores de nuvem. O suporte à arquitetura híbrida garante que os sistemas locais se integrem aos ambientes de nuvem, proporcionando uma experiência de gerenciamento de dados unificada.

Essa flexibilidade beneficia especialmente as equipes com necessidades complexas de infraestrutura ou aquelas que estão passando por migração para a nuvem.

Benefícios do uso de um Data Lakehouse

Nesta seção, discutiremos os benefícios de usar um data lakehouse para gerenciar diversas necessidades de processamento de dados.

1. Escalabilidade e flexibilidade

Os data lakehouses herdam a escalabilidade dos data lakes, o que os torna capazes de lidar com as crescentes necessidades de dados. Você pode adicionar facilmente mais dados sem se preocupar com limitações de armazenamento, garantindo que sua arquitetura de dados cresça com os negócios.

Por exemplo, o Apache Hudi, o Delta Lake e o Apache Iceberg podem dimensionar o armazenamento em milhares de arquivos em sistemas de armazenamento de objetos, como o Amazon S3, o Azure Blob Storage ou o Google Cloud Storage.

A flexibilidade é outro benefício significativo, pois os data lakehouses suportam dados estruturados (por exemplo, registros de transações) e não estruturados (por exemplo, arquivos de log, imagens e vídeos). Isso significa que você pode armazenar todos os seus dados em um só lugar, independentemente do formato, e usá-los para vários casos de uso de análise e aprendizado de máquina.

2. Eficiência de custos

Os data lakehouses armazenam dados a um custo menor do que os data warehouses e ainda oferecem suporte à análise avançada.

Por exemplo, os data lakehouses criados com base no armazenamento de objetos em nuvem (como o Amazon S3 ou o Google Cloud Storage) aproveitam suas camadas de armazenamento econômicas. Combinados com os formatos de arquivo Apache Parquet e ORC, que compactam os dados para minimizar os custos de armazenamento, os data lakehouses permitem que você obtenha economias substanciais.

A natureza unificada dos data lakehouses significa que não há necessidade de manter sistemas separados para armazenamento e análise, o que resulta em eficiência de custos e torna os data lakehouses uma opção atraente.

3. Tempo mais rápido para obter insights

Os recursos unificados de armazenamento e processamento de dados reduzem o tempo necessário para obter insights. Os data lakehouses eliminam a necessidade de mover dados entre ambientes de armazenamento e computação, simplificando os fluxos de trabalho e minimizando a latência.

Tecnologias como o Apache Spark e o Databricks permitem que os dados sejam processados diretamente no lakehouse, eliminando a necessidade de movê-los para ambientes analíticos separados.

Ao ter todos os dados em um só lugar e processá-los de forma eficiente, você pode gerar rapidamente insights que impulsionam uma melhor tomada de decisão. Esse tempo mais rápido para a percepção é particularmente valioso para setores em que as informações oportunas são cruciais, como finanças, varejo e saúde.

4. Governança e segurança de dados

Os recursos de aplicação de esquema e governança de dados atendem aos padrões de qualidade e conformidade de dados. Os data lakehouses oferecem ferramentas para gerenciar o acesso aos dados, as trilhas de auditoria e a linhagem de dados, essenciais para manter a integridade dos dados e atender aos requisitos regulamentares.

Ferramentas como AWS Lake Formation, Azure Purview e Apache Ranger fornecem controle centralizado sobre o acesso aos dados, permissões e trilhas de auditoria, permitindo que você gerencie os dados com segurança e evite o acesso não autorizado

Esses recursos de governança e segurança tornam os data lakehouses adequados para empresas que precisam estar em conformidade com as normas de privacidade de dados, como GDPR ou HIPAA. Ao garantir que os dados sejam gerenciados e protegidos adequadamente, os data lakehouses ajudam a criar confiança nos dados e em seus insights.

Casos de uso de data lakehouse

Nesta seção, vamos analisar todos os casos de uso possíveis para o data lakehouse.

Análise de dados moderna

As equipes de dados usam data lakehouses para análise em tempo real, business intelligence e fluxos de trabalho de aprendizado de máquina. Ao fornecer uma plataforma de dados unificada, os data lakehouses permitem que os profissionais analisem dados históricos e em tempo real, obtendo insights que geram melhores resultados comerciais.

Por exemplo, os varejistas podem usar data lakehouses para analisar dados de vendas em tempo real, identificar tendências e ajustar o estoque de acordo. As instituições financeiras podem aproveitar os data lakehouses para realizar análises de risco e detecção de fraudes, combinando dados de transações históricos e em tempo real para obter uma visão abrangente.

Confira o curso gratuito Understanding Modern Data Architecture para saber mais sobre como funcionam as plataformas de dados modernas, desde a ingestão e o fornecimento até a governança e a orquestração.

Pipelines de IA e aprendizado de máquina

Os data lakehouses fornecem a infraestrutura para a criação e o dimensionamento de modelos de IA e ML, com acesso fácil a dados estruturados e não estruturados. Os modelos de aprendizado de máquina geralmente exigem uma variedade de tipos de dados, e os data lakehouses possibilitam reunir todos os dados relevantes em um só lugar.

Esse acesso unificado aos dados simplifica o processo de treinamento, teste e implementação de modelos de aprendizado de máquina. Os cientistas de dados podem experimentar rapidamente diferentes conjuntos de dados, iterar modelos e dimensioná-los para produção sem precisar se preocupar com silos de dados ou movimentação entre sistemas.

Aplicativos orientados por dados

Os data lakehouses alimentam aplicativos orientados por dados que exigem insights em tempo real e recursos de tomada de decisão. Esses aplicativos geralmente dependem de informações atualizadas para oferecer aos usuários experiências personalizadas ou recomendações automatizadas.

Por exemplo, um mecanismo de recomendação de site de comércio eletrônico pode usar um data lakehouse para analisar o comportamento do usuário em tempo real e fornecer sugestões de produtos relevantes. Da mesma forma, as empresas de logística podem usar data lakehouses para otimizar as rotas de entrega com base em dados de tráfego em tempo real e padrões históricos de entrega.

Plataformas populares de data lakehouse

Chegou a hora de você conhecer as tecnologias que tornam possível a arquitetura de data lakehouse. Nesta seção, explicarei os mais populares.

1. Casa do lago da Databricks

A Databricks foi pioneira na arquitetura de data lakehouse, oferecendo o Delta Lake como um componente central de sua plataforma. O Delta Lake adiciona melhorias de confiabilidade e desempenho aos data lakes, permitindo transações ACID e garantindo a qualidade dos dados.

O Databricks Lakehouse combina a escalabilidade dos data lakes com os recursos de gerenciamento de dados dos data warehouses, fornecendo uma plataforma unificada para análise e aprendizado de máquina. Sua integração com o Apache Spark o torna uma opção atraente para organizações que utilizam recursos de processamento de big data.

Se você quiser saber mais sobre a plataforma Databricks Lakehouse e como ela pode modernizar as arquiteturas de dados e melhorar os processos de gerenciamento de dados, confira o curso gratuito Introduction to Databricks.

2. Google BigLake

O BigLake do Google integra os princípios de data lakehouse com seu ecossistema de nuvem existente, fornecendo uma plataforma unificada de armazenamento e análise de dados. O BigLake permite que os usuários gerenciem dados estruturados e não estruturados, facilitando a realização de análises em diferentes tipos de dados.

Com a integração com os serviços do Google Cloud, o BigLake oferece uma solução abrangente para as equipes de dados que desejam usar ferramentas nativas da nuvem para suas necessidades de dados. Ele suporta processamento em lote e em tempo real, o que o torna adequado para uma ampla gama de casos de uso.

3. Formação do lago AWS

O AWS Lake Formation fornece ferramentas para você configurar um data lakehouse usando os serviços de nuvem do AWS, oferecendo integração e gerenciamento perfeitos. Com o AWS Lake Formation, você pode facilmente ingerir, catalogar e proteger dados, criando um data lakehouse unificado.

O AWS Lake Formation também se integra a outros serviços de análise do AWS, como o Amazon Redshift e o AWS Glue, fornecendo um conjunto completo de ferramentas para processamento e análise de dados. Isso o torna uma opção atraente para organizações que já usam a AWS para sua infraestrutura.

4. Snowflake

A arquitetura do Snowflake está evoluindo para dar suporte aos recursos de data lakehouse, permitindo que os usuários gerenciem com eficiência dados estruturados e semiestruturados. O Snowflake fornece análises de alto desempenho e, ao mesmo tempo, oferece flexibilidade no armazenamento e gerenciamento de dados.

Os recursos de data lakehouse do Snowflake permitem que você combine diferentes tipos de dados e realize análises avançadas sem precisar de vários sistemas. Seu design nativo da nuvem e o suporte a implementações em várias nuvens fazem dele uma opção popular para equipes que desejam modernizar sua infraestrutura de dados.

Se você estiver interessado no Snowflake, confira o curso Introduction to Snowflake.

5. Azure Synapse Analytics

O Azure Synapse Analytics da Microsoft combina recursos de big data e armazenamento de dados em uma solução unificada de data lakehouse.

O Synapse permite que as equipes analisem dados estruturados e não estruturados usando uma variedade de ferramentas, incluindo SQL, Apache Spark e Data Explorer. Sua profunda integração com outros serviços do Azure, como o Azure Data Lake Storage e o Power BI, proporciona uma experiência perfeita para processamento, análise e visualização de dados de ponta a ponta, tornando-o uma opção ideal para organizações dentro do ecossistema do Azure.

6. Apache Hudi

O Apache Hudi é um projeto de código aberto que traz recursos transacionais para os lagos de dados. Ele oferece suporte a transações ACID, upserts e controle de versão de dados.

O Hudi se integra bem a plataformas de armazenamento em nuvem, como Amazon S3 ee Google Cloud Storage, tornando-o adequado para análises em tempo real e pipelines de aprendizado de máquina. Com suporte para mecanismos populares de big data, como o Apache Spark e o Presto, o Hudi oferece flexibilidade para a criação de um data lakehouse personalizado com tecnologia de código aberto.

7. Dremio

A Dremio oferece uma plataforma de data lakehouse aberta para cargas de trabalho rápidas de análise e BI diretamente em data lakes na nuvem.

Com sua abordagem baseada em SQL e a integração com o Apache Arrow, o Dremio permite que as equipes realizem análises de alto desempenho sem a movimentação de dados. Ele é vantajoso para as organizações que desejam oferecer suporte a consultas baseadas em SQLem seus data lakes, o que o torna uma opção popular para as equipes de dados que priorizam velocidade e eficiência.

Comparação das plataformas de data lakehouse

Como você pode imaginar, nem todas as tecnologias que suportam a arquitetura de data lakehouse são criadas da mesma forma. A tabela a seguir os compara em várias categorias:

|

Plataforma |

Tipo de armazenamento primário |

Suporta dados estruturados e não estruturados |

Mecanismo de computação |

Transações ACID |

Processamento em tempo real |

Integração com ML/AI |

Caso de uso ideal |

|

Casa do lago da Databricks |

Delta Lake (Apache Parquet) |

Sim |

Apache Spark |

Sim |

Sim |

Forte (MLflow, Spark ML) |

Análise de big data, IA/ML |

|

Google BigLake |

Armazenamento na nuvem do Google |

Sim |

Google BigQuery |

Sim |

Sim |

Integrado com a IA do Google Cloud |

Análise nativa da nuvem |

|

Formação do lago AWS |

Amazon S3 |

Sim |

Amazon Redshift / AWS Glue |

Sim |

Limitada |

Integração com o Amazon SageMaker |

Lago de dados centrado na AWS |

|

Snowflake |

Proprietário (baseado em nuvem) |

Principalmente estruturado |

Computação Snowflake |

Sim |

Limitada |

Limitada |

Análise de alto desempenho em várias nuvens |

|

Azure Synapse Analytics |

Armazenamento do lago de dados do Azure |

Sim |

SQL, Apache Spark, Data Explorer |

Sim |

Sim |

Forte (ML do Azure, Power BI) |

Análise do ecossistema da Microsoft |

|

Apache Hudi |

Armazenamento de objetos na nuvem (por exemplo, S3, GCS) |

Sim |

Apache Spark, Presto |

Sim |

Sim |

Suporte externo de ML |

Lagos de dados em tempo real de código aberto |

|

Dremio |

Lagos de dados na nuvem |

Sim |

Dremio (Apache Arrow) |

Não |

Sim |

Sem integração nativa |

SQL de alto desempenho em lagos de nuvem |

Desafios e considerações para a implementação de um Data Lakehouse

Algumas coisas são boas demais para serem verdadeiras, e o data lakehouse não é exceção. Aparentemente, ele oferece tudo, mas também tem algumas desvantagens. Vamos analisá-los nesta seção.

1. Integração com sistemas existentes

A integração de um data lakehouse com sistemas legados pode ser complexa e exige um planejamento cuidadoso. As equipes podem precisar migrar dados de data lakes ou armazéns existentes, o que pode consumir muito tempo e recursos.

Também podem surgir problemas de compatibilidade na integração com sistemas mais antigos que não foram projetados para trabalhar com arquiteturas de dados modernas. Para implementar com sucesso um data lakehouse, você deve avaliar sua infraestrutura atual, planejar a migração de dados e garantir que todos os sistemas possam trabalhar juntos de forma harmoniosa.

2. Gerenciar a governança e a segurança dos dados

Equilibrar escalabilidade com governança e segurança pode ser um desafio, especialmente em setores regulamentados. Os data lakehouses devem fornecer ferramentas robustas de governança para gerenciar o acesso aos dados, a linhagem e a conformidade, mantendo a escalabilidade necessária para lidar com grandes conjuntos de dados.

Outra consideração importante é garantir que os dados confidenciais estejam devidamente protegidos. Você precisa implementar controles de acesso, criptografia e auditoria para proteger seus dados e atender aos requisitos regulamentares. Isso pode ser especialmente desafiador em ambientes híbridos e com várias nuvens, em que os dados são distribuídos em diferentes locais.

3. Compensações entre custo e desempenho

Ao implementar um data lakehouse, encontrar o equilíbrio certo entre eficiência de custo e desempenho pode ser um desafio. Embora os data lakehouses ofereçam armazenamento econômico, a obtenção de análises de alto desempenho pode exigir investimentos adicionais em recursos de computação.

Você precisa avaliar cuidadosamente os requisitos de carga de trabalho e determinar a maneira mais econômica de atender às suas necessidades de desempenho. Isso pode envolver a otimização da alocação de recursos, a escolha dos serviços de nuvem certos ou o ajuste da configuração do data lakehouse para garantir que as metas de custo e desempenho sejam atingidas.

Conclusão

Os data lakehouses representam uma evolução significativa na arquitetura de dados, combinando os pontos fortes dos data lakes e dos data warehouses em uma plataforma única e unificada!

Com a imposição de esquemas, suporte a transações ACID, escalabilidade e processamento de dados em tempo real, os data lakehouses oferecem uma solução poderosa para as necessidades modernas de dados.

Os data lakehouses são uma opção atraente para as equipes de dados que buscam simplificar o panorama de dados e aprimorar os recursos de análise.

Explore o curso gratuito Understanding Data Engineering para saber mais sobre data lakehouses e outras tecnologias emergentes de engenharia de dados.

Obtenha a certificação para a função de engenheiro de dados dos seus sonhos

Nossos programas de certificação ajudam você a se destacar e a provar que suas habilidades estão prontas para o trabalho para possíveis empregadores.

Perguntas frequentes

Por que os data lakehouses estão se tornando populares?

Os data lakehouses combinam escalabilidade com análises robustas, o que os torna econômicos para empresas que buscam flexibilidade, alto desempenho e insights de dados em tempo real.

Que desafios os data lakehouses enfrentam em comparação com as arquiteturas de dados tradicionais?

Os data lakehouses devem equilibrar o desempenho dos dados estruturados e não estruturados, que podem ser complexos. A implementação de governança e segurança em diversos tipos de dados e a integração com sistemas legados também apresentam desafios.

Como um data lakehouse lida com o gerenciamento de metadados?

Os data lakehouses usam camadas de metadados (como o tratamento de metadados do Delta Lake) para organizar, aplicar esquemas e otimizar consultas, melhorando a descoberta, a governança e o desempenho dos dados.

Os data lakehouses podem substituir tanto os data lakes quanto os data warehouses?

Embora os lakehouses possam substituir com frequência os data lakes e os warehouses, alguns casos de uso especializado ainda podem exigir sistemas dedicados. Para a maioria das necessidades, as casas de lago oferecem uma solução unificada e flexível.

Como os data lakehouses suportam o controle de versão dos dados?

Tecnologias como Delta Lake e Apache Hudi permitem o controle de versão dos dados, permitindo que os usuários rastreiem as alterações, realizem reversões e garantam a consistência dos dados ao longo do tempo.

Qual é a função dos data lakehouses na democratização dos dados?

Os Lakehouses promovem a democratização dos dados, oferecendo uma plataforma única em que todos os dados são acessíveis e controlados, capacitando equipes mais amplas a acessar e aproveitar os dados com segurança.