Kurs

Im Datenmanagement sind neue Lösungen entstanden, die die Grenzen traditioneller Architekturen wie Data Lakes und Data Warehouses überwinden. Obwohl beide Architekturen bei der Datenspeicherung und -analyse eine wichtige Rolle gespielt haben, können sie bei der Bewältigung moderner Datenverarbeitungsanforderungen eine Herausforderung darstellen.

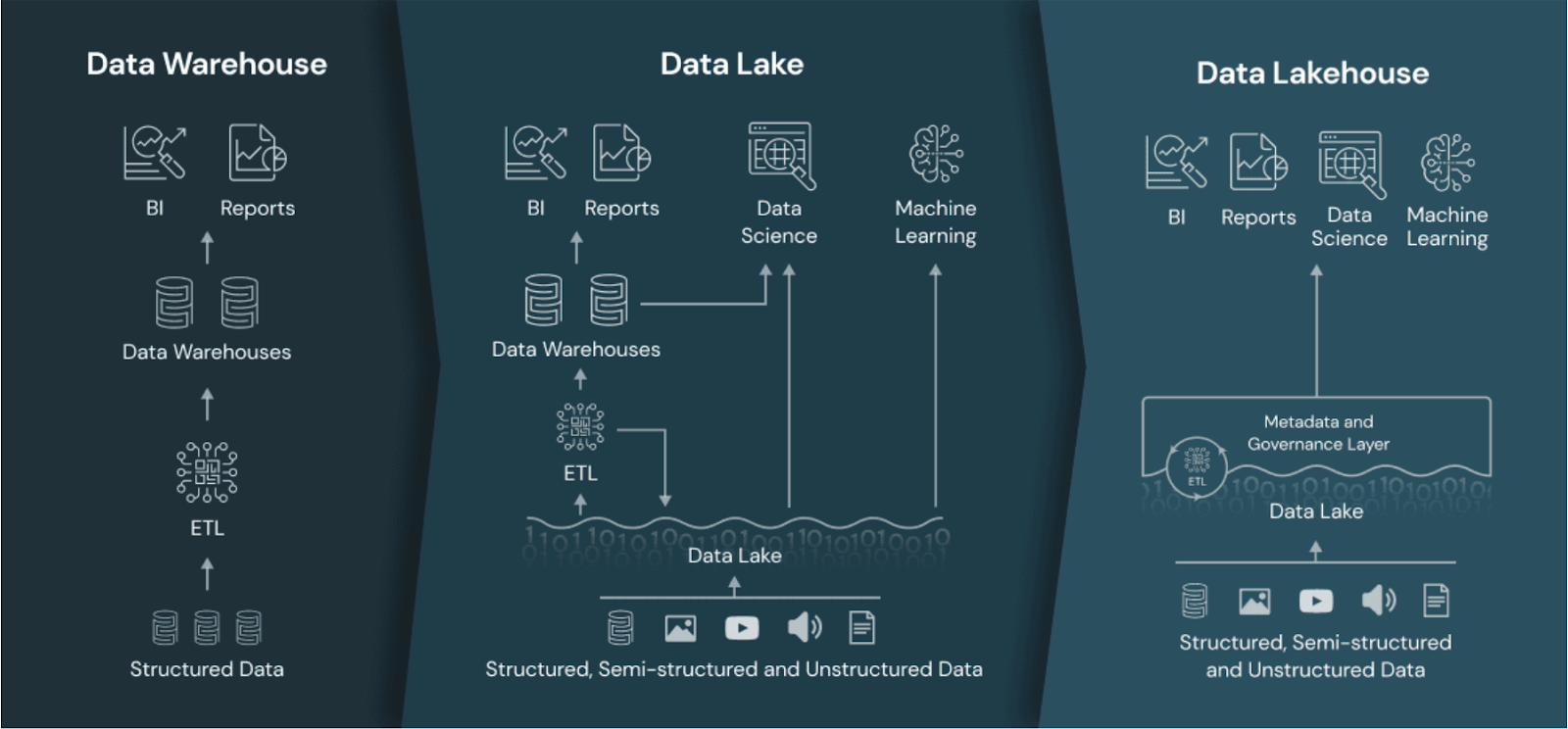

Obwohl Data Lakes skalierbar und flexibel sind, gibt es oft Probleme mit der Governance und der Leistung. Andererseits sind Data Warehouses zwar leistungsfähig für Analysen, aber kostspielig und weniger flexibel. Das Data Lakehouse zielt darauf ab, diese Probleme zu lösen, indem es die Stärken von Data Lakes und Warehouses kombiniert und ihre Schwächen minimiert.

In diesem Leitfaden erkläre ich dir, was ein Data Lakehouse ist, wie es sich von traditionellen Datenarchitekturen unterscheidet und warum es bei Datenexperten, die nach einer einheitlichen Datenmanagementlösung suchen, immer beliebter wird.

Was ist ein Data Lakehouse?

Ein Data Lakehouse ist eine Architektur, die die Skalierbarkeit und kostengünstige Speicherung von Data Lakes mit der Leistung, Zuverlässigkeit und den Governance-Funktionen von Data Warehouses kombiniert.

Durch die Integration der Stärken beider Architekturen bietet ein Data Lakehouse eine einheitliche Plattform zum Speichern, Verarbeiten und Analysieren aller Arten von Daten - strukturierte, halbstrukturierte und unstrukturierte.

Der einheitliche Ansatz ermöglicht eine größere Flexibilität bei der Datenverarbeitung und unterstützt eine breite Palette von Analyseanwendungen, von Business Intelligence bis hin zum maschinellen Lernen.

Das Data Lakehouse im Vergleich zum Data Warehouse und Data Lake. Bildquelle: Databricks.

Werde Dateningenieur

Data Lakehouse vs. Data Lake vs. Data Warehouse

Bevor du dich näher mit der Data Lakehouse-Architektur beschäftigst, ist es wichtig zu verstehen, wie sie sich von Data Warehouses und Data Lakes unterscheidet.

Datenlager

Data Warehouses werden für die Speicherung strukturierte Daten zu speichern und leistungsstarke Analysen und Berichte zu erstellen.

Eine ihrer größten Stärken ist die Fähigkeit, schnelle Abfragen auszuführen, wodurch sie sich gut für Business Intelligence und Reporting Anwendungsfälle.

Data Warehouses verwenden ein klar definiertes Schema, das eine strenge Data Governance unterstützt. So wird sichergestellt, dass die Daten genau, konsistent und für die Analyse leicht zugänglich sind.

Diese Vorteile haben jedoch ihren Preis. Data Warehouses sind in der Regel teuer in der Wartung, weil sie auf spezielle Hardware und umfangreiche Datenumwandlungsprozesse angewiesen sind, die in der Regel ETL-Pipelines (Extrahieren, Umwandeln, Laden) erfordern.

Die starre Struktur von Data Warehouses macht sie auch weniger geeignet für den Umgang mit unstrukturierten Daten oder die schnelle Anpassung an Änderungen des Datenformats. Dieser Mangel an Flexibilität kann eine erhebliche Einschränkung für Organisationen sein, die mit sich schnell entwickelnden Datenquellen oder Daten arbeiten wollen, die keinem vordefinierten Schema entsprechen, wie z.B. Text, Bilder, Audio usw.

Wenn du mehr über die Grundlagen von Data Warehousing erfahren möchtest, schau dir den kostenlosen Kurs Einführung in Data Warehousing an.

Datensee

Data Lakes wurden entwickelt, um große Mengen an halbstrukturierten oder unstrukturierten Datenzu speichern . Ihr Hauptvorteil liegt in ihrer Skalierbarkeit, was sie zu einer attraktiven Option für Teams macht, die mit verschiedenen Datentypen und großen Datenmengen arbeiten.

Die Flexibilität von Data Lakes ermöglicht es, Rohdaten in ihrem nativen Format zu speichern, was sie ideal macht für Datenexploration und wissenschaftliche Projekte.

Allerdings haben Data Lakes oft Probleme mit Data Governance und Datenqualität. Da die Daten in ihrer Rohform ohne viel Struktur gespeichert werden, kann es schwierig sein, eine einheitliche Datenqualität zu gewährleisten.

Die Mangel an Governance kann zu dem führen, was gemeinhin als "Datensumpf" bezeichnet wird, bei dem wertvolle Erkenntnisse unter schlecht organisierten Daten begraben werden.

Die Leistung ist ein weiterer wichtiger Aspekt in Data Lakes, insbesondere bei der Ausführung komplexer analytischer Abfragen. Data Lakes sind nicht für schnelle Abfragen oder für die Kombination verschiedener Datentypen wie Bilder, Text und Audio optimiert.

Daten-See-Haus

Ein Data Lakehouse zielt darauf ab, das Beste aus Data Lakes und Data Warehouses zu kombinieren. Es bietet eine ausgewogenere Lösung, indem es die Skalierbarkeit und die kostengünstigen Speichermöglichkeiten von Data Lakes mit den Leistungs- und Governance-Stärken von Data Warehouses verbindet.

Theoretisch kannst du in einem Lakehouse strukturierte und unstrukturierte Daten zu geringeren Kosten speichern und gleichzeitig die für leistungsstarke Analysen erforderlichen Funktionen nutzen.

Data Lakehouses unterstützen ACID-Transaktionen, was bedeutet, dass Datenaktualisierungen und -löschungen zuverlässig verwaltet werden können, was bei traditionellen Data Lakes oft nicht der Fall ist. Dies ermöglicht eine bessere Datenintegrität und Governance, wodurch sich Data Lakehouses besser für Unternehmensanwendungen eignen.

Data Lakehouses unterstützen auch die Verarbeitung von Daten in Echtzeit und ermöglichen es Unternehmen, Streaming-Daten zu verarbeiten und Erkenntnisse in Echtzeit zu gewinnen, was in einigen Bereichen wichtig ist.

Merkmale und Komponenten eines Data Lakehouse

Wie ist es möglich, das Beste aus beiden Welten in einer einzigen Plattform zu vereinen? In diesem Abschnitt erkläre ich die Komponenten, die die Architektur des Seehauses möglich machen.

1. Trennung von Storage und Compute mit einheitlichem Datenmanagement

In einem Data Lakehouse sind Storage und Compute getrennt, aber eng integriert, was eine flexible, skalierbare Ressourcennutzung ermöglicht.

Die Daten werden in einem kosteneffizienten Cloud-Objektspeicher gespeichert, während die Rechenressourcen je nach Arbeitsanforderung unabhängig voneinander skaliert werden können. Dieser Ansatz reduziert die Notwendigkeit, Daten zwischen Systemen zu verschieben, und ermöglicht es den Nutzern, Daten vor Ort zu verarbeiten, ohne sie aufwendig zu extrahieren und zu laden.

Durch die Integration von Speicher- und Rechenkapazitäten optimieren Data Lakehouses die Datenverwaltung, verbessern die Effizienz und verringern die Latenzzeit, was zu schnelleren Erkenntnissen führt.

Die dynamische Ressourcenzuweisung ermöglicht außerdem eine bessere Kostenoptimierung und stellt sicher, dass die Rechenressourcen effektiv genutzt werden.

2. Schema-Durchsetzung und Governance

Data Lakehouses erzwingen Schemata, um die Datenqualität zu erhalten, und bieten Governance-Funktionen für die Einhaltung von Daten.

Die Durchsetzung von Schemata stellt sicher, dass die Daten in einem strukturierten Format organisiert sind, damit sie leichter abgefragt und analysiert werden können. Dies hilft, Dateninkonsistenzen zu vermeiden und die Datenqualität im gesamten Unternehmen zu verbessern.

Governance-Funktionen in Data Lakehouses ermöglichen es dir, den Datenzugriff, die Datenabfolge und die Einhaltung von Vorschriften zu verwalten. Mit eingebauten Governance-Tools können Data Lakehouses gesetzliche Anforderungen erfüllen und sensible Daten schützen. Das ist besonders wichtig für Branchen wie das Gesundheits- und Finanzwesen, in denen Datenschutz und Compliance entscheidend sind.

3. Unterstützung für ACID-Transaktionen

ACID-Transaktionen sorgen für die Zuverlässigkeit der Daten, so dass du Aktualisierungen und Löschungen sicher verwalten kannst.

In einem Data Lakehouse bieten ACID-Transaktionen das gleiche Maß an Datenintegrität, das man von einem traditionellen Data Warehouse erwartet, aber mit der zusätzlichen Flexibilität, unstrukturierte Daten zu verarbeiten.

Die Fähigkeit, ACID-Transaktionen zu unterstützen, bedeutet, dass Data Lakehouses für geschäftskritische Workloads verwendet werden können, bei denen die Genauigkeit der Daten entscheidend ist. Diese Eigenschaft macht Data Lakehouses zu einer attraktiven Wahl für Unternehmen, die die Datenkonsistenz über verschiedene Datenoperationen hinweg wahren müssen.

4. Datenverarbeitung in Echtzeit

Data Lakehouses können Daten in Echtzeit verarbeiten und ermöglichen so Anwendungsfälle wie Echtzeit-Analysen und Streaming Insights. Die Datenverarbeitung in Echtzeit ermöglicht es den Teams, datengestützte Entscheidungen schneller zu treffen und so die Reaktions- und Anpassungsfähigkeit zu verbessern.

Die Datenverarbeitung in Echtzeit kann zum Beispiel genutzt werden, um Kundeninteraktionen zu überwachen, Lagerbestände zu verfolgen oder Anomalien bei Finanztransaktionen zu erkennen. Indem sie unmittelbare Einblicke ermöglichen, helfen Data Lakehouses dir, den sich ändernden Marktbedingungen voraus zu sein und proaktiv auf neue Chancen zu reagieren.

5. Unterstützung von Multi-Cloud- und Hybrid-Architekturen

Data Lakehouses können in Multi-Cloud- oder Hybrid-Umgebungen betrieben werden und bieten Flexibilität und Skalierbarkeit.

Die Multi-Cloud-Unterstützung ermöglicht es Datenteams, die Bindung an einen bestimmten Anbieter zu vermeiden und die besten Dienste von verschiedenen Cloud-Anbietern zu nutzen. Die Unterstützung hybrider Architekturen stellt sicher, dass lokale Systeme in Cloud-Umgebungen integriert werden können, um ein einheitliches Datenmanagement zu ermöglichen.

Von dieser Flexibilität profitieren vor allem Teams mit komplexen Infrastrukturanforderungen oder solche, die eine Cloud-Migration durchführen.

Vorteile der Nutzung eines Data Lakehouse

In diesem Abschnitt erörtern wir die Vorteile eines Data Lakehouse zur Verwaltung verschiedener Datenverarbeitungsanforderungen.

1. Skalierbarkeit und Flexibilität

Data Lakehouses übernehmen die Skalierbarkeit von Data Lakes und sind damit in der Lage, wachsende Datenanforderungen zu bewältigen. Du kannst problemlos weitere Daten hinzufügen, ohne dich um Speicherplatzbeschränkungen kümmern zu müssen, damit deine Datenarchitektur mit dem Unternehmen mitwächst.

Apache Hudi, Delta Lake und Apache Iceberg können zum Beispiel die Speicherung von Tausenden von Dateien in Objektspeichersystemen wie Amazon S3, Azure Blob Storage oder Google Cloud Storage skalieren.

Ein weiterer großer Vorteil ist die Flexibilität, denn Data Lakehouses unterstützen strukturierte (z. B. Transaktionsdatensätze) und unstrukturierte Daten (z. B. Logdateien, Bilder und Videos). Das bedeutet, dass du alle deine Daten an einem Ort speichern kannst, unabhängig vom Format, und sie für verschiedene Analyse- und Machine Learning-Anwendungen nutzen kannst.

2. Kosteneffizienz

Data Lakehouses speichern Daten zu geringeren Kosten als Data Warehouses und unterstützen dennoch fortschrittliche Analysen.

Zum Beispiel nutzen Data Lakehouses, die auf Cloud Object Storage (wie Amazon S3 oder Google Cloud Storage) aufbauen, deren kostengünstige Speicherebenen. In Kombination mit den Apache Parquet- und ORC-Dateiformaten, die Daten komprimieren, um die Speicherkosten zu minimieren, kannst du mit Data Lakehouses erhebliche Einsparungen erzielen.

Die einheitliche Natur von Data Lakehouses bedeutet, dass keine separaten Systeme für Speicherung und Analyse unterhalten werden müssen, was zu Kosteneffizienz führt und Data Lakehouses zu einer attraktiven Option macht.

3. Schneller zu Erkenntnissen

Einheitliche Funktionen zur Datenspeicherung und -verarbeitung verkürzen die Zeit, die benötigt wird, um Erkenntnisse zu gewinnen. Mit Data Lakehouses müssen Daten nicht mehr zwischen Speicher- und Rechenumgebungen hin- und hergeschoben werden, wodurch Arbeitsabläufe optimiert und Latenzzeiten minimiert werden.

Technologien wie Apache Spark und Databricks ermöglichen es, Daten direkt im Lakehouse zu verarbeiten, sodass sie nicht mehr in separate Analyseumgebungen verschoben werden müssen.

Wenn du alle Daten an einem Ort hast und sie effizient verarbeitest, kannst du schnell Erkenntnisse gewinnen, die zu besseren Entscheidungen führen. Diese schnellere Einsicht ist besonders wertvoll für Branchen, in denen zeitnahe Informationen entscheidend sind, wie z.B. im Finanzwesen, im Einzelhandel und im Gesundheitswesen.

4. Datenmanagement und Sicherheit

Funktionen zur Schemaerzwingung und Data Governance erfüllen die Anforderungen an Datenqualität und Compliance. Data Lakehouses bieten Werkzeuge zur Verwaltung des Datenzugriffs, der Prüfpfade und der Datenreihenfolge, die für die Wahrung der Datenintegrität und die Einhaltung gesetzlicher Vorschriften unerlässlich sind.

Tools wie AWS Lake Formation, Azure Purview und Apache Ranger bieten eine zentrale Kontrolle über Datenzugriff, Berechtigungen und Prüfprotokolle, so dass du Daten sicher verwalten und unbefugten Zugriff verhindern kannst

Diese Governance- und Sicherheitsfunktionen machen Data Lakehouses für Unternehmen geeignet, die Datenschutzbestimmungen wie GDPR oder HIPAA einhalten müssen. Indem sie sicherstellen, dass die Daten ordnungsgemäß verwaltet und geschützt werden, tragen Data Lakehouses dazu bei, Vertrauen in die Daten und ihre Erkenntnisse zu schaffen.

Data Lakehouse Anwendungsfälle

In diesem Abschnitt gehen wir alle möglichen Anwendungsfälle für das Data Lakehouse durch.

Moderne Datenanalytik

Datenteams nutzen Data Lakehouses für Echtzeit-Analysen, Business Intelligence und maschinelle Lernabläufe. Durch die Bereitstellung einer einheitlichen Datenplattform ermöglichen Data Lakehouses den Fachleuten, historische und Echtzeitdaten zu analysieren und Erkenntnisse zu gewinnen, die zu besseren Geschäftsergebnissen führen.

Einzelhändler können zum Beispiel Data Lakehouses nutzen, um Verkaufsdaten in Echtzeit zu analysieren, Trends zu erkennen und ihren Bestand entsprechend anzupassen. Finanzinstitute können Data Lakehouses zur Risikoanalyse und Betrugserkennung nutzen, indem sie historische und Echtzeit-Transaktionsdaten für einen umfassenden Überblick kombinieren.

Im kostenlosen Kurs Moderne Datenarchitekturen verstehen erfährst du mehr über die Funktionsweise moderner Datenplattformen, von Ingestion und Serving bis hin zu Governance und Orchestrierung.

Pipelines für KI und maschinelles Lernen

Data Lakehouses bieten die Infrastruktur für den Aufbau und die Skalierung von KI- und ML-Modellen und ermöglichen einen einfachen Zugang zu strukturierten und unstrukturierten Daten. Modelle für maschinelles Lernen benötigen oft eine Vielzahl von Datentypen, und Data Lakehouses ermöglichen es, alle relevanten Daten an einem Ort zusammenzuführen.

Dieser einheitliche Datenzugriff vereinfacht das Trainieren, Testen und Einsetzen von Machine Learning-Modellen. Datenwissenschaftler können schnell mit verschiedenen Datensätzen experimentieren, Modelle iterieren und sie für die Produktion skalieren, ohne sich um Datensilos oder die Bewegung zwischen Systemen kümmern zu müssen.

Datengesteuerte Anwendungen

Data Lakehouses versorgen datengesteuerte Anwendungen, die Echtzeit-Einsichten und Entscheidungsmöglichkeiten benötigen. Diese Anwendungen verlassen sich oft auf aktuelle Informationen, um den Nutzern personalisierte Erfahrungen oder automatische Empfehlungen zu bieten.

Eine Empfehlungsmaschine für eine E-Commerce-Website kann zum Beispiel ein Data Lakehouse nutzen, um das Nutzerverhalten in Echtzeit zu analysieren und relevante Produktvorschläge zu machen. In ähnlicher Weise können Logistikunternehmen Data Lakehouses nutzen, um Lieferrouten auf der Grundlage von Echtzeit-Verkehrsdaten und historischen Liefermustern zu optimieren.

Beliebte Data Lakehouse Plattformen

Es ist an der Zeit, die Technologien kennenzulernen, die die Data Lakehouse-Architektur möglich machen. In diesem Abschnitt erkläre ich die beliebtesten.

1. Databricks Seehaus

Databricks ist ein Pionier der Data-Lakehouse-Architektur und bietet Delta Lake als Kernkomponente seiner Plattform an. Delta Lake verbessert die Zuverlässigkeit und Leistung von Data Lakes, ermöglicht ACID-Transaktionen und sichert die Datenqualität.

Databricks Lakehouse kombiniert die Skalierbarkeit von Data Lakes mit den Datenverwaltungsfunktionen von Data Warehouses und bietet eine einheitliche Plattform für Analysen und maschinelles Lernen. Die Integration mit Apache Spark macht es zu einer attraktiven Wahl für Unternehmen, die Big-Data-Verarbeitungsfunktionen nutzen.

Wenn du mehr über die Databricks Lakehouse Plattform erfahren möchtest und wie sie Datenarchitekturen modernisieren und Datenmanagementprozesse verbessern kann, dann schau dir den kostenlosen Kurs Einführung in Databricks an.

2. Google BigLake

Googles BigLake integriert die Prinzipien von Data Lakehouse in sein bestehendes Cloud-Ökosystem und bietet eine einheitliche Datenspeicher- und Analyseplattform. Mit BigLake können strukturierte und unstrukturierte Daten verwaltet werden, was die Durchführung von Analysen über verschiedene Datentypen hinweg erleichtert.

Durch die Integration mit Google Cloud Services bietet BigLake eine umfassende Lösung für Datenteams, die Cloud-native Tools für ihre Datenanforderungen nutzen möchten. Sie unterstützt sowohl die Stapelverarbeitung als auch die Echtzeitverarbeitung und eignet sich damit für eine Vielzahl von Anwendungsfällen.

3. AWS Lake Formation

AWS Lake Formation bietet Tools zum Einrichten eines Data Lakehouse mit den Cloud-Services von AWS, die eine nahtlose Integration und Verwaltung ermöglichen. Mit AWS Lake Formation kannst du ganz einfach Daten aufnehmen, katalogisieren und sichern und so ein einheitliches Data Lakehouse schaffen.

AWS Lake Formation lässt sich auch mit anderen AWS-Analyse-Services wie Amazon Redshift und AWS Glue integrieren und bietet so eine vollständige Suite von Tools für die Datenverarbeitung und -analyse. Das macht es zu einer attraktiven Option für Unternehmen, die bereits AWS für ihre Infrastruktur nutzen.

4. Schneeflocke

Die Architektur von Snowflake wird weiterentwickelt, um Data Lakehouse-Funktionen zu unterstützen, mit denen Nutzer strukturierte und halbstrukturierte Daten effizient verwalten können. Snowflake liefert leistungsstarke Analysen und bietet gleichzeitig Flexibilität bei der Datenspeicherung und -verwaltung.

Die Data Lakehouse-Funktionen von Snowflake ermöglichen es dir, verschiedene Datentypen zu kombinieren und fortschrittliche Analysen durchzuführen, ohne mehrere Systeme zu benötigen. Sein Cloud-natives Design und die Unterstützung für Multi-Cloud-Einsätze machen es zu einer beliebten Wahl für Teams, die ihre Dateninfrastruktur modernisieren wollen.

Wenn du dich für Snowflake interessierst, schau dir den Kurs Einführung in Snowflake an.

5. Azure Synapse Analytics

Azure Synapse Analytics von Microsoft kombiniert Big-Data- und Data-Warehousing-Funktionen in einer einheitlichen Data-Lakehouse-Lösung.

Mit Synapse können Teams sowohl strukturierte als auch unstrukturierte Daten mit einer Vielzahl von Tools analysieren, darunter SQL, Apache Spark und Data Explorer. Die tiefe Integration mit anderen Azure-Diensten wie Azure Data Lake Storage und Power BI bietet eine nahtlose Erfahrung für die durchgängige Datenverarbeitung, -analyse und -visualisierung, was sie zu einer idealen Option für Unternehmen innerhalb des Azure-Ökosystems macht.

6. Apache Hudi

Apache Hudi ist ein Open-Source-Projekt, das Data Lakes mit transaktionalen Funktionen ausstattet. Es unterstützt ACID-Transaktionen, Upserts und die Versionierung von Daten.

Hudi lässt sich gut in Cloud-Speicherplattformen wie Amazon S3 undund Google Cloud Storage integrieren und eignet sich daher für Echtzeit-Analysen und maschinelle Lernpipelines. Mit der Unterstützung für beliebte Big-Data-Engines wie Apache Spark und Presto bietet Hudi Flexibilität für den Aufbau eines benutzerdefinierten Data Lakehouse auf Open-Source-Technologie.

7. Dremio

Dremio bietet eine offene Data Lakehouse Plattform für schnelle Analysen und BI-Workloads direkt auf Cloud Data Lakes.

Mit seinem SQL-basierten Ansatz und der Integration von Apache Arrow ermöglicht Dremio Teams leistungsstarke Analysen, ohne dass Daten verschoben werden müssen. Es ist von Vorteil für Unternehmen, die SQL-basierte Abfragenin ihren Data Lakes unterstützen wollen, was es zu einer beliebten Wahl für Datenteams macht, die Wert auf Geschwindigkeit und Effizienz legen.

Vergleich der Data Lakehouse Plattformen

Wie du dir vorstellen kannst, sind nicht alle Technologien, die die Data Lakehouse-Architektur unterstützen, gleich. Die folgende Tabelle vergleicht sie in verschiedenen Kategorien:

|

Plattform |

Primärspeicher Typ |

Unterstützt strukturierte und unstrukturierte Daten |

Compute Engine |

ACID-Transaktionen |

Verarbeitung in Echtzeit |

Integration mit ML/AI |

Idealer Anwendungsfall |

|

Databricks Seehaus |

Delta Lake (Apache Parkett) |

Ja |

Apache Spark |

Ja |

Ja |

Stark (MLflow, Spark ML) |

Big Data-Analytik, KI/ML |

|

Google BigLake |

Google Cloud Storage |

Ja |

Google BigQuery |

Ja |

Ja |

Integriert mit Google Cloud AI |

Cloud-native Analytik |

|

AWS Lake Formation |

Amazon S3 |

Ja |

Amazon Redshift / AWS Glue |

Ja |

Begrenzt |

Amazon SageMaker Integration |

AWS-zentriertes Daten-Lakehouse |

|

Schneeflocke |

Proprietär (Cloud-basiert) |

Vorrangig strukturiert |

Schneeflocken-Rechner |

Ja |

Begrenzt |

Begrenzt |

Multi-Cloud, Hochleistungs-Analytik |

|

Azure Synapse Analytics |

Azure Data Lake Storage |

Ja |

SQL, Apache Spark, Data Explorer |

Ja |

Ja |

Strong (Azure ML, Power BI) |

Microsoft Ökosystem-Analysen |

|

Apache Hudi |

Cloud Object Storage (z. B. S3, GCS) |

Ja |

Apache Spark, Presto |

Ja |

Ja |

Externe ML-Unterstützung |

Open-Source-Echtzeit-Datenseen |

|

Dremio |

Cloud Data Lakes |

Ja |

Dremio (Apache Arrow) |

Nein |

Ja |

Keine native Integration |

Leistungsstarkes SQL auf Cloud Lakes |

Herausforderungen und Überlegungen bei der Implementierung eines Data Lakehouse

Manche Dinge sind zu schön, um wahr zu sein, und das Data Lakehouse ist da keine Ausnahme. Sie bietet scheinbar alles, aber sie hat auch einige Nachteile. In diesem Abschnitt gehen wir sie durch.

1. Integration in bestehende Systeme

Die Integration eines Data Lakehouse mit Altsystemen kann komplex sein und erfordert eine sorgfältige Planung. Möglicherweise müssen Teams Daten aus bestehenden Data Lakes oder Warehouses migrieren, was zeit- und ressourcenaufwändig sein kann.

Kompatibilitätsprobleme können auch bei der Integration mit älteren Systemen auftreten, die nicht für moderne Datenarchitekturen ausgelegt sind. Um ein Data Lakehouse erfolgreich einzuführen, musst du deine aktuelle Infrastruktur bewerten, die Datenmigration planen und sicherstellen, dass alle Systeme harmonisch zusammenarbeiten können.

2. Verwaltung von Datenmanagement und -sicherheit

Der Spagat zwischen Skalierbarkeit, Governance und Sicherheit kann eine Herausforderung sein, besonders in regulierten Branchen. Data Lakehouses müssen robuste Governance-Tools bereitstellen, um den Datenzugriff, die Datenabfolge und die Einhaltung von Vorschriften zu verwalten und gleichzeitig die Skalierbarkeit zu gewährleisten, die für die Verarbeitung großer Datenmengen erforderlich ist.

Ein weiterer wichtiger Aspekt ist die Sicherstellung, dass sensible Daten ordnungsgemäß gesichert werden. Du musst Zugangskontrollen, Verschlüsselung und Audits einführen, um deine Daten zu schützen und die gesetzlichen Anforderungen zu erfüllen. Das kann vor allem in hybriden und Multi-Cloud-Umgebungen eine Herausforderung sein, in denen die Daten über verschiedene Standorte verteilt sind.

3. Kompromisse zwischen Kosten und Leistung

Bei der Implementierung eines Data Lakehouse kann es eine Herausforderung sein, die richtige Balance zwischen Kosteneffizienz und Leistung zu finden. Während Data Lakehouses kosteneffizienten Speicherplatz bieten, kann eine leistungsstarke Analyse zusätzliche Investitionen in Rechenressourcen erfordern.

Du musst die Anforderungen an die Arbeitsbelastung sorgfältig abwägen und die kosteneffizienteste Methode zur Erfüllung deiner Leistungsanforderungen ermitteln. Dazu kann es gehören, die Ressourcenzuweisung zu optimieren, die richtigen Cloud-Dienste auszuwählen oder die Konfiguration des Data Lakehouse anzupassen, um sicherzustellen, dass sowohl Kosten- als auch Leistungsziele erreicht werden.

Fazit

Data Lakehouses stellen eine bedeutende Entwicklung in der Datenarchitektur dar, da sie die Stärken von Data Lakes und Data Warehouses in einer einzigen, vereinheitlichten Plattform vereinen!

Mit der Durchsetzung von Schemata, der Unterstützung von ACID-Transaktionen, Skalierbarkeit und Datenverarbeitung in Echtzeit bieten Data Lakehouses eine leistungsstarke Lösung für moderne Datenanforderungen.

Data Lakehouses sind eine überzeugende Option für Datenteams, die ihre Datenlandschaft vereinfachen und ihre Analysefähigkeiten verbessern wollen.

Im kostenlosen Kurs Understanding Data Engineering erfährst du mehr über Data Lakehouses und andere aufkommende Data Engineering Technologien.

Lass dich für deine Traumrolle als Data Engineer zertifizieren

Unsere Zertifizierungsprogramme helfen dir, dich von anderen abzuheben und potenziellen Arbeitgebern zu beweisen, dass deine Fähigkeiten für den Job geeignet sind.

FAQs

Warum werden Data Lakehouses immer beliebter?

Data Lakehouses kombinieren Skalierbarkeit mit zuverlässigen Analysen und sind damit für Unternehmen, die Flexibilität, hohe Leistung und Dateneinblicke in Echtzeit suchen, kostengünstig.

Vor welchen Herausforderungen stehen Data Lakehouses im Vergleich zu traditionellen Datenarchitekturen?

Data Lakehouses müssen ein Gleichgewicht zwischen der Leistung für strukturierte und unstrukturierte Daten herstellen, die sehr komplex sein können. Die Umsetzung von Governance und Sicherheit für verschiedene Datentypen und die Integration von Altsystemen ist ebenfalls eine Herausforderung.

Wie geht ein Data Lakehouse mit der Verwaltung von Metadaten um?

Data Lakehouses nutzen Metadatenschichten (wie das Metadatenhandling von Delta Lake), um Daten zu organisieren, Schemata durchzusetzen und Abfragen zu optimieren und so Datenerkennung, Governance und Leistung zu verbessern.

Können Data Lakehouses sowohl Data Lakes als auch Data Warehouses ersetzen?

Während Lakehouses oft Data Lakes und Warehouses ersetzen können, erfordern einige spezielle Anwendungsfälle immer noch spezielle Systeme. Für die meisten Bedürfnisse bieten die Seehäuser eine einheitliche, flexible Lösung.

Wie unterstützen Data Lakehouses die Datenversionierung?

Technologien wie Delta Lake und Apache Hudi ermöglichen die Versionierung von Daten, so dass die Nutzer/innen Änderungen nachverfolgen, Rollbacks durchführen und die Datenkonsistenz im Laufe der Zeit sicherstellen können.

Welche Rolle spielen Data Lakehouses bei der Demokratisierung von Daten?

Lakehouses fördern die Demokratisierung von Daten, indem sie eine einzige Plattform bieten, auf der alle Daten zugänglich sind und verwaltet werden. Dadurch können breitere Teams sicher auf Daten zugreifen und sie nutzen.