Kurs

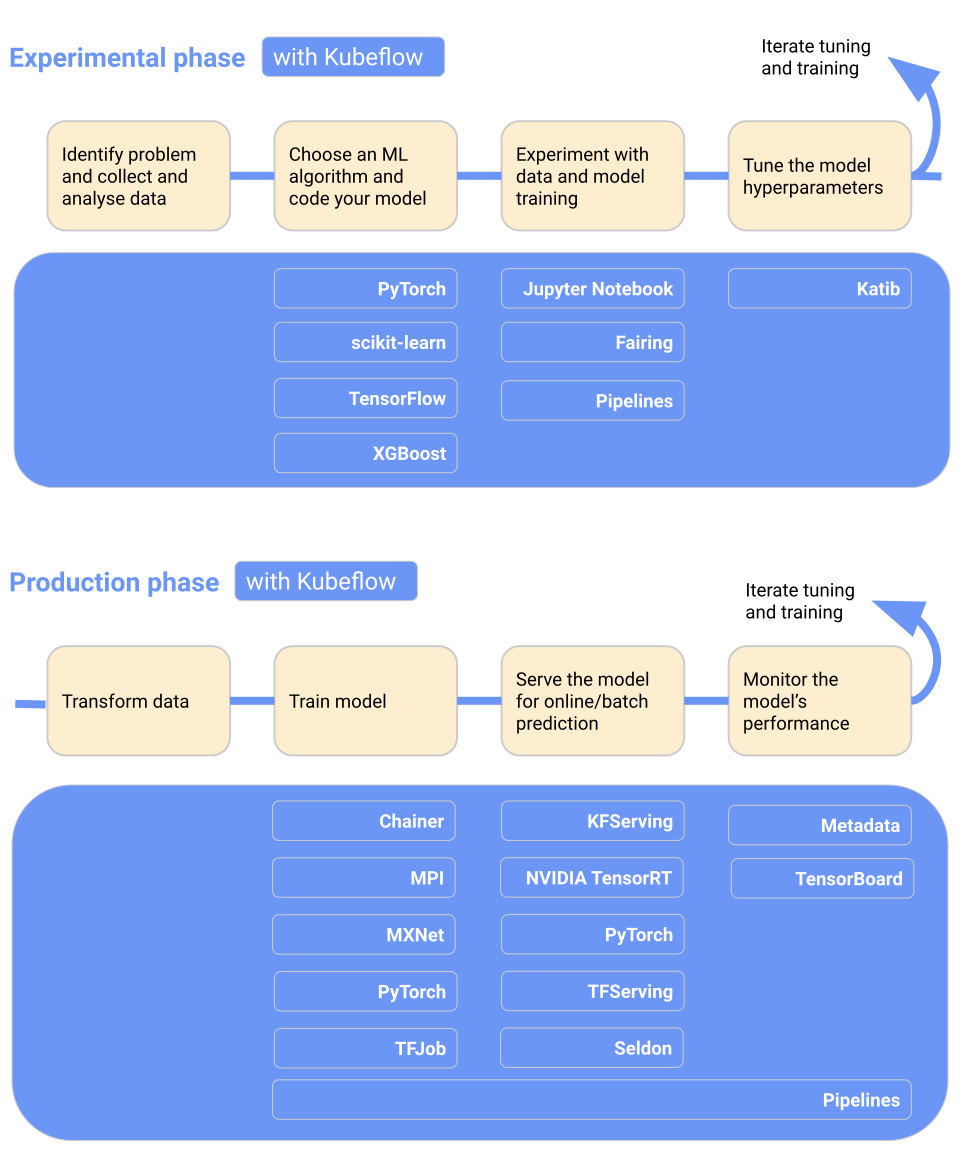

Wie wir in unserem Artikel " Erste Schritte mit MLOps" beschrieben haben, basiert MLOps auf den Grundlagen von DevOps, der Softwareentwicklungsstrategie zur effizienten Erstellung, Bereitstellung und Ausführung von Unternehmensanwendungen.

Es ist ein Ansatz für die Verwaltung von Machine-Learning-Projekten in großem Maßstab. MLOps verbessern die Zusammenarbeit zwischen Entwicklungs-, Betriebs- und Data Science-Teams. Das Ergebnis sind eine schnellere Modellbereitstellung, eine optimierte Teamproduktivität, geringere Risiken und Kosten sowie eine kontinuierliche Modellüberwachung in der Produktion.

Warum MLOps wichtig ist und welche Probleme es lösen soll, erfährst du in unserem Blog über die Vergangenheit, Gegenwart und Zukunft von MLOps.

In diesem Beitrag lernen wir die besten MLOps-Tools für die Modellentwicklung, -bereitstellung und -überwachung kennen, um das Ökosystem des maschinellen Lernens zu standardisieren, zu vereinfachen und zu rationalisieren. Wenn du eine gründliche Einführung in die MLOps-Grundlagen erhalten möchtest, schau dir unseren Lernpfad an.

Willst du mit generativer KI beginnen?

Lerne, wie du mit LLMs in Python direkt in deinem Browser arbeiten kannst

Rahmenwerk für große Sprachmodelle (LLMs)

Mit der Einführung von GPT-4 und später GPT-4o hat der Wettlauf begonnen, große Sprachmodelle zu erstellen und das volle Potenzial der modernen KI auszuschöpfen. LLMs benötigen Vektordatenbanken und Integrationsframeworks für den Aufbau intelligenter KI-Anwendungen.

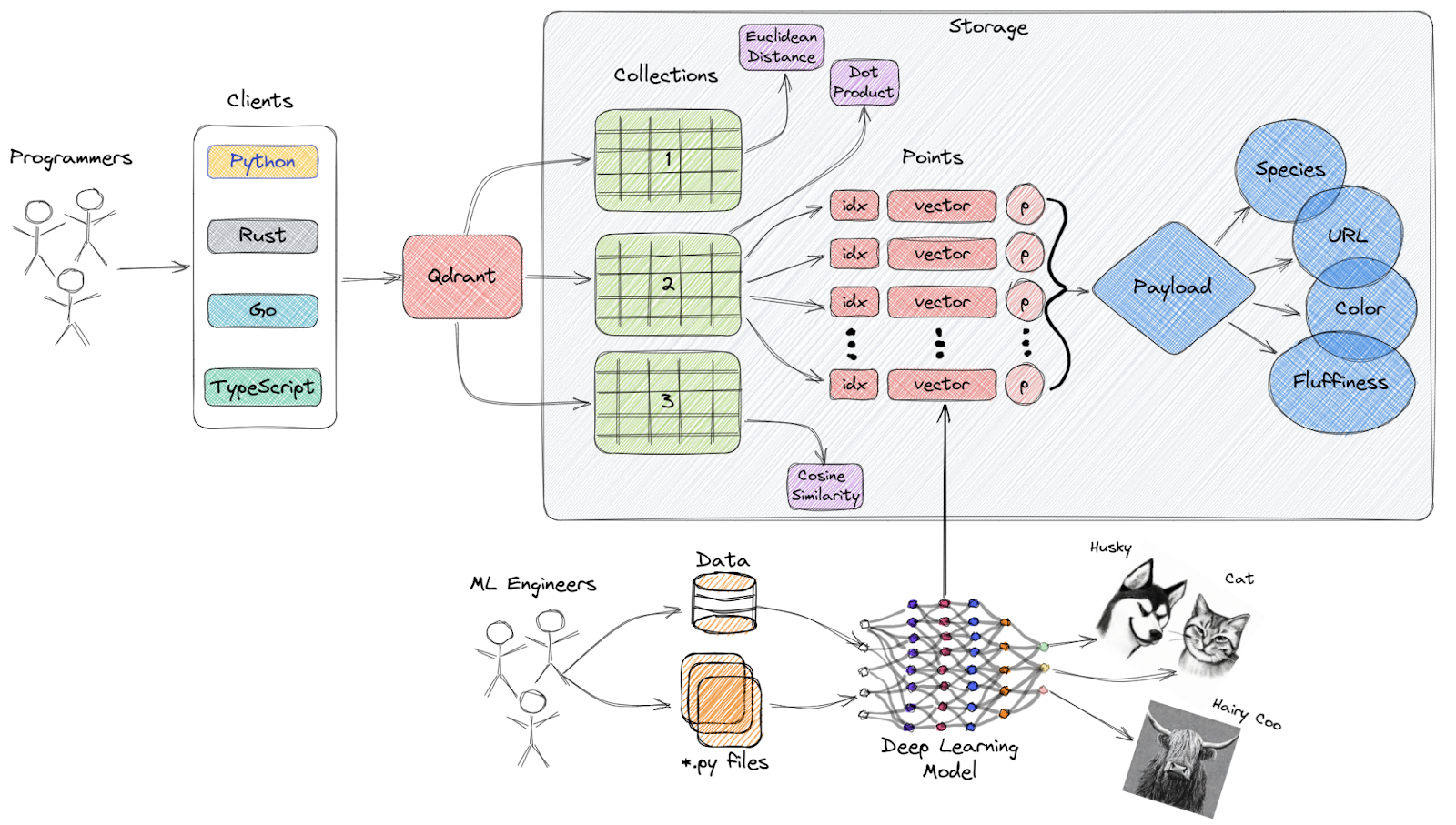

1. Qdrant

Qdrant ist eine Open-Source-Suchmaschine für Vektorähnlichkeit und eine Vektordatenbank, die einen produktionsreifen Dienst mit einer praktischen API bietet, mit der du Vektoreinbettungen speichern, suchen und verwalten kannst.

Überblick über die Architektur von Qdrant

Wichtige Merkmale:

- Einfach zu verwendende API: Sie bietet eine benutzerfreundliche Python-API und ermöglicht es Entwicklern, Client-Bibliotheken in verschiedenen Programmiersprachen zu erstellen.

- Schnell und genau: Es verwendet eine einzigartige Modifikation des HNSW-Algorithmus für die Approximate Nearest Neighbor Search, die eine hochmoderne Suchgeschwindigkeit ermöglicht, ohne Kompromisse bei der Genauigkeit einzugehen.

- Reichhaltige Datentypen: Qdrant unterstützt eine Vielzahl von Datentypen und Abfragebedingungen, darunter String-Matching, numerische Bereiche, geografische Standorte und mehr.

- Verteilt: Sie ist Cloud-nativ und kann horizontal skaliert werden, so dass die Entwickler genau die richtige Menge an Rechenressourcen für jede Datenmenge nutzen können, die sie benötigen.

- Effizient: Qdrant wurde vollständig in Rust entwickelt, einer Sprache, die für ihre Leistungsfähigkeit und Ressourceneffizienz bekannt ist.

Entdecke die besten Vektordatenbanken, indem du Die 5 besten Vektordatenbanken | Eine Liste mit Beispielen liest.

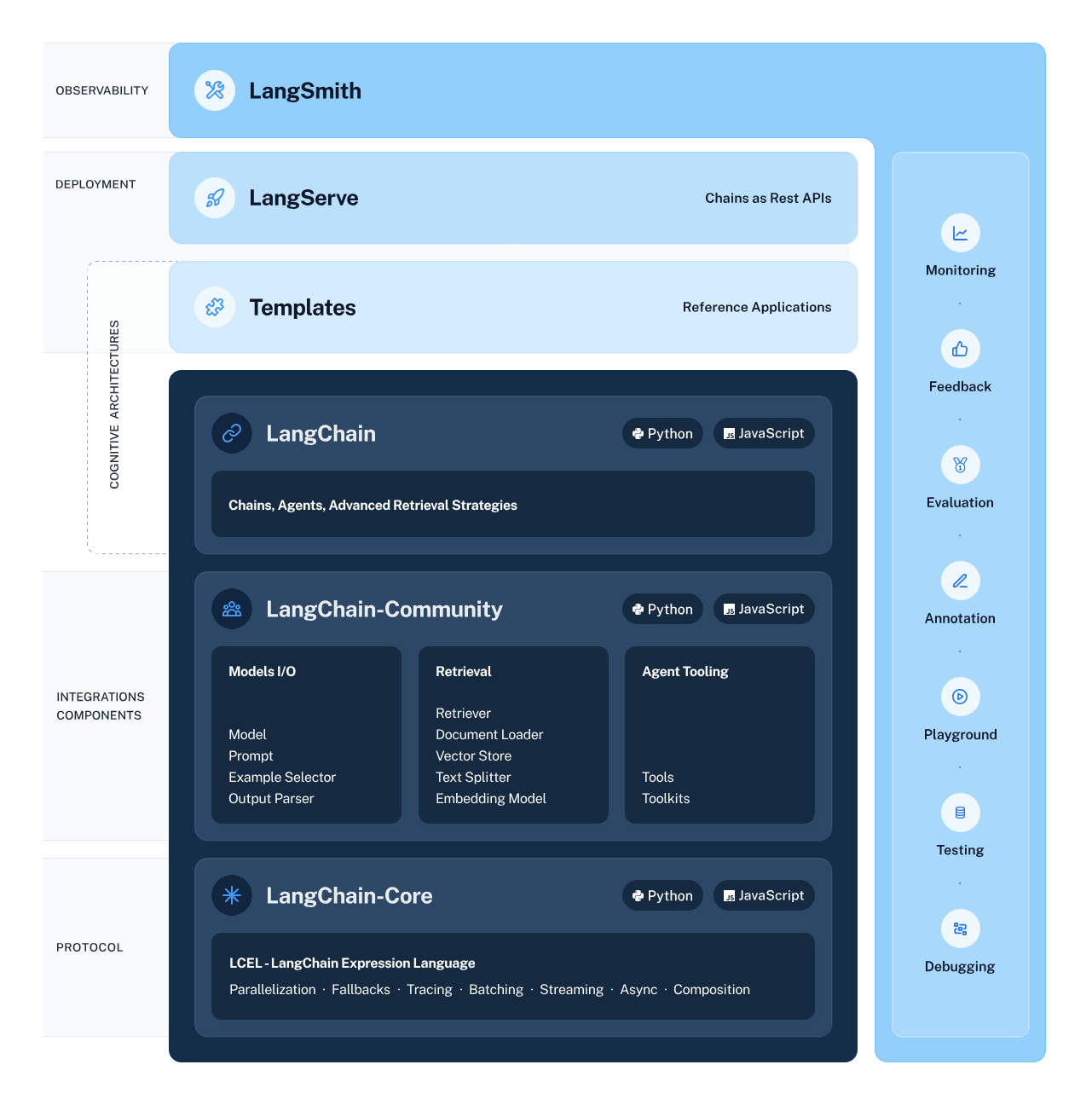

2. LangChain

LangChain ist ein vielseitiges und leistungsstarkes Framework für die Entwicklung von Anwendungen, die auf Sprachmodellen basieren. Es bietet verschiedene Komponenten, mit denen Entwickler kontextbezogene und schlussfolgernde Anwendungen erstellen, einsetzen und überwachen können.

Der Rahmen besteht aus 4 Hauptkomponenten:

- LangChain-Bibliotheken: Die Python- und JavaScript-Bibliotheken bieten Schnittstellen und Integrationen, mit denen du kontextabhängige Anwendungen entwickeln kannst.

- LangChain-Vorlagen: Diese Sammlung von leicht einsetzbaren Referenzarchitekturen deckt eine Vielzahl von Aufgaben ab und bietet Entwicklern vorgefertigte Lösungen.

- LangServe: Diese Bibliothek ermöglicht es Entwicklern, LangChain-Ketten als REST-API einzusetzen.

- LangSmith: Eine Plattform, mit der du Ketten, die auf einem beliebigen LLM-Framework aufbauen, debuggen, testen, bewerten und überwachen kannst.

LangChain Ecosystem

Lerne , wie du LLM-Anwendungen mit LangChain erstellst und entdecke das ungenutzte Potenzial großer Sprachmodelle.

Lernpfade und Werkzeuge zur Verwaltung von Modellmetadaten

Mit diesen Tools kannst du die Metadaten der Modelle verwalten und die Experimente nachverfolgen:

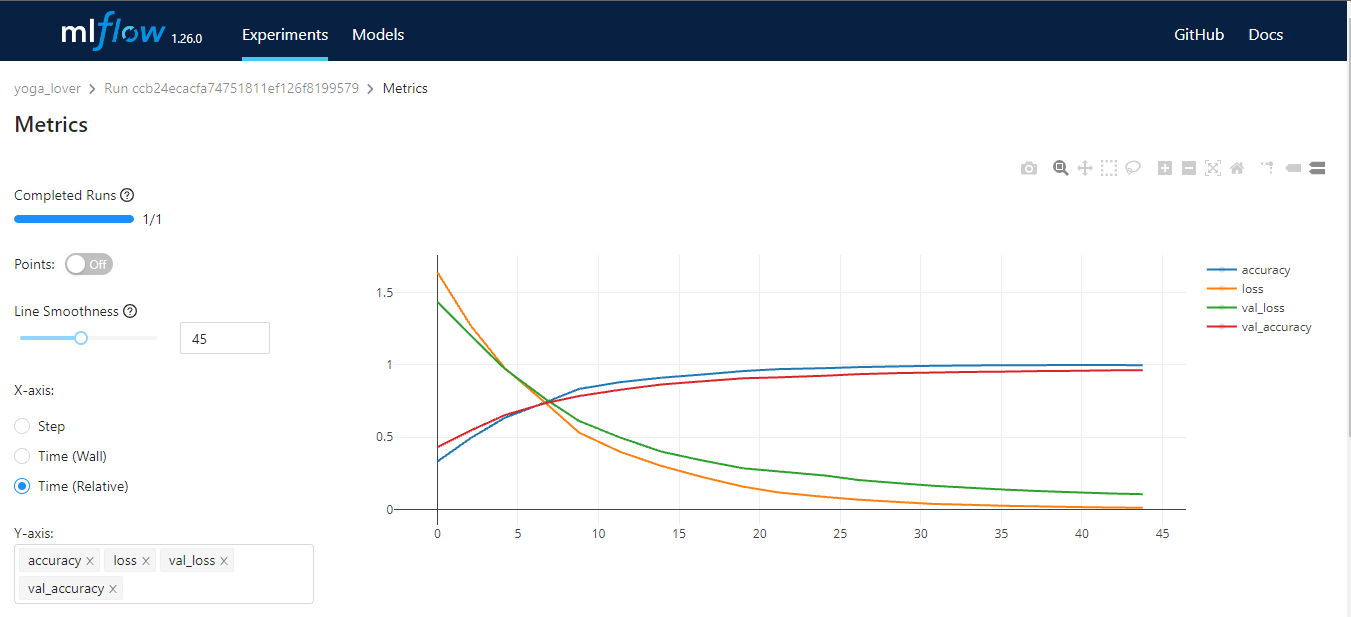

3. MLFlow

MLflow ist ein Open-Source-Tool, das dir hilft, die wichtigsten Teile des Lebenszyklus des maschinellen Lernens zu verwalten. Er wird in der Regel für die Nachverfolgung von Experimenten verwendet, du kannst ihn aber auch für die Reproduzierbarkeit, den Einsatz und die Modellregistrierung nutzen. Du kannst die Machine-Learning-Experimente und Modell-Metadaten mit CLI, Python, R, Java und REST API verwalten.

MLflow hat vier Kernfunktionen:

- MLflow-Tracking: Speichern und Zugreifen auf Code, Daten, Konfiguration und Ergebnisse.

- MLflow-Projekte: Paket Datenwissenschaft Quelle für Reproduzierbarkeit.

- MLflow-Modelle: Einsatz und Verwaltung von Machine-Learning-Modellen in verschiedenen Serving-Umgebungen.

- MLflow-Modellregistrierung: ein zentraler Modellspeicher, der die Versionierung, Stufenübergänge, Anmerkungen und die Verwaltung von Machine Learning-Modellen ermöglicht.

Bild vom Autor

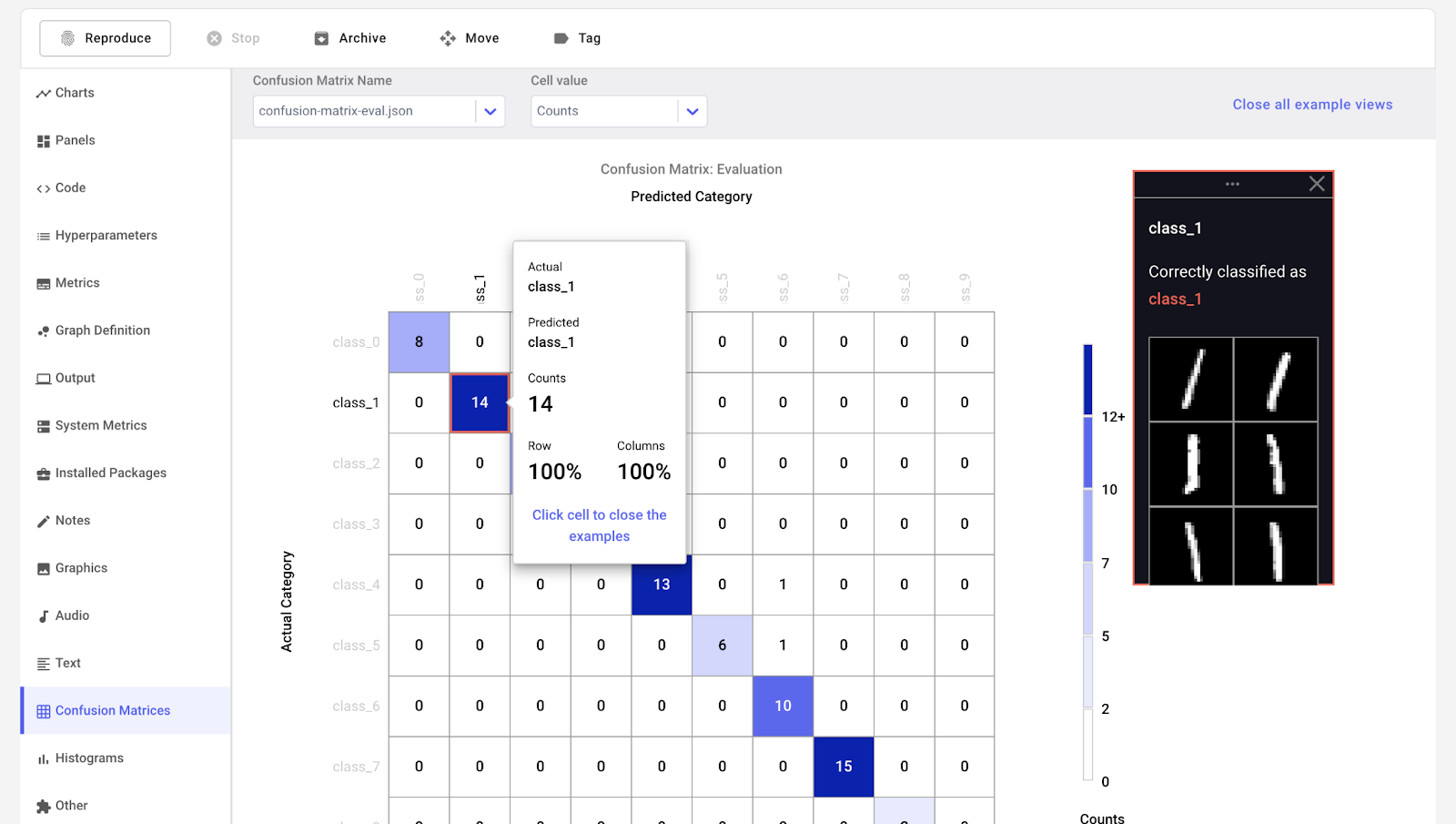

4. Comet ML

Comet ML ist eine Plattform zum Verfolgen, Vergleichen, Erklären und Optimieren von Machine-Learning-Modellen und Experimenten. Du kannst es mit jeder Bibliothek für maschinelles Lernen verwenden, z. B. Scikit-learn, Pytorch, TensorFlow und HuggingFace.

Comet ML eignet sich für Einzelpersonen, Teams, Unternehmen und Hochschulen. So kann jeder die Experimente leicht visualisieren und vergleichen. Außerdem kannst du damit Muster aus Bildern, Audio-, Text- und Tabellendaten visualisieren.

Bild von Comet ML

5. Gewichte & Verzerrungen

Weights & Biases ist eine ML-Plattform für die Nachverfolgung von Experimenten, die Versionierung von Daten und Modellen, die Optimierung von Hyperparametern und die Modellverwaltung. Außerdem kannst du damit Artefakte (Datensätze, Modelle, Abhängigkeiten, Pipelines und Ergebnisse) protokollieren und die Datensätze visualisieren (Audio, visuell, Text und tabellarisch).

Weights & Biases hat ein benutzerfreundliches zentrales Dashboard für Experimente zum maschinellen Lernen. Wie Comet ML kannst du es mit anderen Bibliotheken für maschinelles Lernen integrieren, z. B. Fastai, Keras, PyTorch, Hugging Face, Yolov5, Spacy und vielen anderen. Du kannst dir unsere Einführung in Gewichte & BIase in einem separaten Artikel ansehen.

Gif von Weights & Biases

Hinweis: Du kannst auch TensorBoard, Pachyderm, DagsHub und DVC Studio für die Verfolgung von Experimenten und die Verwaltung von ML-Metadaten verwenden.

Orchestrierung und Workflow-Pipelines MLOps Tools

Diese Tools helfen dir, Data-Science-Projekte zu erstellen und Workflows für maschinelles Lernen zu verwalten:

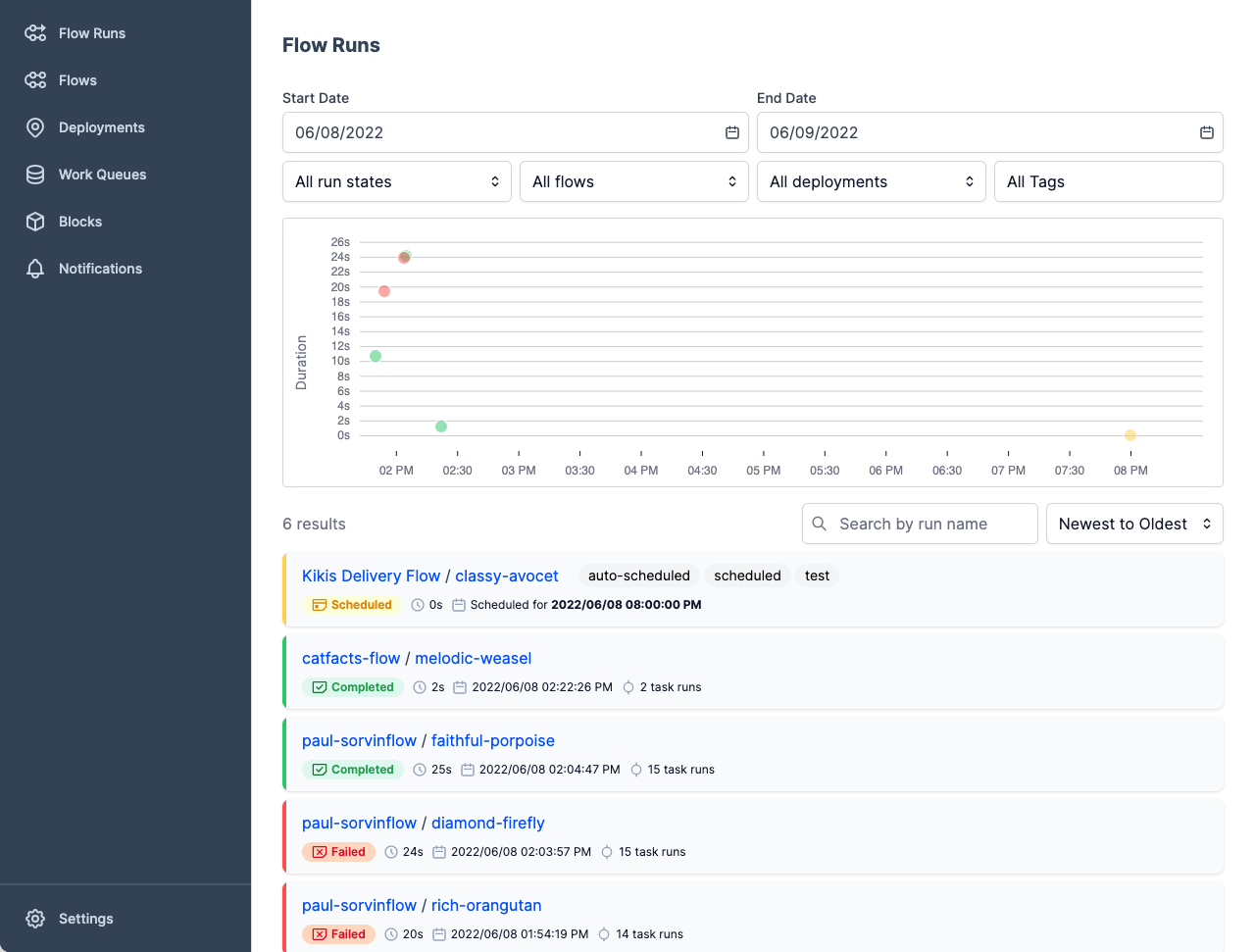

6. Präfekt

Prefect ist ein moderner Datenstack für die Überwachung, Koordination und Orchestrierung von Arbeitsabläufen zwischen und über Anwendungen hinweg. Es ist ein leichtgewichtiges Open-Source-Tool, das für End-to-End-Pipelines für maschinelles Lernen entwickelt wurde.

Du kannst entweder Prefect Orion UI oder Prefect Cloud für die Datenbanken verwenden.

- Prefect Orion UI ist eine quelloffene, lokal gehostete Orchestrierungs-Engine und ein API-Server. Sie bietet dir Einblicke in die lokale Prefect Orion-Instanz und die Arbeitsabläufe.

- Prefect Cloud ist ein gehosteter Dienst, mit dem du Flows, Flow Runs und Deployments visualisieren kannst. Außerdem kannst du Konten, Arbeitsbereiche und die Zusammenarbeit im Team verwalten.

Bild von Prefect

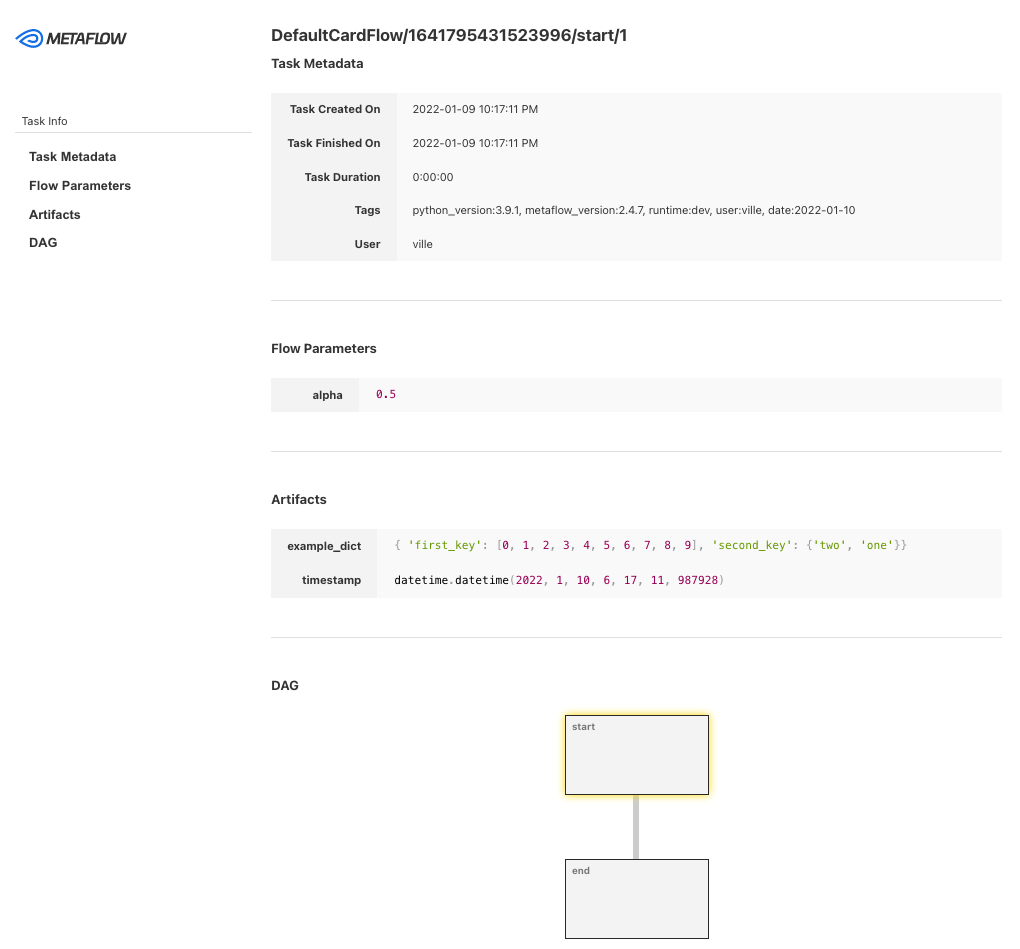

7. Metaflow

Metaflow ist ein leistungsstarkes, kampferprobtes Workflow-Management-Tool für Data Science- und Machine Learning-Projekte. Es wurde für Datenwissenschaftler entwickelt, damit sie sich auf die Erstellung von Modellen konzentrieren können, anstatt sich um die MLOps-Technik zu kümmern.

Mit Metaflow kannst du Arbeitsabläufe entwerfen, sie im Maßstab ausführen und das Modell in der Produktion einsetzen. Es verfolgt und versioniert Experimente und Daten zum maschinellen Lernen automatisch. Außerdem kannst du die Ergebnisse im Notizbuch visualisieren.

Metaflow arbeitet mit mehreren Clouds (einschließlich AWS, GCP und Azure) und verschiedenen Python-Paketen für maschinelles Lernen (wie Scikit-learn und Tensorflow) zusammen, und die API ist auch für die Sprache R verfügbar.

Bild von Metaflow

8. Kedro

Kedro ist ein auf Python basierendes Tool zur Workflow-Orchestrierung. Du kannst damit reproduzierbare, wartbare und modulare Data-Science-Projekte erstellen. Es integriert Konzepte aus dem Software-Engineering in das maschinelle Lernen, wie z.B. Modularität, Trennung von Belangen und Versionierung.

Mit Kedro kannst du:

- Richte Abhängigkeiten und Konfigurationen ein.

- Richte Daten ein.

- Erstelle, visualisiere und führe die Pipelines aus.

- Logging und Lernpfad für Experimente.

- Einsatz auf einem einzelnen oder verteilten Rechner.

- Erstelle wartbaren Data Science Code.

- Erstelle modularen, wiederverwendbaren Code.

- Arbeite mit Teamkollegen an Projekten zusammen.

Gif von Kedro

Hinweis: Du kannst auch Kubeflow und DVC für Orchestrierung und Workflow-Pipelines verwenden.

Tools zur Versionierung von Daten und Pipelines

Mit diesen MLOps-Tools kannst du Aufgaben rund um die Versionierung von Daten und Pipelines verwalten:

9. Dickhäuter

Pachyderm automatisiert die Datenumwandlung mit Datenversionierung, Lineage und End-to-End-Pipelines auf Kubernetes. Du kannst jede Art von Daten (Bilder, Protokolle, Videos, CSVs), jede Sprache (Python, R, SQL, C/C++) und jede Größenordnung (Petabytes an Daten, Tausende von Jobs) integrieren.

Die Community Edition ist Open-Source und für ein kleines Team. Organisationen und Teams, die erweiterte Funktionen wünschen, können sich für die Enterprise Edition entscheiden.

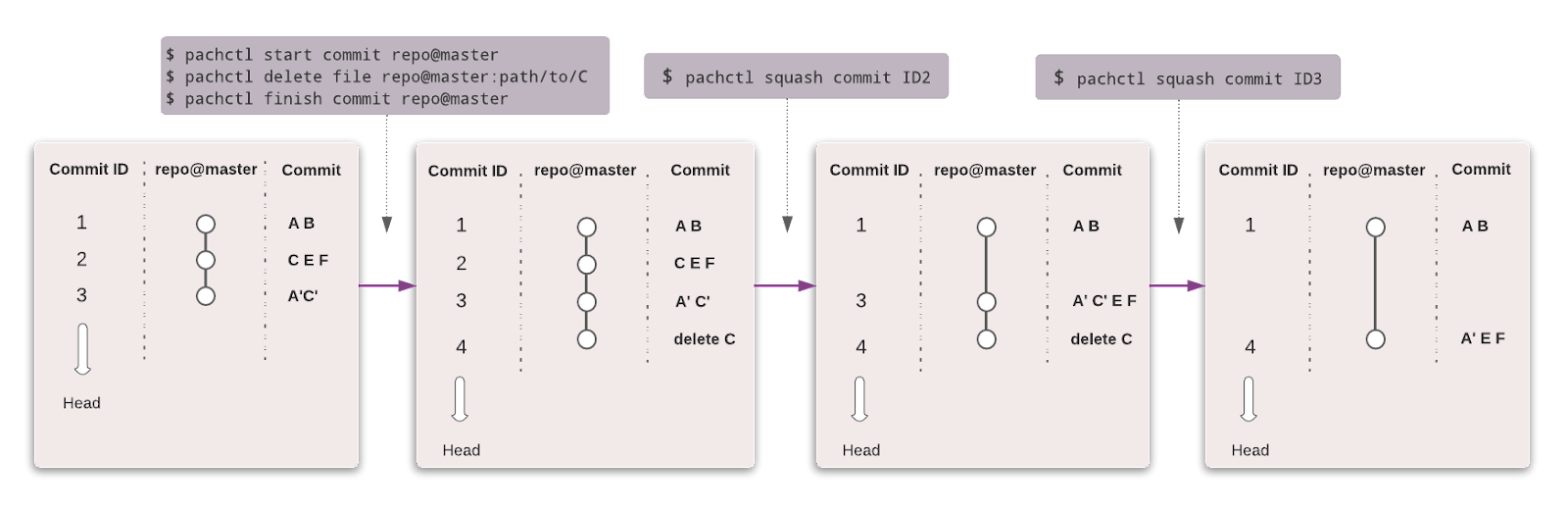

Genau wie bei Git kannst du deine Daten mit einer ähnlichen Syntax versionieren. In Pachyderm ist die höchste Ebene des Objekts Repository, und du kannst Commit, Branches, File, History und Provenance verwenden, um den Lernpfad und die Version des Datensatzes zu verfolgen.

Bild von Pachyderm

10. Datenversionskontrolle (DVC)

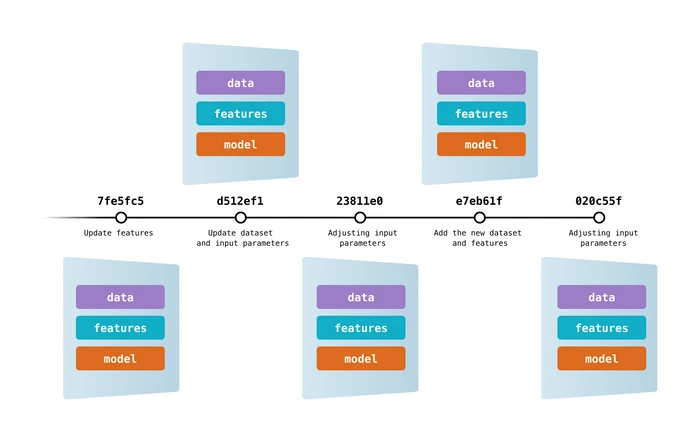

Data Version Control ist ein beliebtes Open-Source-Tool für Machine-Learning-Projekte. Es arbeitet nahtlos mit Git zusammen und ermöglicht dir die Versionierung von Code, Daten, Modellen, Metadaten und Pipelines.

DVC ist mehr als nur ein Lernpfad und ein Tool zur Versionskontrolle.

Du kannst es verwenden für:

- Lernpfad für Experimente (Modellmetriken, Parameter, Versionierung).

- Erstelle, visualisiere und führe Pipelines für maschinelles Lernen aus.

- Workflow für Einsatz und Zusammenarbeit.

- Reproduzierbarkeit.

- Daten- und Modellregistrierung.

- Kontinuierliche Integration und Bereitstellung für maschinelles Lernen mit CML.

Bild von DVC

Hinweis: DagsHub kann auch für die Versionierung von Daten und Pipelines verwendet werden.

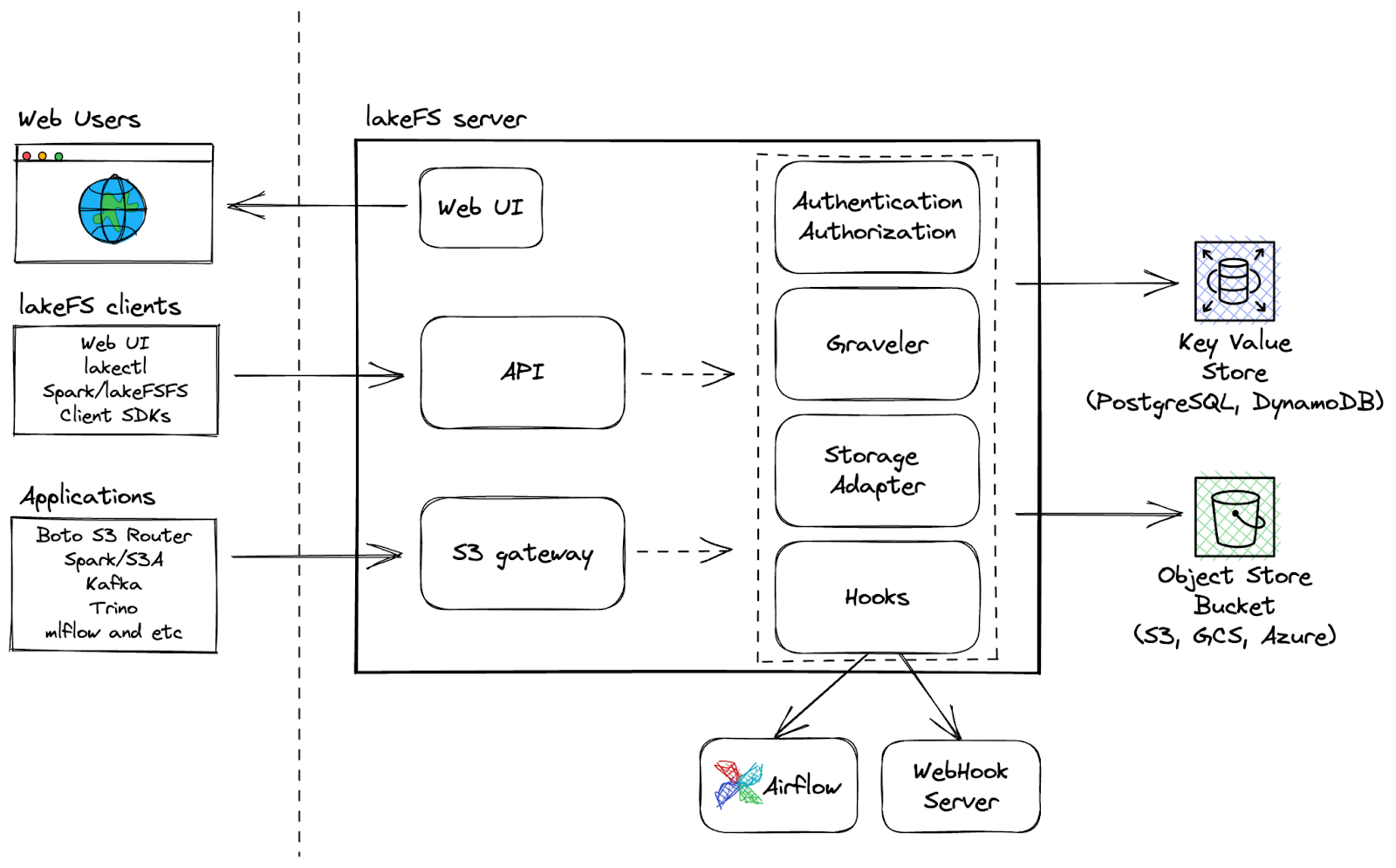

11. LakeFS

LakeFS ist ein Open-Source-Tool für die skalierbare Versionskontrolle von Daten, das eine Git-ähnliche Versionskontrollschnittstelle für Objektspeicher bietet und es den Nutzern ermöglicht, ihre Data Lakes wie ihren Code zu verwalten. LakeFS ermöglicht die Versionskontrolle von Daten im Exabyte-Bereich und ist damit eine hochskalierbare Lösung für die Verwaltung großer Data Lakes.

Zusätzliche Fähigkeiten:

- Git-Operationen wie Branching, Commit und Merge über jeden Speicherdienst ausführen

- Schnellere Entwicklung mit Zero Copy Branching für reibungsloses Experimentieren und einfache Zusammenarbeit

- Nutze Pre-Commit- und Merge-Hooks für CI/CD-Workflows, um saubere Arbeitsabläufe zu gewährleisten

- Die robuste Plattform ermöglicht eine schnellere Wiederherstellung von Datenproblemen mit der Revert-Funktion.

LakeFS Architektur

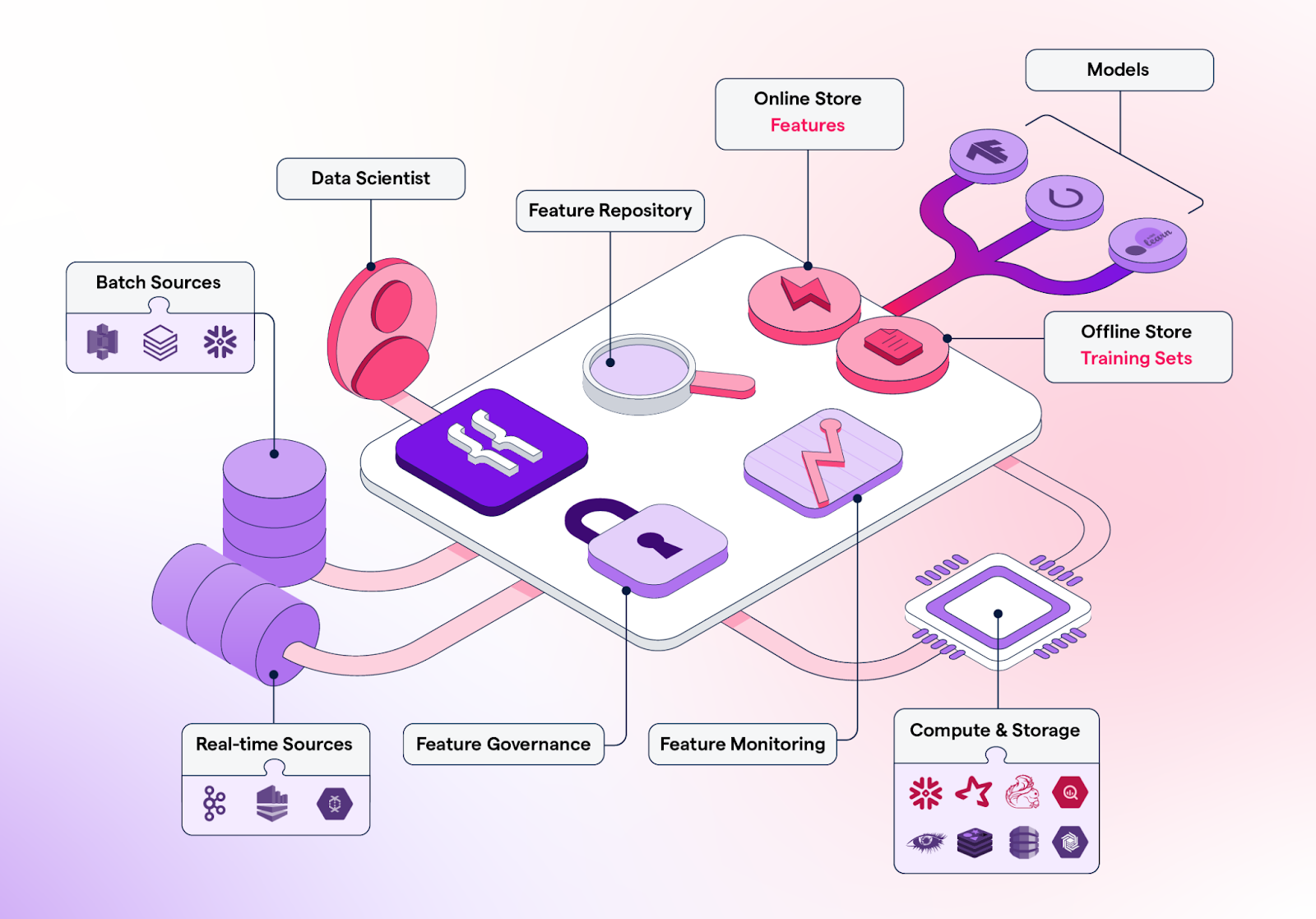

Feature Stores

Feature-Stores sind zentrale Repositories zum Speichern, Versionieren, Verwalten und Bereitstellen von Features (verarbeitete Datenattribute, die für das Training von Machine-Learning-Modellen verwendet werden) für Machine-Learning-Modelle in der Produktion und für Trainingszwecke.

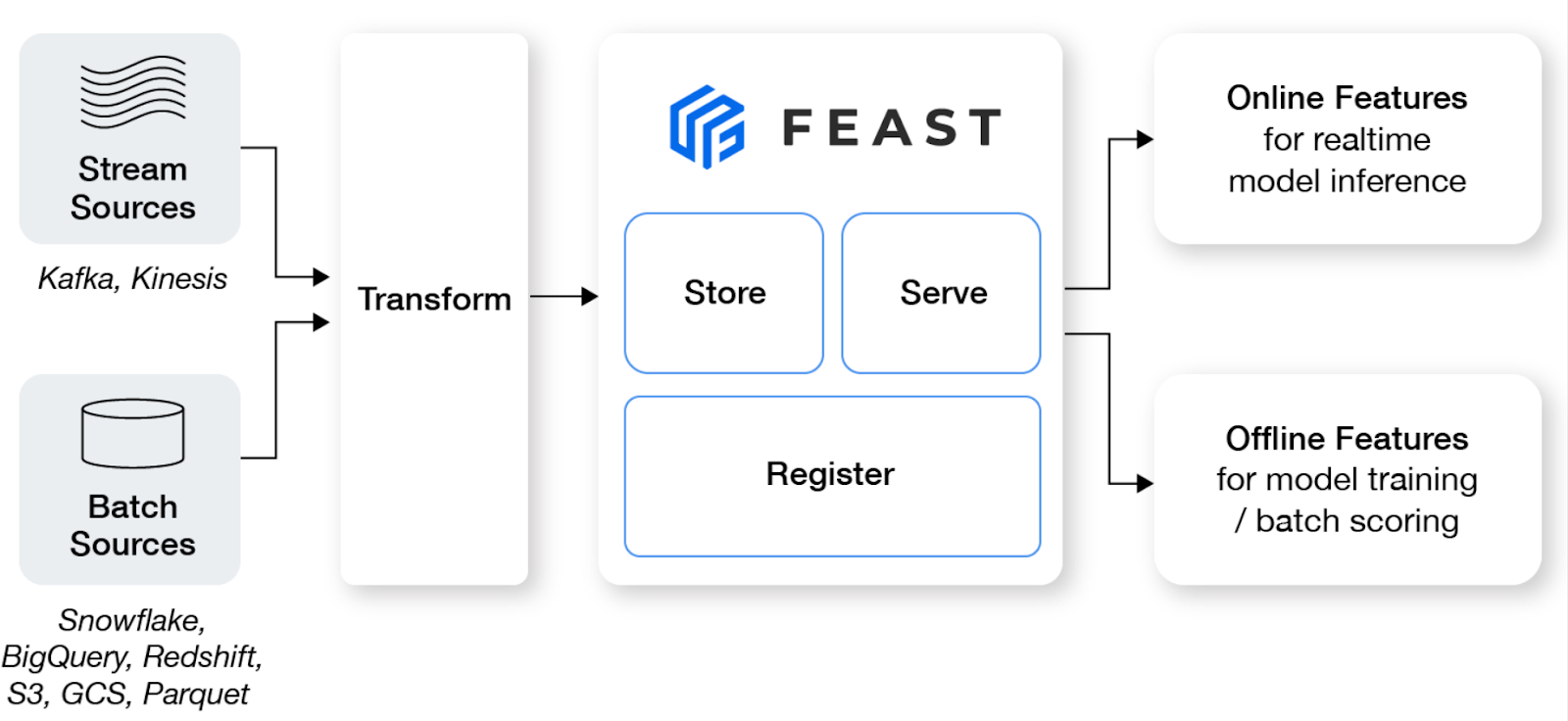

12. Fest

Feast ist ein Open-Source-Feature-Store, der Teams für maschinelles Lernen dabei hilft, Echtzeitmodelle zu produzieren und eine Feature-Plattform aufzubauen, die die Zusammenarbeit zwischen Ingenieuren und Datenwissenschaftlern fördert.

Wichtige Merkmale:

- Verwalte einen Offline-Store, einen Online-Store mit geringer Latenz und einen Feature-Server, um eine gleichbleibende Verfügbarkeit von Features sowohl für Trainings- als auch für Servicezwecke sicherzustellen.

- Vermeide Datenverluste, indem du genaue Point-in-Time-Feature-Sets erstellst und Datenwissenschaftler davon befreist, sich mit dem fehleranfälligen Zusammenfügen von Datensätzen zu beschäftigen.

- Entkopple ML von der Dateninfrastruktur, indem du eine einzige Zugriffsebene hast.

Bild von Feast

13. Featureform

Featureform ist ein virtueller Funktionsspeicher, mit dem Datenwissenschaftler die Funktionen ihrer ML-Modelle definieren, verwalten und bereitstellen können. Sie kann Data-Science-Teams dabei helfen, die Zusammenarbeit zu verbessern, Experimente zu organisieren, die Bereitstellung zu erleichtern, die Zuverlässigkeit zu erhöhen und die Compliance zu wahren.

Wichtige Merkmale:

- Verbessere die Zusammenarbeit, indem du Funktionen im Team teilst, wiederverwendest und verstehst.

- Wenn dein Feature bereit ist, wird Featureform deine Dateninfrastruktur orchestrieren, um es für die Produktion bereit zu machen.

- Das System stellt sicher, dass keine Merkmale, Kennzeichnungen oder Trainingssätze verändert werden können, um die Zuverlässigkeit zu erhöhen.

- Mit integrierter rollenbasierter Zugriffskontrolle, Audit-Protokollen und dynamischen Serving-Regeln kann Featureform deine Compliance-Logik direkt durchsetzen.

Bild von Featureform

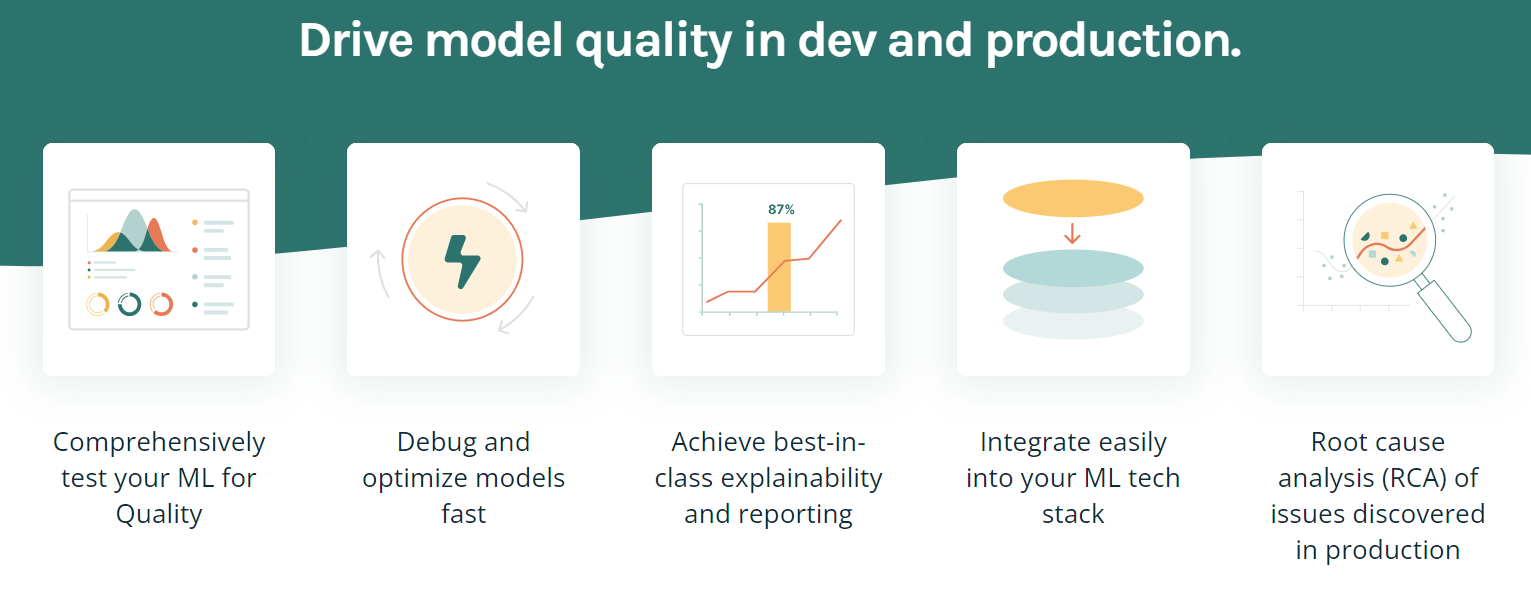

Modellversuche

Mit diesen MLOps-Tools kannst du die Modellqualität testen und die Zuverlässigkeit, Robustheit und Genauigkeit von Machine Learning-Modellen sicherstellen:

14. Deepchecks ML Modelle testen

Deepchecks ist eine Open-Source-Lösung, die alle deine ML-Validierungsanforderungen erfüllt und sicherstellt, dass deine Daten und Modelle von der Forschung bis zur Produktion gründlich getestet werden. Es bietet einen ganzheitlichen Ansatz zur Validierung deiner Daten und Modelle durch seine verschiedenen Komponenten.

Bild von Deepchecks

Deepchecks bestehen aus drei Komponenten:

- Deepchecks Testing: Ermöglicht es dir, benutzerdefinierte Prüfungen und Suiten für die Validierung von Tabellen, natürlicher Sprachverarbeitung und Computer Vision zu erstellen.

- CI & Testing Management: bietet CI & Testing Management, damit du mit deinem Team zusammenarbeiten und Testergebnisse effektiv verwalten kannst.

- Deepchecks Monitoring: Verfolgt und validiert Modelle in der Produktion.

15. TruEra

TruEra ist eine fortschrittliche Plattform, die die Modellqualität und -leistung durch automatisierte Tests, Erklärbarkeit und Ursachenanalyse verbessert. Es bietet verschiedene Funktionen, um Modelle zu optimieren und zu debuggen, eine erstklassige Erklärbarkeit zu erreichen und sich einfach in deinen ML-Tech-Stack zu integrieren.

Wichtige Merkmale:

- Mit der Funktion zum Testen und Debuggen von Modellen kannst du die Modellqualität während der Entwicklung und Produktion verbessern.

- Es kann automatisierte und systematische Tests durchführen, um Leistung, Stabilität und Fairness sicherzustellen.

- Es versteht die Entwicklung der Modellversionen. So kannst du Erkenntnisse gewinnen, die zu einer schnelleren und effektiveren Modellentwicklung führen.

- Identifiziere und ermittle, welche spezifischen Merkmale zu den Modellverzerrungen beitragen.

- TruEra lässt sich problemlos in deine aktuelle Infrastruktur und deinen Arbeitsablauf integrieren.

Bild von TruEra

Werkzeuge für die Modellbereitstellung und -wartung

Wenn es um den Einsatz von Modellen geht, können diese MLOps-Tools eine große Hilfe sein:

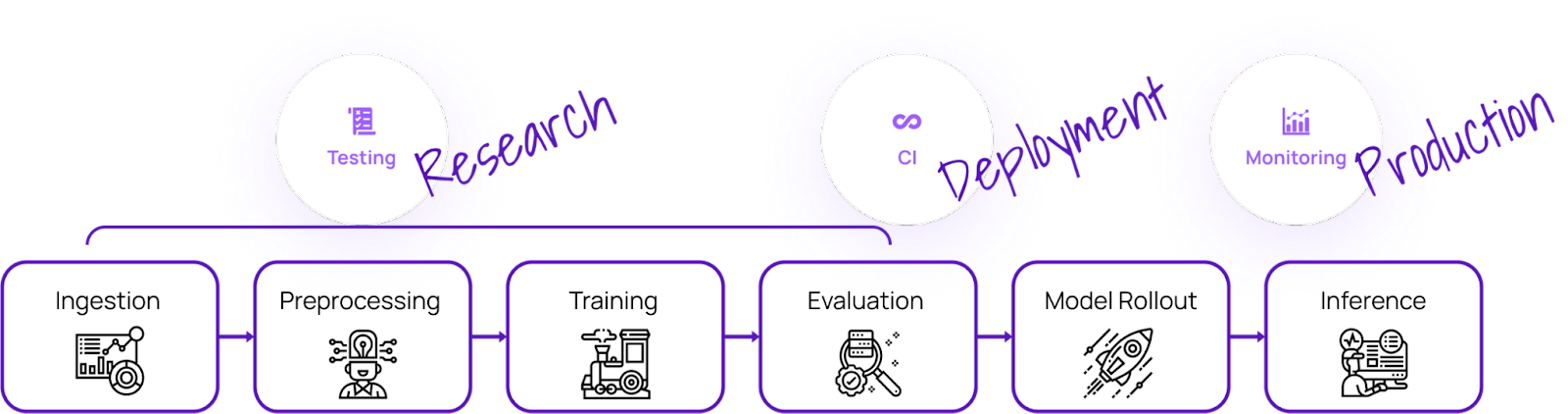

16. Kubeflow

Kubeflow macht die Bereitstellung von Machine Learning-Modellen auf Kubernetes einfach, portabel und skalierbar. Du kannst es für die Datenaufbereitung, das Modelltraining, die Modelloptimierung, das Prediction Serving und den Motor der Modellleistung in der Produktion verwenden. Du kannst Machine Learning Workflows lokal, vor Ort oder in der Cloud einsetzen. Kurz gesagt, es macht Kubernetes für Data Science Teams einfach.

Wichtige Merkmale:

- Zentrales Dashboard mit interaktiver Benutzeroberfläche.

- Pipelines für maschinelles Lernen für Reproduzierbarkeit und Rationalisierung.

- Bietet native Unterstützung für JupyterLab, RStudio und Visual Studio Code.

- Abstimmung der Hyperparameter und Suche nach neuronaler Architektur.

- Trainingsaufträge für Tensorflow, Pytorch, PaddlePaddle, MXNet und XGboost.

- Arbeitsvorbereitung.

- Biete Administratoren die Möglichkeit, mehrere Benutzer zu isolieren.

- Funktioniert mit allen großen Cloud-Anbietern.

Bild von Kubeflow

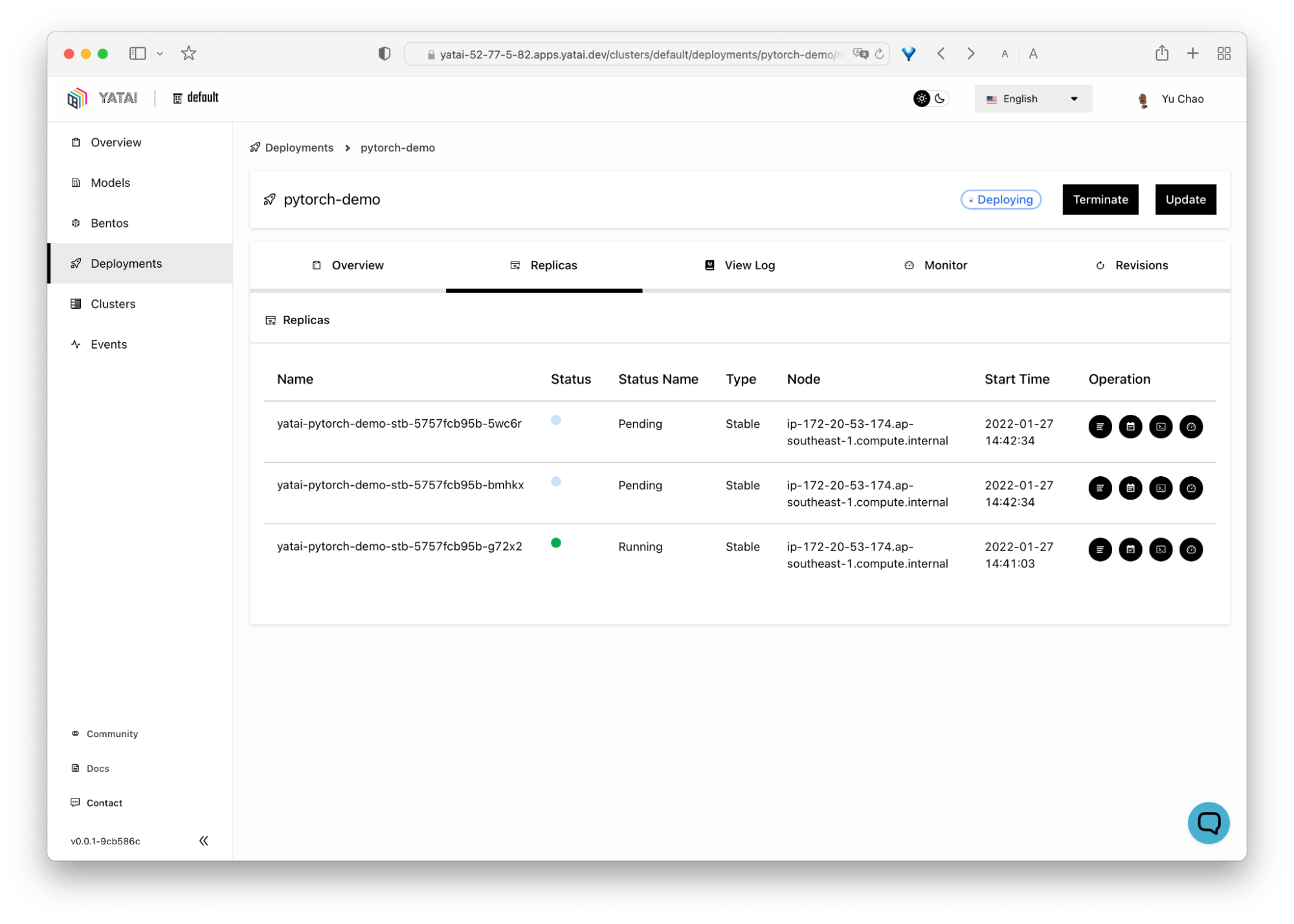

10. BentoML

BentoML macht es einfach und schneller, Anwendungen für maschinelles Lernen bereitzustellen. Es ist ein Python-basiertes Werkzeug für die Bereitstellung und Pflege von APIs in der Produktion. Sie skaliert mit leistungsstarken Optimierungen durch parallele Inferenz und adaptives Batching und bietet Hardware-Beschleunigung.

Das interaktive, zentrale Dashboard von BentoML erleichtert die Organisation und Überwachung des Einsatzes von Machine Learning-Modellen. Das Beste daran ist, dass es mit allen Arten von Frameworks für maschinelles Lernen funktioniert, wie Keras, ONNX, LightGBM, Pytorch und Scikit-learn. Kurz gesagt: BentoML bietet eine Komplettlösung für die Bereitstellung, das Servicing und die Überwachung von Modellen.

Bild von BentoML

18. Hugging Face Inferenz-Endpunkte

Hugging Face Inference Endpoints ist ein Cloud-basierter Service von Hugging Face, einer All-in-One ML-Plattform, die es Nutzern ermöglicht, Modelle, Datensätze und Demos zu trainieren, zu hosten und zu teilen. Diese Endpunkte sollen den Nutzern helfen, ihre trainierten Machine-Learning-Modelle für Inferenzen einzusetzen, ohne dass sie die erforderliche Infrastruktur einrichten und verwalten müssen.

Wichtige Merkmale:

- Halte die Kosten so niedrig wie 0,06 $ pro CPU-Kern/Stunde und 0,6 $ pro GPU/Stunde, je nach deinem Bedarf.

- Einfacher Einsatz innerhalb von Sekunden.

- Vollständig verwaltet und autoskaliert.

- Teil des Hugging Face Ökosystems.

- Sicherheit auf Unternehmensebene.

Bild von Hugging Face

Hinweis: Du kannst auch MLflow und AWS Sagemaker für die Modellbereitstellung und das Serving verwenden.

Modellüberwachung in der Produktion ML Ops Tools

Egal, ob sich dein ML-Modell in der Entwicklung, in der Validierung oder in der Produktion befindet, mit diesen Tools kannst du eine Reihe von Faktoren überwachen:

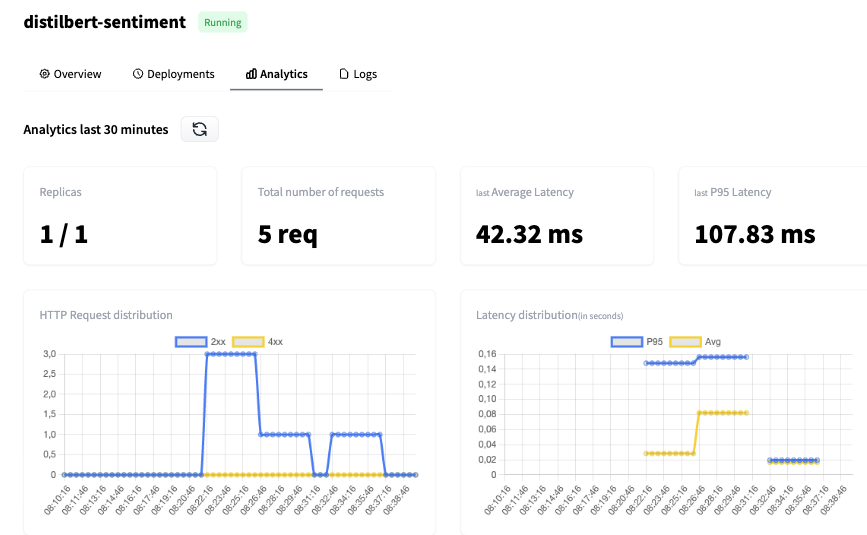

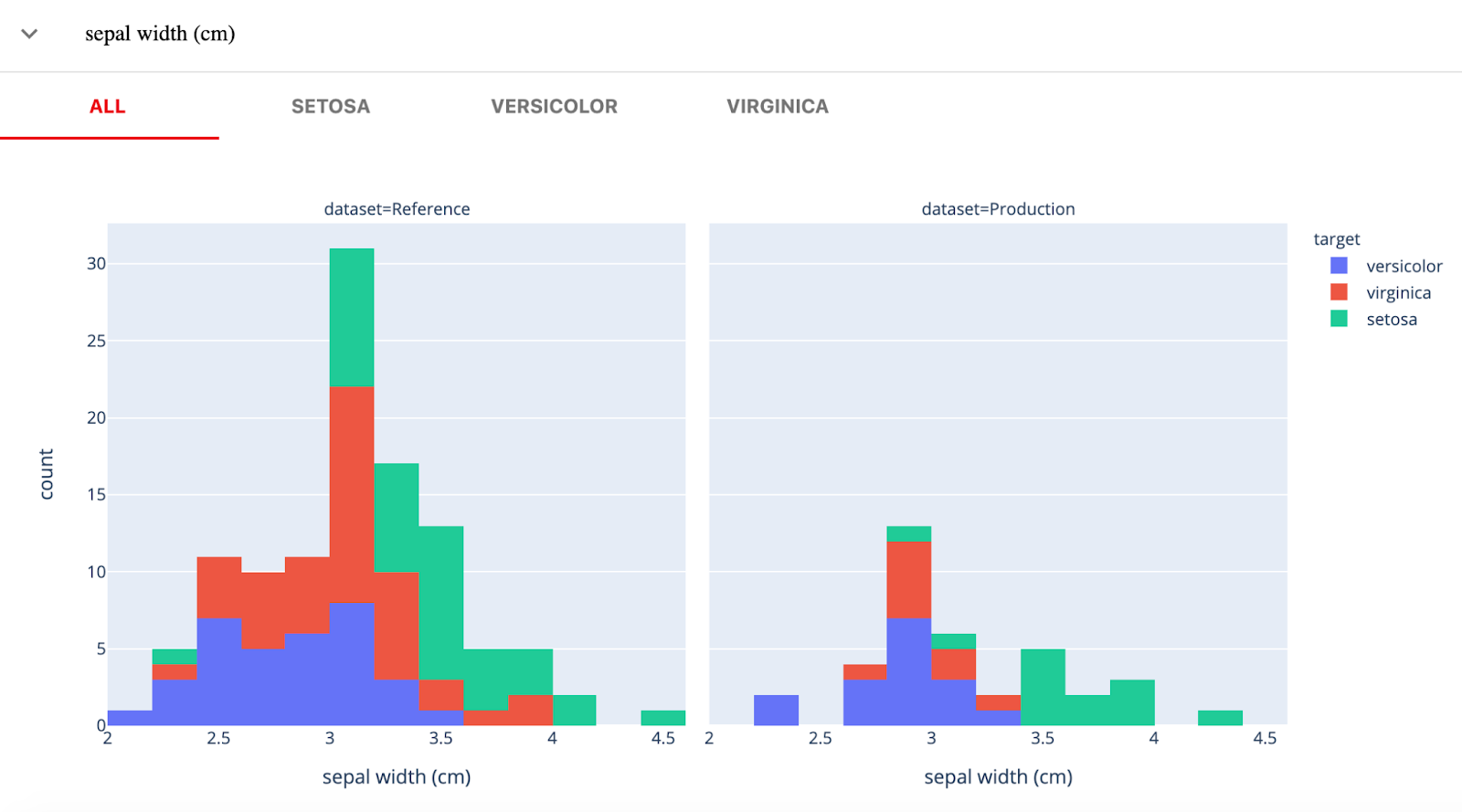

19. Offensichtlich

Evidently AI ist eine quelloffene Python-Bibliothek zur Überwachung von ML-Modellen während der Entwicklung, Validierung und in der Produktion. Sie prüft die Daten- und Modellqualität, die Datendrift, die Zieldrift sowie die Regressions- und Klassifizierungsleistung.

Offensichtlich gibt es drei Hauptkomponenten:

- Tests (Batch-Modellprüfungen): zur Durchführung von strukturierten Daten- und Modellqualitätsprüfungen.

- Berichte (interaktive Dashboards): interaktive Datendrift, Modellleistung und Zielvirtualisierung.

- Monitore (Echtzeit-Monitoring): Überwacht Daten und Modellmetriken des eingesetzten ML-Dienstes.

Bild von Evidently

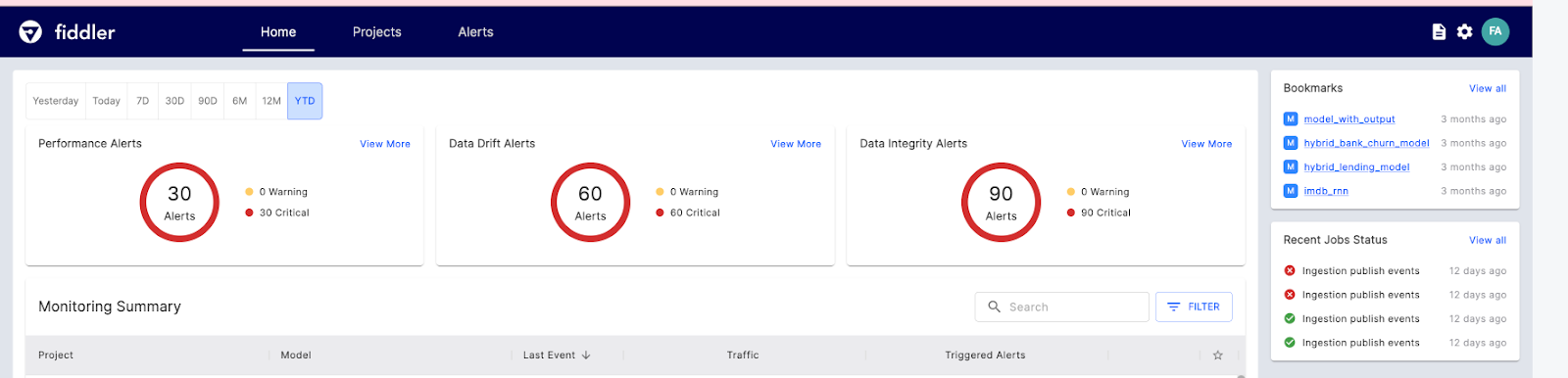

20. Fiddler

Fiddler AI ist ein ML-Modell-Überwachungstool mit einer einfach zu bedienenden, übersichtlichen Benutzeroberfläche. Damit kannst du Vorhersagen erklären und debuggen, das Verhalten der Modi für den gesamten Datensatz analysieren, Modelle für maschinelles Lernen in großem Umfang einsetzen und die Modellleistung überwachen.

Sehen wir uns die wichtigsten KI-Funktionen von Fiddler für die ML-Überwachung an:

- Leistungsüberwachung: Detaillierte Visualisierung der Datenabweichung, wann und wie sie abweicht.

- Datenintegrität: Vermeide es, falsche Daten für die Modellschulung einzugeben.

- Lernpfad für Ausreißer: zeigt univariate und multivariate Ausreißer an.

- Servicemetriken: zeigen grundlegende Einblicke in den ML-Servicebetrieb.

- Warnungen: Richte Warnungen für ein Modell oder eine Gruppe von Modellen ein, um vor Problemen in der Produktion zu warnen.

Bild aus Fiddler

Laufzeit-Engines

Die Runtime Engine ist für das Laden des Modells, die Vorverarbeitung der Eingabedaten, die Durchführung der Inferenz und die Rückgabe der Ergebnisse an die Client-Anwendung verantwortlich.

21. Ray

Ray ist ein vielseitiges Framework zur Skalierung von KI- und Python-Anwendungen, das es Entwicklern erleichtert, ihre Machine-Learning-Projekte zu verwalten und zu optimieren.

Die Plattform besteht aus zwei Hauptkomponenten: einer verteilten Kernlaufzeit und einer Reihe von KI-Bibliotheken, die auf die Vereinfachung von ML-Berechnungen zugeschnitten sind.

Ray Core bietet eine begrenzte Anzahl grundlegender Elemente, die für den Aufbau und die Erweiterung verteilter Anwendungen genutzt werden können.

- Tasks sind Funktionen, die keinen Status haben und innerhalb des Clusters ausgeführt werden.

- Actors sind Worker-Prozesse, die zustandsabhängig sind und innerhalb des Clusters erstellt werden.

- Objekte sind unveränderliche Werte, auf die jede Komponente innerhalb des Clusters zugreifen kann.

Ray bietet außerdem KI-Bibliotheken für skalierbare Datensätze für ML, verteiltes Training, Hyperparameter-Tuning, Reinforcement Learning und skalierbares und programmierbares Serving.

Das folgende Beispiel zeigt das Training und den Einsatz eines Gradient Boosting Classifier-Modells.

import requests

from starlette.requests import Request

from typing import Dict

from sklearn.datasets import load_iris

from sklearn.ensemble import GradientBoostingClassifier

from ray import serve

# Train model.

iris_dataset = load_iris()

model = GradientBoostingClassifier()

model.fit(iris_dataset["data"], iris_dataset["target"])

@serve.deployment

class BoostingModel:

def __init__(self, model):

self.model = model

self.label_list = iris_dataset["target_names"].tolist()

async def __call__(self, request: Request) -> Dict:

payload = (await request.json())["vector"]

print(f"Received http request with data {payload}")

prediction = self.model.predict([payload])[0]

human_name = self.label_list[prediction]

return {"result": human_name}

# Deploy model.

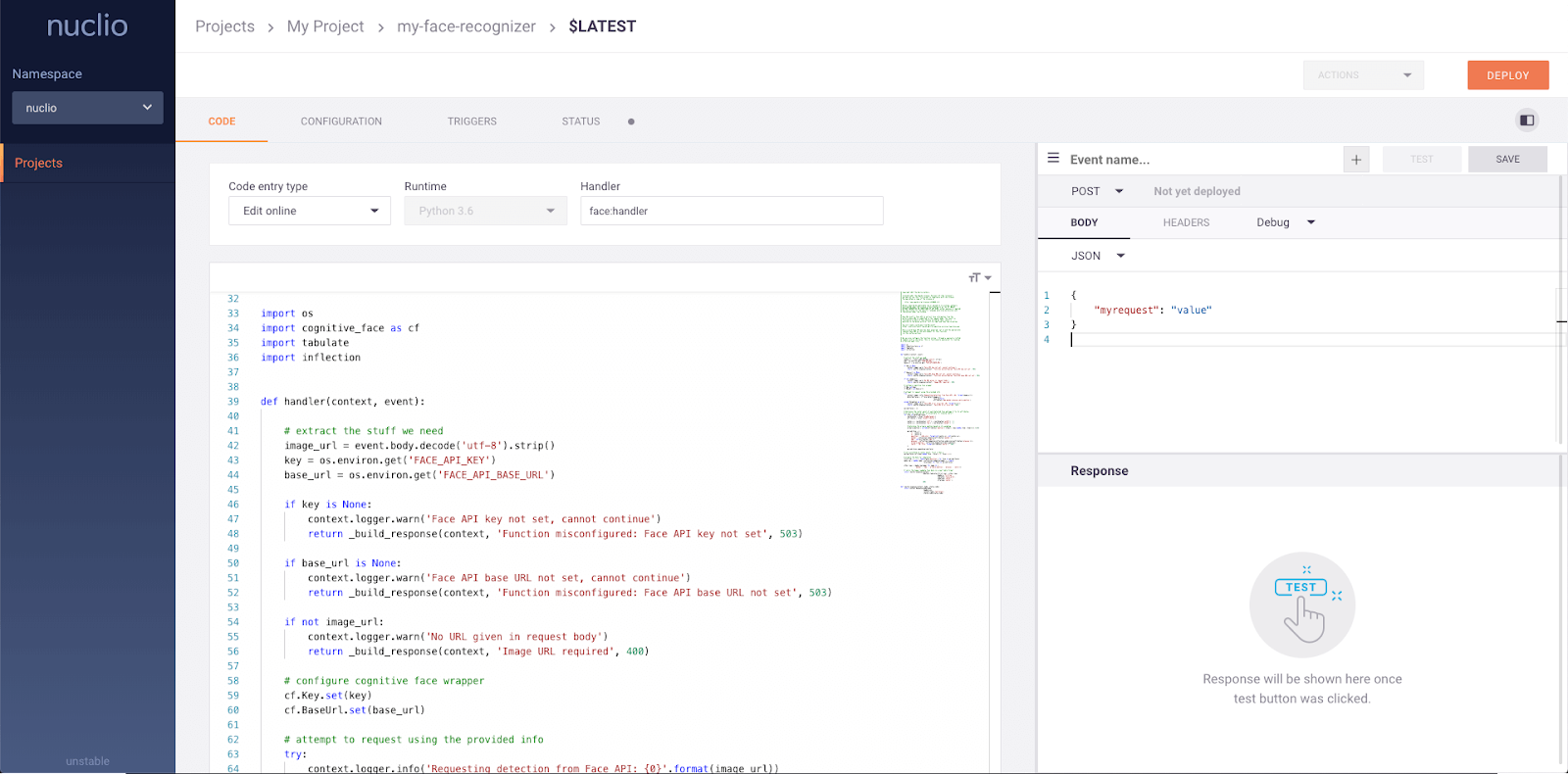

serve.run(BoostingModel.bind(model), route_prefix="/iris")22. Nuclio

Nuclio ist ein leistungsstarkes Framework, das sich auf daten-, I/O- und rechenintensive Workloads konzentriert. Sie ist so konzipiert, dass sie serverlos ist, d.h. du musst dich nicht um die Verwaltung von Servern kümmern. Nuclio ist gut in beliebte Data-Science-Tools wie Jupyter und Kubeflow integriert. Es unterstützt außerdem eine Vielzahl von Daten- und Streaming-Quellen und kann über CPUs und GPUs ausgeführt werden.

Wichtige Merkmale:

- Benötigt nur minimale CPU/GPU- und E/A-Ressourcen, um die Echtzeitverarbeitung durchzuführen und gleichzeitig die Parallelität zu maximieren.

- Lässt sich mit einer Vielzahl von Datenquellen und ML-Frameworks integrieren.

- Bietet zustandsabhängige Funktionen mit Datenpfadbeschleunigung

- Übertragbarkeit auf alle Arten von Geräten und Cloud-Plattformen, insbesondere auf Geräte mit geringem Stromverbrauch.

- Entwickelt für Unternehmen.

Bild von Nuclio

End-to-End MLOps-Plattformen

Wenn du auf der Suche nach einem umfassenden MLOps-Tool bist, das dich während des gesamten Prozesses unterstützt, findest du hier einige der besten:

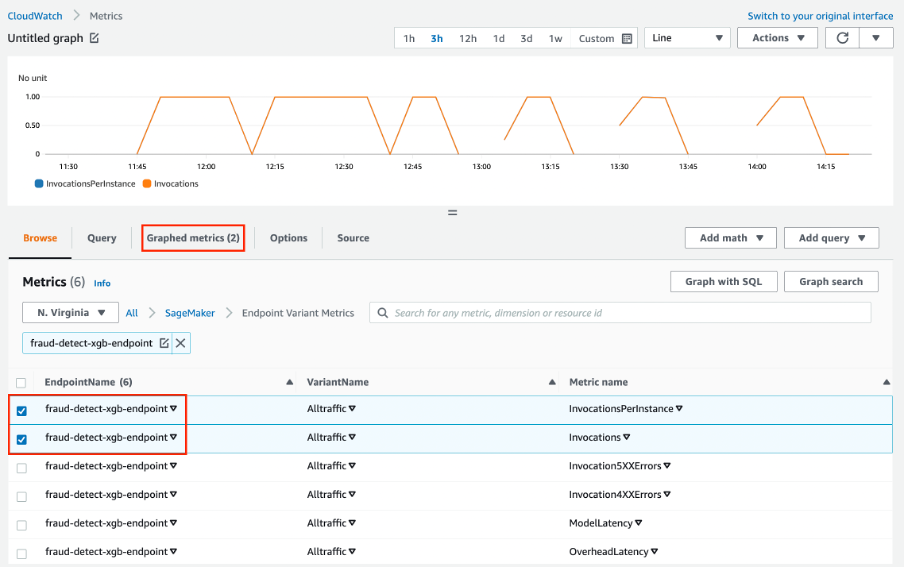

23. AWS SageMaker

Amazon Web Services SageMaker ist eine One-Stop-Lösung für MLOps. Du kannst die Modellentwicklung trainieren und beschleunigen, Experimente nachverfolgen und versionieren, ML-Artefakte katalogisieren, CI/CD-ML-Pipelines integrieren und Modelle nahtlos in der Produktion einsetzen, bedienen und überwachen.

Wichtige Merkmale:

- Eine kollaborative Umgebung für Data Science Teams.

- Automatisiere ML-Trainingsabläufe.

- Setze Modelle in der Produktion ein und verwalte sie.

- Verfolge und pflege die Modellversionen.

- CI/CD für automatische Integration und Bereitstellung.

- Kontinuierliche Überwachung und Beibehaltung der Modelle, um die Qualität zu erhalten.

- Optimiere die Kosten und die Leistung.

Bild von Amazon SageMaker

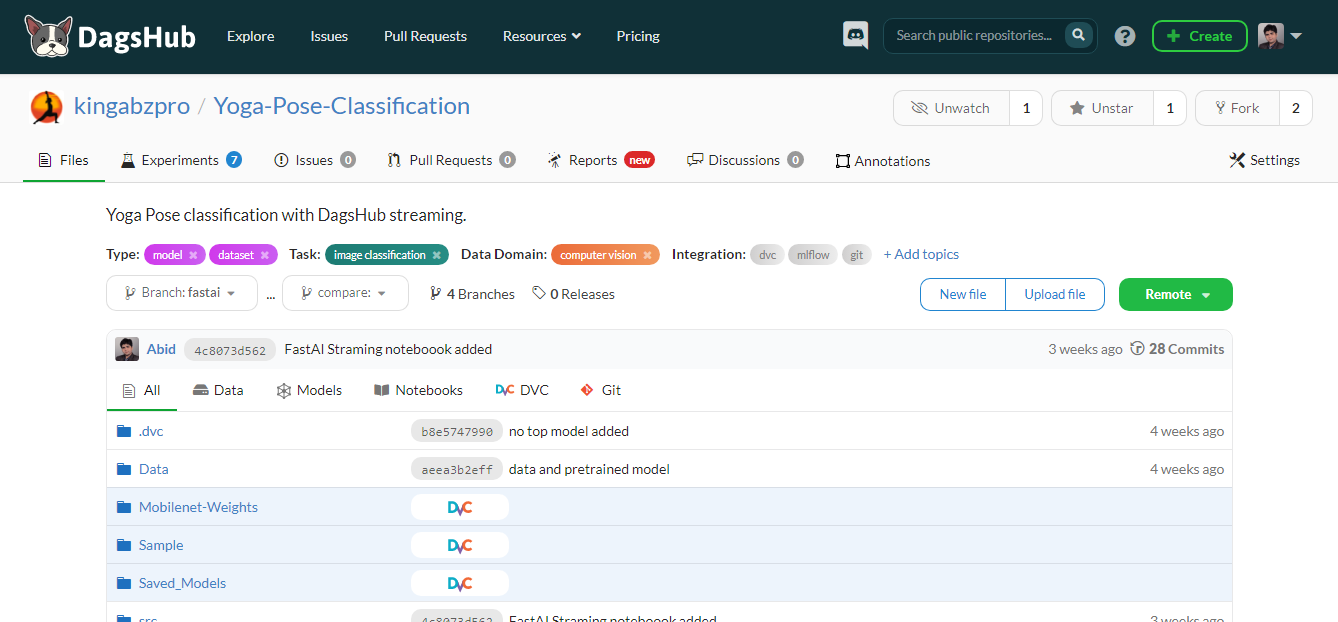

24. DagsHub

DagsHub ist eine Plattform für die Machine-Learning-Community, um Daten, Modelle, Experimente, ML-Pipelines und Code zu verfolgen und zu versionieren. Es ermöglicht deinem Team, Machine-Learning-Projekte zu erstellen, zu überprüfen und zu teilen.

Einfach ausgedrückt ist es ein GitHub für maschinelles Lernen, und du bekommst verschiedene Tools, um den gesamten maschinellen Lernprozess zu optimieren.

Wichtige Merkmale:

- Git- und DVC-Repository für deine ML-Projekte.

- DagsHub-Logger und MLflow-Instanz zur Nachverfolgung von Experimenten.

- Datensatzbeschriftung mit Label Studio Instanz.

- Vergleiche die Jupyter-Notebooks, den Code, die Datensätze und die Bilder.

- Möglichkeit, die Datei, eine Codezeile oder den Datensatz zu kommentieren.

- Erstelle einen Bericht für das Projekt, genau wie im GitHub-Wiki.

- Visualisierung der ML-Pipeline.

- Reproduzierbare Ergebnisse.

- CI/CD für die Modellschulung und den Einsatz.

- Daten-Zusammenführung.

- Biete Integration mit GitHub, Google Colab, DVC, Jenkins, externem Speicher, Webhooks und New Relic.

Bild vom Autor

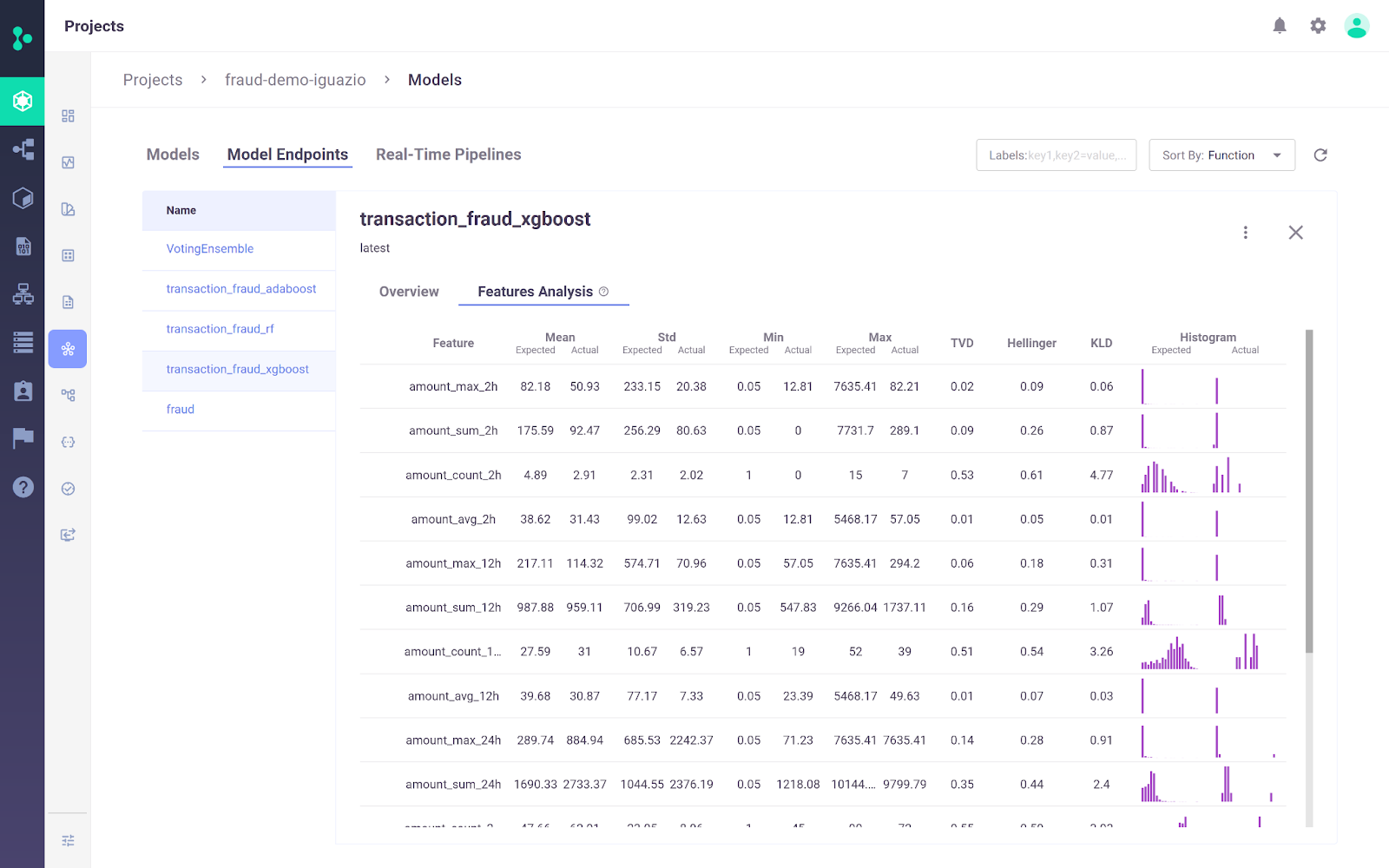

25. Iguazio MLOps Platform

Die Iguazio MLOps-Plattform ist eine End-to-End-MLOps-Plattform, die es Unternehmen ermöglicht, die maschinelle Lernpipeline von der Datenerfassung und -aufbereitung bis hin zum Training, Einsatz und der Überwachung in der Produktion zu automatisieren. Es bietet eine offene(MLRun) und verwaltete Plattform.

Ein wesentliches Unterscheidungsmerkmal der Iguazio MLOps-Plattform ist ihre Flexibilität bei den Einsatzoptionen. Nutzer können KI-Anwendungen überall einsetzen, auch in Cloud-, Hybrid- oder On-Premises-Umgebungen. Dies ist besonders wichtig für Branchen wie das Gesundheits- und Finanzwesen, in denen Datenschutzbedenken eine Bereitstellung vor Ort erforderlich machen können.

Bild von der Iguazio MLOps Plattform

Wichtige Merkmale:

- Die Plattform ermöglicht es Nutzern, Daten aus jeder beliebigen Quelle aufzunehmen und mit dem integrierten Feature Store wiederverwendbare Online- und Offline-Funktionen zu erstellen.

- Es unterstützt das kontinuierliche Training und die Evaluierung von Modellen im großen Maßstab durch skalierbare serverlose Systeme mit automatischer Nachverfolgung, Datenversionierung sowie kontinuierlicher Integration und Bereitstellung.

- Die Modelle lassen sich mit wenigen Klicks in der Produktion einsetzen, die Modellleistung wird kontinuierlich überwacht und die Modellabweichung wird reduziert.

- Die Plattform verfügt über ein einfaches Dashboard zur Verwaltung, Steuerung und Überwachung von Modellen und der Produktion in Echtzeit.

MLOps Tools Übersicht

Hier ist eine Vergleichstabelle, mit der du diese Tools Seite an Seite bewerten und dich für die besten für deine Projekte entscheiden kannst:

| Tool | Hauptfunktionalität | Unterstützte Frameworks | Optionen für den Einsatz |

|---|---|---|---|

| Qdrant | Vektorielle Ähnlichkeitssuche und Datenbankmanagement | Python, mehrere Sprachen | Cloud-nativ, horizontal skalierbar |

| LangChain | Anwendungen mit Sprachmodellen entwickeln | Python, JavaScript | REST API, Vorlagen |

| MLFlow | Lernpfad, Modellregistrierung, Einsatz | Python, R, Java, REST API | Lokal, Wolke |

| Comet ML | Lernpfad und Optimierung von Experimenten | Scikit-learn, PyTorch, TensorFlow, HuggingFace | Lokal, Wolke |

| Gewichte & Verzerrungen | Lernpfad, Daten- und Modellversionierung | Fastai, Keras, PyTorch, HuggingFace, Yolov5, Spacy | Lokal, Wolke |

| Präfekt | Workflow-Orchestrierung und -Überwachung | Python | Lokal (Orion UI), Cloud |

| Metaflow | Workflow Management für Data Science | Scikit-learn, TensorFlow, Python, R | AWS, GCP, Azure, lokal |

| Kedro | Workflow-Organisation, Reproduzierbarkeit | Python | Lokal, verteilt |

| Dickhäuter | Datenumwandlung, Versionierung und Abstammung | Jede Sprache | Kubernetes |

| DVC | Versionierung von Daten und Pipelines | Git, Python | Lokal, Wolke |

| LakeFS | Git-ähnliche Versionskontrolle für Data Lakes | Jeder Speicherdienst | Lokal, Wolke |

| Fest | Zentraler Merkmalspeicher für ML-Modelle | Python | Lokal, Wolke |

| Featureform | Virtueller Merkmalspeicher für ML-Modelle | Python | Lokal, Wolke |

| Deepchecks | ML-Modellprüfung und -Validierung | Python | Lokal, Wolke |

| TruEra | Modellqualität und Leistungstests | Python | Lokal, Wolke |

| Kubeflow | ML-Modellbereitstellung und -Orchestrierung | TensorFlow, PyTorch, PaddlePaddle, MXNet, XGboost | Kubernetes, cloud |

| BentoML | Modellbereitstellung und API-Verwaltung | Keras, ONNX, LightGBM, PyTorch, Scikit-learn | Lokal, Wolke |

| Hugging Face | Inferenz und Modellentwicklung | Jedes Modell | Cloud |

| Offensichtlich | Überwachung von ML-Modellen auf Daten- und Zielabweichungen | Python | Lokal, Wolke |

| Fiddler | ML-Modellüberwachung und Fehlerbehebung | Python | Lokal, Wolke |

| Ray | KI- und Python-Anwendungen skalieren | Python | Lokal, Wolke |

| Nuclio | Serverloses Framework für daten- und rechenintensive Workloads | Jupyter, Kubeflow | Cloud, vor Ort |

| AWS SageMaker | End-to-End-Management des ML-Lebenszyklus | Python, R, Java, TensorFlow, PyTorch | AWS-Wolke |

| DagsHub | Versionierung und Zusammenarbeit für ML-Projekte | Git, DVC, MLflow | Lokal, Wolke |

| Iguazio | End-to-End-Automatisierung von ML-Pipelines | Python, MLRun | Cloud, Hybrid, Vor-Ort |

Fazit

Wir befinden uns in einer Zeit, in der die MLOps-Branche einen Boom erlebt. Jede Woche gibt es neue Entwicklungen, neue Startups und neue Tools, die das grundlegende Problem der Umwandlung von Notebooks in produktionsreife Anwendungen lösen sollen. Selbst bestehende Tools erweitern ihren Horizont und integrieren neue Funktionen, um zu Super-MLOps-Tools zu werden.

In diesem Blog haben wir die besten MLOps-Tools für verschiedene Schritte des MLOps-Prozesses kennengelernt. Diese Tools helfen dir bei der Erprobung, Entwicklung, Einführung und Überwachung.

Wenn du neu auf dem Gebiet des maschinellen Lernens bist und dir die wichtigsten Fähigkeiten aneignen willst, um einen Job als Machine Learning Scientist zu bekommen, solltest du unseren Lernpfad zum Machine Learning Scientist mit Python besuchen.

Wenn du ein Profi bist und mehr über die Standard-MLOps-Praktiken erfahren möchtest, lies unseren Artikel über die MLOps Best Practices und ihre Anwendung und schau dir unseren Lernpfad zu den MLOps-Grundlagen an.

Verdiene eine Top-KI-Zertifizierung

MLOps Tools FAQs

Was sind MLOps Tools?

MLOps-Tools helfen, das ML-Ökosystem zu standardisieren, zu vereinfachen und zu rationalisieren. Diese Tools werden für die Nachverfolgung von Experimenten, die Verwaltung von Modell-Metadaten, die Orchestrierung, die Modelloptimierung, die Versionierung von Workflows, die Modellbereitstellung und -bereitstellung sowie die Modellüberwachung in der Produktion eingesetzt.

Welche Fähigkeiten werden für einen MLOps Engineer benötigt?

- Die Fähigkeit, Cloud-Lösungen zu implementieren.

- Erfahrung mit Docker und Kubernetes.

- Erfahrung in der Qualitätssicherung mit Lernpfaden und Workflow-Versionierung.

- Die Fähigkeit, MLOps-Pipelines aufzubauen.

- Vertraut mit dem Linux-Betriebssystem.

- Erfahrung mit ML-Frameworks wie PyTorch, Tensorflow und TFX.

- Erfahrung mit DevOps und Softwareentwicklung.

- Erfahrung mit Unit- und Integrationstests, Daten- und Modellvalidierung sowie der Überwachung nach der Implementierung.

Welche Cloud ist die beste für MLOps?

AWS, GCP und Azure bieten eine Vielzahl von Tools für den Lebenszyklus des maschinellen Lernens. Sie alle bieten End-to-End-Lösungen für MLOps. AWS liegt in Sachen Popularität und Marktanteil an der Spitze. Außerdem bietet es einfache Lösungen für die Modellschulung, den Service und die Überwachung.

Ist MLOps leicht zu lernen?

Das hängt von deinen bisherigen Erfahrungen ab. Um MLOps zu beherrschen, musst du sowohl das maschinelle Lernen als auch den Lebenszyklus der Softwareentwicklung lernen. Neben guten Kenntnissen in Programmiersprachen musst du auch verschiedene MLOps-Tools erlernen. Für DevOps-Ingenieure ist es einfach, MLOps zu erlernen, da die meisten Tools und Strategien von der Softwareentwicklung bestimmt werden.

Ist Kubeflow besser als MLflow?

Das hängt vom jeweiligen Anwendungsfall ab. Kubeflow bietet Reproduzierbarkeit auf einer größeren Ebene als MLflow, da es die Orchestrierung verwaltet.

- Kubeflow wird im Allgemeinen für den Einsatz und die Verwaltung komplexer ML-Systeme im großen Maßstab verwendet.

- MLFlow wird in der Regel für die Verfolgung von ML-Experimenten und die Speicherung und Verwaltung von Modellmetadaten verwendet.

Wie unterscheidet sich MLOps von DevOps?

Beides sind Strategien zur Softwareentwicklung. DevOps konzentriert sich auf die Entwicklung und Verwaltung großer Softwaresysteme, während MLOps sich auf die Bereitstellung und Wartung von Machine Learning-Modellen in der Produktion konzentriert.

- DevOps: Continuous Integration(CI) und Continuous Delivery(CD).

- MLOps: Continuous Integration, Continuous Delivery, Continuous Training und Continuous Monitoring.

Wie lassen sich MLOps-Tools in bestehende Data Science-Workflows integrieren?

Die MLOps-Tools sind so konzipiert, dass sie sich nahtlos in bestehende Data-Science-Workflows einfügen. Sie unterstützen in der Regel verschiedene Data-Science-Tools und -Plattformen, stellen APIs für die Integration bereit und bieten Plugins oder Erweiterungen für beliebte Data-Science-Umgebungen. Diese Integration ermöglicht es Datenwissenschaftlern, ihre aktuellen Arbeitsabläufe beizubehalten und gleichzeitig die Vorteile von MLOps für eine bessere Skalierbarkeit, Reproduzierbarkeit und Bereitstellungseffizienz zu nutzen.

Können MLOps-Tools bei der Erklärbarkeit und Fairness von Modellen helfen?

Ja, viele MLOps-Tools enthalten Funktionen zur Verbesserung der Erklärbarkeit und Fairness von Modellen. Sie bieten Funktionen wie Modellinterpretation, Erkennung von Verzerrungen und Fairness-Metriken, die dabei helfen, zu verstehen und zu verbessern, wie Modelle Entscheidungen treffen. Dies ist entscheidend für den Einsatz von verantwortungsvoller KI und die Einhaltung der gesetzlichen Vorschriften.

Kann ich eine MLOps-Zertifizierung machen?

MLOps-spezifische Zertifizierungen sind noch im Entstehen begriffen, aber es gibt bereits mehrere auf maschinelles Lernen und Datenwissenschaften ausgerichtete Zertifizierungen, die MLOps-Fähigkeiten abdecken. In unserem Leitfaden zu den MLOps-Zertifizierungen findest du eine Aufschlüsselung.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.