Curso

Conforme exploramos em nosso artigo sobre Introdução ao MLOps, o MLOps foi desenvolvido com base nos fundamentos do DevOps, a estratégia de desenvolvimento de software para escrever, implantar e executar aplicativos corporativos com eficiência.

É uma abordagem para gerenciar projetos de aprendizado de máquina em escala. Os MLOps aprimoram a colaboração entre as equipes de desenvolvimento, operacionais e de ciência de dados. Como resultado, você obtém uma implementação mais rápida do modelo, produtividade otimizada da equipe, redução de riscos e custos e monitoramento contínuo do modelo na produção.

Saiba por que o MLOps é importante e quais problemas ele pretende resolver lendo nosso blog sobre O passado, o presente e o futuro do MLOps.

Nesta postagem, vamos conhecer as melhores ferramentas de MLOps para desenvolvimento, implantação e monitoramento de modelos para padronizar, simplificar e otimizar o ecossistema de aprendizado de máquina. Para obter uma introdução completa aos fundamentos do MLOps, confira nossa trilha de habilidades.

Você quer começar a usar a IA generativa?

Saiba como trabalhar com LLMs em Python diretamente em seu navegador

Estrutura de modelos de idiomas grandes (LLMs)

Com a introdução do GPT-4 e, posteriormente, do GPT-4o, começou a corrida para produzir grandes modelos de linguagem e realizar todo o potencial da IA moderna. Os LLMs exigem bancos de dados vetoriais e estruturas de integração para a criação de aplicativos inteligentes de IA.

1. Qdrant

O Qdrant é um mecanismo de pesquisa de similaridade vetorial de código aberto e um banco de dados vetorial que fornece um serviço pronto para produção com uma API conveniente, permitindo que você armazene, pesquise e gerencie embeddings vetoriais.

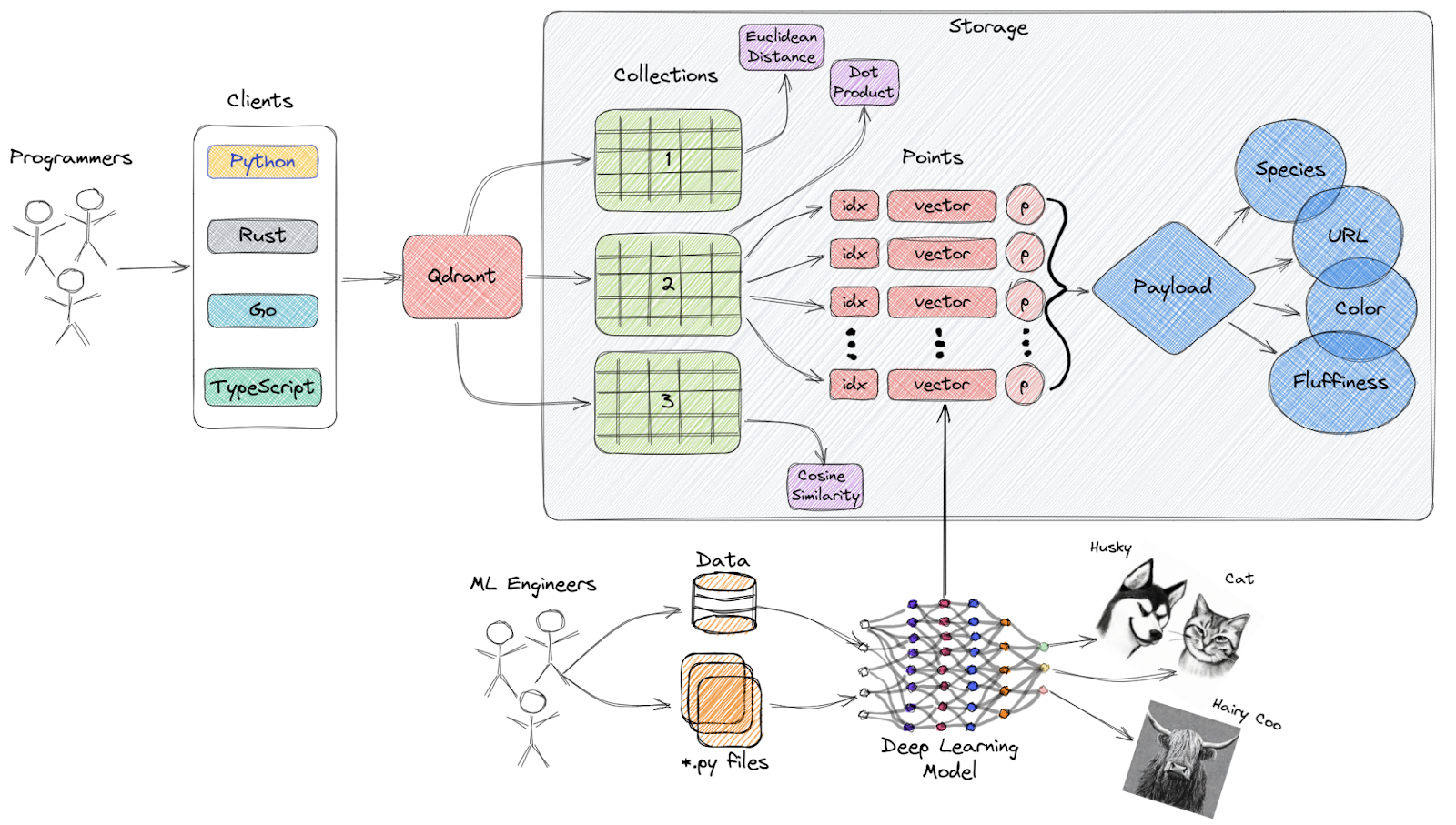

Visão geral de alto nível da arquitetura da Qdrant

Principais recursos:

- API fácil de usar: Ele fornece uma API Python fácil de usar e também permite que os desenvolvedores gerem bibliotecas de clientes em várias linguagens de programação.

- Rápido e preciso: Ele usa uma modificação personalizada exclusiva do algoritmo HNSW para a busca pelo vizinho mais próximo, proporcionando velocidades de busca de última geração sem comprometer a precisão.

- Tipos de dados avançados: O Qdrant oferece suporte a uma ampla variedade de tipos de dados e condições de consulta, incluindo correspondência de strings, intervalos numéricos, localizações geográficas e muito mais.

- Distribuído: Ele é nativo da nuvem e pode ser dimensionado horizontalmente, permitindo que os desenvolvedores usem a quantidade certa de recursos computacionais para qualquer quantidade de dados que precisem servir.

- Eficiente: O Qdrant foi desenvolvido inteiramente em Rust, uma linguagem conhecida por seu desempenho e eficiência de recursos.

Descubra os principais bancos de dados vetoriais lendo Os 5 melhores bancos de dados vetoriais: uma lista com exemplos.

2. LangChain

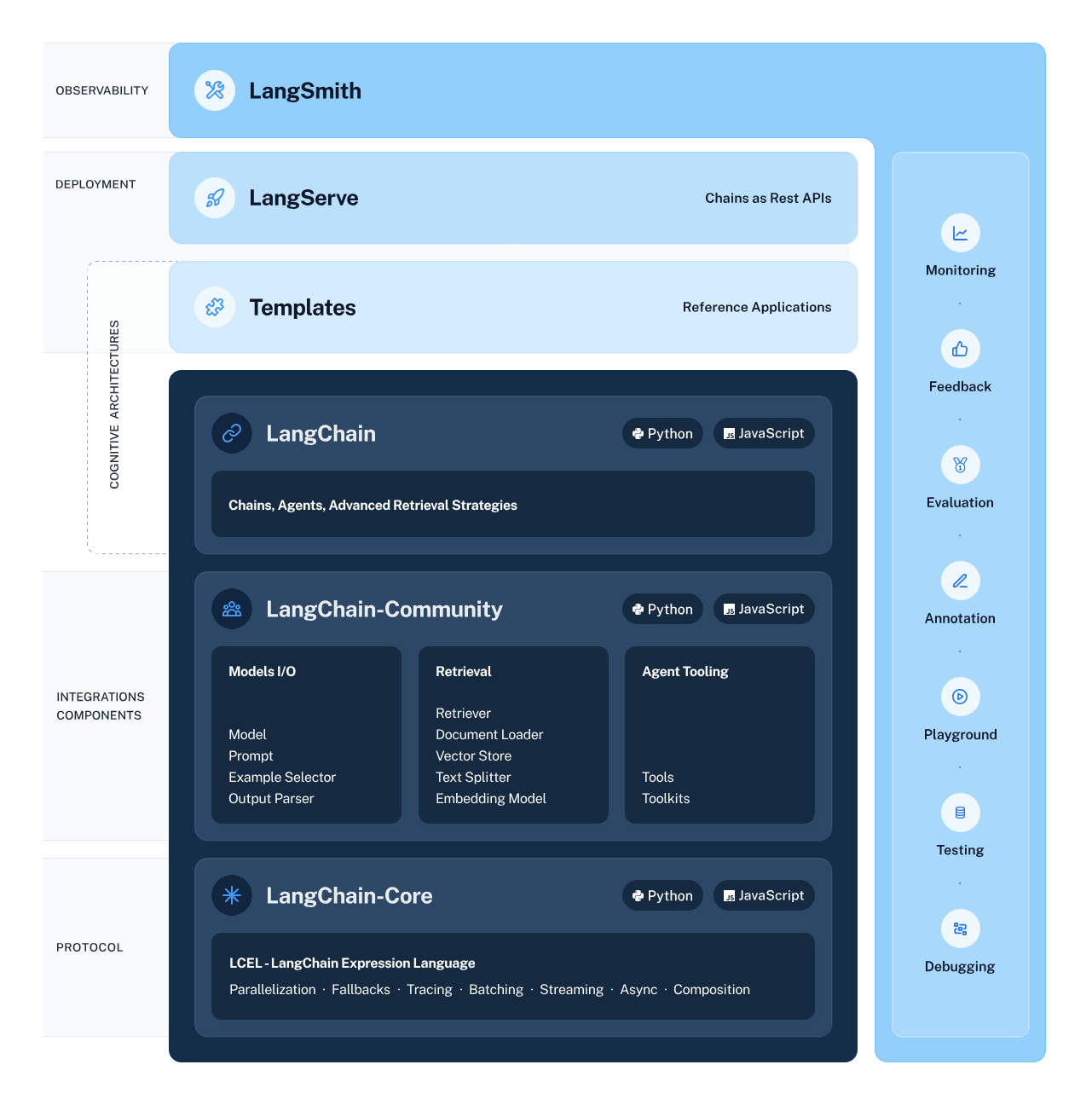

O LangChain é uma estrutura versátil e avançada para o desenvolvimento de aplicativos alimentados por modelos de linguagem. Ele oferece vários componentes para permitir que os desenvolvedores criem, implantem e monitorem aplicativos com reconhecimento de contexto e baseados em raciocínio.

A estrutura consiste em quatro componentes principais:

- Bibliotecas LangChain: As bibliotecas Python e JavaScript oferecem interfaces e integrações que permitem que você desenvolva aplicativos de raciocínio com reconhecimento de contexto.

- Modelos LangChain: Essa coleção de arquiteturas de referência facilmente implementáveis abrange uma ampla variedade de tarefas, fornecendo aos desenvolvedores soluções pré-construídas.

- LangServe: Essa biblioteca permite que os desenvolvedores implantem cadeias LangChain como uma API REST.

- LangSmith: Uma plataforma que permite a você depurar, testar, avaliar e monitorar cadeias criadas em qualquer estrutura LLM.

LangChain Ecosystem

Saiba como criar aplicativos LLM com o LangChain e explore o potencial inexplorado de modelos de linguagem grandes.

Ferramentas de rastreamento de experimentos e gerenciamento de metadados de modelos

Essas ferramentas permitem que você gerencie os metadados do modelo e ajudam no rastreamento de experimentos:

3. MLFlow

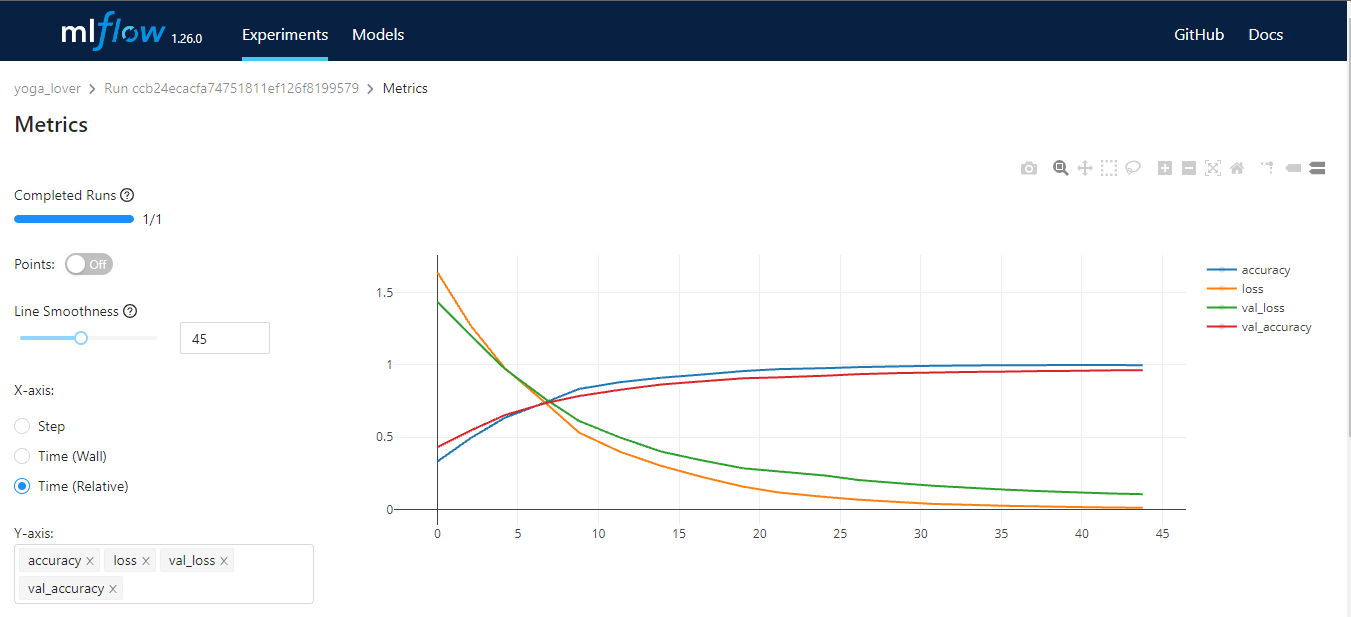

O MLflow é uma ferramenta de código aberto que ajuda você a gerenciar as partes principais do ciclo de vida do aprendizado de máquina. Geralmente, ele é usado para rastreamento de experimentos, mas você também pode usá-lo para reprodutibilidade, implantação e registro de modelos. Você pode gerenciar os experimentos de aprendizado de máquina e os metadados do modelo usando CLI, Python, R, Java e API REST.

O MLflow tem quatro funções principais:

- Rastreamento de MLflow: armazenamento e acesso a código, dados, configuração e resultados.

- Projetos MLflow: pacote de fontes de ciência de dados para reprodutibilidade.

- Modelos MLflow: implantação e gerenciamento de modelos de aprendizado de máquina em vários ambientes de serviço.

- Registro de modelo do MLflow: um armazenamento de modelo central que fornece controle de versão, transições de estágio, anotações e gerenciamento de modelos de aprendizado de máquina.

Imagem do autor

4. Cometa ML

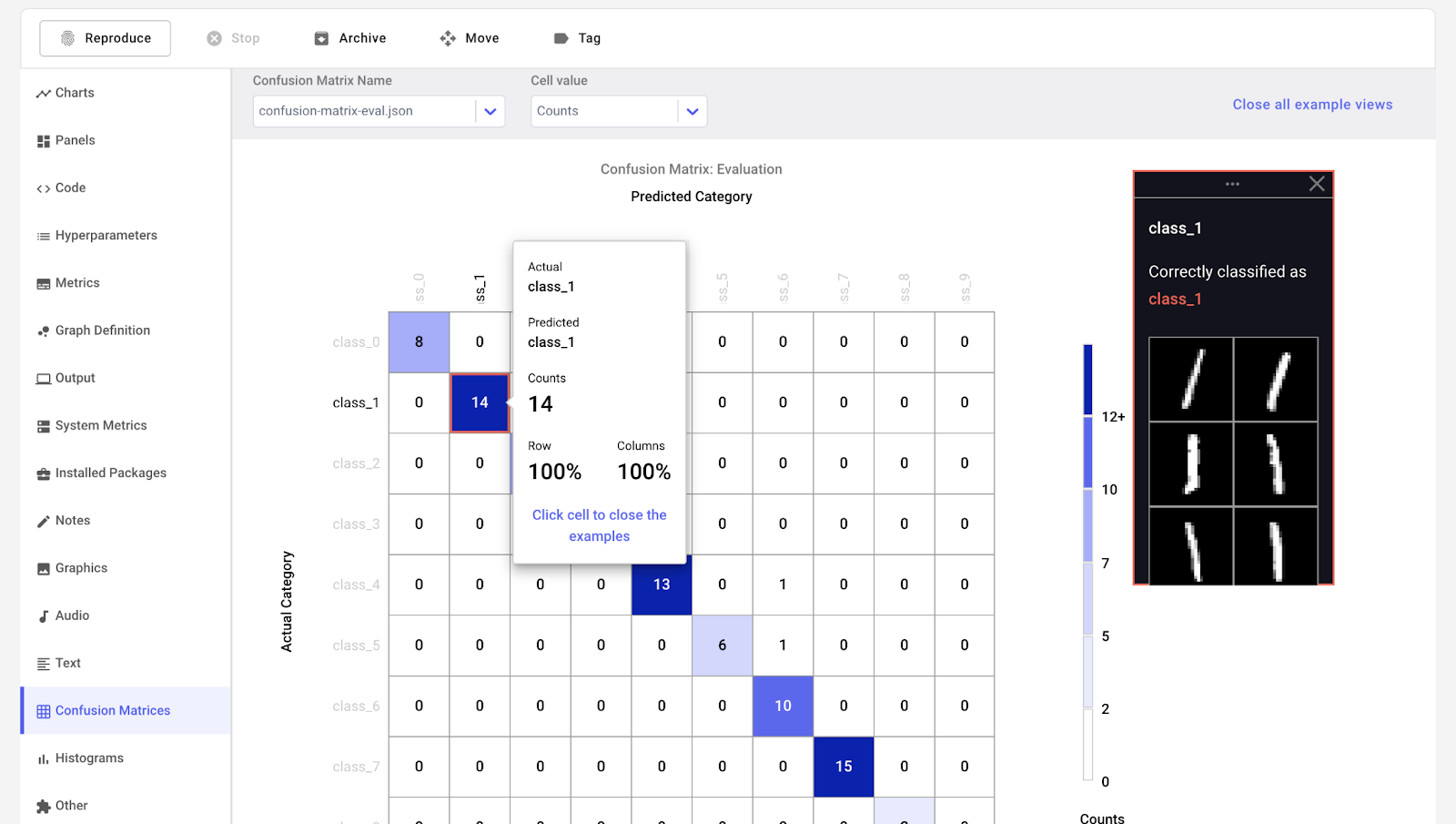

O Comet ML é uma plataforma para rastrear, comparar, explicar e otimizar modelos e experimentos de aprendizado de máquina. Você pode usá-lo com qualquer biblioteca de aprendizado de máquina, como Scikit-learn, Pytorch, TensorFlow e HuggingFace.

O Comet ML destina-se a indivíduos, equipes, empresas e acadêmicos. Ele permite que qualquer pessoa visualize e compare facilmente os experimentos. Além disso, ele permite que você visualize amostras de imagens, áudio, texto e dados tabulares.

Imagem do Comet ML

5. Pesos e vieses

O Weights & Biases é uma plataforma de ML para rastreamento de experimentos, versão de dados e modelos, otimização de hiperparâmetros e gerenciamento de modelos. Além disso, você pode usá-lo para registrar artefatos (conjuntos de dados, modelos, dependências, pipelines e resultados) e visualizar os conjuntos de dados (áudio, visual, texto e tabular).

O Weights & Biases tem um painel central de fácil utilização para experimentos de aprendizado de máquina. Assim como o Comet ML, você pode integrá-lo a outras bibliotecas de aprendizado de máquina, como Fastai, Keras, PyTorch, Hugging Face, Yolov5, Spacy e muitas outras. Você pode conferir nossa introdução a Weights & Bases em um artigo separado.

Gif de Weights & Biases

Observação: Você também pode usar o TensorBoard, o Pachyderm, o DagsHub e o DVC Studio para rastreamento de experimentos e gerenciamento de metadados de ML.

Ferramentas MLOps de orquestração e pipelines de fluxo de trabalho

Essas ferramentas ajudam você a criar projetos de ciência de dados e gerenciar fluxos de trabalho de aprendizado de máquina:

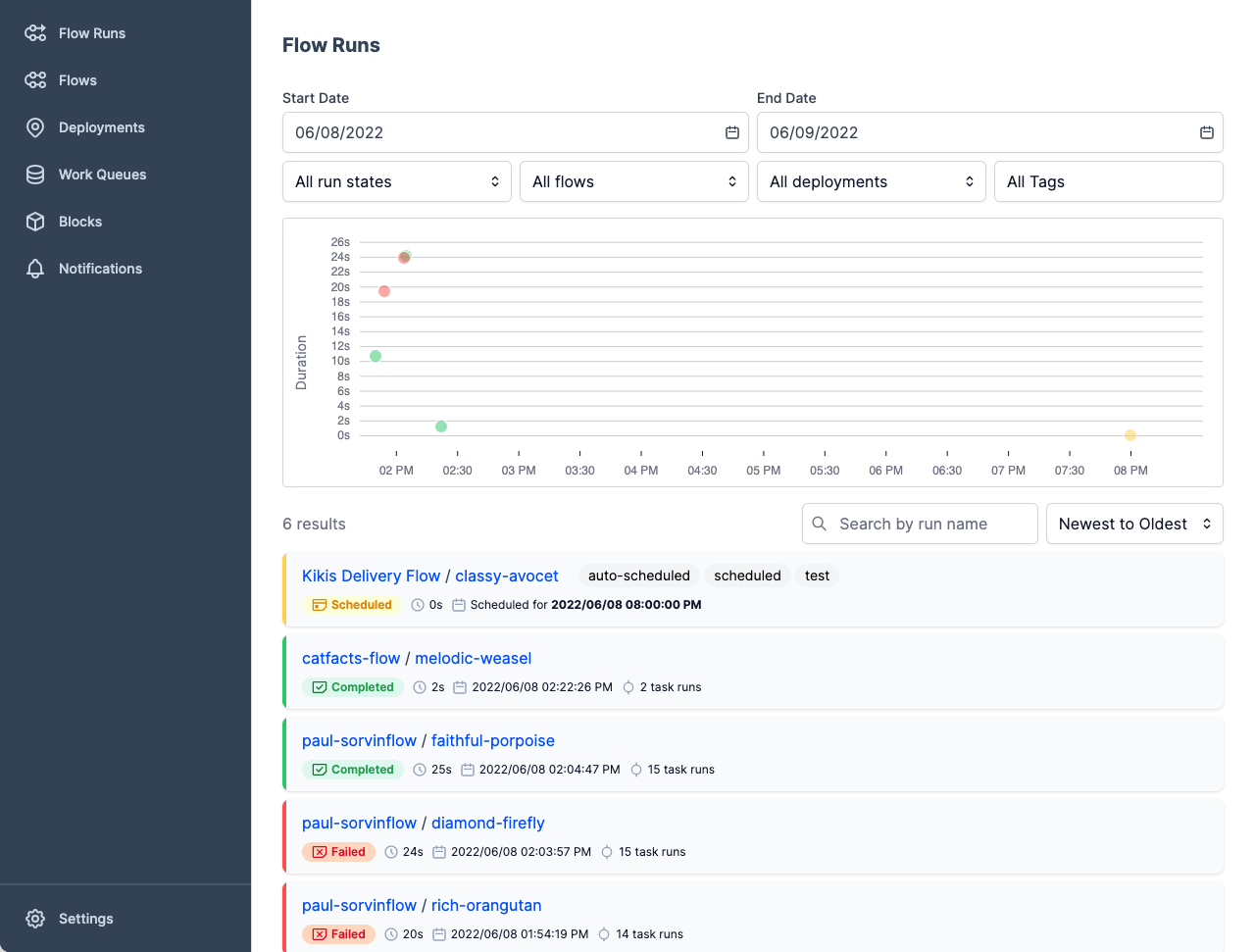

6. Prefeito

O Prefect é uma pilha de dados moderna para monitorar, coordenar e orquestrar fluxos de trabalho entre aplicativos. É uma ferramenta leve e de código aberto criada para pipelines de aprendizado de máquina de ponta a ponta.

Você pode usar o Prefect Orion UI ou o Prefect Cloud para os bancos de dados.

- O Prefect Orion UI é um mecanismo de orquestração e servidor de API de código aberto, hospedado localmente. Ele fornece a você informações sobre a instância local do Prefect Orion e os fluxos de trabalho.

- O Prefect Cloud é um serviço hospedado para você visualizar fluxos, execuções de fluxos e implementações. Além disso, você pode gerenciar contas, espaço de trabalho e colaboração em equipe.

Imagem da Prefect

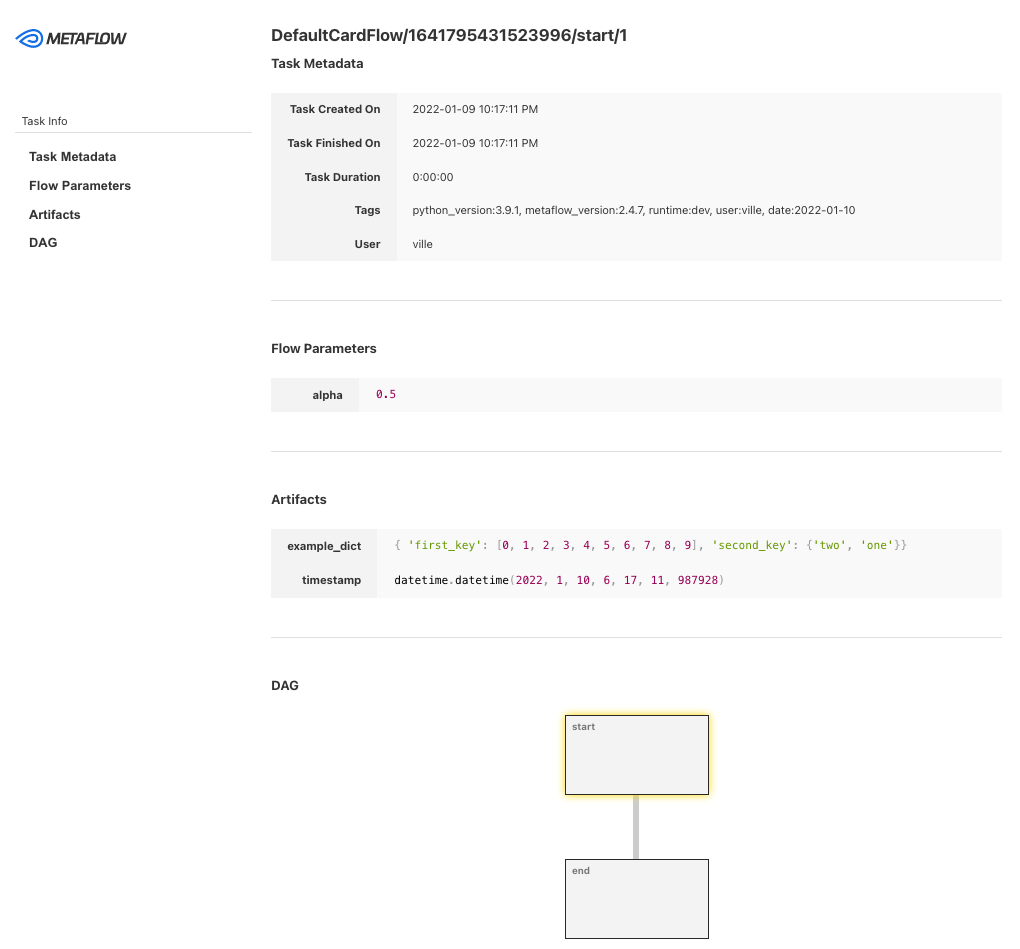

7. Metaflow

O Metaflow é uma ferramenta de gerenciamento de fluxo de trabalho avançada e resistente a batalhas para projetos de ciência de dados e aprendizado de máquina. Ele foi desenvolvido para cientistas de dados, para que eles possam se concentrar na criação de modelos em vez de se preocupar com a engenharia de MLOps.

Com o Metaflow, você pode projetar o fluxo de trabalho, executá-lo em escala e implantar o modelo na produção. Ele rastreia e versiona automaticamente os dados e os experimentos de aprendizado de máquina. Além disso, você pode visualizar os resultados no notebook.

O Metaflow funciona com várias nuvens (incluindo AWS, GCP e Azure) e vários pacotes Python de aprendizado de máquina (como Scikit-learn e Tensorflow), e a API também está disponível para a linguagem R.

Imagem da Metaflow

8. Kedro

O Kedro é uma ferramenta de orquestração de fluxo de trabalho baseada em Python. Você pode usá-lo para criar projetos de ciência de dados reproduzíveis, passíveis de manutenção e modulares. Ele integra os conceitos da engenharia de software ao aprendizado de máquina, como modularidade, separação de preocupações e controle de versão.

Com o Kedro, você pode:

- Defina as dependências e a configuração.

- Configurar dados.

- Crie, visualize e execute os pipelines.

- Registro e rastreamento de experimentos.

- Implementação em uma única máquina ou em uma máquina distribuída.

- Crie um código de ciência de dados de fácil manutenção.

- Criar código modular e reutilizável.

- Colaborar com colegas de equipe em projetos.

Gif de Kedro

Observação: você também pode usar o Kubeflow e o DVC para orquestração e pipelines de fluxo de trabalho.

Ferramentas de controle de versão de dados e pipeline

Com essas ferramentas de MLOps, você pode gerenciar tarefas relacionadas a dados e controle de versão de pipeline:

9. Paquiderme

O Pachyderm automatiza a transformação de dados com controle de versão de dados, linhagem e pipelines de ponta a ponta no Kubernetes. Você pode fazer a integração com qualquer dado (imagens, logs, vídeo, CSVs), qualquer linguagem (Python, R, SQL, C/C++) e em qualquer escala (Petabytes de dados, milhares de trabalhos).

A edição comunitária é de código aberto e para uma equipe pequena. As organizações e equipes que desejam recursos avançados podem optar pela edição Enterprise.

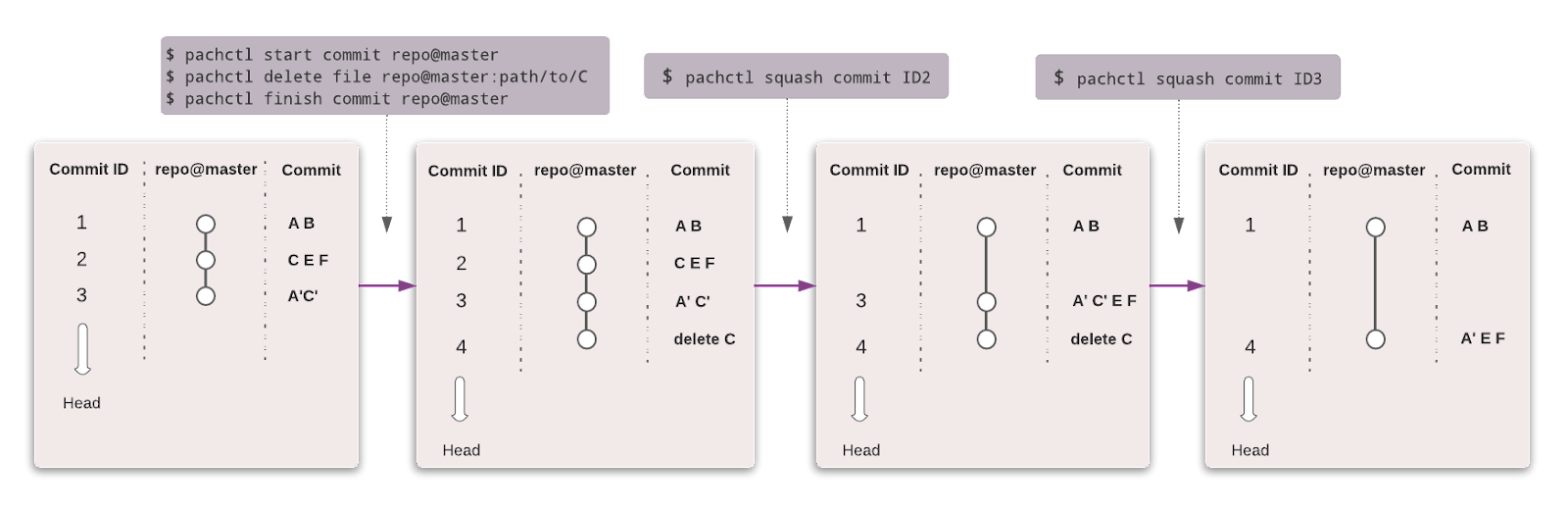

Assim como o Git, você pode versionar seus dados usando uma sintaxe semelhante. No Pachyderm, o nível mais alto do objeto é o Repositório, e você pode usar Commit, Branches, File, History e Provenance para rastrear e versionar o conjunto de dados.

Imagem de Pachyderm

10. Controle de versão de dados (DVC)

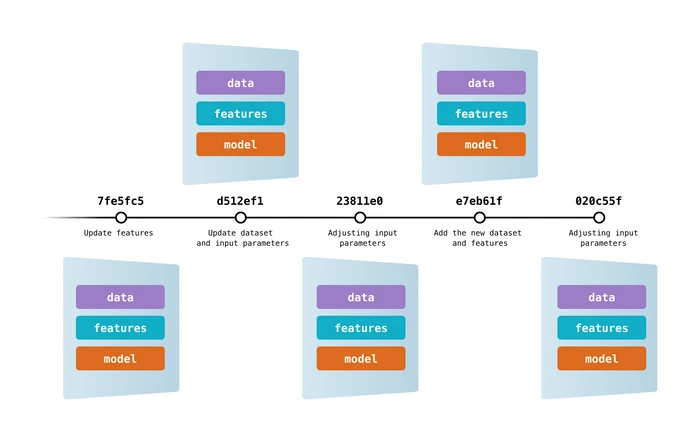

O Data Version Control é uma ferramenta popular e de código aberto para projetos de aprendizado de máquina. Ele funciona perfeitamente com o Git para fornecer a você versões de código, dados, modelos, metadados e pipeline.

O DVC é mais do que apenas uma ferramenta de controle de dados e controle de versão.

Você pode usá-lo para:

- Rastreamento de experimentos (métricas de modelo, parâmetros, controle de versão).

- Crie, visualize e execute pipelines de aprendizado de máquina.

- Fluxo de trabalho para implementação e colaboração.

- Reprodutibilidade.

- Registro de dados e modelos.

- Integração e implantação contínuas para aprendizado de máquina usando CML.

Imagem do DVC

Observação: O DagsHub também pode ser usado para controle de versão de dados e pipeline.

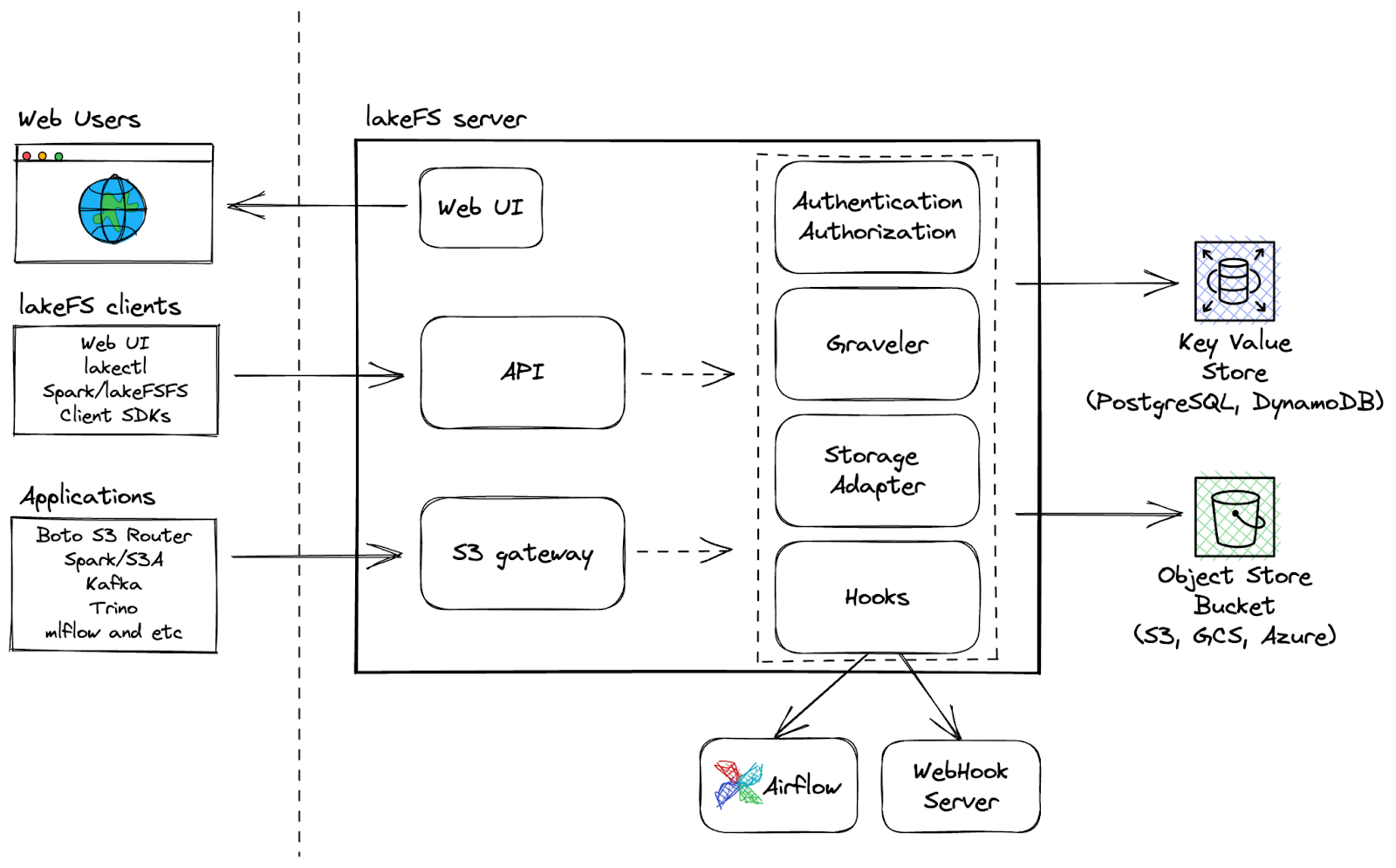

11. LakeFS

O LakeFS é uma ferramenta de controle de versão de dados dimensionável e de código aberto que fornece uma interface de controle de versão semelhante à do Git para armazenamento de objetos, permitindo que os usuários gerenciem seus lagos de dados como fariam com seu código. Com o LakeFS, os usuários podem controlar a versão dos dados em escala de exabytes, o que o torna uma solução altamente dimensionável para o gerenciamento de grandes lagos de dados.

Recursos adicionais:

- Execute operações do Git como ramificação, confirmação e mesclagem em qualquer serviço de armazenamento

- Desenvolvimento mais rápido com ramificação de cópia zero para experimentação sem atrito e colaboração fácil

- Use ganchos de pré-compactação e mesclagem para fluxos de trabalho de CI/CD para garantir fluxos de trabalho limpos

- A plataforma resiliente permite a recuperação mais rápida de problemas de dados com o recurso de reversão.

LakeFS Architecture

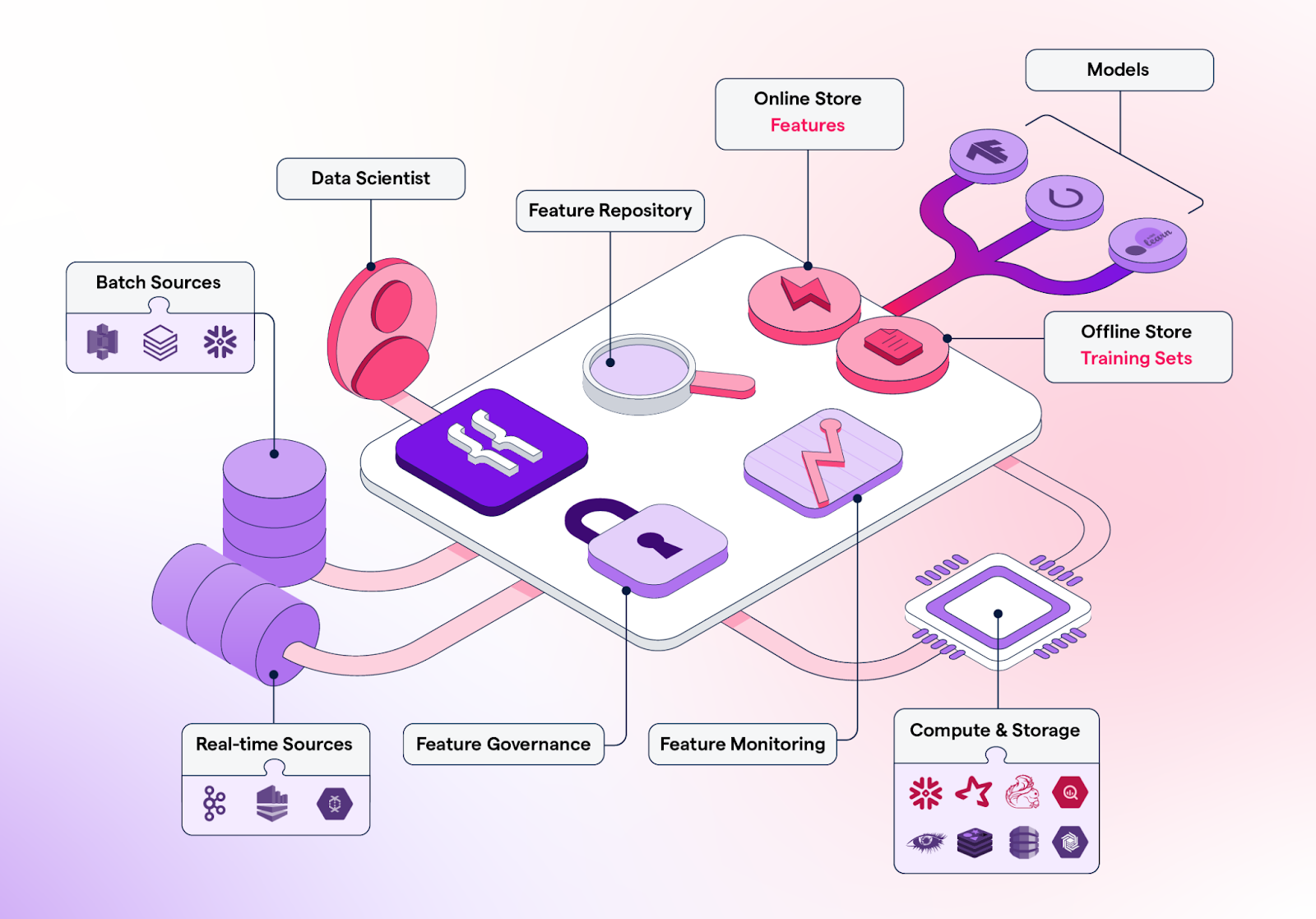

Lojas de recursos

Os repositórios de recursos são repositórios centralizados para armazenamento, controle de versão, gerenciamento e fornecimento de recursos (atributos de dados processados usados para treinar modelos de aprendizado de máquina) para modelos de aprendizado de máquina em produção e também para fins de treinamento.

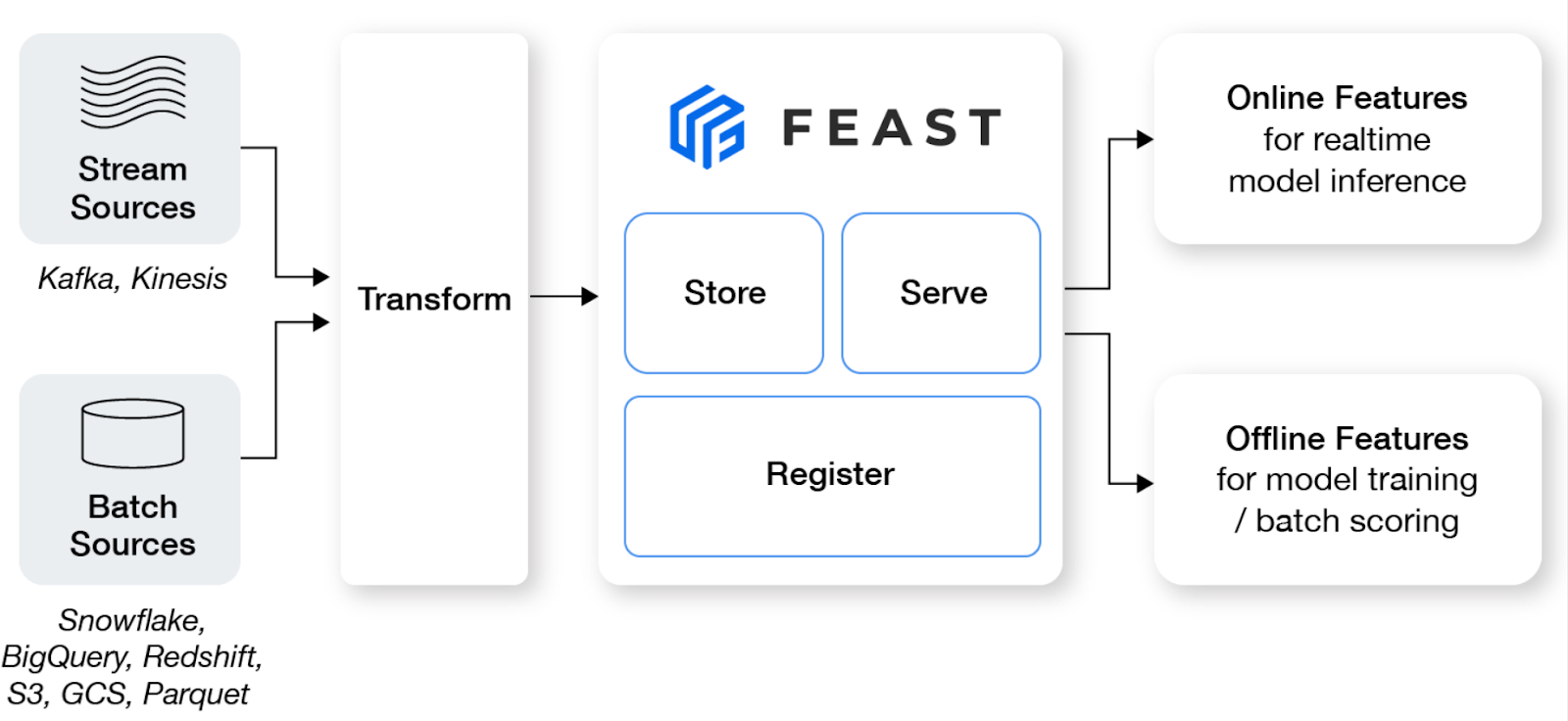

12. Festa

O Feast é um armazenamento de recursos de código aberto que ajuda as equipes de aprendizado de máquina a produzir modelos em tempo real e a criar uma plataforma de recursos que promove a colaboração entre engenheiros e cientistas de dados.

Principais recursos:

- Gerencie uma loja off-line, uma loja on-line de baixa latência e um servidor de recursos para garantir a disponibilidade consistente de recursos para fins de treinamento e atendimento.

- Evite o vazamento de dados criando conjuntos de recursos precisos e pontuais, liberando os cientistas de dados de lidar com a união de conjuntos de dados propensos a erros.

- Desacoplar o ML da infraestrutura de dados, tendo uma única camada de acesso.

Imagem de Feast

13. Forma de recurso

O Featureform é um armazenamento virtual de recursos que permite que os cientistas de dados definam, gerenciem e atendam aos recursos de seus modelos de ML. Ele pode ajudar as equipes de ciência de dados a aprimorar a colaboração, organizar a experimentação, facilitar a implantação, aumentar a confiabilidade e preservar a conformidade.

Principais recursos:

- Melhore a colaboração compartilhando, reutilizando e compreendendo os recursos de toda a equipe.

- Quando seu recurso estiver pronto para ser implantado, o Featureform orquestrará sua infraestrutura de dados para deixá-lo pronto para a produção.

- O sistema garante que nenhum recurso, rótulo ou conjunto de treinamento possa ser modificado para aumentar a confiabilidade.

- Com controle de acesso integrado baseado em função, logs de auditoria e regras de serviço dinâmicas, o Featureform pode aplicar diretamente a sua lógica de conformidade.

Imagem do Featureform

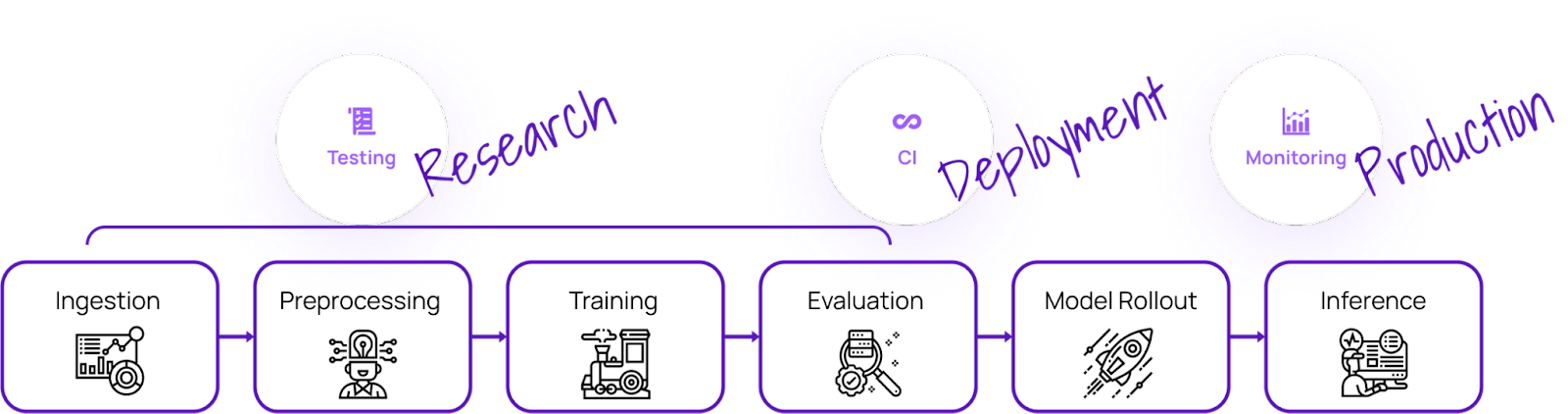

Teste de modelos

Com essas ferramentas de MLOps, você pode testar a qualidade do modelo e garantir a confiabilidade, a robustez e a precisão dos modelos de aprendizado de máquina:

14. Deepchecks Teste de modelos de ML

O Deepchecks é uma solução de código aberto que atende a todas as suas necessidades de validação de ML, garantindo que seus dados e modelos sejam totalmente testados, desde a pesquisa até a produção. Ele oferece uma abordagem holística para validar seus dados e modelos por meio de seus vários componentes.

Imagem de Deepchecks

O Deepchecks consiste em três componentes:

- Teste Deepchecks: permite que você crie verificações e conjuntos personalizados para validação tabular, processamento de linguagem natural e visão computacional.

- CI e gerenciamento de testes: fornece CI e gerenciamento de testes para ajudar você a colaborar com a sua equipe e gerenciar os resultados dos testes de forma eficaz.

- Monitoramento Deepchecks: rastreia e valida modelos em produção.

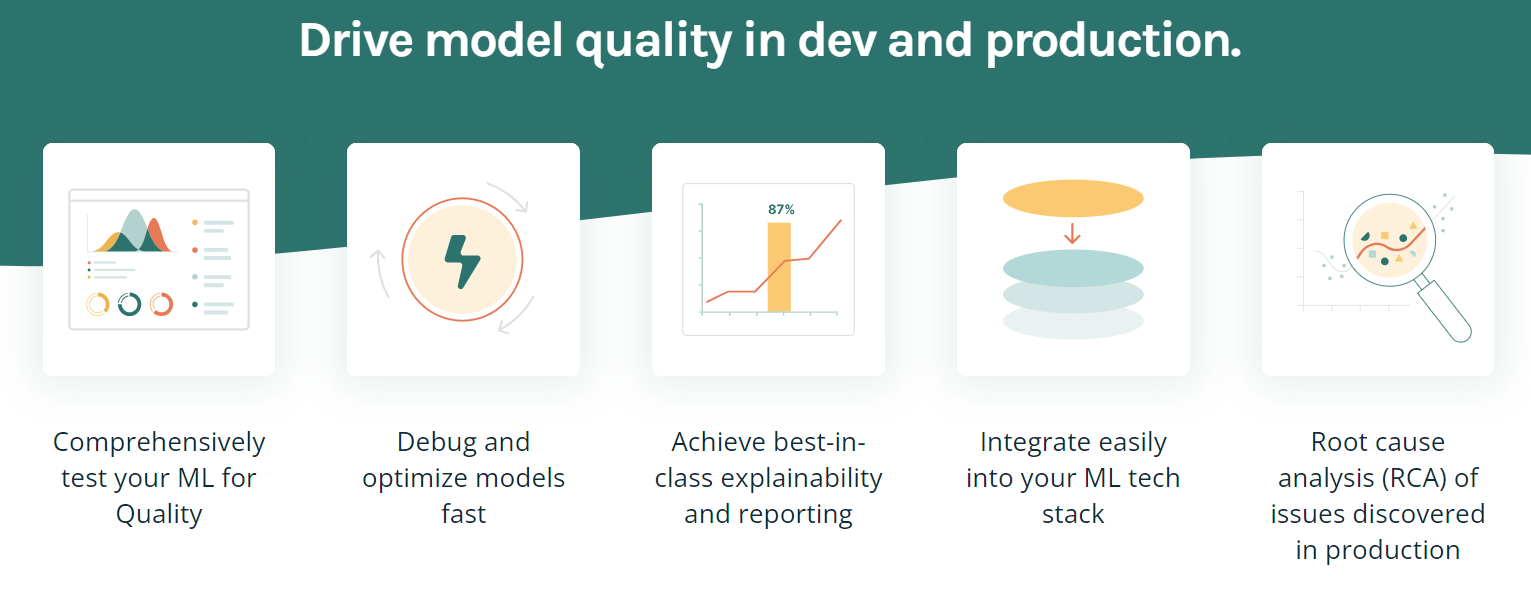

15. TruEra

O TruEra é uma plataforma avançada projetada para impulsionar a qualidade e o desempenho do modelo por meio de testes automatizados, explicabilidade e análise de causa raiz. Ele oferece vários recursos para ajudar a otimizar e depurar modelos, obter a melhor explicabilidade da categoria e integrar-se facilmente à sua pilha de tecnologia de ML.

Principais recursos:

- O recurso de teste e depuração de modelos permite que você melhore a qualidade do modelo durante o desenvolvimento e a produção.

- Ele pode realizar testes automatizados e sistemáticos para garantir o desempenho, a estabilidade e a imparcialidade.

- Ele compreende a evolução das versões do modelo. Isso permite que você extraia insights que orientam o desenvolvimento de modelos mais rápidos e eficazes.

- Identificar e apontar quais recursos específicos estão contribuindo para o viés do modelo.

- O TruEra pode ser facilmente integrado à sua infraestrutura e ao seu fluxo de trabalho atuais, sem complicações.

Imagem por TruEra

Ferramentas de implantação e de serviço de modelos

Quando se trata de implementar modelos, essas ferramentas de MLOps podem ser extremamente úteis:

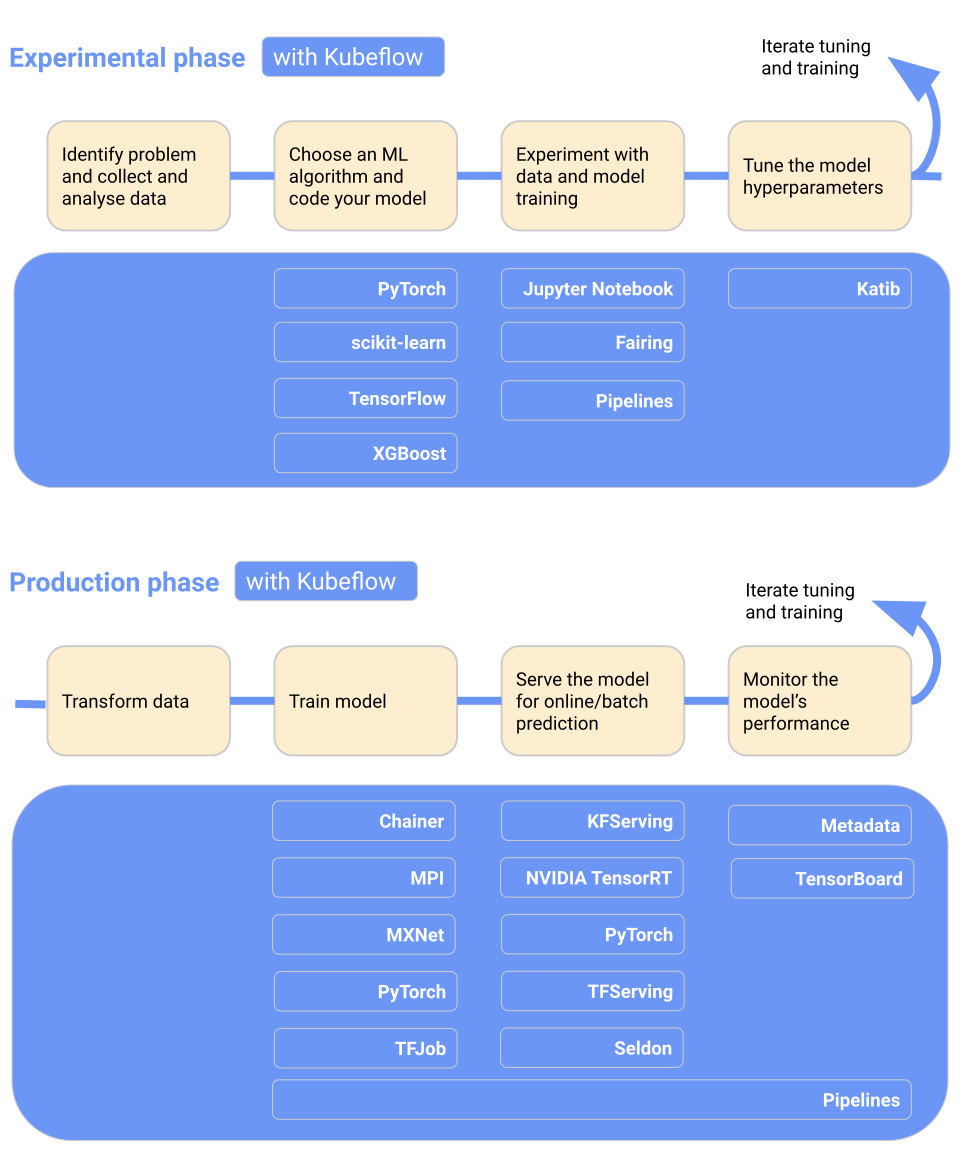

16. Kubeflow

O Kubeflow torna a implantação do modelo de aprendizado de máquina no Kubernetes simples, portátil e dimensionável. Você pode usá-lo para a preparação de dados, treinamento de modelos, otimização de modelos, serviço de previsão e motorização do desempenho do modelo na produção. Você pode implementar o fluxo de trabalho de aprendizado de máquina localmente, no local ou na nuvem. Em resumo, ele torna o Kubernetes fácil para as equipes de ciência de dados.

Principais recursos:

- Painel de controle centralizado com interface de usuário interativa.

- Pipelines de aprendizado de máquina para reprodutibilidade e simplificação.

- Oferece suporte nativo para JupyterLab, RStudio e Visual Studio Code.

- Ajuste de hiperparâmetros e pesquisa de arquitetura neural.

- Trabalhos de treinamento para Tensorflow, Pytorch, PaddlePaddle, MXNet e XGboost.

- Programação de trabalho.

- Forneça aos administradores o isolamento de vários usuários.

- Funciona com todos os principais provedores de nuvem.

Imagem do Kubeflow

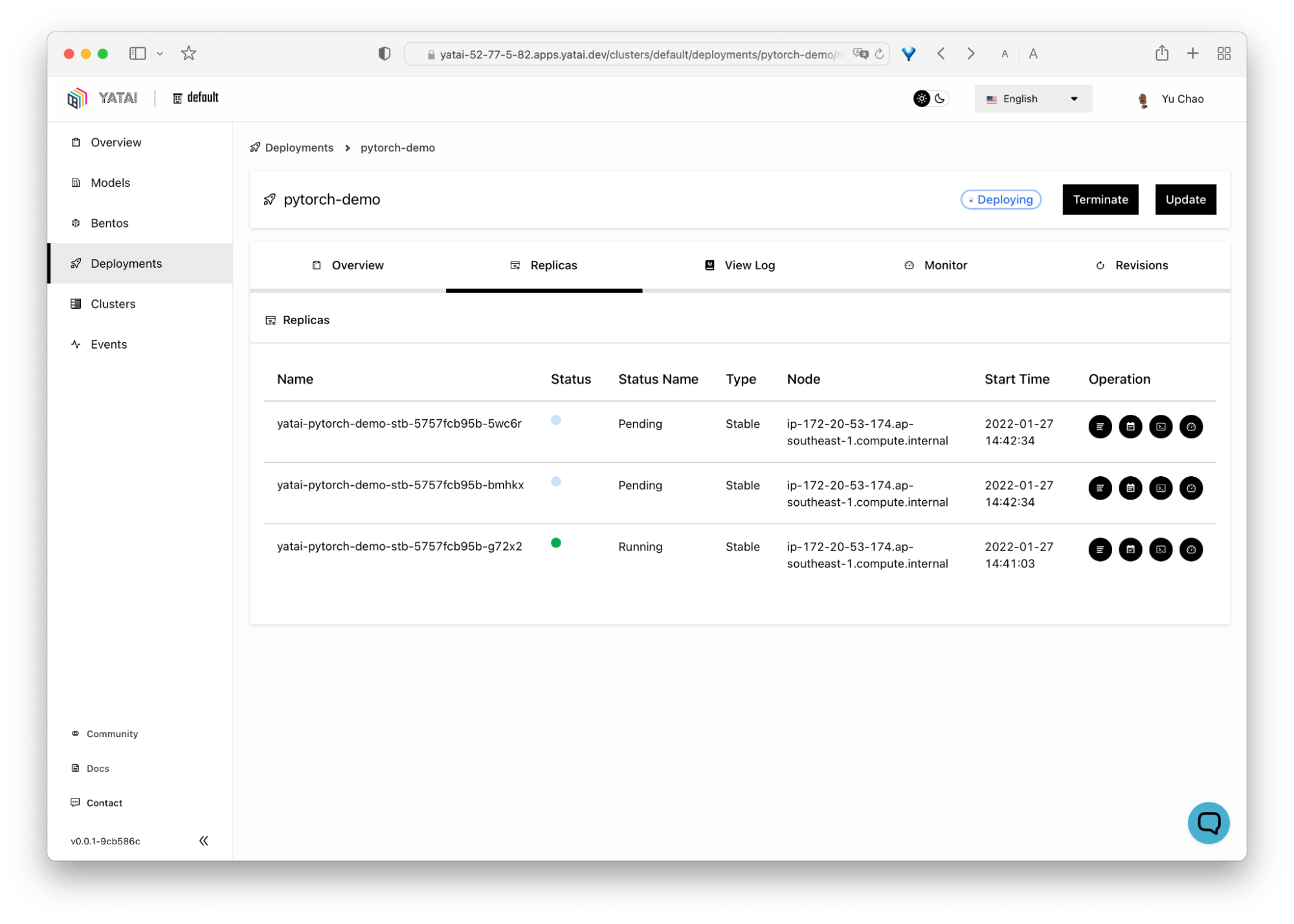

10. BentoML

O BentoML facilita e agiliza o envio de aplicativos de aprendizado de máquina. É uma ferramenta baseada em Python para implantação e manutenção de APIs na produção. Ele é dimensionado com otimizações avançadas, executando inferência paralela e agrupamento adaptável, e oferece aceleração de hardware.

O painel centralizado e interativo do BentoML facilita a organização e o monitoramento da implementação de modelos de aprendizado de máquina. A melhor parte é que ele funciona com todos os tipos de estruturas de aprendizado de máquina, como Keras, ONNX, LightGBM, Pytorch e Scikit-learn. Em suma, o BentoML oferece uma solução completa para implementação, serviço e monitoramento de modelos.

Imagem de BentoML

18. Pontos finais de inferência de face de abraço

O Hugging Face Inference Endpoints é um serviço baseado em nuvem oferecido pela Hugging Face, uma plataforma de ML tudo-em-um que permite aos usuários treinar, hospedar e compartilhar modelos, conjuntos de dados e demonstrações. Esses endpoints são projetados para ajudar os usuários a implementar seus modelos de aprendizado de máquina treinados para inferência sem a necessidade de configurar e gerenciar a infraestrutura necessária.

Principais recursos:

- Mantenha o custo tão baixo quanto US$ 0,06 por núcleo de CPU/hora e US$ 0,6 por GPU/hora, dependendo de suas necessidades.

- Fácil de implementar em segundos.

- Totalmente gerenciado e com escala automática.

- Parte do ecossistema Hugging Face.

- Segurança de nível empresarial.

Imagem de Hugging Face

Observação: Você também pode usar o MLflow e o AWS sagemaker para implantação e fornecimento de modelos.

Monitoramento de modelos em ferramentas de ML Ops de produção

Independentemente de seu modelo de ML estar em desenvolvimento, validação ou implantado na produção, essas ferramentas podem ajudar você a monitorar uma série de fatores:

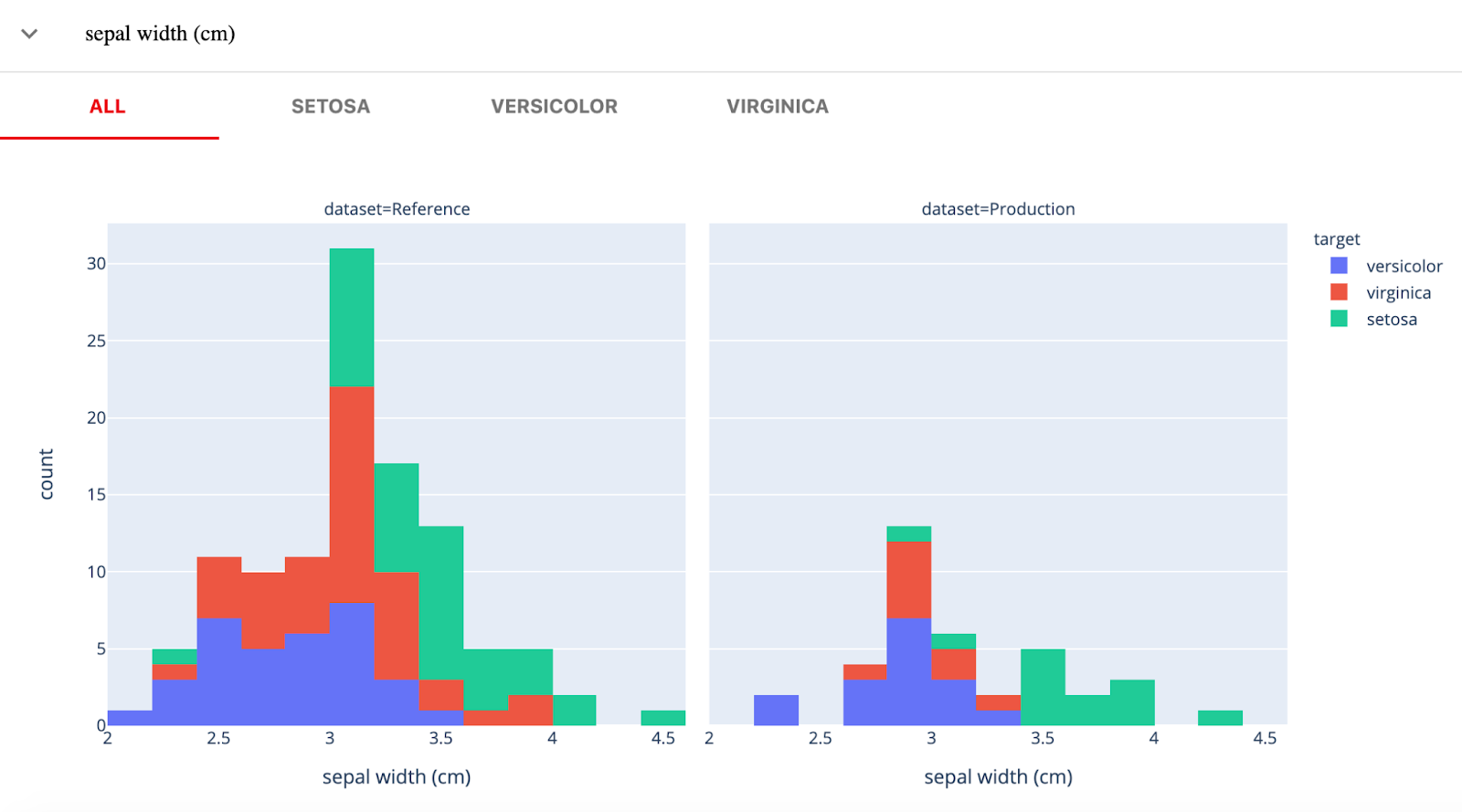

19. Evidentemente

Evidently AI é uma biblioteca Python de código aberto para monitorar modelos de ML durante o desenvolvimento, a validação e a produção. Ele verifica a qualidade dos dados e do modelo, o desvio dos dados, o desvio do alvo e o desempenho da regressão e da classificação.

Evidentemente, tem três componentes principais:

- Testes (verificações de modelos em lote): para realizar verificações de qualidade de dados estruturados e modelos.

- Relatórios (painéis interativos): desvio interativo de dados, desempenho do modelo e virtualização de alvos.

- Monitores (monitoramento em tempo real): monitora os dados e as métricas do modelo do serviço de ML implantado.

Imagem de Evidently

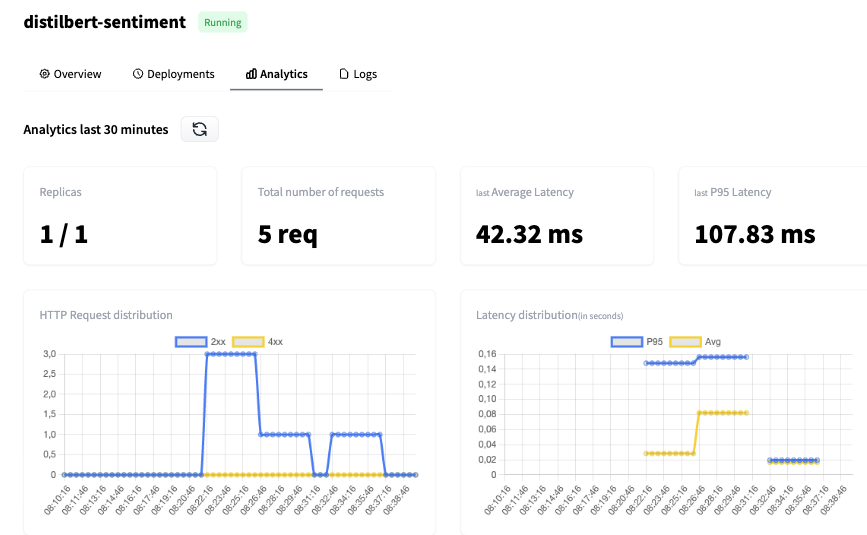

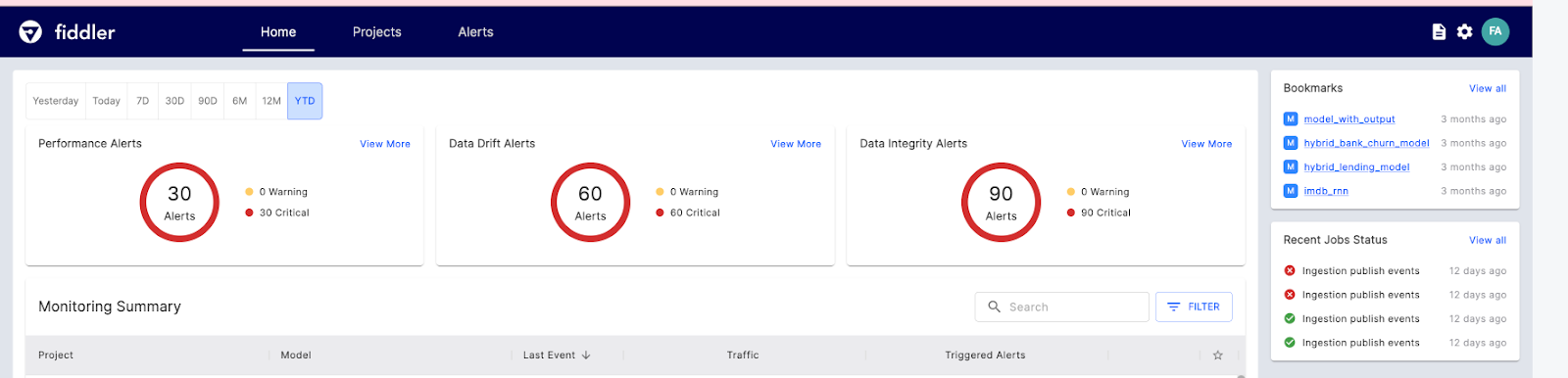

20. Violinista

O Fiddler AI é uma ferramenta de monitoramento de modelos de ML com uma interface de usuário clara e fácil de usar. Ele permite que você explique e depure previsões, analise o comportamento do modo para todo o conjunto de dados, implemente modelos de aprendizado de máquina em escala e monitore o desempenho do modelo.

Vamos dar uma olhada nos principais recursos de IA do Fiddler para monitoramento de ML:

- Monitoramento de desempenho: visualização detalhada do desvio de dados, quando e como ele está sendo desviado.

- Integridade dos dados: evite fornecer dados incorretos para o treinamento do modelo.

- Rastreamento de outliers: mostra outliers univariados e multivariados.

- Métricas de serviço: mostra insights básicos sobre as operações de serviço do ML.

- Alertas: configure alertas para um modelo ou grupo de modelos para avisar sobre os problemas na produção.

Imagem de Fiddler

Mecanismos de tempo de execução

O mecanismo de tempo de execução é responsável por carregar o modelo, pré-processar os dados de entrada, executar a inferência e retornar os resultados para o aplicativo cliente.

21. Raio

O Ray é uma estrutura versátil projetada para dimensionar aplicativos de IA e Python, facilitando aos desenvolvedores o gerenciamento e a otimização de seus projetos de aprendizado de máquina.

A plataforma consiste em dois componentes principais: um núcleo de tempo de execução distribuído e um conjunto de bibliotecas de IA adaptadas para simplificar a computação de ML.

O Ray Core oferece um conjunto limitado de elementos fundamentais que podem ser usados para criar e expandir aplicativos distribuídos.

- As tarefas são funções que não têm um estado e são executadas no cluster.

- Os atores são processos de trabalho que têm estado e são criados dentro do cluster.

- Os objetos são valores imutáveis que podem ser acessados por qualquer componente do cluster.

A Ray também fornece bibliotecas de IA para conjuntos de dados dimensionáveis para ML, treinamento distribuído, ajuste de hiperparâmetros, aprendizado por reforço e serviço dimensionável e programável.

O exemplo a seguir demonstra o treinamento e a veiculação de um modelo de classificador de Gradient Boosting.

import requests

from starlette.requests import Request

from typing import Dict

from sklearn.datasets import load_iris

from sklearn.ensemble import GradientBoostingClassifier

from ray import serve

# Train model.

iris_dataset = load_iris()

model = GradientBoostingClassifier()

model.fit(iris_dataset["data"], iris_dataset["target"])

@serve.deployment

class BoostingModel:

def __init__(self, model):

self.model = model

self.label_list = iris_dataset["target_names"].tolist()

async def __call__(self, request: Request) -> Dict:

payload = (await request.json())["vector"]

print(f"Received http request with data {payload}")

prediction = self.model.predict([payload])[0]

human_name = self.label_list[prediction]

return {"result": human_name}

# Deploy model.

serve.run(BoostingModel.bind(model), route_prefix="/iris")22. Nuclio

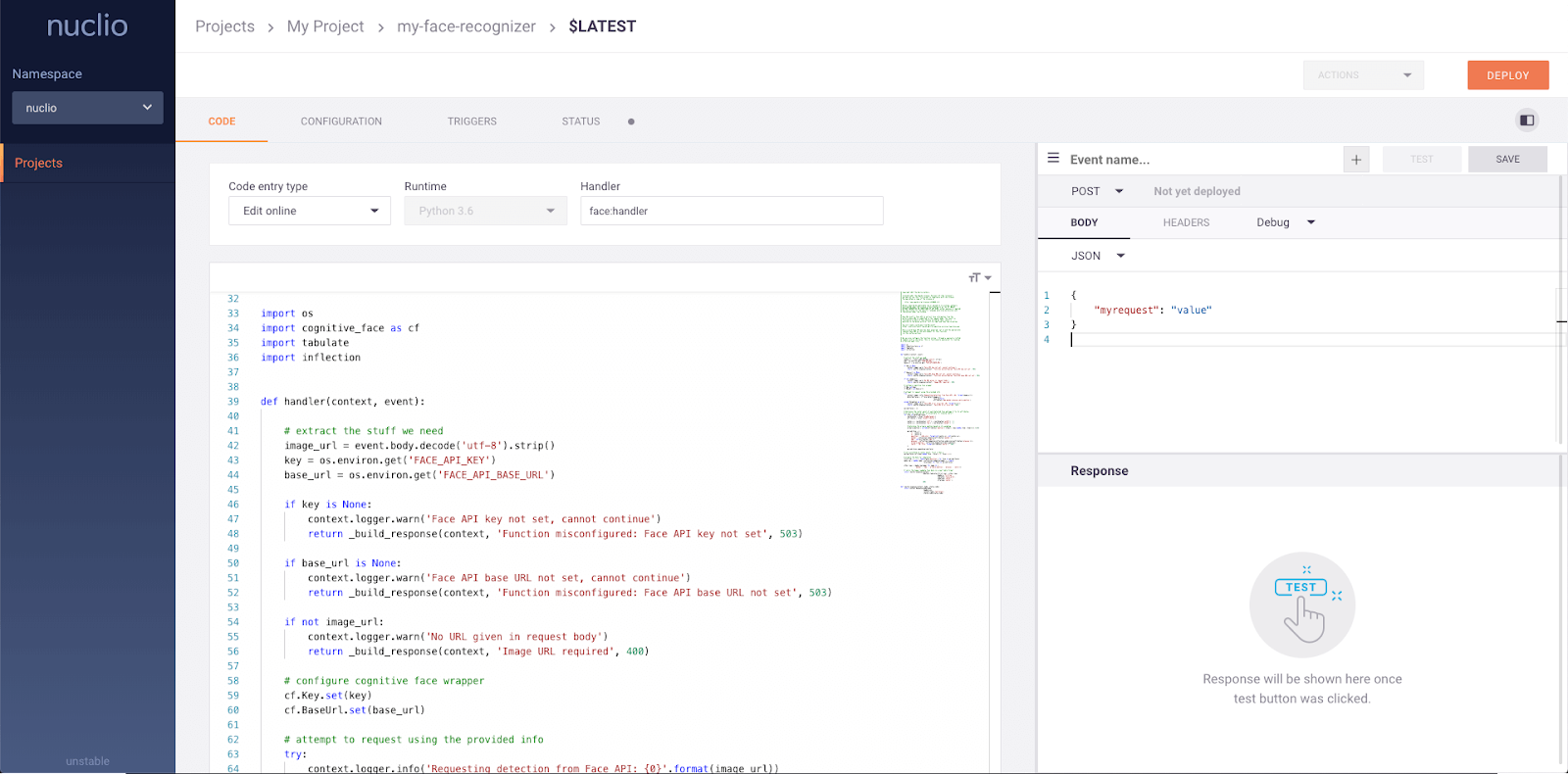

O Nuclio é uma estrutura avançada que se concentra em cargas de trabalho com uso intenso de dados, E/S e computação. Ele foi projetado para ser sem servidor, o que significa que você não precisa se preocupar com o gerenciamento de servidores. O Nuclio é bem integrado a ferramentas populares de ciência de dados, como Jupyter e Kubeflow. Ele também oferece suporte a uma ampla variedade de fontes de dados e streaming e pode ser executado em CPUs e GPUs.

Principais recursos:

- Requer recursos mínimos de CPU/GPU e E/S para executar o processamento em tempo real e, ao mesmo tempo, maximizar o paralelismo.

- Integra-se a uma ampla variedade de fontes de dados e estruturas de ML.

- Fornece funções de estado com aceleração de caminho de dados

- Portabilidade em todos os tipos de dispositivos e plataformas de nuvem, especialmente dispositivos de baixo consumo de energia.

- Projetado para a empresa.

Imagem de Nuclio

Plataformas de MLOps de ponta a ponta

Se você estiver procurando uma ferramenta abrangente de MLOps que possa ajudar durante todo o processo, aqui estão algumas das melhores:

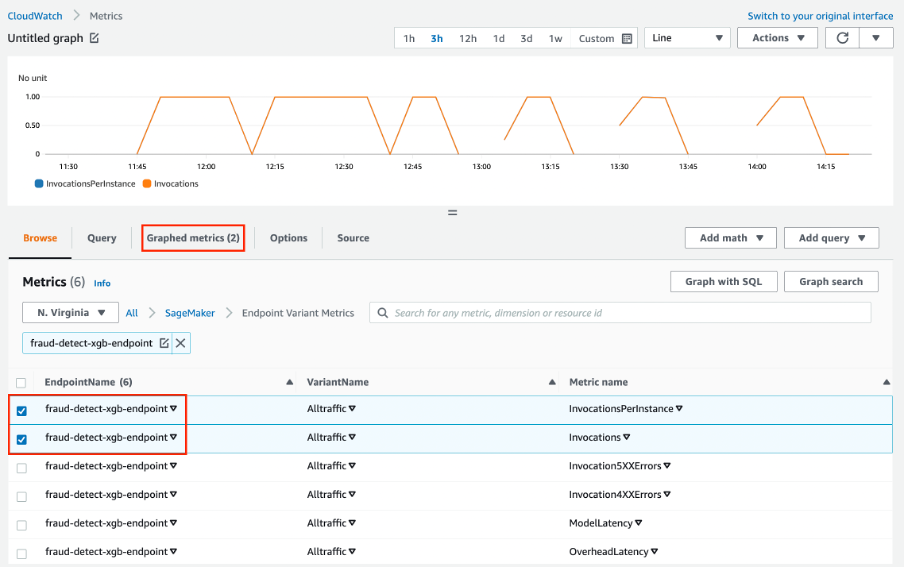

23. AWS SageMaker

O Amazon Web Services SageMaker é uma solução completa para MLOps. Você pode treinar e acelerar o desenvolvimento de modelos, rastrear e versionar experimentos, catalogar artefatos de ML, integrar pipelines de ML de CI/CD e implantar, servir e monitorar modelos na produção sem problemas.

Principais recursos:

- Um ambiente colaborativo para equipes de ciência de dados.

- Automatize os fluxos de trabalho de treinamento de ML.

- Implantar e gerenciar modelos em produção.

- Rastrear e manter versões de modelos.

- CI/CD para integração e implementação automáticas.

- Monitoramento contínuo e retenção de modelos para manter a qualidade.

- Otimize o custo e o desempenho.

Imagem do Amazon SageMaker

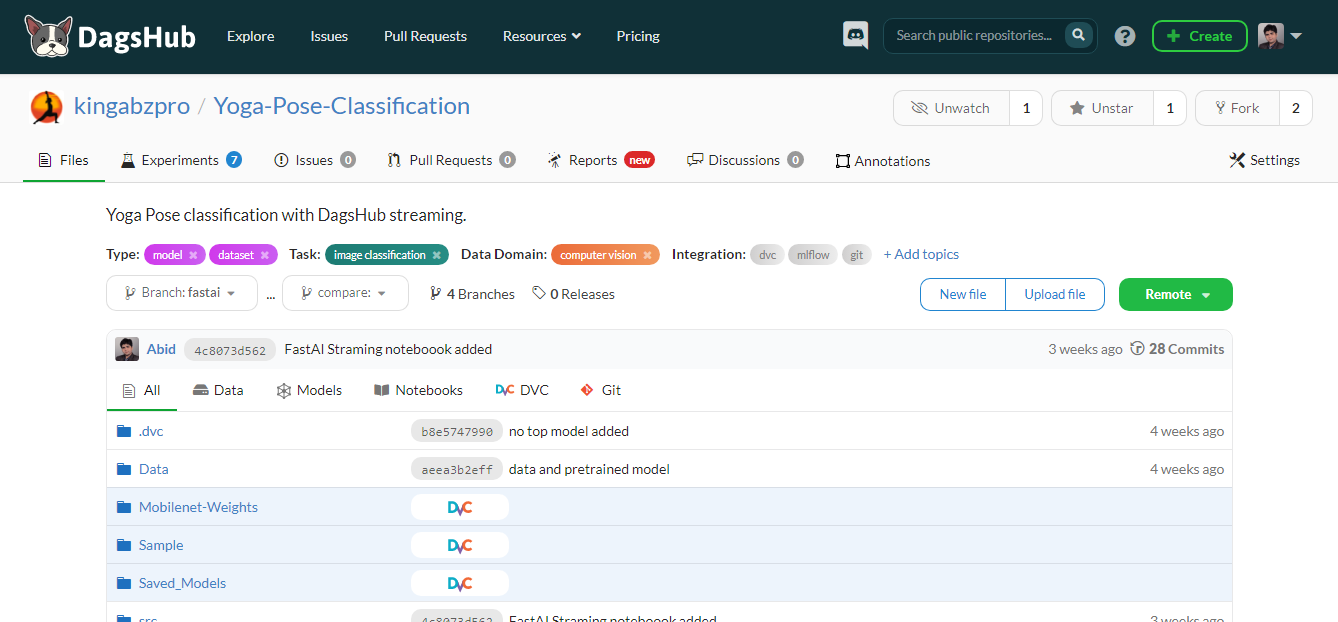

24. DagsHub

O DagsHub é uma plataforma criada para que a comunidade de aprendizado de máquina rastreie e controle a versão de dados, modelos, experimentos, pipelines de ML e código. Ele permite que sua equipe crie, revise e compartilhe projetos de aprendizado de máquina.

Simplificando, ele é um GitHub para aprendizado de máquina, e você obtém várias ferramentas para otimizar o processo de aprendizado de máquina de ponta a ponta.

Principais recursos:

- Repositório Git e DVC para seus projetos de ML.

- Registrador do DagsHub e instância do MLflow para rastreamento de experimentos.

- Anotação de conjunto de dados usando a instância do Label Studio.

- Difundir os notebooks, códigos, conjuntos de dados e imagens do Jupyter.

- Capacidade de comentar o arquivo, a linha do código ou o conjunto de dados.

- Crie um relatório para o projeto, assim como o wiki do GitHub.

- Visualização do pipeline de ML.

- Resultados reproduzíveis.

- Execução de CI/CD para treinamento e implantação de modelos.

- Fusão de dados.

- Fornecer integração com GitHub, Google Colab, DVC, Jenkins, armazenamento externo, webhooks e New Relic.

Imagem do autor

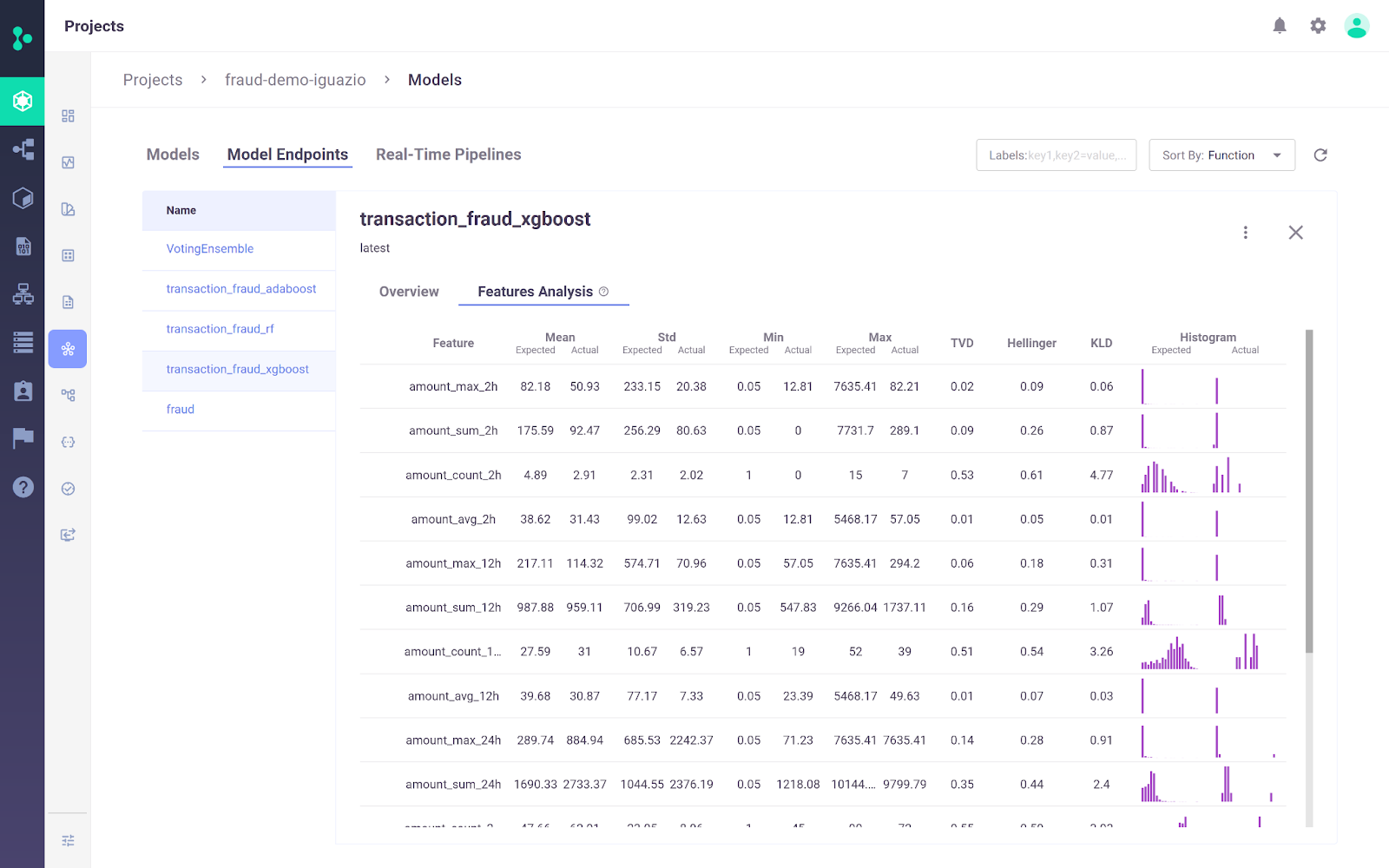

25. Plataforma MLOps da Iguazio

A Iguazio MLOps Platform é uma plataforma de MLOps de ponta a ponta que permite que as organizações automatizem o pipeline de aprendizado de máquina, desde a coleta e a preparação de dados até o treinamento, a implementação e o monitoramento na produção. Ele oferece uma plataforma aberta(MLRun) e gerenciada.

Um diferencial importante da plataforma MLOps da Iguazio é a flexibilidade nas opções de implementação. Os usuários podem implementar aplicativos de IA em qualquer lugar, inclusive em ambientes de nuvem, híbridos ou locais. Isso é particularmente importante para setores como saúde e finanças, em que as preocupações com a privacidade dos dados podem tornar a implantação no local um requisito.

Imagem da plataforma MLOps da Iguazio

Principais recursos:

- A plataforma permite que os usuários ingiram dados de qualquer fonte e criem recursos reutilizáveis on-line e off-line usando o armazenamento de recursos integrado.

- Ele suporta o treinamento e a avaliação contínuos de modelos em escala, usando o serverless dimensionável com rastreamento automatizado, controle de versão de dados e integração e implantação contínuas.

- Fácil de implantar modelos na produção com apenas alguns cliques, monitora continuamente o desempenho do modelo e reduz o desvio do modelo.

- A plataforma vem com um painel simples para gerenciar, administrar e monitorar modelos e produção em tempo real.

Visão geral das ferramentas MLOps

Aqui está uma tabela de comparação para que você possa avaliar essas ferramentas lado a lado e decidir quais são as melhores para seus projetos:

| Ferramenta | Funcionalidade principal | Estruturas compatíveis | Opções de implementação |

|---|---|---|---|

| Qdrant | Pesquisa de similaridade vetorial e gerenciamento de banco de dados | Python, vários idiomas | Nativo na nuvem, escalável horizontalmente |

| LangChain | Desenvolver aplicativos com modelos de linguagem | Python, JavaScript | API REST, modelos |

| MLFlow | Rastreamento de experimentos, registro de modelos, implantação | Python, R, Java, REST API | Local, na nuvem |

| Cometa ML | Rastreamento e otimização de experimentos | Scikit-learn, PyTorch, TensorFlow, HuggingFace | Local, na nuvem |

| Pesos e vieses | Acompanhamento de experimentos, controle de versão de dados e modelos | Fastai, Keras, PyTorch, HuggingFace, Yolov5, Spacy | Local, na nuvem |

| Prefeito | Orquestração e monitoramento do fluxo de trabalho | Python | Local (UI do Orion), nuvem |

| Metaflow | Gerenciamento de fluxo de trabalho para ciência de dados | Scikit-learn, TensorFlow, Python, R | AWS, GCP, Azure, local |

| Kedro | Orquestração de fluxo de trabalho, reprodutibilidade | Python | Local, distribuído |

| Paquiderme | Transformação de dados, controle de versão e linhagem | Qualquer idioma | Kubernetes |

| DVC | Controle de versão de dados e pipeline | Git, Python | Local, na nuvem |

| LakeFS | Controle de versão semelhante ao Git para lagos de dados | Qualquer serviço de armazenamento | Local, na nuvem |

| Festa | Armazenamento centralizado de recursos para modelos de ML | Python | Local, na nuvem |

| Forma de recurso | Armazenamento virtual de recursos para modelos de ML | Python | Local, na nuvem |

| Verificações profundas | Teste e validação do modelo de ML | Python | Local, na nuvem |

| TruEra | Teste de qualidade e desempenho do modelo | Python | Local, na nuvem |

| Kubeflow | Implantação e orquestração de modelos de ML | TensorFlow, PyTorch, PaddlePaddle, MXNet, XGboost | Kubernetes, nuvem |

| BentoML | Implementação de modelos e gerenciamento de API | Keras, ONNX, LightGBM, PyTorch, Scikit-learn | Local, na nuvem |

| Cara de abraço | Inferência e implementação de modelos | Qualquer modelo | Nuvem |

| Evidentemente | Monitoramento de modelos de ML para desvio de dados e alvos | Python | Local, na nuvem |

| Violinista | Monitoramento e depuração de modelos de ML | Python | Local, na nuvem |

| Raio | Dimensione aplicativos de IA e Python | Python | Local, na nuvem |

| Nuclio | Estrutura sem servidor para cargas de trabalho com uso intensivo de dados e computação | Jupyter, Kubeflow | Nuvem, no local |

| AWS SageMaker | Gerenciamento de ciclo de vida de ML de ponta a ponta | Python, R, Java, TensorFlow, PyTorch | Nuvem AWS |

| DagsHub | Controle de versão e colaboração para projetos de ML | Git, DVC, MLflow | Local, na nuvem |

| Iguazio | Automação de ponta a ponta de pipelines de ML | Python, MLRun | Nuvem, híbrido, no local |

Conclusão

Estamos em um momento em que há um boom no setor de MLOps. Toda semana você vê novos desenvolvimentos, novas startups e novas ferramentas sendo lançadas para resolver o problema básico de converter notebooks em aplicativos prontos para produção. Até mesmo as ferramentas existentes estão expandindo o horizonte e integrando novos recursos para se tornarem ferramentas super MLOps.

Neste blog, aprendemos sobre as melhores ferramentas de MLOps para várias etapas do processo de MLOps. Essas ferramentas ajudarão você durante os estágios de experimentação, desenvolvimento, implementação e monitoramento.

Se você é novo no aprendizado de máquina e deseja dominar as habilidades essenciais para conseguir um emprego como cientista de aprendizado de máquina, experimente fazer nosso curso de carreira de Cientista de Aprendizado de Máquina com Python.

Se você é um profissional e deseja saber mais sobre as práticas padrão de MLOps, leia nosso artigo sobre as melhores práticas de MLOps e como aplicá-las e confira nossa trilha de habilidades MLOps Fundamentals .

Obtenha uma das melhores certificações de IA

Perguntas frequentes sobre as ferramentas MLOps

O que são ferramentas MLOps?

As ferramentas de MLOps ajudam a padronizar, simplificar e otimizar o ecossistema de ML. Essas ferramentas são usadas para rastreamento de experimentos, gerenciamento de metadados de modelos, orquestração, otimização de modelos, controle de versão de fluxo de trabalho, implantação e fornecimento de modelos e monitoramento de modelos na produção.

Quais são as habilidades necessárias para um engenheiro de MLOps?

- Capacidade de implementar soluções em nuvem.

- Experiência com Docker e Kubernetes.

- Experiência com garantia de qualidade usando rastreamento de experimentos e controle de versão de fluxo de trabalho.

- Capacidade de criar pipelines de MLOps.

- Familiarizado com o sistema operacional Linux.

- Experiência com estruturas de ML, como PyTorch, Tensorflow e TFX.

- Experiência com DevOps e desenvolvimento de software.

- Experiência com testes de unidade e integração, validação de dados e modelos e monitoramento pós-implantação.

Qual é a melhor nuvem para MLOps?

A AWS, o GCP e o Azure oferecem uma variedade de ferramentas para o ciclo de vida do aprendizado de máquina. Todas elas oferecem soluções completas para MLOps. A AWS assume a liderança em termos de popularidade e participação de mercado. Ele também oferece soluções fáceis para treinamento, atendimento e monitoramento de modelos.

O MLOps é fácil de aprender?

Isso depende de sua experiência anterior. Para dominar o MLOps, você precisa aprender tanto o aprendizado de máquina quanto os ciclos de vida de desenvolvimento de software. Além de uma forte proficiência em linguagens de programação, você precisa aprender várias ferramentas de MLOps. É fácil para os engenheiros de DevOps aprenderem MLOps, pois a maioria das ferramentas e estratégias é orientada pelo desenvolvimento de software.

O Kubeflow é melhor que o MLflow?

Depende do caso de uso. O Kubeflow oferece reprodutibilidade em um nível maior do que o MLflow, pois gerencia a orquestração.

- Kubeflow é geralmente usado para implantar e gerenciar sistemas complexos de ML em escala.

- MLFlow é geralmente usado para rastrear experimentos de ML e armazenar e gerenciar metadados de modelos.

Como o MLOps é diferente do DevOps?

Ambas são estratégias de desenvolvimento de software. O DevOps se concentra no desenvolvimento e no gerenciamento de sistemas de software em grande escala, enquanto o MLOps se concentra na implantação e na manutenção de modelos de aprendizado de máquina na produção.

- DevOps: Integração Contínua (CI) e Entrega Contínua (CD).

- MLOps: Integração contínua, entrega contínua, treinamento contínuo e monitoramento contínuo.

Como as ferramentas de MLOps se integram aos fluxos de trabalho de ciência de dados existentes?

As ferramentas MLOps são projetadas para se integrarem perfeitamente aos fluxos de trabalho de ciência de dados existentes. Em geral, eles oferecem suporte a várias ferramentas e plataformas de ciência de dados, fornecem APIs para integração e oferecem plug-ins ou extensões para ambientes populares de ciência de dados. Essa integração permite que os cientistas de dados mantenham seus fluxos de trabalho atuais e, ao mesmo tempo, aproveitem os benefícios do MLOps para melhorar a escalabilidade, a reprodutibilidade e a eficiência da implementação.

As ferramentas MLOps podem ajudar na explicação e na justiça do modelo?

Sim, muitas ferramentas de MLOps incluem recursos para melhorar a explicabilidade e a imparcialidade do modelo. Eles oferecem funcionalidades como interpretação de modelos, detecção de viés e métricas de imparcialidade, que ajudam a entender e melhorar a forma como os modelos tomam decisões. Isso é fundamental para implantar uma IA responsável e manter a conformidade com os padrões regulatórios.

Posso obter uma certificação MLOps?

As certificações específicas de MLOps ainda estão surgindo, mas há várias certificações focadas em aprendizado de máquina e ciência de dados que abrangem as habilidades de MLOps. Leia nosso guia de certificações de MLOps para obter um detalhamento.

Sou um cientista de dados certificado que gosta de criar aplicativos de aprendizado de máquina e escrever blogs sobre ciência de dados. No momento, estou me concentrando na criação e edição de conteúdo e no trabalho com modelos de linguagem de grande porte.