Lernpfad

Wir haben alle schon von CPUs (Central Processing Units) und GPUs (Graphics Processing Units) gehört, aber kennst du auch die Unterschiede in der Art und Weise, wie sie die Verarbeitung durchführen? Obwohl beide für die moderne Computertechnik unverzichtbar sind, dienen sie unterschiedlichen Zwecken.

In diesem Leitfaden werde ich die Unterschiede, Anwendungsfälle und die sich verändernden Rollen von CPUs und GPUs aufschlüsseln.

Was ist eine CPU?

Die CPU, die oft als das "Gehirn" des Computers bezeichnet wird, ist die zentrale Einheit, die allgemeine Rechenaufgaben ausführt. Sie ist für die Verwaltung komplexer, sequenzieller Anweisungen optimiert und umfasst fast alle Aspekte des Computers, von der Handhabung von Anwendungen bis hin zur Ausführung des Betriebssystems. Zu den Anwendungen gehören alles von deinem Browser bis hin zu Chatprogrammen und E-Mails.

CPUs sind wirklich gut bei Aufgaben, die Präzision und Zuverlässigkeit erfordern, wie z.B. das Ausführen von arithmetischen Operationen, logikbasierte Entscheidungen und die Steuerung des Datenflusses.

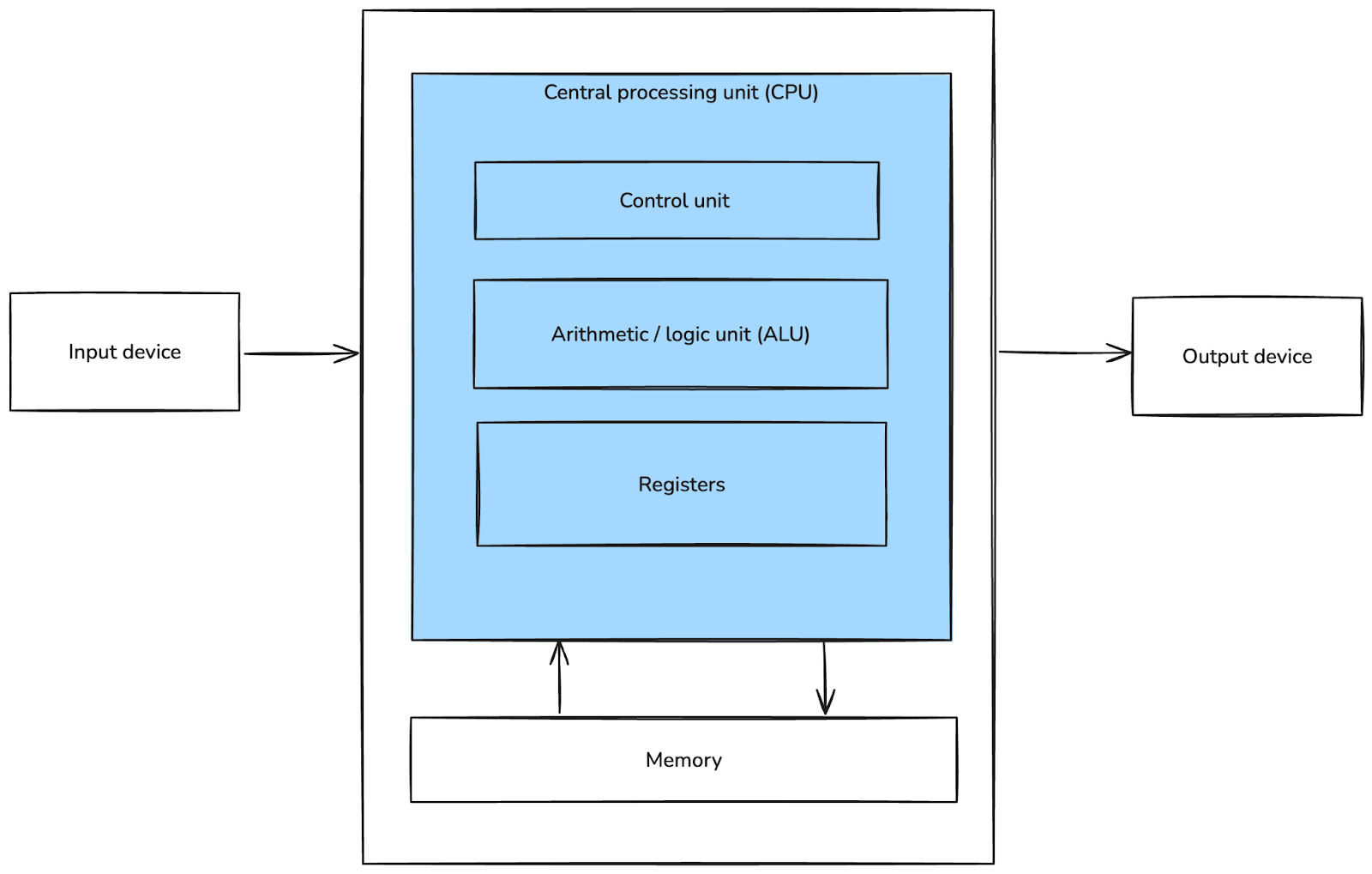

Grundlegende Von-Neumann-Architektur. Bild vom Autor.

Moderne CPUs verfügen oft über mehrere Kerne, so dass sie mehrere Aufgaben gleichzeitig ausführen können (wenn auch in geringerem Umfang als bei GPUs). Sie enthalten auch fortschrittliche Technologien wie Hyper-Threading und Cache-Hierarchien, um die Effizienz zu verbessern und die Latenzzeit bei der Aufgabenausführung zu verringern.

Wie eine CPU funktioniert

CPUs verarbeiten Aufgaben sequentiell, indem sie einem Befehlszyklus folgen, der das Holen, Dekodieren, Ausführen und Speichern von Daten umfasst. Dieser schrittweise Ansatz ermöglicht eine hohe Präzision und Zuverlässigkeit, wodurch sich CPUs ideal für Single-Thread-Aufgaben wie Datenbankabfragen, Codekompilierung und komplexe Simulationen eignen.

Moderne CPUs können zwar bis zu einem gewissen Grad multitaskingfähig sein, aber ihre Stärke liegt eigentlich in ihrer Fähigkeit, komplexe Berechnungen durchzuführen, bei denen es auf Genauigkeit und Ordnung ankommt.

CPUs verfügen außerdem über robuste Fehlerbehandlungsmechanismen, um Berechnungen ohne Datenbeschädigung oder logische Fehler durchzuführen.

Eigenschaften von CPUs

CPUs zeichnen sich durch wenige Kerne mit hohen Taktraten aus. Jeder Kern konzentriert sich auf einen oder einige wenige Threads gleichzeitig, was sie sehr effizient für Aufgaben macht, die viel Rechenleistung, aber wenig Parallelität erfordern.

Zu den wichtigsten Eigenschaften von CPUs gehören:

- Taktgeschwindigkeit: Gemessen in GHz, bestimmt dies, wie viele Zyklen ein Kern pro Sekunde ausführen kann, was sich direkt auf die Leistung bei Single-Thread-Aufgaben auswirkt.

- Cache-Speicher: CPUs haben integrierte Caches (L1, L2 und L3), in denen häufig genutzte Daten gespeichert werden, um die Zeit zu verkürzen, die für das Abrufen von Daten aus dem RAM benötigt wird.

- Befehlssätze: CPUs verwenden komplexe Befehlssätze (wie x86), um eine Vielzahl von Aufgaben zu bewältigen, von mathematischen Berechnungen bis zur Multimediaverarbeitung.

Trotz ihrer Präzision und Vielseitigkeit sind CPUs nur begrenzt in der Lage, massiv parallele Arbeitslasten effizient zu bewältigen, z. B. das Training großer Machine-Learning-Modelle oder das Rendern hochauflösender Grafiken. Für solche Aufgaben übernehmen oft spezialisierte Prozessoren wie GPUs die Führung. Warum das so ist, wollen wir im nächsten Abschnitt untersuchen.

Was ist ein Grafikprozessor?

Ein Grafikprozessor (GPU) ist ein spezieller Prozessor, der für Aufgaben optimiert ist, die eine parallele Verarbeitung oder die gleichzeitige Verarbeitung mehrerer Informationsbins beinhalten.

GPUs wurden ursprünglich für das Rendering von Bildern für Videospiele und visuelle Anwendungen entwickelt, haben sich aber zu leistungsstarken Werkzeugen entwickelt, die in verschiedenen Bereichen eingesetzt werden, z. B. in der Datenwissenschaft, beim maschinellen Lernen, beim Mining von Kryptowährungen und bei wissenschaftlichen Simulationen. Ihre Fähigkeit, riesige Datenmengen parallel zu verarbeiten, hat sie zu einem entscheidenden Faktor für Hochleistungsrechner und die Entwicklung von KI gemacht.

Wie ein Grafikprozessor funktioniert

GPUs haben Tausende kleinerer Kerne, die einfache Aufgaben unabhängig voneinander ausführen können, was sie ideal für parallele Workloads macht.

Im Gegensatz zu CPUs, die sich auf Präzision und Ordnung konzentrieren, teilen GPUs große Probleme in kleinere Aufgaben auf, verarbeiten sie parallel und fassen die Ergebnisse zusammen. Diese Architektur ermöglicht es GPUs, sich bei Operationen auszuzeichnen, bei denen dieselben Anweisungen wiederholt auf große Datensätze angewendet werden.

Beim Rendern eines Bildes weist ein Grafikprozessor zum Beispiel jedem Pixel einen eigenen Kern für die gleichzeitige Verarbeitung zu, was den Vorgang erheblich beschleunigt. Beim maschinellen Lernen ermöglicht diese Parallelität ein schnelleres Training, indem Datenstapel verarbeitet und Berechnungen wie Matrixmultiplikationen auf vielen Kernen gleichzeitig durchgeführt werden.

Moderne Grafikprozessoren verfügen auch über Funktionen wie Tensor Cores (in NVIDIA-GPUs) oder andere spezialisierte Einheiten zur Beschleunigung von KI-Aufgaben, was sie für Aufgaben wie das Training neuronaler Netzwerke noch effizienter macht.

Merkmale von GPUs

Zusammengefasst sind dies die Merkmale, die GPUs auszeichnen:

- Kernzahl: Ein Grafikprozessor (GPU) kann Tausende von Kernen haben, sodass er umfangreiche parallele Arbeitslasten bewältigen kann. Während diese Kerne einzeln weniger leistungsfähig sind als die CPU-Kerne, ist ihre kombinierte Leistung immens.

- Taktgeschwindigkeit: GPUs haben im Vergleich zu CPUs niedrigere Taktraten. Dieser Kompromiss ermöglicht es, mehr Kerne auf einem Chip unterzubringen und den Durchsatz gegenüber der Single-Thread-Leistung zu erhöhen.

- Speicherbandbreite: GPUs sind mit einem Speicher mit hoher Bandbreite (wie GDDR6 oder HBM) ausgestattet, um die datenintensiven Anforderungen der Parallelverarbeitung zu bewältigen.

- Skalierbarkeit: Moderne Grafikprozessoren unterstützen Multi-GPU-Setups, bei denen Aufgaben auf mehrere GPUs verteilt werden, um die Leistung zu steigern.

Python von Grund auf lernen

Unterschiede zwischen CPUs und GPUs

Gehen wir nun auf die spezifischen Unterschiede zwischen CPUs und GPUs ein. Eine der wichtigsten Fragen, die wir besprochen haben, war die nach dem Verhältnis von seriellen und parallelen Berechnungen, aber es gibt noch weitere wichtige Fragen.

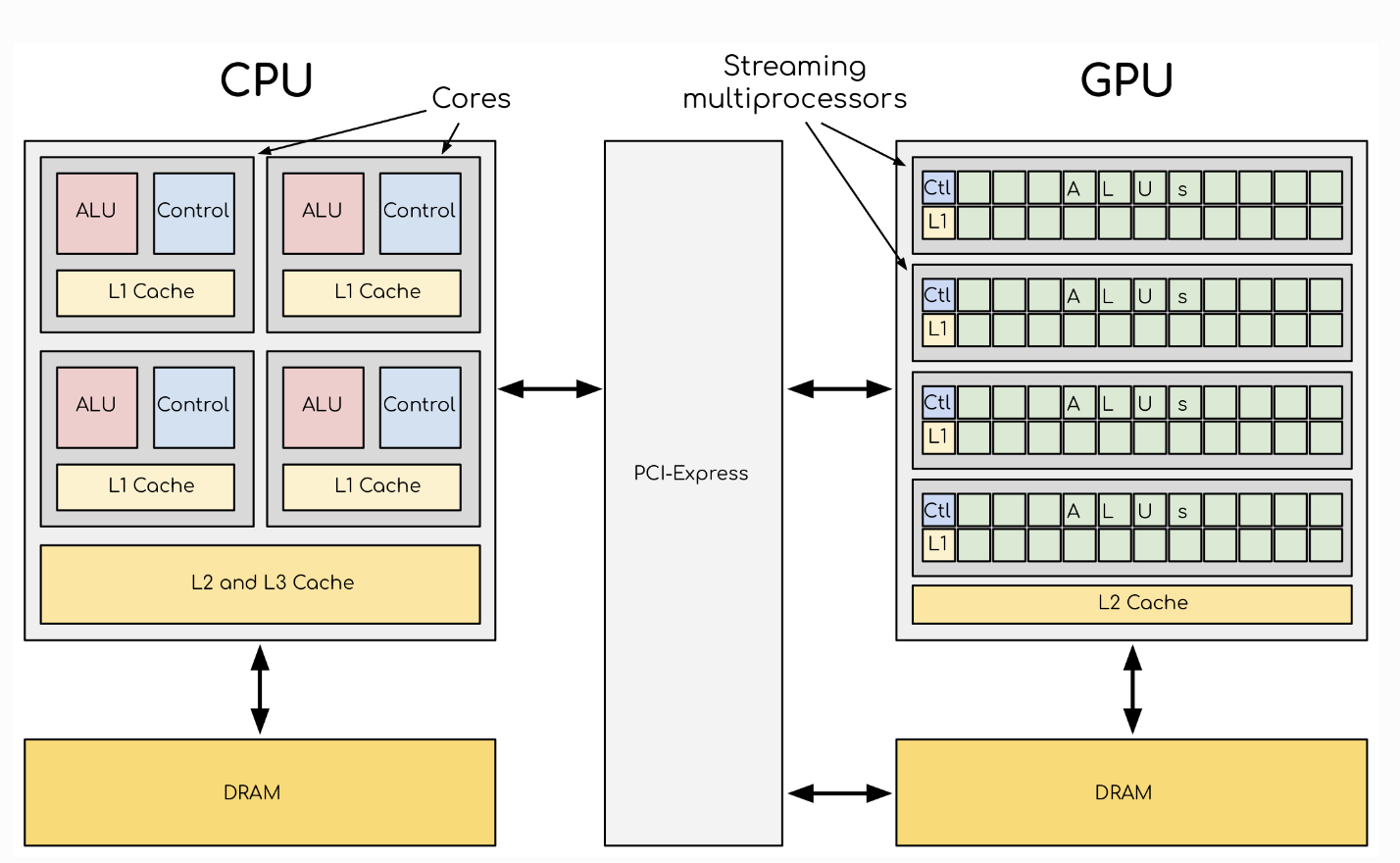

Architektur und Design

CPUs werden mit weniger, leistungsfähigeren Kernen gebaut, die für Single-Thread- und sequenzielle Verarbeitung optimiert sind. Diese Kerne verfügen über fortschrittliche Steuereinheiten, größere Caches (L1, L2 und manchmal L3) und Unterstützung für anspruchsvolle Befehlssätze wie x86-64 oder ARM.

Im Gegensatz dazu verfügen GPUs über eine riesige Anzahl kleinerer Kerne, die für die Bearbeitung paralleler Aufgaben ausgelegt sind. Diese Kerne arbeiten nach dem SIMD-Modell (Single Instruction, Multiple Data), bei dem dieselbe Operation auf mehrere Datenpunkte gleichzeitig angewendet wird.

Ein Vergleich zwischen der GPU- und der CPU-Architektur. Bild Quelle.

Leistung und Effizienz

Wie du dir vorstellen kannst, wirken sich die Unterschiede in der Architektur direkt auf die Leistung aus.

Mit ihren hohen Taktraten und der fortschrittlichen Befehlsverarbeitung eignen sich CPUs hervorragend für Aufgaben mit geringer Latenz, die hohe Präzision und logische Operationen erfordern. Beispiele dafür sind die Verwaltung des Betriebssystems, Datenbankabfragen und die Ausführung von Anwendungs-Threads. CPUs sind außerdem vielseitiger und können dank ihrer Befehlsdekodierung und Verzweigungsvorhersage effizient zwischen verschiedenen Arbeitslasten wechseln.

Wie bereits erwähnt, sind GPUs besonders gut für Aufgaben geeignet, bei denen es auf Parallelität ankommt. Ihre Fähigkeit, mehrere Datenströme gleichzeitig zu verarbeiten, macht sie unverzichtbar für Operationen mit hohem Durchsatz, wie z. B. Videocodierung, wissenschaftliche Simulationen und das Training neuronaler Netze. Beim Deep Learning beschleunigen GPUs zum Beispiel Matrixmultiplikationen und Backpropagation und verkürzen so die Trainingszeiten im Vergleich zu CPUs drastisch.

Der Kompromiss liegt in der Art der Arbeitsbelastung: CPUs übertreffen GPUs bei sequenziellen Aufgaben, während GPUs bei datenintensiven, parallelen Aufgaben dominieren.

Stromverbrauch

GPUs verbrauchen in der Regel mehr Strom, weil sie eine hohe Anzahl von Kernen haben und eine intensive parallele Verarbeitung benötigen, während CPUs tendenziell einen geringeren Strombedarf haben.

Ein High-End-Grafikprozessor kann unter Last mehrere hundert Watt verbrauchen, insbesondere bei intensiven Operationen wie dem Training von Machine-Learning-Modellen oder dem Rendern von 4K-Grafiken. Darüber hinaus erhöhen die hohen Anforderungen an die Speicherbandbreite den Stromverbrauch weiter.

CPU-Funktionen wie dynamische Spannungs- und Frequenzskalierung (DVFS), stromsparende Zustände (C-States) und effiziente Kühlungsmechanismen ermöglichen es den CPUs, Leistung und Stromverbrauch effektiv in Einklang zu bringen. Dadurch eignen sich CPUs besser für Geräte, die eine längere Akkulaufzeit oder eine geringere Wärmeabgabe benötigen, wie z. B. Laptops und mobile Geräte.

Kosten und Verfügbarkeit

CPUs sind in Consumer-Geräten weit verbreitet und in der Regel günstiger. Ihr breiter Nutzen und ihre Marktsättigung machen sie für die Verbraucher relativ preiswert. Einsteiger-CPUs können unter 100 Dollar kosten, während Hochleistungsmodelle für Server oder Workstations in die Tausende gehen können.

GPUs, insbesondere Hochleistungsmodelle, sind teurer und werden häufig in Workstations, Spielesystemen und Hochleistungscomputern eingesetzt. Consumer-GPUs für Spiele können zwischen 200 und 1.000 Dollar kosten, während spezialisierte GPUs für Rechenzentren oder wissenschaftliche Forschung, wie die A100 von NVIDIA oder die Instinct-Serie von AMD, Zehntausende von Dollar kosten können.

In der folgenden Tabelle findest du einen detaillierten Vergleich zwischen CPUs und GPUs, der es dir erleichtert, die Unterschiede auf einen Blick zu erkennen:

|

CPU (Central Processing Unit) |

GPU (Graphics Processing Unit) |

|

|

Primäre Funktion |

Universelle Verarbeitung für sequenzielle Aufgaben |

Spezialisiert auf Parallelverarbeitung und datenintensive Aufgaben |

|

Architektur |

Weniger, leistungsstarke Kerne, optimiert für Single-Thread-Leistung |

Tausende von kleineren, einfacheren Kernen, die für Parallelität optimiert sind |

|

Verarbeitungsmodell |

Serielle Ausführung: Aufgaben werden nacheinander abgearbeitet |

Parallele Ausführung: mehrere Aufgaben werden gleichzeitig bearbeitet |

|

Kernzahl |

Typischerweise 4-64 Kerne in Consumer-CPUs |

Hochleistungs-GPUs können Tausende von Kernen haben |

|

Taktgeschwindigkeit |

Höhere Taktraten (bis zu ~5 GHz) |

Niedrigere Taktraten (~1-2 GHz) |

|

Stärken |

Präzision, sequenzielle Aufgaben, Vielseitigkeit und logische Operationen |

Hoher Durchsatz für große Operationen wie Matrixmathematik |

|

Anwendungsfälle |

Betrieb von Betriebssystemen, Anwendungslogik, Datenbanken |

Grafikrendering, maschinelles Lernen, wissenschaftliches Rechnen |

|

Stromverbrauch |

Niedriger durch weniger Kerne und energieeffiziente Designs |

Höher aufgrund der dichten Kerne und der Anforderungen an die Speicherbandbreite |

|

Speicherbandbreite |

Niedriger, typischerweise für Latenz optimiert |

Höher, für den Durchsatz optimiert (z. B. GDDR6, HBM-Speicher) |

|

Kosten |

Relativ erschwinglich und weithin verfügbar |

Teurer, besonders bei Hochleistungsmodellen |

|

Anwendungen |

Laptops, Desktops, Server, mobile Geräte |

Spielsysteme, Workstations, HPC-Umgebungen, KI-Workloads |

|

Flexibilität |

Breite Kompatibilität für vielfältige Aufgaben |

Optimiert für bestimmte Arbeitslasten, die Parallelität erfordern |

CPU Anwendungsfälle

Gehen wir kurz auf einige spezifischere Anwendungsfälle für CPUs ein:

- Allzweck-Computer: CPUs eignen sich perfekt für alltägliche Aufgaben, wie das Surfen im Internet, die Nutzung von Produktivitätsanwendungen und die Verwendung deines Computers für den täglichen Gebrauch. Der Großteil der Arbeitslast deines Computers entfällt auf die CPU.

- Single-Thread-Anwendungen: Aufgaben, die eine Single-Thread-Verarbeitung erfordern, wie z. B. spezielle Finanzberechnungen, sind besser für CPUs geeignet. Andere Single-Thread-Anwendungen sind Textverarbeitungsprogramme, Browser und Musikanwendungen.

- Verwaltung des Betriebssystems: CPUs wickeln wichtige Systemprozesse ab und verwalten Eingaben, Ausgaben und Hintergrundaufgaben, damit das System reibungslos funktioniert.

GPU Anwendungsfälle

Gehen wir kurz auf einige GPU-spezifische Anwendungsfälle ein:

- Grafik- und Videoverarbeitung: Grafikprozessoren (GPUs) wurden entwickelt, um qualitativ hochwertige Grafiken zu erstellen, was sie für Spiele, Videobearbeitung und grafikintensive Anwendungen unverzichtbar macht. Das ist möglich, weil sie parallel arbeiten können, wie ich in diesem Artikel bereits erwähnt habe. Viele grafikintensive Spiele erfordern einen ziemlich starken Grafikprozessor, um ohne Verzögerungen oder Probleme zu spielen.

- Maschinelles Lernen und KI: Grafikprozessoren werden häufig zum Trainieren von Machine-Learning-Modellen und zur schnellen Verarbeitung großer Datensätze eingesetzt, um die hohen Anforderungen von KI-Algorithmen zu erfüllen. Aufgrund des Umfangs der Berechnungen sind sie vor allem für Projekte notwendig, die neuronale Netze verwenden. Da viele Berechnungen parallel durchgeführt werden können, sind GPUs ein wichtigerBestandteil des komplexen maschinellen Lernens.

- Datenwissenschaft und wissenschaftliches Rechnen: GPUs können große Berechnungen und Matrixoperationen in der Datenwissenschaft beschleunigen, was sie für datenintensive Analysen und Simulationen wertvoll macht. Die Berechnung von Dingen wie Tensoren, Bildanalyse und Faltungsschichten erfordert enorme Rechenleistung. Polars bietet zum Beispiel eine GPU-Engine zur Beschleunigung von Abfragen.

Die Zukunft von CPUs und GPUs

Sowohl CPUs als auch GPUs werden immer leistungsfähiger und komplexer! Ihre Zukunft zeigt einen Anstieg der Rechenleistung und eine weit verbreitete Nutzung.

CPUs, die sich an mehr Kerne anpassen

Die CPUs haben immer mehr Kerne, um den modernen Multitasking-Anforderungen gerecht zu werden. Das verbessert ihre Fähigkeit zum seriellen Rechnen und bietet durch Multithreading auch einige Möglichkeiten zum parallelen Rechnen.

Einige Trends in der CPU-Entwicklung sind:

- Erhöhte Kernzahlen: Consumer-CPUs haben heute oft 8-16 Kerne, während Server-Prozessoren 64 oder mehr Kerne haben können. Dies ermöglicht verbesserte parallele Rechenfähigkeiten durch Technologien wie simultanes Multithreading (SMT) und Hyperthreading.

- Heterogene Architekturen: Moderne CPUs wie Intels Alder Lake-Serie oder ARMs big.LITTLE-Design kombinieren leistungsstarke Kerne mit energieeffizienten Kernen, um sowohl den Stromverbrauch als auch die Aufgabenleistung zu optimieren.

- Integration mit spezialisierten Einheiten: CPUs integrieren zunehmend Beschleuniger, wie z. B. KI-Inferenzmaschinen oder Grafikprozessoren, direkt auf dem Chip, um die Leistung bei bestimmten Arbeitslasten zu erhöhen.

GPU-Entwicklung für Allzweck-Computing

GPUs entwickeln sich weiter, um Allzweckaufgaben zu bewältigen, was sie für datenintensive Operationen immer vielseitiger macht. Hersteller wie NVIDIA und AMD investieren in hardwareunabhängige Software-Ökosysteme (z. B. CUDA, ROCm), um die Einsatzmöglichkeiten von Grafikprozessoren über die Grafik hinaus zu erweitern.

Viele Pakete für maschinelles Lernen sind jetzt in der Lage, GPUs zu nutzen. Frameworks wie TensorFlow und PyTorchunterstützen jetzt nativdie GPU-Beschleunigung, was die Berechnungszeiten drastisch reduziert.

Spezialisierte Verarbeitungseinheiten

Die Zukunft der Datenverarbeitung ist nicht nur auf CPUs und GPUs beschränkt. Der Aufstieg spezialisierter Prozessoren wie TPUs (Tensor Processing Units) und NPUs (Neural Processing Units) spiegelt die wachsende Nachfrage nach aufgabenspezifischer Hardware wider:

- Tensor Processing Units (TPUs): Die von Google entwickelten TPUs sind speziell für die Beschleunigung von Berechnungen in neuronalen Netzwerken konzipiert. Anders als GPUs konzentrieren sich TPUs auf matrixlastige Operationen und sind für große KI-Aufgaben optimiert. Wenn du weitere Fragen hast, lies den Artikel über TPUs vs. GPUs.

- Neural Processing Units (NPUs): NPUs werden in mobilen Geräten und Edge Computing eingesetzt, um KI-bezogene Aufgaben wie Bilderkennung, Sprachverarbeitung und natürliches Sprachverständnis zu bewältigen und dabei nur wenig Strom zu verbrauchen.

- Fortschritte bei FPGAs und ASICs: Field-Programmable Gate Arrays (FPGAs) und anwendungsspezifische integrierte Schaltkreise (ASICs) gewinnen ebenfalls an Bedeutung, da sie für bestimmte Anwendungen wie Kryptowährungs-Mining, Netzwerk-Paketverarbeitung und Echtzeit-Analysen angepasst werden können.

Fazit

CPUs und GPUs bringen jeweils einzigartige Stärken für das Rechnen mit: CPUs zeichnen sich durch allgemeine und präzise Aufgaben aus, während GPUs bei der parallelen Verarbeitung und bei datenintensiven Arbeitslasten glänzen. Das Verständnis dieser Unterschiede hilft Datenwissenschaftlern, Spielern und Fachleuten dabei, eine fundierte Hardware-Auswahl zu treffen.

Wenn du wissen willst, wie GPUs Deep Learning-Modelle antreiben, schau dir Introduction to Deep Learning with PyTorch an. Für ein breiteres Verständnis der KI-Technologien und ihrer Anwendungen bietet der Lernpfad KI-Grundlagen einen umfassenden Überblick. Wenn du tiefer in die Mechanismen des maschinellen Lernens eintauchen möchtest, solltest du den Kurs Maschinelles Lernen verstehen lernen.

Werde ein ML-Wissenschaftler

FAQs

Kann ein Grafikprozessor eine CPU für alltägliche Rechenaufgaben ersetzen?

Nein, GPUs sind kein Ersatz für CPUs. Während GPUs bei Parallelverarbeitungsaufgaben hervorragend abschneiden, fehlt ihnen die Vielseitigkeit und die Single-Thread-Leistung, die CPUs für Allzweckaufgaben bieten.

Wann sollte ich eine CPU und eine GPU zusammen verwenden?

Ein hybrider Ansatz kann optimale Leistung bieten, indem er die Stärken beider Prozessortypen für Aufgaben wie Videobearbeitung und neuronale Netze nutzt.

Warum werden beim maschinellen Lernen und bei der KI GPUs anstelle von CPUs eingesetzt?

Bei Aufgaben des maschinellen Lernens und der KI werden oft große Datensätze verarbeitet und zahlreiche Berechnungen gleichzeitig durchgeführt. GPUs mit ihrer hohen Kernzahl und ihren parallelen Verarbeitungsmöglichkeiten können diese Aufgaben viel schneller erledigen als CPUs.

Gibt es neben CPUs und GPUs auch spezielle Prozessoren für bestimmte Aufgaben?

Ja, spezialisierte Prozessoren wie TPUs (Tensor Processing Units) sind für bestimmte Arbeitslasten wie maschinelles Lernen konzipiert. TPUs kombinieren Elemente von CPU- und GPU-Architekturen, um die Leistung für bestimmte Arten der Datenverarbeitung zu optimieren.

Ich bin Datenwissenschaftler mit Erfahrung in räumlicher Analyse, maschinellem Lernen und Datenpipelines. Ich habe mit GCP, Hadoop, Hive, Snowflake, Airflow und anderen Data Science/Engineering-Prozessen gearbeitet.