Kurs

Der massive Einsatz von Tools wie ChatGPT und anderen generativen KI-Tools hat zu einer großen Debatte über die Vorteile und Herausforderungen von KI geführt und darüber, wie sie unsere Gesellschaft umgestalten wird. Um diese Fragen besser beurteilen zu können, ist es wichtig zu wissen, wie die sogenannten Large Language Models (LLMs) hinter den KI-Tools der nächsten Generation funktionieren.

Dieser Artikel gibt eine Einführung in das Reinforcement Learning from Human Feedback (RLHF), eine innovative Technik, die Reinforcement-Learning-Techniken und menschliche Anleitung kombiniert, um LLMS wie ChatGPT zu beeindruckenden Ergebnissen zu verhelfen. Wir werden uns damit beschäftigen, was RLHF ist, welche Vorteile und Grenzen es hat und welche Bedeutung es für die zukünftige Entwicklung des sich schnell entwickelnden Bereichs der generativen KI hat. Lies weiter!

RLHF verstehen

Um die Rolle der RLHF zu verstehen, müssen wir zunächst über den Ausbildungsprozess von LLMs sprechen.

Die Technik, die den beliebtesten LLMs zugrunde liegt, ist ein Transformator. Seit ihrer Entwicklung durch Google-Forscher/innen sind Transformatoren zum modernsten Modell im Bereich der KI und des Deep Learning geworden, da sie eine effektivere Methode zur Verarbeitung von sequentiellen Daten, wie z. B. den Wörtern eines Satzes, bieten.

Eine detailliertere Einführung in LLMs und Transformatoren findest du in unserem Large Language Models (LLMs) Concepts Course.

Die Transformatoren werden mit einem riesigen Textkorpus aus dem Internet durch selbstüberwachtes Lernen trainiert, eine innovative Art des Trainings, bei der die Daten nicht von Menschenhand beschriftet werden müssen. Vortrainierte Transformatoren sind in der Lage, eine breite Palette von Problemen der natürlichen Sprachverarbeitung (NLP) zu lösen.

Damit ein KI-Tool wie ChatGPT ansprechende, genaue und menschenähnliche Antworten geben kann, reicht es jedoch nicht aus, eine vortrainierte LLM zu verwenden. Letztlich ist die menschliche Kommunikation ein kreativer und subjektiver Prozess. Was einen Text "gut" macht, wird stark von menschlichen Werten und Vorlieben beeinflusst und ist daher sehr schwer zu messen oder mit einer klaren, algorithmischen Lösung zu erfassen.

Die Idee hinter ELF ist, menschliches Feedback zu nutzen, um die Leistung des Modells zu messen und zu verbessern. Was RLHF im Vergleich zu anderen Verstärkungslerntechniken einzigartig macht, ist die Nutzung der menschlichen Beteiligung zur Optimierung des Modells anstelle einer statistisch vordefinierten Funktion zur Maximierung der Belohnung des Agenten.

Diese Strategie ermöglicht eine anpassungsfähigere und individuellere Lernerfahrung, so dass LLMs für alle Arten von branchenspezifischen Anwendungen geeignet sind, wie z.B. Code-Assistenz, juristische Recherche, das Schreiben von Aufsätzen und das Verfassen von Gedichten.

Wie funktioniert der RLHF?

RLHF ist ein anspruchsvoller Prozess, der ein Training mit mehreren Modellen und verschiedene Einsatzphasen umfasst. Im Wesentlichen kann sie in drei verschiedene Schritte unterteilt werden.

1. Wähle ein vortrainiertes Modell

In der ersten Phase wird eine vortrainierte LLM ausgewählt, die später mit RLHF feinabgestimmt wird.

Du könntest deinen LLM auch von Grund auf vorbereiten, aber das ist ein kostspieliger und zeitaufwändiger Prozess. Daher empfehlen wir dringend, einen der vielen vorbereiteten LLMs zu wählen, die für die Öffentlichkeit zugänglich sind.

Wenn du mehr darüber erfahren möchtest, wie man LLM trainiert, findest du in unserem Tutorial Wie man ein LLM mit PyTorch trainiert ein anschauliches Beispiel.

Beachte, dass du dein Modell auf zusätzliche Texte oder Bedingungen abstimmen kannst, bevor du mit der Feinabstimmung durch menschliches Feedback beginnst, um den spezifischen Anforderungen deines Modells gerecht zu werden.

Wenn du zum Beispiel einen KI-Rechtsassistenten entwickeln willst, könntest du dein Modell mit einem Korpus juristischer Texte verfeinern, damit dein LLM besonders vertraut mit juristischen Formulierungen und Begriffen wird.

2. Menschliches Feedback

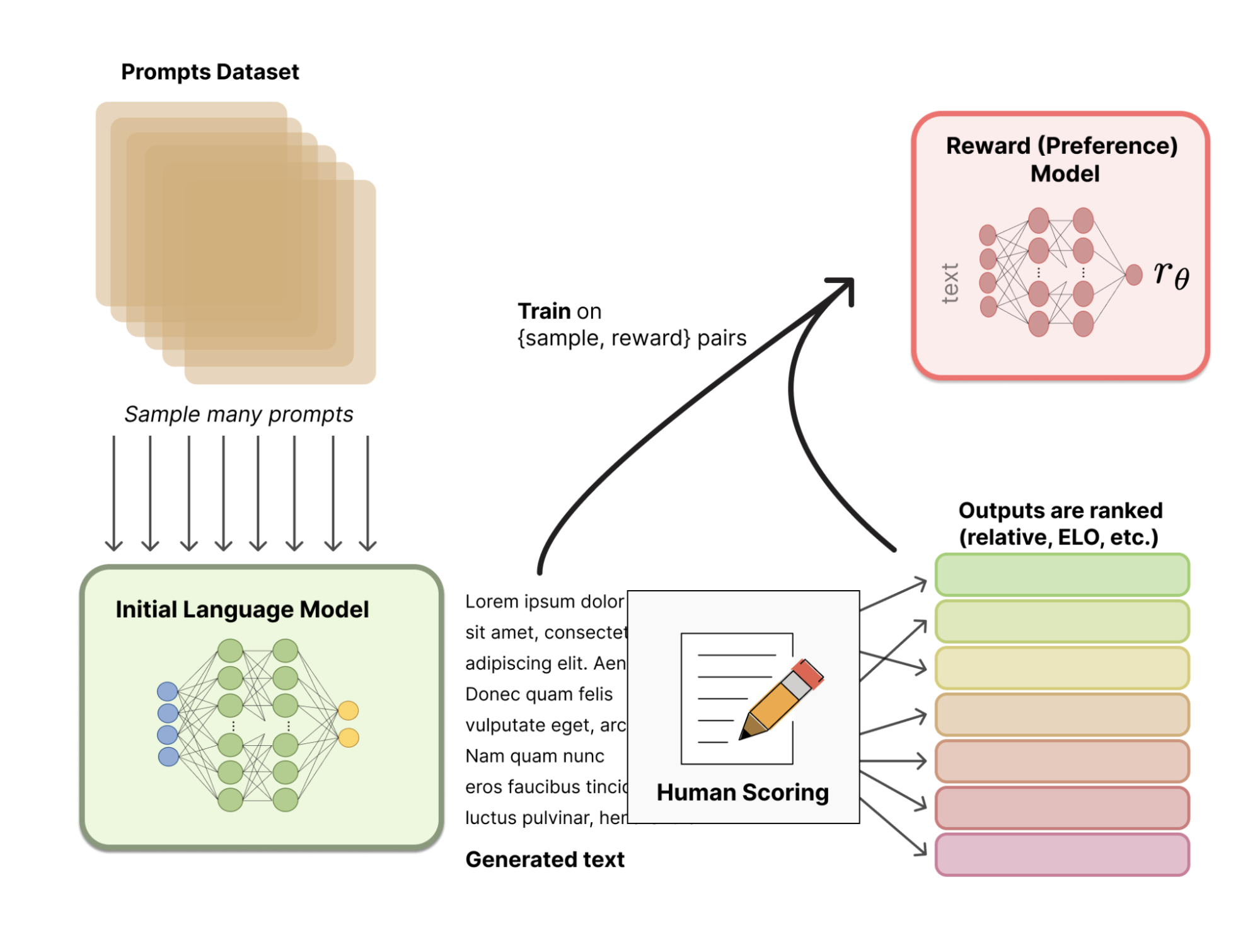

Anstatt ein statistisch vordefiniertes Belohnungsmodell zu verwenden (das für die Kalibrierung der menschlichen Präferenzen sehr restriktiv wäre), nutzt RLHF das menschliche Feedback, um dem Modell zu helfen, ein subtileres Belohnungsmodell zu entwickeln. Das Verfahren läuft folgendermaßen ab:

- Zunächst wird ein Trainingssatz von Eingabe-Prompts/Generierte-Texte-Paaren durch das vortrainierte Modell erstellt, indem eine Reihe von Prompts gesampelt wird.

- Als Nächstes geben menschliche Tester/innen den generierten Texten einen Rang, wobei sie bestimmte Richtlinien anwenden, um das Modell an die menschlichen Werte und Vorlieben anzupassen und es sicher zu machen. Diese Ränge können dann mit verschiedenen Techniken, wie z. B. Elo-Rating-Systemen, in Punkte umgewandelt werden.

- Schließlich wird das gesammelte menschliche Feedback vom System genutzt, um seine Leistung zu bewerten und ein Belohnungsmodell zu entwickeln.

Das folgende Bild veranschaulicht den gesamten Prozess:

Quelle: Hugging Face

3. Feinabstimmung mit Verstärkungslernen

In der letzten Phase produziert der LLM neue Texte und verwendet sein auf menschlichem Feedback basierendes Belohnungsmodell, um eine Qualitätsbewertung zu erstellen. Die Punktzahl wird dann vom Modell verwendet, um seine Leistung bei nachfolgenden Aufforderungen zu verbessern.

Menschliches Feedback und Feinabstimmung mit Reinforcement-Learning-Techniken werden so in einem iterativen Prozess kombiniert, der fortgesetzt wird, bis ein bestimmter Grad an Genauigkeit erreicht ist.

Anwendungen von Reinforcement Learning aus menschlichem Feedback

RLHF ist eine moderne Technik zur Feinabstimmung von LLMs wie ChatGPT. RLHF ist jedoch ein beliebtes Thema, und es gibt immer mehr Literatur, die sich mit anderen Möglichkeiten als NLP-Problemen beschäftigt. Unten findest du eine Liste mit anderen Bereichen, in denen RLHF erfolgreich eingesetzt wurde:

- Chatbots. ChatGPT ist das prominenteste Beispiel für die Möglichkeiten von RLHF. Um mehr darüber zu erfahren, wie ChatGPT RLHF verwendet, schau dir diesen Artikel an : "Was ist ChatGPT?" , in dem wir ChatGPT direkt gefragt haben, wie es funktioniert.

- Robotik. Die Robotik ist einer der Hauptbereiche, in denen das RLHF vielversprechende Ergebnisse liefert. Die Verwendung von menschlichem Feedback kann einem Roboter helfen, Aufgaben und Bewegungen auszuführen, die in einer Belohnungsfunktion schwer zu spezifizieren sind. OpenAI-Forscher haben es geschafft, einem Roboter mit Hilfe von RLHF den Rückwärtssalto beizubringen - eine ziemlich schwierige Aufgabe, die es zu modellieren gilt.

- Spielen. Techniken des Verstärkungslernens wurden zur Entwicklung von Videospiel-Bots eingesetzt. RLHF kann jedoch dazu verwendet werden, Bots auf der Grundlage menschlicher Vorlieben zu trainieren und sie zu menschenähnlichen Spielern zu machen, anstatt zu einfachen belohnungsmaximierenden Maschinen. OpenAI und DeepMind haben zum Beispiel Bots darauf trainiert, Atari-Spiele mit RLHF zu spielen.

Die Vorteile von RLHF

RLHF ist eine leistungsstarke und vielversprechende Technik, ohne die die nächste Generation von KI-Tools nicht möglich wäre. Hier sind einige der Vorteile von RLHF:

- Erhöhte Leistung. Menschliches Feedback ist der Schlüssel dafür, dass LLMs wie ChatGPT wie Menschen "denken" und klingen. HLHF ermöglicht es Maschinen, komplexe Aufgaben, wie z.B. NLP-Probleme, zu lösen, die menschliche Werte oder Präferenzen beinhalten.

- Anpassungsfähigkeit. Da LLMs mit Hilfe von menschlichem Feedback in allen Arten von Aufforderungen feinabgestimmt werden, ermöglicht RLHF es Maschinen, eine Reihe von verschiedenen Aufgaben auszuführen und sich an erwartete Situationen anzupassen. Damit bringen uns LLMs näher an die Schwelle zur Allzweck-KI.

- Kontinuierliche Verbesserung. RLHF ist ein iterativer Prozess, d.h. das System wird kontinuierlich verbessert, indem seine Lernfunktion durch neues menschliches Feedback aktualisiert wird.

- Erhöhte Sicherheit. Durch menschliches Feedback lernt das System nicht nur, wie es etwas tun soll, sondern auch, was es nicht tun soll. Das sorgt für effektive, sichere und vertrauenswürdige Systeme.

Grenzen des RLHF

RLHF ist jedoch nicht kugelsicher. Diese Technik birgt auch gewisse Risiken und Einschränkungen. Unten siehst du einige der wichtigsten:

- Begrenztes und kostspieliges menschliches Feedback. RLHF ist auf die Qualität und Verfügbarkeit von menschlichem Feedback angewiesen. Die Arbeit zu erledigen kann jedoch langsam, arbeitsintensiv und kostspielig sein, vor allem, wenn die anstehende Arbeit viele Rückmeldungen erfordert.

- Verzerrungen im menschlichen Feedback. Trotz der Verwendung von standardisierten Richtlinien für das Feedback wird die Bewertung oder das Ranking letztendlich von menschlichen Vorlieben und Werten beeinflusst. Wenn die Bewertungsaufgaben nicht gut formuliert sind oder die Qualität des menschlichen Feedbacks schlecht ist, kann das Modell verzerrt werden oder unerwünschte Ergebnisse verstärken.

- Verallgemeinerung auf neue Kontexte. Selbst wenn LLMs mit viel menschlichem Feedback fein abgestimmt sind, können immer unerwartete Zusammenhänge auftreten. In diesem Fall besteht die Herausforderung darin, den Agenten robust für Situationen mit begrenztem Feedback zu machen.

- Halluzinationen. Wenn das menschliche Feedback begrenzt oder schlecht ist, können Agenten sogenannte Halluzinationen erleben, also unerwünschtes, falsches oder unsinniges Verhalten.

Zukünftige Trends und Entwicklungen in RLHF

RLHF ist eines der Rückgrate moderner generativer KI-Tools wie ChatGPT und GPT-4. Trotz der beeindruckenden Ergebnisse ist RLHF eine relativ neue Technik, und es gibt noch viel Spielraum für Verbesserungen. Zukünftige Forschung zu RLHF-Techniken ist entscheidend, um LLMs effizienter zu machen, ihren ökologischen Fußabdruck zu verringern und einige der Risiken und Einschränkungen von LLMs zu beseitigen.

Um über die neuesten Entwicklungen in den Bereichen generative KI, maschinelles Lernen und LLMs auf dem Laufenden zu bleiben, empfehlen wir dir unsere kuratierten Lernmaterialien:

- Einführung in das Reinforcement Learning - In diesem Tutorium werden die grundlegenden Konzepte und Begriffe des Reinforcement Learning behandelt.

- Deep Learning in Python - Dieser Lernpfad hilft den Lernenden, ihr Wissen über Deep Learning zu erweitern und ihre Fähigkeiten im maschinellen Lernen auf die nächste Stufe zu bringen.

- Deep Learning Tutorial - Dieses Tutorial gibt einen Überblick über Deep Learning und Reinforcement Learning.

- Ethischer Einsatz von maschinellem Lernen zur Entscheidungsfindung - In diesem Blogbeitrag geht es um die Bedeutung ethischer Überlegungen beim Einsatz von maschinellen Lernmodellen.

Ich bin freiberufliche Datenanalystin und arbeite mit Unternehmen und Organisationen auf der ganzen Welt an Data-Science-Projekten zusammen. Ich bin auch Ausbilder für Data Science mit mehr als 2 Jahren Erfahrung. Ich schreibe regelmäßig datenwissenschaftliche Artikel in englischer und spanischer Sprache, von denen einige auf etablierten Websites wie DataCamp, Towards Data Science und Analytics Vidhya veröffentlicht wurden. Als Datenwissenschaftlerin mit einem Hintergrund in Politik- und Rechtswissenschaften ist es mein Ziel, an der Schnittstelle von Politik, Recht und Technologie zu arbeiten und die Macht der Ideen zu nutzen, um innovative Lösungen und Erzählungen voranzutreiben, die uns dabei helfen können, dringende Herausforderungen wie die Klimakrise anzugehen. Ich betrachte mich als Autodidakt, der ständig lernt und ein überzeugter Verfechter der Multidisziplinarität ist. Es ist nie zu spät, neue Dinge zu lernen.