programa

Meta AI ha anunciado el lanzamiento de Llama 3.2, que introduce el primer multimodal multimodales de la serie. Llama 3.2 se centra en dos áreas clave:

- LLMs con visión: Los modelos multimodales de parámetros 11B y 90B ahora pueden procesar y comprender tanto texto como imágenes.

- LLMs ligeros para borde y móvil: Los modelos de parámetros 1B y 3B están diseñados para ser ligeros y eficientes, lo que les permite ejecutarse localmente en dispositivos periféricos.

En este artículo, me abriré paso entre el ruido para destacar los aspectos clave de los nuevos modelos Llama 3.2, incluyendo cómo funcionan, sus casos de uso, cómo acceder a ellos y mucho más.

Llama 3.2 Modelos 11B y 90B Vision

Una característica clave de Llama 3.2 es la introducción de modelos habilitados para visión con 11.000 y 90.000 millones de parámetros.

Estos modelos aportan capacidades multimodales al ecosistema Llama, permitiendo que los modelos procesen y comprendan tanto texto como imágenes.

Capacidades multimodales

Los modelos de visión de Llama 3.2 destacan en tareas que requieren reconocimiento de imágenes y procesamiento del lenguaje. Pueden responder a preguntas sobre imágenes, generar pies de foto descriptivos e incluso razonar sobre datos visuales complejos.

Según los ejemplos de Meta, los modelos pueden analizar gráficos incrustados en documentos y resumir las tendencias clave. También pueden interpretar mapas, determinar qué parte de una ruta de senderismo es la más empinada o calcular la distancia entre dos puntos.

Casos de uso de los modelos de visión Llama

Esta integración del razonamiento de texto e imagen ofrece una amplia gama de aplicaciones potenciales, entre las que se incluyen:

- Comprensión del documento: Estos modelos pueden extraer y resumir información de documentos que contengan imágenes, gráficos y tablas. Por ejemplo, una empresa podría utilizar Llama 3.2 para interpretar automáticamente los datos de ventas presentados de forma visual.

- Respuesta visual a preguntas: Al comprender tanto el texto como las imágenes, los modelos de Llama 3.2 pueden responder a preguntas basadas en el contenido visual, como por ejemplo identificar un objeto en una escena o resumir el contenido de una imagen.

- Pie de foto: Los modelos pueden generar leyendas para las imágenes, lo que los hace útiles en campos como los medios digitales o la accesibilidad, donde es importante comprender el contenido de una imagen.

Abierto y personalizable

Los modelos de visión de Llama 3.2 son abiertos y personalizables. Los desarrolladores pueden afinar tanto las versiones pre-entrenadas como las alineadas de estos modelos utilizando el programa Meta Torchtune de Meta.

Además, estos modelos pueden desplegarse localmente a través de Torchchatreduciendo la dependencia de la nube y proporcionando una solución a los desarrolladores que desplegar sistemas de IA on-prem o en entornos con recursos limitados.

Los modelos de visión también están disponibles para su prueba a través de Meta AI, el asistente inteligente de Meta.

Cómo funcionan los modelos de visión de Llama 3.2

Para que los modelos de visión de Llama 3.2 puedan comprender tanto texto como imágenes, Meta integró un codificador de imágenes preentrenado codificador de imágenes en el modelo de lenguaje existente mediante adaptadores especiales. Estos adaptadores enlazan los datos de imagen con las partes de procesamiento de texto del modelo, permitiéndole manejar ambos tipos de entrada.

El proceso de entrenamiento comenzó con el modelo lingüístico Llama 3.1. En primer lugar, el equipo lo entrenó con grandes conjuntos de imágenes emparejadas con descripciones de texto para enseñar al modelo a conectarlas. Después, lo perfeccionaron utilizando datos más limpios y específicos para mejorar su capacidad de comprensión y razonamiento sobre el contenido visual.

En las etapas finales, Meta utilizó técnicas como ajuste fino y datos sintéticos para garantizar que el modelo diera respuestas útiles y se comportara con seguridad.

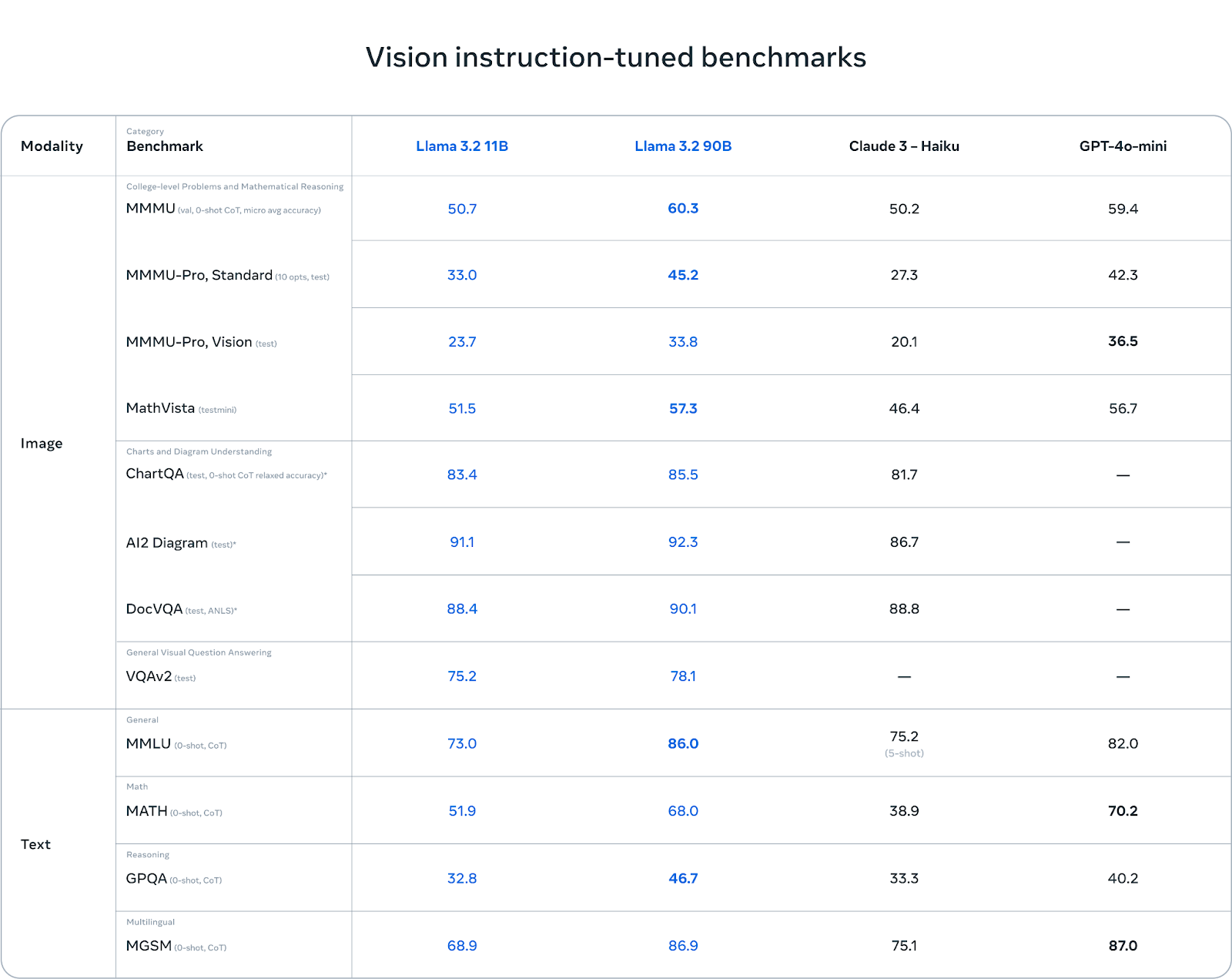

Puntos de referencia: Puntos fuertes y débiles

Los modelos de visión Llama 3.2 brillan en comprensión de gráficos y diagramas. En pruebas comparativas como AI2 Diagram (92,3) y DocVQA (90,1), Llama 3.2 supera a Claude 3 Haiku. Esto lo convierte en una opción excelente para tareas de comprensión de documentos, respuesta a preguntas visuales y extracción de datos de gráficos.

En las tareas multilingües (MGSM), Llama 3.2 también rinde bien, casi igualando a GPT-4o-mini con una puntuación de 86,9, lo que la convierte en una opción sólida para los desarrolladores que trabajan con varios idiomas.

Fuente: Meta AI

Aunque Llama 3.2 rinde bien en tareas basadas en la visión, se enfrenta a retos en otras áreas. En MMMU-Pro Vision, que pone a prueba el razonamiento matemático sobre datos visuales, GPT-4o-mini supera a Llama 3.2 con una puntuación de 36,5 frente al 33,8 de Llama.

Del mismo modo, en la prueba de referencia MATH, el rendimiento de GPT-4o-mini (70,2) supera significativamente a Llama 3.2 (51,9), lo que demuestra que Llama aún tiene margen de mejora en las tareas de razonamiento matemático.

Modelos ligeros Llama 3.2 1B y 3B

Otro avance significativo de Llama 3.2 es la introducción de modelos ligeros diseñados para dispositivos edge y móviles. Estos modelos, con 1.000 y 3.000 millones de parámetros, están optimizados para funcionar en hardware más pequeño, manteniendo un compromiso razonable en cuanto al rendimiento.

IA en el dispositivo: En tiempo real y privado

Estos modelos están diseñados para funcionar en dispositivos móviles, proporcionando un procesamiento rápido y local sin necesidad de enviar datos a la nube. Ejecutar modelos localmente en dispositivos de borde ofrece dos ventajas principales:

- Tiempos de respuesta más rápidos: Como los modelos se ejecutan en el dispositivo, pueden procesar peticiones y generar respuestas casi instantáneamente. Esto es especialmente útil para las interacciones en tiempo real, donde la velocidad es crucial.

- Mejorado privacidad: Con el procesamiento local, los datos del usuario nunca tienen que salir del dispositivo. Esto mantiene la información sensible, como los mensajes personales o los eventos del calendario, segura y bajo el control del usuario, en lugar de enviarla a la nube.

Los modelos ligeros de Llama 3.2 están optimizados para los procesadores Arm y son compatibles con el hardware de Qualcomm y MediaTek, que alimentan muchos dispositivos móviles y de vanguardia en la actualidad.

Aplicaciones de Llama 3.2 1B y 3B

Los modelos ligeros están diseñados para diversas aplicaciones prácticas en el dispositivo, como:

1. Resumiendo: Los usuarios pueden resumir grandes cantidades de texto, como correos electrónicos o notas de reuniones, directamente en su dispositivo sin depender de servicios en la nube.

2. Asistente personal de IA: Los modelos pueden interpretar instrucciones de lenguaje natural y realizar tareas, como crear listas de tareas pendientes o programar reuniones.

3. Reescritura de textos: Estos modelos son capaces de mejorar o modificar el texto sobre la marcha, lo que los hace útiles para aplicaciones como la edición automatizada o las herramientas de reformulación.

Cómo funcionan los modelos ligeros Llama 3.2

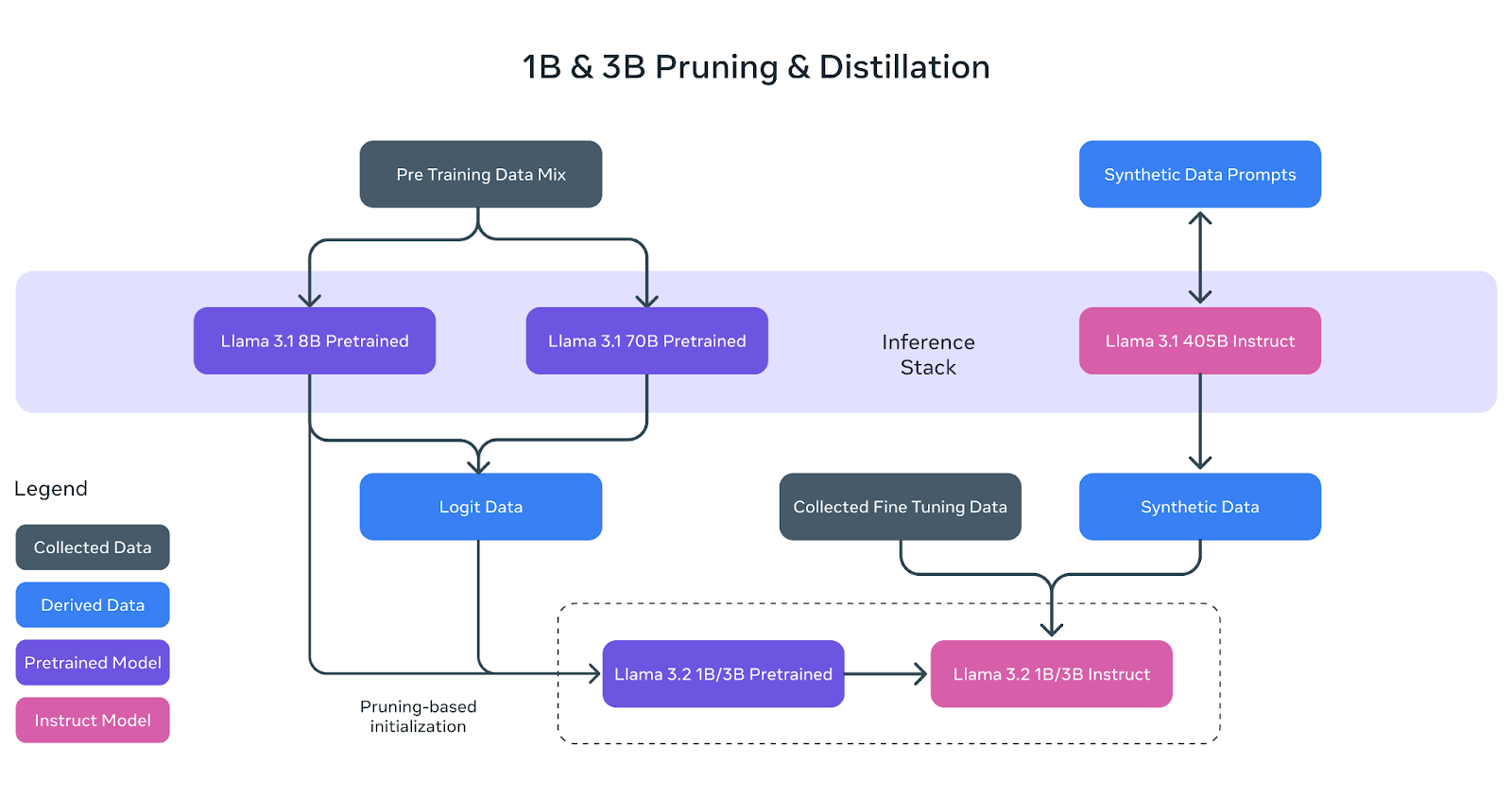

Los modelos ligeros Llama 3.2 (1B y 3B) se construyeron para adaptarse con eficacia a los dispositivos móviles y de borde, manteniendo un gran rendimiento. Para conseguirlo, Meta utilizó dos técnicas clave: la poda y la destilación.

Fuente: Meta AI

Poda: Hacer el modelo más pequeño

La poda ayuda a reducir el tamaño de los modelos Llama originales eliminando las partes menos críticas de la red y conservando al mismo tiempo todo el conocimiento posible. En el caso de los modelos 1B y 3B de Llama 3.2, este proceso comenzó con el modelo preentrenado más grande Llama 3.1 8B.

Mediante la poda sistemática, el equipo de Meta AI pudo crear versiones más pequeñas y eficientes del modelo sin una pérdida significativa de rendimiento. Esto se representa en el diagrama anterior, donde el modelo 8B preentrenado (recuadro morado) se poda y refina para convertirse en la base de los modelos Llama 3.2 1B/3B más pequeños.

Destilación: Enseñar a los modelos más pequeños

La destilación es el proceso de transferencia de conocimientos de un modelo más grande y potente (el "maestro") a un modelo más pequeño (el "alumno"). En Llama 3.2, los logits (predicciones) de los modelos mayores Llama 3.1 8B y Llama 3.1 70B se utilizaron para enseñar los modelos más pequeños.

De este modo, los modelos 1B y 3B, más pequeños, podían aprender a realizar tareas con mayor eficacia, a pesar de su tamaño reducido. El diagrama anterior muestra cómo este proceso utiliza los datos logits de los modelos mayores para guiar a los modelos 1B y 3B durante el preentrenamiento.

Perfeccionamiento final

Tras la poda y la destilación, los modelos 1B y 3B se sometieron a un post-entrenamiento, similar al de los modelos Llama anteriores. Esto implicó técnicas como el ajuste fino supervisado, el muestreo de rechazo y la optimización directa de las preferencias para alinear los resultados de los modelos con las expectativas de los usuarios.

También se generaron datos sintéticos para garantizar que los modelos pudieran manejar una amplia gama de tareas, como resumir, reescribir y seguir instrucciones.

Como se muestra en el diagrama, los modelos finales de instrucción Llama 3.2 1B/3B son el resultado de la poda, la destilación y un amplio post-entrenamiento.

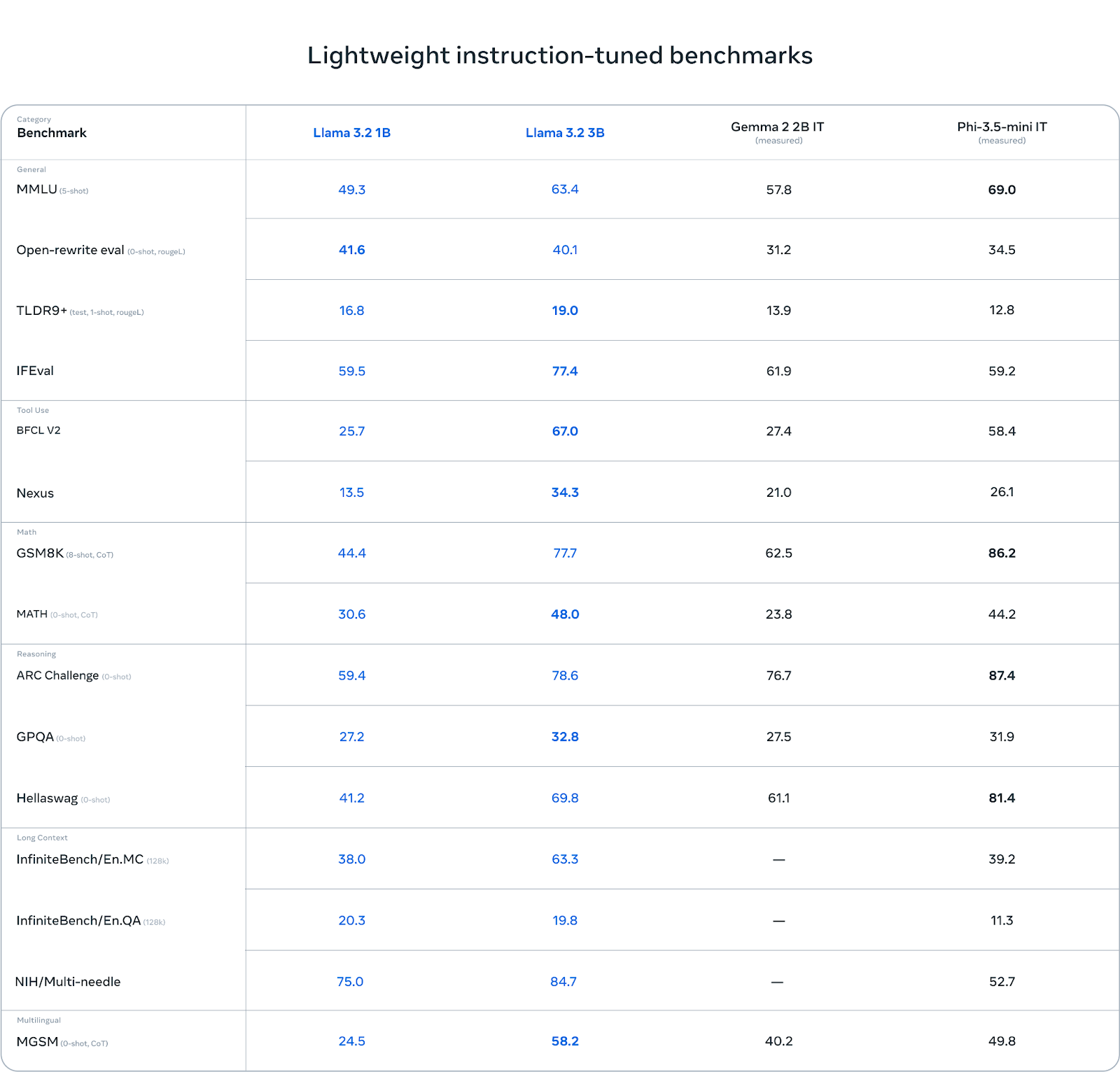

Puntos de referencia: Puntos fuertes y débiles

Llama 3.2 3B destaca en ciertas categorías, especialmente en tareas que implican razonamiento. Por ejemplo, en el Desafío ARC, obtiene una puntuación de 78,6, superando a Gemma (76,7) y quedando ligeramente por detrás de Phi-3,5-mini (87,4). Del mismo modo, obtiene buenos resultados en la prueba comparativa Hellawag, alcanzando 69,8, superando a Gemma y manteniéndose competitivo con Phi.

En tareas de uso de herramientas como BFCL V2, Llama 3.2 3B también brilla con una puntuación de 67,0, por delante de ambos competidores. Esto demuestra que el modelo 3B maneja con eficacia las tareas de seguimiento de instrucciones y las relacionadas con las herramientas.

Fuente: Meta AI

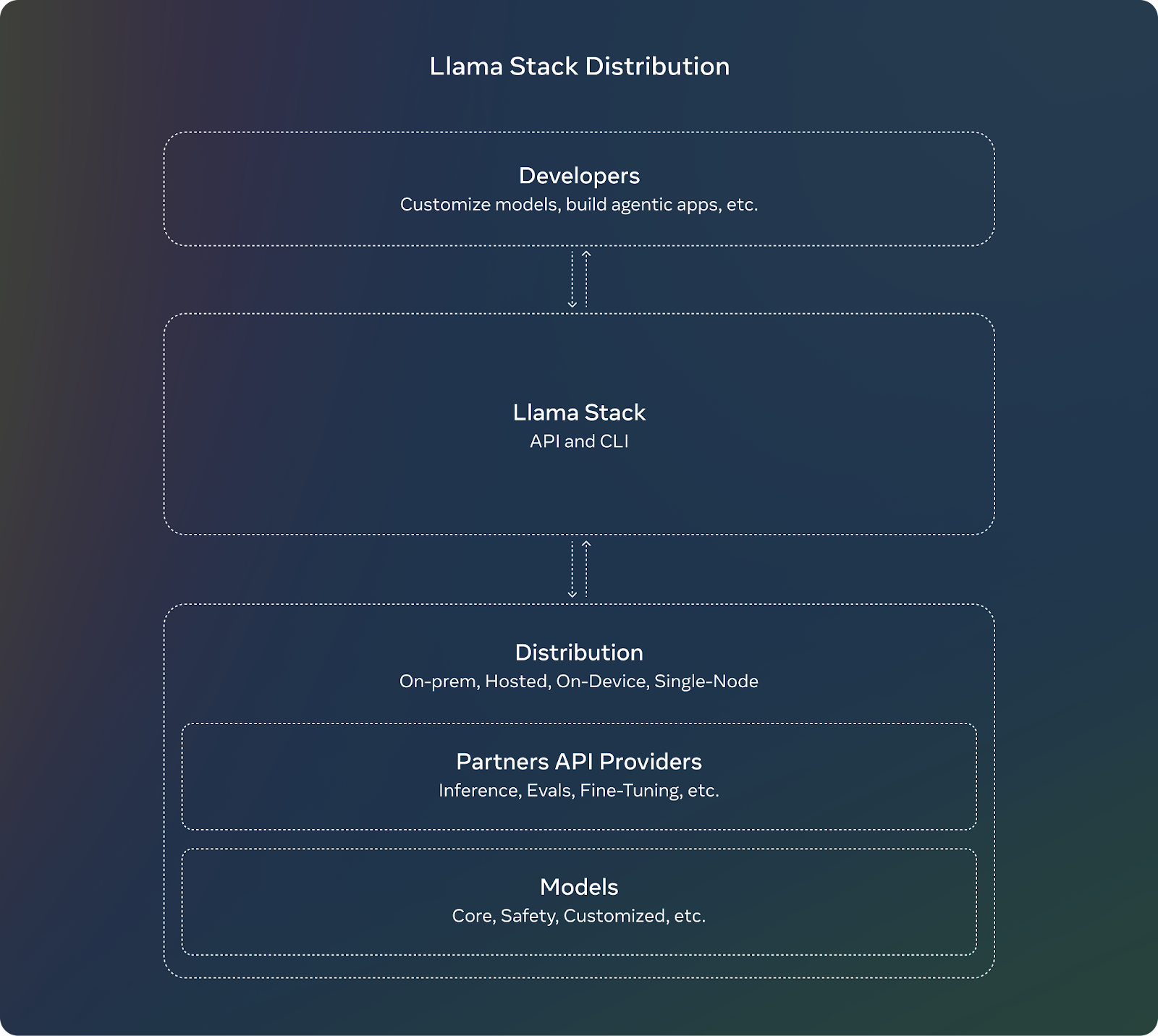

Distribución de la pila de llamas

Para complementar el lanzamiento de Llama 3.2, Meta presenta la Pila Llama. Para los desarrolladores, utilizar la Pila Llama significa que no tienen que preocuparse de los complejos detalles de configurar o desplegar grandes modelos. Pueden centrarse en crear sus aplicaciones y confiar en que la Pila Llama se encargará de gran parte del trabajo pesado.

Estas son las características clave de la Pila Llama:

- API normalizadas: Los desarrolladores pueden utilizarlos para interactuar con los modelos Llama sin tener que construirlo todo desde cero.

- Funciona en todas partes: La Pila Llama está diseñada para funcionar en diferentes plataformas:

- Nodo único: Ejecutar modelos Llama en un solo ordenador.

- En las instalaciones: Utilizando los modelos en tus propios servidores o nube privada.

- Nube: Desplegar modelos Llama a través de proveedores en la nube como AWS o Google Cloud.

- Dispositivos móviles y de borde: Haciendo posible ejecutar modelos Llama en teléfonos o dispositivos pequeños sin depender de la nube.

- Soluciones prefabricadas: La Pila Llama ofrece soluciones "llave en mano", que son como configuraciones ya hechas para tareas comunes como el análisis de documentos o la respuesta a preguntas. Pueden ahorrar tiempo y esfuerzo a los desarrolladores.

- Seguridad integrada: La Pila también incluye funciones de seguridad integradas, que garantizan que la IA se comporte de forma responsable y ética durante su despliegue.

Fuente: Meta AI

Llama 3.2 Seguridad

Meta sigue centrándose en IA responsable con Llama 3.2. Llama Guard 3 se ha actualizado para incluir una versión con visión que admite las nuevas capacidades multimodales de Llama 3.2. Esto garantiza que las aplicaciones que utilicen las nuevas funciones de comprensión de imágenes sigan siendo seguras y cumplan las directrices éticas.

Además, Llama Guard 3 1B se ha optimizado para su despliegue en entornos con recursos más limitados, haciéndolo más pequeño y eficiente que las versiones anteriores.

Cómo acceder y descargar los modelos Llama 3.2

Acceder y descargar los modelos Llama 3.2 es bastante sencillo. Meta ha puesto estos modelos a disposición en múltiples plataformas, incluyendo su propio sitio web y Hugging Face, una popular plataforma para alojar y compartir modelos de IA.

Puedes descargar los modelos Llama 3.2 directamente del sitio web oficial de Llama. Meta ofrece tanto los modelos más pequeños y ligeros (1B y 3B) como los modelos más grandes con visión (11B y 90B) para que los desarrolladores los utilicen.

Cara de abrazo es otra plataforma en la que están disponibles los modelos Llama 3.2. Proporciona un acceso fácil y lo utilizan habitualmente los desarrolladores de la comunidad de IA.

Los modelos Llama 3.2 están disponibles para su desarrollo inmediato en nuestro amplio ecosistema de plataformas asociadas, como AMD, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud y Snowflake, entre otras.

Conclusión

El lanzamiento de Meta de Llama 3.2 introduce los primeros modelos multimodales de la serie, centrándose en dos áreas clave: modelos habilitados para visión y modelos ligeros para dispositivos edge y móviles.

Los modelos multimodales 11B y 90B ahora pueden procesar tanto texto como imágenes, mientras que los modelos 1B y 3B están optimizados para un uso local eficiente en dispositivos más pequeños.

En este artículo he expuesto lo esencial: cómo funcionan estos modelos, sus aplicaciones prácticas y cómo puedes acceder a ellos.

Preguntas frecuentes

¿Qué es Llama 3.2 y en qué se diferencia de Llama 3.1?

Llama 3.2 introduce capacidades multimodales, que permiten a los modelos comprender tanto texto como imágenes. También ofrece modelos ligeros diseñados para un uso eficiente en dispositivos edge y móviles, a diferencia de Llama 3.1, que se centraba principalmente en el procesamiento de texto.

¿Cómo se comparan los modelos de visión Llama 3.2 con GPT-4o-mini y Claude 3 Haiku?

Los modelos de visión Llama 3.2 rinden de forma competitiva, destacando en tareas de razonamiento de imágenes y texto. Sin embargo, pueden ir ligeramente por detrás de la GPT-4o-mini en ciertas tareas especializadas como la resolución de problemas matemáticos.

¿Es Llama 3.2 de código abierto?

Sí, los modelos Llama 3.2 son de código abierto y están disponibles para su descarga en el sitio web oficial de Llama y en Hugging Face. Los desarrolladores pueden acceder a los modelos, ajustarlos y desplegarlos en varias plataformas, lo que garantiza la flexibilidad y la personalización.

¿Qué es la Pila Llama y por qué es importante para los desarrolladores?

La Pila Llama proporciona API estandarizadas y soluciones preconstruidas para desplegar los modelos Llama en múltiples entornos, desde la nube hasta el dispositivo. Simplifica el proceso de creación de aplicaciones de IA con Llama 3.2, garantizando una integración y un despliegue más sencillos.

¿Cuáles son los requisitos de hardware para ejecutar los modelos Llama 3.2?

Llama 3.2 ofrece modelos ligeros optimizados para procesadores Arm y hardware Qualcomm y MediaTek, lo que le permite funcionar eficazmente en dispositivos móviles. Los modelos más grandes pueden requerir GPUs más potentes o una infraestructura basada en la nube para un rendimiento óptimo.